深度卷积神经网络模型辅助下结直肠息肉检测系统对初级医师结直肠小息肉检出率的影响

王晓峰,周 璐,姚乐宇,何 凡,3,彭海霞,杨大明#,黄晓霖,3#

1.上海交通大学医学院附属同仁医院内镜中心,上海 200336;2.上海交通大学电子信息与电气工程学院,上海 200240;3.上海交通大学医疗机器人研究院,上海 200240

2020 年,全球癌症数据[1]显示:结直肠癌发病率在新发肿瘤中排名第3 位,死亡率排名第2 位;我国新发结直肠癌54 万例,死亡29 万例。通过结直肠镜检查,早期发现和切除结直肠肿瘤至关重要。临床上,息肉检出率被认为是结肠镜检查质量的评判标准;息肉检出率每增加1%,结直肠癌发病率降低3%~6%[2-3]。但由于内镜医师水平参差不齐以及息肉形态各异,结直肠息肉存在不同程度的漏诊[4]。因此,亟需一个能够自动识别息肉的客观诊断系统,以降低结直肠息肉,尤其是腺瘤的漏诊率。

近年来人工智能(artificial intelligence,AI)技术在多领域迅速发展,深度卷积神经网络(deep convolutional neural network,DCNN)的提出带动了计算机视觉领域的崛起[5]。DCNN 能从大数据中学习,兼具高精度和高速处理的优点。DCNN的这种特性,使其在医疗领域,尤其是在影像学图像方面应用广泛。2003 年,KARKANIS 等[6]首次报道了使用计算机辅助检测(computer-aided detection,CADe)系统检测结直肠息肉,检出率>90%。近年来,国内研究发现实时CADe 可以明显提高腺瘤检出率[7-9]。但上述研究对象均为有操作经验的内镜医师;而缺乏结肠镜操作经验的内镜医师能否从CADe中获益,值得探讨。为了探究AI 对初学者结直肠息肉检出率的影响,本研究构建了一个基于YOLO算法的结直肠息肉检测系统,用于视频条件下及实时操作中检测结直肠息肉,现将研究结果报道如下。

1 对象与方法

1.1 研究对象、数据处理及分类

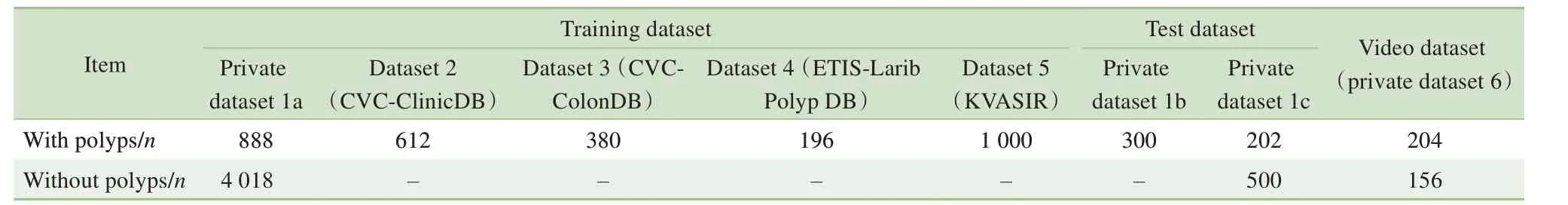

选取上海交通大学医学院附属同仁医院内镜中心数据库2019 年1 月—2020 年12 月的结肠镜图像及2021 年1 月—3 月的结肠镜视频(伦理备案号2020-118),并剔除其中模糊、无法识别正常结构等不合格的图像及视频。图像由研究人员进行分类,分为无息肉图像和有息肉图像,并采用软件对息肉进行标注(图1);对视频进行剪辑,分为无息肉视频和有息肉视频。再由2名高年资(具有10年以上结肠镜诊疗经验)内镜医师对2 类图像和视频进行确认。若存在争议,则剔除该图像或视频,并以这2 位医师共同确认的诊断结果为金标准。最终,将筛选出的图像和视频分为2 个数据集:数据集1(5 908 张图像)和数据集6(360 条短视频)。其中,数据集1 分为数据集1a(4 906 张图像)、数据集1b(300 张图像)和数据集1c(702张图像),数据集1c为从视频数据集6中截取的图像。数据集6 中无息肉视频156 条,含息肉视频204 条;每条含息肉视频中仅有1 枚息肉,息肉最大径为3~8 mm;所有视频播放时长为12~24 s。所有图像及视频均在白光、非放大模式下拍摄。所使用的结肠镜是日本OLYMPUS 公司的260 型或290 型。另有不同来源的图像数据集2~5,即公共数据集CVCClinicDB、CVC-ColonDB、ETIS-Larib Polyp DB 和KVASIR[10-13],共包含2 188 张图片。数据集1a 和数据集2~5 为模型训练集,数据集1b 和数据集1c 为模型测试集(表1)。

图1 私有数据集示例Fig 1 Examples of a private dataset

表1 6个数据集基本资料Tab1 Basic information of the 6 datasets

1.2 YOLOV3模型构建和训练

YOLOV3 模型是一种可以用于目标检测的DCNN[14]。通过在训练集上的训练,YOLOV3 模型可以直接预测输入图像中存在的物体的位置和类别。YOLOV3 使用Darknet53 作为骨干网络,进行图像特征提取。Darknet53 是一个包含卷积层和残差层的DCNN。当一张图像输入Darknet53 后,经过降采样,其尺寸降为原有的1/32,其图像通道数由原有的三通道扩增为1 024 通道。例如,尺寸为416×416 的三通道输入图像,经由Darknet53 处理后,将转化为尺寸为13×13×1 024 的特征向量。基于由图像提取的特征向量,YOLOV3 模型利用回归方法进行检测框的预测。对于每个检测框,YOLOV3 将给出检测框相对于锚框的中心坐标偏移量和检测框的宽度和高度偏移量,检测物体的类别和置信度。

在YOLOV3 训练开始前,由于训练集数据有限,为了提升训练的效果,使用在ImageNet 数据集上预训练的权重对YOLOV3 的骨干网络Darknet53 进行权重初始化[15],使网络的训练过程有更好的初始点,能够使网络更快地收敛。在训练的过程中,对每批输入样本进行数据增强以提高网络的泛化性能。采用的数据增强方法包括图像旋转、亮度变换和图像锐化。网络的训练使用Adam 优化器[16],训练过程包含75 轮,初始学习率为10-4;在训练的第50 轮后,学习率衰减为10-5。为避免过拟合,训练过程中对网络的权重进行了正则化,正则化权重为10-4。

1.3 模型测试

为了对上述训练完成的YOLOV3 的效果进行评估,分别使用私有图像数据集和短视频截取的数据集对其进行测试。使用数据集1b 及短视频截取数据集1c 对模型进行测试。在测试集上,利用灵敏度、特异度和精确度衡量YOLOV3 模型的性能。本模型灵敏度达0.940,特异度达0.813,精确度达0.783。

1.4 实验设计

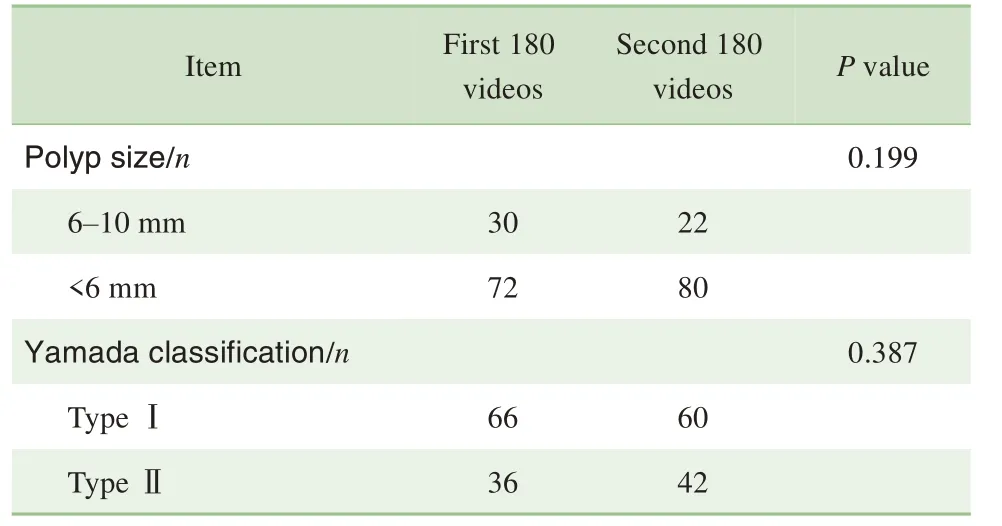

邀请10 名无结肠镜操作经验的医师参与研究,随机分为AI 辅助组(A 组,n=5)及无AI 辅助组(B组,n=5)。2 组医师对上述数据集6 中360 条视频进行判读,将360 条视频分为前组180 条视频和后组180 条视频,前后组各包含息肉视频102 条。前180条视频,2组均无AI辅助。后180条视频,AI辅助组辅以息肉检测系统,将视频数据集经检测系统处理后标记息肉,供研究者判读;无AI 辅助组则观看原始视频,判读是否存在息肉。根据息肉大小,将息肉分为小息肉(最大径6~10 mm)和微小息肉(最大径<6 mm)2 组[17];其中52 枚(25.5%)息肉属于小息肉,152 枚(74.5%)息肉属于微小息肉。同样,根据息肉的形态,将息肉分为山田Ⅰ型与山田Ⅱ型2组[18];其中126 枚属于山田Ⅰ型,78 枚属于山田Ⅱ型(表2)。前期,利用图片及视频对受试者进行培训,让受试者可以区分正常肠壁、息肉、肠黏膜堆积形成皱褶、粪水等。培训后对受试者进行随机化分组,通过判读前组视频,检验每组受试者是否处于同一水平。若视频中存在息肉,受试者未能检出,则视为漏诊;若视频中无息肉,受试者判断存在息肉,则视为误诊。

表2 数据集6中息肉大小及类型分布Tab 2 Size and shape of polyps in dataset 6

1.5 统计学分析

2 结果

2.1 漏诊情况比较

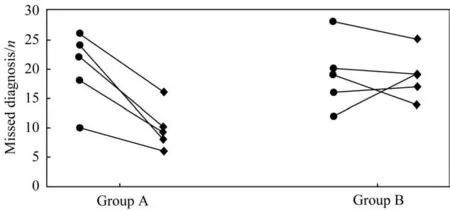

前180 条视频均无AI辅助时,A 组与B 组结直肠息肉平均漏诊例数分别为(20.5±5.7)例和(19.0±3.4)例,差异无统计学意义;后180条视频中,A 组息肉漏诊例数为(9.8±3.4) 例,明显小于B 组的(18.8±3.6)例,差异有统计学意义(P=0.031)。A 组内比较,后180 条视频息肉漏诊例数小于前180 条视频息肉漏诊例数,差异具有统计学意义(P=0.007)(图2)。

图2 2组受试者前后视频集检出息肉漏诊个数分布Fig 2 Distribution of the number of missed diagnosed polyps in the pre-and post-video sets of the two groups

2.2 误诊情况比较

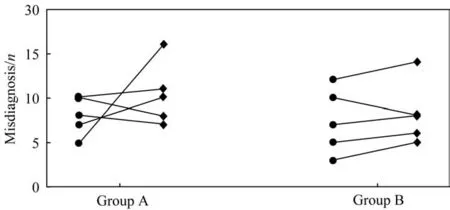

前180 条视频均无AI辅助时,A 组与B 组结直肠息肉平均误诊例数分别为(8.0±1.9)例和(7.4±3.3)例;后180 条视频中,A 组与B 组结直肠息肉平均误诊例数分别为(10.4±3.1)例和(8.2±3.1)例;组间差异均无统计学意义。A 组内比较,后180 条视频息肉误诊例数与前180 条视频息肉误诊例数的差异也无统计学意义(图3)。

图3 2组受试者前后视频集检出息肉误诊个数分布Fig 3 Distribution of the number of misdiagnosed polyps detected in the pre-and post-video sets of the two groups

3 讨论

随着内窥镜技术的不断进步,结肠镜检查的质量越来越受到重视。高质量的结肠镜检查在结直肠癌的早期诊治中具有重要意义,其中息肉检出率是衡量结肠镜操作质量的一个重要标准。既往研究[19-21]显示,结肠镜教学中心负责人培训以及有操作经验护士协助等举措均能提高息肉检出率。但上述方法需要较高的人力、物力和时间投入,且目前我国各地区消化内镜医师水平、分布比例、内镜资源配置等差异较大,短时间内培养出经验丰富的内镜医师的难度较大。因此,利用计算机自动识别结直肠息肉的客观诊断辅助系统帮助缺乏经验的内镜医师快速成长势在必行。随着AI 的不断发展,深度学习已经成功应用于语音识别、图像识别等领域。在内窥镜领域,利用深度学习识别和捕捉动态的目标,可以弥补人类视觉捕捉不全及易于疲劳的缺点[22-25]。目前,深度学习的卷积层神经网络框架众多,本研究构建的模型使用的是YOLOV3。YOLOV3 模型广泛应用于胃肠息肉的检查,也可应用于其他疾病的诊断[26-28]。

多项研究[6-9]提示,AI 辅助结肠镜诊断,可以提高结肠镜操作医师的腺瘤检出率。本研究发现,对于经过培训的无结肠镜操作经验的医师,AI 辅助组结直肠息肉漏诊例数明显低于无AI 辅助组;同时,2组间息肉误诊例数的差异无统计学意义。此外,A组受试者AI 辅助判读视频时息肉漏诊例数低于无AI 辅助时,且差异具有统计学意义。本研究中纳入204 枚息肉,其中74.5%属于微小息肉,25.5%属于小息肉。研究结果显示,AI 辅助可以增加无操作经验内镜医师对小息肉或者微小息肉的检出率。2020 年国内GONG 等[7]研究发现,AI 辅助可以提高结肠腺瘤的检出率;2019 年WANG 等[8]发现,对于腺瘤检出率低的内镜医师,给予AI 辅助后可以明显提升腺瘤检出率。这2 项研究均发现AI 辅助可以提高5 mm 以下息肉的检出率,对5 mm 以上的息肉检出率无明显影响。可见,AI 技术可以辅助发现微小病灶,减少内镜检查过程中微小病灶的遗漏,从而提高结肠镜检查的质量。尽管有学者[29]认为,部分小息肉为非进展性息肉;但是,也有部分研究显示结肠镜检查中大部分息肉为小息肉,其中一半为腺瘤,存在恶变的可能,应当早期切除[30-32]。因此,AI 辅助可提示缺乏结肠镜操作经验的医师发现息肉,尤其是小息肉及微小息肉,可辅助缺乏经验的内镜医师作出诊断,具有较好的临床价值。

本研究尚存在几点不足。首先,本研究为单中心研究。虽然纳入公共数据集,但图像数据仍相对较少;且在收集图像时排除了含有泡沫、粪水等大量干扰图像,而这些干扰在临床操作中是不可避免的,这可能会影响模型在真实操作中的应用。后续研究中,我们会前瞻性收集图像,扩大训练集,以期提高临床实用性。其次,本系统在实时结肠镜操作过程中同样可以识别息肉,但是否能提高缺乏经验的初级内镜医师的息肉检出率还未可知。之后,我们将在实时结肠镜操作中,验证本系统对初级内镜医师结直肠息肉检出率的影响。