“证据推理”能力测评工具的开发与检验

[摘要]“证据推理”能力强调从已有经验、问题情境中识别、转换、形成证据,利用证据进行推理,从而获得结论、解决问题的关键能力。基于测量评价理论的探讨,确立测评工具研制的思路,利用前期研究中确立的“证据推理”能力的内涵结构,参考PISA试题,研究设计了试测工具。利用效标关联设计和Rasch分析方法检验工具的信效度。根据数据结果对其进行修正,最终形成更为科学、信效度高、实用性好的“证据推理”能力测评工具。研究中测评工具的开发思路和方法,可以为素养、能力测评工作提供一定的借鉴。

[关键词]“证据推理”能力;测评工具;Rasch分析;实证检验

[中图分类号]G424.74[文献标识码]A

[文章编号]1673—1654(2023)05—050—011

基金项目本文系浙江省社科规划课题“基于项目式学习发展学生科学思维能力的跨学科实践和测评研究”(课题编号:23NDJC133YB)的阶段性研究成果之一。

学科核心素养是不同学科培养人的指引,是课程目标,也是评价依据。其中,理科课程对推理思维的培养显示出高度的重视[1],在各科目的课程标准文件中有着不同但明确的表达,如数学学科中的“逻辑推理”、物理学科中的“科学思维”、化学学科中的“证据推理”、生物学科中的“理性思维”等。虽然表达各异,但对于科学研究的本质过程与思维要求,学界形成了共识,如“基于事实证据和科学推理对不同观点和结论提出质疑、批判,进而提出创造性见解”[2]是科学思维的要求,也是科学素养的体现。本研究关注的是“基于证据的推理”能力素养,尝试开发能够测评这种构念的工具,并利用实证数据进行检验、修正。

在前期研究的基础上,确立“证据推理”能力这一构念的内涵、结构;与之相匹配,选择测评工具的内容载体,使每个项目都有明确的水平要求,每个水平层次都有多个项目来测查;结合专家审议的方式初步构建出测评的工具,由此保证其内容效度和表面效度。继而利用实证校验(empirical validation)的方式对工具进行质量检验,将试测工具与经典的LCTSR(LawsonsClassroomTestofScientific Reasoning)相比较,进行效标关联效度的检验。基于Rasch测量模型对测试数据进行质量分析;依据参数结果,结合访谈,进行项目的修正、优化,最终获得质量检验合格的测评工具。

一、测评对象的内涵结构

测评对象为“证据推理”能力,首先需要对该构念进行界定。结合新课标中学科核心素养的阐释,及国内外文件中对能力素养的表达,将“证据推理”能力(Evidence-based Reasoning Competence,ERC)定义为:在科学学习中,从已有经验、问题情境中识别、转换、形成证据,利用证据进行推理,从而获得结论、解决问题的能力表现[3]。识别、筛选证据,转换、形成证据,应用、评价证据等过程是科学探究和科学实践的重要环节,是科学工作者展开科学研究、得到科学发现的基本过程。关注于“基于证据的推理”能力,也即“证据推理”能力,对科学学习和教学具有重要意义。

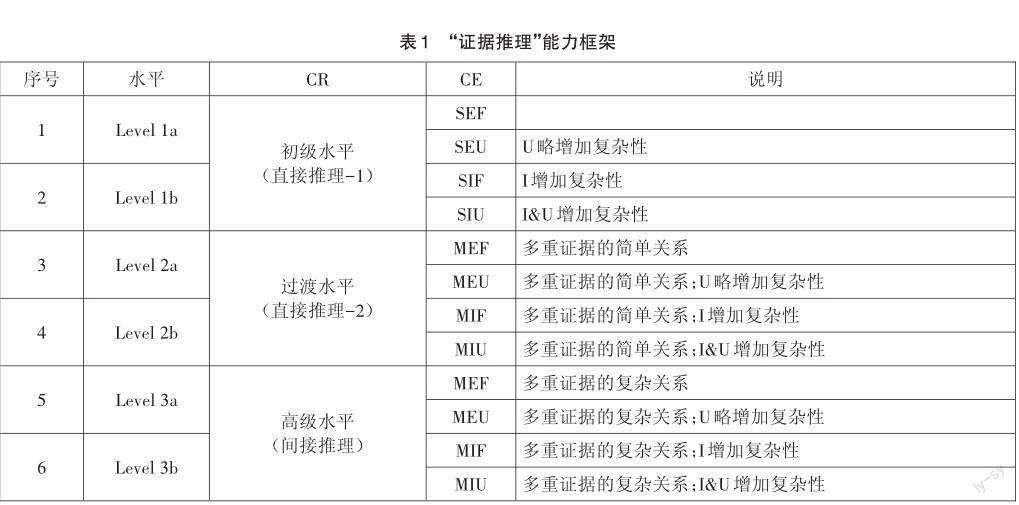

基于理论探讨和德尔菲调查法,整合“证据”和“推理”两方面的复杂性,逐步构建形成了可操作的、多水平递进的“证据推理”能力框架(Framework of Evidencebased Reasoning Competence,FERC)[4]。最终的框架确立了6个水平,在每一级推理复杂性水平之下各有两个子水平(a与b),在证据复杂性上交叉体现,如表1所示。框架反映了学生“证据推理”能力的不同水平表现,即测评对象的内涵结构。

在此框架中,证据的复杂性(CE)从三个方面去刻画,涉及证据的显现程度(以E表示显性,I表示隐性)、情境熟悉度(以F表示熟悉,U表示陌生),以及所需证据的数量(S表示单一证据,M表示多重证据);推理的复杂性(CR)划分为三个层级,初级水平、过渡水平和高级水平。例如,当学生解答问题时,遭遇一个陌生情境(U),线索不明(I),而且所需利用的证据较多(M),在这种复杂性表征的组合情况下(MIU),其解决问题的困难程度自然最高;若学生遇到的是熟悉的情境(F),仅需单一证据(S),而且显而易见(E),这种证据复杂性(SEF)对思维的要求最低。

二、测评工具的设计

依据测评工具开发的理论基础,按照研制思路,参照测量构念的水平框架,进行测评工具的设计。

(一)项目编制的原则

测量是以被试对工具项目的作答反应区分被试的能力水平,工具项目的难度表征需从主客体两方面考虑[5]。被试群体是根据测量理论或实际情况挑选出的样本,而项目本身的复杂程度则是在工具研制过程中必须设计、考虑的。从项目或工具客体的影响来看,项目的新颖性、逻辑结构[6]、情境设置、任务要求等问题本身的属性影响着项目的难度,其本质是关系复杂性(relational complexity)的作用[7]。

本研究所关注的是学生在科学领域的能力表现,因此内容涉及科学学习、科学知识方面,这是项目设计可供选择的情境来源和内容依托。“证据推理”能力的测查项目应注重情境的创设,在解决问题的过程中,从项目的情境中挖掘“证据”,在头脑中进行转换,运用推理思维去作答。根据水平框架(表1),证据所依托的内容载体应从显性/隐性、熟悉/陌生等多个方面去设计。

例如,大型的国际测评项目PISA就是以“能力”测评为核心目标,以“情境”为主要载体,依据包含“能力”“知识”和“态度”的科学框架,开发了科学能力测评工具[8]。一般不要求學过有关的知识,只需根据题目情境、文字说明(提供信息)、图表(如条形图)等,加以分析、转换,提取出有价值的“证据”,结合题目前面所提供的信息(类似于科学常识、道理)建立出正确的关系(运用推理思维),这样才能正确解答问题[9]。题目的呈现形式和情境要求增加了解答的难度,主要涉及可能不熟悉的情境,甚至非常陌生,是被试解决问题的障碍之一;题目中的图像解读,需要被试从中提取“证据”,建立简单的数学关系或因果关系等,做出推断。此外,与PISA一样,还需设计详细的评分标准和编码,尤其是对于非选择题(如建构反应题)。

基于以上分析,项目设计主要遵循了以下原则:①项目中尽量不涉及具体的学科知识要求;②以不同的情境为载体;③以多种形式表现证据及其复杂性,如图表、文字等混合呈现;④能力要求依据框架而来,水平层次具体而清晰;⑤避免冗长多余的表述增加阅读负担等。据此,结合专家小组审议的建议保证基本的表面效度,开发了适于测查学生“证据推理”能力的工具。

(二)项目对应与评分

参考PISA 2006的科学样题①,初步编制的测评工具共有25个项目,包含12个单项选择题(P01,P02,P06,P07,P08,P10,P11,P14,P15,P18,P19,P23);13个建构反应题,其中8个1分题(P03,P04,P05,P09,P16,P17,P20,P25),5个2分题(P12,P13,P21,P22,P24),满分为30分。工具项目的情境丰富,涉及科学的多个领域,涉及的证据来源于生活现象、实验现象、科学常识、科学史料、数据资料等。

在项目设计的过程中,需要从显现度、情境熟悉度和所需证据数量三个方面考虑每道题所呈现的“证据”,确保每道题都有一个水平归属,不至于出现某水平上没有可测的项目,或者某项目的水平不明的情况。试测项目与框架水平的对应情况如表2所示。

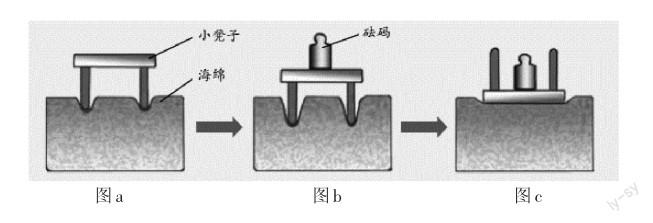

例如项目P01,是一道选择题,正确答案是D。题目涉及的情境是龋齿问题,被试很熟悉,而且解题所需的证据可以直接从题干中获得,利用简单的信息即可推理得到“细菌产生酸性物质”,能力水平要求低。而项目P12要求通过实验情境(以图示和文字说明)推导出压强(或压力)的影响因素,解题的证据并不复杂,但需要从图中对比、转换才能获取(a与b相比增加了重量或质量),比较隐性,而且相比于龋齿、沙滩或雪地上的行走,被试并不熟悉利用小凳子和海绵做实验的这种特定情境,下一步做出正确推理,回答出影响因素并不难。项目P12是建构反应题,获得满分(2分)还需要正确、完整地回答出因素与结果之间的关系,可参考评分标准示例。

项目示例(P01):

生活在我们口腔中的细菌会导致龋齿(牙齿蛀蚀)。对于龋齿,我们查找到以下信息:

·导致龋齿的细菌以糖为食物;

·糖能转化成酸性物质;

·酸性物质会破坏牙齿表面;

·刷牙对预防龋齿有帮助。

(1)(1分)为什么细菌会造成龋齿?()(P01)

A细菌产生珐琅质B细菌产生糖

C细菌产生矿物质D细菌产生酸性物质

项目示例(P12):

人在沙滩或雪地上行走,会在沙滩或雪地上留下脚印,即压力会使物体的表面产生凹陷的效果。为探究影响压力效果的相关因素,开展实验(如下图所示),通过比较海绵凹陷的程度,得出结论。

(1)(2分)对比a与b,你能发现影响压力效果的因素之一是什么?并请用一两句话描述这个结论。(P12)

评分标准示例(P12):

以下回答计2分:正确回答了因素,并且正确描述或对比了现象及压力大小的作用效果。

·可能的回答:因素是重物(压力)的大小(多少);受力面相同时(或描述出图a与b都是凳子脚作用于海绵),压力越大(或说明加上重物),压力的作用效果越明显。

以下回答计1分:正确回答了因素;但仅描述或对比了现象,未描述作用效果与压力大小这个变量之间的关系。

·可能的回答:因素是重物(压力)的大小(多少);图a压得浅,图b压得深。

以下回答计0分:因素回答错误(即使现象对比的描述正确,也计为完全错误);或因素与现象对比均错误;或仅作答一部分且错误。

·可能的回答:因素是接触面;重物大,作用效果明显。

未填答记-3(缺失值)

在统计编码时,将没有作答的记为缺失值(编码为-3),而非赋0分;得分即编码数字;选择题回答正确则编码为1,错误为0,未作答的缺失情况同样编码为-3;卷面最低得分为0,最高分为30分。

三、测评工具的检验

除了利用專家审议的方法保证工具的内容效度、表面效度之外,还应运用试测收集实证数据的方式进行质量分析。本研究进行了试测,使用效标关联的方法及Rasch测量模型进行数据分析。

(一)试测概述

在正式的试测之前,挑选部分样本进行了小范围测试,以检视ERC工具施测时可能发生的情况,如测试时长、学生阅读题项所遇到的问题等。之后挑选样本进行试测,基本流程和数据处理方式概述如下。

1.测试实施的流程

以效标关联效度(criterion validity)为指标检验“证据推理”能力(ERC)测评工具的实用效度(pragmatic validity)。许多研究采用LCTSR[10-11]进行推理能力的评价和分析,其内容效度已然得到证实[12-13],因此可以将LCTSR作为一个基准,来检视另一个测量工具,以二者的相关性来说明新的测量工具是否具有效标效度。

试测包含两次测试。首先利用LCTSR对被试样本进行测试,回收测试数据;在一周后,对同一批样本进行“证据推理”能力的测试。在两次测试过程中,由班主任或任课教师主试,向学生简要说明测试的基本情况,强调根据题目信息进行作答(两次测试的卷首位置均提供了说明),测试时间均为30分钟。

2.试测的样本选择

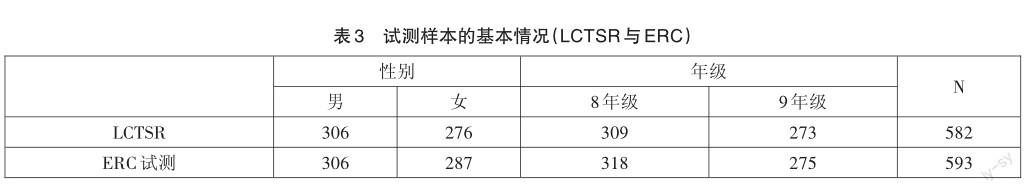

两次测试的样本来自S市的两所初级中学(YC与YL),包含八、九两个年级,这两所中学的基本情况类似,教学质量位于区内中等水平,数据分析时,并不比较学校差异,将样本混合进行整体考查。

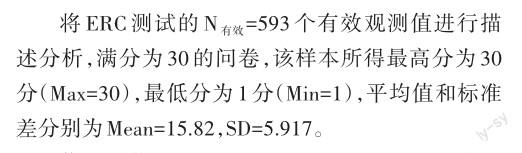

发放的测试卷共有627份,其中YC中学248人,八年级154人,九年级94人;YL中学379人,八年级186人,九年级193人。剔除未作答的答卷(缺失处理),前后两次测试的有效样本率均达到95%以上。被试的基本情况如表3所示,参加LCTSR测试的有效样本数为N=582,ERC测试的有效样本共有593人,两个测试均是男生略多于女生,8年级略多于9年级。

3.数据的处理方式

施测之后,评阅所收集的问卷,评阅人为课程与教学论专业的博士生1名、硕士生1名,评阅之前对其进行培训和指导,严格按照评分标准进行。对于建构反应题,评判不一致时需互相商议,仍无法达成一致则交由专家组决断。

以LCTSR测试的结果为标杆,与同样本下的ERC测试结果相比对,计算相关系数表征后一工具的效度。然后,运用Rasch测量模型对本轮试测结果进行具体分析,以期对ERC测评工具进行质量检验,更为重要的是获得工具修正的依据。

(二)试测结果

按照第二轮试测的流程,利用SPSS 22.0对测试的数据进行描述分析和校标效度检验,利用WINSTEPS 3.72.0进行Rasch分析。

1.描述统计与效标效度

信度系数为Cronbachsα=0.809(N=593),表明ERC测评工具的内部一致性信度良好,可以认为25个项目所测查的是同一种构念[14]。

将ERC与LCTSR测试进行匹配,共计552名被试作答了两次测试,二者得分的相关系数为0.527(Pearson积差相关),统计显著(p = 0.000,N=552),即显著的中度相关,说明用于试测的ERC测评工具具有较好的实用效度。

总的来说,SPSS分析获得的信效度系数反映试测工具的质量良好。对于“证据推理”能力这一构念,它与科学推理能力既有共性,又有区别。与测量科学推理能力的LCTSR工具有显著的相关性即可印证二者的共同之处,说明试测工具能够对学生的“推理能力”构念进行测评;而本研究的ERC测评又不只如此,其研究的问题或对象是学生在科学学习领域,基于“证据”进行“推理”的能力。

2.Rasch分析的结果

参考WINSTEPS使用手册及Rasch模型应用的实证研究[15],对试测数据进行统计和分析,参照比对使用手册中的参数指标进行评价。

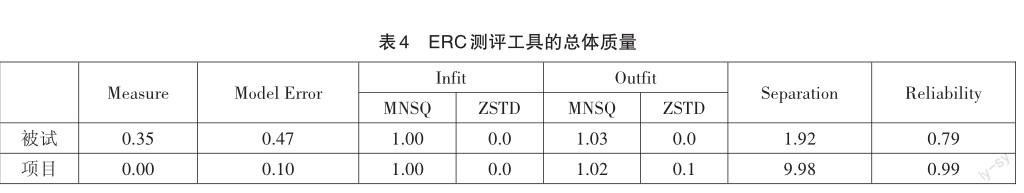

(1)总体质量分析

将所有的观测值数据(N=627)导入WINSTEPS中进行运算,软件自动识别出缺失(missing)或缺少作答(lacking responses)的观测值34个,即共计593个被试(person)的回答视为有效(valid responses),所有25个项目(item)均被估算,结果如表4所示。在Rasch模型中,将项目的难度估计值(Measure)固定为0,此时被试的Measure即反映了被试的平均能力水平,就本研究而言,即被试的ERC水平为0.35(Rasch分),略高于项目难度值,差距并不大,说明该工具项目合适于该轮试测样本的ERC测评。

结合表中的其他参数可以说明工具的总体质量,这些参数均有其可以接受的取值范围。模型误差(Model Error)反映了实际观测值与理论模型值之间的差异,被试和项目的误差值均较小,接近于0,说明利用工具收集的观测值(observation)能够较为准确地反映真实情况,即学生的ERC;Infit与Outfit反映的是观测数据与模型之间的拟合度,分别包含MNSQ与ZSTD两个值,对本研究的被试和项目而言,其MNSQ趋近于1,ZSTD趋近于0,皆十分理想(perfect),说明ERC测评工具的观测值与Rasch理论的理想模型适配良好;分离度(Separation)参数表示工具项目区分被试能力的程度,值越大说明区分得越好,从表中可以看到,项目的分离度大(9.98),被试的分离度接近于2(1.92),在可以接受(acceptable)的范围[16-17];信度(Reliability)系数说明的是观测结果的一致性、稳定性,信度愈高表示测量误差值愈低,进行某个构念的测评时,希望所获得的观测值不会因形式或时间的改变而有所变动,试测工具的项目难度测量信度值(0.99)趋近于1,被试能力测量的信度(0.79)低于項目信度,但仍属于信度良好的范围内。

基于Rasch模型假设,以上参数结果说明ERC试测工具的总体质量特征良好。但在被试分离度上略有欠缺,而且有可能存在其他未能反映的问题,还需进行深入细致的检验和分析。

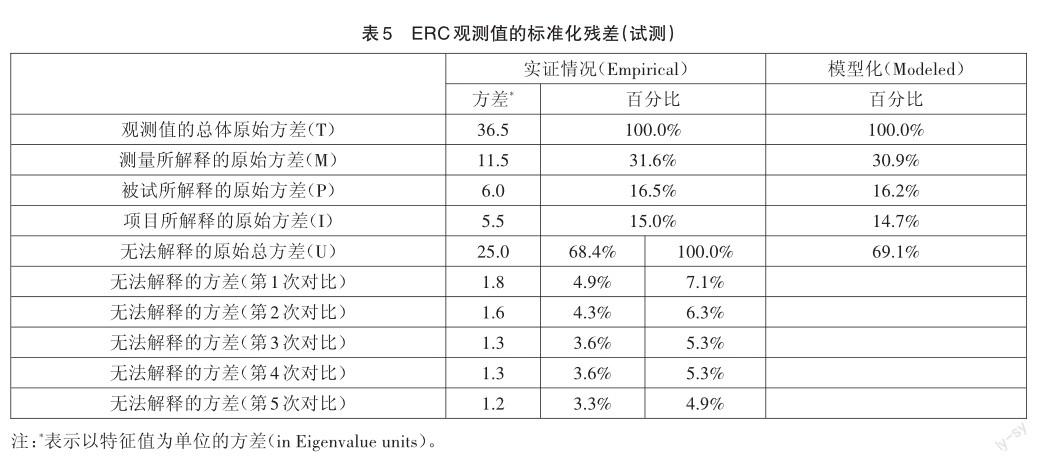

(2)单维性的分析

满足单维性(unidimensionality)是“好测量”(good measurement)的特征之一,将试测后的观测值进行多维度检查(multidimensionality investigations),得到标准化残差分析的有关数据(表5)。

Rasch测量模型是利用基于标准的主成分分析(PCA,principle components analysis)(正交不旋转)对原始分(raw score)进行检验。在以上标准化残差表中,无法解释的原始总方差(Raw unexplained variance)下的“对比”(contrast)最为关键,它反映了按照主成分分析能否分解出某成分(component)或因素(factor)不能由Rasch测量解释,但这些成分或因素又需要被解释。当第一个成分的残差大于2时,则需要进一步审视项目的观测值,找到是什么原因产生了这个“脱离”维度(off-dimensional)的成分。单维性即检测是否有可能的“威胁”存在,存在非Rasch模型才能解释那些“无法解释”(unexplained)的部分,而这正是表中的“对比”(contrasts)所报告的内容。

就本研究的试测工具而言,第1个成分的残差为1.8<2,满足单维性要求,说明工具项目经Rasch模型检验,即使是“无法解释”的部分也未发现威胁Rasch测量的因素,可以认为观测值都能够由Rasch测量下的项目难度、被试能力及评定结构等进行解释。根据表中的数据,测量所能解释的原始方差(Raw variance explained by measures)占原始分数总体方差(Total raw variance in observations)的31.6%,不算很高,但是因为不存在第2个维度,则數据在统计意义上仍是可控的,方差解释率良好,可以不必修正工具或样本[18]。

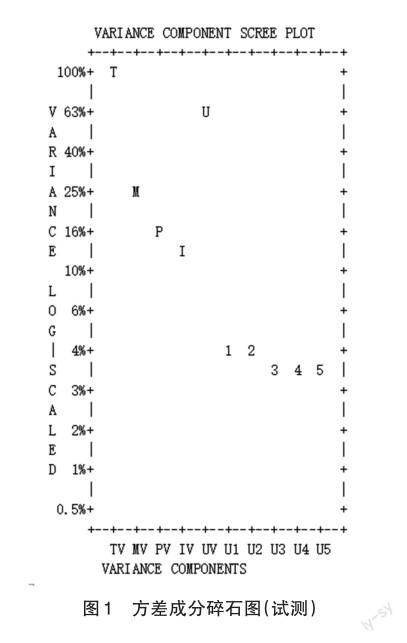

按照对数尺度(logarithmically scaled),以表中方差值的百分比为纵坐标,呈现出各成分方差的碎石图(图1)。图中字母T、U、M、P、I代表的是不同方差;数字1~5则表示分解的可能成分(components),它们所占百分比皆在3%~4%,由图可以清晰地比对出各自的差异不大,再次印证了试测工具的项目仅测量了一个ERC构念。

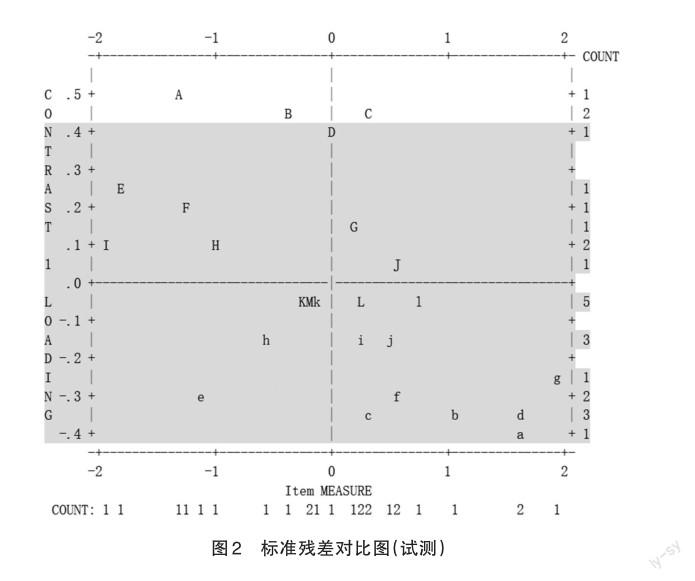

为探查测评工具中更加细节的问题,提供工具完善的线索和方向,对25个项目进行了具体的分析。图2所示的标准残差对比图(Standardized Residual Contrast Plot)直观呈现了所有项目的载荷系数(loading)与项目难度估计值(item measure)的关系。图中的字母表示的是不同的项目,此处共有25个,当纵坐标的数值超过[-0.4,0.4]区间范围时,即不满足单维性检验。

由图2可知,项目A(P12)、B(P13)与C(P21)超出规定的参数范围,需要在工具优化的过程中重新审视,仔细考虑是否存在其他因素影响这些项目对于ERC的测查。

(3)项目作答分析

对于工具所有项目的作答情况,可以进行细致对比分析,例如对于选择题,某些选项如无人选择,则需重新考虑选项的设置。而本轮试测中,所有选择题(共12个单项选择的项目)的选项均有被试作答。

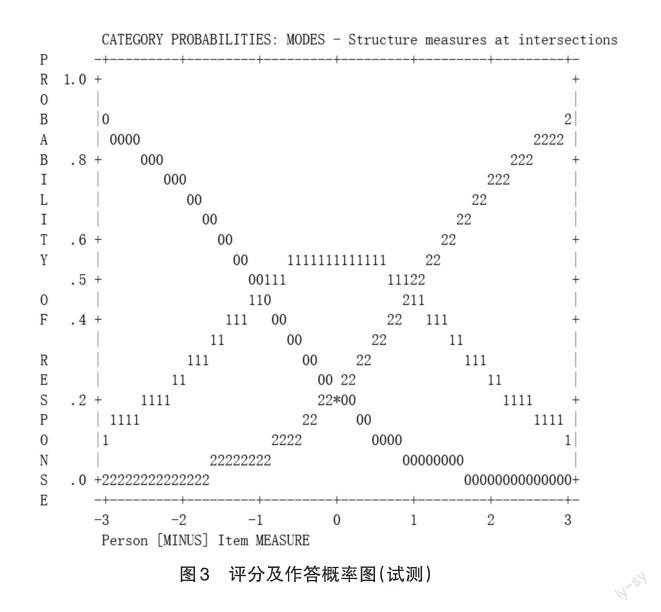

建构反应评分题,包括012计分题(5个)及01计分题(8个)。如图3所示,以012计分题的作答概率曲线为例,横坐标表示的是被试能力与项目难度估计值之间的差值(Person [MINUS] Item MEASURE),纵坐标表示对被试作答评分(0,1,2)的概率。在临界值(threshold)位置,被试获得两种分数的概率相等,即曲线交叉处的纵坐标相等。图示的3条曲线界限明显,能至少涵盖[-3,3]的能力区间,并在恰当的能力点有峰值,如能力最高的被试获得最高分(3分)的几率最大,或者说能力最高的被试才最有可能获得最高分。根据项目的作答曲线,本轮试测工具在各评分等级之间区分度较好,能够合理说明不同能力学生的得分几率的大小,符合Rasch模型的基本理论假设。

此外,基于Rasch模型对观测项目的分布及拟合情况进行分析,结果发现,除了少数项目需要再修正,工具能够基本涵盖被试样本的能力水平,与模型拟合较好,对于ERC这一构念的考查和估计是“有效的”。至此,通过LCTSR测试及ERC试测,对测评工具进行了质量分析,数据结果表明,该工具的信效度良好,满足Rasch理论模型的假设,但仍有一些项目需要修正、完善。

四、测评工具的修正

基于Rasch模型对ERC测评工具进行质量分析的过程中,不仅获得了工具质量的参数,也发现了存在问题的项目。在项目修正过程中,主要依据量化的数据结果,同时还调查了答题者的实际感受,由此更加全面地考虑如何改进工具的项目。总体来看,试测工具的项目修正主要涉及剔除质量较差的项目,修改计分题的评分标准,或者改变题型和试题表述等方面。

在数据支持和访谈分析相结合的基础上,我们修正了其他单维性不良、水平不一致、拟合指数不好的项目。我们也重新梳理了各项目的表述、措辞,某些项目的复杂性编码、能力水平的归属等。而且在细节的修改上,质性的访谈方法更为有效。例如,项目P14预设的证据复杂性编码为MEF,即需要多重的、显性化证据,题目情境是面包制作过程中的发酵这类生活现象,属于熟悉的情境。但经访谈发现,学生并不熟悉面团发酵,访谈对象表示“听说过这个词,不过不懂”“猜测应该是有气体产生”等。可见,该项目的情境熟悉度并不符合预设,其证据复杂性编码应为MEU。定量的数据结果与质性分析的合理结合有助于挖掘数据表层之下的意义,这些修正、调整对准确、深入分析学生的能力表现很有必要。

经过检验和优化,最终形成的ERC工具包含23个项目,满分25分,与框架水平的对应情况如表6所示。

五、结语

本研究从测量理论的阐释出发,择定以IRT为指导,采用纸笔测验,以Rasch模型为数据检验的方法,确立了ERC测评工具研制的思路,并依此进行具体的描述和讨论。结合专家审议,依据“证据推理”能力的内涵结构,以尽量少的学科内容要求和情境创设为准则,参考PISA试题,编制了试测工具。其后利用实证方法检验工具的信效度,此处包含效标关联效度的设计,以及Rasch分析方法的应用,以求更加科学全面地实施工具检验。

在效标关联效度的验证及Rasch模型的数据检验之下,得到了工具质量良好的结论,同时也获得了工具修正的线索和启发;针对试测工具中值得重新审视的项目,从评分标准、题型、情境表达等方面予以改进,甚至剔除,以求获得更为科学的、信效度优秀的、实用性好的测评工具。

研究采用的測评工具开发思路和方法,可以为素养、能力测评工作提供一定的借鉴和启发。本研究所开发的工具不依托于某特定学科,以求单纯考查学生的关键能力,因此能适用于物理、化学等多个科学学科,在实际教学评实践中,也可根据需要进行适当改编。但工具的应用、推广,也需要更大样本的测量调查。而且,测量过程中所挑选的样本,所应用的统计方法对工具质量及样本表现的分析等都有影响,对各种质量参数的结果也需谨慎采纳,有必要结合深入的质性分析技术,实现进一步的优化。

参考文献:

[1]核心素养研究课题组.中国学生发展核心素养[J].中国教育学刊,2016,(10):1-3.

[2]教育部.普通高中物理课程标准[M/S].北京:人民教育出版社,2017:4-5.

[3]罗玛.从科学推理到证据推理:内涵的探讨[J].化学教学,2019,(09):3-6.

[4]罗玛.“证据推理”能力的水平框架构建——基于德尔菲调查[J].化学教学,2021,(03):13-18.

[5]罗玛,王祖浩.教育考试中试题难度的测评研究——影响因素、评估方法及启示[J].教育测量与评价,2016,(9):52-57.

[6] Fynewever H. A Research Methodology for Studying What Makes Some Problems Difficult to Solve [J]. International Journal of Science Education,2010,32(16):2167-2184.

[7]辛自强.关系-表征复杂性模型的检验[J].心理学报,2003,35(4):504-513.

[8] OECD. Measuring Student Knowledge and Skills:The PISA 2000 Assessment of Reading,Mathematical and Scientific Literacy. Education and Skills [Z]. Sourceoecd Education & Skills,2000.

[9] OECD.Cresswell J,Vayssettes S.Assessing Scientific,Reading and Mathematical Literacy:A Framework for PISA 2006 [Z]. 2006.

[10] Lawson A E.The Development and Validation of A Classroom Test of Formal Reasoning [J]. Journal of Research in Science Teaching, 1978,15(1):11-24.

[11] Lawson A E. The Generality of Hypothetico-deductive Reasoning:Making Scientific Thinking Explicit [J]. American Biology Teacher,2000,62(7):482-495.

[12] Bao L,Cai T,et al. Learning and Scientific Reasoning [J]. Science,2009,323(5914):227-237.

[13] Lee C Q,She H C.Facilitating StudentsConceptual Change and Scientific Reasoning Involving the Unit of Combustion [J].Research in Science Education,2010,40(4):479-504.

[14]荣泰生.AMOS与研究方法[M].重庆:重庆大学出版社,2010:81-83.

[15] Sondergeld T A,Johnson C C.Using Rasch Measurement for the Development and Use of Affective Assessments in Science Education Research [J]. Science Education,2014,98(4):581-613.

[16] Lamar M M.Using and Developing Measurement Instruments in Science Education:A Rasch Modeling Approach [J]. Science Education,2012,96(1):183–185.

[17] Mok M M,Cheong C Y,Moore P J,et al.The Development and Validation of the Self-directed Learning Scales(SLS)[J]. Journal of Applied Measurement,2006,7(4):418-449.

[18] Linacre J. M. A Users Guide to WINSTEPS / MINISTEP:Rasch-model Computer Programs [M]. Chicago,IL:WINSTEPs. com,2011:333-337.

The Development and Validation of the Measurement Instrument of the Evidence-based Reasoning Competency

Luo Ma

College of Teacher Education,Ningbo University. Ningbo,Zhejiang,315211

Abstract:Thecompetencyof“Evidence-basedReasoning”(EBR)emphasizedtheidentification,transformation and formation of scientific evidence,using evidence to reason and reach a conclusion,leading to the problem-solving. This study begun with the discussion of the theory on measurement and evaluation in order to identify the process of instrument development.Based on the structure of the construct of EBR competency,according to our previous study,and the PISA instrument,this study designed an instrument for pilot test.It used the criterion-related examination and Rasch analysis to test the reliability and validity of the instrument after the pilot test.According to the data results,the modification of the instrument was conducted to obtain the valid and reliable,practical and scientific instrument for EBR competency measurement.And the development process and method applied in this study would provide some reference and inspiration for ability assessment and measurement.

Key words:Evidence-based Reasoning(EBR)Competency,Measurement Instrument,Rasch Analysis,Empirical Examination

①PISA 2006科學的样题,来源链接为https://www.docin.com/p-53392617.html。