多项选择题命题技术:基于新手命题员培训的案例

王肖竹 王佶旻

[摘要]聚焦一项语言测评课程中的命题培训,分析27名研究生作为新手命题员,在经过命题知识讲解,独立编写的多项选择题和小组合作修订后,命题成果中的题目缺陷,比较部分新手与专业命题员编写的题目在作答结果上的差异,并对其中9名研究对象进行课后访谈。研究发现,新手命题员的题目经过合作修订后质量有较大提升,在难度和区分度方面部分题目可以达到与专业命题员相似或更高的水平,以实践和合作为基础的命题培训对语言测评素养有提升作用。研究结果为语言测试多项选择题命题技术的学习效果提供了证据,为命题培训提供了参考。

[关键词]多项选择题;命题培训;合作命题;命题员;语言测评素养

[中图分类号]G424.74[文献标识码]A

[文章编号]1673—1654(2023)05—031—010

基金项目国家社科基金重大项目“汉语交际能力标准与测评体系研究”(项目号15ZDB101)以及北京高校高精尖学科建设项目资助。

一、引言

客观题(selected-response items)的编写是一个需要大量指导和技术的创作过程,是一项艺术性和科学性兼具的工作,其中多项选择题(multiple choice item)是最常用的一种,其作答和评分高效、可考查的内容丰富,通常用来测验语言理解能力和语法、词汇等语言知识,便于实现诊断功能[1]。尽管多项选择题具有猜测的弊端,且对于语言测试而言,多项选择题不能直接考查语言表达等交际能力,但高质量的题目依然可以有效测量多方面的认知能力[2]。由于试题质量是影响测试效度的关键因素,对于语言测评工作者和语言教师等相关方而言,命题是语言测评素养的必要成分[3-4],在设计和评价试题上发挥着重要作用。已有研究观察和总结了专业命题人员的工作过程与经验[5-7],但语言测试方面并没有探究非专业人员的命题能力是如何形成的、命题培训是否有效等问题。本研究以一项多项选择题命题培训为案例,通过分析语言学和教育学相关专业研究生在命题培训中不同阶段产出的题目的质量,体现命题技术学习以及合作命题的效果。从命题技术培训效果这一角度,补充现有对语言测试命题工作的研究,从而更深入地理解命题能力的发展。

二、文献综述

(一)命题技术与语言测评素养

命题(item writing)是根据测评目的,编写相应的试题任务来测评某种潜在能力的过程。在测试开发中,命题环节需要在测试规范(test specification)的指导下进行并对题目进行多轮修订以确认其质量[8]。语言测评素养通常被定义为合理设计、评价和使用语言测评活动所需的知识、技能和原则[4,9-10]。在语言测评素养的定义中命题属于“技能”部分[3],它是一项综合性的技术,既包含对基本命题原则的掌握,也需要与测试开发实施的各个环节配合,包含对语言测评目的和构念的理解。在高风险考试情境下,因为考试与备考的需要,命题可能被认为是语言测评素养的主要体现。例如,Zhang & Yan通过分析市级中学英语考试的题目质量来反映教师语言测评素养,发现题目整体难度、区分度和内部一致性较好,一些题目中正确答案设定出现问题,可能由教师语言水平不足和试图编写出有区分度的干扰项两方面原因共同导致[11]。孙海洋、熊洁发现,大学英语教师在参与题库共建项目中,不仅命题质量和能力有较大提高,其对语言测评各方面的理解也有所加强[12]。命题技术与语言测评素养息息相关,一定程度上可以反映语言测评素养水平。因此,命题技术在我国语言测评培训中占有重要地位[13]。

在语言测评素养的发展中,实践是一个重要的中介因素,通过培训课程等方式学到的知识需要通过实践运用才能得到巩固和发展[14]。以语言教师这一群体为例,教师对语言测评培训的需求也更偏向理论在现实中的表现和具体操作[15-16]。命題技术的规则性、操作性较强,在培训中适合与实践结合,以达到更好的学习效果。在此概念下,命题可以作为一个较为独立的技术单元,具体而言,命题可以根据题型、考查技能、测评目的等分为多种类型,目前针对语言测试命题员的研究主要通过访谈等质性方法探索命题工作过程,如新手与专业命题员编写听力测试题的过程差异[5]、命题员合作命题过程中对测试规范的运用、工作组中的合作机制和影响个人命题过程的因素[6],以及训练听力测试命题员编写更加具有真实性的语料[7]等。针对汉语作为第二语言的测试,赵琪凤对来华留学预科汉语考试命题员进行了调查,强调了命题经验及反思对命题能力提升的作用[17]。这些研究主要从命题员自身工作过程反思的角度揭示命题工作经验,为命题员培训和测试编写提供建议。对于新手命题培训中的多项选择题的编写这一问题,目前尚未有研究探讨。

(二)多项选择题命题质量

题目质量是影响测试效度的关键因素,与命题技术密切相关。对于多项选择题的编写原则,学者基于教材、文献等进行归纳,试图全面、准确地定义选择题命题原则,并且进行验证[18]和修订迭代[2,19-22]。在不同学科教育领域,已有一些研究通过对多项选择题进行题目缺陷(item writing flaw)标注和分析,来作为测试效度验证的证据[23-24]或检验命题经验[25]等因素对题目质量的影响。从已有文献对多项选择题命题原则的归纳来看,主要可以从内容的适切性、格式的严整性、表述方式(语法)的规范性、语义表达的清晰性四个方面来理解,涉及题干、选项以及题组的编写。本研究的编码框架在Haladyna整理的31条[19]和Haladyna & Rodriguez的22条[22]选择题命题原则基础上进行改编,使其在对汉语二语水平测试的多项选择题质量分析上具有可操作性,改编的具体内容见研究方法部分。

三、研究设计

(一)研究问题

Taylor指出,为了促进测试信息的正确解读和使用,语言测评素养需要在不同的相关群体中建立起来,不仅包括专业的语言测试工作者,教师、学生以至公众都需要具有相应水平的语言测评素养[9]。本研究旨在通过非专业新手命题员命题技术培训这一案例,收集个人命题和小组合作修订的两次命题数据,探究多项选择题命题原则框架运用于汉语作为第二语言水平测试所反映出的命题质量问题及发展,并通过小规模试测对比新手命题员与专业命题员产出的题目在作答结果上的差异,结合学生的课后访谈,以体现命题技术在提升命题质量和语言测评素养方面的效果。具体研究问题如下:

(1)通过题目缺陷标注,新手命题员的个人命题和小组合作修订后的题目质量分别有怎样的特点?

(2)基于同一篇阅读理解文章,2份新手命题员的命题成果与1份专业命题员的题目在试测结果上有何差异?

(3)在课后访谈中学生认为命题培训的效果有哪些?

(二)研究环境及研究对象

基于一门研究生阶段的语言测评课程,该课程的目的是介绍语言测试专业的基本内容和研究方法,并掌握命题、测试数据分析等实用技术,以辅助研究生进行语言测试、二语习得等相关专业的研究,并为未来潜在的语言教师提供测评素养的基础。在语言测评课程中,对命题技术的培训包括4课时的命题讲解和2课时的讨论,共6课时,占授课总时长的1/4。在命题讲解结束后,学生需要完成命题作业,内容为基于给定的一篇听力语料(关于一次堵车事件的原因及化解)和阅读语料(关于我国医院男护士短缺的现状及原因分析),分别编写4—5个测试汉语二语听力/阅读理解水平的多项选择题,作业完成情况计入学期成绩。完成后学生自行组成5个小组,在小组内对命题作业进行筛选和修订,每个小组整理出一份听力和阅读理解试题,并在课堂上展示和讨论,在课堂建议的基础上进一步修改,形成最终的命题成果。

研究对象为语言测评课程上的27名研究生新手命题员,其年级、专业和相关经验分布如表1。

(三)研究方法

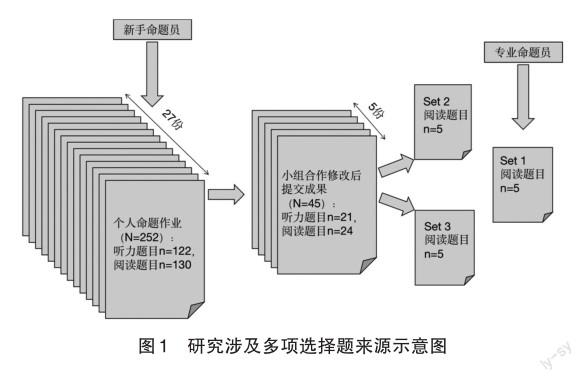

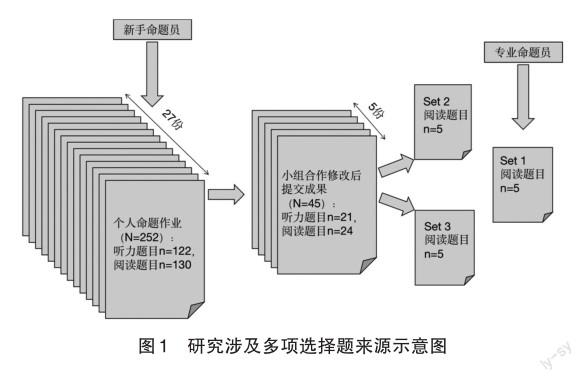

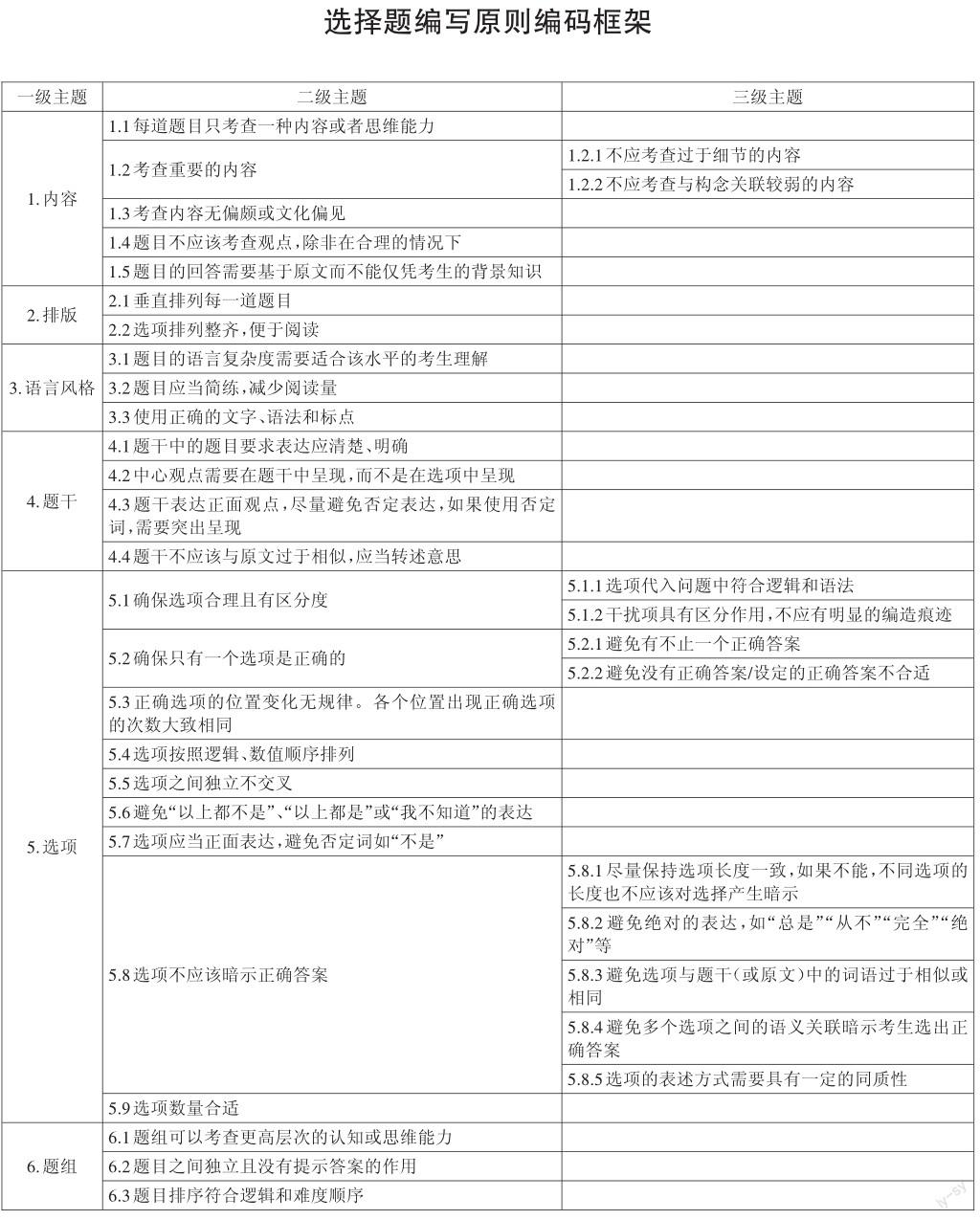

采用混合研究方法。首先对题目质量进行定性分析和编码,统计题目缺陷的数量和频率。题目包含新手命题员个人命题的成果,包括122道听力题和130道阅读题,共252道;新手命题员小组合作和班级讨论后修订的命题成果,包括21道听力题和24道阅读题,共45道(见图1)。试题编码框架的内容保留了Haladyna & Rodriguez的22条选择题命题原则框架的“内容、排版、语言风格、题干、选项”五个主要维度(一级主题),并添加了“题组”这一维度(听力和阅读试题均以题组的方式呈现)。大部分编码为二级主题,其中有四项下细分为三级主题(详细编码框架见附录)。编码框架确定后,2名语言测试方向的博士生分别对所有的听力和阅读试题(共297项)进行了编码,对意见不同的编码进行了讨论,调整后达成一致。为了使数据呈现简明,在分析和讨论时,主要通过一级主题来归纳统计,在频率较高的问题下描述更加细致的问题分类。

量化数据来源为82名中高级汉语二语学习者(基本信息见表2)对三份(5*3道)阅读理解试题的作答情况。三份阅读题目中(Set 1、Set 2、Set 3),Set 1为专业命题员编写,Set 2来源于新手命题员最终命题成果中的1份题目,Set 3来源于新手命题员最终命题成果中的2份题目(为了尽可能使三份题目内容不重叠),用于试测的三份题目在试测前进行了少量局部修改以避免明显的题目缺陷。选出的三份阅读理解试题通过问卷星发放给被试完成,每名被试都完成三份题目,通过随机顺序来抵消题组顺序对难度的影响。共回收有效答卷82份。对于三份试题的质量差异,使用SPSS 26和ITEMAN 3.50软件分别进行均值比较和试题分析(经典测量理论),试题分析包含难度、区分度①、点二列相关系数②以及无效干扰项③的数量。

課程中的9名学生参与了课后访谈,访谈内容包含在整个课程中的收获和对语言测评理解的变化,在访谈过程中没有刻意引导学生说出对命题技术培训部分的看法,对访谈内容进行开放式编码后,分析其中与命题技术有关的理解和收获。

四、结果

(一)个人命题和小组合作命题质量比较

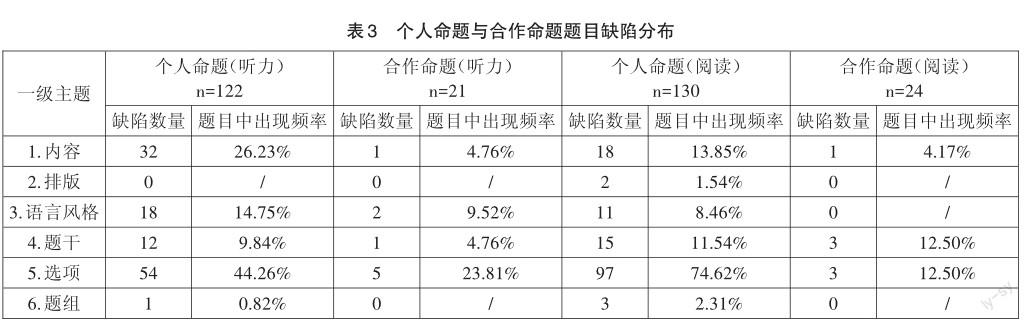

从选择题缺陷在每题平均出现的频率来看,小组合作修订后的命题质量(各题平均缺陷频率为35.56%)明显高于个人命题(各题平均缺陷频率为104.37%)。其中听力题的缺陷出现频率从95.9%降至42.86%,阅读题缺陷出现频率从112.31%降至29.17%。从问题出现的数量来看(见表3),听力和阅读题目都是选项中的缺陷最多,阅读题尤其明显;其次严重的问题是考查内容合适性,这点在听力题目上更为突出。

具体分析个人命题的缺陷特点,从听力题目来看,在选项的编写上,问题常见于选项的合理性、正确选项的设定和选项之间的语义或语法关联产生暗示。出现频率最高的问题是5.1.2(干扰项的区分度不足),共出现18次(14.75%),这一问题与出现频数第二多(13.11%)的1.2.1(考查过于细节的内容)有较大关联,问题出现的原因是有大量听力题考查点在某个细节词语,因此虽然命题员编写的干扰项与正确答案具有同质性,但并没有与原文产生内容关联,干扰项的区分度不高。例如1-2和2-1,有这样问题的题目共出现13次。听力题目中另一个常见的问题是1.2.1考查内容与构念关联较弱(13.11%),即考查的内容不是听力理解能力,而可能是听辨音能力(“十”和“四”),如15-1;或以阅读理解的方式命题,如25-3。此外,听力题目也存在3.1语言过于复杂(7.38%)、3.2表达不够简洁(6.56%)等问题。

1-2.小狗的颜色是:

A.白色B.黑色C.棕色D.黄色

答案:A

2-1.张先生使用的交通工具是什么?

A.电动车B.汽车

C.摩托车D.自行车

答案:D

15-1.这件事发生在昨天什么时候?

A.上午十点半B.下午十点半

C.上午四点半D.下午四点半

答案:A

25-3.“张先生估计这只小狗就是这两天从主人家跑丢的”这句话是什么意思?

A.张先生推测小狗是最近跑丢的

B.张先生知道这只小狗是谁的

C.张先生想起曾见过这只小狗

D.张先生看到过这只小狗的主人

答案:A

阅读题目的缺陷更加集中于选项编写方面,74.62%的题目有选项方面的问题,其中出现最多的单项问题包括5.2.1正确答案不唯一(20.77%)和5.2.2正确答案不合适(15.38%),这与阅读理解语料的信息量更丰富和具有层次性有关。如题目6-2,ABC三个选项都可以作为正确答案。题目13-2列举数字是为了突出我国男护士比例低的情况,而题目中设定的正确选项没有明确这一点,因此正确答案不合适。与听力题目问题相似,5.1.2干扰项区分度不足的问题在阅读题目中也较多(11.54%)。

6-2.女护士照顾男病员时,女护士会感到()

A.很尴尬B.难为情

(二)阅读理解试题作答情况比较

C.不方便D.很痛苦

答案:C

13-2.第四段的数字是为了说明?

A.护士的数量多B.男护士供不应求

C.美国、芬兰经济发达D.医院很多

答案:B

从小组合作修订后的问题来看(见表3),出现问题的总频率降低,阅读和听力题目仍然存在题干和选项的问题,阅读题题干出现问题更多(12.5%),如1-4题干没有实际意义。这道题同时也存在考查内容不是单一维度(1.1)的问题。听力题选项出现问题更多(23.81%),如3-1,该题A选项代入问题后逻辑上合理性不强,且各选项结构可能产生暗示。由此可见,小组合作产出的题目质量有明显提高,这源于删除了原来质量较差的题目,并对“潜力”较高的题目进行修改。不过在两轮修订后,依然存在一些没有发现或解决的问题,说明仅一轮合作修订还不足以保证题目质量。

1-4.下列哪种说法是正确的?

A.男护士有职业优越感。

B.作者支持中国的传统观念。

C.报考护理学校的学生很多。

D.男人觉得当护士很羞愧。

答案:D

3-1.十几辆汽车为什么一起刹车?

A.张先生骑自行车B.发生了事故

C.发生了堵车D.主路上有狗

答案:D

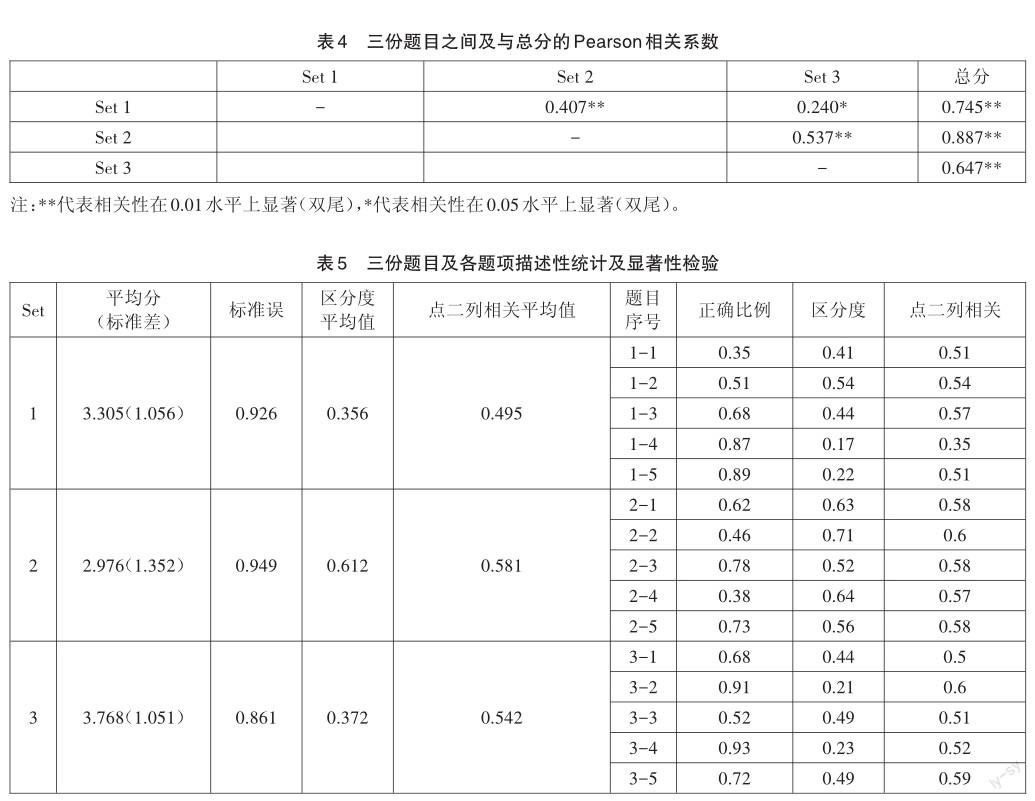

基于同一篇语料的三份阅读题试测结果显示,15道题的内部一致性信度(Cronbachsα)为0.657,其中第1题(Set 1)和第13题(Set 3)得分与整体分数一致性最低,去掉兩题后Cronbachsα系数达到0.704,其他题项均与总分相关性较高。Set 2的内部一致性(0.507)高于Set 1(0.231)和Set 3(0.329),且与总分的相关性最高(见表4)。

表5列出了三份题目及各题项的正确率、区分度和题组内部的点二列相关系数。比较三份题目的平均分,方差分析结果为F(2,80)=9.52,p=0.00,LSD方法事后比较发现,Set 3的难度显著低于Set 2和Set 1。具体看每道题的难度,Set 2的难度系数在0.38-0.78,较为适中;Set 1难度系数介于0.35-0.89,跨度较大;Set 3难度系数介于0.52-0.93,较为容易。

Kruscall-Wallis检验三份试题在点二列相关系数上没有显著差异,Kruscall-Wallis H = 5.055,df =2,sig = 0.08;区分度有显著差异,Kruscall-Wallis H = 8.716,df =2,sig = 0.013,Set 2区分度系数显著高于Set 3和Set 1,每道题的区分度均在0.5以上。说明Set 2的区分效果较好。

从选项来看,干扰项选择率超过正确选项的情况Set 1和Set 2分别有1个;无效干扰项(选择率低于0.05)的数量,Set 1为5个,Set 2为4个,Set 3为7个。干扰项的作用上,每份题目均有一定问题,侧面反映了Set 3难度显著低于另外两份题目的结果。

(三)访谈结果分析

在谈到语言测评课程中的收获时,命题技术部分是提及次数最多的一个主题(占编码总数的39.02%)。其原因主要有以下方面:(1)对于计划进行二语习得研究和从事教学工作的学生来说,命题技术具有很强的实用性;(2)命题单元讲练结合,在实际操作中可以更加深入地理解命题原则如何操作;(3)比起理论知识,命题技术的培训更加易懂,学习过程参与度、兴趣度高。经过语言测评课程的学习,学生对语言测评理解的变化中与命题技术有关的内容(占编码总数29.17%)主要包含:(1)意识到命题工作的复杂性,从命题者的角度批判地看待题目;(2)意识到命题工作中团队合作的重要性,命题是一项融合多种考量、多人贡献的工作;(3)意识到母语者在为二语学习者编写题目时需要转变视角,具备相应的二语习得知识。

五、讨论

(一)多项选择题编写的困难

通过分析多项选择题命题缺陷及试测结果,可以总结出新手命题员选择题命题的困难主要体现在选项、内容、语言风格和题干方面,在排版和题组设置上问题较少,这一结果与赵琪凤对命题员的调查具有一致性[17]。具体来看,选项编写中出现问题最多的是确保选项合理性和区分度,确保只有一个正确选项,以及避免选项之间的语义或语法关联暗示。在内容方面的主要问题是考查点过于细节和考查内容非构念。多项选择题本身在考查语言能力方面具有局限性,如果考查点过于细节,将进一步削弱选择题对思维能力的考查,且容易导致没有区分作用的干扰项。考查内容非构念这一问题可能由与新手命题员相关的两个原因造成。首先,新手命题员对测试规范的熟悉程度不够高,命题时对语境、构念的关注意识较弱,因此出现将听力题出成阅读题的情况。其次,新手命题员作为汉语母语者,有时从自身已有的测试经验出发,对考查内容进行臆测,而不是对照汉语二语所需的知识和能力进行考查。例如考查听辨音能力,或关联词的替换,这些考查点可能来源于汉语母语者的语文考试。在语言风格方面,表现为题目语言过于复杂,需要增进对汉语二语能力标准和大纲的了解程度。在题干方面,阅读题目中出现不聚焦问题的题干,体现出命题中确定“提问角度、方式和内容”方面的困难[17]。

以上聽力和阅读理解题目的问题分布与已有对于选择题命题质量问题分析的研究对比,相似之处在于选项方面“干扰项不合理”“正确答案设定”的问题较多[23-25],但从常见问题来看有所差异。在Tarrant等对香港护理测试多项选择题的分析[23],以及Costello、 Holland、Kirwan对(包含计算机、社会科学和医学)30门慕课的202项选择题命题缺陷分析中[24],最严重的问题在于表达方面,包括绝对的表达、否定表达、信息模糊和不聚焦的题干等,这在本研究中体现不突出,可能是因为本研究命题员使用母语编写二语测试时不会面临语言水平和表达准确性的问题,但可能会因为不够理解二语的学习和使用而引发其他问题。Pham等对医学生和专业医生的命题质量标注与本研究的分布情况大致相似,问题频率由高到低依次是选项、题干、内容、风格和形式[25]。

(二)多项选择题命题培训的效果

本研究主要通过对比新手命题员经过命题指导学习后的个人命题和小组合作修订的命题成果,以及对比新手命题员形成的两份阅读题和专业命题员命题的试测难度和区分度,来体现命题技术学习对命题能力发展的作用。首先,虽然在完成命题作业前学生已经了解了命题需要遵循的一般原则并了解了语言水平测试的目的和规范,而且也确保了学生参与的投入度,但个人命题中仍然出现较多问题,平均每个题目有1.04个错误。小组合作修订命题质量的大幅度改善得益于合作和讨论中集中的多人智慧,这与专业命题工作的特点一致[6,8]。第二,从难度、区分度和无效干扰项数量的对比来看,新手命题员完成的两份题目中,一份的质量高于专业命题员,另一份过于简单、无效干扰项较多。值得注意的是,由于采取被试内设计,为使题目内容尽可能不重复,Set 3是由2份合作命题重组而来的,这一操作可能降低了原题组的质量(影响了考查点分布的合理性)。结果说明,经过短期的命题技术培训和合作修改,新手命题员可以产出质量较好的题目,有些甚至好于专业命题员,合作对于命题质量的提升有重要作用。

(三)多项选择题命题实践与语言测评素养的提升

通过访谈发现,在整个语言测评课程中,命题技术是多数学生反映有实际帮助的一部分,这与其较强的实践性是分不开的,这一结果与已有研究中教师对于语言测评培训的实践需求一致[14-16]。同时,学生在进行命题实践时不仅需要一般性的命题原则指导,也需要对语言能力和语言测评的构念有准确的理解,在选择题质量上主要体现在内容部分,个人命题中考查内容过于细节或与构念无关的问题,经过小组合作和讨论后,比例明显下降。另外,访谈发现命题技术提高的效果不仅限于语言测试领域,对二语习得研究(如实验材料的编制)以及调查问卷的设计方面也有所帮助,体现了语言测评素养并不孤立于专业领域内,而是融通于语言教学与研究中的,这一结果正面回应了Taylor对语言测评专业知识与其他学科及非专业群体的距离过远、不利于社会各方语言测评素养发展的担忧[9]。此外,在具体操作过程中,对原则的灵活运用、小组讨论中互相学习等能力都是内化在实践过程中的,是实践能力提高的一种体现。因此,命题技术的培训有助于语言测评素养的整体提高,有助于降低畏难心理并激发深入学习相关内容的兴趣。

六、结语

对题目质量的定性、定量分析以及访谈中发现,以实践和合作为基础的命题培训可以达到较好的效果,并提升了新手命题员的语言测评素养,为语言测试多项选择题命题培训提供了一定实证依据。因此,建议语言测评培训课程可以采取实践导向的方法,适当结合理论指导和实际操作,以使培训获得更高的效率和接受度。此外,改编的多项选择题命题原则的编码框架为命题质量分析提供了参考。本案例研究在数据代表性和准确性方面存在一定局限,由于所有的听力和阅读题目都基于一篇听力和一篇阅读语料,在试测中题项数量较少;此外,三份题目基于同一篇文章,一定程度上降低了作答难度和干扰项的选择率,影响了试测结果解读的准确性。今后的命题研究可以收集更大范围的数据,对语言测验试题编写的过程特点进行刻画。另外,Pham等认为将学生命题成果纳入题库建设中有一定价值[25],将语言测试命题作为相关专业学生的实践机会并实现试题资源的可持续发展,可以作为进一步研究的方向。

参考文献:

[1] Rodriguez M C. Selected-response Item Development [C] // Lane S,Raymond M R,Haladyna T M.Handbook of Test Development(Second Edition). Routledge,2016:259-273.

[2] Haladyna T M. Developing and Validating Multiple-Choice Test Items [M]. Routledge,2004.

[3] Davies A.Textbook Trends in Teaching Language Testing [J]. Language Testing,2008,25(3):327-347.

[4] Fulcher G.Assessment Literacy for the Language Classroom [J]. Language Assessment Quarterly,2012,9(2):113-132.

[5] Salisbury K.The Edge of Expertise:Towards an Understanding of Listening Test Item Writing as Professional Practice [D]. Kings College London,2005.

[6] Kim J,Chi Y,Huensch A,et al. A Case Study on an Item Writing Process:Use of Test Specifications,Nature of Group Dynamics,and Individual Item Writers Characteristics [J]. Language Assessment Quarterly,2010,7(2):160-174.

[7] Rossi O,Brunfaut T.Text Authenticity in Listening Assessment:Can Item Writers Be Trained to Produce Authentic-Sounding Texts?[J].Language Assessment Quarterly,2021,18(4):398–418.

[8] Spaan M. Evolution of a Test Item [J]. Language Assessment Quarterly,2007,4(3):279-293.

[9] Taylor L.Developing Assessment Literacy [J].Annual Review of Applied Linguistics,2009,29:21-36.

[10]Inbar-LourieO. ConstructingaLanguageAssessment Knowledge Base:A Focus on Language Assessment Courses [J]. Language Testing,2008,25(3):385-402.

[11] Zhang C,Yan X. Assessment Literacy of Secondary EFL Teachers:Evidence from a Regional EFL Test [J].Chinese Journal of Applied Linguistics,2018,41(01):25-46+120.

[12]孙海洋,熊洁.命题对提升大学英语教师测评素养的作用:基于UNICOMM题库共建项目的质性研究[J].西安外国语大学学报,2020,28(02):75-80.

[13] Jin Y.The Place of Language Testing and Assessment in the Professional Preparation of Foreign Language Teachers in China [J]. Language Testing,2010,27(4):555–584.

[14] Xu Y,Brown G.Teacher Assessment Literacy in Practice:A Reconceptualization [J]. Teaching and Teacher Education,2016,58:149-162.

[15] Malone M E.The Essentials of Assessment Literacy:Contrasts between Testers and Users [J].Language Testing,2013,30(03):329-344.

[16] Yan X,Zhang C,Fan J J.“Assessment knowledge is important,but…”:How Contextual and Experiential Factors Mediate Assessment Practice and Training Needs of Language Teachers[J]. System,2018,74:158-168.

[17]赵琪凤.来华留学预科汉语考试命题调查研究[J].语言教学与研究,2021,(02):35-44.

[18] Rodriguez M C.The Art & Science of Item Writing:A Metaanalysis of Multiple-choice Item Format Effects [C] // Annual Meeting of The American Educational Research Association,Chicago,IL,1997.

[19] Haladyna T M,Downing S M,Rodriguez M C.A Review of Multiple-Choice Item-Writing Guidelines for Classroom Assessment [J]. Applied Measurement in Education,2002,15(3):309-333.

[20] Frey B B,Petersen S,Edwards L,et al.Item-Writing Rules:Collective Wisdom [J].Teaching and Teacher Education,2005,21(4):357-364.

[21]王佶旻.漢语测试中多项选择题的命题技术探究[J].中国考试,2012,(05):39-44.

[22] Haladyna T M,Rodriguez M C. Developing and Validating Test Items(1sted.)[M]. Routledge,2013.

[23] Tarrant M,Knierim A,Hayes S K,et al.The Frequency of Item Writing Flaws in Multiple-Choice Questions Used in High Stakes Nursing Assessments [J]. Nurse Education in Practice,2006,6(6):354-363.

[24] Costello E,Holland J,Kirwan C.The Future of Online Testing and Assessment:Question Quality in MOOCs [J].International Journal of Educational Technology in Higher Education,2018,15(42).

[25] Pham H,Court-Kowalski S,Chan H,et al.Writing Multiple Choice Questions—Has the Student Become the Master? [J].Teaching and Learning in Medicine,2022:1-12.

Investigating the Development of Multiple-choice Item Writing Skills:A Case Study of an Item-Writing Training Program

Wang Xiaozhu Wang Jimin

Beijing Language and Culture University,Beijing,100083

Abstract:This case study,set in a Chinese as a second language(CSL)teaching environment,examines an item-writing training session focusing on multiple-choice items in a language assessment course for graduate students majoring in applied linguistics or educational evaluation.In the item-writing training process,the 27 participants took lectures on item-writing principles before they generated items of reading and listening comprehension individually with the purpose of measuring CSL proficiency,and then revised and refined them collaboratively in groups. The items were evaluated based on the principles of multiple - choice item writing adapted from Haladyna and Rodriguez(2013)to analyze the quality of items before and after collaborative revision.3 sets of reading comprehension items,two written collaboratively by the novice item writers and one by professional item writers,were piloted on 82 L2 Chinese learners to compare the quality of items in terms of item difficulty,discrimination,and non-functional distractors. Additionally,nine participants were interviewed about their experience and conception of language assessment in the course.The study found an obvious improvement in the quality of items revised collaboratively compared to those generated individually after lecture,with the mean number of item writing flaws dropping from 1.04 to 0.36 per item.Moreover,one of the two sets of items written collaboratively by novice item writers exhibited higher quality compared to the set written by professional item writers because of moderate difficulty and higher discrimination.The interviews revealed that item-writing training was evaluated positively in the language assessment course as it was practice-based and useful in future careers,raising the level of language assessment literacy in various aspects.In short,the evidence was supportive of the effectiveness of the item-writing training program.

Key words:Multiple-choice Items,Item-Writing Training,Collaborated Item Writing,Item Writer,Language Assessment Literacy

附錄

(责任编辑:吴茳)

①区分度计算方法为高分组(得分最高的27%)被试在该题上的通过率减去低分组(得分最低的27%)被试在该题上的通过率。

②点二列相关系数的计算方法为每个题项与该份题目(题组内部)得分的Pearson相关系数。

③选择率低于0.05的干扰项,根据Pham et al.(2022)。