沙尘图像色彩恢复及增强卷积神经网络

石争浩,刘春月,任文琦,都双丽,赵明华

1.西安理工大学计算机科学与工程学院,西安 710048;2.中山大学网络空间安全学院,深圳 518107

0 引 言

在沙尘天气条件下,由于大气中悬浮沙尘微粒对入射光线的散射和吸收作用,户外计算机视觉系统所采集图像产生严重退化和降质,如图像颜色偏黄失真、对比度低,细节模糊等(图1(a)),严重影响户外计算机视觉系统在目标识别、视频监控、视频导航和智能交通应用中的工作性能。因此,沙尘图像的增强研究引起了人们的广泛关注,并提出了很多针对沙尘图像增强的解决方法,包括使用直方图均衡化及其变体来拉伸图像的对比度(Wang等,2016),使用基于Retinex的方法来增强图像的对比度和亮度(Gao等,2015),或者将沙尘增强问题作为一个去雾问题来处理(He等,2008)。虽然上述工作对沙尘图像的增强处理都取得了不同程度的效果,但输出图像依然存在颜色偏差、图像亮度和图像对比度不足等问题。

图1 在沙尘天气中捕获的图像及其对应的增强图像

沙尘图像和雾霾图像都是由于空气中的尘霾粒子对光的散射和反射作用导致的低质量图像。不同于雾霾图像,沙尘图像的颜色偏黄失真,主要原因是大气中的介质对光大量反射和散射。其次,沙尘微粒吸收部分蓝光,使传播的光颜色单一,导致沙尘图像颜色偏黄。因此不能直接使用去雾算法对沙尘图像进行处理。沙尘图像的增强不仅要考虑对清晰度和对比度的增强,同时还要考虑图像颜色的校正。对于失真严重、偏色程度较大的沙尘图像,由于细节信息严重缺失,导致处理后的图像细节丢失,颜色也有不同程度的失真。

基于以上所述,本文提出一种带色彩恢复的沙尘图像卷积神经网络增强方法。采用色彩恢复模块对沙尘图像进行色彩恢复,将色彩恢复后的图像作为条件输入到去尘增强模块中,在去除沙尘的同时解决沙尘带来的细节模糊和内容缺失问题,而且使恢复图像的颜色更加自然。大量实验表明,该方法既可以校正给定沙尘图像的色偏,又可以得到细节清晰的无沙尘图像,能够取得比现有方法较好的增强效果。图1(b)给出了本文方法的沙尘图像增强结果。

本文主要贡献包括:1)提出一种端到端的基于卷积神经网络的沙尘图像色彩恢复与增强模型;2)提出一种恢复沙尘图像色彩的网络结构;3)提出一种沙尘图像的去尘增强卷积结构;4)提出一种基于物理光学成像模型的沙尘图像生成方法,并制备了大规模的合成沙尘图像数据集。

1 相关工作

沙尘图像增强的主要任务是消除沙尘对图像质量的影响,提高图像的清晰度,主要涉及图像色彩的恢复校正和沙尘图像清晰度增强两方面工作。

1.1 沙尘图像颜色恢复校正方法

目前,最常用的图像颜色校正技术是白平衡方法,其中包括基于RGB颜色空间(Wang等,2016)的灰度世界算法和基于YUV颜色空间(周荣政 等,2005)的白色补丁算法。这两种方法可以在一定程度上恢复图像颜色,但是仍然存在颜色偏差。为了解决这一问题,Rizzi等人(2002)提出基于灰度世界和白色补丁的组合方法来校正图像颜色。Kwon和Kim(2012)提出一种基于Retinex的图像颜色校正方法。Liu等人(2017)提出了一种基于颜色转移的颜色校正方法,该方法可以转移与沙尘图像具有最高相似度的清晰图像的颜色,从而获得正常的彩色图像。上述方法虽然能恢复沙尘图像的整体颜色,但是对于失真严重、偏色程度较大的图像处理后依然会有颜色失真的情况。

1.2 沙尘图像清晰度增强方法

沙尘图像清晰度增强方法可以分为两大类:基于视觉感知的增强方法和基于物理光学模型的图像复原方法(Huang等,2014)。其中,基于视觉感知的增强方法不考虑图像的退化机理,通常采用现有的图像处理技术如直方图均衡化(智宁 等,2016)、拉普拉斯滤波器(Wang等,2016)和Retinex视网膜增强(Gao等,2015)等算法,直接对退化图像的像素和邻域进行处理,以增强图像的对比度和校正图像的颜色。

与基于视觉感知的增强方法不同,基于物理光学模型的复原方法考虑图像的退化机理,并根据图像退化的光学模型,反演退化过程获得清晰图像画面,如Tan(2008)通过最大优化局部区域增加对比度进行图像去雾,该方法能够增加图像对比度、改善图像的能见度,但会出现图像过饱和的现象。He等人(2009)提出了一种基于暗信道先验的去雾方法。Shi等人(2019)提出了一种基于光晕还原暗通道先验去雾的沙尘图像增强方法。Zhu等人(2015)提出了一种基于颜色衰减先验的去雾方法,该方法对于轻度雾霾图像能够得到很好的结果,但是对于重度雾霾图像的效果不佳。Yu等人(2016)提出了一种基于大气散射模型和信息损失约束的沙尘退化图像恢复方法,该方法有效地改善了沙尘图像的对比度,但是不能完全消除光晕。Fu等人(2014)提出了一种基于融合的单幅沙尘图像增强方法。

近年来,随着深度学习(如卷积神经网络和生成对抗神经网络(generative adversarial network, GAN))技术蓬勃兴起,及其在图像分类、图像识别等领域的广泛应用及突出表现,深度学习在退化图像增强方面的应用也引起人们的广泛关注。如Ren等人(2016)提出一种基于卷积神经网络(convolutional neural network, CNN)的去雾方法。Cai等人(2016)提出先利用深度网络估计透射图,然后使用大气散射模型恢复无雾图像。Li等人(2017)提出一种重新构造大气散射模型的图像去雾方法。Zhang和Tao(2020)提出一种多尺度端到端图像去雾模型。即使这些方法都估计了中间特征图,但它们仍属于基于大气散射模型的方法,并且在沙尘图像上进行测试时,往往会导致严重的颜色失真。Yang等人(2018)提出一种用于图像去雾的端到端生成模型。Zhang和Patel(2018)提出一种用于图像去雾的完全可训练的双生成器方法。Engin等人(2018)利用未配对条件GAN的鲁棒性恢复无雾图像。Dudhane等人(2019)提出了一种去除浓雾的端到端的可训练残差初始GAN。Guo等人(2019)提出一种联合估计场景传输图和大气光的深度去雾网络。

相比于各种传统沙尘图像增强方法,基于深度学习的方法直接利用卷积神经网络学习沙尘退化图像与透射图或者清晰图像之间的映射关系,解决了手工设计特征的困难,在色彩校正和雾化清晰这两个方面都分别取得了优于传统方法的结果。但现有方法多数是针对雾霾图像的增强问题提出的,专门针对沙尘图像的工作比较少,因此直接应用于沙尘图像的增强处理时,输出图像色彩依然存在不同程度的失真,图像的清晰度也存在不足。

与上述现有方法不同,考虑沙尘图像的退化机理,本文提出一种带有色彩恢复的沙尘图像卷积神经网络增强方法,既能较好恢复校正输入图像的色彩,又能得到细节清晰的无尘图像。

2 本文方法

本文提出一种带色彩恢复的沙尘图像卷积神经网络增强方法,总体结构如图2所示,由沙尘图像色彩恢复子网(sand dust color correction, SDCC)和沙尘图像去尘增强子网两部分组成。其中,沙尘图像色彩恢复子网用于校正沙尘图像的颜色,去尘增强子网用于去除沙尘图像中的沙尘,可以实现从沙尘图像到无沙尘清晰图像的恢复。

图2 网络模型结构

2.1 沙尘图像色彩恢复子网

在沙尘天气中拍摄的图像不仅图像细节模糊不清,而且存在严重颜色失真,主要表现为图像严重偏黄。现有方法多采用灰度世界算法(Reinhard等,2001)来恢复沙尘图像的颜色,灰度世界算法可以简单快速地处理图像,但是当图像场景颜色并不丰富时,该算法常会失效。本文针对灰度世界算法的缺点,提出一种新颖的沙尘图像色彩恢复网络结构,如图3(图中,⊕表示相加运算,⊗表示相乘运算)。首先,将输入的沙尘图像I分解为R、G、B这3个通道,对每一个通道,采用卷积核大小为3的卷积层进行处理,获得伪彩色映射IP,即

图3 SDCC的结构图

(1)

式中,f3×3表示滤波器大小为3×3的卷积运算,i表示用于每个颜色通道的卷积滤波器数,i∈{1,2,…,32}。

此外,对每个伪彩色映射IP进行伪颜色校正,获得增强后的伪彩色特征映射Jp,即

(2)

(3)

(4)

对于增强后的伪彩色特征映射Jp,首先将其还原为R、G、B特征映射,然后通过一个卷积层将其转换为R、G、B颜色通道。最后,将其拼接为RGB图像。

将颜色校正后的RGB图像通过跳跃连接送入沙尘图像去尘增强网络。

2.2 沙尘图像去尘增强子网

本文设计了一个带有自适应实例归一化残差块(adaptive instance normalized residual blocks, AIN-ResBlock)的编码器解码器结构作为沙尘图像去尘增强子网的网络结构(如图2)。该网络以沙尘图像和SDCC子网得到的颜色校正图像作为输入,使用自适应实例归一化模块(adaptive instance normalized blocks, AIN)自适应地恢复去尘增强子网中特征映射存在的颜色失真问题,并通过残差块实现图像沙尘的去除。使用AIN-ResBlock,不仅使去尘增强子网解决沙尘带来的细节模糊和内容缺失问题,而且使恢复图像的颜色更加自然。

为了将SDCC子网得到的颜色校正结果很好地融入到去尘增强子网中,本文采用了自适应实例归一化模块,如图4(a)所示。通过计算去尘增强子网的特征映射h的均值和标准差对其进行归一化处理,其均值和标准差的计算式为

(5)

(6)

式中,H′和W′分别为特征映射h的高和宽,ε=10-5。

将SDCC颜色校正后的彩色图像进行卷积操作得到仿射变换参数γ*和β*。将去尘增强子网归一化后的特征映射进行仿射变换。由于AIN模块是逐像素操作,因此,仿射变换参数γ*和β*将逐像素的对整个网络的特征点进行颜色校正。AIN模块的计算式为

(7)

式中,μc和σc分别表示通道c中h的均值和标准差。

本文将具有颜色校正功能的AIN模块加入到残差块中以得到更好的去沙尘结果,图4(b)为加入AIN模块的AIN-ResBlock。

图4 沙尘图像去尘增强子网

2.3 损失函数

本文在训练网络时采用的损失函数由L1损失函数、感知损失函数和梯度损失函数组成。

2.3.1L1损失

为了让生成的图像更加真实,本文在色彩恢复子网和去尘增强子网中采用了L1损失,即

(8)

式中,Y代表输入的清晰图像,x表示输入的沙尘图像,f(x)代表处理后的图像,h(x)表示色彩恢复后的结果图。式(8)中的两个损失函数项是不分先后顺序的,因为它们都会融合到最终的总损失函数(式(12))中一起进行反向传播。在整个网络结构中,色彩恢复子网的输出为去尘增强子网的输入,因此,在网络执行反向传播时,式(8)中的h(x)项只对色彩恢复子网起作用。

2.3.2 感知损失

为了尽量减少沙尘图像增强网络结果的感知特征与真实图像的感知特征之间的差异,本文引入了预训练的VGG16(Visual Geometry Group 16-layer network)网络的感知损失,即

(9)

式中,φi(f(x)),φi(h(x))和φi(Y)分别表示f(x),h(x)和Y对应的特征图,Ci、Hi和Wi分别表示特征图的通道数、高度和宽度。

2.3.3 梯度损失

为了更好地恢复图像的细节和结构,本文在网络中采用水平方向和垂直方向的梯度损失函数。

Lv和Lh分别表示水平方向的梯度损失和垂直方向的梯度损失,定义为

(10)

(11)

式中,下标v和h分别表示水平方向和垂直方向的梯度值。

2.3.4 总损失函数

因此,网络模型的总损失函数可以表示为

Losstotal=LossL1+λLossVGG+Lv+Lh

(12)

式中,λ表示损失函数的调整参数。

3 实验结果及分析

3.1 沙尘图像数据集的构建

由于很难获得配对的真实沙尘图像数据集,因此,本文收集了COCO(common objects in context)数据集中的10 500幅图像作为配对沙尘图像的基准数据,并对其进行处理,得到合成的沙尘图像。

由于沙尘图像的光学特性与雾霾图像相似(Fu等,2014),因此采用大家普遍使用的雾霾图像成像模型(式13))来描述沙尘图像和无沙尘图像的形成过程,遵循式(13)给出的大气散射模型合成沙尘图像和各自的清晰图像,即

I(x)=J(x)t(x)+A(1-t(x))

(13)

式中,x是像素位置,J(x)是真实的清晰图像,I(x)是沙尘图像,t(x)=e-βd(x)表示场景透射图,其中β为衰减系数,d(x)是场景深度图,而A代表大气光。

为了合成沙尘图像,有关场景深度图的信息是必不可少的,因此本文采用基于深度学习的深度估计算法DORN(deep ordinal regression network)(Fu等,2018)估计真实图像的场景深度d(x)。

在式(13)中,第1项表示可见度的直接衰减,而第2项表示雾的浓度和偏色的影响。因此,通过改变大气光A,可以合成不同颜色的沙尘图像。当A=(0.8,0.8,0.8)时,可以得到色彩平衡的雾霾图像,由于沙尘图像具有黄色色调,本文根据RGB颜色对照表,通过大量实验,选择了15种接近沙尘图像颜色的色号(如表1所示),并将这15种色号对应的RGB值作为大气光散射模型的大气光A,从而生成15种不同类型的沙尘图像。本文使用衰减系数β控制雾的浓度,其中β∈(0.5,1.5)。最后,根据式(13)来合成沙尘图像I(x)。

表1 沙尘图像颜色的色号对应的RGB值

通过15种不同的色号模拟沙尘图像,使得本文提出的网络模型可以应对不同的真实沙尘天气,提高模型的性能。图5为根据15种色号生成的15种不同颜色条件下的沙尘图像。但是在合成沙尘图像上训练的网络处理真实沙尘图像时,性能会有不同程度的下降。其主要原因是训练数据不能涵盖各种真实的沙尘图像场景。考虑弱监督学习不需要配对的训练数据即可直接从真实数据中学习训练样本和目标数据间的潜在映射关系,拟在后续研究中,将弱监督学习和强监督卷积神经网络相结合,通过弱监督学习,将真实沙尘图像引入训练数据中,从而提高模型对真实沙尘图像的增强能力。

图5 合成的沙尘图像

3.2 训练细节

在训练时,本文从生成的10 500幅图像中,选择10 000幅作为训练集,500幅作为测试集。训练图像的大小为256×256×3。使用Adam作为优化算法,并且将学习率设为2×10-4。β1和β2分别为0.9和0.999。本文将网络训练了50次迭代,并且每隔10个迭代将学习率缩小为原来的一半。损失函数的参数λ=0.5。实验代码采用Pytorch和Nvidia RTX 2070 GPU实现。最后,采用真实沙尘图像来验证模型的有效性。

3.3 实验结果

3.3.1 合成沙尘图像数据集的结果

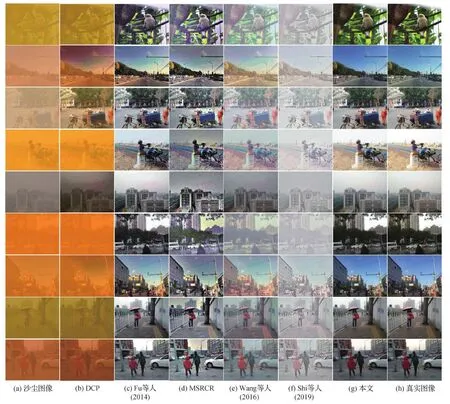

为了验证所提方法的有效性,本文将其与传统沙尘图像增强方法和基于深度学习的方法进行比较。图6显示了本文方法和传统沙尘图像增强方法在合成沙尘图像测试数据集上的比较结果。对比方法为DCP(dark channel prior)(He等,2009),Fu等人(2014)方法,MSRCR(multi-scale retinex with color restoration)(Jobson等,1997),Wang等人(2016)方法,Shi等人(2019)方法。图7显示了本文方法和基于深度学习的方法在合成沙尘图像测试数据集上的比较结果。对比方法为MSCNN(multi-scale convolutional neural network)(Ren等,2016),AOD-Net(all-in-one dehazing network)(Li等,2017),GCA-Net(gated context aggregation network)(Chen等,2019),EPDN(enhanced pixzpix dehazing network)(Qu等,2019)。

图6 本文方法与传统的沙尘图像增强方法在合成的测试图像上的比较

为了定量分析去沙尘结果,表2显示了本文方法和上述各种方法在合成沙尘图像数据集上的平均峰值信噪比(peak signal to noise ratio, PSNR)和平均结构相似性(structural similarity index, SSIM)的比较。可以看出,本文方法得到了最大的PSNR和最大的SSIM。

3.3.2 真实沙尘图像实验结果

为了证明使用合成图像训练的模型可以很好地扩展到真实世界的沙尘图像,本文还评估了真实世界沙尘图像的结果。图8显示了本文方法与传统沙尘图像增强方法的比较结果。对比方法为DCP(He等,2009),Fu等人(2014)方法,MSRCR(Jobson等,1997),Wang等人(2016)方法,Shi等人(2019)方法。可以观察到,DCP不能去除沙尘并且仍然存在颜色失真;Fu等人(2014)方法可以恢复输入沙尘图像的颜色,但是图像的天空区域存在光晕;MSRCR可以将沙尘图像的整体黄色去除,但是图像中人和物体的颜色较暗,导致视觉效果较差;Wang等人(2016)方法可以很好地恢复输入沙尘图像的颜色,但是会出现明显的光晕伪影;Shi等人(2019)方法可以很好地恢复输入沙尘图像的颜色,但是,恢复的图像存在过度曝光的问题。与以上几种传统的沙尘图像恢复方法相比,本文方法没有光环伪影,不仅可以还原真实沙尘图像的颜色,而且还能还原图像的纹理和细节。

图8 本文方法与传统的沙尘图像增强方法在真实图像上的比较

图9显示了本文方法与基于深度学习的方法的比较结果。对比方法为MSCNN(Ren等,2016),AOD-Net(Li等,2017),GCA-Net(Chen等,2019),EPDN(Qu等,2019)。可以观察到,MSCNN、AOD-Net、GCA-Net和EPDN等方法都可以对输入沙尘图像中的沙尘进行一定的去除,但是不能很好地恢复沙尘图像的颜色偏差。与以上几种基于深度学习的方法相比,本文方法可以很好地恢复沙尘图像的颜色,并且在图像去沙尘方面表现得很好。

图9 本文方法与基于深度学习的方法在真实图像上的比较

表3 不同方法在真实世界图像上的定量比较

比较训练网络对合成沙尘图像处理结果(如图7)与对真实沙尘图像处理结果(如图8)可以发现,训练网络对合成沙尘图像的增强结果明显好于对真实沙尘图像的增强结果,说明使用在合成沙尘图像上训练的网络处理真实沙尘图像时,性能会有不同程度的下降。其主要原因是训练数据不能涵盖各种真实的沙尘图像场景。考虑弱监督学习不需要配对的训练数据即可直接从真实数据中学习训练样本和目标数据间的潜在映射关系,拟在后续研究中,将弱监督学习和强监督卷积神经网络相结合,通过弱监督学习,将真实沙尘图像引入训练数据中,从而提高模型对真实沙尘图像的增强能力。

为了验证本文提出的色彩恢复子网的有效性,本文将色彩恢复子网(SDCC)的颜色校正结果与现有常用的颜色校正方法进行对比,实验结果如图10所示。对比方法为使用灰度世界算法(Reinhard等,2001),伽马矫正算法(Xu等,2009),限制对比自适应均衡化算法(limit contract adaptive histogram equalization, CLAHE)(Pizer等,1990)。可以观察到灰度世界算法可以整体恢复沙尘图像的颜色,但是对于天空区域,存在黄色色块;伽马矫正算法只能将沙尘图像的偏色减少,并不能完全去除。CLAHE不能完全恢复沙尘图像的黄色,并且恢复的图像天空区域存在光晕。与以上几种算法相比,本文所提SDCC恢复的沙尘图像的颜色更加自然,并且天空等区域也不存在光晕和偏色。

图10 本文所提 SDCC与常用颜色校正方法在真实图像上的比较

4 消融研究

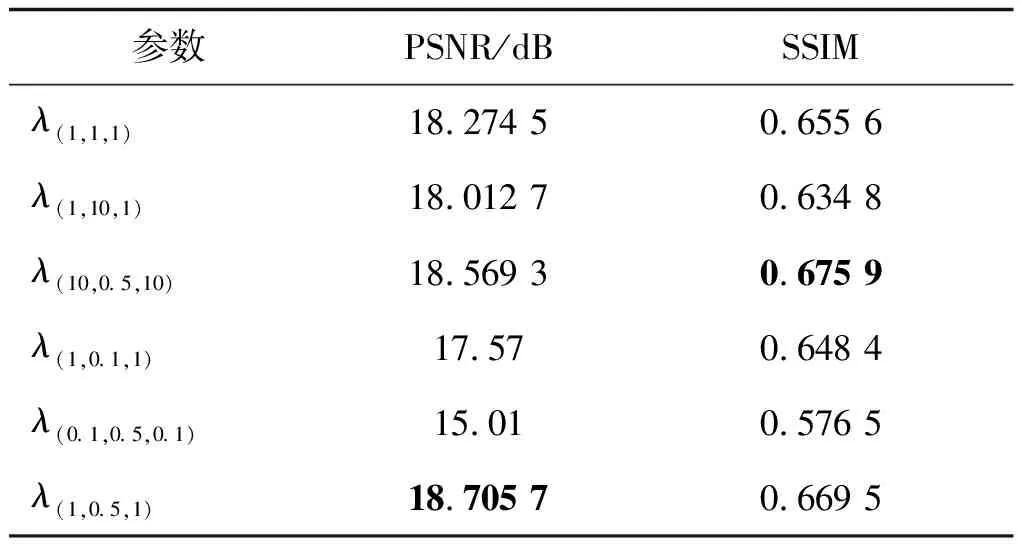

本节分析损失函数参数对网络性能的影响,以优化提出的沙尘图像增强网络。本文的损失函数采用了L1损失、感知(P)损失和梯度(G)损失。本节使用λ(L1,P,G)分别表示3个损失项前面的参数。表4给出了在训练网络时,不同参数对所提沙尘图像增强网络的定量评估。

通过表4可以看出,当感知损失前面的参数为0.5时,会产生更好的结果。增大L1损失和梯度损失的参数虽然会一定程度增大SSIM值,但是同时也降低了PSNR值,而减小L1损失和梯度损失的参数会降低SSIM值和PSNR值。综合上述分析,选择第6行的参数设置作为本文的最终方案。

表4 不同损失函数参数的定量比较

沙尘图像的增强处理,涉及颜色校正和清晰度增强两个互有影响而又紧密关联的运算,在具体处理时,是先对偏色进行校正还是先增强清晰度?哪个能够获得更好的增强效果?为此,本文进行了如下实验:修改原提出网络模型结构,即首先使用去尘增强模块进行去沙尘操作,然后使用色彩恢复模块恢复沙尘图像的颜色,并与原提出网络增强结果进行对比,部分实验结果如图11所示。可以观察到,修改后的网络可以去除图像中的沙尘,但是并不能很好地恢复图像颜色。而原提出的网络模型可以在去除沙尘的同时很好地恢复图像的色彩,得到与清晰图像十分接近的结果。

图11 修改后网络与原始网络的对比结果

当色彩恢复模块在后时,由于沙尘图像不同颜色通道的像素分布不均匀,去尘增强子网在处理中使图像颜色失真更复杂更严重,所以,将图像色彩恢复模块放在去尘增强模块之后并不能得到很好的结果。但是把色彩恢复模块放在前面时,由于对图像进行了色彩恢复,所以去尘增强子网处理的是色彩平衡的模糊图像,因此,可以在去除沙尘的同时很好地恢复图像的色彩,得到与清晰图像十分接近的结果。

5 结 论

本文提出了一种带色彩恢复的沙尘图像卷积神经网络增强方法。通过色彩恢复子网(SDCC)恢复输入沙尘图像的颜色,使用去尘增强子网去除沙尘图像中的沙尘,得到清晰的无沙尘图像。所提的SDCC子网学习不同的光照相关特征,并在给定的沙尘图像中很好地恢复颜色。提出的去尘增强子网将SDCC子网的结果作为条件输入,用来恢复无沙尘清晰图像。通过分析,可以看出,所提网络可以很好地恢复沙尘图像的颜色并且能够去除沙尘。此外,本文还构建了一个大规模的配对沙尘图像数据集,用来训练所提网络。从广泛的实验分析中可以看出,所提方法能够恢复沙尘图像颜色,并且能够从不同类型的沙尘图像中恢复无沙尘图像。

本文实验采用合成数据集对所提出方法进行训练与测试,采用真实沙尘图像对本文提出方法的有效性进行验证。对比实验结果表明,与对比方法相比,本文方法在合成沙尘图像上的PSNR和SSIM两个客观评价指标都取得了最好的结果,具有明显的优势;在真实沙尘图像上也能显著提升增强图像的质量,具有较高的应用价值。

然而,由于基于深度学习的沙尘图像增强方法在训练样本的获取方面存在天然的局限性,如真实场景中的沙尘图像及其对应的清晰图像采集难度较大,因此本文提出的带色彩恢复的沙尘图像卷积神经网络增强方法采用合成的沙尘图像作为训练集来估计无沙尘图像,在合成沙尘图像上训练的网络处理真实沙尘图像时,性能会有不同程度的下降。因此,如何构建真实沙尘天气下的沙尘图像和与之对应的清晰图像是一个难以解决的问题。同时,对于真实场景沙尘图像的增强结果的评价指标是一个具有挑战性的问题。虽然现在有一些评价图像质量的指标,但这些指标都是一些通用的图像评价指标,而且现有指标的评价结果与人眼感知质量有很大的差距。因此,针对沙尘图像增强方法的性能评价指标,也是未来需要进一步研究的具有挑战性的问题。

参考文献(References)

Cai B L, Xu X M, Jia K, Qing C M and Tao D C.2016.Dehazenet: an end-to-end system for single image haze removal.IEEE Transactions on Image Processing, 25(11): 5187-5198[DOI: 10.1109/TIP.2016.2598681]

Chen D D, He M M, Fan Q N, Liao J, Zhang L H, Hou D D, Yuan L and Hua G.2019.Gated context aggregation network for image dehazing and deraining//Proceedings of 2019 IEEE Winter Conference on Applications of Computer Vision(WACV).Waikoloa, USA: IEEE: 1375-1383[DOI: 10.1109/WACV.2019.00151]

Dudhane A, Aulakh H S and Murala S.2019.RI-GAN: an end-to-end network for single image haze removal//Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops.Long Beach, USA: IEEE: 2014-2023[DOI: 10.1109/CVPRW.2019.00253]

Engin D, Genc A and Ekenel H K.2018.Cycle-Dehaze: enhanced cyclegan for single image dehazing//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops.Salt Lake City, USA: IEEE: 938-946[DOI: 10.1109/CVPRW.2018.00127]

Fu H, Gong M M, Wang C H, Batmanghelich K and Tao D C.2018.Deep ordinal regression network for monocular depth estimation//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City, USA: IEEE: 2002-2011[DOI: 10.1109/CVPR.2018.00214]

Fu X Y, Huang Y, Zeng D L, Zhang X P and Ding X H.2014.A fusion-based enhancing approach for single sandstorm image//Proceedings of 2014 IEEE 16th International Workshop on Multimedia Signal Processing(MMSP).Jakarta, Indonesia: IEEE: 1-5[DOI: 10.1109/MMSP.2014.6958791]

Gao H, Wei P and Ke J.2015.Color enhancement and image defogging in HSI based on Retinex model//Proceedings of the SPIE 9622, 2015 International Conference on Optical Instruments and Technology.Beijing, China: SPIE: #962203[DOI: 10.1117/12.2193264]

Guo T T, Li X L, Cherukuri V and Monga V.2019.Dense scene information estimation network for dehazing//Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops.Long Beach, USA: IEEE: 2122-2130[DOI: 10.1109/CVPRW.2019.00265]

He K M, Sun J and Tang X O.2009.Single image haze removal using dark channel prior//Proceedings of 2009 IEEE Conference on Computer Vision and Pattern Recognition.Miami, USA: IEEE: 1956-1963[DOI: 10.1109/CVPR.2009.5206515]

Huang S C, Chen B H and Wang W J.2014.Visibility restoration of single hazy images captured in real-world weather conditions.IEEE Transactions on Circuits and Systems for Video Technology, 24(10): 1814-1824[DOI: 10.1109/TCSVT.2014.2317854]

Jobson D J, Rahman Z and Woodell G A.1997.A multiscale Retinex for bridging the gap between color images and the human observation of scenes.IEEE Transactions on Image Processing, 6(7): 965-976[DOI: 10.1109/83.597272]

Kwon K J and Kim Y H.2012.Scene-adaptive RGB-to-RGBW conversion using retinex theory-based color preservation.Journal of Display Technology, 8(12): 684-694[DOI: 10.1109/JDT.2012.2215954]

Li B Y, Peng X L, Wang Z Y, Xu J Z and Feng D.2017.AOD-Net: all-in-one dehazing network//Proceedings of 2017 IEEE International Conference on Computer Vision(ICCV).Venice, Italy: IEEE: 4780-4788[DOI: 10.1109/ICCV.2017.511]

Liu H, Li C, Wan Y Q and Zhang Y C.2017.Dust image enhancement algorithm based on color transfer//Proceedings of the 2nd CCF Chinese Conference on Computer Vision.Tianjin, China: Springer: 168-179[DOI: 10.1007/978-981-10-7299-4_14]

Pizer S M, Johnston R E, Ericksen J P, Yankaskas B C and Muller K E.1990.Contrast-limited adaptive histogram equalization//Proceedings of the 1st Conference on Visualization in Biomedical Computing.Atlanta, USA: IEEE: 337-345[DOI: 10.1109/VBC.1990.109340]

Qu Y Y, Chen Y Z, Huang J Y and Xie Y.2019.Enhanced pix2pix dehazing network//Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Long Beach, USA: IEEE: 8152-8160[DOI: 10.1109/CVPR.2019.00835]

Reinhard E, Adhikhmin M, Gooch B and Shirley P.2001.Color transfer between images.IEEE Computer Graphics and Applications, 21(5): 34-41[DOI: 10.1109/38.946629]

Ren W Q, Liu S, Zhang H, Pan J S, Cao X C and Yang M H.2016.Single image dehazing via multi-scale convolutional neural networks//Proceedings of the 14th European Conference on Computer Vision(ECCV).Amsterdam, the Netherlands: Springer: 154-169[DOI: 10.1007/978-3-319-46475-6_10]

Rizzi A, Gatta C and Marini D.2002.Color correction between gray world and white patch//Proceedings of the SPIE 4662, Human Vision and Electronic Imaging VII.San Jose, USA: SPIE: 367-375[DOI: 10.1117/12.469534]

Shi Z H, Feng Y N, Zhao M H, Zhang E H and He L F.2019.Let you see in sand dust weather: a method based on halo-reduced dark channel prior dehazing for sand-dust image enhancement.IEEE Access, 7: 116722-116733[DOI: 10.1109/ACCESS.2019.2936444]

Tan R T.2008.Visibility in bad weather from a single image//Proceedings of 2008 IEEE Conference on Computer Vision and Pattern Recognition.Anchorage, USA: IEEE: 1-8[DOI: 10.1109/cvpr.2008.4587643]

Wang J, Pang Y W, He Y Q and Liu C S.2016.Enhancement for dust-sand storm images//Proceedings of the 22nd International Conference on Multimedia Modeling.Miami, USA: Springer: 842-849[DOI: 10.1007/978-3-319-27671-7_70]

Xu G, Su J, Pan H D, Zhang Z G and Gong H B.2009.An image enhancement method based on gamma correction//Proceedings of the 2nd International Symposium on Computational Intelligence and Design.Changsha, China: IEEE: 60-63[DOI: 10.1109/ISCID.2009.22]

Yang X T, Xu Z and Luo J B.2018.Towards perceptual image dehazing by physics-based disentanglement and adversarial training//Proceedings of the 32nd AAAI Conference on Artificial Intelligence.New Orleans, USA: AAAI: 7485-7492

Yu S Y, Zhu H, Wang J, Fu Z F, Xue S and Shi H.2016.Single sand-dust image restoration using information loss constraint.Journal of Modern Optics, 63(21): 2121-2130[DOI: 10.1080/09500340.2016.1184340]

Zhang H and Patel V M.2018.Densely connected pyramid dehazing network//Proceedings of 2018 IEEE/CVF conference on Computer Vision and Pattern Recognition.Salt Lake City, USA: IEEE: 3194-3203[DOI: 10.1109/CVPR.2018.00337]

Zhang J and Tao D C.2020.FAMED-Net: A fast and accurate multiscale end-to-end dehazing network.IEEE Transactions on Image Processing, 29: 72-84[DOI: 10.1109/TIP.2019.2922837]

Zhi N, Mao S J and Li M.2016.Visibility restoration algorithm of dust-degraded images.Journal of Image and Graphics, 21(12): 1585-1592(智宁, 毛善君, 李梅.2016.沙尘降质图像清晰化算法.中国图象图形学报, 21(12): 1585-1592)[DOI: 10.11834/jig.20161203]

Zhou R Z, He J and Hong Z L.2005.Adaptive algorithm of auto white balance for digital camera.Journal of Computer-Aided Design and Computer Graphics, 17(3): 529-533(周荣政, 何捷, 洪志良.2005.自适应的数码相机自动白平衡算法.计算机辅助设计与图形学学报, 17(3): 529-533)

Zhu Q S, Mai J M and Shao L.2015.A fast single image haze removal algorithm using color attenuation prior.IEEE Transactions on Image Processing, 24(11): 3522-3533[DOI: 10.1109/TIP.2015.2446191]