水下光学图像重建方法研究进展

王柯俨,黄诗芮,李云松

西安电子科技大学综合业务网理论及关键技术国家重点实验室, 西安 710071

0 引 言

海洋是地球生态系统的重要组成部分,也是生命赖以生存的自然栖息地,蕴含着丰富的资源。探索、开发和保护海洋资源具有重要的战略意义,一直都是世界各国争先关注的重点。在当前国内外形势下,中国正在加快建设海洋强国,大力发展智慧海洋。海洋信息的获取和智能信息处理技术是合理开发利用海洋资源的重要保障。作为海洋信息获取的主要技术手段之一,水下光学图像广泛应用于海洋生物研究、海底地貌勘察、海洋军事应用和水下目标检测(Fu 等,2020;Lin 等,2020)等水下工程和研究领域中。然而由于光在水下传播会被水介质吸收和散射,同时水下成像环境复杂恶劣,导致成像设备捕获的原始图像质量退化严重,往往存在对比度低、模糊和颜色失真等问题,不仅降低了人眼主观视觉感受,更限制了各类水下智能信息处理系统的应用(Liu 等,2020)。因此,研究有效的水下光学图像重建方法,去除海水对成像的影响,并提高智能处理系统的性能,具有非常重要的意义。

为了获得清晰的水下光学图像,研究者们提出了诸多方法。从方法机理上可分为两大类:硬件驱动方法和软件驱动方法。硬件驱动方法也就是基于光学的方法,指通过设计新的光学成像设备和系统来提高水下图像的质量。现有的硬件驱动方法包括偏振成像、距离选通成像、荧光成像和立体成像(Tian 等,2018;Risholm 等,2018)。偏振成像是一种被动成像方法,能够迅速地捕获图像并显著降低噪声。距离选通成像是一种主动成像方法,在混浊水中应用广泛。这两种系统的设备参数设置较复杂,且很容易受到环境的影响。荧光成像技术用途之一是检测珊瑚礁中的微生物,而立体成像技术主要应用在水下机器人等设备中。这两类技术通过估计能见度系数来辅助恢复水下图像。上述硬件驱动方法往往需要针对特定场景专门设计复杂的成像系统,成本较高,实际应用受限(郭银景 等,2021)。

软件驱动方法即基于计算的方法,其思想是设计计算机图像处理算法来优化重建现有光学相机拍摄的水下退化图像。早期采用传统的图像增强或复原方法来处理水下图像。其中图像增强方法不依赖物理模型,通过直接调整图像的像素值来改善视觉质量;而图像复原方法则基于物理模型,利用有效的先验假设来估计成像模型的未知参数,进而反演得到清晰图像。这两类传统方法虽然成熟有效,但局限性较大,难以适应复杂的水下环境,普适性较差。随着深度学习技术的蓬勃发展,基于深度学习的方法在水下图像处理任务中表现出更强的适应性和发展潜力,已逐渐成为当前水下图像处理领域的研究热点。这类方法无需手动提取特征,而是利用深度神经网络强大的特征挖掘能力,采用大量数据训练网络去自动学习水下图像的特征。目前这方面的研究还不够成熟,在网络结构和训练数据等方面仍存在许多问题。总之,相比于复杂、高成本的硬件驱动方法,基于计算的软件驱动方法具有低成本和易实现等优点,应用更广泛。

本文聚焦于软件驱动的水下光学图像重建方法,全面综述其研究进展。相较于郭继昌等人(2017)、从润民等人(2020)和郭银景等人(2021)发表的综述,本文全面梳理了该领域的难点和技术发展历程,然后按照研究发展顺序依次分析了现有4大类处理方法的基本思想、代表性方法及优缺点;分类归纳了目前可以公开获取到的水下图像数据集,总结了其特点和适用范围;归纳了现阶段常用的水下图像质量评价方法,并对典型的水下图像重建方法进行了性能评测,通过对比分析总结了现有方法的特点和局限性,展望了将来有待研究的方向。

1 水下成像概述

1.1 水下图像退化机理

水下图像退化的主要原因是水介质的散射和吸收作用。在海水环境下,悬浮颗粒与微生物引起的散射作用改变光路的传播方向,吸收作用导致环境光线的能量衰减。光线传播距离越长,衰减越多。这样的散射吸收作用使成像设备捕获的图像呈现对比度低、物体边界模糊的现象(如图1(a))。

图1 水下图像示例

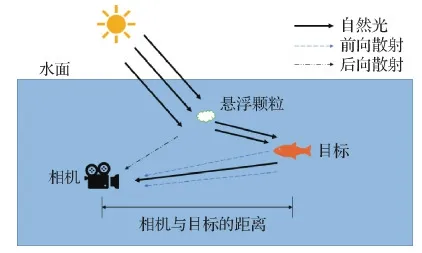

如图2所示,水下光线传播路径中,主要散射作用是前向散射和后向散射。前向散射即光线从物体传播到相机的小角度偏移,会导致物体边界模糊;后向散射是被水中微粒散射到成像平面的环境光线,会进一步降低图像对比度并加重纹理模糊。

图2 水下成像过程

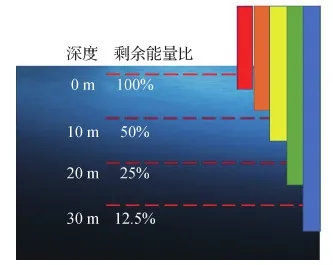

不同于大气环境,不同波长的光线在水中的衰减系数不同,导致水下图像色彩失真,对比度和亮度下降(如图1(b))。如图3所示,清澈的海水中,波长较长的红色光被优先吸收,传播距离最短,其后依次为橙光、黄光、绿光和蓝光,因此海洋水体往往是蓝绿色的。

图3 水下光选择性衰减

水下成像环境复杂,光线的衰减不仅与成像距离、波长有关,还与水质、温度和盐度等因素有关。如何提高对比度、校正色偏,恢复出清晰的水下图像是非常具有挑战性的问题。

1.2 水下成像模型

本节回顾水下光学成像模型,包括经典的McGlamery-Jaffe模型、广泛使用的Schechner-Karpel模型及其修正后的Akkaynak-Treibitz模型。

1.2.1 McGlamery-Jaffe模型

McGlamery-Jaffe成像模型建立了水下图像像素点亮度与照明条件、物体反射特性、水介质以及相机传感器特性之间的映射。McGlamery(1980)给出了该模型的理论基础,Jaffe(1990)拓展了模型并应用到水下系统的设计中。

到达相机平面的光线I可以分解为3个部分:由自然光线经过拍摄物体反射到达相机的成像平面的直接分量D;水下目标反射过程中小角度散射后仍能到达成像平面的前向散射分量F;没有经目标反射到达成像平面的后向散射分量B。I可以建模为3个分量的线性叠加,计算为

I=D+F+B

(1)

McGlamery-Jaffe模型涵盖了广泛的成像条件,参数众多且计算复杂。其中,水的光学特性尤其难获得,因为即使在相同的地理位置,它们也在时刻变化,只能通过专业设备测量得到。因此,该模型主要用于水下导航或监控等具备专门设备的任务中。

1.2.2 Schechner-Karpel模型

许多学者对McGlamery-Jaffe模型进行了简化,其中最具代表性且广泛应用的模型是Schechner-Karpel模型(Schechner和Karpel,2004)。该模型将直接分量和前向散射分量视为有用信号,后向散射分量视为干扰。考虑到前向散射分量近似直接分量,可以表示为直接分量与点扩散函数的卷积,从而将直接分量和前向散射分量合并为一个分量。定义有效场景亮度J为未衰减的反射光。该模型建模了J沿着物体到相机的传播路径衰减的过程。将均匀的全局背景光记为B∞,退化模型为

I=J·T+B∞(1-T)=

J·e-ηz+B∞·(1-e-ηz)

(2)

式中,T是透射率图,表征J的退化程度,即散射或吸收作用后到达相机的残余光线比;η是衰减系数,它是吸收系数α和散射系数β之和,即η=α+β;z是目标到相机的距离。I、J、T、B∞、η、α和β都是关于波长的函数。

不同颜色通道的透射率满足如下关系,即

(3)

式中,ηk,k∈{r,g,b}分别代表RGB颜色通道的衰减系数。

Schechner-Karpel模型考虑了不同波长光的选择性衰减,形式简单,参数少,因此广泛用于基于物理模型的水下图像复原方法。此外,大多数基于深度学习的水下图像处理算法也基于此模型合成训练数据和设计网络架构。

1.2.3 Akkaynak-Treibitz模型

Akkaynak 和 Treibitz(2018)的研究指出,通用的水下成像模型忽略了关键的依赖关系:1)直射分量和后向散射分量的衰减系数不同;2)后向散射的衰减系数强烈地依赖于背景光;3)后向散射的衰减系数还与时刻、水深以及水体是吸收作用还是散射作用为主等因素有关。为此,提出一种改进的水下图像成像模型,其表达式为

I=J·TD+B∞·(1-TB)=

Je-ηD(vD)·z+B∞(1-e-ηB(vB)·z)

(4)

式中,TD和TB分别代表直接透射率和后向散射率,ηD和ηB分别代表直接传输和后向散射分量的衰减系数,同样与波长有关;向量vD和vB代表系数依赖。具体来说,vD={z,ρ,E,Sλ,β},且vB={E,Sλ,b,β},ρ是反射系数,E是辐射度,Sλ是传感器的光谱响应,b是波束散射系数。此外,与后向散射有关的系数随传感器、环境照明和水的类型而变化。

综上所述,McGlamery-Jaffe模型和Akkaynak-Treibitz模型参数更多,计算结果更精确,但由于其复杂性,往往应用在有专业设备的水下任务中。目前的大多数水下图像处理算法仍然采用Schechner-Karpel模型。

1.3 水下图像处理的挑战

目前水下图像处理的首要挑战是如何适应真实水下场景的复杂性和多样性。在不同水域拍摄的水下图像的模糊程度和色偏各不相同。如图4所示,图4(a)(b)分别为沿海水和浑浊水。图4(a)具有典型的蓝绿色偏,并在拍摄时使用了人工光源补光,由于场景照明不均匀,人工光源在岩石区域产生光斑,掩盖了图像细节。图4(b)由于水中悬浮颗粒和微生物较多,吸收和散射效应更严重,同时噪声较大,图像的对比度更低,细节更模糊。

图4 不同的水下场景

为了解决水下图像对比度低、色偏严重、纹理细节模糊和光照不均等问题,国内外学者提出了大量的水下图像重建方法,本文将在第2节详细介绍一些代表性的工作。

第2个挑战是难以获得大规模丰富多样的真实水下数据集。受限于水下拍摄条件,真实场景拍摄所获取的水下图像的数量、场景和类型都不够丰富,而人工模拟方式生成的数据则不够真实。更重要的是,在实际中无法直接获得水下退化图像所对应的清晰真值图像,因此构建包含清晰真值图像的配对数据集是非常困难的。若直接采用传统算法处理后的恢复图像作为其真值图像,又难以突破传统算法处理效果的限制。众所周知,训练数据的质量直接影响深度学习方法的性能。因此如何构建合适的水下数据集是基于深度学习的水下图像处理方法的研究难点之一。本文将在第3节详细这方面的研究进展。

第3个挑战是缺乏完善的水下退化图像的质量评测体系。MSE(mean squared error)、PSNR(peak signal-to-noise ratio)、SSIM(structural similarity)等经典的图像质量评价指标,应用在水下图像质量评价中不够客观,评价结果易出现与主观感知不一致的现象。针对水下图像设计的评价指标稳定性不够,准确性不理想。水下图像质量评价对算法的设计与更新具有重要的指导意义,因此如何设计系统的评价方法也是水下图像清晰化算法的研究难点之一。本文将在第4节介绍目前应用于水下图像质量评价的方法。

2 方 法

水下图像重建是开展水下光学探测的关键技术之一,已逐渐成为当前的研究热点和难点问题,受到越来越多国内外学者的关注。其核心问题是如何抑制散射和吸收效应带来的不利影响,提高图像对比度和清晰度,并补偿颜色失真。

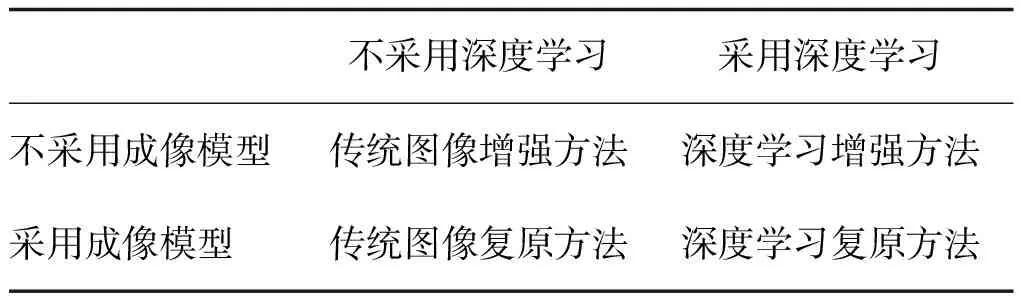

近年来国内外先后涌现出许多对水下退化图像进行重建的处理方法,图5概括了目前水下光学图像重建方法的发展历程。对于现有方法,本文按照是否采用深度学习技术以及是否采用水下成像模型,将其进一步划分为4大类,即传统图像增强方法、传统图像复原方法、深度学习复原方法以及深度学习增强方法,如表1所示。

表1 水下光学图像重建方法分类

下面参照图5所示的水下光学图像处理方法的发展历程,依次介绍上述4类处理方法。

图5 水下光学图像重建的发展历程

2.1 传统图像增强方法

这类方法针对水下图像退化的具体表现,如对比度降低、图像模糊以及存在色偏等,选取合适的图像增强技术来改善图像质量。现有的图像增强方法有许多分类方式,如Liu 等人(2020)按照空间域和频率域划分;Wang 等人(2019)按照不同颜色空间划分。本文则依据功能,将其划分为3类,即对比度提升方法、色偏校正方法和综合方法。表2归纳了典型的传统图像增强方法。

表2 传统图像增强方法:功能、作用域、光源、颜色空间、测试集

2.1.1 对比度提升

典型的对比度提升方法包括直方图均衡(histo-gram equalization, HE)、伽马校正(gamma correction, GC)和拉伸像素值等。

HE的本质是减少图像的灰度级以换取对比度的提升。由于HE方法没有考虑位置信息,故而常常会放大噪声。Zuiderveld(1994)对HE方法进行改进,提出了对比限制自适应直方图均衡(contrast limited adaptive histogram equalization, CLAHE)方法,通过划分子块,对单个子块进行直方图均衡,克服了HE方法的不足。但该算法处理后容易在子块边界处出现块效应。Hitam等人(2013)在CLAHE方法基础上提出混合CLAHE-Mix方法用于水下图像增强。将CLAHE应用于RGB颜色模型和HSV颜色模型,生成两幅图像,并通过欧几里得范数进行组合。实验结果表明,CLAHE-Mix能够显著提高水下图像的对比度,降低噪声和伪影,从而提高图像的视觉质量。基于HE的方法在提升对比度的同时容易放大噪声,且难以改善色偏问题。一些研究者又提出了对直方图滑动拉伸的方法提升对比度。

Iqbal等人(2007)提出了一种基于综合颜色模型(integrated color model, ICM)的水下图像增强方法。首先利用对比度拉伸算法均衡RGB图像的颜色对比度,滑动拉伸衰减严重的红绿色分量的直方图。接着将RGB颜色空间转换为HSI色彩空间。在HSI空间,利用滑动直方图拉伸方法处理图像的饱和度与亮度,提高HSI的真实色彩,解决照明问题。该方法通过在两个颜色空间先后应用均衡,解决了水下图像对比度低的问题。但是此方法没有考虑三通道分量的统计分布以及位置信息,导致部分区域增强效果不理想。

Ancuti等人(2012)提出了一种基于融合策略的单幅水下退化图像的处理方法。首先,分别利用白平衡方法和局部自适应直方图均衡方法处理退化图像以获取两幅待融合图像。然后,根据两幅图像的对比度、显著特征和曝光度等特征确定融合权重。最后,将两个融合图像和定义的权重组合,从而产生具有更好的全局对比度和细节信息的增强图像。

这类算法通常适用于自然光照明的水下场景。由于未针对人工光源照明设计,在处理带有人工光源的水下图像时效果不佳。

2.1.2 色偏校正

传统的色彩校正方法包括灰度世界假设(gray world assumption, GWA)、白平衡假设(white balance, WB)和灰度边缘假设(gray edge assumption, GEA)等。由于水下图像的RGB分量能量较低,直接应用GWA、WB进行水下图像增强时,往往会引入严重的伪影,放大图像内部噪声,甚至造成颜色失真。同时水下图像对比度低、可视化边缘少,GEA算法的假设条件被破坏,对水下图像的应用效果也不佳。

相比而言,Retinex算法能够较好地平衡图像细节增强和色偏校正等问题,具有更好的适应性,广泛应用于水下图像增强中。Fu等人(2014)基于Retinex理论提出了一种水下图像色偏校正算法。首先对RGB通道进行简单的色彩校正;其次,提出了一种变分Retinex模型分解水下图像的反射率(图像细节)和照度(亮度),采用交替方向优化策略求解模型;最后,采用CLAHE算法进行后处理,解决图像模糊和曝光不足的问题。Zhang等人(2017)在此基础上进行了改进,提出了Lab-MSR(multi-scale Retinex)方法,扩展了Retinex水下图像增强框架。在CIELAB颜色空间中,对L通道进行双边滤波,对A和B通道进行三边滤波,估计并去除颜色空间中的亮度分量,能够有效抑制光晕伪影。这两种基于Retinex理论的算法同样忽略了人工光源的影响,均假设水下场景由自然光源主导。

Ancuti等人(2018)在Ancuti等人(2012)融合方案的基础上提出了一个基于色彩平衡的新方法。首先对原始图像进行白平衡预处理,用于补偿水下选择性吸收造成的图像色偏。然后对预处理后的图像进行增强处理,分别利用伽马校正和高斯滤波获得两个增强图像。最后将增强图像进行融合,以进一步增强图像的边缘和细节。该方法适用范围广泛,能够对不同条件下(如不同相机、景深和光源等)的水下图像进行有效增强,恢复图像的色彩特征和边缘细节。

由于在夜间、水下以及非均匀照明等不利条件下,拍摄的图像往往颜色光谱分布不匀,至少一个颜色通道的信息接近完全丢失。Ancuti等人(2020)提出了彩色通道补偿(color channel compensation, 3C)方法,从另外的颜色中重建丢失的信道信息。该方法可作为图像处理的预处理步骤。

2.1.3 综合方法

上述增强算法各有优缺点,综合方法可以结合多种增强方法的优点,以得到更佳的处理结果。

在ICM基础上,Iqbal等人(2010)考虑到人工光源的影响,提出了无监督的色彩校正方法(unsupervised color correction method, UCM)。先在RGB空间对图像进行对比度均衡和改善色偏,然后再采用ICM 中的对比度拉伸方法拉伸图像。从结果来看,该方法能够有效提升对比度并去除水下图像的蓝绿色偏。然而UCM压缩了蓝色通道的强度值,会导致从其他色偏场景(如浑浊水环境)获取的水下图像的复原效果不理想。

Huang等人(2018)提出相对全局直方图拉伸(relative global histogram stretching, RGHS)算法。基于灰度世界理论,对G和B通道进行均衡并重新分配RGB通道直方图,实现对比度校正。采用双边滤波消除噪声的影响,同时保留有价值的细节。颜色校正是通过拉伸CIE-Lab颜色空间中的L分量并修正A和B分量实现。该方法适用于浅水图像的增强,结果具有更好的感知质量、更高的图像信息熵和更小的噪声。

除了空间域,还可以从变换域增强图像。例如,Vasamsetti等人(2017)提出了一种基于小波变换的水下图像透视增强技术框架,能够改善水下图像的低对比度和色偏,同时不改变目标的结构细节。该方法对RGB通道分量分别进行离散小波变换,分解得到近似系数(低频信息)和细节系数(高频信息),不断修正两个系数直到最后一层(最精细的尺度),此时应用色彩校正技术去除色偏,最后进行小波重构。该方法可以作为水下探测与跟踪技术的预处理,以提高精度。

总之,传统图像增强方法原理简单,能够有效改善图像的视觉效果。但是此类方法没有考虑图像的降质原理,忽略了降质程度与深度之间的关系。导致增强结果不够自然真实,容易出现局部区域欠增强或过增强的现象,如图6所示。

图6 增强算法处理示例

2.2 传统图像复原方法

这类方法以水下退化图像的物理成像模型为基础,利用不同的先验或假设提取图像特征,估计成像模型的未知参数,最终反演出降质前的清晰图像。根据1.2节的介绍,目前广泛采用的成像模型是Schechner-Karpel模型,其未知参数包括透射率和全局背景光。水下图像复原的核心问题就是如何准确估计透射率T和全局背景光B∞。因此,本节针对这两个问题对现有方法进行综述。

2.2.1 透射率估计

为了准确估计透射率,国内外学者相继提出了各种不同的先验。本文梳理了目前已提出的先验,并依据先验类型对其中的代表性方法进行介绍。

1)暗通道先验及其改进。暗通道先验(dark channel prior, DCP)方法由He等人(2009)提出,在图像去雾领域取得了很好的效果。作者观测到,大部分户外无雾图像的非天空区域,像素中至少一个颜色通道的亮度值非常低,接近零。

考虑到水下成像模型和大气散射模型在去雾问题上具有相似性,Chiang和Chen(2012)率先将DCP应用到水下图像复原中,提出了波长补偿和图像去雾(wavelength compensation and image dehazing, WCID)方法,不直接估计透射率,而是利用DCP估计水下图像的深度图,分离前景和背景区域,通过比较前景和背景的平均亮度来检测并去除人工照明。然而DCP估计水下图像的深度图并不准确,由深度图对前景和背景像素进行分类效果不佳。

而后许多研究者对DCP方法进行了不断改进,代表性的工作包括Drews等人(2013)提出的水下暗通道先验(underwater dark channel prior, UDCP)、Galdran等人(2015)提出的红通道先验(red channel prior, RCP)和Peng等人(2018)提出的广义暗通道先验(generation of dark channel prior, GDCP)。

UDCP方法在计算暗通道值时忽略损失严重的红色通道,只用蓝绿通道来计算;RCP方法在计算暗通道时用1与红通道值的差来代替红通道值。Lu等人(2015)观察到在浑浊的水中红色通道并不一定衰减最多,也可能是蓝色通道,继而提出水下中值暗通道先验(underwater median dark channel prior, UMDCP),取红蓝通道的信息估计透射率。此外,Peng等人(2018)推广了暗通道先验,首先借助梯度信息估计深度图,利用场景深度信息得到背景光,最后代入成像模型估计出透射率值。上述这些改进的暗通道先验在一定程度上提升了水下图像透射率估计的准确性。

2)其他先验。Carlevaris-Bianco等人(2010)观察到,水下图像中透射率越小的区域,其红通道的衰减越大,红通道与蓝绿通道间的差值越大,继而提出一种基于差值的先验,即最大亮度先验(maximum intensity prior, MIP)。此方法利用红通道亮度最大值和蓝绿通道亮度最大值的差值定义透射率图。然而MIP在人工照明场景下假设可能会失效,导致无法估计出准确的透射率。

Li等人(2016)提出了最小信息损失先验(minimum information loss principle, MILP),通过降低局部区域红色通道信息损失估计红色通道透射率,再利用三通道透射率的比值关系估计出蓝绿通道透射率。Wang等人(2017a)则利用最大衰减识别(maximum attenuation identification, MAI)方法估计透射率。上述水下先验均基于颜色信息,会低估一些与海水具有相似颜色特征的物体的透射率值,例如蓝色或绿色的物体。

Peng和Cosman(2017)基于图像模糊和光吸收(image blurriness and light absorption, IBLA)提取水下退化图像的深度图,再利用指数衰减模型估计出透射率。Berman等人(2021)提出基于雾线(haze-line)假设的透射率估计方法,并借助灰度世界假设估计三通道衰减因子间的比值;然而当背景光亮度明显大于场景时,大多数像素将指向同一方向,难以探测到haze lines,从而导致该方法失效。

2.2.2 背景光估计

对于背景光,通常利用图像中深度趋于无穷的像素来估计。为了准确选取这类像素,目前已提出了多种估计手段。

第1类是基于颜色信息的方法。WCID先将图像分成若干局部块,然后确定每个局部块的亮度最小值,取局部最小值中最亮的像素点值作为背景光值。UDCP方法选取水下暗通道中最亮的像素点值作为背景光值;RCP方法则先取红通道中亮度值前10%的像素点,再取这些像素点的亮度最大值作为背景光值。

MILP先选取暗通道中亮度值前0.1%的像素点,再取这些像素点中红通道与蓝通道差值最大的像素点值作为背景光值。MAI考虑到水下背景光并不总是均匀的,将图像分割成小像素块,估计出局部背景光,每个像素块取红通道中亮度最暗10%的像素点作为背景光值。GDCP选取深度图中值最大的前0.1%的像素点,取像素点值之和估计背景光。

此类方法根据深度无穷远的区域亮度很高或者红色通道衰减最为严重的特点估计背景光值,但图像中一些具有相同颜色特性的物体会对估计过程产生干扰,使得背景光估计不准确。

第2类是基于纹理信息的方法,如Berman等人(2021)的方法选取图像边缘图中最为平滑的区域估计背景光,但这类方法同样会被具有相同特征的物体干扰。

第3类是基于深度信息的方法,如MIP在估计透射率后,将透射率值最小的区域的亮度值作为背景光。对于这类方法,透射率估计不准确会影响背景光估计,特别是如果图像中并未包含远处海水区域,即没有深度趋于无穷大的像素时,就难以在图像中选取一个接近背景光的像素,故而其估计结果将产生较大误差。

此外,背景光还可以根据模糊信息获得,如IBLA方法根据图像的模糊度和方差,估计背景光;Lu等人(2015)考虑到人工照明和闪光灯对水下成像的影响,基于色线模型估计背景光。

由此可见,传统图像复原方法考虑了水下图像的退化机理,在成像模型参数估算准确的条件下,复原结果更为自然准确。表3总结了目前具有代表性的水下图像复原方法。但是由于水下环境复杂多样,难以得到准确普适的先验知识,在一些场景下会因先验失效而导致图像复原结果不理想。因此这类方法的准确性与普适性有待进一步提高。

表3 传统物理模型方法:参数估计、后处理、光源、测试集

近年来也有将盲复原技术与水下成像模型相结合的方法。谢骏等人(2021)基于McGlamery-Jaffe成像模型,结合水下图像的红通道的稀疏特性,提出了一种水下图像变分盲复原方法。将模型的重要分量集成到变分能量模型中,利用交替方向乘子法迭代求解,解决了图像的模糊、对比度低和色偏的问题。现有研究的关注点主要在于如何提高复原方法的鲁棒性,在不同水下环境和水质条件下都能够获得良好的恢复效果。

2.3 深度学习复原方法

自从深度学习技术在图像分类、目标检测等高级视觉任务领域取得巨大成功之后,越来越多的学者尝试利用深度学习技术来解决低级视觉任务,如图像超分辨率重建、去噪、去雾以及水下图像重建等,并取得了良好的效果。由于水下光学图像的退化机理与户外雾霾图像相似,因此在早期学者们常常借鉴图像去雾的处理框架和网络结构对水下图像进行处理。

在早期利用深度学习技术重建水下图像时,涌现出来的都是基于物理成像模型的深度学习方法。本文称之为深度学习复原方法。这一类方法可以看成是深度学习技术与传统图像复原方法的结合,其本身仍然是以成像模型为基础,沿用图像复原的基本思路,即通过估计模型未知参数(透射率和背景光),进而反演清晰图像。与传统复原方法的不同之处在于,传统复原方法依靠先验假设来估计模型参数,而深度学习复原方法则通过大量数据训练深度神经网络,继而利用训练好的网络来估计模型参数。下面介绍几种典型的深度学习复原方法。

早期的深度学习复原方法采用有监督学习,设计神经网络来估计Schechner-Karpel成像模型中的重要参数,同时利用该模型合成配对的水下图像数据集训练网络。Shin等人(2016)在第一个深度学习去雾网络DehazeNet(Cai 等,2016)的启发下,提出了一种利用卷积神经网络(convolutional neural network, CNN)来估计水下图像透射率和背景光的方法。该方法使用同一个CNN网络来分别估计局部透射率和全局背景光,网络包含多尺度融合、特征提取和非线性回归3个阶段,并使用合成数据作为训练集,输入不同色偏的水下模拟图像块,由CNN网络输出对应块的透射率或全局背景光。该方法虽然获得了不错的复原效果,但由于训练数据只是局部图像块,缺少全局深度信息,并且估计透射率时忽略了三通道透射率之间的差异,使得恢复图像会出现颜色失真和清晰度不足的现象。

Hou等人(2018)提出了残差卷积神经网络URCNN以校正色偏,包括用于透射率估计的残差结构和用于平衡水下照明的场景残差计算方法(基于灰度世界假设和多尺度局部最大饱和度特征)。

Barbosa等人(2018)提出了一种基于CNN的图像复原方法,该方法采用二阶段学习方式。第1阶段先训练DehazeNet估计透射率图,然后采用UDCP方法估计背景光,最后根据水下成像模型恢复清晰图像;第2阶段再次训练透射率估计网络,通过一组图像质量度量损失更新网络的权重,指导图像复原学习过程。

Wang等人(2019)提出了基于CNN的并行参数估计网络,包括水下图像透射率估计分支和水下图像背景光估计分支。该网络能够增强图像对比度并校正色偏,得到的恢复图像较为自然清晰,但其并未考虑人工光源的强度估计问题,当输入场景为人工光源辅助成像的水下图片时,会出现局部过亮的现象。

上述方法均使用基于Schechner-Karpel简化成像模型的合成数据来训练网络,导致网络复原能力有限。近来也有使用更复杂的成像模型合成数据,或者不依赖配对数据集,直接利用无监督/自监督学习方法复原水下图像。

Liu等人(2021)提出了IPMGAN(integrating physical model and generative adversarial network)方法,将Akkaynak-Treibitz成像模型嵌入到网络设计中,引导条件生成对抗网络(conditional genrative adversarial network, CGAN)复原水下图像。生成器包含3个共享权值的编解码器分支,分别估计出背景光、透射率图和散射图,再根据Akkaynak-Treibitz模型复原清晰图像。同时判别器分辨复原后的图和真值图。这种将成像模型与GAN网络结合的方式能够有效结合二者优势。

Kar等人(2021)首次应用零次学习(zero-shot learning)方法复原水下图像,解决真实世界配对水下图像样本少的问题。借助简单的CNN网络估计Schechner-Karpel模型的透射率和背景光参数,设计了无参考损失函数引导网络向着去除色偏和避免过饱和的方向优化。该框架不仅可用于水下图像复原,还可拓展到图像去雾和低光照增强领域。

总而言之,深度学习复原方法通过神经网络自动学习水下退化图像与成像模型参数(即背景光和透射率图)之间的非线性映射关系,网络学习难度较低,网络结构相对简单。这类方法主要有两个缺陷。一是网络训练只能利用基于成像模型的合成数据,导致复原能力有限,这是因为真实水下图像对应的透射率和背景光参数很难获得,而合成的水下图像与真实水下环境差异较大,因此利用合成数据训练的网络往往只能作用于特定环境的水下图像,在一些较为复杂的真实水下图像上处理效果不佳;二是无法避免误差传递,小的模型参数估计误差在复原过程中可能被放大,导致复原结果偏差较大。

2.4 深度学习增强方法

为了克服深度学习复原方法的缺陷,越来越多的学者尝试利用神经网络强大的自适应学习能力,不借助物理模型,直接“端到端”地学习水下退化图像与相应清晰图像之间的映射关系。本文称其为深度学习增强方法。由于不依赖成像模型,这类方法更容易构建丰富多样的水下数据集,同时网络结构的设计也更加灵活,与深度学习复原方法相比,其普适性更强,复原效果更优。近两年涌现出大量的端到端增强网络,并且已经成为水下图像重建方向的主流方法。表4总结了现有代表性的深度学习复原方法和增强方法。

表4 深度学习方法:网络特点、框架、测试集、损失函数、指标

为了简单起见,本文直接按照网络类型将现有方法分为基于CNN的增强网络和基于GAN的增强网络。

2.4.1 基于CNN

这一类方法通过设计精细的CNN网络模型和构建相关损失函数,端到端复原水下退化图像,输入原始水下图像到网络后可直接输出清晰的水下图像。代表性的方法有Wang等人(2017b)提出的UIE-Net(underwater image enhancement network)、Sun等人(2019)提出的P2P(pixel to pixel)网络以及Anwar等人(2018)提出的UWCNN(underwater image enhancement fully convolutional neural network)等。

UIE-Net是一种端到端的水下图像增强网络,包含颜色校正和去雾两个子网络。利用像素干扰策略提取局部块的固有特征,提升了深度学习模型的收敛速度和精度。作者还合成了一个用于训练的包含20万幅水下图像的数据集,包含了不同程度的失真和雾化的水下图像。

P2P网络是一种对称的编码器—解码器网络,此方法以像素—像素的自适应方式实现了图像增强。将卷积层作为编码器滤除噪声,保留关键的细节特征;将反卷积层作为解卷积层,恢复丢失的细节,逐个像素细化图像。卷积层和反卷积层之间的跨层连接,加速了网络的训练过程。

Anwar等人(2018)考虑到不同水体衰减系数的差别,提出了一种结合基于成像模型和水下场景先验的水下图像合成方法。根据不同水体的衰减系数曲线,利用RGB-D NYU-v2(New York University)数据集(Silberman 等,2012)分别合成了10种不同水质和退化等级的水下图像数据集。得益于训练数据的丰富多样,提出的UWCNN网络虽然结构简单,依然取得良好的恢复效果。

Li等人(2020)借鉴图像融合的思想,提出了Water-Net网络。首先对原始图像分别进行白平衡、直方图均衡和伽马校正处理,将处理后的3幅图像输入网络,通过网络自动学习出相应的3个置信度图,最后根据置信度图对3幅输入图像进行加权融合,从而得到增强后的水下图像。

Li等人(2021)设计了一种结合水下模型特点的编解码网络Ucolor,由多颜色空间编码器网络和透射率引导解码器网络组成。编码器能够融合HSV、RGB和Lab 共3个颜色空间的特征,同时结合注意力机制,集成并突出最具鉴别性的特征。解码器网络嵌入透射率信息作为特征选择器,为不同空间位置的特征赋予不同的权重,以强调质量退化的区域。最后结合3个残差增强模块,重建清晰的水下图像。

这类端到端的CNN网络通常采用编解码器学习特征,再借助多分支的结构融合不同感受野的特征。编解码器中重复的上下采样操作会损失图像的纹理结构和边缘细节,影响最终的复原结果。多分支的网络结构往往较复杂,学习难度大,有时会出现难拟合的问题。同时,这类方法通常采用有监督学习,需要大量的配对水下图像,且严重依赖数据集的分布。

2.4.2 基于GAN

生成对抗网络能够自动完成图像构建并不断优化,近来广泛应用于水下图像增强中。网络利用生成器合成水下图像,再使用判别器分辨图像是真实的水下图像还是合成的水下图像。两个网络相互对抗,不断调整参数,直到判别器无法判断生成器的输出结果是否真实。基于GAN的代表性方法包括:Li等人(2018)提出的WaterGAN、Guo等人(2020)提出的UWGAN和Lu等人(2019)提出的MCycleGAN等。

WaterGAN方法将室内图像和对应深度图作为输入合成15 000幅RGB-D图像,然后使用一个二阶段的端到端颜色校正网络训练合成的水下图像,最后输入真实的水下图像进行测试,输出增强后的图像和对应深度图。

UWGAN网络是一种弱监督学习方法,可以学习失真图像与非失真图像之间的非线性映射。网络包括一个生成器和一个判别器。生成器采用残差MSDB(multiscale dense block)合成水下图像,判别器区分生成器生成的合成图像和对应的真实水下图像。

MCycleGAN是一种结合了DCP和CycleGAN的自适应水下图像复原网络,同样采用弱监督学习。首先利用DCP获得水下退化图像的透射率,辅助多尺度结构相似度测度损失的计算,提高了图像的复原性能。

此外,还有许多算法采用CGAN网络。Islam等人(2020)提出了一种基于CGAN的实时水下图像复原网络FUnIE-GAN。该方法设计了一个目标函数用于监督对抗训练,目标函数根据感知图像的整体内容、颜色、局部纹理和风格信息来评估图像质量。Han等人(2021)将对比学习引入GAN框架,提出了一种无监督端到端网络CWR(contrastive underwater restoration)用于水下图像复原。Desai等人(2021)提出了RUIG(realistic underwater image generation)方法,借助Akkaynak-Treibitz模型合成配对水下图像作为网络训练集,再利用CGAN网络复原水下图像。

总的来说,由于水下图像的退化情况复杂多样,为了得到良好的性能,通常这一类GAN网络都设计得较为复杂,学习难度较大,有时会出现难以拟合的问题。

综上,传统图像增强和复原算法原理清晰,可解释性强,但往往设计复杂,需要提取人工特征,并且受限于成像模型和先验假设,适用范围较小。而深度学习增强和复原方法具有很强的特征挖掘和表达能力,能够学习到更多深层次的水下退化图像特征,能够更好地处理复杂场景,相比于传统方法更灵活,适用性更广,恢复图像质量更好。但是深度学习方法普遍依赖丰富多样的数据集,目前网络的泛化能力不足,且计算复杂度高,难以满足实时性要求。

3 数据集

数据集的数量和质量对深度学习方法至关重要。现有的水下数据集制作方法大体上可分为模拟合成以及真实场景拍摄两大类。其中模拟合成方法包括模拟水下场景并拍摄、利用水下成像模型合成图像以及利用GAN网络生成图像等。通常模拟合成方法受限于模拟条件或水下成像模型,容易出现图像类型单一或图像不够真实的问题。而真实场景拍摄的难度较大,成本较高,不易获得大规模数据集,且很难覆盖水下复杂多样的环境。本节详细归纳了目前已公开的水下图像数据集,如表5所示。

表5 水下图像数据集:特点、描述

3.1 合成数据集

1)TURBID数据集。Duarte等人(2016)通过向水缸中倒入不同程度的牛奶模拟水下浑浊的情况,建立了TURBID数据集,共112对分辨率为3 676×2 496像素的水下合成图像集。该数据集包括5种不同程度的退化图像及对应的真值图,Milk和DeepBlue子集各有20幅图像,Chlorophyll子集包括42幅图像,Blue和Green Tea子集未开源。

2)WaterGAN数据集。Li等人(2018)以4个室内Kinect数据集(B3DO, UW RGB-D Object, NYU Depth, Microsoft 7-scenes)作为输入,每幅室内图像都配对深度图信息,再利用WaterGAN网络构建了共15 000对水下合成图像集。

3)UWCNN训练集。Anwar等人(2018)基于1 449对包含深度图室内数据集NYU Depth v2,根据不同的衰减系数合成10种Jerlov类型的水下图像数据集,可模拟不同水质、不同退化等级下具有不同色偏和模糊程度的水下图像。

3.2 真实场景数据集

1)SQUID(stereo quantitative underwater image dataset)数据集。Berman等人(2021)收集了一组在不同地点拍摄的不同水质的图像,数据集包括57组立体图像,每组提供了原始图像、TIF文件、相机校准文件和深度图,包含了不同季节、深度和水类型(热带水域和较暗的沿海水域)的现场数据,可用于水下图像复原算法处理效果评估。

2)UIEBD(underwater image enhancement benchmark dataset)数据集。Li等人(2020)建立了大规模水下图像增强基准数据集。包括两个子集:890对原始水下图像及相应的高质量配对参考图像、60幅无参考图像的具有挑战性的水下图像。其中配对图像集中的参考图像,是通过主观测试选择的,即由50名参与者从一组经过12种传统图像增强/复原方法处理后的图像中选出了视觉效果最好的作为参考图。

3)RUIE(real-world underwater image enhancement)数据集。Liu等人(2019)构建了RUIE数据集,根据不同任务分为3个子集,UIQS(underwater image quality set, 用于评测水下图像质量,3 630幅)、UCCS(underwater color cast set,用于评测不同算法的纠正色偏的能力,300幅)、UHTS(underwater higher-level task-driven set,用于评测不同算法的分类和检测目标能力,300幅)。图像由24台固定在不同位置的摄像机拍摄得到,涵盖了不同深度和照明条件的场景,能够用于水下图像质量评价、目标检测分类等。

4)EUVP(enhancing underwater visual perception)数据集。Islam等人(2020)建立了EUVP数据集,其中有12 420个配对实例和6 665个未配对实例,可用于感知图像增强。作者采用7种不同摄像机拍摄,其中一些图像截取自Youtube视频,包含了不同场景、水体类型和光照条件。未配对数据集根据6名志愿者的主观判断划分出质量好和质量差的图。配对图像使用拍摄的清晰图像作为真值图,利用GAN网络合成相应的退化图像,但部分真值图本身带有蓝色色偏。

5)OceanDark数据集。该数据集是由位于深海、使用人工照明的摄像机拍摄得到,包含183幅1 280×720像素的水下图像。同时还为每个示例提供了多种元数据,包括捕获日期、时间、位置、纬度、经度、深度和使用的摄像机系统。可以用于低照度水下增强系统。

4 质量评价

首先归纳现有的水下图像质量评价方法,然后采用代表性的评价指标来定量评价8种典型的水下图像处理方法的性能。

4.1 评价指标

图像质量评价方法可以分为主观评价(subject assessment, SA)和客观评价(objective assessment, OA)。主观评价基于人眼视觉效果对水下图像质量进行评价,客观评价则基于特定算法由计算机设备对水下图像质量进行自动评价。本小节主要介绍客观评价方法。

根据能够得到的参考图像(原始图像)信息的多少,客观评价方法可分为全参考(full-reference, FR)、半参考(reduced-reference, RR)和无参考(non-reference, NR)质量评价方法。在评价水下图像质量时,通常采用的是全参考和无参考的质量评价方法。对于带有真值图的水下图像,通常可采用峰值信噪比(PSNR)、结构相似度(SSIM)、PCQI(patch-based contrast quality index)、CIEDE(International Commission on Iuumination 2000 color-difference formula)2000等全参考指标进行质量评估。这种水下图像通常是在模拟合成或真实水下环境中配对拍摄的。对于没有真值图的水下图像,采用无参考的图像质量评价指标,如色彩对比度指数(color contrast index, CCF)、水下彩色图像质量评价(underwater color image quality evaluation, UCIQE)、水下图像质量度量(underwater image quality measures, UIQM)等。表6总结了这些客观评价指标的特点和应用。

表6 客观评价指标汇总表

PSNR指标常用于客观评价图像的劣化程度,单位为dB。两图像之间的PSNR值越大,图像劣化的程度越低。该指标计算为

(5)

式中,MSE表示复原图像与真值图之间的均方误差,MAX为图像能取到的最大像素值。对8 bit图像,该值为255;对彩色图像,分别计算RGB 3个通道的PSNR值,然后取平均值。

SSIM指标由Wang等人(2004)提出,从亮度、对比度和结构3个方面综合评价图像质量。当两幅图像完全一致时,SSIM的值为1,差异越大,值越小。该指标计算为

(6)

式中,μJ*与μJ分别表示真值图和复原图像的均值,σJ*和σJ分别表示两幅图像的标准差,σJJ*代表两幅图像的协方差。为防止分母为0,增加常数c1和c2。

由于PSNR没有考虑人眼的视觉特性,与主观感知的一致性较低,往往需要结合SSIM指标进行更客观的评价。

PCQI指标是一种新的基于局部块的客观质量评估方法,由Wang等人(2015)提出。使用局部块结构的自适应表示,能够将任意图像块分解为平均强度、信号强度和信号结构这3个分量,然后以不同的方式评估它们的感知失真。该指标计算为

(7)

式中,M代表局部块的总数,qi,qc,qs分别代表平均强度、信号强度和信号结构。

PCQI的原理近似于SSIM,但不同点在于:1)所提出的基于块的表示显式构建了一个局部自适应坐标系统,允许将任何新信号分解为3个物理上有意义的分量;2)分量的强度是在新的坐标系中投影得到的;3)与SSIM中的对比度评价分量不同,当信号强度增强时,该值可以大于1。

CIEDE2000指标由Luo等人(2001)提出,可用于评价图像在色彩空间的相似程度。指标值越大,图像之间的色差越大,颜色越不相近,其计算为

fCIEDE2000=

(8)

式中,ΔL′,ΔC′和ΔH′代表两幅图的亮度差、色度差和色相差;KL,KC和KH为参数因子,代表与相关实验条件有关的校正系数;SL,SC和SH为权重函数,用以校正颜色空间的均匀性;RT为旋转函数,代表校正色空间蓝色区域容差椭圆主轴方向的偏转。

针对水下图像设计的无参考评价指标,大多通过线性组合测试分量,分配不同的权重以获得更好的评价。水下图像像素在Lab颜色空间中主观评价相关的统计分布表明,清晰度和色彩因素与主观图像质量感知相关,因此无参考指标也大多基于此设计特征。

BRISQUE(blind/referenceless image spatial quality evaluator)指标是Mittal等人(2012)提出的一种基于自然场景统计的图像质量评价方法,部分学者将其用于水下图像质量评价。基于图像空间域呈现的统计规律,首先提取待评价图像的对比度归一化系数的平均差值,然后将该系数拟合作高斯分布。提取分布特征并输入到支持向量机进行回归计算,得到图像的评估结果。值越低,代表图像质量越高。

UCIQE指标由Yang和Sowmya(2015)提出,是首个针对水下彩色图像的度量指标。该指标为色度标准差、亮度对比度以及饱和度平均值的线性组合,用于定量评价水下图像的非均匀色偏、模糊和低对比度的情况。其值越高,代表水下图像的质量越高,计算方式为

fUCIQE=a1×σc+a2×conl+a3×μs

(9)

式中,σc是色度标准差,conl代表亮度对比度,μs是饱和度平均值。亮度对比度表征图片的全局灰度分布,通过计算亮度通道中所有像素值的最低1%和最高1%之间的差值得到。对于具有模糊、色偏和海雪畸变的水下图像,系数分别设为a1=0.468 0,a2=0.274 5,a3=0.257 6。对于其他具有特定类型失真的水下彩色图像,若训练集具有相同的失真,则不同度量组合的UCIQE效果更好。

受到人眼视觉系统特性的启发,Panetta等人(2016)提出了UIQM指标,将色彩度UICM(underwater image colorfulness measure)、清晰度UISM(underwater image sharpness measure)和对比度UIConM(underwater image contrast measure)3个水下图像属性度量线性组合。UIQM值越高,表示图像质量越好,计算为

fUIQM=b1×fUICM+b2×fUISM+b3×fUIConM

(10)

式中,权重b1,b2,b3的选择取决于应用目的。例如,在水下图像色彩校正应用中,UICM需要更多的权重,而在增强水下图像能见度时,则对比度项UIConM和清晰度项UISM更为重要。

CCF指标是Wang等人(2018)在水下吸收散射特性成像分析的启发下提出的,该指标用于测量水下彩色图像质量。通过将色彩指数(colorfulness)、对比度指数(contrast)和雾密度指数(fogdensity)进行特征加权,可以分别量化由吸收引起的色彩退化、由前向散射引起的模糊和由后向散射引起的模糊。具体计算为

fCCF=ω1×d1+ω2×d2+ω3×d3

(11)

式中,d1表示色彩指数,d2表示对比度指数,d3表示雾密度指数。该方法使用多元线性回归法计算得到3个系数的值,分别为ω1=0.175 93,ω2=0.617 59,ω3=0.339 88。

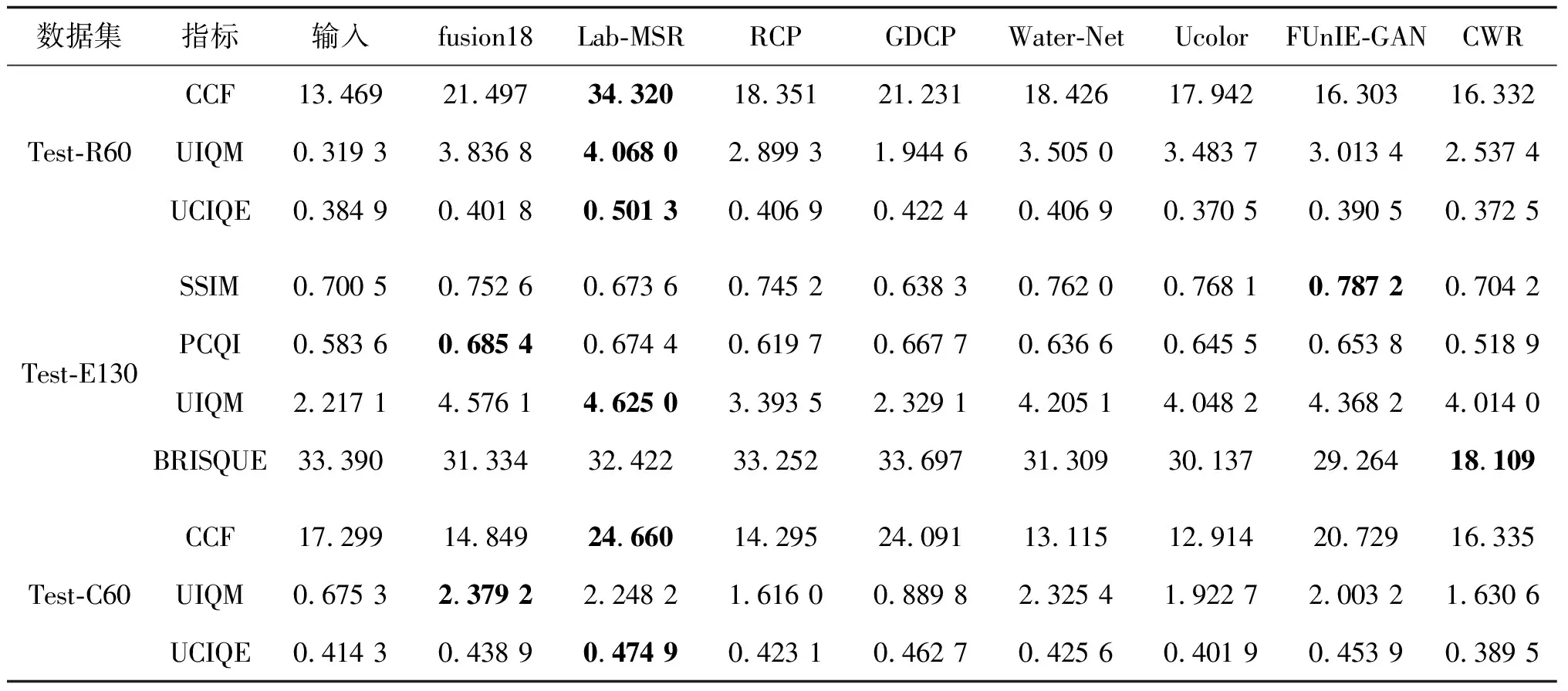

4.2 性能对比

1)测试集。为了评估现有算法在校正色偏、去模糊和提升对比度方面的效果与泛化能力,本文从已公开的真实场景数据集中选取了3个测试集,依次记为Test-R60, Test-E130和Test-C60,分别用于色偏校正测试、对比度提升测试和综合测试。其中Test-R60取自数据集RUIE-UCCS,包含60幅带有蓝、绿色偏的水下图像,没有配对的真值图。本文从EUVP数据集的配对样本中挑选了130幅包含不同水下场景的模糊图像以及配对的清晰真值图,构成测试集Test-E130。Test-C60包含60幅真实的水下图像,取自UIEBD数据集中具有挑战性的场景,没有配对的真值图。这样的组合方式保证了测试集的丰富性,涵盖了不同色偏和模糊程度的水下图像,图7展示了这3个测试集中的示例。其中Test-R60的图像分辨率为400×300像素,Test-E130为256×256像素,Test-C60为1 280×720像素。

图7 数据集样例

2)对比方法。选取了8种典型的水下图像复原/增强方法进行性能对比测试,供读者参考。这些方法包括:两种传统图像增强方法,即fusion18(Ancuti 等,2018)和Lab-MSR(Zhang等,2017);两种传统图像复原方法,即RCP(Galdran等,2015)和GDCP(Peng等,2018);4种深度学习增强方法,即Water-Net(Li 等,2020)、Ucolor(Li 等,2021)、FUnIE-GAN(Islam 等,2020)和CWR(Han 等,2021),其中Water-Net和Ucolor都是基于CNN的方法,而FUnIE-GAN和CWR都是基于GAN的方法。需要说明的是,由于fusion18和RCP方法并未开源,使用其他研究者复现的代码,其他方法都使用论文作者提供的源码进行测试。

3)评价指标。对于Test-R60,本文使用NR指标CCF、UIQM和UCIQE进行客观评价,侧重算法对色偏去除能力的评估。对Test-E130,使用FR指标SSIM、PCQI和NR指标UIQM、BRISQUE进行评价,侧重对算法在提升对比度和去模糊的能力的评估。对Test-C60,使用NR指标UIQM、UCIQE和BRISQUE进行客观评价。上述指标中,BRISQUE指标的值越低,表示图像质量越好,而其余指标则是值越高表示图像质量越好。

4.2.1 色偏校正测试

评估不同算法在Test-R60测试集上的处理效果。由于FUnIEGAN算法和CWR算法只能输出固定大小的图像(256×256像素),为了便于方法对比,本文调整了图像的大小,使其与原始图像的大小一致。处理的结果如图8(a)所示。

图8 不同算法处理结果对比

从主观结果来看,fusion18方法去除蓝绿色偏的效果最显著,但细节并不清晰。Lab-MSR方法尽管去除了色偏,但存在过度颜色补偿,在图像的部分区域引入了红色色偏,近景的岩石区域尤其明显。RCP和GDCP方法去除了部分色偏,但图像整体对比度没有提升。Water-Net去除色偏的效果比较明显,图像对比度也有提升,然而远景的色偏去除不彻底。FUnIE-GAN方法去除绿色色偏的效果明显,但处理蓝色色偏的图像时会失效。Ucolor和CWR仅能去除部分色偏,但图像的对比度有提升,Ucolor去除绿色色偏的效果更好,CWR去除蓝色色偏的效果更好。

客观指标的计算结果如表7所示。Ucolor和CWR的UCIQE指标与原图相比有所下降,这一点与主观感受较为一致。所有算法处理后图像的CCF指标和UIQM指标相对原图均有提升,这是综合了清晰度和去除色偏的结果。在所有处理方法中,Lab-MSR方法的各项指标最好,但这与主观感受不一致。客观指标的测试结果表明,这几类指标并不能完全反映主观感受,色调偏红的处理结果反而指标更好。

表7 不同算法处理效果

4.2.2 对比度提升测试

在Test-E130数据集上进行对比度提升测试评价,处理结果如图8(b)所示。大多数方法处理后,图像的对比度都有明显提升。fusion18、RCP、Water-Net、Ucolor和FUnIE-GAN方法处理后,图像的细节区域更清晰,整体和局部对比度都有提升。其他算法对比度提升的效果并不明显,原始图像中模糊的区域经过处理后仍然模糊。Lab-MSR的处理结果仍存在颜色过增强的问题,恢复图像色调不自然。CWR提升了图像对比度,但色偏没有明显改善。主观上FUnIE-GAN复原的效果最好,水下生物的色彩也更自然。除了RCP和GDCP,其余算法的SSIM指标结果相对于原图都有提升;除了CWR以外,其余算法的局部对比度指标PCQI都有提升;CWR的BRISQUE指标结果最好。这3个客观指标的计算结果基本与主观结果一致。

4.2.3 综合测试

在Test-C60测试集上开展综合测试。从主观效果图8(c)可以看出,FUnIEGAN算法完全失效,处理结果不尽如人意。RCP和GDCP算法处理后并无明显改善。Ucolor、Water-Net和CWR处理结果相对较好,对比度有提升,但也无法完全去除色偏。相对而言,CWR处理结果的颜色更自然。fusion18和Lab-MSR的处理效果并不稳定,部分场景(如图8(c)第2行)会失效。客观指标计算结果如表7,所有算法处理后UIQM指标都有提升,Lab-MSR的CCF指标最好,Ucolor和CWR的UCIQE指标相对原图略有下降。

综合来看,这些典型方法各有优劣,在传统算法中,fusion18的普适性最强,能够处理不同类型的水下图像;在深度学习方法中,Water-Net的表现最稳定。在其余方法中,RCP和GDCP算法都针对特定的场景设计先验,在其他场景上可能失效,普适性明显不够。Ucolor和FUnIE-GAN在去除色偏和提升对比度上都有明显的效果,但在一些挑战性的场景下会失效。CWR去除色偏的效果并不显著,但恢复图像整体色彩上更加自然。Lab-MSR同样存在普适性不够的问题。由此可见,设计更具泛化性和鲁棒性的水下图像重建方法,仍是未来需要重点研究的问题。

5 结 语

本文综述了国内外在水下光学图像重建方面的研究现状,分析了水下图像退化的原因,然后按照研究的发展顺序,对现有方法进行分类讨论,并分析了其优缺点;其次介绍了目前可获取的公开水下图像数据集以及现阶段水下图像质量评价方法,最后采用主观和客观评价指标对典型方法的性能进行了评测和对比分析。

目前水下光学图像重建的研究已取得可观进展,但各类方法仍存在不足之处。传统增强方法忽略了水下成像的光学属性,容易引入颜色偏差和伪影,并且仅对单一或有限特征进行增强,容易出现局部区域过饱和或欠饱和情况。传统复原方法由于成像模型和先验的局限性,难以适应多样的水下环境,应用范围有限。深度学习复原方法无法避免误差叠加问题,复原结果不够准确。深度学习增强方法的网络复杂,学习难度较大,泛化能力不足。

由此可见,在水下光学图像重建领域依然存在许多问题,今后可在以下几方面进一步研究。

1)提高方法的鲁棒性和泛化性。现有方法对真实场景的恢复效果不理想,特别是退化严重的情况,无法满足实际应用的需求。因此需要研究能够适应多样的水下环境并根据不同的退化类型自适应调整策略的处理方法。

2)开展面向实际应用的实时处理。水下环境复杂,现有方法为了提高恢复图像的质量,往往需要设计复杂的算法或网络,处理时间比较长,难以实时应用。端到端的深度增强网络可以较为理想地解决这一问题。如何设计面向实时应用的轻量化网络是今后的研究重点。

3)将水下图像重建与高级视觉任务相结合。现有方法大都以提高水下图像主客观质量为目标,忽略了图像重建任务与其他高级视觉任务(如目标检测)的联系,使得图像质量的提升并不一定能促进后续视觉应用。如何利用高级视觉任务驱动水下图像重建也是值得研究的方向。

4)建立更合理完善的水下图像质量评价体系。目前虽已提出了多种针对水下图像的质量评价方法,但仍缺少广泛认可的完备评价体系,现有客观指标的评价结果与人的主观感知之间仍存在较大差异,限制了该研究领域的进一步发展。此外,视觉任务驱动的评价方法也有待研究。

参考文献(References)

Akkaynak D and Treibitz T.2018.A revised underwater image formation model//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City, USA: IEEE: 6723-6732[DOI: 10.1109/CVPR.2018.00703]

Ancuti C, Ancuti C O, Haber T and Bekaert P.2012.Enhancing underwater images and videos by fusion//Proceedings of 2012 IEEE Conference on Computer Vision and Pattern Recognition.Providence, USA: IEEE: 81-88[DOI: 10.1109/CVPR.2012.6247661]

Ancuti C O, Ancuti C, De Vleeschouwer C and Bekaert P.2018.Color balance and fusion for underwater image enhancement.IEEE Transactions on Image Processing, 27(1): 379-393[DOI: 10.1109/TIP.2017.2759252]

Ancuti C O, Ancuti C, De Vleeschouwer C and Sbert M.2020.Color channel compensation(3C): a fundamental pre-processing step for image enhancement.IEEE Transactions on Image Processing, 29: 2653-2665[DOI: 10.1109/TIP.2019.2951304]

Anwar S, Li C Y and Porikli F.2018.Deep underwater image enhancement[EB/OL].[2021-08-13].https://arxiv.org/pdf/1807.03528.pdf

Barbosa W V, Amaral H G B, Rocha T L and Nascimento E R.2018.Visual-quality-driven learning for underwater vision enhancement//Proceedings of the 25th IEEE International Conference on Image Processing(ICIP).Athens, Greece: IEEE: 3933-3937[DOI: 10.1109/ICIP.2018.8451356]

Berman D, Levy D, Avidan S and Treibitz T.2021.Underwater single image color restoration using haze-lines and a new quantitative dataset.IEEE Transactions on Pattern Analysis and Machine Intelligence, 43(8): 2822-2837[DOI: 10.1109/TPAMI.2020.2977624]

Cai B L, Xu X M, Jia K, Qing C and Tao D C.2016.DehazeNet: an end-to-end system for single image haze removal.IEEE Transactions on Image Processing, 25(11): 5187-5198[DOI: 10.1109/TIP.2016.2598681]

Carlevaris-Bianco N, Mohan A and Eustice R M.2010.Initial results in underwater single image dehazing//OCEANS 2010 MTS/IEEE SEATTLE.Seattle, USA: IEEE: 1-8[DOI: 10.1109/OCEANS.2010.5664428]

Chiang J Y and Chen Y C.2012.Underwater image enhancement by wavelength compensation and dehazing.IEEE Transactions on Image Processing, 21(4): 1756-1769[DOI: 10.1109/TIP.2011.2179666]

Cong R M, Zhang Y M, Zhang C, Li C Y and Zhao Y.2020.Research progress of deep learning driven underwater image enhancement and restoration.Journal of Signal Processing, 36(9): 1377-1389(从润民, 张禹墨, 张晨, 李重仪, 赵耀.2020.深度学习驱动的水下图像增强与复原研究进展.信号处理, 36(9): 1377-1389)[DOI: 10.16798/j.issn.1003-0530.2020.09.001]

Desai C, Tabib R A, Reddy S S, Patil U and Mudenagudi U.2021.RUIG: realistic underwater image generation towards restoration//Proceedings of 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops(CVPRW).Nashville, USA: IEEE: 2181-2189[DOI: 10.1109/CVPRW53098.2021.00247]

Drews P Jr, do Nascimento E, Moraes F, Botelho S and Campos M.2013.Transmission estimation in underwater single images//Proceedings of 2013 IEEE International Conference on Computer Vision Workshops.Sydney, Australia: IEEE: 825-830[DOI: 10.1109/ICCVW.2013.113]

Duarte A, Codevilla F, De O Gaya J and Botelho S S C.2016.A dataset to evaluate underwater image restoration methods//OCEANS 2016.Shanghai, China: IEEE: 1-6[DOI: 10.1109/OCEANSAP.2016.7485524]

Fu X P, Shang X D, Sun X D, Yu H Y, Song M P and Chang C I.2020.Underwater hyperspectral target detection with band selection.Remote Sensing, 12(7): #1056[DOI: 10.3390/rs12071056]

Fu X Y, Zhuang P X, Huang Y, Liao Y H, Zhang X P and Ding X H.2014.A retinex-based enhancing approach for single underwater image//Proceedings of 2014 IEEE International Conference on Image Processing(ICIP).Paris, France: IEEE: 4572-4576[DOI: 10.1109/ICIP.2014.7025927]

Galdran A, Pardo D, Picón A and Alvarez-Gila A.2015.Automatic red-channel underwater image restoration.Journal of Visual Communication and Image Representation, 26: 132-145[DOI: 10.1016/j.jvcir.2014.11.006]

Guo J C, Li C Y, Guo C L and Chen S J.2017.Research progress of underwater image enhancement and restoration methods.Journal of Image and Graphics, 22(3): 273-287(郭继昌, 李重仪, 郭春乐, 陈善继.2017.水下图像增强和复原方法研究进展.中国图象图形学报, 22(3): 273-287)[DOI: 10.11834/jig.20170301]

Guo Y C, Li H Y and Zhuang P X.2020.Underwater image enhancement using a multiscale dense generative adversarial network.IEEE Journal of Oceanic Engineering, 45(3): 862-870[DOI: 10.1109/JOE.2019.2911447]

Guo Y J, Wu Q, Yuan J J, Hou J C and Lyu W H.2021.Research progress on underwater optical image processing.Journal of Electronics and Information Technology, 43(2): 426-435(郭银景, 吴琪, 苑娇娇, 侯佳辰, 吕文红.2021.水下光学图像处理研究进展.电子与信息学报, 43(2): 426-435)[DOI: 10.11999/JEIT190803]

Han J L, Shoeiby M, Malthus T, Botha E, Anstee J, Anwar S, Wei R, Armin M A, Li H D and Petersson L.2021.Underwater image restoration via contrastive learning and a real-world dataset[EB/OL].[2021-08-13].https://arxiv.org/pdf/2106.10718.pdf

He K M, Sun J and Tang X O.2009.Single image haze removal using dark channel prior//Proceedings of 2009 IEEE Conference on Computer Vision and Pattern Recognition.Miami, USA: IEEE: 1956-1963[DOI: 10.1109/CVPR.2009.5206515]

Hitam M S, Awalludin E A, Yussof W N J H W and Bachok Z.2013.Mixture contrast limited adaptive histogram equalization for underwater image enhancement//Proceedings of 2013 International Conference on Computer Applications Technology(ICCAT).Sousse, Tunisia: IEEE: 1-5[DOI: 10.1109/ICCAT.2013.6522017]

Hou M J, Liu R S, Fan X and Luo Z X.2018.Joint residual learning for underwater image enhancement//Proceedings of the 25th IEEE International Conference on Image Processing(ICIP).Athens, Greece: IEEE: 4043-4047[DOI: 10.1109/ICIP.2018.8451209]

Huang D M, Wang Y, Song W, Sequeira J and Mavromatis S.2018.Shallow-water image enhancement using relative global histogram stretching based on adaptive parameter acquisition//Proceedings of the 24th International Conference on MultiMedia Modeling.Bangkok, Thailand: Springer: 453-465[DOI: 10.1007/978-3-319-73603-7_37]

Iqbal K, Odetayo M, James A, Salam R A and Talib A Z H.2010.Enhancing the low quality images using unsupervised colour correction method//Proceedings of 2010 IEEE International Conference on Systems, Man and Cybernetics.Istanbul, Turkey: IEEE: 1703-1709[DOI: 10.1109/ICSMC.2010.5642311]

Iqbal K, Salam R A, Osman A and Talib A Z.2007.Underwater image enhancement using an integrated colour model.IAENG International Journal of Computer Science, 34(2): 239-244[DOI: 10.1016/S0031-3203(01)00040-1]

Islam M J, Xia Y Y and Sattar J.2020.Fast underwater image enhancement for improved visual perception.IEEE Robotics and Automation Letters, 5(2): 3227-3234[DOI: 10.1109/LRA.2020.2974710]

Jaffe J S.1990.Computer modeling and the design of optimal underwater imaging systems.IEEE Journal of Oceanic Engineering, 15(2): 101-111[DOI: 10.1109/48.50695]

Kar A, Dhara S K, Sen D and Biswas P K.2021.Zero-shot single image restoration through controlled perturbation of Koschmieder’s model//Proceedings of 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).Nashville, USA: IEEE: 16200-16210[DOI: 10.1109/CVPR46437.2021.01594]

Li C Y, Anwar S, Hou J H, Cong R M, Guo C L and Ren W Q.2021.Underwater image enhancement via medium transmission-guided multi-color space embedding.IEEE Transactions on Image Processing, 30: 4985-5000[DOI: 10.1109/TIP.2021.3076367]

Li C Y, Guo J C, Cong R M, Pang Y W and Wang B.2016.Underwater image enhancement by dehazing with minimum information loss and histogram distribution prior.IEEE Transactions on Image Processing, 25(12): 5664-5677[DOI: 10.1109/TIP.2016.2612882]

Li C Y, Guo C L, Ren W Q, Cong R M, Hou J H, Kwong S and Tao D C.2020.An underwater image enhancement benchmark dataset and beyond.IEEE Transactions on Image Processing, 29: 4376-4389[DOI: 10.1109/TIP.2019.2955241]

Li J, Skinner K A, Eustice R M and Johnson-Roberson M.2018.WaterGAN: unsupervised generative network to enable real-time color correction of monocular underwater images.IEEE Robotics and Automation Letters, 3(1): 387-394[DOI: 10.1109/LRA.2017.2730363]

Lin W H, Zhong J X, Liu S, Li T and Li G.2020.ROIMIX: proposal-fusion among multiple images for underwater object detection//Proceedings of 2020 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Barcelona, Spain: IEEE: 2588-2592[DOI: 10.1109/ICASSP40776.2020.9053829]

Liu R S, Fan X, Zhu M, Hou M J and Luo Z X.2020.Real-world underwater enhancement: challenges, benchmarks, and solutions under natural light.IEEE Transactions on Circuits and Systems for Video Technology, 30(12): 4861-4875[DOI: 10.1109/TCSVT.2019.2963772]

Liu R S, Hou M J, Liu J Y, Fan X and Luo Z X.2019.Compounded layer-prior unrolling: a unified transmission-based image enhancement framework//Proceedings of 2019 IEEE International Conference on Multimedia and Expo(ICME).Shanghai, China: IEEE: 538-543[DOI: 10.1109/ICME.2019.00099]

Liu X D, Gao Z and Chen B M.2021.IPMGAN: integrating physical model and generative adversarial network for underwater image enhancement.Neurocomputing, 453: 538-551[DOI: 10.1016/j.neucom.2020.07.130]

Lu H M, Li Y J, Zhang L F and Serikawa S.2015.Contrast enhancement for images in turbid water.Journal of the Optical Society of America A, 32(5): 886-893[DOI: 10.1364/JOSAA.32.000886]

Lu J Y, Li N, Zhang S Y, Yu Z B, Zheng H Y and Zheng B.2019.Multi-scale adversarial network for underwater image restoration.Optics and Laser Technology, 110: 105-113[DOI: 10.1016/j.optlastec.2018.05.048]

Luo M R, Cui G and Rigg B.2001.The development of the CIE 2000 colour-difference formula: CIEDE2000.Color Research and Application, 26(5): 340-350[DOI: 10.1002/col.1049]

McGlamery B L.1980.A computer model for underwater camera systems//Proceedings Volume 0208, Ocean Optics VI.Monterey, USA: SPIE: 221-231[DOI: 10.1117/12.958279]

Mittal A, Moorthy A K and Bovik A C.2012.No-reference image quality assessment in the spatial domain.IEEE Transactions on Image Processing, 21(12): 4695-4708[DOI: 10.1109/TIP.2012.2214050]

Panetta K, Gao C and Agaian S.2016.Human-visual-system-inspired underwater image quality measures.IEEE Journal of Oceanic Engineering, 41(3): 541-551[DOI: 10.1109/JOE.2015.2469915]

Peng Y T, Cao K M and Cosman P C.2018.Generalization of the dark channel prior for single image restoration.IEEE Transactions on Image Processing, 27(6): 2856-2868[DOI: 10.1109/TIP.2018.2813092]

Peng Y T and Cosman P C.2017.Underwater image restoration based on image blurriness and light absorption.IEEE Transactions on Image Processing, 26(4): 1579-1594[DOI: 10.1109/TIP.2017.2663846]

Risholm P, Thielemann J T, Moore R and Haugholt K H.2018.A scatter removal technique to enhance underwater range-gated 3D and intensity images//Proceedings of OCEANS 2018 MTS/IEEE Charleston.Charleston, USA: IEEE: 1-6[DOI: 10.1109/OCEANS.2018.8604613]

Schechner Y Y and Karpel N.2004.Clear underwater vision//Proceedings of 2004 IEEE Computer Society Conference on Computer Vision and Pattern Recognition.Washington, USA: IEEE: 536-543[DOI: 10.1109/CVPR.2004.1315078]

Shin Y S, Cho Y, Pandey G and Kim A.2016.Estimation of ambient light and transmission map with common convolutional architecture//OCEANS 2016 MTS/IEEE Monterey.Monterey, USA: IEEE: 1-7[DOI: 10.1109/OCEANS.2016.7761342]

Silberman N, Hoiem D, Kohli P and Fergus R.2012.Indoor segmentation and support inference from RGBD images//Proceedings of the 12th European Conference on Computer Vision—ECCV 2012.Florence, Italy: Springer: 746-760[DOI: 10.1007/978-3-642-33715-4_54]

Sun X, Liu L P, Li Q, Dong J Y, Lima E and Yin R Y.2019.Deep pixel-to-pixel network for underwater image enhancement and restoration.IET Image Processing, 13(3): 469-474[DOI: 10.1049/iet-ipr.2018.5237]

Tian H, Zhu J P, Tan S W, Zhang Y Y, Zhang Y, Li Y C and Hou X.2018.Rapid underwater target enhancement method based on polarimetric imaging.Optics and Laser Technology, 108: 515-520[DOI: 10.1016/j.optlastec.2018.07.057]

Vasamsetti S, Mittal N, Neelapu B C and Sardana H K.2017.Wavelet based perspective on variational enhancement technique for underwater imagery.Ocean Engineering, 141: 88-100[DOI: 10.1016/j.oceaneng.2017.06.012]

Wang K Y, Hu Y, Chen J, Wu X Y, Zhao X and Li Y S.2019.Underwater image restoration based on a parallel convolutional neural network.Remote Sensing, 11(13): #1591[DOI: 10.3390/rs11131591]

Wang N, Zheng H Y and Zheng B.2017a.Underwater image restoration via maximum attenuation identification.IEEE Access, 5: 18941-18952[DOI: 10.1109/ACCESS.2017.2753796]

Wang S Q, Ma K D, Yeganeh H, Wang Z and Lin W S.2015.A patch-structure representation method for quality assessment of contrast changed images.IEEE Signal Processing Letters, 22(12): 2387-2390[DOI: 10.1109/LSP.2015.2487369]

Wang Y, Li N, Li Z Y, Gu Z R, Zheng H Y, Zheng B and Sun M N.2018.An imaging-inspired no-reference underwater color image quality assessment metric.Computers and Electrical Engineering, 70: 904-913[DOI: 0.1016/j.compeleceng.2017.12.006]

Wang Y, Song W, Fortino G, Qi L Z, Zhang W Q and Liotta A.2019.An experimental-based review of image enhancement and image restoration methods for underwater imaging.IEEE Access, 7: 140233-140251[DOI: 10.1109/ACCESS.2019.2932130]

Wang Y, Zhang J, Cao Y and Wang Z F.2017b.A deep CNN method for underwater image enhancement//Proceedings of 2017 IEEE International Conference on Image Processing(ICIP).Beijing, China: IEEE: 1382-1386[DOI: 10.1109/ICIP.2017.8296508]

Wang Z, Bovik A C, Sheikh H R and Simoncelli E P.2004.Image quality assessment: from error visibility to structural similarity.IEEE Transactions on Image Processing, 13(4): 600-612[DOI: 10.1109/TIP.2003.819861]

Xie J, Hou G J, Wang G D and Pan Z K.2021.Blind restoration for underwater image based on sparse prior of red channel.Laser and Optoelectronics Progress, 58(16): #1610014(谢骏, 侯国家, 王国栋, 潘振宽.2021.基于红通道稀疏先验的水下图像盲复原.激光与光电子学进展, 58(16): #1610014)[DOI: 10.3788/LOP202158.1610014]

Yang M and Sowmya A.2015.An underwater color image quality evaluation metric.IEEE Transactions on Image Processing, 24(12): 6062-6071[DOI: 10.1109/TIP.2015.2491020]

Zhang S, Wang T, Dong J Y and Yu H.2017.Underwater image enhancement via extended multi-scale Retinex.Neurocomputing, 245: 1-9[DOI: 10.1016/j.neucom.2017.03.029]

Zuiderveld K.1994.Contrast limited adaptive histogram equalization//Graphics Gems IV.USA: Academic Press Professional: 474-485[DOI: 10.5555/180895.180940]