改进融合策略下透明度引导的逆光图像增强

赵明华,程丹妮,都双丽,胡静,石程,石争浩

1.西安理工大学计算机科学与工程学院, 西安 710048;2.陕西省网络计算与安全技术重点实验室, 西安 710048

0 引 言

科技的快速发展,引领人类生活智能化的不断进步,图像处理在社会的各个角落都发挥着至关重要的作用。目前,大多数由恶劣天气引起的低质图像增强方法都致力于低照度图像(Yang等,2021;Xu等,2020)和雨雾图像(Ju等,2021;袁非牛 等,2021)的研究。而逆光图像与低照度图像有着十分明显且重要的不同:后者像素灰度值较低且分布较为集中,而逆光图像不仅存在光照不足的区域,还存在曝光正常的区域,且灰度范围分布较为广泛,如图1所示。若通过增强相机曝光来显示曝光不足区域的信息,那么曝光良好的区域就会曝光过度甚至饱和。此外,由于制作成对的逆光图像数据集十分困难,而深度学习的方法需要大量的图像数据来训练网络模型,对硬件要求较高且比较耗时,目前还没有将深度学习应用于逆光图像增强的技术。因此,在保持曝光正常区域亮度不变的前提下对图像中的逆光区域进行增强,具有十分重要的研究意义(Trongtirakul等,2020)。

图1 逆光图像与正常光照图像、低照度图像的对比

早期传统的图像增强方法主要分为全局增强和局部增强。其中,全局增强方法,如直方图均衡化(histogram equalization, HE)(Zhu等,2015)和灰度变换(满乐 等,2017),也称为单调映射方法,能在一定程度上消除光照较暗导致的区域不可见问题。但逆光图像的灰度分布极不均匀,应用此类增强技术会产生图像对比度失真,局部细节丢失和增强效果不足等问题。局部增强方法,如基于直方图均衡化的改进算法和基于Retinex理论的增强算法,前者包含对比度受限的自适应直方图均衡化(contrast limited adaptive histogram equalization,CLAHE)(Chang等,2018)、局部直方图修正算法(local histogram modification algorithm,LHMA)(Lisani,2018)等,通过计算图像块的局部直方图,对像素灰度值进行重新分布改变图像的对比度。后者包括单尺度Reintex(single-scale Retinex,SSR)(Jobson等,1997a)、多尺度Retinex(multi-scale Retinex,MSR)(Jobson等,1997b)等,该类算法基于Retinex模型,先从原始图像中估计出光照图像,进而算出反射率图像,消除弱光照的影响得到增强后的图像。由于能针对性地适应不同的局部灰度值分布,局部增强方法对逆光图像的增强效果要比全局增强方法更好,但仍存在无法同时保留细节和颜色信息,易在曝光正常区域产生光晕和伪影等问题(Wang等,2019;Buades等,2020)。

上述方法忽略了逆光与非逆光区域的亮度分布问题,直接用于恢复逆光图像会导致局部增强过度。因此研究者们针对该问题提出了一系列算法,大致从两个角度出发。其一是采用融合方法,Wang等人(2016)将图像中的多尺度特征融合为单一特征,并引入权值映射来增强图像的可见性。Buades等人(2020)对输入图像的各个通道分别应用多个色调映射函数,再将其结果融合,并使用锐化算法和色度校正进行后处理。虽然该类方法能保留曝光正常区域的细节信息,但在光照过低的区域存在增强不足的问题。另一类方法从分割的角度出发,对逆光图像中的逆光前景和其他背景进行划分,然后分别应用不同的色调映射函数再融合。Trongtirakul等人(2020)将图像转为亮度图,计算阈值并将其分解为逆光区域和普通区域。Li和Wu(2018)通过监督学习构建的软二值分类器检测逆光区域与其余部分。Li等人(2015)使用由高斯混合模型驱动的软二值分割过程对逆光区域和过度曝光区域进行识别。这类方法依赖于阈值计算的准确性或分类、分割的精确度,具有一定的局限性。

针对上述不足,本文引入了具有高分割精度的抠图模型来检测和识别逆光区域。首先通过基于拉普拉斯金字塔的改进融合策略对图像的亮度分量进行增强,同时将单幅逆光图像输入到深度抠图网络中计算精确透明度值,用于后续的线性融合。本文方法不仅有效地提升了图像的亮度和对比度,恢复了图像的细节和颜色信息,同时也解决了曝光过度和增强不足等问题。

1 相关理论

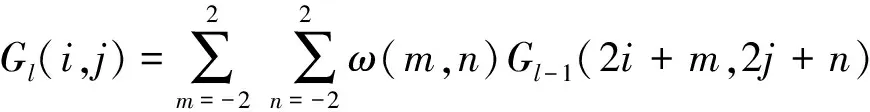

1.1 金字塔融合

图像金字塔通过压缩图像降低尺寸,由高分辨率到低分辨率依下而上有序排列,将图像呈现出一种金字塔式的结构(Ancuti等,2018)。高斯金字塔的每层均使用高斯低通滤波器处理图像,输入的第1层为原始图像,在水平和垂直两个方向上将输入图像削减两倍,并将削减后的低通图像作为后续金字塔等级的输入。计算为

1≤l≤N,0≤i≤Rl,0≤j≤Cl

(1)

式中,N为层数,Rl和Cl分别为l层的行数和列数,Gl是高斯金字塔的l层,ω是5×5的高斯核,表示为

(2)

拉普拉斯金字塔是在高斯金字塔的基础上生成的,由高斯金字塔某层与其上层图像经过上采样处理的结果之差计算而来。

(3)

金字塔融合算法是将所有待融合图像进行拉普拉斯金字塔分解,然后将其同一层按一定规则进行融合,得到一个新的金字塔,再对其进行重构,得到最终的融合图像。

1.2 图像抠图

图像抠图是把图像分解为前景层和背景层(Hou和Liu,2019),为一个线性组合下的图像合成方程,即

I=αF+(1-α)B

(4)

式中,I是给定像素的颜色,F是未知的前景色,B为未知背景色,α为未知的透明度。抠图过程从图像开始,尝试计算其透明度,以此来提取前景。然而,对于每一个像素,这是一个包含7个未知量和3个已知量的难题。传统抠图方法如贝叶斯抠图(Chuang等,2001)、K邻近抠图(Chen等,2013)等技术的主要局限性是将颜色视为一个可区分的特征,当图像前景与背景的颜色重叠时,这种抠图方法的效果就不尽人意(Boda和Pandya,2018)。而基于深度学习的抠图方法可以学习图像的自然结构,将其反映到透明度蒙版上,不主要依赖于色彩信息。本文将图像中的逆光区域视为前景,采用有效的深度抠图模型精确检测出图像中的逆光区域,在一定程度上解决曝光过度的问题,改善增强效果。

2 本文逆光图像增强方法

2.1 算法流程

逆光图像增强面临的重要难题就是无法有效地区分逆光区域与非逆光区域,易产生增强不足和曝光过度的问题。为此,提出一种改进融合策略下透明度引导的逆光图像增强算法,既在保持曝光良好区域亮度不变的情况下增强了逆光区,又大大恢复了图像的亮度和细节。算法流程如图2所示。算法主要步骤如下:

图2 算法流程图

1)将逆光图像转换到HSV空间,提取亮度分量V,对其分别使用改进的自适应对数变换和对比度受限的自适应直方图均衡化进行增强,得到亮度改进的VLOG和对比度改进的VCLAHE。

2)对两个改进的V分量进行拉普拉斯金字塔融合得到V′,使其同时包含二者的有效信息。将V′与原始的色调分量H、饱和度分量S合并,转换到RGB空间得到融合增强图像I′。

3)引入深度抠图模型计算逆光图像的透明度蒙版α,作为权重图进行后续的融合处理。

4)利用透明度蒙版将I′与源图像进行线性融合,得到最终的增强图像。

2.2 改进的金字塔融合策略

对逆光图像的增强实质上是对逆光区域亮度的提升,为了改善因亮度提升引起的对比度下降、细节丢失等问题,提出改进的金字塔融合策略对图像局部区域的亮度与对比度进行增强。

HSV(hue、saturation、value)是一种较为常用的颜色空间,比RGB更加接近于人们对色彩的视觉感知。将图像转换到HSV空间并提取其亮度分量V,针对不同角度进行增强,得到两个改进的V分量。

1)亮度改进的VLOG。通过自适应对数变换可以将V中范围较窄的低灰度值映射到范围较宽的灰度区间,从而提高暗区可视化。具体计算为

VLOG=loga+1(1+a·V)

(5)

式中,a是对数变换因子,其值越大,低灰度提高越明显,其对应的对数变换曲线如图3(a)所示。由于每幅逆光图像的灰度分布都极不均匀,需要进行不同程度的灰度扩展。因此令a的值取决于图像中低灰度值像素的数量,具体为

(6)

式中,N表示输入图像的总像素数,M表示灰度值小于50的像素数(Wang等,2016)。图3展示了两幅不同逆光程度的图像在使用多个不同因子值变换下的增强结果。当源图像中低灰度像素较多时,图像需要更强的拉伸,反之,拉伸强度较弱。如图3(g)上图和下图的自适应因子分别为171.299 3和19.235 4。

图3 不同对数变换因子的增强结果

2)对比度改进的VCLAHE。对比度受限的自适应直方图均衡化(CLAHE)基于块处理来调整图像的灰度直方图分布,将输入图像划分为不重叠的子块,在每个子块内进行直方图均衡化,然后用双线性内插方法将相邻块组合起来。采用CLAHE增强图像的V分量以改善图像的局部对比度,恢复更多的细节信息。MATLAB中adapthisteq函数可用于执行这一操作,其中较高的对比度因子值C(cliplimit)会产生较强的对比度,C值过大会导致过度锐化,图4展示了不同对比度因子的增强效果。经实验对比分析,将对比度因子取值为0.005,用来限制对比度的增强程度,防止图像的同质区域出现过饱和现象。

图4 不同对比度因子的增强结果

对VLOG和VCLAHE进行拉普拉斯金字塔融合得到最终的融合亮度分量V′,具体为

LV′=ω×LLOG+(1-ω)×LCLAHE

(7)

式中,LLOG和LCLAHE分别表示VLOG和VCLAHE的拉普拉斯金字塔,ω为平均权值。图5展示了融合策略的流程。对LV′进行拉普拉斯金字塔重构得到最终的融合亮度分量V′,再将原始的色调分量H、饱和度分量S与改进的V′合并,并转换到RGB空间,得到全局增强图像I′。

图5 改进融合策略的流程图

2.3 透明度蒙版预测

深度抠图网络模型包括两个阶段,网络具体设计参数可参考Xu等人(2017)的方法。第1个阶段是深度卷积编码—译码器网络,该网络的输入是原图和其对应的trimap图,其中trimap图采用描绘边界的方式将图像粗略划分为前景、背景及未知区域,得到与原图大小一致的预测透明度蒙版。

该网络使用了两个损失函数,一个是透明度预测损失,另一个是合成损失。透明度预测损失定义了真实的透明度值和预测的透明度值在每一个像素位置上的绝对差,计算为

(8)

合成损失是指利用真实透明度值合成的图像与预测透明度值合成的图像进行绝对差的计算,近似表示为

(9)

式中,c为RGB通道,p为预测透明度蒙版合成的图像,g为真实透明度蒙版合成的图像。合成损失约束网络的合成操作,从而得到更准确的透明度蒙版预测结果。两个损失的加权总和为总损失,即

(10)

式中,如果像素i在trimap中的未知区域内,ωl=1,否则ωl为0。

上述网络得到的结果通常过于平滑,因此加入第2阶段的网络进一步细化结果。细化网络的输入是原始逆光图像和经过编码—译码器网络输出的预测透明度蒙版。深度抠图与其他逆光图像增强研究中采用的分割方法相比而言,前者在分割的精度上更加精确,其透明度取值为[0,1],因此存在自然的过渡区域,而后者结果并不理想,如图6中红色框所示,因此引入深度抠图模型对逆光图像中曝光不足区域进行分割,使最终的增强结果更加自然。

图6 不同方法对逆光区域检测和分割的结果

Iout=α×I+(1-α)×I′

(11)

式中,α为使用深度抠图模型得到的透明度值,I为输入的逆光图像。图7展示了采用透明度蒙版进行线性融合的实验结果。从中可以看出,经过改进金字塔融合策略增强的图7(c)在背景的森林处被过度增强,失去了对比度。而引入透明度蒙版后,非逆光区域像素值被源图像中对应区域的像素值代替,使曝光正常区域的亮度保持不变,避免了上述问题,证明其有效性。

图7 用透明度蒙版进行线性融合的结果

3 实验结果及分析

实验的运行环境为Lenovo PC端,Corei5-8250U CPU,8 GB内存,操作系统与运行平台为Windows 10、MATLAB R2016b和PyCharm 2020。实验是在目前唯一公开且通用的逆光图像数据集(Li和Wu,2018)的基础上扩充后进行测试的,原数据集有38幅逆光图像,最终测试数据集共包含112幅,其中从Caltech Faces 1999 Dataset、TM-DIED和Brightening数据集(Wei等,2018)中分别获取了12幅(896×592像素)、33幅(800×600像素)和29幅(384×384像素)逆光图像。为验证本文方法的有效性,从主观视觉评价和客观质量评价指标两方面将本文方法与现有的其他方法进行比较,包括经典的直方图均衡化(HE)、多尺度Retinex(MSR)、零参考深度曲线估计(zero-reference deep curve estimation, Zero-DCE)、注意引导微光图像增强(attention guided low-light image enhancement, AGLLNet)和基于分类学习的方法(learning-based restoration, LBR)。

3.1 主观评价

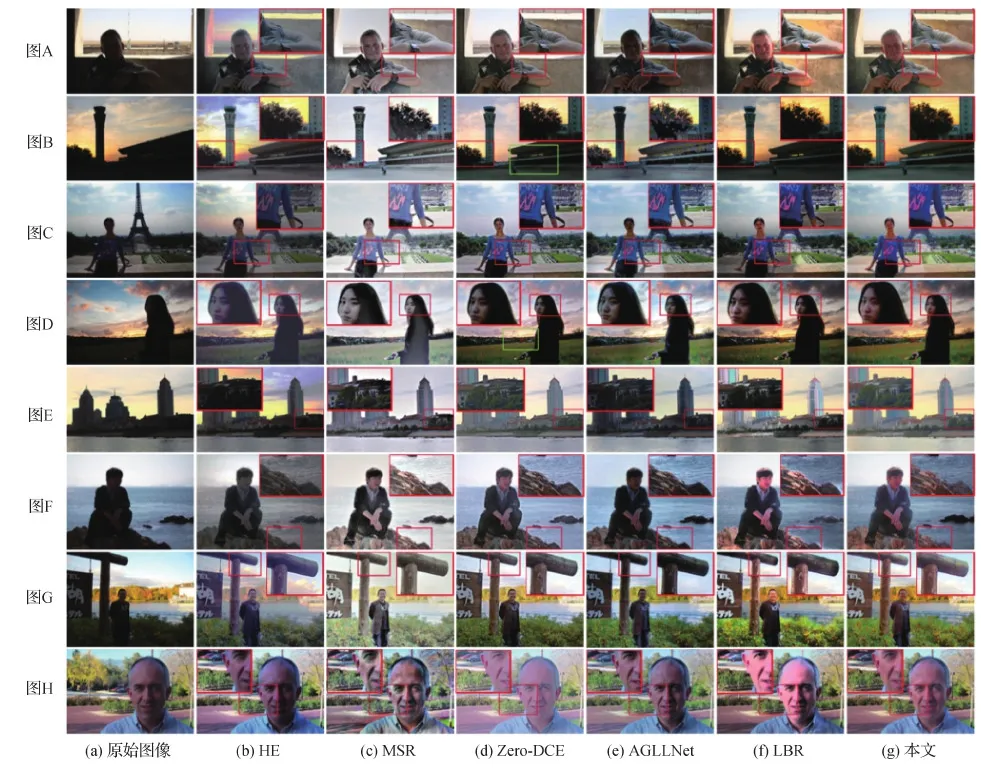

图8是多幅逆光图像在不同方法上增强的实验对比结果。从图8(b)中的图A、图B和图E可以看出,HE方法使逆光区域亮度明显提高,但出现了颜色扭曲,并在非逆光区产生严重的光晕现象,这是由于输出图像的平均亮度被拉伸到灰度范围的中间值,从而丢失了原始图像的亮度信息。图8(c)显示MSR方法以失去对比度为代价提升了图像整体亮度,由于算法在增强过程中对颜色通道分别进行处理,使图像颜色信息丢失,整体偏灰白色。使用Zero-DCE(Guo等,2020)恢复的图像色彩饱和度较低,绿色框还展示了增强不足和饱和度失真的现象。AGLLNet(Lyu等,2021)使用大量合成的低照度图像训练网络,使增强图像在非逆光区域产生曝光过度,如图8中图B和图D放大区域存在明显伪影。LBR(Li和Wu,2018)解决了逆光区域不可见问题,但受到分割精度的影响,导致区域连接边界失真,如图A和图G中的颜色失真,图B中树枝和图F中石头的边缘伪影。与上述5种方法相比,本文方法增强结果同时恢复了图像的细节和颜色信息,避免产生伪影且视觉效果更为自然。

图8 不同算法的增强效果图

3.2 客观评价

由于真实逆光图像没有可参考的标准图像,为了更客观地验证本文方法的有效性,实验采用信息熵(information entropy, IE)(Roberts等,2008)、盲图像质量指标(blind image quality indicators,BIQI)(Moorthy和Bovik,2010)和自然图像质量评价(natural image quality evaluation, NIQE)(Mittal等,2013)等无参考质量评价指标及处理时间对本文方法与其他方法进行比较分析。IE可用来衡量图像信息的丰富程度,值越大表明图像中信息越丰富,图像质量越高。BIQI是一种基于自然场景统计NSS(natural scene statistics)的无参考图像质量评估框架,对图像的退化率进行辨识,值越小说明图像质量越好。NIQE是将图像与设计的自然图像模型进行比较,数值越低说明图像清晰度越高。

实验对数据集中的112幅逆光图像进行评估,将本文方法与其他5种方法的结果进行比较,如表1所示。可以看出,本文方法在IE、BIQI上均获得了最优值,分别比AGLLNet提高了0.137、3.153,在NIQE指标上有较优表现,比Zero-DCE提高了0.133。说明本文方法的信息丰富度较高,失真度低且清晰度较好。关于处理时间,HE和MSR为传统的像素级处理方法,算法复杂度较低。而Zero-DCE是一个轻量级模型,且借助了GPU的加速计算,处理速度较快。AGLLNet具有包含4个深层网络的复杂结构,LBR算法复杂度较高且未经优化,因此运行时间较长。

表1 不同算法的客观评价结果比较

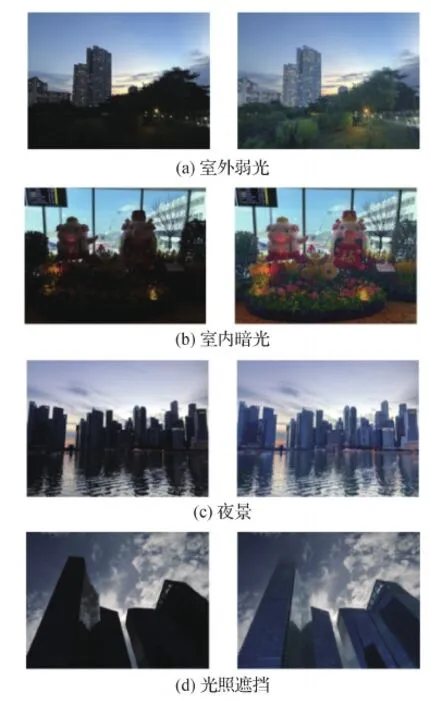

此外,本文方法也可用于光线不足条件下拍摄的局部区域曝光不足图像。比如在夜晚无路灯处(图9(a))、室内光线较暗(图9(b))及受到高建筑物遮挡(图9(d))等条件下拍摄的特殊弱光图像,由于这类图像与逆光图像具备相同特性,本文方法也可对此类图像进行增强,处理结果如图9所示。

图9 对不同特殊光照图像的增强结果

4 结 论

逆光图像增强的主要任务和难题是对逆光区域进行划分和增强,将图像中的逆光区域视为前景,曝光正常区域视为背景,提出了一种改进融合策略下透明度引导的逆光图像增强方法。首先对输入图像的亮度图进行自适应灰度拉伸与对比度提升,通过拉普拉斯金字塔重构同时增强逆光区域的细节和颜色信息;其次利用抠图模型计算输入图像的透明度蒙版;最后对全局增强图像与源图像进行透明度引导的融合处理。实验结果表明,该算法既有效增强了逆光图像又避免了局部曝光过度的问题。相较于传统的HE、MSR方法,深度学习方法Zero-DCE、AGLLNet以及基于分类学习的LBR,本文方法的图像视觉效果更好,避免了颜色失真、光晕和伪影等现象,在IE、BIQI、NIQE等客观质量评价指标上也都取得了较优值。

本文方法从逆光图像灰度分布的特点出发,利用亮度融合策略提升图像的清晰度和对比度,引入抠图模型进行透明度预测,但对于处理复杂场景条件下的逆光图像存在时间复杂度较高、效果欠佳等问题。未来的研究将考虑融入图像结构特征的检测与提取,并探索区域间亮度相关的逆光图像增强方法。

参考文献(References)

Ancuti C O, Ancuti C, De Vleeschouwer C and Bekaert P.2018.Color balance and fusion for underwater image enhancement.IEEE Transactions on Image Processing, 27(1): 379-393[DOI: 10.1109/TIP.2017.2759252]

Boda J and Pandya D.2018.A survey on image matting techniques//Proceedings of 2018 International Conference on Communication and Signal Processing.Chennai, India: IEEE: 765-770[DOI: 10.1109/ICCSP.2018.8523834]

Buades A, Lisani J L, Petro A B and Sbert C.2020.Backlit images enhancement using global tone mappings and image fusion.IET Image Processing, 14(2): 211-219[DOI: 10.1049/iet-ipr.2019.0814]

Chang Y K, Jung C, Ke P, Song H and Hwang J.2018.Automatic contrast limited adaptive histogram equalization with dual gamma correction.IEEE Access, 6: 11782-11792[DOI: 10.1109/ACCESS.2018.2797872]

Chen Q F, Li D Z Y and Tang C K.2013.KNN matting.IEEE Transactions on Pattern Analysis and Machine Intelligence, 35(9): 2175-2188[DOI: 10.1109/TPAMI.2013.18]

Chuang Y Y, Curless B, Salesin D H and Szeliski R.2001.A Bayesian approach to digital matting//Proceedings of 2001 IEEE Computer Society Conference on Computer Vision and Pattern Recognition.Kauai, USA: IEEE: 264-271[DOI: 10.1109/CVPR.2001.990970]

Guo C L, Li C Y, Guo J C, Loy C C, Hou J H, Kwong S and Cong R M.2020.Zero-reference deep curve estimation for low-light image enhancement//Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Seattle, USA: IEEE: 1777-1786[DOI: 10.1109/CVPR42600.2020.00185]

Hou Q Q and Liu F.2019.Context-aware image matting for simultaneous foreground and alpha estimation//Proceedings of 2019 IEEE/CVF International Conference on Computer Vision.Seoul, Korea(South): IEEE: 4129-4138[DOI: 10.1109/ICCV.2019.00423]

Jobson D J, Rahman Z and Woodell G A.1997a.Properties and performance of a center/surround Retinex.IEEE Transactions on Image Processing, 6(3): 451-462[DOI: 10.1109/83.557356]

Jobson D J, Rahman Z and Woodell G A.1997b.A multiscale Retinex for bridging the gap between color images and the human observation of scenes.IEEE Transactions on Image Processing, 6(7): 965-976[DOI: 10.1109/83.597272]

Ju M Y, Ding C, Ren W Q, Yang Y, Zhang D Y and Guo Y J.2021.IDE: image Dehazing and exposure using an enhanced atmospheric scattering model.IEEE Transactions on Image Processing, 30: 2180-2192[DOI: 10.1109/TIP.2021.3050643]

Li Z H, Cheng K and Wu X L.2015.Soft binary segmentation-based backlit image enhancement//Proceedings of the 17th IEEE International Workshop on Multimedia Signal Processing.Xiamen, China: IEEE: 1-5[DOI: 10.1109/MMSP.2015.7340808]

Li Z H and Wu X L.2018.Learning-based restoration of backlit images.IEEE Transactions on Image Processing, 27(2): 976-986[DOI: 10.1109/TIP.2017.2771142]

Lisani J L.2018.An analysis and implementation of the shape preserving local histogram modification algorithm.Image Processing on Line, 8: 408-434[DOI: 10.5201/ipol.2018.236]

Lyu F F, Li Y and Lu F.2021.Attention guided low-light image enhancement with a large scale low-light simulation dataset.International Journal of Computer Vision, 129(7): 2175-2193[DOI: 10.1007/s11263-021-01466-8]

Man L, Zhao Y and Wang H X.2017.Improved nonlinear brightness-lifting model for restoring backlight images.Journal of Computer Applications, 37(2): 564-568(满乐, 赵钰, 王好贤.2017.改进非线性亮度提升模型的逆光图像恢复.计算机应用, 37(2): 564-568)[DOI: 10.11772/j.issn.1001-9081.2017.02.0564]

Mittal A, Soundararajan R and Bovik A C.2013.Making a “Completely Blind” image quality analyzer.IEEE Signal Processing Letters, 20(3): 209-212[DOI: 10.1109/LSP.2012.2227726]

Moorthy A K and Bovik A C.2010.A two-step framework for constructing blind image quality indices.IEEE Signal Processing Letters, 17(5): 513-516[DOI: 10.1109/LSP.2010.2043888]

Roberts J W, van Aardt J A and Ahmed F B.2008.Assessment of image fusion procedures using entropy, image quality, and multispectral classification.Journal of Applied Remote Sensing, 2(1): #023522[DOI: 10.1117/1.2945910]

Trongtirakul T, Chiracharit W and Agaian S S.2020.Single backlit image enhancement.IEEE Access, 8: 71940-71950[DOI: 10.1109/ACCESS.2020.2987256]

Wang Q H, Fu X Y, Zhang X P and Ding X H.2016.A fusion-based method for single backlit image enhancement//Proceedings of 2016 IEEE International Conference on Image Processing.Phoenix, USA: IEEE: 4077-4081[DOI: 10.1109/ICIP.2016.7533126]

Wang R X, Zhang Q, Fu C W, Shen X Y, Zheng W S and Jia J Y.2019.Underexposed photo enhancement using deep illumination estimation//Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Long Beach, USA: IEEE: 6842-6850[DOI: 10.1109/CVPR.2019.00701]

Wei C, Wang W J, Yang W H and Liu J Y.2018.Deep Retinex decomposition for low-light enhancement[EB/OL].[2021-08-24].https://arxiv.org/pdf/1808.04560.pdf

Xu K, Yang X, Yin B C and Lau R W H.2020.Learning to restore low-light images via decomposition-and-enhancement//Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Seattle, USA: IEEE: 2278-2287[DOI: 10.1109/CVPR42600.2020.00235]

Xu N, Price B, Cohen S and Huang T.2017.Deep image matting//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition.Honolulu, USA: IEEE: 311-320[DOI: 10.1109/CVPR.2017.41]

Yang W H, Wang W J, Huang H F, Wang S Q and Liu J Y.2021.Sparse gradient regularized deep Retinex network for robust low-light image enhancement.IEEE Transactions on Image Processing, 30: 2072-2086[DOI: 10.1109/TIP.2021.3050850]

Yuan F N, Li Z Q, Shi J T, Xia X and Li Y.2021.Image defogging algorithm using a two-phase feature extraction strategy.Journal of Image and Graphics, 26(3): 568-580(袁非牛, 李志强, 史劲亭, 夏雪, 李雅.2021.两阶段特征提取策略的图像去雾.中国图象图形学报, 26(3): 568-580)[DOI: 10.11834/jig.200057]

Zhu R, Zhu L and Li D N.2015.Study of color heritage image enhancement algorithms based on histogram equalization.Optik, 126(24): 5665-5667[DOI: 10.1016/j.ijleo.2015.08.169]