《学位法》框架下学位论文撰写中生成式人工智能应用的合规性研究

摘要:以ChatGPT为代表的生成式人工智能(AIGC)极大影响了教育领域,部分学生利用生成式人工智能完成作业甚至学位论文已经成为不可回避的现象,高等教育制度尤其是以学位论文质量为核心评价标准的学位制度面临着严峻挑战。2024年《中华人民共和国学位法》颁布,对学位授予质量及学术不端防范提出了新要求。在《中华人民共和国学位法》框架下加强学位论文写作中人工智能应用的规制具有非常重要的现实意义。生成式人工智能一定程度上突破了工具属性,需要在科技时代对学术不端行为进行重新界定,并借鉴其他领域关于生成式人工智能应用的规制经验,对运用生成式人工智能技术撰写学位论文进行规范。在具体应用中,可以将全文自动生成或超过一定比例自动生成内容的论文视为学术不端行为,判断方式采用技术手段+人工判断标准,并在参考文献、引注等其他应用场景中予以规范,以适应人工智能时代对学位制度和人才培养的需求。

关键词:生成式人工智能;学术不端;学位法;学位论文

作者简介:王霁霞,北京科技大学文法学院教授,北京 100083;刘诗姣,北京科技大学马克思主义学院博士研究生,北京 100083。

科技是人类文明更新迭代发展的根本推动力,科技与教育在近代以来一直有着深度的融合:科技塑造教育的前沿内容、结构及方式,教育则源源不断为科技发展培养人才。在最新一轮的科技革命中,人工智能无疑是其中的关键技术。而以ChatGPT为代表的生成式人工智能(AIGC)的横空出世,更是引发了各个领域的广泛变革。生成式人工智能对教育领域的影响是深刻而全面的,将在科研、教学、师生关系、人机关系等方面改变高等教育生态[1],引发了许多学者的讨论和关注。但生成式人工智能带来的最为直接和严重的冲击是论文写作,尤其是学位论文一直被认为是攻读学位者获得学位的关键要素,而人工智能发展到今天已经几乎拥有了论文写作能力。学位制度是人才培养的基础性制度,2024年通过的《中华人民共和国学位法》(以下简称“《学位法》”)对人才培养质量提出了新要求,在《学位法》框架下探讨学位论文写作中生成式人工智能应用的合规性具有重要的现实意义。生成式人工智能对学位论文现有学术不端审查制度带来了巨大冲击,在学位论文中能否使用、如何使用生成式人工智能技术成为一个亟待解决的问题。是否只要运用人工智能就构成学术不端?是否允许利用人工智能进行数据收集和文献综述?使用到什么程度构成学术不端?我们未来在学位论文的学术规范中如何应对生成式人工智能带来的挑战?这些问题与学位论文伦理规范及我国的学位制度密切相关。在《学位法》新出台的背景下,我们需要对这些问题进行充分探讨,才能为学位制度适应生成式人工智能普遍存在的当下和未来提供参考。

一、在《学位法》框架下加强人工智能应用规制的必要性

(一)《学位法》对学位授予质量及学术不端防范提出的新要求

2024年4月26日全国人大常委会通过、2025年1月1日开始实施的《学位法》总结了《中华人民共和国学位条例》实施四十多年来的成就、经验及不足,对学位授予质量及学术不端防范提出了新要求。

1.《学位法》设专章对学位质量进行规范

提升学位授予质量是《学位法》的重要立法目的之一,《学位法》第六章“学位质量保障”通过规定学位授予单位的职责、研究生导师的职责来确保学位授予质量,并规定了教育行政部门和省级学位委员会的学位授权点评估职责,对不能保证所授学位质量的责令限期整改,情节严重的可撤销学位授予资格。这些立法内容体现了《学位法》通过明确教育行政部门、学位委员会、学位授予单位、导师等几个层面主体的职责,来确保学位授予质量。

2.《学位法》对防范学术不端行为提出了明确要求

《学位法》第37条第1款规定,“学位申请人、学位获得者在攻读该学位过程中有下列情形之一的,经学位评定委员会决议,学位授予单位不授予学位或者撤销学位:(一)学位论文或者实践成果被认定为存在代写、剽窃、伪造等学术不端行为”。这一规定将学术不端行为作为不授予学位或撤销学位的法定理由,突出了《学位法》对学术不端行为的零容忍。

3.《学位法》对生成式人工智能等前沿问题的规制体现了包容审慎的态度

在《学位法》制定起草过程中,2023年8月审议中的《学位法(草案)》直接规定了利用人工智能代写学位论文属于学术不端行为并可以撤销学位[2]。但在《学位法》正式通过的法律文本中,原草案中的“利用人工智能代写学位论文”变成了“代写”,这一变化体现了《学位法》对生成式人工智能等前沿问题进行规制的包容审慎态度。一方面,我们需要培养掌握前沿知识和技术的人才,与科技的深度融合是基本趋势。在百年未有之大变局的当下,人工智能技术发展是推动大国博弈的新边疆,在国际权力格局的重组中发挥着重要作用[3],人工智能技术与专业培养的融合就更为重要。另一方面,随着生成式人工智能工具越来越容易为公众所使用,它们正迅速融入各个领域和行业。这迫切需要我们重新制定人工智能教育政策,培养学生掌握和理解这项技术的原理[4],而不是一刀切将其列为禁止行为。在这一背景下,更有必要对生成式人工智能在论文写作中的运用进行规范,对《学位法》关于“代写”这一学术不端行为的内涵进行界定,才能不断适应科技发展对学位制度的要求。

(二)生成式人工智能对学位论文学术不端行为审查带来的挑战

以ChatGPT为代表的生成式人工智能与前一代人工智能相比,最为明显的进步在于人工智能已经具备了相当的自主性。在技术上,生成式人工智能通过模拟大脑的神经元,将人脑中的神经网络移植复制到人工智能中,即人工神经网络(ANN),使人工智能像人一样会思考和创作[5],这种特点重塑了教育的底层逻辑[6],也击穿了对学位论文学术不端行为审查的现有制度和技术。

1.禁止使用生成式人工智能的规范无法在现实中真正禁止学生使用

生成式人工智能一经出现,就引发了人们的担心:学生不仅会利用人工智能生成工具完成作业和课程论文,甚至直接用它来生成学位论文。为此,一些国家、行业和大学,最开始都发布了规定禁止学生使用ChatGPT。如2023年4月1日,意大利数据保护机构出台禁令禁止使用ChatGPT[7]。当然,意大利这一禁令的目的是确保用户,尤其是未成年人的安全和隐私。一些著名大学相继发布禁止学生使用ChatGPT完成作业、论文的规定,如英国包括牛津大学和剑桥大学在内的八所著名大学均规定使用生成式人工智能完成作业论文是学术不端行为[8];澳大利亚一些大学不得不将考试和成绩评价方式改回传统纸笔形式[9]。尽管有这些禁止性规定,但现实中仍然有相当部分学生使用生成式人工智能工具进行论文写作。据一份针对1000名美国大学生的调查数据显示,三分之一的受访大学生使用ChatGPT来完成书面作业和论文,并且其中60%的学生在一半以上的论文作业中使用生成式人工智能[10]。英国最近一项在线调查数据显示,47.3%的剑桥大学的学生使用过ChatGPT来成大学作业和论文,超过五分之一的学生表示他们经常或总是这样[11]。学生之所以在有禁令的情况下仍然使用ChatGPT,重要原因在于很难查实是否使用了ChatGPT。正如大多数受访学生所说,尽管他们知道利用生成式人工智能完成论文属于作弊,但他们仍然会使用,因为大部分学生认为老师和学校并不知道他们使用了该工具[10]。

2.传统的查重方式无法判断学位论文写作是否运用了生成式人工智能

在生成式人工智能出现之前,对抄袭等学术不端行为的判断标准是在文字和内容上是否存在大量重复。但生成式人工智能出现后,人工智能产出作品的逻辑发生了变化:生成式人工智能复制的不再是曾经的作品,而是通过大语言模型(Large Language Model,LLM)学习和训练,掌握了艺术作品的创意与风格,最终只需要一些简单的文本输入,就可以从大语言模型中学到的内容里产生新的创意内容[12]。也就是说,生成式人工智能生成的内容与以往的内容并不重复,由 ChatGPT 生成的高度连贯的文本很难与人类的原创文章区分开来,因此检测抄袭或作弊的传统方法将失去有效性[13]。我们无法用传统的抄袭概念来定义生成式人工智能产出的内容,甚至一些法学学者认为,生成式人工智能产出的内容就是著作权法上的作品,除了缺少人类作者以外,已经拥有了作品的全部要素,应当给予知识产权保护[14]。在这样的逻辑下,传统的认定抄袭的技术手段——查重,就无法判断生成式人工智能是否参与了论文写作,因为其每次生成的内容是不重复的。

3.当前对生成式人工智能参与论文写作的检测技术尚未成熟

虽然目前已有一些识别工具来检测论文内容是否由生成式人工智能完成,如推出了ChatGPT的Open AI自己推出的一款机器与人类写作区别检测软件AI Text Classifier,普林斯顿大学开发了GPTZero软件来识别,但这些检测软件只能检测出疑似人工智能生成的内容,并不能完全确定是否是人工智能生成的内容,同时也存在出错的概率。

(三)对运用生成式人工智能撰写学位论文进行规制的必要性

1.过度使用生成式人工智能可能会造成学生的创新思维和批判思维能力下降

已经有学者指出,我们人类的思维不像机器,而是更优雅、更有创造力,使用语法和语言,与周围的人和事打交道,这是人类属性的一部分[15]。而过度使用生成式人工智能可能会导致学生的写作和批判性思维能力下降,因为他们会更加依赖自动化工具来完成作业和论文[16]。

2.人工智能生成的内容包含一些未经验证的错误信息,存在一定误导学生的可能

ChatGPT等生成式人工智能的使用可能会导致学生学术精神异化、学生隐私安全受到威胁、社会主义核心价值观受冲击等问题[1],因为人工智能自动生成的内容是在海量的信息数据中提炼的,但这些信息并未经过检验。因此,依赖未经检验的大语言模型和信息生成的论文,很可能存在错误,在使用中进一步误导学生,加深错误偏见[15]。基于生成式人工智能的文字生成机制和局限性,联合国教科文组织(UNESCO)于2023年制定出台了《生成式人工智能在教育与研究领域的应用指南》(Guidances for General AI in Education and Research,以下简称“《应用指南》”)。该指南明确指出,除非生成式人工智能的基本模型和方法发生重大变化,否则生成式人工智能仍可能产生错误并显示出其他局限性,因此,作为用户的教师和学习者必须对任何成果采取批判的视角。同时,指南也提到了生成式人工智能的应用是教育与研究领域的重要趋势,培养学生使用人工智能的能力是在教育及其他领域安全、合乎道德和有意义地使用人工智能的关键[17]。

3.生成式人工智能自动生成的论文本质上不会有真正的创新

无论是机器的自我学习,还是人工智能进行大语言模型学习和训练,其生成作品的基本逻辑是通过现有素材的模拟生成新的内容。但这里的新内容是不可能有本质性创新的内容,因为机器学习后生成的内容只能是对现有素材风格的模仿。如人工智能软件可以将任何草图转换为任何已知画家风格的画作,但却无法像人类一样创作出“印象派”等新型风格的画作。生成式人工智能生成的论文也只能是对已往素材的有效整理和形式上的完整输出,但不可能像人一样拥有发现自然和社会规律、进行哲学思考、提出创新理论的能力。生成式人工智能的出现,确实造成了遮蔽与压抑教育中的人、教育活动、教育系统的主体性的弊端[18],也被认为大有取代人类之势,但在思想和真正创新上,生成式人工智能仍然不可能取代人类,因为它无法在人类已有的大语言模型之外生成任何新内容。而培养学生的思考和创新能力,正是教育的根本目标。

二、人工智能时代学术不端行为的界定标准及规制经验

(一)人工智能时代学术不端行为的界定标准

学术不端行为的涵义及界定标准是随着时代的发展而不断变化的,人工智能时代学术不端行为已经有了新的内涵。针对生成式人工智能运用问题,一些香港受访大学生建议:“应当明确规定哪些领域允许使用生成式人工智能技术,哪些不允许,以及使用的后果是什么。”另一位学生提到:“应当明确限制的程度。”受访教师和学生都质疑:“在这个AI时代,作弊的定义是什么?”[4] 以前的学术不端行为更多是指抄袭他人、数据造假、未获科技伦理审查等,但生成式人工智能出现后,人工智能生成的内容是否构成抄袭成为一个迫切需要回答的问题。回答这个问题的关键,在于对生成式人工智能的属性进行界定。生成式人工智能是否已经突破工具属性决定了其生成的内容是否属于通过学术不端行为产生的作品。

生成式人工智能出现以来部分学生对人工智能时代作弊的定义提出了质疑——为什么使用人工智能等同于作弊?ChatGPT就像Office、Excel办公软件、CAD画图工具一样,只是科技不断进步之下人类写作的工具,只要论文的整体框架是自己构思的,为什么不能使用ChatGPT更高效地完成论文呢[4]?

在生成式人工智能出现以前,包括我国在内的大多数国家的法院在审判实践中基本都采用了人工智能工具说,对人工智能辅助完成的作品给予保护,将其视为人类或法人创作的工具。如在“中国AI作品第一案”中,原告腾讯公司通过人工智能软件生成的财经文章被被告使用,法院在判决中认为,利用人工智能软件生成的文章具有原创性,属于著作权法中的作品,著作权归属拥有和使用人工智能软件的公司即原告所有①。

在学位论文写作中,各类统计分析软件和CAD等画图软件一直被视为论文写作的工具,使用这样的工具不会被认为是作弊行为。但生成式人工智能出现以后,其作为工具的定位已经动摇,我们无法纯粹地将其视为人类创作的工具:一方面,人工智能进行或参与创作的逻辑发生了本质性的改变。在生成式人工智能参与下,整个论文的生成过程几乎无需人类过多参与,用户只需要输入最为简单的提示,就可以生成完整的论文或艺术作品[19]。人类的贡献度在生成式人工智能出现后,变得稀薄甚至可以忽略。另一方面,从因果关系和人类的控制力角度看,生成式人工智能已经突破了工具属性。Office、Excel办公软件、CAD画图软件之所以被认为是工具,就在于它们是完全按照人类的意图在实现人类创作的内容,它们本身并不输出和生成创作内容。而生成式人工智能出现后,人类作为用户尽管提示了关键词,但对生成的内容是无法控制的。2023年美国版权局关于卡什塔诺娃(Kashtanova)著作权申请的处理决定引发了全世界的关注。在这个案件中,美国版权局认为卡什塔诺娃运用生成式人工智能辅助完成的漫画,其主要贡献来自人工智能软件,而非申请人,因此驳回了其著作权保护申请。其中,关于创作内容与人类贡献的因果关系阐释得非常清晰:生成式人工智能程序不是作者控制和引导以达到创作目的的工具,在因果关系上,其以不可预测的方式生成作品,无法认定用户与作品之间存在创作与被创作的关系[20]。

因此,生成式人工智能突破了传统的工具属性,由其自动生成的文字内容不应当被视为人类作者创作的作品,内容占比若达到一定比例应当构成学术不端。随着人工智能在教育和评估中的使用越来越普遍,学生必须了解该技术背后的原理,以维护学术诚信,防止作弊行为[4]。我们的教育不能回避人工智能,而是需要全面告知学生人工智能语言模型的产生原理和逻辑,并将其目的和局限性有效地传达给学生[21]。同时,要引导学生公开和诚实地使用生成式人工智能,全面认识和理解人工智能可能产生的伦理和社会影响,防止由于人工智能产生的偏见固化和永久化[22]。

(二)生成式人工智能应用的现有规制

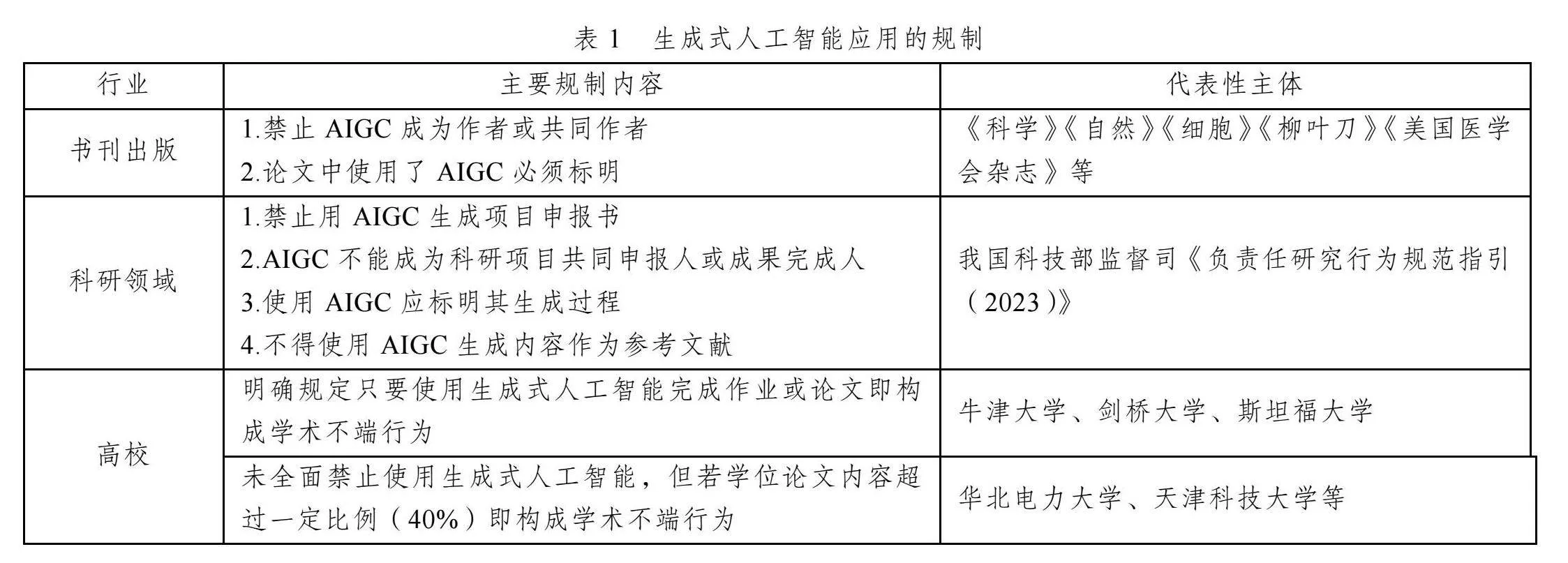

在学位论文的人工智能写作规范尚未成型之前,可以借鉴书刊出版、科学研究等领域对人工智能应用的规制作为参考。

1.书刊出版行业关于生成式人工智能撰写论文的规制方式

书刊出版行业是最早开始对生成式人工智能写作进行规制的领域。与学位论文写作类似,期刊发表与著作出版领域,如果面对的是生成式人工智能完成的论文和著作,还能不能发表呢?对此,《科学》和《自然》等顶级期刊均明确表示,人工智能不能成为合作作者,如果论文中使用了生成式人工智能必须标明[23]。根据《自然》的统计,2023年超过了1万篇学术论文被撤稿,创历史新高[24],人工智能代写成为撤稿的重要原因。如何识别论文中是否存在人工智能生成或代写的内容成为学术期刊迫切需要解决的问题。此外,《细胞》《柳叶刀》《美国医学会杂志》等顶级期刊均发表声明称,人工智能不具有作者资格,并要求使用人工智能的研究人员在稿件中进行说明。

2.科研部门关于生成式人工智能运用的规范

生成式人工智能除了可以自主写作论文,还可以生成课题申报书、课题报告等内容。我国是最早对生成式人工智能运用于科研领域进行规范的国家,2023年,科技部监督司发布的《负责任研究行为规范指引(2023)》中明确规定,不得使用生成式人工智能直接生成申报材料,不得将生成式人工智能列为成果共同完成人。同时,使用生成式人工智能生成的内容,特别是涉及事实和观点等关键内容,应明确标注并说明其生成过程,确保真实准确和尊重他人知识产权[25]。2023年10月,美国总统拜登签署行政命令,推出美国首个针对生成式人工智能的监管规定。但该规定主要是从生成式人工智能的安全性、可靠性角度进行规范,未针对在科学研究与学位论文中如何运用人工智能进行规范。2024年,欧盟通过《人工智能法案》,是第一部对人工智能进行综合规制的法律文件,更多针对的是人工智能的安全性及其监管和治理,也未对写作中如何规范运用人工智能问题进行规定。

3.高校关于生成式人工智能运用的规范

目前,尚未有国家通过法律的形式对生成式人工智能在学位论文写作中的应用进行规范。联合国教科文组织出台的《应用指南》是在教育领域对生成式人工智能进行应用和规范的整体性规定,但没有专门针对学位论文的规范。关于在学位论文写作中应用生成式人工智能的规定更多是在一些高校中进行探索。如一些美国高校要求学生在使用AI工具完成作业或论文时进行说明,并对使用AI的程度加以限制。我国华北电力大学、湖北大学、福州大学、南京工业大学、天津科技大学等多所学校发布规定,明确学校将引入人工智能代写检测技术,抵制人工智能代写论文的行为。

总体来说,对于生成式人工智能运用于论文写作,目前还没有形成统一的规范,处于零散规制阶段,各部门自己制定规制方案和判断标准。不同领域的代表性规范见表1。

三、运用生成式人工智能进行学位论文写作的学术不端行为判断标准

(一)学位论文全文自动生成或大部分内容自动生成的属于学术不端

《学位法》规定了代写学位论文属于学术不端行为并可以撤销学位。此处的代写应当包括人工智能代写,即全文都由人工智能自动生成。这种情形属于学术不端行为,这也是剑桥大学、牛津大学、斯坦福大学等世界知名高校的通行做法。此外,大部分内容由人工智能生成的也应当纳入学术不端行为范围。正如前文所分析,生成式人工智能突破了工具属性,人类在其中的作用显得微不足道,人的提示与最终生成的作品之间因果关系不明显,人工智能工具以随机的方式生成内容,这些都否定了人类作为人工智能生成物的作者身份。因此,学位论文全文自动生成与大部分内容自动生成都属于学术不端行为。

(二)生成式人工智能辅助完成学位论文必须满足公开标注、辅助性等要件才能排除学术不端嫌疑

现实中最为复杂的情形是运用生成式人工智能辅助完成的论文到底构不构成抄袭和学术不端情节。是不是完全不允许我们的学生运用生成式人工智能工具?已有学者分析过完全禁绝生成式人工智能不仅现实上做不到,而且完全将学生挡在这一轮科技浪潮之外,还可能会导致学生无法跟上未来人工智能发展浪潮[15]。因此,让学生了解最新的技术,同时明确生成式人工智能的使用边界,并教育和告知学生人工智能的局限,可能是更为有效的方法。

那么,在论文写作中,生成式人工智能的使用边界在哪里呢?或者说,如果运用生成式人工智能辅助完成论文,需要满足什么条件才能排除学术不端嫌疑?

第一个重要的边界就在于论文的整体框架、主要及核心内容均由学生本人完成,而非人工智能生成。这个判断标准也是法律实践中关于作者与作品贡献力的判断标准。在2023年美国版权局发布的卡什塔诺娃(Kashtanova)漫画案中,美国版权局判断作者是谁的标准即到底是谁生成了作品。该案被认为是生成式人工智能创作物作者身份认定的重要案件,引发了全世界关注。美国版权局认为人工智能软件并不是卡什塔诺娃控制和引导以达到其理想作品的工具,而是以不可预测的方式生成作品,因此,就版权而言,人工智能软件的用户不是该技术生成图像的“作者”。尽管卡什塔诺娃在申请中辩解,其花费了相当多的精力和时间对人工智能生成的图像进行修改、调整,但美国版权局并不认为这些努力构成了作品形成的创造主脑(the inventive or master mind),因而拒绝认可其法律上的作者身份[20]。在论文写作中也是如此,论文的创作主脑必须是学生,论文整体构思、主要内容都是学生自主完成,而不能由人工智能完成。

第二个重要的边界是人工智能辅助完成的类似数据统计等内容必须明确标注。这也是生成式人工智能在使用中必须符合的透明度原则。明确标注的透明度原则已经被《科学》《自然》等期刊采用,目前在出版界,由中国科学技术信息研究所与Elsevier、Springer Nature、Wiley三家国际出版集团共同完成的《学术出版中AIGC使用边界指南》明确要求研究人员使用生成式人工智能(AIGC)必须标明,否则就是学术不端行为[26]。2023年9月,科学界也出现了一起引发广泛关注的因ChatGPT代写而撤稿的SCI论文:由于论文中现了“regenerate response”(重新生成回复)的字样,这个词语表明该论文曾使用过生成式人工智能,而作者在投稿时并未明确披露,后来论文被撤稿[27]。在论文写作中,随着科技的发展,运用人工智能进行数据统计等辅助工作可能会越来越多,但这些辅助内容必须在写作中加以标明,以接受审查,否则将构成学术不端行为。

第三个重要的边界在于人工智能辅助完成的内容必须限定在一定比例范围内。允许在学位论文中使用生成式人工智能进行辅助,就必须对辅助的程度予以限定。达到多大比例的内容应当认定为超越了辅助的限度,是规范生成式人工智能的运用必须明确的内容。从目前各高校规范的比例来看,基本上规定40%以内的比例居多。因此,在探索阶段,可以先按照40%的比例作为辅助的限度予以规范,未来再根据实施的情况进行不断完善和调整。

(三)学术不端的判断方式采用技术识别+人工判断的方式

对人工智能生成内容进行检测,是对人工智能进行规制及识别并防止学术不端行为的重要技术手段。2024年5月,欧盟委员会发布《生成式人工智能透明度:机器生成内容的识别》,重点分析了如何通过技术手段识别出人工智能生成的文字内容[28]。这些不断升级迭代的技术手段,提供了我们识别人工智能生成内容的便捷方式。但在我国现阶段,除了极少数大学外,对学位论文仍然只采用传统“查重”的单一方式进行学术不端行为的识别,这一做法显然已经跟不上时代了。在生成式人工智能大规模运用的当下,有必要在技术手段上以“查重”为基础,增加人工智能生成内容疑似文字检测程序,确保人工智能代写论文的行为被识别并被规制。目前,除了国外的AI Text Classifier和GPTZero等检测软件,国内万方数据公司开发的万方文察[29],知网推出的“AIGC检测服务系统”等,都是用来识别人工智能生成疑似内容的技术软件[30]。这些检测技术的原理是通过还原人工智能生成内容的过程,通过算法可以识别人工智能生成的文章特有的独特模式,总结人工智能生成内容可能具有的逻辑特点和语言特点,从而区分人类和人工智能创作的内容[31]。各学校可以根据自己的学科特点,选择最适合自己学科的检测技术,来识别疑似人工智能生成的内容。

需要注意的是,人工智能生成内容的检测与查重不一样,目前所有检测技术识别出来的只能是疑似内容,并不能完全确定。认定文字内容是否由人工智能生成,必须依靠人工判断。同时,由于检测技术本身具有滞后性,当某种检测技术出来后,就会有反检测人工智能工具出现,未来人工智能疑似写作检测技术需要不断更新。因此,在技术检测的基础上,还需要增加同行专家的判断。这也是许多期刊目前的做法:除了用技术手段检测外,更多需要依靠同行评议来判定到底是否存在机器生成的文字[31]。因为论文是否有创新,最有发言权的是学术同行。真正具有创新性的研究和论文是无法由人工智能自动生成的。因此,需要技术多重手段+同行判断来共同判断学位论文写作中是否存在学术不端行为,确保培养人的创新能力和研究能力。

(四)学位论文中生成式人工智能运用的其他场景及其合规性问题

除了在学位论文正文的写作中应当对生成式人工智能进行规范外,在学位论文写作的其他场景中也需要对人工智能使用的合规性进行规范,主要包括:①不应当把生成式人工智能的内容作为参考文献来源,也不应当直接使用未经核实的由生成式人工智能生成的参考文献。生成式人工智能在数据抓取和整理方面具有大语言模型的优势,但这些自动生成的内容不能作为参考文献,以防止算法的偏见、偏差造成论文写作中文献依据的偏差。②对其他作者已标注为人工智能生成内容的,一般不应作为原始文献引用。③在使用生成式人工智能生成的内容时,尤其涉及他人观点的引用时,应明确标注并说明其生成过程,确保真实准确和尊重他人知识产权。

参考文献

[1] 周洪宇, 常顺利. 生成式人工智能嵌入高等教育的未来图景、潜在风险及其治理[J]. 现代教育管理, 2023(11): 1-12.

[2] 王金虎. 学位法草案提交审议: 用人工智能代写论文等学术不端或被撤销学位[N]. 光明日报, 2023-08-29(4).

[3] 余南平, 张翌然. ChatGPT/生成式人工智能对教育的影响: 大国博弈新边疆[J]. 华东师范大学学报(教育科学版), 2023(7): 15-25.

[4] CHAN C K Y. Comprehensive AI policy education framework for university teaching and learning[J]. International journal of educational technology in higher education, 2023, 20: 1-25.

[5] HARGREAVES S. Words are flowing out like endless rain into a paper cup: ChatGPT amp; law school assessments[J]. Legal education review, 2023, 33: 68-105.

[6] 张治. ChatGPT/生成式人工智能重塑教育的底层逻辑和可能路径[J]. 华东师范大学学报(教育科学版), 2023(7): 131-142.

[7] EMILIO F D, BRIEN M O. Artificial intelligence: stop ChatGPT by the Italian SA personal data is collected unlawfully, and no age verification system is in place for children[EB/OL]. (2023-04-01) [2024-08-31]. https://apnews. com/article/chatgpt-ai-data-privacy-italy-66634e4d9ade3c0eb63edab62915066f.

[8] WOOD P. Oxford and Cambridge ban ChatGPT over plagiarism fear[EB/OL]. (2023-02-28) [2024-08-31]. https://www. universityworldnews.com/post.php?story=20230304105854982.

[9] GOODALL R. Australian universities to return to ‘pen and paper’ exams after student AI use[EB/OL]. (2023-01-31) [2024-08-31]. https://www.theguardian.com/australia-news/ 2023/jan/10/universities-to-return-o-penand-paper-exams-after-students-caught-using-ai-to-write-essays.

[10] Intelligent. Nearly 1 in 3 college students have used ChatGPT on written assignments[EB/OL]. (2023-01-23) [2024-08-31]. https://www.intelligent.com/nearly-1-in-3-college-students-have-used-chatgpt-on-written-assignments/.

[11] HENNESSEY M. Exclusive: almost half of Cambridge students have used ChatGPT to complete university work [EB/OL]. (2023-04-21) [2024-08-31]. https://www.varsity.co. uk/news/25463.

[12] ALHADEFF J, CUENE C, REAL D M. Limits of algorithmic fair use[J]. Washington journal of law, technology amp; arts, 2024, 19(1): 1-53.

[13] PERKINS M. Academic integrity considerations of AI large language models in the post-pandemic era: ChatGPT and beyond[J]. Journal of university teaching and learning practice, 2023, 20(2): 7-24.

[14] 冯晓青, 李可. 人工智能生成内容在著作权客体中的地位[J]. 武陵学刊, 2023, 48(6): 46-55,66.

[15] COLTRI M A. The ethical dilemma with Open AI ChatGPT: is it right or wrong to prohibit it?[J]. Athens journal of law, 2024, 10(1): 121-132.

[16] CIVIL B. ChatGPT can hinder students’ critical thinking skills: artificial intelligence is changing how students learn to write[EB/OL]. (2023-03-17) [2024-08-31]. https://www. queensjournal.ca/chatgpt-can-hinder-students-critical-thinking-skills/.

[17] UNESCO. Guidance for generative AI in education and research[EB/OL]. (2023-09-07) [2024-03-12]. https://www. unesco.org/en/articles/guidance-generative-ai-education-and-research.

[18] 张黎, 周霖, 赵磊磊. 生成式人工智能教育应用风险及其规避——基于教育主体性视角[J]. 开放教育研究, 2023(5): 47-53.

[19] PERRITT H H. Copyright for robots?[J]. Indiana law review, 2023, 57(1): 139-198.

[20] United States Copyright Office. Re: Zarya of the dawn [EB/OL]. (2023-02-21) [2024-08-31]. https://www.copyright. gov/docs/zarya-of-the-dawn.pdf.2023-2-21.

[21] SOHAIL S S, FARHAT F, HIMEUR Y, et al. Decoding ChatGPT: a taxonomy of existing research, current challenges, and possible future directions[J]. Journal of King Saud University, computer and information sciences, 2023, 35: 1-23.

[22] 荀渊. ChatGPT/生成式人工智能与高等教育的价值和使命[J].

华东师范大学学报(教育科学版), 2023(7): 56-63.

[23] THORP H H, VINSON V. Change to policy on the use of generative AI and large language models[EB/OL]. (2023-11-07) [2024-08-31]. https://www.science.org/content/blog-post/change- policy-use-generative-ai-and-large-language-models.

[24] NOORDEN V R. More than 10000 research papers were retracted in 2023——a new record[EB/OL]. (2023-01-23) [2024-08-31]. https://www.nature.com/articles/d41586-023- 03974-8.

[25] 中华人民共和国科学技术部. 科技部监督司发布《负责任研究行为规范指引(2023)》[EB/OL]. (2023-10-23) [2024-08-31]. https://www.most.gov.cn/kjbgz/202312/t2023 1221_189240.html.

[26] 中国科学技术信息研究所, 爱思唯尔, 施普林格·自然, 等. 学术出版中AIGC使用边界指南[EB/OL]. (2023-09-22) [2024-08-31]. https://www.istic.ac.cn/html/1/227/243/245/170 1698014446298352.html.

[27] CONROY G. Scientific sleuths spot dishonest ChatGPT use in papers[EB/OL]. (2023-09-08) [2024-08-31]. https://www. nature.com/articles/d41586-023-02477-w.

[28] Generative AI transparency: the identification of machine- generated content[EB/OL]. (2024-05-21) [2024-08-31]. https://publications.jrc.ec.europa.eu/repository/bitstream/JRC137136/JRC137136_01.pdf.

[29] 万方数据. 科技论文诚信风险综合察验服务——万方文察重磅发布[EB/OL]. (2023-09-22) [2024-08-31]. https://cx. wanfangdata.com.cn/cnris/hyzx/20230922/889907624026308608.html.

[30] 清华同方. 同方知网推出AIGC检测服务系统[EB/OL]. (2023-09-19) [2024-08-31]. https://www.thtf.com.cn/detail/ 1876.html.

[31] Charlesworth Author Services. How do journals identify the use of AIGC in papers and what happens when they find out?[EB/OL]. (2023-11-08) [2024-08-31]. https://www. cwauthors.com/article/Use-of-AIGC-in-papers.

(责任编辑" 周玉清)