基于多模态超声图像的深度学习在鉴别诊断肝内胆管细胞癌与肝细胞癌中的应用*

曹佳智 任佑祥 陈科 林江莉 黄河 李加伍 凌文武 罗燕

(1.四川大学华西医院超声医学科,四川 成都 610041; 2.四川大学材料科学与工程学院生物医学工程系,四川 成都 610065)

原发性肝癌严重威胁着人类的生命健康[1],最常见的两种病理类型为肝细胞癌(Hepatocellular carcinoma, HCC)与肝内胆管细胞癌(Intrahepatic cholangiocarcinoma, ICC),分别占原发性肝癌的75%~85%与10%~15%[1-2]。虽然ICC的发病率相对较低,但恶性程度更高,可切除率低,预后极差[3-5],且与HCC的治疗手段存在显著差异。因此,准确鉴别两者对治疗方案的选择及改善预后都很关键。影像学是术前诊断ICC和HCC的首选方法,研究显示超声造影(Contrast-enhancedultrasound, CEUS)、增强CT及MRI对ICC的诊断准确率相似,但有些ICC可表现出同HCC类似的“快进快出”增强影像学特点[6-7],尤其是在慢性肝病背景下的ICC,近一半病例的CEUS特点与HCC类似[8-9],故术前影像学检查对鉴别二者仍有一定的困难。深度学习(Deep learning, DL)的出现为医学图像的识别和分析诊断提供了新的思路,是目前人工智能(Artificial intelligence, AI)领域最受关注和被广泛研究的技术,包括卷积神经网络(Convolution neural network,CNN)、深度信念网络(Deep belief network, DBN)等多种模型,而CNN被认为效果最优。Sarraf等[10]应用CNN来区分正常大脑和患阿尔茨海默病的大脑,显示该模型准确率高达96.85%。Yasaka等[11]基于增强CT的CNN鉴别肝脏良恶性肿瘤的研究显示,其诊断准确性为84%。这些研究均表明基于医学图像的DL能够对疾病进行很好的分类和鉴别。但关于联合多模态超声图像的DL用于ICC及HCC的分类鉴别还罕见报道。因此,本研究在回顾性纳入相对较多的ICC与HCC病例样本基础上,探讨基于单独B-mode图像、CEUS图像、联合B-mode及CEUS图像的不同CNN模型对鉴别诊断ICC与HCC的效能,为其鉴别诊断提供新的思路和方法。

1 资料与方法

1.1 一般资料 回顾性分析2011年1月—2018年5月在四川大学华西医院超声科进行肝脏占位性病变超声检查的病例,最终纳入305例ICC和945例HCC,其中ICC中有205例进行了CEUS检查,所有HCC病例均进行了CEUS检查。采用随机编号的方式从205例ICC和945例HCC病例中各选出50例作为模型测试组,剩下所有病例作为模型训练组。纳入标准(同时满足):①经手术或穿刺活检病理证实为ICC或HCC。②既往肝脏有明确病理诊断信息,如有无肝纤维化或肝硬化等。③基本临床信息完整,包括性别、年龄、HBV及HCV的检测、肿瘤标志物如AFP、CA19-9等。排除标准(满足其中任意一项):①在肝脏超声检查前已进行过肝脏局部或全身治疗的病例,如肝脏部分切除、放化疗、局部消融等。②肝脏超声或CEUS图像缺失。③超声图像模糊或有伪影遮挡,影响图像分析。

1.2 仪器与检查方法 常规超声检查仪器主要包括Philips iU22彩色多普勒超声诊断仪(Royal Philips, the Netherlands),配备C5-1凸阵探头,频率为1~5 MHz,以及L9-3线阵探头,频率为3~9 MHz;Philips HDI 5000彩色多普勒超声诊断仪(Royal Philips, the Netherlands),配备C5-2凸阵探头,频率为2~5 MHz;GE LOGIQ E9 彩色多普勒超声诊断仪(GE Healthcare, Milwaukee, WI),配备C5-1凸阵探头,频率为1~5 MHz;CEUS检查采用的是PhilipsiU22彩色多普勒超声诊断仪及C5-1凸阵探头,配备了CEUS软件。对全肝进行扫查,记录病灶的常规超声表现并存储图像。CEUS检查使用的造影剂为Sono Vue(Bracco,Milano,Italy),使用时现场用5 mL生理盐水配置成微泡混悬液,抽取2.4 mL造影剂经肘静脉快速团注,然后立即用5 mL生理盐水冲管,完成注射的同时开启计数器;对于多发病灶的患者,选取最大病灶作为观察目标,记录相关图像特征,并存储实时的CEUS视频或不同时相的图片,用于后续的脱机分析。根据EFSUMB的CEUS指南,将其分为动脉期(注射造影剂后6~30 s)、门脉期(31~120 s)及延迟期(>120 s)。

1.3 研究流程 研究分为训练阶段和测试阶段。训练阶段主要是构建鉴别诊断ICC与HCC的CNN模型;测试阶段为评估已构建好的模型性能。

1.4 图像预处理

1.4.1 超声图像感兴趣区的标定 对所有超声图像进行肿瘤范围感兴趣区(Region of interest,ROI)标记,所有标记均由一位5年以上和另一位10年以上CEUS检查经验的医师共同协商完成。采用“四点法”进行标定,每个点均距肿块中心最远,且经上述四个点能画出将肿块容纳在内的矩形框,见图1。

图1 肿瘤ROI标定Figure 1 Labeling of liver tumor ROI on the sonogram

1.4.2 超声图像中ROI的截取 进行ROI截取时,其周围留出部分非肿瘤区域,在外周形成一个比肿瘤ROI更大的区域(见图2黄色框所示),且分割线与声像图上肿块之间的距离进行了随机变化,即图中黄色框与蓝色框之间的距离均在肿瘤短径的1/8~3/8内随意变动(见图2)。将截取的图像用于训练及验证模型的研究。

图2 肿瘤ROI截取Figure 2 ROI interception of liver tumor on the sonogram

1.4.3 数据增强 数据增强主要用于训练集的图像数据中,在每次将所截取的超声图像输入CNN前,对图像进行一些随机变换的处理,以增加图像数据量和多样性。数据增强方式主要包括四种:随机翻转、随机旋转、随机亮度、随机对比度。①以随机函数决定是否进行左右翻转(翻转或不翻转)(见图3)。②随机翻转后再行随机旋转处理,以截取的图像中心为轴心,在二维平面上随机旋转,旋转角度范围为-5°至+5°(见图4)。③随机旋转后,对图像进行随机亮度的变换。

图3 图像左右翻转Figure 3 The left and right flip of the image注:A.为正常截取的ICC声像图;B.A图经水平翻转后。

图4 图像随机翻转Figure 4 Random flip of the image注:A.正常截取的ICC声像图;B、C.经随机旋转后的声像图。

上述公式中随机数γ的取值范围为(0.6, 1.4)。所以训练集图像的数据增强过程根据①~④步骤顺序进行,以增加训练集的图像数据量。

1.4.4 对截取后的肝脏超声图像进行统一缩放 将所有截取后的ROI均缩放至224×224,这样可加快网络的收敛(使损失函数越来越小),从而提升网络模型的训练速度。

1.5 CNN基本结构研究 采用的DL模型为CNN,基本结构包括卷积层、激活函数、池化层、全连接层及Softmax层[12]。

1.5.1 卷积层 卷积层的主要作用是提取输入图像中的特征。本研究采用的卷积核大小为3×3,卷积核与原始图像的任何3×3像素矩阵的卷积都遵循离散二维卷积公式[13]:X(i,j)=Σm=0Σn=0A(m,n)*B(i-m,j-n)

X表示卷积结果,A表示卷积核,B表示被卷积矩阵(原始图像),即X00=B00A00+B01A01+B02A02+B10A10+B11A11+B12A12+B20A20+B21A21+B22A22。

1.5.2 激活函数 本研究中采用的激活函数是ReLU,其作用是在卷积层输出的矩阵中正值不变的情况下,将负值归为0,从而抑制了负向取值,有利于增加模型的非线性元素,更好的提取相关特征,进而提高其处理复杂问题的能力。ReLU函数表达为[14]:

1.5.3 池化层输出的卷积特征 经激活函数后与池化层(pooling layer)相连,本研究采用的是最大池化,卷积步长为2。

1.5.4 全连接层和Softmax层 全连接层(Fully-conntected layer,FC)也含有多个神经元,它是以前面所有卷积层、池化层所获得的特征为输入,其特点是该层的每个神经元都与上一层所有神经元相连。Softmax层是神经网络的最后一层,其作用是对CNN所获取的特征进行最终分类,以概率输出[15]。损失函数主要作用是评价模型输出结果与真实标签之间差异的大小,数值越小表示差异越小。本研究采用分类交叉熵作为损失函数,以避免训练时梯度消失的情况。

1.6 构建训练模型

1.6.1 训练的图像数据 在模型训练过程中,训练集及验证集所用图像数据为研究对象中的训练组。 ICC和HCC均按照B-mode、动脉期、门脉期及延迟期分别存入不同文件夹中,然后共同归入训练组,文件夹中以病例为单位进行归类。

1.6.2 CNN模型 CNN模型(Keras框架中集成)包括VGG16[16]、InceptionV3[17]、Inception-ResNet V2[18]、多图VGG及多图Inception共5个CNN模型。

1.7 模型测试及效能评价 测试的图像数据为研究对象中的测试组,即随机选取的50例ICC和50例HCC。模型测试只需要将测试组的图像数据根据训练时的图像组合方式输入到相应的预测模型中即可,然后这些模型分别预测所输入的图像为ICC和HCC的概率,两者概率之和为1,最终以图像预测为ICC的概率作为输出结果。以真实标签为依据,评价不同模型对鉴别测试组中ICC与HCC的诊断效能。

2 结果

2.1 训练组及测试组病例基本信息 模型测试组和模型训练组基本信息,见表1。最终共纳入超声图像7427幅,其中训练组中含有常规超声声像图即B-mode图像2572幅,CEUS动脉期声像图1486幅,门脉期声像图1248幅,延迟期声像图1294幅;测试组中包括B-mode图像302幅,动脉期声像图206幅,门脉期声像图150幅,延迟期声像图169幅,见表2。

表1 训练组及测试组病例基本信息Table 1 Characteristics of patients in the training group and test group

表2 测试组及训练组图像数量分布(单位:幅)Table 2 The distribution of the number of images in the test group and training group

2.2 CNN预测模型鉴别ICC与HCC的诊断效能

2.2.1 基于单独B-mode图像的CNN诊断效能 基于单独B-mode图像的CNN模型鉴别诊断ICC与HCC的效能均不理想,其中VGG16的AUC为0.672,诊断效能稍优于其它两个模型,差异有统计学意义(P<0.05),但这3个模型的特异性都较低,见表3。

表3 基于单独B-mode图像的CNN模型鉴别诊断ICC与HCC的效能Table 3 Diagnostic performance of CNN model based on the B-mode images to discriminate between ICC and HCC

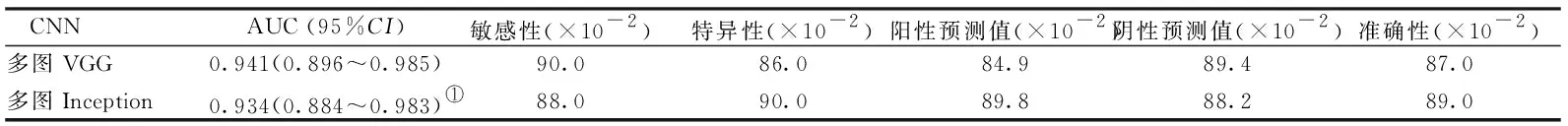

2.2.2 基于CEUS图像的CNN诊断效能 基于CEUS动脉期、门脉期及延迟期图像的两种CNN预测模型对鉴别ICC与HCC的诊断效能都很高,AUC分别为0.941和0.934,两者之间差异无统计学意义(P=0.803),见表4。

表4 基于CEUS图像的CNN模型鉴别诊断ICC与HCC的效能Table 4 Diagnostic performance of CNN model based on the CEUS images to discriminate between ICC and HCC

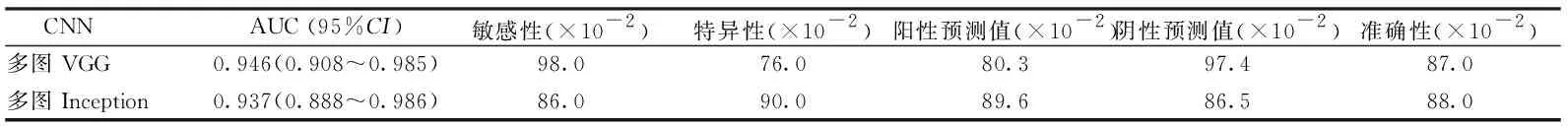

2.2.3 联合B-mode及CEUS图像的CNN诊断效能 联合B-mode及CEUS动脉期、门脉期及延迟期图像的CNN对鉴别ICC与HCC的诊断效能都很高,AUC分别为0.946和0.937,多图VGG模型略优于多图Inception,但两者之间差异无统计学意义(P=0.688),见表5。

表5 联合B-mode及CEUS图像的CNN模型鉴别诊断ICC与HCC的效能Table 5 Diagnostic performance of CNN model combined with B-mode and CEUS images to discriminate ICC and HCC

3 讨论

有研究[20]表明,联合ICC和HCC的常规超声及CEUS相关图像特征,能显著提高对二者的鉴别诊断能力,但很大程度上依赖医师的经验;且由于医学影像数据量庞大,人工筛选远不能满足当前的医疗需求。近年来,基于大数据的DL被广泛用于医学图像处理和疾病诊断方面[21],CNN作为一种DL模型,同样对训练的图像数据量有很高的要求,因为模型内含有大量参数,如果数据量过少会引起过拟合现象,即模型泛化能力差,影响其性能及稳定性[22]。但在实际临床工作中,建立大规模、高质量的医学图像数据库本身就很困难,尤其还要对这些图像进行人工标注。

因此,有研究[23]提出在保持图像真实标签不变的情况下,数据增强是一种提高图像数据量切实可行的方式。目前常用的方法包括旋转、翻转、缩放、平移、裁剪、高斯噪声、模糊处理等[23-27],其主要是源于数字图像处理技术的几何变换和图像增强,被广泛用于生物医学、工程学等领域。本研究采用了随机翻转、随机旋转、随机亮度、随机对比度这四种方式,经过上述数据增强处理后,可以使训练后的模型具有更好的泛化能力和鲁棒性,更适合在实际临床中应用。

目前关于超声图像的DL对肝脏肿瘤的分类诊断研究还很少[28-30],本研究尝试建立基于超声图像的CNN模型来鉴别诊断ICC与HCC,并对其诊断效能进行测试。在单独应用B-mode图像建立的三个模型中,VGG16的诊断效能稍优于InceptionV3 及Inception-ResNetV2,但整体诊断效能均较低,且特异性也很低,尤其是后两者,特异性仅为39.5%和37.0%,表明这些模型容易将HCC误诊为ICC,分析原因可能是ICC和HCC在常规超声图像上本来就有很多相似之处,导致神经网络提取到很多相似的特征,从而不易区分。

CEUS用于鉴别诊断ICC与HCC本身也存在一定争议,故本研究对基于CEUS三个时相所建立的CNN模型鉴别诊断效能也进行了初步探讨,包括多图VGG和多图Inception。结果显示,这两个模型对鉴别ICC与HCC的诊断效能基本相似,AUC分别为0.941和0.934,两者之间差异无统计学意义(P>0.05),其敏感性、特异性及准确性均超过85.0%。Midya A等[31]应用增强CT门脉期图像建立的CNN对ICC与HCC进行鉴别诊断,结果显示其对区分诊断ICC的AUC仅为0.72,准确性为69.7%,明显低于本研究结果,可能与该研究纳入的样本量较小,且仅分析了一个增强时相有关。另外,本研究也显示基于CEUS建立的模型性能明显优于单独B-mode图像所建立的模型,主要原因可能是CEUS多时相图像能够让模型提取到更多的深层次特征,从而提高模型的泛化能力和准确性。

联合B-mode及CEUS图像所建立的多图VGG和多图Inception对鉴别ICC与HCC同样具有很高的诊断效能,AUC分别为0.946和0.937,但与仅基于CEUS图像所建立的模型相比,虽然用于模型训练的图像模式及图像数量明显增加(6600幅vs.4028幅),但模型性能并未显著提高。有学者[13]认为建立模型所需的训练集图像数量可能存在一个界值,在数据量达到这个界值后,模型的性能便趋于稳定,即使再增加训练的数据量,性能也不会显著提高。本研究也存在一定的局限性,首先由于ICC的发生率比HCC低很多,因此纳入的ICC病例相对较少,虽然采用了数据增强的方法,但仍可能对模型的训练有一定的影响;其次,模型的建立未考虑肝脏背景等一些附加信息,然而这些信息可能有助于二者的鉴别;另外,本研究用于验证模型的数据量相对较小,其验证结果可能存在一定的偏倚,有待于多中心、大样本量的前瞻性研究进一步优化模型。

4 结论

本研究结果提示,基于多模态超声图像的CNN模型能较好的鉴别诊断ICC与HCC,为两者的术前鉴别诊断提供了新的参考方法。