基于双参数阈值的蚕茧分割及双宫茧识别研究

蒋昭琼 应婧 王春霞 宋乐见 何清燕 郭鹏 吝祥根 邓立黎

摘要: 针对粘连蚕茧难以准确分割、现有双宫茧识别方法局限性等问题,本文提出了基于双参数阈值的蚕茧分割计数、蚕茧形状复原及双宫茧识别的串联算法。首先,应用可变分割阈值结合形态学运算的方法对图像进行分割计数,再遍历完成分割的每个蚕茧的像素点,应用基于边缘检测与椭圆拟合的蚕茧形状复原方法拟合蚕茧形状,然后计算蚕茧长短轴比值和面积参数,采用双参数多级阈值对双宫茧进行检测。实验结果显示,图像分割计数准确度为100%,双宫茧全部检出,双宫茧与单宫蚕茧分类准确率为98.6%。该方法检出了面积阈值法易漏检的小双宫茧,也较准确地识别出与长短轴比值阈值接近的蚕茧类型。

关键词: 图像分割;双宫茧;计数;分类;算法;阈值

中图分类号: TS143.215

文献标志码: A

文章编号: 1001-7003(2023)04-0018-08

引用页码:

041103

DOI: 10.3969/j.issn.1001-7003.2023.04.003(篇序)

蚕茧原料的质量直接影响生丝质量,在缫丝前应对蚕茧进行分选,剔除无法用于缫丝的下茧。传统的蚕茧分选基本依靠人工视觉进行判别,劳动强度大、选茧效率低、漏选率高,选茧的准确性易受选茧人员的技术水平、精神状态等主观因素影响[1-3]。近年来,随着人工智能的高速发展,机器视觉技术广泛应用于代替人眼进行测量和判定。目前,以蚕茧图像为研究对象开展了一系列研究,包括蚕茧表面积的展开[4]与测量[5-7]、雌雄蚕蛹分类识别[8]、方格蔟蚕茧分割定位[9]与黄斑茧检测[10]、蚕茧表面污斑面积的自动检测[3]、下茧与上车茧的分类识别[1-2,11-13]等,充分展现出机器视觉技术在蚕茧分选领域的应用潜力。在实际应用中,蚕茧的分类识别首先需要解决目标蚕茧的计数问题。黄静等[14]针对二值图像中出现的多个对象相互粘连的情况,应用形态学方法和K-means聚类算法,实现了对蚕茧图像的分割和计数。孙卫红等[15]提出了一种基于凹点定向腐蚀的粘连蚕茧图像分割方法,平均分割准确率为96.2%。古亭等[16]提出了一种基于距离变换的粘连蚕茧分割方法,计数准确率达99%以上。孔繁圣等[17]利用改进的多层次距离变换并结合分水岭的分割算法,计数精度达到99.97%,但该方法在对大小差异大的蚕茧计数时会造成准确率下降。这些方法主要用于分割计数,没有进一步讨论分割后的蚕茧种类识别。

双宫茧是制作蚕丝被的最佳原料,在选茧过程中,要与其他类型下茧分开单独归为一类。目前机器视觉技术中,双宫茧的识别主要有面积阈值法和椭圆长短轴比值阈值法。杜昕等[18]、宋亚杰等[19]通过不同蚕茧图像面积计算方法,利用面积阈值来判断是否为双宫茧。Prasobhkumar等[20]采用椭圆拟合蚕茧形状,计算椭圆的长短轴比值,将比值小于1.426的蚕茧判断为双宫茧。面积阈值法的缺点是较小的双宫茧不能检出。椭圆长短轴比值阈值法则不适用于头尾相连类型的双宫茧,且过度依赖于对蚕茧形状的准确拟合。然而,由于蚕茧形状的轻微不规则、附丝及蚕茧之间的粘连,使得椭圆拟合与实际形状有出入,可能误判在阈值附近的蚕茧种类。因此,仅依靠面积阈值或者拟合的椭圆长短轴比值阈值进行双宫茧识别,均存在一定局限性。针对粘连蚕茧难以准确分割、双宫茧识别局限性等问题,本文提出了基于可变阈值结合形态学运算的蚕茧分割计数、基于边缘检测与椭圆拟合的蚕茧形状复原及基于双参数多级阈值的双宫茧识别算法。

1 方 法

1.1 图像采集

蚕茧图像采集装置由光源、工业相机(海康威视MV-CE200-10UC)、镜头(LOMOSEN ZX-SF3528T)、实验架和计算机构成。在蚕茧分选的视觉系统中,一旦结构固定,每台相机与测试视野之间的距离就不会改变,故本实验采用固定的工业相机与测试台距离,采集蚕茧图像进行分析。

1.2 蚕茧图像分割计数

图像分割方法一般是通过灰度、颜色、纹理和形状等特征对图像进行分割。常见的传统分割方法有基于阈值、边缘、聚类的分割,这些方法在界限分明的目标分割中能又快又好地

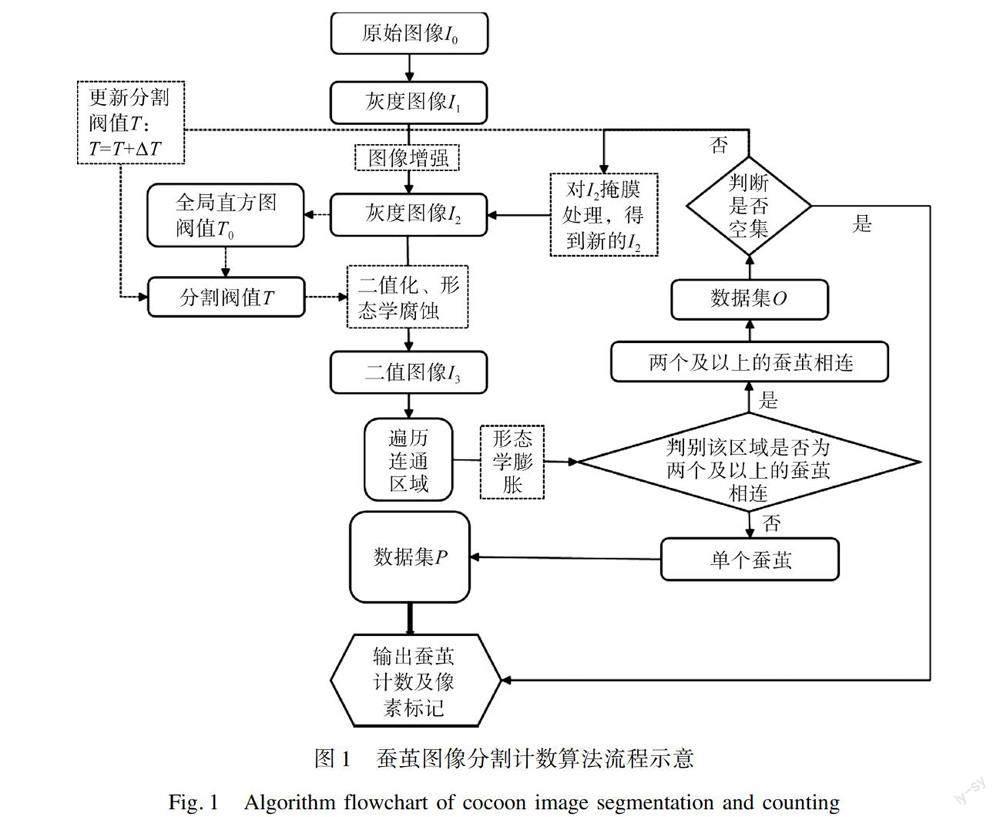

完成分割,但对于光照不均匀、分割对象多、相邻分割对象的边缘灰度相近等情况较难完全分割。由于蚕茧图像中蚕茧分布密集且有附丝干扰,相邻蚕茧边缘灰度相近,传统图像分割方法难以分割完全。为解决直接应用傳统图像分割算法的缺陷,本文提出了一种基于可变分割阈值结合形态学运算的图像分割改进算法,其算法流程如图1所示。

1) 将采集的彩色图像I0转化为灰度图I1,再增加图像对比度I2,然后提取图像全局直方图阈值T0,将其作为初始的图像分割阈值T。

2) 应用分割阈值T对图像I2进行二值化、形态学腐蚀运算,得到二值图I3,去掉I3中面积较小的连通区域,遍历余下的每个连通区域,进行形态学膨胀运算,应用单个蚕茧像素面积阈值S0及长宽阈值L0来判别该区域是否为两个及以上的蚕茧相连。若不是,则该连通区域为单个蚕茧,将该区域像素点进行标记并计数,依次存入数据集P;若是蚕茧相连,则将该区域像素点放入数据集O。

3) 若数据集O非空,对I2进行掩膜处理,使数据集O中像素点为前景,其余像素点为背景,得到新的只包含未分割开的蚕茧的灰度图像I2;更新分割阈值T,新的分割阈值在上一级阈值的基础上增加ΔT,即T=T+ΔT,返回步骤2。

4) 若数据集O为空集,或迭代次数到达上限,则退出循环。

分割好的蚕茧数据集P,由数组p1、p2…pi…pn组成,代表图像中有n个蚕茧,向量pi为第i个蚕茧的像素点。

该算法应用了连通区域的像素面积和连通区域像素点外接矩阵的长边长两个参数,对每个连通区域是否进入下一级分割进行判定。

1.3 单个蚕茧形状复原

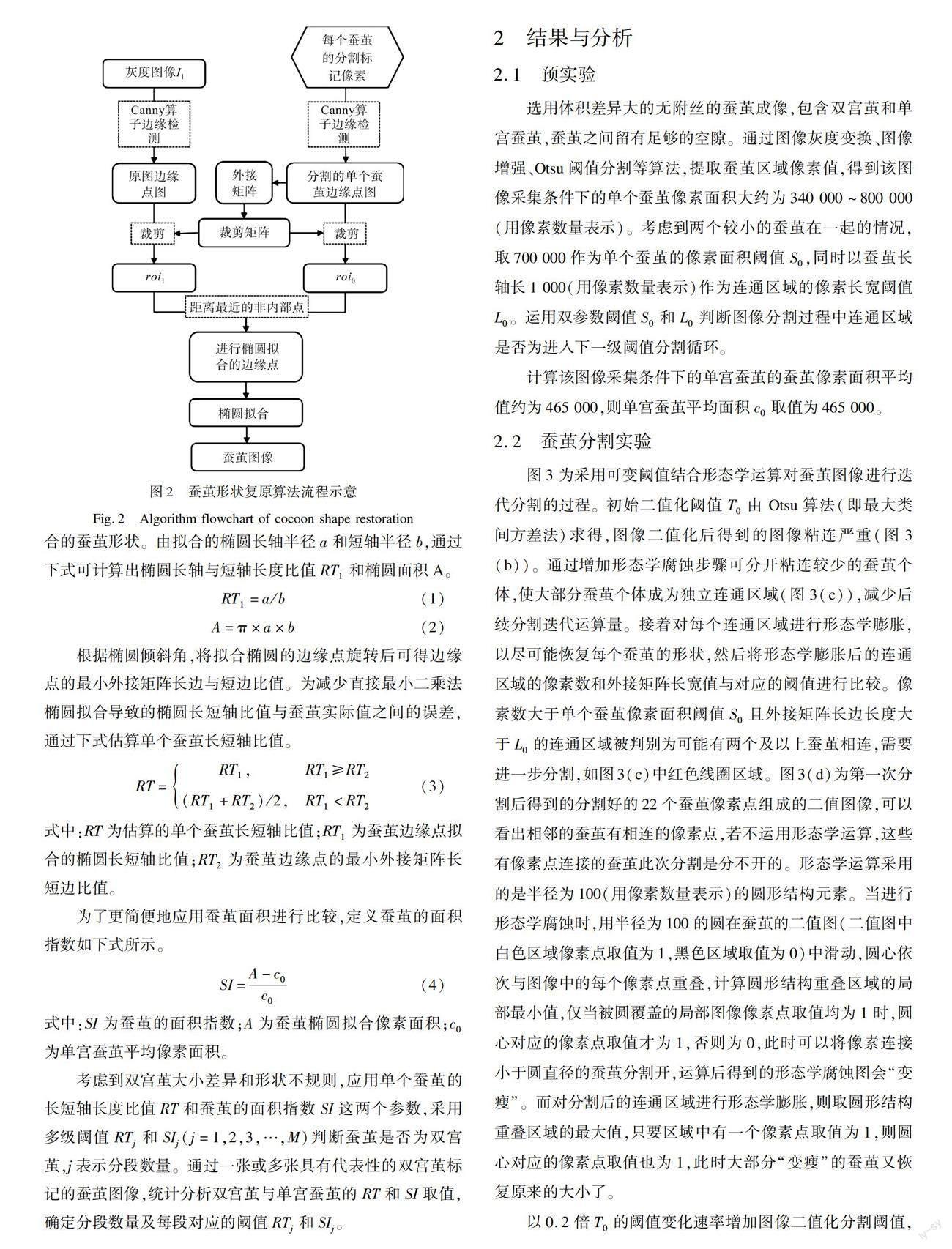

由于高阈值分割导致得到的单个蚕茧图像小于原图像大小,要进一步对每个蚕茧进行分析,需要进行蚕茧形状复原。由此提出基于边缘检测与椭圆拟合的蚕茧形状复原算法:对于每个蚕茧,分割出的像素点组成的图像小于等于实际图像,重叠两图像后,前者在后者的内部;选用合适的标准差和高低阈值,通过Canny算子进行边缘检测;根据像素点真值区域,适当拓宽确定目标区域位置,并进行裁剪,得到两个大小相同的边缘点组成的二值图像roi0和roi1,roi0为分割出的像素点组成的图像边缘检测图,roi1为从原图边缘检测图中裁剪的目标区域;对roi0中的边缘点进行去冗,去掉内部点和多余的轮廓点,以减少运算量;遍历roi0中的邊缘点,在roi1中找到非roi0边缘轮廓区域内的、与该点距离最近的点,由这些点进行椭圆拟合[21],得到该蚕茧的图像(图2)。

1.4 双宫茧的识别

对于每一个蚕茧,经过目标分割、形状复原,得到椭圆拟合的蚕茧形状。由拟合的椭圆长轴半径a和短轴半径b,通过下式可计算出椭圆长轴与短轴长度比值RT1和椭圆面积A。

RT1=a/b(1)

A=π×a×b(2)

根据椭圆倾斜角,将拟合椭圆的边缘点旋转后可得边缘点的最小外接矩阵长边与短边比值。为减少直接最小二乘法椭圆拟合导致的椭圆长短轴比值与蚕茧实际值之间的误差,通过下式估算单个蚕茧长短轴比值。

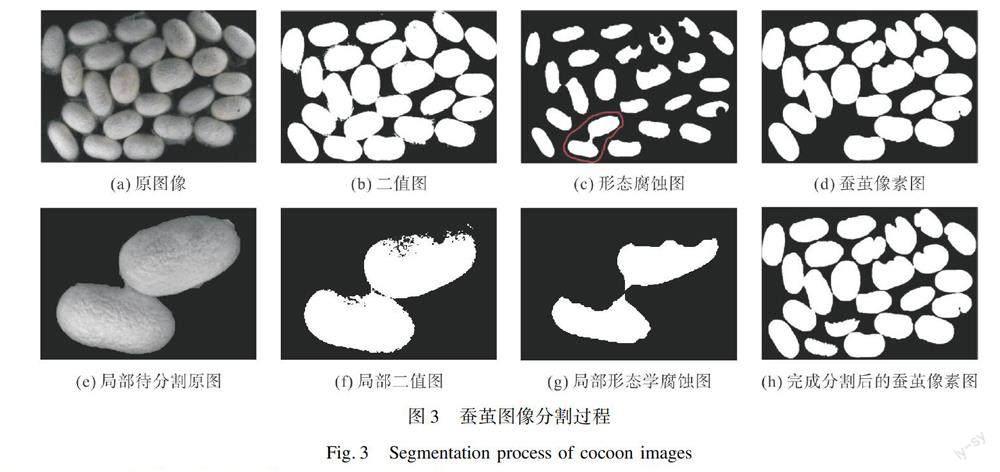

RT=RT1,RT1≥RT2(RT1+RT2)/2,RT1 式中:RT为估算的单个蚕茧长短轴比值;RT1为蚕茧边缘点拟合的椭圆长短轴比值;RT2为蚕茧边缘点的最小外接矩阵长短边比值。 为了更简便地应用蚕茧面积进行比较,定义蚕茧的面积指数如下式所示。 SI=A-c0c0(4) 式中:SI为蚕茧的面积指数;A为蚕茧椭圆拟合像素面积;c0为单宫蚕茧平均像素面积。 考虑到双宫茧大小差异和形状不规则,应用单个蚕茧的长短轴长度比值RT和蚕茧的面积指数SI这两个参数,采用多级阈值RTj和SIj(j=1,2,3,…,M)判断蚕茧是否为双宫茧,j表示分段数量。通过一张或多张具有代表性的双宫茧标记的蚕茧图像,统计分析双宫茧与单宫蚕茧的RT和SI取值,确定分段数量及每段对应的阈值RTj和SIj。 2 结果与分析 2.1 预实验 选用体积差异大的无附丝的蚕茧成像,包含双宫茧和单宫蚕茧,蚕茧之间留有足够的空隙。通过图像灰度变换、图像增强、Otsu阈值分割等算法,提取蚕茧区域像素值,得到该图像采集条件下的单个蚕茧像素面积大约为340 000~800 000(用像素数量表示)。考虑到两个较小的蚕茧在一起的情况,取700 000作为单个蚕茧的像素面积阈值S0,同时以蚕茧长轴长1 000(用像素数量表示)作为连通区域的像素长宽阈值L0。运用双参数阈值S0和L0判断图像分割过程中连通区域是否为进入下一级阈值分割循环。 计算该图像采集条件下的单宫蚕茧的蚕茧像素面积平均值约为465 000,则单宫蚕茧平均面积c0取值为465 000。 2.2 蚕茧分割实验 图3为采用可变阈值结合形态学运算对蚕茧图像进行迭代分割的过程。初始二值化阈值T0由Otsu算法(即最大类间方差法)求得,图像二值化后得到的图像粘连严重(图3(b))。通过增加形态学腐蚀步骤可分开粘连较少的蚕茧个体,使大部分蚕茧个体成为独立连通区域(图3(c)),减少后续分割迭代运算量。接着对每个连通区域进行形态学膨胀,以尽可能恢复每个蚕茧的形状,然后将形态学膨胀后的连通区域的像素数和外接矩阵长宽值与对应的阈值进行比较。像素数大于单个蚕茧像素面积阈值S0且外接矩阵长边长度大于L0的连通区域被判别为可能有两个及以上蚕茧相连,需要进一步分割,如图3(c)中红色线圈区域。图3(d)为第一次分割后得到的分割好的22个蚕茧像素点组成的二值图像,可以看出相邻的蚕茧有相连的像素点,若不运用形态学运算,这些有像素点连接的蚕茧此次分割是分不开的。形态学运算采用的是半径为100(用像素数量表示)的圆形结构元素。当进行形态学腐蚀时,用半径为100的圆在蚕茧的二值图(二值图中白色区域像素点取值为1,黑色区域取值为0)中滑动,圆心依次与图像中的每个像素点重叠,计算圆形结构重叠区域的局部最小值,仅当被圆覆盖的局部图像像素点取值均为1时,圆心对应的像素点取值才为1,否则为0,此时可以将像素连接小于圆直径的蚕茧分割开,运算后得到的形态学腐蚀图会“变瘦”。而对分割后的连通区域进行形态学膨胀,则取圆形结构重叠区域的最大值,只要区域中有一个像素点取值为1,则圆心对应的像素点取值也为1,此时大部分“变瘦”的蚕茧又恢复原来的大小了。 以0.2倍T0的阈值变化速率增加图像二值化分割阈值, 对需要进一步分割的区域对应的蚕茧原图进行分割。图3(e~g)为图3(c)中红色线圈区域的蚕茧在分割阈值为T0的1.6倍时的图像分割过程。分割结束后,根据每个蚕茧对应的像素点,就能找到该蚕茧在图中的位置(图3(h))。 应用该蚕茧目标分割算法,本文测试了10张图片共222个蚕茧的分割计数。结果显示,每张图片中的蚕茧均分割完全,计数准确度100%,如表1所示。 2.3 蚕茧形状复原 蚕茧图像经过目标分割后,应对每个蚕茧的像素点进行处理以复原该蚕茧形状,以便进行蚕茧种类识别(图4)。从图4(a~c)可以看出,高阈值分割的蚕茧、光照不均和表面污点的蚕茧在图像分割中得到的像素点图小于原图像大小。本文以图4(a)中的红色线圈区域的蚕茧像素点为例,对单个蚕茧形状复原过程进行描述。采用Canny算子(边缘检测算子),选用标准差为20,低阈值为0,高阈值为0.2,对像素点图和原图进行边缘检测,以像素点图的边缘点外接矩阵为中心,向四面扩展300像素点数来确定感兴趣区域位置和大小,并对图像进行裁剪,得到两个大小相同的边缘点组成的二值图像roi0和roi1。为了可视化区分两个边缘点图,本文以分割出的像素点组成的图像代替其对应的边缘点图roi0,如图4(d)所示,白色区域为目标蚕茧像素点,点线部分为原图边缘检测裁剪后的蚕茧轮廓边缘点。 接着应用两个边缘点图的几何关系筛选目标蚕茧的边缘点,去除其他蚕茧和附丝的边缘点。再对目标蚕茧边缘点进行椭圆拟合,如图4(e)所示。为了对比蚕茧形状复原效果,本文在蚕茧原图中用彩色线条画出了拟合的椭圆,如图4(c)(f)所示,可以看出大部分拟合的椭圆线条与蚕茧轮廓重合。 2.4 双宫茧检测实验 由于蚕茧的轻微不规则及个别外点的存在,有的蚕茧拟合的椭圆与蚕茧轮廓有些许出入。从图4(f)可以看出,该蚕茧拟合的椭圆短轴长度比实际蚕茧的短轴长,这样会导致椭圆长短轴比值比蚕茧实际情况小,因此需要适当对长短轴比值进行校正。应用椭圆拟合的倾斜角度,对目标蚕茧的轮廓边缘点进行角度变换,得到新的坐标,使变换后的这些点拟合的椭圆长短轴与坐标轴平行。由此可得到这些边缘点区域的最小外接矩阵的长边与短边像素长度比值RT2,并与拟合的椭圆长短轴比值RT1进行比较,应用式(3)确定该蚕茧长短轴比值RT。通过拟合的椭圆面积A及预实验中得到的单宫蚕茧平均像素面积c0,应用式(4)可计算出面积指数SI。应用估算的蚕茧长短轴半径比RT和面积指数SI,来判断该蚕茧是否为双宫茧。在本文实验中,通过统计分析,结合双宫蚕茧特征,设定满足以下条件之一即为双宫茧,如下式所示。 ①RT<1.4且SI>0②RT<1.5且SI>0.1③RT<1.6且SI>0.21④RT<1.7且SI>0.25⑤SI>0.4(5) 式(5)为双宫茧识别的双参数多级阈值,只要满足其中一个条件则判别为双宫茧。条件①和条件②主要依据蚕茧的长短轴半径比进行判断,为了限制边缘不完整的蚕茧图片被归为双宫茧,在长短轴半径比阈值的基础上,加了面积指数限制条件。条件③和条件④协同考虑蚕茧长短轴半径比与面积指数。条件⑤主要依据双宫蚕茧的面积比正常蚕茧大得多来进行判断,能兼容头尾相接的双宫茧类型。若五个条件均不满足,则认为不是双宫茧(图5)。 表2显示了图5中12个蚕茧的类型及其椭圆拟合参数。第1~7个蚕茧为双宫茧,满足条件①或条件②。其中第6个蚕茧和第7个蚕茧,若仅用Prasobhkumar等[20]椭圆拟合的长短轴半径比阈值0.426来判断,会被归为单宫蚕茧类。若单纯以面积来进行判别,第4个蚕茧的面积比第8~12个蚕茧的面积都小,会优先将后者判断为双宫茧而漏检前者。因而,采用基于估计的蚕茧长短轴比与面积参数相结合的双参数判别方式对双宫茧进行识别,比仅采用一种参数的方法实用性更强。 应用本文提出的算法,分别对10张蚕茧图片进行蚕茧图形分割、蚕茧形状复原及双参数阈值的双宫茧判别,实验结果如表3所示。10张图片共222个蚕茧,实际双宫茧数为46个,检出数共49个。检出的49个蚕茧中,实际双宫茧有46个,另外3个是误检为双宫茧的单宫蚕茧。总体上,双宫茧与单宫蚕茧分类识别准确率为98.6%。 进一步对误检的蚕茧进行分析,本文截取了这3个误检蚕茧的椭圆拟合进行对比,如图6所示。图6(a)为板印蚕茧,可能由于蚕结茧时受到挤压使得该视野面的面积较大。这类误检可以通过提取板印茧特征、建立多分类模型、板印茧类型优先判定来排除。图6(b)(c)蚕茧椭圆拟合不准确,通过分析发现,因为蚕茧周边附丝厚,部分位置附丝与蚕茧边缘之间几乎没有灰度梯度,边缘检测时,这些位置的蚕茧的边缘点未能检出,而是扩张到更远的附丝区域,此时采用直接最小二乘法进行椭圆拟合会使拟合的椭圆与蚕茧形状差异较大,从而导致出现误检。实际人工选茧生产线上,会优先去除附丝,以避免附丝遮挡蚕茧特征,影响选茧效率和准确度。机器视觉成像质量同样受附丝影响,实际应用中也应去除厚重的附丝,让图像显现出蚕茧本身面貌,才能更准确分类。 3 结 论 蚕茧目标分割与定位是蚕茧种类识别的基础,为解决蚕茧分选环节双宫茧机器视觉识别技术难题,针对粘连蚕茧难以准确分割、双宫茧识别局限性等问题,本文提出了基于可变阈值结合形态学运算的双参数控制的蚕茧分割计数算法、基于边缘检测与椭圆拟合的蚕茧形状复原及基于双参数的多级阈值双宫茧识别方法,将蚕茧分割与种类识别串联,以保证方法的适用性。图像分割计数算法能有效地标记蚕茧个体位置,分割计数准确度高达100%,保证后续的蚕茧种类识别能够顺利开展。通过蚕茧形状复原算法拟合的蚕茧形状,根据估算的蚕茧长短轴比值和面积指数两个参数,采用多级阈值对双宫茧进行检测,既能检出面积阈值法不能检出的小双宫茧,也能避免椭圆长短轴比值阈值法识别双宫茧的局限性。在双宫茧检测实验中,双宫茧全部检出,极少数单宫蚕茧被误检为双宫茧,双宫茧与单宫蚕茧分类识别的准确率为98.6%。 本文提出的蚕茧目标分割和双宫茧识别串联算法,能有效地对机器视觉图像进行处理得到各蚕茧目标是否为双宫茧的结论。该串联算法以预实验确定所摄图像中正常蚕茧面积、正常蚕茧长轴长作为先验条件。对于轻微重叠的蚕茧目标可以分割开,但对于重叠放置严重的蚕茧可能会误分割为同一个蚕茧,从而影响蚕茧分类识别。因此,此方法适用于蚕茧平铺在视野中成像的图像处理。 参考文献: [1]孙卫红, 黄志鹏, 梁曼, 等. 基于颜色特征和支持向量机的蚕茧分类方法研究[J]. 蚕业科学, 2020, 46(1): 86-95. SUN Weihong, HUANG Zhipeng, LIANG Man, et al. Cocoon classification method based on color feature and support vector machine[J]. Acta Sericologica Sinica, 2020, 46(1): 86-95. [2]陳国栋. 引入注意力机制的蚕茧识别算法[J]. 纺织报告, 2020, 39(11): 23-25. CHEN Guodong. Cocoon recognition algorithm based on attention mechanism[J]. Textile Reports, 2020, 39(11): 23-25. [3]陈浩, 杨峥, 刘霞, 等. 基于MATLAB的桑蚕茧选茧辅助检验方法的研究[J]. 丝绸, 2016, 53(3): 32-36. CHEN Hao, YANG Zheng, LIU Xia, et al. Study on auxiliary testing method for mulberry silkworm cocoon sorting based on MATLAB[J]. Journal of Silk, 2016, 53(3): 32-36. [4]孙卫红, 廖艺真, 梁曼, 等. 蚕茧表面图像等效阶梯柱面展开[J]. 中国图象图形学报, 2020, 25(3): 498-506. SUN Weihong, LIAO Yizhen, LIANG Man, et al. Equivalent step cylinder unfolding of silkworm cocoon surface image[J]. Journal of Image and Graphics, 2020, 25(3): 498-506. [5]甘勇, 孔庆华, 韦荔甫. 基于数字图像处理的蚕茧表面积计算方法[J]. 光学技术, 2007(1): 27-28. GAN Yong, KONG Qinghua, WEI Lifu. A method to calculate cocoons superficial areas based on the digital image processing[J]. Optical Technique, 2007(1): 27-28. [6]華中平, 甘勇. 基于图像处理的蚕茧表面积计算方法[J]. 丝绸, 2004(3): 16-18. HUA Zhongping, GAN Yong. A method to calculate cocoons superficial area based on image processing[J]. Journal of Silk, 2004(3): 16-18. [7]周志宇, 刘喜昂, 杨东鹤. 机器视觉在蚕茧表面积测量中的应用[J]. 纺织学报, 2006(12): 29-31. ZHOU Zhiyu, LIU Xiang, YANG Donghe. Application of machine vision in measurement of cocoon superdicial area[J]. Journal of Textile Research, 2006(12): 29-31. [8]龚攀, 李光林. 基于计算机视觉的蚕蛹性别识别应用研究[J]. 农机化研究, 2014, 36(1): 206-209. GONG Pan, LI Guanglin. The recognition application research of the tupa gender based on computer vision[J]. Journal of Agricultural Mechanization Research, 2014, 36(1): 206-209. [9]刘莫尘, 许荣浩, 李法德, 等. 基于颜色与面积特征的方格蔟蚕茧分割定位算法与试验[J]. 农业机械学报, 2018, 49(3): 43-50. LIU Mochen, XU Ronghao, LI Fade, et al. Algorithm and experiment of cocoon segmentation and location based on color and area feature[J]. Transactions of the Chinese Society for Agricultural Machinery, 2018, 49(3): 43-50. [10]刘莫尘, 许荣浩, 闫筱, 等. 基于FCM及HSV模型的方格蔟黄斑茧检测与剔除技术[J]. 农业机械学报, 2018, 49(7): 31-38. LIU Mochen, XU Ronghao, YAN Xiao, et al. Detection and elimination of yellow spotted cocoon in mountage based on FCM algorithm and HSV color model[J]. Transactions of the Chinese Society for Agricultural Machinery, 2018, 49(7): 31-38. [11]李时杰, 孙卫红, 梁曼, 等. 基于CD-YOLO算法的蚕茧种类识别[J]. 中国计量大学学报, 2021, 32(3): 398-405. LI Shijie, SUN Weihong, LIANG Man, et al. Cocoon species recognition based on CD-YOLO algorithms[J]. Journal of China University of Metrology, 2021, 32(3): 398-405. [12]孙卫红, 杨程杰, 邵铁锋, 等. 基于MSRCR与注意力机制的群体蚕茧智能识别算法[J]. 丝绸, 2022, 59(6): 58-65. SUN Weihong, YANG Chengjie, SHAO Tiefeng, et al. Intelligent recognition algorithm of group cocoons based on MSRCR and CBAM[J]. Journal of Silk, 2022, 59(6): 58-65. [13]张印辉, 杨宏宽, 朱守业, 等. 基于轻型调控网络的下茧机器视觉实时检测[J]. 农业机械学报, 2022, 53(4): 261-270. ZHANG Yinhui, YANG Hongkuan, ZHU Shouye, et al. Machine vision real time detection of inferior cocoons based on lightweight manipulation network[J]. Transactions of the Chinese Society for Agricultural Machinery, 2022, 53(4): 261-270. [14]黄静, 张琦, 江文斌. 基于改进K-means算法的蚕茧自动计数方法的研究[J]. 丝绸, 2014, 51(1): 37-40. HUANG Jing, ZHANG Qi, JIANG Wenbin. Study on automatic cocoon counting method based on improved K-means algorithm[J]. Journal of Silk, 2014, 51(1): 37-40. [15]孙卫红, 洪徐健, 梁曼, 等. 基于凹点定向腐蚀的粘连蚕茧图像分割方法[J]. 蚕业科学, 2019, 45(3): 369-376. SUN Weihong, HONG Xujian, LIANG Man, et al. Image segmentation method for adhesive cocoons based on directional erosion in concave point[J]. Acta Sericologic of Science, 2019, 45(3): 369-376. [16]古亭, 李子印, 王乐. 基于距离变换的粘连蚕茧分割方法[J]. 计算机工程与应用, 2019, 55(23): 177-181. GU Ting, LI Ziyin, WANG Le. Method for segmentation of silkworm cocoons based on distance transformation[J]. Computer Engineering and Applications, 2019, 55(23): 177-181. [17]孔繁圣, 李子印, 古亭, 等. 基于多层次距离变换的蚕茧分割计数算法[J]. 蚕业科学, 2020, 46(2): 190-196. KONG Fansheng, LI Ziyin, GU Ting, et al. Cocoon segmentation and counting algorithm based on multi-level distance transformation[J]. Acta Sericologic of Science, 2020, 46(2): 190-196. [18]杜昕, 刘文烽, 林毅坚. 基于机器视觉动态选茧系统的研究[J]. 企业科技与发展, 2018(4): 91-94. DU Xin, LIU Wenfeng, LIN Yijian. Research on dynamic cocoon selection system based on machine vision[J]. Sci-Tech & Development of Enterprise, 2018(4): 91-94. [19]宋亞杰, 谢守勇, 冉瑞龙. 机器视觉技术在蚕茧无损检测中的应用研究[J]. 现代农业装备, 2006(9): 48-51. SONG Yajie, XIE Shouyong, RAN Ruilong. Application research on machine vision technology in nondestructive test of cocoon[J]. Modern Agricultural Equipment, 2006(9): 48-51. [20]PRASOBHKUMAR P P, FRANCIS C R, GORTHI S S. Automated quality assessment of cocoons using a smart camera based system[J]. Engineering in Agriculture, Environment and Food, 2018, 11(4): 202-210. [21]FITZGIBBON A, PILU M, FISHER R B. Direct least squares fitting of ellipses[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1999, 21(5): 476-480. Research on cocoon segmentation and double cocoon recognition based on two-parameter thresholds JIANG Zhaoqiong1,2, YING Jing1,2, WANG Chunxia1,2, SONG Lejian1, HE Qingyan1,2, GUO Peng1, LIN Xianggen1, DENG Lili1 (1.Sichuan Research & Design Institute of Agricultural Machinery, Chengdu 610066, China; 2.Key Laboratory of Agricultural EquipmentTechnology for Hilly and Mountainous Areas, Ministry of Agriculture and Rural Affairs, Chengdu 610066, China) Abstract: The quality of cocoons directly affects the quality of raw silk. Before reeling, the cocoons should be sorted to remove the inferior cocoons that cannot be used for reeling. The double cocoon is the best raw material for making silk quilts. Therefore, it should be separated from other types of inferior cocoons and classified separately in the process of selecting cocoons. The traditional cocoon sorting basically relies on manpower, which involves high labor intensity, low efficiency of cocoon selection and high missing rate, and the accuracy of cocoon selection is easily affected by subjective factors such as the technical level and mental state of cocoon selection personnel. With the rapid development of artificial intelligence, machine vision technology is widely used to replace human eyes for detection and recognition. At present, in machine vision technology, the recognition of double cocoons mainly includes area threshold method and the threshold method of the ratio of long to short axis of ellipse. The disadvantage of the area threshold method is that small double cocoons cannot be detected. The threshold method of the ratio of long to short axis of ellipse is not applicable to the double cocoon of the head-to-tail type and relies too much on the accurate fitting of the cocoon shape. However, due to the slight irregularity of the cocoon shape, the attachment silk and the adhesion between the cocoons, the ellipse fitting is different from the actual shape, which may result in peoples misjudging the cocoon type near the threshold. Therefore, there are some limitations in the identification of double cocoons by only depending on the area threshold or the threshold of the ratio of long to short axis of the fitted ellipse. Due to the dense distribution of cocoons in the cocoon image and the interference of attached silk, the gray scale of adjacent cocoons is similar, so it is difficult to conduct segmentation completely by traditional image segmentation methods. Therefore, the segmentation and counting problem of target cocoons should be solved first for the classification and recognition of cocoons. Aiming at the problems that it is difficult to accurately segment the adhered cocoons and the limitations of the existing double cocoon recognition methods, we proposed a series of algorithms for the segmentation and counting of cocoons, the shape restoration of cocoons and the recognition of double cocoons. Firstly, we proposed an improved image segmentation algorithm based on variable segmentation threshold by combining with morphological operation. Otsu binarization threshold was used as the initial segmentation threshold, and binarization, morphological erosion operation and morphological expansion operation were performed on the image. The pixel area threshold and length-width threshold of single cocoons were used to distinguish the connected region. If a cocoon is a single one, it is marked and counted. If it is determined to be connected to other cocoons, the segmentation threshold is increased again for another segmentation. Then, a cocoon shape restoration method based on edge detection and ellipse fitting was proposed. The pixels of each cocoon that had been segmented were traversed. The Canny operator was used to detect the edge of the original image. The pixel points of the segmented cocoon were used to determine the edge points of the cocoon, and the edge points were elliptically fitted to obtain the image of the cocoon. Finally, the ratio of long to short axis of the cocoon and the area parameters were calculated, and the double-parameter threshold was used to recognize the double cocoon. And then, the serial algorithm proposed in this paper was used to segment cocoon graphics, restore cocoon shape, and distinguish double cocoons in 10 cocoon images. The results show that the 222 cocoons of all the ten pictures are completely segmented, and the counting accuracy is 100%. A total of 46 double cocoons in the pictures are detected, and the classification accuracy of double cocoons and single cocoons is 98.6%. This method detects the small double cocoons which are easy to be missed by the area threshold method, and accurately identifies the cocoon type which is close to the threshold of the ratio of long to short axis. The series algorithm of cocoon target segmentation and double cocoon recognition proposed in this paper can effectively process the machine vision image to get the conclusion whether each cocoon is a double one. In the series algorithm, the pre-experiment is used to determine the area of the normal cocoon and the length of the long axis of the normal cocoon as the prior conditions in the captured image. The cocoon target with slight overlap can be separated, but the cocoons with serious overlap may be mistakenly divided into the same group, thus affecting the classification and recognition of the cocoon. Therefore, this method is suitable for the image processing of cocoons laid flat in the field of vision. Key words: image segmentation; double cocoons; counting; classification; algorithm; threshold 收稿日期: 2022-08-26; 修回日期: 2023-03-01 基金項目: 四川省省级科研院所基本科研业务费项目(2021JBKY0014-05);四川省蚕桑创新团队项目(SCCXTD-2022-17) 作者简介: 蒋昭琼(1984),女,高级农艺师,主要从事农产品质量与品质检测技术、农产品加工及贮藏技术研究。