自适应特征融合的相关滤波跟踪算法

李 彪,孙 瑾,李星达,李 扬

南京航空航天大学 民航学院,南京211106

目标跟踪作为计算机视觉领域最具挑战性的研究方向之一,在视频监控、汽车导航、机器人技术、人机交互、医学等领域有着广泛的应用。

目标视觉跟踪主要分为生成式和判别式方法。生成式方法首先对当前帧目标区域建模,在下一帧寻找与模型最相似的区域,其模型的建立可以分为基于核、基于子空间的方法以及基于稀疏表示的方法,经典的算法有均值漂移[1]、卡尔曼滤波[2]、粒子滤波[3]。判别式方法不仅利用了目标自身的外观信息,还利用了目标周围的背景信息,从背景中区分并估计出感兴趣的目标区域。其跟踪方法可以分为基于在线Boosting的方法、基于支持向量机的方法、基于随机学习的方法以及基于判别分析的方法,在目标跟踪精度与性能上优于生成式方法。

近年来,基于相关滤波的判别式目标跟踪方法凭借其精度高、实时性、鲁棒性好,逐渐成为领域内主流的研究方向[4-5]。Bolme等[6]于2010年提出MOSSE(minimum output sum of squared error)算法,将灰度图作为特征运算,在频域内实现快速的学习和检测,开创了相关滤波应用在跟踪领域的先河。Henriques 等[7]提出了CSK(circulant structure of tracking-by-detection with kernels)与KCF[8](kernelized correlation filter)经典的相关滤波器。Danelljan 等[9]用多通道颜色特征CN(color names)去扩展CSK,提出了CN(adaptive color attributes for real-time visual tracking)算法,该算法对于形变目标非常有效,一定程度上弥补了HOG 特征针对快速形变的不足。虽然上述相关滤波算法大幅度提高了跟踪精度和准确率,但是针对尺度变化的影响,Danelljan等[10]通过结合独立的一维尺度滤波器先后提出DSST(discriminative scale space tracker)和快速版本的fDSST(fast DSST)解决尺度估计问题,该算法先利用平移滤波找到最佳位置,再利用一维尺度滤波器,找到最佳尺度大小。Li 等[11]提出了一种融合多特征的尺度自适应相关滤波算法SAMF(scale adaptive with multiple features tracker),在平移滤波的基础上增加了尺度池,但在目标形变、遮挡等因素干扰下跟踪效果不稳定。Possegger等[12]提出了一种干扰感知跟踪方法DAT(defense of color-based model-free tracking)。该方法基于RGB 空间建立颜色直方图干扰感知目标模型,利用目标概率图的概率值与距离值加权定位目标,得到跟踪结果。由于仅由单一颜色特征描述目标模型,在复杂场景下跟踪效果较差。2016年,Bertinetto等[13]结合DAT方法与相关滤波器提出Staple(complementary learners for real-time tracking)算法,通过融合两种类型的分类器提高跟踪性能。SRDCF(learning spatially regularized correlation filters for visual tracking)[14],缓解了由于DCF 算法中循环矩阵造成的边界效应,但实时性不高。陈晨等[15]从多核融合的角度推导出了一种新的多模糊核相关滤波器(multi-fuzzy kernels correlation filter,MFKCF),采用单一HOG 特征,无法适应形变较大场景。杨佳霖等[16]提出了一种快速尺度估计的增强型多核相关滤波算法,该方法基于DSST 方法,在预测目标位置的基础上实现尺度估计,一旦位置预测出现偏差,会对最后的跟踪准确率产生影响。李福进等[17]提出了一种高置信度的尺度自适应核相关跟踪方法以提高跟踪精度,但是算法速度只能达到15 frame/s 左右,无法满足实时性要求。近年来随着深度学习的发展,后续又涌现出了CCOT[18](continuous convolution operators)与ECO[19](efficient convolution operators for tracking)等基于深度的学习的目标跟踪算法,融入深度特征的多模板相关滤波跟踪算法,文献[20]通过训练神经网络得到深度特征,但是速度慢,无法满足实时性。魏永强等[21]提出了深度特征的相关滤波视觉跟踪算法提升跟踪精度,但在尺度更新和速度上存在不足。

相关滤波算法通过在频域内实现快速的学习和检测,速度优势明显,逐渐成为跟踪领域的研究热点。但这类算法通过循环移位实现模板训练,在应对目标形变和快速运动存在不足,特别是尺度变换十分敏感,实现稳健的目标跟踪仍然面临着非常严峻的挑战。为提高复杂背景下跟踪的鲁棒性,本文在核相关滤波跟踪框架之下,采用多个核相关滤波器框架,选取多元特征,并基于特征的互补性预测目标位置,同时采用尺度池方法实现尺度估计,提高跟踪算法在光照、形变、旋转、尺度变化等跟踪场景下的鲁棒性。

1 相关滤波跟踪算法(correlation filter)

在相关滤波算法中,Staple 算法继承了相关滤波算法的速度优势,同时也结合了颜色概率直方图的概率模型特性,所以本文以Staple为例对相关滤波算法进行介绍。

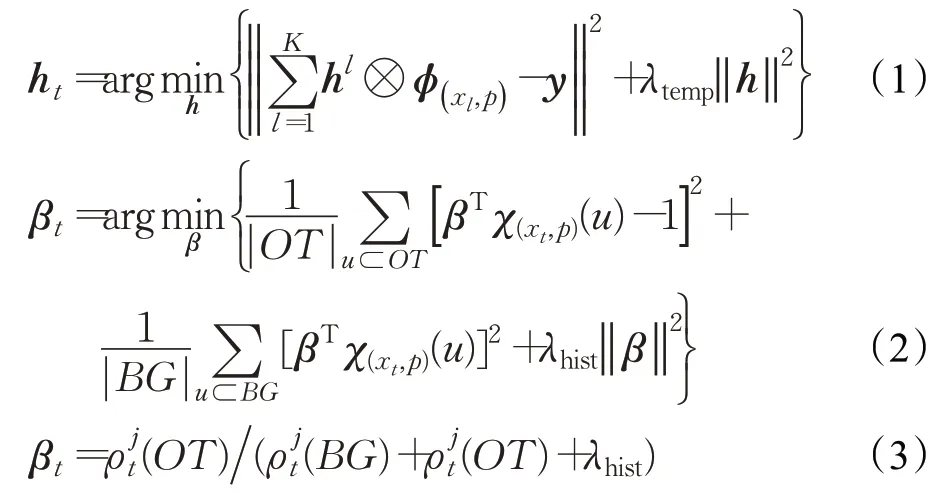

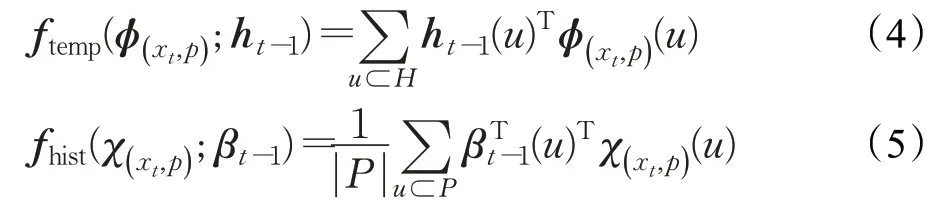

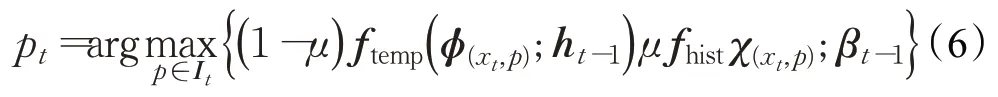

Staple 算法首先采用2 个独立的框架,分别利用HOG 和颜色直方图特征分别训练位置预测器,进行位置响应图的融合,然后再采用尺度滤波器进行尺度预测。分类器的训练过程可以描述为:

其中,公式(1)为采用HOG 特征的相关滤波器模型,公式(2)为颜色概率直方图模型,公式(3)为颜色概率直方图预测模型的解。t为当前视频帧数;h为位置滤波器的模型参数,HOG特征维数l=1,2,…,K。β为直方图颜色概率模型参数;λtemp和λhist分别为滤波器模型和直方图颜色概率模型中的正则化系数;(xt,p)为第t帧图像中的训练样本;x为第t帧中检测的新目标位置p产生的一系列训练样本位置;ϕ(·)和χ(·)分别表示训练样本在滤波器模型和直方图颜色概率模型中的特征表达,对应特征维度分别为K和M;y为期望滤波响应参数,⊗表示循环相关操作,BG和OT分别表示训练的目标区域和背景区域包含的像素个数。其中,表示落在第j个直方图区间的像素点为目标的概率,表示落在第j个直方图区间的像素点为背景的概率,j=1,2,…,M。

对于目标的检测,Staple 算法使用两种分类器分别对候选样本进行预测,得到各自的响应输出:

其中,ftemp(·)和fhist(·)分别为候选样本在滤波器模型和直方图颜色概率模型下的响应输出;H和P是两种模型中参与计算的二维像素区域;p∈It,It表示第t帧中根据上一帧的目标位置pt-1产生的一系列候选样本位置。

对两种响应采用固定权重进行融合,得到最终响应输出。在所有候选样本中找到响应输出最大的样本对应的位置,即为目标的预测位置其中μ为固定权重值。

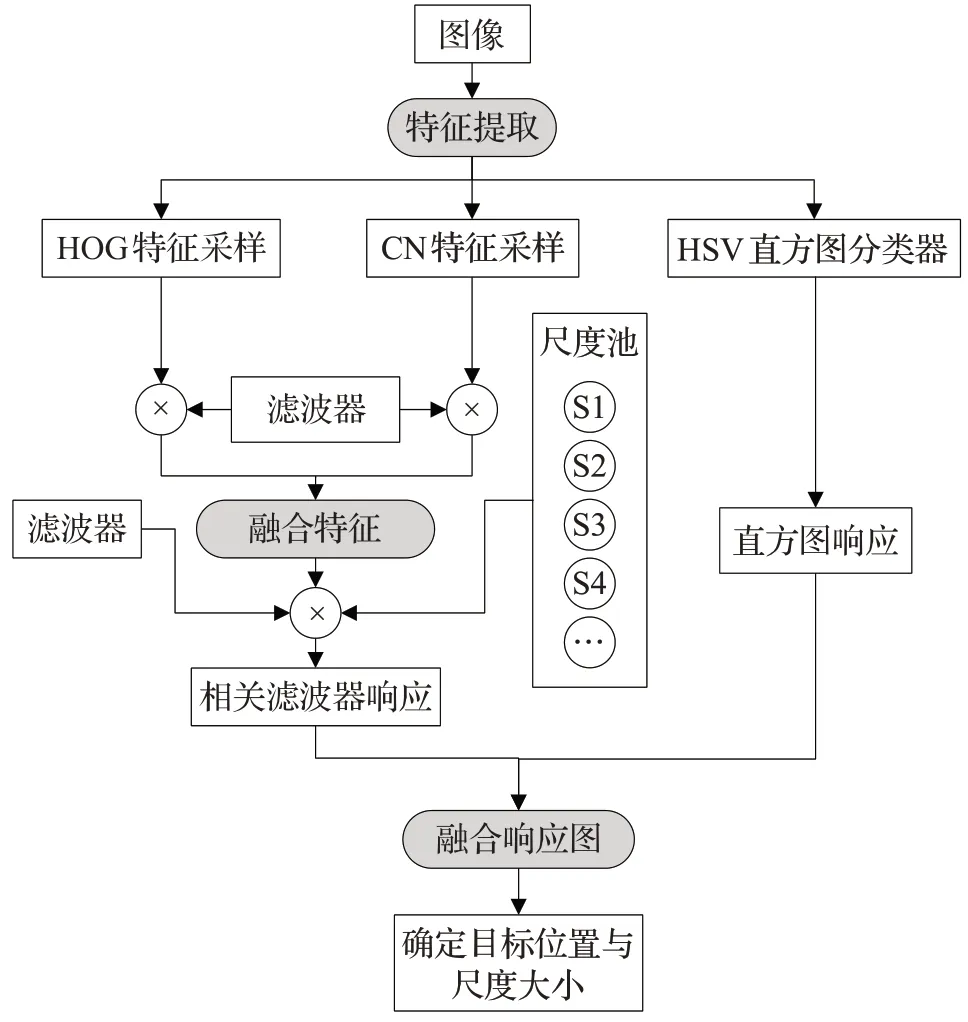

得到新一帧的目标位置pt后,使用线性插值的方法对式(1)相关滤波器位置预测模型和式(2)的颜色概率直方图模型分别进行更新:

其中,^表示傅里叶变换;⊙表示点乘;ηhist为滤波器模型的学习率;l=1,2,…,K为特征位数。表示落在第j个直方图区间的像素点为目标的概率;表示落在第j个直方图区间的像素点为背景的概率,j=1,2,…,M。

由于目标在跟踪过程中发生尺度变化,Staple 采用DSST 尺度估计算法来更好地追踪目标,该算法通过一维的尺度相关滤波器,以当前中心位置pt为中心点获取目标的最佳尺度。

2 自适应特征融合相关滤波跟踪算法

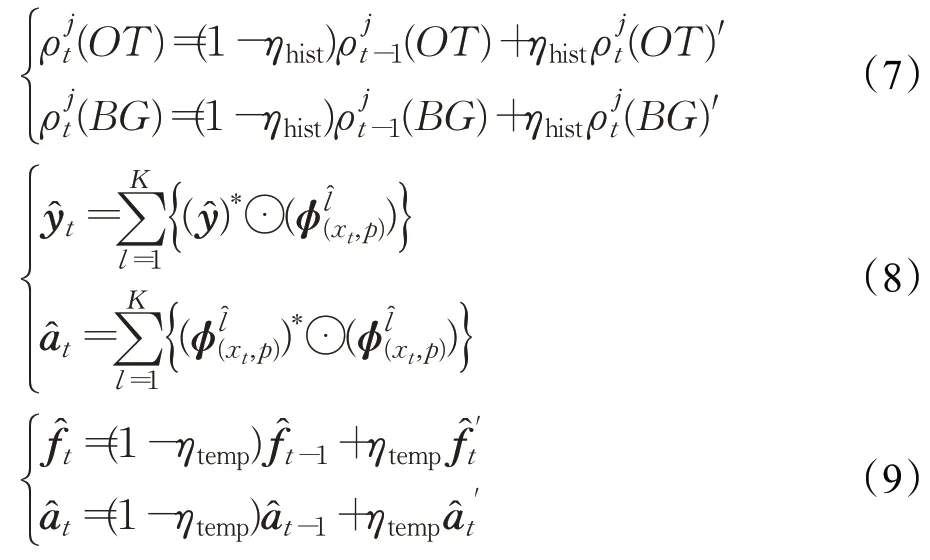

本文提出一种基于相关滤波的特征自适应融合及尺度估计的跟踪算法。图1 是整体算法跟踪过程的可视化表示。在特征表征方面上,本算法提出一种多元互补特征自适应融合方法,考虑颜色特征对目标形变的鲁棒性较高,但对光照敏感,而HOG 特征与此正好相反。因此本算法通过颜色特征和HOG特征两种相关滤波响应图峰值自适应分配权重后形成互补融合特征表征目标。在颜色特征中本文又选取了CN特征和颜色统计特征。颜色统计特征获取像素级颜色概率特征,对形变不敏感,适用于快速变形和运动目标跟踪,但往往通过缩小目标以获取前景目标的准确描述,不适用于目标尺度变换检测[13],而CN 颜色将RGB 的3 通道图像投影到11个颜色通道特征,在尺度估计跟踪算法中表现良好[11],因此本文在颜色特征中选取两种互补特征,首先基于CN和HOG的自适应互补获取融合特征,同时采用尺度池机制跟踪目标,进而为降低颜色特征对光照的影响,最后选取HSV颜色统计特征提高跟踪精度。

图1 本文算法跟踪框架Fig.1 Framework of total tracking

本文基于相关滤波器和颜色概率直方图模型的数学表达,在两个独立的岭回归框架下利用互补特征信息实现滤波器模型的求解,在保证了跟踪算法的稳定性和收敛性的同时,实现目标的准确定位。

2.1 目标特征表征与自适应特征融合

目前相关滤波跟踪算法采用的颜色特征中有CN特征和统计直方图概率特征,如SAMF采用的是CN特征,Staple 采用的是颜色直方图特征。CN 特征运用在相关滤波框架中时不可避免受到相关滤波边界效应影响,而像素级概率颜色概率响应不受这一影响,能正确检测快速变形和快速运动情况,但颜色直方图特征不适用于尺度估计,为此本文在目标位置跟踪中,在相关滤波框架下结合颜色直方图提高位置相关滤波器的跟踪精度,并用HSV 颜色空间代替RGB 空间以降低光照影响;尺度估计时采用HOG和CN颜色融合特征,使跟踪能够适应目标尺度变化。

现有经典算法一般也采用多特征提高跟踪鲁棒性,如Staple采用HOG和灰度特征,SAMF采用HOG、CN和灰度三种特征,文献[22]也采用了多种特征,但这些方法中多元特征融合方法就是简单的矢量叠加。不同场景下,不同的特征判别能力不同,因此本文提出了一种根据滤波响应图来对特征进行自适应加权的特征融合方法,根据特征判别效果自适应确定权重,使优势特征能够占据主导地位,以更好地处理光照、快速形变等问题。

传统的相关滤波类算法是用岭回归方法来对滤波器进行训练的,它的损失函数如式(10)所示:

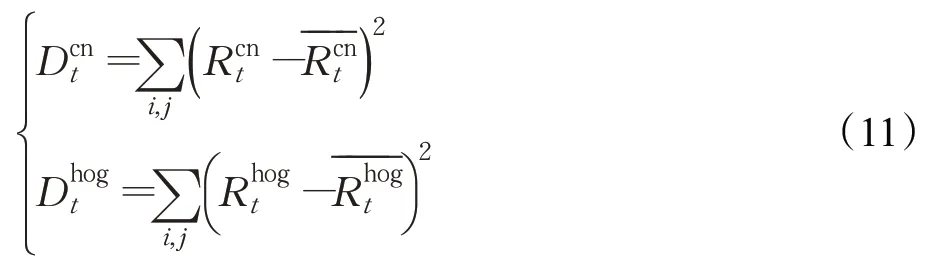

其中,R定义为样本响应模板(i,j)处的滤波响应值;为(i,j)处高斯理想响应值,两者差距越小证明该样本的滤波响应越大,即滤波器越理想;A为正则项。因此,如何最小化损失差是提升跟踪效果的重点。Ri,j为当前帧中样本在滤波器中的实际响应值;本算法将损失差的大小作为衡量下一帧特征权重的标准,式(11)首先分别计算HOG和CN特征在第t帧的损失差。

两个特征各自的自适应权重由式(12)确定:

最后将c(·)作为融合特征相关滤波器的最终特征输入滤波器,求得的响应最大。

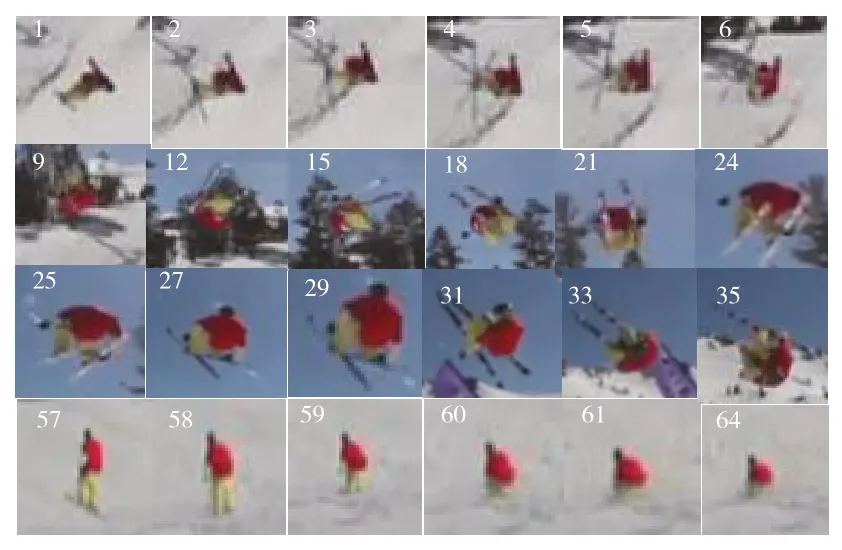

特征相关滤波响应图说明了用该特征表征目标的准确度。因此本文以特征期望响应图与实际相关响应图之间的损失差作为确定特征权重的依据。为了进一步说明本文提出的特征权重自适应融合的有效性,以标准数据库中的Skiing视频序列进行分析说明,如图2。

图2 Skiing视频序列Fig.2 Skiing video sequence

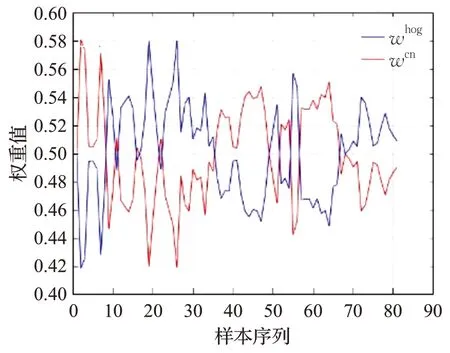

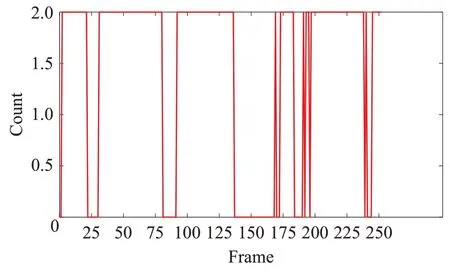

依据式(12)计算的视频序列中颜色和HOG特征滤波器各自特征权重的变化结果如图3 所示。该视频序列中目标在不同时间段内目标形状与颜色发生变化时,形状与颜色自适应权重发生相应变化。其中1~6 帧背景较为单一,但目标形状发生较大变化,此时颜色特征表征目标的准确度要高于HOG 特征,通过计算发现HOG特征滤波器损失差加大,颜色滤波器损失差较小,采用本文计算方法颜色特征权重高于HOG 特征;9~35帧是滑雪者在空中进行翻滚,中目标形变较小,HOG特征削波器损失差较小,而且HOG 特征能有效克服光照变化,因此形状滤波器准确性强于颜色滤波器准确性,此时HOG 特征权重要大于颜色权重。57~64 帧图像形状发生较大变化,形状滤波器损失差加大,而颜色滤波器损失差较小,颜色特征权重上升,颜色滤波器准确性强于形状滤波器。

图3 自适应特征权重图Fig.3 Adaptive feature weight graph

相对于像素级颜色概率特征,运用CN 颜色特征进行尺度估计,但在相关滤波框架中时不可避免受到相关滤波边界效应影响,而像素级概率颜色概率响应不受这一影响,能正确检测快速变形和快速运动情况,因此本文进一步再与颜色直方图模型响应输出进行融合准确确定目标位置。常用的颜色直方图模型是基于RGB空间三维直方图,例如Staple 方法中采用的,但RGB 易受光照影响,而HSV空间更接近人们对彩色的感知经验,更容易跟踪某种颜色的物体,常用于图像识别等领域,因此本文采用HSV空间计算颜色概率直方图。

2.2 目标尺度估计

在目标跟踪过程对目标进行实时的尺度预测,可以在一定程度上提高算法跟踪的精度和鲁棒性能,目前主流相关滤波尺度估计主要有尺度滤波器和尺度池方法。文献[10-11]采用的DSST 是一维尺度滤波器,具有33个尺度大小,为了实时性通常选取单一特征,目标变化大则尺度估计不准,尺度估计时建立在位置定位基础上的,因此对位置定位精度要求比较高。SAMF算法采用尺度池方法,尺度池中含有7 个尺度因子,尺度与位置估计相互促进,因此尺度估计比较稳定,不易出现估计偏移过大等情况,且可以采用多特征进行特征互补,文献[12-14]中多采用尺度池策略。根据上述分析,本文采用尺度池方法,并结合2.1 节提出的自适应特征融合的相关滤波算法进行尺度估计。

初始目标模板大小定义为ST=(sw,sh),尺度池S={t1,t2,…,tk},其中ti是尺度因子。假设相关滤波目标窗口大小为st,对于当前帧,在HOG 和CN融合特征基础上,列举了{tisi|ti⊂S}中k个大小的尺寸,通过不同的尺度得到一系列响应输出:

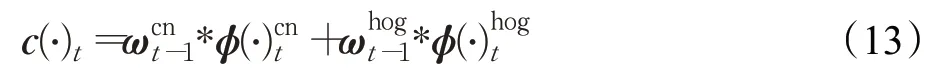

2.3 目标跟踪置信度判断策略

相关滤波算法依据最大响应值Rmax来完成目标定位,反映的是目标模型与目标搜索区域中对应位置的相关性,Rmax越大则表示相关性越高,即目标与该区域的相似度越高。但是当遮挡、形变等干扰情况发生时,响应图将呈现出“多峰”形态,所对应的位置区域可能是背景区域或其他的遮挡物,这将导致跟踪性能的退化。

KCF、DSST、Staple 等许多跟踪算法不进行跟踪结果可靠性判定,每一帧的结果都用来更新。但当目标被遮挡,或者跟踪结果出现差错时会使跟踪器准确性逐渐变差,造成模型漂移,因此模型更新不可或缺,但同时想要保证跟踪速度,就需要一种简单有效的模型更新策略,通过之前已有资源来进行判断,而不需要进行太多复杂的计算。相关滤波算法MOOSE 中作者提出了peak-to-sidelobe ratio(PSR)峰值旁瓣比,用于量化响应图像的锐度,但是PSR 对于局部遮挡效果不好。于是基于PSR算法的基础上,LCMF【23】(large margin object tracking with circulant feature maps)的作者对相关滤波算法进行了改进。本文利用文献[23]中提出的平均峰值相关能量(average peak-to-correlation energy,APCE)作为评价指标来设计跟踪置信度判定策略,衡量算法跟踪结果的可靠性。对于任意的响应图R,APCE计算方式为:

其中,Rmax、Rmin、Ri,j分别表示响应最高、最低和位置(i,j)上的响应,这个判据可以反映响应图的振荡程度,当APCE 突然减小时,就是目标被遮挡,或者目标丢失的情况,当前帧的APCE 相对于这段视频的APCE 历史均值有很明显的减小,因此在这种情况下选择不更新模型,从而避免了模型的漂移。只有当APCE都以一定比例大于历史均值的时候,模型才进行更新,可以大大减少模型漂移的情况,同时减少了模型更新的次数,达到了加速的效果。

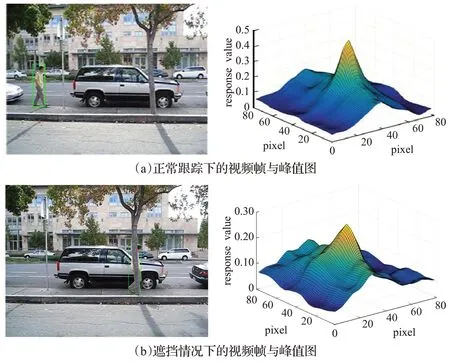

为说明平均峰值相关能量作为评价指标在文章中有效性,本文以标准数据库中David3 视频序列作为说明。相关滤波中响应图是确定目标位置主要计算阶段,所以响应图能否与理想响应图相似会对跟踪结果以及模型产生较大影响。相关滤波器输出响应分数的最大值所在位置即目标位置,当跟踪准确的时候,对应一个峰值明显且近似理想响应的响应图。而当目标跟踪效果不佳的时候,如遮挡、丢失、形变量大以及模糊等,响应图表现出剧烈的振荡。如果继续用不确定是否是目标的区域作为训练样本去更新模型,可能导致跟踪结果出错。David3 视频段中原视频跟踪图与APCE 防遮挡算法跟踪结果的位置响应图如图4所示。

图4 非遮挡与遮挡情况下的响应图Fig.4 Response diagram under non-occluded and occluded conditions

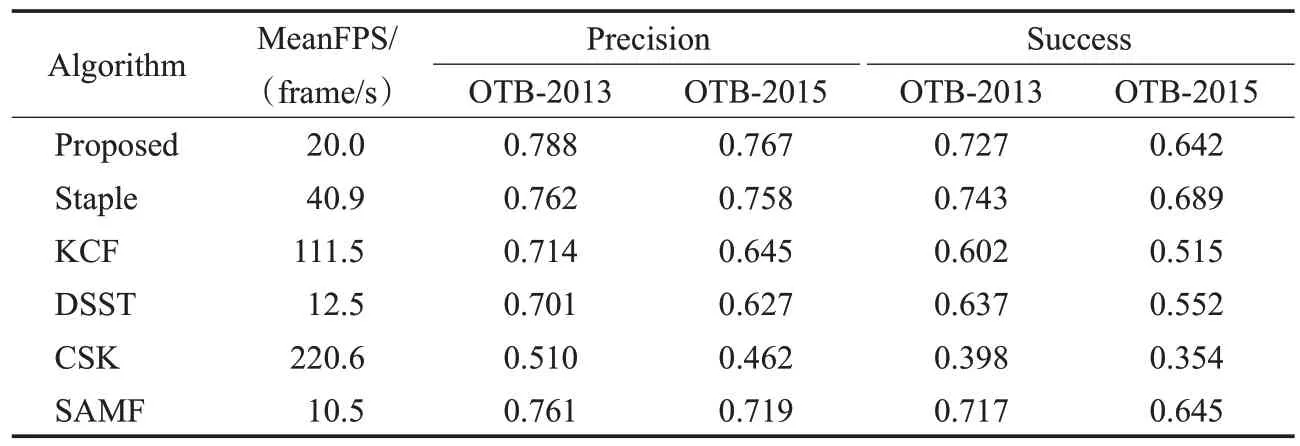

David3视频中使用平均相关峰值能量评价指标后,模型的更新情况如图5所示。当模型更新时,帧数对应Count为2,不更新则为0。在22~28帧左右,人体受到遮挡时Count 为零,不再受到遮挡后恢复正常。81~91 帧左右,人体受到树木遮挡时Count 为零,不再受到遮挡后恢复正常。137~182 帧由于人体转向导致模型不再更新,Count 为零。184~190 帧左右,人体再次受到遮挡,Count为零。239帧左右人体再次受到遮挡Count为零,综上可知防遮挡算法实时有效,当目标跟踪效果不佳的时候,如遮挡、形变量大时会及时停止模型更新以防模型的污染,加速算法的运行。

图5 模型更新次数图Fig.5 Model update times

3 实验结果及分析

3.1 实验环境及参数

为验证本文算法的有效性,采用跟踪领域通用的公开数据集OTB-2013[24]与OTB-2015[25]对本文算法进行测试与分析。OTB-2013 和OTB-2015 视频数据集包含了尺度变化(scale variation,SV)、遮挡(occlusion,OCC)、形变(deformation,DEF)、运动模糊(motion blur,MB)、快速运动(fast motion,FM)、平面内旋转(in-plane rotation,IPR)和平面外旋转(out-of-plane rotation,OPR)等11 种影响因素构成的视频序列。实验运行环境为i7-9700 型号的CPU(主频3.00 GHz)及8 GB 内存的PC机,测试平台为Matlab R2018a。实验选取目前表现较好的5 种主流的相关滤波算法与本文算法进行比较与分析。通过相关实验,本文算法参数设置如下,HOG相关滤波器和CN 相关滤波器的正则化参数设置为λ=0.001,学习率η=0.01,HOG特征和CN特征的cell数为4×4,梯度方向为9,维数为3,高斯标准差为σ=1/16,共有9 个尺度池因子1、0.980、0.985、0.990、0.995、1.005 1.010、1.015、1.020。颜色直方图bin 通道数为32,颜色直方图响应图与相关滤波器响应图融合系数分别为0.4和0.6,颜色直方图学习率η=0.01。

本实验中的定量分析采用以OPE(one-pass evaluation)模式运行得到的跟踪准确率(precision)和成功率(success)数据作为算法性能的评价指标。其中准确率为跟踪中心点位置误差小于阈值的帧数Fcenter占总体视频帧数Ftotal的比例,即,中心位置误差则表示序列中目标预测位置中心点与实际目标中心点欧式距离的平均值。成功率则用跟踪重叠率(交并比)来度量,重叠率是指整个跟踪序列中目标预测区域与实际区域交并比大于给定阈值的帧数占比。

其中,Rt是跟踪目标区域,Ro是实际目标区域。

3.2 特征融合有效性实验

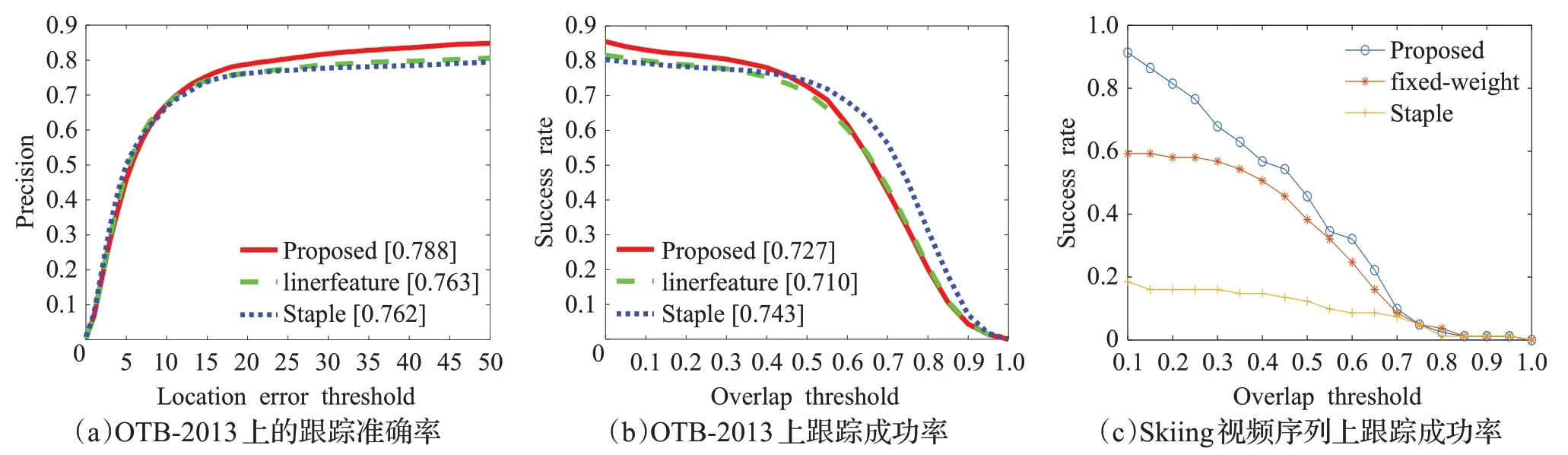

为验证本文特征自适应融合有效性,选取Staple算法(单一HOG特征)、HOG特征和CN线性相加特征(权重分别为0.5)和本文自适应特征融合方法分别对Skiing视频序列OTB-2013 标准数据库上进行实验比较,图6显示了跟踪准确度、成功率的结果。

图6 在OTB-2013和Skiing视频序列上的跟踪结果Fig.6 Results on OTB-2013 and Skiing video sequences

通过上述实验结果说明本文自适应特征融合改进算法在应对形变、旋转、光照变化、背景复杂等多种干扰因素时具有较好的跟踪准确性和鲁棒性。

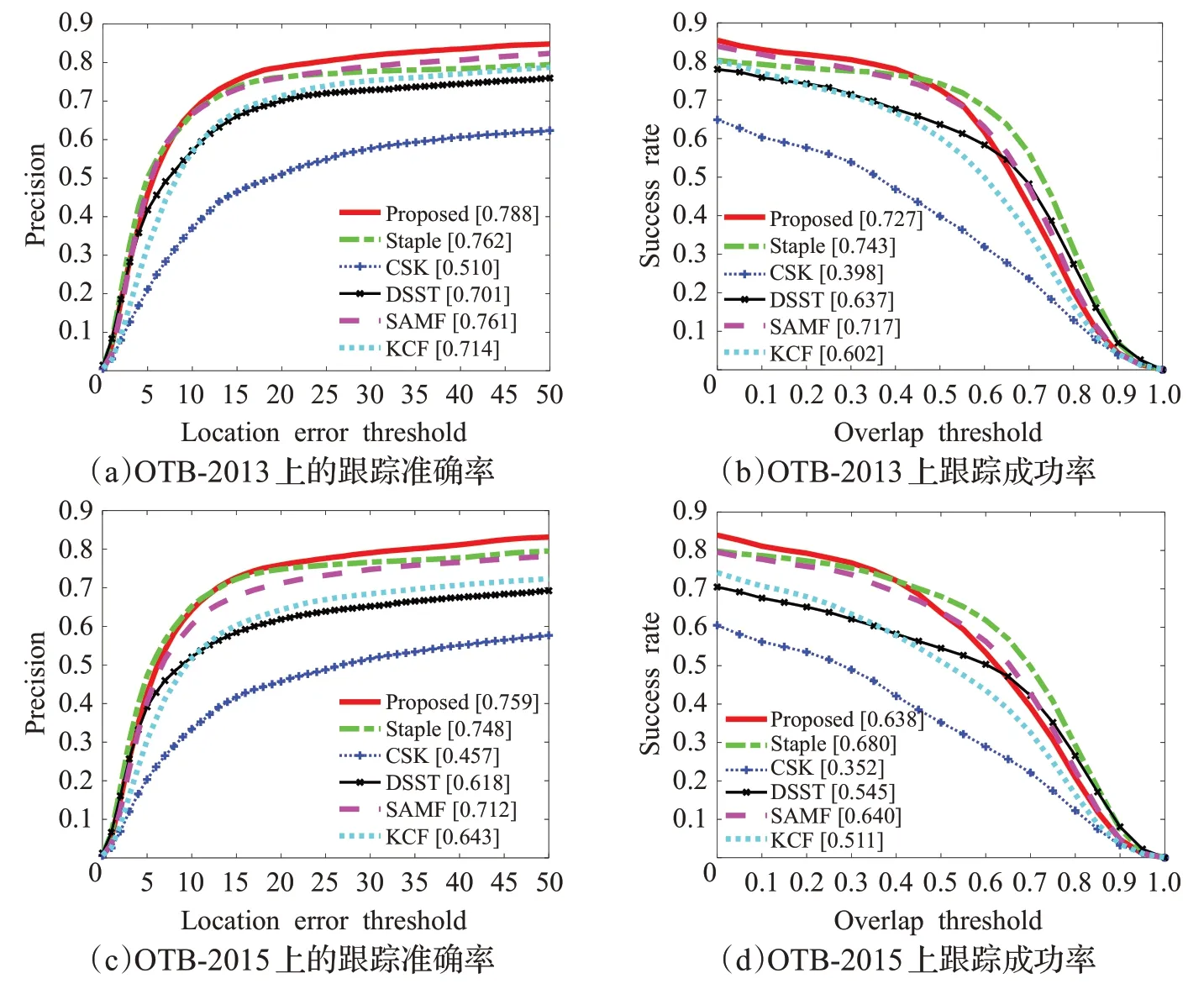

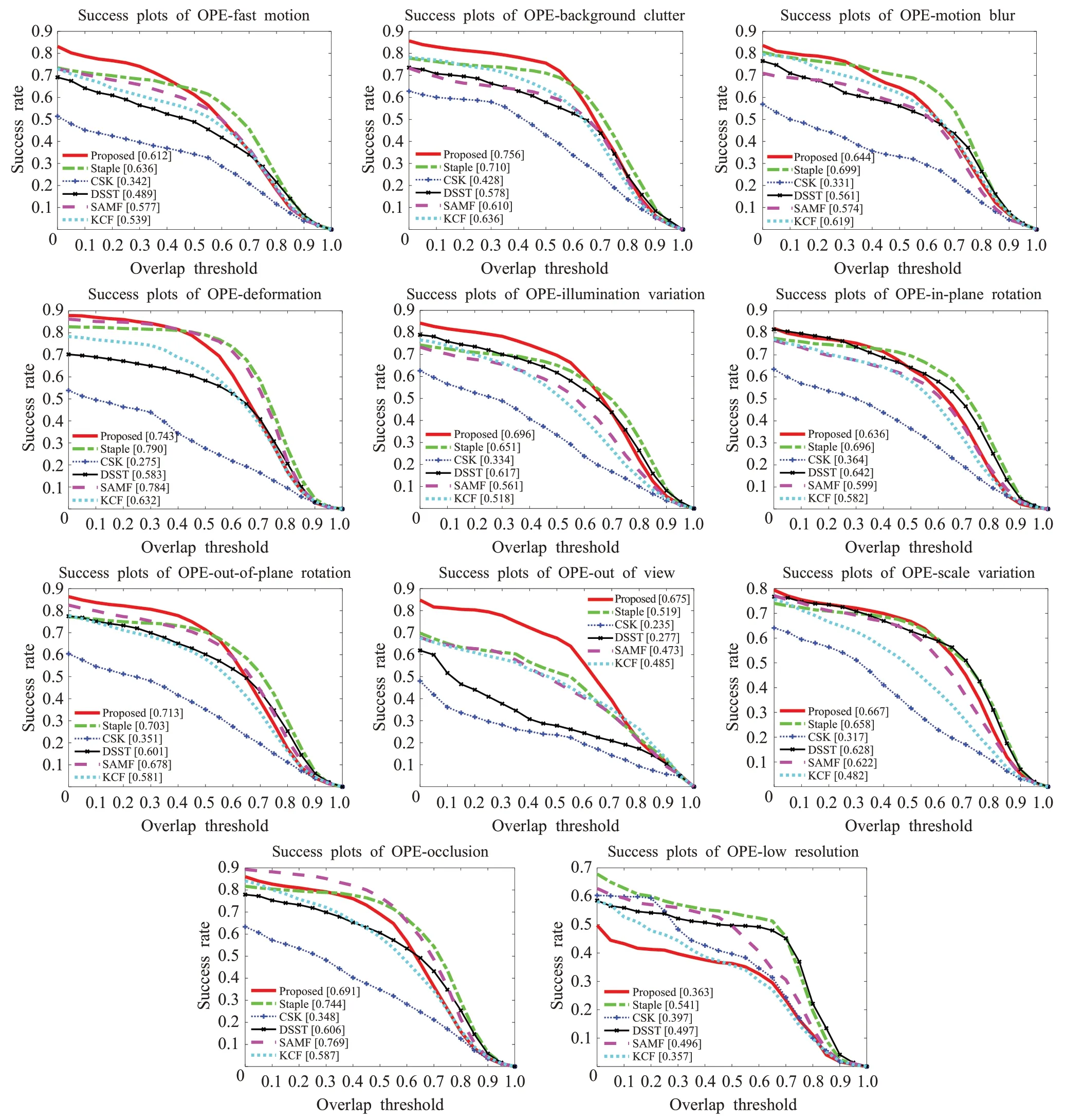

3.3 标准数据集上跟踪算法性能比较

对本文算法进行总体性能评估。在OTB-2013 和OTB-2015的视频序列上与5种近年来效果较好的跟踪算法KCF、CSK、DSST、SAMF、STAPLE进行综合比较,如图7 所示。在OTB-2013 和OTB-2015 中本文算法准确度在所有算法中取得了最优的跟踪结果,与次优的Staple 算法相比,本文算法在精确率方面有3.412%和1.187%的提升;在成功率图上接近最优的Staple 算法,展现了优异的总体性能。表1列出了本文算法与5种跟踪算法运行的平均传输帧率(FPS)、平均精度和平均成功率。

表1 六种跟踪算法在不同基准上的平均跟踪性能参数表Table 1 Mean tracking performance parameters on different benchmarks for six kinds of tracking algorithms

图7 在OTB-2013和OTB-2015的跟踪结果比较Fig.7 Tracking results on OTB-2013 and OTB-2015

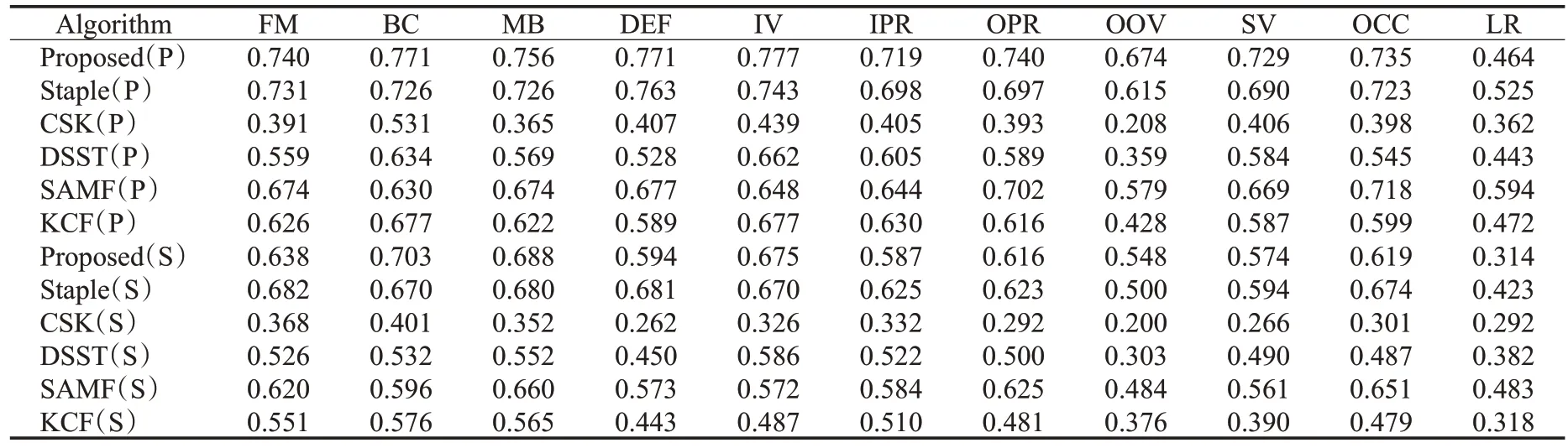

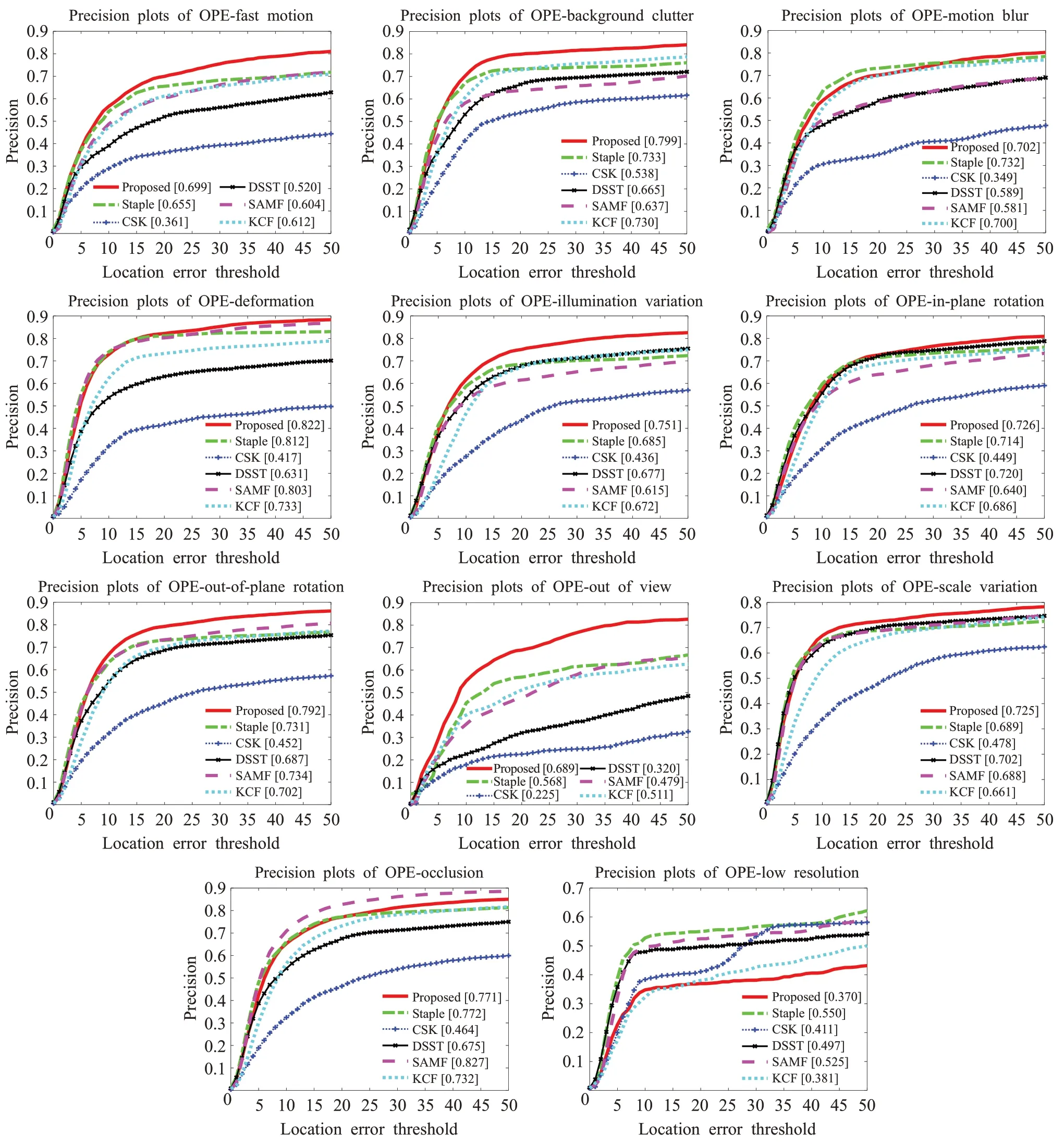

为充分对比各个算法针对不同场景的性能差异,根据OTB-2013数据库中的视频序列场景属性分别在快速运动(fast motion)、背景干扰(background clutters)、运动模糊(motion blur)、形变(deformation)、光照变化(illumination variation)、平面内旋转(in-plane rotation)、平面外旋转(out-of-plane rotation)、目标消失(out-ofview)、尺度变化(scale variation)、遮挡(occlusion)和低分辨率(low resolution,LR)进行跟踪结果比较,图8、9分别显示了跟踪准确率和跟踪成功率,可以看出本文算法跟踪性能优于其他算法。表2显示了在OTB-2015不同场景属性下的跟踪准确率和成功率,也证明了本文算法的有效性。

表2 本文算法与其他5种跟踪算法在OTB-2015环境下的跟踪准确率(P)与成功率(S)对比结果表Table 2 Comparison results between proposed method and other five kinds of tracking algorithms on OTB-2015

图8 OTB-2013中11种场景下各算法的准确率比较Fig.8 Comparison of tracking precision rate for each algorithm under eleven kinds of scenes in OTB-2013

图9 OTB-2013中11种场景下各算法的成功率比较Fig.9 Comparison of tracking success rate for each algorithm under eleven kinds of scenes in OTB-2013

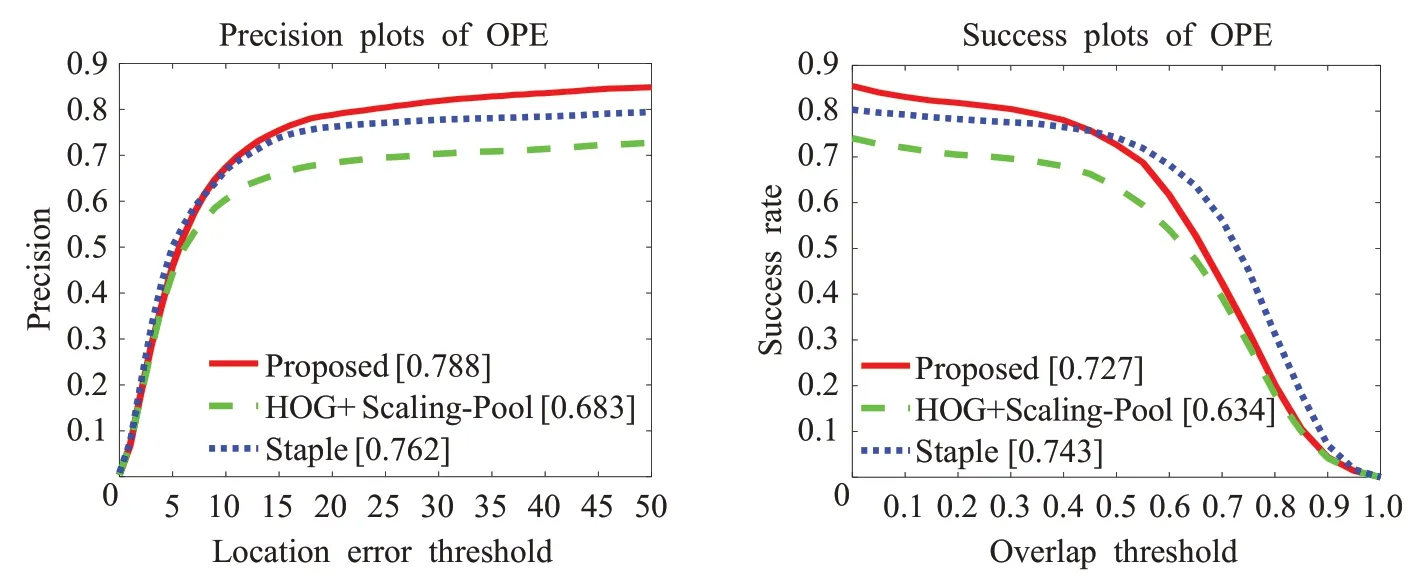

为验证本文HOG 特征与CN 特征融合算法的有效性,将本文算法与基于HOG 特征与尺度池方法(HOG+Scaling-Pool)和Staple 方法(HOG+颜色概率特征,尺度估计采用尺度滤波器)在OTB-2013上进行比较,结果如图10 所示。由于本文算法和Staple 方法增加了颜色特征,所以跟踪性能优于单一HOG特征跟踪方法;相比较Staple方法,本文方法在尺度估计中也融合了颜色信息,所以进一步提高了跟踪效果。

图10 融合特征验证实验Fig.10 Fusion feature verification experiment

本文虽然采用多个相关滤波器和一个颜色直方图模型,但还是基于相关滤波器和颜色概率直方图模型的数学表达,是两个独立的岭回归问题。两种方法均可采用最小二乘与二次正则化方法得到封闭的解,以实现滤波器模型的求解,保证了跟踪算法的稳定性和收敛性,同时实现滤波器模型与新的目标之间相关的可靠性,保证目标的准确定位。通过在标准数据集上OTB-2013与OTB-2015 进行实验分析,可以看出本文跟踪算法在实时性、稳定性、有效性上都具有良好的表现。同时与5种主流跟踪算法进行对比也验证了本文算法的跟踪有效性。

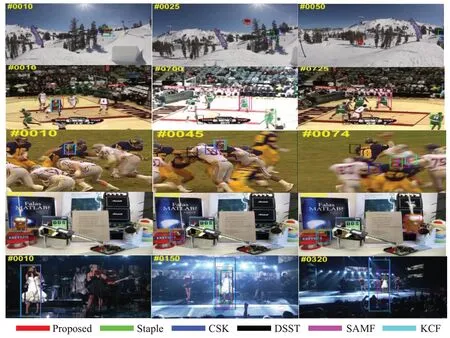

3.4 特定视频跟踪效果比较

实验选取5 组具有代表性的视频序列对本文算法及比较算法进行定性分析,图11 为各算法在每组视频序列中部分帧的跟踪结果展示,视频序列的名称按照从上到下依次为 skiing、basketball、football、lemming 和singer。由图11可见,skiing视频中,视频在第15帧时只有本文算法还能追踪准确,并且在后续的形变、尺度变化、光照变化、面内和面外旋转的干扰下仍能保持跟踪成功;basketball 视频中,也存在明显的尺度变化和形变、光照、背景等干扰因素,本文算法实现了对目标尺度的稳定跟踪;football 视频中主要的干扰因素是运动模糊和尺度变化背景复杂,明显可以看出本文算法优于其他算法。lemming 视频中,目标经历了完全遮挡,尺度变化运动模糊等问题,本文算法在尺度预测和跟踪准确性上有着有益的表现。singer 视频中,存在着尺度变化和光照变化、形变等干扰因素综,本文算法依旧可以有着不错的表现。综上所述,对特定视频进行定性分析的结果进一步验证了本文算法在应对遮挡、形变、旋转、尺度变化、光照变化、背景复杂、运动模糊等多种干扰因素时具有较好的跟踪准确性和鲁棒性。

图11 5组视频上的部分跟踪视频序列Fig.11 Partial tracking results on 5 video sequences

4 结束语

本文提出了一种多相关滤波器下特征自适应融合目标跟踪算法,通过采用CN和HOG特征自适应融合的方式提高相关滤波目标特征的有效性,并利用尺度池方法对目标尺度进行估计和更新,实现了复杂场景下目标的稳定跟踪,并通过在标准数据集上的实验验证了本文算法。