基于Faster R-CNN算法的自主空中加油锥套识别

张宇博,曹有权

基于Faster R-CNN算法的自主空中加油锥套识别

张宇博,曹有权

(中国电子科技集团公司第二十研究所,西安 710068)

随着无人机技术的发展,自主空中加油技术增加了无人机飞行半径和有效载荷,提升了无人机的作战效能。本文针对复杂环境下无人机软管式空中加油的精确引导技术,在无人机自主空中加油近距离对接阶段过程中,对油机锥套识别这个关键环节展开研究。利用深度学习和图形处理,提出一种基于Caffe框架的Faster R-CNN神经网络深度学习的新方法。为了保证该方法的鲁棒性和广泛应用,采用软管式空中加油的真实数据,制作了一个图像的深度学习数据集。根据实验数据验证了基于Caffe框架的Faster R-CNN锥套识别算法的鲁棒性和识别精度,并通过对比实验证明了在复杂的无人机加受油环境中,该识别算法也具有较好的锥套识别能力。

无人机空中加油;计算机视觉;锥套识别;深度学习算法

0 引言

在现代军事活动中,自主空中加油技术可以增加无人机行驶航程和有效载荷,延长航行时间,极大地提高了无人机的效能,扩大了作战半径,增强了战略部署[1]。因此,展开针对自主空中加油关键技术的研究具有重要的意义。目前,基于软管式空中加油即通过软管连接的受油锥套和加油插头对接完成油料的传输。由于其经济性和灵活性,该加油方式尤其适用于无人机空中的自主加受油[2-4]。因此,越来越多的研究人员致力于软管式无人机自主空中加油的技术开发。软管式无人机自主空中加油是一个复杂的过程,一般包括四个阶段:会合阶段、跟踪对接阶段、加油阶段和退出阶段。其中对接阶段是整个加油过程的关键阶段,同时也是风险最大的阶段[5]。受油机的锥套识别对后续获取锥套的相对位置和估计锥套相对姿态至关重要,也是软管式无人机自主空中加油对接阶段的一个关键环节。由于基于视觉的自主空中加油技术具有高准确性和独立性,因此用该方法来解决加受油机对接期间低控制精度和低安全性的问题[6]。虽然视觉在无人机自主空中加油的对接阶段已经有多种应用,但由于锥套受到光照、形变、遮挡等因素影响,使得对锥套识别跟踪有了更多的挑战[7]。

1 锥套识别的研究分析

目前,基于视觉的自主空中加油方法,已经在无人机加受油真实跟踪场景中得到验证,并且在无人机加油的控制精度和安全性等方面取得了良好的效果。Pollini等人在锥套上安装发光二极管[8-11]和涂漆标记[12-14]等人工特征,来辅助测量锥套位置和估计锥套位姿。但该方法容易由放置的标记引起锥套本身遮挡,造成锥套图像局部信息丢失,并且还增加了锥套上的电源线路数量,这为自主空中加油带来了潜在的危险。Wang等人利用一种具有高反射性能的特殊材料制成红色环形特征来进行有效的锥套识别[12-13],该识别方法需要对锥套预先进行一定的修改,在不考虑空气湍流条件的情况下,使用3D Flash Lidar相机对无人机自主空中加油进行地面测试,可以识别从锥套高反射材料返回的强信号。在该领域很多方法都注重采用手动标记锥套特征,对标记点进行检测进而完成对锥套的识别,但手动标记的目标特征对跟踪场景适应性不强,应用不具有普遍性。因此,Yin等人在不使用人工特征的情况下,利用模板匹配和阈值分割来识别自主空中加油中锥套的运动曲线[15]。然而,模板匹配不能解决所有的锥套运动状态,并且由于锥套和环境的变化,使用分割锥套的经验阈值很难确定。Martinez提出了一种基于单目视觉的自主空中加油算法[16],该算法利用复杂的机器实验台,模拟在空中大气湍流条件下估计锥套偏航位置,然而该方法对遮挡的锥套识别鲁棒性差。Gao等人提出了一种基于多尺度、低秩和稀疏分解的识别算法[17-18],在无人工标记特征点的条件下估算出锥套的位置。然而该方法在云、雾、光干扰等复杂环境条件下无法有效识别到锥套。因此,需要更优化的算法来提高对锥套识别的鲁棒性。

近年来,随着深度学习在机器视觉领域的飞速发展,在无人机自主空中加油方面,其准确度已经超越了传统的图像处理方法。与传统的方法不同,深度学习不需要手动设计特征,而是模拟人类的视觉感知系统,根据原始图像特征点进行抽象表达。

基于深度学习的卷积神经网络出人意料地为图像识别和目标识别等诸多问题提供了令人满意的解决方案。Girshick等人提出基于R-CNN网络跟踪方法具有较高的目标识别精度[19]。然而,R-CNN网络的训练在时间和空间耗时费力,而且对目标识别速度慢[20]。此外,R-CNN网络模型大,参数数量多,导致识别速度慢,需要大量的标记数据,经过ImageNet的预训练后再对网络进行再训练[21]。本文研究的Faster R-CNN将卷积神经网络与RPN网络相结合进行目标位置的预测[22],是对R-CNN网络的改进和优化。经改进的网络应用于自主空中加油锥套识别,可以提高识别速度,满足自主空中加油的实时检测需求。因此,利用Faster R-CNN网络框架的锥套识别技术受到了许多研究机构的更多关注。

许多研究人员也一直在使用Caffe,这是一个利用GPU的深度学习框架,具有表达性架构、可扩展代码和高速等优点[23]。本文提出了基于Caffe框架的Faster R-CNN网络,在无人机加受油对接过程中进行实时锥套识别的方法。在自主空中加油目标识别阶段,未对目标锥套进行人工标记特征,此方法既避免了在锥套被局部遮挡时跟踪丢失的问题,又可以在复杂的环境下实现有效的锥套识别。首先,为确保在复杂环境下实现对锥套识别具有较高的准确性和鲁棒性,该方法直接使用真实空中加油视频中提取的锥套图像作为数据集,而不是利用发光二极管或其他手动标记的锥套图像网络训练和测试。软管式空中加油视频包含了在各种复杂环境中,如晴天、多云、雾天和强光干扰下,不同形状、大小和局部遮挡的锥套图像。然后,利用GPU在Caffe框架上采用真实的软管式空中加油数据进行Faster R-CNN训练。最后,分析该方法的识别结果及其精度,并与其他识别方法进行了比较。实验结果表明,该方法在各种不同的环境中都能有效地进行锥套识别,是机器视觉应用深度学习方法成功的又一例证。本文的贡献可以总结如下:

(1)提出软管式自主空中加油对接阶段中进行实时锥套识别的框架,该框架使用GPU在Caffe框架上进行Faster R-CNN训练;

(2)将卷积神经网络与GPU结合,而不使用人工附加特征;

(3)锥套识别方法具有较高的鲁棒性,不仅可以对局部遮挡的锥套进行准确识别,而且在云、雾、强光干扰等复杂的环境条件中都能有效地识别锥套;

(4)锥套识别方法具有高精度、强鲁棒性和快速的识别性能。

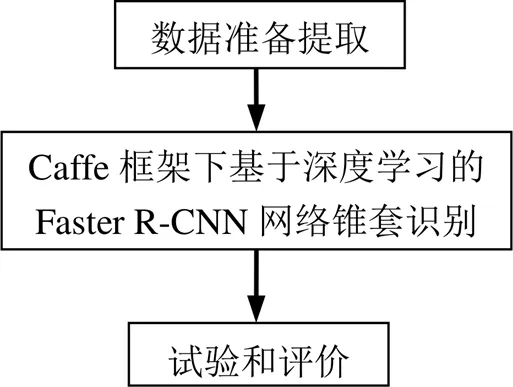

2 锥套识别系统的设计

本文提出了一种基于Faster R-CNN网络的Caffe框架,用于软管式自主空中加油对接阶段,对加油锥套进行识别。为了保证系统的鲁棒性和精确性能,预先准备了一个包含各种环境中不同加油锥套的数据集,用于学习加油锥套的浅层和深层特征,Faster R-CNN识别算法采用GPU在Caffe框架上对真实的锥套数据进行实验,在不同的环境中,研究了基于多尺度、低秩和稀疏分解的识别结果,并将其与本文所提出的方法进行比较。基于Caffe框架的Faster R-CNN神经网络的软管式自主空中加油的锥套识别流程如图1所示。

图1 锥套识别流程图

3 锥套识别方法

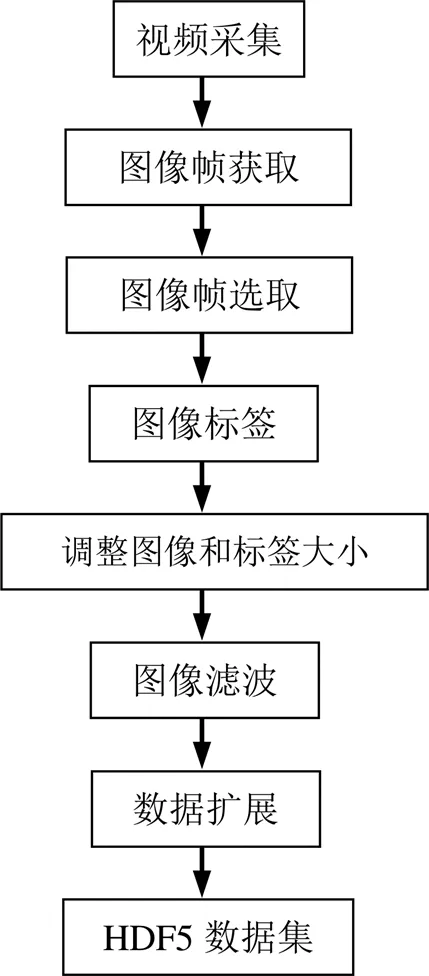

3.1 数据集的准备

为了确保在各种环境条件下对锥套识别具有较好的鲁棒性,本文提出的锥套识别方法使用从软管式空中加油视频中提取的加油锥套的真实自主空中加油图像。软管式空中加油视频包含了各种环境条件,如晴朗、多云、雾天和强光干扰,以及加油锥套形变、大小和遮挡等。所制备的数据集包含四个关键组成部分:软管式空中加油的原始视频采集;图像帧的提取、选择和标记;原图像及相应标签的调整、滤波和增强;数据格式转换。基于Faster R-CNN网络的加油锥套识别数据集准备流程如图2所示。

图2 数据集的准备

数据准备的具体步骤如下:

(1)软管式空中加油的原始视频采集

由于加油锥套识别任务缺少已有的数据集,原始的软管式空中加油视频集会起到重要的基础性作用,此数据集更有利于神经网络学习锥套的原有特征。因此,软管式空中加油视频尽可能包含诸如晴朗、多云、雾天、强光干扰等复杂的实际场景中不同形状、大小和局部遮挡的锥套图像。而对于加油视图中的视频,特别是软管式空中加油近距离对接阶段的视频,需要进一步放大处理。

(2)图像帧的提取、选择和标记

在Linux平台服务器上,通过视频处理工具从软管式空中加油视频中提取图像帧。为减少冗余信息和节省样本后续标记的时间,本实验以每秒1帧的速度提取图像,在进行基于Faster R-CNN神经网络的锥套识别时,可以使用GPU实现大于30帧/s的锥套检测,即可满足无人机加受油对接的实时性识别要求。

提取图像帧后,选择带有锥套的图像,使用Matlab软件中的LabelMe工具进行锥套标注。在提取的图像帧上,锥套区域使用一个方框进行标记,方框的四个边(顶部、底部、左侧和右侧)标记了锥套的位置。每个图像中的方框四个坐标构成的区域,对应着原始图像中锥套的候选区域。

(3)调整图像尺寸以及相应的标签,并进行图像的滤波和增强

使用四坐标方框标记锥套区域后,为了方便处理和满足神经网络深度学习的要求,将RGB图像调整为256×256个像素与对应的标签(坐标)一致。

本文主要关注的是软管式自主空中加油的近距离对接阶段,然后对调整后的图像进行进一步滤波,每个标记区域的阈值为20个像素(阈值1)大小。滤波后,标记区域的大小超过20个像素,平均为65个像素。

为了模拟扰动引起的锥套运动,同时放大数据集,对滤波后的图像分别在50个像素(阈值2)和10度(阈值3)内进行平移和旋转增强。需要注意的是在软管式自主空中加油对接阶段,由于各种环境干扰,锥套可能在水平和垂直轴上任意程度地无序移动,从而获取锥套在每一帧中的形状和大小变化。

(4)数据格式转换

将扩充后的数据集(包含相应标签的图像)转换为HDF5数据格式,满足Faster R-CNN的Caffe深度学习框架。HDF5数据集由两部分组成:形状为×3×256,以及标签的形状为×8,其中为HDF5数据集中的图像数量。

数据集包括41个软管式空中加油的原始视频、原始视频列表、从视频中提取的1985张原始图像以及原始图像的标签。并且经过调整锥套图像尺寸以及相应的标签,再将锥套图像经过滤波和增强之后存入数据集,最终数据集包含超过100 000张锥套图像。

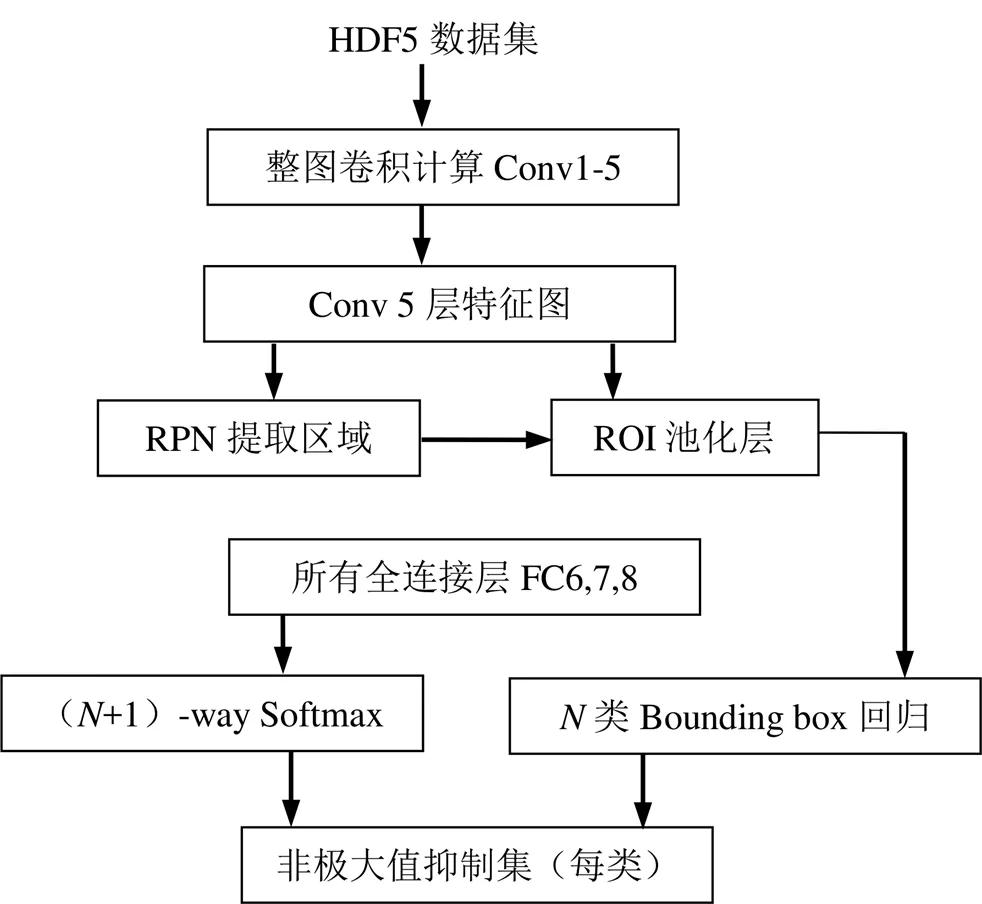

3.2 基于Faster R-CNN网络的锥套识别模型

3.2.1 算法描述

根据实际自主空中加油数据中锥套的特征,提出了基于Caffe框架的Faster R-CNN的视觉近距离锥套识别算法模型,它包含了HDF5数据集、卷积、池化、RNP网络、激活层、全连接层、失活层、ROI Pooling和欧式损失等多个模块。由于R-CNN的模型可以从数据中预测边界框,但很难推广到具有新的或不寻常的纵横比或配置的对象。本文模型也使用相对粗糙的特征来预测边界框,因为对输入神经网络的图像Faster R-CNN架构有多个下采样层。R-CNN使用区域建议而不是滑动窗口来查找图像中的目标。有选择性地搜索生成潜在的边界框,卷积网络提取特征,支持向量机对边界框进行评分,线性模型调整边界框,非最大抑制消除重复检测。这个复杂管道的每个阶段均独立精确地进行调优。

R-CNN的每个网格单元提出一个潜在的边界框,并使用卷积特性对这些框进行评分。然而,本文的识别模型对网格单元的建议设置了空间限制,这有助于减轻对同一目标的多次检测。其他的快速检测器如Fast R-CNN和Faster R-CNN,主要通过共享计算和使用神经网络的建议窗口来代替选择性搜索[14]以加速R-CNN框架。与R-CNN相比,Fast R-CNN和Faster R-CNN在速度和精度上都有提高。本文提出的锥套识别算法流程如图3所示。

图3 Faster R-CNN算法流程图

R-CNN是通过Selective Search方法等预处理步骤来提取候选区域作为CNN网络输入,但有严重的速度瓶颈。因为计算机在对所有的区域进行特征提取时会有重复计算。而Faster R-CNN可以很好地解决这个冗余计算问题,Faster R-CNN是对R-CNN算法的优化改进,在提取目标的候选区域时,Faster R-CNN算法摒弃了滑动窗口和Selective Search方法,直接使用RPN网络来生成目标建议区域,这样能极大地提升检测框生效的速度。RPN网络结构分两条主干,一部分是用于计算对于anchors的边框回归偏移量,以获取精准的建议区域;另一部分是通过Softmax分类anchors获得目标和背景信息。RPN网络使用9个不同尺寸的anchors遍历卷积层获取的特征图,为每一个点都配备这9个anchors作为初始的检测框,并且通过后面两次边框回归偏移量来修正检测边框的位置。9个anchors提取的256个建议区域,相当于R-CNN的Selective Search提取约2000个候选区域。RPN网络降低了计算复杂度,使得候选区域提取目标更有针对性,从而提升了Faster R-CNN算法的检测目标速度和精度。然后在使用卷积神经网络对区域建议框提取特征向量,并将特征向量输入到全连接层中获得Softmax分类的概率值和边框回归值。

不同尺寸的候选区域锥套识别具体算法描述如下:

首先,将输入图像与卷积层上的滤波器进行卷积、池化生成特征图。利用滤波器将输入图像进行卷积运算,再使用激活函数得到该层的输出特征如式(1)所示:

在获取特征图过程中,为了减少网络参数,降低网络计算量和过度拟合,本文采取最大池化和随机失活。这两种方法都减少了神经网络中的过拟合,提高了训练的速度,从而可以使学习的特征更具有鲁棒性,更好地处理泛化的新数据。

然后,将特征图输入到RPN提取区域,并对所有的候选区域进行前景和背景的判断,使用边框回归偏移量来修正anchor,以获取精确的检测边框位置。

最后,通过ROI pooIing层形成固定大小的特征图,进行全连接操作,利用Softmax进行具体目标类别的分类,并再次使用边框回归获取最终检测边框的精准位置,对检测边框做非极大值抑制同时获取置信度最大的检测框,确定为期望目标的检测位置同时计算损失。将锥套识别结果放入欧式距离损失,根据识别结果和真实标签得到锥套识别误差。欧式距离损失定义如式(3)所示:

通过参考损失函数利用反向传播算法对网络参数进行调优,训练网络模型得到最优网络参数,利用所获取的网络参数可以得到最优的锥套识别结果。

4 实验和讨论

在本节通过实验验证Faster R-CNN算法对空中加油锥套识别的有效性。此外,还将讨论该方法的检测结果和精度分析,并与其他方法进行比较。

4.1 实验环境

锥套检测实验是在真实的自主空中加油数据上进行的——从软管式空中加油视频中提取的真实图像,使用的锥套没有Led等人工特征或油漆标记。软管式自主空中加油视频包含各种情况,如晴朗、多云、雾天和光干扰条件,以及不同形状、大小和遮挡的锥套图像。需要注意的是,软管式空中加油的真实视频已经包含了实际加油对接真实的环境干扰。

训练数据集包含加油视图和非加油视图的锥套图像。测试数据集只包含加油视图的锥套图像,特别是在空中加油的近距离对接阶段拍摄的图像。因此,在本实验中采用交叉验证策略来评估该方法的性能。

该算法使用Python编程语言实现,环境为Ubuntu 14.04.1 LTS (GNU/Linux 3.13.0-32-generic x86_64),Intel Xeon E5-2620 v2六核处理器2.1 GHz 的CPU和NVIDIA GeForce GTX TIT的GPU。

4.2 实验结果

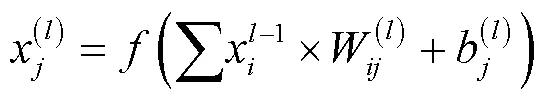

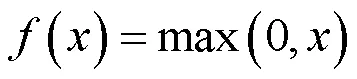

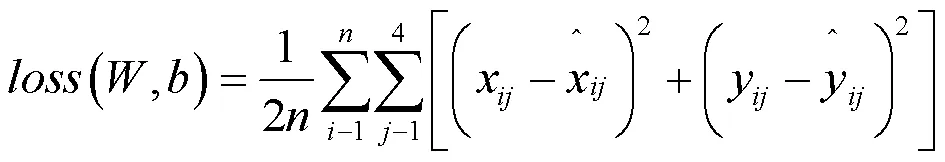

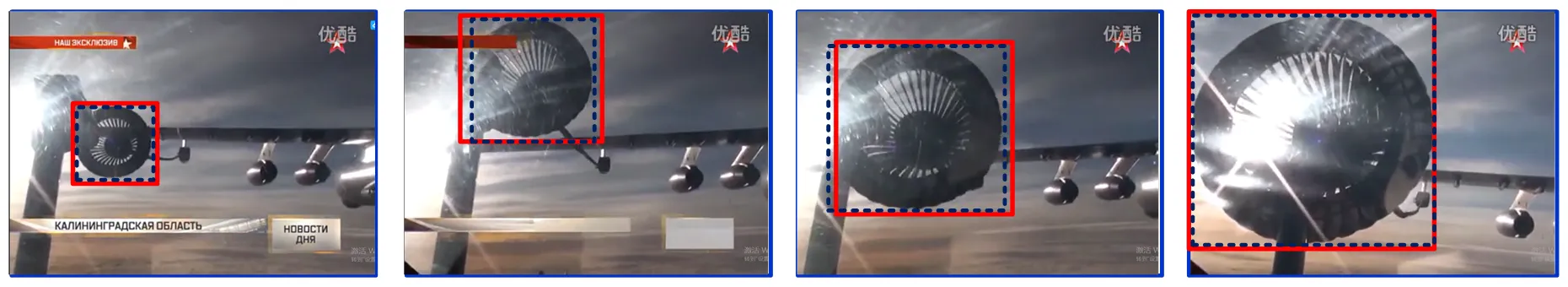

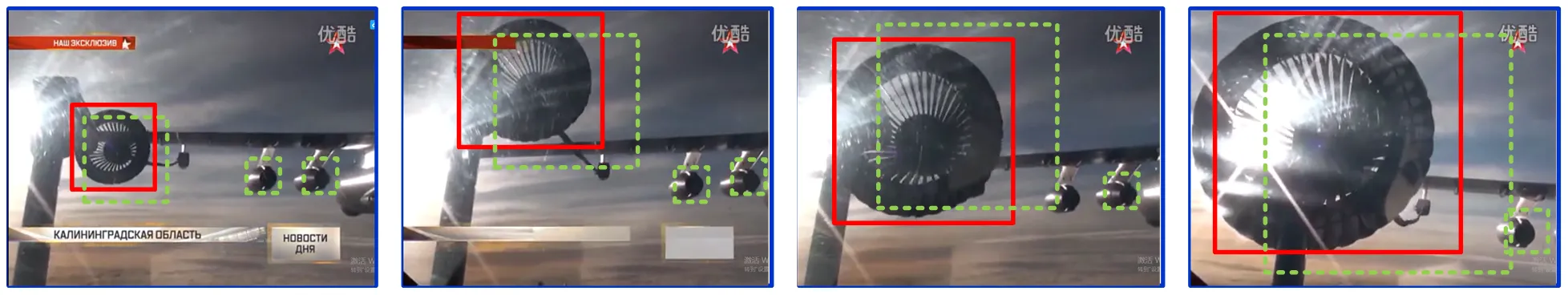

实验在基于Caffe框架的Faster R-CNN神经网络模型上,对软管式空中加油的真实数据进行识别测试。本文方法在各种环境条件下的锥套检测结果如图4~图6所示。图中的实线框和虚线框分别表示真实标签和预测标签。图4是在天气晴朗的环境中,对不同形状、大小和遮挡的锥套的检测结果。从图4中可以看出,本文提出的检测方法具有良好的检测性能和较高的检测精度。图5是在多云和雾天环境中,对不同形状、大小和水雾遮挡的锥套检测结果。在图5中,虽然环境条件不是很理想,但是锥套检测的准确性和性能仍然很好,只是略低于图4。图6所示为仰视目标检测的结果,具有不同形状、大小和遮挡的锥套的强光干涉条件。在图6中,尽管环境条件比较极端,但锥套检测的准确性和性能与图5相似,略低于图4。从图4~图6中可以看出,本文提出的基于Caffe框架的Faster R-CNN算法对空中加油锥套识别,在各种环境条件下都具有良好的准确性和鲁棒性。

图4 在晴天环境下锥套的识别结果

图5 多云、多雾环境下锥套的识别结果

图6 强光干涉环境下锥套的识别结果

在自主加油对接阶段的锥套检测阶段,无人机上安装的视觉传感器获取的图像通常包含加油锥套以及在各种环境条件下的无人机和天空部分。锥套之外的背景区域在某种程度上相对不复杂。因此,锥套检测需要简单快速的神经网络和真实空中加油锥套的图像就可以有效地工作;因此,Faster R-CNN算法适用于不同的环境,检测速度可满足自主空中加油的要求。对分辨率为256×256的图像,本文算法使用GPU的时间开销优于每30帧/s,适用于软管式自主空中加油对接阶段的实时锥套检测应用。在实际空中加油数据上的实验结果表明,该方法在各种条件下都能有效地进行实时精准的锥套识别。

4.3 实验结果的评价与分析

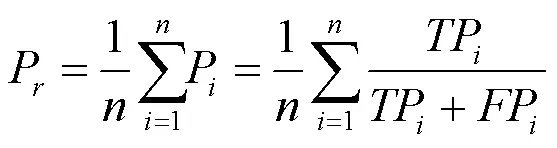

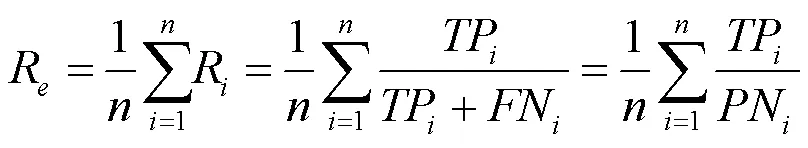

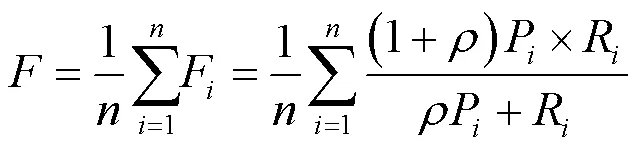

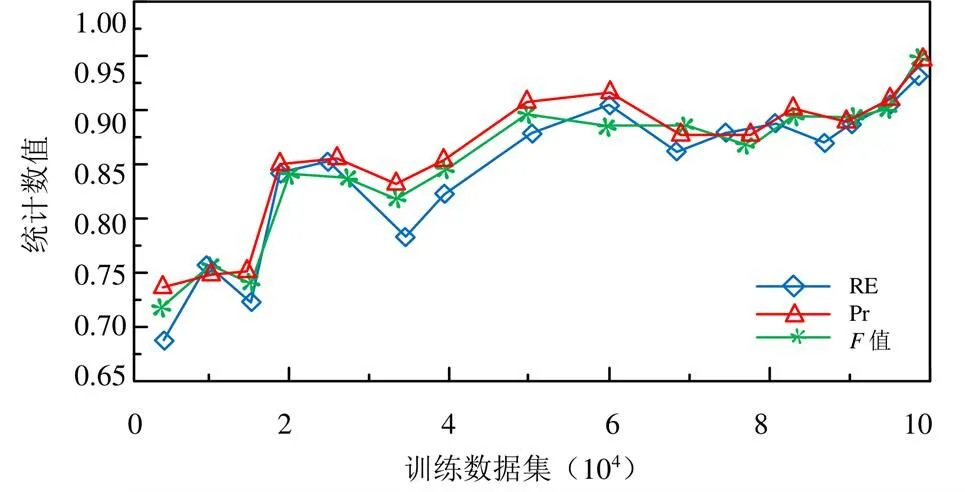

为定量评价锥套检测的精度是否满足软管式自主空中加油系统对高精度的要求,应用了精确度、召回率和F值统计标准,精确度如式(4)所示:

召回率如式(5)所示:

图7 基于Faster R-CNN的锥套检测性能统计

4.4 不同算法在相同帧中锥套识别进一步验证

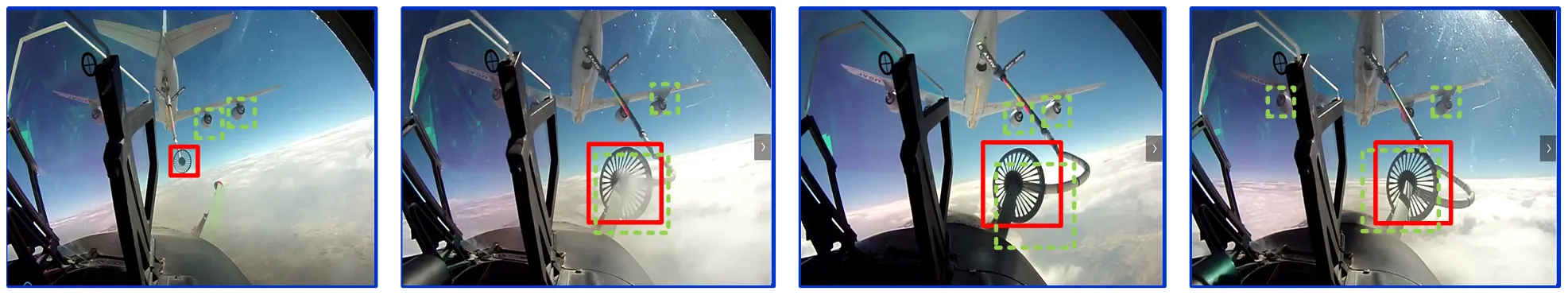

为了进一步验证运用基于Caffe框架的Faster R-CNN网络进行空中加油锥套识别的有效性,将本文算法与Gao等人提出的多尺度、低秩和稀疏分解的识别算法相比较。在真实的不同环境空中加油视频中进行锥套实时检测,检测效果如图8~图10所示,其中实线框和虚线框分别表示Faster R-CNN和多尺度、低秩稀疏分解的检测结果。可以看出实线识别框能够在复杂的场景中稳定锁住识别目标,即使在强光、多云和遮挡的情况下都能够准确识别锥套没有发生抖动、漂移和误检。而虚线框在这些环境干扰的情况下发生了抖动和漂移,不能够准确识别锥套位置,在多云多雾环境中发生了未能检测的锥套,并且把圆形的发动机和机尾误检成了目标。

因此,真实加油视频中相同帧的锥套检测结果表明基于Caffe框架的Faster R-CNN网络的锥套识别方法,能够在各种环境条件下获得锥套高精度的实时检测,对锥套遮挡和复杂的天气环境情况具有很强的鲁棒性。这些都表明了本文所提出方法的有效性。

图8 强光干涉环境下锥套的识别结果

图9 多云、多雾环境下锥套的识别结果

图10 在晴天环境下锥套的识别结果

5 结论

在软管式自主空中加油对接阶段利用GPU,利用基于Caffe框架的Faster R-CNN神经网络实现实时的锥套检测,不需要人工标记。实际空中加油数据的实验结果表明,该方法具有精度高、鲁棒性强、速度快、不受遮挡和复杂环境条件影响的特点。

基于软管式空中加油的真实数据集,包含各种环境情况,对没有人为特征标记的锥套识别,这表现出本文识别算法具有较高的稳健性和准确性。本文提出了一种在Caffe框架中Faster R-CNN神经网络的实时锥套检测模型。通过真实空中加油数据的实验结果表明,该方法能够有效地进行锥套识别检测,能够满足软管式自主空中加油的要求,是深度学习方法成功应用的又一例证。本文所提出的方法在利用深度学习进行真实环境下的锥套检测方面具有很大的潜力,可以避免LED的放置或绘制特征,在软管式自主空中加油的实际应用中具有竞争力和吸引力。

由于真实空中加油锥套数据集的不断丰富和深度学习识别方法的不断成熟发展,将更有价值的真实空中加油数据与智能深度学习相结合,可以进一步提高锥套检测的性能,值得进一步研究。

[1] Nalepka JP, Hinchman JL. Automated aerial refueling:extending the effectiveness of unmanned air vehicles[R]. Reston:AIAA, 2005. Report No.: AIAA-2005-6005.

[2] Hansen JL, Murray JE, Campos NV. The NASA Dryden AAR project: a flight test approach to an aerial refueling system[R].Reston:AIAA,2004.ReportNo.:AIAA-2004-4939.

[3] Campa G, Napolitano MR, Perhinschi M, etc. Addressing pose estimation issues for machine vision based UAV autonomous serial refueling [J]. Aeronaut, 2007,111(1120):389–396.

[4] Dong XM, Xu YJ, Chen B. Progress and challenges in automatic aerial refueling[J]. Air Force Eng Univ Nat Sci Edn 2008,9(6):1–5.

[5] Ding M, Wei L, Wang BF. Vision-based estimation of relative pose in autonomous aerial refueling[J]. Chin J Aeronaut 2011;24 (6):807–815.

[6] Chen CI, Stettner R. Drogue tracking using 3D flash lidar for autonomous aerial refueling[C]// Proceedings of SPIE 8037, laser radar technology and applications XVI 2011 Jun 8. Orlando, USA. Bellingham: SPIE, 2011. p. 1–11.

[7] Martı´nez C, Richardson T, Campoy P. Towards autonomous air-to-air refuelling for UAVs using visual information[C]// Proceedings of IEEE international conference on robotics and automation; 2013 May 6–10. Karlsruhe, Germany. Piscataway (NJ):IEEE Press; 2013. p. 5736–5742.

[8] Pollini L, Campa G, Giulietti F, Innocenti M. Virtual simulation set-up for UAVs aerial refueling[R]. Reston: AIAA. 2003. Report No.: AIAA-2003-5682.

[9] Mati R, Pollini L, Lunghi A, etc. Vision-based autonomous probe and drogue aerial refueling[C]// Proceedings of IEEE 14th mediterranean conference on control and automation; 2006 Jun 28–30. Ancona, Italy. Piscataway (NJ): IEEE Press; 2006. p. 1–6.

[10] Pollini L, Mati R, Innocenti M, etc. Napolitano M. A synthetic environment for simulation of vision-based formation flight[R]. Reston: AIAA; 2003. Report No.: AIAA-2003-5376.

[11] Xie HW, Wang HL. Binocular vision-based short-range navigation method for autonomous aerial refueling [J]. Beijing Univ Aeronaut Astronaut 2011,37(2):206–209.

[12] Wang XF, Dong XM, Kong XW. Feature recognition and tracking of aircraft tanker and refueling drogue for UAV aerial refueling[C]// Proceedings of 25th IEEE Chinese control and decision conference,2013 May 25–27. Guiyang, China. Piscataway (NJ): IEEE Press,2013. p. 2057–2062.

[13] Wang XF, Kong XW, Zhi JH, etc. Real-time drogue recognition and 3D locating for UAV autonomous aerial refueling based on monocular machine vision [J]. Aeronaut, 2015,28(6):1667–1675.

[14] Chen CI, Koseluk R, Buchanan C, etc. Autonomous aerial refueling ground test demonstration:a sensor-in-the-loop and non-tracking method[J]. Sensors, 2015,15(5):10948–10972.

[15] Yin YJ, Xu D, Wang XG, etc. Detection and tracking strategies for autonomous aerial refuelling tasks based on monocular vision [J]. Robot Syst., 2014, 11(1):399–412.

[16] Martı´nez C, Richardson T, Thomas P, etc. A vision-based strategy for autonomous aerial refueling tasks[J]. Robot Auton Syst, 2013,61(8):876–895.

[17] Gao SB, Cheng YM, Song CH. Drogue detection for vision-based autonomous aerial refueling via low rank and sparse decomposition with multiple features[J]. Infrared Phys Technol, 2013,42(4):1089–1094.

[18] 宋春华,高仕博,程咏梅. 自主空中加油视觉导航系统中的锥套检测算法[J]. 红外与激光工程,2013,42(4).

[19] Girshick R, Donahue J, Darrell T, Malik J. Rich feature hierarchies for accurate object detection and semantic segmentation [J]. Proceedings of IEEE conference on computer vision and pattern recognition; 2014 June 23–28. Columbus, USA. Piscataway (NJ): IEEE Press; 2014. p. 580–587.

[20] Girshick R. Fast R-CNN[C]. Proceedings of IEEE international conference on computer vision; 2015 December 11–18; Santiago, Chile. Piscataway(NJ):IEEE Press,2015:1–9.

[21] Ren SQ, He KM, Girshick R, etc. Faster R-CNN: Towards real-time object detection with region proposal networks[C].Proceedings of neural information processing systems; 2015 December 5–10; Montreal, Canada,2015: 1–14.

[22] 冯小雨,梅卫,胡大帅. 基于改进Faster R-CNN的空中目标检测[J]. 光学学报,2018,v.38,435(6):250-258.

[23] Jia YQ, Shelhamer E, Donahue J, etc. Caffe: convolutional architecture for fast feature embedding[C]. Proceedings of 22nd ACM international conference on multimedia; 2014 November 3–7. Orlando, USA. New York: ACM,2014:1–4.

[24] Cheng MM, Mitra NJ, Huang XL, etc. Global contrast based salient region detection[J]. IEEE Trans Pattern Anal Mach Intell 2015,37(3):569–582.

Automatic Identification of Aerial Refueling Cone Sleeve Based on Faster R-CNN Algorithm

ZHANG Yubo, CAO Youquan

With the development of UAV technology, autonomous aerial refueling technology increases the flight radius and payload of UAV and improves the combat effectiveness of UAV. The paper focuses on the precise guidance technology of UAV hose aerial refueling in complex environment, and studies the key link of drogue detection during the close docking phase of UAV autonomous aerial refueling. Using deep learning and graphics processing unit, a new method based on Faster R-CNN neural network is proposed. In order to ensure its robustness and wide application, an image deep learning data set was made by using real data of hose aerial refueling. Based on the experimental data, the robustness and identification accuracy of the identification algorithm based on Caffe framework Faster R-CNN cone sleeve were verified, and the comparison experiment proved that the identification algorithm also had better identification ability of cone sleeve in the complex UAV oil-feeding environment.

UAV Aerial Refueling; Computer Vision; In-Depth Learning Algorithm; Drogue Detection

V249

A

1674-7976-(2021)-04-297-09

2021-03-30。张宇博(1991.06-),陕西商洛人,硕士,主要研究方向为视觉导航和卫星导航。