番茄果实串采摘点位置信息获取与试验

梁喜凤,金超杞,倪梅娣,王永维

(1. 中国计量大学机电工程学院,杭州 310018;2. 乐清市委市政府农村工作办公室,乐清325600;3. 浙江大学生物系统工程与食品科学学院,杭州 310058)

0 引 言

农业果蔬自动收获是实现农业生产自动化、智能化发展的重要环节,对降低生产成本,提高农业作业的效率等具有重要意义。目前,国内外学者对各类果实采摘机器人进行了大量理论和试验研究。如日本Monta等[1-4]开发了葡萄、番茄、草莓等水果的自动采摘机器人,主要由机械手、末端执行器、视觉传感器和行走装置组成,能够在温室或野外自动工作;Henten等[5]研究了黄瓜机器人的采摘环境与流程,包括移动机构、7DOF机械手、视觉系统、采摘手爪等,其视觉系统识别率达到 95%,成功采摘率为 80%。在果实识别和定位方面,张铁中等针对黄瓜[6]、番茄[7]、茄子[8]、草莓[9]等多种果蔬收获进行了研究,在解决草莓的重叠问题上,引入了BP网络与聚类分割和分水岭法,试验表明其方法具有通用性。熊俊涛等[10-11]提出了扰动条件下荔枝的识别定位方法,通过搭建震荡平台模拟自然环境下的震荡扰动过程,利用聚类分割结合霍夫直线检测求解坐标点,试验表明,采摘点定位深度误差小于6 cm,采摘点计算精度位于87.5%~97.5%之间,满足末端执行器采摘需求;同时进行了自然环境中的微扰动柑橘的识别,确定了扰动果实采摘点,准确率达85%[12]。郭艾侠等[13]提出了一种融合Harris与sift算法的荔枝采摘点计算与立体匹配方法,计算采摘点的匹配成功率可达89.55%。武涛等[14]提出的猕猴桃分割方法可以较好地将猕猴桃从背景中分离出来;罗陆锋等[15]在葡萄串的采摘点定位研究过程中,将提取出的果梗边缘图通过Hough直线检测的方法检测出线段,并求出所有已检测的线段与葡萄串的质心垂线距离,根据生长规则,与质心距离最小线段的中心点被设定为采摘特征点,采摘点定位准确率达88.33%;戚利勇[16]根据双目视觉原理计算了黄瓜采摘点空间坐标,相对于物距 500~750 mm,最大定位误差 9.46 mm。王丹丹等[17]提出了基于平滑轮廓对称轴算法的苹果目标采摘点定位方法,试验表明平滑轮廓算法可以提高定位精度和运算效率。宋西平等[18]运用机器视觉技术实现葡萄目标从相机图像获取到采摘点三维空间数据计算的实现过程, 获得了葡萄采摘点的三维坐标,采摘点的X、Y、Z方向的最大位置误差分别为1.216、2.588、1.851 mm,满足机器人采摘定位的要求。梁喜凤等[19]基于提取番茄果实串连通区域边界的采摘点识别方法,对垂直向下的串番茄采摘点识别效果较好。Ruiz等[20]利用颜色分割法和细化算法确定柑桔果梗的长度和采摘点的位置,成功率达到96.2%。Wang等[21]采用小波变换和K-均值聚类法进行荔枝果实串在复杂自然环境中的识别和定位,识别定位效果良好,Wei等[22]研究了一种复杂农业背景中提取成熟果实的方法,对番茄、石榴、草莓、柿子 4种果实进行了试验,识别成功率达95%以上。

上述研究成果为果实采摘机器人开发奠定了坚实的基础,但现有针对番茄、黄瓜、猕猴桃等研究成果均是单果采摘进行的,果实串采摘如葡萄,主要进行了特有种植模式下提取采摘点的研究,而葡萄与鲜食番茄果实串形状、果实分布等均不同,因此现有的果实采摘技术与方法不能直接用于番茄果实串采摘。

鲜食番茄是中国重要的果蔬之一,目前中国番茄的收获基本都是靠人工采摘,通常对成熟番茄进行逐个采摘。这种单果采摘方式存在劳动力成本高、效率低、果实易损伤等问题。近年来国内外普遍种植一种新的番茄品种——串番茄[23],这种番茄通常每穗有果实3~5个,当果穗上最后一个果实进入转色期后整穗采摘、贮存、运输、销售,番茄品种和种植模式的改变,为成串果实采摘提供了条件。成串采摘能够提高采摘效率,降低收获成本,采摘时机器人末端执行器夹持果实串的果梗,而不需要直接接触果实,能够大大减少采摘过程中造成的果实损伤。果梗采摘点的位置准确确定是采摘成功的关键,本文以番茄果实串为研究对象,研究番茄果实串果梗采摘点位置信息获取方法。

1 番茄果实串图像分割与质心获取

1.1 材料与方法

番茄果实串的单幅图像采集于嵊州蓝城农业基地,单图像处理时,利用Sony TX30数码相机从果实串侧面拍摄,采集图像110幅,单幅图像大小为1 920´1 440像素,为后期便于操作将原始图像通过改变像素进行图像压缩至800´800像素。

1.2 果实串图像分割

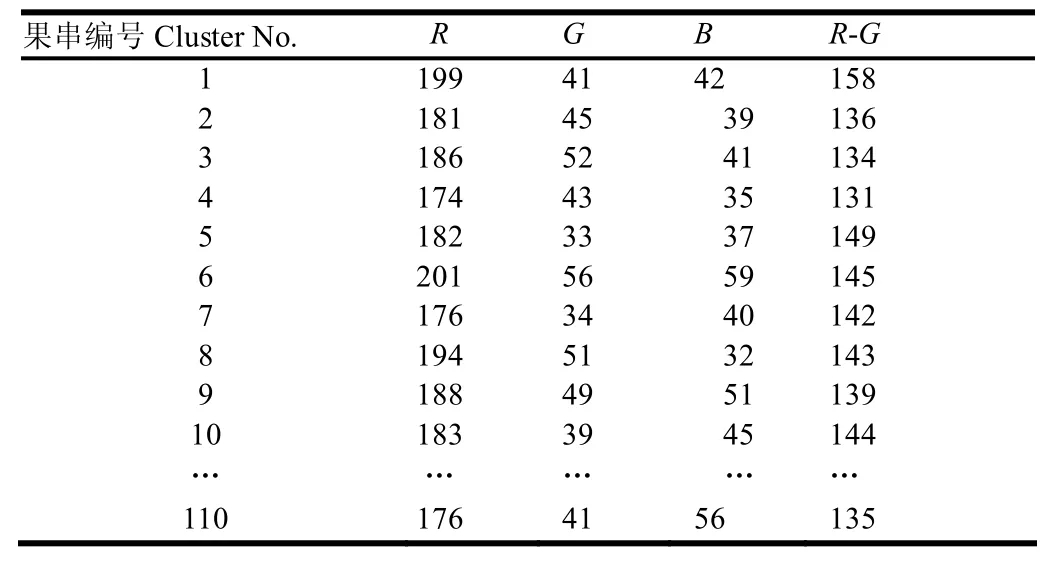

为分析目标果实串与背景颜色因子的差异,在RGB模型下,将果实串图像划分为成熟果实、果梗、未成熟果实和叶片区,提取番茄果实串各个区域的颜色因子,采用R-G分量差处理,部分数据如表1所示。

表1 成熟番茄区域R-G颜色分量差值Table 1 Difference between R and G in mature tomato clusters

由表1可知,成熟果实串区域R-G分量差大于100,番茄果实串与背景差异最为显著,且番茄果实串的R-G直方图呈现双峰分布。利用最大类间方差法(Otsu)[24-25]进行目标果实串分割。将番茄果实串R-G图像从1到T划分不同灰度等级[26],图像以t阈值为基准划分为2个区域X1={1,2, 3,…,t}和X2={t+1,t+2,t+3,…,T}(t为动态阈值),设每个级别的灰度概率为

式中N代表整幅图的总像素数,ni是第i个像素的灰度值,整幅图像的总平均灰度级为

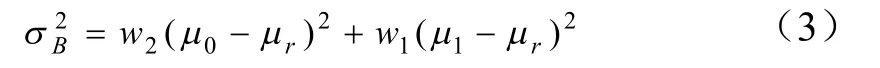

2个区域X1和X2各自出现的概率为w1、w2,平均值为μ0、μ1,则背景和目标之间的类间方差σB为

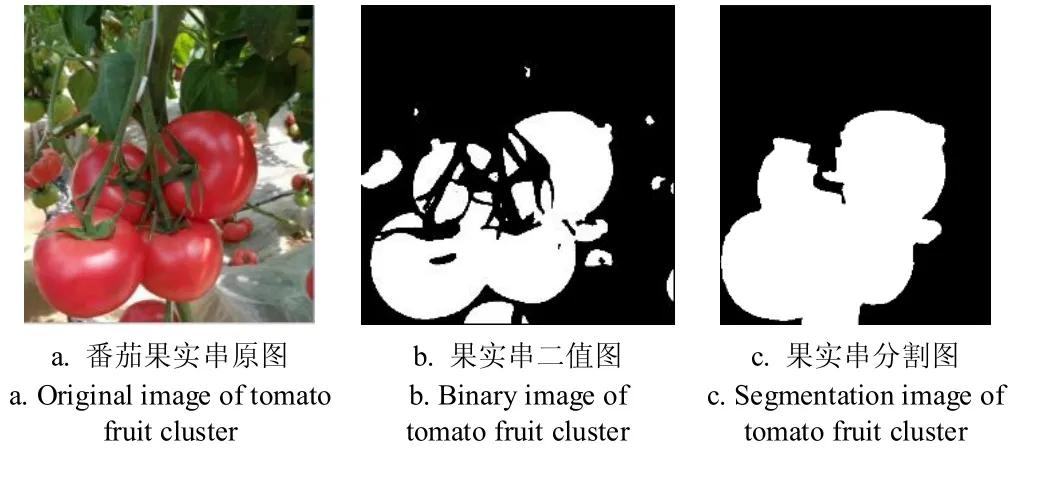

式中μr代表整幅图像的平均灰度。t在[1,T]范围内依次取值,其中σB2取最大时的t值即Otsu算法的最佳阈值,即可获得果实串分割图像。但由于光照不均匀、果实串成熟度差别和背景中随机干扰,以及部分残留区域与成熟番茄果实串的颜色相近,造成果萼目标区域存在孔洞。在番茄果实串图像分割后,果实串图像存在干扰因子,采用形态学闭运算和腐蚀以及阈值法相结合的填充算法去除干扰,得到完整的番茄果实串图像。目标番茄果实串分割处理过程如图1所示。

图1 目标果实串图像分割过程Fig.1 Segmentation process of tomato fruit cluster image

1.3 番茄果实串质心获取

番茄果实串质心提取的准确性会影响后续果梗的感兴趣区域(region of interesting,ROI)计算,此处质心坐标为二维图像上的像素坐标,描述果实串在图像中的位置,果实串的质心计算公式如下

式中x0和y0分别为果实串横、纵的像素质心坐标,i代表番茄果实串区域内第i个像素点,n表示整个番茄果实串区域包含的总的像素个数,xi和yi分别表示第i点的横纵坐标。果实串的质心和外接矩形如图2所示。

图2 番茄果实串外接矩形区域和质心Fig.2 Enclosing rectangle and centroid of tomato fruit cluster

2 果梗骨架提取与角点检测

2.1 果梗ROI确定

为方便快速确定采摘点位置,减少与采摘点无关的区域对目标采摘点定位的影响,在果实串上方设定了果梗矩形感兴趣区域,采摘点计算时,只对该区域的图像进行处理。

果梗的感兴趣区域(ROI)由果梗和果实串的物理特性决定的。受到重力影响,果实串通常是悬垂向下生长,因此当从果实串侧面拍摄时,果梗总是位于果实串的质心上方;果实串的体积较大,呈现在二维图像上的果梗横坐标介于果实串最大和最小横坐标之间;根据果梗的实测统计,果梗长度有一定范围,通常,一簇番茄果实串包含3~5个番茄,果梗长度在52~78 mm之间,因此果梗纵坐标值位于一定区间范围之内。基于以上约束条件,设定果梗的矩形感兴趣区域的底边与果实串的质心相交且果实串质心穿过底边中线,对果实串与果梗关系的实测值与图像坐标进行大量数据统计,获得了果梗区域的计算方法

式中L与H分别为果梗矩形感兴趣区域长度和宽度,xmin和xmax分别代表了果实串外接矩形左右边的横坐标的像素坐标值,ymax和ymin代表了上下边的纵坐标像素数值。

根据果实串的质心和果串的轮廓边界确定了 110组果实串果梗的矩形感兴趣区域,其中4组如图3所示。

图3 果梗的矩形感兴趣区域Fig.3 Rectangle region of interest of stems

由图3可知,每个果实串果梗的感兴趣区均被识别,且矩形区域包含了该果实串整个果梗。其余各组果梗感兴趣区的识别情况类同。

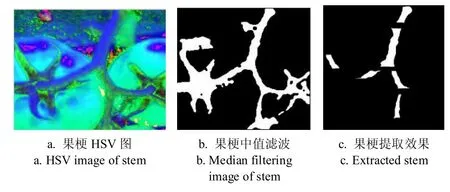

2.2 果梗分离

将果梗感兴趣区域的 RGB彩色通道图转换成 HSV通道图,在H通道下,果梗和背景呈现不同的灰度级别。为了保留果梗的有效区域,去除背景,同时考虑算法的快速性和鲁棒性,利用H分量灰度图下像素之间的颜色灰度差异,分析直方图,统计果实串、果梗、叶片三个区域H分量灰度平均值如图4所示。

图 4 果实串、果梗、叶片三个区域H分量平均灰度值Fig.4 Average value of H in fruit cluster, stem and leaf area

由图4可知果实串、果梗、叶片区域H分量平均灰度值分别位于0~0.27,0.27~0.55,0.55~1.0之间。对果梗图像二值化,设定果梗图像的H分量灰度值如下

式中h为在(x,y)像素点的H分量数值,满足条件的分量数值在对应的 H灰度图中的像素点 (,)f x y灰度设为 255或0。

为降低果梗干扰噪声对骨架连通关系的影响,通过形态学闭运算和中值滤波、提取最大连通区域的方式降低果梗干扰因子,得到背景与果梗区分度更加显著的果梗图像,但是部分叶片与果梗连接,且颜色相近的部分干扰较难去除。在尽量减少图像处理过程中果梗信息损失的情况下,进一步通过逐行扫描像素并设定果梗像素宽度阈值的方式去除干扰,试验统计拍摄的果梗图像中所占用的像素宽度发现(拍摄距离为1 m,果梗为垂直或近似垂直方向),目标番茄果实串图像果梗的像素宽度为40~85像素之间,故设定像素宽度大于85个像素点的横向像素线段作为背景区域,并将这些背景区域的像素值设为0,逐行扫描之后的图像被分成很多离散的区块,由果梗的生长规则可知,与非果梗零碎区域和部分干扰相比,果梗在图像中各个部分区块所占面积较大,根据统计数据,计算果梗区域面积,确定区块的像素面积阈值为 800像素,去除小面积区域,从而得到唯一的果梗信息,如图5所示。

图5 番茄果实串果梗提取过程Fig.5 Extracting process of stem of tomato fruit cluster

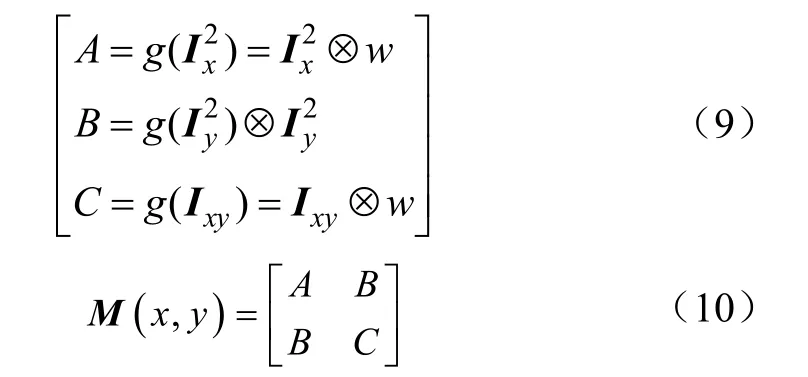

2.3 果梗骨架提取

正常生长的果梗具有类线性的特点,且在分布上具有角点的特性,为简化的果梗原有形状,提取果梗核心信息,采用Zhang细化算法提取果梗的骨架。Zhang细化算法属于迭代算法[27-28]中的一种,针对番茄果实串果梗的二值图像,分2步进行处理:

第一步,遍历所有目标区域的点,对满足下面要求的像素点进行标记,其中N(P1)是P1邻域内非0的个数,S(P1)是以P2到P9为序时这些点的值从0到1变化的次数。

1)2≤N(P1)≤6

2)S(P1)=1

3)P2*P4*P6=0

4)P4*P6*P8=0

第二步,与第一步类似,满足下面条件的点则删除。

1)2≤N(P1)≤6

2)S(P1)=1

3)P2*P4*P8=0

4)P2*P6*P8=0

完成上述 2个步骤为一次算法,通过不断循环迭代上述 2个步骤,直到没有像素可以删除,即可得到细化后的骨架。在二值图像中,1表示前景像素值,0表示背景像素值,若一个点为1且该点的8连通邻域内存在至少一个点为0,则认为该像素点处于目标的边缘[29],果梗骨架提取结果如图6所示。

由图6可知,Zhang细化算法能够完整地提取目标果梗,虽然也有部分增生现象,比如果梗骨架分叉位置出现少量毛刺,但冗余分叉并不明显,在保证连通性的情况下,尽可能地减少了毛刺产生的分叉,果梗骨架提取效果比较理想。

图6 细化法提取的3个果梗骨架Fig.6 Stem skeletons abstracted by thinning algorithm

2.4 果梗角点检测

角点的定义方式有2种:1)在一个邻域内,一个特征点拥有2个主方向;2)2边缘交点定义为角点[30-31]。在提取果梗骨架基础上,通过 Harris算法进行果梗角点检测。具体步骤如下:

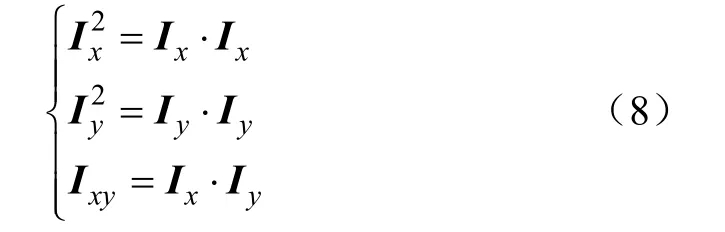

1)果梗图像用I(x,y)进行描述,图像的梯度方向可以用Ix和Iy表示。

式中为张量积符号。

2)计算Ix和Iy的梯度乘积。

3)将2)得到的3个参数利用高斯函数做高斯加权操作,即可得到:

式中g(x)表示x的高斯函数,M(x,y)为协方差矩阵。

4)计算Harris中角点响应R值,设定阈值,将小于阈值的R置零。

式中 traceM和 detM分别代表M的迹|A+C|和行列式|ACB2|,Harris角点计算过程中,经验系数α的范围在0.04~0.06之间[30],本文取0.04。

5)通过3´3和5´5的模版,在邻域内非极大值抑制运算,筛选出的邻域极大值点即为角点,通过“+”号标记角点,如图7所示。

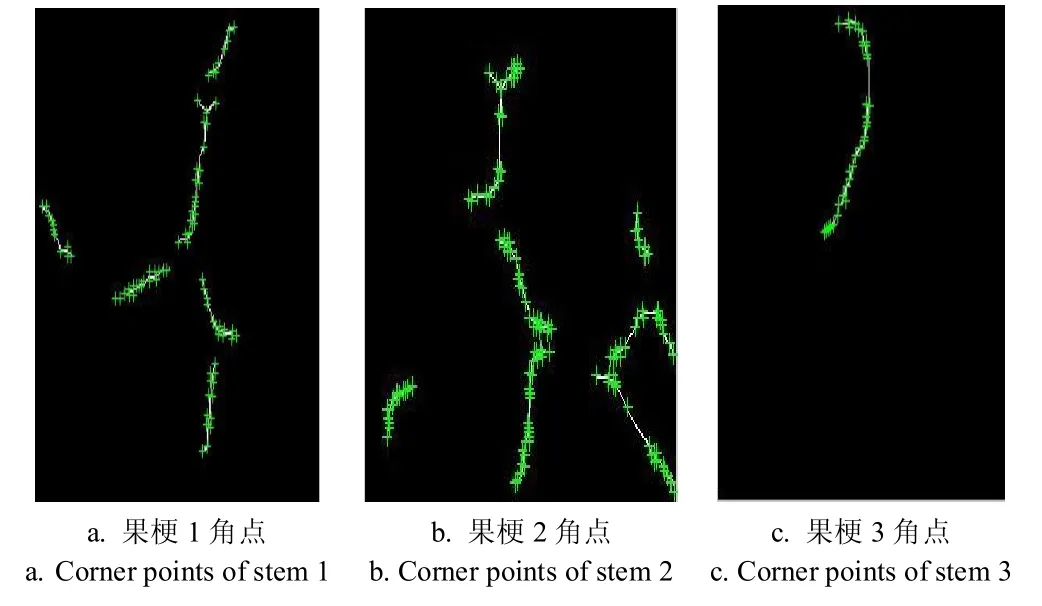

图7 番茄果实串果梗的角点检测Fig.7 Corner points detection of stems of tomato fruit clusters

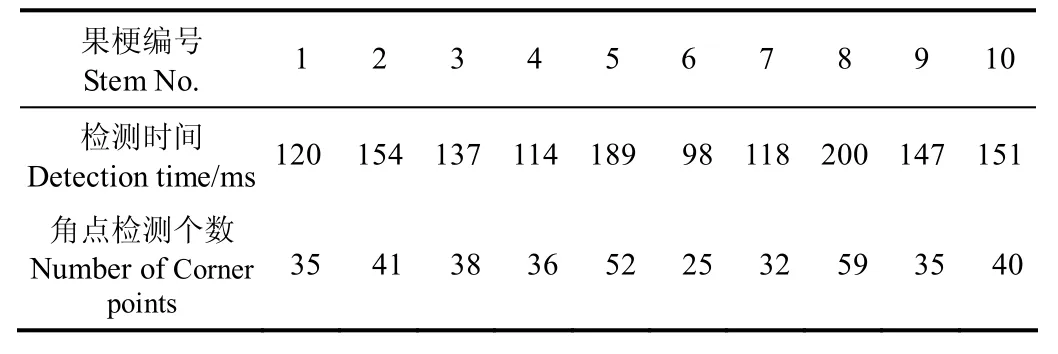

由图 7可知,由于果梗的枝梢分叉以及其生长的不规则性,本文Zhang细化算法提取的骨架通过Harris算法检测出来的角点较多,随机选取的10组果梗角点检测数据如表2所示。

表2 Harris检测数据Table 2 Harris detection data

本次角点的检测在 Windows7操作系统下,软件为Matlab2012a,计算机型号:惠普G4,CPU:Intel酷睿双核I5 3230 MHz,主频:2.6 GHz,RAM:8 GB。从试验结果可以看出 Harris算法在本研究中能够快速检测角点,实现过程简单,计算时间短,小于200 ms。

2.5 果梗采摘特征点计算

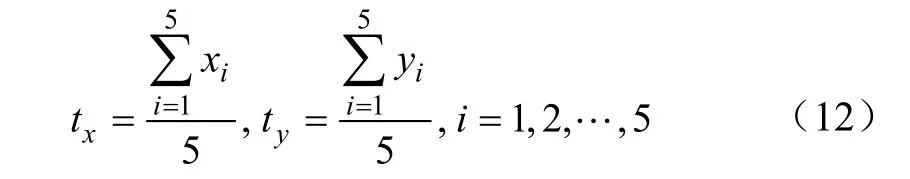

番茄果实串果梗整体呈鱼骨形态,采摘点的位置位于果梗上第一个果实分叉部位与植株主干之间,检测的果梗骨架为其中轴线,结合采摘方法和果实串的生长规则,为减小误差,将第一个果实分叉点与植株主干之间检测出的骨架角点按纵轴方向由大到小排序后,遵循从高到低的原则,选取5个角点并计算其像素坐标平均值,计算的结果作为本文番茄串的采摘特征点,即

式中tx和ty分别为采摘点的横纵坐标值,(xi,yi)为各角点按照y值大小排序的坐标值。

3 采摘点位置信息获取试验与分析

3.1 试验方法与材料

为了验证基于果梗骨架角点方法进行番茄果实串采摘点位置信息获取的合理性,在温室自然光照条件下,采集60幅番茄果实串及果梗图像进行采摘点信息获取试验分析。

3.2 试验指标判定

采摘特征点的坐标标记如图 8所示,本文定义位置信息获取成功和失败的标准是:定位到的采摘特征点位于果梗范围之内为获取成功,定位到分叉、背景或者主梗上端主杆的位置均判定为获取失败。

图8 采摘点的位置信息获取结果Fig.8 Position information acquisition results of the picking point on the stems

3.3 试验结果与分析

试验进行了60组果梗采摘点位置信息获取的数据分析,试验中位置获取失败案例为6组,成功率为90%。失败原因:其中 1组是由于光照的影响,造成采摘点偏移到了主杆位置,如图8d所示;3组试验图像定位到了果梗分叉的地方,会造成后续机械装置漏采的现象;2组试验图像中的采摘点在背景区域,其原因是由于前期处理过程中,受大量叶片簇群的影响,造成提取出的果梗像素尺寸与原图相差较大,从而使骨架发生偏差,最终计算得到的采摘点位置偏移了主梗。60组试验图像的番茄串质心和采摘特征点的横纵坐标像素值如图9所示。

图9 采摘点与果实串质心坐标数据对比Fig.9 x and y coordinates data comparison of picking point and centroid of tomato fruit clusters

由图 9可知,质心位置与采摘特征点的横坐标变化绝对差值位于 0~53像素之间,像素偏差平均为 21像素。质心位置与采摘特征点纵坐标的差异较大,两者最大相差380像素,即采摘点与质心在垂直方向距离较大,主要由于番茄植株本身主要是纵向生长,果实串呈下垂姿态,垂直方向上两者位置相差较大,而其质心位置与采摘点横向差距则较小。因此,采摘点位置相对果实串质心具有相对稳定的变化规律,以果实串质心作为参考提取果梗感兴趣区域,进而实现采摘点位置信息获取可行。

4 结论与讨论

1)通过分量差处理,采用Otsu算法通过形态学闭运算和腐蚀与阈值法相结合的填充算法能够消除目标果实串干扰信息,获得完整的番茄果实串分割图像。

2)根据提取的果实串图像信息确定果梗的矩形感兴趣区域,结合形态学闭运算、阈值法、图像降噪和中值滤波法,设定横向像素宽度大于 85个像素点为背景区域,像素值设为0,确定果梗感兴趣区域面积阈值为800像素,提取出单一的果梗图像。

3)利用快速并行细化算法提取果梗骨架,Harris检测方法检测骨架的角点,选取位于果实串第一个果实分叉点与植株主干之间的果梗骨架角点,通过计算获得采摘特征点位置信息,成功率为90%。

由于图像拍摄角度的差别,果梗的骨架角点检测会产生小幅度差别,对特征点计算有所影响,因此果实串采摘点位置信息提取的精确性有待进一步研究。

[1]Monta M, Kondo N, Shibano Y. Agricultural robot in grape production system[C]// Proceedings of 1995 IEEE International Conference on Robotics and Automation. U.S.A: IEEE Publisher, 1995.

[2]Kondo N, Monta M, Fujiura T. Fruit harvesting robots in Japan[J]. Advances in Space Research the Official Journal of the Committee on Space Research, 1996, 18(1/2): 181-184.

[3]Kondo N. Fruit grading robot[C]// Proceedings of 2003 IEEE/ASME International Conference on Advanced Intelligent Mechatronics (AIM 2003), U.S.A: IEEE Publisher, 2003.

[4]Kondo N, Ninomiya Kazunori, Hayashi Shigehiko, et al. A new challenge of robot for harvesting strawberry grown on table top culture[C]// ASAE Annual International Meeting,Florida: Tampa Convention Center, 2005.

[5]Henten E J V, Hemming J, Tuijl B A J V, et al. An autonomous robot for harvesting cucumbers in greenhouses[J]. Autonomous Robots, 2002, 13(3): 241-258.

[6]袁国勇,张铁中. 温室黄瓜果实的模式识别与分割-利用Bayes分类判别模型[J]. 农机化研究,2006(7):150-153.Yuan Guoyong, Zhang Tiezhong. Pattern recognition and segmentation of greenhouse cucumber fruit-using Bayes classification discriminate model[J]. Agricultural Mechanization Research, 2006(7): 150-153. (in Chinese with English abstract)

[7]赵金英,张铁中,杨丽. 西红柿采摘机器人视觉系统的目标提取[J]. 农业机械学报,2006,37(10):200-203.Zhao Jinying, Zhang Tiezhong, Yang Li. Objective extraction of visual system of tomato picking robot[J]. Transactions of the Chinese Society for Agricultural Machinery, 2006, 37(10):200-203. (in Chinese with English abstract)

[8]刘长林,张铁中,杨丽. 茄子收获机器人视觉系统图像识别方法[J]. 农业机械学报,2008,39(11):216-219.Liu Changlin, Zhang Tiezhong, Yang Li. Image recognition method for the harvesting robot visual system[J]. Transactions of the Chinese Society for Agricultural Machinery, 2008,39(11): 216-219. (in Chinese with English abstract)

[9]周天娟,张铁中,杨丽,等. 基于数学形态学的相接触草莓果实的分割方法及比较研究[J]. 农业工程学报,2007,23(9):164-168.Zhou Tianjuan, Zhang Tiezhong, Yang Li, et al. Method of segmentation and comparative study of strawberry fruits based on mathematical morphology[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2007, 23(9): 164-168. (in Chinese with English abstract)

[10]熊俊涛,邹湘军,陈丽娟,等. 采摘机械手对扰动荔枝的视觉定位[J]. 农业工程学报,2012,28(14):36-41.Xiong Juntao, Zou Xiangjun, Chen Lijuan, et al. The visual orientation of the picking robot on the disturbance of litchi[J].Transactions of the Chinese Society of Agricultural Engineering(Transactions of the CSAE), 2012, 28(14): 36-41. (in Chinese with English abstract)

[11]Xiong Juntao, Lin Rui, Liu Zhen, et al. The recognition of litchi clusters and the calculation of picking point in a nocturnal natural environment[J]. Biosystems Engineering,2018, 166: 44-57.

[12]熊俊涛,邹湘军,彭红星. 扰动柑橘采摘的实时识别与采摘点确定技术[J]. 农业机械学报,2014,45(8):38-43.Xiong Juntao, Zou Xiangjun, Peng Hongxing, et al. Realtime identification and picking point location of disturbance citrus picking[J]. Transactions of the Chinese Society for Agricultural Machinery, 2014, 45(8): 38-43. (in Chinese with English abstract)

[13]郭艾侠,熊俊涛,肖德琴,等. 融合Harris与sift算法的荔枝采摘点计算与立体匹配[J]. 农业机械学报,2015,46(12):38-43.Guo Aixia, Xiong Juntao, Xiao Deqin, et al. Computation of picking point of Litchi and its binocular stereo matching based on combined algorithms of Harris and SIFT[J]. Transactions of the Chinese Society for Agricultural Machinery, 2015,46(12): 38-43. (in Chinese with English abstract)

[14]武涛,袁池,陈军. 基于机器视觉的猕猴桃果实目标提取研究[J]. 农机化研究,2012,34(12):21-26.Wu Tao, Yuan Chi, Chen Jun. Research on the extraction of fruit of kiwi fruit based on machine vision[J]. Agricultural Mechanization Research, 2012, 34(12): 21-26. (in Chinese with English abstract)

[15]罗陆锋,邹湘军,熊俊涛,等. 自然环境下葡萄采摘机器人采摘点的自动定位[J]. 农业工程学报,2015,31(2):14-21.Luo Lufeng, Zou Xiangjun Xiong Juntao, et al. Automatic positioning of picking points of grape picking robot in natural environment[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2015,31(2): 14-21. (in Chinese with English abstract)

[16]戚利勇. 黄瓜采摘机器人视觉关键技术及系统研究[D].杭州:浙江工业大学,2011.Qi Liyong. Cucumber Picking Robot Vision Key Technologies and Systems [D]. Hangzhou: Zhejiang University of Technology, 2011. (in Chinese with English abstract)

[17]王丹丹,徐越,宋怀波,等.基于平滑轮廓对称轴法的苹果目标采摘点定位方法 [J].农业工程学报,2015,31(5):167-174.Wang Dandan, Xu Yu, Song Huaibo, et a1. Localization method of picking point of apple target based on smoothing contour symmetry axis algorithm[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE),2015, 31(5): 167-174. (in Chinese with English abstract)

[18]宋西平,李国琴,罗陆锋. 基于机器视觉的葡萄采摘点三维空间定位系统的研究[J]. 江苏农业科学,2016,44(7):377-380.Song Xiping, Li Guoqin, Luo Lufeng. Localization system in 3-D space of picking point of grape based on machine vision[J]. Jiangsu Agricultural Science, 2016, 44(7): 377-380. (in Chinese with English abstract)

[19]梁喜凤,章艳. 串番茄采摘点的识别方法[J]. 中国农机化学报,2016,37(11):131-134,149.Liang Xifeng, Zhang Yan. Recognition method of picking point for tomato clusters[J]. Journal of Chinese Agricultural Mechanization, 2016, 37(11): 131-134, 149. (in Chinese with English abstract)

[20]Ruiz L A, Molto E, Juste F, et al. Location and characterization of the Stem–Calyx area on oranges by computer vision [J]. Journal of Agricultural Engineering Research, 1996, 64(3): 165-172.

[21]Wang Chenglin, Zou Xiangjun, Tang Yunchao, et al.Localisation of litchi in an unstructured environment using binocular stereo vision[J]. Biosystems Engineering, 2016,145: 39-51.

[22]Wei Xiangqin, Jia Kun, Lan Jinhui, et al. Automatic method of fruit object extraction under complex agricultural background for vision system of fruit picking robot[J].Optik-International Journal for Light and Electron Optics,2014, 125(19): 5684-5689

[23]刘诗辉. 大棚串番茄高产高效栽培技术[J]. 上海蔬菜,2011(6):32-33.Liu Shihui. High-yield, high-efficiency cultivation techniques for tomato in greenhouses[J]. Shanghai Vegetables, 2011(6):32-33. (in Chinese with English abstract)

[24]梁光明,孙即祥,马琦,等. Otsu算法在Canny算子中的应用[J]. 国防科技大学学报,2003,25(5):36-39.Liang Guangming, Sun Jixiang, Ma Qi, et al. Application of otsu algorithm in canny operator[J]. Journal of National University of Defense Technology, 2003, 25(5): 36-39. (in Chinese with English abstract)

[25]胡敏,李梅,汪荣贵. 改进的Otsu算法在图像分割中的应用[J]. 电子测量与仪器学报,2010,24(5):443-449.Hu Min, Li Mei, Wang Ronggui. Application of improved Otsu algorithm in image segmentation[J]. Journal of Electronics & Measurements, 2010, 24(5): 443-449. (in Chinese with English abstract)

[26]戴天虹,吴以. 基于OTSU算法与数学形态学的木材缺陷图像分割[J]. 森林工程,2014,30(2):52-55.Dai Tianhong, Wu Yi. Wood defect image segmentation based on otsu algorithm and mathematical morphology[J].Journal of Forest Engineering, 2014, 30(2): 52-55. (in Chinese with English abstract)

[27]Zhang T Y, Suen C Y. A fast parallel algorithm for thinning digital patterns[J]. Communication of the ACM, 1984, 27(3):236-239

[28]吴选忠. Zhang快速并行细化算法的扩展[J]. 福建工程学院学报,2006,4(1):89-92.Wu Xuanzhong. Expanding of Zhang's parallel thinning algorithm[J]. Journal of Fujian Institute of Engineering, 2006,4(1): 89-92. (in Chinese with English abstract)

[29]贾挺猛,荀一,鲍官军,等. 基于机器视觉的葡萄树枝骨架提取算法研究[J]. 机电工程,2013,30(4):501-504.Jia Tingmeng, Xun Yi, Bao Guanjun, et al. A study on the extraction of grape branch skeletons based on machine vision[J]. Electromechanical Engineering, 2013, 30(4): 501-504.(in Chinese with English abstract)

[30]孙向阳. 角点检测及其在纤维识别中的应用研究[D]. 上海:东华大学,2009.Sun Xiangyang. Corner Detection and its Application In Fiber Identification [D]. Shanghai: Donghua University, 2009.(in Chinese with English abstract)

[31]Olfa Haggui, Claude Tadonki, Lionel Lacassagne, et al.Harris corner detection on a NUMA manycore [J]. Future Generation Computer Systems, 2018, 88: 442-452.