基于YUV颜色空间的脸部区域特征点定位方法

宋怀波,齐关锋,钱 程

(西北农林科技大学机械与电子工程学院,陕西杨凌712100)

面部主要特征点的精确定位是判断面部表情的关键,在驾驶员疲劳驾驶[1]、生物特征识别[2-3]、视频监控[4]、信息安全[5]、访问控制[6]、智能机器人[7]等领域有着广泛的应用前景。但是,受光线明暗、摄像角度、肤色差异、性别、年龄等因素影响,同一个人在不同地点和时间内拍摄到的人脸图像存在很大的差异。因此,实现不同场景下的面部主要特征点的有效定位成为模式识别研究领域最富挑战性的研究课题之一,受到了越来越多的关注。

面部主要特征点很多,目前的研究主要集中在眼部与嘴部的精确定位上。在眼部区域定位研究方面,主要采用模板匹配法[8]、特征脸方法[9]、神经网络法[10]、基于对称性的方法[11]和 Hough变换方法等。模板匹配方法、特征脸方法以及神经网络方法着重于眼部区域的整体特征,后两种方法主要考虑几何特性。上述方法在光照均匀、背景简单时可行,但其计算量较大,不利于实时处理,且对光照、旋转角度等的影响极为敏感,很难实现准确定位。在嘴部区域定位研究方面,多采用局部梯度算子法[12]、主元特征矢量分析法[13]、积分投影与色度匹配相结合的方法[14]以及色素分布的方法[15]等。上述方法在提取嘴唇形状时,容易造成非嘴唇边缘信息的残留以及嘴唇边缘不完整等问题[16],影响嘴部特征点的定位精度。

为了实现不同场景下的人脸面部主要特征点的精确定位,结合YUV颜色空间理论与差分投影技术,在完成人脸区域定位的基础上,利用YUV颜色空间中的红色差分量实现嘴部区域的提取,利用差分投影技术,并以嘴部区域的提取结果作为眼部区域定位的基础实现眼部区域的定位。

1 基于直方图拟合的人脸区域定位

受各种因素的影响,人脸图像一般处于一个极度复杂的场景中,实现其准确分割具有一定难度。以往的研究多利用颜色信息进行人脸区域的分割,分割结果往往不够准确。本文提出了一种基于直方图拟合的人脸图像分割方法,将图像直方图拟合出具有多峰特性的效果,以达到抑制噪声,便于面部目标分割的目的。

1.1 基于最小二乘法的图像直方图拟合

1.1.1 曲线拟合的最小二乘法原理

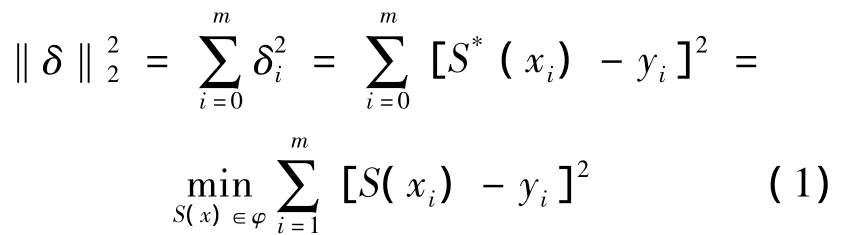

给定一组数据(xi,yi)(i=0,1,…,m),在函数类φ=(φ1,φ2,…,φn)中寻找一个函数 y= S*(x),使得误差平方和最小

式中:S(x)=a0φ0(x)+a1φ1(x)+…+anφn(x) (n<m)。

用最小二乘法求曲线拟合,就是在S(x)中求一函数y=S*(x),使误差平方和取得最小的问题。通常,函数类多采用多项式进行,因此,它转化为求多项式S(x)系数的极小值点的问题。

1.1.2 基于最小二乘法的直方图自适应曲线拟合

图1是拍摄的1幅彩色人脸图像,图2是其所对应的灰度图像的灰度直方图。由图2可以看出,其直方图并不呈现明显的双峰状态,且存在过多的极值点,很难采用常规的分割算法进行处理。

图1 拍摄到的原始人脸图像Fig.1 O riginal human face image

图2 图1的灰度直方图Fig.2 The histogram of fig.1

为解决这一问题,提出了一种基于最小二乘法的灰度直方图拟合算法,通过设定一个足够大的迭代阶次N,并分别计算各阶次下的拟合误差,选取拟合误差最小的拟合阶次作为最优拟合曲线。拟合后的曲线较好地表达了原始直方图的灰度分布并呈现出较好的多峰特性,便于图像的分割。

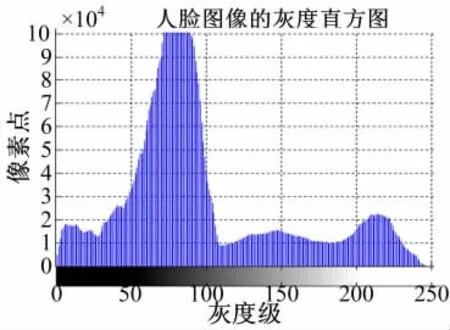

1.2 人脸位置的检测

在绝大部分情况下,人脸区域占整幅图像的比例有限,不可能占据直方图曲线的最大峰值,同时根据人脸图像的先验知识,面部区域三基色值表现为R>G>B,即人脸区域的像素灰度值偏亮。考虑到人脸区域易受光照等因素的影响,本文将大于最大峰值右侧的所有区域均定义为人脸区域。该方法可以有效地降低算法的复杂度,虽然有可能造成分割准确度的下降,但由于采用YUV颜色空间来进行后续处理,并不影响主要特征点的定位。图1的分割结果如图3所示。由图3可以看出,利用该方法可以有效地分割出人脸目标区域。

图3 人脸分割结果Fig.3 The results of face segmentation

2 基于彩色矢量图嘴部区域定位算法

唇色是人脸彩色图像中数据量相对集中且稳定的区域,利用唇色检测人嘴部区域具有鲁棒性高、简单易行等特点。研究表明,不同性别、不同年龄、不同肤色的人虽然在彩色空间分布上存在差异,但人类的唇色在彩色空间确实有很好的聚类性,因此可以利用唇色信息实现鲁棒的嘴唇定位。

2.1 基于彩色矢量图的嘴唇区域定位

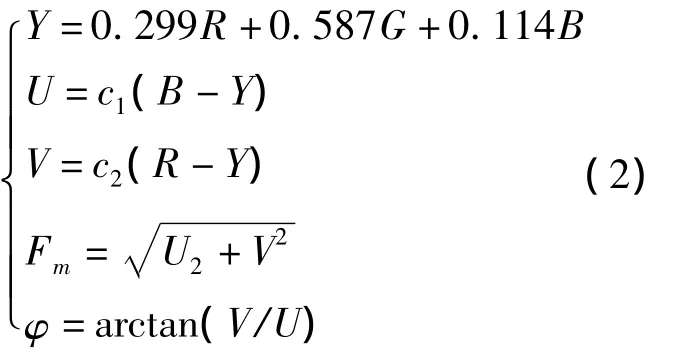

相对于RGB模型,YUV颜色模型更符合人眼特性,其转换公式如下

式中:c1、c2为蓝、红基色色差压缩系数,取值分别为c1=0.493,c2=0.877;Y表示颜色的亮度信息,(B-Y)、(R-Y)为色差信号;U、V为相互正交的色度分量;Fm代表彩色的色饱和度;φ代表色调。

2.2 基于唇色的人脸嘴部区域提取方法

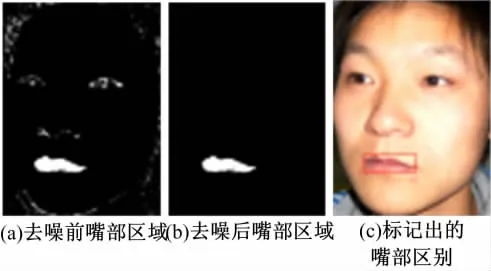

统计结果表明,嘴部区域的相角在87°~103°之间[15],利用相位信息得到的人嘴部区域结果如图4(a)所示。去噪后嘴部区域如图4(b)所示,标记出的嘴部区域如图4(c)所示。可以看出,利用该方法可以有效地提取出嘴部区域。

图4 定位的嘴唇区域Fig.4 The positioning lips area

3 基于差分投影的眼部区域定位算法

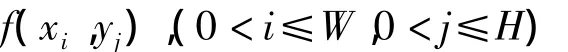

人的眼部区域包含大量的不同信息(如睫毛、瞳孔等),因此眼睛区域内横纵向灰度变化较大,眼睛区域的差分投影具有较大值。设人脸图像为

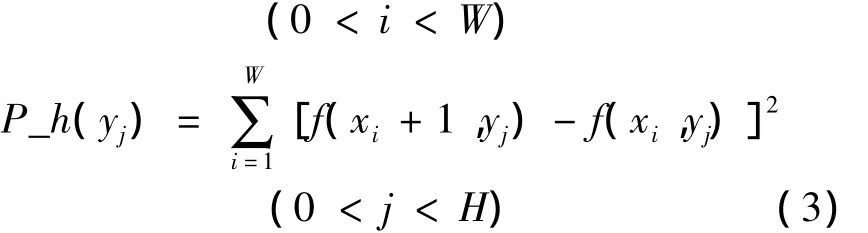

式中:W和H分别为图像的宽和高。图像的水平差分投影P_h(y)、竖直差分投影P_v(x)计算如下

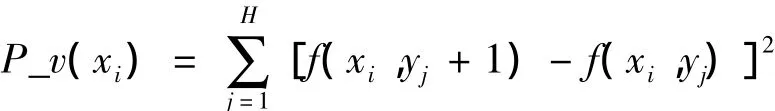

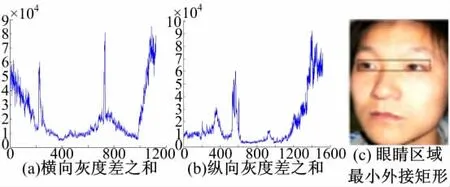

其横向差分投影如图5(a)所示,在嘴部纵坐标左右,存在两个明显的峰值,代表左右眼睛的纵坐标位置。图5(b)为其水平差分投影,利用眼睛横坐标小于嘴部横坐标这一先验知识,即可提取出样布的横坐标。眼部区域的定位结果如图5(c)所示。

图5 差分投影方法提取眼睛候选区域Fig.5 Differential projection of eyes candidate region

4 试验与讨论

面部主要特征点的定位实验主要由图像采集、结果分析和讨论三部分组成。

4.1 人脸图像数据库的建立

以面部姿态为主要拍摄部位,共拍摄8位受试者的测试样本98幅。其中,未发生视觉分散的样本10幅,轻度视觉分散32幅,临界状态样本32幅,严重视觉分散样本24幅,部分样本示例如图6所示。

图6 拍摄到的部分试验图像Fig.6 Som e sam p les of experim ental images

4.2 嘴部与脸部特征识别试验

试验所使用的样本统计信息及嘴部、眼部识别结果如表1所示。

表1 特征点定位试验样本数分布及其结果Table 1 Experimental sample distribution and the results

由表1可以看出,采用基于YUV颜色矢量图的方法对嘴部区域进行检测具有很高的鲁棒性,但随着视觉分散的加剧以及遮挡的影响,检测率会明显下降。在眼部识别时,具有相似的规律,由于眼部区域受到诸多因素的影响,其精度比嘴部区域的定位效果偏低。

4.3 人面部特征三角形的绘制结果

根据上述算法,在完成嘴部、眼睛区域的定位后,绘制的面部特征三角形如图7所示。从图7中可以看出,当测试对象发生姿态变化时,其特征三角形也发生了相应的变化,为接下来进行面部姿态的识别奠定了良好的基础。

图7 绘制出的人面部特征三角形实例Fig.7 Facial features triangle exam p les

5 结束语

为了实现面部主要特征点的精确定位,首先采用直方图拟合的方法并结合先验知识,实现了一种简化的脸部区域提取方法。在此基础上,提出了一种基于YUV颜色空间与差分投影相结合的人脸区域主要特征点定位方法,有效地实现了面部主要特征点的精确定位。由于眼部区域的定位是在嘴部区域定位的基础上进行的,因此,当无法准确实现嘴部区域定位时,本算法的精度会受到较大影响。

[1]彭召意,周玉,朱文球.用于疲劳驾驶检测的人眼快速跟踪方法[J].计算机工程,2010,36(15):191-193.

Peng Zhao-yi,Zhou Yu,Zhu Wen-qiu.Fast human eyes trackingmethod for drowsy driving detection[J].Computer Engineering,2010,36(15):191-193.

[2]王蕴,朱勇,谭铁牛.基于虹膜识别的身份鉴别[J].自动化学报,2002,28(1):1-10.

Wang Yun,Zhou Yu,Tan Tie-niu.Biometrics personal identification based on iris pattern[J].ACTA Automatica Sinica,2002,28(1):1-10.

[3]严严,章毓晋.基于视频的人脸识别研究进展[J].计算机学报,2009,32(5):878-886.

Yan Yan,Zhang Yu-jin.State of the art on video-based face recognition[J].Chinese Journal of Computers,2009,32(5):878-886.

[4]Chellappa R,Wilson C,Sirohey S.Human and machine recognition of faces:A survey[J].Proceedings of the IEEE,1995,83(5):705-740.

[5]Li SZ,Jain A K.Handbook of Face Recognition[M]. New York:Springer,2005.

[6]Zhao W,Chellappa R,Rosenfeld A,et al.Face recognition:A literature survey[J].ACM Computation Survey,2003,35(4):399-458.

[7]杨佳,黄玉清,陈小宁.基于区域生长的机器人路标识别方法研究[J].计算机工程与设计,2008,29 (13):3410-3418.

Yang Jia,Huang Yu-qing,Chen Xiao-ning.Study on robot landmark recognition based on region growing[J]. Computer engineering and design,2008,29(13):3410-3418.

[8]Brunelli R,Poggio T.Face recognition:Features vemus templates[J].IEEE Trans PAMI,1993,15(10):1042-1052.

[9]Pentland A,Moghaddam B,Starner T.View based and modular eigen spaces for face recognition[C]//Proceedings of the IEEE Conference on CVPR,Seattle,Washington,1994:84-91.

[10]刘艳梅,薛定宇,徐心和.基于人工神经网络的立体视觉定位方法[J].计算机工程与应用,2005,41 (22):33-35.

Liu Yan-mei,Xue Ding-yu,Xu Xin-he.Stereovision measurement method based on neural network[J]. Computer Engineering and Applications,2005,41(22): 33-35.

[11]Reisfeld D,Yeshurun Y.Robust detection of facial features by generalized symmetry[C]//IEEE Proceedings.11th IAPR International Conference,1992:117-120.

[12]靳薇,张建奇,张翔.基于局部梯度算子的嘴部检测与定位[J].光电工程,2009,36(10):135-140.

Jin Wei,Zhang Jian-qi,Zhang Xiang.Detection and localization of themouth based on local gradient operator[J].Opto-Electronic engineering,2009,36(10):135-140.

[13]王琢玉,贺前华.基于主元分析的人脸特征点定位算法的研究[J].计算机应用,2005,25(11):2581-2583.

Wang Zhuo-yu,He Qian-hua.PCA-based location algorithm of human face features[J].Computer applications,2005,25(11):2581-2583.

[14]陶丹,冯骁宇.一种基于积分投影与色度匹配相结合的快速人眼嘴定位算法[J].计算机应用研究,2009,26(4):1578-1588.

Tao Dan,Feng Xiao-yu.Fast eye and mouth location algorithm based on integral projection and colormatching[J].Application Research of Computers,2009,26(4): 1578-1588.

[15]Tang C Y,Chen Z,Huang Y P.Automatic detection and tracking of human heads using an active stereo system[J].International Journal of Pattern Recognition and Artificial Intelligence,2000,14(2):137-166.

[16]Shan SG,Cao B,Gao W.Extended fisherface for face recognition from a single example image person[J]. IEEE International Symposium on Circuits and Systems,2002,(2):81-84.