大语言模型技术背景下重塑研究生论文评价与指导

摘要:作为生成式人工智能领域的关键分支,大语言模型凭借其在理解和生成自然语言文本方面的卓越性能,已经成为学术写作的新助力。这一技术的发展为研究生论文的评价体系带来了前所未有的挑战,迫切需要我们在评价维度、标准和方法上进行优化和创新。研究生的论文写作指导同样需要与时俱进,通过提升学生的人工智能素养、强调原创性和批判性思维的培养,以及提升学术品位,来引导学生在新技术的辅助下,更加高效地进行学术创作和知识创新。

关键词:大语言模型;人工智能;研究生论文;学术诚信;研究生教育

作者简介:王琳,重庆大学法学院副教授,重庆 400044。

在研究生教育体系中,学术论文考核作为评估学生学术能力和研究成果的重要手段,一直是学业评价的核心组成部分。大语言模型技术的发展引发了对学生在论文写作中滥用该技术的担忧,研究生任课教师与导师正面临着一项前所未有的挑战:如何调整研究生论文的写作指导与评价方式以适应当前的技术变革?本文旨在对这一议题作出探讨,以期为教育工作者在新技术环境下指导和评价研究生论文写作提供参考。

一、大语言模型技术机理及其在论文写作中的作用

自然语言处理(Natural Language Processing,NLP)是计算机科学与语言学的交叉学科,研究用计算机理解和生成自然语言的各种理论和方法,属于人工智能领域的一个重要甚至核心分支[1]2。语言模型(Language Model,LM),也被称为统计语言模型(Statistical Language Model),是描述自然语言概率分布的模型,它可以计算一个词序列或一句话的概率,也可以在给定上文的条件下对接下来可能出现的词进行概率分布的估计[1]20。自2018年起,大语言模型(Large Language Models,LLMs),即有显著规模的预训练语言模型,为自然语言处理领域带来了新的机遇和挑战[2]。相较于小规模语言模型,大语言模型出现了一些新的能力,大大加强了其在真实场景下的可用性,诸如根据用户输入的自然语言指令执行特定任务的“指令遵循”(instruction-following)能力,以及根据简单的提示词,例如“请一步一步思考”(Let’s think step by step),来生成论证过程的推理能力[3]。

在此有必要说明一下目前更为常见的术语“生成式人工智能”(Generative Artificial Intelligence,GenAI)和“大语言模型”的关系,以解释本文为何使用后一个概念。生成式人工智能的核心能力是生成新的内容或数据,这些内容或数据在统计上与训练数据相似,但又不同于任何特定实例。生成式人工智能的应用非常广泛,包括但不限于图像生成、音乐创作、文本生成、语音合成等[4]8。大语言模型是生成式人工智能的一个子集,专注于处理和生成自然语言文本。鉴于本文关注的是人工智能对于论文写作评价和指导的影响,故将术语限定在“大语言模型”这一概念上更为准确。

大语言模型被认为可以作为智能科研助手而发挥作用,它能够解读文献、解释概念,总结科研进展[5],还可以被用于生成摘要、引言、方法、结果、讨论、结论和参考文献等论文组成部分[6]164。一项在英国进行的涵盖2555名本科生与研究生的调查结果揭示:逾半数的受访学生已经在使用或正考虑采用相关技术来达成学术目标[7]。瑞典一项全国性调查收集了1700多条开放式评论,研究结果显示学生在学术写作中频繁使用诸如ChatGPT一类的大语言模型技术[8]。我国近期一项针对研究生使用ChatGPT情况的实证研究揭示,过半数的调查对象在学习和科研中使用ChatGPT,“双一流”建设高校研究生使用ChatGPT的频率高于普通高校研究生[9]。由于ChatGPT是我国学生不易获得的国外大语言模型技术,而国产大语言模型发展迅速并且容易获得,可以推测我国研究生使用大语言模型技术的总体比例要更高。

二、大语言模型发展给研究生论文评价带来的挑战

1.对评价公平性的挑战

学生使用LLMs技术可能会妨碍教师对学生的学业表现做出公平的评价。LLMs技术对研究生论文评价带来三种意义上的公平性挑战。第一种公平性问题是,由于经济条件、科技素养等方面的差异,不是所有研究生都有能力使用这一技术,可导致学生之间的数字应用鸿沟进一步加大[10]。这可能导致那些能够有效利用LLMs的学生在论文写作上占据技术优势,并借此获得更高的成绩[11]。第二种公平性问题是,虽然并不存在客观上使用该技术的限制,但一些学生利用了LLMs来提升论文的语言流畅性、结构完整性或论点的连贯性,而有些学生没有使用,导致使用该技术的学生获得更高的论文评分。这种现象看起来就类似于体育比赛中有运动员使用兴奋剂来提高自己的成绩。第三种公平性问题是,有学生提交人工智能生成的论文,获得的分数却高于那些亲自投入时间和精力努力撰写论文的学生。有研究指出,在某些学科的论文考核中,人工智能生成的文本能保持始终如一的质量,表现最好的学生能够超过人工智能生成的论文,但大多数学生的表现要么相当,要么更差。排名后三分之一的学生将有很大的动机提交人工智能生成的作品以获得更高的分数[12]。

2.对评价真实性的挑战

学生使用LLMs技术可能会导致教师对其真实学术能力造成误判。LLMs可以使学生绕过对课题深入研究的过程就能制作出看似专业的学术论文,但学生实际上可能并不真正理解文章中的概念和论证[12],以致论文无法反映他们实际的研究能力和学术水平[13]。在社交平台上,随处可见利用LLMs技术辅助撰写论文的经验分享贴。笔者亲身体验了这一技术操作。首先,简单地输入提示词,例如“请提出关于法律与道德关系的论文选题”,便可迅速获得诸如“法律的道德基础:自然法与实证法的对话”“道德判断在司法决策中的角色”等十个选题建议。进一步输入“请就道德判断在司法决策中的角色题目生成写作大纲”,几秒钟内一个包含从前言至结论的完整七章节大纲便呈现出来。还可以要求模型就大纲中的某一部分进行详尽阐述,比如“请就提纲中道德判断在司法决策中的历史与现状详细阐述1000字”,模型便生成了符合字数要求的、初步看起来逻辑连贯的内容。如此重复,在几分钟内便可生成一篇万字文章。在知网的创作功能“知网研学”还出现了“AI创作”板块,宣传可以“一键生成高质量文章”。

3.对学术不端审查的挑战

LLMs能够生成流畅、连贯且看似原创的文本,学生可能会把LLMs自动生成的内容作为自己的作品提交[11],而教师依赖人工智能文本生成检测工具对学生提出学术不端的指控可能发生错误[14]。AI代写至少展现出以下两个新特点,使得它会带来比传统代写更为严峻的挑战。其一,AI代写的可获取性显著高于传统代写方式。在传统的代写模式下,无论是通过购买“论文作坊”的代写服务还是依赖他人的无偿协助,通常需要承担一定的经济成本或提供其他形式的对价。然而,现在只要有网络,就能够轻松地访问并利用免费的大语言模型技术。这种便捷性和低成本的特性无疑会极大地增强AI代写的吸引力。其二,AI代写的隐蔽性显著高于传统代写方式。在传统的代写实践中,无论是通过中介机构还是直接与代写者联系,往往会产生可追踪的痕迹。相比之下,AI代写通常在个人设备上独立完成,根据所提交的文本本身也难以判断是否为人工智能生成。ChatGPT背后的公司OpenAI明确说明他们还无法检测人工智能生成的文本[15]。随着人工智能工具变得越来越复杂,准确检测文本是由人类还是人工智能编写的概率在降低[16]。

三、对消极应对策略的分析与批判

当前,针对学生在论文写作中使用大语言模型有两种消极应对策略:一是“禁止策略”,即完全禁止学生在论文写作中使用此类技术;二是“替代策略”,即采用其他评估方式来取代传统的论文考核方式。尽管这两种策略基于对潜在问题的合理关注,但它们各自存在显著缺陷,并非可行的解决方案。

1.禁止策略

考虑到LLMs技术可被用于代写论文的风险,有学校和教师在布置论文作业时提出不可以使用此类技术。例如,牛津大学和剑桥大学因担心抄袭而禁止使用这项技术[17],纽约公立学校宣布通过设立防火墙的方式禁止师生使用ChatGPT[18],香港大学向师生发出内部邮件,禁止在所有作业中使用ChatGPT或其他AI工具[19]。一项关于84所美国一流大学人工智能使用政策的研究发现,其中有9所高校持“禁止使用”态度,占比10.7%[20]。禁止策略的提出者不反对人工智能可以被合理地运用于学习和研究,但是考虑到教师无法鉴别出学生提交的论文是否基于滥用技术,于是把禁止使用LLMs工具作为一种预防措施,以遏制潜在的学术不端行为。

这种禁令出自对前面所提到的评价公平性、真实性和难以审查学术不端行为的合理担忧,但是这些担忧却不能充分支持禁用政策。

(1)关于评价公平性的担忧并不能证立教师要求学生禁用LLMs。一方面,不公平并非源于学生使用技术本身,而是源于在禁用LLMs规则之下有学生通过秘密使用该技术获得额外优势,即不公平实际在于违规者通过作弊获得好处。如果所有学生都被允许在论文写作中使用LLMs,那么所有学生都将站在相同的竞争平台上。如果教师规定禁止使用LLMs技术,但某些学生违反规定秘密使用,而教师又无法有效识别违规行为,那么诚实遵守规则的学生就会处于不利地位,这才是评价过程中的不公平。另一方面,论文评价的核心标准并非衡量学生的努力程度,而是评价其成果的质量,正如体育竞技中判断谁为优胜者并非根据运动员的训练时长。教师担心自己无法辨别论文是否为学生所写,有可能给那些投入大量时间和精力撰写论文的学生的分数,低于那些借助人工智能在较短时间内完成论文的学生。但是,评价者应考虑到,除了时间与精力的付出,学习策略以及技术资源的有效利用也属于付出和投入。若采用符合学术规范的技术手段来提高研究效率,不宜被视为不公平竞争。

(2)关于评价真实性的担忧并不能充分证立禁用政策。教师可能认为LLMs技术包装了学生的实际水平,使学生在论文中展现出超过实际能力的表现。然而,这种“包装”或者“美化”并非全然负面,它在某些情况下反映了技术对学生研究能力的提升作用。例如,对于那些在语言表达上存在困难但拥有创新思维的学生,LLMs可以作为一个有效的中介,帮助他们更流畅地传达自己的想法。这类似于法学家哈特(H. L. A. Hart)在评价边沁(Jeremy Bentham)的著作时所提到的,边沁的晦涩表达有时会阻碍读者理解其深刻思想,哈特愿意充当一个中间人,使边沁的观点更加清楚明白和通俗易懂[21]。LLMs在当下可扮演类似角色,协助语言表达能力有限的学生更有效地表达自己的见解。当学生运用LLMs来润色语言表达,并且从中选择出好的以及贴切自己思想的表达方式,在这种情况下,没有理由说:“如果你不用LLMs,你的表达不会这么好,这不是你真实的水平。”正如我们不会要求人们放弃使用现代纺织机械,转而坚持手工织布一样,同样没有理由要求学生在语言表达上保持原始的不完善。语言表达不应成为学术交流的障碍,学生利用AI来增强和完善自己的表达能力,应被视为一种合理利用现代技术资源以提高学术成果质量的行为,它有助于学生更好地展示其研究潜力。

(3)对于学术不端行为的担忧并不能充分证立禁止政策。诚然,学术不端行为确实是有可能发生的,但禁止学生使用该技术无异于因噎废食。禁止政策使得学生无法获得技术赋能科研之益,何况学生在毕业后也需要在工作中使用这些技术[7]。禁用政策是不可持续的,不利于培养未来人工智能社会中的公民[22]。学术不端行为通常涉及故意的欺诈,如抄袭、数据造假或引用篡改,而合理使用LLMs技术则不属于这一范畴[23]。“AI辅写”与AI“代写”不同[24],LLMs作为一种工具,其道德属性取决于使用者的行为。学生可以借助人工智能技术高效地梳理和阅读文献资料,辅助进行复杂的数据分析,通过与人工智能辩论来获得启发,改善论文的结构和语言表达,这些应用属于使用技术来提效科研过程和提升学术成果质量的范围,宜被视为一种正当有益的学术实践。遏制学术不端行为应侧重于教育学生正确使用人工智能技术,而非禁止其使用。

综上所述,尽管禁止政策可能出自一些看起来非常合理的担忧,但经过深入分析,我们发现它们并不足以支持禁用政策。

2.替代策略

另外一些学者建议以其他方式替代论文考核,诸如演讲、口头报告、同伴评审等[11]。笔者认为,这些考核方式虽然可以同论文一起组合为更全面、更科学的学业评估体系,但却不能替代论文评价,将后者排除出研究生的学业评估是不合适的。

在我国,学术型研究生的培养目标明确包括科研能力的培养。2024年4月26日颁布的《中华人民共和国学位法》第二十条规定:学术学位申请人应当具有从事学术研究工作的能力。如果研究生要获得学术型的硕士学位,具有科学研究工作的能力是必要条件。而对于这一能力的训练和展示来说,论文撰写是最为直接和有效的途径。论文撰写要求学生具备提出研究问题、文献综述、设计实验、分析数据、理论探讨、撰写报告等一系列能力,论文考核有助于确保学术学位获得者达到一定的科研水平。虽然LLMs技术对学术研究产生影响,但这并未颠覆目前学术领域以论文发表作为评价研究者科研能力和成果的做法,学术期刊的地位也依然稳固。论文能够凝练、有序地呈现人类思考成果,并将其准确地加以传播。总之,对于学术型研究生培养来说,论文考核在考查研究生科研能力中具有不可替代性,尽管论文评价方式存在改进空间,但将其从研究生学业评价体系中完全排除是不合适的。

四、优化研究生论文写作评价系统

由前文分析可以得出如下基本看法:一方面,对于学术型研究生培养来说,应继续采用论文考核作为研究生学业评价的主要方式;另一方面,教师应考虑如何改革和优化论文评价,以便更准确地识别和评价学生的科研能力和成果水平。对于如何优化,本文尝试做一些初步探索。

1.从一元到多元:补充配套辅助评价办法

针对滥用大语言模型所带来的评价公平性和真实性挑战,教师宜以多类型学习证据支持评价[25]。对研究生论文的评价宜配合口头答辩,以便能够了解学生科研能力和学术水平的真实情况[26]。已有大学规定邀请随机挑选的学生参加“真实性面试”(authenticity interview),请学生澄清他们的学科知识以及他们是如何研究其提交的论文的[27]。在人工智能发展背景下,论文评价应不只限于本文本身,还需要考查学生如何批判性地运用人工智能[28]。教育工作者可以分析学生与LLMs技术的互动情况,以考查他们的批判性思维和解决问题的能力,如可以通过评估学生在使用人工智能时所提问题的质量、所获得信息的相关性,以及学生检查、反思和挑战人工智能生成信息的能力来考查学生[15]。

笔者并不赞成教师在目前的技术条件下依赖检测工具来判断学生提交的是否为人工智能自动生成的论文。虽然有机构已经开通了AIGC检测服务,检测的依据是“人类的创作往往是随机且富有灵感的,而接受过大量文本训练的AI已经形成了生产文本的‘固有’范式,倾向于使用‘一致’的结构和规则,因此具有更高的可预测性”[29]。然而,鉴于人工智能技术的发展日新月异,其语言表达方式会不断趋向于人类,并能够具有灵活多样的表达风格。人工智能生成内容甚至已经获得文学奖项[30],试图从文本本身特征区分其来源的检测方案似乎难以为继。OpenAI公司声明,对检测器的研究没有表明它们足够可靠。他们发现人工智能生成内容检测器将莎士比亚的作品和《独立宣言》等人类写作的文本标记为人工智能生成,还发现检测器更有可能对使用第二语言的学生和写作特别公式化或简洁的学生的论文做出误判[15]。误判不仅可能损害学生的学术声誉,还可能对学生的心理健康造成负面影响。

2.从结果到过程:加强科技应用伦理审查

在人工智能发展背景下,教师在论文评价中需要督促学生履行基于学术诚信要求的透明义务[31]。2023年12月科技部监督司发布的《负责任研究行为规范指引(2023)》强调了作者在论文中使用生成式人工智能时的披露义务[32],这不仅有助于维护学术诚信,还能让读者更好地理解研究过程和结果的可靠性。教师可指导学生在撰写论文时明确标注并详细说明其运用人工智能工具的生成过程,包括但不限于所使用的人工智能软件的名称、版本、使用时间,以及其在研究中的具体应用方式,如文献综述、数据分析、图表生成等。考虑到这些记录和披露可能增加学生的负担,教师应与学生共同探索和持续优化透明义务履行的平衡点,确保披露信息既充分又不过度烦琐。为了确保披露的一致性和专业性,可以推荐学生使用或参考2023年9月中国科学技术信息研究所联合几家国际出版集团发布的《学术出版中AIGC使用边界指南》中的披露模板[33]。教师可和学生一起探讨如何根据自己的学科特点调适这些模板,并在实际应用中不断完善,以适应不断变化的学术环境和人工智能技术的发展。确保学术诚信和合乎道德地使用生成式人工智能技术也可以通过培养一种开放的环境来实现,在这种环境中,学生可以就其使用的具体案例提出问题,并公开讨论相关的挑战,而不必担心受到惩罚[34]。

3.从形式到实质:强化论文内容质量评价

教师应加强对研究生论文中呈现的问题意识、论证逻辑等实质内容进行分析和评价。以往教师能够通过考查论文的形式特征,方便地对学生的学术态度和论文质量做出初步评估。形式上的评价标准,如参考文献的充分性、引用格式的正确性、语言的流畅性,通常能够帮助教师识别出学生论文中的低层次错误[35]。形式上的错误是很容易发现的,并且能反映出学生的写作态度,由此也使教师认为有理由推断论文有较多明显形式错误的学生不会对内容进行仔细斟酌。然而,现在LLMs技术能够迅速生成结构规整、语言流畅的长篇幅文本,这就要求教师在评价学生论文时,必须对论文的实质内容进行更为细致的甄别和判断。为了确保评价的公正性和客观性,教师应当关注学生在论文中展现的问题意识、论证的逻辑性和说服力等核心维度。为了避免实质评价过程中的主观性和随意性,教师可以参考学位论文评审的量表,制定一套更为详尽的课程论文评价标准。在布置论文作业之初,将这些评价标准明确告知学生,让学生了解论文评价的具体要求。这样的做法不仅有助于学生明确目标,提高论文质量,同时也能够确保教师在合理范围内行使学业评价权。

4.从底线到卓越:设定更高的论文学术标准

教师应当引导学生理解并实践论文写作之“愿望的道德”。根据法学家富勒对“义务的道德”与“愿望的道德”的区分,前者指行为的底线规范,后者指行为追求更为卓越的上线[36]。以写作为例,文法规则就属于义务的道德,富有文采就属于愿望的道德。“底线”与“卓越”是与“形式”和“内容”相关但不同的范畴。底线通常指的是必须达到的最低标准或要求,而卓越则是指超越一般水平追求更高层次的优秀。论文的形式和内容则是另一个维度的概念区分:论文形式是作者思想的外在表现形式,如文字的排列、语法、篇章的结构等;内容则是指思想本身要传达的意义。无论是形式还是内容,我们都可以对之提出从底线到卓越的不同评价标准。在人工智能时代,学生更容易满足论文的底线要求,生成式人工智能可以其强大的算力来预处理海量在线资料,帮助研究者极大地节省搜索信息的时间和精力成本[37]。这使得学生能够从机械劳动中解放出来,可以投入更多时间和精力追求内容和形式上的卓越。教师应适时更新评价体系,以更高的标准来激励学生,进而挖掘并激发他们的潜能。例如,在形式上,语言表达不仅要追求通顺,还应力求精确与简洁;在内容上,论文不应仅仅满足于对现有研究的梳理和复述,而应致力于提出新的观点和更为深入的分析。这些都对指导教师的能力水平和精力投入提出了更高的要求。

五、重塑研究生论文写作指导方法

伴随着论文评估标准的提高,教师宜同步改造研究生论文写作指导方法,帮助学生追求更高水平的论文撰写。笔者尝试结合技术发展、学术伦理研究以及法律领域的最新进展提出一些建议。

1.培养智能素养,引导学生以科技助力科研

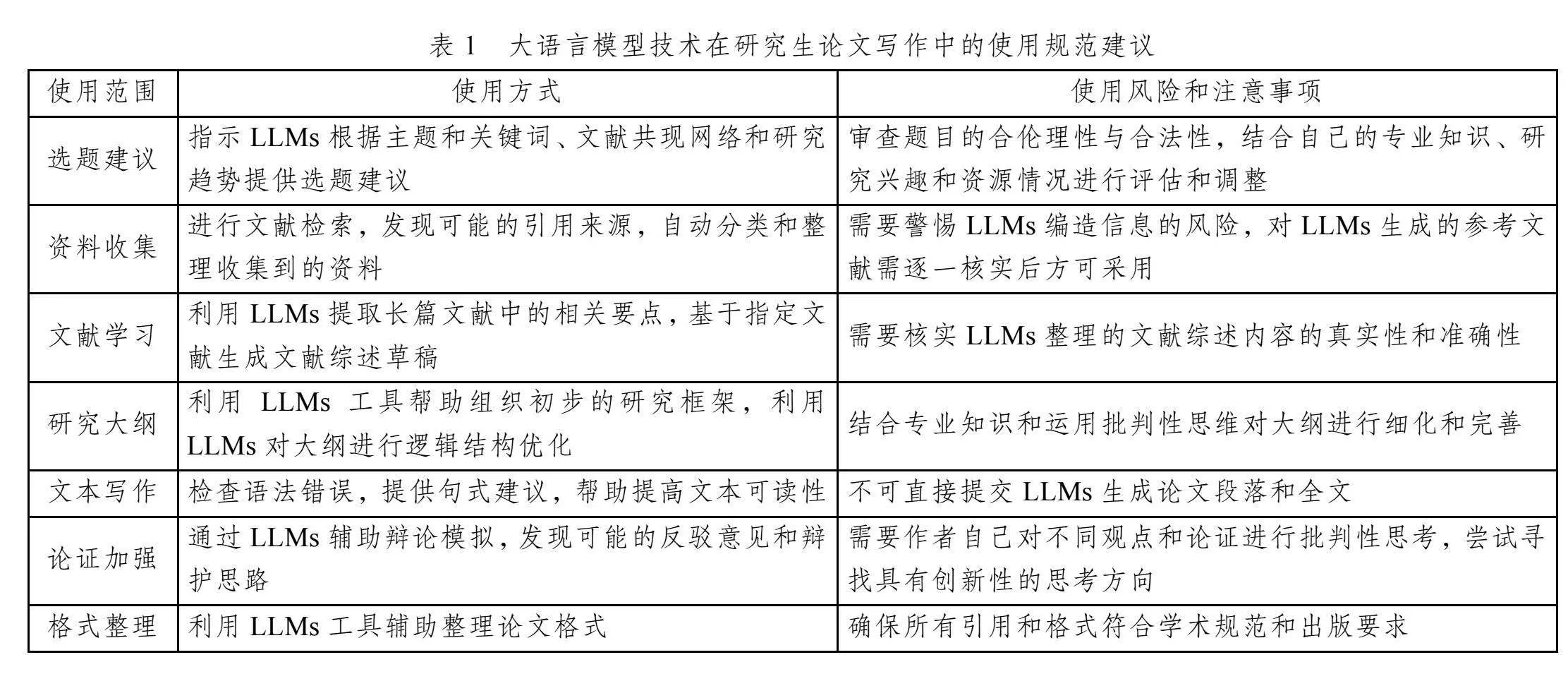

目前研究生课程教师和导师在指导学生论文写作时多侧重于研究规范和理论探索方面的指导,而对技术应用的重视程度不足。人工智能驱动高等教育的转型发展已成为数智化时代的必然趋势,高等教育系统需主动适应技术变革,提升学生的人工智能素养。哈佛大学和杜克大学都在2024年春季学期开设了有关人工智能的通识课程[38-39],我国高校应借鉴此类经验,教授学生如何识别人工智能技术在不同研究阶段的适用性,探讨和制定AI的使用边界,敦促学生遵守学术诚信。具体而言,笔者参考2023年9月中国科学技术信息研究所联合几家国际出版集团发布的《学术出版中AIGC使用边界指南》、2023年12月科技部监督司发布的《负责任研究行为规范指引(2023)》以及联合国教科文组织于2023年9月发布的《生成式人工智能在教育与研究领域的应用指南》[4]这三份文件,尝试提出研究生在论文写作过程中可以使用LLMs的范围、方式、使用风险和注意事项(见表1)。

值得注意的是,面对快速更迭的新技术,教师未必占有知识和技能优势,需要以谦虚的心态同学生一起探索,研究生导师应积极拥抱新技术而不是消极回避。我们必须认识到生成式人工智能开启了新的机遇之门,应当主动接纳这些创新技术,并且引导学生积极利用它们,以确保我们的教学和研究能够与时代发展保持同步[40]。

2.强化核心素养,培养学生原创和批判能力

在人工智能时代,我们可能需要重新审视和定义作品的“原创性”。现有的著作权法理论认为创作是人依据其自由意志直接决定表达性要素的行为[41]。在这种理解框架下,教师对学生论文的原创性要求常常是指在没有外界帮助,尤其是人工智能的辅助下,学生完全凭借其个人努力创作的成果。然而,随着人工智能技术的不断进步和普及,我们正步入一个技术融入人类思维和写作的时代,未来高等教育政策宜从人机协作的角度重塑对原创性的理解[27]。人类和人工智能共同创造的混合写作正在变得普遍并将很快成为常态。人工智能工具生成的文本可以被编辑、修改、返工和重新混合,最终的结果可以是一个人类和人工智能编写的混合产品,关于创作的道德评价的传统观念正在受到挑战[42]。“文本生成”(侧重于正确的写作、编辑和释义)和“思想生成”(侧重于创造新概念、综合它们以及做出判断)不同[26],在指导研究生论文写作时,教育者应当着重培养学生的思想生成能力。联合国教科文组织发布的《生成式人工智能教育与研究应用指南》建议,人类现在可以从GenAI提供的结构良好的大纲开始写作,而不是从头开始计划所有想法。在未来,教师应重点培养学生在设计和编写提示词、对GenAI输出进行批判性评估等高阶思维方面的技能,以及在GenAI大纲的基础上批判性地展开讨论的能力[4]37-38。

批判性思维对于培养学生的原创能力具有核心重要性。在研究生培养中,批判性思维作为一类默会知识长期被忽视[43]。人工智能时代教育工作者需要培养学生对人工智能生成内容进行批判性评估的能力[4]37。人工智能生成内容要么可以被归类于事实性断言,要么可以被归类于规范性断言。就前一类内容来说,需要培养学生评估事实性断言可信性的意识和能力。这是目前被强调较多的方面,其实只要从可靠来源认真核对人工智能生成的文本,这方面的问题并不难解决。更具挑战性的是如何去判断人工智能生成的关于诸如是非对错的规范性断言。这就需要教师去指导学生掌握更为精致和复杂的论证知识与技术,诸如辨别人工智能生成内容表达的模糊和歧义,分析所生成的内容的论证结构,从概念的清晰性和逻辑的严密性去评估人工生成的内容的说服力,辨识多种类型的论证错误。为了培养稳健的批判性思维,教育者应探索有效的教学模式,营造鼓励深入分析和质疑的学习环境[44]。值得注意的是,人工智能本身可以作为工具,通过辩论式和批判式的对话来促进学生批判性思维的发展[45]。如果运用得当,技术可以很好地帮助学生发展和训练批判性思维。例如,IBM开发的Project Debater人工智能系统具有强大的辩论能力,学生同之对话和辩论,可以发现新的观点和理由,并能够反思自己推理中的不足[46]。

3.涵养学术品位,激发学生创造的内在动机

激发学生进行思想创造的内在动机可以帮助我们走出“猫捉老鼠”的无意义循环。目前的内容查重就极易陷入了“猫捉老鼠”式的循环,检测软件不断更新换代,抄袭者随之不断寻求新的规避办法。对降低文字重复率的要求,导致学生将精力投入到无意义的表达变换的文字游戏上,而非真正的学术创新。因此,有理由担忧如果教师用诸如内容“AIGC值”这样的标准来要求学生,也极易导致师生之间陷入“猫捉老鼠”式的困境。所以,教师应当将关注的焦点从外在行为约束更多地转向内在动机的培养,引导学生追求真正的学术成就和知识创新。

教师应激发学生在论文写作中展现创造性思维的兴趣和个性,具有创造力的学生会自觉不满足于AI提供的答案。约翰·密尔(John Mill)在其伦理理论中区分了“高级快乐”与“低级快乐”,高级快乐较难获得满足,但对这两种快乐都有过体会的人,会更愿意追求高级快乐[47]。类似的,有些学生满足于投机取巧用自动生成的论文交差,很大程度上是因为他们还没有从论文写作和智慧创造中体会到成长和发现的乐趣。创造性的学术活动所带来的快乐更难获得,但是如果体会过它,人们就会更愿意去追求它。为此,教师应多去认可和赞赏学生在写作中表现出来的优点和成长性,帮助学生在论文写作中体会自我了解、自我突破、自我迭代发展的快乐[48]。如果学生能够体会论文写作中的这种高级快乐,就会自发地产生追求在学术探索中实现突破,发现和形成属于自己的独特学术表达的内在动机。

参考文献

[1] 车万翔, 郭江, 崔一鸣. 自然语言处理: 基于预训练模型的方法[M]. 北京: 电子工业出版社, 2021.

[2] 赵铁军, 许木璠, 陈安东. 自然语言处理研究综述[J].新疆师范大学学报(哲学社会科学版), 2024, 45(1): 174-196.

[3] 舒文韬, 李睿潇, 孙天祥, 等. 大型语言模型: 原理、实现与发展[J]. 计算机研究与发展, 2024, 61(2): 81-91.

[4] MIAO F C, WAYNE H. Guidance for generative AI in education and research[M]. Paris: UNESCO, 2023.

[5] 车万翔, 窦志成, 冯岩松, 等. 大模型时代的自然语言处理: 挑战、机遇与发展[J]. 中国科学: 信息科学, 2023, 53(9): 5-47.

[6] 安若鹏. 我的科研助理: ChatGPT全方位实用指南[M]. 王学彬, 高顾家, 译. 上海: 上海交通大学出版社, 2024.

[7] JOHNSTON H, WELLS R F, SHANKS E M, et al. Student perspectives on the use of generative artificial intelligence technologies in higher education[J]. International journal for educational integrity volume, 2024, 20(2).

[8] OU A W, STOHR C, MALMSTROM H. Academic communication with AI-powered language tools in higher education: from a post-humanist perspective[J]. System, 2024, 121.

[9] 任玉鑫, 王光臣, 汤庆新. 数字赋能背景下研究生使用ChatGPT 实际效能、风险检视及治理路径[J]. 黑龙江高教研究, 2024, 42(5): 73-79.

[10] 杨俊锋. 生成式人工智能与高等教育深度融合: 场景、风险及建议[J]. 中国高等教育, 2024(5): 52-56.

[11] COTTON D R E, COTTON P A, SHIPWAY J R. Chatting and cheating: ensuring academic integrity in the era of ChatGPT[J]. Innovations in education and teaching international, 2024, 61(2): 228-239.

[12] YEADON W, INYANG O, MIZOURI A. The death of the short-form physics essay in the coming AI revolution[J]. Physics education, 2023, 58(3).

[13] 王佑镁, 王旦, 梁炜怡, 等. “阿拉丁神灯”还是“潘多拉魔盒”: ChatGPT教育应用的潜能与风险[J]. 现代远程教育研究, 2023, 35(2): 48-56.

[14] KAYLA J. Professors are using ChatGPT detector tools to accuse students of cheating. But what if the software is wrong?[EB/OL]. (2023-04-13) [2024-04-01]. https://www. usatoday.com/story/news/education/2023/04/12/how-ai-detection-tool-spawned-1-cheating-case-uc-davis/11600777002/.

[15] OpenAI. How can educators respond to students presenting AI-generated content as their own?[EB/OL]. [2024-07-09]. https://help.openai.com/en/articles/8313351-how-can-educators-respond-to-students-presenting-ai-generated-content-as-their-own.

[16] ELKHATAT A M, ELSAID K, ALMEER S. Evaluating the efficacy of AI content detection tools in differentiating between human and AI-generated text[J]. International journal for educational integrity volume, 2023, 19(17).

[17] WOOD P. Oxford and Cambridge ban ChatGPT over plagiarism fears[EB/OL]. (2023-03-04) [2024-04-02]. https://www.universityworldnews.com/post.php?story=20230304105854982.

[18] KORN K, KELLY S. New York City public schools ban access to AI tool that could help students cheat[N/OL]. (2023-01-06) [2024-06-13]. https://edition.cnn.com/2023/01/ 05/tech/chatgpt-nyc-school-ban/index.html.

[19] 中国新闻网. 港大禁用ChatGPT等AI工具为全港大学首例[EB/OL]. (2023-02-18) [2024-02-13]. https://baijiahao.baidu. com/s?id=1758158352378135603amp;wfr=spideramp;for=pc.

[20] 刘盛. 美国一流大学在教育教学实践中应用ChatGPT的划界及其启示[J]. 高等教育研究, 2023(10): 89-98.

[21] HART H L A. Essays on Bentham: studies in jurisprudence and political theory[M]. New York: Oxford University Press, 1982: 1-2.

[22] SULLIVAN M, KELLY A, MCLAUGHLAN P. ChatGPT in higher education: considerations for academic integrity and student learning[J]. Journal of applied learning amp; teaching, 2023, 6(1): 1-10.

[23] 王少. 生成式人工智能对学术不端治理的妨碍及对策[J]. 科学学研究, 2024, 42(7): 1361-1368.

[24] 李志锴, 张骁. 人工智能生成内容(AIGC)应用于学位论文写作的法律问题研究[J]. 学位与研究生教育, 2024(4): 84-93.

[25] 刘明, 郭烁, 吴忠明, 等. 生成式人工智能重塑高等教育形态: 内容、案例与路径[J]. 电化教育研究, 2024, 45(6): 57-65.

[26] HALAWEH M. ChatGPT in education: strategies for responsible implementation[J]. Contemporary educational technology, 2023, 15(2): ep421.

[27] LUO J H. A critical review of GenAI policies in higher education assessment: a call to reconsider the “originality” of students’ work[J]. Assessment amp; evaluation in higher education, 2024. https://doi.org/10.1080/02602938.2024.2309963.

[28] Tertiary Education Quality and Standards Agency. Assessment reform for the age of artificial intelligence[R/OL]. (2023-11-23) [2024-07-02]. https://www.teqsa.gov.au/guides-resources/reso urces/corporate-publications/assessment-reform-age-artificial-intelligence.

[29] 吴叶凡, 付丽丽, 刘恕, 等. AI代写论文现象如何科学治理[N]. 科技日报, 2024-01-18(5).

[30] 周毅. 最科幻的一集: 清华教授用AI写小说, 斩获科幻奖[EB/OL]. (2023-12-13) [2024-02-18]. https://baijiahao.baidu. com/s?id=1785149884431032416amp;wfr=spideramp;for=pc.

[31] 程睿. ChatGPT介入学术论文创作透明度义务的履行[J]. 中国高教研究, 2023(11): 66-73.

[32] 科技部监督司. 负责任研究行为规范指引(2023)[EB/OL]. (2023-12) [2024-07-05]. https://www.most.gov.cn/kjbgz/2023 12/W020231221582942330036.pdf.

[33] 中国科学技术信息研究所, 爱思唯尔, 施普林格·自然, 等. 学术出版中AIGC使用边界指南[EB/OL]. (2023-09-22) [2024-07-13]. https://www.istic.ac.cn/ueditor/jsp/upload/file/ 20230922/1695373131354098301.pdf.

[34] Russell Group. New principles on use of AI in education [EB/OL]. (2023-07-04) [2024-04-02]. https://russellgroup.ac. uk/news/new-principles-on-use-of-ai-in-education/.

[35] 梁晨, 李伟健, 王屹. 自我迷失与理性回归: 把脉人文社科类研究生的学术论文撰写——基于教育学视角[J]. 学位与研究生教育, 2022(6): 25-31.

[36] 富勒. 法律的道德性[M]. 郑戈, 译. 北京: 商务印书馆, 2005: 6-7.

[37] 胡安宁, 周森. 站在巨人肩膀上的初学者: 社会科学研究中的生成式人工智能[J]. 江苏社会科学, 2024(1): 57-65.

[38] Artificial and natural intelligence (Gen Ed 1125)[EB/OL]. [2024-07-07]. https://gened-fas-harvard-edu-s.atrust.cqu.edu. cn/classes/artificial-and-natural-intelligence.

[39] University courses at Duke University. Digital you UNIV103 [EB/OL]. [2024-07-07]. https://ucourses.duke.edu/univ103/.

[40] 王喆, 夏清泉. 生成式人工智能对研究生师生角色的消解与重构[J]. 研究生教育研究, 2023(5): 48-54.

[41] 王迁. 再论人工智能生成的内容在著作权法中的定性[J]. 政法论坛, 2023, 41(4): 18-35.

[42] EATON S E. Postplagiarism: transdisciplinary ethics and integrity in the age of artificial intelligence and neurotechnology[J]. International journal for educational integrity, 2023, 19(23).

[43] 李忠. 研究生学术写作与训练的困境及其纾困——基于学位论文写作规范问题的分析[J]. 学位与研究生教育, 2022(4): 12-19.

[44] 费多益. 基于推理论证训练的哲学教学模式探索[J]. 科学技术哲学研究, 2019(6): 121-128.

[45] 戴岭, 赵晓伟, 祝智庭. 智慧问学: 基于ChatGPT的对话式学习新模式[J]. 开放教育研究, 2023, 29(6): 44-53.

[46] 网易智能. 人机大战“辩论赛”: IBM的AI选手战胜人类辩论冠军[EB/OL]. (2018-06-20) [2024-02-17]. https://m.163. com/tech/article/DKO06G2V00098IEO.html.

[47] 穆勒. 论自由[M]. 徐大建, 译. 上海: 世纪出版集团上海人民出版社, 2008: 9.

[48] 朱旭东, 郭绒. 论学术论文写作训练: 价值、方式和内容——基于“学术论文写作和规范”课程的经验[J]. 学位与研究生教育, 2022(6): 6-15.

(责任编辑" 周玉清)