AIGC背景下科技学术生态风险的协同防范体系构建

摘要: 人工智能生成内容(AIGC)背景下,学术生态风险被放大,包括基于真实研究的科技论文置信度降低、学术不端的科技论文数量激增、作者责任无人承担。而原有的风险防范手段仅能较好识别第三项风险,对于前两项风险识别效果欠佳,而这两项风险都会影响科技论文置信度。鉴于置信度不足的论文通常缺乏足够的科研事实支撑,提出把科技论文的审核和科研行为的真实性、科研结果的真实性结合起来的监管手段,构建协同防范体系。该体系包含长效的科研大数据比对机制、实验生成类图像溯源机制、对科研单位的监督机制、标准化的重复实验失败举报处理流程,使科技论文刊发的学术规范更系统更完备,有利于提高研究可靠性、保障科技论文置信度,并有助于提升学术风气,提高中国的国际学术话语权。

关键词:生成式人工智能;人工智能生成内容;科技论文;学术生态;学术监管;科研管理

中图分类号:G311;G230;C931.2 文献标志码:A 文章编号:1008-4657(2024)05-0081-10

人工智能生成内容(Artificial Intelligence Generated Content,简称AIGC)是指利用人工智能工具,基于某些预先设定或人工智能在训练中学习的算法、模型、规则,根据输入内容,进行内容产生、填充、调整及形式转化,自动生成的新的内容。在此过程中使用的人工智能工具称为生成式人工智能(Generative Artificial Intelligence,简称GAI)。

生成式人工智能已被广泛应用于生活创作领域,并已渗透到学术界。以ChatGPT(Generative Pre-trained Transformer)为代表的基于大语言模型的文本输出类生成式人工智能因其生成内容与人工撰写内容难于区分而给出版界带来震动。实际上,早在2022年6月,就有以人工智能署名的论文发表,但直到2023年1月,ChatGPT以共同通讯作者的身份发表了一篇JCR分区Q1的论文,才引发学术界广泛关注。之后,陆续有ChatGPT署名的论文诞生。由于人工智能生成内容在真实性、学术性、创新性上并不能得到保证,加之其他一些法律[ 1-3 ]、学术伦理[ 4 ]、价值观[ 5 ]上的争议,学术界普遍担忧人工智能生成内容会破坏良好的学术生态坏境[ 4,6-9 ]。对于人工智能生成文本,不同学术出版者态度不尽相同:德国《自然科学》允许使用大语言模型生成文本,但要求进行人工审查,以保证生成论文的准确性和可靠性[ 10 ];《自然Nature》《细胞Cell》《柳叶刀The Lancet》以及国内的《暨南学报(哲学与社会科学版)》《天津师范大学学报(基础教育版)》禁止将生成式人工智能列为作者,仅允许使用其辅助撰写论文,但需在文中研究方法部分或致谢部分予以声明;《科学Science》和国际机器学习会议(ICML)禁止使用大语言模型生成文本。对于人工智能生成视觉资料(图像和视频等),由于涉及虚假的实验结果,各学术出版者都禁止使用。

AIGC对科技期刊传统的论文评审模式、评审标准、出版伦理等造成急剧冲击。有的学者对此持很乐观的态度,认为出版业有能力自行解决相关风险[ 11-14 ],也有的学者对相关风险表示担忧,认为规范和问责机制是更好的解决之道[ 6,15-18 ]。目前比较系统地提出解决方案的有:蒋雪颖等[ 17 ]和刘宝存等[ 6 ]认为可以用技术手段、出版规范、问责制度来解决人工智能生成内容滥用的风险;张萍等[ 18 ]认为应从期刊内部管理和外部协同治理的方面共同防范机器参与论文写作。以上学者的解决方案在理论框架上有着较为完整的逻辑,问责机制也比较完善,但基于“疑罪从无”的人权保护原则,这些方案需建立在人工智能生成文本与人工撰写的文本能准确区分的基础之上,而目前这个基础并不存在[ 16,19-20 ]。而且由于生成式人工智能和检测技术在共同发展,很难期待将来的检测技术能达到并长期维持准确区分两者的状态。更何况,由于人工智能大大提升了科研工作效率,在科研工作中使用人工智能及其生成内容很难被绝对禁止,越来越多的学者对其态度趋于开放,认为应积极迎接这种改变而非抵制[ 21 ]。以往的观点多基于知识产权视角提出,侧重于辨别及限制在学术论文中使用AIGC,然而,对于科技论文来说,其研究内容的置信度远比论文撰写方式是由人工撰写或人工智能生成更为重要。AIGC背景下,某些科技论文中可能隐藏无意中产生的错误认知,实施效率更高的剽窃、伪造、篡改等学术不端行为产生的不实论文数量也可能大量增长。如何防治科技论文置信度降低的科技学术生态风险已成为科学界面临的重要且棘手的问题,置信度不足的科技论文如被批量传播将对科技学术生态造成破坏,阻碍科技发展,科技学术界亟需一种可执行性较强的防范体系来应对这种风险。

一、科技论文的产生过程中使用人工智能是大势所趋

科技论文与科技期刊的使命是传播科技研究成果、促进科技学术交流。因此,如果某种行为有利于传播科技研究成果、促进科技学术交流,那么该行为就应当被科技出版界鼓励;反之,如果某种行为阻碍传播科技研究成果、妨碍科技学术交流,甚至把错误的认知当成知识来传播、误导学术交流,那么该行为就应当被拒绝。合理使用人工智能有助于科研成果快速传播和更新,使用人工智能是科技论文产生方式不可避免的变革和发展趋势。

(一)科技论文特殊的作品价值判断标准是基础

对于普通作品,作品价值在于思想的不同表达。思想与表达二分法是著作权法中的一个重要原则,保护的是思想的外在表达形式,而非思想本身。例如,在高等教育教材领域,同一门课程往往有多个版本的教材,其思想相同,都是向高校学生介绍和传播该门课程大学阶段需要掌握的知识体系;但由于各个作者对于不同章节的重要性观点不同,对读者的接受能力的判断不同,对知识的理解角度不同,个人的写作习惯也不同等原因,其思想的表达,即各章节的设置及详略、各种实例和图表的选择、行文风格等都有较大的区别。对于普通文字作品而言,在思想不变的前提下,表达的不同可以形成不同的作品价值。

对于科技论文,作品价值在于思想本身的创新。科技论文是科技领域的学术论文,即对科技领域中的学术问题进行研究后,记录科学研究的过程、方法及结果,用于进行学术交流、讨论或出版发表,或用作其他用途的书面材料[ 22 ]。创新性是科技论文的核心价值所在,也是科技论文同行评议的重点。在表达上,科技论文大多遵循相对固定的写作格式,有着相似的平实严谨的语言风格等,并不追求表达的新颖。科技论文的创新性要求其与以往研究相比,对某个学术问题在研究的对象、方法、结论这三项至少有一项不同,即思想的不同。对于科技论文而言,在思想不变的前提下,表达的不同不能形成不同的作品价值。按照《CY/T 174—2019 学术出版规范 期刊学术不端行为界定》中的相关定义,这种“表达的不同”属于剽窃行为。

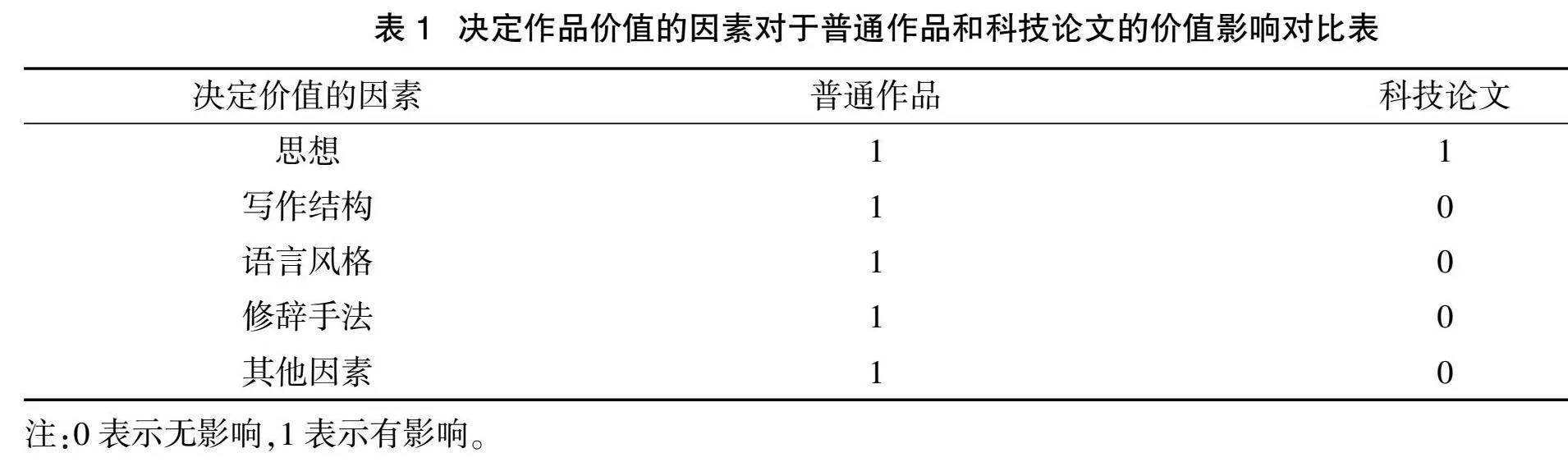

决定作品价值的因素对于普通作品和科技论文的价值影响对比如表1所示。

因此,在科技伦理规范内,如果在撰写科技论文中使用一定的工具或技术能更为直观、形象或便捷地表达思想时,那么该种工具或技术便具备了手段价值,具有合理使用的基础。

(二)合理使用人工智能促进科技成果的产生、传播和交流

1.推动科研进程,促进科技成果产生

首先,合理使用人工智能提高了科研效率和论文写作效率。在选择研究课题以及制定研究计划阶段,可以借助生成式人工智能,收集关键词或主题相关参考文献,并进行分类和梳理,总结参考文献结论,并帮助研究人员发现新的信息来源,实时跟踪研究领域最新进展[ 23 ],生成的团队成员共享的文献资源库,并支持团队成员一起补充文献资料、阅读、做文献笔记[ 24 ],从而增加文献阅读阶段团队成员的思想交互,提高阅读效率,并启发创造性的研究灵感,团队成员产生的灵感也可实时记录、交流,最终促进研究课题的选择以及研究计划的制定和完善。在研究进行阶段,已有的人工智能实验室技术已进入实用阶段,目前不仅能预测稳定存在的无机化合物[ 25 ],而且能在硬件设备完善的情况下自动合成化合物,17天内完成相当于一名博士研究生10年的工作量[ 26 ]。在论文撰写阶段,可利用生成式人工智能归纳、整理研究材料,对研究数据选择合适的分析方法、进行统计分析、制作和优化统计表,对引文进行格式检查、自动排序,对语言进行翻译和润色以提高文本的可读性,对已完成的论文提取摘要等,同时可以在写作中实现团队成员间的实时协作。

其次,合理使人工智能可以增加科技研究者的有效科研时间。生成式人工智能可快捷地将已有的数据和资料整理成向研究单位定期提交的各种总结类、汇报类的文本,令科技研究者这类工作时间大幅缩短;也可将word文档直接转化为ppt,令科技研究者为各种学术交流准备材料的时间大幅缩短。科技研究者非科研类工作的缩短使得在总工作量不变的前提下,其有效科研时间增加。

由此可见,合理使用人工智能可以将科技研究者从机械性、重复性的工作内容中解放出来,通过提高科研和写作效率及增加有效科研时间的方式,使研究者能有更多的精力进行创新性的研究思考,从而推动科研进程,促进科研成果产生。

特别强调,以上人工智能生成内容在使用时都应人工检查辨别真伪。

2.缩短科技论文出版时滞,促进科技成果传播和交流

一是在论文审稿阶段,生成式人工智能可以对论文进行分类标引,推荐审稿专家,收集相同主题的论文,辅助审稿专家审阅稿件[ 2 ]。人工智能对于论文中的关键信息报告不全、统计方法或结果错误、数据剽窃、抄袭等质量问题能较好识别,还能辅助审稿编辑排查不规范表述,检查引文准确性。因此,参考人工智能审读报告进行审读将提升审稿效率,缩短审稿等待时长。二是在退修阶段,如果审稿专家较多,评审意见繁杂,也可利用生成式人工智能汇总和分类评审意见以帮助作者快速理解评审意见,提高作者依照评审意见修改论文的效率。三是在编校阶段,针对拼写和语法错误,参考人工智能校对建议,可快速修改部分错误,提高编校效率和质量。由此可见,合理使用生成式人工智能将减少科技论文在各流程所花费的时间,从而缩短科技论文出版时滞,促进科技成果传播和交流。

综上,合理使用人工智能不仅不会影响科技论文的作品价值,反而会推进科研进程、缩短科技论文出版时滞,促进科技成果的产生、传播和交流,因此,科技论文的产生过程中使用人工智能是不可阻挡的历史趋势。

二、不当使用AIGC带来科技学术生态风险

(一)基于真实研究的科技论文置信度降低的风险

首先,是论文真实性风险,即客观方面的置信度风险。第一,使用AIGC文本,若隐含的知识性错误未被发现和改正,会降低科技论文真实性。一部分基于大语言模型的生成式人工智能会在写综述时一本正经地编造引用并不存在的文献,在行文上却看起来无懈可击[ 27 ];会按照法律条文和案例的一般格式和行文习惯编造现实中不存在的法律条文和案例;也会在论文中列举一些与论文内容无关的方程,可能只是因为按照论文的一般结构,此处应有方程。如果这类错误没有被发现和改正,出现在正式发表的科技论文里,那么该论文的真实性将无法保证。第二,误用AIGC图片作为实验生成类图像,会降低科技论文真实性。很多实验生成类图像的微小区别、实验条件与实验结果的对应关系都将直接影响研究结论,使用错误的实验生成类图像会产生错误认知,对研究结论的置信度带来毁灭性打击。因此,不当使用AIGC文本和图片都会减低科技论文客观方面的置信度。

其次,是论文偏离作者本意的风险,即主观方面的置信度风险。研究价值和研究结论的阐述均含有价值判断的内容,而人工智能难以实现价值判断,而且即便是技术上能实现,由于作者思想的多样性,这种技术上的价值判断也很难与作者的价值判断完全一致,无法准确表达作者的思想。因此,科技论文的研究价值和研究结论的撰写时使用AIGC,将可能使得这部分内容偏离作者本意,降低科技论文主观方面的置信度。

总之,即使研究事实真实存在,对AIGC的不当使用也会影响科技论文的置信度,破坏科技学术生态环境,干扰后续研究者的研究计划,阻碍相关领域的研究进程。

(二)学术不端的科技论文数量激增的风险

虽然虚构研究事实或伪造、篡改研究结果的学术不端行为在学术界一直都存在,但AIGC的数据巨量化和内容创造力的特点[ 28 ],降低了这类行为的实施难度。人工智能可根据使用者提供的资料高效形成文本,但如果使用的输入资料是伪造或篡改的,那么生成的文本也将存在相应的学术不端问题。在AIGC背景下,对图片进行些微改动变得更容易了,这种便捷的技术手段可能用于伪造、篡改实验生成类图像。虽然目前很多检测技术声称能检测出AIGC,但并不能保证检测准确度。更何况,即便是能准确地在科技论文中检测出AIGC,意义也不大,因为在科技论文中,需要准确识别的是研究数据、图片是否真实,而非论文的撰写方式如何。可见,在AIGC背景下,学术不端的科技论文的高产与识别效率的低下形成矛盾。

(三) 作者责任无人承担的风险

按照一般的署名原则,对论文有实际贡献的责任者应列为作者,包括参与选定研究课题、制订研究方案、直接参与全部或主要部分研究工作并作出相应贡献,以及参加论文撰写并对内容负责的个人或单位[ 22 ]。从主体上来说,生成式人工智能是一个辅助工具,既不是个人也不是单位,缺乏作为作者的主体资格;从能力和责任上来说,生成式人工智能不能独立发起原创性研究,也不能对研究结果负责,并缺乏持有和转让版权的能力,即缺乏作为作者的基本能力和责任。故将其列为作者的行为是不合理的,属于虚假署名,是学术不端行为。我们没有在科技论文里为电子表格、画图软件、数据处理软件署名,当然也无需为生成式人工智能署名,只需对使用了该工具的论文按照要求如实填写声明,并说明具体使用情况。

而且,作者责任还包含伦理、道德等社会价值观的约束,以及各种规章制度、法律法规等奖惩措施的约束,在社会中生产生活的个人或单位受其约束,而人工智能由于不存在价值观也没有对奖惩措施的敬畏之心,因而不受约束。

已有论文存在生成式人工智能署名的情况,可以认为是其作者出于逃避作者责任、哗众取宠或其他利益理由的不当署名行为。例如2022年12月一篇雷帕霉素抗衰老应用的论文曾把ChatGPT列为第一作者,而按照学术界的惯例,第一作者是选定研究课题、制订研究方案的研究组织者,或是直接参与全部或主要部分研究工作并作出最大贡献者,显然ChatGPT并不在以上两项之列。

因此,将人工智能署名为作者将使得作者责任无人承担,既不利于保证科技论文的质量,也不利于促进研究成果的转化。该风险因目前的审稿体系能有效识别,防范效果较好。

三、现有风险防范手段的不足和困境

科技论文现有的质量保障主要通过科技论文出版环节的内部处理环节和外部规范(学术道德规范和法律法规)来实现,是以学术道德规范和法律法规为行为准则,由科技期刊编辑部主导,作者、同行评议专家共同参与的质量保障体系。

(一)学术道德规范和法律法规效力不强

道德规范推行及产生效果需要时间积累,且不具有强制效力,如没有强力监管手段的配合,结果可能不尽人意。为了防范学术不端,加强诚信治理,并引导相关利益主体就人工智能生成内容使用达成共识。2023年9月20日,中国科学信息研究所联合爱思唯尔、施普林格·自然、约翰威立国际出版集团制定并发布了《学术出版中AIGC使用边界指南》[ 23 ],提出了透明度和问责制、质量和诚信、隐私和安全、公平、可持续发展共五个原则,提供了一个符合道德行为的框架,以帮助作者、研究机构、学术期刊出版单位等就如何合规合理地使用人工智能生成内容做出指导。这是我国作为科技大国为维护学术生态环境做出的重要举措。该规范实施时间较短,也并未全面传播覆盖,且不具备强制力,其效果还有待观察。

在法律法规方面,尚未有专门的法律法规对利用人工智能进行的各种学术不端行为作出规定。以往科技论文剽窃、伪造、篡改等学术不端行为的频率不高,零星的学术不端行为的危害相对较小,通常达不到需要法律制约的程度,因而也未针对其立法。而AIGC背景下,这类学术不端行为变得越发频繁,很可能从零星的学术不端行为演变成量产的学术不端行为,行为的危害性大大提升。由于生成式人工智能属于新生事物,尚未积累足够的案例,立法工作相对薄弱。我国2023年5月23日颁布并于2023年8月15日起施行的《生成式人工智能服务管理暂行办法》,仅用于约束生成式人工智能服务提供者的行为,尚未有法律法规用于约束生成式人工智能服务使用者的行为。

因此,在现阶段,用学术道德规范和法律法规防范AIGC背景下的科技学术生态风险实施难度较大,作用效力不强。

(二) 作者责任需要有效监督

在科技论文的形成和发表阶段,作者责任主要包括两点:

1.作者应对科技论文的学术质量负责

首先,在科技论文写作中,对于科技论文中思想性、创造性较强的部分应该采取人工撰写的形式,以保证科技论文的学术性、创新性。其次,科技研究者在使用前应选择合适的生成式人工智能工具,并对论文中使用的AIGC进行全面人工审查和修改。大语言模型由于本身特性,导致AIGC的真实性无法保障,研究者应谨慎使用以ChatGPT为代表的基于大语言模型的生成式人工智能。这种真实性不足结果主要由两类原因产生:第一,大语言模型预训练和微调使用的语料库资料以及联网补充更新的背景数据资料并不都是准确可靠的,错误的语料库和背景数据资料会产生缺乏真实性的文本[ 29 ];第二,大语言模型由于自身设计的原因,在语料库和背景数据资料里缺乏答案的情况下,会自行编造一个语法正确、语言逻辑通顺、符合该语言写作习惯的答案,并不考虑其是否符合客观事实。例如,对于5052铝合金能否通过热处理强化,ChatGPT给出了肯定的回答。然而5052铝合金组织为单相固溶体,其溶解度不随温度而显著变化,属于不可热处理强化的铝合金[ 30 ]。研究者可选择数据来源更可靠的人工智能工具生成内容以减少错误的产生,如,可选择Research Rabbit,不仅可以进行文献检索,还支持不同用户间的协作、共享[ 24 ]。在使用合适的人工智能工具生成内容后,再进行全面的人工审查和修改以排除错误。这样,人工撰写的关键部分可以保证科技论文的学术性、创新性,合适的人工智能工具生成的内容经人工全面审查、修改后可以保证其真实性,人工撰写内容和人工智能生成内容有机结合,保证了科技论文的学术质量。

2.作者应对科技论文的署名行为负责

应按照署名规范,根据参与研究的个人或单位对论文实际贡献的大小在文中依次署名,不应将不符合署名条件的个人或单位列为作者,不应将人工智能工具等列为作者。

那么,依靠作者自发地履行作者责任是否能有效控制人工智能生成内容带来的学术生态风险呢?作者在学术道德水平、认知水平和责任心上有较大的差异,并不能保证所有作者都积极自发履行作者责任;同时,科技研究存在竞争性,科技论文的写作也属于较为私密的过程,对于作者是否正确履行了作者责任缺乏有效监督。在这种情势下,把防范AIGC背景下的科技学术生态风险的责任寄希望于作者自律显然是不现实的。

(三) 传统审稿体系人力资源有限

生成式人工智能把基于真实研究的科技论文的写作时间从数个月缩短到几小时(极端情况下,一篇论文甚至能在一小时之内能完成初稿),极大提高了论文写作效率。伪造的虚假科技论文由于不需整理研究数据,所需的时间只会更短。因此,在生成式人工智能全面运用到科技论文的写作之后,预计置信度不可靠的科技论文投稿量将呈数量级增长,给科技期刊审稿工作带来巨大压力,科技期刊不得不面对论文工厂产能跨越式提高带来的冲击。

那么,科技期刊是否可以通过自身努力来解决这个矛盾呢?

科技期刊关注检测工具的更新情况,以技术手段缓解即将到来的大量低质量论文投稿的冲击是否可行?赵凯[ 5 ]对于人工智能生成内容在出版行业的应用现状及趋势,提出了人机协同审核的构想。但是由于技术水平的原因,目前的人工智能审读报告会遗漏很多错误,实用性不强,更何况检测工具有其局限性。为了保证审稿质量,科技期刊不能以检测工具的检测结果直接判定论文的质量,而应该把检测结果作为参考,以人工阅读为主,综合判断其质量。因此,在AIGC背景下,新的形势对科技期刊编辑部的人力资源有了更高的需求。相对于可能出现的呈数量级增长的投稿数量,编辑数量无法对等增长,编辑部将面临编辑人力资源不足的问题。同行评议是当前大多数科技期刊审稿的一个重要环节,同理,编辑部也将面临审稿专家人力资源不足的问题。飞速增长的论文工厂产能与数量有限的编辑和审稿专家资源形成矛盾。这将导致平均每篇稿件的审读时间将大幅减少,审稿质量降低,出版时滞延长。

四、 新的协同防范体系的建立

一方面,现有的以学术道德规范和法律法规为行为准则,由科技期刊编辑部主导,作者、同行评议专家共同参与的质量保障体系已不能应对人工智能生成内容带来的审稿工作量的巨大增长;另一方面,以论文本身作为判断研究价值依据的审核方式在可靠性上有着先天不足,无法确定研究事实是否存在和研究结果是否真实。AIGC背景下,在数量很大的真假掺杂的科技论文投稿中筛选出置信度可靠、有研究价值并符合署名规范的科技论文,是目前审稿体系所无法独立承担的一项任务,需要一种行之有效的防范体系加以辅助,以应对当前困局。

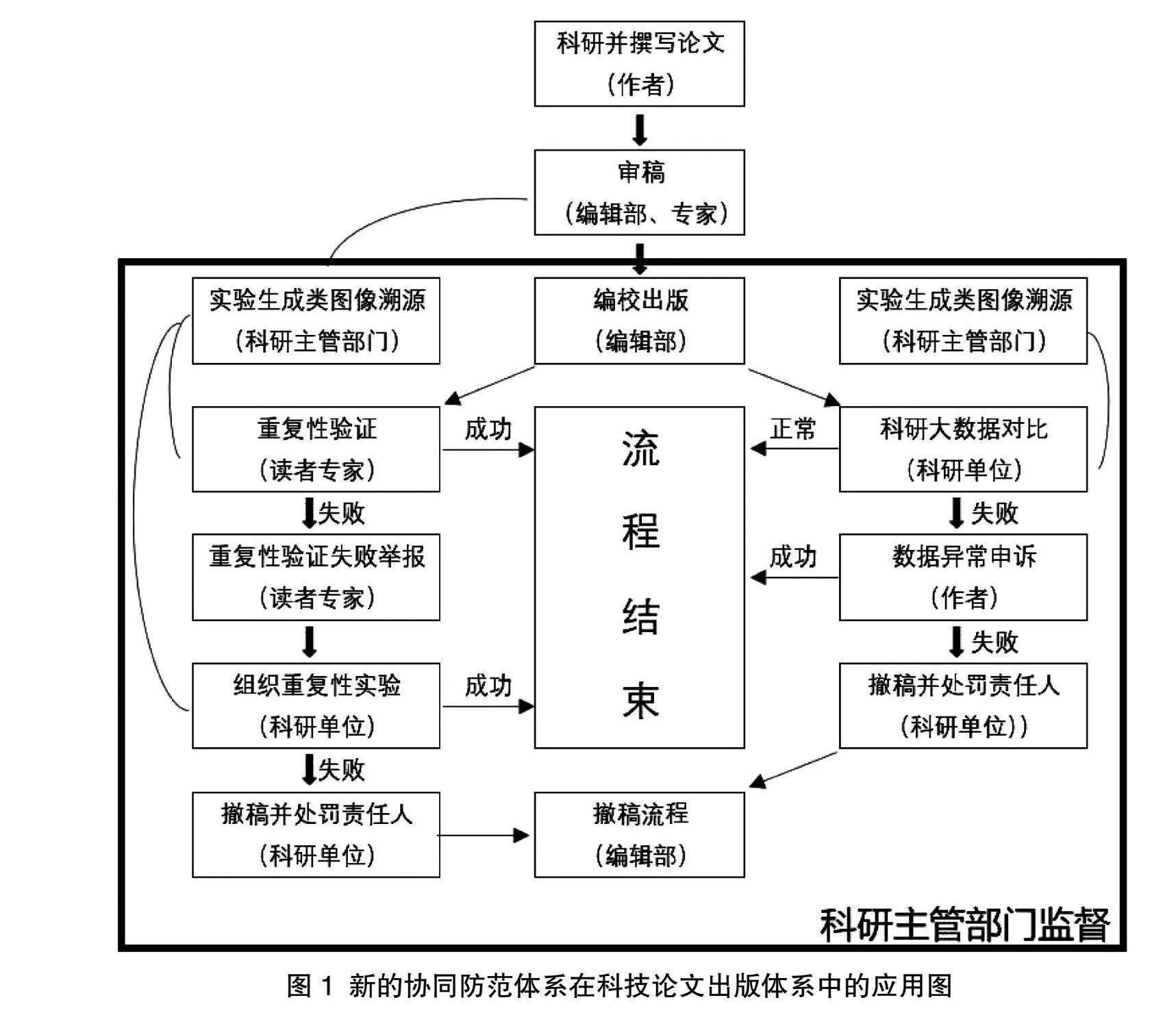

由于科技研究中的纯理论研究(如数学研究、某些学科的基础理论研究)论文还未发现使用AIGC的情况,本协同防范体系的建立暂时将这部分研究排除在考虑之外,仅考虑基于科学实验的研究所对应的科技论文。构建新的协同防范体系应用于科技论文出版体系如图1所示。

(一) 长效的科研大数据比对机制

长效的科研大数据比对机制可以防治虚构研究事实的学术不端行为。生成式人工智能只能伪造科技论文里的文本、图片等书面材料,并不能伪造现实中发生的科研事实。因此,在判断研究的真实性上,结合科研事实进行审核的方式,将比仅依靠审读书面材料进行审核的方式更为可靠。

各科研单位应依托单位已有的各种工作数据(包括但不限于财务数据和申报数据),建立长效的学术监管体系,定期把本单位科研人员发表的科技论文与其实际科研工作进行联合审核,审查相关研究行为的真实性;在此基础上,对学术不端的研究者进行惩处,并对相关论文及时撤稿。AIGC背景下,长效的科研大数据比对机制使得伪造研究事实的学术不端行为事实清楚、证据充分,相关处罚也能落到实处,将更切实地惩前毖后。长效的科研大数据比对机制包含以下几个方面的内容:

第一,应建立完整的科研大数据库,为长效的科研大数据比对机制提供实施基础。科研大数据库是指对科研工作过程中产生的非研究数据的各种外部信息进行整理、归纳和保存,形成的数据库。应将以下内容纳入科研大数据库:1.研究场所和仪器使用记录。科技研究的实验和检测一般发生在特定场所,真实的研究行为必然会有相应的研究场所,真实的研究数据的产生常常需要使用相关仪器,这类记录既包含场所或仪器使用时的纸质或电子登记记录,也包含监控记录或门禁记录中人员出入的数据。2.采购记录。研究单位通常会对常用耗材进行集中采购和管理,采购时间和相应的采购清单应予以记录。各项目组除了从公共库房领取常规耗材外,对于需定制的、保质期很短的、需提前预约的或其他特殊的实验材料常常会自行采购,采购时间和相应的采购清单也应予以记录。3.支付记录。这主要包括项目组自行采购材料的支付记录,以及研究相关的各种劳务支出的支付记录。4.耗材的入库、出库记录。科技研究的过程中常常伴随着实验材料、药品及其他耗材的消耗,对于耗材的入库、出库应专人管理,实时记录。5.设备的物流接收记录、安装记录、实验室施工记录(有的设备需要特定的电源、通风、光照等条件,需要对实验室进行改造才能安装)。有些专业设备到货后需厂商上门安装,各项目组应记录好接收和安装的时间、人员,并附有相关人员签字。6.其他能印证科研行为的相关数据。例如,医学研究对应的病历信息,教育研究对应的相关学生的人口统计学信息、考试成绩,大型仪器所在实验室的用电记录等等。科研大数据库的建立是判断研究行为真实性的基础条件,科研大数据库的内容越完善,越有利于准确判断研究行为的真实性。

第二,应建立科研大数据库内部数据自动比对机制,以保证科研大数据库的各项数据准确无误。科研大数据库内部数据自动比对机制是定期或实时自动比对数据库内的相关数据,发现数据的异常和矛盾之处,查明原因,及时更正,以保证科研大数据库的准确性。对于不实填报应要求填报人限时提供证明材料予以更正,对于存在主观恶意伪造数据材料进行虚假填报的行为人应予以处罚。常见的异常之处有内容的矛盾(如,采购清单与入库记录不符)、时间的矛盾(如,设备使用记录早于安装时间、安装时间早于物流收货时间)等。

第三,应建立定期的科技论文与科研大数据联合比对机制,以便及时发现涉嫌虚构科研行为的科技论文。进行定期的科研成果统计时,将科技论文内容与科研大数据库进行比对,及时发现数据异常和矛盾之处,防范研究人员基于虚假的研究事实伪造科技论文并发表。常见的异常之处有内容的矛盾(如论文中使用的特殊耗材实际未采购)、时间的矛盾(如论文实验进行的时间早于耗材入库时间、检测进行的时间早于该检测仪器的安装时间)、硬件设施不能满足论文所需研究条件等。

第四,应允许研究人员提交证明材料进行申诉,以准确判断数据异常和矛盾的原因。数据异常和矛盾既有可能是科研大数据库的数据错误填报、漏报造成的,也可能是研究人员伪造科研事实造成的。例如对于论文中使用的特殊耗材实际未采购的情况,如研究人员能提供其他途径获得该耗材的记录且记录被证明为真实的,则属于耗材来源漏报的情况,应对其申诉予以采纳,并在数据库中补充该数据。

总之,长效的科研大数据比对机制将使得虚构研究事实的科技论文失去生存的土壤,让这种行为的相关证据明确、充分,使研究单位可以对相关学术不端的科技论文及时撤稿,减少其对科技学术生态环境的伤害,也让研究单位对相关行为人的处罚有理有据,并为后续立法中的相关罚则的制定提供事实依据。这一措施将有效防范AIGC背景下伪造研究事实的科技论文数量激增的风险,在其数量激增的初期遏制住增长势头,避免论文投稿量跨数量级增长对于审稿体系的冲击。

(二)实验生成类图像溯源机制

实验生成类图像溯源机制可以防治不实的实验生成类图像引起的科技论文结论置信度降低的风险,包含图片误用的情况以及剽窃、伪造和篡改图片的学术不端行为。实验生成类图像溯源机制是指对真实的实验生成类图像及其相关信息予以统一保存备案,发放溯源码,并允许任何人通过溯源码查看其对应的实验生成类图像及其相关信息。这一措施可以防治剽窃、伪造和篡改实验生成类图像作为研究结果的学术不端行为。实验生成类图像对于研究结果至关重要,而对实验生成类图像的剽窃(对他人的实验生成类图像些微改动后使用)和篡改(对自己的实验生成类图像修改后使用)却又很难识别,更有甚者,在AIGC背景下,直接用人工智能生成的图片伪造成实验生成类图像的行为也变得简便易行且难以识别。为保证科技论文中使用的实验生成类图像的真实可靠,我们可以通过标记真实的实验生成类图像的方法予以解决。建议参照食品安全领域的做法,建立实验生成类图像的溯源机制:由国家科技主管部门组织搭建实验生成类图像查询平台,各检测仪器生产厂商在为检测仪器配套的软件里预留平台接口,在仪器产生实验生成类图像时同步完成该图的溯源码生成和备案,备案信息除原图外还应包括仪器信息(生产厂家、仪器型号、仪器编码)以及该图生成的时间、设备参数、IP地址所在地(或仪器备案的安装地址)。研究者在科技论文中使用到的每一张实验生成类图像都应提供溯源码,供编辑、审稿人和读者后续查询。

建立实验生成类图像溯源机制不仅可以防范一部分基于真实研究的科技论文置信度降低的风险(作者不慎使用错误的实验生成类图像的情况,或误用AIGC图片作为实验生成类图像的情况),还从源头上防范剽窃、伪造和篡改实验生成类图像作为研究结果的学术不端行为,使得研究的置信度大大提高。而且,由于包含设备参数信息,同领域研究者进行重复实验验证的时间成本和经济成本也将大幅降低。与此同时,率先建设实验生成类图像溯源机制会引导科研nC24SSk4JSPXvPUm/vUiMQ==的学术中心向我国部分转移,对于提高我国的国际学术话语权具有重要意义。

(三) 标准化的重复实验失败举报处理流程

标准化的重复实验失败举报处理流程用于保障协同防范体系高效运行。之前提到的实验生成类图像溯源机制给所有读者提供了发现将剽窃、伪造和篡改的实验生成类图像作为实验结果的机会,并降低了读者进行重复实验验证的时间成本和经济成本,那么,在读者重复实验验证失败的时候,还应为其提供通畅的举报渠道和公正透明的处理流程。这一方面保证结论有误的科技论文能被及时撤稿,减少对科技学术生态的污染;另一方面也可以惩前毖后,警示其他研究者。

标准化的重复实验失败举报处理流程包括以下几个方面的内容:

第一,科研单位应公布举报所需材料和提交通道。重复实验失败举报一般应为实名举报,举报所需材料包含举报人信息和举报材料。举报人信息应包含举报人实名信息、工作单位、联系方式等。举报材料应标明所举报科技论文的标题以及出版信息(如所发表的期刊名、年、卷、期、页码等),并提供举报人重复实验的实验数据。举报提交通道应多元、便捷,由于重复实验可能在全国甚至世界各地开展,因此重复实验失败举报应至少包含一条能接受异地举报者提交举报的通道。第二,科研单位应要求被举报人提供原始实验数据备查。重复实验失败举报审核通过后,科研单位应要求被举报人提供原始实验数据,一方面可对数据进行审查,另一方面也为研究单位组织重复实验提供必要的实验参数。第三,科研单位应积极组织重复实验。科研单位既可以要求论文作者在全程录像的条件下开展重复实验,也可以组织单位其他科研人员依照该科技论文的原始研究数据开展重复实验,也可以邀请第三方机构依照该科技论文的原始研究数据开展重复实验,重复实验的结果应予以公布,并向举报人反馈。对于已确定无法通过重复实验验证的科技论文,科研单位应及时联系相关出版方(主要是科技期刊)对该论文撤稿,并视该结果出现的原因为工作失误或主观恶意,给予相应处罚。

标准化的重复实验失败举报处理流程能提高结论有误的科技论文处理效率,减少其传播,降低其对科技生态环境的污染。

(四)对科研单位的监督机制

对科研单位的监督机制用于保障协同防范体系中的科研单位积极履行相关职责。因为科研单位对结论有误的科技论文积极组织重复实验验证并及时撤稿的行为可能影响其学术声誉,并影响相关科研人员的基金申报,常常不符合科研单位的短期利益,所以科研单位有可能做出包庇行为,不处理相关科技论文和科研人员,并隐瞒该情况。因此,科研主管部门对科研单位的监督机制是科技学术生态风险的协同防范体系有效运行必不可少的保障。在监督上可以采取不定期抽查、开放常规的投诉渠道等方式。对包庇行为可以通过处罚科研单位负责人、扣减该单位下年度科研拨款、限制该单位基金项目申报等方式进行惩处。

五、结语

合理使用人工智能不会影响科技论文的价值,反而有助于研究者高效完成科技论文,并缩短出版时滞,从而有利于科技研究成果的快速传播,促进学术交流,因此,人工智能在科技论文中的使用是不可避免的历史发展趋势。在AIGC背景下,虽然科技学术生态风险变大了,但这种风险是可以通过适当的措施来防范的。本研究把科技论文的审核与科研事实结合,提出构建基于科研事实的协同防范体系,该体系兼顾了当前技术水平和实施的经济成本,在科研管理的实践上具有较高的实用性。该体系的构建可使科技论文刊发的学术规范更系统更完备,有利于提高研究可靠性,保障科技论文置信度,并有助于提升学术风气,提高我国的国际学术话语权。期待本研究能为良好的科技学术生态建设提供一点新思路。

参考文献:

[1]储陈城,魏培林.生成式人工智能犯罪中研发者刑事责任的认定——以ChatGPT为例[J].重庆理工大学学报(社会科学),2023,37(9):103-113.

[2]王大志,张挺.风险、困境与对策:生成式人工智能带来的个人信息安全挑战与法律规制[J].昆明理工大学学报(社会科学版),2023,23(5):8-17.

[3]魏顺光.AIGC爆火的法律困境及其应对之道——基于ChatGPT为中心的思考[J].人工智能,2023(5):93-100.

[4]袁源,谢文亮.ChatGPT在学术出版应用场景中的伦理困境及其纾解之道——基于利益相关者理论的思考[J].科技与出版,2023(8):89-96.

[5]赵凯.版权、伦理与价值观审核——人工智能生成内容(AIGC)对编辑职业能力的新挑战[J].科技与出版,2023(8):62-68.

[6]刘宝存,苟鸣瀚.ChatGPT等新一代人工智能工具对教育科研的影响及对策[J].苏州大学学报(教育科学版),2023,11(3):54-62.

[7]张璐,郭晓亮,景勇,等.ChatGPT对学术期刊的影响及应对策略研究[J].出版与印刷,2023(4):91-96.

[8]王琪.技术赋能与问题衍生:ChatGPT对学术期刊出版的影响[J].河南大学学报(社会科学版),2023,63(5):139-145,156.

[9]骆飞,马雨璇.人工智能生成内容对学术生态的影响与应对——基于ChatGPT的讨论与分析[J].现代教育技术,2023,33(6):15-25.

[10]曹兵,唐帅,李洁,等.ChatGPT对科技期刊的影响及其应用[J].传播与版权,2023(18):48-52.

[11]张新玲,谢永生,章权.ChatGPT对学术期刊的挑战及其应对策略[J].传媒,2023(19):27-29.

[12]宋时磊,杨逸云.应用场景、风险与前景:ChatGPT类大语言模型时代的学术出版[J].出版科学,2023,31(5):76-84.

[13]李松山.ChatGPT背景下科技期刊面临的挑战及应对策略[J].传播与版权,2023(19):58-61.

[14]任宇,罗剑萍,甘甜.ChatGPT对学术出版实践的影响及其应对[J].武汉理工大学学报(社会科学版),2023,36(4)::113-119.

[15]沈锡宾,王立磊,刘红霞.人工智能生成内容时代学术期刊出版的机遇与挑战[J].数字出版研究,2023,2(2):27-33.

[16]张萌,朱鸿军.知识暗流的合规实践:ChatGPT在学术出版中的应用与挑战[J].科技与出版,2023(5):33-40.

[17]蒋雪颖,刘欣.生成式人工智能技术下的学术生产与出版:变革、失范与路径[J].数字图书馆论坛,2023,19(5):64-71.

[18]张0f2459ba6b98a7b81d083f3f7e89c3e0e7b2865bb6784df9c57dd3e8fc44a055萍,张小强.机器参与论文写作的出版伦理风险与防范对策[J].中国科技期刊研究,2022,33(4):439-449.

[19]范志武,姚金良.基于深度金字塔卷积神经网络的ChatGPT生成文本检测方法[J].数据分析与知识发现,2024,8(7):14-22.

[20]王一博,郭鑫,刘智锋,等.AI生成与学者撰写中文论文摘要的检测与差异性比较研究[J].情报杂志,2023,42(9):127-134.

[21]He S,Yang F,Zuo J,et al. ChatGPT for scientific paper writing—promises and perils[J/OL]. The Innovation,2023,4(6): 100524.(2023-10-18)[2023-11-28]. https://www.cell.com/the-innovation/fulltext/S2666-6758(23)00152-2.

[22]GB/T7713.2-2022.学术论文编写规则[S].北京:中国标准出版社,2022. GB/T7713.2-2022.

[23]中国科学院信息研究所.学术出版中AIGC使用边界指南[E/OL].(2023-09-22)[2023-10-17].https://www.istic.ac.cn/ueditor/jsp/upload/file/20230922/1695373131354098301.pdf.

[24]王树义,张庆薇,张晋.AIGC时代的科研工作流:协同与AI赋能视角下的数字学术工具应用及其未来[J].图书情报知识,2023,40(5):28-38,126.

[25]Merchant A,Batzner S,Schoenholz S S,et al. Scaling deep learning for materials discovery[J]. Nature,2023,624:80–85.

[26]Szymanski N J,Rendy B,Fei Y. et al. An autonomous laboratory for the accelerated synthesis of novel materials[J]. Nature,2023,624: 86-91.

[27]曾建华.人工智能与人文学术范式革命——来自ChatGPT的挑战与启示[J].北京师范大学学报(社会科学版),2023(4):78-88.

[28]李白杨,白云,詹希旎,等.人工智能生成内容(AIGC)的技术特征与形态演进[J].图书情报知识,2023,40(1):66-74.

[29]李庆红,叶文梓.ChatGPT促进教育变革的机制、范式与风险[J].中国教育科学(中英文),2023,6(3):45-51.

[30]高湘民,申皓铭.生成式人工智能对科技论文写作的影响[J].中国科技信息,2023(15):124-128.

Construction of Collaborative Prevention System of

Scientific and Technological Academic Ecological

Risks under the Background of AIGC

XU Liqun

Abstract: In the context of artificial intelligence generated content (AIGC), academic ecological risks are amplified, including the risk of decreased credibility of scientific papers based on real research, the risk of a surge in the number of scientific papers based on academic misconduct, and the risk that the author is not held accountable. However, the original risk prevention method can only identify the third risk well, while the identification effect of the first two risks which will both affect the credibility of scientific and technological papers is poor. In view of the fact that papers with low credibility usually lack sufficient support of scientific research facts, we propose to combine the review of scientific papers with the authenticity of scientific research behavior and results to build a collaborative prevention system. The system includes a long-term big data comparison mechanism for scientific research, an image traceability mechanism for experimental generation, a supervision mechanism for scientific research institutions, and a standardized process for reporting and handling repeated experimental failures, which makes the academic norms of scientific and technological papers more systematic and complete, and is conducive to improving research reliability and guaranteeing the credibility of scientific and technological papers. It also helps to enhance the academic atmosphere and improve China's international academic discourse power.

Key words: Generative artificial intelligence; Artificial intelligence generates content; Scientific and technological papers; Academic ecology; Academic supervision; Scientific research management