基于多光谱航空图像的农田生长异常区域实时分割模型

胡海洋 陈健 张丽莲 杨林楠

摘要:针对农田异常区域分割问题,采用特征融合跳跃连接模块和全局-局部注意力模块改进UNet网络模型,提出了一种农田异常区域实时分割网络,实现了对多种农田异常区域的精细分割。结果表明,农田生长异常区域实时分割模型的平均交并比(MIoU)明显优于其他模型,平均交并比为41.24%;相较于使用UNet作为基线的模型,虽然本研究模型的参数量略有增加,但农田分割效果明显提升,MIoU提高了4.16个百分点;与基于Transformer编码器的SegFormer模型相比,本研究模型的参数量基本相同,MIoU提高了2.50个百分点。本研究模型通过采用自适应采样训练方法确保在每个类别上都能取得出色的分割效果。利用多光谱航空图像训练农田生长异常区域实时分割模型,有助于实现无人机对农田生长进行实时监测、预警,推动智慧农业发展进程,为自动监测农田生长情况提供了新的方法和思路。

关键词:多光谱;农田生长异常区域;航空图像;UNet;DeepLabV3+;SegFormer

中图分类号:S435.12;TP18 文献标识码:A

文章编号:0439-8114(2024)06-0198-06

DOI:10.14088/j.cnki.issn0439-8114.2024.06.032 开放科学(资源服务)标识码(OSID):

Real-time segmentation model for abnormal growth areas in farmland

based on multispectral aerial images

HU Hai-yang, CHEN Jian, ZHANG Li-lian, YANG Lin-nan

(College of Big Data/Yunnan Engineering Technology Research Center of Agricultural Big Data/Yunnan Engineering Research Center for Big Data Intelligent Information Processing of Green Agricultural Products,Yunnan Agricultural University, Kunming 650201,China)

Abstract: In response to the problem of abnormal segmentation in farmland, a feature fusion skip connection module and a global-local attention module were used to improve the UNet network model. A real-time segmentation network for abnormal farmland areas was proposed, which achieved fine segmentation of various abnormal farmland areas. The results showed that the Mean Intersection Union ratio (MIoU) of the real-time segmentation model for abnormal growth areas in farmland was significantly better than that of other models, with a MIoU of 41.24%;compared to the model using UNet as the baseline, although the number of parameters in this study model had slightly increased, the farmland segmentation effect had significantly improved, with an increase of 4.16 percentage points in MIoU;compared with the SegFormer model based on Transformer encoder, the parameter count of this study model was basically the same, with an increase of 2.50 percentage points in MIoU. This research model ensured excellent segmentation performance in each category by using adaptive sampling training methods. Using multispectral aerial images to train a real-time segmentation model for abnormal growth areas in farmland could help achieve real-time monitoring and early warning of farmland growth by drones, promote the development of smart agriculture, and provide new methods and ideas for automatic monitoring of farmland growth.

Key words: multispectral; abnormal growth areas in farmland; aerial images; UNet; DeepLabV3+; SegFormer

随着农业智能化的迅速发展,将无人机影像和神经网络结合进行农田生长异常区域的实时分割成为一项备受关注的任务。这项任务旨在通过结合高分辨率的无人机影像和先进的神经网络技术,实现对农田作物生长状况的实时监测与分析。对影像中的丰富纹理信息进行提取,由神经网络对农田的整体生长情况进行精准分析,检测出其中可能存在生长异常的区域。这项技术不仅可以用于实时监测农作物的生长状态,及时发现并定位生长异常区域,还可以为农业生产提供智能化的决策支持,及时采取相应的调控措施,如合理施肥、及时灌溉、防治病虫害等,最大程度地提高农田产量、优化资源利用。此外,通过长期监测和积累还能够为农业科研提供宝贵的数据支持,推动农业智能化、农业智慧化技术的不断发展和进步。

语义分割是计算机视觉领域的基本任务之一,可以广泛应用于各种场景。然而,高精度的语义分割网络模型具有参数多、计算成本高的特点。当需要将模型部署在计算能力受限的设备上时,就需要一种模型参数较少、计算成本较低且效率高的轻量化语义分割模型,旨在以有限的计算能力生成高质量的像素级分割结果[1]。Yang等[2]提出了一种高效的非对称扩展语义分割网络EADNet,该网络由多个不同尺度的非对称卷积分支组成,可以捕获多尺度多性状的图像信息,平均交并比(MIoU)为67.1%;Paszke等[3]针对需要低延迟任务提出了新的深度神经网络ENet,ENet减少了下采样次数并使用深度卷积来追求极其紧凑的框架,使得ENet在模型速度提升、参数减少的同时达到了与现有模型相当的精度;Romera等[4]提出了一种能够实时运行语义分割的结构,其核心层用残差连接并且分解卷积,以简单的结构实现了高精度;侯志强等[5]提出一种基于空间信息引导的双分支实时语义分割算法,该算法采用双分支结构分别获取特征的空间信息和语义信息,并设计了一种空间引导模块捕获特征的局部信息和上下文信息,弥补了图像高分辨率特征在降采样过程中的信息损失,该算法在Cityscapes和CamVid数据集上的平均交并比分别达77.4%和74.0%,FPS分别达49.1和124.5。

深度神经网络的研究推动多个领域的视觉识别任务取得成功,引起了越来越多学者对其在农业应用方面的关注。孙俊等[6]提出一种轻量级葡萄实时语义分割模型,该模型利用通道特征金字塔模块进行特征提取,采用池化卷积融合结构完成下采样并利用跳跃连接融合多种特征恢复图像细节;易诗等[7]提出了一种适用于红外图像的红外实时双边语义分割网络来保证夜间农田环境下红外图像语义分割的精度与实时性;肖利平等[8]针对农田监测区域大、监测节点能量有限及异常事件具有偶发性等特点,提出了一种基于改进压缩采样匹配追踪的农田信息异常事件检测算法,仿真试验证明该算法检测成功率提高了20%,且速度提升了50%。

农业问题给计算机视觉带来了新的挑战,如航空农田图像的语义分割需要对标注稀疏程度极高的超大图像进行推理,部分航测图像在计算能力和内存消耗方面给端到端分割带来了巨大的问题。此外,航空农田图像的语义分割与其他航空图像数据集上的典型语义分割任务相比具有更大的挑战性,例如要分割空中农田图像中的杂草模式,算法必须能够识别形状和覆盖范围截然不同的稀疏杂草集群。为了解决上述问题,本研究基于轻量级的UNet架构,通过改进训练方法和特征融合模块实现农田生长异常区域的快速分割。

1 模型与方法

1.1 模型架构

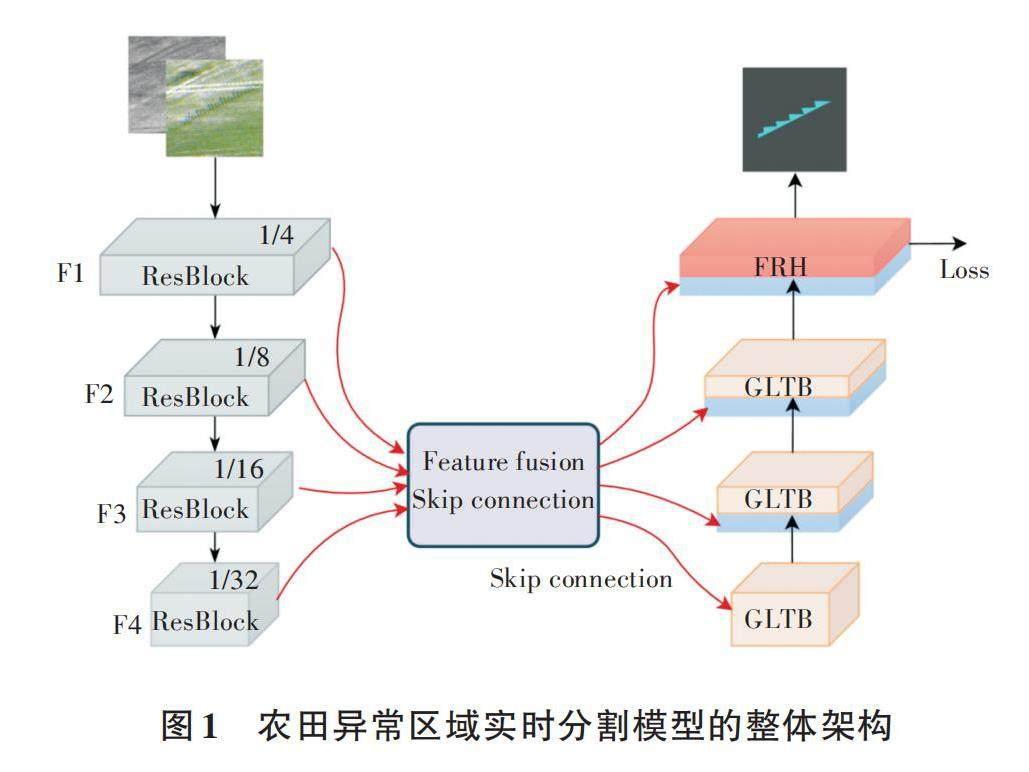

为了在较低性能的嵌入式设备上实现高效检测,本研究对UNet网络模型[9]进行结构改进和调整。相较于其他实时分割模型,UNet模型在图像处理速度和分割精度上都表现出显著优势。模型采用编码器-解码器模型架构,其中编码器的主干特征提取网络基于ResNet18。与通常UNet中参数较多的阶段式CNN特征提取网络不同,本研究将其固定为由4个ResBlocks(N=4)组成的结构。每个ResBlock中,特征图的高度和宽度减半,通道数量翻倍。编码器的4个输出(F1、F2、F3、F4)传递到特征融合模块,以进行进一步处理。在解码器部分,为了避免直接线性上采样模块无法充分利用编码过程中的特征细节,引入了基于Transformer的全局-局部注意力模块。这种设计能更好地捕获多光谱图像上的特征信息,从而实现更准确的分割结果。最终,本研究的模型不仅适用于嵌入式设备,而且在实时分割任务中表现出卓越性能。

在具体的特征矩阵处理过程中,编码器对输入图像(H×W×4)进行处理,生成具有形状[H2i+1×W2i+1×Ci]的分层多分辨率特征(H为图片高度,W为图片宽度,i为特征图层级,Ci为第i层特征图的通道数)。编码器的4个输出(F1、F2、F3、F4)通过特征融合跳跃连接模块进行进一步处理。特征融合跳跃连接模块内部包含3个上升融合模块和3个下降融合模块,用于处理相邻的特征图,输出具有与输入相同形状的特征图。在解码器中,模型采用3个全局-局部Transformer模块,同时获取全局和局部上下文信息,为在恢复特征图至原始大小的过程中提供更全面的信息。最后,使用具有通道注意力和空间注意力的细化头处理级联特征,以预测具有形状的分割图。在生成最终的分割图之前,模型需经过卷积层和上采样操作处理。图1为农田异常区域实时分割模型的整体架构。

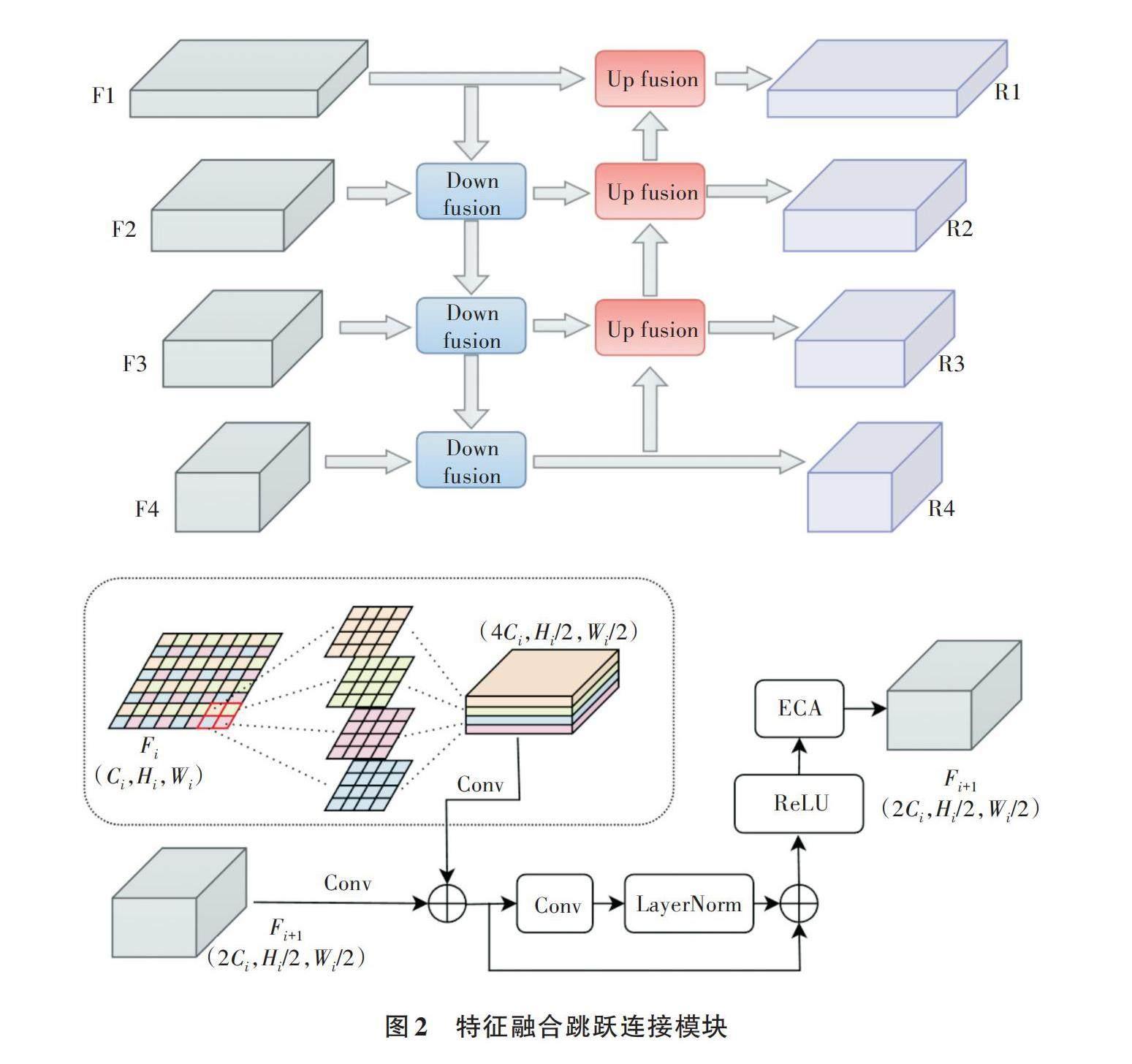

1.2 特征融合跳跃连接模块

农田无人机影像经过编码器生成特征图,其中来自浅层和深层的特征图在语义信息上有不同的侧重方向。本研究通过使用特征融合跳跃连接模块,将相邻编码器输出的特征图进行特征融合,并通过跳跃连接的方式输入解码器。该融合模块包括3次向下融合和向上融合,如图2所示。向下和向上融合模块分别处理2个相邻的跳跃连接特征映射并将它们融合在一起。整个融合过程分为2轮,每轮只在一个方向上相邻的2个特征图之间进行特征融合,可以是从顶部编码器层到底部编码器层或相反的方式。这一策略有效减少了编码器和解码器之间的语义鸿沟,同时能够捕获不同层次和感受野大小的特征,提供更丰富的多尺度信息。因此,特征融合跳跃连接模块能够有效整合深层和浅层的语义信息,通过拼接处理最大限度地减少下采样过程中的空间信息损失,同时避免了采用计算量较大的密集连接方式。

在模块内部,通过向下融合模块将相邻的浅层特征图与深层特征图进行融合,产生与深层特征图相同大小的特征图。在像素层面上,将Fi划分为4个子图,其高度和宽度为原始高度和宽度的50%。随后,在通道维度上堆叠这4个子图,将形状为(Ci,Hi,Wi)的特征图转换为(4Ci,Hi/2,Wi/2)。该设计的关键在于,与常见的池化操作不同,本研究在改变特征图大小的同时不丢失信息,同时保留了先前特征图的局部信息。原先空间相邻的4个像素现在仍然在通道上相邻,即将空间相邻转换为通道相邻。将Fi转换成形状为(2Ci,Hi/2,Wi/2)的特征图,其正好匹配Fi+1的形状。需要注意的是,每个组的卷积核大小为2×4×Kh×Kw(Kh为内核高度,Kw为内核宽度),确保卷积中涉及的通道像素正好是4个相邻像素,这样特征图的局部性仍然保留良好,且相较于普通卷积,计算成本大大降低。将2个特征图的形状调整一致,并通过加权的方式将它们融合成1个特征图。在上采样融合模块中,通过执行与下采样融合模块中重新组织特征图操作相反的步骤,将空间尺寸较小的特征图转换为较大尺寸,其余步骤基本相同。

1.3 基于Transformer的解码器

在农田的无人机影像中,经常出现天然形成的无规则形状的区域,这使得在进行区域分割时,缺乏全局语义信息的参与,很难实现精确的实时分割。为应对该挑战,本研究采用了3个全局-局部Transformer模块和1个特征细化头,构建轻量级特征解码头。通过这种分层和轻量级的设计,解码器能够在多个尺度上捕获全局和局部上下文信息,同时保持高效率。解码器的设计使得模型能够更好地理解农田影像中天然形成的无规则形状区域,通过全局-局部Transformer模块获取更全面的上下文信息,从而提高实时分割的精度。特征细化头进一步优化了分割结果,使模型在保持高效率的同时,更好地适应农田影像的复杂特征。整体而言,解码器设计有效克服了区域分割中缺乏全局语义信息的问题,提高了模型的准确性和鲁棒性。

解码器的设计基于UNetformer[10],融入了全局-局部注意力模块(GLTB)进行特征还原。本研究利用GLTB模块从解码器的深层特征图中获取较浅特征图的关键信息路径。GLTB包括全局-局部注意力、多层感知器、2个批规范化层及2个附加操作。Efficient global-local attention是一种由Wang等[10]提出的专为复杂城市场景语义分割而设计的注意力模块,其内部构建了全局和局部2个平行分支,分别捕捉全局和局部上下文信息。这种设计在特征融合中显著提高了模型性能。

作为相对较浅的结构,局部分支借助2个并行卷积层,其核大小分别为3×3和1×1,以有效提取局部上下文信息。在求和操作之前,本研究引入了2个批量归一化操作,以增强特征的稳定性。同时,全局分支采用了基于窗口的多头自注意力机制,旨在捕获全局上下文。该过程包括将特征图通过1×1卷积转换为1维序列,随后按窗口进行划分,形成注意力的Query(Q)、Key(K)和Value(V)[10]。局部分支由并行的1×1卷积和3×3卷积组成,旨在更全面提取局部特征。全局分支中提取的全局上下文和局部分支中的局部上下文通过深度卷积、批量归一化操作及标准的1×1卷积进行融合,以获取精准的全局-局部上下文。

1.4 自适应采样训练方法

在现实农田和数据集图像中,同时存在语义类别分布不平衡问题,例如播种漏缺区域被观察面积较小,其数量和量级与正常的耕地区域差别较大。在模型的训练过程中,本研究引用自适应采样训练的方法,在每次迭代训练时利用相关的类别分布和网络置信度自动选择训练样本的权重。数据采样器会动态选择图像,优先考虑类别出现频率较低且网络置信度最低的图像。实际上,每个类别的动态概率Dc 对c进行取样,计算公式如下。

[Dc=σ(1-dist×conf)γ] (1)

式中,c为样本类别;dist为类分布的数组;conf为实际的类网络置信度;σ为归一化函数;γ为松弛参数。一旦在给定该动态更新概率的情况下选择了语义类别c,就从包含该类别c的数据Xc的子集中随机挑选图像。

在数据预处理阶段中,考虑试验在一个有监督的环境下进行并要得到dist数组,本研究计算每个语义类[c∈C]的像素数量并在范围[0,1]进行归一化。在训练过程中计算每个类的网络置信度,并将结果存储在大小为|C|的数组中。然后,通过对属于此类别的像素求平均值,从可用的实况标签导出每个类别c的平均置信度值。最后,在步骤t-1中,实际网络置信度被计算为先验置信度的指数移动平均值,计算公式如下。

[conft=αconft-1+(1-α)conft] (2)

式中,t为当前迭代的步骤数;t-1为上一次迭代的步骤数;α为平滑因子。

2 数据集与方法

2.1 数据集

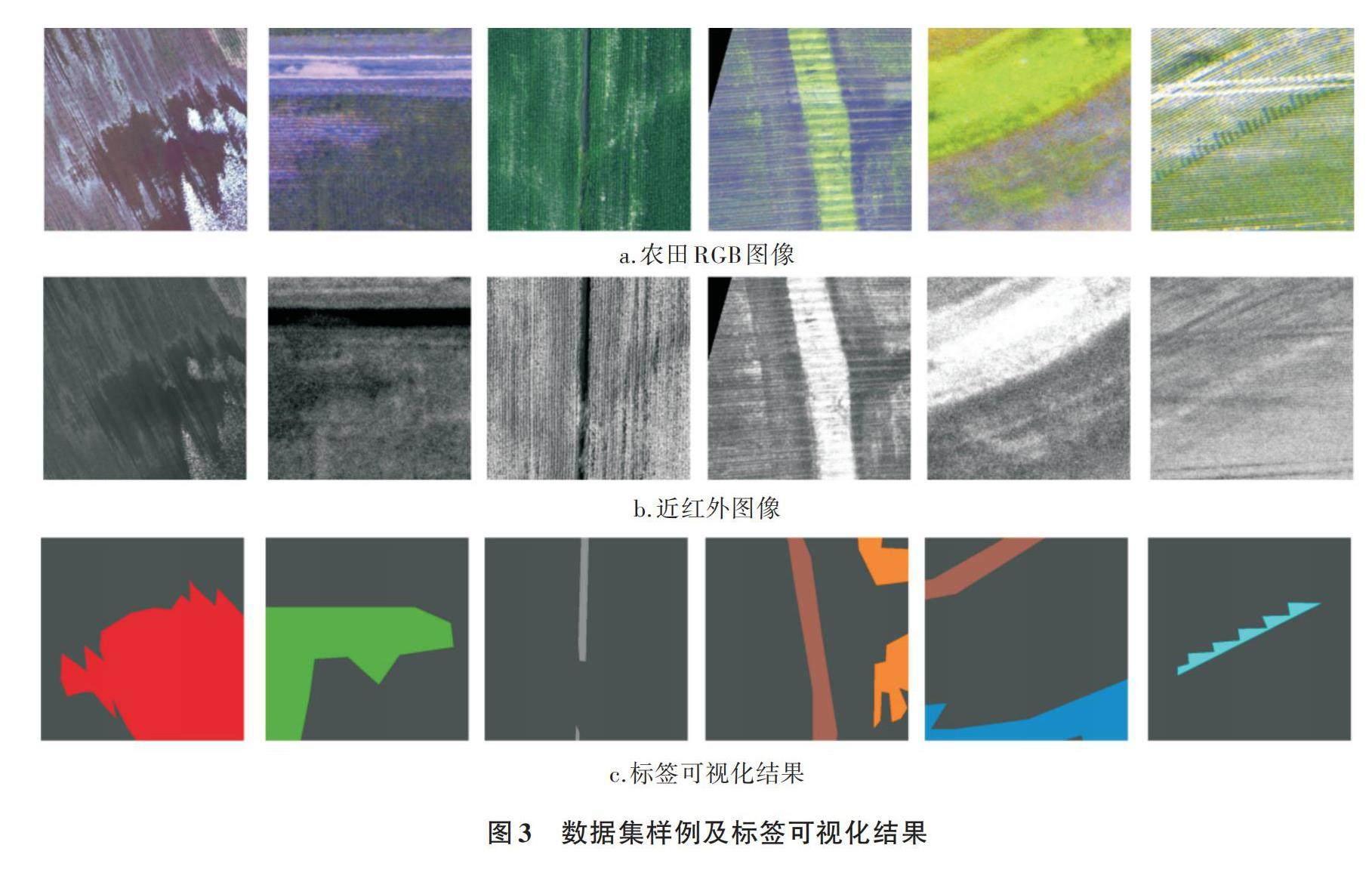

为确保试验的准确性,本研究使用大规模航空农田图像数据集 Agriculture-Vision 2021[11]。该数据集包含3 432张高质量、多波段的农田航空图像,每张图像的分辨率高达10 cm/px。这些农田图像是在2017—2019年拍摄,覆盖了多个生长季节,并涵盖了许多农业地区。每个区域的图像包括4个颜色通道:近红外(NIR)、红色、绿色和蓝色。使用专有的广域多光谱系统(WAMS)进行拍摄,该系统以10 cm/px的分辨率同时捕获4个通道。

试验中采用的田间区域标签类型包括背景(正常农田)、双株、干枯、养分缺乏、播种遗漏、积水区域、水道和杂草丛。从数据集中选择图像,其中包括10 675张训练集图片和4 235张验证集图片。随后,将采样图中每个类别区域的二值标签融合到同一张掩码图片中,以确保网络模型可以同时分割所有类别的区域。图3展示了数据集样例及标签可视化结果。

为了以直观方式可视化每个字段图像并为后续试验做准备,本研究将数据集中的4个通道分离为常规RGB图像和额外的单通道NIR图像,并将它们存储为2个512 px×512 px JPG图像。本研究舍弃了标签覆盖率超过90%的图像以确保所有图像都保留了足够的上下文信息。这样的处理方式有助于确保试验中保持足够的图像上下文,同时保持合理的图像尺寸,为后续分析提供可靠的信息。

2.2 训练细节

所有试验在Pytorch平台进行,采用NVIDIA 3090显卡,CPU型号为Intel(R) Xeon(R) Silver 4210R CPU @ 2.40 GHz,操作系统为Ubuntu 20.04。在数据集增强方面,本研究采用了范围为(1.0,2.0)的随机缩放,随机水平和垂直翻转,以及在训练过程中随机裁剪。对原始数据进行推断,无需进一步预处理,因为在进行农田航拍图像分割时所有模型主干网络都没有进行预训练。为了加快训练收敛速度,部署AdamW优化器训练所有模型,学习率设置为6 × 10-5,权重衰减为0.01。损失函数采用Dice损失函数[12]。

3 结果与分析

3.1 评价指标

图像分割评价指标采用平均交并比(MIoU)。平均交并比作为遥感图像语义分割的标准量度,表示模型计算预测得到的标准图像与人工标记的图像交集与并集之比,计算公式如下。

[MIoU=1k+1i=0kpiij=0kpij+j=0kpji-pii]

式中,k为总类别数;i、j分别为2种标签的类别;Pii为属于i类且预测正确的像素数量。当i为标签且i不等于j时,Pij和Pji分别为假正和假负。

3.2 对比试验

为了验证本试验提出的农田生长异常区域实时分割模型的效果,选取了遥感分割流行的UNet、DeepLabV3+[13]与SegFormer[14]3种网络模型进行对比分析。由表1可知,农田生长异常区域实时分割模型(以下简称本研究模型)的MIoU明显优于其他模型,相较于使用UNet作为基线的模型,虽然本研究模型的参数量略有增加,但农田分割效果明显提升,MIoU提高了4.16个百分点。与基于Transformer编码器的模型SegFormer相比,本研究模型的参数量基本相同,MIoU提高了2.50个百分点。

表2列出了各模型在每个区域类别的交并比(IoU)。在一些标签训练样本较少的情况下,DeepLabV3+在双株和水道类别中网络分割能力较差。SegFormer在不同类别中差异较大,在播种遗漏类别中表现突出,但在双株类别中表现较差。通过采用自适应采样训练方法,本研究模型成功避免了在任何特定类别上出现明显差异的结果,确保在每个类别上都能取得出色的分割效果。

4 小结

通过对多光谱农田航拍数据集进行深入分析,本研究对UNet进行了改进,实现了对农田异常区域的自动化识别。相较于UNet、DeepLabV3+和SegFormer网络模型,本研究模型表现出色,平均交并比为41.24%。改进方面主要包括对多光谱数据的优化预处理和引入深度学习技术。试验结果清晰展示了模型在准确性和实时性方面的优势。然而,仍需在特定天气条件和数据集多样性方面进行优化。总体而言,本研究提出的基于多光谱航空图像的农田异常区域实时分割模型在农业监测领域具有应用潜力,可为提升农田管理的科学性和智能性提供有效的手段。

参考文献:

[1] 李鹏辉. 基于深度卷积神经网络的语义分割算法研究[D].兰州:西北师范大学,2021.

[2] YANG Q, CHEN T, FAN J, et al. Eadnet: Efficient asymmetric dilated network for semantic segmentation[A]. ICASSP 2021—2021 ieee international conference on acoustics, speech and signal processing[C]. Toronto,Canada:IEEE, 2021. 2315-2319.

[3] PASZKE A, CHAURASIA A, KIM S, et al. ENet: A deep neural network architecture for real-time semantic segmentation[J/OL].Computer vision and pattern recognition. https://doi.org/10.48550/arXiv.1802.02611.

[4] ROMERA E, ALVAREZ J M, LUIS M. BERGAS A, et al. Erfnet: Efficient residual factorized convnet for real-time semantic segmentation[J]. IEEE transactions on intelligent transportation systems, 2017, 19(1): 263-272.

[5] 侯志强,戴 楠,程敏捷,等.空间信息引导的双分支实时语义分割算法[J/OL].北京航空航天大学学报,2024.http://kns.cnki.net/kcms/detail/11.2625.V.20230630.1810.012.html.

[6] 孙 俊,宫东见,姚坤杉,等.基于通道特征金字塔的田间葡萄实时语义分割方法[J].农业工程学报,2022,38(17):150-157.

[7] 易 诗,李俊杰,贾 勇.基于红外热成像的夜间农田实时语义分割[J].农业工程学报,2020,36(18):174-180.

[8] 肖利平,全腊珍,余 波,等.基于改进CoSaMP的农田信息异常事件检测算法[J].农业机械学报,2019,50(10):230-235.

[9] RONNEBERGER O, FISCHER P, BROX T. U-Net: Convolutional networks for biomedical image segmentation[A].Medical image computing and computer-assisted intervention-MICCAI 2015:18th international conference[C].Munich, Germany:Springer international publishing, 2015.234-241.

[10] WANG L B, LI R, ZHANG C E, et al. UNetFormer: A UNet-like transformer for efficient semantic segmentation of remote sensing urban scene imagery[J]. Journal of photogrammetry and remote sensing,2022,190: 196-214.

[11] CHIU M T, XU X Q, WEI Y C, et al. Agriculture-vision: A large aerial image database for agricultural pattern analysis[A]. Proceedings of the IEEE/CVF conference on computer vision and pattern recognition[C]. Seattle,USA:IEEE,2020.2828-2838.

[12] ZHAO R J,QIAN B Y,ZHANG X L, et al. Rethinking dice loss for medical image segmentation[A]. 2020 IEEE international conference on data mining[C]. Sorrento,Italy:IEEE, 2020.851-860.

[13] CHEN L CH, ZHU Y K, PAPANDREOU G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation[A]. Proceedings of the European conference on computer vision (ECCV)[C]. Munich,Germany:Springer,2018.801-818.

[14] XIE E, WANG W H, YU Z D, et al. SegFormer: Simple and efficient design for semantic segmentation with transformers[J]. Advances in neural information processing systems,2021,34: 12077-12090.