大语言模型的会计垂域推理能力探究

钟慧 陈宋生 王明

【摘要】大语言模型(Large Language Models, LLMs)目前正在重塑各行各业的学习方式、 思维模式和研究范式。如何使 LLMs 与行业结合、 重构 LLMs 与行业的关系, 是推动企业数字化变革和社会发展的重要命题。要实现LLMs在垂域发挥重要作用, 最重要的是提升LLMs的推理能力。本文以如何提升LLMs在会计领域的推理能力为起点, 提出会计垂域推理能力的概念、 研究路径、 评测标准, 分析中文开源模型清华智谱的GLM 系列的评测结果, 为后续的推理研究提供标准范式, 并为如何提升会计推理能力提供评价标准, 力图推动LLMs在会计领域达到应有水平。同时, 为验证LLMs的会计推理能力, 本文比较了GLM-6B、 GLM-130B、 GLM-4 在算术推理能力和会计常识推理能力方面的差别, 并将 OPENAI 的 GPT-4作为基准进行分析。结果表明, 在不同推理提示工程下, 模型规模显著影响推理能力, 虽然各种模型算术推理能力已经得到极大的提高, 但是会计推理能力还远不能达到应用水平, 需要在应用中逐层优化, 研究为LLMs会计垂域进入应用实践的优化过程提供参考。

【关键词】大语言模式;垂域模型;推理能力;提示词工程;会计推理能力;基准数据集

【中图分类号】 TP18;F231 【文献标识码】A 【文章编号】1004-0994(2024)11-0017-9

一、 引言

随着人工智能领域的发展, 人工智能技术[例如大数据、 超级计算、 脑传感、 大语言模型(Large Language Models,LLMs)等特别是通用自然语言模型, 越来越受到理论界与业界的关注, 他们期望利用人工智能技术驱动社会走向智能化。人工智能俨然已经成为新一代科技创新和产业变革的核心驱动力、 国家和社会创新发展的核心动力、 产业转型发展的核心支撑力, 以及提升国家竞争力、 维护国家安全的重要内容。2017年7月, 国务院印发《新一代人工智能发展规划的通知》, 将人工智能作为一项重要发展目标, 力图构筑我国在人工智能领域的先发优势, 推动人工智能的跨学科探索性研究, 将人工智能与数学、 神经科学、 量子科学、 社会学、 经济学等交叉融合, 推动关键技术的跨领域运用, 服务于社会各个领域。2023年7月, 国家网信办等七部门联合公布《生成式人工智能服务管理暂行办法》, 鼓励生成式人工智能技术在各行业、 各领域的创新应用, 鼓励生成式人工智能算法、 框架、 芯片及配套软件平台等基础技术的自主创新。

在人工智能与LLMs的浪潮下, LLMs技术更新迭代, 模型能力不断加强, 逐渐形成从底层算力、 模型开发到行业深度应用的全新智能产业。随着通用LLMs在垂域的发展, 如何使通用LLMs从基础能力下沉到行业纵深领域的具体应用、 释放企业数字化转型潜力, 已成为LLMs技术未来发展的重要方向。相较于模型垂域应用, 通用LLMs在数据、 算力、 规模等方面具有较大的优势。但从实用性和可实现性视角看, 垂域应用有着不可比拟的优势, 如: 具有更丰富的纵深领域知识, 其通过提示词工程和微调等训练方式, 专注于特定的下游任务, 能够以较低的成本实现高效率运行, 推动LLMs在业务中的具体落地。垂域LLMs在教育、 金融、 医学、 法律、 数学等方面进行了初步探索(Li等,2023;Zhang等,2023;Wang等,2023;Yang等,2023), 但目前在会计领域, 未发现训练有效的垂域LLMs, 也没有LLMs的垂域应用, 且尚不存在一个公认且有效的测试数据集。研究由此出发。

现有 LLMs与会计结合的实践应用中, 通常采用两种方式。第一种是直接使用计算机的思路与框架, 只是把数据换成会计相关语料(Liu等,2023), 这种应用没有针对性, 缺乏会计专业视角。第二种是会计人员对 LLMs的应用场景进行设计应用(Tong等,2024), 由于把通用 LLMs 直接嫁接到使用场景, 缺乏对 LLMs 的原理分析, 无法进行专业优化。这两种方式都是基于LLMs通用能力进行的, 并未考虑会计领域的特殊性。会计领域涉及众多数学推导、 判断和模型公式等, 相对于LLMs 的自然语言生成(Natural Langnage Generation,NLG)和自然语言理解(Natural Langnage Understanding,NLU)能力, LLMs在会计领域的应用应当更偏重LLMs的推理能力(Reasoning)。因此, 现阶段LLMs在会计领域的应用, 应将会计专业理解与LLMs 的应用原理相结合, 制作可以评测LLMs会计专业能力的数据集, 且分析测评结果, 为后续优化指明方向。

本文可能的贡献在于: 第一, 拓展了通用LLMs在会计领域的垂直应用研究。本文梳理了LLMs在逻辑推理、 数学推理、 常识推理、 抽象推理等方面的技术现状, 分析了这些能力与会计推理的关联, 为后续研究奠定了基础。第二, 弥补了会计评测领域数据集缺失的空白。本文构建了一个覆盖全面、 多样化的会计常识推理基准测试集, 区别于已有财经领域数据集, 本测试集聚焦会计循环、 财务报表、 会计分录等核心主题, 严格控制题目质量, 全面评估LLMs的会计领域推理能力。第三, 选取了GPT-4、 GLM 等代表性LLMs在自构建测试集上进行评测, 并分析其表现。这一结果对于理解LLMs在会计领域的适用性具有重要参考价值。第四, 探讨融合了领域知识、 优化推理策略等提升LLMs会计推理能力的路径, 为后续研究指明了方向, 有望推动LLMs与会计专业知识的深度融合, 加速智能化会计实践的落地。

二、 文献综述

(一)LLMs 在会计垂域的发展

通用LLMs在垂直领域的发展在医学和法律领域已崭露头角, 这为其在会计领域垂域应用的建设提供了借鉴。LLMs在医学领域的成功应用(Panagoulias等,2024)集中在医疗图像诊断方面, 因为图像有极强的自然科学客观规律性, 可以被AI识别, 并利用LLMs诊断的自然语言输出, 提高AI应用的可解释性, 使其在医学上的应用比在其他行业有更好的前景。在法律领域的应用上(Chalkidis,2023), LLMs难以达到应用级别, 原因是法律环境是一个人类环境, 影响因素不稳定, AI对这种人为规律的识别能力较弱, 且法律的解释权威性是不能假借予LLMs的。会计领域介于医学和法律之间, 既有相对客观的经济规律和稳定的会计准则, 又面临复杂多变的人类环境, LLMs需要具备更强的能力, 不同于医学图像诊断的记忆, 它们需要像人类一样解释因果关系, 并具备举一反三的逻辑推理能力。会计领域非常注重LLMs的推理能力, 尤其是计算推理和会计常识推理能力。本文探讨了推理能力的关键性, 旨在突破现有会计应用的局限性。现有研究不足主要有:

1. 单纯研究推理能力的提升。这种研究致力于提升LLMs的某一项或几项推理能力(Huang和Chang,2022), 但是没有具体涉足会计常识推理能力, 而其整体提升的常识推理能力混进各种专业知识, 并且提升的推理能力只能达到50% ~ 80%的准确度(Li等,2023), 不能保证会计推理达到理想状态。此外, 尚未发现专门针对会计推理能力的文献。

2. 只关心粗放型的语料基础的预训练垂域研究。BloombergGPT(Wu等,2023)、 FinGPT(Liu等,2023)等通过训练语料的专业化和参数规模增大这种万能方式来解决一切LLMs的能力提升问题, 但是这种方法依靠的是没有规律的涌现能力, 尚未知其产生机理(Zhao等,2023)。

3. 任务式的LLMs微调研究。这类研究利用微调的方式提升情感分析任务的准确性(Fatouros等,2023)、 回答金融会计知识的准确性(Theuma和Shareghi,2024)、 金融会计文本分类的准确性(Shah等,2023)等, 这些都是自然语言本来就有的任务, 只是语料变成与金融会计相关, 没有针对会计特有的任务特征——需要计算、 需要会计专业方能理解。

4. 概述式的研究。廖高可和李庭辉(2023)、 欧阳日辉和刘昱宏(2024)调研已有会计领域LLMs的研究情况与应用现状后发现, 尚未形成会计领域LLMs的研究方法与范式, 更未涉及会计推理概念与能力提升的具体方案。

综上, 已有会计垂域研究最大的问题是套用自然语言处理的研究方法, 研究会计文档分类、 问答、 情感分析任务的完成能力, 而未抓住会计专业方向的重点能力——会计推理能力。这种套用掩盖了LLMs的真实垂域能力。复旦大学的金融 DISC-FinLLM 的研究(Chen等,2023)按照自然语言的任务能力提升方式, 试图大量使用金融相关语料微调提升金融能力, 但是效果甚微。原因主要是在提升能力之前, 未充分评测LLMs在专业领域缺失的具体能力, 继而针对此能力进行后续提升方法研究。

(二)LLMs会计垂域推理能力

在 LLMs研究理论中, 模仿人的逻辑形式完成具体的事情, 简称推理(Huang和Chang,2022;Yu等,2023)。逻辑推理评测通常由LLMs回答推理问题的准确性来衡量。按照现行LLMs推理能力分类, 可将其划分为四种推理能力: 逻辑推理、 数学和计算推理、 常识推理、 抽象推理(Sun等,2023;Huang和Chang,2022)。这四类推理能力在会计领域的应用至关重要, 每一个具体的会计应用场景都涉及不同的推理能力。会计领域大量依赖应用逻辑和数学计算能力, 意味着训练出缜密的推理能力是LLMs应用于会计领域的关键。

逻辑推理能力指的是模型基于特定的事实与命题, 依据规则推导出其他命题的能力, 主要包括自然语言推理与论证推理。自然语言推理主要是判断两个句子之间的逻辑关系, 例如蕴含、 矛盾或是否相关等, 根据句子语意去判断真实表达意图。自然语言推理能力在会计领域发挥着重要作用, 例如它能够分析财务报告中的叙述, 判断管理层讨论与财务数据之间是否存在逻辑的一致性(是否言行一致)等。论证推理则是评估论证的有效性和结构, 主要是识别论据和结论。论证推理在财务领域的应用体现在投资报告或市场分析方面, 用以评估其论证的合理性和市场走向预测是否基于有效论据。

数学和计算推理(Cobbe等,2021)主要是指LLMs解决数学运算、 逻辑推导以及运用计算机技术解决问题的能力, 包括算术问题求解、 几何问题求解、 数学证明等。算术求解主要是基于文本描述解决数学问题, 例如从财务报表的叙述中自动提取和计算关键财务指标(利润率、 增长率等), 以便快速分析推断出公司的财务健康状况; 几何问题求解是理解与解决结合图形和文本描述的几何问题, 具体可应用于行业估值中, 例如在评估商业地产价值时, 通过分析其形状、 大小和位置信息(结合地理信息系统GIS数据), 计算出潜在的商业利用价值; 数学证明是生成或验证数学证明的逻辑过程, 在会计领域能够实现复杂财务模型的验证和模型的预测, 确保其在逻辑和数学上的正确性。

常识推理(Talmor等,2022)是基于常识和经验的思维方式, 对事件发展的逻辑进行归纳总结, 得出合理判断的能力。常识推理包括事件和因果推理、 常识问答等。事件和因果推理是指LLMs理解文本中事件之间的因果关系和顺序, 在会计领域的表现也较为多样化, 能够分析市场事件如并购、 政策变更等对公司财务状况的影响; 常识问答主要就是使用常识知识回答问题, LLMs需要懂得会计领域的专有名词、 行业准则等基本常识性问题, 能够回答有关财会相关知识, 辅助会计决策。

抽象推理(Hu等,2023)主要是指从抽象的概念出发, 得出普适性规律和认识的推理过程, 主要包括模式识别和分类、 类比和类比推理。模式识别和分类, 顾名思义就是识别分类抽象模式和概念, 在大量数据中识别出异常数据, 适用于公司风险管理与欺诈检测; 类比和类比推理是在不同概念、 对象或情景之间的类比, 比较不同时点或不同事件的相同特征, 寻找其中的相似性与差异性。

上述计算机推理研究结合会计理论和会计推理教育定义会计推理(Accounting Reasoning), 这是一个涉及财务和会计信息解读、 分析与判断的过程, 它依赖于对财务数据的理解、 评估和应用, 以做出合理的经济决策。这种推理过程包括识别和分析会计信息的能力、 解释财务报表中的数据, 以及将这些信息用于预测、 评估和制定策略。

(三)数据集评测基准

在自然语言处理(Natural Language Processing,NLP)发展初期, 通用LLMs的评测主要是使用简单基准测试, 评估集中于语法与词汇等, 包括句法分析、 词义消歧等任务。随着深度学习的出现, NLP拥有更加广泛的基准, SNLI(Bowman等,2015)和SQuAD(Rajpurkar等,2016)这些基准测试不仅能够评估模型的系统性能, 而且可以提供足够的训练数据, 以便于评估特定任务的准确性。随后, 大规模预训练语言模型的崛起, 例如BERT模型(Devlinet等,2019), 使得LLMs的测评方法逐渐演变为适应这些新型通用模型的性能评估方法。如今越来越多的开源基准数据集用于评测LLMs对各项任务的应对与挑战, 这些测试基准包括但不限于GLUE(Wang等,2018)、 SuperGLUE(Wang等,2019)和 BIG-Bench(Srivastava等,2022)。随着语言模型规模的不断扩大, LLMs在零次学习和少量学习的设置下都表现出显著的改进, 可以与微调的预训练模型相媲美。这一转变促成了评估领域的转变, 标志着从传统以任务为中心的基准转向关注以能力为中心的评估。随着这一趋势的发展, 设计用于知识、 推理和各种其他能力的评估基准的范围已经扩大。这些基准的特点是放弃训练数据, 并制定总体目标, 即在零次学习(Zero-shot)和少次学习(Few-shot)设置下全面评估模型的能力(Zhong等,2023;Zhang等,2023;Li等,2023)。

相比于通用LLMs, 垂直领域应用以其实用性及可实现性等优势, 备受学术界和业界的关注。它具有更丰富的纵深领域知识, 能够回答更加专业的问题, 推动LLMs在业务中的具体落地。它专注于特定的下游任务, 通用LLMs的测试基准已不完全适用于LLMs的垂域应用评测, 故需要引入一系列专门的基准测试评估 LLMs在特定领域和应用程序中的能力(Chang等,2023)。对于专业领域评测基准, CMMLU、 GAOKAO Benchmark、 MATH、 APPS、 CUAD、 CMB、 CFBenchmark 等任务与数据集已在中文、 教育、 数学、 计算机、 法律、 中医、 金融等专业领域建立起基准测试(Li等,2023;Zhang等,2023;Wang等,2023;Yang等,2023), 这些专业领域的基准能够很好地评测模型在专有领域的能力, 也能够通过基准数据集的建立构建其专有领域的垂直模型。

对于评测基准而言, LLMs的评测数据集涉及多个方面多项任务(例如 CLUE 中文理解评估基准有九项自然语言理解任务), 但内容大多较为宽泛, 给出的答案往往是大众化、 普适化的内容。通用模型强调的是全方位、 多层次的应对能力, 它对各个专业层次都有应对能力, 但应对复杂情况的处理能力较弱。对于LLMs的垂域评测方式, 以 DISC-FinLLM(Chen等,2023)模型为例, 该模型作为基于多个专家微调的财务金融LLMs, 通过微调形成垂直运用能力, 其主要评估方法包括四个组成部分: 财务NLP任务、 人员测试、 数据分析和实时分析。为评估这四部分能力, DISC-FinLLM模型通过爬虫、 开源数据集等完成其财务NLP任务、 实时分析任务, 通过自建数据集方式实现数据分析任务(Wang等,2023)。同样的, BloombergGPT(Wu等,2023)在金融领域特定任务和通用任务两方面对模型进行整体评估。对于金融领域特定任务的评估, 数据是来源于开源数据集与彭博社专有的内部数据集; 对于通用任务的评估, 通过对BIG-Benchmark等基准数据集的提取与评估得出最终结果, 评估数据集来自HELM、 SuperGLUE、 MMLU和GPT-3等开源的评估基准(Lu等,2023)。

对于模型垂域评测来说, 通用LLMs的评测基准仍适用。LLMs垂域应用需要一定的通用能力, 但对于专业纵深能力来讲, 需要建设自有数据集来进行训练。对于LLMs的垂域建设, 各个专业领域已有布局和建设。以LLMs的会计垂域为例, LLMs垂域评测基准存在一些不足之处: 一是LLMs并无一个固定的会计垂域测评基准, 大多是自建基准或自建数据集, 这在一定程度上降低了垂域评测的可信度; 二是相较于通用LLMs, LLMs在会计垂域处理长文本内容的性能上存在差异, 它们的性能随着上下文长度的增加而显著恶化(Bai等,2023); 三是模型的规模与模型精度之间存在正相关关系, 垂域应用要确保精度, 必须使用高质量数据(Liu等,2023;Li等,2023), 通用模型测评基准不能完全有效评估模型垂域能力。

LLMs向垂直领域迁移的趋势日趋明显, 如何在尽可能保留模型通用能力的同时提高模型在垂直领域的能力一直是热门话题。会计领域垂域应用的建立, 不仅需要进行逻辑探索、 模型的微调与提示, 还需要一个客观的评测基准, 如果缺失评测基准, 垂域能力则会失去说服力。因此, 需要建立客观的数据集测评已有或未来的新模型的会计能力。通过模型的评测得分判断垂域LLMs是否能够应用于实际会计场景, 为后续模型的优化提供借鉴。

三、 实验设计与结果

(一)实验设计

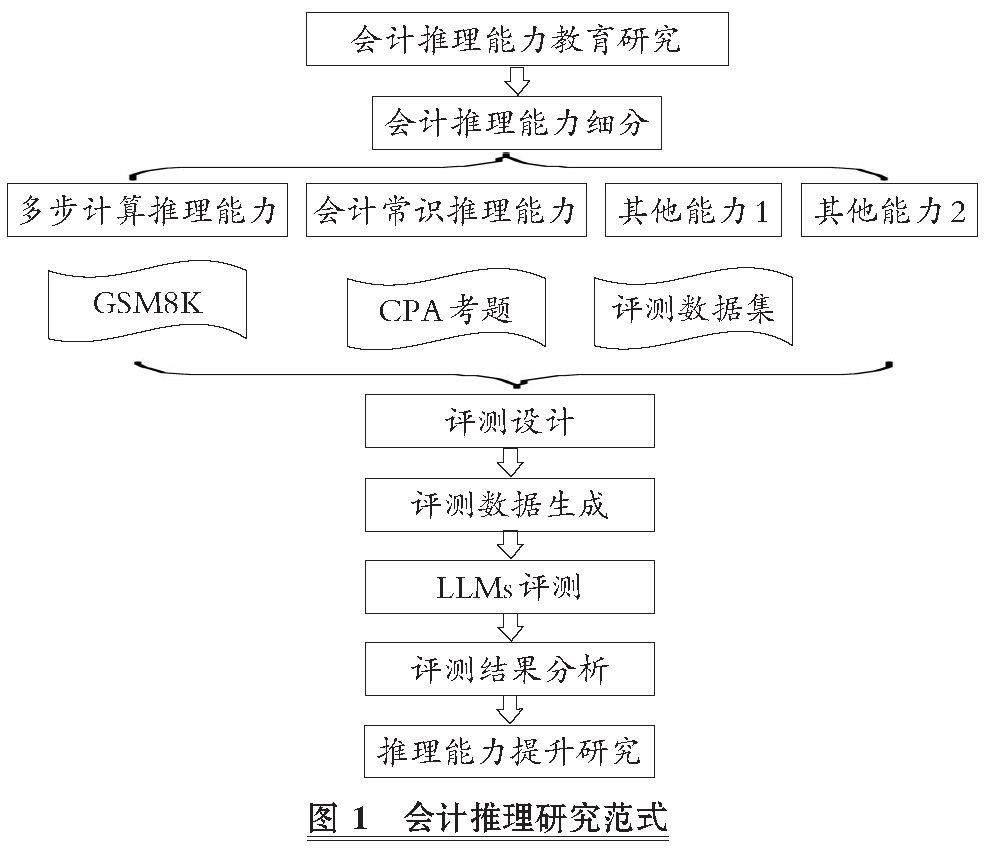

本文创新了LLMs会计推理能力研究范式(见图1)。首先根据会计教育内容与推理定义理论, 抽象出细分会计推理能力; 然后对每一种细分能力进行评测设计, 包括细分能力的评测方法、 评测可参考的数据集、 评测体系设计; 接着根据评测设计生成测评数据集; 最后进行测评并生成测评结果分析, 根据测评结果提出提升评测能力的方法。

借鉴会计教育方法, 把LLMs当成一个已经有一定会计基础的学生进行专业教育, 首先需要评测LLMs的会计水平, 定位其缺失的会计内容, 比如折旧方法使用不当、 经营现金流组成部分理解错误、 计算错误等, 再根据错误的内容进行处理。在处理过程中, 如果需要数据进行微调或者上下文提示工程设计, 则要根据具体错误内容生成相关性大数据。斯坦福大学陈丹琦团队的研究表明, 使用精选过的5%数据比原来100%数据微调模型能产生更佳的效果(Xia等,2024), 精选过的数据集能够使用高度与提升能力相关的数据, 精准地优化LLMs的会计推理能力。因此, 会计推理能力研究的第一步是准确评测出LLMs会计推理能力的具体缺陷。这需要会计教育分析归类, 把会计推理能力细分, 然后再进行评测方法研究。

为了不与计算机通用推理能力重合, 可以对跨级推理能力进行分类: 多步计算推理能力、 会计常识推理能力、 会计模式识别能力、 会计类比能力。其中, 多步计算推理是为了迎合会计分析中经常出现复杂连贯的计算, 会计常识推理能力包括各种会计概念理解、 方法选取、 方法使用能力。对于这两种能力, 几乎在一切会计问题上都需要LLMs具备较高的水平。而会计模式识别和会计类比能力在特定场合, 比如预测、 发现规律、 比较分析中会有特殊使用。因此, 多步计算推理能力和会计常识推理能力是基础会计推理能力, 而其他能力是适用于不同应用场合的特殊会计推理能力。本文以基础会计推理能力的评测为主。

在评价LLMs的推理能力时, 常用准确性来衡量。在会计和审计领域, 对推理能力的衡量除准确性外, 还需要推理过程具有可解释性, 便于人类理解复杂过程得出的结果是否符合经济原理或者人类目标。到目前为止, 尚未有LLMs在各项推理任务中都能达到100%的准确率, 但是部分已经达到人类水平。提高各种LLMs在各种推理任务中的完成准确率, 是目前推理研究的目标, 也是会计垂域LLMs真正应用于实践的关键, 但甚少学者研究推理过程的可解释性。因此, 本文设计一个推理过程, 让LLMs在利用财务常识计算推理解决问题时, 提供一个可解释的过程, 并提高计算准确性。

(二)多步计算推理能力评测标准

已有许多评测基准(Benchmarks)用以评测LLMs的通用推理能力[如表1所列(Srivastava等,2022;Yu等,2023;Chang等,2023)], 这些评测基准一般是自然语言推理任务使用的公共数据集, 数据集中是测试某种推理能力的题目, 并且附有答案, 用来快速检测LLMs在回答这些题目时的准确率, 包括逻辑推理、 常识推理、 数学推理等, 通过在不同类型的推理任务上测试模型来评估其推理能力。评测中文会计推理能力, 需要中文领域的评测基准, 特别是评测会计常识推理能力时, 如果使用外文的评测基准会使得评测错误率由于翻译错误的存在而被高估。多步计算推理能力由于题目语言表达比较简单, 翻译错误率极低, 可以以数学和计算推理中的评测基准作为参考, 生成新的评测标准。

在计算推理基准数据集中, 最适合评测会计多步计算推理能力的数据集是GSM8K(Cobbe等,2021), 它是一个包含8.5K个高质量、 语言多样性的小学数学文字题目的数据集。该数据集旨在支持需要多步推理的基础数学问题的问答任务。这些问题需要2 ~ 8步解决, 解决方案主要为使用基本算术运算(+、-、×、÷)执行一系列基本计算, 以得出最终答案。一位聪明的中学生应该能够解决每个问题。问题不需要超出早期代数水平, 绝大多数问题可以在不明确定义变量的情况下解决。以自然语言提供解决方案, 而不是纯数学表达式, 是最普遍有用的数据格式。香港中文大学对GSM8K进行改进, 生成的 MR-GSM8K(Zeng等,2024)挑选原数据集中的应用题部分, 把题目分成顺向和逆向两类, 逆向是需要通过设未知数解方程的题目, 顺向是按照思路计算即可得到最终答案的题目。在会计知识中, 排除模型分析计算, 大多数计算处于小学数学水平, 涉及日期计算、 多步串联计算时需要确保LLMs可以记住前面的计算结果, 以将其使用于后续步骤。因此, MR-GSM8K 的顺向题目非常适合会计多步计算推理能力评测。MR-GSM8K是目前最常用的计算逻辑测试数据集, 在多种LLMs评测中被列为首选评测基准, 多年的测试经验证明了其测试计算逻辑的可靠性。过滤掉MR-GSM8K中的逆向题, 再把答案字数少于 300字的题目也过滤掉, 剩下的题目就是分析步骤比较长(3步以上)且计算形式与一般会计计算相近的题目。最终, 剩下586条长计算步骤的MR-GSM8K题目, 其可以作为会计多步计算推理能力的基准数据集, 称为Multi-Calculation-Benchmark。以下是会计多步计算推理能力基准数据集中的例子:

题目: 杰西卡正试图计算她每个月需要支付的所有债务总额。她的学生贷款最低还款额为每月300美元, 信用卡的最低还款额为每月200美元, 而她的按揭贷款最低还款额为每月500美元。如果杰西卡想支付比最低额度多 50% 的金额, 她一年内需要支付多少钱?

(三)中文会计常识推理能力评测标准

中文会计常识推理评测基准有两部分来源: 一是从英文评测基准翻译而来; 二是通过原生中文会计常识推理任务标注或者爬取取得。相比于多步计算推理能力的评测, 中文会计常识推理能力有显著的区域差异, 国内外使用的会计准则的差异, 导致国外的会计评测基准不能被直接使用, 而一般的原生评测基准是从通用常识推理 基准数据集中筛选出会计相关的数据作为评测基准。中文语言理解评测基准CLUE(Chinese Language Understanding Evaluation)(Xu等,2020)是一个面向中文的类似于GLUE(General Language Undersanding Evaluation)(Wang等,2018)的语言理解基准, 它旨在评估和提高中文自然语言处理模型的性能。CLUE包括一系列不同的任务, 如文本分类、 阅读理解和命名实体识别、 推理任务等, 这些任务涵盖语言理解的各个方面。通过这些任务, CLUE能够全面评估中文处理模型能力, 并推动中文自然语言处理技术的发展。而由 CLUE 衍生出的推理数据集有以下几种:

第一, CMNLI 自然语言推理数据集。该数据集内容来自fiction、 telephone、 travel、 government、 slate等, 通过对原始英文MNLI 和XNLI数据翻译得到。该数据集可用于判断给定的两个句子之间是属于蕴涵、 中立还是矛盾关系。数据集例子如下:

题目: 在这项任务中, 给你一对句。你的工作是选择这两个句子是否明确一致(蕴含)/不一致(矛盾), 或者是否无法确定(中立)。你的答案必须是数字 0(蕴含)、 1(中性)或 2(矛盾)的形式。句子 1: 是的, 我告诉你, 虽然如果你去给那些网球鞋定价, 我明白为什么你现在知道它们的价格在 100 美元的范围内了。句子 2: 网球鞋有一系列的价格。

第二, OCNLI 中文原版自然语言推理数据集。原生中文自然语言推理数据集 OCNLI是第一个非翻译的、 使用原生汉语的大型中文自然语言推理数据集, 与CMNLI 具有相似的推理任务, 数据集例子如下:

题目: 在这项任务中, 给你一对句。你的工作是选择这两个句子是否明确一致(蕴含)/不一致(矛盾), 或者是否无法确定(中立)。你的答案必须是数字 0(蕴含)、 1(中性)或 2(矛盾)的形式。句子 1: 因为营业额上升了、 看来, 扩销的目标有可能实现。句子 2: 营业额上升了。

第三, 蚂蚁金融语义相似度数据集(AFQMC)。AFQMC数据集与 OCNLI 一样, 这些基准数据集提取出来的会计数据集可以评测出LLMs对语言表达相似度的推理能力, 确定LLMs对语言结构、 词汇通用概念的理解。大规模中文金融领域语料库BBT-FinCorpus(Lu等,2023)、 CFBenchmark(Lei等,2023)这两个金融专业数据集注重一般自然语言任务, 如实体命名识别和分类等, 没有结合会计的专业分析推理, 不能评测LLMs对会计专业概念的理解、 方法的使用能力。DISC-FinLLM 的语料(Chen等,2023)虽然涉及会计分析推理, 但是只涉及少数概念识别, 极少有方法评测。FinEval(Zhang等,2023)是一个真正意义上评测会计常识推理能力的基准数据集, 在会计常识上只有120道题目数据, 并没有系统覆盖会计学科理论上的大部分章节, 计算题只占1/4不到, 大部分是简单的概念识别, 不涉及会计分析方法。数据例子如下:

题目: 哪个选项符合债务重组准则的会计处理要求。

A. 债务重组中涉及的债权、 重组债权、 债务、 重组债务和其他金融工具的确认、 计量

B. 通过债务重组形成企业合并

C. 债权人与债务人在债务重组前后均受同一方或相同的多方最终控制, 且该债务重组的交易实质是债权人或债务人进行了权益性分配或接受了权益性投入

D.以存货清偿债务

计算题可以很好地评测出LLMs对会计概念的理解以及方法的使用是否已经达到类人类理解的阶段, 而不仅仅是记忆体能力。全面覆盖会计知识点才能评测LLMs的会计常识推理能力的问题所在。因此, 以上评测基准并不能很好评测LLMs的专业会计能力, 并找出其问题。比较好的评测方法是使用会计考试题作为评测标准, 其可以满足知识点覆盖问题, 以及评测LLMs对概念、 方法的理解。使用入学考试或者学校专业考试(Cheng等,2023)的题目虽然可以从非常基础的会计知识变化到更高级的知识, 但是它们不一定直接与成为一名执业会计师所需的知识相关联, 不能评测LLMs的实践能力。

本文通过使用专业认证考试题目来评测 LLMs 的会计常识推理能力。个人在某一专业认证考试的通过往往代表着个人在该领域有着足够的认识与理解。只有大语言模型通过专业资格考试, 才能说明其具有某一行业的入门能力。 因此, 大语言模型通过会计专业认证能力测试是其在财会垂域应用的基础。中国注册会计师(CPA)考试共有六个科目, 据此可把会计常识推理能力划分成对应的六个细分(会计、 审计、 税法、 财务管理、 经济法和战略)。

本文以会计常识推理能力为例, 构建评测 LLMs 对应推理能力的数据集。在会计能力考试中, 相较于职称考试, CPA考试的国际认可度更高、 专业范围更广, 能够适用于多种财经行业的高级职位。因此, 采用CPA会计科目考试题目中的计算题作为基准数据集, 题目覆盖CPA 考试大纲的各个章节, 包括30章113节知识点内容, 涉及会计分录借贷判别、 科目选择、 金额计算、 会计准则适用、 会计概念理解、 方法适用等共404题, 称为Accoun-ting-Reasoning-Benchmark。评测题目的答案使用的是直接计算结果, 而不是选择题项目, 原因在于: 研究发现, 某些LLMs在做选择题项目时会有选项倾向, 而某些 LLMs 即使分析错误, 也会进行反复反省, 直到得出一个可选项为止, 这会导致评测失败。数据例子如下:

题目: 2×17年12月30日, 绿地公司购入一项设备, 支付买价498 万元, 另支付运输费2万元。该项固定资产预计使用年限为10 年, 绿地公司采用直线法计提折旧, 预计净残值为零。2×20年12月31日, 绿地公司对该项资产进行减值测试。在确定其公允价值时, 绿地公司根据相关信息得知市场上在1个月前有相关交易发生, 成交价为500 万元, 成新率为100%。已知该项设备的成新率为60%, 2×20年12月31日绿地公司确定该项设备的公允价值为()。答案: 300万元 解析: 确定该设备公允价值时, 按照市场上成交价计算, 由于获取的信息中成交价对应的成新率是100%, 而绿地公司购入的资产本身成新率为60%, 所以其公允价值应按照成交价乘以成新率来确定。综上, 绿地公司该项设备的公允价值=500×60%=300(万元)。涉及知识点: 公允价值概述 难度: 容易 是否真题: 否

对数据集的难度进行定义, 数据集难度界定涉及章节的难度以及计算步骤和逻辑的难度, CPA考试会计计算题章节难度如下(从难至易): 合并报表—长期股权投资与合营安排—金融工具—收入—租赁—所得税—股份支付—或有事项—政府补助—企业合并—会计政策、 会计估计—其他章节。根据计算难度和步骤界定如下: 难: 计算步骤较多(>3)或章节较为困难, 或人类正确率较低; 中等: 计算步骤中等(2 ~ 3 步左右), 章节难度适中; 普通: 计算容易(1 ~ 2 步), 章节简单; 容易: 计算容易, 一般一步解决。

在覆盖CPA考试大纲的30章内容中, 会计教授按照考点及知识点选取了真题和模拟题, 答案选用真题匹配答案和适用频率高的刷题APP模拟题答案, 并让拥有CPA《会计》科目及格资格的人员复核答案。题目选取后, 进行基本的清洁流程, 把重复性题目和冗余题目清除。

本文没有确切预测LLMs在上述考试中表现如何的依据。但从Eulerich等(2023)的研究结果来看, 它应该能够回答一些问题。预期GPT-4和GLM-4比小规模参数模型如GLM-6B表现得更好。

(四) 评测实验结果分析

实验以闭源模型 OPENAI的GPT-4模型评测为基准(Baseline), 比较清华智谱开源模型 GLM-6B、 GLM-130B、 GLM-4 的测评结果。测评过程中, 使用思维链(Chain of Thought,CoT)(Wei等,2022), 也就是让LLMs在解答过程中把详细分析过程输出, 增加模型的分析能力, 便于最后评测结果分析模型的错误原因。同时, 使用Few-shot- Learning(Yu等,2023)方法, 在输入题目的同时, 给予LLMs三个具体分析解答的例子, 让其可以学习如何解题。实验过程如下:

首先, 在上下文提示词工程阶段, 对Zero-shot、 CoT、 Few-shot-CoT分别进行抽样题目的测试, 在CoT和Zero-shot测试过程中, 发现最终输出结果混乱, 比如最终结果没有明确表明、 语言会中英混合、 如有反思阶段会循环进行直至达到上下文长度限制。因此, 为了在检测结果时能够使用LLMs进行简单的答案对比判断, 降低检测人工成本, 利于检测结果的推广, 本文采用Few-shot-CoT进行。同时, Zero-shot对复杂多步的问题的测试准确率极低, 在抽样中, 计算题的准确率只有Few-shot-CoT的50%不到, 在会计常识测试抽样中更是达到了仅有的个位数准确率, 没有发挥出LLMs的潜在能力。因此, 建议在所有的会计垂域应用中, 使用Few-shot-CoT作为上下文提示工程标准。本文的Few-shot-CoT仅选用三个GSM8K未入选题目的CoT例子作为CoT展开模式, 计算过程与输出最终结果的示例如下:

仿照例子的做法, 逐步地思考, 并给出题目的答案。请严格按照例子的输出格式, 在推理最后###答案: 处给出数字答案\n例子: \n问题1: 一位电子产品销售员以每台700元的价格购买了5部手机, 并用价值4000元的钞票付款。销售员需要找回多少零钱?\n 逐步思考: \n步骤1: 销售员购买5部手机, 每部700元, 总共5×700 =[$]<<5×700=3500>>3500元。步骤3: 销售员需要找回4000-3500 =[$]<<4000-3500=500>>500元的零钱。\n###答案: 500\n\n

然后, 使用LLMs对数据集问题进行批量解决, 形成LLMs的输出结果Responses。

接着, 以题目的正确答案Truth为基准, 让GLM-4扮演会计阅卷教师的角色, 把每道题目的Responses作为学生答题答案, 让GLM-4做出答题是否准确的判断。

最后, 统计答题的准确率。

对LLMs进行Multi-Calculation-Benchmark评测, 结果如图2所示。

GPT-4是其他LLMs评测的基准, 直至2024年2月, 其在普通推理能力中仍然处于第一梯队, 相当于LLMs的标杆。开源模型在进行测评时, 对照GPT-4的表现, 分析开源模型的差距, 并且在后续改进中, 以基准为优化目标。从评测结果看, 多步计算推理能力在小规模参数如GLM-6B模型(60亿参数)LLMs中表现极差, 只有20%不到的准确率, 与基准的差距过大, GLM-6B模型的多步计算推理能力远达不到人工相比的及格率60%, 而会计对运算要求更高, 要达到90%以上, 才能满足会计应用的要求。同样是千亿级别的LLMs, GLM-130B、 GLM-4和GPT-4也有明显差距, GLM-130B虽然有涌现能力的参数规模, 但是准确率还没达到人类及格线。这种低准确率LLMs在有计算场景的应用上没有可行性, 严重影响分析结果。因此, GLM-6B和GLM-130B不适合独立使用进行会计分析。

只对多步计算推理能力评测效果优良的GPT-4和GLM-4进行Accounting-Reasoning-Benchmark评测。由于这个Benchmark是由计算题组成, 多步计算推理能力会极大地影响其评测。在相同的会计常识推理能力下, 预期GPT-4的评测准确率会高于GLM-4, 但是结果却相反, 如图3所示, GPT-4 的准确率只有16.58%, 而GLM-4达到21.78%。总体来说, GLM-4的会计常识推理能力比GPT-4 要强5%。如果考虑多步计算的影响, 这个差距更大。两个模型在会计常识推理能力上都没有及格, 离应用还有很大距离, 需要进行后续的调优和改进。GLM-4相对于GPT-4有更优的会计常识推理能力, 从图3中可以观察到GLM-4容易难度下的数据集。由于大多只有一步计算, 准确率达到40%, 而其他三种难度的准确率与难度似乎没有直接的关系, 证明GLM-4的难度表现与人类理解的会计常识难度是不一致的。它会对会计某些独特的知识点理解较好, 对某些会计方法使用较差, 而不能用人类的会计准确率替代。这三种难度都属于多步计算的会计常识题目, 因此多步计算推理能力的影响是比较接近的, 对只有一步计算的容易题目影响较少。因此, 去除多步计算推理错误的影响后, 后三种难度会有相对较高的提升。进一步提高GLM-4 的会计应用能力, 需要在后续分析GLM-4的会计常识推理缺陷, 进而进行改进。

在普通难度和中等难度两类题目的准确率上, 出现了与难度相反的关系, 进一步印证了GLM-4在会计常识推理上的难度判定与人类的判定有差距。为了找出这种反差的原因, 本文对这两种难度的错题进行了分类统计, 可以把错误归结为六类主要原因:

第一, 会计方法使用错误。LLM在分析过程中对相关会计准则或会计处理方法的运用出现偏差或错误, 如在特定情况下错误地选择了计量属性、 未能正确识别需要进行会计处理的事项、 对准则规定的确认条件理解有误等, 由此导致在中间计算过程或最终答案上出现错误。

第二, 知识点掌握不全面。这部分题目中, LLM对题目涉及的部分知识点理解不到位或者遗漏了一些关键信息, 从而在分析过程中考虑不周全, 未能全面领会题意。

第三, 题目过于复杂导致难以处理。有一部分题目涉及特别复杂的会计处理或计算, LLM在这类题目上遇到了较大困难, 体现为分析逻辑不够清晰或者处理方法失当。这可能超出了LLM目前的能力范围。

第四, 答题逻辑和思路正确但计算出错。这类题目中LLM对知识点的理解和运用大体正确, 构建了合理的答题逻辑, 但在具体数字计算环节出现了一些失误。

第五, 知识点理解存在偏差。这部分错题反映出LLM对一些会计概念或处理原则的理解存在偏差或混淆, 如资产减值准备的计提、 递延所得税的确认等。在一些需要综合考虑多方面因素的问题上, 如或有事项的判断、 资产减值迹象的识别等, LLM对各因素的权衡不够到位, 得出的结论有时存在片面或矛盾之处。

第六, 知识应用不精准。LLM虽然对一些会计准则的原理性内容理解较好, 但在具体应用到实务问题时还不够精准到位, 如现金流量表的编制、 所得税费用的确认等。同时, 对一些细节的把握也有偏差。这反映出LLM在将理论知识运用到实务的能力上还有待加强。

图4是两种难度在六类错误原因中的占比, 有些题目错误的原因不是单一的, 所以占比总和不是100%。普通难度的题目极少涉及实务, 所以没有实务错误类型。

第一种错误特征“会计方法使用错误”和第五种错误特征“知识点理解存在偏差”有一定的相似性和关联性, 这两种错误特征都反映出LLM对某些会计知识点的理解和掌握还不够全面、 准确, 而知识点理解上的偏差很可能会导致会计方法使用上的错误。这种对知识的基本识别错误占了错误比例的50%以上, 而且相对于其他错误容易修正, 是一个值得关注的错误大类型。但是它们之间又有根本的区别: “会计方法使用错误”主要是指在具体运用会计处理方法时出现错误, 如错误选择计量属性、 未正确识别需处理的事项等, “知识点理解存在偏差”主要是指对会计概念、 会计原则等理论知识的理解存在偏差或混淆, 侧重于会计理论认知层面; “会计方法使用错误”通常表现为在具体的会计处理环节如确认、 计量、 列报等方面出现的错误, 在解题过程中易于识别, “知识点理解存在偏差”可能会间接导致会计处理的错误, 但更多地体现在分析和论证环节对某些概念的错误表述或理解不到位, 有时可能不会直接反映在最终的计算答案中; 在提升难易度和评测精准度上, “会计方法使用错误”更有利, “知识点理解存在偏差”的识别需要对比分析, 更难发现。

第二类错误“知识点掌握不全面”是GLM-4无论在会计常识推理还是多步计算推理中都会出现的一种常见错误, GLM-4会经常遗漏题目影响因素, 这种错误与LLMs的本质特点关系更强烈, 需要提升通用能力才能较好地解决。从难度区分上分析, 两种难度的计算步骤多是2 ~ 3步, 极少出现1步, 因此计算难度比较类似, 计算占比的差异可以归咎于抽样误差, 与GLM-4在两类题目中计算的差异性无关。第三种错误“题目过于复杂导致难以处理”是指对一些特殊或小众的会计处理如BT项目、 售后租回等准则的了解不够全面, 对新修订准则的知识更新也有所滞后, 导致分析不够周全, 未能全面领会题意。从第二、 三和四种错误的占比对比可以看出, 两种难度的差距并不大, 而且从以上分析来看, 这三种错误一般跟题目难度关系不大。因此, 难度与准确度的反差可以归咎于是第一种和第五种错误的反差造成的。而这两种错误的题目难度, 在区分普通和一般时, 是以章节按CPA考试的难易度进行的。可以看出, GLM-4的章节难易度在这个维度与CPA考纲的难易度区分并不完全一致。这是由于大多数LLM内核的难易度是跟训练语料的常见程度有关, 如果某些CPA章节的训练语料更常见, 相对来说它就更容易学习到该章节的内容。

四、 结论

本研究探讨LLMs在会计领域的应用前景, 通过设计两个评测基准来评估 LLMs在多步计算推理以及会计专业知识方面的表现。结果表明, 尽管LLMs在通用领域已经取得令人瞩目的成就, 但在会计专业领域, 它们的表现还有很大提升空间。具体而言, 当前最先进的LLMs如GPT-4在多步计算推理任务上的准确率最高可达91.45%, 而在会计专业知识任务上的准确率低于22%。通过进一步的分析, 本文探究了LLMs在会计常识推理过程中出现错误的主要原因并指出错误的六个类型, 分析出各类错误在难度分层中的占比及差异, 这也为后续改进指明了方向。

从本文设计的实验中可以发现, LLMs难以利用训练中获得的通用知识来处理会计领域的具体问题。未来研究可以关注以下方面: 一是继续扩充高质量的会计领域语料, 为 LLMs 提供更多专业知识的学习素材; 二是在通用LLMs的基础上, 采用领域自适应的微调方法, 使其更好地适配会计场景; 三是探索在会计领域引入外部知识增强方法, 例如利用知识图谱等先验知识来指导 LLMs推理; 四是借鉴认知科学和教育学的理论, 优化LLMs的Few-shot学习范式, 提高其快速学习新知识的能力; 五是深度发掘LLMs缺失的会计能力, 从其推理错误内容中找寻具体的模型改进方法, 推动六类错误的改进。

总之, LLMs在会计领域的应用还处于起步阶段, 未来仍需在数据、 模型和评测等多个层面开展研究。通过学界和业界的共同努力, LLMs必将在会计智能化进程中发挥越来越重要的作用。本研究为这一目标的实现提供了重要的理论与实践参考。

【 主 要 参 考 文 献 】

廖高可,李庭辉.人工智能在金融领域的应用研究进展[ J].经济学动态,2023(3):141 ~ 158.

欧阳日辉,刘昱宏.生成式人工智能(AIGC)融入制造业的理论逻辑与实现路径[J/OL].新疆师范大学学报(哲学社会科学版):1 ~ 14. [2024-05-22].https://doi.org/10.14100/j.cnki.65-1039/g4.20240016.001.

Chalkidis I.. Chatgpt may pass the bar exam soon, but has a long way to go for the lexglue Benchmark[DB/OL]. https://arxiv.org/abs/2304.12202,2023-03-09.

Chang Y., Wang X., Wang J., et al.. A survey on evaluation of large language models[ J]. ACM Transactions on Intelligent Systems and Technology,2024(3):1 ~ 45.

Chen W., Wang Q., Long Z., et al.. Disc-finllm: A chinese financial large language model based on multiple experts fine-tuning[DB/OL]. https://arxiv.org/abs/2310.15205,2023-10-23.

Chen Z., Chen W., Smiley C., et al.. Finqa: A dataset of numerical reasoning over financial data[DB/OL]. https://arxiv.org/abs/2109.00122,2021-09-01.

Cobbe K., Kosaraju V., Bavarian M., et al.. Training verifiers to solve math word problems[DB/OL].https://arxiv.org/abs/2110.14168,2021-10-27.

Fatouros G., Soldatos J., Kouroumali K., et al.. Transforming sentiment analysis in the financial domain with ChatGPT[ J]. Machine Learning with Applications,2023(14):100508.

Hu H., Lu H., Zhang H., et al.. Chain-of-symbol prompting elicits planning in large langauge models[DB/OL].https://arxiv.org/abs/2305.10276,2023-05-17.

Huang J., Chang K. C. C.. Towards reasoning in large language models: A survey[DB/OL]. https://arxiv.org/abs/2212.10403,2022-12-20.

Lei Y., Li J., Jiang M., et al.. CFBenchmark: Chinese financial assistant Benchmark for large language model[DB/OL].https://arxiv.org/abs/2311.05812,2023-11-10.

Li C., Liang J., Zeng A., et al.. Chain of code: Reasoning with a language model-augmented code emulator[DB/OL]. https://arxiv.org/abs/2312.04474,2023-12-07.

Liu X. Y., Wang G., Zha D.. Fingpt: Democratizing internet-scale data for financial large language models[DB/OL]. https://arxiv.org/abs/2307.10485,2023-07-19.

Lu D., Wu H., Liang J., et al.. BBT-Fin: Comprehensive construction of chinese financial domain pre-trained language model, corpus and Benchmark[DB/OL]. https://arxiv.org/abs/2302.09432,2023-02-18.

Panagoulias D. P., Virvou M., Tsihrintzis G. A.. Evaluating LLM--Genera-ted Multimodal Diagnosis from Medical Images and Symptom Analysis[DB/OL].https://arxiv.org/abs/2402.01730,2024-01-18.

Shah A., Paturi S., Chava S.. Trillion dollar words: A new financial data-set, task & market analysis[DB/OL]. https://arxiv.org/abs/2305.07972,2023-05-13.

Srivastava A., Rastogi A., Rao A., et al.. Beyond the imitation game: Quantifying and extrapolating the CPAabilities of language models[DB/OL].https://arxiv.org/abs/2206.04615,2022-06-09.

Sun J., Zheng C., Xie E., et al.. A survey of reasoning with foundation models[DB/OL]. https://arxiv.org/abs/2312.11562,2023-12-17.

Talmor A., Yoran O., Bras R L., et al.. Commonsenseqa 2.0: Exposing the limits of AI through gamification[DB/OL].https://arxiv.org/abs/2201.05320,2022-01-14.

Theuma A., Shareghi E.. Equipping language models with tool use CPAability for tabular data analysis in finance[DB/OL].https://arxiv.org/abs/2401.15328,2024-01-27.

Wang A., Singh A., Michael J., et al.. GLUE: A multi-task Benchmark and analysis platform for natural language understanding[DB/OL]. https://arxiv.org/abs/1804.07461,2018-04-20.

Wang Y., Kordi Y., Mishra S., et al.. Self-instruct: Aligning language models with self-generated instructions[DB/OL]. https://arxiv.org/abs/2212.10560,2022-12-20.

Wei J., Wang X., Schuurmans D., et al.. Chain-of-thought prompting elicits reasoning in large language models[ J]. Advances in Neural Information Processing Systems,2022(35):24824 ~ 24837.

Wu S., Irsoy O., Lu S., et al.. Bloomberggpt: A large language model for finance[DB/OL]. https://arxiv.org/abs/2303.17564,2023-03-30.

Xia M., Malladi S., Gururangan S., et al.. Less: Selecting influential data for targeted instruction tuning[DB/OL].https://arxiv.org/abs/2402.04333,2024-02-06.

Xu L., Hu H., Zhang X., et al.. CLUE: A Chinese language understanding evaluation Benchmark[DB/OL]. https://arxiv.org/abs/2004.05986,2020-04-13.

Yu Z., He L., Wu Z., et al.. Towards better chain-of-thought prompting strategies: A survey[DB/OL]. https://arxiv.org/abs/2310.04959,2023-10-08.

Zhang L., Cai W., Liu Z., et al.. Fineval: A chinese financial domain knowledge evaluation Benchmark for large language models[DB/OL]. https://arxiv.org/abs/2308.09975,2023-08-19.

Zhao W. X., Zhou K., Li J., et al.. A survey of large language models[DB/OL]. https://arxiv.org/abs/2303.18223,2023-03-31.