基于改进残差神经网络的家蚕日龄识别模型

田丁伊 石洪康 祝诗平 陈肖 张剑飞

摘要:家蚕日龄的准确识别有助于精准饲喂和动物福利,因此为准确识别家蚕生长时期中3龄第1天至5龄第7天,共14个日龄,在实际环境下采集特定家蚕品种,构建以14个日龄为单位的数据集。提出一种基于改进残差神经网络的MogaResNet,该方法在经典残差神经网络ResNet50的基础上,引入多阶门控机制以获取日龄图像的显著性特征。通过在同一个家蚕日龄数据集上开展模型训练与测试得到,MogaResNet的识别准确率为96.57%,F1值为96.57%,召回率为96.62%,与Swin Transformer、MobileNet v3、CSPNet和DenseNet四个经典模型的评价指标相比,MogaResNet在家蚕的日龄识别中具有较强的识别能力,可以为开展家蚕精准饲喂和数字化管理相关工作提供基础。

关键词:家蚕;日龄识别;多阶门控机制;残差神经网络

中图分类号:TP391.4: S883.6

文献标识码:A

文章编号:20955553 (2024) 02025908

收稿日期:2023年3月15日 修回日期:2023年5月10日

基金项目:四川省自然科学基金资助项目(2023NSFSC0498);南充市科技计划项目(22YYJCYJ0009)

第一作者:田丁伊,女,1999年生,吉林吉林人,硕士研究生;研究方向为农业电气化与自动化。Email: 704791007@qq.com

通讯作者:祝诗平,男,1969年生,四川巴中人,博士,教授;研究方向为农业电气化与自动化。Email: zspswu@126.com

Dayage recognition model for the domestic silkworm based on improved residual neural network

Tian Dingyi1, 2, Shi Hongkang1, 2, Zhu Shiping1, 2, Chen Xiao3, Zhang Jianfei3

(1. College of Engineering and Technology, Southwest University, Chongqing, 400700, China;

2. Yibin Academy of Southwest University, Yibin, 644000, China; 3. Sericultural Research Institute,

Sichuan Academy of Agricultural Sciences, Nanchong, 637000, China)

Abstract:

Accurate identification of silkworm dayage contributes to precise feeding and animal welfare. In order to accurately identify 14 dayage from the first day of age 3 to the seventh day of age 5 in the growth period of silkworm, this paper constructs a dataset with 14 dayage units by collecting specific silkworm species in a real environment. This paper proposes MogaResNet method based on an improved residual neural network. This method introduces a multiorder gating mechanism to obtain the saliency features of dayage images based on the classical residual neural network ResNet50. Through model training and testing on the same domestic silkworm dayage dataset, the recognition accuracy of MogaResNet is 96.57%, the F1 value is 96.57%, and the recall rate is 96.62%. Compared with the evaluation indexes of four classic models, including Swin Transformer, MobileNet v3, CSPNet and DenseNet, MogaResNe achieved a stronger recognition ability in dayage recognition of domestic silkworm, which can provide a foundation for carrying out work related to precise feeding and digital management.

Keywords:

silkworm; dayage identification; multiorder gating mechanism; residual neural network

0 引言

家蠶是一种重要的经济昆虫,目前在我国南方地区广泛养殖。家蚕的生命周期短,生命形态多样,其中涉及养殖的幼虫期约持续25天。在正常条件下,家蚕在每个龄期下生长时间较为固定,在3龄持续3天,4龄持续4天,5龄持续7天,满足每一龄期的发育天数后将进入休眠期,眠起响食或吐丝结茧。同时,家蚕形态每天都会发生变化,外形特征是判断家蚕是否健康发育的重要依据[1]。此外,家蚕在不同龄期饲养的要求不同,需要的桑叶品质和数量也不相同,因此,家蚕的日龄识别在家蚕饲育中具有重要作用。家蚕的日龄识别是家蚕科研生产中的基础工作,准确识别家蚕日龄不仅有助于开展精准饲喂和数字化管理,还有助于家蚕健康发育状态的初步诊断[23]。目前家蚕日龄的识别方式主要是手工记录,当饲养批次较多或饲养品种较多时,不但识别效率较低且劳动强度高[4]。鉴于家蚕在连续日龄下生命形状存在差异,因此,有必要开展高效智能的家蚕日龄识别方法研究。

利用计算机视觉技术和深度学习算法开展农业领域的各种识别研究是当前研究的热点,在近年的研究发展中取得广泛的成果[58]。在家蚕识别领域,石洪康等[9]使用轻量化模型开展家蚕幼虫品种识别,取得较高的识别准确率。石洪康等[10]在家蚕的病害识别研究中,改进部分残差神经网络,采用特征融合和缩减结构方法,开展有效的家蚕病害识别试验。于业达等[11]针对蚕蛹雌雄自动识别算法提出基于梯度特征的深度卷积神经网络,不但减少识别的计算量还降低数据采集成本;陶丹[12]基于计算机视觉,构建适合于蚕蛹图像的CNN模型,开展蚕蛹雌雄的鉴别研究;何瑞敏等[13]利用噪声数据改进Mask RCNN,其模型框架中的像素重加权和边框细调策略,提高模型对蚕体的分割能力,对4龄、5龄蚕体的识别准确率达到了96.83%。Wen等[14]提出了一种基于多尺度特征融合的KM-YOLOv4,旨在提高模型对日常集约化养蚕的检测。其优势在于减少计算负荷和模型规模,检测精度提高了1.82%。李时杰等[15]以深度学习模型BLYOLOv3为依托,有效识别黄斑茧、上车茧、烂茧。上述研究内容表明计算机视觉技术和深度学习算法可以实现家蚕品种、病害、蚕蛹性别和蚕茧品质的有效识别,但上述研究均未涉及家蚕的日龄识别。为此,本文在现有研究方法的基础上,拟采用计算机视觉技术和深度学习算法,开展家蚕日龄识别研究,为家蚕识别领域的研究建立基础。

家蚕在连续日龄的生长发育阶段,外形差异非常小,即便是人眼也难以区分,因此在构建基于深度学习的识别模型时,如何能获取到家蚕特征成为确保识别准确率的关键。为此,本文在广泛使用的残差神经网络ResNet50的基础上,引入多阶门控机制获取家蚕日龄图像的显著性特征,构建一种基于改进残差神经网络的日龄识别模型,可用于家蚕饲育环境下的日龄识别。

1 材料与方法

1.1 家蚕日龄识别图像数据集

1.1.1 图像采集

为确保训练模型的应用能力,本研究在实际养殖环境下开展图像采集工作,构建家蚕日龄图像数据集。图像采集地点在四川省农业科学院蚕业研究所(四川省南充市)的专业养蚕室内。采集时间为2022年4月28日—5月14日,即家蚕生长的3龄第1天至5龄第7天,其中5月1日、5月6日、5月7日三天为家蚕的休眠时间,未进行图像采集。采集环境是在室内的自然光照条件下。采集设备使用智能手机(iphone 6s)和用于固定设备的三脚架,如图1所示。采集的图像如图2所示。

(a) 3龄第1天

(b) 3龄第2天

(c) 3龄第3天

(d) 4龄第1天

(e) 4龄第2天

(f) 4龄第3天

(g) 4龄第4天

(h) 5龄第1天

(i) 5龄第2天

(j) 5龄第3天

(k) 5龄第4天

(l) 5龄第5天

(m) 5龄第6天

(n) 5龄第7天

本研究中的采集与识别对象是我国西南地区的主推家蚕品种之一:芳·秀×白·春[16]。家蚕数量共500只,每只家蚕由专业人员在标准饲育环境下养殖。采集图像时,将家蚕逐个从蚕箔中取出,放置于拍摄装置正下方,并将采集设备屏幕长宽比设置为1∶1,避免图像尺寸缩放后家蚕形状发生变化。为避免同一日龄下个体大小成为识别的特征,需设置相同的焦距进行采集。采集完成后放回蚕箔中继续饲喂。鉴于1龄和2龄的家蚕个体较小,图像的采集工作较为困难,故本研究采集从3龄第1天至5龄第7天除休眠期外14天的图像,每天采集数量500张,共计采集7000张图像。

1.1.2 预处理与数据集构建

完成图像采集后,将同一日龄的家蚕图像放置在一个文件夹内代表一个识别类别,构建出家蚕日龄识别图像数据集,数据集的类别数量为14个。由于采集设备拍摄的图像尺寸为3224像素×3224像素,而分类模型的输入图像尺寸一般为224像素×224像素,采用双线性插值法将原始图像尺寸缩放为224像素×224像素。

本研究中獲取的全部图像按照6∶2∶2比例将数据集拆分成训练集、验证集和测试集,划分后训练集包含4200张图片,验证集与测试集包含1400张图片。其中训练集和验证集用于模型训练,测试集用于测试训练完成后的模型的识别效果。

1.1.3 数据增强

本文利用深度学习开发工具Tensorflow自带的Image Data Generator图片生成器,根据其中参数要求进行随机增强,即在训练过程中,随机从训练集中选取图像进行旋转、水平与垂直方向平移、随机水平翻转、放大五种增强处理方式,实现数据的随机增强。这种方法虽然扩充了数据,但并未增加图片的总体数量。数据的增强提高了模型的泛化能力与鲁棒性。在图片生成器中,rescale值设置为1/255,将图像的RGB值转化至0~1之间;图像旋转度数为0~45的随机数;水平与垂直偏移范围为0~0.2;随机水平翻转半数图像;图片在长和宽的方向上同时进行放大,zoom_range值设置为0.3。数据增强效果如图3所示。

(a) 原始图像

(b) 垂直平移

(c) 水平平移

(d) 放大

(e) 旋转

(f) 水平翻转

1.2 家蚕日龄识别模型

1.2.1 残差神经网络

残差神经网络(ResNet)[17]是计算机视觉领域最具有代表性的识别模型之一,其核心思想如图4所示,即输入特征x跨越连接到灰色模块后进行相加,以此可将网络的深度显著增加,并防止反向传播时出现梯度消失或爆炸。

残差神经网络的特征提取部分主要由Conv块和Identity块堆叠进行图像特征提取,如图5所示。两种模块的结构基本相同,区别在于Conv块会将输入特征维度降为原来的1/2,并在残差边上使用大小为1×1的卷积核和Batch Normalization运算进行特征映射和归一化。

(a) Conv Block

(b) Identity Block

1.2.2 多阶门控机制

多阶门控机制源自于MogaNet,该模型是2022年由Li[18]提出的仿Vision Transformers(ViT)的纯卷积神经网络,其特点是促进中阶特征的提取对模型性能的提升。多阶门控机制如图6所示。

多阶门控机制的结构由2个分支组成,其中左边的分支可视为一个残差连接;右边的分支主要进行特征提取,对于输入特征图进行特征提取时,先使用尺寸为5×5的卷积核进行深度可分离卷积运算,而后将特征图切片成为3个子特征图,对于其中2个子特征图,分别使用尺寸为5×5和7×7的卷积核进行特征提取,另一个直接映射到下一层,将3个子特征图拼接后使用1×1卷积进行融合后再使用SiLU函数进行特征激活,最后将两个分支上的特征相加后使用1×1的卷积进行通道调整后输出。多阶门控机制的优势在于,使用不同尺寸的大卷积核和膨胀卷积,能够显著增强网络的感受野,并实现多阶特征的捕获,从而增强模型的性能。

1.2.3 家蚕日龄识别模型结构

本研究中的模型主要根据残差神经网络中的Conv Block和Identity Block进行改进,借助多阶门控机制的优势,将Conv2d(3×3)替换为DWConv Block,组成的MogaConv Block和MogaIdentity Block如图7所示。

(a) MogaConv Block

(b) MogaIdentity Block

最终搭建的家蚕日龄识别模型结构MogaResNet是以ResNet50为基本框架,再利用MogaConv Block和MogaIdentity Block两部分进行4个阶段的堆叠,改进后的残差网络整体结构如图8所示。其中Conv2d是卷积层,即对输入图像进行二维卷积;MaxPooling2d是最大池化层;AveragePooling2d是平均池化层;浅绿色模块是每一个阶段特征提取后的特征图。

利用MogaResNet进行特征提取的流程是:首先将对输入图像的边缘填充3个像素,并使用尺寸为7×7的卷积核按照步长为2进行图像特征提取,接着进入池化窗口大小3×3,步长为2的最大池化层;然后是连续4个阶段的特征提取;在获取到维度为7×7×1024的特征后,再使用窗口大小为7×7的全局平均池化层将其维度压缩成1×1×1024,最后使用Softmax分类器输出网络的预测结果。

1.3 试验环境

本文搭建的识别模型和参与对比试验的模型均在相同的环境下试验,硬件环境包括:DELL Prescion 5808图像工作站,其处理器为Intel(R) Core(TM) i7-9800X CPU,内存大小为32G,GPU为NVIDIA GeForce RTX 2080Ti显卡。软件环境包括:Windows10 64位操作系统,编程语言为Python3.7,编译器为Jupyter notebook深度学习框架为Tensorflow1.14 GPU。所有的模型使用相同的超参数进行训练,包括:迭代次数为300次,初始学习率为0.01,在训练过程中以验证集上的损失值为参照,若该值连续5次迭代时未明显上升,将学习率×0.8,mini batch_size为16,优化器为Adam,使用交叉熵损失函数。以模型的参数量、单次迭代时间以及在测试集上的准确率Accuracy、F1值、精准率Precision和召回率Recall等作为评价指标,其计算公式分别如式(1)~式(4)所示。

Accuracy=TP+TNTP+TN+FP+FN

(1)

Precision=TPTP+FP

(2)

Recall=TPTP+FN

(3)

F1=2×Precision×RecallPrecision+Recall

(4)

式中:

TP——

預测为正类实际为正类的数量;

TN——

预测为负类实际为负类的数量;

FP——

预测为正类实际为负类的数量;

FN——

预测为负类实际为正类的数量;

F1——

调和Precision与Recall的调和平均数。

其中准确率Accuracy的分母表示训练的总样本数,分子表示正确预测的样本数。精准率Precision的分母表示预测为正的样本数,分子为实际为正的样本数。召回率Recall的分母表示真正总的正样本数,分子是预测正确的正样本数。

2 试验与结果

2.1 与原始网络的对比试验

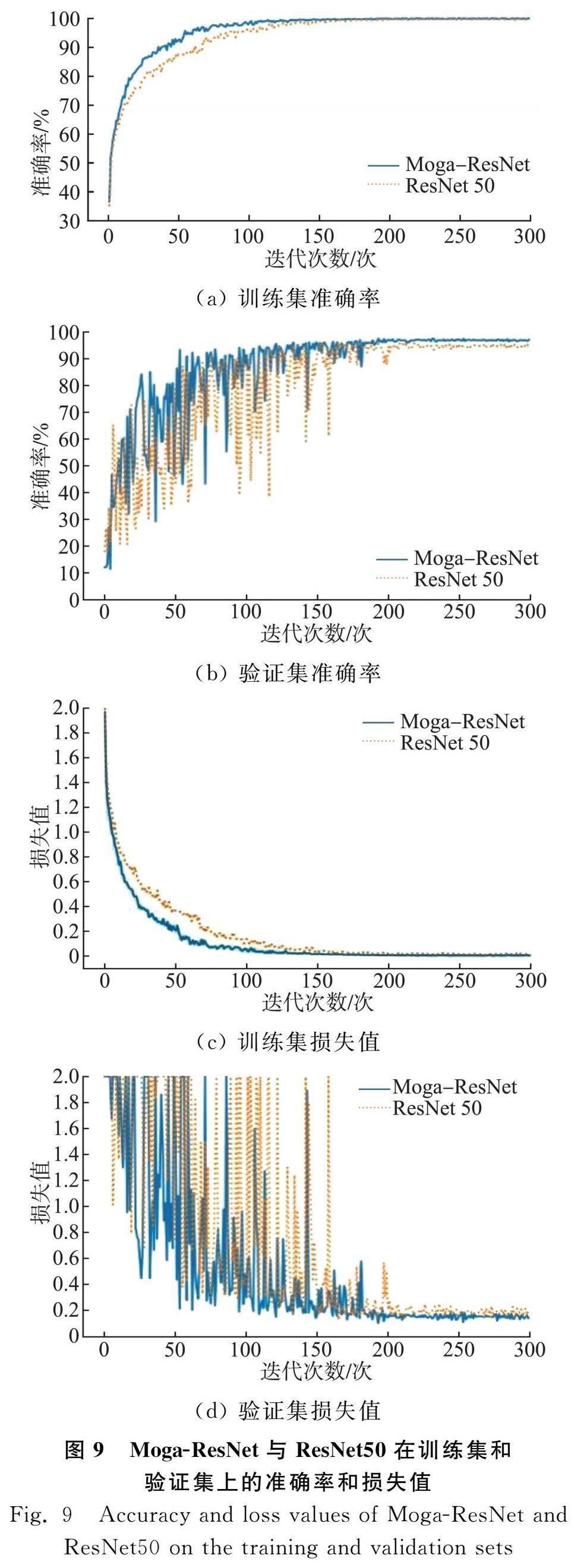

为验证本研究中添加多阶门控机制的方法对原始模型的识别能力具有一定的提升,将ResNet50和MogaResNet在相同的环境下进行训练和测试,并记录模型在训练集和验证集上的准确率和损失值,用于观察模型的训练性能。

MogaResNet在训练集和验证集上的准确率和损失值如图9所示,图9(d)中验证集损失值大于2的用2替换。由图9可知,在训练初期,两种模型在训练集和验证集上的准确率较低,损失值较大。随着训练的进行,大约经过100次迭代,两种模型在训练集上的准确率达到90%以上,损失值在0.2以下,表现较好的收敛状态。而在验证集上,两种模型的准确率和损失值均出现了较为明显的波动,约耗费200次迭代才达到较为稳定的状态。同时,从图9可以得出,较原始ResNet50模型,使用多阶门控机制的MogaResNet模型具有更快的收敛速度,约20次迭代后,验证集上的准确率明显高于原始网络,且损失值也更小,表明提出的模型能够提取到更为丰富有效的特征,促使模型的收敛性能更佳。

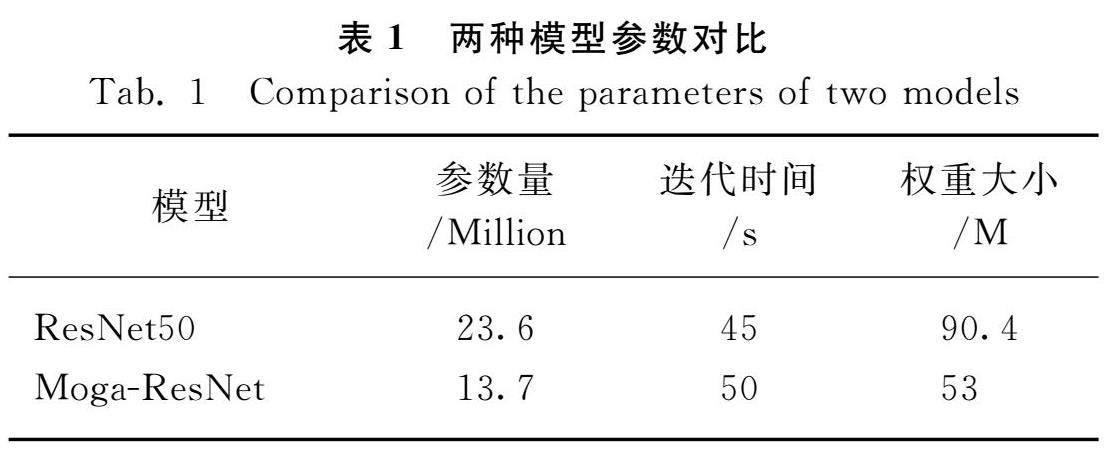

表1反映了MogaResNet与原始模型的参数量和单次迭代时间和权重大小。由表1可知,由于多阶门控机制中采用深度可分离卷积和膨胀卷积,改进后的模型的参数量为13.7 Million,远少于原始模型23.6 Million,從而使得模型的权重也大幅减少,这有利于模型在边缘或嵌入式设备上的部署。同时,根据表1中两个模型的迭代时间可以看出,虽然改进后模型的单次迭代时间略高于原始模型,但鉴于训练集和验证集共有5600张图像,试验规模较大,因此可认定两种模型的检测效率大致相同。综上所述,MogaResNet在家蚕日龄识别中更具优势。

模型训练完成后,本研究使用最后一次迭代的权重文件在测试集上进行测试,分别计算准确率、F1值和召回率,结果如表2所示。

(a) 训练集准确率

(b) 验证集准确率

(c) 训练集损失值

(d) 验证集损失值

从表2中可得,较原始模型相比,MogaResNet在识别准确率、F1值和召回率方面均有≥1%的提升,鉴于测试集中共包含1400张图像,因此,改进后的模型能够多识别出14张图像。

为可视化两种模型对每种类别的识别效果,输出了两种模型在测试集上识别结果的混淆矩阵,结果如图10所示。

(a) ResNet50

(b) MogaResNet

从图10中可知,混淆矩阵横坐标为模型的预测类别,纵坐标为图像在数据集中的实际类别,标签“0~13”分别代表3龄第1天至5龄第7天共14个日龄类别。混淆矩阵对角线上的值为模型正确识别的数量,其余位置的值为模型错误识别的数量。由图10可知,较为接近的日龄最容易发生错误识别,例如类别8和类别9,即5龄第2天和第3天,ResNet误识别6张,MogaResNet误识别5张。同时,MogaResNet对3龄第1天(类别0)和4龄第4天(类别6)的识别准确率达到100%,而对5龄第2天(类别8)的识别准确率仅为90%。但从整体来看,MogaResNet可以将两个类别之间的错误识别控制在5张以内,而原始模型共有3次错误识别且错误识别的数量大于5张,由此也表明MogaResNet添加的多阶门控机制,能够显著改善原始模型的识别效果。

2.2 与经典模型的对比试验

为进一步验证本研究中MogaResNet模型的识别效果,本研究使用几种常见的经典模型与MogaResNet进行对比试验,其中经典模型包括Swin Transformer[19]、MobileNet v3[20]、CSPNet[21]和DenseNet[22]。五种模型统一在本研究中构建的家蚕日龄数据集上进行训练与测试,同一环境下的对比试验结果如表3所示。

与MogaResNet相对比的四种模型中,SwinTransformer主要应用移动窗口方法,使用标准多头自注意力模块,训练准确率达到94.29%,F1值为94.29%,召回率为94.28%。MobileNet v3主要应用了MnasNet与NetAdapt两种自动化机器学习技术,针对问题搭建最优架构,其取得的识别准确率为93.14%,F1值为93.11%,召回率为93.26%。CSPNet的方法是分割特征图,再利用跨阶段分层结构合并,准确率为95.36%,F1值为95.33%,召回率为95.36%。DenseNet使用多个Dense Block与Transition Layer,其训练后的准确率达到95.79%,F1值为95.78%,召回率为95.86%。

从对比结果可得,与Swin Transformer、MobileNet v3、CSPNet和DenseNet相比,MogaResNet模型的准确率、F1值和召回率均有提高,表明本研究提出的改进残差神经网络模型MogaResNet对家蚕日龄图像具有较强的识别能力。

3 结论

1) 本文的研究对象是3龄第1天至5龄第7天的家蚕,以14个日龄为单位构建出图像数据集用于模型的训练与测试。本文中搭建的MogaResNet模型,结合了ResNet50中的残差结构,采用多阶门控机制进行特征提取,该模型在家蚕的日龄识别中产生了较好的效果。

2) 本文中MogaResNet的参数量为13.7 Million,识别准确率为96.57%,F1值为96.57%,召回率为96.62%,与ResNet50相比,MogaResNet权重较小,较Swin Transformer等模型的各项评价指标均有提升。根据评价指标体现出的优势,证明了改进残差神经网络MogaResNet对家蚕日龄识别分类具有一定的可行性。

参 考 文 献

[1]朱慧敏. 硒添食对家蚕生长发育及硒蛋白相关基因表达的影响[D]. 镇江: 江苏科技大学, 2022.

Zhu Huimin. Effects of selenium supplementation on growth and development of silkworm and expression of selenoproteinrelated genes [D]. Zhenjiang: Jiangsu University of Science and Technology, 2022.

[2]张雨丽, 李豪, 樊银凤, 等. 全龄人工饲料育与桑叶育家蚕生丝的蛋白质成分比较[J]. 蚕业科学, 2022, 48(3): 228-236.

Zhang Yuli, Li Hao, Fan Yinfeng, et al. Comparative analysis of protein composition of raw silk from silkworm reared on artificial diet and mulberry leaf in all instars [J]. Acta Sericologica Sinica, 2022, 48(3): 228-236.

[3]蔡幼民. 家蚕人工饲料育研究工作回顾[J]. 蚕业科学, 2022, 48(1): 1-6.

Cai Youmin. A review of our research on artificial diet rearing of silkworm [J]. Acta Sericologica Sinica, 2022, 48(1): 1-6.

[4]逄玉軍, 马彦辉, 程国辉, 等. 辽宁省柞蚕留根单母的时代演进和生产要点[J]. 蚕桑茶叶通讯, 2020(1): 7-8.

[5]孙亮, 柯宇航, 刘辉, 等.计算机视觉技术在植物病害识别上的研究进展[J]. 热带生物学报, 2022, 13(6): 651-658.

Sun Liang, Ke Yuhang, Liu Hui, et al. Advances in recognition of plant diseases based on computer vision [J]. Journal of Tropical Biology, 2022, 13(6): 651-658.

[6]任治洲, 谢云, 晁志恒, 等. 基于物联网与深度学习技术的农作物生长状况远程动态监测系统[J]. 物联网技术, 2022, 12(8): 15-18, 21.

[7]杨涛, 李晓晓. 机器视觉技术在现代农业生产中的研究进展[J]. 中国农机化学报, 2021, 42(3): 171-181.

Yang Tao, Li Xiaoxiao. Research progress of machine vision technology in modern agricultural production [J]. Journal of Chinese Agricultural Mechanization, 2021, 42(3): 171-181.

[8]何雨霜, 王琢, 王湘平, 等. 深度学习在农作物病害图像识别中的研究进展[J]. 中国农机化学报, 2023, 44(2): 148-155.

He Yushuang, Wang Zhuo, Wang Xiangping, et al. Research progress of deep learning in crop disease image recognition [J]. Journal of Chinese Agricultural Mechanization, 2023, 44(2): 148-155.

[9]石洪康, 田涯涯, 杨创, 等. 基于卷积神经网络的家蚕幼虫品种智能识别研究[J]. 西南大学学报(自然科学版), 2020, 42(12): 34-45.

Shi Hongkang, Tian Yaya, Yang Chuang, et al. Research on intelligent recognition of silkworm larvae races based on convolutional neural networks [J]. Journal of Southwest University (Natural Science Edition), 2020, 42(12): 34-45.

[10]石洪康, 肖文福, 黄亮, 等. 基于卷积神经网络的家蚕病害识别研究[J]. 中国农机化学报, 2022, 43(1): 150-157.

Shi Hongkang, Xiao Wenfu, Huang Liang, et al. Research on recognition of silkworm diseases based on convolutional neural network [J]. Journal of Chinese Agricultural Mechanization, 2022, 43(1): 150-157.

[11]于业达, 高鹏飞, 赵一舟, 等. 基于深度卷积神经网络的蚕蛹雌雄自动识别[J]. 蚕业科学, 2020, 46(2): 197-203.

Yu Yeda, Gao Pengfei, Zhao Yizhou, et al. Automatic identification of female and male silkworm pupa based on deep convolution neural network [J]. Acta Sericologica Sinica, 2020, 46(2): 197-203.

[12]陶丹. 基于机器视觉的家蚕蛹雌雄识别研究[D]. 重庆: 西南大学, 2019.

Tao Dan. Sex discrimination study of silkworm pupae based on machine vision technology [D]. Chongqing: Southwest University, 2019.

[13]何锐敏, 郑可锋, 尉钦洋, 等. 基于改进Mask RCNN模型的工厂化养蚕蚕体识别与计数[J]. 智慧农业(中英文), 2022, 4(2): 163-173.

He Ruimin, Zheng Kefeng, Wei Qinyang, et al. Identification and counting of silkworms in factory farm using improved mask RCNN model [J]. Smart Agriculture, 2022, 4(2): 163-173.

[14]Wen C, Wen J, Li J, et al. Lightweight silkworm recognition based on multiscale feature fusion [J]. Computers and Electronics in Agriculture, 2022, 200: 107234.

[15]李時杰, 孙卫红, 梁曼, 等. 基于深度学习的蚕茧种类实时检测系统设计[J]. 上海纺织科技, 2021, 49(11): 53-55, 58.

Li Shijie, Sun Weihong, Liang Man, et al. Design of realtime detection system for silkworm cocoon species based on deep learning [J]. Shanghai Textile Science & Technology, 2021, 49(11): 53-55, 58.

[16]张友洪, 沈以红, 肖文福, 等. 家蚕杂交组合芳·绣 × 白·春的选配[J]. 蚕业科学, 2014, 40(6): 1017-1023.

Zhang Youhong, Shen Yihong, Xiao Wenfu, et al. Selective breeding of Bombyx mori cross combination Fang· Xiu × Bai· Chun [J]. Acta Sericologica Sinica, 2014, 40(6): 1017-1023.

[17]He K, Zhang X, Ren S, et al. Deep residual learning for image recognition [C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2016: 770-778.

[18]Li S, Wang Z, Liu Z, et al. Efficient multiorder gated aggregation network [J]. arXiv preprint arXiv: 2211.03295, 2022.

[19]Liu Z, Lin Y, Cao Y, et al. Swin transformer: Hierarchical vision transformer using shifted windows [C]. Proceedings of the IEEE/CVF International Conference on Computer Vision, 2021: 10012-10022.

[20]Howard A G, Zhu M, Chen B, et al. MobileNets: Efficient convolutional neural networks for mobile vision applications [J]. arXiv preprint arXiv: 1704.04861, 2017.

[21]Wang C Y, Liao H Y M, Wu Y H, et al. CSPNet: A new backbone that can enhance learning capability of CNN [C]. Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops, 2020: 390-391.

[22]Huang G, Liu Z, Van DerMaaten L, et al. Densely connected convolutional networks [C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2017: 4700-4708.