学术论文学科领域层次标签分类方法

贾启龙,张仰森,刘帅康,朱思文,高强

(北京信息科技大学 智能信息处理实验室,北京 100192)

0 引言

随着人们对学科领域进行越来越精细的分类,当前细分学科领域的层次关系愈加庞大。如何将学术论文快速精准地分类至学科领域的层次标签体系中成为了一个亟待解决的问题[1]。学术论文的层次标签分类任务不同于普通的文本分类,学术论文的专业领域性更强,文本中存在更显著的所属学科领域的相关特征。传统的文本分类方法在处理具有层次标签的学术论文时面临一些难以突破的瓶颈,它们通常忽略了层次标签的结构特征,导致模型分类效果不佳。因此,对学术论文进行层次标签分类不仅需要考虑层次标签结构对分类结果的影响,还需要提取出学术论文中的学术领域特征。

近年来,文本分类技术的快速发展,为学术论文的层次标签分类任务提供了有力的支撑。随着深度学习的蓬勃发展,越来越多的研究者通过神经网络来构建分类模型。研究者们使用递归神经网络(recurrent neural network,RNN)、基于卷积神经网络的文本分类(text convolutional neural network,TextCNN)及其变种模型实现了自动提取文本语义的深层次特征,降低了成本,极大地提高了层次标签分类领域的模型性能。文献[2]提出了一种能够针对树形结构的基于局部多层感知机的层次多标签分类 (hierarchical multi-label classification with local multi-layer perceptrons,HMC-LMLP)模型,该模型在每个层次上训练一个多层感知机,每个层次的输出为该层次的预测向量,进而使得整个网络结构均可利用上一层提供的信息,以保证预测结果的一致性。然而,依赖于层次结构设计的多层感知机模型会导致计算成本随着层次结构的加深和类别标签的增多而显著提高。此外,这种设计也容易导致过拟合,从而降低模型在新数据上的泛化性能。文献[3]提出改进熵计算的HMC4.5方法,使用所有分类的信息量之和,生成一组较为简单的规则合集,自上而下划分簇状结构。这种方法采用基于决策树的机器学习技术,因此具有很好的可解释性。然而,当层次关系设置不合理时,它可能会归纳出过于复杂的规则,从而导致最终分类结果过拟合。神经网络模型通常采用词袋模型对词向量进行语义表示,但这种方法很难捕捉到全局文本中的深层次语义特征关联。此外,这类模型忽略了层次标签之间的结构特征关联,使得模型在捕捉语义信息方面面临困难。

随后,预训练模型的出现使得许多文本分类任务效果大幅改善。研究者们使用基于Transformer的双向编码器表示 (bidirectional encoder representation from Transformers,BERT)[4]、生成式预训练Transformer (generative pre-trained Transformer,GPT)[5]、知识增强的语义表示(enhanced representation through knowledge integration,ERNIE)[6]等预训练模型在大规模无标注的语料文本上进一步学习词向量,以更精准地表达语义特征。通过对不同任务进行下游微调,预训练模型极大地提升了文本分类领域的全部任务性能。在层次标签分类任务上,文献[7]提出将文本建模为图结构,使用随机游走生成标签序列训练得到标签的嵌入表示。该方法通过标签相似度的权重损失函数可以较好地捕捉标签之间的依赖关系。文献[8]则对文本和标签进行图表示后,通过BERT和双向门控循环单元(gate recurrent unit,GRU)提取文本的上下文语义信息,并通过多头注意力机制将标签的层次信息融合到文本表示中,进而抽取文本中不同部分和标签层次之间的关系。上述方法通过训练一个整体分类器进行层次分类,虽然降低了计算成本,但是在层次标签分类上容易导致欠拟合问题。为了有效利用层次标签的结构特征,文献[9]提出的层次多标签分类网络 (hierarchical multi-label classification networks,HMCN)模型,从2种角度提取层次特征,在相邻的节点间提取局部特征,在所有节点间提取全局特征。将局部特征与全局特征融合,并通过长短期记忆 (long short term memory,LSTM) 递归神经网络结构对层次信息进行编码,在每一层标签中都输出局部预测和全局预测,最后将各个局部预测进行连接,与全局预测进行加权组合得到最后的预测结果。这种融合了局部和全局特征的分类器,能够有效地提高分类效果。但是,HMCN模型并没有对文本进行有效的词嵌入,也没有考虑到文本与层次标签之间的关系。文献[10]进一步提出了基于注意力机制的LA-HCN(label-based attention for hierarchical multi-label text classification neural network)模型,从各层标签出发建模与文本之间的关联,文本与标签的依赖在层次之间共享,且对不同的层次基于文本生成不同的嵌入表示,从而较好地抽取了文本的层次特征。

目前的研究主要关注如何利用层次标签信息,对提取文本与层次标签之间关系的研究较少。对于学术论文这种领域性较强的文本,其包含着很强的所属层次标签语义关系。因此,本文针对学术论文的层次标签文本分类问题进行深入研究,提出了一种基于ERNIE预训练模型与融合图注意力网络(graph attention networks,GAT)的学术论文学科领域层次标签文本分类方法(text hierarchical label classification based on ERNIE and graph attention networks,GETHLC)。通过ERNIE预训练模型获得学术论文标题和摘要的嵌入向量,并通过GAT模块学习层次标签的结构关系,最终将融合后的向量输入到层次标签分类器中,实现对学术论文所属层次领域标签的准确预测。

1 GETHLC模型

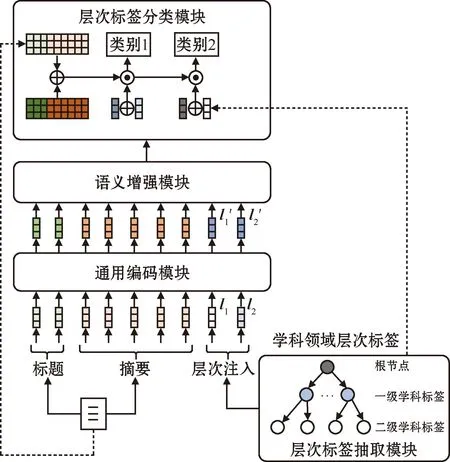

本文构建的GETHLC模型架构如图1所示。它主要包含4个模块:1)层次标签抽取模块。该模块对学术论文的层次标签特征进行抽取,得到每个学术论文样本的层次标签结构特征,并融入学术论文的表示向量中,作为通用编码模块的输入。2)通用编码模块。该模块对学术论文表示向量及其层次标签结构特征向量统一编码,以获得学术论文的文本表示和层次标签表示。3)语义增强模块。该模块提取文本上下文时序信息,增强文本的语义特征表示,以进一步提取二者之间的深层次关联关系。4)层次标签分类(hierarchical label classifier,HLC)模块。该模块以语义增强模块输出的特征向量与原始文本表示向量和层次标签特征向量作为输入。在遵循层次结构自上而下的依赖原则下,构建了一个具有依赖关系的层次标签分类模型,最终实现了对学术论文层次标签的分类,得到学术论文的层次标签分类结果。

图1 GETHLC模型框架Fig.1 GETHLC model framework

1.1 层次标签抽取模块

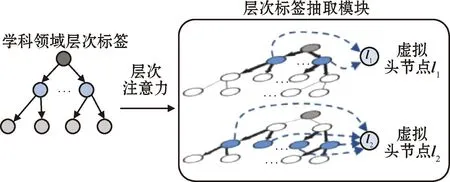

层次标签中通常蕴含着拓扑结构信息。为了获取层次标签之间的关系,采用图模型来表示层次标签结构。为了能够充分利用标签的层次结构,模型使用GAT[11-12]来捕获标签之间的层次结构特征关系。同时,为了加深对层次标签结构的特征提取,采用具有K层堆叠的图注意力神经网络对学科领域层次标签结构进行建模。层次标签抽取模块如图2所示。

图2 GAT模块Fig.2 GAT module

为了能够充分捕获层次标签的结构特征,层次标签抽取模块将从全局和局部2个方面计算节点特征。为了能够获得层次标签的全部结构信息,在全局角度下计算节点之间的注意力互相关系数。对于节点集中任意的2个节点ui和uj,其注意力互相关系数为

eij=α(Wi,Wj)

(1)

式中:i、j为节点序号;Wi、Wj为ui和uj节点中可学习的参数矩阵;α为线性变换层,目的是将矩阵结果转换到实数域上。由此,得到所有节点之间的影响关系。

此外,为了使模型能够捕捉到层次标签结构中相邻标签间的不同,模型还需从局部角度提取特征。本文通过掩盖图注意力机制(masked graph attention)将局部注意力机制引入图结构。对于相邻的2个节点ux和uy,其注意力互相关系数为

(2)

式中:exm(m∈Nx)为按式(1)计算节点ux与节点um之间的注意力互相关系数,Nx为节点ux的相邻节点序号集合。由此,得到所有节点的邻居节点权重。

此外,为了提取层次标签结构更多的关联信息,进行K次堆叠操作,则节点ui堆叠后的节点特征u′i为

(3)

为了更好地获得每层节点的特征关系,本文为h层标签体系分别创建虚拟节点l1、l2、…、lh,并将lh与层次标签第h层的所有标签节点连接起来,如图2所示,通过虚拟节点来连接聚合同一层次的信息。对于第i层上的虚拟节点li为

(4)

式中:a、b分别为第i层的节点编号上下界。由此,得到层次标签结构每个节点的特征与每层节点的全局特征,为后续模块提供层次标签结构的特征信息。

1.2 通用编码模块

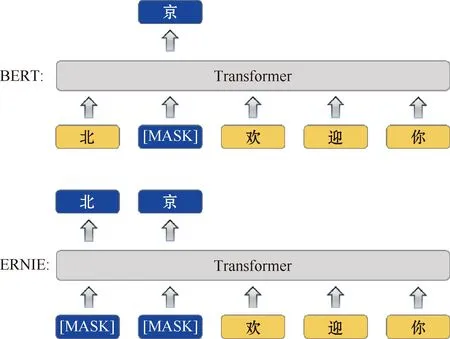

为了对输入文本进行语义表征,本文采用基于Transformer的ERNIE预训练模型[13]作为通用编码模块。对输入文本进行编码通常使用BERT模型,以获得文本的语义表征,但其仅对字进行遮掩,导致难以捕捉到文本中所包含的学科领域知识的语义表达。ERNIE模型与BERT模型的对比如图3所示。与BERT模型不同,为了更好地表达文本蕴含的知识,ERNIE模型在BERT模型的基础上引入了知识图谱对句子中的实体进行遮掩,从而生成更为精准的上下文特征表达,进而提供输入文本中对学科领域知识的语义表达。

图3 ERNIE模型与BERT模型对比Fig.3 Comparison between ERNIE model and BERT model

ERNIE模型的训练方法与BERT模型类似,通过遮掩句子中的部分字,让编码器根据句子的上下文预测被遮掩的字。此外,将2个句子进行拼接,让编码器再去判断2个句子是否为原文中相邻的句子,以此来学习句子中的上下文信息。在遮掩策略上,ERNIE模型采用实体为单位进行遮掩,并借助知识图谱来辅助选取实体。如此一来,ERNIE模型就不仅能够学到字级别的上下文信息,同时可以通过前后文来获取到知识层面的语义信息。

1.3 语义增强模块

为了提取输入文本更深层次的语义特征,本文采用双向长短期记忆(bi-directional LSTM,BiLSTM) 神经网络模型[14]作为语义增强模块提取深层语义信息。它由2个相反方向的LSTM网络组成。LSTM网络是由多个计算单元循环交接组成的,因此能够有效地学习长序列中的依赖信息。每个计算单元包含输入门、遗忘门、输出门和内部状态信息表示。计算单元的输入门在t时刻的状态信息为

it=σ(Wxixt+Whiht-1+Wcict-1+bi)

(5)

式中:σ为Sigmoid函数;ht-1为计算单元在时间t上一时刻的输出;xt为在t时刻的输入;ct-1为计算单元在t-1时刻的内部状态信息;Wxi、Whi、Wci为输入门的权重矩阵;bi为输入门的偏置。计算单元的遗忘门在t时刻的状态信息为

ft=σ(Wxfxt+Whfht-1+Wcfct-1+bf)

(6)

式中:Wxf、Whf、Wcf为遗忘门的权重矩阵;bf为遗忘门偏置。计算单元在t时刻的内部状态信息为

ct=ftct-1+ittanh(Wxcxt+Whcht-1+bc)

(7)

式中:tanh为激活函数;Wxc、Whc为内部状态信息的权重矩阵;bc为内部状态信息偏置。最后,计算单元的输出门在t时刻的状态信息为

ot=σ(Wxoxt+Whoht-1+Wcoct-1+bo)

(8)

式中:Wxo、Who、Wco为输出门的权重矩阵;bo为输出门偏置。最终,LSTM计算单元的输出为

ht=ottanh(ct)

(9)

(10)

式中:⊕为对2个向量进行相加。在使用ERNIE预训练模型训练输入向量,并通过BiLSTM模型提取特征向量后,将输出结果输入层次标签分类模块。

1.4 层次标签分类模块

为了对输入的文本表示向量进行层次标签预测,本文构建了层次标签分类模块。为避免模型在进行多轮特征抽取时遗忘原始文本特征,该模块分别对文档特征和标签特征进行了残差连接[15]。通过将BiLSTM模型输出的文本特征向量和层次标签特征向量,分别与原始的文本向量和层次标签向量进行残差连接,从顶层开始向低层逐层进行第i层标签向量的残差连接,以输出第i层的预测结果Pi为

Pi=Softmax(Pi-1⊙Li)

(11)

(12)

(13)

Li=μ·max{0,Softmax(Yin-Yip)}2

(14)

式中:Yin为第i个节点的预测表示向量;Yip为第i个节点的父节点预测表示向量;μ∈[0,1]为惩罚系数,该值越大表明对节点的惩罚力度越强。最终,本模型的损失函数L为

(15)

2 数据集

为验证本文GETHLC模型的效果,在大规模中文科学文献数据集CSL[16]上进行了对比实验和消融实验。

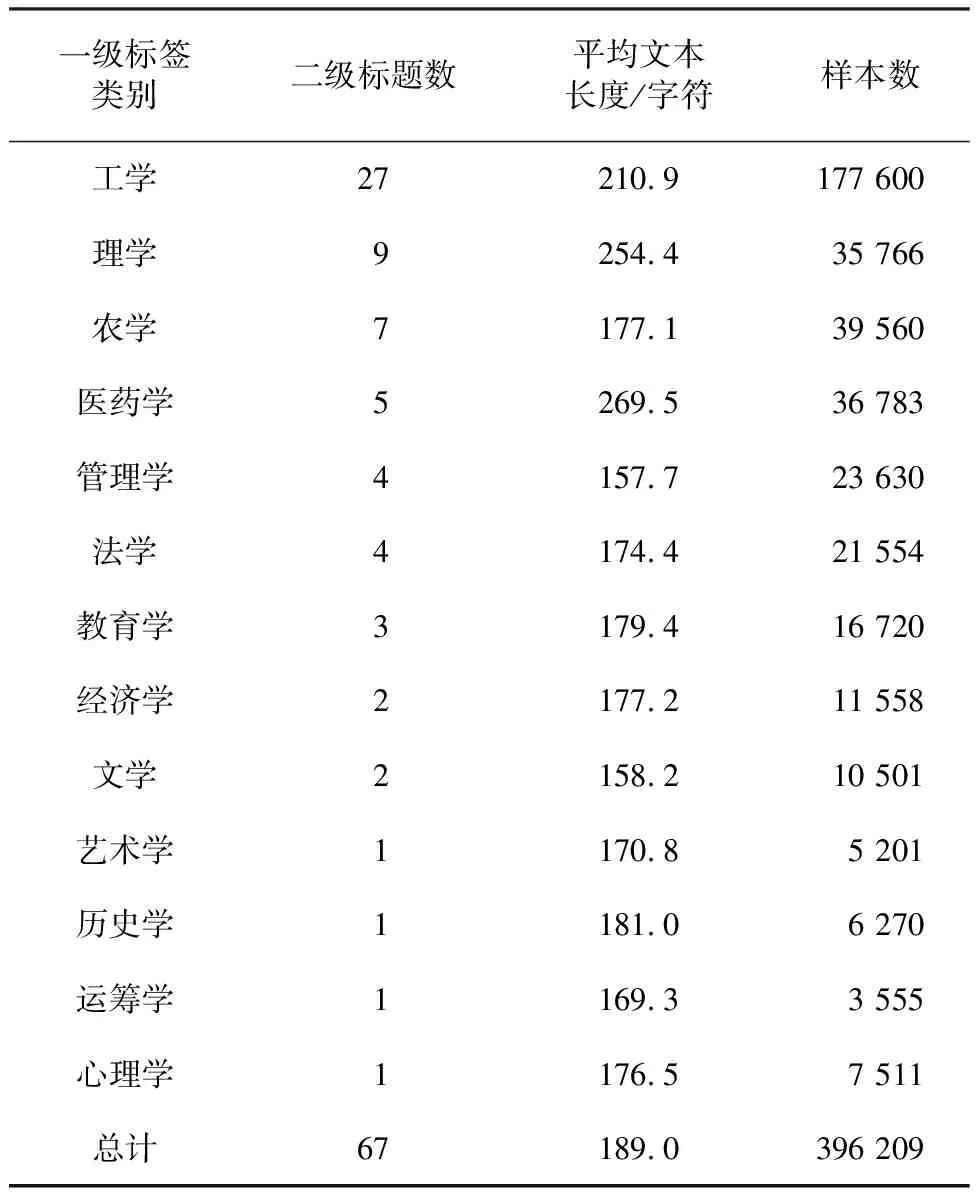

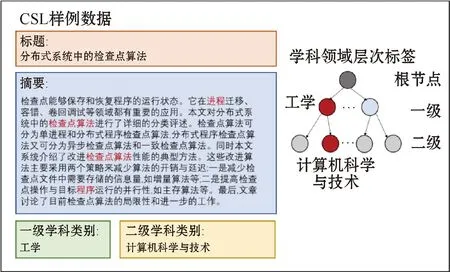

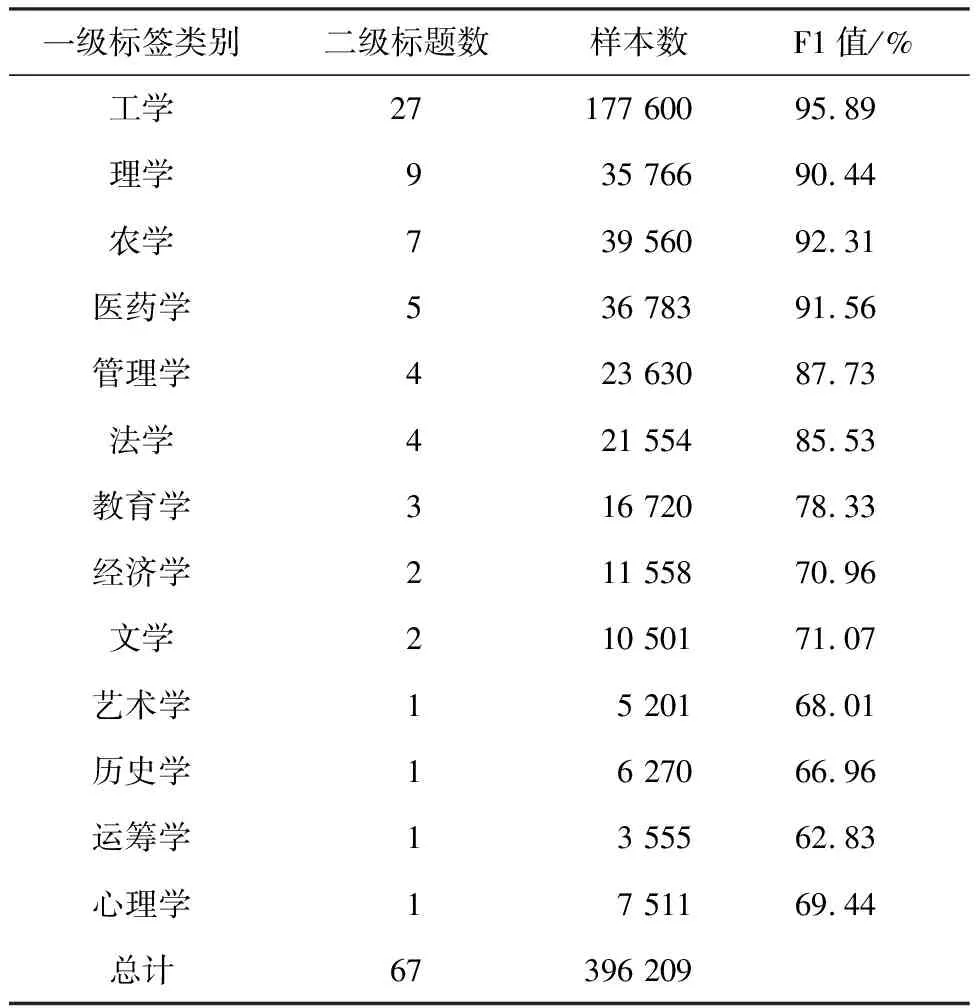

CSL数据集中包含396 209篇中文核心期刊论文,其中包括论文的标题、摘要、关键字、学科和门类。训练集、验证集和测试集的划分比例为8∶1∶1。表1为CSL数据集的一些统计数据。图4为CSL数据集中的样例数据。

表1 CSL数据集的统计数据Table 1 Statistics of the CSL dataset

图4 CSL数据集中的样例数据Fig.4 Example data from the CSL dataset

通过对数据集分析可知:

1)该数据集样本共有396 209个,数据集使用学科和门类作为层次标签,共有2层标签,其中一级标签类别有13种,二级标签类别有67种,说明该数据集可以很好地验证层次标签分类效果。

2)该数据集样本的平均文本长度为189.0个字符,除理学和医药学平均文本长度较长外,其他类别均为平均水平,说明该数据集的输入样本文本长度合理。

3)各类别之间的数量分布较为均匀,除工学样本数较多外,其他类别为平均水平,说明该数据集在分类类别上较为均衡,没有特别突出的数据倾斜问题。

3 实验结果及分析

3.1 对比实验及结果分析

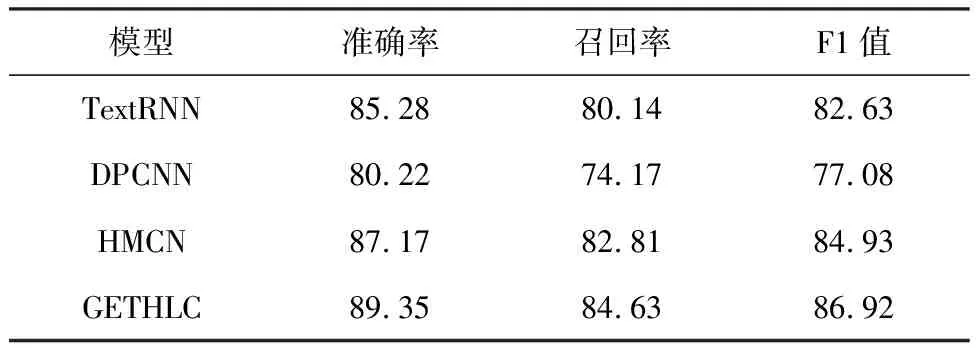

为了验证GETHLC模型的效果,本文选取在层次分类任务常用模型[17]中表现较好的基于多任务学习的递归神经网络文本分类(RNN for text classification with multi-task learning,TextRNN)模型、深度金字塔卷积神经网络(deep pyramid convolutional neural networks,DPCNN)文本分类模型、HMCN模型作为对比模型。所选模型介绍如下:

TextRNN:该模型对标签进行扁平化处理,利用 RNN 循环神经网络对输入文本向量进行编码,最后将编码输入到全连接层,并与Softmax激活函数相结合,以预测输入文本的层次标签分类结果。

DPCNN:该模型使用更深层次的卷积神经网络,能够有效地捕捉文本的长距离依赖关系。

HMCN:该模型利用层次结构中的局部预测结果,并整合整体层次结构的全局预测结果,从而进行层次标签分类。

模型对比实验结果如表2所示。

表2 模型对比实验结果

从表2可以看出,GETHLC模型性能超越了TextRNN、DPCNN、HMCN三种基准模型。其中,在准确率、召回率和F1值方面分别比最好的HMCN模型高出2.18、1.82、1.99百分点。值得注意的是,DPCNN使用更深层次的卷积神经网络处理层次标签,但这可能导致一些特征被过度压缩,从而影响模型的精度。而TextRNN在处理层次标签时丢失了层次信息,导致模型无法学习到层次结构信息。另外,HMCN没有充分考虑原始文本输入的上下文语义信息,从而导致模型不能有效抽取输入文本的语义特征。综上所述,相较于其他文本分类模型,本文所提出的GETHLC模型在学术论文层次标签分类任务上具有更优秀的表现。

3.2 消融实验结果与分析

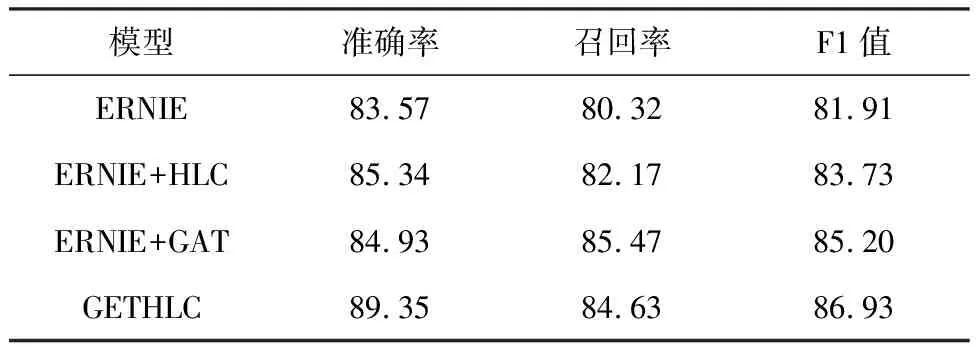

为了进一步验证模型结构的有效性,本文进行了消融实验,以研究影响实验结果的独立因素。实验结果如表3所示。

表3 消融实验结果Table 3 Results of ablation experiments %

对比表3中,仅使用ERNIE、使用ERNIE+HLC、使用ERNIE+GAT和本文(ERNIE+HLC+GAT)4种模型在CSL数据集上的表现效果可以发现,原始基准模型ERNIE效果最差,原因在于其仅简单地对输入文本抽取语义信息,未充分考虑层次结构中的标签关系。ERNIE+HLC模型在构造分类器的过程中利用层次结构中的标签层次信息,使分类结果带有原始层次信息,对比单一的ERNIE模型准确率、召回率和F1值分别提升1.77、1.85和1.82百分点。ERNIE+ GAT模型在抽取输入文本语义信息之前,先通过GAT抽取层次结构中的标签关系,其F1值达到了85.20%,对比仅构造层次标签分类器的ERNIE+HLC模型提升了1.47百分点。综合来看,GAT和HLC都对层次结构特征抽取有积极意义,因此GETHLC模型考虑融合GAT和HLC模型,同时利用层次结构原始特征和提取后的特征,实验结果表明,GETHLC模型的F1值达到了86.93%,相较于以上3种模型中最优的F1值提升了1.73百分点。该组消融实验充分体现了GETHLC模型各个模块的有效性。

3.3 分类错误样例结果与分析

为进一步分析GETHLC模型的不足,本文对层次标签分类出现的错误情况进行统计,分析可能导致错误的原因。

1)数据样本不均衡

对每个一级类别分别进行评估,得到各个一级类别的F1值如表4所示。可以发现模型的F1值在样本数充足的分类中较高,而在样本数不足的分类中较低。这表明GETHLC模型需要大量语料进行训练才能取得较好的效果,而在少量样本情况下容易出现欠拟合。为了解决这个问题,后续研究将考虑扩充较少样本的类别,使模型能够充分学习到所有标签的特征,从而提高模型的分类效果。

表4 模型在CSL数据集每个类别的分类结果Table 4 Classification results of the model for each category on the CSL dataset

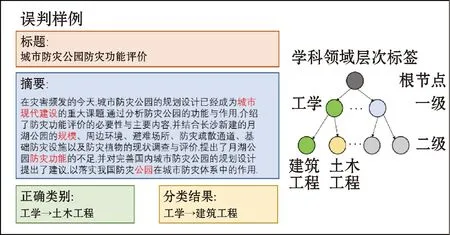

2)标签分级不合理

通过分析图5中的一个错误样例,可以发现在样本数充足的工学分类中,模型仍然可能出现分类错误。这是因为原始层次标签的分级不合理,导致标签之间具有较高的语义相似性。这使得GETHLC模型在抽取层次标签结构特征时,可能出现图注意力误导现象,忽略不同标签之间的重要信息。为了解决这个问题,后续研究将考虑引入对抗性样本来纠正此类现象,从而使模型更加准确。

图5 误判样例数据Fig.5 Misjudgment example data

4 结束语

针对学术论文的学科领域层次标签分类问题,提出了一种学术论文层次标签分类模型。首先利用图神经网络模型抽取标签的层次结构特征,接着通过ERNIE预训练模型学习文本和标签的语义信息;将这2种特征向量融合,以获得输入文本的深层次语义信息;最后,通过构建层次标签分类器,进一步提升学术论文层次标签分类模型的性能。实验结果表明,与现有几种文本分类模型相比,本文提出的GETHLC模型在层次标签分类任务的整体性能上实现了有效提升。

然而,GETHLC模型使用了多种网络进行特征融合,这使得模型的复杂度较高,参数调整较为繁琐。此外,局部模型训练效果不佳可能会导致模型整体精度下降。因此,未来的研究将关注如何通过整体训练模型参数来更高效地提高模型训练效果。同时,尽管GETHLC在学术论文这类层次信息丰富的文本上表现良好,但未来研究可以探索将其应用于其他类型的文本,以实现更广泛的适用性。