基于视觉的空投系统姿态获取及解算技术研究

吴琼,张红英,李霞

1.南京航空航天大学,江苏 南京 210016

2.天津理工大学 天津市先进机电系统设计与智能控制重点实验室,天津 300384

3.天津理工大学 国家机电工程实验教育示范中心,天津 300384

重型设备和物资的精确空投是大型军用运输机的基本能力,运输机投放辎重利用空投货台作为载体。为了实现空投货台的平稳着陆,计算空投货台实时的三轴姿态角十分重要,以避免侧翻事故的发生[1-2]。常规空投活动使用全球定位系统(GPS)和惯性测量单元(IMU)获得货物平台的位置和姿态信息。然而,在有遮挡信号的场景(如建筑物和山谷)中,GPS 信号则易丢失,不能精确定位。IMU 使用加速度计和陀螺仪长期工作,逐渐累积误差产生严重的漂移,难以提供空投货台准确的姿态信息[3-4]。利用摄像机估计空投货台降落姿态需要广泛研究,且缺乏相关的理论依据。因此,本文对利用视觉技术进行空投货台姿态估计的可行性进行了相应的研究。

随着计算机视觉的发展,基于视觉估计无人机的位姿受到了国内外学者的关注。C.Patruno等[5-6]通过级联检测识别直升机停机坪的H标志,利用曲率检测H形标志的12个角点并进行匹配,最终得到机载摄像机的三维姿态,之后在室内和室外杂乱环境下利用H 形标志的轮廓信息对飞行器位姿进行精准测量。Xu等[7-9]利用地面合作目标的实际形状和灭影线特征自主估计无人机的着陆姿态,并验证了利用线特征进行姿态估计比点特征具有更高的精度和可靠性。Yuan 等[10]为扩展旋翼无人飞行器视觉测量范围,提出分层视觉的定位方法,设计了三个着陆阶段以适应不同尺度的视觉人工目标。Wang 等[11-12]利用单目相机,使四旋翼飞行器能够在不同海况的条件下自动跟踪和降落在船舶甲板平台上,证明了视觉系统的精准性和鲁棒性。Hao 等[13]提出基于谱残差的协同目标三重约束鲁棒检测算法,使无人机在复杂环境下检测合作目标有较高的准确率。Zhang等[14]提出只需从包含5个编码标记点的单幅影像中获取姿态角,减少了相邻两帧影像求解姿态角的时间,对0°滚转角和25°俯仰角的测量精度已达到0.01°和0.04°。Fan等[15]以固定翼无人机为研究对象,用谱残差检测感兴趣区域,基于稀疏编码和空间金字塔匹配5个特征点,最后采用正交迭代估计无人机相对跑道的三轴欧拉角。P.R.Palafox 等[16]提出一种健壮的无人机自主起飞、跟踪、降落到移动平台的系统。系统基于视觉定位和高度自适应PID控制器,即一种新型高度自适应PID控制器对着陆平台进行跟踪。Andrew 等[17-18]利用机场跑道的平行线信息,通过分析跑道消影点与飞行器位姿的关系,由单幅跑道图像求解得到了飞行器的位姿信息。Cesetti 等[19]提出无人机从高分辨率航空图,寻找自然地标并利用光流进行图像匹配,最终确定无人机的导航轨迹。Tsai 等[20-21]通过Hu 不变矩识别T 形合作目标,并利用合作目标中的平行线及交点解算位姿参数。Miao 等[22-24]提出一种基于单目视觉的微小型无人机的自主着陆方法,首先利用奇异值分解(SVM)算法对合作标志进行提取,然后采用一种基于牛顿迭代的非线性优化算法用于估计无人机位置和姿态,最后将惯导数据和视觉定位数据通过自适应卡尔曼滤波进行融合。Park 等[25-28]通过地面摄像机对安装在飞行器上的 LED 灯进行拍摄,结合LED 灯的位置关系和视觉算法实现了对飞行器的位姿估计。阎峰[29]提出了一种基于立体视觉的固定翼无人机位姿测量方法,通过立体视觉重建目标无人机三维点云,基于无人机组件三维点云拟合鲁棒地完成位姿测量。

国内外学者对利用视觉估计飞行器位姿进行了很多研究,但无人机飞行高度都在50m 之内,对高空降落的飞行器位姿解算研究相对较少。由于空投系统初始空投高度过高,空投货台着陆过程是相对着陆标志从远距离到近距离的过程,目前大部分方案集中于近距离基于合作标志的飞行器着陆引导。随着距离的增加,当超出算法的有效距离,位姿估计精度就会变差,甚至不可用,所以无法沿用无人机低空视觉着陆的研究经验,不满足实际空投需求,从而成为利用视觉解算空投货台姿态技术发展的“瓶颈”。

为了解决这个问题,本文提出了一种基于视觉的方法:(1)解算空投货台的姿态,设计地面合作标记;(2)根据距地面的不同高度,识别不同的合作标记;(3)在不同降落阶段使用不同的视觉算法提取可靠的图像特征信息;(4)以准确提取特征满足空投为目标,验证视觉算法的有效性和实时性。

1 解算空投货台姿态的可视化算法

1.1 合作目标设计

本文设计了整体合作目标,包含一个中心合作目标和4个边缘合作目标,如图1 所示。可调节中心合作目标和边缘合作目标的距离,使合作目标放大,扩展了合作目标的有效拍摄距离,满足空投货台在高空的测姿要求。随着距地高度的升高,中心合作目标和边缘合作目标在采集影像中所占的像素越来越小,最终可退化成5个特征点集,也可作为地面特征为空投货台降落提供视觉参考。设计“房形”合作目标,单一合作目标形状简单,共有7 个角点,避免提取的角点数量过多影响算法运行时长,也可保证整体合作目标在距地160m 的高空可以清晰拍摄到合作目标。并且单一合作目标中有5 个角点不共线,角点位置分散,易于提取。合作目标的颜色要相对于背景突出,方便识别,故合作目标采用黑色和白色,相对于背景容易分割。

图1 合作目标示意图Fig.1 Schematic diagram of cooperation objectives

空投货台距地面合作目标之间的距离分为0~20m近地面和20~160m远地面两个阶段。利用针孔相机模型的相似三角形成像原理计算出整体合作目标和中心合作目标的尺寸,为合作目标的设计提供理论依据。

1.2 可视化算法的描述

1.2.1 图像处理总体框架

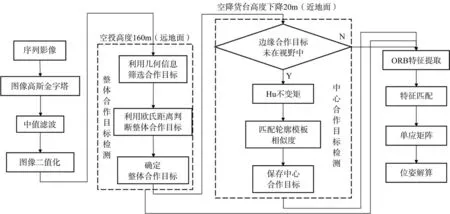

对采集得到的序列影像首先利用高斯金字塔进行压缩,减少图像处理量,再利用大津算法(Otsu)进行二值化,可适应在复杂环境下,对图像阈值的自动调节,降低背景对合作目标的干扰。最后利用中值滤波对采集影像中的噪声进行去噪,并尽可能保留影像中的边缘信息。通过空投货台的高度气压计输出的距地高度选择不同的尺度下视觉人工特征,空投货台姿态总体解算步骤如图2所示。

图2 基于视觉的空投货台姿态解算方法总体框图Fig.2 Block diagram of vision-based approach for solving the heading attitude of air-dropped cargo platform

1.2.2 整体合作目标提取

空投货台初始降至160m,高空拍摄地面合作目标在整张影像上的像素面积比过小,且存在干扰物干扰正确合作目标的筛选,利用合作目标的几何特征对干扰目标进行筛选。首先经过高斯金字塔对图像质量进行压缩,中值滤波去除影像中的噪声,再进行灰度化、二值化处理。利用拉普拉斯算子对影像边缘进行滤波,获取图像中众多的连通域,根据合作目标面积—周长比不变的固有几何性质对连通域进行筛选,再计算各候选连通域质心间的欧氏距离判定整体合作目标,可快速剔除非期望连通域。再求得包含点集最小面积的矩形,最终将矩形图像剪裁出来。

本文根据“房形”的合作标志自身面积—周长比固定不变的几何性质对候选连通域进行筛选。合作目标的具体尺寸如图3 所示。图3 中,D为中心合作目标与边缘合作目标的水平和垂直距离,la为中心合作目标长边数值,lb为中心合作目标短边数值。

图3 合作目标几何特征Fig.3 Geometric characteristics of cooperative target

1.2.3 中心合作标志提取

空投货台在降落过程中,在距地面20m 以内的范围,由于相机视场,在输出影像中无法出现完整的合作目标,出现4个边缘合作目标数量不齐或者标志不完整的情况,如图4所示。且合作目标所占影像的像素比变高,故只提取整体合作目标中的中心合作目标。

图4 中心合作目标的提取Fig.4 Extraction of central cooperation target

Hu 不变矩使得合作目标可以平移、旋转和尺度不变形,不会受到目标几何变化的影响,可准确识别不同拍摄距离下的合作目标,是衡量图像特征的区域描述子。

计算模板合作目标S1 和影像中所有连通域的Hu 不变矩,选取和模板合作目标Hu 不变矩数值相近的轮廓作为合作目标,进一步排除整体合作目标区域内的干扰噪声,筛选影像中出现的合作目标。再将所有合作目标连通域与模板进行相似度匹配,选取相似度最高和面积最大的目标作为中心合作目标。

1.3 姿态提取部分

1.3.1 合作目标特征提取与匹配

本文选择采用FAST算法来检测特征点BRIEF 算法计算一个特征点的描述子(ORB)特征提取合作目标的角点,根据ORB 提取的特征点计算二进制的鲁棒独立基本特征(BRIEF)描述子,利用相邻帧影像中的BRIEF 描述子使用汉明距离进行匹配。汉明距离是一种衡量特征距离的计算方法,即为两字符串的对应位置中不同字符的个数,计算数值越小,特征之间越相似。对上一节筛选得到的远地面整体合作目标与近地面中心合作目标进行特征点的提取和匹配,如图5所示。

图5 合作目标特征提取和匹配Fig.5 Cooperative target feature extraction and matching

1.3.2 姿态解算

姿态解算实际就是对于机载相机外参数的估计。由于空投货台处于高空俯视拍摄合作目标位置,合作目标所有特征点中必共在同一平面,则可以通过单应性进行运动估计。单应(Homography)变换,是用来描述物体在世界坐标系和像素坐标系之间的位置映射关系,假设图像I1和I2具有一对匹配良好的特征点p1和p2。在提取落在平面P上的合作目标的所有特征点时,令该平面满足以下等式

式中,n是平面P法线;d是机载摄像机到基准帧的垂直高度。基于单应关系的相对位姿估计主要包括地面法矢量计算和相对位姿解算两个过程。当世界坐标系确定后,景物平面在坐标系中的法向量一般情况下是不会发生变化的,因此在求解位姿前,对地面法向量进行计算,而地面法向量为空投货台距地面合作目标的垂直高度,该数值由机载的高度气压计测量提供。

对单应矩阵利用SVD得到旋转矩阵R和平移矩阵t,再将旋转矩阵转换成欧拉角(滚转角φ、俯仰角θ和偏航角ψ),转换关系如下

式 中,A 为cosψcosϕ;B 为sinψcosϕ;C 为-sinα;D 为cosψsinθsinϕ-sinψcosθ;E 为cosψcosθ+sinψsinϕsinθ;F 为cosϕsinθ;G 为sinψsinθ+ cosψsinϕcosθ;H 为sinψsinϕcosθ-cosψsinθ;I为cosϕcosθ。

在空投系统下降过程中货台运动剧烈,货台搭载机载摄像机需要对焦地面合作标志,为的是使拍摄特征一直保持相机的视场范围内,以防合作目标丢失。故需控制云台相机转动,使相机镜头的主点对准目标坐标系的中心。云台的转动导致视觉算法无法直接反映空投货台在世界坐标系下三轴欧拉角的数值。机载摄像机和云台固定装载在空投货台的质心处,再通过角度编码器获取云台转动的角度RT,最终和根据视觉影像解算出的姿态角Rs进行运算来获取空投货台真实的三轴姿态角Rr

2 户外试验

试验中,空投货台的初始降落高度分为160m远地面和20m近地面两部分,除验证视觉算法的有效性,还比较了视觉算法实时输出的估计值和测量真实值之间的误差。最终在“时间性能”部分讨论了视觉算法在处理时间方面的性能。

2.1 试验材料与设备

本文试验中采用大疆御Mavic Air 2无人机模拟空投货台在空投开伞后的降落过程,如图6 所示。由于目前的研究还没有完全实现视觉算法与飞控的结合,并正在进一步研究中,以下的试验过程只通过无人机采集航拍图像,然后由测试平台进行仿真试验。

图6 试验现场场景Fig.6 Experiment scene

无人机模拟空投货台降落过程中,初始降落高度在距地160m的有效距离范围内进行分析。空投货台开伞后,垂直方向的降落速度为0~2m/s的匀速运动,水平移动速度约等于当地风速。无人机将降落过程分为近地面和远地面两个阶段。根据实际合作目标材质要求,整体合作目标尺寸为10m×7.4m,中心合作目标尺寸为2m×1.5m,边缘合作目标尺寸为1m×0.7m,中心合作目标和边缘合作目标的水平和垂直距离为3m,并固定在地面上,使合作目标距地面的高度为0,确保视觉算法估计的无人机姿态角即为在世界坐标系下的真实姿态。

在无人机降落过程中,对不同降落高度进行数据统计并将试验结果记录下来。通过计算机对采集影像进行处理,计算出无人机滚转角、俯仰角和偏航角作为估计值,以机载IMU 测量的姿态角结果作为真值,并用均方根误差(RMSE)衡量观测值较真值之间的偏差

式中,i表示需处理第n帧影像;θi表示真实空投货台姿态角;θ̂i表示基于视觉算法解算的三轴姿态角;trans为欧式距离的均方根,表示视觉算法解算姿态与真实三轴姿态在当前帧影像中的误差。

在试验场景中分别进行6 组试验:3 组近地面试验和3组远地面试验。最终取3 次试验结果的RMSE 值进行平均,得到最终累计的试验误差数据,以增加试验数据的说服力。

2.2 识别合作标志有效性试验

为验证视觉算法能识别合作目标的有效性和可行性,所以设立试验进行验证。由于无人机降落过程中姿态角变化较为平稳,通过对合作目标进行不同方向、不同飞行位置的拍摄,得到具有较大几何形变和角度畸变的影像,并识别影像中出现的合作目标,合作目标识别结果如图7所示。

图7 影像中合作目标识别结果Fig.7 Cooperation target identification result

通过试验结果可以验证,设计的视觉算法对合作目标发生几何形变、角度畸变以及尺度变化是有效的和鲁棒的。

2.3 近地面的姿态估计阶段试验

近地面飞行试验的目的是验证无人机姿态估计视觉算法的有效性和精准性。近地面试验空投货台从距地高度20m处降落,飞行距离较短,垂直降落速度约为0.45m/s,相机采样频率较高。比较视觉解算姿态角和机载IMU 输出的真实姿态随时间变化规律,并计算RMSE 值,如图8所示。

图8 无人机近地面基于视觉解算出相对于地面合作目标的姿态角误差分析Fig.8 The attitude angle error analysis of UAV near ground is calculated based on visual solution

图8说明了无人机姿态误差和降落时间的关系,红色线代表基于视觉算法估计的无人机降落的实时姿态角的拟合曲线,蓝色线代表机载IMU 输出的真实值的拟合曲线。近地面降落时间45s,从距地高度20m处降落至地面。滚转角φ和俯仰角θ估计值相对于IMU 输出的真实值略有变化,偏航角ψ估计值似乎非常接近没有不规则波动的真实曲线。近地面滚转角、俯仰角和偏航角的RMSE值分别为0.856°、0.794°和0.412°,试验结果表明,本文提出的基于视觉的位姿恢复方法具有良好的性能。在近地面试验中,即使边缘合作目标未出现在相机视野范围内,不完整成像,也可识别出正确的中心合作目标,再次证明了该算法的有效性和鲁棒性。

随着无人机和地面合作目标之间的相对距离减小,中心合作目标超出机载相机的视野范围,影像中无法呈现完整的合作目标的轮廓或全部角点,此时无人机采用定点盲降完成最后阶段的自主着陆,而且高度较低时会存在一定的地面效应,因此无人机最终着陆位置会偏离标志中心。

2.4 远地面的姿态估计阶段试验

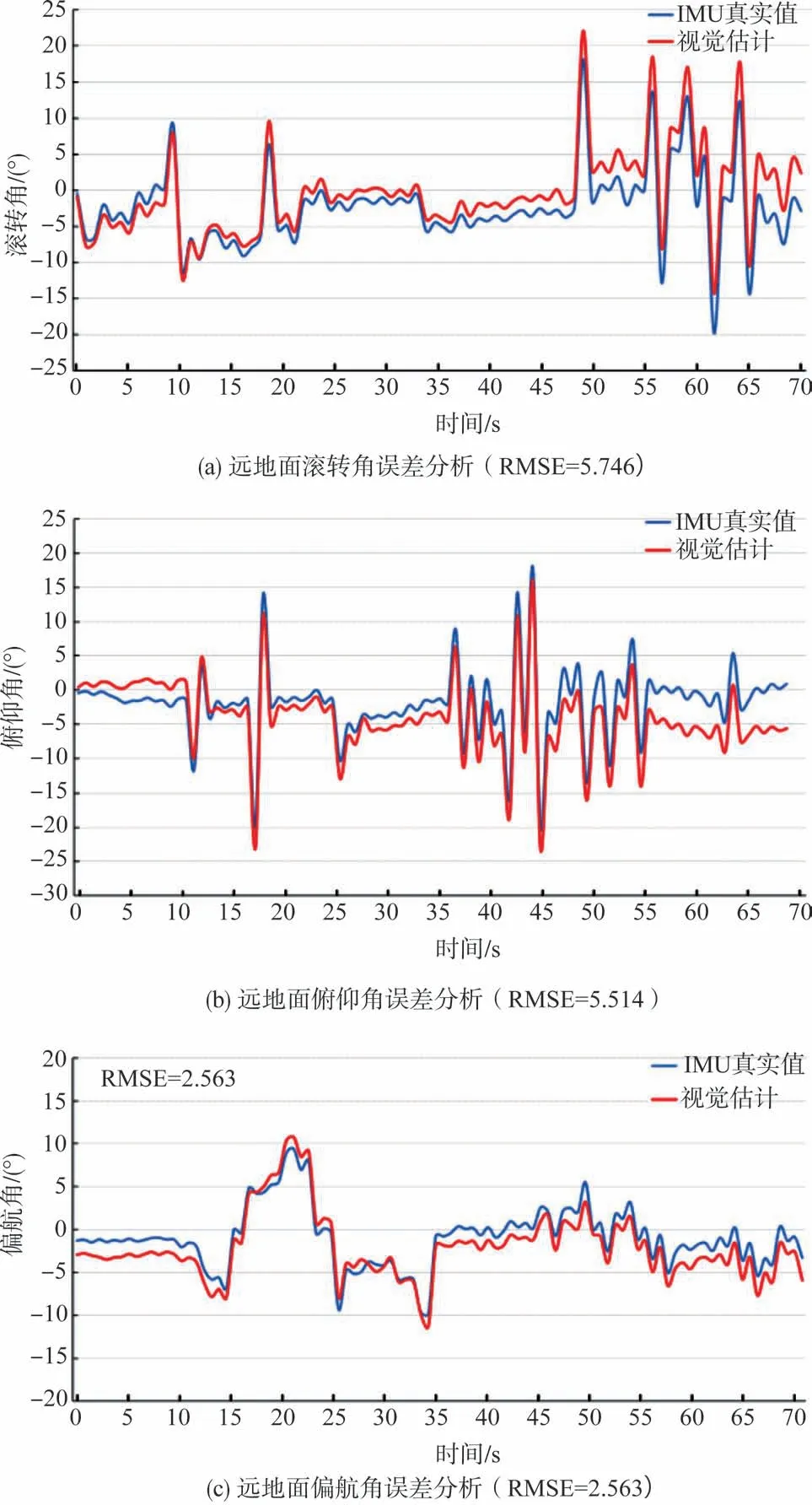

试验的目的是验证利用视觉算法对无人机进行姿态估计的可行性。远地面试验空投货台从距地高度160m 处降落,飞行距离和飞行范围较大,垂直降落速度约为2m/s,设置相机采样频率较低。利用摄像机记录降落过程中不同姿态角下的影像数据,经视觉算法分别对无人机的横滚角、俯仰角和偏航角进行估计,并计算RMSE 衡量观测值同真值之间的偏差,试验结果如图9所示。

图9 无人机远地面基于视觉解算出相对于地面合作目标的姿态角误差分析Fig.9 The attitude angle error analysis of UAV far ground is calculated based on vision solution

图9 说明了无人机姿态误差和降落时间的关系,远地面降落时间为70s,从初始降落160m 的高度降落至距地面20m处。由于空降货台初始降落高度过高,视觉估计误差较大,但随着降落高度的下降,视觉精度提高,视觉估计曲线逐渐贴合真实曲线。在远地面距地面高160m处无人机的滚转角和俯仰角的RMSE 值最大在 5.6°左右,分别为5.746°和5.514°,而无人机的偏航角的误差较小,仅为2.563°,小于滚转角和俯仰角的误差。远地面试验在复杂环境中采集影像,存在颜色相似和形状相似的干扰物体,会影响合作目标的提取,但视觉算法仍然能够识别合作目标并对姿态进行估计,再次证明了视觉算法的鲁棒性以及对外部干扰的可靠性。

远地面的平均姿态角大于近地面的姿态角的原因是采样频率较慢,两帧时间间隔较长,无人机本身的旋转角度较大。无人机高速降落或降落过程中强烈的振动使得采集得到的影像模糊,降低了图像的质量,合作目标的角点模糊。当空投的高度较高时,经过视觉算法筛选出的有效合作目标区域的像素数量占整幅影像的像素占比过少,使得合作目标中同一角点的所占像素过少,导致角点提取错误,进而导致误匹配。这些因素可能会在合作目标检测和角点提取过程中对算法产生负面影响,从而导致图像处理过程中出现故障。

通过无人机飞行仿真,验证了基于视觉的空投货台姿态解算方法的有效性。对远地面和近地面两个阶段的试验数据进行整合,统计从160m 的高空平稳降落到地面的三轴欧拉角的RMSE 值。由图10 可知,随着无人机距地面的高度下降,解算出的滚转角、俯仰角和偏航角的RMSE 减小。但视觉解算出的滚转角和俯仰角的RMSE值受距地面合作目标高度的影响更大,而对偏航角的影响较小。这一结论与试验2观察得到的结论相符。

图10 无人机降落过程相对于合作目标的不同姿态的RMSEFig.10 RMSE of different attitudes of the UAV landing process relative to the cooperative target

无人机在到达20m 的近地面后滚转角、俯仰角和偏航角均小于1°,无人机的三轴的姿态误差较为稳定,以实现较为准确的位姿估计。在近地面时,较低的RMSE 值再次证明了该算法的有效性。在给定的检测范围内,在不同高度阶段,不同的视觉算法具有不同的定位精度,姿态误差会发生不同的变化。虽然空投货台不断下降,解算位姿偏差不断下降,但随着误差的累积,解算三轴姿态的误差将出现缓慢增长。

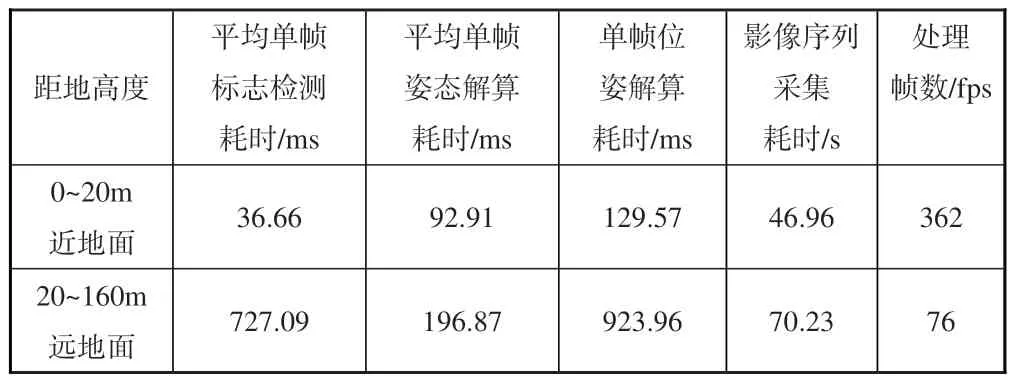

2.5 时间性能试验

为验证算法的实时性,对视觉算法的时间性能进行测试,以避免无人机失衡。分别对近地面和远地面两个阶段无人机的降落时间进行统计,算法的实时性根据单帧位姿解算时间进行衡量,见表1。

表1 两个阶段姿态估计时间性能测试Table 1 Two-stage attitude estimation time performance experiment

由表1可知,近地面阶段单帧位姿解算时间为129.57ms,可保证10帧/s的工作频率,可实时完成对无人机姿态的获取。试验已经证明,当无人机运动速度低于0.45m/s时,基于视觉解算无人机位姿方法能够确保自主降落的实时性要求。远地面阶段单帧无人机位姿解算时间为923.96ms,平均单帧影像的处理时间在1s以内,能够满足1帧/s影像采样频率。

远地面阶段单帧位姿解算耗时远远大于近地面阶段的原因有:当无人机处于远地面阶段时,采集影像分辨率为3840×2160,以保证影像中合作目标的清晰,大大增加了处理的像素数量,增大计算量,使得位姿解算时间增加。另外,距地面合作目标距离过高,采集的影像在杂乱的背景中包含许多干扰物体,从而增加了合作目标检测的处理时间,并且远地面阶段需处理中心合作目标和边缘合作目标的角点数量,而近地面则只需处理中心合作目标的角点,这也会增加姿态解算的时间。这些原因使得远地面阶段只能满足1帧/s的处理速度。

3 结束语

本文提出了一种基于单目视觉的空投货台姿态估计和自主着陆算法。该方法利用单目摄像机检测特定的合作目标,求解空投货台的三轴姿态角。将着陆过程分为近地面20m和远地面160m两个阶段,设计了不同尺度的合作目标作为不同阶段的视觉参考,这有效地提高了飞行器的降落高度。在远地面阶段,利用整体合作目标的固有几何特性,从背景中检测并估计空投货台与地面合作目标的相对位置。在近地面着陆时,采用Hu不变矩区分中心合作目标作为视觉标记,以减少图像中的特征数量,提高算法的实时性和姿态角精度。

为了说明所提出的分阶段视觉算法的性能,本文进行了室外试验和分析。试验结果表明,该算法提供了一个高精度的视觉标记姿态角。近地面相对位姿估计的最大RMSE 为0.836°,平均单帧位姿估计时间为129.57ms,综合性能指标较好。远地面相对姿态估计的最大RMSE 值为5.746°,平均姿态估计时间小于1s。虽然目前的研究只是初步的工作,但是它证明了基于视觉算法的空投货台的着陆过程中的姿态角的可行性。

未来的工作是提高视觉系统的鲁棒性,并考虑空投货台降落时遇到恶劣的天气环境(如雾霾、大雨等)。视觉算法和机载系统的控制系统的集成可以进一步提高机载着陆的可靠性和准确性。