基于人机接触压力图像的被护理人姿态识别*

宋国印,陈梦倩,郭士杰

(1.河北工业大学电气工程学院,天津 300130;2.河北工业大学省部共建电工装备可靠性与智能化国家重点实验室,天津 300130;3.河北省机器人感知与人机融合重点实验室,天津 300130)

0 引 言

移乘护理机器人可以帮助失能老人实现在床和轮椅间的转移,准确并实时地识别被护理人的姿态是保障被护理人安全性与舒适性的必要条件。不适的移乘姿态会引起被护理人的疼痛,同时易导致危险的发生,如何使护理机器人在移乘被护理人时,准确识别被护理人的姿态,是当前亟待解决的问题。

近年来,众多科研人员提出了基于视觉信息或触觉信息的被护理人姿态识别方法,并期望应用于移乘护理机器人[1,2]。视觉信息用于识别被护理人的姿态存在受视角限制以及障碍物的遮挡等问题,基于触觉信息的识别方法不存在上述问题。触觉传感器在柔性化、弹性化、透明化、可扩展性、轻量化和多功能化等方面取得显著进展[3~8],因此基于触觉信息的人机交互应用越来越广泛。Mori Y 等人[9,10]开发了一种护理机器人RIBA,采用随机森林算法,根据机器人移乘被护理人时的人机接触压力,估算被护理人腰部在床上划定的9 个区域的位置。结果表明,该方法对被护理人腰部位置的估算达到85%的准确率,但只能估算腰部1 个部位的位置。Funabora Y 等人[11]提出了一种基于触觉信息的被护理人姿态识别方法。对8名健康受试者(3名男性和5名女性)进行了实验,实验结果表明,识别腰部位置的误差为40 ~116 mm,腰角度误差在13°幅度内,但只能识别腰部的位置,识别精度不高。在基于触觉信息识别被护理人姿态领域中,实现多关节的高准确度识别是目前面临的主要挑战。

1 双臂移乘护理机器人

图1所示为本文研制的双臂移乘护理机器人,机器人利用“公主抱”方式对被护理人实现移乘。该机器人利用视觉和触觉识别手段实现对被护理人的姿态识别;具备对周围环境自主导航、主动避障的功能。通过在机器人头部安装视觉相机,在双臂和胸部安装触觉传感器实时感知双臂抱人状态,同时双臂上的触觉传感器能够采集被护理人腿部、背部与护理机器人的接触压力。运动控制和安全保障模块规划双臂抱人轨迹,完成移乘被护理人任务。

图1 双臂移乘护理机器人

2 基于多模态数据的被护理人姿态识别方法

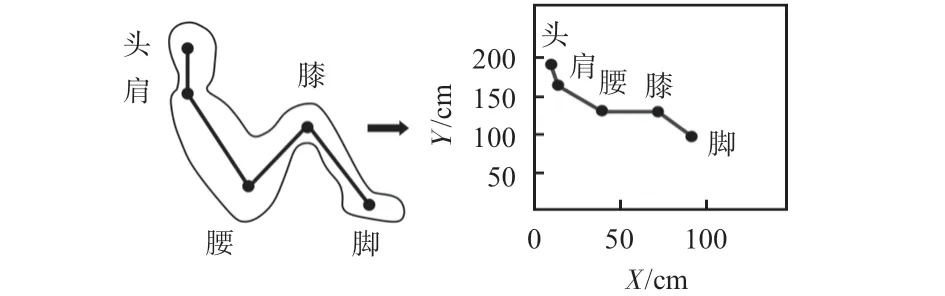

根据双臂移乘护理机器人利用双臂以“公主抱”方式转运被护理人,本文将被护理人人体模型简化为四连杆人体模型,将人体关节定义为头、肩、腰、膝和脚5 个关节点,如图2所示。

图2 关节分布

2.1 模型架构

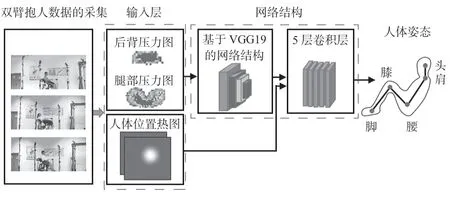

本文提出了基于多模态数据的被护理人姿态识别方法,算法流程如图3所示。首先,采集人机接触压力和被护理人姿态数据,获得网络训练需要的数据集;其次,将被护理人腿部和后背接触压力图像输入到基于VGG19 的网络结构,接触压力图像经过基于VGG19的网络结构提取特征后得到特征图;然后,将特征图与人体位置热图绑定输入到最后5层卷积层进一步优化人体关节预测结果;最后,根据网络输出结果获得含有5个关节点的被护理人姿态。

图3 被护理人姿态识别流程

CNN作为深度学习的代表,具有很强的特征提取和表达能力。文献[12]基于CNN 设计了卷积姿态机(convolution pose machine,CPM)算法,该算法利用了全卷积的网络学习图像特征和图像间的空间信息来解决姿态估计任务[13]。受此启发,基于VGG19[14]模型与CNN,设计了估算被护理人姿态的网络结构[15],如图4 所示。其中,C 代表卷积层(3 ×3为卷积尺寸),卷积层含有多个卷积核,卷积核提取图像中不同的特征,假设Xi表示第i层某一特征图的输出,其卷积的计算公式为

图4 网络结构

式中Xi-1为第i-1 层卷积层或者池化层的输出,也是第i层卷积层的输入;wi为第i层的卷积核;bi为第i层的偏移向量;fi(x)为第i层卷积层的激活函数。考虑到收敛速度和改善梯度消失问题,选用修正线性单元(rectified linear unit,ReLU)作为激活函数,函数表达如下

P代表池化层(2 ×2为池化核尺寸),池化的作用是在保持原有主要特征不丢失的前提下尽量压缩图片尺寸和精减数据维度,函数表达式为

式中Fij为输入特征图的像素值;池化域大小为n×n;设池化过程中移动步长为n,S为某一池化域池化后得到的特征值。

处理过程如下:由于后背和腿部压力图像通道数目为6,不能与VGG19 首层所需的3 通道匹配,因此在VGG19首层添加1 层卷积层(卷积核尺寸和数目均为3),经过该层卷积操作得到与VGG19首层三通道数匹配的图像I。

初中美术的情感教育是初中美术课程教学过程的重要组成部分,主要是以美术课堂的使用和教学内容为载体。课堂上贯穿着跨学科、计划和系统的思想,以及政治、美术、劳动和道德教育的渗透。通过充分尊重和培养学生的情感素质,学生将形成良好的道德观,为周围创造正面和积极的社会价值。初中美术课程中情感教育的目的是将情感教育与美术知识的学习相结合,达到提高学生美术学习效率,以及明确学习目标的目的,为学生的健康成长提供保障。

然后,将图像I输入到VGG19 网络,VGG19 网络选取前10层的初始权重进行迁移学习。图像I经过VGG19 的前10层和2层卷积层,卷积计算提取特征,得到特征图F。由于人体位置热图携带少量的特征信息,并未将其经过VGG19前10层卷积计算,而是将其与特征图F堆叠输入到最后5层卷积网络。网络的输出最后经过2 个1 ×1 的卷积层,1 ×1 的卷积层可以降低参数和通道数,类似于全连接层,输出为5 个关节热图,即5 个关节的坐标估计。Loss表达模型输出的推理值与真实值之间不一致程度,有效地加强网络反向传播能力,进行模型训练和参数更新。

基于多模态数据的被护理人姿态识别,融合了接触压力数据和人体位置数据。通过迁移VGG19 的前10 层,可高效地提取压力图像中的高维特征。人体位置热图输入到最后5层卷积层而不是与压力图一同输入网络,可减少网络训练对硬件的要求,减少计算量,加快了运算速度。

2.2 损失函数

为了预测被护理人关节位置,定义模型训练过程中的5通道真实热图truth为以真实关节位置为极值中心的5幅高斯图像,选用欧氏损失函数,计算predi与truthi的最小平方误差作为模型优化的损失函数,如式(4)

式中i为热图索引,predi为预测关节位置,truthi为实际关节位置,‖·‖为矩阵范数。

3 实验与结果

3.1 数据集的采集

本文搭建了成本低、载重达200 kg的模拟移乘护理机器人双臂的实验平台。该实验平台由上位机、运动控制卡、驱动器和伺服电机组成,实验平台的前臂和后臂分别模拟双臂移乘护理机器人的2条手臂,前臂具有2个自由度,可上下和水平运动;后臂具有1个自由度,可上下运动。

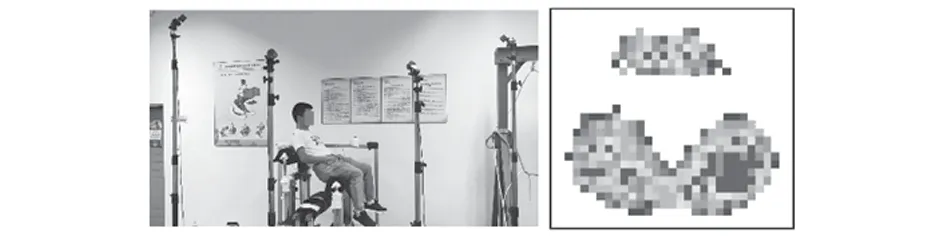

基于阵列式压力传感器和运动捕捉系统,本文设计了可实时显示并识别记录双臂抱人接触压力和被护理人姿态的采集系统,如图5 所示。压力采集系统采集双臂抱人时的人机接触压力图像,采用Tekscan 公司的阵列式结构柔性触觉压力传感器,每只传感器分布32 ×32 共1 024 个压力感应点阵列,感应点阵列表征压力变化,采集频率达到100 Hz。利用OptiTrack运动捕捉系统测量双臂抱人人体位置坐标和被护理人的关节位置坐标。采用4 台摄像机,采样频率120 Hz。

图5 实验环境的搭建

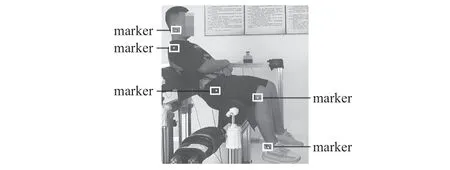

数据采集时,将2 只压力传感器分别固定放置在实验平台的双臂上,在实验平台的周边放置4 台摄像机。为了让摄像机捕捉到受试人员关节位置,需要在受试者头部、肩关节、髋关节、膝关节和踝关节粘贴标记(marker)点。粘贴marker点的受试人员模拟被护理人坐在双臂上,如图6 所示。10 s后开始采集,然后双臂开始运动,抱起受试人员,即可实现动态、实时采集被护理人姿态和接触压力图像。抱起被护理人采集1组数据,放下被护理人采集1 组数据,每组中间间隔30 s,每组坐姿要求与上一组的坐姿不同,每组采集1 200张压力图像和600帧关节位置数据,每位受试者采集5组数据。

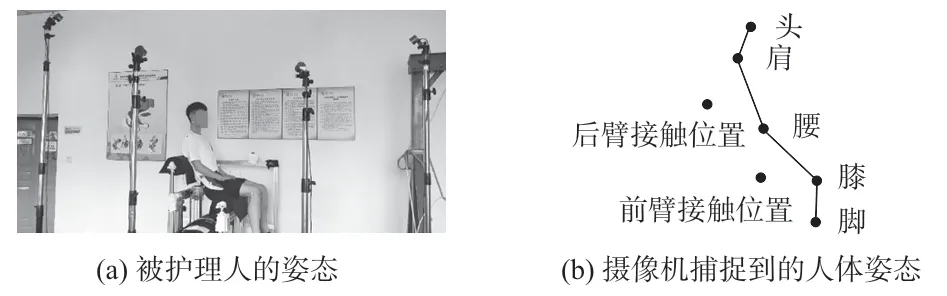

图6 移乘被护理人

采集了51名测试者双臂抱人接触压力图像和被护理人姿态数据,其中,男生46名、女生5名,测试者身高150 ~190 cm,体重为40 ~100 kg。图7 为接触压力采集实例,采集了受试者背部和腿部与双臂的接触压力。图8为采集的3名受试者部分压力图像样本,图8(a)为后背压力图像,图8(b)为腿部压力图像,受试者压力特征分布存在差别。图9为运动捕捉系统采集到的被护理人姿态和双臂抱人人体位置图像,图9(a)和图9(b)分别为被护理人姿态和摄像机捕捉到的人体姿态。

图7 接触压力采集实例

图8 部分压力图像样本

图9 OptiTrack采集的人体姿态

3.2 数据预处理

彩色图像具有R,G,B 三个通道,包含更丰富的信息,因此,将压力图像转变为彩色图进行处理与识别。在采集压力数据的过程中,受设备及周围环境的干扰,压力图像中常包含噪声,因此采用阈值法,通过设定原始压力图像的阈值从中分割出人和双臂接触区域的压力图像。针对图像中噪声引起的孤立点,会影响图片质量,进而影响姿态识别正确率。本文采用了图像形态学技术对图像中的噪声进行滤波处理,利用开运算去除图像中孤立的点,更加凸显接触压力分布特征。此外,为了提高训练速度,加速网络收敛,所有图像进行归一化处理,统一像素值在0 ~1之间的目标图像[16]。针对OptiTrack运动捕捉系统采集的双臂抱人人体位置坐标不能输入到CNN 问题,采用高斯函数,把人体位置坐标作为高斯函数的中心点坐标,生成人体位置热图,从而充分发挥CNN在图像特征提取上的优良性能。

3.3 实验结果与分析

实验采用的工作站配置如表1 所示。实验共采集了30万个实验样本,采用10 cm规则作为关节预测评估标准,采用PCKh标准作为所用方法准确度的衡量标准[17,18]。对本文方法进行评估,结果如表2所示。其中,髋和膝关节的识别准确率96. 66 %,踝关节的识别准确率最低为80.00%,平均准确率为90.00%。髋和膝关节识别准确率高是由于数据采集时,2 处关节部位不受身体其他部位的遮挡,能被所有摄像机捕捉到。踝关节在数据采集过程中易受身体其他部位的遮挡,导致摄像机某时刻捕捉不到踝关节的位置,造成数据缺失,通过OptiTrack 运动捕捉软件补点操作后,拟合的数据和真实数据存在误差,导致识别准确率低。

表1 软硬件实验平台

表2 关节识别准确度%

以1个实测关节位置数据和网络预测结果为例进行对比,如表3所示,只有肩关节1 个点的坐标识别错误,其余各点均能正确识别。虽然肩关节的位置预测错误,本文算法预测的结果与正确值的偏差仅为1.3 cm,表明该算法能够有效识别被护理人5个关节的位置坐标。为了得到被护理人姿态,首先将人体5 个关节坐标位置在运动捕捉系统坐标系下拼接,然后可视化,即可得到如图10所示结果。

图10 运动捕捉系统坐标系下被护理人2D姿态

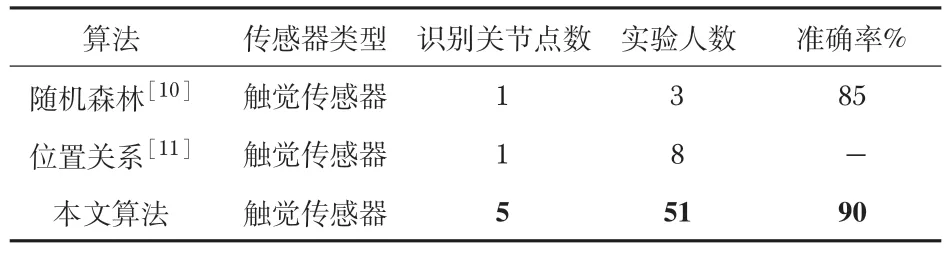

本文将实验结果与其他算法进行比较,如表4所示,文献[10,11]中被护理人姿态识别都是基于触觉传感器,但识别人体关节点数少于2,识别人体关节点数较少。文献[10]准确率高达85%,但只能识别腰部位置在事先设定的9个区域的位置,采集3个人的实验数据,实验样本数据较少。文献[11]基于位置和角度关系识别被护理人姿态,需要经过位置和角度关系的计算,计算过程复杂,最大误差为116 mm。与上述方法相比,本文识别关节点数最多,关节识别准确率达到了90%,这主要是本文采集的数据集多达30万个,数据充足且具有多样性,网络结构采用VGG19的前10层来提取特征,有效减小了误差、噪声及无效值的影响,充分提取压力图像的特征信息,融合了压力和人体位置的多模态数据,提高关节预估的准确性。

表4 3 种被护理人姿态识别算法比较

4 结 论

针对目前基于触觉信息识别人体护理姿态的方法存在识别关节点数量少及准确度低的问题,设计了一种基于多模态数据的被护理人姿态识别方法。利用触觉传感器和OptiTrack 运动捕捉系统采集了人体压力图像和被护理人姿态数据,通过基于VGG19 CNN的结构,估算双臂抱人时被护理人的姿态。实验表明:该方法的被护理人姿态识别平均准确率达到了90%。在以后的工作中将解决CNN训练耗时问题,同时融合视觉和触觉信息,提高识别准确率。