新型架构下的密集网络在肺部影像的分割研究

陈 亮,高文根,张 晨,陈 东

1.安徽工程大学 电气工程学院,安徽 芜湖 241000 2.安徽工程大学 高端装备先进感知与智能控制教育部重点实验室,安徽 芜湖 241000

1 引 言

随着计算机视觉的发展,对图片的分类、分割和检测的能力也越来越强。语义分割就是对目标图像进行理解与推断,将分割任务转化为对像素点的分类。而对肺部图像的分割就是对肺实质和肺部背景的像素点分类,突出目标肺实质区域。

肺实质的分割对肺结节检测有着至关重要的作用,尽早检测出肺结节的性质,对预防和医治肺癌都有着举足轻重的影响[1]。除了医生手动分割的方法外,还有传统机器学习方法和深度学习方法。在深度学习研究中,全卷积网络FCN(Fully Convolutional Networks)可以说是开山之作,它是由Long 等提出,开创了语义分割的解编码结构[2],该模型通过上采样和下采样对图像的每一个像素点进行分类。不过这种操作会在池化过程中丢失部分特征信息,而U-Net的提出比FCN稍晚一点,它独特的解编码和跳跃连接结构,使它在医学图像分割上有着出色的表现[3]。这也使得研究者对这种U型网络有着持续的研究。由于医学图像的数据集规模一般都比较小,难以发挥深度学习网络模型在医学图像分割领域中的优势,所以进一步改进这种U型网络使其能适应像医学图像这种小规模数据集便成了研究者们研究的方向之一。文献[4]中Res-UNet用于视网膜血管的分割,由Xiao等在2018年提出,该模型本质上就是经典的Resnet和Attention结合,残差连接在梯度传播上解决叠加层的局限性,而Attention部分属于硬注意力机制,只针对视网膜提高了关注度,而血管部分还是有所缺失。文献[5]中的Attention U-Net用于胰脏图像的分割,由Oktay等在2018年中期提出,该模型本质上就是加入软注意力机制,加大了局部ROI的权重,有效抑制无关区域的干扰。Attention U-Net中注意力机制与Res-UNet中的不同,使得Attention U-Net有着更广的应用场景,但是该模型的复杂度要更高一些。文献[6]中的U-Net++用于肝脏等医学影像的分割,由Zhou等在2019年提出,为了解决梯度消失问题利用了密集跳跃连接,深度监控有效辨别粗细粒度特征。但是该模型并没有提取到多尺度的信息,多尺度的原始特征往往因为过度矫正而无法充分利用。

上述各种改进U型模型都为四层(四次下采样),而本文提出了一种新的三层卷积神经网络模型DA-UNet,用于肺实质的分割,其中充分利用密集连接网络,且使用补偿模块的空洞空间金字塔和注意门[7-9],兼顾边缘局部和全局的特征信息,使得分割精度进一步提升,且新型三层分割网络对比于其他改进网络参数量较少,减少了不必要的算力消耗,在实验数据集上有着更佳的分割效果。

2 相关工作

2.1 架构设计依据

在医学分割领域,U-Net一直是分割效果不错的模型之一。经过一些调研,发现U-Net作者也只是凭经验设计的网络层数,并没有具体的依据和说明。所以说这些网络层数也不是一成不变的,为了保证深度学习网络的性能增益,可以根据现实需要增减,提出了两个新的约束在深度结构设计中:

第一个约束条件是对于每一卷积层,都要保证其学习更复杂模式的能力,也就是学习能力。

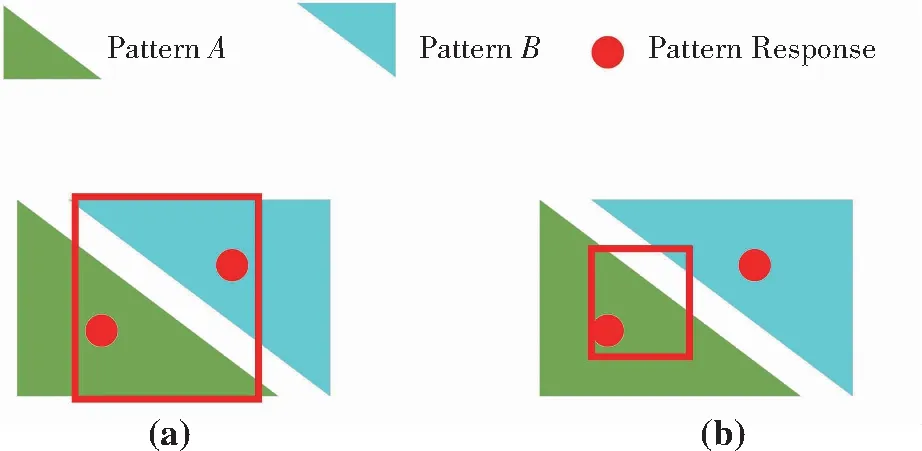

由图1可以看出,图1(a)中生成patternAB,而图1(b)中卷积层不能很好地学习到patternAB和它们的关系,因为卷积核的尺寸小于A特征与B特征响应的距离,卷积层就不能学习到较为复杂的特征。解决的办法有3种:

(1) 使用更大的卷积核;

(2) 通过下采样降低响应距离;

(3) 使用空洞卷积。

图1 卷积图Fig.1 Convolution graph

为了定量测量卷积层学习能力的大小,定义了c-value,第一个约束数学公式如下:

(1)

(2)

第二个约束条件是顶层的感受野应该不大于图像区域。卷积层的加深,感受野慢慢到达输入边界,是为了学习新的目标特征信息。但是如果感受野超过了输入图像的尺寸,容易产生过拟合,导致分割效果变差。第二个约束数学公式如下:

(3)

如式(3)所示,左边的式子是最顶层卷积层的Receptive Field,2i-1(k-1)是第i个stage每一层的Receptive Field的增量,2i-1(k-1)ai是第i个stage的Receptive Field的总增量,右边的式子图像尺寸为z。由上述可见,本文提出的DA-UNet网络结构,三次上下采样加上空洞空间金字塔ASPP,符合两个约束条件。其中的关键就是感受野的大小,输入图像中任何一个单元的感受野以外的地方都不会影响该单元的值,因此有必要仔细控制感受野,以确保它覆盖又不超过整个相关的图像区域。

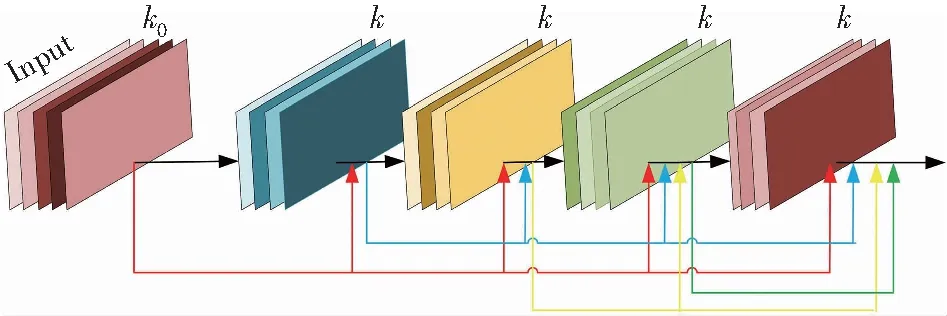

2.2 密集模块(Dense Block)

为了追求更高的准确率,自AlexNet以来,神经网络倾向于更深,更复杂的结构设计。比如上述的各种U-Net改进模型。这种卷积神经网络对肺实质的分割,就是将肺实质和肺部背景的像素点分割开来,之后对图像像素点的灰度值进行配对,凸显出完整的肺实质区域。本文所使用的密集网络主要包括密集模块和过渡层。

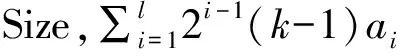

如图2所示,原本U-Net中的普通卷积在L层的输出为

XL=HL(xL-1)

图2 标准卷积Fig.2 Standard convolution

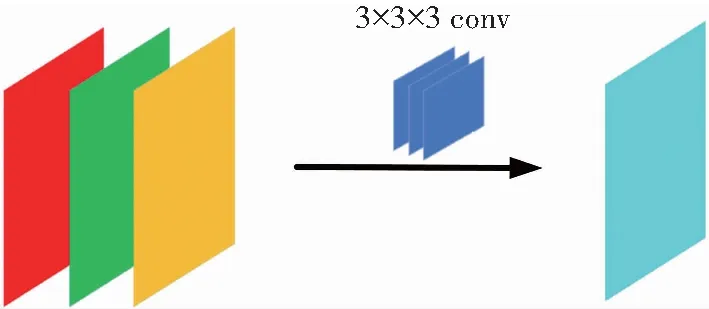

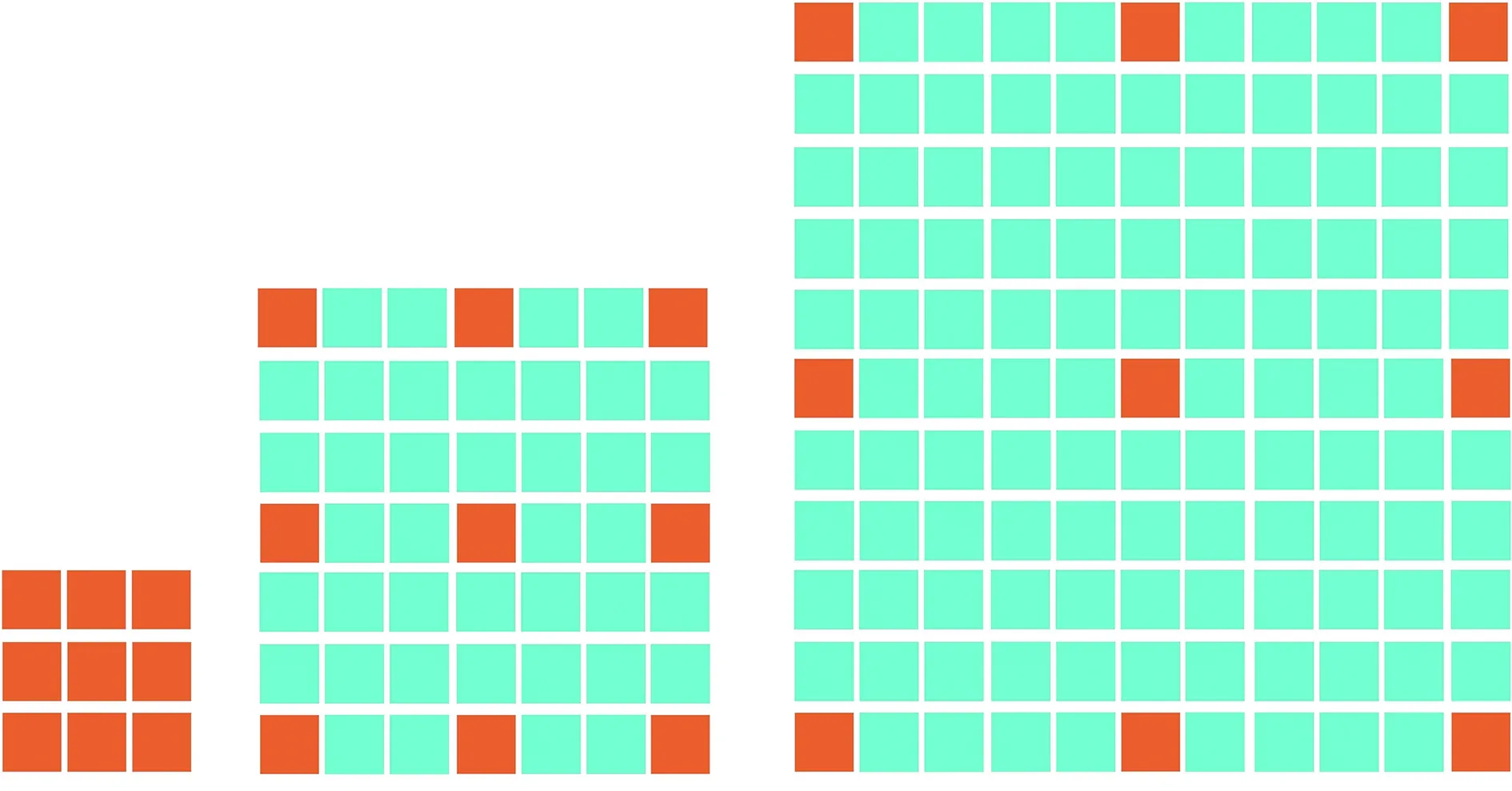

如图3所示,为了进一步改善层之间的信息流,提出了一种密集的连接模式,在Dense Block中的非线性组合函数在L层的输出为

XL=HL([x0.,x1.,x2,…,xL-1])

图3 密集模块 Fig.3 Dense module

传统的卷积是对前一层的feature maps进行处理,而Dense Block里的密集跳跃连接结构是对前面所有层feature maps的处理,在L层的输出的特征图数量公式:

KL=K0-(L-1)K

在密集模块中,早期卷积层通过信道级联连接到所有后续层。这意味着密集块中每个层的输入都是之前所有层连接在一起的输出。基本上,每个层都会根据以前层获得的“集体知识”学习其他特征图。该策略通过特征重用提高了网络的表示能力。在早期层中学习的特征将被传递,从而避免了冗余特征的学习,增强了信息流动。在Dense Block中由于后面层的输入会非常大,内部可以采用Dense neck层来减少计算量,它起到的作用是降低特征数量,提升计算效率。主要是在原有结构上增加1×1 conv,即BN+Relu+1×1 conv+BN+Relu+3×3 conv,称为Dense net-B结构。

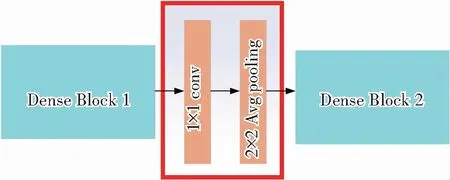

如图4所示,Transition层是连接两个Dense Block的过渡层,在此层中可以压缩图像,和传统U-Net的下采样Max pooling有一样的效果,结构为BN+Relu+1×1 conv+2×2 Avg pooling。

图4 过渡层Fig.4 Transition layer

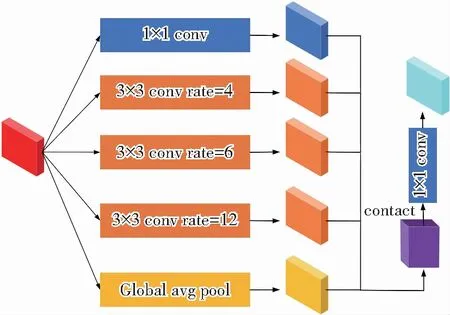

2.3 空洞空间金字塔池化(ASPP)

空洞空间金字塔池化,是由Chen等在DeepLabv3+语义分割网络中首次提出,在ASPP中最为关键的是使用了空洞卷积和深度可分离卷积的概念。深度可分离卷积就是把普通卷积的乘法运算,因式分解成先乘再相加的运算,这样可以大大减少模型所需的参数量和计算量。它的工作原理是将以往普通卷积操作同时考虑通道和区域, 改成卷积先只考虑区域,然后再考虑通道。实现了通道和区域的分离。

空洞卷积如图5所示,普通的卷积过程(dilation rate = 1),这时,3×3卷积后的感受野为3,而空洞卷积的感受野的公式为

k′=(d-1)×(k-1)+k

(3)

由式(3)可知,在图5中扩张率=1时,等同于普通的3×3卷积,而扩张率=3时,感受野为7,扩张率=5时,感受野为11。由此可以看出在相同的特征图下,更大的扩张率,可以得到更加密集的特征信息,但是也不能一味地加大膨胀系数,越大的空洞卷积所带来的网格效应也就越明显,所以必须按照实际分割的特征图大小和影像包含信息的实际情况设置空洞空间金字塔池化里扩张卷积的膨胀系数。

(a) 扩张率=1 (b) 扩张率=3 (c)扩张率=5

空洞空间金字塔如图6所示,它的工作流程是输入图像经过五次处理后再叠加在一起。第一次处理是,输入图像经过1×1×64的卷积操作,加上BN操作后得到了第一个特征图,第二次到第四次的处理是,输入图像经过3×3×64的卷积操作,不过这里的卷积操作是深度可分离卷积,可以在扩大感受野的同时减少参数量和计算量。由式(3)可知,膨胀系数分别是4,8,12的3×3空洞卷积,当膨胀系数为最大的12时,这时卷积的感受野是25,而经过三次下采样的输入图像只有32×32,此时的感受野接近又不超过整个相关的图像区域。其网络结构可表示为conv(3×3)+BN+conv(1×1)+BN +ReLU。值得注意的一点是,为了使输出的特征图大小一致,其中膨胀系数rate等于padding系数,由于边缘效应的影响(大的膨胀率下padding随之增加)所以第五次的图像处理为全局平均池化,减轻边缘效应的影响,得到有全局特征的图片。

图6 空洞空间金字塔池化Fig.6 Atrous spatial pyramid pooling

2.4 反卷积(Transposed Convolution)

在语义分割模型中,在输入图片经过池化下采样之后,需要进行与正常卷积相反的转换,将尺寸变小的图片恢复到原本输入图片一样的大小,这个过程也就是上采样。当输入图像在编码时,是将图片逐步缩小,获得不同层次的feature maps,解码时是将缩小后的图片利用反卷积操作再逐步放大。正向卷积是输入图像根据卷积核的大小,按照一定比例补0之后旋转卷积核,进行卷积操作。用矩阵公式来说,假设输入图片的像素矩阵为X,输出矩阵为Y,那么矩阵运算公式为

Y=CX

而反向卷积就是正向卷积的逆运算,用矩阵运算来说的话,就是通过C和Y得到X,这是简单的逆运算过程,所以具体的计算公式为:

X=CTX

3 整体架构

3.1 算法流程

本模型算法框架保留U-Net独特的解编码和跳跃连接操作结构,并在其结构上进行模型修剪和改进,把原本的四层上下采样,削减成三次。DA-UNet如图7所示,其中左侧为编码路径,包含三层六个Dense Block密集卷积模块和三个Transition过渡层,也就是下采样层,目的是为了通过逐步缩小特征图尺寸来学习更多语义分割信息,右侧是解码路径,也有三层六个Dense Block密集卷积模块和三个反卷积上采样模块,目的是为了恢复由下采样导致的逐步缩小特征图,并且使用了注意力解码模式(AG) 为了抑制图片中的背景像素对分割效果的影响,突出包含关键信息的目标区域。此外,“U”形网络底部的加入空洞空间金字塔(ASPP),为了解决因肺部影像中肺实质与其余组织器官的相似性,导致实际分割效果不理想,特别是图像边界的分割上的问题。

图7 整体模型Fig.7 Overall model

编码阶段:该模型有三次下采样,为了提高分割模型充分提取有用特征信息和利用上下文信息的能力,并且在不过分加深网络而导致参数量急剧增加的前提下,受Dense Net密集检测网络的启发下,使用两个Dense Block卷积模块代替原本的两次3×3普通卷积,其内部的密集跳跃连接结构可以更有效地提取和利用有效信息。而感受野的问题,受DeepLabv3+采用空间金字塔池模块提醒[10],能够通过以多种空洞卷积和多个有效视野传入特征来编码多尺度上下文信息,扩大卷积核感受野。将深度可分离卷积应用于空洞空间金字塔池模块,从而形成更快、更强的编码网络。

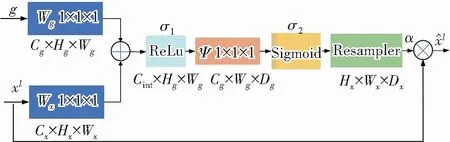

解码阶段:DA-UNet采用编解码结构进行语义分割,解码过程也就是图像恢复过程,对应三次下采样,解码部分也有三次上采样,上采样的方法是反卷积,反卷积是使用2×2的卷积,步长为2。同样的是使用两个Dense Block卷积模块代替原本两次3×3普通卷积,而为了更好地还原图像,使用了一种新的用于医学成像的注意门(AG)模型[11-13]。

可以看出,图8中g是解码阶段的高级特征图,xl为编码阶段的低级特征图,Wg是门控信号,Wx为注意门。

图8 注意力门Fig.8 Attention gate

(5)

如式(5)所示,首先g,xl都会经过1×1卷积,目的是为了保证两个特征图有同样的尺寸和通道数,然后两者相加,这时高层信息的目标区域的值会变大。再使用ReLu激活函数,经过Ψ的1×1卷积通道数变为1。

之后如式(6)所示,利用sigmoid函数和双线性插值的重采样恢复与xl相同的特征图大小,生成注意力系数表α。

(6)

3.2 损失函数(CE)

交叉熵损失Cross Entropy Loss,也叫Log Loss,最初的交叉熵公式如下所示。交叉熵损失函数值越小,两种分布越相似,交叉熵就是衡量分布的相似程度。

L(y,f(x))=-ylog(f(x))

在本文中分割出的二图片与标签图片越相似,损失函数的值越小,对于二分类问题,交叉熵损失函数如下:

4 实验结果与分析

4.1 实验材料

本文数据集采用了两种数据集,一种公共数据集是2016年LUNA肺结节检测数据集,其中包含267组双肺的原图和对应的标签图片,剔除了分割有误的图片,利用了262组图片和对应的标签图片,按照训练集验证集9∶1的比例,其中训练集是234组图片,验证集是28组图片。为了测试本模型对其他数据集的泛化能力,使用了另外一种是肝脏数据集,有398组图像及其对应的标签图像。其中320组为训练集,78组为验证集。

4.2 参数设置

本模型搭建框架是Pytorch, 用Jupyter notebook编写了相关模型代码,实验室的电脑为NVIDIA GTX3050TI,训练和验证的Bachsize为2,数据集1、数据集2的Epoch设置为80,本模型损失函数为Cross Entropy Loss,Adam优化器,学习率为0.001,并使用学习率衰减,每7轮学习率缩小90%,加快模型收敛速度。

4.3 评价指标

在图像分割任务中,分割像素的准确率(Accuracy,fACC),和分割图像与实际的标签图像的交并比(IoU),是评价分割效果的重要指标,在本文医学肺部图像分割中也采用了这两种评价指标。计算公式为:

(7)

式(7)中,GT是标签图像的分割结果,SR是三层DA-UNet模型分割结果。

(8)

式(8)中,像素点是肺实质像素也被模型判定为肺实质像素点的数量称为TP,像素点是肺实质背景像素也被模型判定为肺实质背景像素点的数量称为TN,像素点是肺实质背景像素却被模型判定为肺实质像素点的数量称为FP,像素点是肺实质像素却被模型判定为肺实质背景像素点的数量称为FN[14]。

4.4 实验结果

4.4.1 对比实验

为了证明改进模块对分割效果的提升,做了对比实验,并且使用了两种数据集,1是LUNA肺结节检测数据集,2是肝脏数据集。实验结果分别如下:

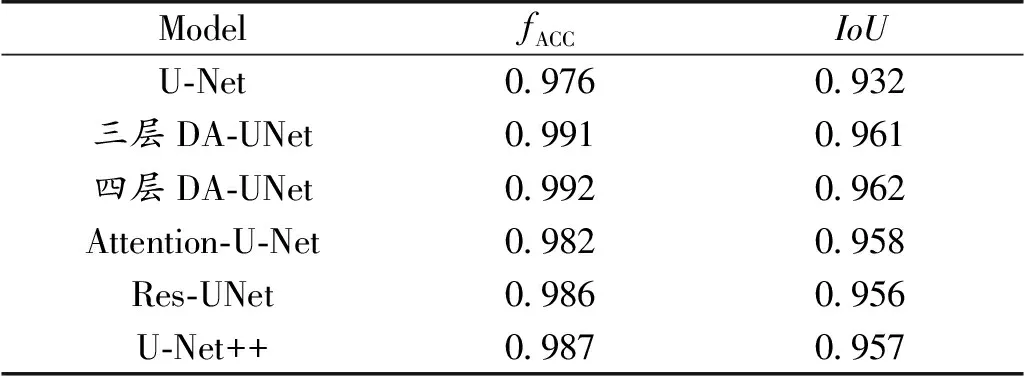

表1 数据集1验证集结果Table 1 Validation set results of dataset 1

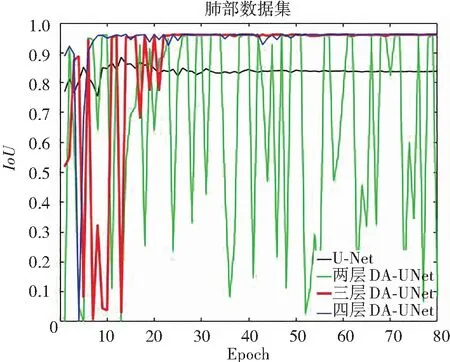

模型除了层数上的区别,还有空洞空间金字塔ASPP的膨胀系数不一样,因为根据第一小节架构设计中可知,要想模型的实验效果比较好,模型里卷积的感受野要做到接近又不超过整个相关的图像区域,二层DA-UNet经过两次下采样,最小像素是64×64,所以两层的膨胀系数是6,12,18,感受野最大为37,三层DA-UNet经过三次下采样,最小像素是32×32,所以三层的膨胀系数是6,8,12,感受野最大为25,而四层的最小像素是16×16,系数为2,4,6,感受野最大为13,避免应感受野过大带来的网络过拟合问题。如图9所示,传统U-Net和改进的DA-UNet在数据集1的验证集上运行80轮的IoU结果。

图9 数据集1 IoU结果Fig.9 IoU results of dataset 1

由表1和图9可知,三层和四层的DA-UNet的模型分割效果相差不大。本文提出三层DA-UNet模型为红线,评价指标IoU稳定在0.961左右,而黑线U-Net稳定在0.932左右。绿线是两层DA-UNet的分割结果,很明显IoU结果不稳定,难以收敛。可能的结果有几种,比如下采样次数太少,网络深度不够,前两层的卷积没有提取到足够多的高阶信息,其次使用空洞金字塔具有网格效应,再者就是Batchsize太小,无法一次性提取到太多的信息,不过因为此次实验为消融对比实验,不能考虑太多的变量,或者实验室电脑性能有限,本文就暂且不考虑这些问题,待之后解决。

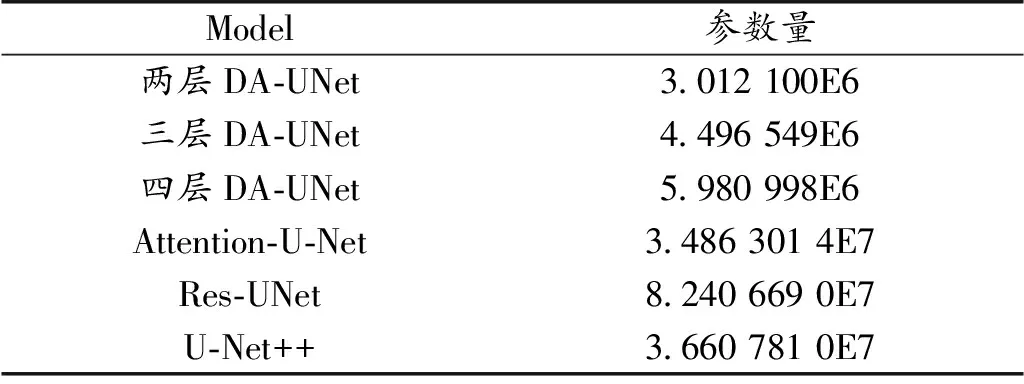

从表2可知,当输入张量为1×3×256×256时,参数量用科学计数法计数,本模型在对比各种U-Net的改进版本中,参数量都是最少的,且三层和四层的DA-UNet的参数量相差25%左右,所以出于算力消耗的方面考虑,三层的DA-UNet模型是更佳的分割网络。

表2 参数量对比结果Table 2 Comparative results of parameter volumes

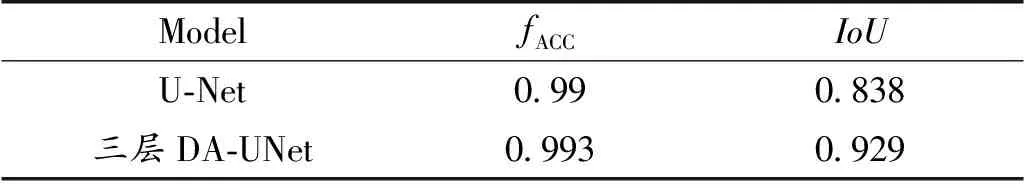

表3为肝脏图片分割,因为只是作为泛化能力验证,所以出于计算力的考虑,只做了两个模型实验。

表3 数据集1验证集结果Table 3 Validation set results of dataset 1

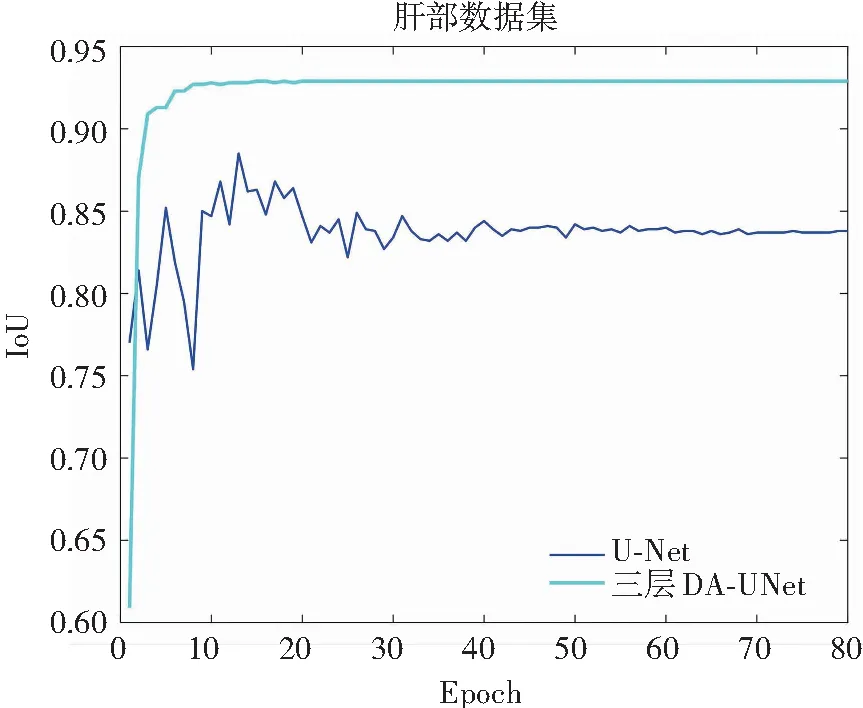

如图10所示,在泛化实验的数据集2肝脏图像分割结果中,实验经过80轮训练之后,评价指标IoU有了明显的差距,DA-UNet稳定在0.929左右,而U-Net稳定在0.838左右。

图10 数据集2 IoU结果Fig.10 IoU results of dataset 2

4.4.2 分割效果图

如图11所示,这是使用两种数据集产生的分割图,A和B是LUNA肺结节检测数据集,C和D是肝脏的数据集,A和C为传统U-Net,A中看红色框内很明显可以看出,有多处明显缺陷,特别是肺部末端都没有很好的分割,C分割图像中红色框则分割区域不完整,所以传统U-Net分割效果不够优秀。而B和D为改进的DA-UNet网络,B中在模糊边界上的分割效果还是有一定瑕疵不够平滑,同样D中也出现的同样问题。不过可以看到在整体肺实质的分割没有太大的缺陷。

图11 分割结果图Fig.11 Segmentation results

5 结 论

改进的DA-UNet网络三次上下采样的参数量只有传统四次上下采样的75.2%左右,所以出于算力消耗的方面考虑,三层的DA-UNet模型是更佳的分割网络。把解编码网络从普通的卷积网络提升为特征重用的密集卷积网络,以优化网络的特征提取能力,此网络不仅可以做到更深,并且因为Dense Block内的短的跳跃连接结构,可以解决随着网络层数增加而出现的网络退化问题。因为和跳跃连接中U-Net的简单复制拼接不同,注意门在解码操作之前被插入到编码路径提取的特征图中,以提升跳跃连接中信息融合操作的效果。此外,“U”形网络底部的Bottleneck被空洞空间金字塔(ASPP)所取代,扩大感受野,获得上下文多尺度信息,加强了对全局信息的掌握[15]。在肺部数据集实验中可以看到三层DA-UNet也就是三次下采样的DA-UNet,运行80轮之后在测试集上准确率达到了0.991,而IoU则为0.961,比起传统U-Net的评价指标IoU提升了2.9%;在泛化实验的肝脏图像中,DA-UNet的IoU稳定在0.929左右,而U-Net稳定在0.838左右。从实验结果可以看出,在两种数据集中无论是收敛速度还是稳定性,改进模型都有着不错的表现。