结合特征融合与物理校正的水下图像增强方法

王德兴,杨钰锐,袁红春,高 凯

(上海海洋大学 信息学院,上海 201306)

1 引 言

随着社会和科学的发展,有着丰富资源和众多未知生物的海洋吸引着各个国家的探索和研究[1-2]。深海环境的图像通常通过电子摄像设备获取,然而水下拍摄得到的图像存在色偏、能见度低、边缘细节缺失等严重问题。呈现色偏的主要原因是水对不同的波长的光具有不同的吸收能力。随着水深增加,红色长波最先被吸收,蓝色和绿色的短波穿透力弱,易扩散分散,因此拍摄的图像呈现了蓝绿色[3]。由于海水是一种相当复杂的混合介质,海水中分布着不均匀的悬浮物质,比如微型浮游植物和非藻类颗粒[4],所以水下图像还会呈现色彩失真、对比度低、细节特征模糊等问题。同时人工光源的使用也是造成图像低质量的重要原因之一。在现实中,水下图像具有重要的理论价值和实际应用意义[5],增强和复原低质量的水下图像是一项有价值且具有挑战性的任务。提供高质量水下图像能为海洋勘探、资源开发、海洋救援等众多工程带来工作效率的提升。

水下图像增强和复原的方法按其原理可分为3 类:基于物理模型的方法、基于物理的方法和基于的深度学习的方法。基于物理模型的方法依据物理成像模型,将水下图像增强看作是水下成像的反向问题,通过反向求解水下成像模型以复原高质量的水下图像。该方法需要依据水下成像原理、大气散射模型[6-9]等。暗通道先验[10]的提出对水下图像增强领域的研究具有重要的意义[11-12]。Xu 等人[13]提出新的基于视网膜的光估计方法。Zhou等[14]提出基于多尺度Retinex算法的色彩校正模块恢复水下图像的色偏。基于物理的方法是直接修改图像的像素值来改善水下图像的颜色和对比度。基于直方图统计的方法在细节增强方面表现出色[15-17]。Ulutas 等人[18]根据相邻元素的空间关系提出全局对比度校正和局部颜色校正模块,能够提高水下图像的视觉质量。Wang 等人[19]分析图像直方图位置关系提出了还原图像自然颜色和细节方法。融合方法被认为是一种不错的策略[20]。Zhu 等人[21]提出使用小波变换融合两张分别被经典白平衡和改进先验方法预处理过的水下图像来改善图像的自然表达的方法。Gao 等人[22]提出使用不同物理方法预处理的两张图像根据权重不同进行多尺度特征融合的方法。基于深度学习的方法依托于强大的建模工程和大量的训练数据。深度学习在图像处理和一些高级视觉任务上显示出卓越的性能,根据模型主体结构可将其进一步分为基于卷积神经网络(CNN)和基于生成对抗神经网络(GAN)的方法。Wang 等人[23]提出基于两种颜色空间的端到端的CNN 方法。Li等人[24]提出了门控融合网络方法,将3 个输入图像组合实现水下图像的增强。Li等人[25]提出基于GAN 的算法,其核心是提高整个水下图像的感知质量。Wang 等人[26]提出的基于Inception-Residual 的GAN 算法,把残差思想和Inception 模块嵌入到GAN 中去增强水下图像。

物理方法操作简单且易于应用,能够根据像素之间的位置关系和像素统计策略来恢复图像的细节,提高图像对比度和亮度,但在严重失真的图像和大量相同色偏风格的图像中很难做到。深度学习是基于大量的数据驱动并由人工神经网络研究升级得到的方法。人工神经网络通常包括反向传播的思想,能够把正向传播的结果作为反馈信息对网络的最终输出结果进行优化。在水下图像处理中,基于深度学习的方法能够灵活地学习处理多变的水下环境,泛化能力强,训练优秀的模型能够应用在相同类型的其他场景,然而模型庞大的深度学习方法需要大量的参数,对计算机配置的要求较高,因此在实际应用中受到限制。

由于单一的方法处理复杂的水下图像相对困难,受文献[26-31]的启发,为了有效提高水下图像的质量,本文提出结合轻量级特征融合网络和多颜色模型校正的水下图像增强方法。该方法采用模块化设计,可减少代码的冗余,降低方法的理解难度。在轻量级特征融合网络部分,改进的特征融合模块不仅能够更好地保护图像的空间细节特征,而且能在不降低特征信息提取能力的前提下减少模块的参数量。改进的注意力模块采用两种池化方式分别对中间特征图权重再分配,再将两个新特征图融合,既能提取重要特征纹理又能保留特征图背景信息。该部分的轻量级体现在参数量的大幅度减少。与改进前的算法相比,参数量由0.15M 减少到0.03M(减少约80%),模型训练速度提高。多颜色模型校正部分是基于物理方法对RGB 和HIS颜色空间中各颜色通道和重要参数进行校正,均衡图像颜色,最终得到色彩自然真实、质量更高的图像。本文方法不仅解决了深度学习网络的计算机高配置要求和参数量庞大等问题,还具备了神经网络的强泛化能力和物理方法增强图像细节、提高图像对比度和亮度的能力。

2 基本原理和分析

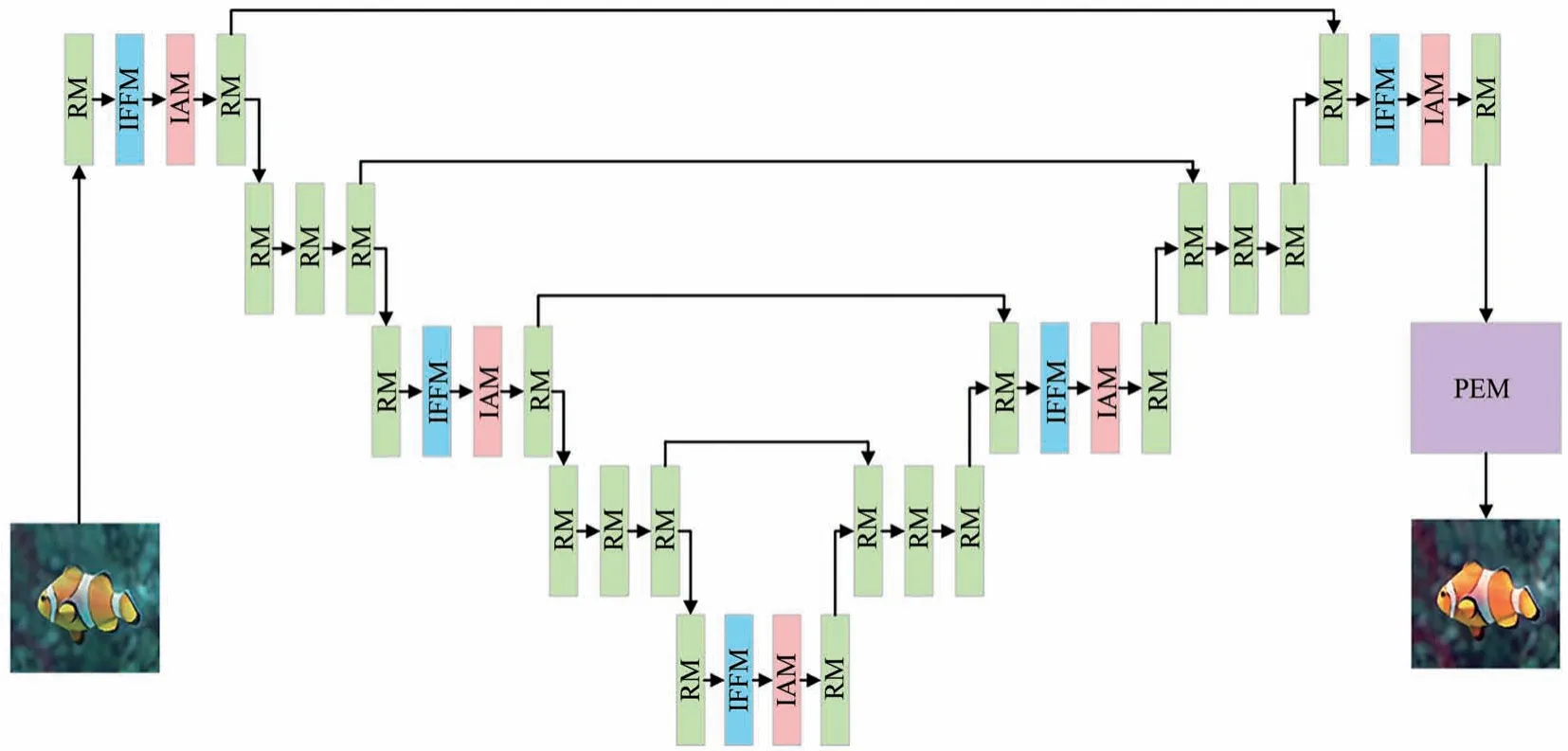

本文提出的方法由轻量级特征融合网络和多颜色模型校正两部分组成。轻量级特征融合网络部分的主体架构采用类似于U-Net 的网络模型。本文提出自构建模块代替U-Net 中的卷积层以提高网络的特征提取能力。多颜色模型校正部分在RGB 颜色模型和HIS 颜色模型中通过拉伸像素值和重要参数的范围来实现对图像质量的提升。总体架构图如图1 所示。

图1 网络总体架构Fig.1 Overall network architecture

本文设计4 种类型的自构建模块,包括改进的特征融合模块(Improved Feature Fusion Module,IFFM)、残差模块(Residual Module,RM)、改进的注意力模块(Improved Attention Module,IAM)和物理增强模块(Physical Enhancement Module,PEM)。按照自构建模块的组合顺序的不同,将其组合成4 种类型,共计10 个局部块。前9 个局部块属于轻量级特征融合网络,第10 个局部块属于多颜色模型校正。按从左到右的顺序,第1、3、5、7 和第9 个局部块是按照RM、IFFM、IAM 和RM 的顺序连接而成,第2、4、6 和第8 个局部块由3 个RM连续拼接而成,第10个局部块是单独的PEM。

2.1 改进的特征融合模块

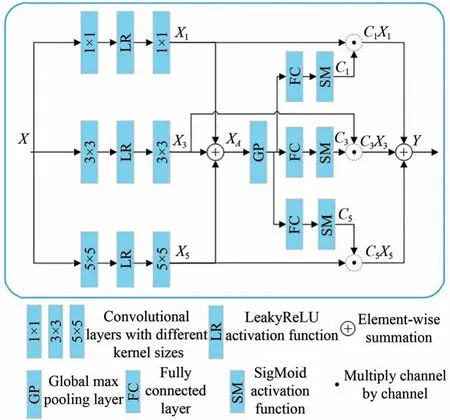

传统U-Net 网络的卷积层通过上采样和下采样的方式实现。但是上采样计算量和参数量呈正相关,参数量越多计算量越大;下采样方法会因为参数量少而丢失特征图中某些重要的信息。为了解决上述问题,提出了改进的特征融合模块来代替卷积层。该模块采用不同大小卷积核生成不同比例的特征图,再与相匹配的通道特征融合得到具有多尺度语义信息的特征图。特征融合能够减轻多层网络的训练难度,提高网络的鲁棒性和准确性。与改进前的模块相比,模块中使用SigMoid 激活函数代替全连接层,一方面降低全连接层对图像空间结构的破坏程度,更好地保护图像空间特征,保留了更多的细节纹理;另一方面减少模块中的训练参数量,加快训练速度。模块结构如图2 所示。

图2 改进的特征融合模块Fig.2 Improved feature fusion module

该模块将输入的特征图X变换为特征图Y,实现多尺度的语义信息特征的提取。在该模块中,首先分别用1×1、3×3 和5×5 的卷积核对特征图X进行卷积运算,然后经过激活函数,最后再使用同样大小的卷积核再次卷积运算,得到3 种不同尺度的特征图Xi,Xi的计算如式(1)所示:

其中:i∈(1,3,5),Convi×i表示使用i×i大小的卷积核进行的卷积运算,LR 表示 LeakyReLU 激活函数。使用逐元素求和的方式将特征图X1、X3和X5融合为XA,XA的计算方式如式(2)所示:

式中,+表示逐元素求和计算。对特征图XA使用全局最大池化和全连接层计算,再由函数激活获得张量Ci。其计算公式如式(3)所示:

其中:i∈(1,3,5),公式(3)可得到自适应选择的通道张量C1、C3和C5,GP 为全局最大池化计算,FC 为全连接计算,SM 为SigMoid 激活函数。最终该模块输出的特征图Y是由特征图Xi与之相适应的Ci逐通道相乘再融合得到:

其中:Y是该模块最终输出的特征图,·表示逐通道相乘操作,+表示特征图逐元素求和。

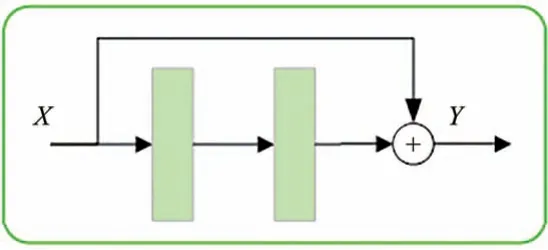

2.2 残差模块

残差模块不仅能够解决深度神经网络退化问题而且还能加快其收敛速度,保持数据保真度[32],学习更深层次的特征。模块结构如图3 所示。

图3 残差模块Fig.3 Residual module

图中X为输入的特征图,Y为输出的特征图。Y的计算公式如式(5)所示:

式中使用两个卷积层Conv 对特征图X卷积运算,然后再与X逐元素相加得到Y。

2.3 改进的注意力模型

注意力机制是对权重资源重新分配的机制,将原本平均分配的资源根据注意力对象的程度高低实现再分配。在该模块中,使用两种池化策略关注图像在通道方面的权重分配,首先使用具有不同池化效果的分支对该模块的输入特征图计算,然后将两个分支得到的中间特征图融合,最后融合图像与该模块的输入特征图逐元素相乘得到包含有重要信息特征的输出特征图。图4是改进的注意力模型。

图4 改进的注意力模型Fig.4 Improved attention module

该模块的输入特征图为X,输出的特征图是Y。第一个分支对特征图采用全局最大池化计算,全局最大池化能够提取特征纹理,减少无用信息的影响,然后对16 通道的特征图进行卷积映射为4 通道的特征图,并由激活函数激活重要特征,最后再将4 通道特征图转换为16 通道特征图得到Sh。另一个分支是采用全局平均池化计算,全局平均池化能够保留背景信息,减少过拟合现象,后续操作同第一分支一样,得到Bh。Sh和Bh的计算公式如式(6)所示:

式中:MP 为全局最大池化计算,AP 为全局平均池化计 算,Conv 为1×1 大小的 卷积层,LR 为LeakyReLU 激活函数。最终输出的特征图Y是由Sh和Bh逐元素相加后与特征图X逐元素相乘得到。特征图Y的计算公式如式(7)所示:

其中:+表示逐元素求和计算,SM 是SigMoid 激活函数,⊗表示逐元素相乘操作。

2.4 物理增强模块

特征融合网络在RGB 颜色空间中能够解决纹理细节不足、背景色偏不能还原等问题,但也会伴随有色彩不均衡、对比度低等问题,因此设计物理增强模块解决这个问题。首先在RGB 颜色模型中对各颜色通道做颜色均衡化,对各颜色通道的像素在合适范围调整来增加对比度。由于RGB颜色空间不能直接反应一些重要参数,如饱和度、色调和亮度,因此需要将图像再转换到HIS 颜色模型并对这些参数进行校正,以进一步增强图像的自然表现力。在该模块中,分别使用RGB 和HIS 颜色模型对各颜色通道、亮度和饱和度在适度的范围内拉伸以达到增强图像效果的目的。物理增强模块的流程图如图5 所示。

图5 物理增强模块的流程图Fig.5 Flowchart of the physical enhancement module

输入图像后,首先进行RGB 颜色均衡化处理,其次判断图像的主色偏是否为绿色。如果为绿色,则进行绿色通道单边校正和蓝色通道双边校正,否则进行蓝色通道单边校正和绿色通道双边校正,然后对图像的红色通道单边校正,最后在HIS 颜色模型中对饱和度和亮度进行双边校正并输出图像。

2.4.1 RGB 颜色均衡化

水下图像的主色偏通常为绿色或者蓝色两类。经过上一步特征融合网络的处理能够解决大部分的色偏,可能还会留有轻微色偏问题,这一步可对图像颜色做均衡化,消除轻微色偏。首先计算图像在RGB 模型中各个颜色通道中像素最大值Rmax、Gmax和Bmax,三者中值最大就代表该图像的色偏通道。其计算公式如式(8)所示:

其中:输入图像X的尺寸为M×N,i∈(0,M),j∈(0,N),(i,j)为图像的像素点位置坐标,IR(i,j)、IG(i,j)和IB(i,j)分别代表图像的红色通道像素值、绿色通道像素值和蓝色通道像素值。

本文以绿色为图像的主色偏为例详细描述均衡化计算过程。保持主色偏通道不变,需要调整蓝色和红色通道的像素值使图像颜色均衡,因此需要计算基于主色偏在其他两个颜色通道的增益因子。首先计算三颜色通道上像素值的平均值,计算公式如式(9)所示:

其中:IR(i,j)、IG(i,j)和IB(i,j)分别代表图像在各颜色通道(i,j)位置的像素值,Ravg、Gavg和Bavg表示红绿蓝三颜色通道上像素值的平均值。增益因子是基于3 个像素平均值得到:

其中:a表示红色通道的增益因子,b表示蓝色通道增益因子。新的蓝色和绿色通道的像素值由乘数来确定,由公式(11)计算得出:

其中:R和B为原来图像的红色和蓝色像素值,R*和B*是图像均衡化后的红色和蓝色像素值。

2.4.2 RGB 颜色模型对比度校正

整体颜色做均衡化能解决轻微色偏问题,图像的对比度需要进一步增强。这一部分主要是在RGB 颜色模型中采用拉伸强度值范围的方式校正对比度。

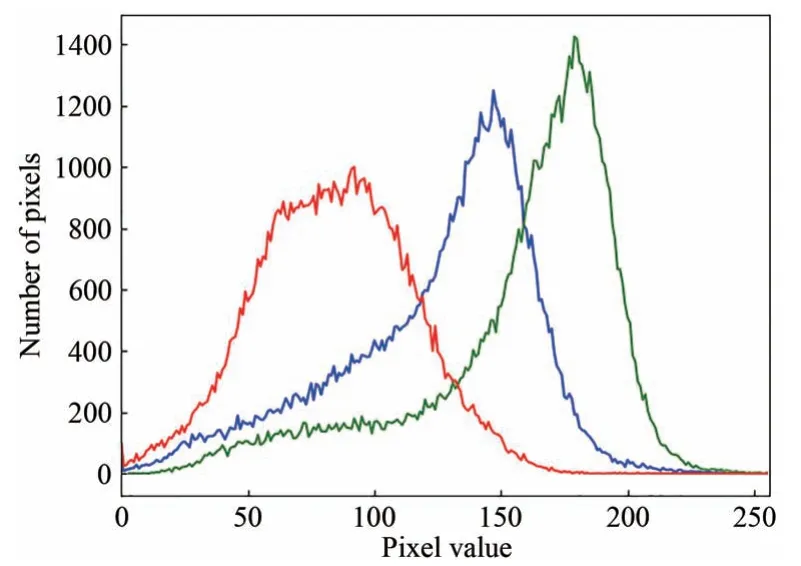

RGB 颜色模型中各颜色通道的像素取值范围为0~255,统计各个颜色通道的不同像素值出现的次数并画出像素分布折线图,如图6 所示。图6 中横坐标表示像素点的像素值,纵坐标表示像素点个数,其中红色折线代表红色通道,蓝色代表蓝色通道,绿色代表绿色通道。

图6 RGB 像素分布折线图Fig.6 RGB pixel distribution line diagram

对比度的增强采用拉伸特定范围内的像素值实现。该方法先确定拉伸后图像的上下限,通常用归一化的方式确定折线图中的最小和最大像素值,将不同通道的像素点按照值从小到大排序,在排序后的两端分别舍弃总像素点总数的0.2%的像素点,仅保留中间的0.2%~99.8%的像素点。图7 是绿色通道标有裁剪点像素分布的折线图。

图7 绿色通道的像素分布折线图Fig.7 Pixel distribution line diagram of the green channel

通常过高或者过低的像素值会严重影响图像的质量,导致不具代表性的缩放,因此图7 中标注lower_limit 箭头所指左边的所有点都将被舍弃,upper_limit 右侧的点也将舍弃,仅选在0.2%和99.8%范围内的像素点,并将其应用在校正公式中,对图像分3 个步骤进行校正。校正公式如式(12)所示:

其中:Po是对比度校正后图像的像素值;Pi为参考像素值;a表示下限值,其最小为0;b是上限值,其最大为255;c表示当前颜色通道中最小像素值;d表示当前颜色通道中最大像素值。

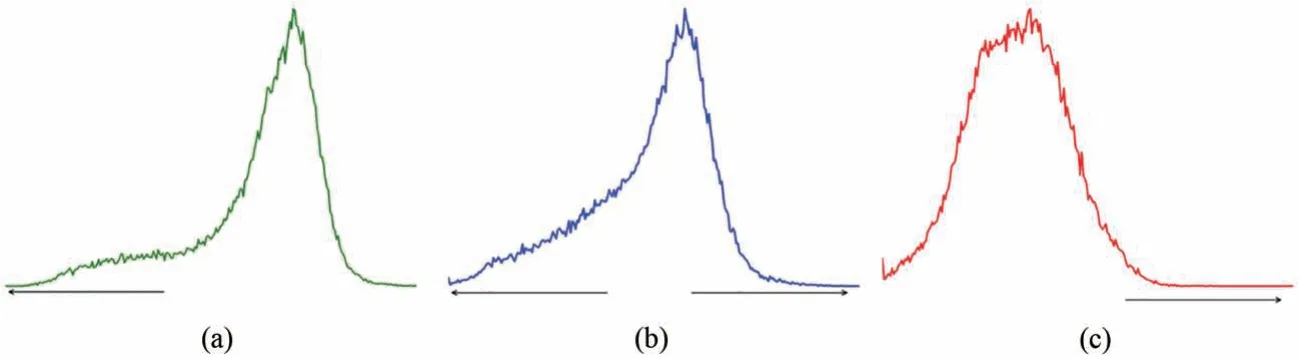

如果颜色均衡化时确定主色偏为绿色,那么第一步进行绿色的单边校正,第二步进行蓝色双边校正,第三步进行红色单边校正。否则按照蓝色单边校正,绿色双边校正,红色单边校正的顺序校正。以绿色色偏为例,各颜色通道校正方式和方向如图8 所示。

图8 各颜色通道像素分布图。(a)绿色通道像素分布图;(b)蓝色通道像素分布图;(c)红色通道像素分布图。Fig.8 Pixel distribution of each color channel.(a)Green channel pixel distribution map;(b)Blue channel pixel distribution map;(c)Red channel pixel distribution map.

第一步,图8(a)为绿色通道像素分布图,校正方式为单边校正,校正方向是朝向像素值最小侧,通过向像素值最小侧来解决偏绿问题,校正公式如式(13)所示:

公式(13)与公式(12)对比,b为Gup,Gup代表绿色通道中upper_limit 指向的像素点的像素值,该像素值作为上限。a为0,把0 作为下限。c为Min 表示当前图像中最小像素值。d为Max,表示当前图像中最大像素值。

第二步,图8(b)为蓝色通道像素分布图,校正方式为双边校正,朝向像素值最大和最小两侧。校正公式如式(14)所示:

公式(14)与公式(12)对比,b为255,255 作为蓝色像素值的上限代表蓝色通道的最大像素值。a为0,0 作为蓝色像素值的下限。c为Min 表示当前图像中最小像素值。d为Max,表示当前图像中最大像素值。

第三步,图8(c)为红色通道像素分布图,校正方式为单边校正,校正方向是朝向像素值最大侧。校正公式如式(15)所示:

该公式与公式(12)对比,b为255,因为要向像素值最大侧拉伸,把255 作为上限。a为Rlo,Rlo代表红色通道中lower_limit 指向的像素点的像素值,该像素值作为下限。c为Min 表示当前图像中最小像素值。d为Max,表示当前图像中最大像素值。

2.4.3 HIS 颜色模型

将图像的RGB 颜色模型转换为HIS 颜色模型,在HIS 颜色模型中继续提高图像的质量。HIS 颜色模型即色调(H)、饱和度(S)和亮度(I),色调是纯色成分,饱和度是颜色的纯正度,亮度是照明成分[25]。对饱和度和亮度两个参数用校正公式(12)来获得新的值,校正方向朝向亮度暗侧和亮侧两个方向,这种调整有助于具体的数据分布图更好地扩展到两个方向,使其可见度增大且更加清晰。

本文方法在轻量级特征融合网络部分,因为主体架构与U-NET 网络相似,所以前5 个局部块充当的特征提取器的编码器部分,第6 到第9个局部块是融合信息重建清晰图像的解码器部分。原始水下图像通过该网络能够提升图像的质量,既能够解决水下图像色偏的主要问题,又能够不破坏图像空间结构,尽可能多地保留图像的纹理细节。水下图像增强不同于高级机器视觉任务,如目标检测、目标识别等,因此不需要高维度的信息特征,故减少卷积中的通道数能减少特征融合网络的训练时间,同时也能降低网络的复杂性。该网络把相邻两个模块间的通道设置为16,再加上对特征融合模块的改进,因此特征融合网络的参数量进一步地减少,由0.15M 减小到0.03M,约减少了80%。在多颜色模型校正部分,对前一部分的图像先进行颜色均衡化处理,然后在适度的范围内拉伸RGB 颜色模型中各个颜色通道和HIS 颜色模型中饱和度和亮度参数,最后得到自然清晰、色彩丰富的无色偏图像。

3 实验结果及分析

3.1 实验环境

所有实验均使用PyCharm 编译器,运行在Win10 PC,AMD Ryzen Threadripper 1950X 16-Core Processor 3.40 GHz 处理器,NVIDIA GeForce GTX 1080Ti GPU,使 用Tensorflow1.4 作为深度学习框架。输入图像大小为256×256 像素值,优化器选用Adam 优化器,学习速率设为0.01,批量大小设置为5,训练周期设置为100。

因为现实世界中获取真实的水下图像的高质量的参考图像是困难的,因此Islam 等人[33]提出了真实世界水下图像及可参考的高质量图像的数据集EUVP。从该数据集中组合选用3 235 组成对的水下生物图像,其中一张是具有偏色、低对比度和雾状效果等问题的水下真实图像,另一张是可供参考的图像,该图像是利用域迁移技术CycleGAN 方法获得的具有参考意义的低色偏的高质量图像。本文将3 235 组图像分成训练集和A 组测试集。训练集包含3 150 组图像,用于本文方法训练出模型;A 测试集有85 组图像,用于模型的测试。数据集EUVP 中包含了无参考的真实水下图像。为了验证方法的泛化性和有效性,从中随机选出350 张用作B 组测试数据,测试数据中包含了水下生物和水下环境等内容。

在评价指标方面,水下图像增强的目的是直观地改善图像的颜色,去除色偏,增强对比度,提高整体的视觉效果。根据有无参考图像,本文采用两套指标对本文算法进行客观评价。

A 组测试数据包含可参考的图像,因此采用全参考图像质量评估:计算预测图像和参考图像各个通道的像素位置的标准均方根误差检验值(NRMSE),NRMSE 的值越小代表两张图像在同一像素点的值越接近,即空间细节信息越相似;峰值信噪比(PSNR)是最常用的用于反应图像是否失真的客观评价指标,PSNR 的值越大表示图像的质量越好,失真度越小;结构相似性(SSIM)衡量增强后的图像和可供参考的图像在亮度、结构和相似度方面的差异,其值越大代表增强后的图像与参考图像越相似。

由于B 组测试集是无参考图像的水下图像,采用无参考的水下图像度量评估:水下彩色图像质量度量(UCIQE)表示图像在色度、亮度和饱和度3 方面的平衡程度,其值越大图像质量越高;信息熵(IE)表示图像信息丰富程度的度量,信息越丰富的图像则该值越高;自然图像质量评价器(NIQE)表示图像中观察到的信息是否自然,该值越低代表图像整体表现更自然。

3.2 消融实验

为了验证所提出方法的可行性和创新性,本文设计了消融实验来证明:第一个实验仅使用特征融合网络增强水下图像;第二个实验把原始水下图像只进行多颜色模型校正方法增强;第三个实验使用特征融合网络和多颜色模型校正相结合的方法。3 个实验均在A 组测试数据上进行,最后对实验增强后的结果进行定性和定量的分析。实验结果部分图像展示如图9 所示。

图9 消融实验定性比较。(a)水下图像;(b)第一个实验;(c)第二个实验;(d)第三个实验;(e)参考图像。Fig.9 Qualitative comparison of ablation experiments.(a)Underwater image;(b)First experiment;(c)Second experiment;(d)Third experiment;(e)Reference image.

首先对图9 的实验结果做定性分析。第一个实验的结果显示,增强后的水下图像本身存在的色偏问题得到解决,可以消除图像中大部分区域的色偏,图像纹理和细节较大程度上得到了保留。但是增强后的图像存在明显的模糊感,整体的亮度和对比度表现不佳。第二个实验的结果显示,校正后的水下图像在对比度和亮度方面得到很大的提升,但是对水下图像存在的色偏问题没有得到完全解决。第三组实验的结果显示,增强后的图像色偏问题被解决,整体色彩显示与参考图像一致;图像的对比度、饱和度和亮度方面的视觉呈现更好,图像表现清晰自然,色彩丰富。

定量分析结果如表1 所示。通过数据分析,第3 个实验在NRMSE 取得的平均值为0.203 6,小于前两个实验结果,说明第三个实验得到的增强图像和参考图像在像素位置关系上相似,空间细节信息更接近。PSNR 和SSIM 的均值分别是22.140 7 和0.797 8,数值上都超过前两个实验,说明增强后的水下图像在亮度、结构和相似度方面与参考图像更相似,细节纹理方面表现得更好。UCIQE、IE 和NIQE 分别取得0.479 1、7.381 9 和13.121 3 的平均值,均优于前两组实验,说明本文方法增强后的图像包含的信息更丰富,图像质量更高,图像表现更自然。

表1 消融实验数据表Tab.1 Ablation experiment data table

无论是主观分析还是客观分析,第三个实验结果要优于前两个实验结果,说明本文提出的特征融合网络和多颜色模型校正相结合的方法是可行的且具有创新性,能够更好地解决水下图像出现的严重色偏、对比度低等质量问题。

3.3 实验对比

本文提出的图像增强方法与现有的水下图像增强方法做对比分析,对比方法包括基于物理模型的方法(UDCP[12])、基于物理的方法(DBFusion[21])和 基于深度学习的方法(Water-Net[24],Global-Local Net[2],Ucolor[25],LAFFNet[27])。具 体实验操作如下:首先分别在A 组测试集和B 组测试集中对水下图像做增强处理,然后将各方法的实验结果进行定性和定量的分析,最后对各方法的复杂度进行比较。

3.3.1 A 组测试集对比实验

图10为含有参考图像的A 组测试集定性分析对比图,图10(a)显示了具有偏色、低对比度、模糊和噪音的水下退化图像,图10(b~h)展示了7 种比较方法的增强水下图像后的效果图,图10(i)是提供的高质量的参考图像。图10(b)是UDCP增强结果,该方法不能还原图像,没有解决最基本的色偏问题,反而加重了绿色色偏,另外整体颜色表现暗淡。图10(c)是Water-Net 方法增强结果,该方法能够对水下图像的色偏进行校正,清晰度有所提升,但是与给出的参考图像相比,表现出轻微暗色调,亮度和饱和度敏感度低。图10(d)是DBFusion 方法,其增强结果和UDCP 相似,不仅没有对色偏进行校正,而且对比度表现得也不佳,整体色彩表现暗淡无光,细节表达欠缺。从Global-Local Net的结果(图10(e))来看,虽然有效地改善了水下图像的色偏问题,但是图像部分区域色调偏白,过度曝光显得图像不够自然。与提供的参考图像对比,图像亮度仅在部分区域得到提升。图10(f)为Ucolor 方法的结果,其能够有效改善水下图像的色偏问题,对比度也有所提升,但是亮度方面仅在部分区域提升,与参考图像相比,整体图像的色调偏白,增加了图像的模糊感。图10(g)为LAFFNet 方法的结果,图像整体得到了改善,能够解决基本的色偏问题,但是部分图像表层出现了类似黄色烟雾,严重影响到视觉体验。图10(h)为本文提出方法的结果,一方面能够解决水下图像色偏问题,整体色调更加接近提供的参考图像;另一方面整体保持颜色丰富,增强了对比度和亮度,色彩自然丰富,纹理细节清晰,进一步提升了图像视觉感知,更接近于真实的参考图像。

图10 A 组测试集上不同方法的定性比较。(a)水下图像;(b)UDCP;(c)Water-Net;(d)DBFusion;(e)Global-Local Net;(f)Ucolor;(g)LAFFNet;(h)本文方法;(i)参考图像。Fig.10 Qualitative comparison of different methods in group A test set.(a)Underwater image;(b)UDCP;(c)Water-Net;(d)DBFusion;(e)Global-Local Net;(f)Ucolor;(g)LAFFNet;(h)Our method;(i)Reference images.

为了客观分析各个方法在A 组测试集的表现,采用全参考评价指标对增强后的图像进行定量分析,7 种方法的定量分析结果如表2 所示。从表2 可以看出,本文提出的方法在3 个评价指标的平均值上均优于其他的对比算法,其中NRMSE的平均值为0.203 6,说明本文方法的增强效果在像素级别上接近真实参考的图像。PSNR 的均值为22.140 9,说明本文方法失真更少,图像质量更好。SSIM 取得0.797 9,表示输出图像在细节和纹理上更接近参考图像,在图像结构层面上与参考图像更相似。3 个指标的表现说明本文提出的方法增强后的图像质量更好且更接近于参考图像。

表2 A 组测试集增强图像的指标对比Tab.2 Index comparison of enhanced images in group A test set

3.3.2 B 组测试集对比实验

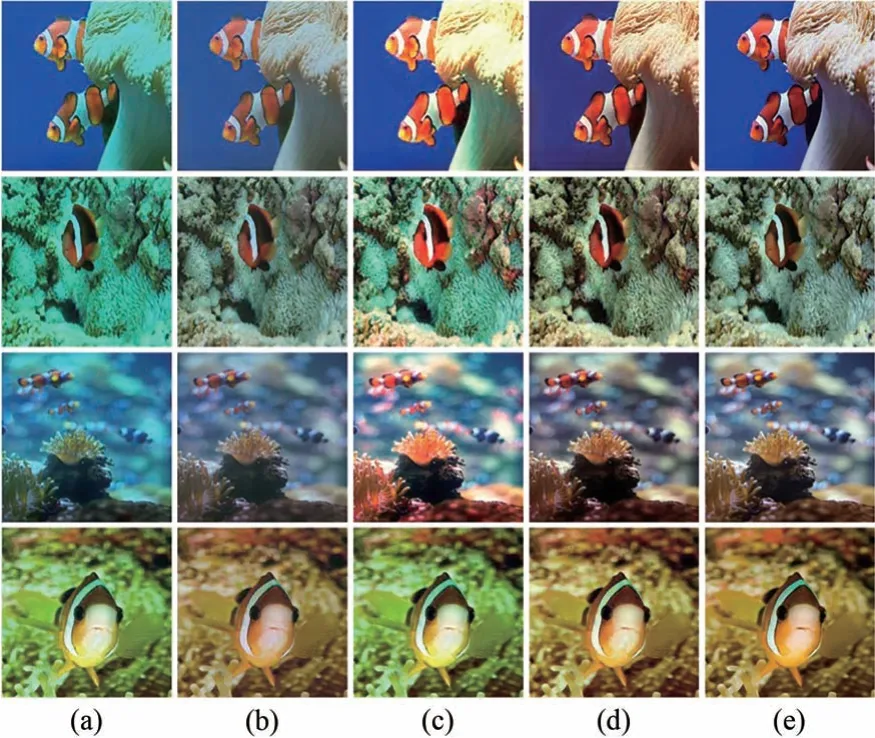

事实上水下获取到的图像往往没有真实的陆地对照图像,因此为了验证本文方法的泛化性,在B 组测试集上分别进行主观分析和客观分析。7 种对比方法在B 组测试集上的定性对比分析图如图11 所示。UDCP(图11(b))和DBFusion(图11(d))不仅不能对图像做到最基础的色偏校正,还进一步加深了绿色色偏,出现了暗色的伪影,对比度和亮度方面不如原始的水下图像。在UDCP图像集中,部分图像还出现局部泛红和颜色失真等情况,DBFusion 方法的表现好于UDCP。Water-Net(图11(c))和Ucolor(图11(f))能够很好地对基础色偏进行校正,但是校正的力度不够,部分区域还会有色偏,近景表现正常,远景会出现色偏,在亮度和对比度方面表现出色,Ucolor 方法表现要优于Water-Net方法。Global-Local Net(图11(e))和LAFFNet(图11(g))这两种方法能够解决基本的色偏问题,但是图像中在远景部分还是会有绿色的色偏。Global-Local Net 局部区域亮度过亮,因此图像亮度不够柔和,自然表现有些欠缺。LAFFNet 结果在亮度和对比度上有很好的改进,但是在图像表层出现了雾状噪音,表现为图像模糊不清晰。与其他方法相比,本文方法无论是在远景还是近景部分都能解决色偏,在图像亮度、对比度和饱和度方面均优于前6 种方法,图像由远到近颜色均衡自然,图像中近处生物和环境细节纹理清晰,图像全局对比度高,自然真实,视觉感知效果更好。

图11 B 组测试集的不同方法的定性比较。(a)水下图像;(b)UDCP;(c)Water-Net;(d)DBFusion;(e)Global-Local Net;(f)Ucolor;(g)LAFFNet;(h)本文方法。Fig.11 Qualitative comparison of different methods for group B test set.(a)Underwater image;(b)UDCP;(c)Water-Net;(d)DBFusion ;(e)Global-Local Net ;(f)Ucolor ;(g)LAFFNet;(h)Our method.

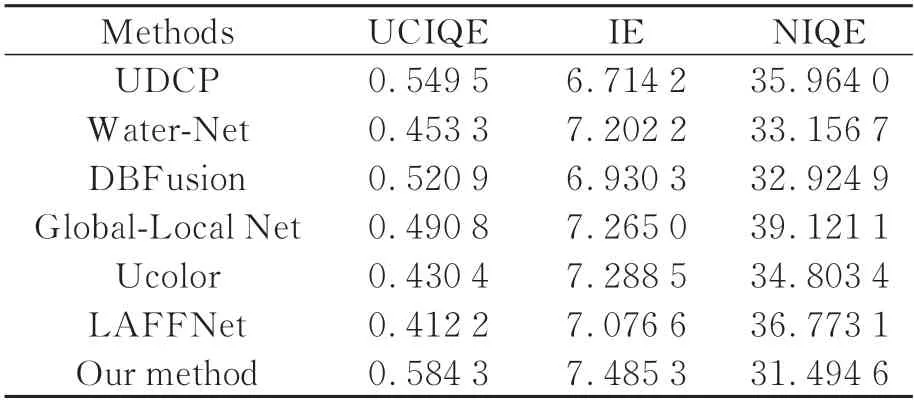

对没有参考图像的B 组测试集数据,我们采用无参考的水下图像质量评价指标UCIQE、IE 和NIQE,7 种方法在各评价指标上的平均得分如表3 所示。UCIQE 取得高于其他方法的平均分值0.584 3,表明色度、亮度和饱和度3 个指标较平衡,图像质量更高。IE 平均值7.485 3 表明图像信息丰富度高,在细节纹理上表现更好、更清晰。NIQE 得分31.494 6 低于其他对比方法,说明图像中的信息更加自然真实。

表3 B 组测试集增强图像的指标对比Tab.3 Index comparison of enhanced images in group B test set

3.3.3 各方法复杂度的比较

深度学习算法用参数数量(Parameters)和浮点运算 数(Floating point operations,FLOPs)指标来衡量其复杂度。参数数量用来形容模型大小程度,模型中包含的参数的总数量越多说明模型越大,单位为M(106)。FLOPs也是理论计算量,用于衡量算法的运算速度,该值越小说明模型的运算速度越快,单位为G(109)。由于UDCP 和DBFusion 方法不属于深度学习,无法计算其指标,最后得到其他算法的参数数量和FLOPs 如表4 所示。由表4 可知,本文提出的算法在参数数量和浮点运算数指标上仅次于Global-Local Net算法,与改进前的LAFFNet 算法相比,参数数量由0.15M 减少到0.03M(减少约80%),浮点运算数由9.77G 减少到5.95G(减少约39%)。说明本文算法得到的模型在参数量方面更小,运算速度有一定的提升,满足在低配置设备部署的要求。

表4 各方法复杂度的比较Tab.4 Comparison of the complexity of each method

4 结 论

针对低质量(存在严重色偏、能见度低和低对比度等问题)的水下图像,本文提出一种轻量级特征融合网络与多颜色模型校正相结合的水下图像增强方法。该方法属于模块化设计,使用自构建模块可减少代码的冗余,提高其可阅读性,提升网络的性能。改进的特征融合模块减少了全连接层带来的图像空间结构的破坏,而且能在不降低图像特征信息提取能力的前提下减少模块的参数量,减轻多层网络的训练难度。增加的改进的注意力模型对水下图像既能提取特征纹理又能保住背景信息。物理增强模块能在多颜色模型中对各颜色通道、亮度和对比度的值在合适的范围内进行校正,进一步减少色偏,增强对比度和亮度,使图像自然真实。本文方法为轻量级水下图像增强方法,一方面改进的特征融合模块能够减少参数量,另一方面模块间通道数降低为16,使本文方法的参数量从0.15M 下降到0.03M(降低约80%),有效提升训练速度。实验结果表明,同最新的图像增强方法对比,在有参考图像数据集上,NRMSE、PSNR 和SSIM 评价指标的平均值分别是0.203 6、22.140 7和0.797 9,比第二名对比算法提升了9.3%、3.7%和2.3%。在无参考图像的数据集上,UCIQE、IE 和NIQE 评价指标的平均值分别是0.584 3、7.485 3 和31.494 6,比第二名对比算法提升了6%、2.9%和4.5%。本文提出的方法可以有效校正色偏,同时提升亮度、饱和度和对比度,使增强后的图像色彩更自然丰富。