基于人脸多特征融合的精神分裂症自动识别

李 雯,郭 湘,秦林雨,何 凌,郑秀娟,李元媛

(1.四川大学 生物医学工程学院,四川 成都 610065;2.四川大学 电气工程学院,四川 成都 610065;3.四川大学 华西心理卫生中心,四川 成都 610041)

0 引 言

精神分裂症症状[1,2]多样,认知功能障碍是其核心症状之一,表现信息加工能力下降、语言表达障碍、抽象思维困难等功能损伤[2]。目前临床上该病的诊断主要取决于医生的主观判断,效率低且缺少客观的辅助诊断指标[3]。

研究表明,精神分裂症患者的认知表达能力障碍常表现在视觉阅读、面部表情、运动趋势等非语言行为[2,4-6]。

眼动信息反映人的视觉阅读能力,因精神分裂症患者注意功能与信息处理功能的下降,其眼动信息与正常人存在差异[1,7,8],并被用于精神分裂症的分类检测。如Huang等[9]通过眼动仪获取自由观看任务中扫视速度、注视时间等眼动特征,在随机森林分类器中实现87.1%的分类正确率。现研究多借助眼动仪提取眼动特征[8,9],成本高、受试者负担重。

言语表达过程伴随嘴部区域等面部表情的变化,言语功能损伤可从患者的面部行为观测[4,10,11]。如Birnbaum等[10]提取精神分裂症患者视频中的面部运动单元(facial action unit,FAU)的强度信息进行分析,指出唇角拉肌表情单元等嘴部区域在交叉实验中分类准确率达72%。面部运动单元可用于面部肌肉变化强度分析,但缺乏对嘴部关键点及其动态变化的进一步研究。

头部异动是精神分裂症患者运动障碍的表现之一[6,12,13]。Abbas等[12]通过计算机视觉模型量化患者的头部帧间运动距离,以实现精神分裂症的分类。Dean等[13]对访谈视频中精神疾病超高风险青年的头部区域帧间灰度变化进行运动能量分析,得到高风险患者表现出更大的运动幅度的结论。对患者的头部运动信号进行分析对精神分裂症诊断有临床意义[9],但现有研究缺少对其动态过程的分析,或基于观察者主观的评分,缺乏客观表征。

针对研究现状,提出基于人脸多特征融合的精神分裂症自动识别算法,根据患者在文本朗读过程中眼部、嘴部、头部姿态的异动,综合眼动周期特性、嘴部运动幅度特性、头部姿态角度变化特性构建融合特征,结合分类器实现精神分裂症患者与正常对照组的分类识别,为精神分裂症提供辅助诊断指标。

1 基于人脸多特征融合的精神分裂症自动识别算法

1.1 系统总流程

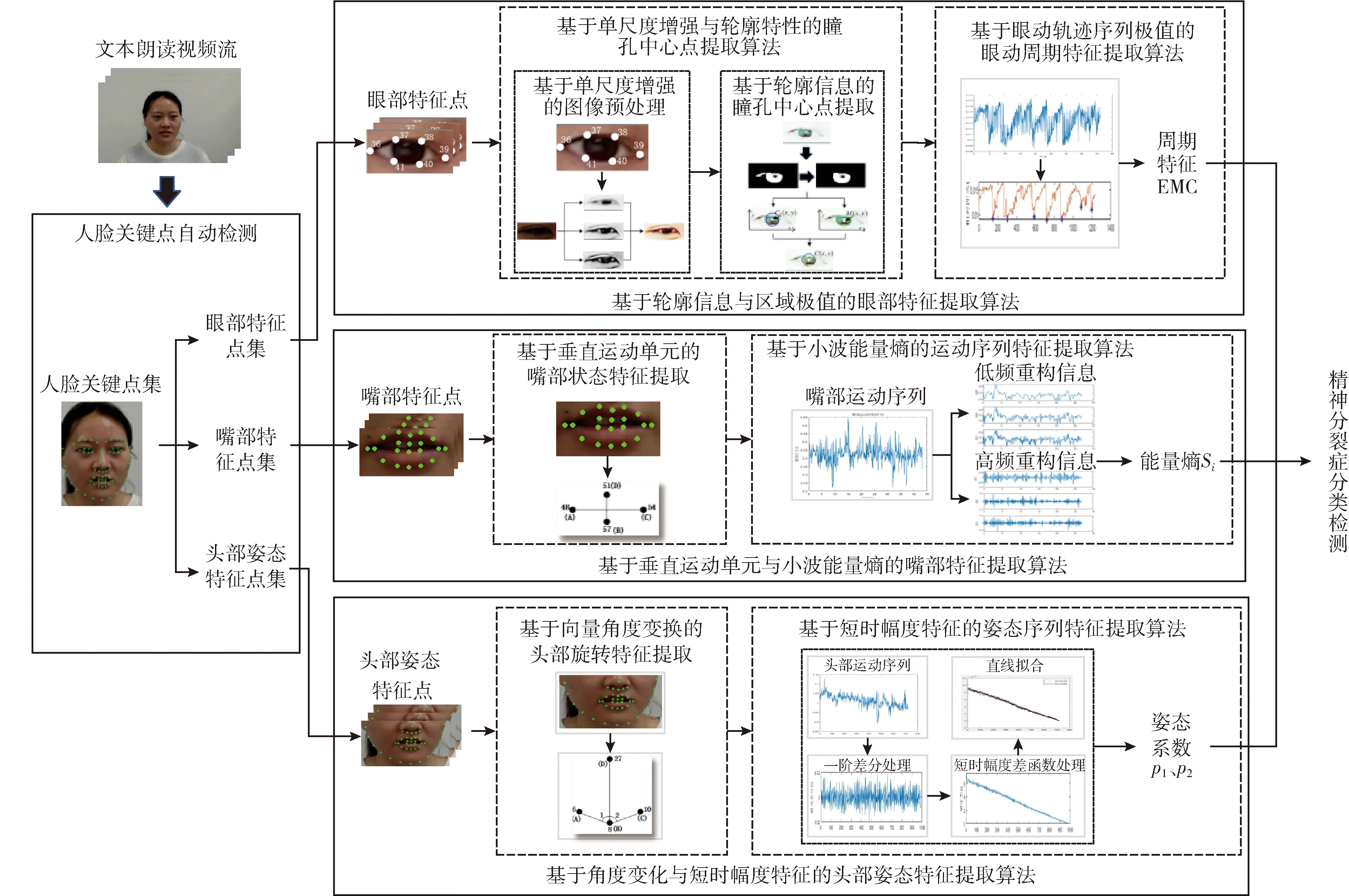

受认知功能障碍的影响,精神分裂症患者的注意功能和对信息的处理能力降低、言语意识变差,表现与正常人在视觉信息整合、言语表达能力、头部姿态上的差异[4-6]。为实现精神分裂症自动识别,针对文本朗读过程中精神分裂症患者非言语行为异常,提出基于人脸多特征融合的精神分裂症自动识别算法,系统总流程如图1所示。

图1 基于人脸关键点的多特征精神分裂症自动识别算法流程

1.2 人脸关键点自动检测

精神分裂症患者情感迟钝、言语匮乏,具有明显的认知功能障碍[1-3]。在读话过程中,其面部各区域伴有不同程度的运动,表现眼动、读话、头部姿态的异常。为研究读话过程中精神分裂症患者脸部运动特征,获取各部位的特征点信息,应用Dlib库提取人脸关键点。

Dlib基于梯度增强的回归树方法[14],将提取的图像特征映射为人脸关键点,实现对人脸区域中眉、眼、鼻、嘴等部位共68个关键点的定位检测。实验对精神分裂症患者读话视频帧应用Dlib人脸检测方法,对图像中人脸关键点集D位置信息进行提取。

在读话过程中,精神分裂症患者伴有眼部视线移动、嘴部开合运动以及头部姿态变化。为表征精神分裂症患者面部运动特征,分别提取眼部、嘴部、头部3个区域的特征点集D39-41、D48-67、D6,8,10,27, 人脸关键点区域划分如图2所示。

图2 人脸关键点区域划分

1.3 基于轮廓信息与区域极值的眼部特征提取算法

现有眼动特征多使用眼动仪进行提取,给受试者带来负担,且测量成本较高[8,9,16]。因此,通过无接触式的相机拍摄受试者读话视频,提出基于轮廓信息与区域极值的眼部运动特征提取算法,提取眼动轨迹,分析其眼动周期特性。

1.3.1 基于单尺度(Retinex)增强与轮廓特性的瞳孔中心点提取算法

为提取眼动轨迹,需对眼睛的瞳孔中心进行定位。基于轮廓信息的瞳孔中心点提取算法应用基于单尺度(Retinex)增强的图像增强处理,消除光照影响。实现对眼部区域图像的预处理后,提出基于轮廓特征的瞳孔中心点提取算法,通过轮廓信息特性获得瞳孔中心点位置信息。

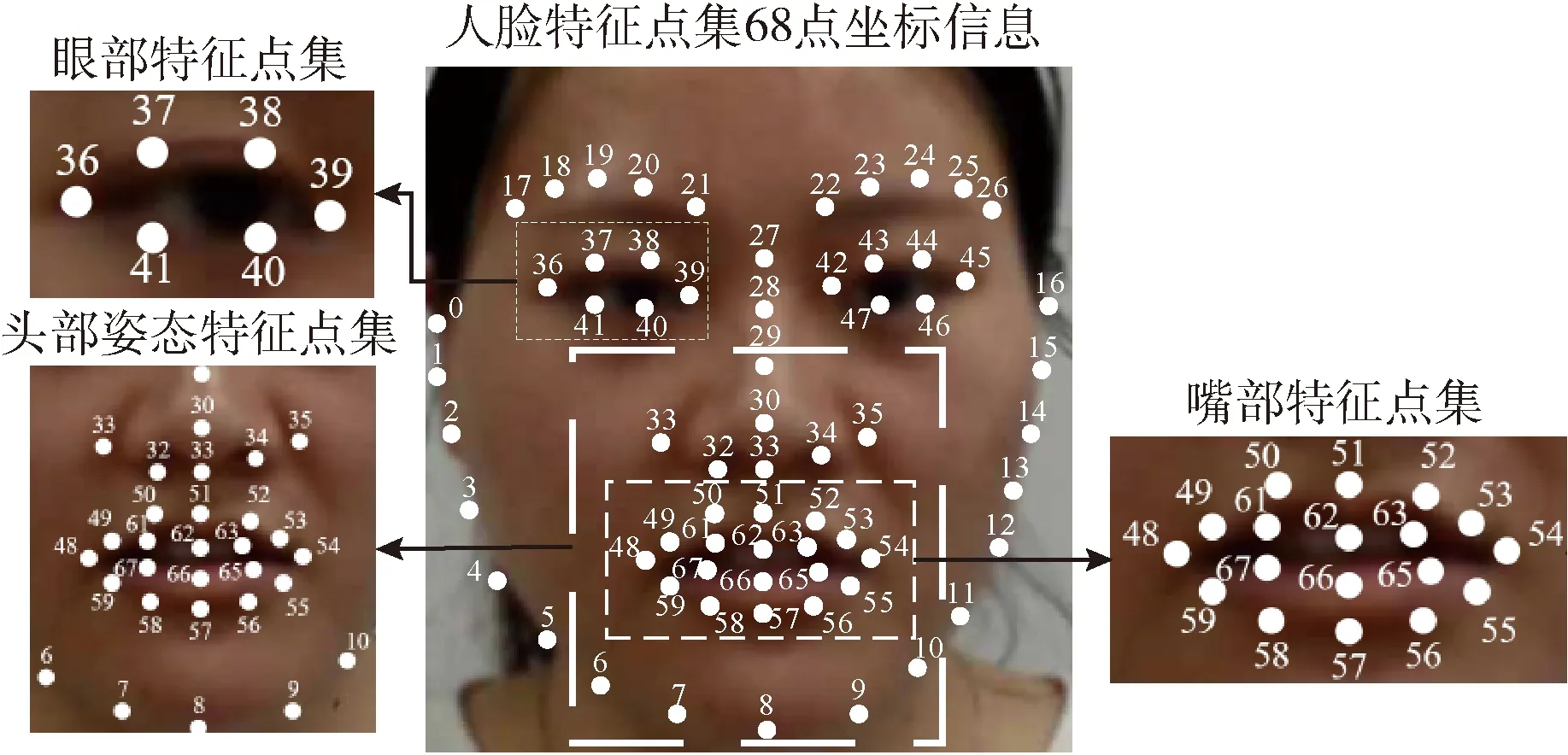

(1)基于单尺度增强的图像预处理

数据拍摄环境的光照条件不同,拍摄所得图像光照不均匀,造成实验对象眼部区域阴影,需消除光照影响。

单尺度增强算法可增强图像中的暗处细节,改善图像受光照不均匀部分[17]。算法将图像分解为RGB三通道,分别去除利用高斯变换得到的光照分量,将各通道合成得到增强结果。

图3为基于单尺度增强的图像增强处理效果。根据眼部特征点集D39-41定位信息,提取眼部ROI区域(如图3(a)所示),其眼睛大部分区域被阴影覆盖,为定位瞳孔中心带来困难,需消除图像中的光照阴影。算法将图像分解为R、G、B三通道图像后(如图3(b)~图3(d)所示),3个通道分别经过单尺度增强,每个通道图像的对比度都得到明显增强(如图3(e)~图3(g)所示),最后将各通道增强图像进行合并(如图3(h)所示)得到预处理结果。经过单尺度增强处理后,眼部区域图像中的光照不均匀得到有效改善,暗处的眼部细节得到增强,对比度得到有效提高。

图3 基于单尺度增强的图像增强处理效果

(2)基于轮廓信息的瞳孔中心点提取算法

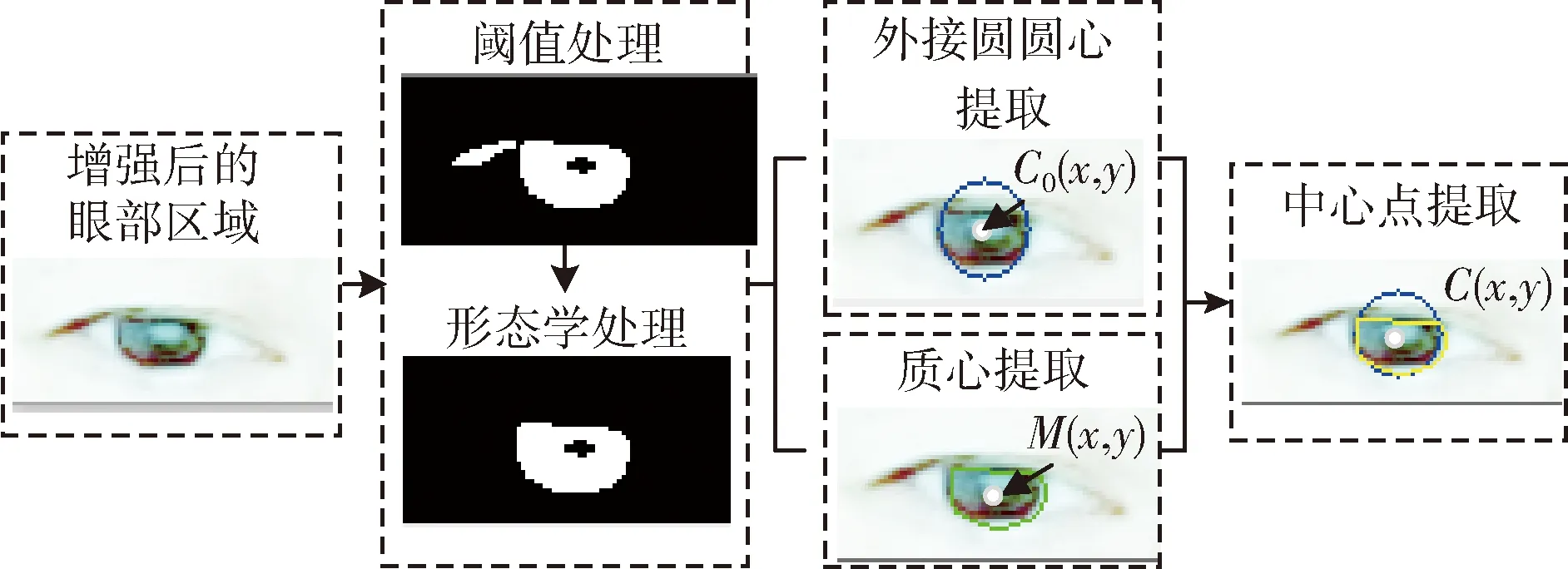

对精神分裂症患者眼部图像进行预处理后,提出基于轮廓信息的瞳孔中心点坐标提取算法,利用图像的轮廓特性实现对瞳孔中心点坐标的提取。

基于白色巩膜与深色虹膜的颜色差异大的特点,应用全局阈值处理方法,得到眼部区域的粗分割二值图像,实现眼睛的虹膜部分的初步提取。为去除眼睑等其它小连通域对分割结果的影响,利用形态学方法去除小连通域、平滑二值区域的边缘,得到虹膜二值区域。

不同实验对象在读话过程中眼睛的睁开程度不同,难以实现虹膜二值区域的完整提取。为表征瞳孔中心点信息,对虹膜二值区域进行轮廓信息分析,提取轮廓的外接圆圆心,外接圆能囊括二值区域,外接圆圆心能描述区域中心。为进一步完善对中心点的描述,对二值区域进行质心的提取,质心描述了二值区域分布的平均位置。取两者坐标的平均值,作为中心点坐标信息C(x,y), 如式(1)所示

(1)

式中:C0(x,y) 为二值区域轮廓外接圆圆心,M(x,y) 为二值区域的质心。

图4为瞳孔中心点提取算法效果,对经过增强处理后的眼部区域图像进行阈值处理,实现眼睛的虹膜部分的初步提取,并利用形态学方法去除眼睑等深色区域造成的孤立点。基于虹膜二值区域的轮廓信息特点,实现对精神分裂症患者眼睛中心点坐标C(x,y) 的提取。

图4 基于轮廓信息的瞳孔中心点提取算法效果

1.3.2 基于眼动轨迹序列极值的眼动周期特征提取算法

精神分裂症患者注意功能受损,信息处理功能下降,其视觉阅读更加困难[7,8]。为提取精神分裂症患者视线阅读特征,提出基于眼动轨迹序列极值的眼动周期特征提取方法,将连续帧的瞳孔中心点位置信息表征眼动轨迹后,分析序列的极值特性,提取眼动平均周期特征。

(1)相对眼动轨迹序列表征

通过基于轮廓信息的瞳孔中心点提取算法,得到每帧图像中右眼的中心点位置信息C(x,y) 后,根据连续帧图像中相对位置移动变化来表征眼动轨迹,如图5所示。

图5 相对轨迹特征点

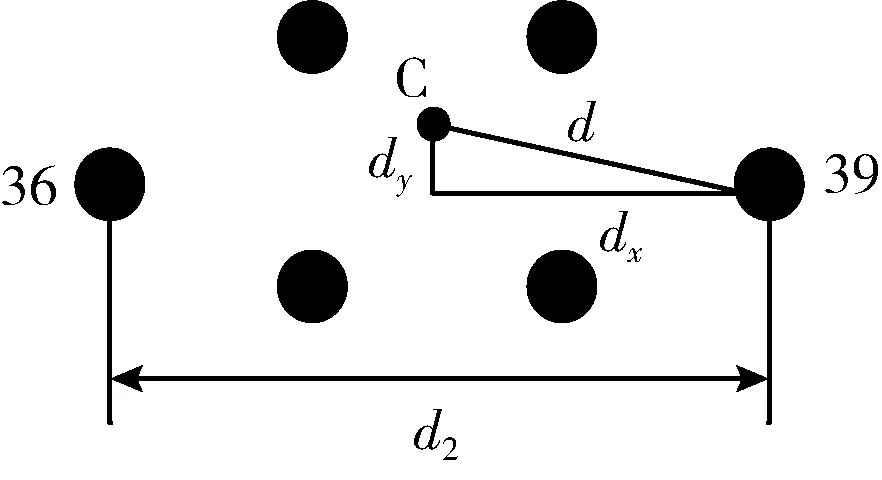

人脸检测点集D中的36、39点表示右眼的内外眼角点,两眼角点之间的距离是固定不变的。计算中心点C(x,y) 与内眼角点D39(x,y) 的相对距离d,如式(2)所示,表征每张图片中右眼瞳孔中心点与内眼角点之间的相对距离

(2)

式中:d1为中心点C到点D39之间的距离,d2为36点D36与点D39之间的距离。

dx表征中心点C(x,y) 与内眼角点D39(x,y) 的水平方向上的相对眼动距离,如式(3)所示

(3)

dy表征中心点C(x,y) 与内眼角点D39(x,y) 的垂直方向上的相对眼动距离,如式(4)所示

(4)

提取每段读话中所有连续帧的特征值d、dx、dy,得到眼动轨迹Leye、 眼动轨迹水平分量Leyex、 眼动轨迹垂直分量Leyey。

(2)基于序列区域极值的眼动特征EMC(eye movement cycle)提取

患者在读话过程中,视线随文字分布水平移动,中心点随时间变化而产生的序列的峰值和谷值反映了其视线阅读规律。将提取出的精神分裂症患者眼动序列Leye, 对其进行中值滤波,去除序列中的突变值,得到眼动序列Leye′。 进行滤波后,提取局部谷值点Ri并设置阈值T,缩小谷值范围,得到Qk, 如式(5)所示

(5)

式中:Riy为点集y方向上的值,LN为序列Leye′的长度。

根据谷值点集Qk中的时域特点,将其分为N组,每组点集为每个谷值附近的极小值点,Qk={Q′1,Q′2,…,Q′N}。 分别提取每一组极小值点集中的最小值代表序列谷值,如式(6)所示

Q″n=min(Q′n)

(6)

计算每组点集最小值之间的帧差并取平均值,得到周期特征值EMC,如式(7)所示

(7)

式中:N为Q″n的个数,Q″nx为Q″n点集x方向上的坐标,fs为提取序列视频对应的帧率。

1.4 基于垂直运动单元与小波能量熵的嘴部特征提取算法

言语障碍是认知障碍中的重要领域,精神分裂症患者听觉言语加工、视觉阅读和言语产生存在一定的缺陷,导致语言认知功能下降,阅读能力降低、阅读意识变差[4]。为研究精神分裂症患者嘴部运动特征,提出基于小波能量熵的嘴部运动特征提取算法。

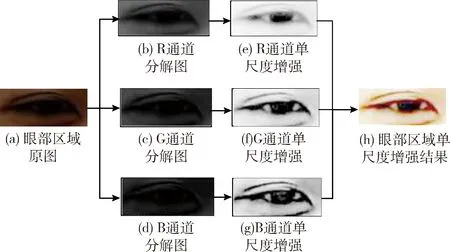

1.4.1 基于垂直运动单元的嘴部状态特征MR(mouth ratio)提取

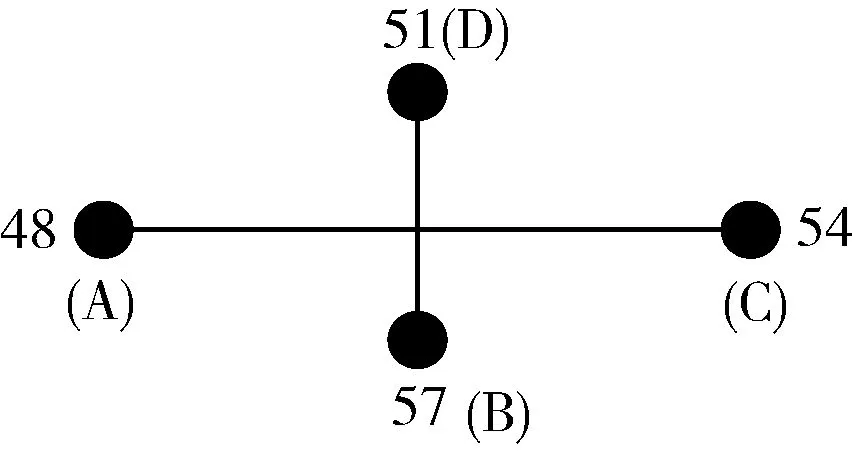

通过嘴巴的开合程度来表示读话过程中测试者的读话状态,从而实现对精神分裂症患者嘴部运动特征的描述。由人脸检测得到的特征点集D可知,D48-67均为嘴部特征点,可通过这些嘴部特征点表征读话过程中嘴的开合程度,嘴部运动特征点如图6所示。

图6 嘴部运动特征点

提出基于垂直运动单元的嘴部状态特征MR(mouth ratio),表示读话过程中嘴巴的开合程度,如式(8)所示

(8)

式中:BD为D51到D57点之间的距离,AC为D48到D54之间的距离,BD与AC的比值即为嘴部特征值MR。

1.4.2 基于小波能量熵的运动序列特征提取算法

通过提取读话视频中所有连续帧的特征值MR,得到嘴部运动时间序列为MR(n)(n=1,…,N)。 为对序列进行不同尺度分析,提取读话过程中实验者读话特性,提出基于小波能量熵的嘴部运动序列特征提取算法。

算法通过小波变换对信号进行多尺度分解,实现对信号的局部化分析;再将各频率系数进行重构,进行能量熵计算。应用小波变换对嘴部运动时间序列MR(n)进行3层小波分解,通过小波变换分解为低频信息MRa1和高频信息MRd1,MRa1继续分解为低频信息MRa2和高频信息MRd2, 低频信息MRa2再继续分解为低频信息MRa3和高频信息MRd3, 完成三层小波分解,如式(9)所示

MR(n)=MRa1+MRd1=MRa2+MRd2+MRd1=MRa3+MRd3+MRd2+MRd1

(9)

对分解所得各频率信息进行重构并计算能量值Ei与总能量值E,如式(10)所示

(10)

式中:Fi为每个频率的能量占比,Si为每个频率重构信息的能量熵,i=a1,a2,a3,d1,d2,d3。

1.5 基于角度变化与短时幅度特征的头部姿态特征提取算法

精神分裂症患者具有运动功能障碍[12],表现行为迟缓等差异,其阅读文本时思维灵敏性低、反应迟钝。在相同读话环境下,患者视线移动受阻,借助头部姿态变化完成阅读。为表征其头部姿态变化特点,提出基于角度变化与序列幅度特征的头部姿态特征提取算法,基于角度变化表征头部姿态特征后,应用短时幅度差函数分析其序列特征。

1.5.1 基于向量角度变化的头部旋转特征HRAR(head rotation angle ratio)提取

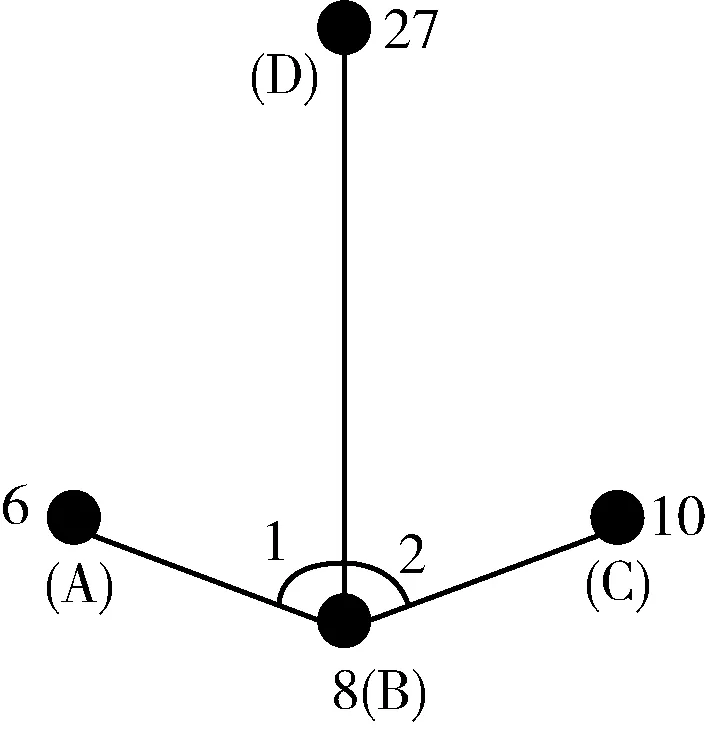

为了描述头部姿态变化,提出基于向量角度变换的头部旋转特征提取算法。根据人脸检测结果中特征点提供的位置信息,选取表征头部姿态的特征点集D6,8,10,27, 特征点集几何分布如图7所示。

图7 头部运动特征点

提出特征值HRAR,表示读话过程中精神分裂症患者头部姿态特征,其公式为式(11)

(11)

1.5.2 基于短时幅度特征的姿态序列特征提取算法

提取连续图像帧中的头部旋转特征HRAR,得到头部姿态变化时间序列HR(n)(n=1,…,N)。 对序列HR(n) 进行一阶差分处理,表示其前后增量变化。应用短时平均幅度差函数表征其幅度特征,衡量信号幅度的变化,如式(12)所示

(12)

式中:HR(m) 是头部运动时间序列,HR′(j) 是短时平均幅度差函数序列。

经过短时平均幅度差函数处理后的序列呈直线分布,对HR′(j) 进行线性最小二乘拟合,设n为1,得到拟合系数p1、p2, 构成P,即序列特征值,如式(13)所示

(13)

1.6 SVM(support vector machine)分类器

支持向量机(SVM)是一种经典的二值分类器[3,9],其通过在特征空间寻找一个最优超平面,实现两类样本数据到超平面的距离最大化。SVM模型存储空间小,算法鲁棒性较高,是小样本训练常用的学习方法。

2 实验结果与分析

2.1 实验数据

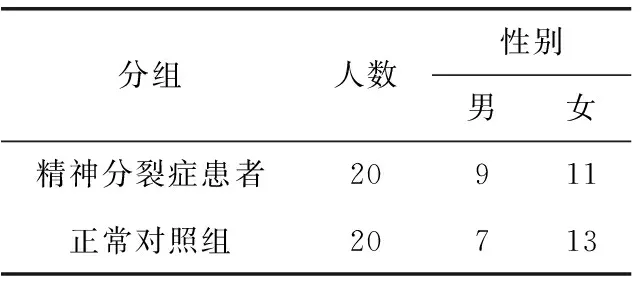

本实验数据来源于四川大学华西医院心理卫生中心和眉山市精神卫生中心,共采集20位精神分裂症患者和20位正常对照组的文本朗读视频,数据信息见表1。

表1 实验数据采集情况

受试者按要求在平静状态下,正对显示屏进行文本朗读任务,朗读文本为一段科普性陈述语句。朗读开始后,使用专业的录像设备对文本朗读过程进行数据录制。实验共采集40段文本朗读视频,视频帧分辨率为1920×1080。

2.2 基于人脸多特征融合的精神分裂症自动识别算法结果与分析

针对精神分裂症患者在文本朗读过程中眼动、嘴部读话与头部姿态的异常,提出基于人脸多特征融合的精神分裂症自动识别方法,对面部区域中眼部、嘴部以及头部姿态3个区域的特征进行提取分析:①基于轮廓信息与区域极值的眼部特征提取算法提取眼动周期EMC。②基于小波能量熵的嘴部运动特征提取算法提取能量熵Si。 ③基于角度变化与序列幅度特征的头部姿态特征提取算法提取姿态系数P。将眼动周期EMC、能量熵分量Sa1、 头部姿态系数P构建融合特征向量,实现对精神分裂症患者的自动识别检测。

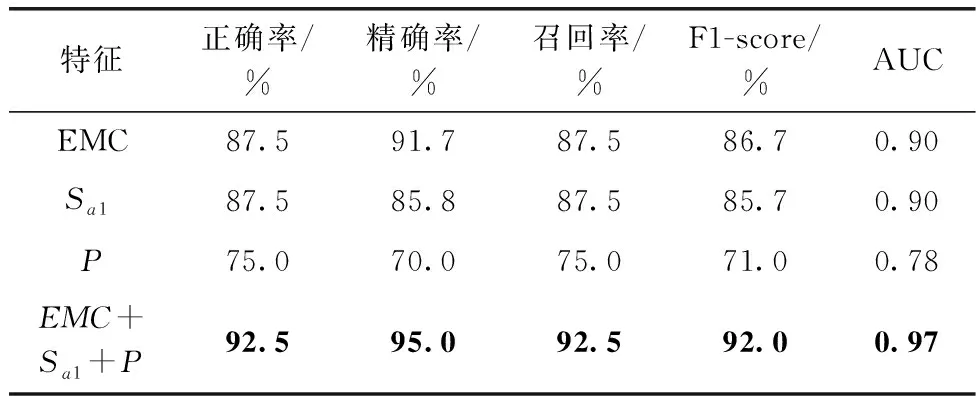

实验提取每段视频的融合特征,结合SVM分类器进行精神分裂症的自动分类识别,实验结果见表2。实验使用5个指标对分类结果进行评价:正确率(accuracy)为被正确识别的样本数在总样本数中的占比;精确率(precesion)为被正确识别的正样本在所有被识别为正样本的数目中的占比;召回率(recall)为被正确识别的正样本在所有真实情况下为正样本的数目中的占比;F1-score为精确率与召回率的调和平均;AUC(area under the curve)为ROC(receiver operating characteristic)曲线下的面积,AUC越大表明其分类性能越好。

表2 基于人脸多特征融合的精神分裂症自动识别结果

由表2可知,实验对特征EMC、Sa1、P进行了十折交叉验证,3组特征在实验中均表现较好的分类结果,分别得到87.5%、87.5%、75.0%的分类正确率,91.7%、85.8%、70.0%的分类精确率。

基于人脸多特征融合的精神分裂症自动识别方法提取的特征向量EMC+Sa1+P, 在十折交叉验证实验中得到92.5%的分类正确率,在各组特征中获得最高的实验结果。

实验结果表明,本文提出的基于人脸多特征融合的精神分裂症自动识别方法,即对精神分裂症患者在文本朗读过程中各区域表现差异进行多参数表征,构建的融合特征实现分类检测,实现了92.5%的分类正确率,分类性能优于单区域特征。融合特征综合分析了精神分裂症患者的眼动障碍、言语障碍与头部姿态异动,反映了患者视觉信息处理能力下降、言语表达淡漠的特点,特征表现较好的分类检测能力、鲁棒性强,实现了对精神分裂症患者的自动分类检测。

2.3 眼动周期EMC与眼动周期分量EMC_x对分类结果的讨论与分析

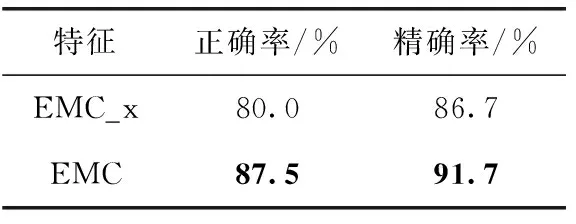

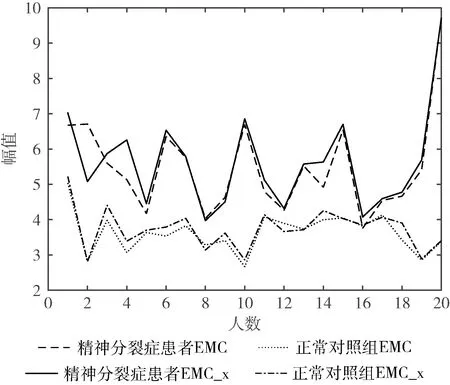

为分析不同方向眼动特征对实验的影响,实验基于轮廓信息与区域极值的眼部特征提取算法,分别提取眼动轨迹Leye和眼动轨迹水平分量Leyex, 并将对应的眼动周期EMC、眼动周期分量EMC_x。

精神分裂症患者与正常对照组在不同方向眼动特征的差异如图8所示。结合SVM分类器进行十折交叉验证,将两组特征的分类检测结果进行比较,对比结果见表3。

表3 基于轮廓信息与阈值特点的眼部特征提取算法实验结果

图8 精神分裂症患者与正常对照组的眼动周期差异

由实验结果可知,眼动周期水平分量EMC_x在交叉验证实验中实现80.0%的正确率、86.7%的精确率,眼动周期EMC在交叉验证实验中实现87.5%的正确率、91.7%的精确率。实验结果说明,不同方向提取的眼动特征直接影响分类结果,眼动周期EMC结合了垂直方向上的眼动细节,提取的眼动信息更加精确,表现更好的分类性能,实现对精神分裂症眼动特性的良好表征。

2.4 小波能量熵Si对分类结果的讨论与分析

精神分裂症患者言语认知功能下降,阅读意识低,语言表达淡漠[2],从嘴部运动反映其表达特性。实验通过提出基于小波能量熵的嘴部特征提取算法,提取特征MR表征读话过程中嘴巴的开合程度,得到嘴部运动时间序列MR(n), 利用三层小波变换分解特征值序列MR(n), 根据重构信息MRi提取能量熵Si(i=a1,a2,a3,d1,d2,d3)。Sa1、Sa2、Sa3为嘴部运动特征中的低频能量熵,Sd1、Sd2、Sd3为嘴部运动特征中的高频能量熵。

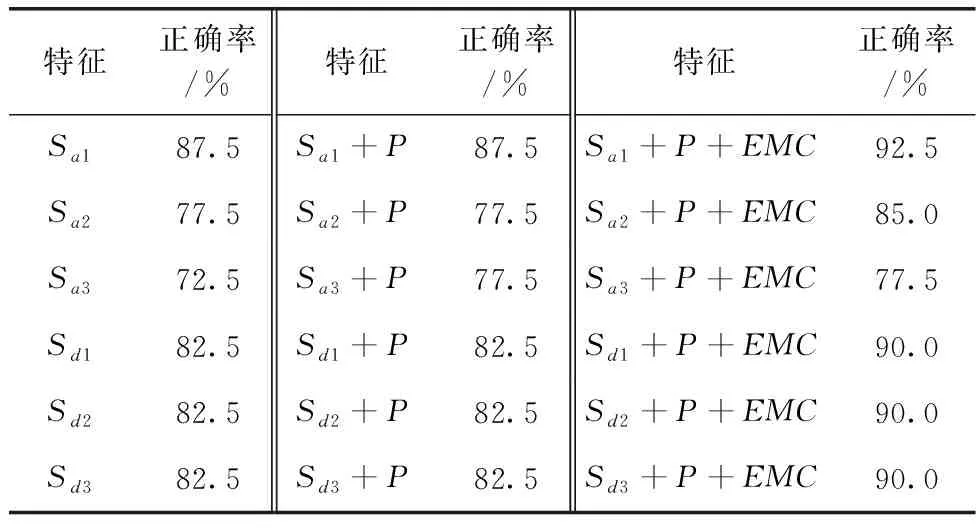

为讨论能量熵Si对实验结果的影响,实验提取20位精神分裂症患者和20位正常对照组的能量熵特征Sa1、Sa2、Sa3、Sd1、Sd2、Sd3, 并将其与P、EMC进行特征组合,在SVM中进行十折交叉验证实验,对比实验结果见表4。

表4 嘴部特征中不同频率能量熵特征的实验结果

由表4可知,能量熵分量Sa1、Sa2、Sa3、Sd1、Sd2、Sd3在实验中分别得到87.5%、77.5%、72.5%、82.5%、82.5%、82.5%的分类正确率。其中,能量熵特征Sa1得到最高87.5%的识别正确率。实验将能量熵Sa1、Sa2、Sa3、Sd1、Sd2、Sd3分别与头部姿态系数P、眼动周期EMC进行两组特征组合。在组合特征的实验结果中,与频率能量熵Sa1进行组合的特征向量Sa1+P、Sa1+P+EMC分别得到87.5%、92.5%的分类正确率,在Si+P、Si+P+EMC的特征组合中分类正确率最高。

由实验结果可知,在基于小波能量熵的嘴部特征提取算法提取的嘴部运动特征中,不同频率能量熵特征影响精神分裂症的识别结果,低频重构信息的能量熵特征反映了精神分裂症患者在文本朗读过程中的嘴部运动能量特性,其中能量熵Sa1在嘴部特征中表现患者与正常对照组嘴部运动差异,在所有频率能量熵中获得较高的分类正确率,能有效实现对精神分裂症患者和正常志愿者的分类检测。

2.5 对比实验结果与分析

2.5.1 国内外精神分裂症自动识别算法的对比实验结果与分析

近年来国内外研究学者通过视频信号,从面部运动单元、头部运动变化中提取特征[10,11,13],实现对精神分裂症的自动分类检测。面部运动单元由面部表情编码系统(facial action coding system,FACS)定义,精神分裂症患者表情淡漠、反应迟钝,研究学者通过计算面部运动单元的强度信息[10,11],分析精神分裂症患者的面部特征,从而实现分类、病情检测的目的。同时,研究者根据视频信号中精神分裂症患者头部等运动差异,提取前后帧灰度差异特征分析患者的身体运动异常[13]。

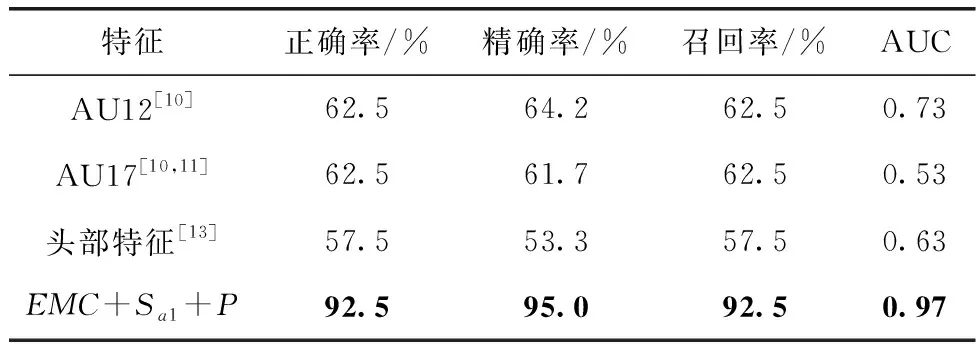

针对本实验数据,提取视频信号中的面部运动单元特征与头部运动特征,对国内外技术进行对比实验,结果见表5。

表5 国内外特征与本文特征对比结果

由表5可知,基于本实验数据提取的AU12、AU17、头部运动特征在十折交叉验证实验中获得57.5%~62.5%的分类正确率,精神分裂症患者在文本朗读过程中表现了面部运动与头部运动异常。面部运动单元AU12、AU17分别表征了嘴角拉起程度和下巴提起程度,在与正常对照组的分类实验中实现62.5%的分类正确率。基于文献[13]提取的头部运动特征实现57.5%的分类正确率。而提出的基于人脸多特征融合的精神分裂症自动识别方法,从视频图像出发,综合分析了精神分裂症患者在眼动、嘴部开合、头部姿态在动态过程中的微小运动差异,获得92.5%的分类正确率,优于其它特征的分类结果,具有良好的鲁棒性。

2.5.2 本文特征在不同分类器中的实验结果对比

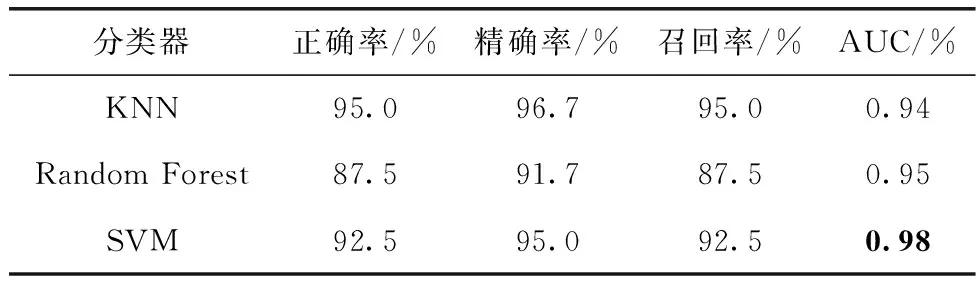

在对提取的精神分裂症特征进行分类实验时,国内外研究学者多采用支持向量机(SVM)[3,9]、随机森林(random forest)[3,9]、K最近邻规则(K-nearest neighbor,KNN)[3,15]等机器学习算法,实现对精神分裂症的分类识别。实验使用上述3种分类器对提取的融合特征EMC+Sa1+P进行分类实验,对比实验结果见表6。

表6 本文特征在不同分类器中的实验结果对比

由表6结果可知,实验提取的特征在3个分类器中实现了较好的分类结果,随机森林、KNN、SVM分别实现了87.5%、95.0%和92.5%的分类正确率,以及0.94、0.95、0.98的AUC。随机森林算法通过训练多个决策树模型,将测试数据放入模型进行投票得到预测结果[3,9],对本实验数据实现87.5%的分类正确率。KNN分类算法不需参数估计[15],算法复杂度低,对本实验数据实现95.0%的分类正确率。SVM分类器在两类数据分类中具有较好的表现[3,9],其在特征空间寻找最优超平面,对实验精神分裂症患者与正常对照组两类数据进行分类,实现92.5%的分类正确率。其评估指标AUC在3个分类器中得到最高的0.98,表明分类器具有较好的泛化能力,适用于本实验小样本的分类。实验结果表明,基于人脸多特征融合的精神分裂症自动识别方法提出的融合特征在多个分类器中表现良好的分类性能,能有效实现对精神分裂症的分类检测。

3 结束语

为寻找精神分裂症客观辅助诊断指标,提出基于人脸多特征融合的精神分裂症自动识别算法,针对文本朗读视频提取眼部、嘴部、头部姿态区域特征,并构建融合特征进行分类识别。实验对采集的20位精神分裂症患者与20位正常对照组的视频进行特征提取,构建的融合特征在SVM分类器中实现92.5%的分类正确率,其中眼动特征EMC与嘴部特征Sa1对精神分裂症患者面部区域运动特性的良好表征,分别实现91.7%和87.5%的分类正确率。与国内外其它特征进行对比,提出的融合特征获得最高的分类结果。