基于鼠标轨迹语义理解的医学影像阅片交互意图识别

杨晨希,乔 栋,牛 怡,崔 磊,冯 筠

(1.西北大学 信息科学与技术学院,陕西 西安 710127;2.运城市中心医院,山西 运城 044000)

近年来,受国民健康意识加强、人口结构老龄化、诊断成像技术复杂度不断增加等因素影响,放射科医生日常工作负担加重。为影像科医生减轻阅片负担,帮助其更有效率地进行影像诊断推理与决策已成为各界关注的热点,具有重大的社会意义与临床应用价值。随着数字成像技术、计算机技术与网络技术的进一步发展,20世纪80年代医学影像存档与通信系统(picture archiving and communication system,PACS)这一概念被正式提出。PACS系统主要提供医学影像数据数字化、处理与传输等功能,在一定程度上帮助医生提高了诊断效率和准确率。如今数字化阅片方式已广泛应用于各级医院影像科室中,相比于传统的灯箱胶片式阅片,数字化阅片方式为医生增加了“洞察力”,帮助其提高了阅片效率及准确率。

近年来,人机关系发生重大变革,人机交互理念逐渐从以机器为中心向以人为中心转变,从单一显式的用户动作表达向隐式机器智能推理与显式用户表达融合的方向发展[1]。使计算机系统感知用户人机交互过程中的意图,分析其潜在的、隐藏的需求,已成为人机交互研究领域必然的发展趋势。影像阅片任务几乎都需要医生执行一系列操作及判断,如果阅片系统能够感知、预测用户交互意图,提前做好准备并在正确的时间传递正确的信息,则可以通过提供自适应辅助工具、优化界面等方式改善用户交互体验、优化用户整体人机交互过程,进一步融合医生智慧与机器智能的互补优势,更好地助力医生进行影像阅片诊断。

随着人机交互技术的发展进步,用户可以通过多种方式与计算机进行交互。为了更多地了解用户交互行为,提高人机交互体验,已有相关研究试图对用户的交互意图进行识别及预测。例如,Cronin等人通过用户语音输入、手势输入、眼动输入实现了4种Clutching(激活和取消对系统的控制)技术,以识别用户何时与系统交互,解决医生在无菌环境下使用非接触式PACS系统时可能出现的误触问题[2]。Zhao等人通过脑电信号及眼动信号对用户在模拟飞行任务中的交互意图进行识别,在信号采集后进行特征提取,并对两种信号特征分别使用SVM进行意图分类,最后通过决策级融合得到意图识别结果[3]。该项研究旨在对自适应飞行器人机交互系统设计提供理论依据和技术支持。Soleymani等人收集了参与者的鼠标键盘隐式交互数据、眼动跟踪数据、面部表情及肌电信号,对用户搜索多媒体内容过程中的交互意图进行预测[4]。结果表明,用户的眼球凝视和隐式鼠标移动、击键数据具有最丰富的信息量,证明了部署此类方法来改进多媒体检索平台的可行性。除了基于上述交互技术的相关研究外,其他传感技术在各个领域的人机交互研究中也展现出巨大的发展潜力[5-6]。然而,就现阶段而言,大多新型交互技术因受价格、部署环境等问题的限制,整体应用范围较局限,只能在小众的专业领域发挥效果。

鼠标输入目前仍为医生进行医学影像阅片最主要的交互方式,同时,鼠标交互数据的采集可以轻松地通过软件部署实现,且采集过程隐秘,不干扰用户正常工作。在最近的一项研究中,Vosshenrich等人对一名放射科住院医师使用电子阅片系统时的鼠标运动轨迹进行记录,发现在8 h工作时间内其鼠标共进行了10 778次点击操作,移动总距离达到2.2 km[7]。大量的数字影像阅片任务可产生极为丰富且有价值的鼠标交互数据,但出于医学数据隐私、研究领域隔离等问题,数字影像阅片过程中的鼠标交互数据目前还未得到充分研究与利用。对此类交互数据进行分析与挖掘可以进一步得到数字影像阅片过程中潜在有用的信息与知识,以应用于人机交互领域、计算机辅助诊断领域的研究中。鼠标交互数据是一种典型的同时具有时间维度属性和空间维度属性的生物行为数据[8],可以从不同的粒度、层面和视角记录人机交互过程中用户的活动信息,还可以隐式和动态地提供有关用户心理状态、体验感受和交互系统可用性等有用信息,现已被广泛应用于用户网页搜索行为预测[9-12]、人机身份认证[13-14]、用户情感状态理解[15-17]、用户参与度度量[18]等诸多人机交互领域的研究中。

基于上述背景,本文旨在根据鼠标交互轨迹实现医学影像阅片交互意图识别的目的。在本文中,用户交互意图被定义为用户在使用系统阅片过程中所进行的交互行为,例如点击按钮、浏览图像区域等。由于缺乏对医学影像阅片系统使用过程中的用户鼠标交互数据进行研究的相关工作,因此缺少此类数据的公开数据集。首先,为了获取实验所需的鼠标交互数据以及用户交互行为标签,本文建立了鼠标交互数据集构建框架。基于此框架,在自定义的CXR辅助阅片原型系统上对用户交互过程中的鼠标跟踪数据及交互行为语义标签进行收集。其次,提出了一种基于鼠标轨迹语义理解的医学影像阅片交互意图识别方法,通过对原始鼠标交互数据进行轨迹分段及语义注释识别轨迹语义,实现用户交互意图的理解。最后,在所构建的数据集上通过实验验证了本文方法的可行性及有效性。

1 相关工作

鼠标光标可以充当用户注视活动的弱代理[19],提供一个用于深层次理解用户人机交互行为的方案。有研究表明,用户不仅在做出决策后移动鼠标进行交互,在决策过程中同样会使用鼠标帮助其进行任务处理,鼠标移动可以作为用户思维的“实时运动轨迹”[16]。

目前,对鼠标交互数据进行建模分析的研究主要可分为两类:建模轨迹运动特征和建模轨迹时序特征。建模鼠标轨迹运动特征的研究主要包含特征提取及模型分类等步骤。例如,Lu等人面向人机身份认证问题,对机器滑动轨迹数据的攻击方式进行分析后提取轨迹特征,再利用特征重要性分数及特征相关系数分析进行特征选择,最后,使用XGBoost进行人机身份分类识别,实验结果表明该方法获得了99.09%的准确率及99.88%的召回率[14]。Liu等人收集用户编程过程中的鼠标及键盘交互数据,通过特征提取与分类对用户编程过程中积极、消极与中性3种情感状态进行识别,为用户通过电子平台学习编程的过程提供更好地反馈及体验[15]。Fernández-Fontelo等人对网络调查任务中受访者的鼠标行为数据进行特征提取后分类,用于预测所调查问题对于用户的难易程度[20]。建模鼠标轨迹时序特征的研究主要考虑鼠标交互动作发生的时序性。例如,Zhang等人基于贝叶斯模型结合用户的鼠标键盘交互动作序列及注视行为特征对用户进行文本格式化任务过程中的交互意图进行预测,实验结果表明,使用从鼠标键盘日志中提取出的先前鼠标交互动作序列进行预测的性能明显优于仅从注视行为中提取特征[21]。Kwok等人基于长短时记忆网络模型建模用户历史交互活动及鼠标交互特征,实现用户下一交互活动预测及非意图鼠标点击检测[22]。

在大多数现有的相关研究中,常将整段轨迹数据作为整体分析建模。然而,就本研究而言,鼠标交互数据在不同时段常常蕴含有不同的用户交互语义信息。轨迹语义理解是对时空数据进行分析的一种手段,指在融合多源信息的基础上,通过逻辑推理和知识发现等方法,以理解时空数据产生过程中所反映出的用户行为、状态和偏好等语义信息[23]。对时空轨迹进行语义理解可以为原本简单的地理坐标数据赋予内涵,对深度挖掘数据的多方面价值具有关键作用[24-26]。

综上,本文提出基于鼠标轨迹语义理解的交互意图识别方法,通过轨迹分段和轨迹语义注释获取轨迹的局部语义,实现识别用户医学影像阅片交互意图的目的。

2 医学影像阅片数据集构建

2.1 基本概念

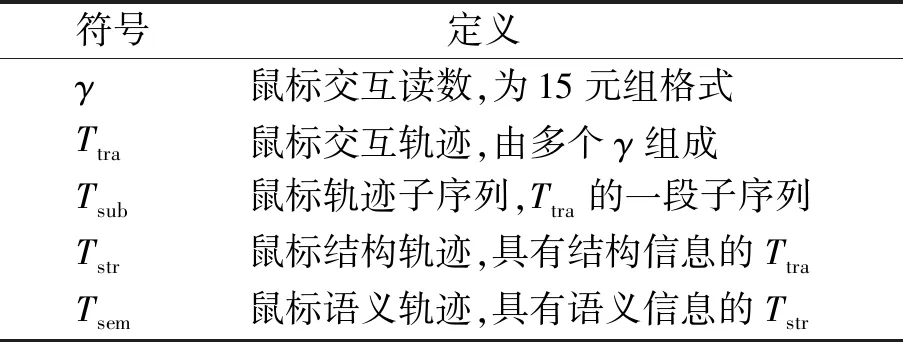

本文主要涉及到的概念及定义具体如下,文中符号总结说明如表1所示。

表1 符号总结Tab.1 Symbol summary

定义1鼠标交互读数γ。一个鼠标交互读数γ为一个15元组,对应一个鼠标交互事件,表示为γ=(x,y,t,p1,p2,…,pm)。其中:t为该鼠标交互事件发生的时间戳;(x,y)表示交互坐标;pi代表鼠标交互事件的其余属性信息,并有i∈[1,m],m为其余属性的个数。

定义2鼠标交互轨迹Ttra。鼠标交互轨迹被定义为一个以时间增序排序的鼠标交互读数序列,以记录交互过程中鼠标交互信息,表示为Ttra={γ1,γ2,…,γn}。其中:γi为鼠标交互读数;n为Ttra的序列长度。

定义3轨迹子序列Tsub。给定一条鼠标交互轨迹Ttra={γ1,γ2,…,γn},其子序列定义为Tsub={γi,γi+1,…,γi+l-1}。其中,1≤i≤i+l-1≤n,l为子序列长度。

定义4鼠标结构轨迹Tstr。鼠标结构轨迹Tstr是对鼠标交互轨迹Ttra经轨迹分段后得到的,由多个轨迹子序列Tsub组成,每段子序列具有相似的属性特征,令Tstr={

定义5鼠标语义轨迹Tsem。鼠标语义轨迹Tsem是带有附加语义信息的鼠标结构轨迹Tstr。在本文中,语义信息表现为每段鼠标轨迹子序列所对应的用户交互行为类别标签。令Tsem={Tsub,bfine>},其中,bfine为用户细粒度交互行为类型标签。

定义6系统响应行为与非系统响应行为。系统响应行为即为软件系统可以识别为特定指令并作出相应反应的鼠标交互行为,如点击按钮。非系统响应行为即为无法被软件系统识别为明确指令的鼠标交互行为,如浏览行为。

定义7背景行为与活跃行为。对于系统无法识别为明确指令的鼠标行为,用户可能借助鼠标光标帮助其进行认知信息处理的此类鼠标动作为活跃行为。与之相对,用户交互过程中只为了移向某个区域、或无意识的鼠标动作为背景行为。

2.2 鼠标交互数据集构建框架

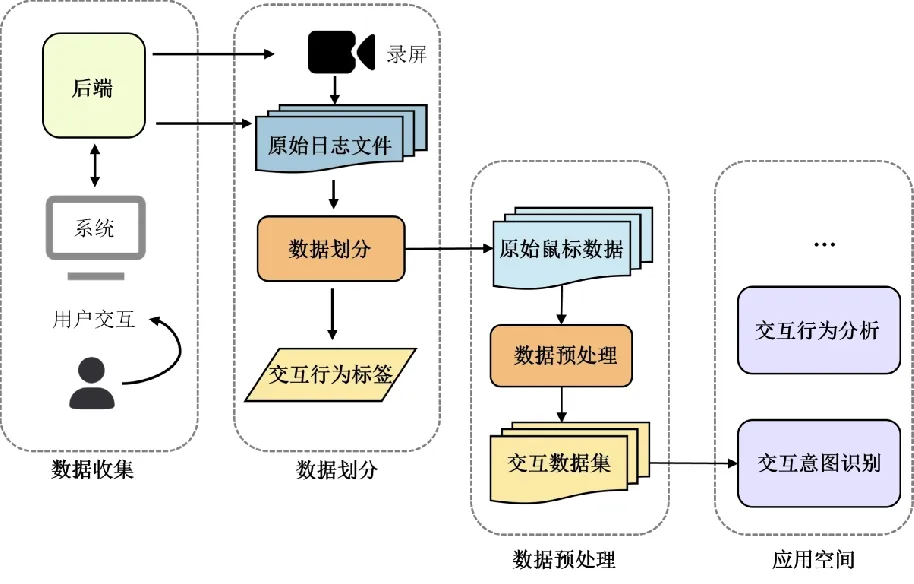

由于缺乏用户使用医学影像阅片系统的公开鼠标交互数据集,为了获得鼠标交互数据及相应的用户交互行为标签,以帮助建立鼠标交互轨迹语义注释模型并验证其性能,本文首先提出了一个鼠标交互数据集构建框架。如图1所示,该框架主要由数据收集、数据划分和数据预处理3个模块组成。数据收集模块收集用户与系统交互过程中的鼠标交互跟踪数据与交互行为标签信息;数据划分模块将原始日志文件划分为原始数据和交互行为标签,其中,交互行为标签在后文用于训练基于监督学习的鼠标轨迹语义注释模型,并验证其性能;数据预处理模块对原始数据集进行格式处理及属性添加。

图1 鼠标交互数据集构建框架Fig.1 Construction framework of mouse interaction dataset

1)数据收集模块。本文数据收集模块用于采集用户与系统交互过程中的3类数据:鼠标交互数据、交互行为标签标记(marker)和屏幕录制视频。此模块主要由屏幕记录器和系统日志记录器2个部件组成。在本文中,系统日志记录器使用Python中的Logging模块及PyQt5鼠标监听模块实现,用于捕获用户与系统交互过程中的鼠标跟踪数据与系统界面参数。其中,所采集的系统参数是根据所使用原型系统的实际界面布局和功能设计的。为了获得准确的用户交互行为标签信息,同时,最大程度上减少参与者在数据收集过程中所需进行的额外标记动作、避免影响正常交互流程,本文进行如下设置:参与者在开始一个交互行为前单击某特定热键,此时系统日志记录器会自动记录一个标记到日志文件中,该标记在后续用于辅助研究人员补充行为标签数据信息。屏幕记录器与日志记录器都运行在系统后台,不会影响用户正常使用过程。由于PyQt5中控件存在不支持部分鼠标监听事件的情况,本文通过重写控件类以实现一个允许完全系统界面鼠标跟踪的自定义服务。

2)数据划分模块。首先,由研究人员结合录屏与交互行为标签标记为日志文件补充交互行为标签信息;然后,通过程序自动将日志文件分离为原始数据集和交互行为标签集。标签数据以JSON格式保存,每个标签数据包含1个用户1次阅片交互过程的总时间、鼠标交互数据总长度、交互行为个数,以及其中每个交互行为的类型、起始时间、起始读数索引。

3)数据预处理模块。首先,对原始数据进行数据格式处理,对于数据中的日期属性,将其转换为时间戳的形式。其次,本文还在原始数据的基础上增加了两个附加属性:①时间间隔属性,表示相邻鼠标交互读数γ(定义1)的时间间隔;②感兴趣区域(areas of interest,AOI)属性[27],依据所用原型系统的功能区域分布划分AOI,以覆盖系统界面的功能元素,并根据交互读数的坐标和系统参数将其映射到对应的AOI上。

基于该框架构建所得鼠标交互数据集由多个鼠标交互数据文件组成,每个文件记录了用户1次阅片交互过程完整的鼠标交互轨迹Ttra(定义2)。

2.3 数据收集

为了采集数据,本文创建了一个自定义的医学影像辅助阅片系统。该系统使用PyQt5开发,用于协助用户进行胸部X光片(chest X-ray,CXR)的读取和诊断。该系统具备基本的交互式图像查看功能(如放大/缩小等),还嵌入了基于人工智能的辅助诊断工具,用户可以使用这些工具辅助阅片。针对该交互系统,共定义了15个AOI区域、20种粗粒度的交互行为及213种细粒度的交互行为,这些交互行为即为用户交互意图。

基于鼠标交互数据集构建框架,本文对用户使用医学影像阅片系统过程中的交互数据进行了收集与处理,以建立相关数据集。数据采集过程共涉及8名影像科医生,均熟悉计算机使用,我们为每个参与者创建独立的账号,以方便区分不同用户的交互记录。一位研究人员在开始进行数据收集前对整体实验流程及该系统的具体功能进行介绍。参与者可以自由探索系统,直到他们清楚地表明已准备好开始进行数据收集过程。在此之后,参与者通过单击录制按钮开始数据收集过程。在数据收集过程中,每位参与者未被告知如何具体执行某个诊断交互行为(例如速度和持续时间),参与者根据自己的偏好与系统进行交互。

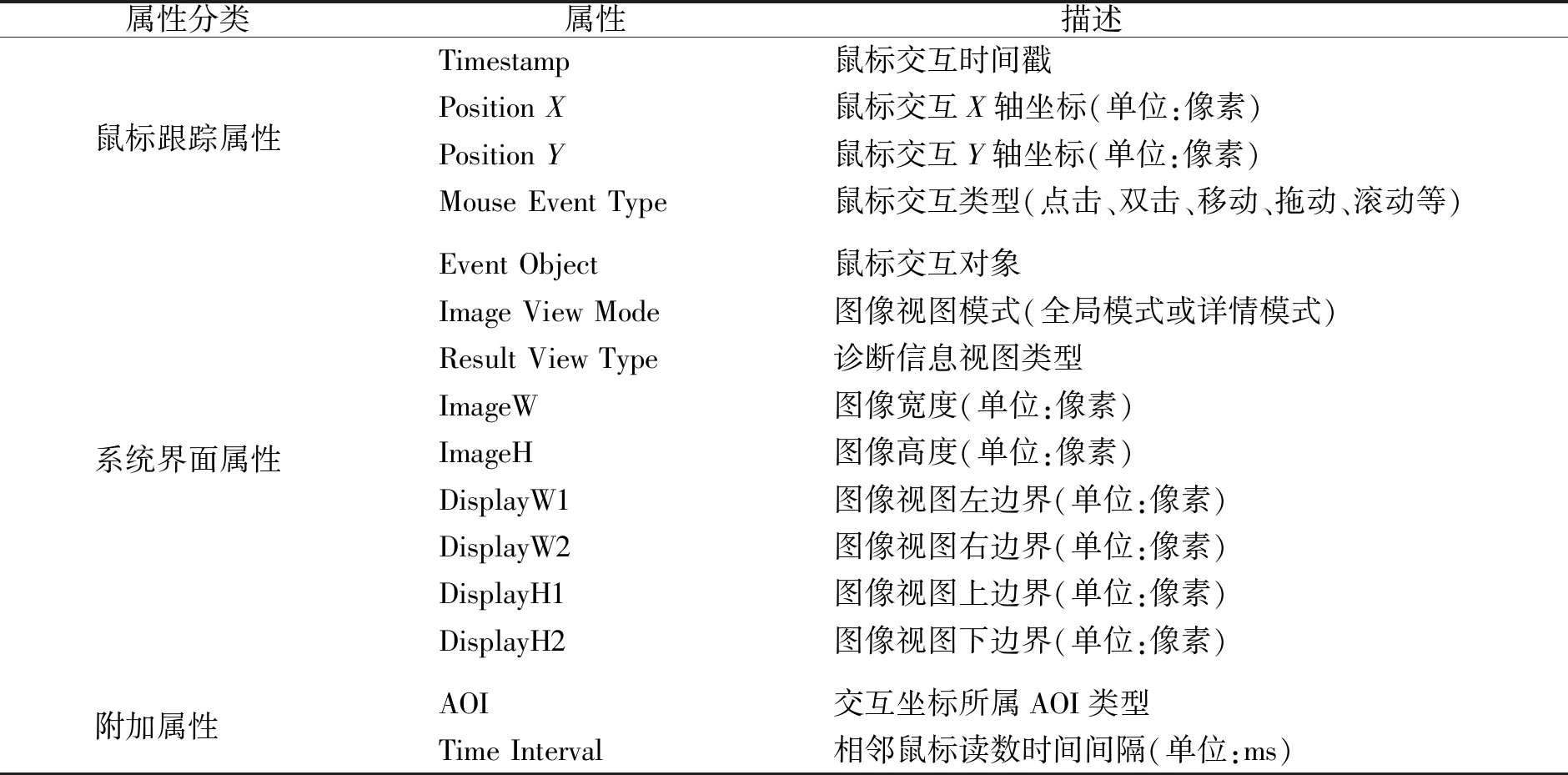

每个参与者被要求对6张CXR影像(3张正常和3张异常)进行阅片,筛选后共收集得到47张影像阅片过程中的鼠标交互数据,即47条鼠标交互轨迹Ttra,平均时长约为204 s。数据集总计包含580 083个鼠标交互读数γ及1 580个粗粒度交互行为语义标签,鼠标交互读数γ的具体字段说明如表2所示。

表2 鼠标交互读数属性字段Tab.2 Mouse interaction reading properties

3 方法设计

3.1 鼠标交互轨迹语义理解框架

本文提出一种基于鼠标交互轨迹语义理解的用户交互意图识别方法,通过对鼠标交互数据进行轨迹语义理解,挖掘鼠标交互数据背后所表示的用户交互行为语义信息。如图2所示,本文提出的鼠标交互轨迹语义理解框架主要分为3层:第1层输入鼠标交互轨迹Ttra;第2层进行轨迹分段,根据鼠标交互读数属性将Ttra划分多个轨迹子序列Tsub(定义3),获得鼠标结构轨迹Tstr(定义4);第3层对鼠标结构轨迹Tstr进行语义注释后输出鼠标语义轨迹Tsem(定义5),实现交互意图的识别。

图2 鼠标交互轨迹语义理解框架Fig.2 Framework of semantic understanding for mouse interaction trajectory

3.2 轨迹分段

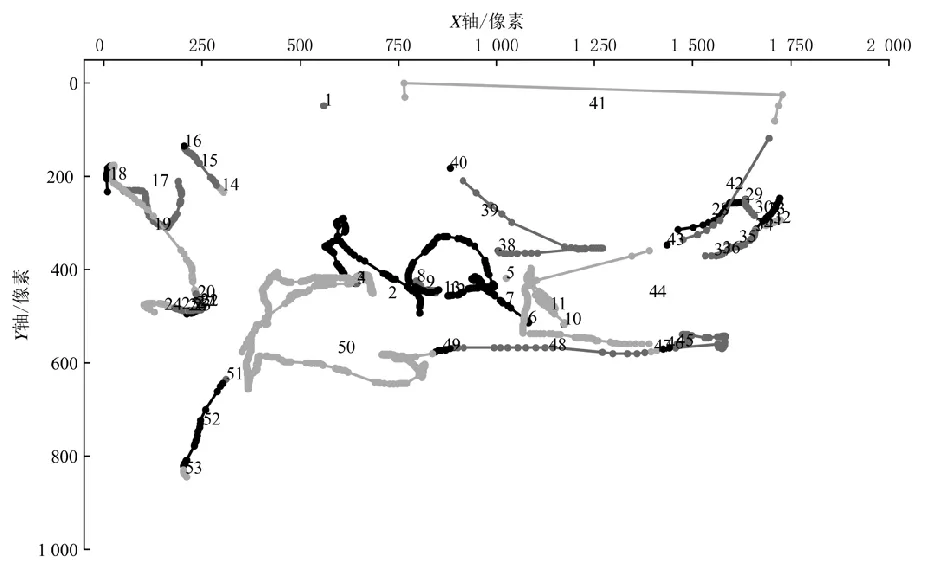

轨迹分段为时空数据分析的基本步骤,常见的轨迹分段方法主要有:基于连续读数的时间间隔分段、基于停留点分段、基于感兴趣区域分段等。其中,基于感兴趣区域的分段方法通常以某兴趣点(point of interest,POI)为中心半径划出一个范围区域,凡是落在该区域内的轨迹点都由该兴趣点来表示,划分后的轨迹则可按照从一个兴趣点到下一个兴趣点的顺序依次表示出来[28]。由于本文面向的研究对象为人机交互系统,在大多软件系统中,特定的系统功能只能发生于界面中特定的功能区域内,同时在同一功能区域内,根据鼠标交互类型的不同也可能实现不同的功能。如在本文设计使用的原型系统中,鼠标单击图像视图区域不会引发系统响应,而双击该区域则会调用系统视图切换功能。因此,本文先根据鼠标交互读数γ中的AOI属性对轨迹进行初步分段,在此基础上再使用读数的Mouse Event Type属性进一步将鼠标交互轨迹Ttra划分为多个连续子序列,每个子序列内读数的AOI属性及Mouse Event Type属性相同。经此步骤,鼠标交互轨迹Ttra转换为鼠标结构轨迹Tstr,如图3所示为本文数据集中一条鼠标交互轨迹的分段示例。

图3 轨迹分段Fig.3 Trajectory segmentation

3.3 轨迹语义注释

经过轨迹分段,鼠标交互轨迹转换为鼠标结构轨迹Tstr={〈Tsub〉},由一系列轨迹子序列Tsub组成。本节通过对Tsub进行语义注释,获得Tsub的细粒度交互行为语义标签bfine,实现鼠标结构轨迹Tstr到鼠标语义轨迹Tsem={〈Tsub,bfine〉}的转换。

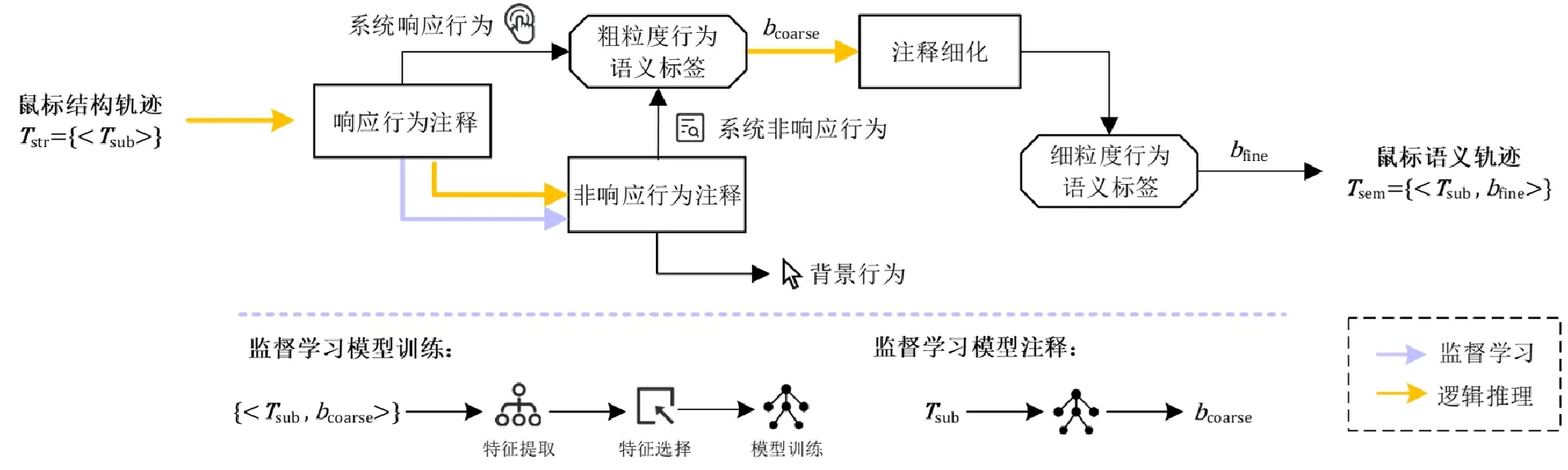

针对鼠标交互轨迹的语义注释流程概览如图4所示。首先,结合逻辑推理与监督模型分步实现轨迹的系统响应行为及非系统响应行为(定义6)语义注释,得到粗粒度交互行为语义标签bcoarse。之后,对粗粒度标签进行注释细化,得到细粒度交互行为语义注释标签bfine,获得用户交互意图的识别结果。其中,粗粒度交互行为语义注释的具体过程如下:依据轨迹子序列Tsub的交互读数属性对鼠标结构轨迹Tstr={〈Tsub〉}中各子序列语义进行逻辑推理判断,若为系统响应行为则将其划分为预定义的响应类别,否则进行下一步非系统响应行为注释。对于未被注释为系统响应行为的鼠标轨迹,先通过逻辑推理将其划分为具体的轨迹语义注释任务,再基于监督学习轨迹语义注释模型对轨迹子序列Tsub进行背景行为/活跃行为(定义7)判别,若为活跃行为则匹配获得Tsub的非系统响应行为类别。系统响应行为与非系统响应行为均为注释所得轨迹的粗粒度交互行为语义bcoarse。

图4 鼠标交互轨迹语义注释设计概览Fig.4 The overview design of mouse interactiontrajectory semantic annotation

3.3.1 鼠标交互特征提取

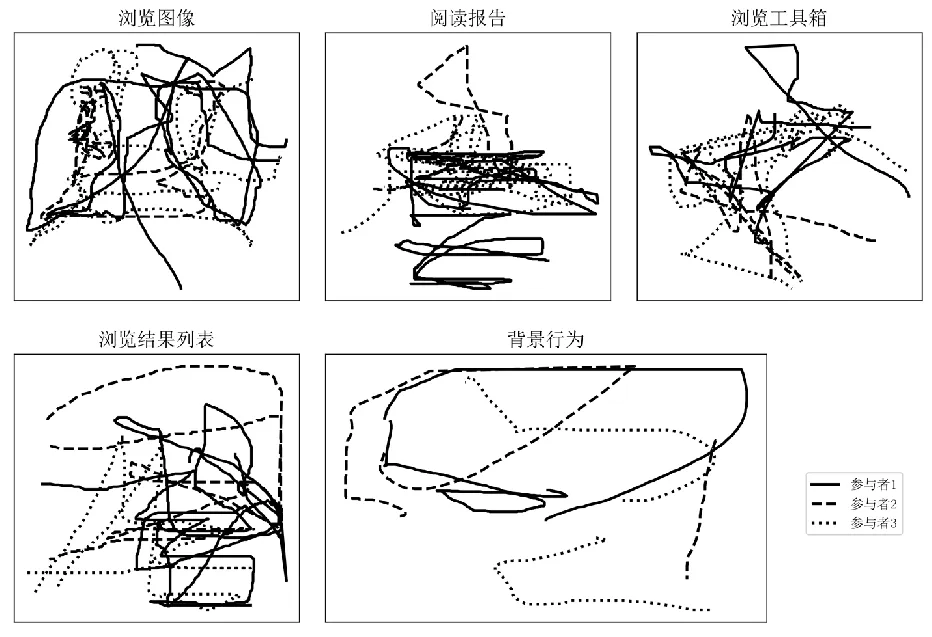

本文从描述活跃行为轨迹与背景行为轨迹差异性的角度提取鼠标交互特征,用于鼠标轨迹的非系统响应行为语义注释任务中。文中共涉及4类活跃行为,如图5所示为4种活跃行为轨迹及背景行为轨迹的示例。

图5 交互行为轨迹可视化示例Fig.5 Visualization example of interaction behavior trajectory

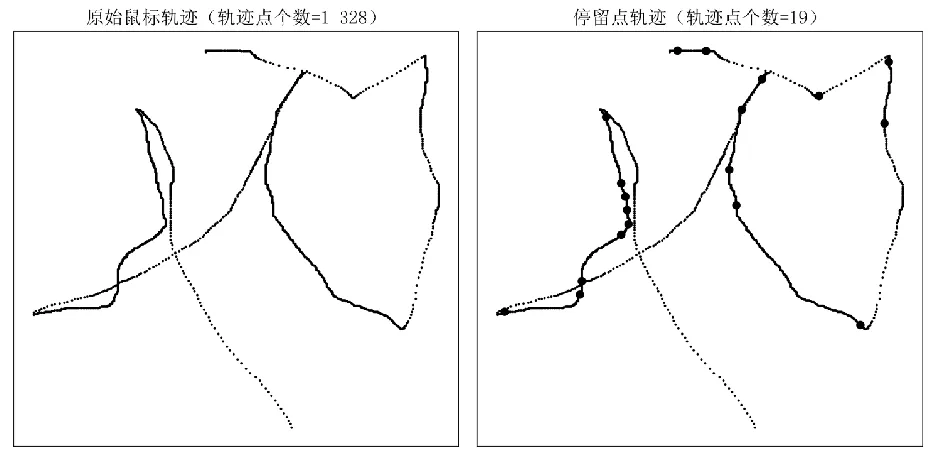

从图5可以观察到,4类活跃行为轨迹与背景行为轨迹间具有较大差异。相较于活跃行为轨迹,背景行为移动轨迹中直线运动较多,移动方向转变次数较少,但转变角度较大,呈现较为简单的运动轨迹。基于上述规律,本文提取了鼠标运动的轨迹轮廓特征及角度特征,以识别背景行为与活跃行为所具有的不同轮廓属性。同时,考虑到鼠标运动与用户思维处理过程的相关性以及人的认知处理过程特性,还提取了鼠标运动速度相关特征。除此之外,停留点表示用户轨迹中在某一段时间内保持相对静止的位置,通常由数个轨迹点组成。在眼动信号处理领域,眼动轨迹在一个区域内运动的停顿被识别为注视点(fixation),通常这些停顿持续时间在100~600 ms之间[29]。注视点常被用于计算各类可反映用户人机交互过程的眼动指标。受上述概念启发,本文使用(100 ms,30像素)及(300 ms,30像素)作为两组时间、距离阈值对鼠标运动轨迹进行停留点检测,并将停留点个数、停留总时间作为额外特征。图6为使用300 ms时间阈值得到的停留点轨迹示例。

图6 停留点检测Fig.6 Stay points detection

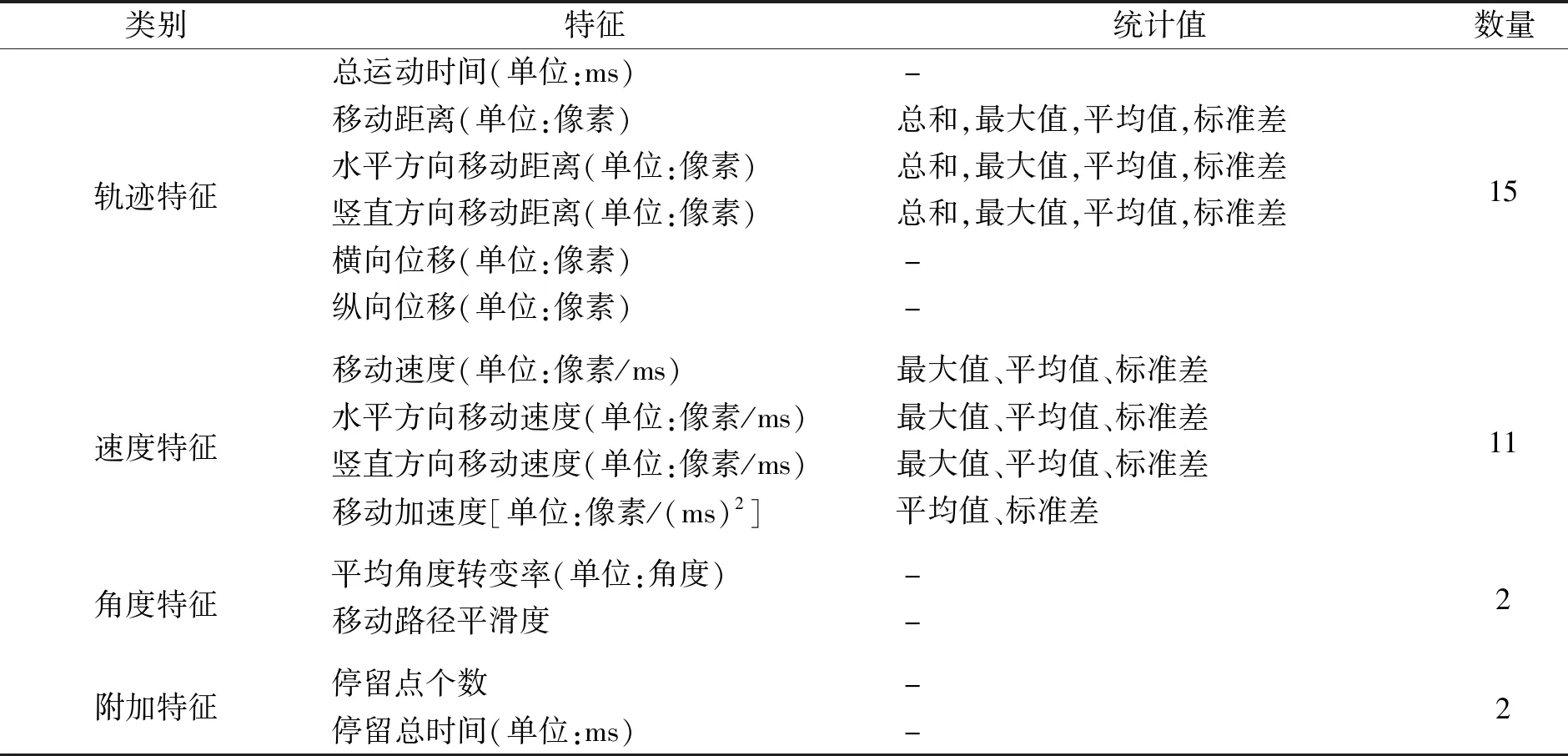

本文共提取30个特征用于监督学习鼠标轨迹语义注释,具体特征如表3所示。

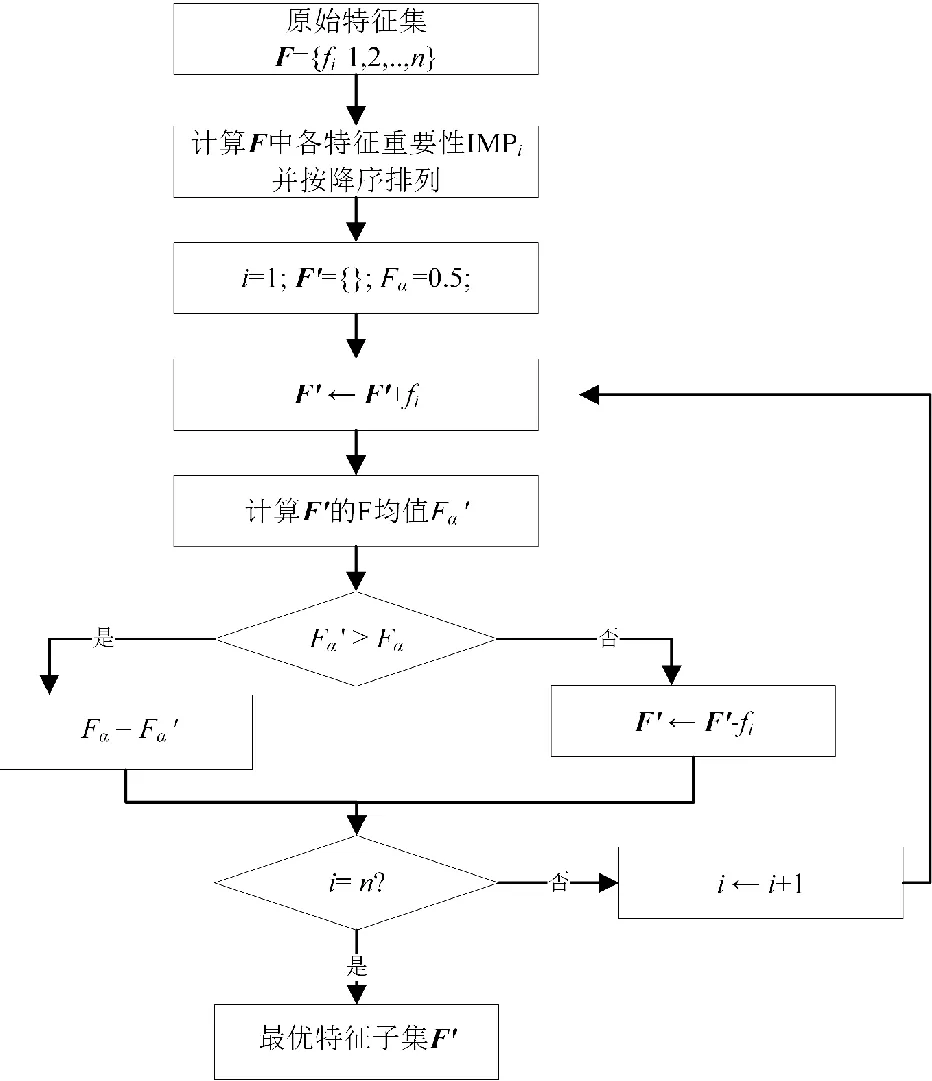

3.3.2 基于贪婪策略的序列前向特征选择算法

在活跃行为轨迹与背景行为轨迹具有差异的同时,不同的活跃行为表示用户不同的认知处理过程,其轨迹也具有较为不同的特性。因此,为了降低冗余和不相关特征对轨迹识别过程的影响,本文对所提取的全部轨迹特征、速度特征和角度特征进行特征选择,采用序列前向选择的方式从原始特征集中寻找最优特征子集,并在选择过程中使用贪心策略,每次选择重要性最高且可使得模型性能提升的特征。

表3 鼠标交互特征Tab.3 Mouse interaction features

特征选择的具体流程如图7所示。

图7 特征选择流程图Fig.7 Feature selection flow chart

(1)

式中:P表示精准率;R表示召回率。

3.3.3 基于监督学习的鼠标轨迹语义注释

本文使用监督学习模型对轨迹进行非系统响应行为语义注释,由于经分段后所得鼠标结构轨迹由长度不等的轨迹子序列Tsub组成,在此,文中采用保留标签的滑动窗口策略,通过滑动窗口从Tsub中采样固定长度的窗口序列,每个窗口序列的标签与其所属Tsub的交互行为类别标签一致。

给定一个长度为l的轨迹子序列Tsub{γi,γi+1,…,γi+l-1},经滑动窗口采样及交互特征提取,可得到n个特征向量,表示为Mat=(V1,V2,…,Vn)T。其中:Vi=(v1,v2,…,vj)为每个窗口序列的特征向量,j为最优特征子集长度;n=(l-w)/s+1为窗口序列的个数,w为滑动窗口长度,s为滑动步长。

鼠标轨迹语义注释模型对一段轨迹子序列Tsub中的n个窗口序列进行语义识别,获得n个窗口序列的识别结果,则此段轨迹子序列Tsub的注释结果最终由窗口序列多数标签决定,即

(2)

式中:lactive为多个窗口序列中活跃行为标签的个数;lbackground为背景行为标签个数。根据注释结果获得此段轨迹子序列的粗粒度语义标签bcoarse。

3.3.4 注释细化

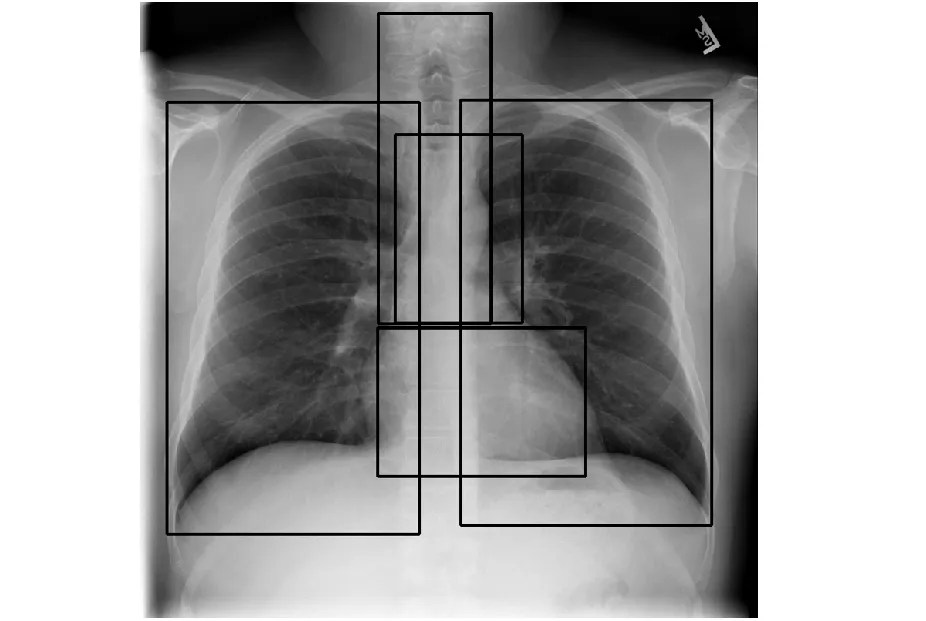

通过轨迹语义注释,已为鼠标交互轨迹注释粗粒度交互行为语义标签。接着,通过鼠标交互读数γ的系统界面属性将交互行为进一步划分为更细粒度的类别,以表示更细粒度的用户交互意图。为了对识别得到的与图像操作相关的行为进行细化,对用于实验的CXR影像进行手动标注。如图8所示,为每张影像标注5个解剖区域边界框,包括“左肺”“右肺”“气管”“上纵隔”与“心影”,每个边界框由其在原始CXR图像坐标系中的左上角点(X1,Y1)和右下角点(X2,Y2)描述。结合此补充数据,可以将相对于系统界面坐标系的原始鼠标坐标数据映射到CXR影像坐标系上,从而实现诸如“浏览图像”行为到“浏览图像心影区域”行为的细化。

图8 CXR解剖边界框标注示例Fig.8 Sample CXR case with overlaying anatomical bounding boxes

经轨迹语义理解,鼠标交互轨迹Ttra丰富化为带有交互行为语义信息的鼠标语义轨迹Tsem。接着,将类型相同且时间间隔小于2 s的行为标签进行合并,最终得到交互行为语义标签序列bseq={〈bi〉}。每个标签bi由4个属性值描述,可表示为bi={bfine,bcoarse,Tstart,Tend}。其中,各属性分别代表该标签的细粒度交互行为类型、所属粗粒度交互行为类型、起始时间及结束时间。该标签序列则表示用户交互过程中各阶段的交互意图。

4 实验结果与分析

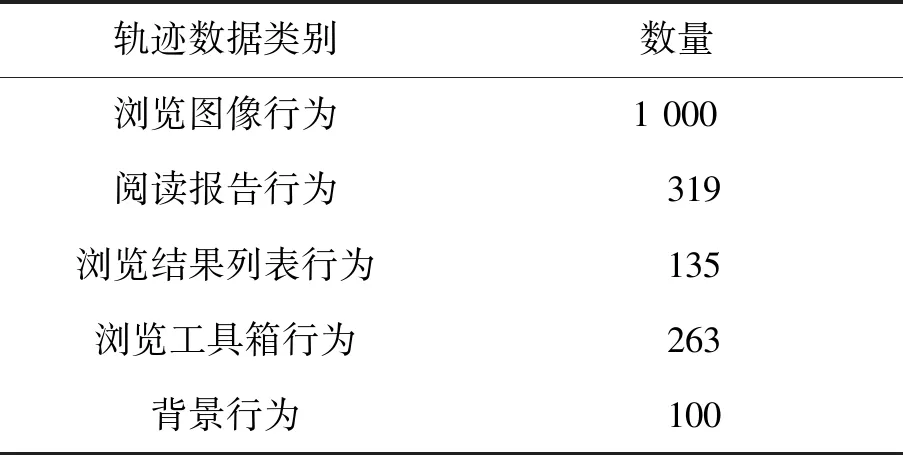

4.1 数据集

为了验证所提方法的有效性,本文在构建的鼠标交互数据集上分别进行了监督模型语义注释实验及交互意图识别实验。

对于监督模型语义注释实验,对轨迹子序列进行等长滑动采样后进行轨迹识别。共涉及4类活跃行为,故针对每类活跃行为建立相应的活跃行为/背景行为语义注释模型。具体实验数据如表4所示,所有实验均采用7∶3的训练集/测试集划分。

表4 基于监督学习的轨迹语义注释实验数据说明Tab.4 Experiment data description of trajectory semantic annotation based on supervised learning

对于交互意图识别实验,收集所得的1 580个粗粒度交互行为标签作为真实标签(ground truth),对意图识别结果进行评价。

4.2 基于监督学习的轨迹语义注释结果

4.2.1 评价指标

由于本文立足的长期目标为研究以用户为中心、能感知用户交互意图从而提供自适应辅助干预的智能计算机系统,系统能尽可能全面地识别出用户交互意图是提供自适应帮助的前提,但同时还需保证用户的使用体验,避免在不恰当的时候提供冗余信息。保证用户交互意图的识别率即为对召回率进行要求,保证用户交互体验即为对精准率进行要求。综上,本文使用准确率、召回率、精准率及F均值作为基于监督学习的轨迹语义注释部分的评价指标,其中,活跃行为轨迹作为正例,背景行为轨迹作为负例。

4.2.2 实验结果

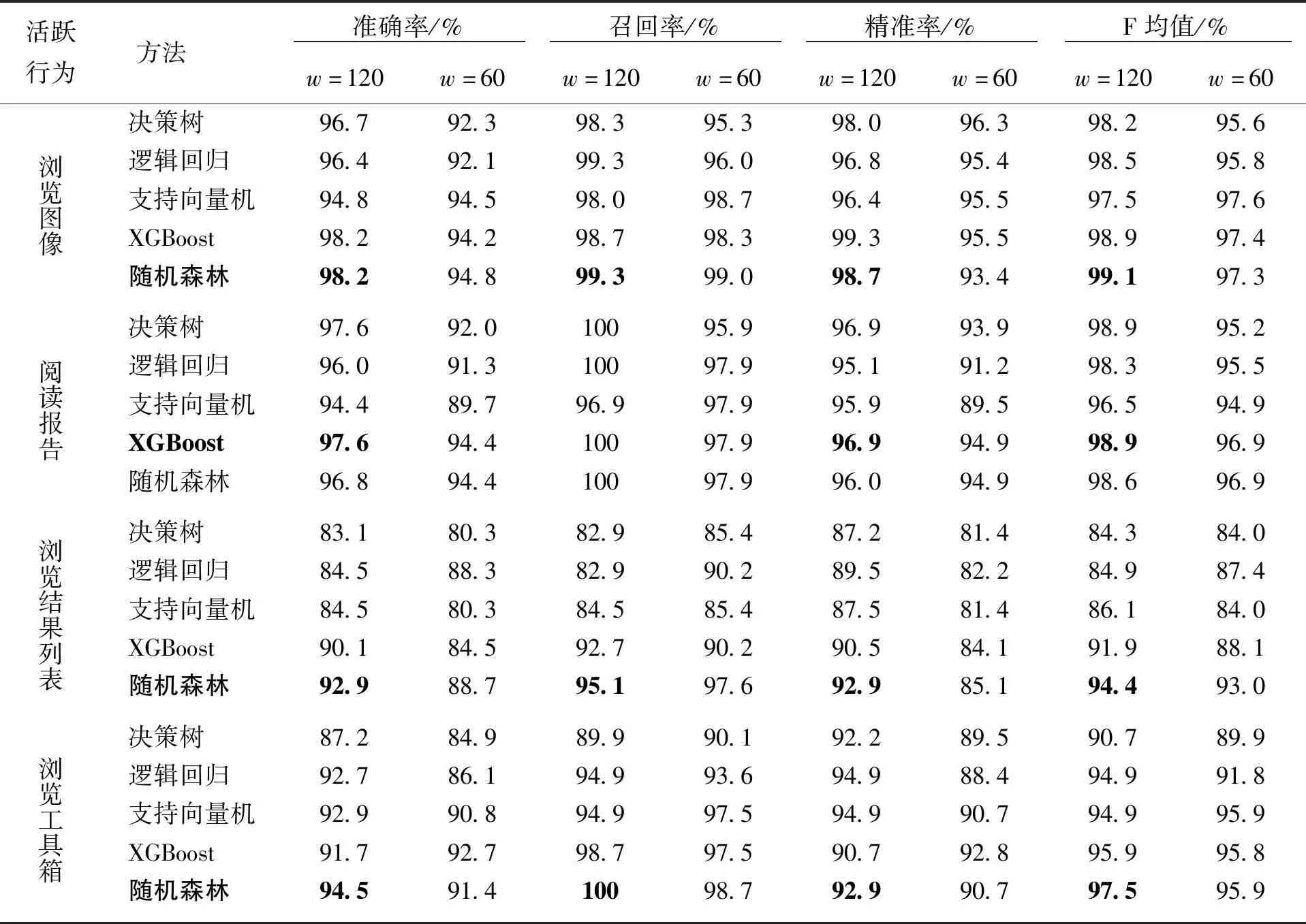

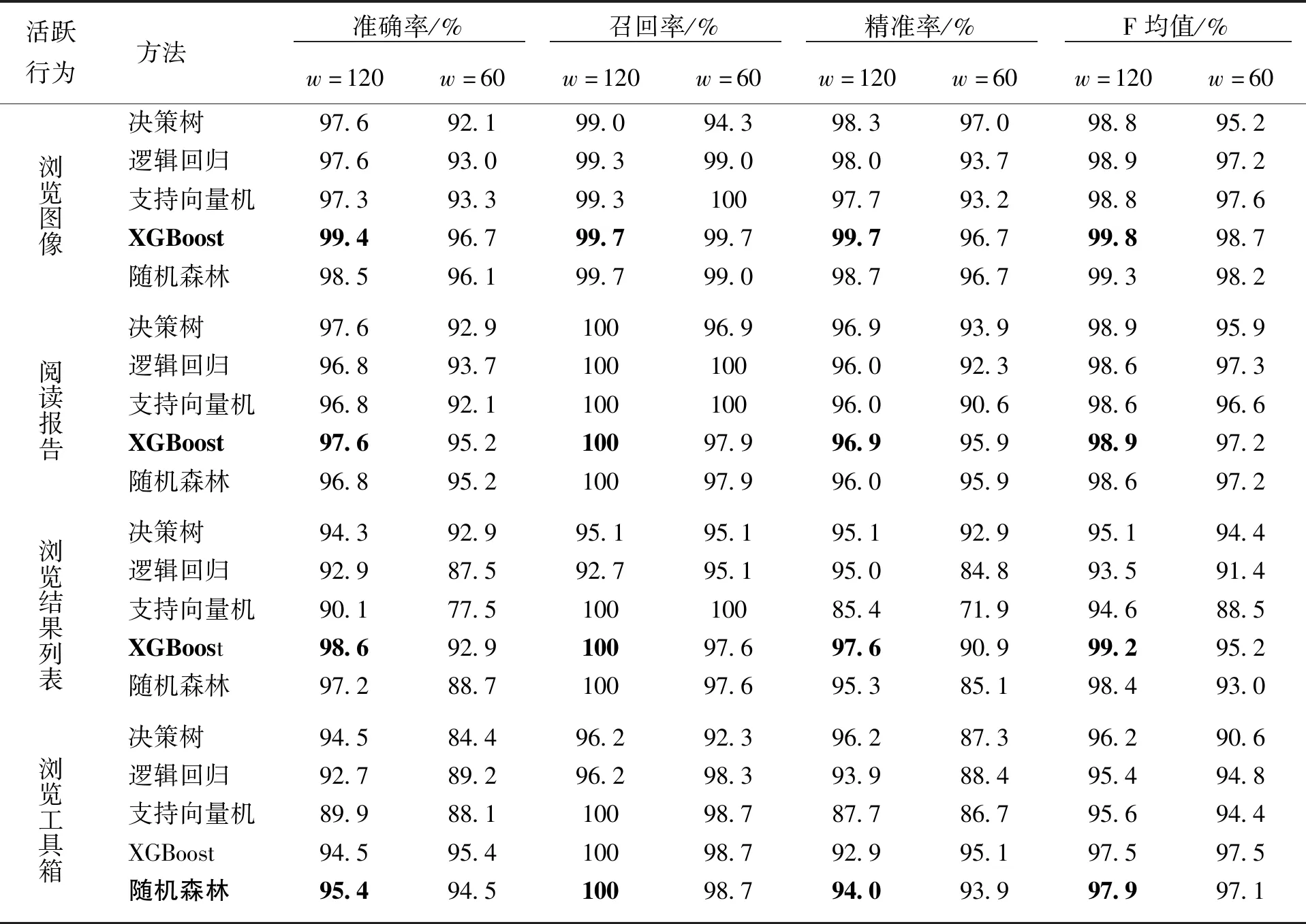

本文使用w=120,s=30及w=60,s=30两组滑动窗口采样参数对轨迹子序列进行等长滑动采样,之后对各窗口序列采用决策树、逻辑回归、支持向量机、随机森林和XGBoost 5种方法进行4类活跃行为/背景行为语义识别任务。

表5为使用原始特征集所得的语义注释结果,可以看到,本文提取的特征可以有效地实现轨迹识别。4类语义注释任务的最优结果(表5中加黑标注)均为使用长度为120的滑动窗口所得,说明相比于长度为60的滑动窗口,使用长度为120的滑动窗口采样时得到的识别结果更好。滑动窗口的选择对于识别性能具有影响,当滑动窗口过小时可能无法较好地提取到局部轨迹所具有的特征信息。集成模型可以更好地发现有效的特征和特征组合,识别性能普遍较好,其中,3类任务使用随机森林模型获得最优结果,1类任务使用XGBoost模型获得最优结果。

表5 基于监督学习的轨迹语义注释评价结果Tab.5 Evaluation result of trajectory semantic annotation based on supervised learningz

表6为经特征选择后所得语义注释结果,其中,4类语义注释任务的最优模型分别选择了15、24、7及11个特征。其中,加黑标注的为每类任务的最优模型。可以发现,通过特征选择,模型的识别能力得到一定提升。“浏览结果列表”行为的识别可能受到数据量影响,初步识别效果较差,但经过特征选择,模型对其识别的能力提升较大,并获得了较高的评价分数。相比而言,“浏览工具箱”行为的识别效果低于其他3者,可能由于此类行为的鼠标交互轨迹中各局部轨迹的区别较大,导致窗口序列间特征具有较大差异。同样,可以从实验结果中发现,在使用原始特征集进行轨迹语义注释时,随机森林模型的识别性能相对而言较好,而通过特征选择,XGBoost模型的识别性能得到较大幅度的提升,在3类注释任务中取得了最高的评价分数,并且在“浏览工具箱”行为识别中获得97.5%的F均值,仅略低于表6中随机森林模型97.9%的最佳分数。

综上所述,本文所提取的特征可以有效实现轨迹识别。不同的活跃行为轨迹间存在差异,通过特征选择,可以为不同的语义注释任务选择更合适、区分度更高的特征,从而能够进一步提升模型的轨迹识别能力,同时,还可减少相关计算量。交互行为在不同时段具有差异,XGBoost模型通过集成策略可以更好地学习交互行为轨迹中各窗口序列特征,具备较强的识别注释能力。

在得到各组最优特征子集的基础上,本文对辅助特征组性能进行实验验证。结果表明停留点特征对不同类别的活跃行为注释任务也具有不同的影响。对于“浏览图像”行为注释,加入辅助特征组进一步提升了模型识别能力;对于“浏览工具箱”行为反而影响了模型性能;对于其他两类行为的识别未有较大影响。

表6 经特征选择的轨迹语义注释评价结果Tab.6 Evaluation result of trajectory semantic annotation after feature selection

4.3 交互意图识别结果

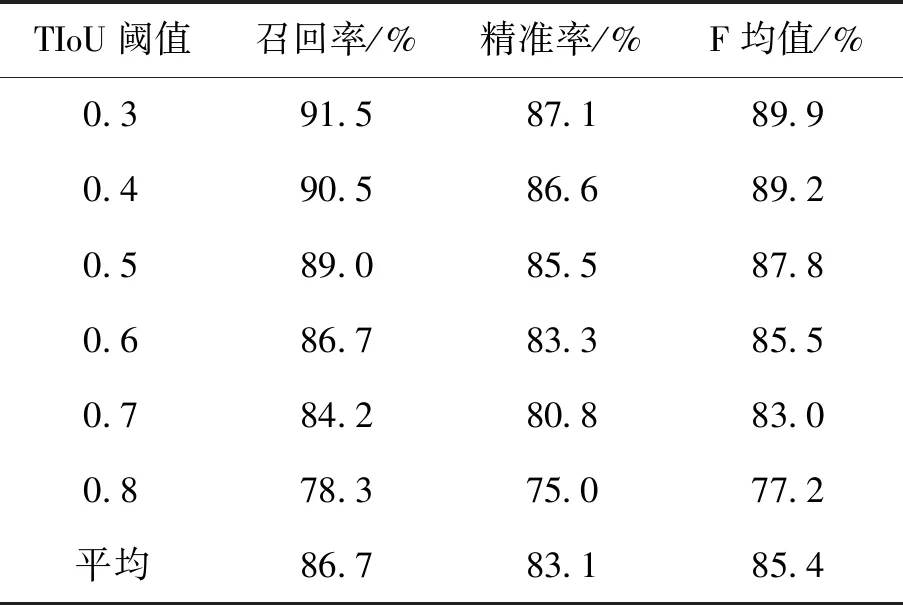

基于鼠标轨迹语义理解的交互意图识别实验仍采用召回率、精准率及F均值作为评价指标。由于部分交互行为在段时间内持续进行,为了能够验证所提方法识别结果的时间精度,在此对真实标签时间窗口与本文识别所得标签时间窗口进行时间交并比(time-intersection over union,TIoU)计算,当且仅当二者标签类型相同且TIoU大于阈值时判断识别结果正确。

选择每类监督模型语义注释任务中最优模型用于识别轨迹语义,面向所构建的包含1 580个粗粒度交互行为的鼠标交互数据集,本文方法共识别1 647个粗粒度交互行为。实验结果如表7所示,在[0.3∶0.8∶0.1]的TIoU阈值设定下,该方法平均识别召回率、精确率、F均值分别为86.7%、83.1%及85.4%,表明该方法可以在保证识别精准率的情况下获得较高召回率,同时,意味着面向日后开发新一代智能阅片系统的任务,该方法可以在保证用户使用体验的基础上有效理解、识别用户交互意图,为实现用户交互意图预测奠定基础。

表7 交互意图识别评价结果Tab.7 Evaluation result of interaction intention recognition

5 总结与展望

面向目前医学影像阅片诊断领域中对用户人机交互过程相关研究缺失、数字医学影像阅片任务中产生的大量鼠标交互数据未得到充分利用的背景,本文探索了鼠标交互数据在医学影像阅片领域中的应用。基于该研究目标建立了鼠标交互数据集构建框架,并基于该框架对用户鼠标交互数据进行收集。针对传统鼠标轨迹相关研究缺乏对轨迹局部性分析理解的问题,本文提出鼠标交互轨迹语义理解框架,对用户鼠标交互轨迹进行轨迹分段及交互行为语义注释,以挖掘用户影像阅片交互意图。通过实验验证了根据鼠标交互轨迹实现用户交互意图识别的可行性以及鼠标交互轨迹语义理解方法的有效性。本文的工作可为开发以用户为中心的新一代人机协同式智能影像阅片系统提供研究思路与基础框架,同时,可能激励相关研究人群进一步探索鼠标交互数据在医学影像阅片诊断中的应用价值。

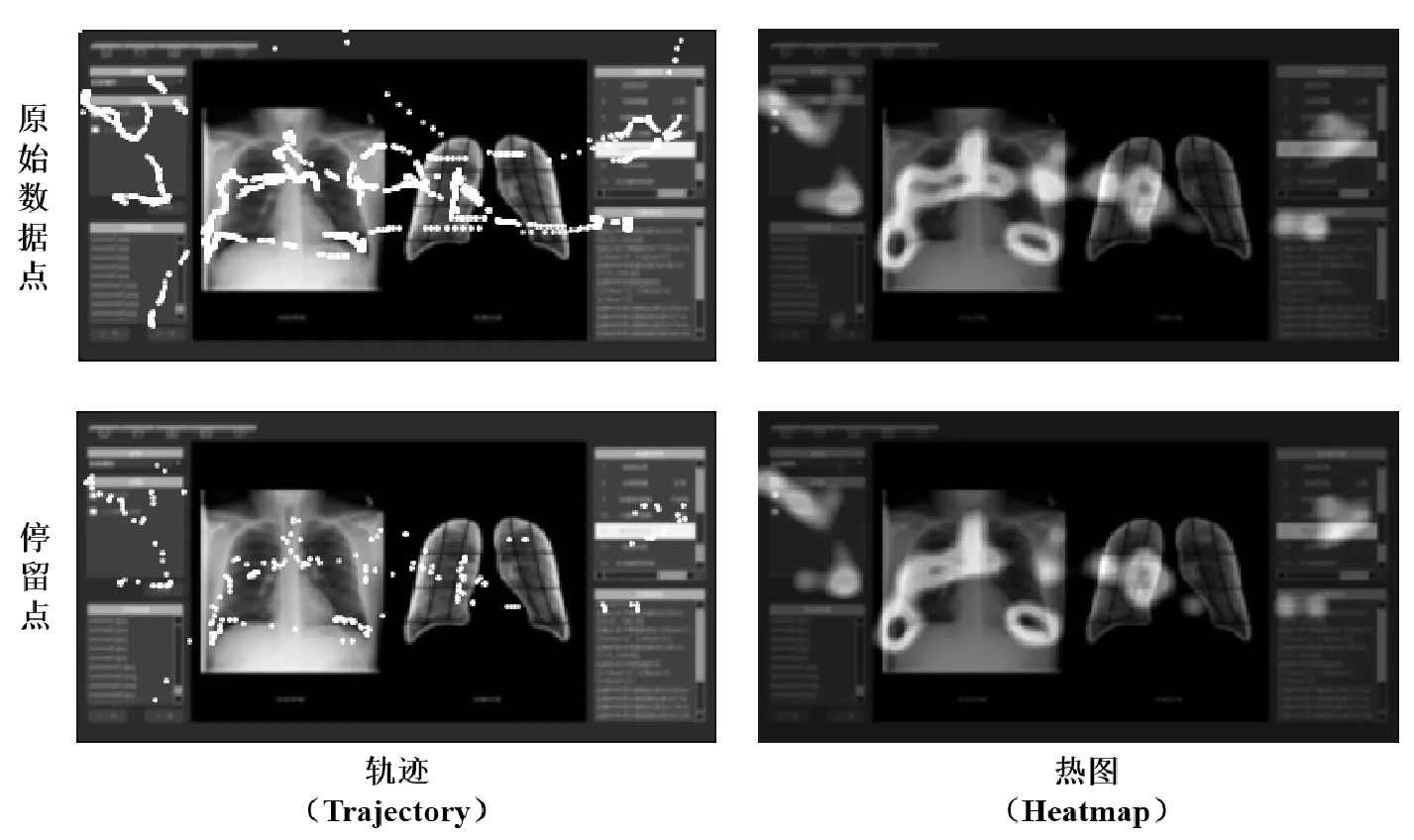

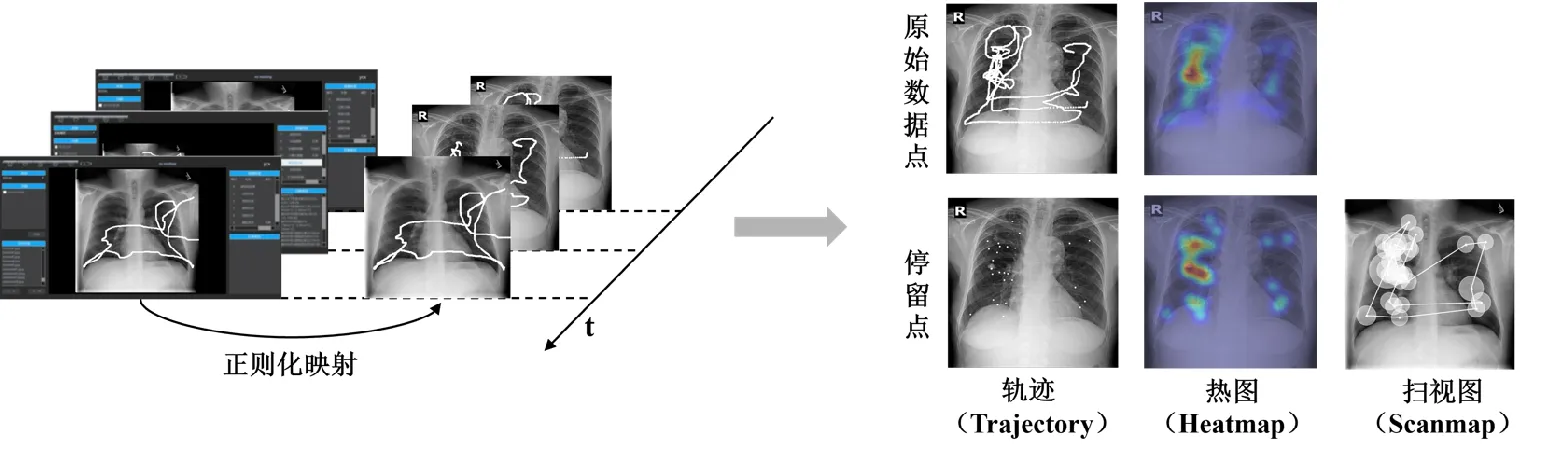

虽然本文的长期研究目标为辅助开发新型影像阅片系统,主要的研究内容为面向鼠标交互数据实现用户交互意图识别,但本文所提出的鼠标交互数据集构建框架及鼠标交互轨迹语义理解框架对于其他相关研究领域同样具有价值。例如鼠标交互数据可以用于还原用户与系统交互的轨迹,通过轨迹及交互热区分析(见图9),可为建模用户使用偏好、辅助计算机系统设计与优化提供大量准确、直观的数据。医学影像阅片交互数据还可用于获取医生阅片过程中对影像的注意力分布。如图10所示,本文将识别得到的“浏览图像”行为轨迹通过正则化处理,映射到该轨迹对应的CXR上,以获取用户一次阅片过程中对该影像完整的浏览轨迹数据,针对该轨迹数据同样可以生成热图及扫视图。此类交互数据蕴涵在医生日常工作中,可作为先验知识帮助深度学习算法性能优化及提高模型可解释性[30]。

图9 系统使用鼠标交互热图Fig.9 Mouse interaction heatmap during system usage

图10 浏览影像鼠标交互热图Fig.10 Mouse interaction heatmap during image browsing

由于本文工作为此方向的一项初步研究,未来将从以下方面对本文工作进行拓展和改进:①基于本文交互意图识别结果实现用户交互意图的预测;②目前本文实验在小样本量下实现,未来拟扩大数据采集规模,以获得更具泛化性的模型及研究结果;③拟通过设计与实验验证此类鼠标交互数据作为先验知识在辅助医学影像人工智能诊断算法训练中的可用性。