基于深度学习的楚国墓葬纺织品图像复原

沙莎 魏宛彤 李强 李斌 陶辉 江学为

摘要: 中国楚国时期纺织品由于其墓葬所属年份较为久远,故其纺织品文物在结构和纹样方面存在残缺、破损、污渍等问题。纺织品文物在修复时只能依赖纺织品修复者的经验和审美,且在修复过程中可能会因为修复人员的主观审美及经验出现修复结果不理想或二次损毁等情况。本文通过收集纺织品文物的图像数据建立纺织品图像数据库,采用深度学习方法中的生成对抗网络模型(GAN),针对残缺的纺织品文物,在图像层面进行补全修复,避免了对纺织品文物的接触,减少在修复过程中对文物的二次损毁。通过数字化方法复原纺织品文物的图像,使其结构完整,纹样连贯,从主观评价方面具有较好的复原效果。复原后的纺织品文物图像可以用于指导实物复原、展览展出等,对楚国墓葬纺织品的研究具有一定的借鉴意义。

关键词: 深度学习;图像复原;生成对抗网络;楚国墓葬;纺织品文物;破损纺织品

中图分类号: TP941.26; TS391.72

文献标志码: A

文章编号: 1001-7003(2023)05-0001-07

引用页码: 051101

DOI: 10.3969/j.issn.1001-7003.2023.05.001

基金项目:

国家自然科学基金项目(61802285);湖北省教育厅科学研究计划重点项目(D20201704);湖北省服装信息化工程技术研究中心开放基金项目(184084006);纺织服装福建省高校工程研究中心开放基金项目(MJFZ18103);福建省新型功能性纺织纤维及材料重点实验室开放基金项目(FKLTFM1813);武汉纺织服装数字化工程技术研究中心开放课题项目(0100000)

作者简介:

沙莎(1987),女,副教授,博士,主要从事针织服装数字化的研究。

古代纺织品文物大多随墓葬出土,與所陪葬的金银铜器等接触,造成纺织品表面常有锈斑、血渍等污渍斑点,也曾出现焚烧后碳化的残缺布片,再加上纺织品文物主要构成是棉、麻、丝、毛等天然纤维,所以水蚀、霉菌、虫蛀的侵蚀导致纺织品文物呈现出残缺、有破洞的状态。其次纺织品文物往往是折叠后存放的,故其在出土后会有折叠扭曲和褶皱的出现[1-3]。埋藏环境与保存环境的温度、湿度及大气中有害物质的附着使纺织品文物在颜色上也存在氧化褪色的现象,长时间与空气接触纺织品的纤维强度下降,发生脆化,易出现断裂,破坏纺织品原貌[4]。近年来,研究者针对纺织品文物的修复大多是在古代纺织品实物基础上进行的,需要纺织品文物修复人员对其进行揭取、整理、清洗、拼接,最后再进行修复工作。其中王淑娟[5]针对脆弱的丝织品文物的修复和保护,采用了绉丝纱作为修复材料,将其包覆在纺织品文物的表面起到保护作用。王菊等[6]采用了背衬织物现代染色技术将现代织物衬垫在纺织品文物后,使文物与背衬融为一体[7],对纺织品文物起到了加固的作用,并且有复原结构、纹样和色彩融合的效果,增强了纺织品文物的观赏性。但以上的修复工作复杂且繁琐,又经常接触对身体有害的物质,不仅要求修复人员有着超高的专业技术,也考验着复原人员的耐心和身体素质。与此同时,纺织品本身较为脆弱,长时间的修复工作也很容易造成文物的二次损毁。所以采用数字化的手段从古代纺织品文物的图像角度入手,引入深度学习的方法,对古代纺织品文物的图像进行修复是极其必要的。

图像修复在计算机领域是一个重要的研究课题[8],传统的图像修复技术主要分为两大类:一是基于结构对图像数据进行修复,这类方法典型的有基于偏微分的修复技术[9-11],如Chan等[12]提出的曲率驱动扩散模型、CDD模型,以及基于全变分的图像修复技术和Eulers elastica模型[13]等;二是基于纹理对图像数据进行修复,典型的有Criminisi等[14]提出的纹理合成算法。但是传统的修复方法在针对很小且细微的破损时有较好的修复效果,复原的纺织品文物图像的信息较为浅层,提取不到纺织品文物图像的深层特征,并且面对纺织品文物较大的破损时容易出现修复后的纺织品文物图像纹理混乱、边缘不连贯等问题,复原效果较差。而基于深度学习的图像修复技术则可以提取到图片更高维度的特征,通过对构建

的修复模型的训练,从而达到较好的复原效果[15]。目前,基于深度学习对图像进行修复的算法模型主要有三类:其一,基于卷积神经网络(Convolutional Neural Network,CNN)[16]的图像修复算法,CNN是具有深度结构的前馈神经网络,它的出现可以使计算机更好地对图像进行特征学习;其二,是依靠生成器和判别器的相互“博弈”来修复图像的生成对抗网络模型(Generative Adversarial Networks,GAN)[17-18];其三,是自编码器(Autoencoder,AE)概念[19],2006年Hinton等[20]提出的降噪自编码器(Denoising Autoencoder,DAE)就是基于自编码器的概念,可以将低维数据恢复出原数据。上下文编码器(Context Encoder,CE)算法[21]是较为经典的编码解码修复算法,但容易忽略图像的全局特征,所以修复好的图像容易出现边缘连接不连贯及纹理结构模糊等问题。本文针对楚国墓葬纺织品图像的特点,选择在图像生成领域效果较好的GAN图像修复模型,并且在GAN的基础上,引入自编码器概念中的U-Net结构作为生成模型,主要为了解决纺织品图像数据较少的问题,判别模型主要由卷积层来组成,通过生成器与判别器的相互博弈来进行纺织品文物图像数据的复原。以此,为古代纺织品的文物修复提供效果参考和古代纺织品纹样、制造技术提供支持。

1 修复流程

近年来,随着考古工作的兴起,与楚国相关的墓葬发掘越来越多。对于楚国疆域范围的界定,多数人认为是湖北、湖南等发掘楚墓较多的地区,但实际上,楚国时期出土的墓葬在河南的南部、陕西的东南部和安徽的中北部均有相当可观数量的发现和挖掘[22]。随着越来越多出土的楚国文物,对于文物的保护工作也是迫在眉睫。楚国墓葬出土的文物依材质大致可以分为以下几类:青铜器、漆器、陶器、金银器、纺织品等。其中只有纺织品是柔性文物,其余均为刚性文物,所以对于纺织品这种形态不稳定的柔性文物的修复更是刻不容缓。

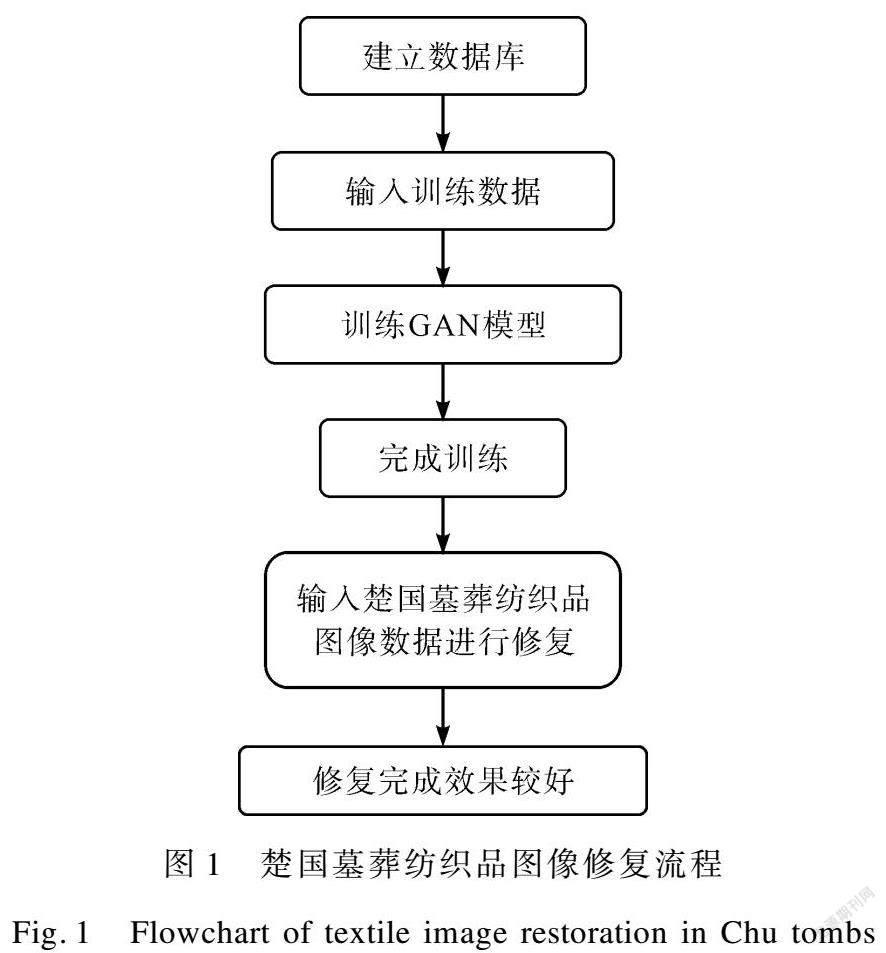

本文在楚国墓葬纺织品修复流程上主要分为以下3个步骤:第1步,由于网络上对古代纺织品图像数据库的缺失,收集古代纺织品图像数据建立古代纺织品图像数据库用于网络模型的训练是极为必要的;第2步,设计古代纺织品图像修复模型的生成器和判别器,选择损失函数,将古代纺织品图像数据库中的部分图像作为训练数据进行输入,训练GAN模型,学习古代纺织品的纹样结构和特征;第3步,将训练后的模型用于楚国墓葬纺织品图像的修复。具体流程如图1所示。

2 基于深度学习的纺织品修复设计

针对楚国墓葬纺织品文物的特点,本文引入深度学习的方法来进行图像层面的复原。首先,在楚国墓葬纺织品文物的纹样方面,内容上一般为动物纹、植物纹、几何纹等。结构上主要分为单独纹样结构和连续纹样结构两种,连续纹样结构又分为二方连续结构和四方连续结构。单独纹样一般会独立地排列在纺织品文物上,连续纹样结构中的二方连续纹样即一个单位的纹样在两条平行线之间进行左右连续或上下连续地重复排列的带状结构纹样,一般用在领缘、袖缘、底边、腰带等位置;四方连续纹样即是由一个单位的纹样向上下左右四个方向重复排列构成的纹样结构,可向四周无限扩展,循环往复,一般用在衣身等面积较大的位置。由此可见,古代纺织品图像大多具有重复性和规律性的特点。在修复纺织品图像时,可以通过对其他已知区域信息特征的提取来进行未知区域的复原。针对纺织品这些特点,本文选用GAN模型来进行楚国墓葬纺织品图像的复原。GAN是Goodfellow等[23]于2014年提出的一种深度学习方法,核心是利用生成器和判别器的相互不断地博弈从而产生较好的输出结果。生成器尽可能地去学习真正的数据分布规律,生成以假乱真的数据,判别器则尽可能地去判别生成器生成的假数据和真实数据,通过两者不断地优化调节达到生成的数据接近真实数据的效果。应用到纺织品文物图像修复上来讲,就是根据纺织品具有重复性和规律性的特点,通过学习输入纺织品图像数据集已知区域的结构纹样特征等数据信息,生成接近于真实纺织品图像未知区域的数据信息,将残缺的纺织品图像在结构上补全,在纹样上连贯。

2.1 纺织品图像修复模型的生成器设计

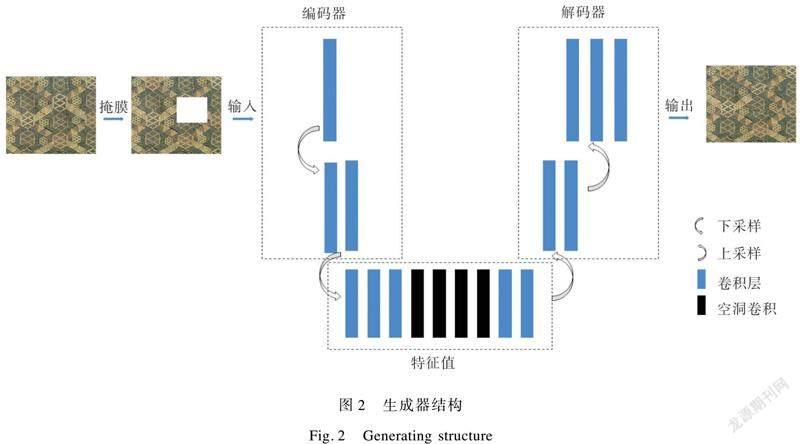

生成器主要采用U-Net[24]结构为基础,是典型的编码-解码结构,是著名的处理医学图像的图像分割网络。与医学图像获取数据难相同,古代纺织品图像数据获取也比较困难,所以采用U-Net结构作为生成器。U-Net结构是由4次下采样通过卷积和池化进行纺织品图像的特征提取,再由4次上采样通过转置卷积恢复其特征,其下采样与上采样显现出U型的对称结构。中间将提取的纺织品图像的特征和复原的纺织品图像特征进行拼接,也叫跳跃连接,增加特征的厚度进行特征图的融合。根据部分纺织品的图案较为复杂的特性,本文改进U-Net结构,减少下采样和上采样的次数,取消池化层,减少纺织品图像数据信息的丢失,分别采用2次下采样操作和2次上采样操作,减少纺织品图像修复模型的计算量。同时根据纺织品图像信息的复杂度和需要修复区域的大小选取步长,纺织品图像中细节越多,纹样越复杂,需要修复的区域越大,步长则需要适当减小;反之,纺织品图像中信息越简单,需要修复的区域越小,步长则可以适当增大以提高计算效率。在下采样操作中,采用自适应步长的卷积对纺织品图像的数据特征进行压缩。上采样也采用自适应的步长,卷积核为3×3的反卷积来进行纺织品图像的特征恢复操作。取消跳跃连接,引入空洞卷积,因为图像数据在下采样的过程中可能会丢失部分边缘数据,减少采样次数可以有效防止数据丢失,而增加空洞卷积又可以加宽视野,减少纺织品图像信息的损失。选择ReLU作为生成器的激活函数,生成器网络结构如图2所示,以此法将楚国墓葬纺织品文物图像的破损缺失部分进行补全。

2.2 纺织品图像修复模型的判别器设计

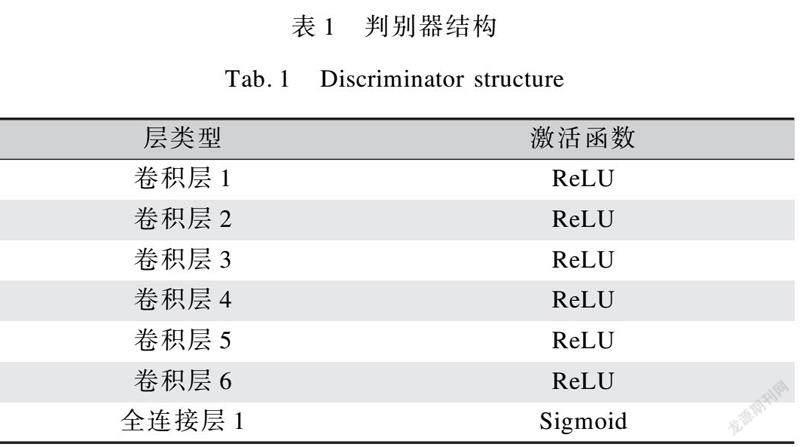

判别器在图像修复中起到十分重要的作用,通过判别器验证纺织品补全后图像的真假,可以决定生成器生成的结果能否作为最后结果输出,还可以指出真实的古代纺织品图像与生成的古代紡织品图像之间的差距,训练生成器生成接近真实的古代纺织品图像。本文判别器采用7层的神经网络结构,将卷积层和全连接层引入判别器中,包含6层的卷积层和1层的全连接层。卷积层采用5×5的卷积核,步长为2,使用ReLU函数作为激活函数。全连接层使用Sigmoid函数作为激活函数,因为全连接层每一个神经元都与前一层的神经元相连,可以整合所有用于分类的特征数据的信息,所以可以进行分类,用以判别输入的古代纺织品图像数据的真假。而Sigmoid函数也常用于二分类问题当中,可以将输入的数据映射到0~1,输入的正数数据的值越大越接近于1,输入的负数数据的值越大越接近于0,输出结果为0或1,若输出为0即判定其输入的古代纺织品图像为假,若输出结果为1即判定其输入的古代纺织品图像为真。但Sigmoid函数的收敛速度较慢,所以卷积层选择收敛速度较快的ReLU函数作为激活函数。实验证明,判别器可以有效判别生成的纺织品图像数据,经过反复博弈,使得生成器生成的纺织品图像质量提升,与真实的古代纺织品图像较为接近。判别器结构如表1所示。

2.3 纺织品图像修复模型的损失函数

损失函数是衡量生成对抗模型好坏的一个重要指标,主要就是用来表现生成的纺织品图像数据与真实图像数据之间的差值。本文使用了MSE损失函数和对抗损失函数作为生成器和判别器的损失函数。其中MSE损失函数即均方误差

损失函数,也叫L2损失函数,是生成的纺织品图像与真实的纺织品图像之间的距离平方的平均值,其定义为:

式中:N为输入的古代纺织品图像的数据样本数量;yi为真实的古代纺织品图像数据;y′i为生成的预测古代纺织品图像数据。

使用MSE损失函数指导的网络模型可以生成古代纺织品图像的大致信息,而想要细致的信息则需要引入对抗损失。GAN网络模型的原理就是判别器要努力识别生成器所生成的图像,使预测图像数据的输出接近为0,真实图像数据的输出接近为1。所以,对抗损失的定义为:

式中:x为真实的古代纺织品图像数据;pdata为真实古代纺织品图像的数据分布;pz为生成的古代纺织品图像数据的分布;D(x)表示真实数据的判别结果,越趋近于1越好;D(G(z))表示生成数据的判别结果,越趋近于0越好。

对抗损失函数可以分别对生成器和判别器进行优化,使得最后训练的古代纺织品图像修复模型达到较好的训练效果,复原的古代纺织品图像接近于真实的古代纺织品图像。

3 实 验

本文实验使用了Python 3.6进行编程,采用了深度学习的框架PyTorch,在配置为NVIDIA RTX 3060的Windows 10的环境中进行。

3.1 数据集

本文的主要研究对象是楚国墓葬出土的纺织品文物。由于古代纺织品图像数据不多,目前也没有关于古代纺织品图像的数据集,所以在图像采集时,主要数据来源是以有着“丝绸宝库”之称的马山一号墓的纺织品文物图像为主;再以其他地方的楚国纺织品文物图像为辅,将纺织品图像进行放大裁剪,将一幅图裁剪成多幅图像,进行图像数据量的增强,通过采集、裁剪、整理,建立纺织品图像的数据集。

3.2 网络训练

将收集的古代纺织品图像数据通过裁剪等方式使得图像数据尺寸为256×256,其中的部分古代纺织品图像数据当成测试集,剩余的古代纺织品图像数据当成训练集。

基于GAN网络模型进行的纺织品图像补全的过程为:1) 将训练集图像数据的随机位置上加上掩膜进行部分遮挡,掩膜尺寸为64×64;2) 将训练数据和掩膜一起输入生成器中,先通过2次下采样的卷积操作,提取真实古代纺织品图像的特征值;3) 再通过空洞卷积将提取压缩后的古代纺织品图像的特征值进行扩充,扩大感受野,减少真实古代纺织品图像的边缘信息的丢失;4) 进行2次上采样的反卷积操作,生成补全后的古代纺织品图像数据;5) 将未被遮挡的完整的真实古代纺织品图像和生成器生成的补全后的古代纺织品图像一起输入到判别器中;6) 利用损失函数计算生成的古代纺织品图像数据与真实的古代纺织品图像数据的差距,通过判别器进行真实图像和补全图像的判别;7) 将判别结果反馈给生成器从而优化生成器,使得生成器生成更加接近真实的古代纺织品图像;8) 经过多次反复,直到生成器生成的古代纺织品图像与真实的图像接近,判别器判别不了为止。此时GAN模型则训练完成。

3.3 纺织品图像复原结果与分析

将测试集图像附上掩膜,将其通过训练后的GAN网络模型进行修复,输入的图像数据尺寸为256×256,掩膜尺寸为64×64,修复后图像如图3所示。

从复原的测试集图像中可以看出复原后图像没有明显边界,并且纹样信息基本得到修复,但图3中纹样信息较为简单,纹样细节不多,且所修复部位均是规则的破损,而古代纺织品的破损大多是不规则的,所以为了检测本文中的方法对不规则破损图像的修复效果,将不规则破损的纺织品图像加上掩膜后进行修复,如图4所示。由图4可以看出,本文对不规则破损图像也具有一定的修复效果,部分复原图像会出现模糊的问题,但基本复原了纺织品图像的纹样和结构等特征信息。

为了进一步检测本文所提出修复模型的有效性,选取纹样较复杂的纺织品文物图像,采用近几年典型的图像修复方法DeepFill v2算法[25]来进行对比实验,复原结果如图5所示。采用DeepFill v2算法复原的古代纺织品图像与本文方法复原的古代纺织品图像(图4(a)(b)),复原效果对比明显。相较于本文方法,在DeepFill v2算法中,自适应上下文编码器(Adaptive Context Encoder,ACE)可以根据图像的上下文信息自动检测缺失区域,但复原的纺织品图像效果较差,图5中最大破损已用红色标记,从标记处看,高次数迭代后的图像复原效果尤其不理想,复原后的图像出现白色斑点,与古代纺织品图像的纹理对比明显;低次数迭代后复原的图像虽然没有明显斑点,但复原的部位并沒有还原纹样信息,且较为模糊混乱,不同颜色之间也有相融现象。可见,采用DeepFill v2算法复原的图像整体上出现了模糊、伪影、噪声等现象,且复原的纹样信息不连贯。而采用本文方法修复的图像,修复后部位较为清晰,复原了纺织品图像的结构和一部分纹样,所复原的内容与纺织品本身的部分衔接较好,纹样结构融为一体,颜色上也没有明显的分界,复原效果较好,复原后图像具有一定的观赏性。

基于以上实验结果进行分析,现有图像修复算法的训练均是基于人脸、建筑、风景等图像数据集,而本文所提出的图像修复模型是基于楚纺织品图像具有重复性和规律性的特征进行构建和训练的,学习了楚纺织品图像的特征,进一步复原楚纺织品图像。就楚国墓葬纺织品图像复原,本文所提出的方法是十分必要且有效的。

4 结 论

本文针对一些修复难度较大,较为脆弱不宜触碰的楚国墓葬纺织品文物提出了一种利用数字化方法从图像层面修复的一种可能性。基于古代纺织品图像数据库,引入深度学习的方法,利用GAN网络模型,进行了楚国墓葬纺织品图像的复原,尤其对于古代纺织品的残缺、瑕疵等问题进行了图像层面的修复。从人的主观角度看,修复后的纺织品图像具有较好的视觉效果,恢复了部分楚国纺织品原有的风采。实验结果为纺织品文物的修复提供了一种全新的角度,也为楚国墓葬纺织品的修复研究提供了一种新的方法。

参考文献:

[1]龚德才. 古代纺织品保护研究[J]. 中国文化遗产, 2004(3): 72.

GONG Decai. Research on protection of ancient textiles[J]. China Culture Heritage, 2004(3): 72.

[2]王孖. 被焚烧过的古代纺织品的保护[C]//中国文物保护协会. 文物保护技术(1981—1991). 北京: 科学出版社, 2010: 148-153.

WANG Ma. Protection of Burned Ancient Textiles[C]//China Association of Cultural Relics Protection Technology. Technology for Cultural Relics Protection (1981-1991). Beijing: Science Press, 2010: 148-153.

[3]马江丽. 基于知识图谱的纺织品文物清洗研究[J]. 上海纺织科技, 2019, 47(7): 17-21.

MA Jiangli. Research on the cleaning of textile relics based on the knowledge map[J]. Shanghai Textile Science & Technology, 2019, 47(7): 17-21.

[4]杨海亮, 周旸, 刘剑, 等. 多光谱摄影技术在印绘纺织品文物信息提取中的应用: 以正德八年诰命为例[J]. 文物保护与考古科学, 2017, 29(2): 33-37.

YANG Hailiang, ZHOU Yang, LIU Jian, et al. The use of multispectral photography technology to extract information from printed textiles: Analysis of a piece of an imperial edict dated to the eighth year of the Ming Emperor, Zheng De[J]. Sciences of Conservation and Archaeology, 2017, 29(2): 33-37.

[5]王淑娟. 绉丝纱在中国古代纺织品修复中的应用[J]. 文物保护与考古科学, 2016, 28(2): 67-72.

WANG Shujuan. Methods of using silk crepeline in the conservation of ancient Chinese textiles[J]. Sciences of Conservation and Archaeology, 2016, 28(2): 67-72.

[6]王菊, 赵喜梅, 李林杉. 现代织物染色技术在古代纺织品保护修复中的应用探讨[J]. 丝绸, 2020, 57(12): 49-54.

WANG Ju, ZHAO Ximei, LI Linshan. Application of modern fabric dyeing technique in protection and restoration of ancient textiles[J]. Journal of Silk, 2020, 57(12): 49-54.

[7]路智勇. 輔料染色技术在古代纺织品保护修复中的应用[J]. 文物保护与考古科学, 2008(2): 56-59.

LU Zhiyong. The application of dyeing techniques in textile conservation and restoration[J]. Sciences of Conservation and Archaeology, 2008(2): 56-59.

[8]陈杰, 李旭姣. 图像修复技术综述[J]. 电信快报, 2021(2): 44-46.

CHEN Jie, LI Xujiao. A survey of image inpainting techniques[J]. Telecommunications Information, 2021(2): 44-46.

[9]赵露露, 沈玲, 洪日昌. 图像修复研究进展综述[J]. 计算机科学, 2021, 48(3): 14-26.

ZHAO Lulu, SHEN Ling, HONG Richang. Survey on image inpainting research progress[J]. Computer Science, 2021, 48(3): 14-26.

[10]姜艺, 胥加洁, 柳絮, 等. 边缘指导图像修复算法研究[J]. 计算机科学与探索, 2022, 16(3): 669-682.

JIANG Yi, XU Jiajie, LIU Xu, et al. Research on Edge-Guided image repair algorithm[J]. Journal of Frontiers of Computer Science and Technology, 2022, 16(3): 669-682.

[11]阮秋琦, 仵冀颖. 数字图像处理中的偏微分方程方法[J]. 信号处理, 2012, 28(3): 301-314.

RUAN Qiuqi, WU Jiying. Partial differential equation (PDE) method on digital image processing[J]. Journal of Signal Processing, 2012, 28(3): 301-314.

[12]CHAN T F, SHEN J. Nontexture inpainting by curvature-driven diffusions[J]. Journal of Visual Communication and Image Representation, 2001, 12(4): 436-449.

[13]CHAN T F, KANG S H, SHEN J. Eulers elastica and curvature-based inpainting[J]. SIAM Journal on Applied Mathematics, 2002, 63(2): 564-592.

[14]ANTONIO C, PATRICK P, KENTARO T. Region filling and object removal by exemplar-based image inpainting[J]. IEEE Transactions on Image Processing, 2004, 13(9): 1200-1212.

[15]唐浩丰, 董元方, 张依桐, 等. 基于深度学习的图像补全算法综述[J]. 计算机科学, 2020, 47(S2): 151-164.

TANG Haofeng, DONG Yuanfang, ZHANG Yitong, et al. Survey of image inpainting algorithms based on deep learning[J]. Computer Science, 2020, 47(S2): 151-164.

[16]FANG Y, LL Y, TU X, et al. Face completion with hybrid dilated convolution[J]. Signal Processing: Image Communication, 2019, 80: 115664.

[17]杨鲁月, 张树美, 赵俊莉. 基于并行Gan的有遮挡动态表情识别[J]. 计算机工程与应用, 2021, 57(24): 168-178.

YANG Luyue, ZHANG Shumei, ZHAO Junli. Dynamic expression recognition with partial occlusion based on parallel Gan[J]. Computer Engineering and Applications, 2021, 57(24): 168-178.

[18]左凯楠. 基于深度卷积生成对抗网络的图像补全研究[D]. 西安: 西北大学, 2020.

ZUO Kainan. Image Inpainting Based on Deep Convolutional Generative Adversarial Network[D]. Xian: Northwest University, 2020.

[19]范春奇, 任坤, 孟丽莎, 等. 基于深度学习的数字图像修复算法最新进展[J]. 信号处理, 2020, 36(1): 102-109.

FAN Chunqi, REN Kun, MENG Lisha, et al. Advances in digital image inpainting algorithms based on deep learning[J]. Journal of Signal Processing, 2020, 36(1): 1002-109.

[20]HINTON G E, SALAKHUTDINOV R R. Reducing the dimensionality of data with neural networks[J]. Science, 2006, 313(5786): 504-507.

[21]PATHAK D, KRAHENBUHL P, DONAHUE J, et al. Context Encoders: Feature Learning by in Painting[C]. Las Vegas, USA: Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 2536-2544.

[22]尚如春. 東周时期楚国社会变迁研究[D]. 长春: 吉林大学, 2019.

SHANG Ruchun. A Study on the Social Transition of Chu in the Eastern Zhou Dynasty[D]. Changchun: Jilin University, 2019.

[23]GOODFELLOW I J, POUGET-ABADIE J, MIRZA M, et al. Generative Adversarial Nets[C]. Montreal, Canada: Proceedings of the 27th International Conference on Neural Information Processing Systems, 2014: 2672-2680.

[24]RONNEBERGER O, FISCHER P, BROX T. U-Net: Convolutional Networks for Biomedical Image Segmentation[C]//Medical Image Computing and Computer-Assisted Intervention-MICCAI 2015: 18th International Conference. Munich, Germany: Proceedings of the Springer International Publishing, 2015: 234-241.

[25]YU J, LIN Z, YANG J, et al. Free-form Image Inpainting with Gated Convolution[C]. Los Alamitos, USA: Proceedings of the IEEE/CVF International Conference on Computer Vision, 2019: 4471-4480.

Abstract: Most of Chu textile cultural relics in China are unearthed from tombs. Due to the long age and poor storage environment, textiles are often incomplete and damaged with rust spots, blood stains and other blots on the surface. At present, the restoration of textile cultural relics is still mainly physical restoration. The process of physical restoration, depending on the subjective aesthetics and experience of the restoration personnel, is easy to cause problems such as unsatisfactory restoration effect or secondary damage. In order to reduce the contact with textile cultural relics, a digital method was used in this study to restore the textiles of Chu tombs at the image level.

The textile image database was established by collecting the image data of textile cultural relics in Chu tombs. The generative adversarial network (GAN) model in the deep learning method was used to repair the incomplete textile cultural relics at the image level, avoiding touching textile cultural relics and reducing the secondary damage in the repair process. At the same time, the generator with the U-Net structure was used in the study to reduce the number of down-sampling and up-sampling, cancel the pooling layer and jump connection, introduce dilated convolution, expand the receptive field, and reduce the loss of textile image data information. According to the characteristics of repeatability and regularity of textile images of Chu tombs, we adopted adaptive step size for the generator. The larger the repair area, the more the details and the more complex the pattern are, and the smaller the step size should be. The smaller the repair area, the less the details and the simpler the pattern are, and the bigger the step size should be, so that the computational efficiency can be improved. The discriminator is of seven-layer network structure, including six convolutional layers and one fully connected layer. The ReLU function was selected as the activation function in the convolutional layers, and the Sigmoid function was selected in the fully connected layer. By learning the data information input into the known area of the textile image database, the generator generated data information close to the unknown area of the real textile image, so as to restore the textile image. The discriminator was used to determine the authenticity of the generated image to adjust the parameters, and the Chu textile image restoration was achieved through continuous optimization of the two. In order to further test the effectiveness of the repair model proposed in this study, the typical image repair method DeepFill v2 algorithm was selected for comparative experiments. The image restored by DeepFill v2 is relatively blurred, with artifacts, noise and other phenomena. The image restored by the method proposed in this study is clear, with the structure and pattern of the textile image being basically restored.

In this study, a digital method is proposed to repair some textile cultural relics unearthed from Chu tombs, which are difficult to repair and fragile. The images of textile cultural relics are restored by the digital method to make the structure complete and pattern coherent, which achieves a good restoration effect from subjective evaluation perspective. The restored textile relic images can be used to guide the restoration of physical objects, exhibitions, etc., which has certain significance for the study of Chu tomb textiles.

Key words: deep learning; image restoration; GAN; Chu tombs; textile cultural relic; damaged textiles