结合感知损失与双重对抗网络的低剂量CT 图像去噪

熊景琦,桑庆兵,胡聪

(江南大学 人工智能与计算机学院,江苏 无锡 214122)

0 概述

近年来,计算机断层扫描(Computer Tomography,CT)成像技术成为医学诊断和治疗中不可或缺的影像学手段[1]。然而,CT 扫描产生的电离辐射会对患者的身体产生危害,甚至可能引发癌变。在临床医学中,应尽可能减少辐射,同时确保可接受的诊断准确性,因此,低剂量CT(Low-Dose CT,LDCT)扫描应运而生。但是,辐射剂量的降低往往会造成重建图像中的斑纹噪声和非平稳条纹伪影增大,导致图像质量下降,从而影响临床诊断[2]。

为了提高图像质量,LDCT 图像去噪成为医学成像领域的一个重要研究方向,许多算法被提出用以改进低剂量CT 图像,这些算法通常被分为三类,分别为投影域正弦图过滤、迭代重建和后处理。前两种算法基于投影域数据,其数据往往不公开,使得研究难度提高,这也造成实际应用中的瓶颈,而后处理方法直接对重建后的低剂量CT 图像进行处理,不依赖原始投影数据,为研究带来了诸多方便。

传统的后处理算法,如非局部均值(Non-Local Mean,NLM)[3]、块匹配(Block-Matching,BM3D)算法[4-5]等,计算效率较高,可以显著提高图像质量。然而,重建后的低剂量CT 图像中的噪声往往呈非均匀分布,传统的后处理算法不能完全解决处理后图像中存在的过平滑、残留伪像、引入新噪声等问题。

近年来,基于深度学习的方法在图像去噪任务中取得了令人瞩目的成绩[6]。深度学习方法通过最小化去噪图像与清晰图像之间的距离,采用外部先验知识和由数据集指导的监督训练策略。使用卷积神经网络的LDCT 去噪方法不依赖大量的投影数据,而直接在CT 数据的图像域中执行,可以自动提取CT 图像的潜在特征,并充分利用非局部相似性的先验知识,在应用中非常方便。DONG等[7]提出一种用于CT 图像去噪的超分辨率卷积神经网络(SRCNN)。此后,基于残差编解码器的网络模型RED-CNN[8]被提出用于低剂量CT图像恢复。章云港等[9]使用空洞卷积改进RED-CNN网络,使得去噪效果得到进一步提升。由于CNN 具有强大的特征学习和特征映射能力[10],因此基于CNN 的图像降噪方案取得了显著效果。然而,训练深度卷积神经网络需要大量干净-噪声图像对,而收集CT 图像数据成本昂贵并且耗时。在实际应用中,很难构建足够大、能满足CNN 充足训练要求的数据集,数据集较小常会引起训练不充分、网络欠拟合等问题,从而导致去噪效果降低,出现图像失真。此外,文献[11-13]的研究表明,以往方法中使用均方误差(Mean Squared Error,MSE)损失来最小化所生成的去噪图像与正常剂量CT 图像之间的距离,倾向于生成过度平滑的图像。而GOODFELLOW 等[14]提出的生成对抗网络(Generative Adversarial Networks,GAN)可以直接学习噪声分布,在重建图像细节上有巨大优势,但GAN 也存在网络训练困难和梯度消失的问题。为了解决这一问题,引入Wasserstein 距离来衡量生成图像与真实图像分布差异的WGAN(Wasserstein GAN)[15]网络被引入到LDCT 图像去噪任务,其重建后的图像具有较好的视觉效果。进一步,YANG等[11]提出将感知损失引入WGAN 的方法,该方法在图像细节保留和解决边缘过平滑问题方面表现出色。LI等[13]使用自监督方法训练感知损失网络并引入自注意力机制用于低剂量CT图像去噪,去噪后图像质量有了显著提升。考虑到配对数据难以获取,朱斯琪等[16]通过改进循环一致性生成对抗网络,在无监督的情况下实现了LDCT 图像的降噪保边及纹理改善。

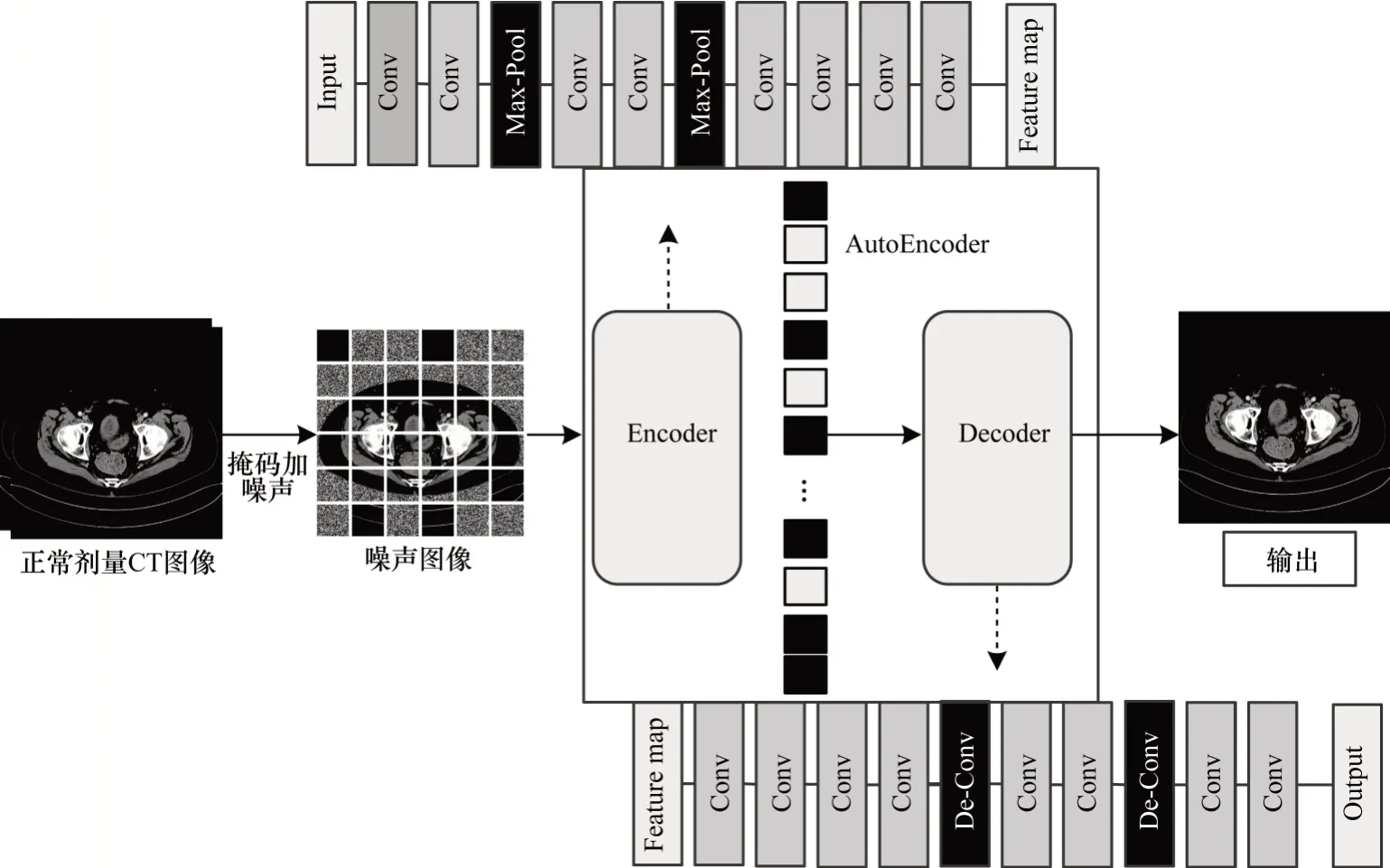

以往的研究仅利用推断条件后验概率p(x|y)来实现低剂量CT 图像修复,由于数据稀缺,导致模型训练不够完全,在建模复杂的真实噪声分布时算法并不能发挥最好效果。YUE等[17]提出一种双重对抗网络(Dual Adversarial Network,DANet)框架,通过图像去噪和噪声生成2 个角度来联合建模干净-噪声图像对的联合分布p(x,y),为图像去噪提供了新的思路。受此启发,本文构建一种双重对抗网络去噪模型,以解决CT 图像修复问题。双重对抗网络的联合学习能让图像去噪和噪声生成相互指导从而实现更好的去噪效果。同时,设计一种Res-Unet残差学习网络来实现去噪和噪声生成任务,残差块的引入能让网络保留更多的图像细节。为了使得去噪效果更符合人体视觉特性,提出一种加权混合损失函数来优化网络,该损失函数包括对抗损失、感知损失和最小绝对偏差(Least Absolute Deviation,L1)损失。为了更好地计算感知损失,提出一种掩膜自监督方法训练一个针对CT 图像的感知损失模型,在该过程中,设计一种自编码器(AutoEncoder,AE)模型作为感知损失网络来提取特征图从而计算感知损失,并使用掩膜自监督方法针对CT 图像域训练模型,以更好地提取CT 图像特征编码。

1 双重对抗网络

假设y为带有噪声的低剂量CT图像,y∈RN×N,x为清晰的常规剂量图像,x∈RN×N。对于低剂量CT 图像去噪,常规去噪方法在最大后验估计框架下利用条件后验概率p(x|y)来推断清晰图像x,即:

不同于常规方法直接学习y→x的映射,双重对抗模型去噪方法对干净-噪声图像对的潜在联合分布p(x,y)进行建模,从而达到去噪效果,其从图像去噪和噪声生成2 个不同的角度对联合分布p(x,y)进行分解。

1.1 图像去噪角度

在贝叶斯框架下,去噪任务可视为推断条件分布p(x|y),在该任务中,学习到的去噪器R 表示一个隐式分布pR(x|y),以近似于真实分布p(x|y)。R 的输出可以得到一个伪干净的图像对(,y),可以看作这个隐式分布pR(x|y)的采样图像,如式(2)所示:

1.2 噪声生成角度

对于CT 图像,其噪声往往是随机产生的,分布不均。因此,噪声生成任务通过引入随机噪声变量z来实现从清晰图像x到噪声图像y的映射,生成任务可视为推断条件分布p(y|x,z)。与式(2)相同,通过生成器G可以得到一个虚假噪声对(x,),如下:

在生成任务中,生成器G的输出可以看作pG(y|x,z)的采样,则生成器的输出G(x,z)可以表示为隐式分布pG(y|x,z),使用生成器G 生成的隐式分布pG(y|x,z)去近似真实分布p(y|x,z),将隐变量z边缘化以获得伪联合分布pG(x,y),作为近似真实联合分布p(x,y):

其中:p(z)表示隐变量z的分布,可以将其设置为均值为0 的高斯分布N(0,I)。同理,生成器生成的噪声图片越逼真,伪联合分布pG(x,y)逼近真联合分布p(x,y)就越准确。

2 模型网络架构

双重对抗网络模型包含去噪器R、生成器G 以及鉴别器D,整体架构如图1 所示,其中:y表示观测到的低剂量CT 图像;x表示正常剂量CT 图像;~分别为去噪器和生成器生成的图像。模型输入为干净-噪声(cleannoise)图像对,经过去噪器R 和生成器G 得到去噪后的图像和生成的伪低剂量CT 图像,与原始干净噪声图像构成伪图像对,再送入鉴别器进行联合对抗训练,然后从图像去噪和噪声生成2 个角度来近似干净-噪声图像对的联合分布p(x,y)。此外,由于生成器和去噪器任务目标不同,因此采用不同的损失函数来优化网络。学习完成的去噪器R 可以直接用于LDCT 去噪,而生成器可以生成更多的干净-噪声图像对用于数据增强。由于深度学习具有强大的拟合能力,因此R、G、D 均采用深度学习网络来实现。

图1 双重对抗网络模型框架Fig.1 Dual adversarial network model framework

2.1 生成器和去噪器网络

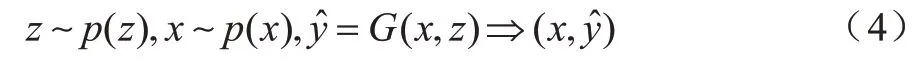

生成器G 和去噪器R 都使用本文设计的Res-Unet网络来实现,在不同任务中具有不同的优化目标。对于低剂量CT 图像去噪任务,从噪声图像恢复出潜在的清晰图像。Res-Unet网络的编解码结构在图像去噪中具有优势,因此,去噪器R 可以直接学习噪声图像到清晰图像的映射。对于噪声生成任务,由于噪声信息与清晰图像信息相比学习难度更低,且网络学习到的噪声分布可以很容易地合成LDCT 图像,因此,使用残差学习[18]策略,让生成器G 学习噪声图像与清晰图像的残差(即v=y-x所得到的噪声)。去噪器R 和生成器G 最终目标分别如下:

其中:Res-Unet(·)表示Res-Unet网络的输出函数;[·,·]表示联合(Concatenation)操作。

考虑到CT 图像的数量相对于自然图像要少,获得有临床意义的标签的难度更大,因此,用于CT 图像的网络模型应选用轻量化模型。Unet[19]架构在医学图像处理中取得了非常好的效果,其模型参数量可以通过更改模型层数以及每层的通道数来降低,与其他模型相比更为轻量级。

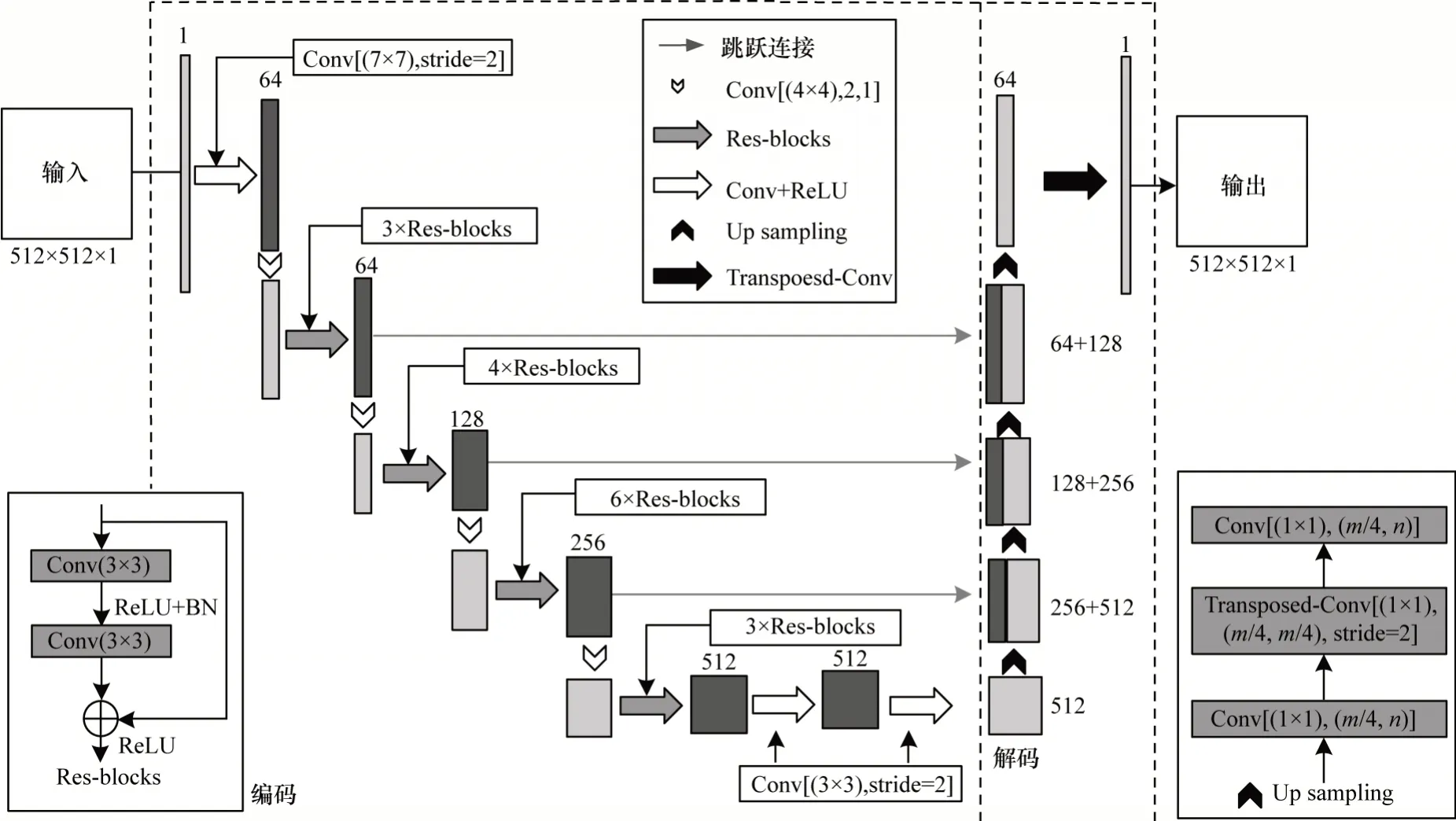

如图2 所示,本文设计的Res-Unet 是在Unet 的基础上进行改进的,Res-Unet 保留Unet 的编码解码结构和跳跃连接部分,具体改进如下:

1)对于编码器部分,Res-Unet利用5 个下采样层来实现特征提取。由于Unet中常规卷积下采样过程会丢失部分重要的图像信息,因此将其中4 个卷积层使用Res-blocks 残差块[20]来代替常规卷积操作从而提取图像特征。Res-blocks 由于加入了恒等连接,可以有效防止卷积操作带来的信息丢失。此外,卷积后的池化操作同样会损失部分图像结构细节,这对像素级任务影响较大,并且导致对抗网络训练不稳定。因此,本文使用卷积核为4×4、步长为2、填充为1 的卷积操作代替卷积后的池化操作。

2)对于解码器部分,采用和编码器相对称的5 次上采样来重建图像以保持图像大小不变,上采样结构如图2 中Up sampling 所示。将图像特征采用转置卷积操作来恢复图像细节。此外,通过跳跃连接将同尺度的下采样特征进行融合,从而减少信息丢失,保存图像细节。

图2 Res-Unet 网络结构Fig.2 Res-Unet network structure

2.2 鉴别器网络

在双重对抗网络中,鉴别器D 与去噪器R 和生成器G 对抗训练,其对图像去噪效果和生成的噪声图像质量起着至关重要的作用,能够引导去噪器和生成器往正确的方向训练。考虑到CT 图像包含丰富的细节信息,图像敏感度高,本文设计如图3 所示的鉴别器体系结构,其输入为512×512×2 的级联图像对(x,y),其中包括4 个跨步卷积层用来减小图像尺寸并提取特征,以及包含1 个全连接层用来融合所提取的特征,模型最后输出标量。

图3 鉴别器网络结构Fig.3 Discriminator network structure

3 损失函数

为了更加有效地训练去噪器R 和生成器G,从而更好地估计联合分布p(x,y),提高双重对抗网络的降噪性能,本文借鉴Triple-GAN[21]所使用的双重对抗训练策略,针对不同任务采用不同的损失函数。

3.1 对抗损失

本文引入WGAN 网络中使用的Wasserstein 距离来计算2 个真实图像对和生成的伪图像对的分布差值,使得对抗模型训练更加稳定。定义如下对抗损失将pR(x,y)和pG(x,y)逐渐推向真实分布p(x,y):

其中:=R(y),=G(x,z);D 为鉴别器,用于将真实的干净-噪声图像对(x,y)和生成的假图像对(,y)、(x,)区分开来;超参数α用于控制生成器G 和去噪器R 的相对重要性。

3.2 感知损失

对于CT 图像而言,保证病理诊断中图像的重要特征非常有必要。使用最小化去噪图像与清晰图像之间距离的MSE 损失,往往会让学习到的模型生成过度平滑的图像并且丢失纹理细节[22],MSE 被证明与人类对图像质量的感知相关度较差,其忽略了对人类感知至关重要的图像的纹理和特征[23]。感知损失可以学习语义特征差异,其相比MSE 损失可以重建更多细节和边缘信息。WGAN-VGG[11]使用一种VGG-Loss 来替代MSE-Loss,用于计算网络输出的常规剂量CT(Normal Dose CT,NDCT)图像和真实图像之间的距离。但是,VGG 网络是在自然图像数据集中的分类任务中通过预训练得到,VGG 特征提取模型可能会提取到与CT 图像无关的特征信息,这会为模型优化带来干扰。

本文设计一种图4 所示的针对CT 图像提取语义特征的自动编码器网络,该网络包含一组对称的编码器子网络和解码器子网络,通过编码器来提取输入图像的高级语义特征用于计算感知损失。

图4 自监督的自动编码器网络结构Fig.4 Network structure of self-supervised autocoder

在预训练感知损失网络时,常规方法设定目标,让模型在像素级上精确重构输入,这样训练出来的模型会过多关注像素级别的细节而忽略了更为重要的语义特征。何凯明[24]提出一种非常简单且高效的自监督方案,其对输入图像块进行随机掩膜,随后对缺失像素进行重建的自监督辅助方法在各种视觉任务中均取得了较好的效果。受此启发,本文使用掩膜自监督的策略针对CT 图像域来训练模型,其自监督任务是对正常剂量CT 图像中随机的75%区域进行高斯噪声掩膜,然后让自编码网络来复原正常剂量CT 图像。自监督的目标是重构清晰输入,让模型从输入的被高斯噪声掩膜后的CT 图像中提取特征编码,然后将其重构为与原始图像最为接近的无噪声CT 图像。自监督学习可以在无标注的情况下学习到图像表征,本文所使用的掩膜自监督学习策略能让预训练的AutoEncoder 提取到CT图像的高级语义特征。

感知损失通过计算编码特征差异来实现,其表达式如下:

其中:φ是自动编码器的编码部分,用于特征提取;w、h、d分别为特征图的宽度、高度和维度;定义为L1正则化。

3.3 混合损失

文献[25-26]研究表明,将对抗损失和传统损失混合可以加快和稳定GAN 网络的训练,因此,本文在去噪任务中加入L1损失,其定义如下:

对于生成任务,由于实际噪声具有随机性,直接使用L1损失不适用,因此对噪声分布的统计信息利用L1损失,具体如下:

其中:GF(·)表示提取噪声一阶统计信息的高斯滤波器。

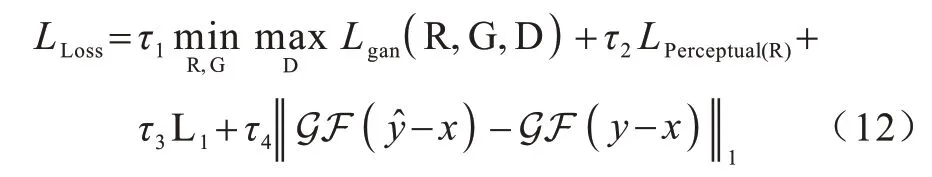

本文双重对抗模型最终损失目标如下:

其中:τ1、τ2、τ3和τ4均为超参数,用来平衡不同损失的权重。

4 实验结果与分析

为了评估本文所提算法在低剂量CT 图像去噪任务中的性能,在Mayo 数据集上[27]进行实验,该数据集是Mayo Clinic 授权的“2016 年NIH-AAPMMayo 诊所低剂量CT 大挑战”的临床数据集,通常作为评估CT 重建和去噪技术的标准参考数据集。Mayo 包括299 例病人头部、胸部和腹部X 射线投影图像,所有病例都包含常规剂量CT 和模拟常规剂量25% 和10% 的低剂量CT 图像,图像大小为512×512 像素。实验从数据集中抽取2 062 例图像对(每例包含NDCT 图像和对应的LDCT 图像作为干净-噪声图像对),其中,80%的图像对作为训练集,将剩余20%的CT 图像对作为测试集。

实验所使用的设备是Window10 环境,Intel®CoreTMi7-8700K @ 3.70 GHz,英伟达GTX 1080(8 GB 显存),16 GB 内存,所有模型训练均使用Pytorch 实现,利用GPU 训练模型。在训练过程中,生成器G、去噪器R 和鉴别器D 的初始学习率分别为0.001、0.001、0.002,以Adam为优化函数,R和G的动量项分别设为(0.9,0.999)和(0.5,0.9),batch size 设置为8。参考文献[28]对混合损失函数的权重设置,对抗损失τ1、感知损失τ2、L1损失τ3和生成器噪声统计约束损失τ4的权重分别设置为1、100、100 和10。对抗损失中α设定为0.5,表明去噪器和生成器同等重要。迭代训练70轮,选取效果最好的模型,使用该模型的去噪器R 在测试集上测试去噪性能。此处,将结合感知损失联合训练完的双重对抗网络表示为DANet-AE,DANet网络中生成器G 可以合成更多的伪LDCT-NDCT 图像对,从而对去噪器进行再训练,将再训练后的网络称为DANet-AE+。

4.1 评价指标

峰值信噪比(Peak Signal-to-Noise Ratio,PSNR)[29]和结构相似性(Structural Similarity,SSIM)[30]是图像去噪领域常用的客观评估指标。

PSNR 值越大,表明降噪图像中需要被保留的生理信息与需要被抑制的噪声信息之比越大,降噪图像质量越高。在图像质量评价领域,文献[31-32]研究表明,PSNR 并未考虑人眼的视觉特性,因此,经常出现评价结果与人主观感觉不一致的情况。考虑到PSNR和SSIM 更加关注像素间的差距,缺乏视觉效果,本文新增梯度幅相似性偏差(Gradient Magnitude Similarity Deviation,GMSD)[31]和平均偏差相似指数(Mean Deviation Similarity Index,MDSI)[32]这2 个在参考图像质量评价中更关注人眼视觉效果的指标,以共同评估算法的去噪性能。

4.2 与当下流行算法的去噪性能比较

本节从定性和定量2 个方面将本文算法与当下流行的LDCT 图像去噪算法进行比较,对比算法包括基于先验特征的传统去噪算法BM3D[4]、基于残差自编码器神经网络的去噪算法RED-CNN[8]、基于生成对抗网络并带有感知损失的算法WGAN-VGG[11]、引入自注意力机制和感知损失的算法SACNN[13]以及使用双重对抗网络的算法DANet[17],所有深度学习算法均在相同训练集上重新训练而得到,评估其在测试集上的去噪性能。

4.2.1 去噪效果定性分析

图5 所示为来自测试集的腹部低剂量CT 图像在不同算法下去噪的可视化结果,其中,关键区域(ROI)在下方被放大。通过图5(a)和图5(b)可以看出,由于低剂量CT 图像入射X 射线光子不足,导致图像退化严重,低剂量CT 图像结构和细节很难看清。对比去噪后的图像与LDCT 图像可以看到,所有算法均在一定程度上抑制了噪声。从图5(c)可以看到,经过BM3D[4]去噪后的图像滤波效果很好,图像平滑噪点较少,但是CT 图像噪声分布不均,传统算法存在明显的块状效应,细节丢失严重,边缘和小的结构变得模糊。从图5(d)~图5(h)可以看到,深度学习算法降噪效果明显超过BM3D,其中,REDCNN[8]由于使用MSE 作为损失函数,去噪后的图像的噪声抑制效果较好,但是丢失了高频信息,图像过度平滑,WGAN-VGG[11]使用VGG 感知损 失解决了过平滑问题,保留了图像大部分纹理,但是也有部分噪声和伪影残留下来。从图5(f)可以看到,SACNN使用自监督方法针对CT 域训练感知损失网络,能够极大保留图像特征,在降噪效果上具有一定优势,与本文算法具有相似的去噪效果。从图5(g)可以看出,DANet[17]与上述算法相比噪声较少,但仍然存在边缘细节丢失问题。从图5(h)可以看出,本文算法使用改进的Res-Unet 作为去噪骨干网络并加入感知损失,伪影噪声抑制效果最佳,且保留了更丰富的内容细节和纹理信息,去噪后的图像更接近正常剂量CT 图像。

图5 不同算法对腹部CT 图像的去噪结果Fig.5 Denoising results of abdominal CT images by different algorithms

4.2.2 去噪效果定量分析

表1 所示为当下流行的LDCT 去噪算法和本文算法在测试集上的PSNR、SSIM、GMSD 和MDSI 量化指标结果,其中,PSNR、SSIM 指标值越大越好,GMSD、MDSI 指标值越小越好。从表1 可以看出:

表1 不同算法在CT 图像测试集上的量化结果 Table 1 Quantization results of different algorithms on CT image test set

1)传统BM3D 算法是一种非局部去噪方法和转换方法的结合,在图像中寻找相似块进行滤波,可以最大程度地保留图像结构信息,其SSIM 有较好结果,表明算法在整体图像结构上保存完好,但是在其他量化指标上并未取得令人满意的效果。

2)深度学习网络具有强大的拟合能力,其降噪性能优于传统BM3D 算法,对噪声抑制效果较好。

3)MSE 损失专注于最小化像素级的平均损失,而PSNR计算依赖MSE,因此,使用MSE损失训练的REDCNN 算法在PSNR 指标上有较好结果,但是这往往也会产生过平滑问题。WGAN-VGG 和SACNN 由于使用感知损失,其去噪结果更符合人眼感知特性,GMSD和MDSI 指标有较好表现。

4)本文DANet-AE+算法采用混合损失函数优化模型,且双重对抗网络训练好的生成器可以合成更多的干净-噪声图像对,对原始数据集做数据增强后对去噪器R 进行再训练,可以进一步提升去噪性能,因此,本文算法的PSNR、SSIM、GMSD 和MDSI 均取得了最好结果。结合主观分析和量化结果可以得出,本文算法的降噪性能优于其他算法。

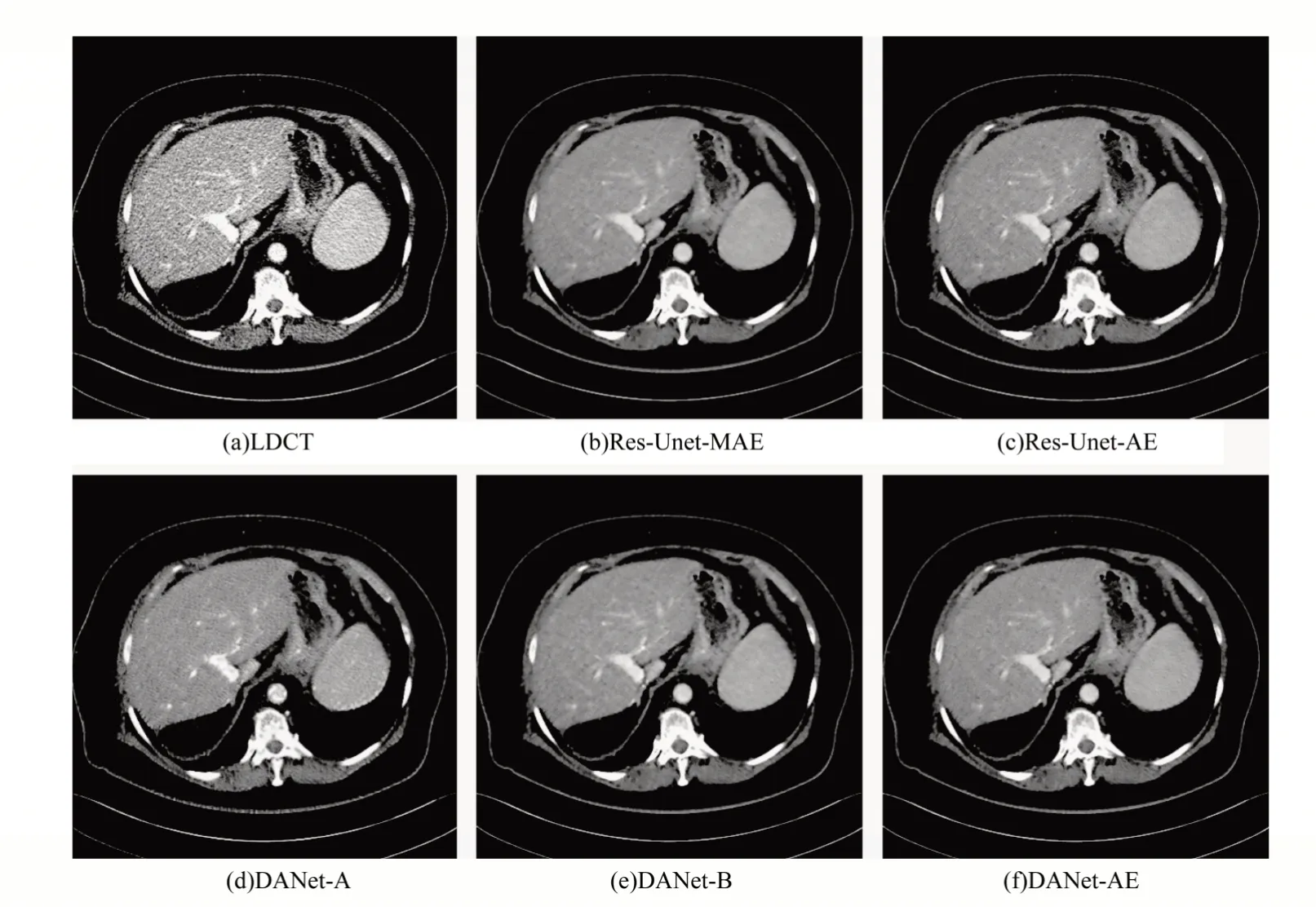

4.3 不同损失函数的对比分析

低剂量CT 图像重建质量在很大程度上受到损失函数的影响,本节设置不同损失函数来训练网络,对比它们在LDCT 图像去噪方面的表现。图6 和表2 展示了不同损失函数的去噪可视化效果和量化指标,其中:Res-Unet-MAE 表示仅使用L1损失进行训练;Res-Unet-AE 表示仅使用感知损失进行训练;DANet-A 表示仅使用对抗损失进行训练;DANet-B 表示使用对抗损失和L1损失进行训练;DANet-AE 表示使用混合损失进行训练。从图6 可以看出,L1损失可以产生更加清晰的图像,但是其同样有着边缘纹理被过度平滑的缺陷,对抗损失可以保留较多的细节,但对伪影抑制不明显,而感知损失使边缘更加明显,极大保留了图像纹理细节,但其容易导致竖纹,混合损失可以在显著抑制噪声伪影的同时保留更多的图像细节和结构。从表2 可以看出,由于SSIM、PSNR 更注重像素级差距,因此优化L1损失的模型在PSNR 指标上有最好结果,但这不能表明其拥有最好的去噪质量。GMSD 和MDSI 指标更注重符合人类视觉系统的感知认知,而从表2 中的GMSD和MDSI 指标可以看到,使用混合损失训练的模型所恢复的CT 图像具有更高的质量,更符合人眼视觉认知特性。

图6 不同损失函数的去噪结果比较Fig.6 Comparison of denoising results of different loss functions

表2 不同损失函数在测试集上的量化结果 Table 2 Quantization results of different loss functions on test set

4.4 消融实验

为了进一步验证DANet-AE 去噪算法的有效性,对整个框架中的不同模块进行消融实验。消融实验中共进行3 组对比:

1)为了验证双重对抗网络模型的有效性,令不带生成器的双重对抗网络为Model-A,将其与正常训练的双重对抗网络DANet-AE进行比较,结果如表3所示。从表3 可以看出,双重对抗网络具有更好的降噪性能,说明去噪器和生成器之间联合学习能相互引导和改进。

2)为了验证使用掩膜自监督方法在CT 图像域上训练的自编码器(AE)模型作为感知损失的有效性,令未使用由掩膜自监督方法训练的自编码器作为感知损失的网络为Model-B,其预训练是针对CT 图像进行简单的重构输入,由于简单重构输入训练出来的感知损失网络过分关注像素级别的细节而忽略了更为重要的语义特征,因此使用自监督方法训练的特征提取器能更好地计算CT 图像的特征差异。表3 的数据结果也验证了本文掩膜自监督方法的有效性。

3)为了验证本文Res-Unet 网络的有效性,训练一个使用Unet网络作为骨干网络来实现去噪和生成任务的双重对抗模型Model-C。对比表3 中的Model-C 和DANet-AE 可以看到,使用Res-Unet 网络,残差块可以极大保留图像信息,其PSNR 和SSIM 指标有明显提升,去噪性能更好。

表3 测试集上的消融实验量化结果 Table 3 Quantitative results of ablation experiment on test set

5 结束语

本文提出一种结合感知损失的双重对抗网络去噪算法,用于实现低剂量CT 图像修复。与传统基于后验概率推断干净图像信息的算法相比,该算法能够避免人工设计先验知识和噪声假设,并且自动学习噪声分布,相比仅从后验概率进行推断的方式,通过数据的联合分布能学习到更多的信息,从而在去噪时更好地抑制噪声。此外,使用自监督方法训练一个针对CT 图像的自动编码器来计算感知损失,加入感知损失的混合损失函数使得去噪效果更符合人体视觉认知特性。实验结果表明,使用混合损失优化的模型在针对低剂量CT 图像去噪修复时可以获得质量更高的重建图像。自监督学习可以在无标注的情况下学习到图像表征,下一步将在去噪网络中使用自监督方法进行预训练,以提升网络的训练效果。此外,考虑到CT 数据往往是三维的,扩充网络结构以对三维数据进行处理,同时结合前后文信息来实现更优的图像去噪效果,也是今后的研究方向。