激光点云的三维目标检测研究进展

周 燕,蒲 磊,林良熙,刘翔宇,曾凡智,周月霞

佛山科学技术学院 计算机系,广东 佛山 528000

目标检测一直是计算机视觉领域中最基本的问题之一。近年来,基于深度学习的目标检测算法极大地推动了各领域的发展,例如智慧交通、自动驾驶、家庭安防等。虽然基于二维图像的目标检测[1-4]已经取得了较大的进展,但针对三维目标的理解[5]和分析仍然是一项具有挑战性的任务。三维目标检测被定义为识别三维场景中特定的目标并估计其位置与方向的任务[6]。三维目标检测主要包含定位与识别两个步骤,即生成一系列与真实环境相关的三维边界框,并对边界框内的目标进行识别。相比于二维目标检测,三维目标检测可以输出物体的长、宽、高及朝向等信息,并通过这些信息获得空间中目标的位置关系,从而能更好地支持语义标注与场景理解。现有的三维目标检测算法按照输入数据的类型可以划分为基于视觉、基于激光点云和基于多模态融合三大类[7]。

基于视觉的三维目标检测方法,又可以细分为基于单目和双目的三维目标检测。如D4LCN(depthguided dynamic depthwise dilated local convolutional network)[8]、AM3D(accurate monocular 3D detection)[9]等,对图像进行深度估计,通过估计值将二维边界框投影到空间中来完成三维目标检测任务。该类方法存在目标定位误差大、对光照敏感等问题,并且其应用场景多为室内。而激光点云能反映目标在空间中的位置,并且不易受光照变化的影响,因此使用激光点云数据完成三维目标检测任务已成为研究的热点。与图像数据不同,激光点云数据具有无序性、非结构性及分布不均等特性。为了与现有的深度学习技术相结合,激光点云的三维目标检测方法按照点云的不同表示方式,又可细分为三种方法:基于原始点云、基于点云投影及基于点云体素化的三维目标检测方法。

(1)基于原始点云的方法,主要使用PointNet[10]系列方法直接对点云进行处理,学习点云的特征并完成分类和三维边界框的估计,例如PointRCNN(point region convolutional neural network)[11]、3DSSD(3D single stage object detector)[12]等。这些基于原始点云进行三维目标检测的方法,能够最大程度保留物体在三维空间中的位置信息,但往往计算量较大且运行速度较慢。

(2)基于点云投影的方法,典型的方法有3D FCN(3D fully convolutional network)[13]、RT3D(real time 3D detection)[14]等。该类方法通过将点云投影为不同角度的二维视图,再利用成熟的二维目标检测网络实现目标检测,但投影操作不可避免地会丢失点云的高度信息,导致检测准确率降低。

(3)基于点云体素化的方法,例如VoxelNet[15]、SECOND(sparsely embedded convolutional detection)[16]等,将无序的点云数据组织成有序的体素表达形式,并应用三维卷积网络提取体素特征实现三维目标检测。体素的表达保留了点云的形状信息,并能有效地提升网络的处理速度,但点云体素化过程会存在量化误差,当点云分布不均时,容易存在大量的空体素,增加计算量。

基于视觉的方法只提供图像的纹理信息,缺乏深度信息;而基于激光点云的方法提供了空间几何信息,但缺乏纹理信息。纹理信息有助于目标的检测与分类,而深度信息能为目标的空间位置估计提供帮助。同时使用图像和激光点云等数据,通过融合的方案来提升整体的性能,也是三维目标检测方法中的一个研究热点。基于图像与点云融合的三维目标检测方法,典型的有MVX-Net(multimodal VoxelNet detection)[17]、MV3D(multi-view 3D detection)[18]等。该类方法充分利用颜色、纹理等底层特征,融合视觉的纹理信息与点云的空间几何信息,实现高精度的目标检测。

当前基于激光点云的三维目标检测方法已逐渐成熟,但仍存在着各种问题,如只专注于提高单一数据集的检测精度,没有充分考虑模型的泛化能力,点云数据被遮挡与截断,点云与视觉信息对齐等问题。因此,基于激光点云的三维目标检测仍具有挑战性。

目前已有相关综述对三维目标检测方法进行了梳理总结[19-22]。文献[19]的综述工作涵盖了与点云相关的多种任务,如三维形状分类、三维目标检测和三维分割;文献[20]首先对二维目标检测进行概述,随后对具有代表性和开创性的三维目标检测算法进行比较和总结;文献[21]对交通场景下的目标检测算法做了较为详尽的综述,其中涵盖了二维、三维以及多模态的目标检测算法;文献[22]以自动驾驶应用为背景,对三维目标检测中基于单目、基于点云和基于多模态方法进行了综述。但现有针对激光点云的三维目标检测方法的讨论与分析工作还有待完善,对未来发展趋势的展望还有待补充。因此,本文在前人综述工作的基础上进行了整合与完善,并对近年来提出的基于激光点云的三维目标检测方法进行系统的总结与梳理。首先根据输入网络的数据形式对基于激光点云的三维目标检测方法进行分类,并对各类方法进行了详细的阐述。根据最近提出的新方法将基于多模态融合的方法细分为点云与视图、体素与视图、点云与体素三种融合方式。其次对目前主流的三维目标检测数据集及评价指标进行介绍。接着对当前激光点云的三维目标检测算法进行讨论分析。最后指出目前三维目标检测算法存在的不足,并对未来的发展趋势进行了展望。

1 基于激光点云的三维目标检测方法

本文将三维目标检测方法按照输入网络的数据形式,划分为四个类别:基于原始点云、基于点云投影、基于点云体素化以及基于多模态融合的检测方法。然后对各类方法脉络进行梳理,并分析三维目标检测方法的优缺点。基于激光点云的三维目标检测算法详细分类如图1所示。

图1 基于激光点云的三维目标检测方法Fig.1 3D object detection methods based on LiDAR point cloud

1.1 基于原始点云的检测方法

使用激光雷达扫描场景获得的点云数据称为激光点云。激光点云数据中包含点的三维坐标及反射强度,蕴含着丰富的几何信息。然而使用手工特征编码的方式来编码点云,难以提取出物体有效的几何信息。又由于激光点云的无序性质,使其无法与二维图像一样使用卷积神经网络来学习特征。2017 年,Qi等[10]开创性地提出了直接处理点云数据的神经网络模型PointNet。该模型使用多层感知机(multi-layer perceptron,MLP)学习点云的空间特征,并使用最大池化来解决点云的无序性问题,但存在局部特征表达能力不足的缺陷。同年,Qi等[23]对PointNet进行了改进,提出一种新的网络模型PointNet++。该网络添加点云局部特征提取模块,增加了网络模型的鲁棒性。实验证明PointNet、PointNet++能有效学习到点云的特征,开拓了基于原始点云的三维目标检测新方法。

得益于PointNet、PointNet++对点云特征的有效提取,Shi 等[11]提出了直接使用点云数据进行检测的网络模型PointRCNN。该方法分为两个阶段:第一阶段,将输入的原始点云使用PointNet++分割为前景点和背景点,并在前景点上生成三维建议框;第二阶段,融合点云的语义特征和局部空间特征,回归得到高质量的三维边界框。通过两个阶段的处理,进一步提高了检测的精度,但需要消耗更多的计算成本。针对回归框计算量大的难题,Yang 等[24]提出了球形锚框的建议框生成方法,同时,引入点池化层对区域内无序的点云有序化,使该层能高效地学习点云特征,从而减少了计算量并实现了较高的召回率。

虽然PointNet、PointNet++能够有效地学习点云特征,但对目标的尺寸感知较弱,进而影响预测框的回归。Li 等[25]提出加入边界距离特征及虚点特征来增强原有PointNet 的性能。边界距离特征即候选框内的点到框边的归一化距离;而虚点特征即在候选框边界上生成固定数量的点,并计算框内点到虚点的距离。这两种特征能够提高网络对目标尺寸的感知能力,使预测框回归更精准。针对PointNet++中特征传播(feature propagation,FP)层耗时的问题,2020年,Yang 等[12]舍弃了FP 层以及修正阶段,如图2 所示,通过特征最远点采样(feature-farthest point sampling,F-FPS)获取更多的前景点,并将采样到的点在监督学习下向目标中心点进行偏移,最后完成预测框的回归与目标类别的分类。该算法的推理速度在同类方法[11]中有显著提升。同样的,Chen等[26]受采样策略的启发,提出了基于点云语义引导的最远点采样(semantics-guided farthest point sampling,S-FPS)。该采样方法对点云进行前景点分割,并将分割的分数作为权重加入到最远点采样中。其采样结果在不同的点云输入顺序下会保持稳定,相比于F-FPS具有更高的鲁棒性。然而使用最远点采样会消耗较多的内存与计算成本,Zhang等[27]提出了实例感知的分层采样策略。该采样策略不仅能采样到更多的前景点,还能明显提高检测的速度。Zheng等[28]为了进一步提高识别准确率以及算法运行速度,提出了网络模型SE-SSD(self-ensembling single-stage object detector)。该网络受Tarvainen 等[29]的启发,设计了教师、学生网络。教师网络用于产生软目标信息,而学生网络利用软目标进行监督训练。为了实现更大的检测范围,学生网络还使用了形状感知的策略,增强其训练样本。实验结果表明,该算法的运行速度比大部分一阶段算法[12,16,30-31]要快,且检测精度超越大部分二阶段算法[11,32-33]。

图2 3DSSD框架图Fig.2 3DSSD framework diagram

为了进一步提升检测的精度,研究人员对点云中存在的几何关系进行了深入的研究。点云由于其特有的性质容易构成图,近年来应用图神经网络探究点云的几何关系也是研究的热点。2020 年,Shi 等[34]提出了基于图神经网络的模型Point-GNN(point graph neural network)。该方法首先将原始点云构建成图表示,学习图中边与顶点的特征,并预测图中每个顶点所属的对象类别和边界框。其次,引入一种自动校准机制来减少顶点平移时带来的影响。最后,使用改进的非极大值抑制操作对边界框进行评分及合并操作。该方法取得了不错的识别准确率,但对远处点云稀疏区域和点云遮挡区域的识别较差。Zhang 等[35]使用点云补全的方法来解决远处目标稀疏的难题。该方法对候选框内的点云进行补全得到稠密的点云以及完整的三维形状,并通过局部-全局注意力机制以及多尺度图的上下文融合来捕捉点云之间联系。最后依赖补全增强编码特征,获得了远距离稀疏点云的目标预测框。

针对目标检测中的非极大值抑制操作,传统做法是将分类置信度作为抑制标准。Zhu 等[36]提出使用交并比(intersection over union,IoU)作为抑制条件比使用分类置信度更合适。基于这种思想,Li等[37]提出了三维交并比(3D IoU)来提高检测的精度。该方法首先使用角点注意力聚集模块学习每个目标的透视不变性特征,并使用角点几何编码模块对候选框编码,旨在产生IoU 建议,该IoU 信息作为非极大值抑制的条件用于后处理。虽然该方法在KITTI 数据集[38]上表现出不错的检测精度,但还存在计算量大从而影响算法实时性的问题。因此,Zhou 等[39]提出了不需要非极大值抑制操作的网络模型SE-RCNN(selfenhanced RCNN),使用空间嵌入策略聚集实例的中心点,并对每个聚类簇生成三维建议框,因此省略了非极大值抑制操作,有效地减少了计算量。

此外,实现三维目标检测任务需要大量的标注数据集,而在三维场景中对目标进行标注需要耗费大量的成本,并且存在场景受限的问题。近年来,出现了弱监督学习,它是减少数据集标注量的有效途径。2020 年,Meng 等[40]率先提出了弱监督的三维目标检测网络WS3D(weakly supervised 3D)。该网络首先使用弱标注的鸟瞰图数据,并在此弱标注的基础上生成圆柱形候选框。该方法能以较低的标注数据量达到与全监督网络相近的效果,但还是需要少量准确的三维标注。同年,Qin 等[41]提出了无需三维标注的检测网络VS3D(visual supervised 3D)。该网络使用预先训练好的图像检测网络作为媒介,将无监督模块生成的三维建议框投影到图像上,利用图像的检测结果对三维目标检测网络进行监督学习。虽然该方法利用了成熟的二维图像网络,但性能与全监督网络相比差距较大。类似的,Wei等[42]也提出了不需要三维标注的弱监督网络FGR(frustumaware geometric reasoning)。该网络基于二维目标检测结果对三维点云进行分割操作,利用关键顶点和关键边与截锥体相交的条件来生成伪三维标签,并通过伪标签来进行监督学习,该方法在性能上可以达到全监督网络的水平。上述的弱监督三维目标检测方法主要应用于室外场景,针对室内场景的弱监督三维目标检测,Xu 等[43]提出了BR(back to reality)的方法。该方法利用合成的三维形状将弱标注标签转换为虚拟场景下的全标注标签,并利用虚拟标签对真实标签进行补充与细化,最后对网络进行辅助监督训练。该方法只需要5%的标注量,就能达到与全监督方法相当的性能水平。

1.2 基于点云投影的检测方法

基于点云投影的三维目标检测方法,通常将点云进行投影,投影视图分为前视图(front-view,FV)、鸟瞰图(bird's eye-view,BEV)以及范围图(range-view,RV)。将点云投影成视图的表达形式,并迁移成熟的二维图像深度学习网络模型来学习和提取投影视图的特征,完成三维目标检测,已经成为三维目标检测中的一个研究方向。

2016 年,Li 等[44]作为先驱者,提出使用二维卷积网络来完成三维目标检测任务。该方法首先将点云投影成前视图,随后利用卷积网络预测目标的置信度以及边界框。该方法是早期使用投影来实现三维目标检测的研究,具有深远的意义。针对区域建议网络中感兴趣区域(region of interest,RoI)池化操作耗时问题,Zeng 等[14]提出Pre-RoI pooling convolution结构来改变操作顺序,其结构如图3 所示,将卷积操作放在RoI 池化之前,对所有RoI 进行一次性卷积,减少运算时间,但会存在分类及定位准确率下降的问题。为此,作者提出改进方案,对RoI 分别提取特征,并将若干区域特征进行拼接以完成预测框的准确回归。类似的,Yang 等[45]提出了PIXOR(oriented from pixel-wise)网络模型。该网络将鸟瞰图作为输入,引用残差网络提取图像特征,并使用两个网络分支分别完成目标识别和定位的任务,在鸟瞰图上生成目标边界框。该方法的平均精度优于此前的方法[44]。除了将点云投影为鸟瞰图和前视图以外,针对点云的稀疏性,一些学者提出了范围图。2019 年,Meyer 等[46]将点云投影到范围图,并且每个像素采用五维编码输入到二维骨干网络提取特征,对每个特征像素都预测类别概率并进行分组,并给出目标建议框。该方法的实验效果证明了范围图的有效性。然而范围图也存在的尺度变化及遮挡的问题。Liang等[47]提出膨胀残差块来减少尺度带来的影响,其网络结构是将膨胀卷积插入到标准的残差块中,使网络能学习到目标的不同尺度特征。而针对遮挡的难题,提出将特征从范围图转移到鸟瞰图的方法,在鸟瞰图上生成区域建议,一定程度上避免了尺度变化以及遮挡的问题。范围图是通过点云的空间坐标系转换得到的,因此范围图数据蕴含着三维空间中的几何信息。Chai 等[48]提出一种可以获取三维几何信息的二维卷积网络模型,其中使用自注意力机制核、PointNet核、边缘卷积核三种核,来替代传统的二维卷积核。该网络模型的参数量比流行的网络模型PointPillar[49]少99.4%,具有较高的目标检测效率。2021年,Fan等[50]也在卷积核上入手,提出了基于范围图的网络模型RangeDet(range view detection)。该网络采用了一种新的卷积方式Meta-Kernel,其操作细节如图4所示。

图3 Pre-RoI pooling convolution示意图Fig.3 Pre-RoI pooling convolution schematic diagram

图4 Meta-Kernel卷积操作示意图Fig.4 Meta-Kernel convolution schematic diagram

Meta-Kernel利用范围图像素与空间中点的对应关系,使用MLP学习空间中点的权重,最终得到卷积输出。这充分考虑了范围图中含有的几何信息,有助于高效特征提取。Sun 等[51]针对大范围的目标检测需要,使用金字塔结构提取范围图的特征,并对前景点进行分割,利用改进的CenterNet[52]网络完成目标的回归预测。同时,作者还将一系列时序不变的范围图作为输入,以减少激光雷达自运动的影响。然而这些基于范围图的检测网络往往只关注单帧点云的处理。Tian等[53]针对多帧的点云的输入,提出了多回合范围图投影机制。该机制将每一帧点云的范围图投影在通道上进行拼接组合,解决了多帧点云投影时发生的重叠问题,并通过模态卷积有效学习范围图通道上的多帧点云投影特征。该方法弥补了多帧点云投影的空白,并为后续点云投影方式的研究提供了思路。

1.3 基于点云体素化的检测方法

基于点云体素化的三维目标检测方法,是首先对点云进行体素化的表达,然后进行三维目标检测的一类方法。体素化能够很好地解决点云自身的无序性,对于有序的体素数据,可以采用三维卷积,并对体素数据进行特征提取及学习。

2017年,Engelcke等[54]首次在三维数据上利用稀疏卷积,提出了Vote3Deep网络模型。该网络将点云体素化后使用手工特征的方式进行编码,并借鉴了Vote3D[55]的思路,对稀疏卷积层使用投票的策略提取其体素的特征。该方法为后续的研究工作提供了思路,但手工编码体素的方式无法有效表达点云的几何特征。针对此问题,Zhou 等[15]提出了端到端的网络模型VoxelNet,使用体素特征编码网络代替手工编码特征,其结构如图5 所示,体素特征编码网络融合学习体素格的逐点特征和局部特征,并将特征输入到区域建议网络生成三维目标边界框,能实现较好的检测效果,但推理阶段实时性较差。

图5 体素特征编码网络Fig.5 Voxel feature encoding network

2018年,Yan等[16]为了提高三维卷积网络的运算效率,受三维空间的稀疏性以及子流形卷积的启发,提出了一种高效的网络模型SECOND。该算法通过改进的稀疏卷积提取体素的高维鸟瞰图特征,并将鸟瞰图特征输入到区域建议网络(region proposal net-works,RPN)中生成候选框。该算法由于采用改进的稀疏卷积,运算速度较快,在后续的研究中被广泛使用。

针对体素化过程存在量化误差以及包含三维几何信息能力有限的难题,He 等[30]设计了一种利用点云结构信息提升定位精度的方法,通过引入辅助网络,使骨干网络在特征提取时更加关注点云的结构信息。针对一阶段的算法预测边界框与分类置信度不匹配的问题,该算法又引入了局部感知操作,将预测框与分类置信度对齐,进一步提升检测精度。同样的,Tian等[56]提出了一种感知点云上下文信息的网络模型CADNet(context-aware dynamic network),通过语义上下文信息捕捉点云密度的变化,使用可分解的动态卷积来学习局部语义上下文特征。该网络对目标点云的密度变化具有较强的鲁棒性。在利用标签数据提高检测的精度方面,Shi 等[33]提出了利用标签内部信息来完成检测的网络模型Part-A2net(partaware and part-aggregation network)。该网络分为局部感知和局部聚合阶段两个阶段。第一阶段,使用稀疏卷积对体素进行特征提取,并结合标注框的局部位置以及前景信息生成高质量的建议框。第二阶段,对RoI 池化特征与局部体素特征进行融合,最后基于融合特征对候选框进行修正操作。该网络在检测准确率上有明显提升。

由于点云稀疏和易受噪声干扰的特性,如何有效地编码点云信息,进而增强体素特征仍然是有待研究的问题。2020年,Zhu等[57]提出了一种新型的三维形状特征编码方式。该方法首先通过对称补齐、凸包计算以及切比雪夫拟合操作,获到点云的形状编码特征,然后根据形状编码特征对相似的形状进行组合。该方法在NuScenes数据集[58]上取得了不错的识别效果。Lang等[49]提出了基于柱体的点云编码方法。该方法首先使用若干个柱体对点云进行划分,其次提取每个柱体内的点云特征并将其编码成伪图像,最后在伪图像上回归目标预测框。该方法不仅能实现较快的运行速度,并且其准确率能与SECOND[16]相匹敌。为了缓解噪声对算法的干扰,Liu 等[31]提出了单阶段的三维目标检测网络TANet(triple attention network)。该网络使用三个注意力模块增强目标的关键信息,同时抑制不稳定的点云。并且采用粗到细的回归模型,在不增加计算开销的情况下提高了定位精度。

受二维目标检测中无锚框检测器CenterNet[52]的启发,在三维目标检测中使用无锚框的方法可以有效地减少计算量,进一步提高算法的实时性能。2020年,Chen等[59]提出了无锚框的网络模型Hotspots。该方法将目标框内的非空体素称为热点,并将每个热点分配到合适的类中。这种处理方式能够有效地对物体的三维形状和几何信息进行编码,并对点云数量较少的目标也具有良好的检测效果和实时性。PointPillar[49]验证了在伪图像上进行三维目标检测的有效性,因此可以结合CenterNet 中将物体视作为中心点的概念,将三维目标视作在伪图像下的一个中心点。基于这种思想,Ge 等[60]也提出了无锚框的网络模型AFDet(anchor free detection)。该算法首先使用PointPillar 作为骨干网络,将点云转换成伪图像。其次对伪图像特征分别回归目标中心、目标中心偏移、目标z轴位置、三维边界框大小以及方向五个特征。最后对于每一个目标,预测一个三维边界框。该算法不需要使用非极大值抑制操作,减少了运算量。类似的,2021年Yin等[61]也提出了一种无锚框的方法CenterPoint。该方法也使用PointPillar作为骨干网络来对点云进行伪图像编码操作,不同的是,CenterPoint使用高斯核散射来生成热值中心图,并且在热值中心图上回归目标中心、目标z轴位置、三维预测框大小以及方向。实验结果表明,该方法在两大数据集Waymo[62]、NuScenes[58]上能达到最佳的准确率。针对物体中心点可能会出现远离目标边界,产生三维目标框偏差的问题,Wang 等[63]引入辅助角注意力模块来预测物体角点。该方法使骨干网络更关注目标的边界,让生成的中心热值特征更具代表性且回归的预测框更精准。

由于存在空间遮挡以及在不同距离下点密度变化较大的问题,Kuang 等[64]提出Voxel-FPN 网络。该网络首先利用多尺度分割点云数据,随后分别使用VEFFPN(voxel feature encoding-feature pyramid networks)及RPN-FPN(region proposal network-feature pyramid networks)提取并集成不同尺度的体素特征,以抵挡点密度变化大的问题。类似的,Hu 等[65]提出点密度感知体素网络(point density-aware voxels,PDV)来捕捉点云密度的变化。PDV通过体素点质心定位体素特征,并通过密度感知RoI网格池化模块聚合空间局部体素特征,实现对密度变化的有效感知。而Ye等[66]针对体素格尺寸参数选择的问题,设计了混合尺度体素网络(hybrid voxel network,HVNet)。该方法将混合尺度体素中的点聚合到全局上下文中,并投影到动态目标尺度的特征上。该方法避免了体素尺寸参数选择难的问题,且能实现较高的识别准确率与运行速度。

通常三维目标检测算法将目标定位以及分类视为两个单独的任务,因此会出现定位准确度和分类置信度不匹配的情况。Zheng 等[67]提出了CIA-SSD(confident IoU-aware single stage detector)网络模型。该算法设计轻量的空间语义特征聚合模块自适应地融合高层语义及底层空间特征,使用IoU感知置信度修正模块对预测进行修正,实现准确预测边界框以及分类置信度。最后使用基于多距离IoU 加权的非极大值抑制获得预测框。许多基于体素的方法都参考二维检测的下采样操作,而Fan等[68]认为下采样对于三维场景并不适用,并提出了单步长的网络模型SST(single stride transformer)。借鉴Transformer 架构,他们还提出了稀疏区域注意模块来解决单步长网络感受野不足的情况,且与点云的稀疏特性很好地配合,避免了过高的计算消耗。该方法在所有单阶段检测算法中实现了最佳性能。

1.4 基于多模态融合的检测方法

基于激光点云不同表示形式的三维目标检测方法各有优劣,单一类型数据难以实现精确高效的检测。为此,将具有互补特性的多种数据进行融合以增强感知能力,成为新兴的研究主题。

1.4.1 点云与视图融合

基于视图的方法可以获取颜色、纹理信息,但较难从视图直接获取空间中目标的几何信息;而基于点云的方法可以获取空间中目标的几何信息,但缺乏视图所拥有的颜色、纹理信息。纹理、颜色信息有助于对目标的检测与分类,而空间几何信息对于目标的准确定位有着至关重要的作用。因此一些三维目标检测方法通过视图、点云融合的方案来提高整体的检测性能。

2017 年,Chen 等[18]率先提出了多模态数据融合的网络模型MV3D。如图6 所示,该网络以鸟瞰图、前景图、RGB图像作为输入源,使用多个分支的卷积神经网络分别提取特征图,并利用鸟瞰图特征生成一系列精准的候选框,随后将候选框投影到各个视图的特征图中。多个分支聚合特征的融合策略能有效融合不同层次的特征,有助于提高网络的检测性能。然而仅在鸟瞰图上进行区域建议框的生成只对某些类别的目标有效,对于尺寸较小的物体就很难体现其检测效果。Ku等[69]提出了一种对不同模态数据进行早融合的网络模型AVOD(aggregation view object detection)。不同于MV3D,在AVOD的区域建议网络中,输入源是RGB 图像与鸟瞰图。由于同时使用RGB 图像特征和鸟瞰图特征,对行人和自行车类别的检测效果有明显提高。而Xu等[70]提出将点云全局特征及图像特征进行拼接,并在此基础上预测三维边界框的8 个顶点及其偏移量。该方法对尺寸较小物体的检测效果有所提高。

为了使RGB图像与点云更好地融合,2018年,Qi等[71]提出使用视锥体的方法来进行检测。该方法首先在图像上生成二维的区域候选框,并结合深度图在原始的点云数据上生成视锥体区域建议。最后使用PointNet 在视锥体候选区域中进行目标分割以及预测框的回归。但该方法对前景点分割效果的好坏比较敏感。Wang 等[72]针对此缺点,提出了基于滑动视锥体的网络模型Frustum ConvNet。不同之处在于,该方法对每个二维建议框都沿视锥轴方向生成视锥体序列。实验结果表明,该方法的检测精度相较于Frustum PointNets 有进一步的提升。为避免图像投影的空间信息损失,Liang等[73]提出了将RGB图像特征投影到鸟瞰图中的方法。受深度参数连续卷积[74]的启发,使用多层感知机作为连续卷积的参数化核函数,提取与鸟瞰图像素对应的点云特征,并与RGB 图像特征在不同尺度下进行融合,能有效避免空间信息的丢失。Xie 等[75]沿用了连续卷积的思路,提出了注意连续卷积来融合点云与RGB 图像,通过相机标定参数可以找到点云对应图像中的语义特征,再结合点云的几何特征,使用注意连续卷积来进行特征的融合。该方法还能有效避免视角差异及量化误差带来的特征表达能力不足的问题。而Huang等[76]则提出LI-Fusion 模块,自适应地估计点云与图像语义信息的相关程度,建立原始点云与图像之间的关系,相关度大的语义特征用以增强点特征的提取。同样为了建立点云与图像的关系,2020 年Vora等[77]提出了PointPainting 网络模型。该网络将点云投影到图像语义分割网络中,并将类别分数附加到每个点上作为信息的增强。该增强的点云对各类检测算法的识别效果均有提高。尽管PointPainting 有突破性的改进,但Wang 等[78]认为图像的高维特征比分割分数更适合与点云融合,并提出了跨模态的网络模型PointAugmenting。该网络首先将点云投影到图像上,并附加点云特征,随后在CenterPoint[61]的基础上添加了图像特征的处理,将图像及点云特征转换为鸟瞰图表示并进行特征融合。该方法在NuScenes 数据集上测试,其平均准确率比最佳的方法CenterPoint高出了6.5%。2022年,Zhang等[79]借助了Transformer 思想,提出针对多模态的对比增强Transformer 网络模型CAT-Det(contrastively augmented transformer detection)。该网络采用Pointformer与Imageformer双分支编码点云与视图模式内的长距离上下文特征,并通过跨模态Transformer 模块融合点云与视图模式间的特征,以实现多模态信息的充分融合。除了使用RGB 图像,Gu 等[80]提出了点云与范围图融合的高效检测网络CVFNet(cross view features network)。该网络通过堆叠点-范围特征融合模块对点云及范围图进行充分的特征融合,并将融合特征组织成伪图像的形式实现检测。该方法在精度与速度上有较大的提升。

单一模态的方法往往较难解决远处点云稀疏以及目标尺度变化大所带来的影响,基于此问题,Zhao等[81]提出了尺度不变和特征加权网络(scale invariant feature reweighting network,SIFRNet)。该网络利用前视图以及视锥体内点云作为输入,并通过实例分割网络及点云变换网络分别学习不同方向的信息及点云旋转带来的全局特征变化。Lu 等[82]提出了空间通道注意力网络(spatial channel attention network,SCANet)来应对尺度的变化。该网络通过引入空间通道注意力模块来获取场景中全局和多尺度信息。他们也提出了一种扩展空间上采样模块,通过结合多尺度低维特征获取具有丰富空间信息的高维特征,从而生成可靠的三维建议框。

对于点云稀疏的区域,一些融合方法[15-16,66-67]会因此受到限制,导致融合效果较差。Liang 等[83]提出了一种多任务的融合网络MMF(multi-task multi-sensor fusion)。该网络通过地面估计和深度补全来生成密集的伪点云,并建立点云与视图特征之间的密集对应关系,实现准确的跨模态特征表示。实验结果表明,该方法对点云稀疏区域的识别准确率提升明显。

1.4.2 体素与视图融合

将体素化的点云与视图结合,可以有效地解决点云体素化时出现的量化误差问题。2020 年,Zhou等[84]提出了鸟瞰图结合透视图进行动态体素化的方法和多视图融合的网络模型MVF(multi-view versatile framework),通过将鸟瞰图和透视图动态体素化,建立点与体素之间的双向映射。多视图融合结构使得每个点从不同视角融合上下文信息,从而提高了检测的精度。受MVF启发,Wang等[85]提出了使用点云两种表达的方法。该方法通过柱面坐标系对点云进行投影,目的是消除透视畸变效应。为了缓解空间混淆效应,使用双线性插值方法将在视图中学习到的特征投影回点中。最后该算法使用一个高效的无锚框网络取代MVF 中基于锚框的区域建议网络,算法性能比MVF 有明显优势。2022 年,Fazlali 等[86]提出一种多任务框架,通过在范围图上完成全景分割,增强了体素化后投影在鸟瞰平面上的特征,弥补了投影视图的缺点,也进一步结合前景语义信息简化了检测任务。

1.4.3 点云与体素融合

基于体素的方法计算效率高,但会丢失信息,导致定位精度差,而基于点的方法虽然计算消耗大,但可以获取较大的感受野,两类算法正好互补。2020年,Shi等[32]结合了点云与体素的优点,提出了一种高性能的网络模型PV-RCNN(point voxel-region convolutional neural network)。该网络主要分为两个阶段:第一阶段,对体素化的点云学习多尺度特征并生成三维候选框;第二阶段,通过体素集抽取模块,将各个神经层的特征连接起来并总结成关键点信息,利用关键点修正建议框,获得三维目标预测。由于该算法在各大数据集都能获得不错的性能,成为了后续各类算法对比的基线网络。为了进一步提高实时性,2021 年,Noh 等[87]提出了融合体素与点云的单阶段网络,与PV-RCNN 不同的是,其点云特征是引入一个预先存储好点云原型特征的模块,并在训练阶段根据当前点云特征与原型特征的相似情况,对模块的原型特征进行动态的更新,这减少了在推理阶段所消耗的时间。Miao等[88]指出图像中上下文信息主要出现在物体的边界和内部,而在点云中主要分布在目标边界。为了有效提取目标边界,Miao 等提出了基于点云、体素、网格特征融合的单阶段网络PVGNet(point voxel grid network)。该网络使用一个统一的骨干网络提取点云、体素以及网格级别的特征,这有助于保留点云中物体的轮廓点。而Qian等[89]提出在候选框之间进行交互迭代,使用由粗到细的方式,在候选框内构造局部邻域图实现对边界的感知。

1.5 小结

1.5.1 基于原始点云的检测方法

基于原始点云的检测方法,多数基于PointNet、PointNet++网络模型直接对点云进行特征的学习,并利用学习到的特征完成对点的分类以及边界框的回归估计任务。表1 对基于原始点云的方法进行了分析与总结。从表中的总结可以看出,基于原始点云的方法通常在点云采样及点云特征的学习两方面进行改进。这两方面也是限制该类算法检测性能的主要原因:增加点云的采样数量可以增强对目标的表征,但会带来计算上的消耗;使用图、注意力机制等操作可以增强对点云间几何关系的学习,但要考虑算法整体的运行效率。由于激光雷达扫描得到的点云存在分布不均的情况,往往会导致点云密度高的区域存在过采样,而稀疏的区域存在欠采样的现象,因此点云采样是基于原始点云方法处理流程中的关键一步。并且当前的点云采样算法难以做到高度的并行处理,对算法的实时性会产生较大影响。如何以较低的计算复杂度对整个场景做到均匀采样,还需要进行深入的研究。而对于采样点之间的特征学习,在不影响整体算法运行效率的情况下,如何有效地挖掘点云之间的几何关系还有待更多地探索。

表1 基于原始点云方法的分析与总结Table 1 Analysis and summary of methods based on point cloud

此外,当前的三维目标检测框架大多是完全监督的学习方式,需要依赖于大量的手工标注数据,与二维图像数据相比,对三维场景中的目标进行标注需要耗费大量的时间。借鉴弱监督学习在二维图像领域的应用,在三维目标检测中使用弱监督学习可以有效减少标注三维标签的成本。表2 对基于点云的弱监督三维目标检测算法进行了分析与总结。

表2 基于点云的弱监督方法分析与总结Table 2 Analysis and summary of weakly supervised methods based on point cloud

虽然WS3D 使用少量精准的三维标注和二维标注能实现有竞争力的性能效果,但依然需要使用三维标注信息。而VS3D、FGR都只通过二维标注来实现弱监督,但这两种方法的效果依赖于二维检测器的性能。BR对室内的弱监督三维目标检测算法做了初步的探索,但所能支持的目标类别有限,并不能满足实际场景识别的要求。因此,如何使用弱监督学习的方法高效地对三维场景进行标注,还需要深入地探索。

1.5.2 基于点云投影的检测方法

一般的,基于点云投影的方法往往使用卷积神经网络框架对投影视图进行处理以获得投影特征,然后通过尺寸先验条件回归生成三维边界框。表3对基于点云投影的方法进行了分析与总结。将点云投影成前视图虽然能大大减少计算的消耗,但在识别的准确率上却不尽如人意,主要是因为前视图并不能反映物体的真实尺度,给物体的准确定位带来的困难。而将点云投影为鸟瞰图仅压缩了空间的高度信息,虽然对目标的定位影响较小,但由于激光点云的稀疏性质,小目标在鸟瞰图上难以被检测。近年来越来越多基于点云投影的方法都聚焦于对范围图的处理,范围图是一种密集的二维表示,其中每个像素包含着三维距离信息,一定程度上保留了空间几何信息。然而使用传统卷积操作无法有效地提取范围图中的空间几何信息,如何使用新的算子有效提取范围图中的空间几何信息还有待更多地研究。并且在范围图上进行目标检测也会受到遮挡和尺度变化的影响,因此提取范围图特征并在鸟瞰图上进行目标检测也会是未来有待研究的方向。

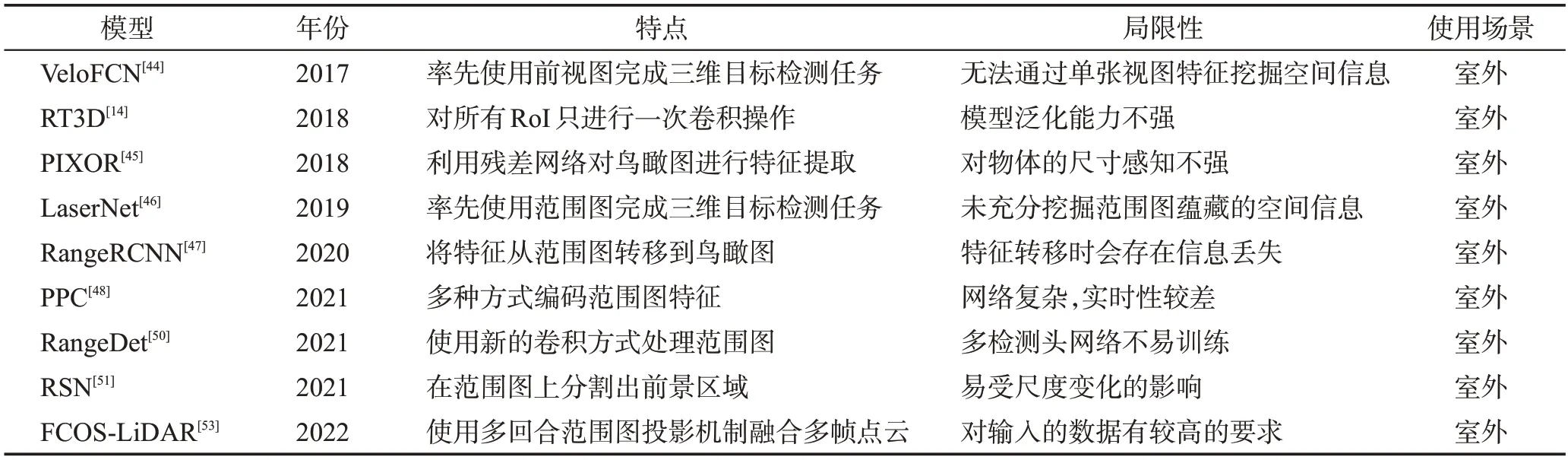

表3 基于点云投影方法的分析与总结Table 3 Analysis and summary of methods based on point cloud projection

1.5.3 基于点云体素化的检测方法

基于点云体素化的检测方法一般将点云离散成三维体素的形式,使用三维稀疏卷积网络或全卷积网络提取体素特征。表4 对该类方法进行了总结分析。点云体素化的划分方式主要有体素与体柱两种。体素划分即在各轴上都进行划分,其包含了更多的三维结构信息,但会占用较大的内存;而场景中的目标在高度上不会发生太大的变化,因此出现了体柱的划分方式,体柱划分只在x与y轴上进行划分,并在后续的处理流程中容易转换成二维的鸟瞰图特征表达形式,节省了内存的占用。虽然使用体柱的划分能使算法具有较高的效率,但简单地使用二维空间来表示点云会丢失较多的三维结构信息。在体素化过程中,不可避免会引入量化的误差,如何选择合适的划分尺寸是基于点云体素化方法的一个关键问题。较小的划分单元意味着更高的分辨率,进而能保留更多的细节信息,但内存也会随之增加。而由于激光点云的稀疏性质,点云体素化过程中会存在许多空体素,这会降低卷积处理的效率,导致更高的计算消耗。因此,如何高效地使用卷积神经网络处理稀疏体素数据需要更多研究。此外,如何对体素中点的几何信息进行有效的编码也是该类方法未来的研究方向。

表4 基于点云体素化方法的分析与总结Table 4 Analysis and summary of methods based on point cloud voxelization

1.5.4 基于多模态融合的检测方法

基于多模态融合的检测方法可以分为点云与视图、点云与体素、体素与视图三种。大致的处理流程是使用多种数据融合的网络架构处理不同的数据并生成三维边界框。表5 对基于融合的方法进行了总结。点云与视图融合,通常分为三类:早融合、中融合与晚融合。早融合即在输入到融合网络前,通过视图信息对点云进行增强;中融合使用骨干网络对点云与视图进行特征提取,随后将特征输入到融合网络中;晚融合则首先使用现有的检测器对点云及视图中的目标进行检测,并对两种检测结果进行融合。早融合与晚融合的方式兼容性较好,可以适应大多数基于点云的检测算法;中融合则利用不同模态之间的特征,实现模态间特征的交融。但早融合与晚融合需要加入二维目标检测或语义分割网络,因此会带来更多的内存消耗;而中融合由于点云与视图在数据上的差异,如何有效进行对齐融合还有待进一步研究。点云与体素融合,将无序的点云与有序的体素数据结合起来,既保留了点云中的形状结构信息,又实现了高效的运算。然而在点云与体素特征的融合过程中,点云与体素的相互转换操作会消耗大量的时间,并不利于实时的检测。因此,减少点云与体素特征融合过程中的计算消耗是点云与体素融合的一个关键问题。体素与视图融合,在对体素高效处理的基础上加入视图的特征。这种融合方法虽然具有较好的实时性,但二维视图的引入并没有在检测性能上有较大的提升,如何使用视图来补充点云体素化过程中丢失的信息,还需要更深入地探索。目前很难有效地对不同传感器数据进行对齐和融合,如何有效地融合不同传感器数据并能在时间和空间上进行对齐是不同模态间融合方法最关键的研究内容。而对于点云模态下不同表达之间的融合,仍需要探索各种表达的优势以及如何高效地对各种表达进行有机的结合。

表5 基于多模态融合方法的分析与总结Table 5 Analysis and summary of methods based on multi-modal fusion

2 数据集与评价指标

数据集对于深度学习算法研究是至关重要的,广泛、完整和标准的数据集通常可以训练出性能优异的深度学习模型。深度学习能够取得快速发展的其中一个主要原因是建立在大量数据的基础上。因此,本章重点介绍现有三维目标场景下的公开数据集,并给出三维目标检测的评判指标。

2.1 常用的三维目标检测数据集

KITTI 数据集[38]是目前三维目标检测领域最常用的公开数据集之一。KITTI数据集包含了7 481个训练数据和7 518个测试数据,其标签将目标细分为“汽车”“行人”“自行车”等8 类,并提供每个类别的2D 标注框与3D 标注框。根据目标的大小、距离、遮挡情况,KITTI数据集将检测难度分为简单、中等、困难3个级别。

NuScenes 数据集[58]是由NuTonomy 与Scale 发布的大规模自动驾驶数据集。该数据集包含了激光点云数据、图像数据以及毫米波雷达数据。NuScenes数据集由1 000 个场景组成,其中850 个场景作为训练验证集,另外150个场景作为测试集。每个场景长度为20 s,有40个关键帧,并对每个关键帧中的目标进行手工标注。NuScenes 数据集主要针对3D 目标检测任务,共标注了道路场景下23类目标的3D检测框信息,并且标注信息可实现与KITTI集标注格式间的转换。相比于KITTI数据集,NuScenes数据集包含的数据规模更大,另外包含了白天、夜晚以及不同天气、光照等更多场景状况的应用。

Waymo开放数据集[62]由Waymo自动驾驶汽车在各种条件下收集的高分辨率传感器数据组成,它与KITTI、NuScenes等数据集相比,在传感器配置、数据集大小上都有很大的提升。Waymo数据集包含3 000段驾驶记录,时长共16.7 h,平均每段长度约为20 s。整个数据集一共包含60 万帧,共有大约2 500 万个3D边界框、2 200万个2D边界框。此外,在数据集多样性上,Waymo也有很大的提升,该数据集涵盖不同的天气条件,包括白天、夜晚不同的时间段,市中心、郊区不同地点,行人、自行车等不同道路对象等。

2.2 评价指标

判断一个目标检测模型的优劣,可以从以下三方面进行评估:目标检测的速度、目标定位的精度和目标分类的精度。

(1)目标检测的速度,通常采用每秒传输帧(frames per second,FPS)来评估,即每秒内可以处理的数据帧数量,FPS数值越大,检测的实时性能越好。

(2)目标定位的精度,一般可以使用IoU来判断,如式(1)所示,其主要是衡量模型生成的预测框与真实框之间的重叠程度。IoU 越接近1,其定位精度越好,反之越差。

(3)目标分类的精度,一般可以使用查准率(precision,P)、查全率(recall,R)以及平均准确率(average precision,AP)等评价指标进行评估。通过设置IoU 的阈值,可评估检测结果中的真阳性(true positive,TP)、真阴性(true negative,TN)、假阳性(false positive,FP)、假阴性(false negative,FN),从而计算出模型的查准率P与查全率R,其计算公式如式(2)、(3)所示。

通过以查全率为横坐标,查准率为纵坐标,即可绘制P-R曲线。通过对P-R曲线进行积分,可以得到平均准确率AP。为了简化计算,KITTI 使用了基于40 个查全点插值的方法来计算平均准确率[90]。如式(4)所示,其中P代表插值点的查准率值。AP 越高,表示对该类的检测精度越高,AP 可以衡量该模型对单类别检测结果的精度。而对于多类别的整体精度表现,通常使用平均精度均值(mean average precision,mAP)衡量,即对所有类别的平均准确率进行平均。

在三维目标检测任务中,虽然AP是用于衡量算法性能的主要指标,但其仅仅能衡量物体的检测与定位精度,不能对检测结果的方向进行衡量。基于此,KITTI数据集定义了一个新的指标——平均方向类似性(average orientation similarity,AOS),用于衡量预测框与真实框的航向角类似程度。AOS的计算方式与AP类似,如式(5)、(6)所示。

式中,r代表查全率,为方向相似性,其被定义为所有预测框与真实框余弦距离的归一化。D(r)表示在查全率r下所有预测结果为正样本的集合。表示预测框航向角与真实框之间的差。δi为惩罚项,为了防止多个预测框匹配到同一个真实框,如果检出目标i已经匹配到真实框,则δi=1,反之,δi=0。

3 讨论

基于激光点云的三维目标检测算法的检测性能主要由第2章所介绍的数据集及评价指标来衡量,尽管会有不同的评价指标,但其中都包含对三维空间中目标的检测精度及召回率。以下对基于不同模态的方法分别进行对比及详细分析。

3.1 基于原始点云的方法

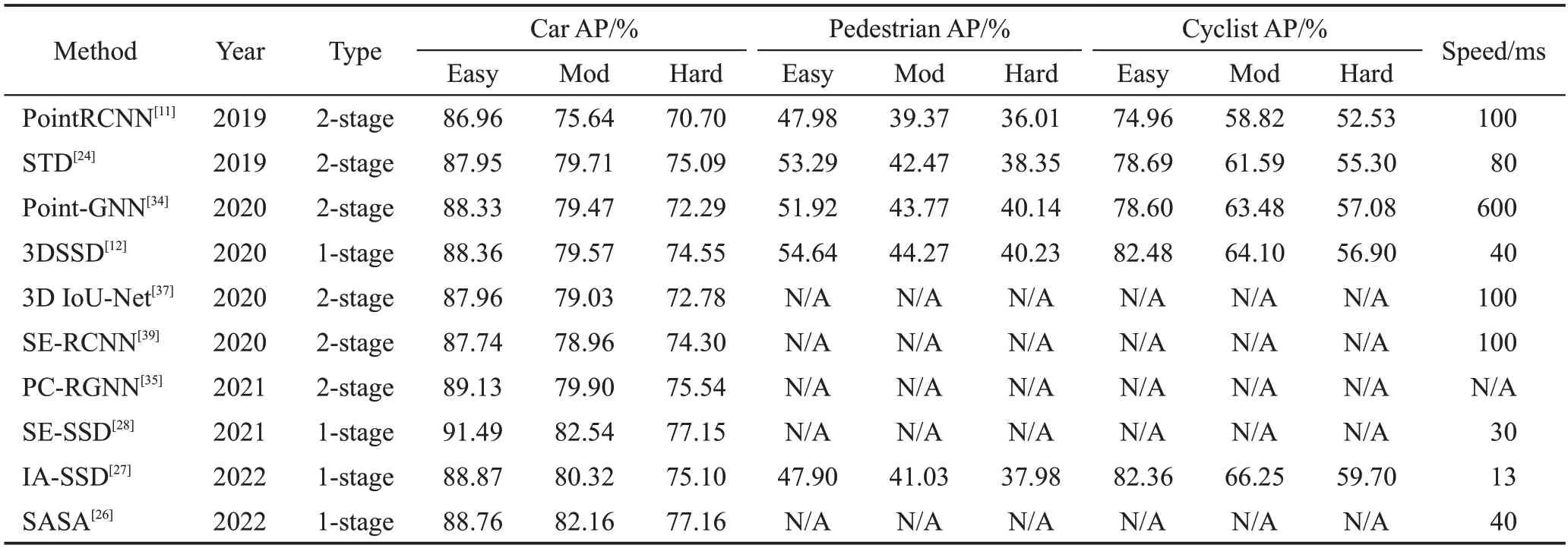

基于原始点云的方法通常使用PointNet、Point-Net++或者其改进方法作为骨干网络提取点云的特征。二阶段方法例如PointRCNN[11]、STD[24]、Point-GNN[34]、SE-RCNN[39],利用点云的高维特征进行前景点分割,并基于分割结果,在前景点生成三维建议框。对于建议框还需要进一步修正,其中STD 在修正阶段将点云转换成体素表达,一定程度上减少了推理时所消耗的时间。一阶段方法如3DSSD[12],针对点云的特征提取网络做出了改进,由于改进了网络结构和只进行一次回归,其运行速度较快。各种基于原始点云的方法在KITTI 测试集上的性能指标如表6所示,可以看出二阶段方法的运行速度逊色于一阶段方法,并且一阶段与二阶段方法之间的性能差距较小,近年来研究也偏向于一阶段类型的方法。虽然部分方法没有对所有类别进行完整的测试,但通过与其他方法的性能对比可知,基于原始点云的方法总体上在检测准确率上与其他方法相比有较大的优势,但在实时性方面总体不如基于体素和视图的方法。

表6 基于原始点云方法的性能指标(KITTI数据集)Table 6 Performance of methods based on point cloud(KITTI dataset)

3.2 基于点云投影的方法

基于点云投影的方法是将点云数据通过相机的内部参数进行投影。投影为鸟瞰图的方法如RT3D[14],这类方法使用手工特征生进行编码,并利用二维目标检测算法完成三维目标检测,但仅在鸟瞰图检测任务上达到较为满意的效果。

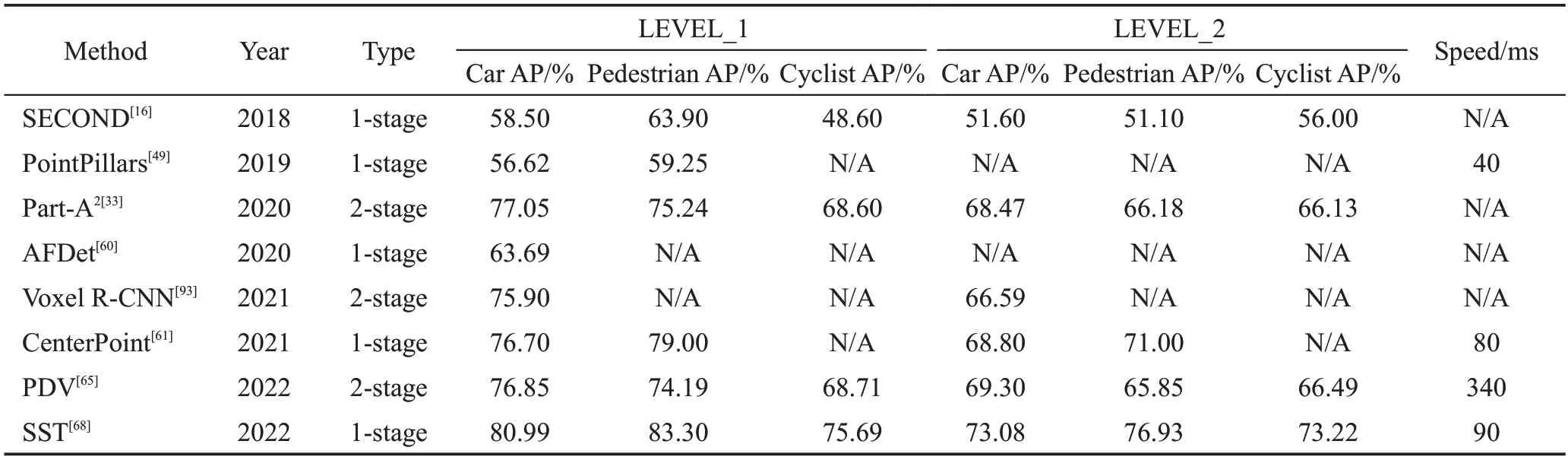

最近一些研究如LaserNet[46]、RangeRCNN[47]等,则是将点云投影为范围图。这种视图蕴含着空间几何信息,而使用传统的卷积核较难学习到这种信息。多数方法都着手对卷积核进行改进,如Range-Det[50]、PPC[48]。除了鸟瞰图在三维检测任务的表现差强人意以外,对范围图的研究变得流行的另一个原因是Waymo、NuScenes 数据集的公开。这些数据集的点云数据较为密集,使范围图中的像素点带有更多的信息,进而能获得较好的检测性能。表7、表8为基于点云投影的方法在两种数据集上的性能指标。基于视图的方法能实现较好的实时性能,但在准确率上不如其他方法,其主要原因是受尺度变化的影响。如何解决同一物体在图像中具有的不同尺度,是一直以来基于视图方法需要重点研究的问题。

表7 基于点云投影方法的性能指标(KITTI数据集)Table 7 Performance of methods based on point cloud projection(KITTI dataset)

表8 基于点云投影方法的性能指标(Waymo数据集)Table 8 Performance of methods based on point cloud projection(Waymo dataset)

3.3 基于点云体素化的方法

基于体素的方法通常将点云数据按照固定的尺寸划分,也有一些方法例如PointPillars[49]、Voxel-FPN[64]等不考虑对z轴的划分。尽管划分方式不同,体素化后的空间都由体素块组成。在三维目标检测中,较少使用二进制值以及手工制作的方式来表示体素特征,往往使用VoxelNet[15]提出的体素特征编码网络及其改进的方法。而更直接的方式是取体素内点云的平均值作为体素特征。三维卷积常常被用来提取体素的高维特征,而SECOND[16]提出的稀疏卷积的方式,因为其运算效率高而得到沿用。一些方法如HDNet[92]在体素划分后,将其转换为鸟瞰图的形式,这些方法虽然能实现较快的运行速度并能在鸟瞰图上达到较好的检测性能,但对于三维空间的检测表现较差。与之不同的是,多数方法在使用三维卷积后再进行鸟瞰图的转换,这种策略能够在检测性能与运行速度中达到一种平衡。由表9可以看出,单阶段网络框架方法的结果在精度和运行速度上都比较平衡。不仅在KITII数据集上进行方法的验证,部分基于体素的方法也在Waymo 上进行了测试验证,如表10所示。也有二阶段网络框架的方法如Part-A2[33]、Voxel R-CNN[93]等,通过修正网络提取目标的三维形状信息,用以结果修正,在增加较少推理时间的情况下,检测性能有进一步的改善。

表9 基于点云体素化方法的性能指标(KITTI数据集)Table 9 Performance of methods based on point cloud voxelization(KITTI dataset)

表10 基于点云体素化方法的性能指标(Waymo数据集)Table 10 Performance of methods based on point cloud voxelization(Waymo dataset)

3.4 基于多模态融合的方法

基于多模态融合的方法旨在对不同模态或同一模态的不同表示进行融合,以实现性能的提升。如MV3D[18]、F-PointNet[71]、AVOD[69]、PointFusion[70]等 方法,在点云数据的基础上,结合图像能提供的颜色、纹理信息等来提升检测的性能,对于点云数量较少的目标以及远处的目标有较好的识别效果。除了利用不同传感器之间的信息,也有方法使用点云的不同模态进行检测。如PV-RCNN[32]、HVPR[87]等,使用了原始点云及体素,旨在更有效地学习目标的三维结构信息。融合的方法根据融合在处理流程中的位置可以分为特征级融合和决策级融合。特征级融合即对各模态的特征进行融合,这种融合方式使用各模态丰富的中间特征,在网络中实现多种模态的互补融合。但不同传感器的数据会存在时空上的差别,且某些模态的高维特征会影响检测网络的性能,这也是一些多模态融合方法性能不及单模态的原因。而决策级融合使用各模态现有的检测网络,融合各模态下的结果并进行预测。与特征级融合相比,决策级融合网络更容易构建,并且不需要考虑数据同步及对齐等问题,但其性能会受各模态检测网络的限制。基于多模态融合的方法在KITTI 数据集上的性能指标如表11所示。为了充分利用各模态信息,多模态融合的方法多数使用二阶段网络框架,然而这增加了运算成本,导致在实时性上不及大部分单模态算法。如何使用一阶段网络框架提升多模态融合方法的实时性能,还需要更多的研究工作。尽管融合了不同类型的数据,该类方法在识别准确率上并没有比单模态方法要突出,主要原因在于不同数据间并没有进行有效的对齐融合,如何有效融合各类数据还需要进一步地探索。

表11 基于多模态融合方法的性能指标(KITTI数据集)Table 11 Performance of methods based on multi-modal fusion(KITTI dataset)

3.5 小结

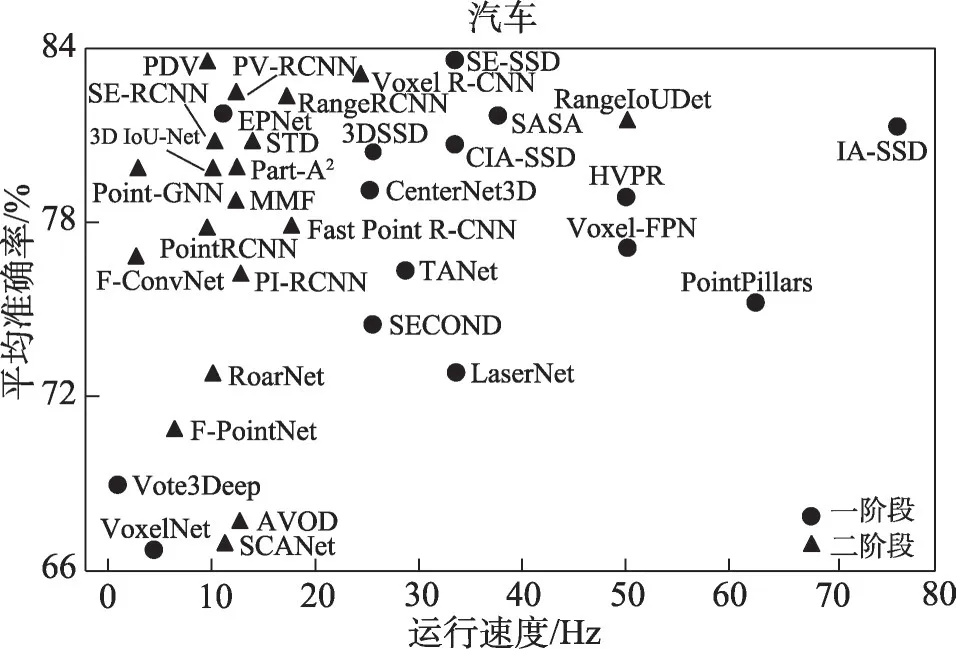

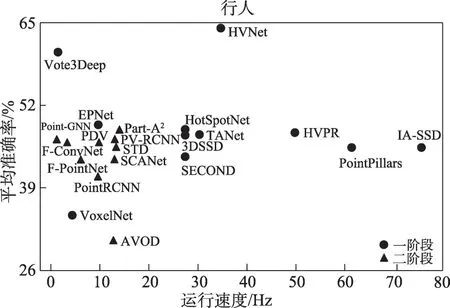

对于三维目标检测而言,检测精度和运行速度是重要的指标。根据检测方法的网络框架,可以分为一阶段与二阶段方法。一阶段、二阶段方法在KITTI数据集中的平均检测率及运行速度对比如图7、图8、图9 所示。一阶段方法往往具有良好的实时性。对汽车类别,二阶段算法往往能达到较高的识别准确率。这是因为在同等距离下,汽车具有比其他类别更多的点云信息,而二阶段网络框架会充分利用这些信息对预测进行修正。但对于行人检测,一阶段及二阶段方法都很难实现较高的平均准确率。其主要是因为行人的点云数量远远少于同等距离下汽车的点云数量,导致检测器难以学习其结构特征。

图7 “汽车”类别性能对比图Fig.7 Performance comparison diagram of“Car”

图8 “行人”类别性能对比图Fig.8 Performance comparison diagram of“Pedestrian”

图9 “自行车”类别性能对比图Fig.9 Performance comparison diagram of“Cyclist”

通过各种模态方法的性能指标可以看出,2019年前的算法都在KITTI 数据集上进行了测试,由于Waymo、NuScenes数据集公开时间较晚,只有最近的一些工作在这两种数据集上进行了测试。多数检测算法只对数据集中的一类或两类目标检测效果较好,而对所有类别都较好的方法实时性较差,不适合实际的应用。一些方法仅在汽车类别上进行了性能验证,导致不能直观地体现方法对不同目标识别的有效性。由于各种新型数据集的出现,在不同的数据集上进行测试,可以对方法的有效性进行验证。

4 存在的不足及未来发展方向

4.1 当前三维目标检测领域存在的不足

尽管三维目标检测取得了长足的进步,但当前三维目标检测依然存在以下问题。

(1)融合方式和融合效率的问题。当前三维目标检测不同模态的数据融合存在一定困难,不能充分地利用视觉语义以及点云空间信息。点云数据所表达的是物体在三维空间中的信息,其结构是无序的、不规则的,而视图是通过将物理世界投影到二维的相机平面来记录信息,其结构是有序的、规则的。由于数据的维度不一致,当需要融合两个不同模态的数据时,不可避免地会发生误差,其融合效率和融合方式都存在挑战。目前基于深度学习的多模态融合三维目标检测算法研究仍方兴未艾,如何提高不同模态的融合效率并充分利用各模态数据的优势,完成三维目标检测仍需更进一步突破。

(2)目标被遮挡与截断导致无法对其进行准确识别的难题。尽管一些算法能在一定程度上缓解点云被遮挡或截断的问题,但仍存在着计算量大、网络结构复杂等问题。因此,如何解决激光点云的遮挡与截断问题,是基于激光点云的三维目标检测方法进一步研究的重点。

(3)高质量的数据集数量有限且数据多样性不足的问题。相比于二维目标检测的数据集,三维目标检测的数据集数量仍然很少。在采用数据增强方式解决数据集样本偏少,提高神经网络模型的泛化能力等方面,进展不明显。同时,当前许多三维目标检测的公开数据集,大多数都是在光照、天气以及路况良好的条件下进行采集,数据集的多样性不足。真实世界往往包含雨、雾、雪等能见度不高的天气情况或更为复杂的路况。为了更能反映真实世界的场景,构建具有多样性的数据集是一项亟待解决的工作。

4.2 发展趋势

(1)多模态融合的三维目标检测成为主流。三维目标检测在室外场景的应用仍然是一项具有挑战性的任务,不同模态的数据有其优势与劣势。视图数据包含丰富的纹理、语义信息,但是缺少深度信息。相反,点云数据包含详细的深度信息,但是却缺少纹理、语义信息。在复杂的室外场景下,空间信息与语义信息对于目标的识别与定位十分重要,仅靠单一模态的数据往往无法进行精确的检测。虽然当前激光雷达传感器成本较高,但随着智能机器人、智能汽车等智能设备的普及,激光雷达传感器的成本也会随之降低。通过融合激光雷达、相机、毫米波雷达等多种传感器数据来感知场景目标,也逐渐成为现实复杂场景的需要。因此,多模态融合的方法逐渐会成为新兴的研究热点。

(2)弱监督学习的三维目标检测是未来方向。效果良好的深度学习算法往往需要大量带有标注信息的数据进行训练,高质量的数据标注需要大量的人力和时间成本,尤其是针对激光点云这种需要精细标注的数据集更为困难。针对该问题,可以引入弱监督学习进行目标检测,利用大量无标注或者粗糙标注的样本来进行模型的学习,这样能够有效地利用数据,提升模型的性能。研究如何利用弱监督学习进行三维目标检测,可降低因数据集问题带来的模型精度下降的影响,推动三维目标检测的进一步发展。

(3)对新型应用领域的扩展也是未来的研究趋势。虽然当前三维目标检测相关的研究已取得了巨大进步,并在相应数据集上取得了较好的性能,但其方法主要集中在自动驾驶场景。针对现实中不同应用场景的挑战,丰富三维目标检测数据集的种类,对提高检测方法在实际应用场景的适应性具有重要意义。现实应用场景中的挑战也为未来的研究提供新的方向,如工业生产场景下的三维目标检测、人机虚拟现实场景下的高精度三维目标检测等。因此,未来将研究新型应用场景下的特点并对方法进行优化改进,以推动三维目标检测的多样性发展。

5 结束语

随着深度学习的快速发展,基于激光点云的三维目标检测技术取得了突破性的进展,并在自动驾驶、智能机器人等领域扮演着重要的角色。本文系统总结了近年来基于激光点云的三维目标检测方法及主流的三维目标检测数据集。对基于激光点云的三维目标检测算法的评价指标进行说明,并对各类算法的性能进行对比分析。根据目前三维目标检测算法存在的问题,指出了其未来的发展方向。随着基于激光点云的三维目标检测算法的检测精度与速度进一步提高,其应用领域会越来越广泛。