基于Self-Attention StyleGAN的皮肤癌图像生成与分类

赵 宸,帅仁俊,马 力,刘文佳,吴梦麟

1.南京工业大学 计算机科学与技术学院,南京211816

2.南京市卫生信息中心,南京210003

3.南京医科大学附属常州第二人民医院,江苏 常州213003

与其他类型的癌症相比,皮肤癌的高发病率使之成为了世界上最严重的健康问题之一[1]。近五十年来,全世界黑色素瘤的发病率在急剧上升。对于黑色素瘤患者来说,五年以内生存率为95%,而晚期则只有15%,这种非常显著的差异突出了及时地识别并发现黑色素瘤对于患者维持生命的重要性。因此,及时发现皮肤癌是降低皮肤癌发病率的关键因素[2]。

皮肤镜是一种用来消除皮肤表面反射的成像技术。当表面反射被消除时,深层皮肤癌病变的可视化得到增强[3]。这种技术与标准摄影相比可以产生较高的诊断准确率。为了改善皮肤癌病变疾病的诊断效果,在临床中引入了皮肤镜检查以协助皮肤科医生进行诊断[4]。但在临床医学中,医生对于皮肤镜的病变图像(尤其是黑色素瘤)的肉眼识别率存在一定的误差,而且对于黑色素瘤的识别要求医生有一定的技术与经验。皮肤癌病变识别的容错率较低,误识别会对患者产生非常严重的后果[5]。

随着计算机技术的迅速发展,人工智能和深度学习技术得到了广泛的应用,尤其是在图像处理方面取得了很大的进步,深度卷积神经网络(DCNNS)能够精确地检测、分割识别医学图像中的区域与对象[6]。深度学习技术在医学临床应用越来越广泛,不仅仅是模式识别领域中的图像分类,在图像生成方面也达到了很好的效果[7-8]。

Milton[9]提出了一种基于深度学习模型的集成神经网络,包括PNASNet-5-large、Inception-ResNetv2、SeNet154和Inceptionv4。在将皮肤镜检查图像输入网络之前,需要对其进行处理和适当增强。在ISIC2018数据集上,准确性为0.76。但样本量不足,准确度较低。Akram 等[10]提出了一个基于集成的深度神经网络,并在ISIC2018皮肤癌病变数据集中进行了分类测试。该方法集成了图像深层的特征信息,生成了最具区别性的特征向量,并保留了原始特征空间。Hu等[11]提出了一种综合分类方法,该方法结合了基于屏蔽和深度卷积残差网络的数据增强,通过一系列实验验证了该方法的有效性。该模型使用更少的训练样本在皮肤疾病数据集上获得了更好的分类结果。

Rashid 等[12]将生成对抗网络(GAN)应用于皮肤癌病变图像数据的增强,并且GAN 的鉴别器还充当了最终分类器,从ISIC2018挑战数据集中进行识别7个皮肤癌病变类别。作者还利用迁移学习来微调DenseNet和ResNet 架构,并将其分类性能与基于GAN 的数据增强模型进行比较。所提出的方法在平衡精度得分方面获得了显着的性能提升。Baur 等[13]提出了一种深层识别的GAN(DDGAN)。合成了逼真的256×256 皮肤病灶图像,并对DDGAN、DC-GAN和LAPGAN进行了比较,表明DDGAN 和LAPGAN 都可以学习数据集的分布并合成逼真的样本。

Baur等[14]利用了渐进式增长的概念,该概念与其他GAN体系结构(如DC-GAN和LAPGAN)在数量和质量上都进行了比较。结果表明,借助渐进式生长,可以合成皮肤癌病变的高度真实的皮肤镜图像,即使是专业的皮肤科医生也很难将其与真实的皮肤病区分开。Bissoto等[15]采用pix2pixHD GAN进行图像合成。他们不是从随机噪声中生成图像,而是从语义图和实例图合成图像。为了反映GAN 系列生成网络对图像模式识别的重要性,Bissoto等[16]从6个方面总结和比较了近年来的GAN:架构贡献、条件技术、法线和约束贡献、损失函数、图像到图像的转换以及验证指标。结果表明,StyleGAN对黑色素瘤生成的影响比其他GAN更现实和更合适。Gong等[17]利用StyleGAN 生成高质量图像,以解决ISIC2019 数据集的最小和不均匀分布,并提高了CNN的分类准确性。他们的方法提高了皮肤镜图像分类的准确性。基于StyleGAN 在增强皮肤癌数据方面的出色表现,选择优化改进StyleGAN并将其用于皮肤癌分类项目。

从以上文献来看,当前皮肤癌病变图像合成研究中最重要的挑战之一是通过上述方法生成的图像的分辨率和质量较差,且神经网络的鲁棒性低。可需要更先进的GAN架构生成高分辨率图像应用于皮肤癌病变图像合成。

为解决上述问题,本文提出了一种基于自注意力样式的生成对抗网络(self-attention style-based GAN,SA-StyleGAN)与SE-ResNeXt-50 相结合的皮肤癌病变图像生成与分类的框架。使用SA-StyleGAN 扩展数据集样本,通过合成新的样本图像来增加模型生成图像的多样性以及不确定性。对于图像分类,使用迁移学习方法在预训练的SE-ResNeXt-50 上构建分类器。使用改进的损失函数可以减少类别内的样本距离,扩大不同皮肤癌病变图像类别之间的样本距离,更好地分析ISIC2019图像的特征并最终产生更好的分类模型。

1 研究方法

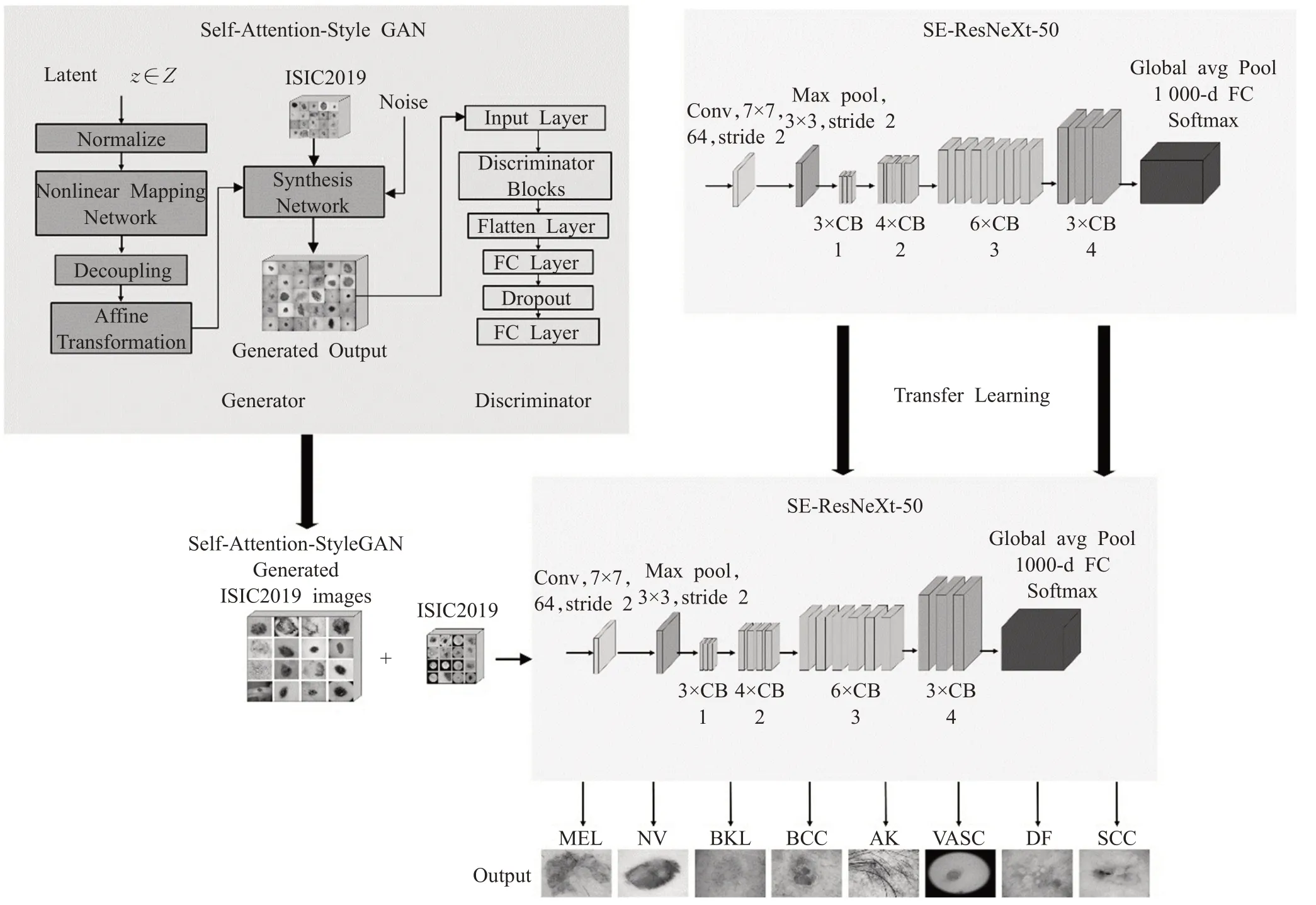

在本文中,提出了一种基于自注意力的样式生成对抗网络(SA-StyleGAN)与SE-ResNeXt-50相结合的皮肤癌病变图像生成与分类的框架。首先对ISIC2019 数据集的样本图像使用SA-StyleGAN进行样本扩充,之后将所有样本图像送入已经过ImageNet数据集预训练过且经过迁移学习的SE-ResNeXt-50进行分类,最后得到分类的结果以及各项结果性能指标。所提出模型的总体框架如图1所示。

图1 生成与分类模型框架流程图Fig.1 Framework flowchart of generation and classification model

提出的皮肤癌病变样本图像声称与分类框架包括三个主要部分:

(1)根据基于样式对抗生成网络的基本架构,提出了SA-StyleGAN,以生成高质量的皮肤癌病变样本图像,并提供给SE-ResNeXt-50分类模型进行分类。

(2)将Angular SoftMax(A-SoftMax)损失函数与SE-ResNeXt-50 分类神经网络相结合,解决样本不平衡造成的数据影响,来平衡不同类别样本的权重,从而可以改善分类模型的性能。

(3)使用迁移学习来训练SE-ResNeXt-50 模型,以提供适当的预训练神经网络模型参数来对ISIC2019 皮肤癌病变图像进行分类,并获得出色的平衡多类别准确性(BMA)。

图2显示了皮肤癌病变样本图像生成,分类过程与迁移学习模型结构示意图。使用SA-StyleGAN平衡,扩充数据集样本,从而通过合成新的样本图像来增加模型不确定性,来均衡不同类别样本的权重。对于图像分类,使用迁移学习方法在预训练的SE-ResNeXt-50上构建分类器,通过预训练的模型对样本进行分类,最终得到分类结果以及各项性能指标。

图2 皮肤癌病变样本图像生成、分类过程与迁移学习模型结构示意图Fig.2 Structure diagram of skin cancer lesion sample generative classification with transfer learning

1.1 基于样式的生成对抗网络(StyleGAN)

基于样式的生成对抗网络(StyleGAN)是由Karras等[18]提出的。与其他对抗生成网络不同,StyleGAN中的样式(用Gram矩阵表示)借用了样式转换并实现了无监督的高度可控图像生成。

StyleGAN包括三个部分:潜码(latent code)和非线性映射网络(nonlinear mapping network),噪声(noise)以及生成网络(synthesis network)。这三个部分将在下面详细描述。

1.1.1 潜码和非线性映射网络

潜在代码中的每个维度对应于皮肤癌病变图像中所关注的特征,例如区域、颜色和头发。当要更改病变图像特征时,必须找到相应的尺寸并调整潜码的值。初始潜码(z1,z2∈Z) 经过正则化后进入非线性映射网络,并获得非线性映射(8 层MLP)后,得到了w1,w2∈W。此时,图像尺寸不变。经过仿射变换和解耦合后,获得y=(ys,yb)代表样式的样式,并用于完成综合网络中的自适应实例规范化(AdaIN)。

为了进一步实现解耦合,使用了混合正则化操作。在训练期间,图像的一部分由两个潜在代码生成(也就是说,图像由两个潜在代码生成的各种样式控制)。该方法可以防止相邻皮肤癌病变类型的相关性。

1.1.2 噪声

生成网络在每次卷积后,将噪声添加到皮肤癌病变图像中的每个像素,以实现多样性和随机性。该噪声仅影响需要变化的皮肤癌病变,而不会改变图像中皮肤的良性皮肤和关键特征。

1.1.3 生成网络

在合成网络中,对原始病变图像进行卷积并逐步取样。在此过程中,y=(ys,yb)用于表示来自非线性映射网络的皮肤样式,并接受噪声以完成卷积,AdaIN 和采样操作。AdaIN公式如下:

其中,μ(xi)和σ(xi)是通过使用每个通道的特征图中的所有像素获得的平均值和方差(即,特征图更改为平均值0和方差1),而特定的ith 是第i层的特征图像。

1.2 基于自注意力样式的生成对抗网络(SAStyleGAN)

StyleGAN为高分辨率图像的合成以及对合成图像的样式和特征的精细控制做出了巨大贡献。但这种结构主要设计用于具有连续信息和样式明显变化的图像。皮肤癌病变图像与这些图像之间存在显着差异。本文致力于通过更改样式控制方法并根据原始Style-GAN简化生成器和鉴别器体系结构来解决这些问题。

皮肤癌病变的图案,颜色和样式远没有其他图像丰富,而且它们的变化不像人脸图像那样连续。由于此限制,将复杂的GAN 架构直接应用于皮肤癌病变图像的合成是不合适的。在原始StyleGAN 的基础上,本文对样式控制方法进行了一些修改,并简化了生成器和鉴别器的结构。拟议的修改如下:

(1)本文放弃了混合正则化工具。皮肤病灶混合的样式会导致样式在生成的图像中重叠,这很难区分和处理。因此,在修改的模型中仅使用一个潜在代码。由于在临床医学中,不同皮肤病变的形状纹理较为相似,所以生成的病变图像的质量需要足够高。图3 为使用了初始StyleGAN 两个潜在代码和使用了本文SA-Style-GAN一个潜在代码生成的样本对比图。

图3 使用了初始StyleGAN两个潜在代码和使用了本文SA-StyleGAN一个潜在代码生成的样本对比图Fig.3 Sample comparison diagram generated by using two latent codes of initial StyleGAN and one latent code generated by proposed SA-StyleGAN

可以看出,在使用StyleGAN初始的两潜在代码时,生成的皮肤病变样本图像会产生类似风格迁移的扭曲,很难被归类,是属于质量较低的样本。而本文使用的单潜在代码则可以有效地消除样本图像扭曲不清晰等问题,为分类器提供高质量的样本图像,也为医学皮肤领域提供更有意义的参考价值。

(2)本文修改了StyleGAN 生成器的结构。由于皮肤病变图像风格和色彩的单一性,对于皮肤分类器而言,224×224 相比于256×256 的样本在分类器中神经网络参数量更少,为了减少高分辨率带给生成器的计算压力,在保证生成样本质量的情况下提高生成器的处理效率,将生成器的最后一个模块的尺寸设置为224×224。

图4 为使用StyleGAN 初始噪声部分和本文SAStyleGAN改进噪声部分的结果详细对比。

图4 使用StyleGAN初始噪声部分和本文SA-StyleGAN改进噪声部分的结果详细对比图Fig.4 Detailed comparison of results of original noise part of StyleGAN and improved noise part of proposed SA-StyleGAN

在使用初始StyleGAN 噪声部分来生成样本图像时,噪声会导致生成的图像包含许多不必要的噪点,为减少噪声对生成器的影响,在每个综合网络模块中,除了第一层(两次添加噪声模块)外,其他层仅添加一次噪声模块。即在第二个3×3 卷积层之前添加一个噪声模块,在第二个3×3 卷积层之后添加一个噪声模块,依此类推。

通过图4可看出,使用本文SA-StyleGAN改进的噪声部分生成的样本几乎没有噪点,样本质量更优。由于皮肤病变样本图像各类别病变较为相似,颜色风格相近且单一,同一类型病变不同发展时期特殊性导致的外形难以区分等特殊性,皮肤科临床医学对于样本的质量与细节要求较高,本文的改进噪声部分可为皮肤科临床区分病变类型提供更真实客观的样本。

(3)修改了StyleGAN 鉴别器的结构。如图3 所示,合成网络单元的不同模块被级联,并且在一个训练周期之后直接从初始输入生成预定大小的图像。然后将生成的图像直接输入到鉴别器。鉴别器由几个鉴别器块组成,每个鉴别器块具有三个卷积层和两个平均池化层。此外,判别结果在退出和最后两个完全连接的层之后输出。

(4)增加自我注意力模块的最佳位置是在中高层特征图上(生成256×256像素的皮肤癌病变图像的情况下为27 和28 层)。尽管使用了渐进式训练和使用了自我注意机制,但由于高分辨率的不稳定训练行为,生成的样本仍遭受一些伪影的影响。为了减轻不稳定的训练行为,使用了两个时间尺度的更新规则。为上一层的特征图,其中Nj是特征图中的位置数。使用的权重αj计算模型在特征图x中jth的位置,其中Wk是1×1卷积模块。

使用权重αj,通过加权平均将所有位置的特征分组来获取全局特征(global attention pooling)。

第i个位置zi的最终重定义的特征为:

其中,Wv执行特征变换以捕获通道方面的依赖关系。逐个广播元素添加用于将全局上下文特征聚合到每个位置的特征。

本文生成的皮肤癌病变图像特征来自于在合成网络中学习到的各种图像的特征以及最初在混合规则中设置的潜在代码。合成网络学习到的主要特征是:(1)皮肤癌病变图像中的头发,(2)皮肤癌病变的颜色,以及(3)皮肤癌病变的形状和面积。引入噪声后,可以从合成网络的卷积层逐层学习皮肤癌病变图像的样式,并将其与接收到的噪声结合起来以生成新的皮肤癌病变图像,并进一步扩大ISIC2019的随机性和多样性。图5 显示了SA-StyleGAN的网络结构。

图5 SA-StyleGAN的结构示意图Fig.5 Structure diagram of SA-StyleGAN

1.3 迁移学习

迁移学习是一种机器学习方法,使用现有知识来解决不同但相关的领域问题[19]。迁移学习的目的是利用现有数据对模型进行训练,然后将预训练的模型直接应用于目标数据集的训练[20]。使用SE-ResNeXt-50在1 000个类别的ImageNet数据集[21]上预先训练了模型参数,之后调整了卷积层的预训练参数来初始化网络参数。通过迁移学习可以显著提高分割模型的精度。

1.4 SE-ResNeXt-50

SE(Squeeze-and-Excitation)模块[22]可通过显式建模通道之间的相互依赖关系,自适应地重新校准各通道的特征响应。这些块可以堆叠在一起,形成SENet 架构,在不同的数据集都有很好的泛化能力,并为现有的卷积神经网络带来显著的性能改善。

图6 是SE 模块的结构示意图。给定一个输入x∈,其特征通道数为c1,通过一系列卷积等一般变换(Ftr()) 后得到一个特征通道数为c2的输入uc。之后是压缩(Squeeze)操作Fsq(⋅),把每个输入的皮肤癌病变特征图的空间维度从H×W压缩到1。之后通过全局平均池化层完成,顺着空间维度来进行特征c1压缩,将每个二维的特征通道变成一个具有整体卷积层的感受野实数zc:

图6 特征压缩与激发模块结构示意图Fig.6 Structure diagram of SE module

zc表征着在特征通道上响应的全局分布,而且使得靠近输入的层也可以获得整体的感受野,之后将输出的维度和输入的特征通道数相匹配。

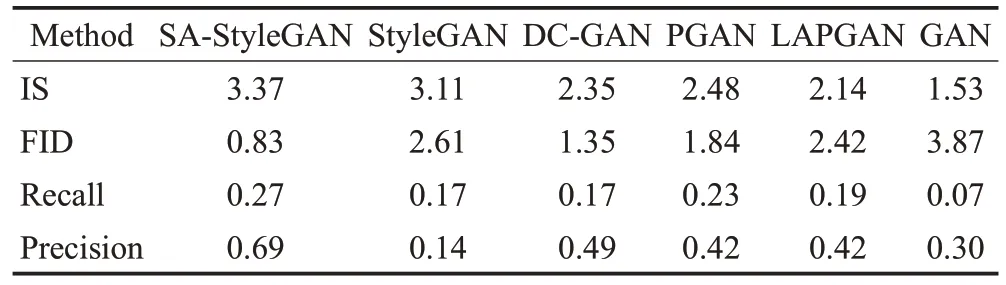

激发操作(Excitation)Fex(⋅,w) 是通过一个bottleneck结构来捕捉不同通道的内部依赖,来分析得到特征通道的裁剪系数sc。通过参数w来为每个特征通道生成权重,δ为sigmoid激活函数。

最后是重置权重的操作,本文将激发操作的输出权重看作是经过特征选择后的每个特征通道的重要程度,然后通过Fscale()逐通道加权到先前的特征上,完成在通道维度上的对原始特征的重标定。

ResNeXt[23]是一种简单、高度模块化的图像具有多分支结构的分类网络结构,通过重复一个聚合了一组具有相同拓扑结构转换的构建块来进行构建。

如图7 所示,ResNeXt 的主要结构由四种Residual block(RB)构成,首先经过7×7 的卷积层与3×3 的最大池化层,之后分别经过3个RB1、4个RB2、6个RB3、3个RB4,在经过最后的全局平均池化全连接层后,得到最后的皮肤癌病变分类结果。ResNeXt结构如图8所示。

图7 四种残差块(RB)的结构示意图Fig.7 Structure diagram of four residual block(RB)

图8 ResNeXt的结构示意图Fig.8 Structure diagram of ResNeXt

为了提高模型的准确率,传统的方法主要是增加网络的深度或宽度,但是随着超参数数量的增加,网络设计的难度和时间空间复杂度也会增加。因此本文提出的SE-ResNeXt结构可以在不增加参数复杂度的前提下提高准确率,同时还减少了超参数的数量。从工程应用场景上来分析,本生成分类模型主要的应用场景为医院皮肤科信息科室,主要用于高效区分各种难以区分的临床皮肤病变病例,及时地对患者的病情进行识别分析,提高黑色素瘤患者的存活率,如图9。

图9 初始ResNeXt与改进ResNeXt的对比图Fig.9 Comparison of initial ResNeXt and improved ResNeXt

本文使用了Angular SoftMax(A-SoftMax)损失[24]作为分类模型的损失函数,它引入了归一化权重,零偏置和角余量的概念。可以扩大不同类样本间的距离,缩小同类样本间的距离。A-SoftMax损失公式如下:

2 实验结果与分析

2.1 数据集

本文实验所采用的数据集是国际皮肤影像协作组织ISIC2019 挑战赛[25-27]公开使用的皮肤病图像数据集,该数据集包括25 331 张训练图片和8 239 张测试图片。实验过程中,本文随机从5 066 张训练图片中抽取其20%作为验证集,参考其验证结果来对模型进行调节,将剩下的20 265张图像80%作为训练数据集,在训练过程中对训练数据使用SA-StyleGAN进行数据样本扩充,对验证集和测试集数据不做数据增强操作。最后在测试集上进行测试得到最终的分类结果,根据其输出来计算分类评估指标。

2.2 预处理

本文使用训练集中每种类型皮肤癌病变的数据来生成更多的样本,并将其纳入实验中。通过SA-StyleGAN对8 种类型的皮肤癌病变图像分别生成1 000 张图片,并邀请专业的检查专家对其进行区分。结果表明,生成的皮肤癌病变图像与真实的ISIC2019图像相差不大,可以作为训练数据集。

2.3 性能指标

2.3.1 生成图像结果性能指标

Inception score(IS)[28]是GAN生成的图像质量的量度,它使用预训练的初始网络[29]通过计算来提取生成的图像特征:

DKL()、p(y|x)、p(y)、y、x分别表示KL 散度公式、样本的条件标签分布、从所有样本获得的边际分布、给定图片以及图片中的主要对象。高值表示样本图像类似于特定的ImageNet类别。

Fréchet inception distance(FID)[30]将一组生成的图像嵌入到由特定起始层或任何CNN[29]表示的特征空间中。它使用连续的多元高斯分布来表示实际数据和生成数据的嵌入特征分布,并且这两个高斯分布之间的Fréchet距离是通过以下公式计算的:

μr和Cr分别表示实际数据的均值和协方差,而μg和Cg分别表示所生成数据的均值和协方差。由于FID具有良好的可识别性、鲁棒性和计算效率,因此它是GAN的良好度量。

2.3.2 分类结果性能指标

为了全面评估模型的分类性能,使用了均衡权重多类精确度(BMA)、敏感度(SE)、平均精度(AP)、特异性(SP)、骰子系数(DC)、曲线下面积(AUC)作为评估指标。

NTP、NTN、NFP、NFN、p、r、TPR、FPR、C分别表示真阳性、真阴性、假阳性、假阴性、精度、召回率、真阳性率、假阳性率,ISIC2019中皮肤癌病变的类别数。

2.4 结果与分析

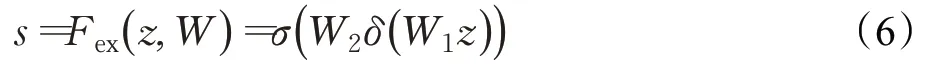

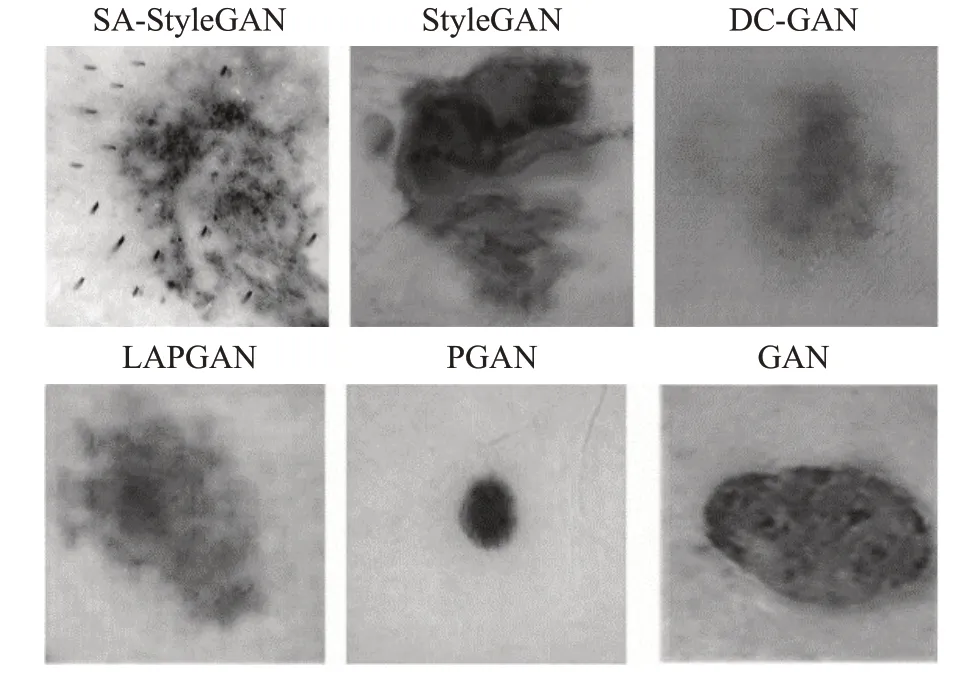

为了更好地验证本文的实验结果,使用SA-StyleGAN、StyleGAN[18]、PGAN[31]、DC-GAN[32]、LAPGAN[33]和GAN[34]分别生成1 000 了个皮肤癌病变图像,然后对样品进行20次评估。实验结果如表1和图10所示。

表1 各模型生成的皮肤癌病变图像性能指标对比Table 1 Comparison of performance indexes of skin cancer lesion images generated by each model

图10 不同对抗生成网络生成的样本图像Fig.10 Sample images generated by different generative adversarial networks

由表1可知,由SA-StyleGAN生成的皮肤癌样本图像的IS值(越高越好)最高,达到3.37。比其他五种方法的IS值分别高0.26、1.02、0.89、1.23、1.84,所提出方法的FID值(越低越好)最低,达到0.83,比其他五种方法分别低1.78、0.52、1.01、1.59、3.04。精确度和查全率的值都在0 到1 的范围内,接近1 的值表示良好的结果。与其他五个模型相比,SA-StyleGAN 在四个指标上得分最高,这表明SA-StyleGAN 生成的图像质量更高,且网络性能更出色。

图11显示了SA-StyleGAN生成的一些皮肤癌病变图像。

图11 SA-StyleGAN生成的皮肤癌病变图像Fig.11 Skin cancer lesion images generated by SA-StyleGAN

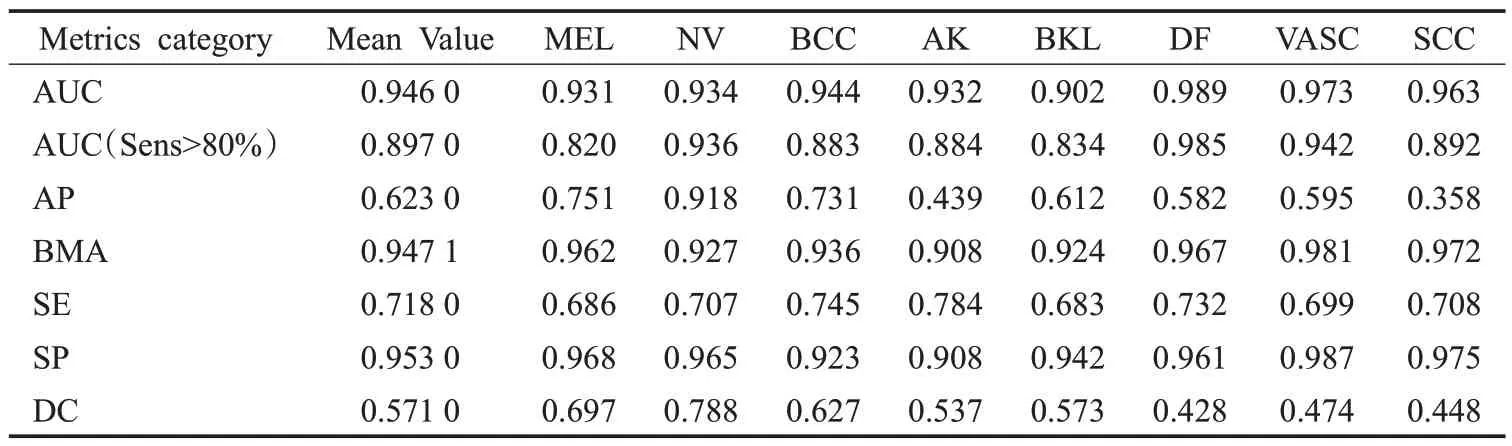

在经过100 个epoch 后,整个模型产生了良好的结果,测试损失达到最小,相应的测试BMA 为0.947 1。表2 显示了不同类型皮肤癌病变的BMA、AUC、AP、SE、SP、DC的结果。

表2 在ISIC2019数据集上的分类结果Table 2 Classification results in ISIC2019 test dataset

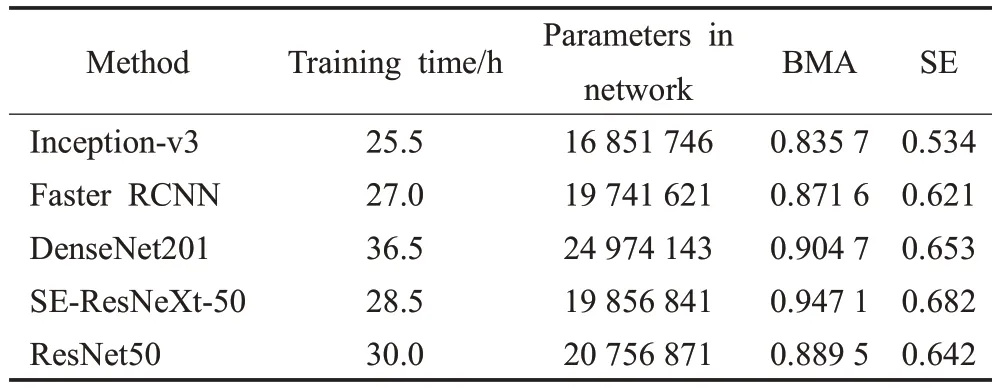

表3 显示了不同神经网络在ISIC2019 数据集分类时的参数以及训练时间和分类结果,可以看出本文使用的SE-ResNeXt-50在获得了最高精度的情况下,参数量较少且训练时间较短,在保证高精确分类结果的同时,也兼备了高效的运算效率。

表3 不同神经网络在ISIC2019数据集分类时的参数以及训练时间和分类结果Table 3 Classification results in ISIC2019 test dataset

混淆矩阵(也称为误差矩阵)是准确性评估的标准格式。皮肤癌病变分类模型输出分为八类,因此用8×8矩阵表示,图12显示了ISIC2019分类结果的混淆矩阵。

图12 分类结果的均值混淆矩阵Fig.12 Confusion matrix of average classification results

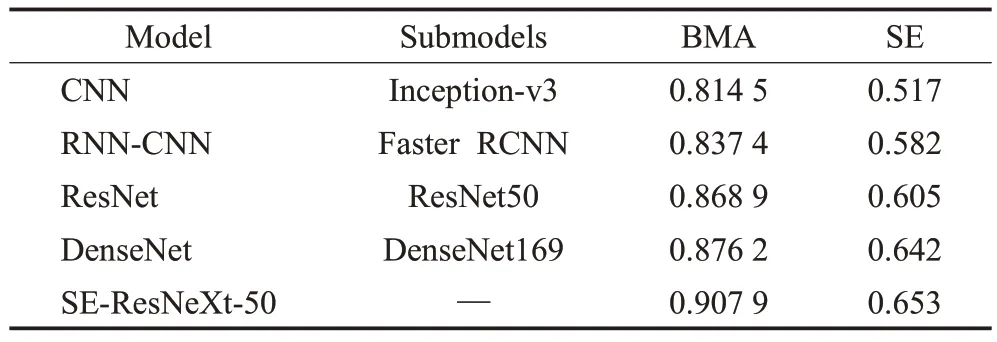

本文在不同的神经网络与数据集中对SA-StyleGAN进行了测试,测试的结果如表4~6所示。

表4 不同神经网络在ISIC2019数据集中分类的结果Table 4 Classification results of different neural networks in ISIC2019 data set

表5 在ISIC2019中使用SA-StyleGAN进行样本扩充后的分类结果Table 5 Classification results of using SA-StyleGAN for sample augmentation in ISIC2019

通过表4~6 可以看出,在ISIC2019 中,不同的神经网络在使用了本文提出的SA-StyleGAN 进行数据及样本扩充之后得到的分类结果比没有使用时的分类结果有显著的提升,CNN、RNN-CNN、ResNet、DenseNet、SE-ResNeXt-50 使用了SA-StyleGAN 的结果比没有使用的结果分别高2.12、3.42、2.06、2.12、3.92 个百分点。在ImageNet数据集中的分类结果表示,SA-StyleGAN在其他分类任务数据集中也可以得到很好的效果来辅助分类。

表6 在ImageNet中使用SA-StyleGAN进行样本扩充后的分类结果Table 6 Classification results of using SA-StyleGAN for sample augmentation in ImageNet

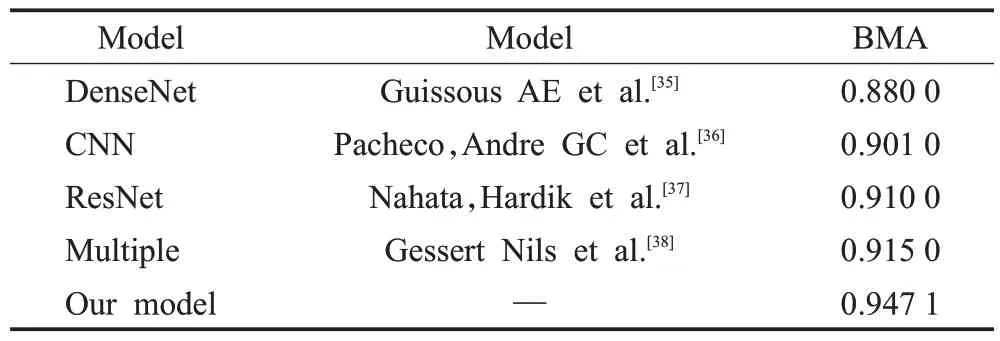

表7表明,本文方法的BMA比Guissous等[35]提出的DenseNet-Inception-v3高6.71个百分点,比Pacheco等[36]提出的基于CNN 的整体分类模型高4.61 个百分点,比Nahata等[37]提出的Inception-ResNet高3.71个百分点,比基于Gessert 等[38]提出的深度学习模型集合的分类模型高3.21个百分点。与现有研究相比,本文提出方法得到了更精确的分类BMA,且生成了高质量的皮肤癌病变样本图像。

表7 在ISIC2019数据集上本文方法与最新现有研究的结果对比Table 7 Comparison of results of proposed method with the latest existing research on ISIC2019 data set

在本文中,使用SE-ResNeXt-50解决了当神经网络层数增加时由反向传播引起的梯度消失。在引入角余量,归一化权重和零偏差之后,新损失函数在ISIC2019分类任务中实现了良好的分类精度。实现了最大的类内样本距离小于最小的类内样本距离的识别标准,减少了数据集内的类内不平衡的情况。使用SA-StyleGAN来生成高质量的皮肤癌病变图像并扩展ISIC2019 数据集,从而有效减少皮肤癌病变数据集样本类别内的样本失衡。迁移学习用于将ImageNet数据集的预训练加权参数迁移到SE-ResNeXt-50来处理ISIC2019数据集,从而提高了模型的学习效率和BMA的收敛速度。

当对模型进行测试和仿真时,有必要在发现难以区分的皮肤癌病变图像时将人工智能系统与皮肤科医生的临床经验相结合。计算机辅助诊断的意义在于良好的疗效和预后。它也可以协助医生进行临床病理判断和诊断。

3 结束语

本文提出了一种新的皮肤癌病变图像生成与分类框架,使用SA-StyleGAN来进行皮肤癌病变数据集样本扩充,解决了现有皮肤癌病变图像数据集各类样本数量、权重不均衡,图像不清晰且质量差的问题,为分类模型提供了高质量的训练样本图像。本文SA-StyleGAN在ISIC2019 皮肤癌病变数据集的实验生成样本图像的各项性能指标都显著优于现有的其他对抗生成网络。本文使用的SE-ResNeXt-50 分类模型可以更好地处理样本图像不同层次的图像信息,降低了神经网络分类任务的难度。本文的工作可以帮助皮肤科医生进行诊断,并为基于人工智能的皮肤镜图像分析提供有价值的参考。在未来的工作中,将致力于将本文的生成与分类框架用于其他样本数量不足且样本图像质量较差的疾病数据集,另一个重点将是进一步加强和改进自动分类系统。将致力于将该计算机辅助诊断系统移植到移动设备上,更好地为患者和皮肤科医生服务。