面向射频指纹识别的高效IQ卷积网络结构

崔天舒,黄永辉,沈 明,张 晔,崔 凯,赵文杰,安军社

(1. 中国科学院国家空间科学中心 复杂航天系统电子信息技术重点实验室, 北京 100190;2. 中国科学院大学 计算机科学与技术学院, 北京 100049; 3. 奥尔堡大学, 丹麦 奥尔堡 DK-9220)

当今社会无线网络无处不在,在日常生活与工业生产中的应用越来越广泛,尤其是随着物联网的发展,无线设备的数量呈现指数级增长,但无线网络在提供便利的同时,也在隐私性和安全性方面带来了巨大的挑战。例如,在低功耗广域网(low power wide area network, LPWAN)中,由于成本、功耗和带宽等的限制,终端向基站传输的数据往往是不加密或者弱加密的,这就留下了安全漏洞。

电子元器件以及印刷电路板在制造和使用过程中存在制造容差与漂移容差,容差效应导致即使是同一厂家同一型号同一系列甚至是同一批次的无线发射设备的实际硬件参数也会存在差异[1],进而导致每个发射机个体都有其独特特性,这一特性被称为射频指纹(radio frequency fingerprint, RFF)。射频指纹识别,是利用无线信号识别特定发射设备的方法,而信号指纹识别[2-4]和RF-DNA[5-7](RF distinct native attribute)等也可认为是与射频指纹识别不同名称的相同概念。射频指纹是无线设备的固有特征,很难被篡改,因此可通过射频指纹识别来确认无线设备身份,增强网络安全性。

此前,比较流行的射频指纹识别方法是基于人工特征提取的方法,先由本领域专家提取信号关键特征,如同相正交(in-phase and quadrature-phase, IQ)不均衡[8]、幅度误差[9-10]和相位误差[11-12]等时域信号特征,或者频域变换[5,13]、Hilbert变换[14-15]、小波变换[16-17]等域变换后再提取特征,然后采用机器学习方法进行分类。通常,需要选取几项甚至十几项特征,计算复杂度高,实际部署使用困难。同时,受通信协议的多样性与多径干扰效应的影响,该方式在特征选择和判决准则方面也缺乏普适性。

随着大数据和人工智能技术的发展,深度学习在图像识别[18-19]、语音识别[20-21]和自然语言处理与理解[22-23]等领域都取得了巨大的成功。射频指纹识别本质上也是一种模式识别,可以将深度学习与射频指纹识别技术深度融合,利用深度学习的方法,自动提取无线信号的模式特征,避免基于经验的人工特征提取,提高复杂电磁环境下发射机的身份识别能力。

在电磁信号识别领域,近年来采用卷积神经网络的方法越来越多。文献[24]提出了一种信噪比(signal noise ratio, SNR)自适应的兴趣区选择多分辨率卷积神经网络算法,在SNR=30 dB的视距条件下,对54台ZigBee设备的分类精度高达97%。文献[25]采用卷积神经网络对功放的非线性特征进行识别,实验结果表明,当信噪比大于20 dB时对7台通用软件无线电外设(universal software radio peripheral, USRP)设备的识别准确率能达到80%。文献[26]以原始IQ采样数据为输入,经过离散傅里叶变换(discrete Fourier transform, DFT)将时域数据变换为频域表达,再经过数据图像化处理,将连续多次DFT的结果组合成一张二维频谱瀑布图,然后再输入卷积神经网络,像图像识别一样进行分类识别,虽然将IQ数据转换成时频图像进行处理的可读性更强,但相对于直接采用卷积网络处理原始IQ采样数据,这种方法在预处理过程中增加了额外计算量。但目前即使是直接处理IQ采样数据的卷积网络[27-31],也存在信息利用率不高和计算量大等问题。

图1为采用IQCNet的射频指纹识别处理流程。面向射频指纹识别应用,本文提出了一种基于IQ相关特征的卷积神经网络结构:IQCNet,此网络以原始IQ信号为输入,首先提取信号的IQ相关特征,然后再提取时域特征,最后采用全局平均池化获得各通道特征均值进行分类,具有信息利用率高、参数数量少和计算量小的特点。

图1 射频指纹识别处理流程Fig.1 RF fingerprint identification processing flow

1 IQ卷积网络结构分析

在图像识别领域,网络输入数据格式是M×N,数据点间存在空间关系,具有各向同性的性质,2个维度间可进行相同操作。而在射频指纹识别领域,原始IQ采样数据格式为N×2,其中N对应信号的时间长度,2对应同相分量I与正交分量Q,两个维度不具备相同性质,无法进行图像处理一样的2维度对称操作,所以目前卷积神经网络对IQ信号的处理都是采用一维卷积提取时间维度特征[27-31],而忽略了IQ间相关特征,进而导致相位信息损失,降低了识别率。

在射频指纹识别领域,当前的卷积神经网络(convolutional neural networks, CNN)都是参照AlexNet[32]的设计:首先采用大滤波器组的卷积层(convolutional layer, Conv)来提取特征,多个卷积层间采用最大池化(max-pooling)来减小数据维度,然后采用数据压平(flatten)操作将多个通道的特征值重新组合为一维,最后采用多个全连接层(fully connected layer, FC)进行分类。网络采用线性整流函数(rectified linear unit, ReLU)作为激活函数,此外为了提高网络的泛化能力,在训练时,全连接层间采用随机失活(dropout)操作进行参数随机舍弃,从而避免出现过拟合现象。

图2展示了目前卷积神经网络在提取时域IQ信号特征时所采用的3种操作方式,其中(a)是文献[27]中基准卷积网络采用的方式,(b)是文献[28-29]中卷积网络采用的方式,(c)是文献[30-31]中卷积网络采用的方式。(a)先采用一维时域滤波器提取时域特征,然后再采用最大池化的方式在IQ方向进行降维,这种在I与Q中取最大值的操作会损失幅度以及相位信息;(b)先采用一维时域滤波器提取时域特征,然后采用Flatten的方式将数据展开,再进行分类,这种方式是在I与Q中提取相同的时域特征;(c)是直接采用二维滤波器,一次性直接提取时域与IQ相关特征,但是,这种操作只能在特征提取的最后一层进行,难以多层连续展开进行。

图2 卷积神经网络的3种提取特征方式示意Fig.2 3 feature extraction methods of CNN

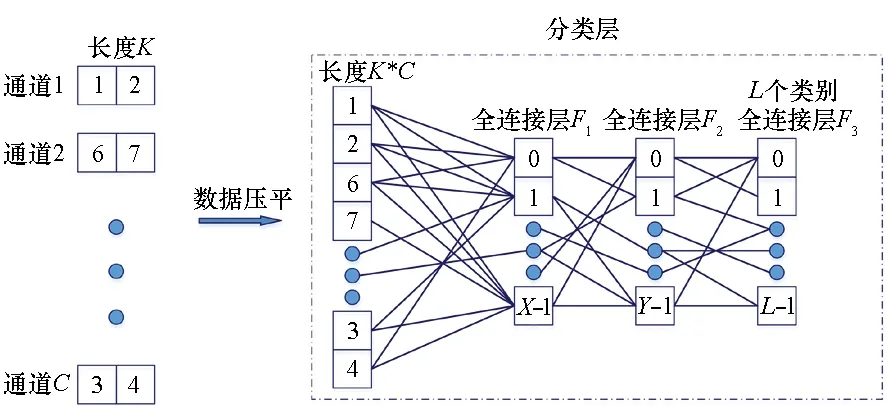

在分类判别阶段,如图3中所示,网络[27-31]都采用多个全连接层,虽然可以提高网络的分类能力,但存在网络参数众多和计算量大的问题。

图3 卷积神经网络分类层示意Fig.3 CNN classification layer

2 IQ卷积网络结构设计

2.1 IQCNet结构

如图4所示,输入数据是时间长度为N的IQ序列,输出为分类类别数量L。IQCNet首先将输入数据扩展为C个通道(卷积核),然后在每个通道内进行IQ相关特征与时域特征的提取,最后仅采用1个全连接层进行分类。

在特征提取层,将特征提取分为2步,分别在不同的维度上进行特征提取,首先采用一维IQ滤波器提取IQ相关特征,然后再使用多层一维时域滤波器提取时域特征,由于充分利用了时序IQ信号的IQ相关特征和时域特征,信息利用率更高,且由于第一个滤波器就完成了数据降维,后续时域滤波的计算量更小。具体实现为:在每个通道内部,第1个卷积层采用(1,2)的滤波器提取IQ相关特征,输出数据维度由N×2变为了N×1,后续处理的计算量降低了一半;然后借鉴VGG(visual geometry group)网络[33]采用多层(3,1)小滤波器提取时域特征,在保证感受野的条件下减少卷积核参数数量;接着,每2个时域滤波器后采用最大池化降低数据维度,减少时域方向计算量。

在分类阶段,借鉴ResNet网络[34]采用的自适应平均池化(adaptive average pooling)替代flatten,首先采用自适应平均池化操作,将每个特征通道的特征平均值作为新的特征值,提高网络的泛化性能;然后在分类时仅采用1个全连接层,以降低参数数量与计算量。具体实现为:首先使自适应平均池化的输出数量与通道数C一致,然后与类别数量L形成1个输入为C、输出为L的全连接层。

除此之外,在卷积层的输出与激活函数之间,添加批归一化(Batch Normalization, BN)[35]操作,以增加模型的鲁棒性和训练速度,并代替 dropout 防止过拟合;网络中采用ReLU作为激活函数,在分类层采用Sigmoid作为分类函数。

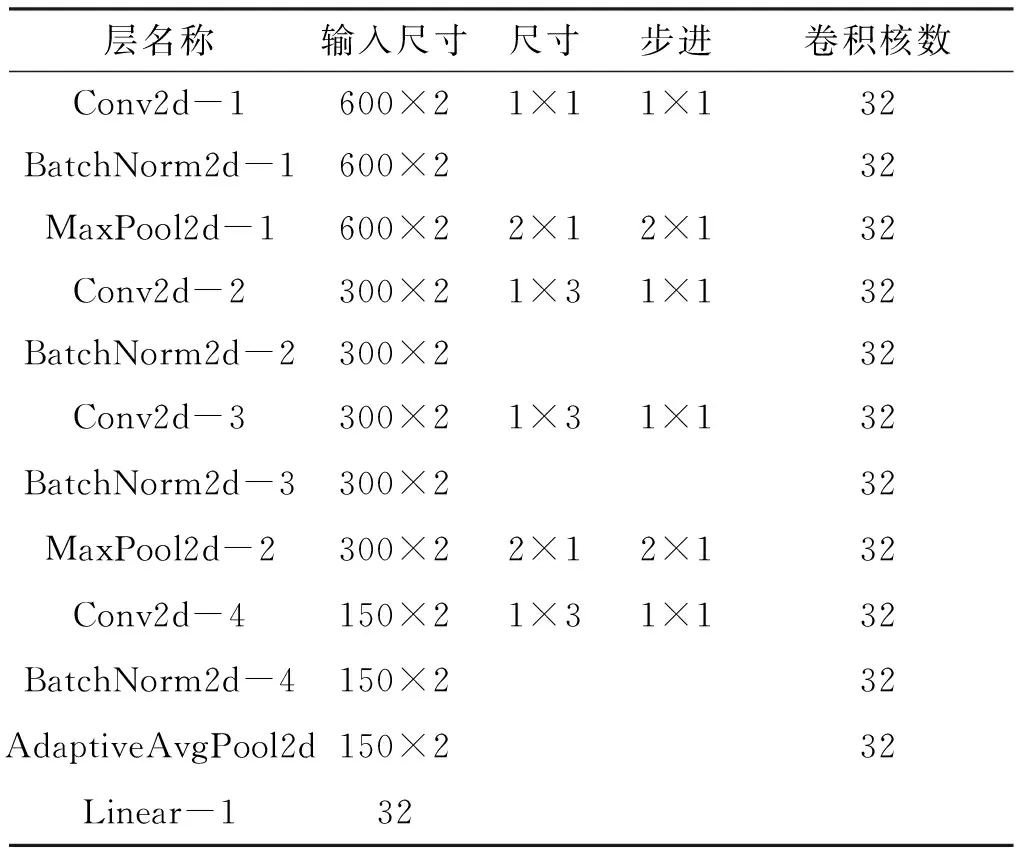

IQCNet网络结构参数是可灵活配置的。如图4所示,IQCNet网络由H个卷积层与1个全连接层构成,其中每个卷积层包含C个特征提取通道。为表示不同结构参数的IQCNet网络,本文用IQCNet(H,C,S)表示具体结构参数,H表示卷积层的层数,C表示每层卷积层的卷积核数量(通道数),S表示时域卷积核大小。如IQCNet(4,32,3)表示具有4个卷积层,且每层包含32个大小为(3,1)时域卷积核的 IQCNet网络,时域卷积核的大小为(3,1)。表1是IQCNet(4,32,3)的网络结构,其中数据输入格式为600×2。

图4 IQCNet网络结构示意Fig.4 IQCNet network structure diagram

表1 IQCNet(4,32,3)网络结构Tab.1 IQCNet(4,32,3) network structure

2.2 对比网络结构

为对比验证IQCNet中提取IQ相关特征是否能有效提高识别准确率,本文设计了除未提取IQ相关特征之外,网络其他部分与IQCNet完全相同的网络,并命名为IQCNet-N(H,C,S)。

将表1中的IQCNet-N(4,32,3)与表2中的IQCNet(4,32,3)对比发现,两者的差别仅在于IQCNet第一个卷积层采用了(1,2)的滤波器提取IQ相关特征,而IQCNet-N未做此处理。

表2 IQCNet-N(4,32,3)网络结构Tab.2 IQCNet-N(4,32,3) network structure

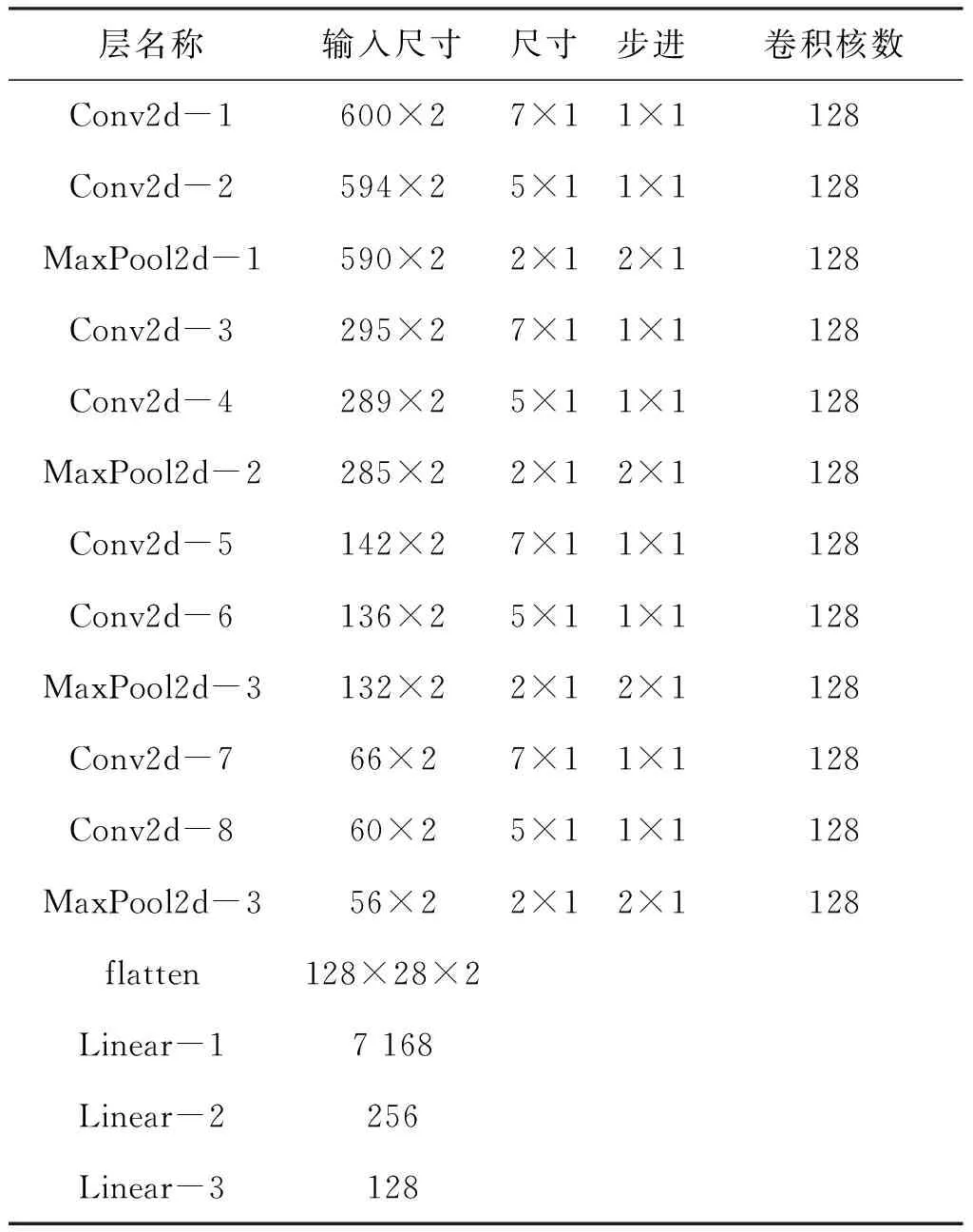

本文选取了网络深度、卷积核大小和通道数量不同的CNN-DRID[28]、CNN-DLRF[29]和CNN-ORACLE[31]3种CNN网络结构与IQCNet进行实验对比,表3、表4和表5是以上三者的网络结构。

表3 CNN-DRID网络结构Tab.3 CNN-DRID network structure

表4 CNN-DLRF网络结构Tab.4 CNN-DLRF network structure

从选取的3种典型卷积网络结构可以看出,CNN-ORACLE的特征提取层最少,只有2层;CNN-DLRF的特征提取层居中,有3层;而CNN-DRID的特征提取层最多,共8层。

表5 CNN-ORACLE网络结构Tab.5 CNN-ORACLE network structure

从卷积核大小角度观察,CNN-DRID使用了(19,1)的大卷积核,而其余二者使用了相对较小的(7,1)的卷积核。从卷积核数量上观察,CNN-DRID的卷积核最多,每层都使用了128个,CNN-ORACLE卷积核最少,只有50个,而CNN-DLRF卷积核数量居中,分别使用了128、32和16个。另外,3者都使用了3个全连接层进行分类。总体来看,CNN-DRID的模型最大,特征提取能力最强,CNN-DLRF模型居中,特征提取能力居中,而CNN-ORACLE模型最小,特征能力也最小。

3 实验验证

3.1 数据集

本文采用FIT/CorteXlab射频指纹识别数据集进行算法验证。该数据集由22台NI USRP N2932生成,其中21台用作发射设备,1台用作接收设备,通信频段为433 MHz,接收机采样速率为5 MSample/s,1台接收机采集了21台发射设备的无线信号用于射频指纹识别[36]。

数据集中,共有3种发送数据类型与2种功率模式。

3种发送数据类型分别为:①正交相移键控(quadrature phase shift keying, QPSK)调制固定数据序列,是经QPSK调制的固定数据,数据内容为IEEE 802.15.4前导头的位序列,以下称为固定包;②QPSK调制随机数据序列,为QPSK调制的随机数据,以下称为随机包;③未调制噪声序列,为未经调制的随机噪声比特,以下称为噪声包。

2类型功率模式为:普通模式,即所有发射机使用固定的功率,并且实验环境无干扰,此模式的传输信道最稳定。变幅度模式,也称为变功率模式,在发射设备位置不变的条件下,改变IQ信号的幅值,用于模拟发射机功率变化,其功率变化范围为20 dB。

由3种发送数据类型与2种功率模式组合成6种实验场景,分别为:固定功率发送固定包、固定功率发送随机包、固定功率发送噪声包、变功率发送固定包、变功率发送随机包和变功率发送噪声包。

实验控制21台发射设备分别周期性地发送信号,接收设备根据发送设备的编号记录并存储数据,发送周期为600个IQ数据点。

FIT/CorteXlab数据集原始文件由带发射机标签和实验条件说明的21个同相信号与21个正交信号文件组成的,且21个发射机的数据样本数量完全相同[37]。本文首先将42个文件处理为21个带标签的M×2格式的时间连续IQ信号数据,然后再转换为(M/N)×N×2的数据格式,文件格式化处理完毕后,每个场景下的数据包大小为5.2 G,当时间长度N为600时,数据样本数为1 091 175个。

3.2 评估方法

本文采用识别准确率对网络模型的泛化性能进行评估,对于分类问题,根据真实值和预测值的结果,可以将整个样本集分为真正例(TP)、伪正例(FP)、真反例(TN)和伪反例(FN),识别准确率Acc定义为:

Acc=(TP+TN)/(TP+TN+FP+FN)

(1)

性能评估采用多次随机实验求平均值的方法获得测试结果,如图5所示,首先从数据集中随机抽取样本,并划分训练样本、验证样本与测试样本,使用随机参数初始化网络模型后进行模型训练、验证与测试,将N次测试结果的平均值作为最终的测试结果,本文所有实验都进行3次随机测试。

图5 实验总体流程Fig.5 Overall experiment process

单次训练、验证与测试过程如图6所示,首先采用无放回随机采样的方式,将数据集按7 ∶1 ∶2的比例生成训练样本、验证样本与测试样本,然后对训练样本进行训练,每训练2个轮次进行1次验证,选取在验证样本中获得最高识别准确率的参数作为最终模型参数,然后对测试样本进行测试,获得模型识别准确率。本文实验发现,训练30个轮次后IQCNet与对比网络损失函数的loss不再下降,因此确定后文每次训练执行30个轮次。

图6 实验详细流程Fig.6 Detailed experiment process

3.3 实验条件

本文的实验条件:操作系统为Ubuntu 18.04.4 LTS,内存为64 GB,CPU为Intel i9-7920X CPU @ 2.90 GHz×24,GPU为NVIDIA GeForce RTX 2080Ti,cuda版本为10.1,编程语言为Python 3.7,深度学习框架为Pytorch 1.4.0。

训练数据的批处理大小为1 024,且每一批次的数据会随机打乱;损失函数采用交叉熵,优化器采用Adam优化器,初始的学习率为0.001,每5个轮次后衰减为原来的0.8倍,其余参数为Pytorch中的默认参数。

交叉熵损失函数定义如下:

(2)

在实验验证中,网络输入的时间长度N会采用256,600,512,1 024,2 048和4 096等数值,无特殊说明时,时间长度为600,与发送周期一致。

文中涉及的参数数量、存储量以及计算量等数据,采用Pytorch的torchstat库计算获得。

3.4 识别准确率

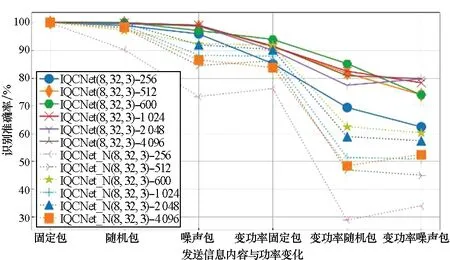

相对于其他网络结构,IQCNet的最大特点是将特征提取分为IQ相关特征与时域特征2步进行,为验证IQ相关特征是否有利于提高识别准确率,本文选取256,512,600,1 024,2 048和4 096等输入时间长度的数据对IQCNet(8,32,3)与IQCNet-N(8,32,3)进行比较验证。

如图7所示,在6种场景下,IQCNet与IQCNet-N在不同输入长度下表现出来的趋势是一致的,即:功率稳定条件下,网络对发射机的识别率比较高,而当功率变化时,网络对发射机的识别准确率都发生下降;而在3种发送包类型中,发送固定包时发射机个体更容易被识别。

从识别准确率来看,在不同场景与不同输入长度下,IQCNet的识别准确率都要比IQCNet-N要高,尤其是在变功率模式下。统计所有识别准确率平均值,IQCNet与IQCNet-N分别为90.39%和78.11%,前者比后者高12.28%,证明IQCNet提取IQ相关特征确实有利于提高识别准确率。

图7 IQ相关特征对识别准确率的影响Fig.7 Impact of IQ correlation features on recognition accuracy

图8展示了IQCNet网络中时域滤波器卷积核大小对识别准确率的影响。首先固定IQCNet网络的卷积深度与卷积核数量,然后比较时域滤波器中卷积核大小分别为(3,1)、(5,1)、(7,1)与(9,1)时的识别准确率。粗略来看,卷积核大小的变化对识别准确率影响不大,统计6种场景下的平均值,以上4者的平均准确率分别为91.67%、91.69%、91.03%和91.11%,相差不超过1%。但是,大卷积核会带来更多的模型参数与计算操作,以上模型的参数数量分别为22 773、37 109、51 445和65 781,执行一次计算需要的浮点计算量分别为3.52、5.58、7.49和9.27的操作,所以在时域特征提取时采用(3,1)的小卷积核是一种高性价比的选择。

图8 卷积核大小对识别准确率的影响Fig.8 Effect of convolution kernel size on recognition accuracy

图9展示了IQCNet网络中卷积层深度对识别准确率的影响。首先固定IQCNet网络中每层的卷积核数量与卷积核大小,然后比较网络深度分别为4、6、8和10时的识别准确率。粗略来看,增加卷积深度确实有利于提高识别准确率,统计6种场景下的平均值,以上4者的平均准确率分别为82.50%、88.95%、91.67%和92.41%,增加卷积深度明显提高了识别准确率。以上模型的模型参数分别为:10 229、16 501、22 773、29 045,浮点计算量分别为2.46、3.17、3.52、3.7的操作,模型参数与计算量也随卷积层深度的增加而增加。

图9 卷积层深度对识别准确率的影响Fig.9 Effect of convolutional layer depth on recognition accuracy

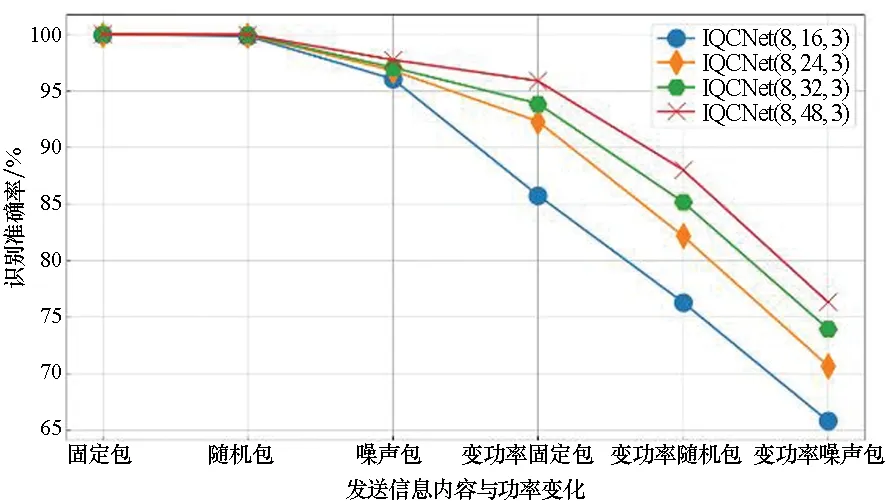

图10展示了IQCNet网络中卷积核数量对识别准确率的影响。首先固定IQCNet网络中卷积层深度与卷积核大小,然后比较卷积核数量分别为16、24、32和48时的识别准确率。粗略来看,增加卷积和数量有利于提高识别准确率,统计6种场景下的平均值,以上4者的平均准确率分别为87.29%、90.31%、91.67%和92.99%,增加卷积数量明显提高了识别准确率。以上模型的模型参数分别为:6 021、13 053、22 773、50 277,浮点计算量分别为0.926、2.02、3.52、7.9的操作,模型参数与计算量也随卷积核数量的增加而增加。

图10 卷积核数量对识别准确率的影响Fig.10 Influence of the number of convolution kernels on the recognition accuracy

图11展示了IQCNet网络中不同算子对识别准确率的影响。

图11 算子对识别准确率的影响Fig.11 Influence of operators on recognition accuracy

将IQCNet(8,32,3)网络中的自适应平均池化层替换为自适应最大池化层的网络称为IQCNet_AdpMaxP,在6种场景下其平均识别准确率为91.78%,比IQCNet(8,32,3)高0.11%,考虑到众多随机因素的影响,这点差距微不足道。可认为,对IQCNet网络而言,自适应最大池化与自适应平均池化是可替换使用的。

将IQCNet(8,32,3)网络中的最大池化层去掉的网络称为IQCNet_NoMaxP,在6种场景下其平均识别率为91.04%,虽然其网络参数与IQCNet(8,32,3)都为22 773个,但是浮点计算量为13.25是IQCNet(8,32,3)的3.76倍,说明IQCNet网络中的最大池化可以在不降低识别准确率的情况下大幅减少计算量。

在IQCNet(8,32,3)网络的基础上,在分类阶段增加2个每层32个神经元的全连接层,称为IQCNet_FC2,并且在训练时全连接层间增加随机失活率为50%的dropout防止过拟合,虽然其参数数量和浮点计算量分别为24 885与3.52,与IQCNet(8,32,3)相比增加不多,但在6种场景下其平均识别率仅为81.62%,比IQCNet(8,32,3)减少了整整10%,说明在IQCNet网络中仅使用1个全连接层是比较好的选择。

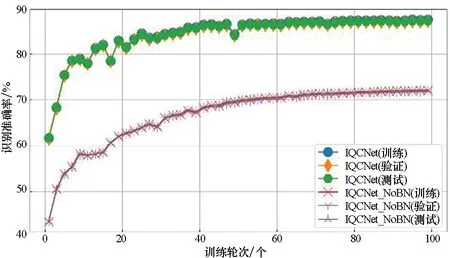

将IQCNet(8,32,3)中的批归一化操作去除的网络称为IQCNet_NoBN,在100个轮次的训练后,在6种场景其平均识别准确率仅为77.68%,比IQCNet(8,32,3)在30个轮次训练后的结果相比相差了14%。图12为在变功率固定包模型下,100个轮次训练过程中IQCNet(8,32,3)与IQCNet_NoBN分别在训练样本、验证样本与测试样本下的识别准确率,由图12可知,在整个训练过程中,批归一化都起到了加快收敛的作用,有利于提高模型的识别准确率。不过,批归一化会带来额外的计算量,在100个轮次的训练中,IQCNet(8,32,3)与IQCNet_NoBN的训练时间分别为9 390 s与7 200 s,可认为批归一化操作增加了30%的计算时间。

图12 批归一化对识别准确率的影响Fig.12 Effect of batch normalization on recognition accuracy

图13展示了IQCNet(8,32,3)与CNN-DRID、CNN-DLRF、CNN-ORACLE等对比网络在6种场景下的识别准确率,由此结果可知:

图13 IQCNet与对比网络识别准确率的比较Fig.13 Recognition accuracy comparison between IQCNet and contrast network

1)识别准确率会受发射机发送数据内容的影响。当发送固定数据内容时,不管发射功率是否变化,发射机个体都更容易被识别,所以提取固定数据内容(例如前导头)更有利于识别发射机身份。

2)功率变化会降低识别率,而且功率变化对固定包的影响相对较小,对随机包和噪声包影响更加明显。

3)IQCNet的识别准确率最高。在6种场景下,CNN-DRID、CNN-DLRF、CNN-ORACLE与IQCNet(8,32,3)的平均识别准确率分别为82.61%、72.09%、61.71%和91.67%,IQCNet(8,32,3)相对前3者的识别率高9.06%、19.58%和29.96%。

3.5 参数与计算量

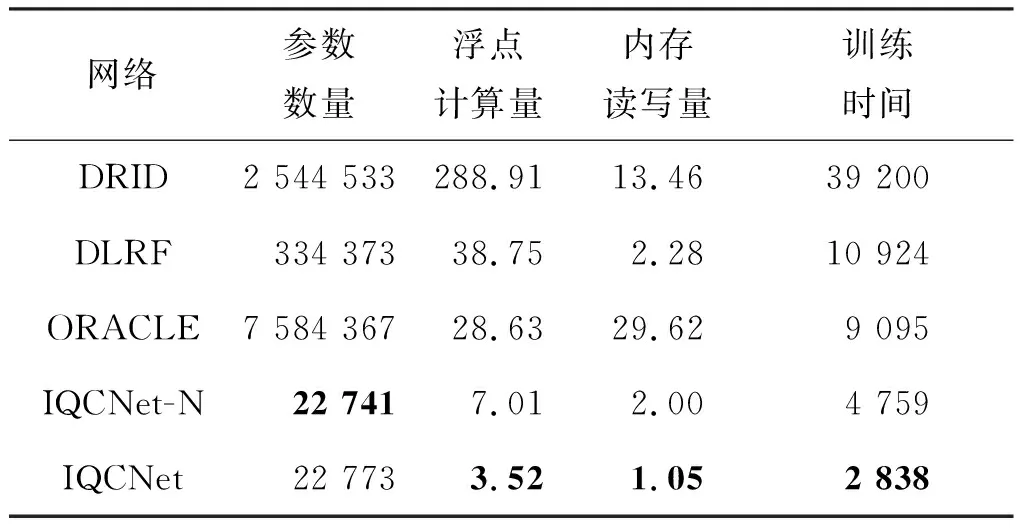

本文采用Pytorch的torchstat库计算网络结构的参数数量、存储量以及计算量,表6是IQCNet(8,32,3) 、IQCNet-N(8,32,3) 与CNN-DRID、CNN-DLRF、CNN-ORACLE参数数量、存储量以及计算量等信息。

表6 网络模型参数及计算量Tab.6 Network model parameters and calculations

在参数数量方面,CNN-DRID、 CNN-DLRF、CNN-ORACLE和IQCNet-N(8,32,3) 的参数量大约分别为IQCNet(8,32,3)的111倍、14倍、333倍和1倍,所以在参数数量方面IQCNet(8,32,3)有非常明显的优势。

在计算量操作方面,CNN-DRID、 CNN-DLRF、CNN-ORACLE和IQCNet-N(8,32,3) 的浮点计算量大约分别为IQCNet(8,32,3)的82倍、11倍、8倍和2倍,所以IQCNet(8,32,3)在计算量方面也具有非常明显的优势。

在存储量方面,CNN-DRID、 CNN-DLRF、CNN-ORACLE和IQCNet-N(8,32,3) 的内存读写使用量大约分别为IQCNet(8,32,3)的13倍、2倍、28倍和2倍,IQCNet(8,32,3)在存储量方面优势同样明显。

在训练时间方面,使用NVIDIA RTX2080Ti GPU平台,在6个场景共31.2 GB数据训练30个轮次,CNN-DRID、 CNN-DLRF、CNN-ORACLE和IQCNet-N(8,32,3)的总时间分别为IQCNet(8,32,3)的14倍、4倍、3倍和2倍,IQCNet(8,32,3)在计算时间方面具有明显的优势。

所以,IQCNet(8,32,3)在参数数量、计算量和存储量以及计算时间等4个方面,相对于CNN-DRID、 CNN-DLRF、CNN-ORACLE和IQCNet-N(8,32,3)都具有明显的优势。

4 结论

本文针对射频指纹识别的应用,对直接处理时序IQ信号的端到端卷积神经网络结构进行了研究。

首先,对当前处理时序IQ信号的几种典型卷积神经网络操作进行了分析,指出了其存在信息利用率低和计算量大等不足,进而提出了基于IQ相关特征的卷积神经网络结构:IQCNet,通过分步提取IQ域和时域等不同维度的特征、多层小滤波器组合和自适应平均池化等手段,以解决以上问题。

然后,本文在FIT/CorteXlab射频指纹识别数据集下,采用多次随机试验对网络的泛化性能进行评估。实验结果表明:在发送内容与功率变化的6种场景下,本文提出的IQCNet相较于未利用IQ相关特征的IQCNet-N平均识别准确率至少提高了12%,而计算量、内存使用量和计算时间仅为后者的50%,说明提取IQ相关特征既能提高识别准确率,又有利于提高计算效率。此外,本文还对IQCNet结构中网络深度、卷积核大小与数量,以及批归一化、最大池化层等算子的作用进行了验证,进一步证明了IQCNet采用的算子的有效性。

最后,采用CNN-DRID、CNN-DLRF和CNN-ORACLE等3种卷积网络结构与IQCNet进行比较,相对于前3者,IQCNet的平均识别率总体提高近20%,而仅使用了7.5%的计算量与19%的存储量,证明IQCNet网络识别准确率更高,而对存储与计算资源的要求更低,是一种高效的IQ卷积网络结构。