融合多模板与位置增强模型的目标跟踪算法

陈诗欣 陈子峰 李瑞珠

摘要:由于现有跟踪算法仅依据初始帧模板进行跟踪,跟踪过程中模板不更新导致跟踪漂移的问题。文章提出一种融合多模板与位置增强模型的目标跟踪算法,构建UPRnet神经网络对目标各阶段外观特征模板做融合,并借助相关滤波器DCF对目标位置作增强,从而实现对当前帧中目标的更准确跟踪。在标准数据集上进行的实验结果表明,提出的方法在运动目标外观发生变化时,相比于其他算法能够取得更优异的跟踪性能。

关键词:目标跟踪;孪生网络;在线更新;模板融合;位置增强

中图分类号:TP18 文献标识码:A

文章编号:1009-3044(2022)27-0021-03

开放科学(资源服务)标识码(OSID):

视觉目标跟踪作为计算机视觉的重要部分,被广泛应用于自动驾驶、智能交通监控、人机交互等领域。在跟踪过程中,运动目标会发生位姿变化、背景变化、被遮挡等情形,时常导致跟踪丢失。虽然近年来目标跟踪方法获得突破性进展,但仍未有成熟稳定、鲁棒性强的目标跟踪器。

目标跟踪算法[1-3]一般由特征提取、搜索策略和模型观测等模块组成。传统的跟踪算法在特征提取阶段主要采取方向梯度直方图、颜色特征提取等方法,但这些方法提取到的特征信息不完整,且存在噪声,容易导致跟踪准确度降低。

近几年,卷积神经网络被广泛应用于视觉目标跟踪算法。Bertinetto等[4]提出了一种基于全卷积孪生网络跟踪算法(Fully-Convolutional Siamese Networks, SiamFC)。该算法通过相关操作计算候选区域与初始帧模板区域的相似度来预测目标在当前帧的位置区域。SiamFC在跟踪过程中不对网络参数进行更新,因此其实时性较高。Li[5]等人基于SiamFC的基础上提出了SiamRPN算法,通过加入区域生成网络(Region Proposal Network,RPN)模块来控制候选区域的尺度大小,从而达到更高的跟踪精度。虽然这些跟踪方法取得了不错的效果,但由于使用固定不变的模板进行跟踪,在目标发生旋转、形变和运动模糊等外观变化时会出现模板匹配出错情况,从而导致跟踪失败。

本文针对SiamRPN算法在跟踪过程中模板更新问题,提出了一种融合上下文时空信息的目标跟踪算法。该算法在特征级上建立模板库,存储目标不同形态下的外观信息,并融合上下文目标的时空信息得到更准确的目标位置。在标准数据集上进行的实验结果表明,提出的方法在运动目标外观发生变化时,相比于其他算法能够取得更优异的跟踪性能。

1 多模板更新与位置增强网络UPRnet构建

构建UPRnet(Update and Position Reinforcement Net)神经网络对目标各阶段外观特征模板做融合,并借助相关滤波器DCF对目标位置作增强,从而实现对当前帧中目标的更准确跟踪。

1.1目标外观特征增强模型

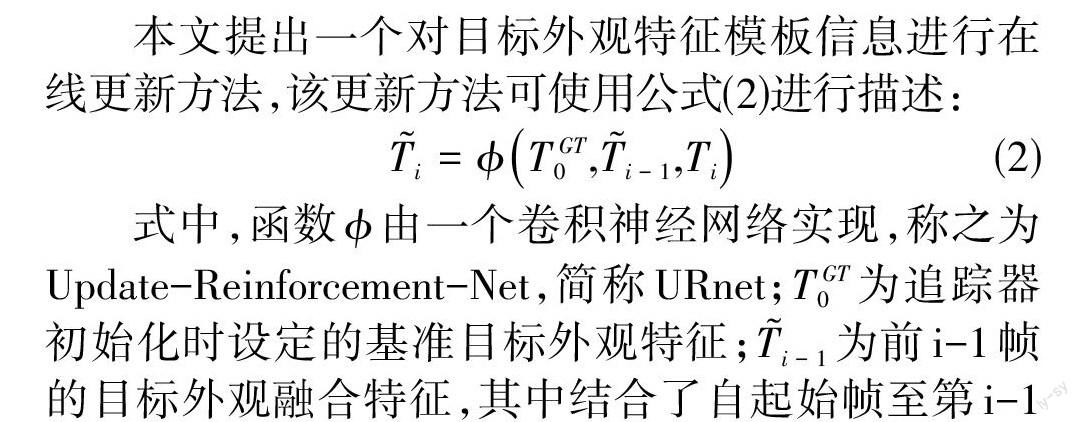

本文提出一个对目标外观特征模板信息进行在线更新方法,该更新方法可使用公式(2)进行描述:

[Ti=?TGT0,Ti-1,Ti] (2)

式中,函数[?]由一个卷积神经网络实现,称之为Update-Reinforcement-Net,简称URnet;[TGT0]为追踪器初始化时设定的基准目标外观特征;[Ti-1]为前i-1帧的目标外观融合特征,其中结合了自起始帧至第i-1帧中目标所有的外观特征;[Ti]为第i帧目标外观特征,由追踪器预测目标在第i帧位置,并对该位置区域范围内的彩色图像进行特征提取得到。该方法通过融合当前帧目标外观特征[Ti]的信息到前一时刻外观融合特征[Ti-1]中,实现对目标外观特征模板的更新。

URnet整体结构如图1所示,在更新上一时刻的融合模板[Ti-1]时,不但会响应目标在当前帧的外观特征[Ti]与融合外观[Ti-1]的不同而产生的更新请求,而且在每一次刷新融合外观模板[Ti-1]时,也充分考虑到基准外观特征[TGT0]信息,因此模板所包含的信息既兼顾了可靠性,也具有更强的鲁棒性。

1.2 目标位置增强模型

虽然 URnet输出一个充分表达的目标外观特征,但是它有时对于一些极为相似的目标仍然不能做到很好的区别,导致跟踪过程中鲁棒性有所下降。针对提升目标定位鲁棒性这一需求,判别相关滤波器DCF(Discrimination Correlation Filters)的性能表现出色。该方法以几何约束模型的方式来表示目标, 有高效的算法[6-8]已被开发去适应目标的特征差异变化,当目标外观出现一定形变时,仍然能够可靠地跟踪目标。

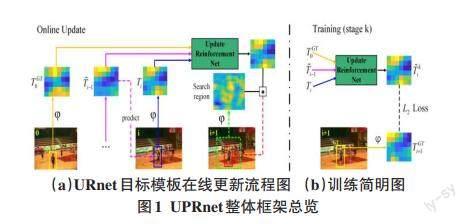

因此,笔者采用了深度DCF公式[9]在本目标位置增强模型中,并称该模型为 Position-Reinforcement-Net,简称为PRnet,其结构如图2所示。为了适配前述公式,对从骨干网络输出的特征图使用1×1卷积核的卷积层降维至64通道。降维后的特征图与64通道的DCF做互相关操作经由PeLU非线性激活层激活得到目标位置响应图,在相关操作所得的响应图中,具有最大数值区域将被视为目标最有可能存在的区域。

随后,该响应图与搜索区域的特征图作叠加操作并由1×1卷积核完成对搜索区域的特征增强。前述的DCF滤波器由一个极高效的反向传播公式进行优化。

2 融合UPRnet的SiamURN跟踪器

本文使用Update-Reinforcement-Net与Position-Reinforcement-Net 组成UPPRnet,与SiamRPN++跟踪器相结合成SiamUPRN跟踪器,能够取得更好的跟踪效果。

SiamUPRN跟踪器网络整体结构如图3所示,通过引入UPRnet实时对目标模板进行更新; 同时PRnet提升目标位置分辨效果,达到总体上跟踪效果的提升。

由于SiamUPRN总计有3个SiameseRPN模块,每一个模块对来自骨干网络不同深度的外观特征进行处理,因此对每一个SiameseRPN模块均前置设置一对UPRnet更新器,来对目标外观特征进行特征融合以及对搜索区域目标位置进行增强。

每对UPRnet模块中的张量流图如图3右所示,其中[Ti]每一次输出后均会被保存下来,并作为下一次更新操作中的[Ti-1]输入;特别地,在跟踪器进行初始化时,即跟踪过程中的第一帧,会先使用骨干网络处理目标基准信息,并保存为[TGT0],同时[Ti],[Ti-1]与[TGT0]三者保持一致。

3 实验分析

为了验证本文提出的算法性能,使用常用数据集VOT2018[10]和LaSOT[11]对算法性能进行验证,参与对比算法为开源代码或根据原文复现得到,并在同一硬件平台上进行性能对比。

本文在两个标志性的跟踪评价基准上验证FusionNet的训练结果,分别是:VOT2018[10]和LaSOT[11]。

3.1 跟踪指标以及跟踪速度

在本节中,笔者评估SiamUPRN跟踪器的综合性能,并与其他跟踪器作对比,包括SiamRPN++,以及同时期的SOTA跟踪器,包括DRT [12]、DeepSTRCF [13]、LSART [14]、R_MCPF [15]、SRCT [16]、CSRDCF [17]、LADCF [18]、MFT [19]、UPDT [20]和ATOM [21]等。

图4中,竖轴为VOT2018 的评判基准EAO;横轴为跟踪速度,在对数坐标轴尺度上,是跟踪器一秒能处理的帧数(Frames Per Second (FPS)),该指标由跟踪器运行在一块NVIDIA TITIAN X GPU上测得。

笔者通过将SiamUPRN与SiamRPN++及其他目前高水平的方法作比较,得出结果是URNet确实为SiamRPN++跟踪器带来性能提升,且未影响其跟踪的实时性。

对于性能,在图5中,对跟踪器性能作出了降序排序,可以看出本文提出的方法让SiamRPN++跟踪器性能表现更为出色。具体数值上,对比SiamRPN++跟踪器与集成了UPRNet的SiamUPRN跟踪器在EAO上的差别,后者相对前者取得了5.26%的性能提升。

对于实时性,观察图4,可以看出本文提出的方法并未影响SiamRPN++跟踪器的跟踪实时性,SiamUPRN在测试时运行帧数为31 FPS。

3.2 LaSOT数据集测试评估

本文也在LaSOT数据集上测试了本文提出的模型,因其中包含长期序列。而在长期跟踪中,更新器的性能对于跟踪器表现来说是极其重要的,因为在跟踪过程中,目标外观可能会出现突然变化,并且目标外观也可能与最开始跟踪的时候不同。

在图6中,依据官方的算法,验证了多个跟踪器的性能,并展示了性能表现前10的跟踪器,包括本文提出的SiamUPRN以及SiamRPN++[9]、MDNet[22]、VITAL [23]、 Struct-Siam [24]、DSiam[25]、 SINT [26]、STRCF [13]、ECO [7]和SiamFC [4]。通過图中数据可以看出,UPRNet增强了SiamRPN++的跟踪能力,在跟踪准确度与精确度上对比SiamRPN++均有一定的增强。同时在该数据集上,SiamUPRN超越了所有其余参与测试的跟踪器。这进一步验证了SiamUPRN的先进性,让目标跟踪定位更准确。

4 结论

针对没有使用任何更新策略更新其目标模板的跟踪器,以深度学习的方式把更新步骤作为一个优化问题。设计UPRnet网络,对目标外观模板以及位置做增强。将UPRnet网络融合到孪生网络中形成SiamUPRN跟踪方法,在两个数据集VOT2018 和LaSOT上均显示出优异的跟踪性能。

参考文献:

[1] Liu L W,Xing J L,Ai H Z,et al.Hand posture recognition using finger geometric feature[C]//Proceedings of the 21st International Conference on Pattern Recognition (ICPR2012).Tsukuba,Japan.IEEE,2012:565-568.

[2] Emami A, Dadgostar F, Bigdeli A,et al. Role of spatiotemporal oriented energy features for robust visual tracking in video surveillance. In 2012 IEEE Ninth International Conference on Advanced Video and Signal-Based Surveillance. IEEE, 2012: 349-354.

[3] Renoust B,Le D D,Satoh S.Visual analytics of political networks from face-tracking of news video[J].IEEE Transactions on Multimedia,2016,18(11):2184-2195.

[4] Bertinetto L,Valmadre J,Henriques J F,et al.Fully-convolutional Siamese networks for object tracking[C]//Computer Vision – ECCV 2016 Workshops,2016:850-865.

[5] Li B,Yan J J,Wu W,et al.High performance visual tracking with Siamese region proposal network[J].2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition,2018:8971-8980.

[6] Bolme D S,Beveridge J R,Draper B A,et al.Visual object tracking using adaptive correlation filters[J].2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition,2010:2544-2550.

[7] Danelljan M,Bhat G,Khan F S,et al.ECO:efficient convolution operators for tracking[J].2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR),2017:6931-6939.

[8] Guo Q,Feng W,Zhou C,et al.Learning dynamic Siamese network for visual object tracking[J].2017 IEEE International Conference on Computer Vision (ICCV),2017:1781-1789.

[9] Li B,Wu W,Wang Q,et al.SiamRPN++:evolution of Siamese visual tracking with very deep networks[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Long Beach,CA,USA.IEEE,2019:4277-4286.

[10] Kristan M, Pflugfelder R, Leonardis A, et al.The Visual Object Tracking VOT2014 Challenge Results[C]// ECCV, 2014.

[11] Fan H, Lin L, Yang F, et al. Lasot: A high-quality benchmark for large-scale single object tracking[C]//Proceedings of the IEEE conference on computer vision and pattern recognition,2019: 5374-5383.

[12] Yan.SiamRPN++: Evolution of Siamese visual tracking with very deep networks[EB\OL].[2021-03-15]. Available: http://arxiv.org/abs/1812.11703.

[13] Fan H,Ling H B.Siamese cascaded region proposal networks for real-time visual tracking[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).Long Beach,CA,USA.IEEE,2019:7944-7953.

[14] Wu Y,Lim J,Yang M H. Online object tracking: a benchmark[C]//in Proc. of IEEE Conference on Computer Vision and Pattern Recognition,2013:241-245.

[15] Sun C,Wang D,Lu H C,et al.Correlation tracking via joint discrimination and reliability learning[J], In CVPR, 2018.

[16] Li F,Tian C,Zuo W,et al.Learning spatial-temporal regularized correlation filters for visual tracking[J]. In CVPR, 2018

[17] Sun C,Lu H C,Yang M H.Learning spatial-aware regressions for visual tracking[J]. In CVPR, 2018.

(下轉第32页)

(上接第23页)

[18] Tianzhu Zhang, Changsheng Xu, Ming-Hsuan Yang.Learning Multi-task Correlation Particle Filters for Visual Tracking[J].IEEE Transactions on Pattern Analysis and Machine Intelligence (TPAMI), 2019,41(2): 365-378.

[19] Lee H,Kim D.Salient region-based online object tracking[C]//2018 IEEE Winter Conference on Applications of Computer Vision (WACV).March 12-15,2018.Lake Tahoe,NV.IEEE,2018.

[20] Lukezic A,Vojir T,Zajc L C,et al.Discriminative correlation filter with channel and spatial reliability[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).July 21-26,2017.Honolulu,HI.IEEE,2017.

[21] Tianyang Xu, Zhenhua Feng, Xiao-Jun Wu.Adaptive Channel Selection for Robust Visual Object Tracking with Discriminative Correlation Filters[J].International Journal of Computer Vision, 2021,129(5):1359-1375.

[22] Matej K, Ales L, Jiri M, et al. The sixth visual object tracking vot 2018 challenge results. ECCV workshop,2018:2-8.

[23] Bhat G,Johnander J,Danelljan M,et al.Unveiling the power of deep tracking[J]. In ECCV, 2018.

[24] Danelljan M,Bhat G,Khan F,et al.ATOM:accurate tracking by overlap maximization[J].In CVPR,2018

[25] Nam H,Han B.Learning multi-domain convolutional neural networks for visual tracking[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition.Las Vegas,NV,USA.IEEE,2016:4293-4302.

[26] Song Y B,Ma C,Wu X H,et al.VITAL:VIsual tracking via adversarial learning[J]. In CVPR, 2018.

【通聯编辑:唐一东】