多残差联合学习的水下图像增强

陈龙,丁丹丹

杭州师范大学信息科学与工程学院,杭州 311121

0 引 言

随着海洋发展越来越受关注,水下机器人也已广泛应用于海底生物资源的勘探等。海水中悬浮的颗粒会吸收和散射光,不同波长的光在海水中发生衰减的程度不同,使得水下机器人拍摄的图像呈现对比度低、偏色等问题,严重影响了机器人所拍摄的水下图像的质量。因此,有必要对这些失真的图像进行增强,得到清晰、逼真的图像,以便于后续分类、识别和分割等任务的展开。

目前常用的水下图像增强方法可以归纳为3类:基于非物理模型、基于物理模型以及基于深度学习的方法。基于非物理模型的方法直接对图像像素值进行处理,不考虑水下图像退化的物理过程。这种类型的方法无需明确建模图像形成过程,即可在空域或频域中直接调整给定图像的像素值。空域方法包括直方图均衡(Hummel,1977)、对象色彩感知的空间处理模型(Buchsbaum,1980)、限制对比度自适应直方图均衡(histogram equalization, HE)(contrast limited adaptive histogram equalization,CLAHE)(Pizer等,1990)、自动白平衡(Liu等,1995)、无监督色彩校正(unsupervised colour correction method, UCM)(Iqbal等,2010)以及融合增强水下图像(Ancuti等,2012)等方法。频域方法通过频域变换,例如小波变换(Singh等,2015)和傅里叶变换等,将图像像素映射到频域,该方法通常利用物理属性对图像进行调整。采用空域和频域方法对水下图像进行增强,传统的图像增强方法在一定程度上可以消除图像模糊、增强边缘等,但这类方法仅仅通过单一的图像处理手段来提高水下图像质量,通过调整图像的像素值来改善视觉质量,但并没有考虑到水下图像退化的物理过程,所达到的效果有限,仍存在噪声大、清晰度较低和颜色失真等问题,因此还需要进一步加强和完善。

考虑到以上缺陷,学者们进一步提出了基于物理模型的方法,核心思想是针对水下图像退化过程构建数学成像模型,根据观测结果和各种先验假设估算成像模型的参数,从而推演出理想状态下未经退化的图像。这种类型的方法通常遵循3个步骤:1)建立退化的水下成像模型;2)估算水下成像模型参数;3)解决逆问题,获得理想状态下未退化的图像。McGlamery(1980)提出了水下成像系统计算模型;Jaffe(1990)对水下成像系统进行了优化;基于成像模型,Nicholas等人(2010)提出了一种用于消除水下图像中光散射影响的方法。He等人(2011)提出了暗通道先验(dark channel prior,DCP)方法用于单图像去雾。但是,水下图像比空中雾霾图像具有更多的前向散射和可见光的选择性吸收与衰减。另外,水下图像通常还具有颜色偏差,比空中图像更模糊等特点。因此,将图像去雾方法应用于水下图像恢复通常是不充分的。Wen等人(2013)推导了一个新的水下光学模型NOM(new optical model)来描述真实物理过程中水下图像的形成,用于增强单幅水下图像;Lu等人(2015)提出了一种基于光谱特征的色彩校正方法来恢复失真的色彩;Galdran等人(2015)基于光在水中呈指数衰减,并且不同波长的光具有不同衰减率的事实,考虑到红光具有最快的衰减,提出了一种红通道方法;Drews等人(2016)又基于水下图像中红色通道的信息不可靠这一事实,提出了水下暗通道先验方法(underwater dark channel prior, UDCP);Li等人(2016a,b,c)先后提出了基于最小信息丢失原理、直方图分布先验以及蓝绿色通道去雾和红色通道校正等3种方法来实现单张水下图像恢复;Peng和Cosman(2017)提出了一种基于图像模糊和光吸收(image blurriness and light absorption, IBLA)的水下场景深度估计方法用于增强水下图像;Berman等人(2017)通过蓝红色和蓝绿色通道的衰减率两个全局参数,将水下图像恢复问题简化为单幅图像去雾问题;Liu等人(2019)设计了用于去雾的聚合传播网络(data-and-prior-aggregated transmission network, DPATN);Song等人(2018)针对水下图像提出了一种基于水下光衰减先验(underwater light attenuation prior, ULAP)的快速有效的景深估计模型,并使用基于学习的线性回归训练模型系数,使用正确的深度图估算RGB光的背景光和透射图,以准确还原水下图像;Yu等人(2019)提出了基于红色通道的图像恢复方法,针对红色通道在水中的衰减特性,引入红蓝色与红绿色通道的衰减比来恢复图像;汤新雨等人(2020)提出了基于透射率修正的湍流模型与动态调整Retinex的水下图像增强方法;Bekerman等人(2020)对水下光学特性进行了研究,并与Berman(2021)共同采集了不同位置拍摄的57幅图像的数据集,以推进水下图像增强的研究。以上方法都需要对水下图像的退化过程构建数学模型,并估算出模型参数信息。非物理模型方法对在空气中拍摄的图像具有良好的效果,但是这些方法忽略了水下图像的特定光学特性,当将它们应用于水下图像时很容易导致颜色偏差。基于物理模型的方法考虑了水下图像的光学特性,但通常依赖于环境假设和专业的物理先验知识,因此有很大的局限性;模型参数的估计方法很难针对不同的水下情况进行概括,缺乏较强的泛化性与普适性。

得益于深度神经网络的发展,一些学者将学习的方法应用于图像质量增强领域。Chen等人(2020)提出了基于滤波和生成对抗网络的恢复方案,在傅里叶域中还原水下图像,并进一步使用生成对抗网络改善图像质量;Li等人(2018)设计了WaterGAN,该网络由深度估计模块和颜色校正模块组成,使用无监督学习方法根据空中图像和深度配对生成真实的水下图像,用于水下图像的色彩校正;Anwar等人(2018)提出了一种基于水下场景的水下图像质量增强方法,分别输入不同场景的水下图像,生成适用于不同场景下的图像增强模型;Wang等人(2021)提出了一种无监督的水下生成对抗网络(underwater GAN, UWGAN),基于改进的水下成像模型从空中图像和深度图对合成逼真的水下图像(具有颜色失真和雾度效果),基于合成的水下数据集使用端到端网络直接重建水下清晰图像;Yang和Lu(2019)提出基于CGAN(condition generative adversarial network)应用多尺度生成网络和双重鉴别网络来解决水下图像失真问题。上述基于学习的方法取得了比传统方法更好的效果,但它们均是基于单分支网络对水下图像进行增强,输入均为单幅图像,无法对多个退化特征进行有效增强。另外,对于较深场景下的水下图像,上述方法的增强效果有所欠缺。也有一些方法借助水下图像的深度图来增强图像,但是水下图像的深度图较难获得,因此这类方法有一定的局限性。

受上述工作的启发,本文提出了一种基于多残差联合学习的水下图像增强方法,结合传统方法进行预处理,再通过多分支卷积神经网络进行特征提取,最后将多分支的特征进行融合,得到普适性高的水下图像增强模型。本文方法的特点是:1)提出了一种新的双层并行卷积神经网络(convolutional neural network, CNN)模型,该网络包含预处理、特征提取与特征融合3个模块,通过多次使用通道注意模块、密集级联和残差学习等方法,能够提取更多图像细节并加强有用特征;2)通过设计结合内容感知、均方误差、梯度和结构相似性(structural similarity, SSIM)的联合损失函数,使用端到端编码网络,在保持原始结构和纹理的同时直接重建清晰图像,不依赖于专业物理先验知识和水下成像模型;3)实验结果表明,通过客观与主观评价两方面的对比,本文方法在客观指标上超越了对比方法,在主观质量方面,水下图像的对比度显著提高,能够产生颜色丰富、偏色更少且清晰度高的增强图像。

1 相关工作

1.1 通道注意力机制

注意力机制是神经网络研究中的一个重要的研究领域,可以视为将可用的处理资源分配偏向于输入数据中信息最丰富的部分。现已广泛应用于自然语言处理、计算机视觉等人工智能相关领域。

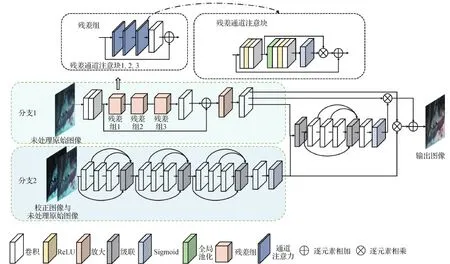

卷积神经网络建立在卷积运算的基础上,该运算通过在局部接受域内将空间和通道信息融合在一起来提取信息特征。为了增强网络的表示能力,Hu等人(2018)提出了通道注意力机制,对通道间的依赖关系进行建模,以对特征进行逐通道调整,这样网络就可以学习通过全局信息来有选择性地加强包含有用信息的特征。通道注意力机制示意图如图1所示(图中,⊗表示逐元素相乘)。Zhang等人(2018)提出了深度残差通道注意网络,考虑通道之间的相互依赖性,以实现图像的超分辨率;Yang和Lu(2019)将通道注意模块嵌入多尺度增强网络,实现图像的去雨效果;You等人(2019)采用将通道注意模块嵌入到卷积块中以增强CycleGAN(cycle generative adversarial network),解决了图像纹理和细节退化的问题;Zhang等人(2020)采用空间注意力模块和通道注意力模块,去除冗余颜色,实现低光图像的降噪和颜色校正。

图1 通道注意力机制

1.2 基于深度学习的水下图像处理方法

近年来,深度神经网络在许多计算机视觉任务中崭露头角。学者们开始探索将神经网络用于水下图像的恢复和增强。

Fabbri等人(2018)提出使用CycleGAN网络生成失真水下图像的高质量配对图像以进行训练,引入梯度下降损失以增强生成网络的预测能力;Hou等人(2018)联合残差学习,将水下成像模型与神经网络结合用以增强水下图像;Anwar等人(2018)利用不同水深的水下图像,基于修改后的水下成像模型和相应的水深等水下场景参数来合成水下图像,并联合残差学习训练了包括10种类型的水下图像的增强模型UWCNN(underwater convolutional neural network);Guo等人(2020)提出了一种新的用于增强水下图像的多尺度密集生成对抗网络用于增强水下图像;Li等人(2020)构建了一个包含950幅图像的水下图像增强基准数据集(underwater image benchmark dataset,UIEB),并设计了WaterNet网络用于增强水下图像。

2 本文方法

针对水下图像全局颜色失真和局部对比度降低等问题,本文提出基于学习的方法,采用两分支卷积网络,通过多残差学习来补偿丢失的信息。进一步地,引入残差通道注意模块来提高视觉质量。最终所生成的图像具有更鲜艳的色彩和更高的对比度。

2.1 图像预处理

由于水下失真图像存在对比度低、场景边缘不清晰的问题,通过将失真图像进行Sigmoid校正,以调整图像的对比度,提高场景边缘的锐利程度。具体方法是,首先将每个像素缩放到[0, 1]范围;然后,对输入图像的每个像素进行校正,计算为

(1)

式中,g表示S型函数的指数幂的常数乘数,默认值为10;c为截止值,用于改变水平方向上特征曲线的S形函数的截止,默认值为0.5。最终得到校正后的图像。

2.2 网络结构

如图2所示,所提出的多残差联合学习的网络由2个分支组成:分支1——残差通道注意分支网络和分支2——残差卷积增强分支网络。分支1采用多个残差连接提取图像中浅层和深层的特征,应用的通道注意力模块将对不同通道的特征重新进行加权分配,有用特征得到加强,无用特征得到抑制。分支2输入的校正后图像的对比度得到提高,边缘信息更为丰富,采用多个密集级联块以提取并增强输入图像的边缘等结构信息。

图2 特征提取与融合结构示意图

分支1中包含浅层特征提取、残差组深层特征提取、放大模块和重建模块。输入图像为原始未经过任何校正处理的RGB水下图像,输入大小为 256×256像素。首先,采用一个平卷积层,一个下采样卷积层,从输入图像中提取特征属性。平卷积层采用卷积核尺寸为3×3,卷积步长为1,卷积核数量为64。下采样卷积层采用卷积核尺寸为3×3,卷积步长为2,卷积核数量为64个。然后是深层特征提取部分,共包括3个残差组,每个残差组中包含3个串联的残差通道注意块。其中,第3个残差通道注意块的输出经过1个平卷积层后与第1个残差通道注意块的输入使用短连接进行逐元素相加操作后,作为第2个残差组的输入。残差组3的输出与第1个残差组的输入使用长连接进行逐元素相加操作。平卷积层采用卷积核尺寸为3×3,卷积步长为1,卷积核数量为64个。

由于在浅层特征提取模块中对输入图像进行了一次下采样,卷积步长为2,图像较输入图像缩小了2倍,因此,输出图像需要被放大两倍。为此设计了放大模块,采用反卷积方式将经过残差组深层特征提取后的图像放大至输入图像大小,即放大2倍。最后,在重建模组中,缩放后的图像特征经过一个平卷积层,尺寸为3×3,卷积步长为1,卷积核数量为3个。至此,输出分支1的增强图像特征。

在分支2中,网络由卷积层和密集级联组成,用以提取图像深层特征,保持输入图像的原始结构和纹理。原始未经过任何校正处理的水下图像与其经过Sigmoid校正处理的图像进行级联后馈入网络。首先是边缘等空间结构信息提取,该功能由3个密集级联块组成,在每个密集级联块中有3个卷积层。在第1个密集级联块中,第1层卷积层由16个大小为3×3×3的卷积核组成,为第1层生成16个输出特征图,卷积步长为1;而随后的卷积层则使用3×3×16的卷积核生成16个输出特征图,卷积步长为1。输入图像在经过3次卷积后,将每次卷积后的图像特征与输入的图像特征进行级联,并作为下一个密集级联的输入。

在第2个密集级联块中,经过3次卷积后的图像特征与经过1次、2次卷积后的图像特征以及第1个密集级联块输出的图像特征进行级联,并作为第3个密集级联块的输入。依此,在第3个密集级联块中,经过3次卷积后的图像特征与经过1次、2次卷积后的图像特征以及第2个密集级联块输出的图像特征进行级联。输入图像在经过3个密集级联块后进行一次卷积,卷积核大小为3×3,卷积步长为1,输出3层特征图。至此,输出分支2的图像增强特征。最后对输出的特征图进行Sigmoid操作。

然后,总干支线将分支1与分支2输出的图像增强特征进行级联,并经过一个密集级联块,密集级联方式以及卷积层卷积核大小和步长与分支2中第1个密集级联块相同。将经过密集级联的图像特征进行一次卷积操作,卷积核大小为3×3,步长为1,最终输出通道数为3的图像特征。随后,对输出的图像特征进行Sigmoid操作。

最后,将分支2与总干支线中增强后的图像特征Sigmoid的结果分别与分支1的增强图像特征相乘,并将两个相乘的结果进行相加操作,得到最终的融合后的增强图像,进行输出。

2.3 损失函数

为了确保神经网络能够生成具有良好视觉效果的图像,将内容感知损失、均方误差(mean square error, MSE)损失、结构相似性(SSIM)损失以及梯度下降损失加权组合在一起,损失函数定义为

L=a×Lvgg+b×Lmse+c×Lssim+d×Lgdl

(2)

式中,a=0.05,b=1,c=0.1,d=0.01。Lvgg表示内容损失项,用于驱动网络生成具有与目标真实图像相似内容的增强图像。基于预训练的19层VGG(Visual Geometry Group)网络的ReLU激活层定义了感知损失,令φj(x)为预训练的VGG19网络φ的第j个激活后的卷积层,j的值设为5。内容损失表示为增强图像E与参考图像G的特征表示之间的差距,即

(3)

式中,N是训练过程中每批的数量;CjHjWj表示VGG19网络内第j个卷积层的特征图的维度。Cj,Hj和Wj是特征图的数量、高度和宽度。

Lmse表示增强图像与参考图像的特征表示之间的MSE损失,计算为

(4)

式中,m和n分别表示图像的宽和高。

Lssim表示增强图像与参考图像的特征表示之间的SSIM损失,计算为

(5)

Lssim(E,G)=1-S(E,G)

(6)

式中,μE、μG分别表示E和G的平均值,σE、σG分别表示E和G的标准差,σEG代表E和G的协方差。C1、C2为常数,避免分母为0带来的系统错误。

Lgdl表示梯度下降损失,给定增强图像E,参考图像G,同时引入了相邻像素之间的相关性,α为大于或等于1的整数,梯度下降损失表示为

||Gi,j-Gi,j-1|-|Ei,j-Ei,j-1||α

(7)

3 实验结果与分析

3.1 实验设置

从水下图像增强基准数据集(UIEB)包含的890幅具有相应参考图像的高清水下图像中,随机选出800幅图像用于制作训练集。然后将选出的800幅分辨率不完全相同的大图像逐一随机剪裁成尺寸为256×256像素的小图像。同时,将选出的800幅图像对应的参考图像作为标签数据。除以上的800幅训练图像外,将UIEB数据集中剩余的90幅有参考图像和60幅无参考图像的水下图像作为测试集,有参考图像的部分测试集的缩略图如图3所示。

图3 有参考图像的水下图像测试图像示例

实验使用Adam优化器,卷积神经网络的初始学习率设为0.001,批量(batchsize)大小为16,迭代400轮。在训练的过程中发现,当训练到200轮左右时,loss出现忽高忽低、不再下降的情况。因此,当神经网络的训练达到200轮时,进一步地将学习率调小为0.000 5。网络会继续收敛优化模型,生成的图像质量较为稳定。实验基于Tensorflow平台展开,使用CPU i7-9700K CPU@3.60 GHz 处理器,32 GB 运行内存,NVIDIA GeForce RTX 1080Ti GPU进行训练与测试。网络训练时间约为10 h。

3.2 实验结果

使用有参考图像的90幅图像进行测试,并给出了客观与主观测试结果。

使用两个参考指标,即峰值信噪比(peak signal-to-noise ratio, PSNR)和结构相似性SSIM,以及非参考水下图像质量评价方法(underwater image quality measure,UIQM)对生成的水下图像的质量进行评价。PSNR反映图像的失真程度,SSIM客观反映图像在多尺度上的结构相似性。对于水下图像,不同波长的光具有的不同吸收率会导致偏色,前向散射效应通常会导致图像特征模糊,而后向散射效应通常会限制图像的对比度。因此,由于水介质的特性会降低图像的色彩、清晰度和对比度,选择能够同时反映水下图像色彩、清晰度和对比度的指标UIQM评估整体水下图像质量。

SSIM计算如式(5)所示。PSNR计算为

(8)

式中,k表示采样值的比特数,对于灰度图像,比特数为8。

UIQM是一种基于人眼视觉系统激励的无参考水下图像质量评价指标,其针对水下图像的退化机理与成像特点,采用色彩测量指标(under water image colorfulness measure, UICM)、清晰度测量指标(under water image sharpness measure, UISM)和对比度测量指标(under water image contrast measure, UIConM)作为评价依据,将UIQM表示为三者的线性组合。其值越大,表示图像的颜色平衡、清晰度、对比度越佳。计算为

fUIQM=c1×fUICM+c2×fUISM+c3×fUIConM

(9)

式中,fUICM表示水下图像的色彩度量,fUISM表示水下图像清晰度测量,fUIConM表示水下图像对比度测量,c1、c2、c3表示加权系数。

fUICM测量公式为

(10)

fUISM测量公式为

(11)

式中,g表示R、G、B三个颜色分量的灰度边缘图,EME(enhancement measure estimation)表示用于测量边缘清晰度的方法。每个RGB颜色分量中的EME度量与系数λ线性组合。其中,λR=0.299,λG=0.587,λB=0.114。fEME测量方法为

(12)

式中,k1k2表示图像被分割的块数,Imax,k,l/Imin,k,l表示每个块内的相对对比度。

通过在灰度图像上应用flogAMEE度量来测量对比度。flogAMEE测量方法为

fUIConM=flogAMEE(fintensity)

(13)

(14)

式中,k1k2表示图像被分割的块数,⊕、⊗和Θ为参数化对数图像处理操作,fintensity为对比度。

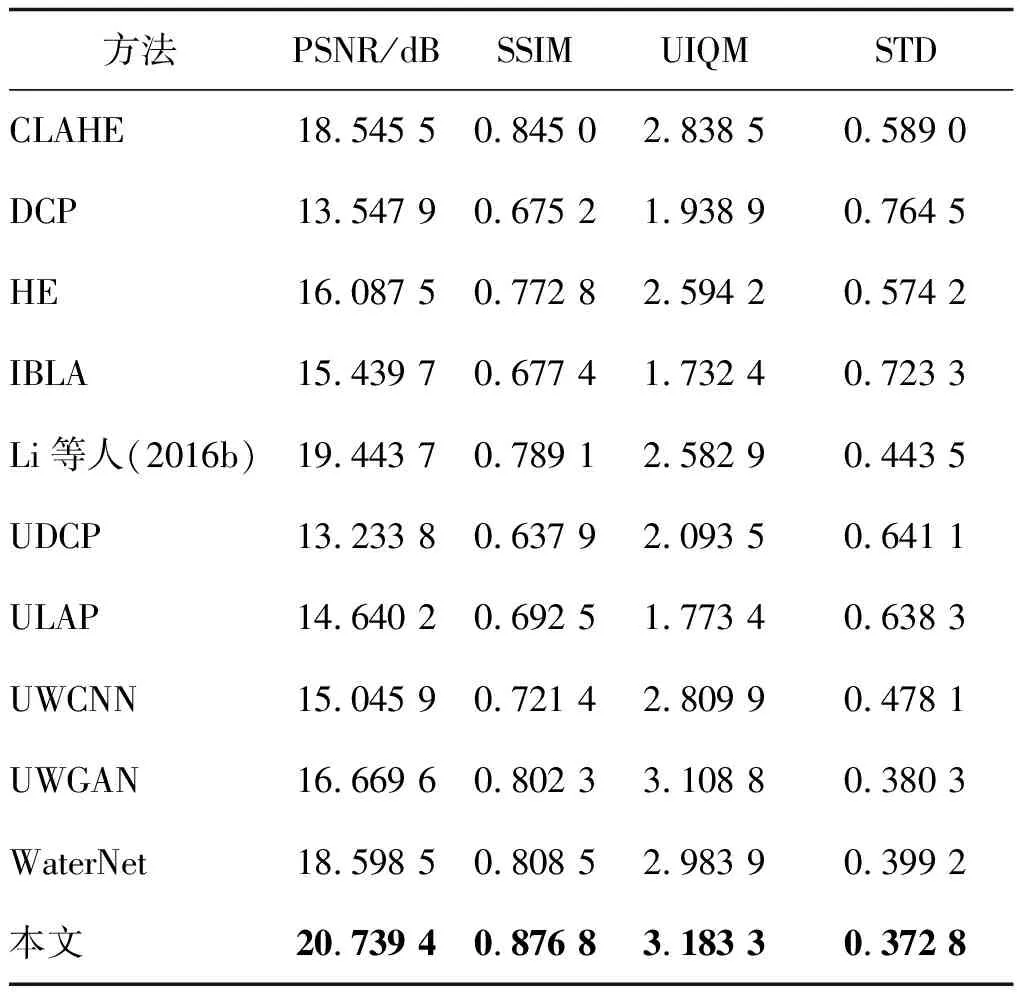

使用不同方法得到的模型对测试集中有参考图像的90幅图像进行测试,平均值的结果如表1所示。可以看出,与其他方法相比,本文方法均获得了最高的PSNR、SSIM和UIQM值,同时测试90幅图像的UIQM指标时获得了最小的标准差(standard deviation, STD)。

表1 不同方法客观比较

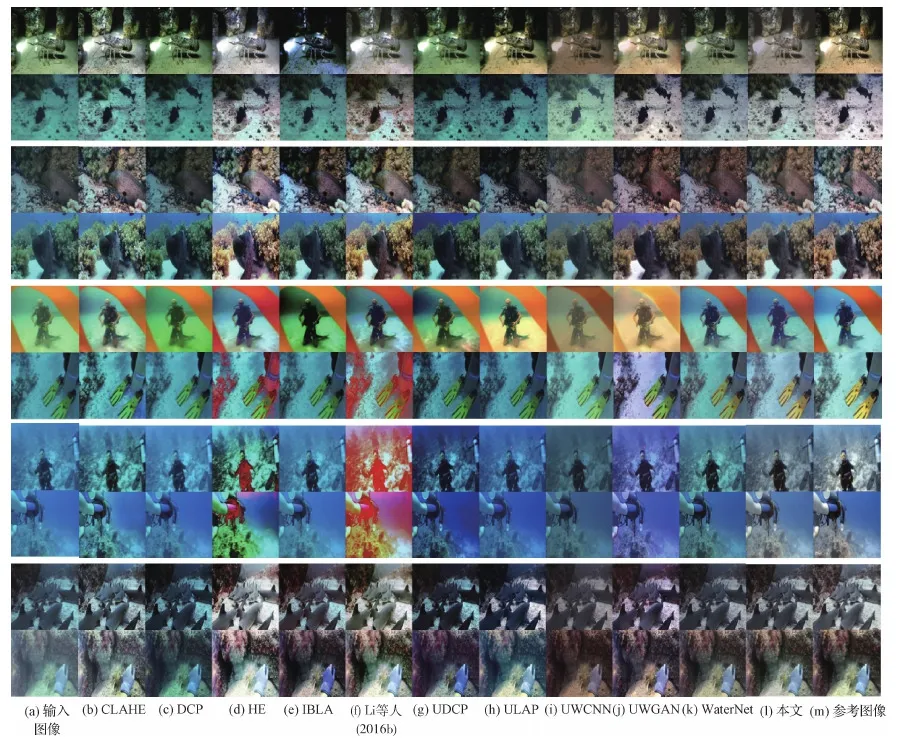

此外,还对比了不同方法得到的增强后水下图像的主观质量。在海洋中,海水越深,其反射的蓝色光就越多,所拍摄出的图像就越偏蓝。从90幅生成的增强图像中选择10幅不同水深的图像样本进行了主观质量对比,如图4所示。就测试的有参考图像的90幅图像而言,CLAHE方法可以改善这些图像的对比度,但会引入伪影并保持类似雾霾的效果;DCP方法几乎无法改善输入的水下图像的质量;使用直方图均衡HE的方法,能够改善图像质量,但存在过曝以及无法正确恢复偏蓝色水下图像等问题;UDCP和IBLA方法效果不明显;Li等人(2016b)和ULAP方法同样也不能恢复偏蓝色水下图像的质量。基于卷积神经网络的方法UWCNN,使用WaterType-I训练模型进行水下图像增强,所生成的图像色彩暗淡不够明亮;基于生成对抗网络的方法UWGAN能够增强一般偏色的水下图像,但是对偏蓝或偏绿的图像几乎没有效果;WaterNet方法同样不能恢复偏蓝图像的质量。与其他方法相比,本文方法不仅能够增强恢复一般的水下图像,使得水下图像偏色、对比度低等多个退化特征得到增强,获得自然清晰的图像;而且对于深海环境下的严重偏蓝或偏绿的图像,本文方法也可以获得较好的主观质量,也更加接近于参考图像。

图4 不同方法主观结果比较

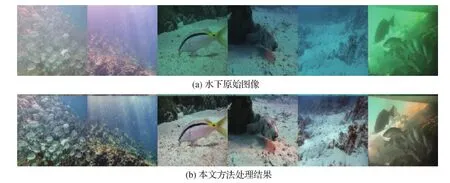

除对具有高质量参考图像的90幅图像进行测试外,还对UIEB数据集中具有挑战性的60幅无参考图像的图像进行了测试。

如图5所示,水下图像偏蓝、偏绿以及对比度低等问题得到了改善,主观质量得到提高。

图5 无参考水下图像主观结果

4 消融实验

4.1 损失函数消融实验

为了验证损失函数中的均方误差损失项、结构相似性损失项、梯度下降损失项以及内容感知损失项对实验结果的影响,对以上4个损失项进行了消融实验,在每次消融实验中,分别去掉其中一个损失项,以进行对比研究。消融实验客观质量比较结果如表2所示。

表2 损失函数消融实验客观结果

此外,将消融实验中生成的图像进行了对比,可以发现,在客观指标上所提出的损失函数能够获得最大的SSIM值和最大的PSNR值;从主观方面看,本文方法生成的图像更加接近参考图像,而去掉损失项进行消融实验的方法生成的图像存在明显偏色的问题,如图6所示。图中w/o表示去掉损失函数中的某个损失项。

图6 损失函数消融实验主观结果比较

4.2 残差组消融实验

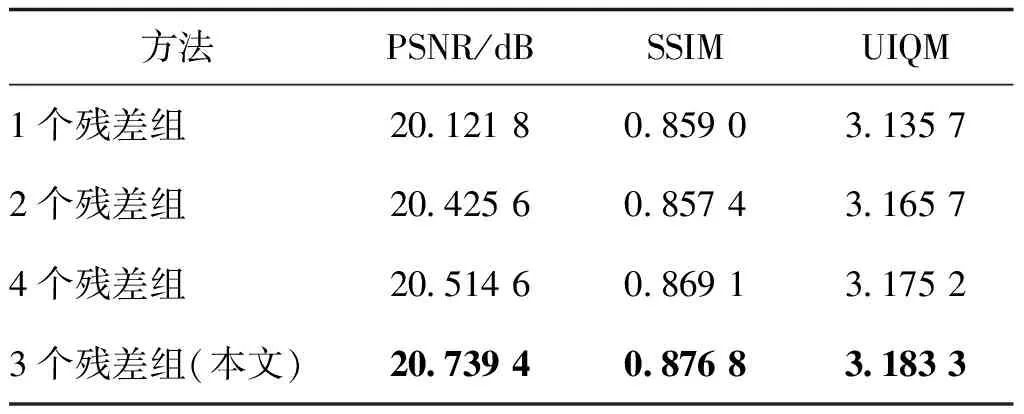

对网络结构中的残差组数量进行控制,将残差组数量分别设置为1个、2个和4个,分别训练网络模型,将对应模型生成的图像进行测试,与本文方法进行对比。残差组数量消融研究比较结果如表3所示。本文方法应用了3个残差组,与其他残差组的实验相比,在PSNR、SSIM和UIQM各项指标中均获得了最好的结果。当残差通道注意分支网络中分别使用1个或2个残差组时,由于卷积层数和跳跃连接不足,不能充分地提取图像的深层特征,影响了增强效果;而当使用4个残差组时,性能比3个残差组有下降,可能的原因是存在一定程度的过拟合。

表3 网络结构中残差组消融实验客观结果

5 结 论

提出了一种用于水下图像增强的多残差联合学习方法。针对全局颜色失真和局部对比度降低的问题,利用双分支网络中多个密集级联和残差学习来补偿丢失的信息。引入通道注意模块加强有用特征,进一步提高视觉质量。1)实验结果表明,本文方法增强后的水下图像PSNR指标达到了20.739 4 dB,SSIM指标达到了0.876 8,UIQM指标达到了3.183 3,均高于其他对比方法;同时,在测量90幅图像的UIQM指标时获得了最小的标准差;在主观质量上,本文方法不仅能够增强恢复一般偏色的水下图像,而且对于严重偏蓝或偏绿的图像,也可以获得较好的主观质量;2)本文方法模型较大、参数量较多,导致网络运行时间复杂度较高。后续将探索减少参数量的方法,使得网络在同等性能下更加轻便化。

参考文献(References)

Ancuti C, Ancuti C O, Haber T and Bekaert P.2012.Enhancing underwater images and videos by fusion//Proceedings of 2012 IEEE Conference on Computer Vision and Pattern Recognition.Providence, USA: IEEE: 81-88[DOI: 10.1109/CVPR.2012.6247661]

Anwar S, Li C Y and Porikli F.2018.Deep underwater image enhancement[EB/OL].[2021-01-23].https://arxiv.org/pdf/1807.03528.pdf

Bekerman Y, Avidan S and Treibitz T.2020.Unveiling optical properties in underwater images//Proceedings of 2020 IEEE International Conference on Computational Photography(ICCP).St.Louis, USA: IEEE: 1-12[DOI: 10.1109/iccp48838.2020.9105267]

Berman D, Treibitz T and Avidan S.2017.Diving into haze-lines: color restoration of underwater images//Proceedings of the British Machine Vision Conference(BMVC).Londaon, UK: BMVA Press, 1(2): 1-12[DOI: 10.52441C.31.44]

Berman D, Levy D, Avidan S and Treibitz T.2021.Underwater single image color restoration using haze-lines and a new quantitative dataset.IEEE transactions on pattern analysis and machine intelligence, 43(8): 2822-2837[DOI: 10.1109/TPAMI.2020.2977624]

Buchsbaum G.1980.A spatial processor model for object colour perception.Journal of the Franklin Institute, 310(1): 1-26[DOI: 10.1016/0016-0032(80)90058-7]

Chen X Y, Yu J Z, Kong S H, Wu Z X, Fang X and Wen L.2020.Towards quality advancement of underwater machine vision with generative adversarial networks[EB/OL].[2021-01-23].https://arxiv.org/pdf/1712.00736.pdf

Drews P L J, Nascimento E R, Botelho S S C and Campos M F M.2016.Underwater depth estimation and image restoration based on single images.IEEE Computer Graphics and Applications, 36(2): 24-35[DOI: 10.1109/MCG.2016.26]

Fabbri C, Islam M J and Sattar J.2018.Enhancing underwater imagery using generative adversarial networks//Proceedings of 2018 IEEE International Conference on Robotics and Automation(ICRA).Brisbane, Australia: IEEE: 7159-7165[DOI: 10.1109/ICRA.2018.8460552]

Galdran A, Pardo D, Picón A and Alvarez-Gila A.2015.Automatic red-channel underwater image restoration.Journal of Visual Communication and Image Representation, 26: 132-145[DOI: 10.1016/j.jvcir.2014.11.006]

Guo Y C, Li H Y and Zhuang P X.2020.Underwater image enhancement using a multiscale dense generative adversarial network.IEEE Journal of Oceanic Engineering, 45(3): 862-870[DOI: 10.1109/JOE.2019.2911447]

He K M, Sun J and Tang X O.2011.Single image haze removal using dark channel prior.IEEE Transactions on Pattern Analysis and Machine Intelligence, 33(12): 2341-2353[DOI: 10.1109/TPAMI.2010.168]

Hou M J, Liu R S, Fan X and Luo Z X.2018.Joint residual learning for underwater image enhancement//Proceedings of the 25th IEEE International Conference on Image Processing(ICIP).Athens, Greece: IEEE: 4043-4047[DOI: 10.1109/ICIP.2018.8451209]

Hu J, Shen L and Sun G.2018.Squeeze-and-excitation networks//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.Salt Lake City, USA: IEEE: 7132-7141[DOI: 10.1109/CVPR.2018.00745]

Hummel R.1977.Image enhancement by histogram transformation.Computer Graphics and Image Processing, 6(2): 184-195[DOI: 10.1016/S0146-664X(77)80011-7]

Iqbal K, Odetayo M, James A, Salam R A and Talib A Z H.2010.Enhancing the low quality images using unsupervised colour correction method//Proceedings of 2010 IEEE International Conference on Systems, Man and Cybernetics.Istanbul, Turkey: IEEE: 1703-1709[DOI: 10.1109/ICSMC.2010.5642311]

Jaffe J S.1990.Computer modeling and the design of optimal underwater imaging systems.IEEE Journal of Oceanic Engineering, 15(2): 101-111[DOI: 10.1109/48.50695]

Li C Y, Guo C L, Ren W Q, Cong R M, Hou J H, Kwong S and Tao D C.2020.An underwater image enhancement benchmark dataset and beyond.IEEE Transactions on Image Processing, 29: 4376-4389[DOI: 10.1109/TIP.2019.2955241]

Li C Y, Guo J C, Chen S J, Tang Y B, Pang Y W and Wang J.2016a.Underwater image restoration based on minimum information loss principle and optical properties of underwater imaging//Proceedings of 2016 IEEE International Conference on Image Processing(ICIP).Phoenix, USA: IEEE: 1993-1997[DOI: 10.1109/ICIP.2016.7532707]

Li C Y, Guo J C, Cong R M, Pang Y W and Wang B.2016b.Underwater image enhancement by dehazing with minimum information loss and histogram distribution prior.IEEE Transactions on Image Processing, 25(12): 5664-5677[DOI: 10.1109/TIP.2016.2612882]

Li C Y, Quo J C, Pang Y W, Chen S J and Wang J.2016c.Single underwater image restoration by blue-green channels dehazing and red channel correction//Proceedings of 2016 IEEE International Conference on Acoustics, Speech and Signal Processing(ICASSP).Shanghai, China: IEEE: 1731-1735[DOI: 10.1109/ICASSP.2016.7471973]

Li J, Skinner K A, Eustice R M and Johnson-Roberson M.2018.WaterGAN: unsupervised generative network to enable real-time color correction of monocular underwater images.IEEE Robotics and Automation Letters, 3(1): 387-394[DOI: 10.1109/LRA.2017.2730363]

Liu R S, Fan X, Hou M J, Jiang Z Y, Luo Z X and Zhang L.2019.Learning aggregated transmission propagation networks for haze removal and beyond.IEEE Transactions on Neural Networks and Learning Systems, 30(10): 2973-2986[DOI: 10.1109/TNNLS.2018.2862631]

Liu Y C, Chan W H and Chen Y Q.1995.Automatic white balance for digital still camera.IEEE Transactions on Consumer Electronics, 41(3): 460-466[DOI: 10.1109/30.468045]

Lu H M, Li Y J, Zhang L F and Serikawa S.2015.Contrast enhancement for images in turbid water.Journal of the Optical Society of America A, 32(5): 886-893[DOI: 10.1364/JOSAA.32.000886]

McGlamery B L.1980.A computer model for underwater camera systems//Proceedings Volume 0208, Ocean Optics VI.Monterey: SPIE: 221-231[DOI: 10.1117/12.958279]

Nicholas C B, Anush M and Ryan M E.2010.Initial results in underwater single image dehazing//Oceans 2010 Mts/IEEE Seattle.Seattle, USA: IEEE: 1-8[DOI: 10.1109/OCEANS.2010.5664428]

Panetta K, Gao C and Agaian S.2016.Human-visual-system-inspired underwater image quality measures.IEEE Journal of Oceanic Engineering, 41(3): 541-551[DOI: 10.1109/JOE.2015.2469915]

Peng Y T and Cosman P C.2017.Underwater image restoration based on image blurriness and light absorption.IEEE Transactions on Image Processing, 26(4): 1579-1594[DOI: 10.1109/TIP.2017.2663846]

Pizer S M, Johnston R E, Ericksen J P, Yankaskas B C and Muller K E.1990.Contrast-limited adaptive histogram equalization: speed and effectiveness//Proceedings of the 1st Conference on Visualization in Biomedical Computing.Atlanta, Georgia: IEEE: 337-345[DOI: 10.1109/VBC.1990.109340]

Singh G, Jaggi N, Vasamsetti S, Sardana H K, Kumar S and Mittal N.2015.Underwater image/video enhancement using wavelet based color correction(WBCC)method//Proceedings of 2015 IEEE Underwater Technology(UT).Chennai, India: IEEE: 1-5[DOI: 10.1109/UT.2015.7108303]

Song W, Wang Y, Huang D M and Tjondronegoro D.2018.A rapid scene depth estimation model based on underwater light attenuation prior for underwater image restoration//Proceedings of the 19th Pacific-Rim Conference on Multimedia.Hefei, China: Springer: 678-688[DOI: 10.1007/978-3-030-00776-8_62]

Tang X Y, Li M, Xu L L, Hao Z and Zhang X W.2020.Underwater image enhancement based on turbulence model corrected by transmittance and dynamically adjusted retinex.Journal of Image and Graphics.25(7):1380-1392(汤新雨,李敏,徐灵丽,郝真,张学武.2020.基于透射率修正的湍流模型与动态调整retinex的水下图像增强.中国图象图形学报, 25(7):1380-1392)[DOI: 10.11834/jig.190482]

Wang N, Zhou Y B, Han F L, Zhu H T and Yao J Z.2021.UWGAN: underwater GAN for real-world underwater color restoration and dehazing[EB/OL].[2021-01-23].https://arxiv.org/pdf/1912.10269.pdf

Wen H C, Tian Y H, Huang T J and Gao W.2013.Single underwater image enhancement with a new optical model//Proceedings of 2013 IEEE International Symposium on Circuits and Systems(ISCAS).Beijing, China: IEEE: 753-756[DOI: 10.1109/ISCAS.2013.6571956]

Yang Y Z and Lu H.2019.Single image deraining using a recurrent multi-scale aggregation and enhancement network//Proceedings of 2019 IEEE International Conference on Multimedia and Expo(ICME).Shanghai, China: IEEE: 1378-1383[DOI: 10.1109/ICME.2019.00239]

You Q J, Wan C, Sun J, Shen J X, Ye H and Yu Q L.2019.Fundus image enhancement method based on CycleGAN//Proceedings of the 41st Annual International Conference of the IEEE Engineering in Medicine and Biology Society(EMBC).Berlin, Germany: IEEE: 4500-4503[DOI: 10.1109/EMBC.2019.8856950]

Yu D B, Huo G Y, Liu Y, Zhou Y and Xu J X.2019.Underwater image restoration based on red channel and haze-lines prior//Proceedings of the 12th International Conference on Intelligent Robotics and Applications.Shenyang, China: Springer: 148-158[DOI: 10.1007/978-3-030-27532-7_13]

Zhang C, Yan Q S, Zhu Y, Li X J, Sun J Q and Zhang Y N.2020.Attention-based network for low-light image enhancement//Proceedings of 2020 IEEE International Conference on Multimedia and Expo(ICME).London, UK: IEEE: 1-6[DOI: 10.1109/ICME46284.2020.9102774]

Zhang Y L, Li K P, Li K, Wang L C, Zhong B N and Fu Y.2018.Image super-resolution using very deep residual channel attention networks//Proceedings of the 15th European Conference on Computer Vision(ECCV).Munich, Germany: Springer: 294-310[DOI: 10.1007/978-3-030-01234-2_18]