利用改进DBSCAN算法的管制雷达目标标定方法

靳慧斌,刘海波,胡占尧,霍百明

(1.中国民航大学 通用航空学院,天津 300300;2.中国民航大学 飞行技术学院,天津 300300;3.中国民航大学 中欧航空工程学院,天津 300300)

民航历年发生的空中交通管理不安全事件中,管制员人因差错导致的不安全事件数至少占总数的80%[1]。可见,对管制过程开展人因研究对于提升民航运行安全水平具有重要意义。

人机交互分析是人因研究的重要方法。人的感觉器官(如眼睛和耳朵)接受信息,传到大脑进行处理、判断和决策,然后大脑发出的指令传递到口、手、脚等部分并执行[2],管制指挥的关键在于准确及时地获取空域内运行航空器的信息。而管制员主要通过眼睛获取航空器的信息[3],因此注视时间和扫视路径等眼动指标能在一定程度上反映被试选择信息的倾向性,目前眼动追踪技术已经能准确记录眼球运动数据。在航空领域,视觉搜索策略[4-6]、工作负荷[7-10]与管制人因差错[11-14]3个方面是国外国内相关研究的主要方面。此外,眼动追踪技术正成为新兴管制技术的重要安全评估手段,如远程塔台界面评估[15]等。综上可知,利用眼动追踪技术捕捉眼球运动信息已经成为国内外研究人员分析管制人机交互的重要手段,通过处理眼动数据,可以提取有意义的眼球运动指标,这些量化指标往往能准确反映管制员的信息搜索和信息获取过程。

雷达界面中航空器目标往往是管制员重点关注对象,这些注视点集中的区域也经常被划分为兴趣区来研究,因此兴趣区提取可以作为一种雷达目标标定的方法。目前兴趣区划分方法主要利用热图法手动划分,该方法虽然快捷简单,但是手动划分一方面缺乏切割兴趣区的理论依据与数据支撑,二是这种粗略的划分方法缺乏一定的精确性。而聚类算法因具有理论数据支撑和一定的准确度而进入人们的视野。但在使用传统的具有噪声的基于密度的聚类算法(DBSCAN,density-based spatial clustering of applications with noise)处理眼动数据时,输入参数不合理会导致聚类效果不理想[16]。因此有必要改进传统DBSCAN算法以避免在处理眼动数据时的问题。

为了提高管制人机交互的效率与安全水平,有必要提出一种能客观准确提取管制雷达界面航空器的目标方法,本研究从眼动数据处理入手进行雷达界面航空器目标标定。利用雷达管制模拟机、眼动仪等搭建模拟管制实验平台,招募8名民航管制学员为实验被试,记录被试在实验过程中的眼动数据,从原始眼动数据中提取注视点信息,对传统DBSCAN算法进行自适应获取参数改进,最后对相关改进进行验证。

1 模拟管制实验

1.1 实验被试

总计8名航空管制学员参加本实验,年龄范围为20~25岁。所有被试在实验前均参与过相关管制培训课程,具备独立完成实验任务的能力。所有管制学员视力正常2.0±0.3。

1.2 实验平台

实验平台硬件部分包括:

1)Tobii X2-60眼动仪:采样率60 Hz,精度0.34°;

2)雷达管制模拟机;

3)14英寸笔记本电脑:分辨率为1 366×768。

1.3 实验程序

具体实验程序如下:

1)连接好所有设备的电源,并将眼动仪与外界设备相连,待连接完成后开启眼动仪,让被试处于设备屏幕前方约0.6 m位置;

2)待眼动仪开启后,先校准眼动仪,保证仪器能准确记录眼睛观察的位置;

3)启动雷达管制模拟机,设定初始航空器数目为7;

4)截取模拟实验过程中某一时刻的管制界面,让被试观察此时的雷达界面,并读取界面中的航空器信息,然后口头报告给主试,直到读取完所有航空器目标的数据,要求被试不能改变标牌的位置或形状,记录每名被试实验过程中的眼动数据,最后换下一被试看同样的雷达界面;

5)关闭并整理所有实验器材。

1.4 实验数据预处理

眼动仪无法记录被试眨眼或看向实验屏幕外时眼睛运动的数据,此时收集到的原始数据是空白数据,数据预处理时需将其删除。

一般认为当人的眼睛停留在某一位置的时间超过100 ms时会形成一次注视[17]。实验使用眼动仪的采样率为60 Hz,即1 s内记录60次数据。因此当眼动仪记录的数据点连续6次未改变位置时,表明眼睛至少在这一位置停留了100 ms,可以认为发生了一次注视过程,此过程眼睛对准的位置称为注视点。这是一种从眼动数据中提取注视点的方法。

2 基于DBSCAN算法的雷达目标标定

2.1 DBSCAN算法简介

管制员在进行空中交通指挥时通过阅读飞机的标牌来获得相关的飞行参数,所以管制员的注视行为能直观反映出其关注的目标。雷达中的航空器目标往往受到相对频繁地关注,因此眼动数据能被用来对雷达界面中航空器目标进行标定。

图1左图显示,雷达界面中有航班号分别为CCA1610、CCA1402和CCA937的3个航空器目标。图1右图为所有被试在雷达界面上的眼动数据热点图,对照2图可以发现航空器附近的颜色较亮,说明注视点在航空器目标附近集中,根据热点图手动画出3个矩形框,得到3个航空器在雷达界面上的大概位置,显然这种划分的精确性较低,因此需要一种具有较高精确性的方法来标定航空器目标。

图1 模拟雷达界面与注视点热图

热点图表明在航空器周围分布的注视点密度大,而其他区域注视点密度小,因此可用基于密度的聚类算法进行处理,眼动数据中不可避免地会有一些由于头部运动等行为导致的噪声数据,因此在选择数据处理方法时需要考虑密度和噪声干扰,而DBSCAN算法能根据密度把数据划分为不同的簇,同时能在具有噪声的数据集中进行聚类[18],因此引入DBSCAN算法处理眼动数据。

DBSCAN算法有2个重要的参数,ε邻域值和密度阈值(Minpts)。对于给定的数据点Q,到Q的距离不大于ε值的区域称为该点的ε邻域,单位是像素。密度阈值一般是一个固定值。DBSCAN算法中,首先统计所有数据点在给定ε值范围内其他数据点的个数,如果其他数据点个数大于给定的密度阈值,即满足建立数据簇的条件,然后遍历所有的数据簇,将密度可达数据簇合并,当搜索不到新的可达数据簇时,结束迭代并建立类别[19]。

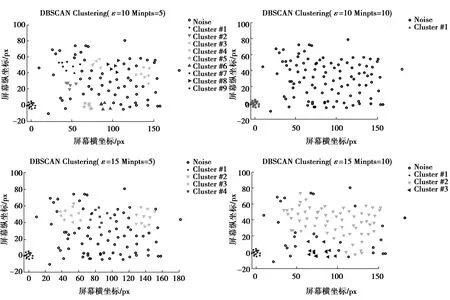

DBSCAN算法取不同参数的计算结果对比如图2,图中以不同形状区分不同类别的数据点,其中的黑空心圆点为噪声点。图2表明,设定的ε邻域数值或者密度阈值都不能合理划分航空器目标和飞机标牌。原因可能是上述2个参数对DBSCAN算法的聚类结果影响较大,如果输入过大的ε邻域值,无法有效过滤噪声点,更容易建立数据簇,从而降低算法的精确性;输入过小的ε邻域值,很多有效数据点被错误地分类为噪声点,降低算法准确性,导致目标区域标定过小;而密度阈值的选取也为全局参数,但不同注视点数据簇的分布密度差异较大,设定单一的密度阈值处理眼动数据并没有取得理想的效果。

图2 用取不同参数的DBSCAN算法处理CCA1610目标附近眼动数据的结果

因此,为了避免不合理设定参数导致错误的结果,提高DBSCAN算法的准确性与精确性,将从自适应获取ε邻域值和变密度阈值设定等方面对传统DBSCAN算法进行改进。

2.2 DBSCAN算法改进

2.2.1 自适应获取ε邻域值

传统DBSCAN算法需要用户合理设定参数,图2聚类效果对比图表明参数值的变化对聚类效果的影响很大,如果用户随机输入参数很可能使不符合预期结果。因此,研究将K-最临近距离分布图与统计分析相结合来自适应获取ε邻域值。

在选取DBSCAN算法推荐的邻域值时,Ester M[20]曲线拐点通过设定密度阈值为4来对比选取ε值。因此为了得到推荐邻域值,设定K-最临近距离分布法中的K=4,即对眼动数据集的一个数据点Q,找出距离Q第4近的数据点P,计算Q点与P点之间的距离,访问所有数据点计算出距离,将距离值放入集合DistMinpts中,然后按距离值大小将数据点升序排序。最后画出DistMinpts排序图,如图3,数据点序号作为横轴,序号对应的距离值为纵轴。一般将排序图中曲线拐点的纵坐标设定为推荐的ε值[21]。图3箭头对准的位置是曲线的拐点,其纵坐标值约为12.5 px,所以推荐ε值为12.5 px。

图3 DistMinpts排序图

DistMinpts排序图推荐值是为达到给定密度阈值,大多数的数据点需要满足的最小ε值。应用概率论中分布概率密度函数的特点,如果能拟合出DistMinpts距离分布的概率密度函数,计算出概率密度函数的极值点,并令ε等于极值点能够达到同样的效果[22]。

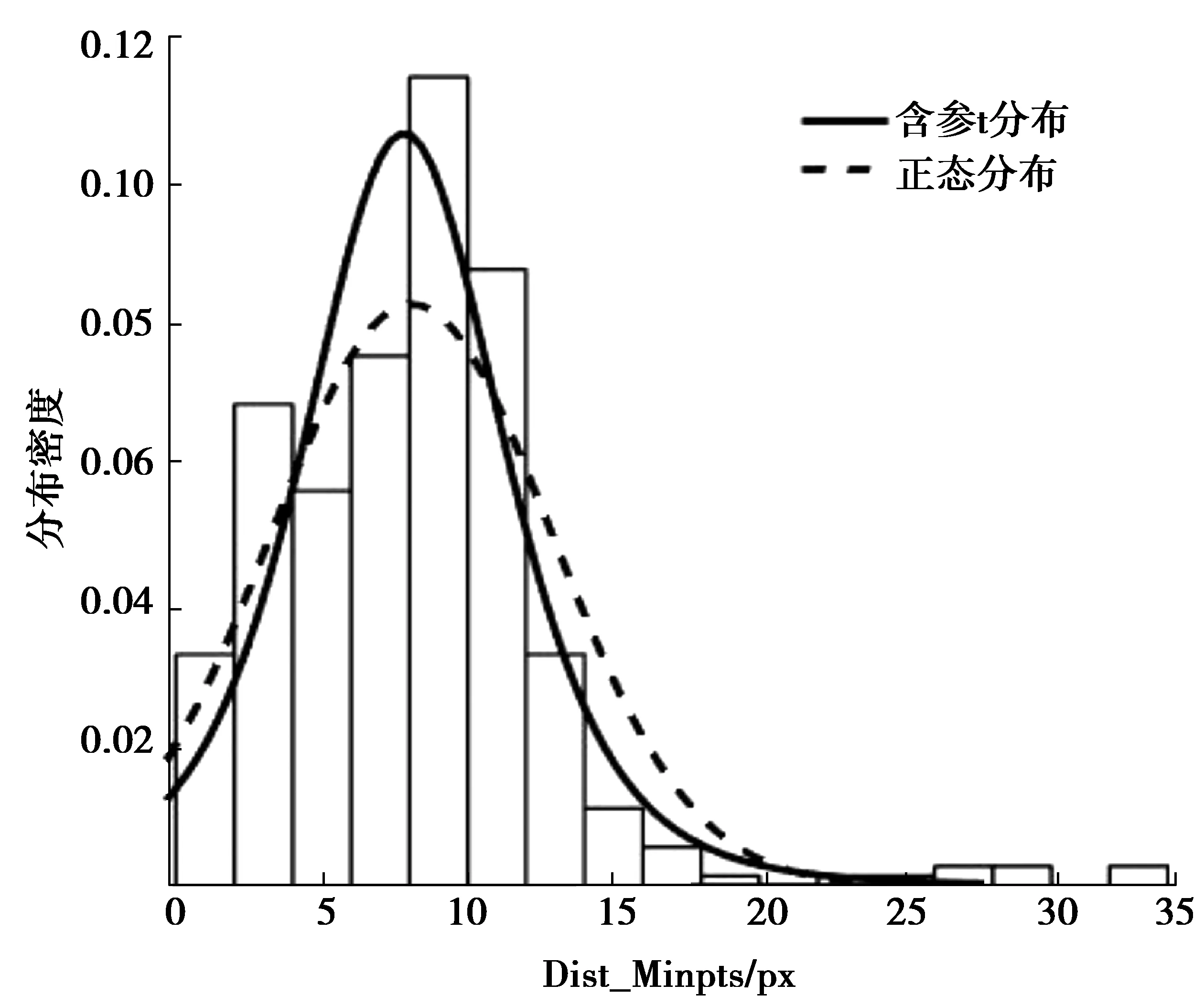

利用不同随机分布的概率密度函数对DistMinpts分布进行拟合,结果如图4。图中虚线曲线、实线曲线分别为正态分布的概率密度曲线以及含有尺度参数和位置参数的t分布(下文简称为含参t分布)概率密度曲线。图4表明,含参t分布的曲线与DistMinpts的分布情况最接近。同时含参t分布的概率密度函数存在唯一的极值点,结合眼动数据,采用最大似然法对参数求解,算得极值点为7.8,因此对DistMinpts分布进行拟合确定的邻域值为7.8。

图4 DistMinpts分布的概率密度函数与拟合曲线

此数值小于DistMinpts排序图法的推荐值,如果直接利用拟合法获得的邻域值会导致大量的数据点被误删,为保证后续聚类过程的效果,需要将拟合法求出的极值进行放大,放大系数m应取1.6,为作图法推荐值与拟合函数极值点的比值。

2.2.2 设定变密度阈值

人在观察图片时对不同对象的观察深度是不同的,其根源是不同对象所拥有的信息量和信息重要度迥异,因此不同对象周围的注视点密度可能相差很大。由于DBSCAN算法使用了固定的全局参数[16],此算法对密度差别较大的数据集(如眼动数据集)聚类效果较差,图2聚类结果表明,设定全局的密度阈值来处理眼动数据可能会产生不理想的分类效果。因此为了提高该算法处理眼动数据的可靠性与精确性,改进算法还应能自适应地改变密度阈值。

首先,根据前文描述的方法获取邻域值后,统计眼动数据集D中所有数据点的ε邻域内存在的其他数据点个数N。将数据点按照对应的N值大小进行降序排序。显然,这时该数据集中序号越靠前的数据点所在数据簇中注视点密度越大。

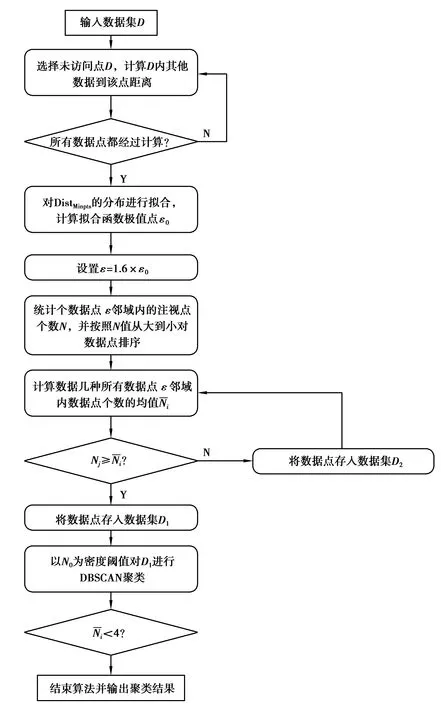

2.2.3 改进算法整体流程

为了提高DBSCAN算法处理眼动数据的可靠性和准确性,对DBSCAN算法进行了改进,即根据数据集自适应获取ε邻域值和变密度阈值设计。对于眼动数据集D,使用改进算法进行处理,最终输出是带有类别标签的聚类分析结果,改进算法整体流程如图5。

图5 改进DBSCAN算法流程图

2.3 改进算法适用性验证

首先是对自适应获取ε邻域方法的适用性验证。在改进的DBSCAN算法中,由于拟合分布概率函数极值ε0与作图法推荐的ε邻域值存在较大的差异,于是设定了一个放大系数,当对其他航空器目标采用一样的放大处理时,需要对这种放大处理和放大系数的适用性进行检验。

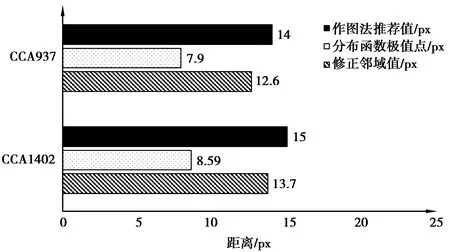

利用8名被试的全部眼动数据做出热点图,在热图中注视点密度较大区域对未标定的另外2架航空器进行粗标。截取出粗标后的眼动数据,处理得到注视点,先利用作图法求出推荐邻域值,再进行分布拟合求出分布函数极值,计算结果对比图如图6。

图6 改进方法的ε邻域估计值

图6中的修正邻域值是将分布函数极值放大1.6倍后的结果,即是另外2个航空器目标采用自适应法得到的ε邻域值,与作图法推荐值相差分别为8.6%和10%,差异较小,表明对于其他位置的航空器目标,放大系数值是合理的。

最后是对改进聚类算法的标定结果进行检验,改进算法应能够准确划分航空器目标和航空器标牌。在上面检验中确定的ε值的基础上,基于MATLAB工具使用改进算法对目标区域的眼动数据进行聚类,聚类结果如图7(a)所示。

图7 眼动数据聚类结果和目标区域提取结果

图7(a)表明改进后的算法能准确划分航空器目标和航空器标牌,并且对雷达界面上其他区域的航空器目标依然能很好地完成聚类。

在3架航空器目标聚类结果的基础上,删除掉噪声点,并使用最小包络矩形法提取出航空器的目标区域,实现对不同航空器目标的标定。提取效果如图7(b),图中左边方框中是航空器区域,右边方框是标牌区域。显然,提出的目标区域标定方法较热图法更为精确,且对于雷达界面中不同的航空器目标都具有良好的适用性。

3 结 论

眼动数据的热点图直观反映出航空器目标附近的注视点密度较大,表明航空器目标是雷达界面中管制员重点关注的目标,在热点图上能粗略标定航空器目标,但仍需进一步处理眼动数据以提高目标提取精度。

研究引入DBSCAN算法并进行改进,提出了一种基于眼动数据的雷达目标标定方法。改进算法能自动处理眼动数据。通过对模拟雷达管制界面中其他目标使用改进算法处理,发现对于不同的航空器,自适应算法获取的ε值与推荐的ε值相差仅为8.6%和10%,证明采用拟合分布函数极值点结合放大系数确定ε值的改进措施是合理的。聚类和提取结果表明,研究提出的雷达目标标定方法,对雷达管制界面中不同航空器目标具有一定的准确性和普适性。