车联网中基于MEC 的V2X 协同缓存和资源分配

李方伟,张海波,王子心

(1.重庆邮电大学通信与信息工程学院,重庆 400065;2.移动通信教育部工程研究中心,重庆 400065;3.移动通信技术重庆市重点实验室,重庆 400065)

1 引言

近年来,随着无线通信和物联网技术的发展,车联网(IoV,Internet of vehicles)已成为5G 的重要应用场景。通过LTE-V 或IEEE 802.11p 技术,车辆可以与基础设施、行人和其他车辆进行通信。智能车辆配备的车载单元(OBU,on board unite)使车辆具有计算能力和存储能力,因此支持通信的智能车辆能够作为移动缓存节点,为终端用户带来方便。

随着车联网快速发展,车载终端已经成为移动计算设备的重要组成部分[1]。为了应对移动数据和云数据流量的增加带来的时延和能耗增加的问题,基于云的车联网被广泛认为是提高服务性能的新范式。在云计算网络中,通过集成通信和计算技术,应用程序可以在本地的车载终端上运行,也可以转移到远程计算云上运行[2-5]。然而,由于回程和主干网传输的容量限制和时延波动,将云服务器放置在远离移动车辆的位置会严重降低卸载效率,并且增加传输时延。为此,业界提出了移动边缘计算(MEC,mobile edge computing)来解决这一问题,在靠近终端用户的地方执行时延敏感和上下文敏感的应用程序[6]。MEC 将云服务推向无线网络的边缘,并在移动车载终端附近提供计算卸载服务,极大地提高了资源利用率和计算性能。此外,MEC 系统中的服务器可以实现网络内缓存功能,类似于以信息为中心的组网(ICN,information-centric networking)[7]提供的功能,可以减少重复信息计算。

边缘缓存技术有效减少了网络中重复内容的计算与传输,是未来无线网络提高频谱利用率、缩短时延、降低网络负载的重要技术之一[8-10]。基于全球流量特性,在短时间内,许多用户会请求一些流行的内容,这些内容占据了大部分流量[11-12]。因此,主动缓存流行内容可以减轻回程链路的负担。在传统的蜂窝系统中,用户请求的内容必须从远离移动网络的互联网内容分发网络(CDN,content delivery network)节点获取,然后在移动核心网络上实现缓存内容[13],回程链路仍然受到容量限制。随着基站和低成本存储单元的发展,在大型基站和小型基站上部署缓存成为可能。同时,车联网的发展使车辆具备缓存能力,V2V(vehicle-to-vehicle)通信可以根据用户之间的社交关系,利用用户设备上的存储单元进行内容共享。

目前,已有大量学者致力于边缘缓存的研究。文献[14]设计了一个新的以信息为中心的异构网络框架,采用基于交替方向乘法器的分布式算法来求解缓存资源的分配问题。考虑到内容的流行度分布、可用的缓存大小和网络的拓扑结构,文献[15]通过设计缓存策略使系统吞吐量最大化。文献[16]提出了一种基于李雅普诺夫的在线算法来优化资源分配和内容缓存策略问题。文献[17]为了进一步降低传输时延及提高相应速率,提出了协同缓存分配和计算分流方案,MEC 服务器之间协同执行计算任务和数据缓存。在车联网中,文献[18]考虑了车辆媒体应用的蜂窝通信网络上的主动内容传输问题,提出了一个新的理论框架来描述移动边缘网络在计算、缓存和通信资源之间的权衡,通过传输跳数、用户需求预测的规模和准确性,以及缓存副本的数量来度量计算、缓存和通信资源。文献[19]研究了高速车辆在LTE-V2I(vehicle-to-infrastructure)网络中的部署问题,考虑MEC 系统的回程能力、车辆速度和内容流行度分布,制定联合优化框架以最小化MEC 系统的缓存,同时最大化平均下载百分比。然而,上述研究主要集中在MEC 服务器侧进行内容缓存,智能车辆的闲置资源没有被有效利用。

本文利用移动边缘计算资源与周围闲置车辆资源来增强边缘缓存能力,其中智能车辆被视为与MEC 服务器共享内容缓存任务的协作缓存代理;充分利用大量异构集成的存储资源进行内容缓存,特别是利用移动智能车辆和手持设备的资源来缓存流行内容;进一步研究车辆异构网络中基于MEC的任务卸载决策和资源分配问题;结合车联网的低时延要求与绿色通信的低能耗要求,将开销定义为时延与能耗的加权组合,提出了一种车联网中基于MEC 的V2X(vehicle-to-everything)协同缓存和资源分配机制,对网络内计算、缓存和通信资源进行有效分配,减少内容访问时延,提高资源利用率。

2 系统模型

2.1 网络模型

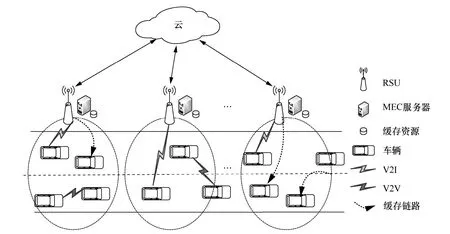

基于MEC 的V2X 协同缓存网络模型如图1 所示。考虑一个车载云协同边缘缓存模型。在这个模型中,道路周围部署L个路边单元(RSU,road side unit),表示为L={M1,M2,M3,…,ML},每个RSU都配有一个MEC 服务器。道路上N个车辆呈泊松分布,其车辆标识为N={1,2,3,…,N},由此车辆表示为V={v1,v2,v3,…,vN}。由于MEC 服务器与邻近车辆均具有计算与缓存能力,因此将其统称为服务节点 W={w1,w2,w3,…,wM}。每个RSU 覆盖范围内随机分布n个车辆,小区j的车辆集合为CVj={v1,v2,…,vn}。车载IEEE 802.11p OBU 具有802.11p 网络接口和蜂窝网络接口,车辆可以通过RSU 将任务卸载至MEC 服务器进行计算,或者卸载至邻近车辆进行V2V 通信。为了有效地复用频谱,V2I 模式和V2V 模式在同一频段工作。频谱被均分为K个子信道,表示为K={1,2,3,…,K},每个子信道带宽为B。车辆卸载策略集合表示为A={a1,a2,a3,…,aN},若ai=1,则代表vi将任务卸载到服务节点wm进行计算;若ai=0,则代表vi在本地执行计算任务。

图1 基于MEC 的V2X 协同缓存网络模型

假设在t时刻,缓存池存在一部分任务,当车辆有任务请求时,首先扫描周围服务节点是否存在任务缓存。如果任务缓存在服务节点上,则服务节点通知车辆任务,并在计算完成后将结果回传给车辆。通过这种方式,车辆不需要进行任务卸载,可以有效降低移动设备的能量消耗和任务卸载的时延。若服务节点上没有请求任务的缓存,则车辆进行卸载决策以及资源分配。当服务节点第一次计算完成请求任务后,考虑缓存决策。服务节点的缓存策略集合表示为Gm={gm,1,gm,2,gm,3,…,gm,n1},若gm,n1=1,则表示服务节点wm将计算任务n1进行缓存,以便下次请求,减少网络传输,降低计算时延。所有服务节点的缓存集合表示为AG={G1,G2,G3,…,GM}。

2.2 通信模型

在基于MEC 的V2X 协同缓存模型中,任务请求车辆vi可以向MEC 服务器或者临近车辆进行任务缓存请求,若服务节点不存在任务缓存,可以将其计算任务Ti卸载到MEC 服务器进行V2I 模式通信,或卸载到邻近车辆进行V2V 模式通信,或在本地执行其计算任务。为了提高频谱利用率,V2V模式复用V2I 模式的上行传输信道。因为车联网环境对于时延要求苛刻,所以考虑一个车辆可以分配多个上行信道。为了更好地描述信道分配情况,本文引入信道连接矩阵C,C 为Noff×K的二元变量矩阵,其中Noff代表卸载用户数量。信道连接矩阵C 的二元变量ci,k代表子信道k是否被分配给用户i。若ci,k=1,则表示子信道k被分配给用户i进行上行数据传输;若ci,k=0,则表示子信道k未被分配给用户i。vi的上行传输速率为

由于V2X 车联网在卸载情况下的干扰环境复杂,考虑同层干扰与跨层干扰,具体而言,干扰环境是复用信道导致的同频干扰,因此任务请求车辆vi在子信道上k的信干噪比(SINR,signal to interference plus noise ratio)表示为

其中,pi为vi的上行传输发送功率,为vi与服务节点gj在子信道k上的信道增益,σ2为高斯白噪声功率,Ii为vi受到的干扰。

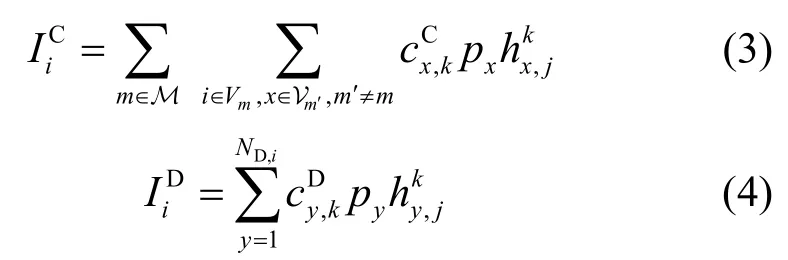

若车辆vi选择的服务节点为车辆,即进行V2V模式通信,可以分别表示为

2.3 计算模型

1)卸载计算

当车辆自身计算能力有限,不足以支持任务的时延要求时,需要将任务卸载至服务节点进行计算。任务处理过程将带来时延和能量消耗。由于回传的处理结果数据量较小,因此本文忽略回传过程的时延和能耗[20],仅考虑上传时延、计算时延以及传输能耗。

定义任务请求车辆vi将任务卸载至服务节点wj的计算过程产生的开销为时延与能耗的加权组合,表示为

其中,α与β分别为非负的时延与能耗的权重因子,且满足为卸载时延与计算时延之和,为服务节点wj分配给车辆vi的计算资源;为传输过程的能量消耗,pi为上行传输功率。

2)本地计算

假设车辆vi计算能力为,不同车辆具有不同的计算能力。当车辆任务在本地计算时,车辆vi所需要负担的开销为

2.4 缓存模型

缓存模型包括2 个部分,即当前存在缓存hitj,i与缓存更新gj,i。hitj,i=1表示服务节点wj已缓存车辆vi的内容;hitj,i=0表示服务节点wj未缓存车辆vi的内容,车辆需要进行卸载或本地计算。假设在一定时间间隔内,服务节点的缓存池中存在X个内容,表示为 X={1,2,…,X}。对于内容x∈X,其流行程度服从Zipf 分布,内容x被请求的概率为

其中,将缓存池中已缓存内容按照降序排列,I(x)表示内容x在缓存内容集合中受欢迎的等级;参数δ表示流行分布倾斜,这意味着更大的δ对应更高的内容复用,即前几个流行的内容占了大部分的请求,设置δ为0.56[22]。

缓存更新参数gj,i表示服务节点wj是否缓存车辆vi的内容。当服务节点wj计算完成车辆vi的任务后考虑缓存更新,gj,i=1表示服务节点wj将缓存任务,gj,i=0表示不缓存任务。

不同的服务车辆拥有不同的缓存能力,由于缓存能力有限,因此服务节点wj缓存内容总量不能超过其自身的最大缓存容量Hj。

2.5 问题形成

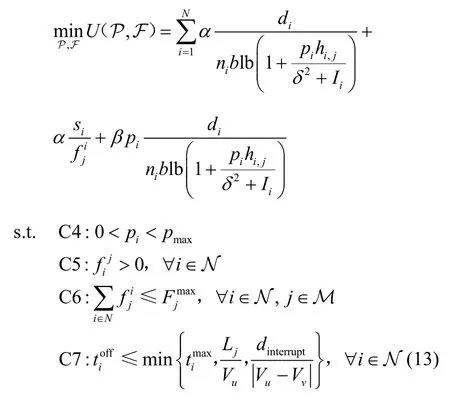

当智能车辆请求一个任务计算时,首先检查自身缓存池是否存在内容缓存。如果内容在本地可用,则不需要发布任务请求;否则,扫描周围服务节点是否存在内容缓存,若存在,则在服务节点计算完成后回传,若不存在,则需要考虑是否卸载。当任务卸载至服务节点计算完成后,服务节点考虑缓存的更新,之后将内容回传,服务结束。本文目标为通过恰当的卸载与缓存决策以及通信和计算资源的分配,使系统开销最小化。因此,优化目标表示为

其中,A 为所有任务请求车辆的卸载策略集合,C为信道连接矩阵,P 为卸载车辆的任务发送功率集合,F 为计算资源分配策略,AG 为服务节点的缓存决策。

约束条件C1 与C3 表示卸载决策为0-1 决策。C2 表示信道分配矩阵为二进制变量。C4 保证了功率分配为非负值且不超过上行传输功率变化范围。C5与C6 表示计算资源分配不超过服务节点的最大计算能力。C7 表示时延约束,其中Lj为vi与RSU 覆盖范围边界的距离,Vu为任务请求车辆的移动速度,Vv为服务车辆的移动速度,dinterrupt为最大中断距离。C8表示服务节点的缓存内容不能超过其最大缓存容量。本文设置车辆为单向匀速行驶。由此,vu与vv的速度差为,其相隔距离达到最大中断距离的时间为。此外,由于单向行驶,因此vi驶出RSUj覆盖范围的最大时间为

3 V2X 卸载与资源分配方案

为了应对现代化车联网中移动数据服务的爆炸性增长需求,开发高效的内容缓存和资源分配方案非常重要,其目标是显著减少冗余数据传输,提高内容交付效率。本文提出了一种基于MEC 的车联网V2X 协同缓存和资源分配机制,根据不同任务请求车辆对传输速率的需求,通过图着色模型为用户分配合适信道;针对最小化系统开销的目标,采用拉格朗日乘子法对功率与计算资源进行分配。考虑到任务重复性,本文利用MEC 服务器与邻近车辆资源增强边缘缓存能力,将缓存模型表示为背包问题,使用动态规划法对其进行缓存决策。

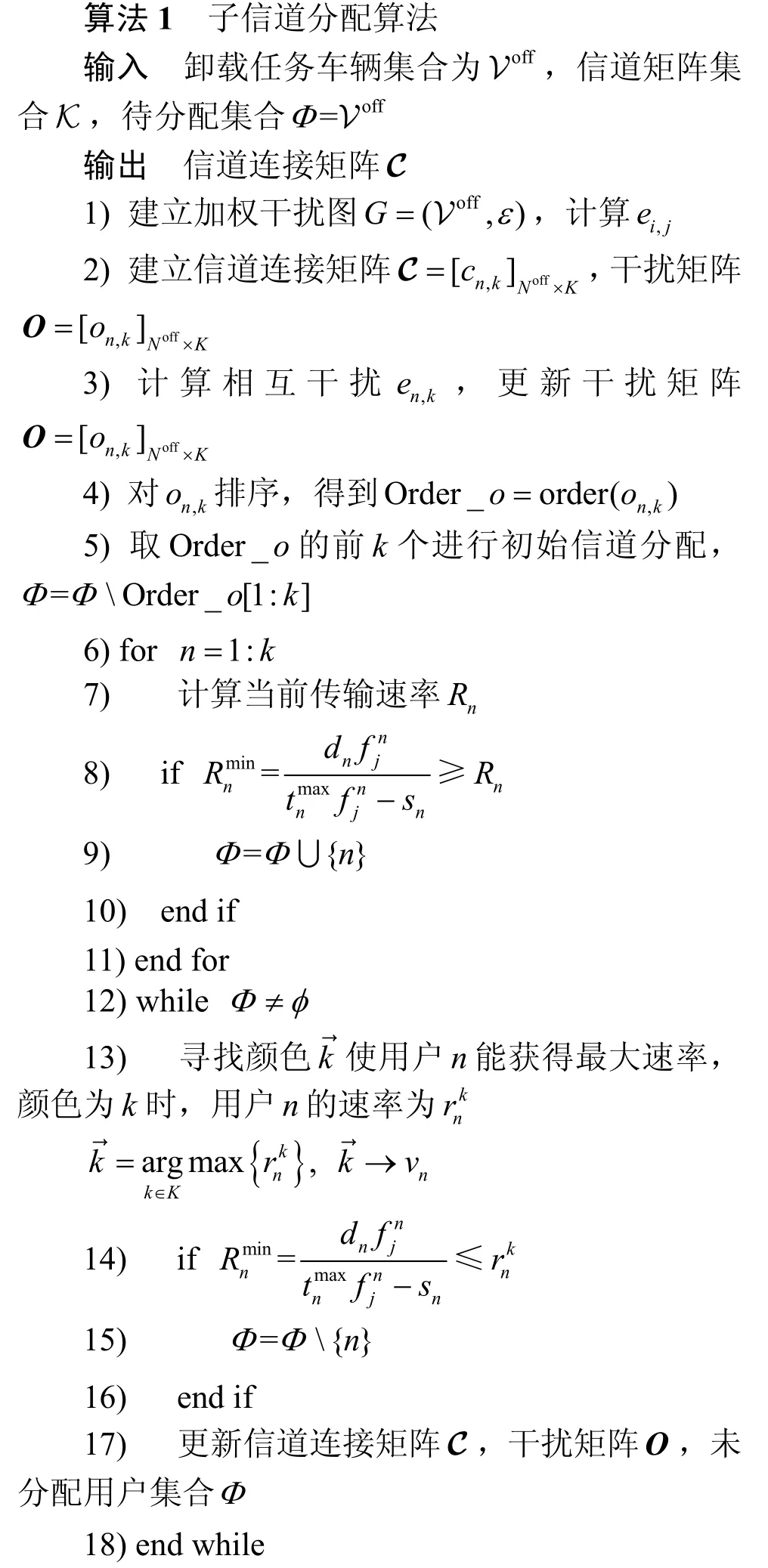

3.1 基于图着色的信道分配

本文采用部分频率复用的方式进行子信道分配,小区内V2I 用户通过OFDM 分配正交子信道,V2V 用户复用V2I 用户上行信道;相邻小区之间的用户由于频率复用而产生信道干扰。将子信道分配转化为图着色模型,建立加权干扰图G=(Voff,ε),其中,Voff表示卸载车辆集合,ε={ei,j}i,j∈V表示用户车辆之间的干扰权重。车辆vi对应的服务节点wx为MEC 服务器(wx∈M)或邻近车辆(wx∈V)。基于此,干扰权重计算式为

其中,i和j表示车辆vi和vj的序号标识;第一行表示当车辆vi与车辆vj处于同一小区且同为V2I用户或者i=j时,相互无干扰;第二行表示车辆vi与车辆vj处于不同小区时,存在复用干扰。

引入信道连接矩阵C 为Noff×K的二元变量矩阵,其中Noff×K代表卸载用户数量。信道连接矩阵C 的二元变量cx,k代表子信道k是否被分配给用户x。建立干扰矩阵代表用户n在信道k上受的干扰之和。

基于图着色的信道分配算法伪代码如算法1所示。

3.2 计算资源分配

当服务节点不存在内容缓存,且车辆决定卸载计算时,由式(10)可得以下优化问题。

对于车辆vi,寻找其干扰上界为

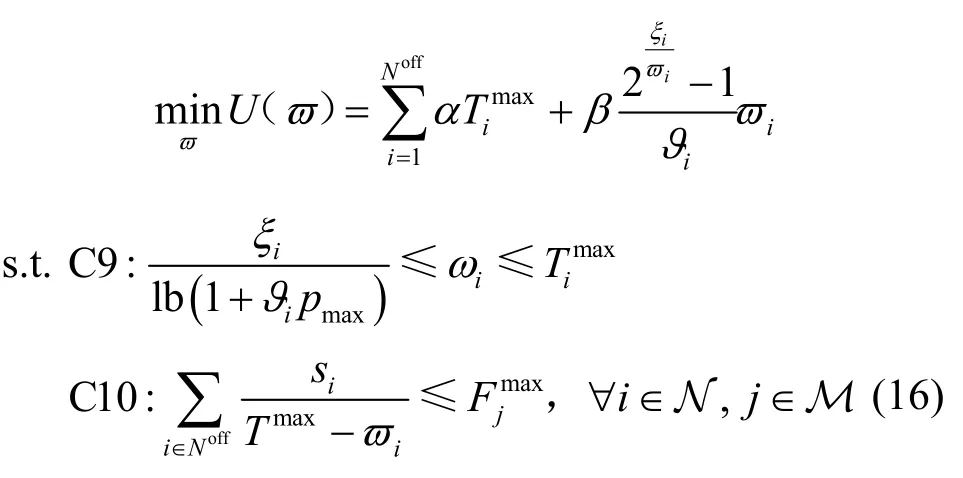

基于以上信息,式(13)可以改写为

在式(16)中对ϖ求二阶导可得

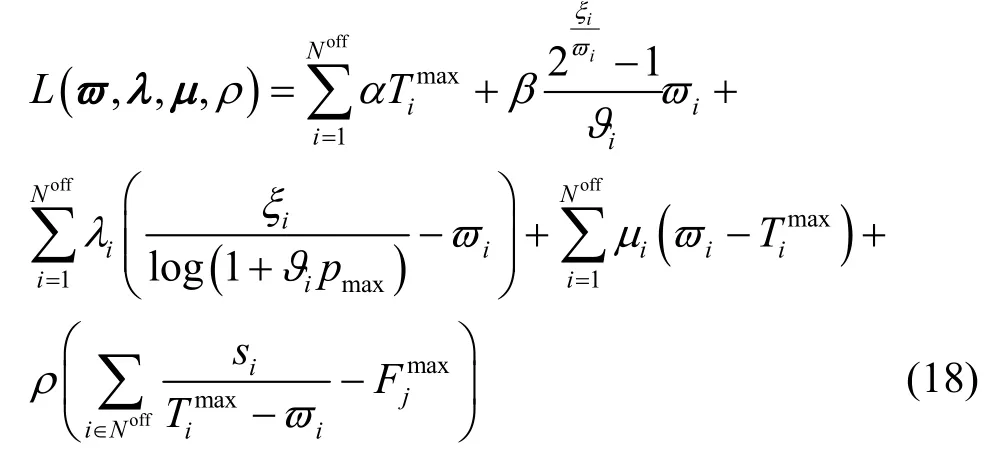

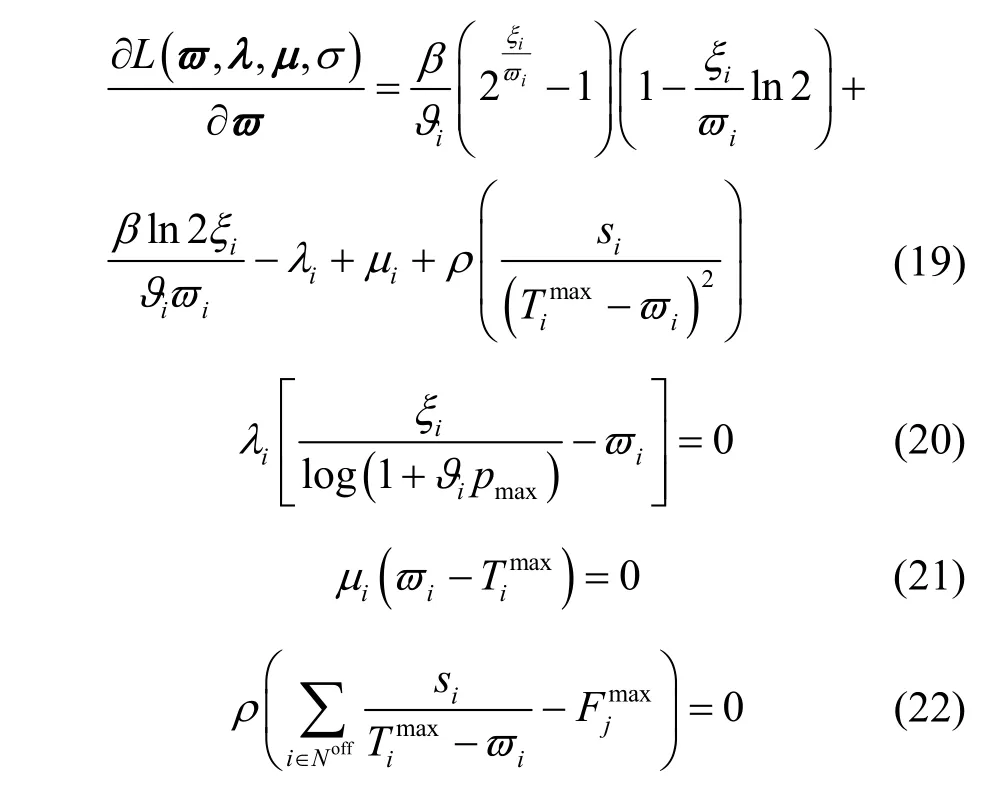

因此,式(16)为凹函数,可以采用 KKT(Karush-Kuhn-Tucker)条件对其进行求解。式(16)的拉格朗日函数为

其中,为卸载车辆的上行传输时延向量,λ和μ为拉格朗日乘子向量,λi、μi、ρ为非负拉格朗日乘子变量,满足KKT 条件

拉格朗日乘子更新规则为

其中,t表示第t次迭代,γ(t)表示迭代步长,时间下限

功率与计算资源分配算法伪代码如算法 2所示。

3.3 缓存决策

任务请求车辆vi将计算任务Zi卸载至服务节点wj执行计算,由于服务节点缓存容量有限,因此在计算完成以后需要选择是否将其缓存,以备后续请求车辆使用。服务节点wj的缓存容量为Hj,若缓存决策gj,i=1,则代表任务Zi被服务节点缓存,因此服务节点需要牺牲缓存容量di,此时问题等效为使服务节点wj的容量{Hj−di}效益最大化;若缓存决策gj,i=0,则代表任务Zi未被服务节点缓存,此时问题等效为使服务节点wj的容量{Hj}效益最大化。

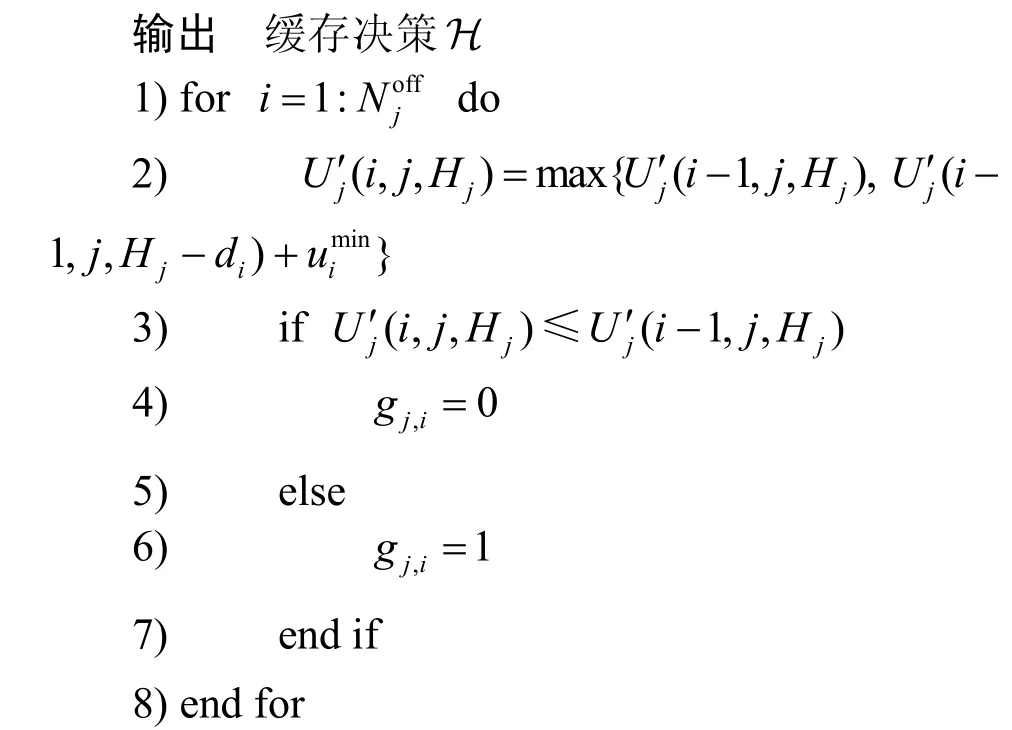

基于以上分析,将缓存决策建模为0-1 背包问题,通过动态规划法[23]对其求解,伪代码如算法3所示。作为输入向量,其中代表vi节约的开销。对于服务节点wj,其动态转移方程为

算法3基于背包问题的缓存决策算法

输入车辆信息服务节点wj状态函数U′j(i,j,Hj),卸载至服务节点wj的车辆数目

3.4 算法总结

基于边缘缓存的V2X 协同卸载与资源分配策略(V2X-CCRA,V2X-collaborative caching and resource allocation)伪代码如算法4 所示,原理如下。车辆首先扫描自身缓存池与周围服务节点是否存在内容缓存,如果存在,则进行计算或者在服务节点计算完成后回传任务结果;如果不存在,则加入卸载集合。针对卸载集合里的任务请求车辆,通过基于图着色的信道分配算法得到一次信道分配矩阵,同时根据拉格朗日KKT 条件得到功率与计算资源分配矩阵。然后,计算本地执行开销以及根据通信与计算资源的分配值计算卸载开销,由于任务请求车辆均满足理性和利己主义,目标均为尽量最小化自身计算代价,因此,比较本地计算与卸载至服务节点计算的执行开销,做出卸载决策。更新卸载集合Θ,找到卸载集合中元素的对应卸载服务节点,得到服务节点集合ϒ。针对ϒ中的每一个服务节点wj,确定其服务的车辆集合Λj,服务节点wj将任务计算完成后进行缓存的更新,考虑是否将这个任务缓存,以备后续请求车辆使用。V2X-CCRA 研究车辆异构网络中基于MEC 的任务卸载决策和资源分配问题,利用MEC 服务器与邻近车辆资源增强边缘缓存能力,对网络内计算、缓存和通信资源进行有效分配,减轻网络负载,提高资源利用率。

算法4基于边缘缓存的V2X 协同卸载与资源分配策略

输入车辆数目N,服务节点wj缓存容量Hj,信道集合K,卸载集合Θ=φ,α,β

4 仿真分析

本文主要研究车联网中的效率优先应用,如文件分享、地理信息收集等时延可容忍数据任务。性能评估阶段,通过MATLAB 平台对本文所提机制进行仿真。本节实验在IEEE 802.11p 车辆网络场景标准和MEC 白皮书的背景下展开,采用3GPP 标准化中提出的信道增益模型[24]。考虑路边有3 个小区,每个小区都配置了RSU 和MEC 服务器。具体仿真参数如表1 所示。

表1 仿真参数

为了评估当前提出机制的性能,将其与本地计算机制(ALCM,all local computing mechanism)、无边缘缓存的全卸载机制(AOCM wo.caching,all offloading computing mechanism without caching)、基于边缘缓存的全卸载计算机制(AOCM w.caching,all offloading computing mechanism with caching)、基于图着色的资源分配机制JCOIM(joint computation offloading and interference management)[24]、基于边缘缓存的V2I 卸载机制V2I-CCRA(V2I collaborative caching and resource allocation)进行比较。

图2 显示了车辆缓存容量与总开销的关系。车辆缓存容量增加,意味着更多的内容可以被缓存到车辆上,道路上可以形成更多的车辆云。当一些车辆从云中移出或离开道路时,用户可以从云中的其他车辆或其他车辆云中获取内容,从而大大减少重复计算,降低系统开销。本文V2X-CCRA 机制相较于基于边缘缓存的全卸载模式,优势明显。基于边缘缓存的全卸载模式由于不考虑本地计算,任务计算全依赖服务节点,卸载过程中由于传输干扰使时延增加,同时车辆移动性原因使服务中断带来重复计算,因此系统开销较大。本文V2X-CCRA 机制基于用户理性与利己主义,使任务请求车辆在卸载与本地计算之间进行权衡,尽量减少任务计算的代价,因此可有效降低系统开销。当车辆缓存容量逐步增长时,2 种机制的区别逐渐减小,这是由于车辆缓存容量增加,使更多的内容可以被缓存,因此需要卸载的任务减少,此时信道竞争减小,服务节点已有足够的能力完成计算。

图2 车辆缓存容量与总开销的关系

图3 和图4 分别为车辆数目和任务量与总开销关系。随着车辆数目与任务量的增加,总开销随之增长。传统的ALCM 由于车辆本身计算能力有限而带来较大的时延开销。当车辆数目较小时,由于任务量较少,缓存空间与计算能力均可良好地胜任任务计算,其中由于基于边缘缓存的AOCM w.caching存在缓存功能,一部分任务不需要卸载计算,降低了上传拥塞,因此性能与V2X-CCRA 相近,且优于JCOIM 机制。然而随着任务量增加,卸载部分的任务数据增大,网络拥塞已不可避免,因此AOCM w.caching 总开销急剧增长。此外,由于全卸载机制导致信道干扰严重且计算资源有限,因此无论是否存在缓存功能,其系统开销均随车辆数目与任务大小增加而迅速增长。JCOIM 机制应用于本文场景,由于其忽略功率分配对系统开销的影响,以及未利用周围临近车辆的闲置计算与缓存资源,因此性能不理想。本文V2X-CCRA 机制充分利用周围闲置资源,合理分配计算与通信资源,V2X 协同卸载可以有效提高资源利用率,缓存机制可以避免重复计算以及减少网络拥塞,从而降低系统开销。

图3 车辆数目与总开销的关系

图4 任务量与总开销的关系

图5 为信道数量与总开销的关系。信道数量增加,干扰逐渐减小,使传输时延降低,总开销减少。全卸载机制由于受信道数量影响较大,因此随着信道数量的增加,总开销降低速度加快。无边缘缓存的AOCM wo.caching 由于所有任务必须全部卸载,因此对信道干扰最敏感,总开销下降速度最明显,但由于服务节点计算资源有限,从而总开销一直大于 AOCM w.caching。本文基于边缘缓存的V2X-CCRA 机制能够更加灵活地管理资源,控制卸载流量,在信道数量变换的情况下做出有效的卸载权衡,保证资源有效利用。

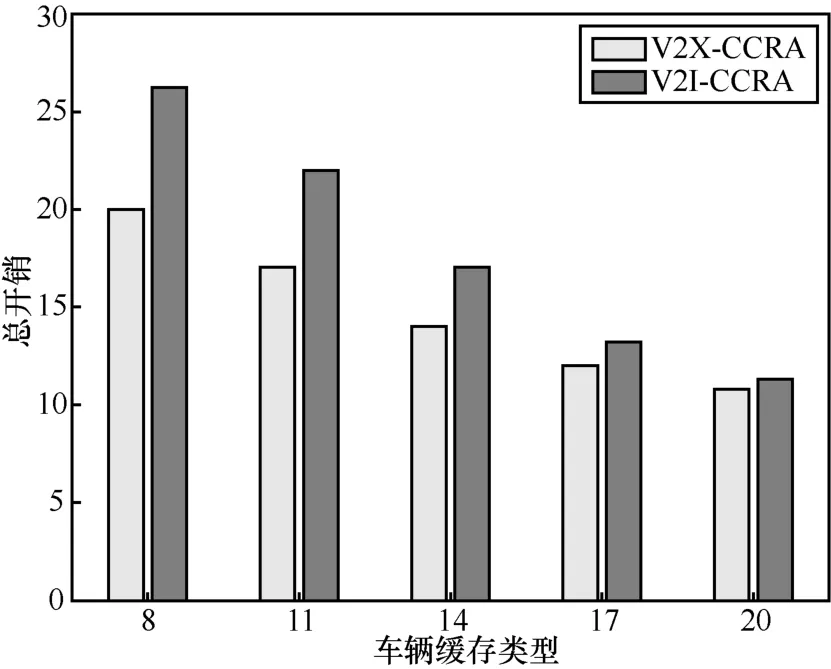

图6 为缓存类型与总开销的关系。缓存类型增加,意味着更多的内容可以被缓存,减少重复计算带来的时延,因此时间消耗逐步降低。在V2I-CCRA中,仅MEC 服务器具有计算与缓存功能,忽略了车辆的缓存能力,因此在服务节点可缓存类型较少时,大部分任务请求需要被卸载计算。V2X-CCRA由于可以有效利用周围车辆的闲置资源,可以增强边缘计算能力,因此相较于V2I 机制总开销较小。当缓存类型逐渐增加,车辆服务器由于缓存容量限制,无法缓存太多任务。MEC 服务器的大容量缓存池可以缓存更多的内容,此时大多数任务已可以从缓存池中获得,因此V2I 机制与V2X 机制的差距逐渐减小。

图5 信道数量与总开销的关系

图6 缓存类型与总开销的关系

5 结束语

本文在基于MEC 的车联网络场景中研究了基于边缘缓存的协同卸载与资源分配策略,利用MEC服务器与邻近车辆资源增强边缘缓存能力,提出了一种基于MEC 的车辆网络V2X 协同缓存和资源分配机制,对网络内计算、缓存和通信资源进行有效分配,避免重复传输,减少内容访问时延,提高资源利用率。仿真结果表明,所提机制可以有效减少任务请求车辆的计算代价以降低任务计算的系统开销,在各参数变化下均能取得较好效果。在未来工作中,将继续研究基于MEC 的V2X 卸载策略,同时考虑由车辆高速移动特性导致链路断开,使任务回传失败的情况,建立基于车辆位置预测的V2X卸载框架。