多目视觉定位协同引导自动运输车研究

曾群生,苏成悦,程天明,张洪钊,黄佩铎

ZENG Qunsheng1,SU Chengyue2,CHENG Tianming2,ZHANG Hongzhao2,HUANG Peiduo2

1.广东工业大学 计算机学院,广州 510006

2.广东工业大学 物理与光电工程学院,广州 510006

1.School of Computer,Guangdong University of Technology,Guangzhou 510006,China

2.School of Physics&Optoelectronic Engineering,Guangdong University of Technology,Guangzhou 510006,China

1 引言

室内定位技术在自动化生产活动中越来越重要[1]。目前自动运输车AGV(Automated Guided Vehicle)的室内定位导航方式有惯性定位导航、循线定位导航、卫星定位导航、超声波定位导航、红外定位导航、激光测距、WiFi局域网、蓝牙技术、RFID技术、ZigBee技术、UWB技术、特殊光定位技术以及视觉定位技术等[2-6]。但上述的定位技术存在不足,如灵活性差、适用性差、不稳定等问题。

基于视觉定位技术具有灵活性高、精度高,无需场景辅助设施的优势。其中全局视觉定位技术具有柔性大、灵活性高,用户可随时用软件定义自动运输车的运输路径[7-8]。文献[9]提出一种基于全局视觉定位导引自动运输车方案,采用半径定比例的双红球作为自动运输车的特定标志物。上位机通过识别双球位置计算出自动运输车的物理空间位置以及姿态方向角。但是并未解决问题:(1)双球标志物被遮挡无法计算出自动运输车的位置问题;(2)在大范围的作业区域,需要多个摄像头扩展物理空间视场协同引导AGV问题。

针对上述存在的两个问题,提出一种多目摄像头全局视觉协同定位引导自动运输进行路径规划导航方案。采用红色单球半径15.0 cm作为车体标志以及MPU6050陀螺仪实现惯性导航,多个摄像头协同可以实现物理视场空间的扩展,适用于工厂大范围的定位。球体标志物的好处是无论在视场中的任意角度看都是一个圆,具有不变性。使用红色单球做为标志物替代双球具有快速识别、抗干扰性强以及实时性高的优势。PC机识别出红色单球的位置并发送给下位机自动运输车,AGV根据当前的坐标位置和运输终点位置运输。同时安装在自动运输车上的陀螺仪传感器可以感知车的二维方向和加速度姿态,当标志物被遮挡的时候,自动运输车利用陀螺仪惯性导航,走出遮挡区域。方案具有适用性强、定位范围大、灵活性高、稳定性好的优势,切合实际工厂自动运输车的定位作业需求。

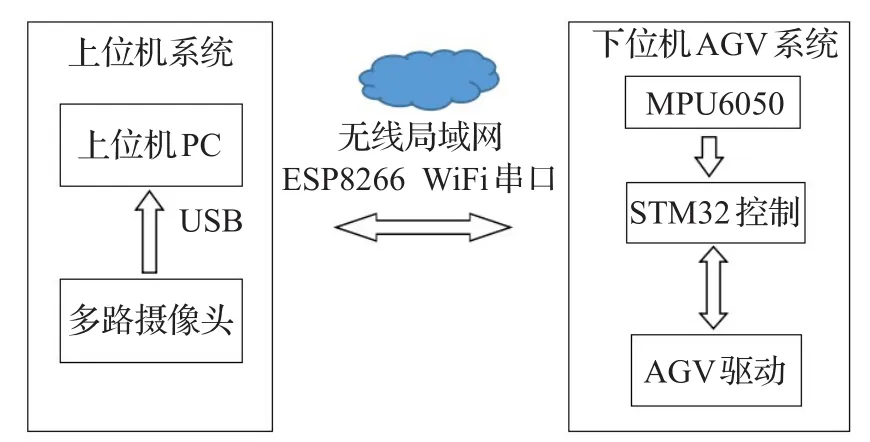

2 多目视觉定位协同系统结构

定位系统总设计结构如图1所示,在室内安装多个摄像头,各路视频流通过USB传输给上位机PC。上位机系统识别出AGV物理位置坐标后,通过无线WiFi发送给下位机ESP8266串口WiFi模块。自动运输车通过自身当前的坐标以及要求运输终点目的位置信息计算出路径。

图1 定位系统总设计结构

3 上位机系统设计

上位机系统由OpenCV和QT平台进行联合开发设计。可以实时感知运输车的位置信息并发送运输车位置坐标,支持多点路径规划导航且用户可以灵活地更改导航路径。系统由以下三部分组成:红色球体标志物识别、空间视场几何投影映射关系的建模以及多摄像头协同视场扩展计算。

3.1 标志物识别

在上位机的程序设计中,红色球体标志物的识别是整个过程最基本的一步[10]。识别算法设计如下:

步骤1标定测得每个镜头的畸变参数,然后对输入的图像进行仿射变换得到矫正图像[11]。

步骤2将采集的RGB图像转换为HSV颜色空间,由于HSV颜色空间色度和亮度通道是单独分开的,因而对光照的敏感度低于RGB图像[12]。

步骤3分割经矫正图像的红色区域。HSV红色约束域为:色度H∈[0 ,10]⋃[1 56,180],饱和度S∈[4 6,255],亮度V∈[4 3,255]。

步骤4对分割后的图像做数学形态学滤波。采用数学形态学的腐蚀和膨胀操作来滤波,以增加边沿圆滑性,同时消除图像上孤立点。

步骤5采用Canny算子提取出边沿轮廓图像,该方法在抗噪声和精确边沿提取上有出色的表现[13]。

步骤6滤波之后创建面积大小以及圆形度约束条件。通过球体大小,确定面积约束范围S'∈[500,10 000],圆形度C∈[0.8,1.0],识别率最高。

上述公式(1),其中P表示物体的周长,S′表示面积。圆形度的值越接近1.0表示该图形越接近圆,可用于消除非圆轮廓。

步骤7筛选出满足条件的轮廓并输出目标小球的位置。

球体标志物识别情况如图2识别过程。

图2 识别算法过程

3.2 空间视场建模

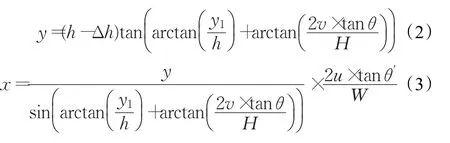

视场建模是建立起图像平面和物理空间坐标之间的映射关系[14],根据小孔成像的原理建立几何投影关系,数学模型如图3所示。

如图3所示区域ABCD为物理空间视场,A′B′C′D′为图像区域,O′为摄像头光心,O作为物理空间坐标系原点,O′G为光轴。H和W分别为图像的高和宽,G′为图像坐标系的原点,取P′(u,v)为图像上坐标,则映射到物理空间为P(x,y)坐标。由映射模型可得关系式:

图3 视场映射模型

θ′、h、∆h、y1、θ 分别表示为水平视场角的半角、摄像头距离地面高度、目标物中心距离地面高度、光轴与地面交点G到O点的距离、垂直视场角的半角,这些参数是可测量的。

3.3 多目摄像头协同导引AGV

3.3.1 两目视场扩展结构及步骤

图4是以两个摄像头物理视场扩建为例的模型,规划运输路径如图中1-2-3-4-5-6。在室内安装两个摄像头,并让它们之间存在一定的视场交叉域。通过3步实现视场扩建:

步骤1计算出2号摄像头的坐标系和1号基准摄像头坐标系的夹角θ;

步骤22号摄像头坐标系通过θ校正为跟基准坐标的方向一致的坐标系,再计算出2号摄像头相对基准摄像头的位置偏移量(△x,△y);

步骤3后面2号摄像头的坐标位置同样经过θ校正再加上偏移量就是扩展的坐标位置。

图4 两目视场扩建模型

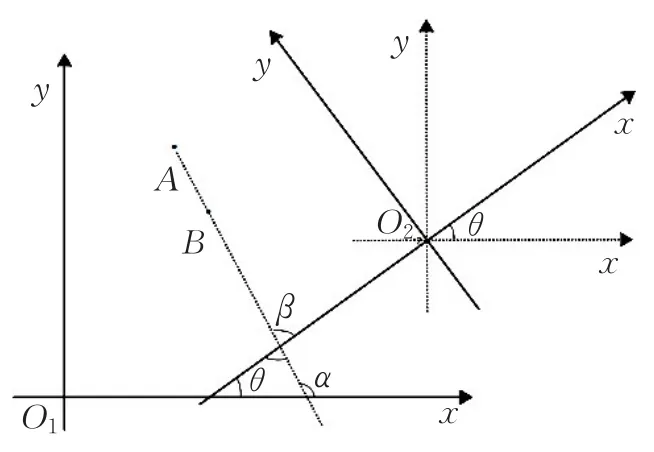

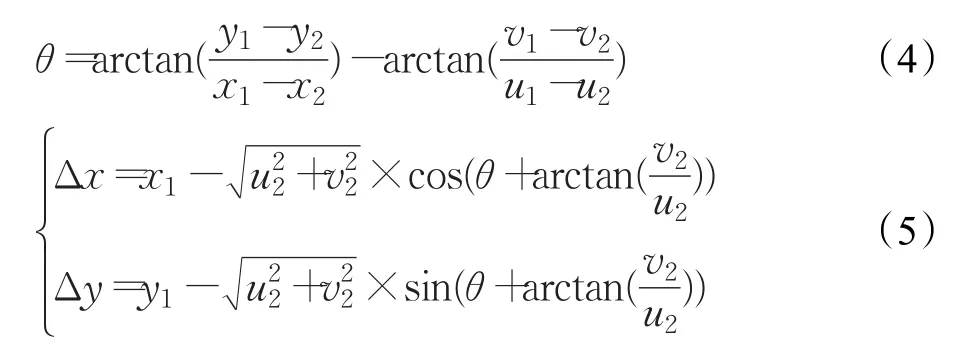

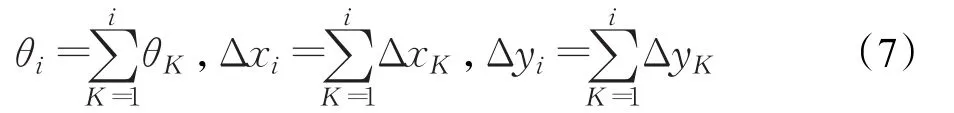

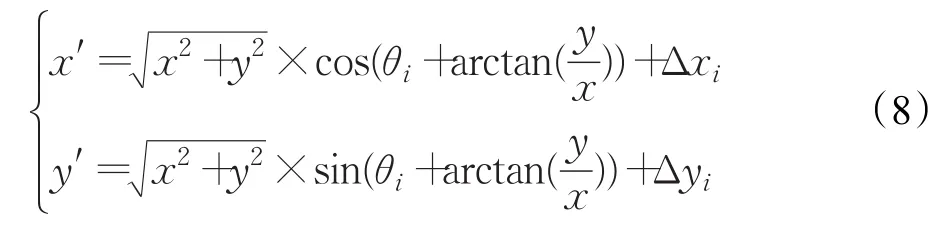

3.3.2 两目视场扩展原理

设1号基准摄像头坐标原点为O1,2号摄像头坐标原点为O2,在视场交叉域中任取两个点A和B,视场1摄像头计算出的物理空间坐标为A(x1,y1),B(x2,y2),视场2摄像头计算出的物理空间坐标为A(u1,v1),B(u2,v2)。其中α、β分别为AB线与1号和2号摄像头坐标轴的正切角,有θ=β-α,几何关系如图5所示。

图5 视场扩展数学建模

通过图5的几何关系,计算得到两坐标轴夹角θ,以及2号摄像头偏移量(△x,△y)。

取2号摄像头中任一点坐标为C(u,v),故其扩展后坐标为 C′(u′,v′),其中有:

3.3.3 多目视场扩展

多目视场扩建是在两目视场扩展理论基础上,进行两两视场扩展进而实现多目视场引导自动运输车。设1号摄像头为基准摄像头,2号摄像头相对1号测得扩展参数,用向量 P1(θ1,Δx1,Δy1)表示;K∈1,2,…,Z ,第K号摄像头相对K-1号摄像头的扩展参数向量为PK-1(θK-1,ΔxK-1,ΔyK-1),则第 i号摄像头相对1号基准摄像头测得的扩展参数为向量 Qi(θi,Δxi,Δyi),i∈1,2,…,K ,其中

故第i号摄像头中任取一点Ji(x,y)经参数向量Qi(θi,Δxi,Δyi)计算得扩展坐标 J′i(x′,y′)。

4 下位机AGV导航控制

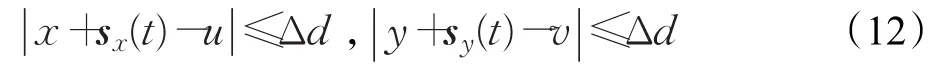

下位机采用一套分时双闭环反馈机制对运输车进行控制。设运输车当前位置坐标为E(x,y),到达点位置坐标F(u,v),控制停止误差为△d。

(1)当球体标志物没被遮挡时,通过比较车当前位置和目标点位置的X方向和Y的反馈差量是否同时在设定的△d范围内,如果是则表示到达目的地,判断条件如下:

(2)当标志物被遮挡时,运输车将失去上位机实时的位置坐标,此时利用MPU6050的加速度传感器计算自身当前位置,从而实现惯性导航[15]。设遮挡t=0时刻,到解除遮挡t=T整个过程X方向和Y方向瞬时加速度分别为ax(t)和ay(t),速度为vx(t)和vy(t),位移为sx(t)和 sy(t)。

X方向和Y方向瞬时速度为:

X方向和Y方向位移为:

故判断到达目标点条件如下:

根据差量利用PID技术控制小车的运动状态[16],算法控制如图6导航控制流程图。

图6 下位机导航控制

5 引导实验

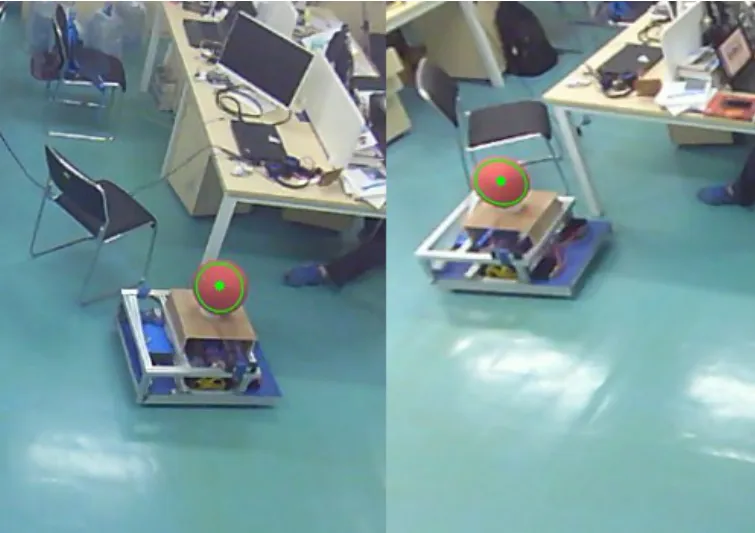

本次实验环境在范围比较大的工作室环境,单目定位视场范围大致为5.0 m×5.0 m。实验环境如图7所示。

实验前参数:

(1)摄像头垂直视角 2 θ=70°,水平视角 2 θ′=70°;

(2)摄像头分辨率为1 280×720,采集速度30 f/s;

(3)摄像头高度h=285.5 cm,标志物质心距离地面的高度∆h=51.5 cm,摄像头光轴与地面交点G到O点的距离y1=134.6 cm。

图7 实验环境

5.1 单目路径规划导航实验

自动运输车单个摄像头规划路径导航场景,如图8所示。为了模拟标志物被遮挡的情况,在场地中人为地加入了一块比较高的挡板,当AGV从2点运输到3点的时候,过程中车的红色球标志物会被挡住,失去实时坐标靠MPU6050陀螺仪惯性导航行走。并记录运输车到达每一个目标点的坐标情况制表1。

图8 单目路径规划导航

表1 单目路径规划导航 cm

表1表明AGV实际到达坐标跟设定目标点存在有±2.2 cm左右误差,这是因为AGV自身程序设定允许±5.0 cm左右误差,因此该误差属于合理值,也是满足自动运输车定位作业的精度要求。设定±5.0 cm左右误差是为了解决实际运输中超过了目标坐标需要运输车不断调整问题。实验表明设定合理的误差阈值,可以使定位系统更加高效、快速。

5.2 双目协同扩展空间误差分析

将自动运输车以不定距无规律地摆放在两个摄像头交叉视场域中6个不同的位置,两个摄像头分别计算出小车的实际物理空间坐标,制得表2视场扩展误差分析。

表2两目误差分析结果为两个摄像头计算物理空间坐标误差是±3.0 cm,理论上AGV摆放一个位置两个摄像头计算出来的物理空间坐标应该是一致的,但是由于设备的误差、实验参数测量的误差导致视场扩展也存在一定的误差,因而两个视场计算出的坐标就存在一定的误差值。在定位视场宽高5.0 m×5.0 m视场范围内,±3.0 cm的扩展误差是可接受的,可实现正常的规划导航。

表2 双目视场扩展误差分析 cm

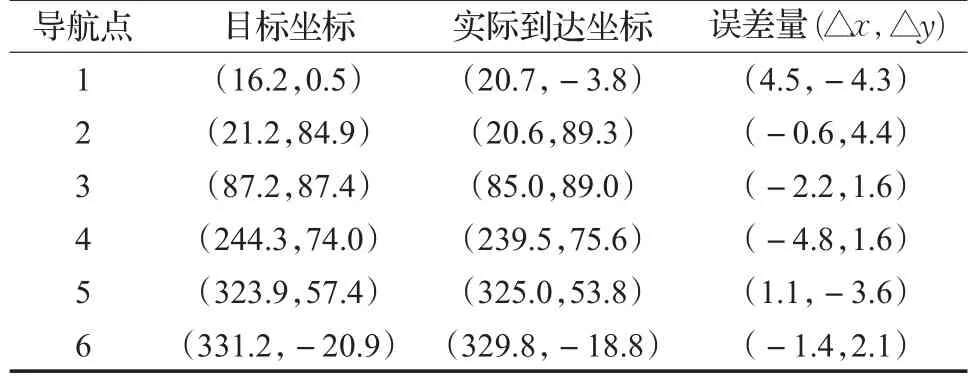

5.3 多目协同路径规划导航实验

以两目扩展导航为实验,测试场景如图9所示。摆放好两个摄像头位置,让两个视场有一定的交叉域,开启上位机的视场校正模式。将AGV车摆放在交叉域中两个不同位置,软件自动计算出扩展参数完成两个视场的物理空间扩展。记录运输车到达每一个目标点的坐标情况制表3。

图9 多目路径规划导航场景

表3 多目路径规划导航cm

AGV成功地依次经过6个目标导航点,最终抵达终点。表3显示导航误差为±5.0 cm,属于设定的误差范围内。两目协同导航的成功验证了视场扩展算法的正确性。如果扩展算法错误,则当运输车从一个视场到达另外一个视场的时候坐标会不一致,这个时候自动车就会重新计算出一条新路径,而这条路径是不可预知的,将会带来一些不可预料问题最终无法实现多目视觉多点规划导航。同时两目视场物理空间的扩建推导理论是可以应用于多目摄像头视场的扩建,且扩展灵活性高,只需要让摄像头之间有一定交叉域就可以实现多目协同导引AGV运输作业,从而实现大范围导航。

6 结束语

针对目前视觉定位存在的未解决问题,文中提出一种以红色单球为车体标志物的多目视觉协同导引AGV运输车的方案并实验验证。具有以下三方面的特点:(1)采用单球代替双球标志物,具有识别速度快、稳定性高的优势。选择球体标志物的好处是任意视角下看到的都是圆,具有不变性。(2)自动运输车主控导航控制算法采用分时双闭环反馈设计,通过安装MPU6050利用惯性导航解决球体被遮挡情况。(3)多目摄像头视场协同引导自动运输车,摄像头之间通过视场交叉域建立起统一的坐标关系,解决了在宽广的室内环境中需要大范围的定位导航作业。

定位系统支持单点和多点路径规划导航,可灵活更改自动运输车的规划路径,同时通过软件扩展算法可灵活地实现多目视觉定位协同导引自动运输车。最终实验结果表明:单目定位视场范围在5.0 m×5.0 m大小内,计算出的双目物理视场扩展误差为±3.0 cm。无论是单目还是多目视觉的多点路径导航误差都达到±5.0 cm预期内,具有可扩展性好、定位范围大、灵活性高的优势,可应用于工业上复杂的室内环境以及运输作业范围要求大的物理空间场合。接下来继续研究:(1)多车在多目视场中的调度运输导航;(2)自动运输车避障功能。

参考文献:

[1]赵锐,钟榜,朱祖礼,等.室内定位技术及应用综述[J].电子科技,2014(3):154-157.

[2]Ye X,Wang Y,Hu W,et al.WarpMap:Accurate and efficient indoor location by dynamic warping in sequencetype radio-map[C]//2016 13th Annual IEEE Int Conf on Sensing,Communication,and Networking,2016:1-9.

[3]Xu D,Han L,Tan M,et al.Ceiling-based visual positioning for an indoor mobile robot with monocular vision[J].IEEE Transactions on Industrial Electronics,2009,56(5):1617-1628.

[4]Takahashi Y.Mobile robot self localization based on multiantenna-RFID reader and IC tag textile[C]//IEEE Workshop on Advanced Robotics and Its Social Impacts,Tokyo,2013:106-112.

[5]Huang H,Yang A,Feng L,et al.Indoor positioning method based on metameric white light sources and subpixels on a color image sensor[J].IEEE Photonics Journal,2016,8(6):1-10.

[6]李金超.基于视觉的自动寻迹AGV控制系统研究[D].河北秦皇岛:燕山大学,2014.

[7]李君.全局视觉导航AGV控制原理与技术的研究[D].武汉:武汉理工大学,2007.

[8]易弘.AGV视觉导航研究[J].国外电子测量技术,2010(2):44-46.

[9]林剑冰,苏成悦,郑俊波,等.机器视觉导引的室内自动运输车定位系统[J].机械科学与技术,2015(11):1675-1681.

[10]Vaishnavi D,Subashini T S.Recognizing image splicing forgeries using histogram features[C]//Mec Int Conf on Big Data&Smart City,2016:1-4.

[11]涂波,刘璐,刘一会,等.一种扩展小孔成像模型的鱼眼相机矫正与标定方法[J].自动化学报,2014(4):653-659.

[12]赵红雨,吴乐华,史燕军,等.基于HSV颜色空间的运动目标检测方法[J].现代电子技术,2013(12):45-48.

[13]赵同刚,陈迅.基于监督学习的Canny图像边缘检测改进算法研究[J].半导体光电,2016(5):731-734.

[14]王文波.基于单目视觉的实时测距方法研究[D].辽宁大连:大连理工大学,2014.

[15]王旭凤.基于惯性导航的室内定位系统的研究[D].长春:吉林大学,2015.

[16]张奎,雷勇.无刷直流电机智能PID控制系统建模与仿真[J].测控技术,2015(4):81-84.