融合元胞自动机和特征加权花卉图像分类方法

李哲妍,张素兰,胡立华,张继福

(1.太原科技大学计算机科学与技术学院,太原030024)

观赏价值、经济价值、药用价值以及趋于成熟的栽培技术一直是人类对花卉研究的热门领域,为了更好地识别和利用花卉资源,花卉分类就成为一项具有研究价值的基础工作。目前关于花卉图像分类的研究还比较少,主要研究成果来自于牛津大学的视觉几何小组(Visual Geometry Group),其方法是使用基于马尔科夫随机场代价函数的分割算法[1]或者基于同类花卉形状协同分布的分割算法[2]将花卉图像进行分割,并在前景图的基础上提取图像特征进而分类。这些分割算法有的需要对图像库中每一类花卉的样本进行前景和背景标注,有的需要对每类花卉特征单独进行训练,这样对图像进行标注或单独训练是需要耗费大量时间。Mabrouk A B等[3]提出了一种在Lab颜色空间使用OTSU最大类间方差算法对花卉图像进行前背景分割,由于OTSU算法对噪音和目标大小十分敏感,因而分割效果并不好,进而会影响图像的分类精度。鉴于存在以上问题,本文将元胞自动机引入花卉图像主体区域提取中。元胞自动机最先是由冯·诺依曼为模拟生命系统所具有的自繁殖功能而提出的[4],近年来,其在图像处理中也体现出了独到的优势,如图像滤波或去噪、平滑、边缘检测和图像分割等,都能用元胞自动机模型进行研究。Qin Y等[5]提出了一种基于元胞自动机的图像显著性检测方法,该方法可以使定义的元胞在离散的时间段内根据局部规则进行迭代、演化,利用元胞间的相互作用以及局部更新规则自动形成图像的显著性图,从而在目标与背景之间自然地形成一条明显的分界线。因此,可将元胞自动机显著性检测方法引入到花卉图像的分割步骤中,从而辅助去提取花卉图像主体区域,减少现有花卉区域分割算法对分类精度的影响。

目前,许多研究者一般将多种特征融合在一起用于提高图像分类的精度,然而传统的特征融合方式通常是在特征表示阶段,同等对待每个特征(即将每个特征的权重都默认为1),即简单地将多个特征串联,以形成新的高维特征,然而并非每个特征对图像分类的贡献都一样,所以不能给它们赋予相同的权重。为有效提高花卉图像分类的性能,本文给出一种融合元胞自动机和加权特征的花卉图像分类方法。首先,通过元胞自动机辅助性地将花卉的主体区域从复杂背景中提取出来。其次,分别对提取的花卉主体区域的颜色特征和局部特征赋予不同的权重,并将其拼接作为融合特征,然后利用SVM进行分类。最后,在花卉图像库上进行了实验,取得了较好的分类效果,验证了所提方法的有效性。

1 元胞自动机与花卉图像

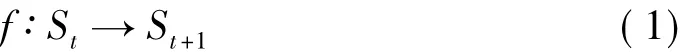

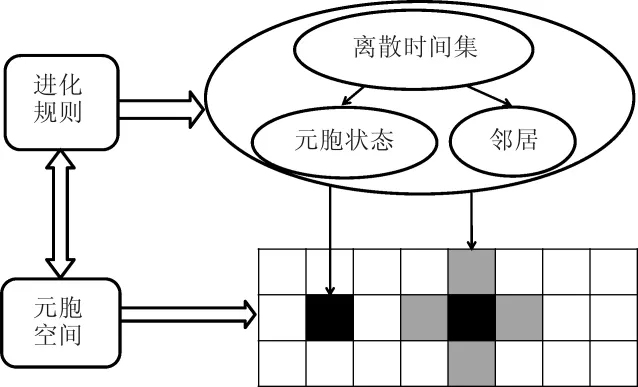

元胞自动机是一个时空离散、状态离散的并行数学模型,它由元胞空间、元胞状态、邻居及进化规则四部分组成,如图1所示。元胞自动机定义为四元组(Zd,S,N,f),其中Zd为d维欧氏空间;S是有限状态集合;N为中心元胞的邻域,N ={x1,x2,……,xi,……,xn},xi为相邻元胞相对于中心元胞的位置;f是元胞状态演变时所遵循的进化规则,如式(1):

式(1)中,St表示所有元胞在t时刻的状态集合,而St+1则表示所有元胞遵循同步更新规则后在t+1时刻的状态集合。

图1 元胞自动机的组成Fig.1 The composition of cellular automaton

元胞自动机在某个时刻的状态是由所有元胞相互作用而形成的,每个元胞下一时刻的变化由元胞本身状态及邻居状态共同决定,这些特点可被应用于花卉图像处理中。因此,将元胞自动机进行相应调整就可得到一个提取花卉主体区域的元胞自动机模型。该模型如下:

1)元胞空间:在这里,元胞空间的几何划分是采用SLIC算法[6],将一幅图分割成N个小的超像素点而不是使用规则的方形格子结构,可使用像素点的平均颜色特征和平均坐标来描述每一个超像素点。如图2所示。

图2 SLIC算法超像素区域划分图Fig.2 SLIC superpixel zoning image

2)状态:状态一般定义为{S1,S2,……,Si,……,Sn}离散化的整数形式,而在文中用每个超像素点的显著值作为它的状态,这个值是0到1之间的连续值。

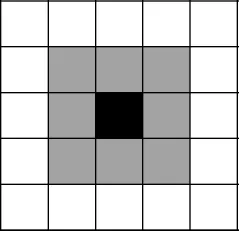

3)邻居:一个元胞在下一时刻的状态由它此刻的状态和邻居元胞的状态共同决定,因此,首先需定义邻居概念。如图3,定义在二维元胞自动机中的黑色方块为中心元胞,灰色方块为其邻居。

图3 元胞自动机的邻居定义Fig.3 Neighbor definition of cellular automaton

为此,广泛的定义了邻居概念,即一个元胞的邻居包括与它相邻的元胞以及和它相邻的邻居共有同一边缘的元胞。如图4所示(蓝色区域是中心元胞,绿色区域是与中心元胞相邻的元胞,红色区域是和同中心元胞相邻的邻居共有同一边缘的元胞)。

图4 元胞邻居示意图Fig.4 Cellular neighbor schematic image

4)进化规则:即一个状态转移函数,其功能是根据当前元胞及其邻居状态确定下一时刻该元胞的状态,并通过元胞间的相互作用动态的进行更新演化。因此,模型设计的关键在于进化规则的设计,通过构建影响因子矩阵和置信度矩阵[5]来平衡不同元胞对每个元胞下一状态的影响力,所有元胞的显著值会依据提出的更新规则同步更新,有限次更新之后可得到一幅目标与背景有明显分界的显著图。

超像素点之间的相似性是由CIE LAB色彩空间中所定义的距离来衡量的。通过定义超像素点i对于超像素点j的影响因子fij来建立影响因子矩阵F=[fij]N × N,如式(2)所示:

其中||ci,cj||代表CIE LAB色彩空间中超像素点i和j之间的欧氏距离。NB(i)是元胞i的邻居的集合。

由于每个元胞下一时刻的状态是由它自己和它的邻居当前时刻的状态共同决定,因此需要平衡这两个关键部分的因素。如果一个超像素点和它的邻居在颜色空间中有较大差异时,则它下一时刻的状态将主要由它自己当前时刻的状态所决定。如果一个元胞和它的邻居在颜色空间上很相似,那么它很可能受周围邻居的影响。因此,可以建立一个置信度矩阵C=diag{c1,c2,…,cN},去更好地促进所有元胞的更新迭代。置信度为式(3):

在元胞自动机模型中,所有的元胞都是根据更新原则同步更新它们的状态。给出影响因子矩阵和置信度矩阵后,同步更新原则定义为式(4):

其中I是单位矩阵,C和F分别是置信度矩阵和影响因子矩阵。

2 方法

花卉图像的复杂背景对图像分类而言并无多大作用,有时甚至造成干扰。因此,进行花卉图像分类的关键一步就是要将花卉的主体区域从复杂背景中提取出来,在此基础上对花卉图像进行特征提取。其具体的思想框架如图5所示。

图5 花卉图像分类思想框架Fig.5 Flower image classification thought framework

2.1 基于元胞自动机的花卉主体区域提取

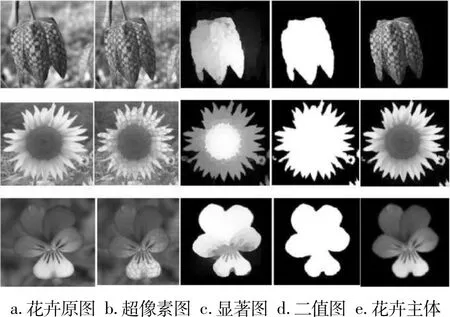

针对图6a中的花卉原图,可应用元胞自动机来提取花卉图像的主体区域。首先,应用SLIC算法将一幅花卉原图分割成N个小的超像素点(如图6b),并通过和分类的边缘种子进行颜色空间和距离空间的对比得到一幅基于背景的显著图。其次,根据相应的规则[5],在基于背景的显著图上使用元胞自动机的新型传播机制得到优化的显著图(如图6c).然后,采用最大类间方差法找到该显著图的一个合适的阈值,这个阈值在[0,1]范围内,将该阈值传递给im2bw完成灰度图转换为二值图的操作(如图6d).最后,在花卉原图的基础上将二值图的白色部分进行填充得到花卉主体区域(如图6e),进而可提取花卉主体区域的图像特征,应用SVM实现花卉图像的分类。

图6 花卉主体区域提取示意图Fig.6 The flower body area extraction schematic image

2.2 基于加权特征融合的SVM分类算法

颜色特征具有对图像内容的描述性较强、易于提取等优点。因为花卉本身就具有色彩鲜明的特点,为了最大程度地表达花卉图像的特征,并且有效地节约存储空间,需要按照16:4:4的比例[7]对H、S、V 进行颜色空间的非均匀量化[8]。此外,SIFT局部特征对旋转、尺度缩放等具有不变性,并且对特征点的个数没有要求,还可以很方便的与其他特征进行融合,所以在同类描述子中SIFT局部特征已被证实具有较强的鲁棒性[9-10]。本文提取这两种图像特征并使用支持向量机[11-12](SVM)解决花卉图像分类问题。传统的特征表示方法是将多个特征直接拼接成单一特征向量来表示一幅花卉图像,这种方法的缺陷在于没有区分不同特征的重要程度。在图像分类中,由于提取的颜色、形状等特征所起的作用并非完全相同,有的特征对分类的贡献多,有的特征对分类的贡献少,所以不能为它们赋予相同权重。在为特征加权的过程中,可为每个特征赋予一个0~1之间的权重,若某个特征对分类的贡献多,则赋予较大的权重,贡献少,则赋予较小的权重。在此,可将不同的特征赋予不同的权重之后进行拼接,如式(5)所示:

其中,T代表拼接后的花卉特征,T1和T2分别代表颜色和局部特征,α和β分别为颜色和局部特征的权重。在式(5)中,让α、β分别取0~1之间的10 个小数(0.1,0.2,...,1.0),用加权融合后的特征描述每一幅花卉图像,并分别求出对应的分类精度。

3实验结果及分析

为验证本文所提方法的有效性,实验选取了17-flower数据集中的13类花卉(依照文献[3],由于Snowdrops,LilyValleys,Cowslips 和 Bluebells 四类花卉的分割效果不好,在此也使用了其中的13种花卉),并随机抽取每个类别中的30幅图片作为训练集,15幅图片作为测试集。一共设置了三组不同的实验图像集,最终的实验结果取三组平均值。在这里,把局部特征SIFT的权重表示为α(0≤α≤1),颜色特征Color的权重表示为β(0≤β≤1).

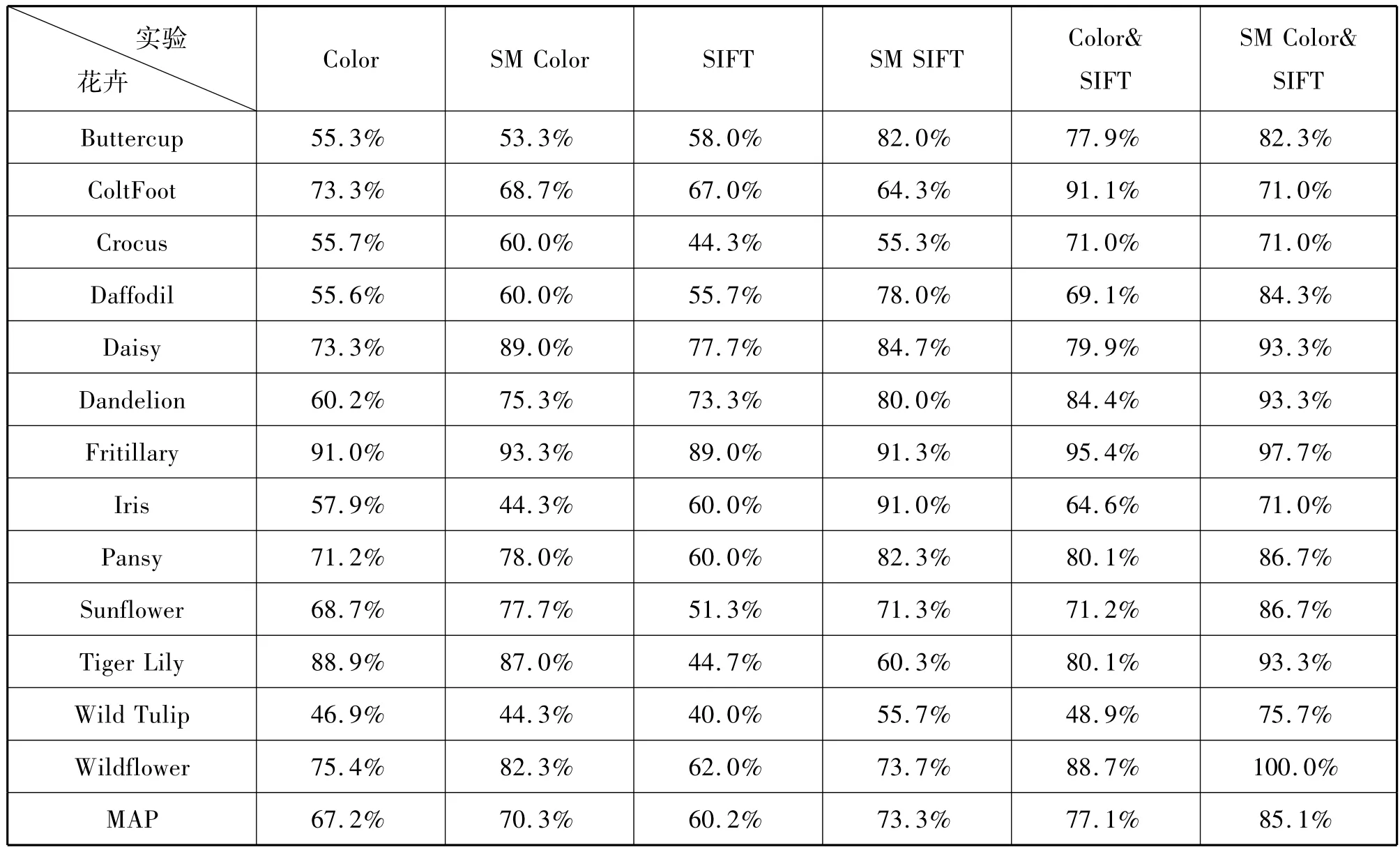

首先设计了6组实验来对比花卉原图与基于元胞自动机提取的花卉主体区域在相同特征下的平均分类精度,分别为:1、基于原图颜色特征(Color);2、基于花卉主体区域的颜色特征(SM Color);3、基于原图SIFT特征(SIFT);4、基于花卉主体区域的SIFT特征(SM SIFT);5、基于原图的颜色特征和SIFT特征(Color&SIFT);6、基于花卉主体区域的颜色特征和SIFT特征(SM Color&SIFT);具体每个花卉类别及整体平均精度如表1所示。

从表1可见,利用元胞自动机提取的花卉主体区域能够规避复杂背景,而使分类精度提高。特别是在颜色与局部特征的组合上更为明显,平均精度MAP(Mean Average Precision)达到了85.1%,明显高于单独使用颜色或SIFT特征进行分类的结果,说明引入元胞自动机进行花卉图像主体区域提取能够提高图像的分类精度,在特征组合方面的分类精度也要优于单独使用某个特征的分类结果。

为区分不同特征的重要程度,按照本文方法,分别给每个特征赋予一个0~1之间的权重。将局部特征SIFT的权重表示为α(0≤α≤1),颜色特征Color的权重表示为β(0≤β≤1),用加权融合后的特征描述每一幅花卉图像,从而得到花卉图像的平均分类精度,如表2所示。

表1 原图与花卉主体图在相同特征下分类的对比实验结果Tab.1 Comparisons of original images and flower body images under the same feature

表2 不同特征权重组合下Oxford-13 flower的分类实验结果对比Tab.2 Comparisons of Oxford-13 flower images under different weighted feature fusion

从表2可以看出,当SIFT特征权重α固定为某个值时,花卉图像分类精度随着颜色特征权重β的逐渐增大而减小;当颜色特征权重β固定为某个值时,花卉图像分类精度随着SIFT特征权重α的逐渐增大而呈现增大的趋势,当α取0.9或1.0、β取0.1或0.2时,花卉图像分类精度达到86.7%.通过实验还可以观察到,表格左下角的分类精度明显高于右上角的值,即处于表格反对角线上的精度值随着权重α的增大、β的减小而逐渐增大,而对角线上的精度值全部为85.1%,与α∶β =1.0∶1.0时的情况一样。因此,当SIFT特征权重的取值较大、颜色特征的取值较小时,基于特征加权融合带来的花卉图像分类准确率提高相当明显。同时也说明在传统的特征融合方式中将每个特征的权重都默认为1的方式并不可取,即花卉图像特征对分类精度的贡献度并不相同。

另外,上述所得结论,与13类花卉图像数据集的 特 点 紧 密 相 关。Buttercup、ColtFoot、Daffodil、Dandelion、Sunflower和WildTulip六种花卉花色均为黄色,即实验集中约有46.1% 的图像为黄色,花色较为单一,若单纯地从Color颜色角度分析,将其作为图像分类特征的区分度并不明显,而除ColtFoot与Dandelion两类花卉从形状特性上来看区分度并不大外,其余11类花卉都有各自较为鲜明的形状区分特性,因此,为了提高花卉图像分类精度,在进行Oxford-13 flower图像数据集的多类分类实验中,相对于简单进行拼接的特征融合而言,增强SIFT特征权重、弱化颜色特征权重将达到更优的分类效果。

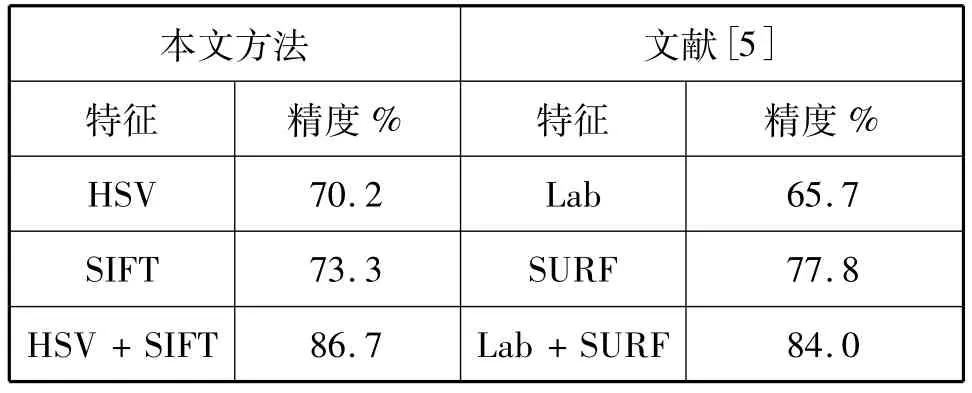

为验证本文方法的有效性,表3列举了在相同实验设置下与文献[3]作对比的结果。文献[3]中,基于前景区域SIFT特征和HSV颜色特征的准确率为84.0%,而本文方法中基于花卉主体区域的HSV量化直方图和SIFT特征的分类准确率为86.7%,可见本文方法是具有一定优势的。

表3 本文方法与文献[3]方法的对比Tab.3 This method compared with the method of literature[3]

4 结束语

利用元胞自动机将花卉的主体区域从复杂背景中提取出来,并对其颜色特征和局部特征进行加权融合,然后利用SVM实现了花卉图像分类,实验表明了该方法可有效地改善花卉图像分类的效果。下一步论文的工作将准备基于花卉主体区域提取更多图像特征,进而探寻描述其最优的特征组合并更好地应用于花卉图像分类中。

参考文献:

[1] NILSBACK M E,ZISSERMAN A.Delving into the Whorl of Flower Segmentation.[C]//Proceedings of the 18thBritish Machine Vision Conference on Image and Vision Computing.Uk:ElSEVIER,2010(28):1049-1062.

[2] YUNING C,LEMPITSKY V,ZISSERMAN A.BiCoS:A Bi-level co-segmentation method for image classification[C]//Proceedings of International Conference on Computer Vision.Washington D C: IEEE Computer Society Press,2011:2579-2586.

[3] MABROUK A B,NAJJAR A,ZAGROUBA E.Image flower recognition based on a new method for color feature extraction[C]//.Proceedings of International Conference on Computer Vision Theory and Applications.Washington D C:IEEE Computer Society Press,2014:201-206.

[4] VON N J.The general and logical theory of automata.[J].Papers of John Von Neumann on Computing & Computer Theory,1951:1-41.

[5] QIN Y,LU H C,XU Y Q,et al.Saliency detection via Cellular Automata[J].2015 IEEE Conference on Computer Vision and Pattern Recognition,2015:110-119.

[6] ZHANG X,CAHILL N D.SLIC superpixels for efficient graph-based dimensionality reduction of hyperspectral imagery[C]//SPIE Defense+Security.International Society for Optics and Photonics,2015.

[7] 吴会宁.基于内容的花卉图像检索算法研究[D].扬州:扬州大学,2014.

[8] 吴会宁,胡学龙,陆慧敏.基于信息熵和分块颜色矩的图像检索[J].扬州大学学报:自然科学版,2014(3):50-53.

[9] ZHANG S,ZHANG J,GUO P,et al.A FWCL-based method for visual vocabulary formation[J].Multimedia Tools &Applications,2016(75):647-665.

[10] MIKOLAJCZYK K,SCHMID C.Scale& affine invariant interest point detectors[J].International Journal of Computer Vision,2004,60(1):63-86.

[11] 张瑞杰,魏福山.结合Fisher判别分析和稀疏编码的图像场景分类[J].计算机辅助设计与图形学学报,2015,27(5):808-814.

[12] 陈开志,乐承沛,钟尚平.融合距离度量学习和 SVM的图像匹配算法[J].小型微型计算机系统,2015,36(6):1353-1357.