一种协同显著目标自动分割方法

王 超,李 静,李东民

(南京航空航天大学 计算机科学与技术学院,南京 211106) E-mail :jingli@nuaa.edu.cn

1 引 言

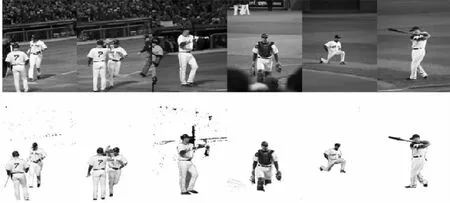

显著目标检测是采用计算机视觉方法在一幅图像中通过抑制图像中冗余繁杂的背景信息能够快速准确的提取出人们感兴趣目标的技术.协同显著目标检测[1]指的是在多幅图像中提取相似或共有的目标,根据图片输入的数量,协同显著检测可以分为两幅和多幅两类.协同显著目标检测在协同分割、目标识别与跟踪、联合目标发现等领域具有广泛的应用,成为图像处理领域的研究热点.单幅图像的显著目标研究不能完全符合人类对图像的认知,协同显著目标检测可以从多幅图像或动态视频中寻找一个或多个相似的目标,与人类对图像的理解相类似,更好的适应人类视觉注意机制,结合协同显著性检测方法可以对多幅图像进行显著性区域有效提取.协同分割[2](Co-segmentation)指的是在没有额外图像标签信息的前提下,在多幅图像中分割相同或相似的目标.图1给出一个协同显著目标分割示例,原图中的棒球选手作为协同显著目标的被分割出来.

当图像的前景与背景区分度较大时,通过单幅显著性目标检测算法就可以获得很好的检测效果,但是在面对多幅图像且图像背景复杂时,由于只在单幅图像范围内计算显著性,不考虑图像之间的相关性对目标的影响,生成的显著图中会不恰当地高亮图像背景.Fu等[3]提出了一种基于聚类的协同显著性检测算法,首先使用CIE LAB颜色和Gabor滤波表示每个像素,经过K-means聚类后,进一步提取图像簇间的对比度线索、空间位置线索和对应线索,最后对三者进行融合生成协同显著性映射图.Zhu等[4]基于局部特征和全局特征进行改进,提出了一种基于线性聚类的显著性检测模型,可以更准确的检测出显著性区域.Du等[5]提出了基于随机森林的非监督协同显著性检测方法,主要应用于检测大规模的图像集.Feng等[6]提出了基于低秩多尺度融合的显著性与协同显著性检测方法..Huang等[7]人充分考虑单一尺度超像素分割不适用于在复杂图像中捕捉显著性目标内部结构的特点,构造了多尺度超像素金字塔结构,通过低秩分析联合检测显著性目标的方法,并使用协同混合高斯模型先验知识进行多幅图像协同显著性检测.YU[8]等提出了一种基于相似底层特征的优化分割方法,该方法对图像数据的变化具有很强的鲁棒性和适应性.Meng等[9]人提出基于目标层次分割技术的分割方法,该方法利用最短路径算法从每个候选区域中确定最终的目标结果.Li等[10]人提出了一种基于显著性模型的目标分割算法,该方法利用显著性检测的灰度图近似获取目标区域,但其结果决定于显著图的准确性.Chen等[11]在超像素分块的基础上,结合标签匹配方法指导目标分割,但运行时间比较长且对图像数据的特点具有一定的要求,稳定性不佳.Liu等[12]人提出了一种基于分层分割的协同显著性检测模型,分别从细分割和粗分割的角度出发确定区域间的相似性和目标的边缘.Zhang等[13]人提出了一种基于图像内显著性先验迁移和图像间显著性深度信息挖掘相结合的协同显著性检测方法.Joulin等[14]人发现当先验知识不足或目标区域大小不一致的时,分割的性能明显下降提出了新的优化方法.

图1 协同显著目标分割示例Fig.1 An example of co-saliency object segmentation

然而,现有的交互式分割方法需要用户进行有限步骤的交互,获取图像中存在的先验信息,才能对目标进行准确分割,本文提出了一种基于协同显著性检测的多阶段协同目标的自动分割方法,第一阶段进行协同显著性检测,第二阶段进行星形图割和基于高斯模型的自动分割,第三阶段通过主动轮廓方法优化细分割结果.通过仿真实验在CPair[15],iCoSeg[16]、MSRC[17]三个多目标数据集上验证,结果表明该方法具有精确、鲁棒等特性,效率明显得到提升.本文在第二节介绍了基于协同显著性检测的多阶段协同目标分割方法.第三节根据提出的方法分别在两幅、多幅及视频图像集进行协同分割实验,并对结果进行分析.最后总结了本文所做的工作及将来的研究方向.

2 基于协同显著性检测的多阶段协同目标分割

图2给出了基于协同显著检测的多阶段协同目标自动分割方法的框架图,该方法主要包含三个阶段.第一阶段,使用基于sPCA和K-Means聚类的协同显著性目标分割方法,获得多图像的协同显著性目标检测的结果图,第二阶段,利用协同显著性检测的结果和星形图割来指导混合高斯模型拟合前景与背景,再使用GrabCut算法实现自动分割,第三阶段,使用基于显著区域的主动轮廓方法进一步优化分割的结果.

图2 多幅图像协同显著目标分割框架图Fig.2 Framework of multiple image co-saliency segmentation

2.1 基于sPCA和K-Means聚类的快速协同显著性目标检测方法

快速协同显著性目标检测方法主要包含三个步骤:首先对输入图像进行均匀分块,抽取底层Lab和RGB特征构成底层特征矩阵,应用截断幂稀疏主成份分析法分析图像块底层特征矩阵,提取图像块的稀疏主特征;其次,使用K-means聚类算法对图像块进行聚类;最后,通过特征融合将生成的单幅图像显著图和多幅图像显著图进行组合,生成协同显著性图.

2.1.1 图像分块与稀疏特征提取

(1)

Am=(a1,a2…aN)T∈RN×f

(2)

当对多幅图像同时进行处理时,将该组中每一幅图像上提取的图像块底层颜色特征矩阵构建成一个更大的图像块底层颜色特征矩阵A+,如式(3)定义:

A+=(A1,A2…AM)T∈RNM×f

(3)

2.1.2 基于聚类的显著性特征计算

按照输入图像的稀疏特征,通过聚类的方法将具有相似特征的图像块均匀的划分到各自的簇中,得到k个簇中心C={c1,c2,…,ck},令Wc,Wl及Wg分别为对比特征、空间特征及全局特征变量,它们基于簇中心C第k个显著特征值的计算如公式(4)、公式(5)、公式(6)所示.

(4)

(5)

(6)

2.1.3 协同显著图生成

根据上述的基于聚类的显著性特征计算可以得到三张不同的显著图,可通过公式(7)为每一张特征显著图进行权值线性组合[10]形成协同显著图.

(7)

其中N为特征显著图的个数,wi为线性融合的权值,Si对第i个特征显著图对应像素点的显著值,通过特征显著图线性融合获得协同显著图.

2.2 基于高斯混合的分割

利用协同显著性检测的结果指导混合高斯模型拟合图像的前景与背景,首先在原有图割能量函数公式的基础上增加新的能量限制,如公式(8)所示 .

E(f)=Esmooth(f)+γEdata(f)+λVpq(f)

(8)

(9)

通过最小割方法找到最小化能量函数E(f)的星形形状的粗分割图.初始化图像抠图算法trimap T[18],将标记为0的元素作为背景元素,记为集合TB,标记为1的元素作为前景元素,记为集合TU.通过这两个集合来初始化高斯混合模型.利用彩色像素的高斯混合模型来描述图像的区域属性,由区域数据项和边界光滑约束项组成能量函数,使用GrabCut方法进行细分割.首先,在RGB彩色颜色空间,使用Gibbs能量函数,其形式如公式(10)所示.

E(α,k,θ,z)=D(α,k,θ,z)+S(α,z)

(10)

其中D为数据项,S为光滑项,α(α∈[0,1])表示某个像素所在的是前景区域还是背景区域,θ为图像前景和背景的灰度直方图,z为图像灰度值数组z=(z1,…zn…,zN).数据项D定义为公式(11).

(11)

U(αn,kn,θ,zn)=-logπ(αn,kn)-logp(zn|αn,kn,θ),其中π(·)是该高斯模型的样本数在总样本中的权值,p(·)是高斯概率分布.因此,数据项的等价表示如公式(12)所示.

D(αn,k,θ,zn)=-logπ(αn,kn)+0.5logdet∑(αn,kn)+

0.5[zn-μ(αn,kn)]T∑(αn,kn)-1[zn-μ(αn,kn)]

(12)

其中μ(α,k)为高斯模型的均值,∑(α,k)为协方差矩阵,k表示某个像素所归属的某个高斯分量,为混合高斯模型参数.通过这三个参数,得到某像素属于目标与背景的概率,可得到区域能量项,即s-t网络中t-link的权值.而平滑项S使用RGB空间的欧氏距离:

(13)

本论文中γ=1,通过公式(13),可确定n-link的权值,然后通过maxflow/mincut算法进行分割.表1描述了通过最大流计算最小割算法的流程.

表1 最大流计算最小割的算法Table 1 Maximum flow/minimum cut algorithm

2.3 基于符号压力的主动轮廓精确分割

为了进一步改善上述分割结果,解决含有弱边界和灰度不均匀的图像在分割时导致分割结果错误的情况.利用符号压力函数SPF(Signed Pressure Force)函数进行曲线演化,处理一些边界比较模糊的区域,令C为一个演化曲线,且C(s):=[0,1]→R2,SPF的函数定义如下:

(14)

其中u(x,y)为当前检测图像,c1和c2分别为inside(C)和outside(C)均分值,其计算如公式(15)所示.

(15)

H(φ)为Heaviside函数,然后使用拉格朗日方程对演化曲线进行精度评估,如公式(16)所示.

(16)

反复迭代以调整水平评估函数,使得φ=0,通过变分水平集图像分割方法对图像做最后的目标平滑与分割.

图3 多幅图像协同显著性目标精确分割效果图Fig.3 An example of multiple image co-saliency segmentation

图3给出了本文算法对应每个步骤效果的实例图.从该图中可以看出,基于K-means和sPCA的快速协同显著性目标检测可以指导主动分割的过程,并能提高GrabCut算法的执行效率.在面对复杂图像,协同显著性检测效果不佳时,该方法仍然能较好的对前景目标进行分割,表现了较强的鲁棒性和容错性.综合三种不同的分割方法,具有非监督、自动化及快速等特点,且可以比较精确的分割出目标区域,为多图像的分割提供了新的思路.

3 实验仿真与分析

3.1 数据集介绍

标准数据集CPair[15],iCoSeg[16]、MSRC[17]是三个常用的多目标数据集,它们包含了多幅图像和相应的人工标注图.其中Co-saliency-Pairs(CPair)数据集包含105组共210幅图像.iCoSeg包含38组图像的手工标记像素注释,每组有一个共同的前景,共643张图像.MSRC数据集包括32组共831幅图像.本文是针对多目标的检测算法,选择了CPair,iCoSeg、MSRC中具有两个或两个以上目标的图片进行实验.

3.2 评价标准与参数介绍

实验在Intel CoreTMi3-3220处理器,4G内存的硬件环境下进行,操作系统为Microsoft Windows7,实验仿真环境为Matlab,通过显著图的准确率 (Precision)-查全率 (Recall) 曲线(简称 PR 曲线)评价显著性目标检测的效果,用错误率error_rate评价分割效果.假设标准显著图为A,算法检测出来的显著图为S,则查准率和查全率的计算公式如下:

(17)

其中sum(S,A)为显著图S和标准图A中对应像素点值的乘积和,sum(S)和sum(A)分别为显著图和标准图的所有像素点个数之和.根据查准率和查全率,应用一种新的评价指标——F均值,它是查准率和查全率的加权平均值,反应了显著性检测的整体预测精度,如公式(18)所示:

(18)

通过参数β2调整了P和R的比重,通常情况下更看重查准率,β2常设定为0.3.

图像分割的错误率计算如公式(19)所示:

(19)

其中Ne为错误分类的像素点个数,Nall为图像总的像素点个数.

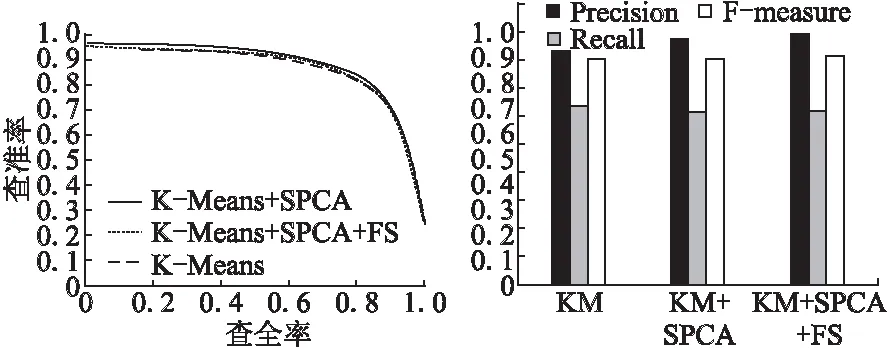

3.3 协同显著性目标检测对比实验

对比只有截断幂稀疏特征提取和截断幂与特征选择两种情况下的查准率与查全率,在CPair和iCoseg数据集上的查准率与查全率曲线对比图分别如图4和图5所示.结果显示,主成分载荷系数的结构化分布具有更好的效果.

图4 CPair数据集下查准率和查全率曲线与具体值对比图Fig.4 Precision-recall curve on CPair dataset

图5 iCoseg数据集下查准率和查全率曲线与具体值对比图Fig.5 Precision-recall curve on iCosegdataset

图6 CPair数据下图像显著性检测具体效果图Fig.6 Salient region visual effect on CPair dataset

图6、图7分别从CPair、iCoseg数据中挑选出部分图片进行效果展示,按照从上到下的排列为:原始图像、标准显著图像、基于聚类显著性检测图像[2]及本文方法图像.

图7 iCoseg数据下图像显著性检测具体效果图Fig.7 Salient region visual effect on iCoseg dataset

3.4 协同显著性目标分割对比

图8展示CPair数据集中成对图像协同显著性目标的分割结果,(1,3为原始图像,2,4为分割结果),可以看出,本文方法在图像较复杂时,能够精确分割出目标,表1给出了该数据集部分图像在不同算法下分割的错误率.

图8 CPair数据集上的协同分割效果图Fig.8 Co-segmentation visual effect on CPair

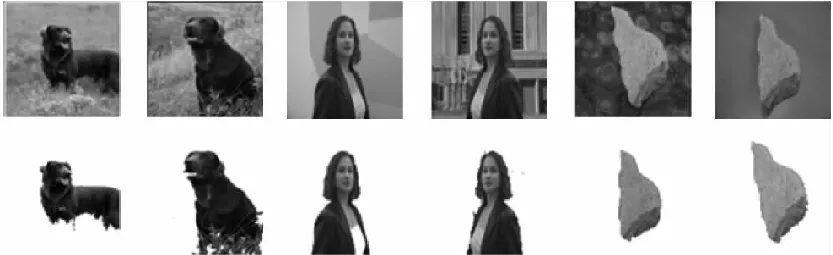

图9展示了iCoSeg和MSRC数据集的协同显著性目标分割结果(第1,3行为原始图像,第2,4行为分割结果),左侧为iCoSeg数据集,右侧为MSRC数据集,此类图像比较复杂,本文的分割结果也略带瑕疵,但是仍然分割出了较完整的显著性目标,第二行组中目标分割有瑕疵,第四行存在分割不满的状况.iCoseg数据集部分分割结果对比如表2所示,MSRC数据集部分分割结果对比如表3所示.

表1 CPair数据集中不同方法分割错误率结果Table 1 Segmentation error rate on CPair dataset

图9 iCoseg和MSRC数据集协同分割结果Fig.9 Co-segmentation visual effect on iCoseg&MSRC

表2 iCoseg数据集中不同方法分割错误率结果表Table 2 Segmentation error rate on iCoseg dataset

表3 MSRC数据集中不同方法分割错误率结果表Table 3 Segmentation error rate on MSRC dataset

图10给出了一个动态视频(第1行为原图,第2行为分割图)的协同目标分割结果, 本文方法在面对不同颜色的同类显著目标时,对目标协同分割具有鲁棒性,弥补了协同显著性检测步骤中对颜色的依赖,改善了显著目标分割的不完整性的问题.

图10 视频数据集协同分割结果图Fig.10 Co-segmentation visual effect on video

4 总 结

针对交互式分割需要通过用户不断进行交互才能获取图像中的先验知识,不能自动分割出图像中感兴趣的目标,本文提出一种基于协同显著性检测的多阶段协同目标自动分割方法.在视觉协同显著性的基础上实现了一种非监督、且具有容错能力的自动化分割方法.通过仿真实验在CPair,iCoSeg、MRSC三个标准数据集上验证了本文方法的有效性.下一步的工作重心在于优化分割效果,能够同时检测分割出图像中的多个协同显著目标.

[1] Ye L,Liu Z,Li J,et al.Cosaliency detection via cosalient object discovery and recovery[J].Signal Processing Letters,IEEE,2015,22(11):2073-2077.

[2] Liang X,Wei Y,Shen X,et al.Reversible recursive instancelevel object segmentation[C].Computer Vision and Pattern Recognition(CVPR),2016:633-641.

[3] Fu H,Cao X,Tu Z.Clusterbased cosaliency detection[J].IEEE Transactions on Image Processing,2013,22(10):3766-3778.

[4] Zhu Ling,Xu Wei-hong,Chen Yuan-tao,et al.Saliency detection model using contrast of local feature and global feature in image[J].Journal of Chinese Computer Systems,2016,37(9):2109-2113.

[5] Du S Z,Chen S F.Detecting cosalient objects in large image sets[J].IEEE Signal Processing Letters,2015,22(2):145-148.

[6] Huang R,Feng W,Sun J Z.Saliency and cosaliency detection by lowrank multiscale fusion[C].In:IEEE International Conference on Multimedia and Expo (ICME),2015.

[7] Huang Z,He F,Cai X,et al.Efficient random saliency map detection[J].Science China Information Sciences,2011,54(6):1207-1217.

[8] Haiping Y U,Fazhi H E,Yiteng PAN,et al.An efficient similarity-based level set model for medical image segmentation[J].Journal of Advanced Mechanical Design,Systems,and Manufacturing,2016,10(8):JAMDSM0100.

[9] Meng F,Li H,Liu G,et al.Object co-segmentation based on shortest path algorithm and saliency model[J].Multimedia,IEEE Transactions on,2012,14(5):1429-1441.

[10] Li H,Ngan K N.A cosaliency model of image pairs[J].IEEE Transactions on Image Processing,2011,20(12):3365-3375.

[11] Chen D J,Liu C Y,Chang L W.Matching based image co-segmentation[C].Information Science,Electronics and Electrical Engineering(ISEEE),2014 International Conference on.IEEE,2014,2:818-822.

[12] Liu Z,Zou W,Li L,et al.Cosaliency detection based on hierarchical segmentation[J].Signal Processing Letters,IEEE,2014,21(1):88-92.

[13] Zhang D,Han J,Han J,et al.Cosaliency detection based on intrasaliency prior transfer and deep intersaliency mining[J].IEEE Transactions on Neural Networks and Learning Systems,2016,27(6):1163-1176.

[14] Joulin A,Bach F,Ponce J.Discriminative clustering for image co-segmentation[C].Computer Vision and Pattern Recognition(CVPR),2010 IEEE Conference on.IEEE,2010:1943-1950.

[15] Ni Bo,He Fa-zhi,Pan Yi-teng,et al.Using shapes correlation for active contour segmentation of uterine fibroid ultrasound images in computer-aided therapy[J].Applied Mathematics-A Journal of Chinese Universities,2016,31(1):37-52.

[16] Batra D,Kowdle A,Parikh D,et al.iCoseg:interactive cosegmentation with intelligent scribble guidance[C].Computer Vision and Pattern Recognitio,2010:3169-3176.

[17] Winn J,Criminisi A,Minka T.Object categorization by learned universal visual dictionary[C].Tenth IEEE International Conference on Computer Vision,IEEE,2005,2:1800-1807.

[18] Juan O,Keriven R.Trimap segmentation for fast and user-friendly alpha matting[J].Lecture Notes in Computer Science,2005,3752:186-197.

附中文参考文献:

[4] 朱 玲,徐蔚鸿,陈沅涛,等.应用图像局部特征和全局特征对比的显著性检测模型[J].小型微型计算机系统,2016,37(9):2109-2113.