空间机械臂抓捕动态目标快速稳定跟踪方法

,,*,,,,

1. 航天飞行动力学技术重点实验室,北京 100094 2. 北京航天飞行控制中心,北京 100094

利用视觉测量系统测量跟踪航天器与目标航天器之间的相对位置与姿态是保证空间任务顺利执行的重要前提。现阶段,国际上常见的光学测量系统主要有:中国“神舟八号”飞船上的CCD光学成像系统[1],美国国家航空航天局“自主交会对接技术验证”(Demonstration of Autonomous Rendezvous Technology,DART)卫星上的高级视频制导系统(Advanced Video Guidance Sensor,AVGS)[2],日本的工程试验卫星-Ⅶ(Engineering Test Satellite-Ⅶ,ETS-Ⅶ)和H-II运载飞船(H-II Transfer Vehicle,HTV)上的接近相机系统[3-4],欧洲航天局自动转移飞行器(Automated Transfer Vehicle,ATV)上的视频测量系统[5]和俄罗斯的光电系统(Optical-Electronic System)[6]等。这些常见的光学测量系统都是通过CCD相机对空间目标上安装的合作靶标进行实时跟踪定位从而完成自主交会对接任务[7]。

目前,人类已经成功实施了数百次自主交会对接任务[8],其中基于视觉的跟踪算法已经取得了较大进展。但是以往的交会对接任务对于对接角度有严格的要求,例如“神舟八号”飞船的对接走廊是以目标飞行器对接轴为中心,半锥角为8°的圆锥[9]。因此,当需要飞行器进行快速交会对接,机械臂执行紧急抓捕时,以往的算法往往难以满足要求。此外,未来空间机械臂自由度多,活动范围大,位置关系灵活,不仅会出现图像形变问题,还会发生目标局部从视场中频繁进出的情况。因此,如何进一步研究视觉跟踪方法解决上述问题,是需要继续深入探讨的内容。

视觉跟踪算法按研究思路可以分为基于学习和基于检测两种类型。基于学习的方法是建立在对目标长距离跟踪学习基础上实现的,计算量大且非常耗时,难以应用于空间目标的跟踪。目前,对空间目标的跟踪主要采用基于检测的方法,通过对序列图像进行检测、识别和相似性比对,实现空间目标实时跟踪。文献[10]提出了一种基于轮廓检测的目标跟踪算法,该算法根据最小二乘原理来进行轮廓拟合,从而识别出目标,解决了自主交会对接近距离段的航天器跟踪问题。文献[11]提出了一种合作靶标快速识别算法,该算法在文献[12]提出的最快圆检测算法的基础上对靶标上的直线特征再次进行判别,进一步提高识别的准确率。文献[13]提出了一种基于稀疏直方图的视觉目标跟踪方法,该方法在粒子滤波目标跟踪框架下,用稀疏直方图来表示目标,将目标模板和候选目标之间的距离作为粒子滤波的观测模型,进而实现序列图像中目标的稳定跟踪。这些算法虽然能够对特定目标进行检测与识别但并未考虑因目标位姿变化而导致的投影形态变化和局部遮挡等问题,在机械臂抓捕空间目标的复杂情况下需要进一步开展相关研究。

本文在CamShift跟踪框架的基础上,针对空间机械臂抓捕的特殊性,提出了一种融合特征选取、模板更新和进出场跟踪策略的跟踪算法。该算法能够进行多目标的连续跟踪,解决目标形态变化引起的跟踪丢失问题,实现对频繁进出视场目标的自适应跟踪。

1 机械臂抓捕过程中的合作目标跟踪算法

1.1 问题描述与算法总体

空间机械臂视觉系统利用末端安装的单目相机检测航天器上的人工标志点,并对标志点进行实时跟踪。图1为机械臂对动态目标实施抓捕的示意,其中目标跟踪是抓捕导航与目标定位的前提和基础,跟踪算法中涉及到的困难主要包括:

1)多目标的区分。被跟踪目标通常由多个形状相似的发光靶标组成,外观形态上差异较小,在跟踪过程中容易产生不同目标之间的混淆,需要选择有效目标特征,以强化不同目标之间的差异,防止跟踪过程中出现由于错跟目标而导致的位姿跳变问题。

2)形态改变时的连续跟踪。由于视觉相机与合作目标之间的角度变化会导致目标形态发生改变,从而使得多帧后的目标形态与初始形态产生较大差异,需要为连续跟踪过程设计自适应的模板更新策略。

3)临近边界的目标检测与跟踪。在自主对接与捕获中,当目标渐入视场时,算法必须能够自主进行目标的检测与跟踪,当目标渐出视场时,算法必须能够准确判断出界的目标,并对视场内目标进行准确跟踪,需要设计部分靶标移入移出视场的抛弃找回策略。

本文将对以上3个方面进行详细论述,以多个靶标构成的合作目标的边界跟踪问题为例,对CamShift算法做了3个方面的改进,得到新的跟踪算法框架如图2所示,分别介绍如下。

1)考虑反向投影图是一种概率表征,反映了模板出现在图像中特定位置的概率,本文中选择概率差异较大的像素部分来表征目标,使得同一帧中目标之间的差异性和同一目标在不同帧之间的相似性同时加强,这样能够有效区分多目标,帮助跟踪算法高效执行。

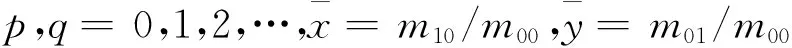

2)CamShift算法的收敛过程中,通过对图像进行矩运算来确定目标中心的位置,本文设计了一种通过对比目标区域和模板区域不变矩特征差异性实现模板更新的机制,既保证了跟踪算法的高效性,也提高了跟踪过程的稳定性。

3)在传统的跟踪算法中只强调连续的跟踪过程,没有考虑目标移出和移入视场时的目标丢失与找回问题。针对由多个目标构成的合作目标的边界跟踪问题,本文设计了一种利用视场内的部分靶标完成对移入和移出靶标的抛弃与找回方法。

后续将对上述3个方面进行详细论述,在论述前首先对跟踪算法基本原理简述如下。

图1 机械臂抓捕示意Fig.1 Sketch of robotic capturing

图2 改进的CamShift算法Fig.2 Flowchart of improved CamShift algorithm

1.2 CamShift跟踪算法简述

CamShift算法[14]是一种建立在MeanShift算法[15]之上的跟踪算法,它将上一帧图像的跟踪结果作为当前帧的初始搜索窗口,将目标颜色直方图的反向投影图作为模板,使用MeanShift算法作为搜索算法,通过计算反向投影图的质心从而得到目标的中心位置,实现目标的跟踪。该算法主要通过3个步骤实现,下面分别进行介绍。

(1)反向投影图的生成

在跟踪过程中,对视频图像处理区域中的某一个像素,通过查询目标的颜色直方图中相应的值,得到该像素可能为目标的概率,遍历图中的每一个像素得到目标颜色概率分布图,也称之为直方图的反向投影图。

设被跟踪目标的图像由n个像素组成,{xi}i=1,…,n表示这些像素点的位置,则目标图像的直方图为:

(1)

(2)

(2)搜索窗口重心及尺寸的计算

目标跟踪主要涉及目标两个方面的变化,第一是目标在图像中位置的移动,第二是目标在图像中尺寸的变化。首先,计算目标位置的变化。对于反向投影图I(x,y),其搜索窗口的重心:

(xc,yc)=(M10/M00,M01/M00)

式中:M00为搜索窗口的零阶矩,计算如下:

M10、M01为一阶矩,计算如下:

其次,计算目标尺寸的变化。通过计算二阶矩可以得到搜索窗口的宽和高:

θ=1/2arctan[b/(a-c)],

1.3 多目标跟踪

CamShift算法使用直方图对目标区域进行建模,通过相似性度量实现目标的匹配和跟踪。然而在多目标跟踪时,如果目标之间颜色特征分布相近,则易造成目标丢失。本文使用了一种改进的灰度直方图对目标进行建模,既能充分表达目标特征又抛弃了冗余信息,能够有效提高算法的鲁棒性。

图3 空间模拟目标Fig.3 Simulated space target with six LEDs

图4 同一帧中6个目标的直方图Fig.4 Histograms of six LED targets in the same image frame

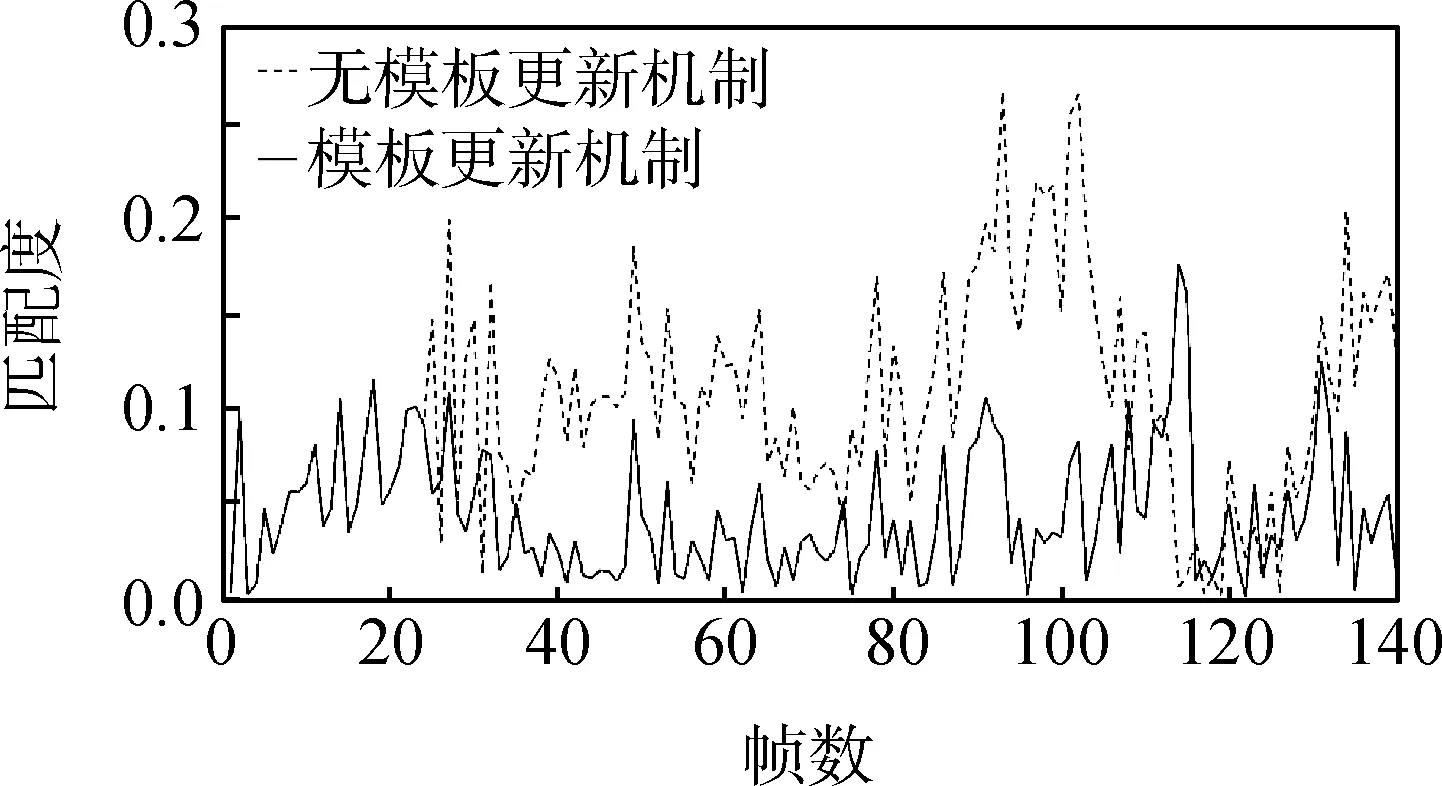

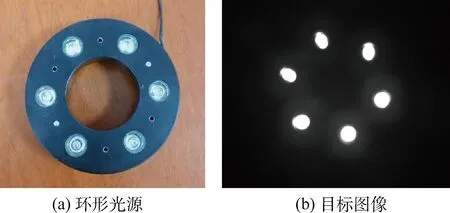

图3为搭载了6个LED灯的空间模拟目标,由于每个LED灯具有相同的结构、尺寸和光照特性,因而由此得到的直方图之间的差异性不大,无法准确进行多目标区分,如图4所示。此外,从直方图中可以看出,大部分的像素集中在直方图的两端,即黑色(灰度值近零)和白色(灰度值为255)两个部分,导致了直方图中间部分被严重压缩。由于全黑或全白的像素不能很好表达目标的特点,在实际跟踪中,应该去除这两部分的影响。由于每个LED灯相对相机的位置、角度不同,因而成像后光斑形状与中心亮度不同,所以每个目标辐射出来的灰度渐变区域也有所不同,因此目标的亮度信息主要集中在目标轮廓周围到背景的渐变区域中。

目标特征选择的算法流程如表1所示。

表1 特征选择算法

其中f(x,y)为目标原始灰度图像,灰度范围为[minf(x,y),maxf(x,y)],共有N个灰度级,h(rk)=nk为f(x,y)的直方图,rk是第k级灰度,nk是图像中灰度级为rk的像素个数。I(x,y)为其二值图像,T为二值化阈值,A为膨胀处理(⊕)的结构元素,iter为循环标识符,c为压缩比例阈值,G为像素个数阈值,l表示像素数少于G的灰度级的个数。如果算法不是第一次进入循环,则用结构元素B(size(B) 图5所示为特征选取后目标直方图。可以看出经过对特征的筛选,目标包含了更丰富的灰度信息,且不同目标之间的差异性增强,有利于目标的检测与跟踪。 图5 基于特征选取的目标直方图Fig.5 Histograms of six LED targets based the feature selectio 在机械臂抓捕过程中,由于受到光照方向、目标姿态等外界环境的影响,目标特征在整个图像序列上也会发生变化,如图6所示,因此必须使用目标特征更新策略来保证长时间跟踪的稳定性和鲁棒性。本节将介绍一种目标特征更新机制,该机制使用不变矩来度量模板与目标之间的相似性,从而实现目标特征的自适应更新。 图6 同一目标的表观变化情况Fig.6 Different appearances of one LED target 1.4.1 相似性度量方法 空间目标运动过程中会受到姿态偏转或光照条件影响,导致目标在图像中的投影外形发生变化。我们期望寻找一种对上述变化敏感而对目标的平移、缩放和旋转不敏感的相似性度量方法。本节中使用了HU不变矩[16]作为相似性度量的方法。HU不变矩是图像二阶和三阶中心矩的函数。对于大小为M×N的数字图像f(x,y),其二维(p+q)阶矩和中心矩分别定义为: 归一化(p+q)阶中心矩定义为: 由此可以得到7个HU不变矩: φ1=η20+η02 φ3=(η30-3η12)2+(3η21-η03)2 φ4=(η30+η12)2+(η21+η03)2 φ5= (η30-3η12)(η30+η12)[(η30+η12)2- 3(η21+η03)2]+(3η21-η03)(η21+η03)· [3(η30+η12)2-(η21+η03)2] φ6= (η20-η02)[(η30+η12)2-(η21+η30)2]+ 4η11(η30+η12)(η21+η03) φ7= (3η21-η03)(η30+η12)[(η30+η12)2- 3(η21+η03)2]+(3η12-η30)(η21+η03)· [3(η30+η12)2-(η21+η03)2] 本文中,使用了由不变矩构成的对比度量标准,来计算两个目标之间的相似性[17]。对比度量标准的公式为: (3) 1.4.2 模板更新机制 (1)特征选取 通常情况下,对灰度图像或轮廓图像进行HU不变矩计算,来比对相似性。本文所用的6个发光合作目标,其灰度图像中存在着大量白色区域(如图7(a)所示),这些区域的区分度不高,对于相似性的度量没有贡献。而对于轮廓图像,则信息过于单一(如图7(b)所示),只包含了目标的形状特征,尤其是在进行矩运算时,不同目标的矩可能相同。因此,选取了目标反向投影图(如图7(c)所示)的HU矩特征来比对相似性。 图7 目标特征Fig.7 Features of six LED targets (2)更新机制 目标在运动过程中由于抖动或者干扰,会出现单帧跳变的现象,只有目标形态连续发生变化,并且前后帧之间具有相似性,才能判定此次形态改变为稳定的,需要进行模板更新。本文中利用HU不变矩判断两帧之间的相似性,基于模板更新的Camshift跟踪算法如表2所示。 表2 基于模板更新的CamShift跟踪算法 图8为启用模板更新机制前后图像匹配度曲线。可以看出,通过模板更新机制,不同帧之间同一目标的相似性显著增加。 图8 图像匹配度Fig.8 Matching degree of images 自主交会对接任务是无人参与的,跟踪定位算法应当具备更加机动的应对策略,来处理相机视场内无目标、视场内逐渐出现目标,以及视场内若干目标消失等情况。基于以上问题,本节给出了一种目标的发现、抛弃与找回策略。当相机视场内无目标时,算法可以读入视频,等待目标出现;当目标出现以后,算法能够自动检测出目标个数及所在位置;当目标临近边界时,算法能够抛弃即将移出视场的目标;当目标逐渐移回视场时,算法也具备找回移入目标的功能。 (1)检测算法 当跟踪开始及有新目标移入视场后,都需要对图像进行检测以确定目标的位置及个数。本文使用了轮廓检测来实现这一功能。在轮廓检测之前,首先要对图像进行形态学滤波、阈值化等预处理获取目标区域的二值图;然后寻找二值图的轮廓,如图9所示。具体的算法为:系统性扫描图像,当遇到连通区域的一个点时,以该点为起始点进行轮廓提取并标记边界上的像素;当轮廓完整闭合,扫描回到上一个位置,直到再次发现新的连通区域;遍历所有连通区域以后,即可得到目标的个数及位置。 图9 目标检测Fig.9 Targets detection (2)找回、抛弃策略 首先定义一个目标框,使得合作目标全部包含在该框中,计算该框与图像边界的距离,以此判断是进行目标抛弃还是检测找回。 在找回策略中,当目标框距离图像边界大于阈值d,则将目标框扩大,并在框内进行重新检测,找回目标。目标框的扩大过程如图10所示,图10(a)为跟踪得到的目标框。然后算法分别判断目标框距离4个边界的距离,由于目标框距离上、下、右边界的距离大于设置的阈值d,所以对目标框进行相应扩大,如图10(b)~(d)所示。扩大后的目标框中包含了一个刚刚由边界进入图像的目标,此时再在目标框内进行目标检测,可以找回在上帧中被抛弃的目标。 图10 找回策略中的目标框变化Fig.10 Variations of target box in the retrieve strategy 在抛弃策略中,当目标框超出图像边界时,抛弃距离边界最近的目标,目标框缩小,再次检测目标框是否超出边界,如果超出则继续删除目标,直至抛弃所有临近边界的目标。目标框缩小的过程如图11所示。图11(a)中算法检测到目标框已经超出图像上边界,此时删除距离上边界最近的一个目标,再次进行检测,发现目标框还是超出边界,继续删除目标,目标框缩小为图11(b)所示。此时目标框在图像边界内,抛弃结束,进入下一帧。 图11 抛弃策略中的目标框变化Fig.11 Variations of target box in the abandon strategy 设图像尺寸为H×W,图像的坐标及目标框的位置如图12所示。目标抛弃与找回策略算法流程如表3所示。 图12 图像的坐标及目标框的定义Fig.12 Image coordinate and definition of target box Step1目标跟踪,得到目标框x,y,Wf,Hf()。Step2if W-x+Wf()>d,目标框向右扩。if x>d,目标框向左扩。if H-y+Hf()>d,目标框向下扩。if y>d,目标框向上扩。Step3if 目标框扩大,目标框内重新检测,得到新的目标框x',y',W'f,H'f()。Step4if x'>0&&y'>0&&x'+W'f 上述算法分为4个步骤,Step 2根据目标框与图像边界之间的距离关系实现目标框的扩大,Step 3在扩大的目标框内对目标进行重新检测,Step 4则判断新的目标框是否出界,删除出界的目标。算法中变量d为距离阈值。 针对以上方法,本节将进行3个试验。试验一验证目标特征选取算法的正确性,试验二验证模板更新的正确性,试验三验证目标处于复杂运动状态(目标形态改变,移入移出视场)时跟踪的正确性与连续性。此外,还对跟踪速度进行了测量。 本节中,利用已有的月球车双目相机系统中的单个相机对手动移动的空间模拟目标进行跟踪。用Viewworks公司的高性能视觉相机VA-1MC作为图像采集设备,镜头加装滤光片,用台式电脑(CPU为Intel 2140,主频达到1.6 GHz,内存为1.93 GB)作为图像处理计算机。在微软Visual Studio 2008软件平台上,利用Intel公司提供的用于计算机视频处理的OpenCV库函数,对采集的视频进行运动检测编程实现。录制的空间模拟目标的视频时长70 s,帧速率24帧/s,图片大小1 024×1 024。空间模拟目标如图13(a)所示,模拟目标为一个同轴环形光源,6个LED灯均匀分布在直径为15 cm、内径为7 cm的同轴环形平面上,滤光后目标图像如图13(b)所示。目标运动过程中与相机之间的夹角在±30°之间。 图13 空间模拟目标Fig.13 Simulated space target 图14 图像匹配度Fig.14 Matching degree of images 试验一,验证目标特征选取算法的正确性。在本试验中,使用了160帧图像序列,利用公式(3)分别计算同一帧中不同目标之间的相似性与同一目标与模板之间的相似性。图14依次给出了使用特征选择算法前后6个目标图像匹配度的曲线。点画线(线Ⅰ)和短虚线(线Ⅱ)分别表示特征选择前后,同一帧图像中,不同目标之间的匹配度。长虚线(线Ⅲ)和实线(线Ⅳ)分别表示特征选取前后,同一目标与模板之间的匹配度。匹配度值越小,说明目标之间越相似;反之,说明目标之间越不相似。表4给出了四条曲线的均值列表。 表4 匹配度均值 分析表4可以得出:1)线Ⅱ均值高于线Ⅰ均值,说明经过特征选取以后,同一帧中,不同目标之间的差异性增强。2)线Ⅱ均值大于线Ⅳ均值,说明经过特征选取以后,目标与模板之间的相似性大于不同目标之间的相似性。3)在目标1、3、5上线Ⅲ均值显著高于线Ⅰ均值,说明没有特征选取时,多个目标出现目标与模板之间的差异性大于多目标之间的差异性。4)在目标1、3、5上,线Ⅳ均值小于线Ⅲ均值,说明特征选取算法改进了这几个目标与模板之间的相似性;在目标2、4、6出现了线Ⅳ均值高于线Ⅲ均值,说明没有特征选取时,多目标之间以及目标与模板之间不能明显地区分开来。通过上述分析可以看出,特征选取算法能够显著提高目标与模板之间的相似性,增加多目标之间的差异性,从而有利于多目标的准确、稳定跟踪。 试验二,验证模板更新的正确性。本试验中,选取了视频的前140帧来测试更新机制的性能。由于6个合作目标的更新机制一样,以其中一个目标为例,对模板更新的结果进行展示。图15给出了目标形态渐变的过程。以第0帧目标图像的反向投影图作为模板,分别计算每一帧目标图像的反向投影图与模板的匹配度,当匹配度超过所设定的阈值,也就是说此时目标图像的反向投影图与模板的差异较大,随即启动模板更新机制。从图15可以看出,在第24帧、第92帧、第115帧、第132帧进行了模板的更新,而此时图像的反向投影图确实是与初始模板有较大差异。 图15 跟踪过程中的模板更新Fig.15 Template update in the tracking 试验三,验证跟踪过程稳定性、连续性和实时性试验。在本试验中,使用空间模拟目标的运动视频检测跟踪算法。视频中关键帧的跟踪结果如图16所示。可以看出,在跟踪过程中,多个目标形态发生明显变化,算法能够通过及时的模板更新策略,保证了跟踪过程的稳定性。在临近边界时,出现多个目标出入视场的情况,算法能够准确对目标进行抛弃和找回,保证了跟踪过程的连续性。最后,表5给出了98帧图像的处理速度,结果表明,算法能够实现10帧/s以上的目标稳定跟踪,保证了跟踪过程的实时性。 图16 目标跟踪过程Fig.16 Process of targets tracking 帧数目标跟踪速度/s1^7帧0.110.0940.1090.0940.110.1090.0948^14帧0.0940.1090.0930.1090.0940.0940.09315^21帧0.0940.0940.0940.1090.0940.1090.09422^28帧0.1090.0930.1090.0940.1090.0940.09429^35帧0.0930.0940.0930.110.0940.0940.09336^42帧0.0930.0940.0930.0930.0930.1090.12543^49帧0.0940.0940.0940.1090.1090.0940.10950^56帧0.0930.1090.0930.1090.0930.0940.09357^63帧0.0930.110.0940.110.110.0930.09364^70帧0.1090.0940.1090.0930.1090.0940.09471^77帧0.0940.110.0930.1090.1090.0940.09378^84帧0.0940.0930.0930.1090.0940.1090.09485^91帧0.0940.0940.0940.1090.1090.0930.10992^98帧0.0940.0930.1090.0940.0940.0930.094 本文针对航天器自主交会对接和机械臂抓捕空间站舱段或货运飞船过程中基于视觉的跟踪技术开展研究,提出了一种基于反向投影模板自适应更新的快速跟踪方法。该算法以CamShift算法为基础,做出了以下3方面的改进:一是,针对靶标中多个相似的发光目标跟踪问题给出了一种特征选择算法,该算法能够有效地提取出具有代表性的目标特征,消除随变性小的信息对跟踪的影响;二是,针对跟踪过程中目标形变问题给出了一种自适应的模板更新算法,该算法能够解决机械臂对目标渐进式捕获过程中由于光照角度、目标姿态的变化而导致的图像形变;三是,针对目标进出视场问题,给出了一种临近边界目标抛弃、找回策略,解决了由于抖动或运动规划约束而导致目标从相机视场中移入、移出的情况。最后,通过试验验证了算法的有效性与时效性。下一步的工作中,将利用即将建设完成的空间机械臂遥操作动态导航定位地面模拟视觉系统中的6自由度机械臂模拟系统对目标的运动状态开展深入分析,对目标在不同角度与速度下的跟踪状态开展研究并进行量化分析。 References) [1] 周建平.天宫一号/神舟八号交会对接任务总体评述[J].载人航天,2012,18(1):1-5. ZHOU J P. A review of Tiangong-1/Shenzhou-8 rendezvous and docking mission[J]. Manned Spaceflight,2012,18(1):1-5(in Chinese). [2] HOWARD R T,JOHNSTON A S,BRYAN T C,et al. Advanced video guidance sensor (AVGS) development testing[C]∥SPIE Defense and Security Symposium. Orlando:SPIE,2004:50-60. [3] ODA M. Attitude control experiments of a robot satellite[J]. Journal of Spacecraft and Rockets,2000,37(6):788-793. [4] YAMANISHI N,SAKASHITA T,KAMIYA T. CFD study for air ventilation optimization in the H-II Transfer Vehicle (HTV) pressurized logistic carrier (PLC)[C]∥40th International Conference on Environmental Systems. Barcelona:AIAA,2010:12-14. [5] CISLAGHI M,FEHSE W,PARIS D,et al. The ATV rendezvous predevelopment programme (ARP)(AAS 99-024)[J]. Advances in Astronautical Astronautical Sciences,1999,101: 259-280. [6] SUSLENNIKOV V. Radio system for automatic rendezvous and docking of Soyuz Progress spacecraft and MIR space station[C]∥Proceedings of the Third European In-orbit Operation Technology Symposium. Noordwijk:ESTEC,1993:101-106. [7] 徐拴锋,杨保华,张笃周,等. 面向非合作目标抓捕的机械臂轨迹规划方法[J]. 中国空间科学技术,2014,34(4):8-15. XU S F,YANG B H,ZHANG D Z,et al. Trajectory planning algorithm for manipulators capturing non-cooperative object[J]. Chinese Space Science and Technology,2014,34(4):8-15(in Chinese). [8] 唐国金,罗亚中,张进. 空间交会对接任务规划[M]. 北京:科学出版社,2008:93-94. TANG G J,LUO Y Z,ZHANG J. Mission planning of space rendezvous and docking[M]. Beijing:Science Press,2008:93-94(in Chinese). [9] 胡军,解永春,张昊,等. 神舟八号飞船交会对接制导,导航与控制系统及其飞行结果评价[J]. 空间控制技术与应用,2011,37(6):1-5. HU J,XIE Y C,ZHANG H,et al. Shenzhou-8 spacecraft guidance navigation and control system and flight result evaluation for rendezvous and docking[J]. Areospace Control and Application,2011,37(6):1-5(in Chinese). [10] KELSEY J M,BYRNE J,COSGROVE M,et al. Vision-based relative pose estimation for autonomous rendezvous and docking[C]∥27th IEEE Aerospace Conference,Big Sky,MT:IEEE,2006:20. [11] 温卓漫,王延杰,邸男,等. 空间站机械臂位姿测量中合作靶标的快速识别[J]. 航空学报,2015,36(4):1330-1338. WEN Z M,WANG Y J,DI N,et al. Fast recognition of cooperative target used for position and orientation measurement of space station′s robot arm [J]. Acta Aeronautica ET Astronautica Sinica,2015,36(4):1330-1338(in Chinese). [12] WU J,LI J,XIAO C,et al. Real-time robust algorithm for circle object detection[C]∥Proceedings of the 9th International Conference for Young Computer Scientists,Zhangjiajie,China,18-21 November,2008:1722-1727. [13] 高升,袁宝峰,齐哲,等. 基于稀疏直方图的空间机械臂视觉目标跟踪方法[J]. 航天返回与遥感,2015,36(3):92-98. GAO S,YUAN B F,QI Z,et al. Space manipulator visual object tracking method using sparsity-based histogram[J].Spacecraft Recovery and Remote Sensing,2015,36(3):92-98(in Chinese). [14] GARY R B. Computer vision face tracking for use in a perceptual user interface[C]∥IEEE Workshop on Applications of Computer Vision. Princeton:IEEE,1998:214-219. [15] CHENG Y. Mean shift,mode seeking,and clustering[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,1995,17(8):790-799. [16] HU M K. Visual pattern recognition by moment invariants[J]. IRE Transactions on Information Theory,1962,8(2):179-187. [17] BRADSKI G,KAEHLER A. Learning OpenCV: computer vision with the OpenCV library[M]. Sebastopol:O′Reilly Media Inc.,2008:279-283.

1.4 目标特征自适应更新

1.5 抛弃找回策略

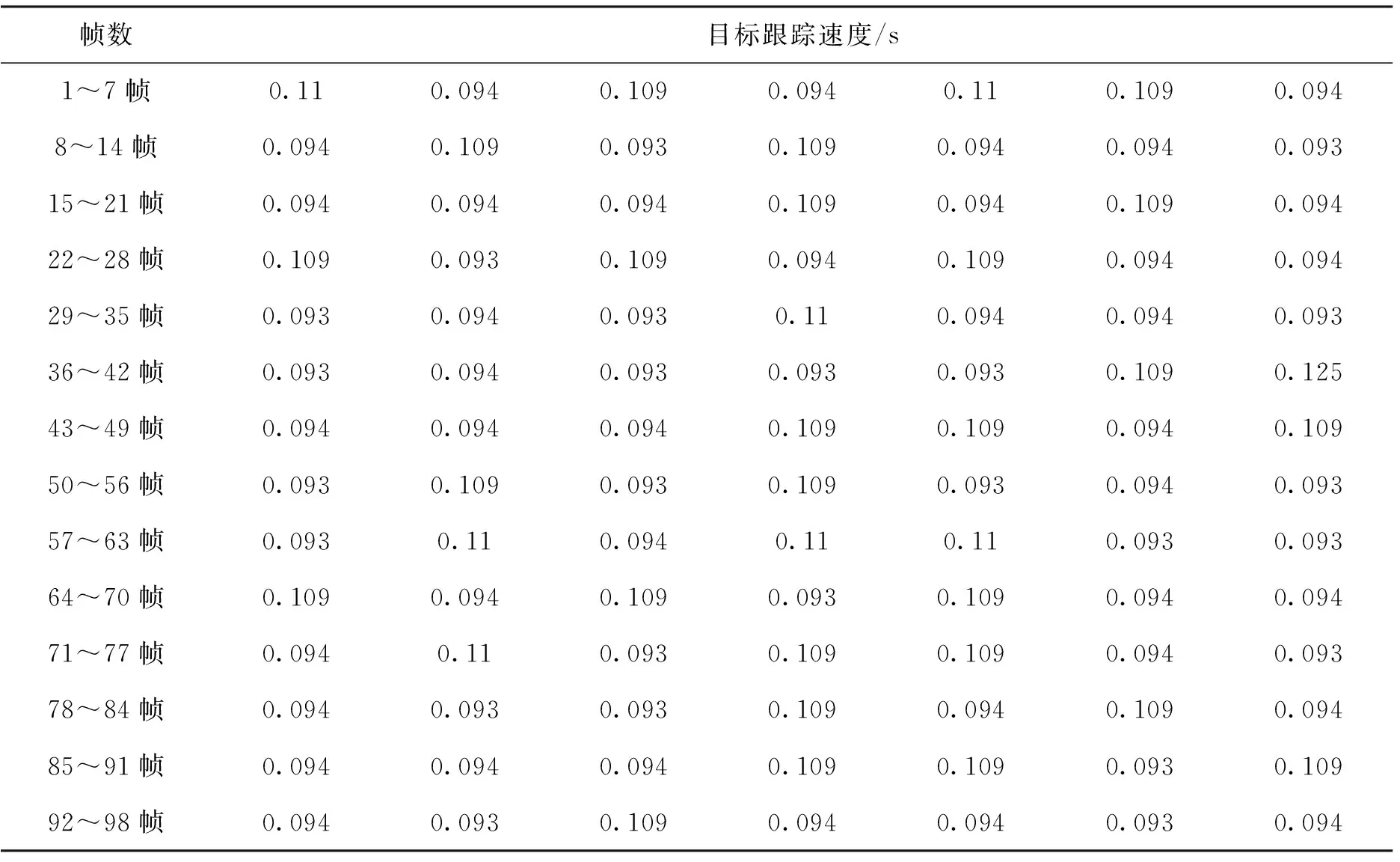

2 仿真校验

3 结束语