基于SIFT算法的无人机视觉导航研究

刘 学,王 峰,温瑞生

(中国电子科技集团公司第五十四研究所,河北 石家庄 050081)

基于SIFT算法的无人机视觉导航研究

刘 学,王 峰,温瑞生

(中国电子科技集团公司第五十四研究所,河北 石家庄 050081)

针对无人机在飞控信道被阻塞和失去卫星定位信号的情况,研究了依靠自主视觉导航来提高生存能力的可能。图像特征信息的获取和匹配是建立图像间的对应关系、实现视觉导航的关键,基于SIFT算法对无人机俯拍图像进行了局部特征的提取、描述和匹配研究,实验结果表明了SIFT算法在无人机俯拍图像的景象匹配中的不变性和准确性,证明了该算法在无人机视觉导航中的应用潜力。

视觉导航;无人机;SIFT算法;特征提取;特征描述;特征匹配

0 引言

随着传感器、处理器技术的革新,无人机行业得到了迅猛发展,尤其在军事领域,成为空中作战发展的新方向[1]。针对日趋严峻的无人机威胁,反无人机技术渐成热点。飞行控制和无线通信遥控是保障无人机安全飞行的关键技术,而一旦失去卫星定位信号和遥控指令,无人机将处于失控境界[2]。目前,应用较为广泛的是朝目标定向发射干扰射频,切断无人机与操作者之间的通信,并阻断其卫星定位信号[3]。如果无人机具备自主飞行能力,在完全失控时就可以安全返航,其战场生存能力会得到很大提升[4]。

视觉导航已经在移动机器人领域得到了广泛研究[5],随着无人机应用技术的发展,基于视觉的无人机导航凭借其良好的抗干扰能力和自主性能逐渐成为研究热点。无人机要实现自主视觉导航,必须要解决2个问题:如何确定自身位置和目标位置?如何到达目标位置[6]?在各种视觉导航策略中,都需要通过当前图像与地图中的参考图像之间的匹配来解决以上问题[7]。因此,稳定而准确的图像特征信息的获取和匹配算法是计算无人机位姿和自主导航方向的关键[8]。以SIFT算法为代表的图像局部不变特征在移动机器人视觉导航中表现出了优越性能[9],但是在无人机视觉导航领域鲜有应用。

本文重点针对SIFT算法在无人机俯拍图像中的局部特征提取、描述和匹配应用进行研究,验证无人机视觉导航过程中采用SIFT算法时图像景物匹配的准确性和不变性,为下一步视觉导航方向的推算奠定技术基础。

1 特征提取

SIFT算法的核心是通过图像金字塔建立尺度空间,遍历所有的尺度和图像位置来检测特征点[10]。采用尺度的连续函数,在所有可能的尺度上搜索稳定的特征来检测对图像尺度变换不变的位置。尺度空间包含一组对原始图像采取模糊和降采样操作的图像序列,对于图像I(x,y),尺度空间L(x,y,σ)通过不同尺度值的高斯核G(x,y,σ)构造而成,如下式所示:

L(x,y,σ)=G(x,y,σ)*I(x,y)。

从原始图像I开始,第一步使用高斯核G(x,y,σ)进行卷积,得到模糊图像L(x,y,σ),然后使用G(x,y,kσ)再次重复这一操作,得到模糊图像L(x,y,kσ)。相邻模糊图像间的差值定义为高斯差分(Difference of Gaussian,DoG)图像D(x,y,σ),如下式所示:

D(x,y,σ)=L(x,y,kσ)-L(x,y,σ)。

特征点的检测和定位即在图像D(x,y,σ)中进行。

SIFT算法的尺度空间如图1所示。对于尺度空间中的每一组,使用高斯核对初始图像进行重复地卷积运算,得到的尺度空间图像用比例系数k加以区分,如图1左栏所示,邻近的高斯图像相减得到右栏的DoG图像,作为当前组的尺度层。随后,对上一组高斯图像的倒数第3层图像进行降采样,作为构建新一组高斯图像的初始图像,重复以上步骤形成下一组DoG图像。

图1 SIFT算法的尺度空间

通过卷积运算得到第1幅高斯图像时,采用的高斯核尺度为σ,比例系数k=21/(LN),其中LN是每组DoG图像中的尺度层的数目,尺度层代表每组DoG图像的中间几幅,用于提取SIFT特征。此外,尺度空间的组数ON的确定也是基于图像大小的。在高斯图像尺度空间中,第o组第l层图像的尺度系数SCol可根据下式计算得到:

o=1,2,…,ON;l=1,2,…,LN;k=21/(LN)。

为了在尺度空间中高效地检测特征点,David Lowe采用了尺度空间的极值,将尺度层中的每个像素点与其26个邻域点进行比较,如果该像素点是其中的最大值或最小值,则作为候选特征点进入下一步骤。通过子像元插值和边缘效应过滤,确定候选特征点的精确位置、尺度和主曲率的比值,并对其进行评估。通常,对比度较低的点容易受噪声干扰而变得不稳定;位于图像边缘上的点的定位误差较大,且对噪声敏感,所以要丢弃以上2种类型的候选特征点[11]。

2 特征描述

2.1 基准方向计算

为了赋予特征旋转不变性,需要计算特征点附近的图像结构的基准方向。给定特征点(x,y),它的高斯图像梯度的大小计算公式为:

m(x,y)=

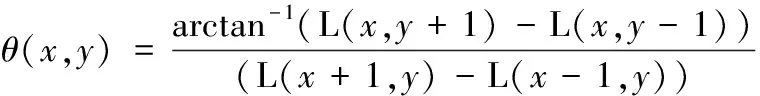

方向计算公式为:

式中,L(.)为梯度运算符。

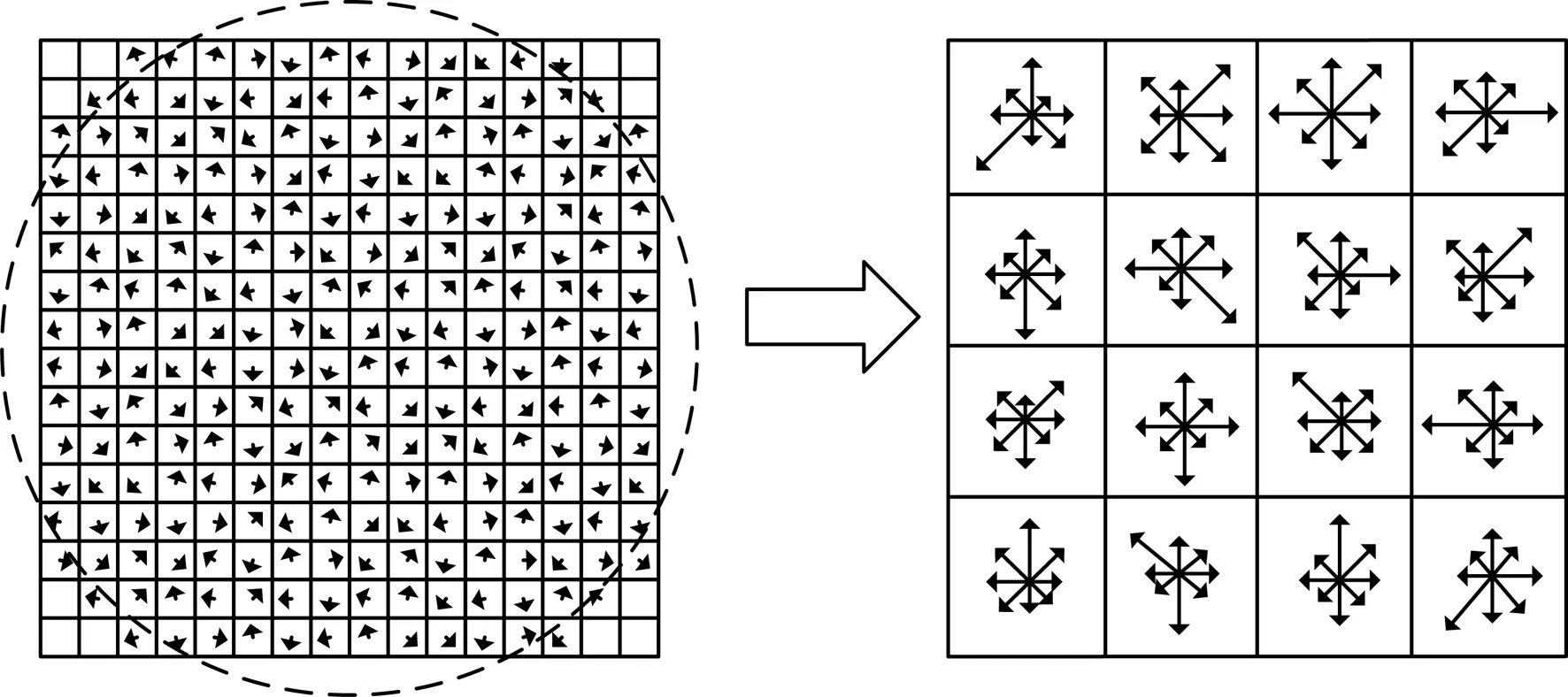

对于尺度为σ的特征点,在以其为中心、以3×1.5σ为半径的圆形区域内建立直方图,统计高斯图像梯度的大小和方向。其中,梯度方向的范围为0~2π,划分为36个方向区间,统计每个方向上的梯度强度信息,如图2所示。为了减小因没有考虑仿射不变性而产生的特征不稳定问题,在统计梯度强度时,通过高斯加权,赋予特征点附近的采样点梯度幅值较大的权重[12]。

图2 由梯度方向直方图确定基准方向

通常情况下,直方图峰值所对应的即是该区域的基准方向,但是当某个直方图箱格的统计数据达到峰值的80%及以上时,可将其作为辅方向,以提高特征匹配时的鲁棒性。至此,检测完毕的图像特征点包含3个信息:位置、尺度和方向。

无人机俯拍图像中随机选取的特征点如图3所示,圆心位置代表特征点,半径大小与特征尺度相对应,半径所指示的方向为基准方向。

图3 SIFT特征示意

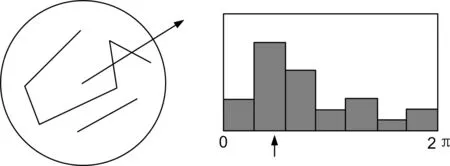

2.2 特征向量构建

SIFT的特征描述符是一个三维向量,通过求取特征点邻域的梯度直方图得到。将尺度为σ的特征点的邻域划分为16个子区域,每个子区域的尺寸为3σ个像元。在计算过程中,需要采用双线性插值,计算的图像区域会扩大。以特征点为中心,将此区域旋转至基准方向,以保证特征向量具有旋转不变性。与求取特征点基准方向有所不同,梯度方向直方图将0~2π的范围划分为8个区间,分别绘制每个子区域在这8个梯度方向上的强度累加值。这种邻域方向性信息联合的思想增强了算法的抗噪声能力,同时对于接下来含有定位误差的特征匹配也提供了较好的容错性能[13]。如此,每个特征点可以得到8×16=128个图像梯度数据,形成128维的SIFT特征向量描述符。

此时,SIFT特征向量描述符已经具备了对尺度变化、旋转等几何变形因素的不变性,继续将特征向量归一化到单位长度,能够对图像对比度变化保持不变。在进行特征描述时,统计的都是以特征点为中心的邻域内的图像信息,将特征点的位置作为所有度量信息的基准,因此具备了图像平移不变性。特征向量构建示意图如图4所示。

图4 特征向量构建示意

3 特征匹配

在完成特征提取和描述之后,还需要解决图像间的特征点匹配问题,在此过程中,主要考虑两方面因素:① 无论经过何种变换,2幅图像中相对应的特征点的描述符间的距离应该是最小的;② 2幅图像中的匹配特征点应该是一一对应的,而不应该存在2个或2个以上的特征点,使它们之间的描述符距离都最小[14-15]。

采用特征向量间的欧氏距离作为相似性判定度量,根据设定的距离阈值,低于该阈值的匹配对成为最终的匹配特征。为了减少图像遮挡和背景混乱产生的误匹配,采用Best Bin First(BBF)算法检索特征点在待匹配图像中的最近邻和次近邻,若满足:最近邻距离≥次近距离×THR,则保留该特征点与其最近邻构成的匹配,否则剔除该匹配对[16]。其中,判断阈值THR∈(0,1)。

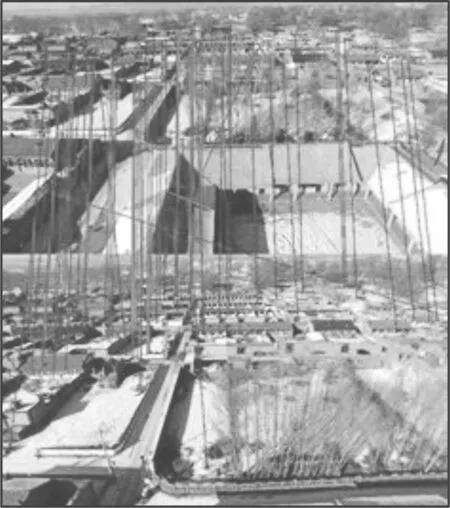

采用SIFT算法进行特征匹配的结果如图5所示。图5中,上、下2幅图像为无人机在同一高度、水平距离百米左右拍摄的同一视角景象。显然,通过BBF算法中的最近邻和次近邻并不能剔除全部误匹配,仍需进一步对匹配特征提纯和优化。

在局部特征匹配对的提纯方法中,随机抽样一致性算法RANSAC(Random Sample Consensus)凭借性能良好、实现简单的特点得到了广泛应用[17]。给定4个特征匹配对,即可完成图像间的透视变换模型计算。对于包含错误匹配的一组特征数据集,随机选取4对特征组成样本,通过反复测试、迭代估计出误差最小的变换矩阵,使得尽量多的特征匹配对都符合这一变换模型,不符合的即为误匹配。该算法的准确率会随迭代次数的增加而提高,当模型的错误概率小于设定的阈值时迭代停止(本文为0.01)。优化后的特征匹配结果如图6所示。

图5 特征匹配结果

图6 特征匹配结果优化

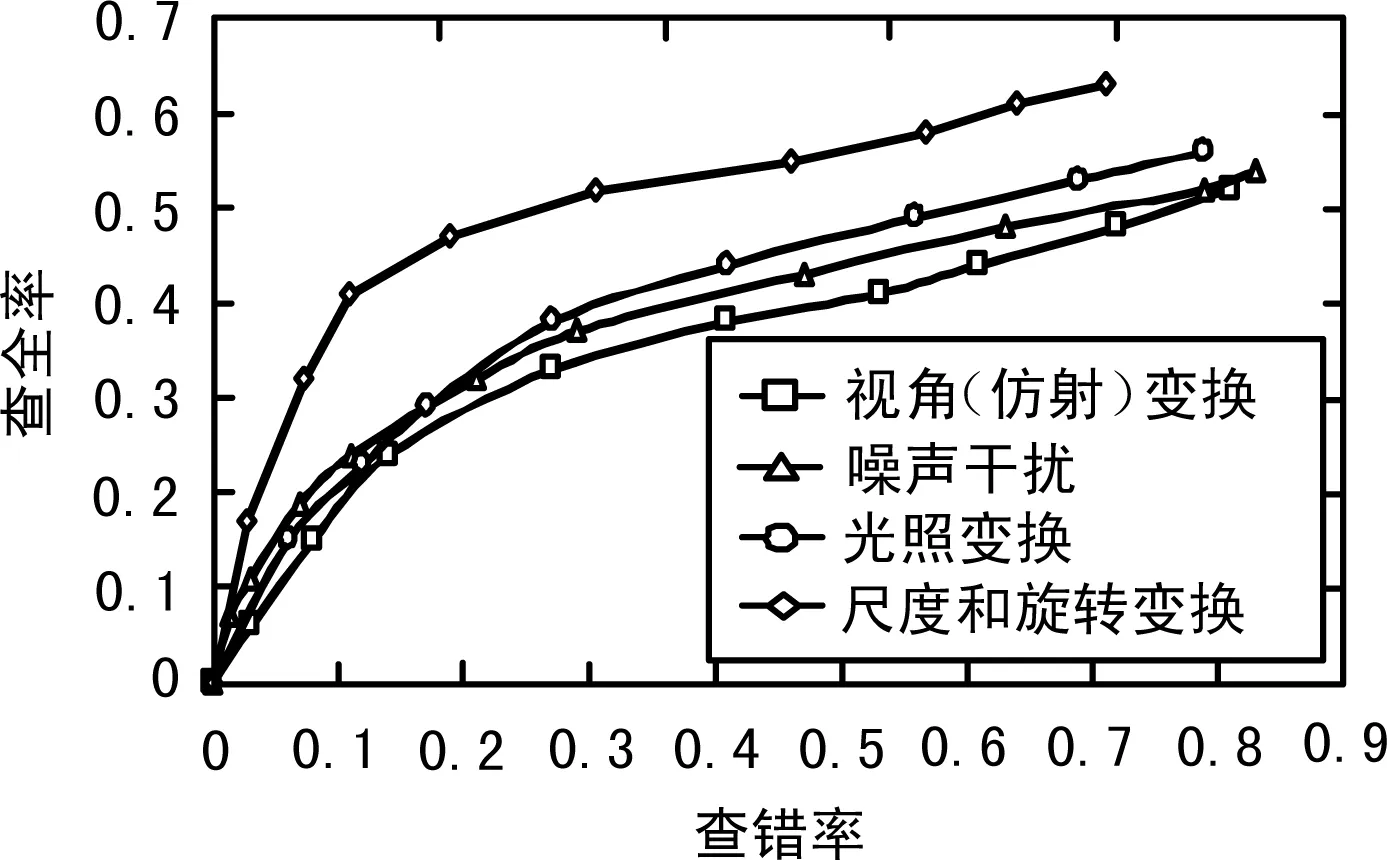

无人机在执行任务过程中需要面临复杂的环境因素,航拍图像之间存在各种视角(仿射)、尺度和旋转、光照变换及噪声干扰,给局部特征匹配带来了很大挑战。为了检验不同环境条件下的SIFT算法性能,采用查全率和查错率作为算法性能的评价指标,该标准基于图像匹配对中的正确匹配和错误匹配的特征数目,被很多学者广泛应用于评价特征提取和描述算法。其中,查全率和查错率是相互独立的,对于横轴代表查错率、纵轴代表查全率的曲线,越靠近左上方表明此描述子性能越好[18]。

通过计算机视觉技术制造图像形变,得到的查错率-查全率曲线如图7所示。从图7可以发现,在一定的查错率下,尺度和旋转变换所对应的查全率较高,即SIFT描述子对尺度和旋转变换的不变性最好,而对视角(仿射)变换、噪声干扰和光照变换能保持一定程度的稳定性,也进一步验证了SIFT算法的核心:求取特征尺度时,采用规范化的高斯拉普拉斯变换,在差分尺度空间查找关键点,实现尺度不变;构造描述子时,参考基准方向对邻域窗口进行旋转,实现旋转不变。

图7 特征匹配的图像变换结果对比

4 结束语

针对无人机失去卫星定位信号和无线通信遥控指令的情况,研究基于视觉导航的无人机自主式飞行。航拍图像之间的对应变换关系是解算无人机位姿、计算导航方向的关键,为此,本文研究了SIFT算法在无人机俯拍图像中的特征提取、描述和匹配。实验结果表明,SIFT算法可以满足无人机视觉导航过程对图像景物匹配的不变性和准确性要求,可以进一步应用于无人机航向的推算。下一步的工作将在改善SIFT算法的实时性、研究自主式视觉导航策略这2个方面展开。

[1] 黄显林,姜肖楠,卢鸿谦.自主视觉导航方法综述[J].吉林大学学报(信息科学版),2010,28(2):158-165.

[2] 段 镇.无人机飞行控制系统若干关键技术研究[D].长春:中国科学院研究生院,2014.

[3] 李 湛.基于鲁棒补偿的小型无人机飞行控制方法研究[D].哈尔滨:哈尔滨工业大学,2015.

[4] 宋 琳.无人机飞行途中视觉导航关键技术研究[D].西安:西北工业大学,2015.

[5] GASPAR J,WINTERS N,VICTOR S J.Vision-based Navigation and Environmental Representations with an Omni-directional Camera [J].IEEE Transactions on Robotics and Automation,2000,16(6):890-898.

[6] HAFNER V V,MÖLLER R.Learning of Visual Navigation Strategies[C]∥Proceedings of the European Workshop on Learning Robots (EWLR-9),2001:47-56.

[7] GOEDEMÉ T,NUTTIN M,TUYTELAARS T,et al.Vision-based Intelligent Wheel Chair Control:The Role of Vision and Inertial Sensing in Topological Navigation[J].Journal of Robotic Systems,2004,21(2):85-94.

[8] LINGUA A,MARENCHINO D,NEX F.Performance Analysis of the SIFT Operator for Automatic Feature Extraction and Matching in Photogrammetric Applications[J].Sensors,2009,9(5):3 745-3 766.[9] 许宪东,洪炳镕,关 毅.机器人视觉导航的几种特征点方法比较[J].华中科技大学学报(自然科学版),2011(39):200-203.

[10] LOWE D G.Object Recognition from Local Scale-invariant Features[C]∥Proceedings of the 7th IEEE International Conference on Computer Vision,1999:1 150-1 157.

[11] 王永明,王贵锦.图像局部不变性特征与描述[M].北京:国防工业出版社,2010.

[12] 帅 通,师本慧,张 霞.高分遥感舰船目标SIFT特征的提取与匹配[J].无线电工程,2015,45(11):48-51.

[13] 张 超.基于局部特征的图像配准算法及应用研究[D].北京:北京理工大学,2015.

[14] 陈 龙.辅助视觉中的图像处理关键技术研究[D].西安:西安电子科技大学,2013.

[15] 吴利平,卢 煜.宽带多媒体集群系统中的图像增强与恢复技术[J].移动通信,2014,38(5):59-63.

[16] 蔺海峰,马宇峰,宋 涛.基于SIFT特征目标跟踪算法研究[J].自动化学报,2010,36(8):1 204-1 208.

[17] FISHER M,BOLLES R.A Random Sample Consensus:A Paradigm for Model Fitting with Application to Image Analysis and Automated Cartography[J]. Communication Association Machine,1981,24(6):381-395.

[18] MIKOLAJCZYK K,SCHMID C.A Performance Evaluation of Local Descriptors[C]∥Proceedings of the Conference on Computer Vision and Pattern Recognition,2003:257-264.

刘 学 男,(1987—),博士,工程师。主要研究方向:图像处理及分析、视觉导航。

王 峰 男,(1971—),研究员。主要研究方向:无线电通信、系统集成。

Research of UAV Visual Navigation Based on SIFT Algorithm

LIU Xue,WANG Feng,WEN Rui-sheng

(The54thResearchInstituteofCETC,ShijiazhuangHebei050081,China)

In view of the case that the UAV (Unmanned Aerial Vehicles) flight control channel is blocked and satellite positioning signal is lost,the research is carried out to explore the possibility of enhancing survivability by autonomous visual navigation.The acquisition and matching of image characteristic information is essential to visual navigation and establishment of the corresponding relation between images.The research on feature extraction,description and matching of UAV top views is carried out based on the SIFT (Scale-Invariant Feature Transform) algorithm.Test results indicate the invariance and accuracy of the SIFT algorithm used in the scene matching of UAV top views,which reveal the great application potential in UAV visual navigation.

visual navigation;UAV;SIFT algorithm;feature extraction;feature description;feature matching

10.3969/j.issn.1003-3106.2017.05.05

刘 学,王 峰,温瑞生.基于SIFT算法的无人机视觉导航研究[J].无线电工程,2017,47(5):19-22.[LIU Xue,WANG Feng,WEN Ruisheng.Research of UAV Visual Navigation Based on SIFT Algorithm[J].Radio Engineering,2017,47(5):19-22.]

2017-02-14

中国博士后科学基金资助项目(2015M580217)。

TP391.4

A

1003-3106(2017)05-0019-04