结合目标提取和压缩感知的红外与可见光图像融合

王 昕,吉桐伯,刘 富

(1.长春工业大学 计算机科学与工程学院,吉林 长春 130012;2.吉林大学 通信工程学院,吉林 长春 130022;3.中国科学院 长春光学精密机械与物理研究所,吉林 长春 130033)

结合目标提取和压缩感知的红外与可见光图像融合

王昕1,2,吉桐伯3,刘富2*

(1.长春工业大学 计算机科学与工程学院,吉林 长春 130012;2.吉林大学 通信工程学院,吉林 长春 130022;3.中国科学院 长春光学精密机械与物理研究所,吉林 长春 130033)

针对红外与可见光图像融合易受噪声干扰从而使目标信息减弱的问题,提出了一种基于目标区域提取和压缩感知的融合算法。首先,在频率域上对红外图像进行显著区域检测得到其对应的显著度图,并在显著图指导下结合区域生长法提取红外图像的目标区域,有效抑制噪声与复杂背景的干扰。然后,用非下采样剪切波变换对待融合的图像进行分解,采用不同的融合策略分别对目标与背景区域的高、低频子带进行融合。针对背景区域提出一种新的基于多分辨率奇异值分解和压缩感知的融合规则,最后,进行非下采样剪切波逆变换得到融合图像。与其他算法的对比实验结果表明,本文算法能更好地突出目标区域,保留图像细节信息,抑制噪声干扰;图像质量评价指标中的信息熵、标准差、互信息、边缘保持度分别提高了3.94%,19.14%,9.96%和8.52%。

图像融合;红外图像;可见光图像;显著度图;非下采样剪切波变换;目标提取;压缩感知;多分辨率奇异值分解

1 引 言

多传感器融合可以增强图像的可信度,提高系统的可靠性,降低对单一传感器性能的要求。融合后的图像可以更准确、更全面地展示出目标或场景的相关信息,更适合人眼观察以及计算机的相关后续处理。红外与可见光图像融合是图像融合的重要分支,也是目前图像融合研究的重点。红外传感器是通过热辐射成像,有利于突出场景中的目标区域,但不能很好地表征场景细节特征;而可见光传感器通过物体反射成像,能够提供目标所在场景的细节信息。因此,红外与可见光融合不仅具有良好的红外图像的目标特征,而且还能很好地保留可见光图像的细节信息。

目前有一种主流的红外与可见光融合算法是基于变换域的方法,如小波变换,金字塔变换,Curvelet变换,Contourlet变换等,但上述方法不具备平移不变性,容易导致图像边缘细节模糊。还有一种基于变换域的方法是非下采样Contourlet变换(Non-subsampled Contourlet Transform,NSCT),其虽然具备平移不变性,融合效果好,但算法复杂度偏高[1]。为了克服此缺陷,文献[2]提出了非下采样剪切波变换(Non-subsampled Shearlet Transform,NSST),它不仅继承了NSCT的所有优点, 而且提高了计算效率,近年来受到国内外学者们的普遍关注。Kong等人基于NSST变换,并与空间频率及PCNN(Pulse Coupled Neural Network)相结合实现了红外与可见光图像融合[3]。该算法虽然效果好,但复杂度偏高;周强等人将NSST成功应用在红外偏振图像融合中[4];除了变换域方法外,学者们还相继提出基于压缩感知的融合算法[5-8],这种方法也是目前的研究热点。压缩感知作为信号处理的新技术,用在图像融合领域可以极大地降低采样数据量,提高融合效率,减轻存储压力。

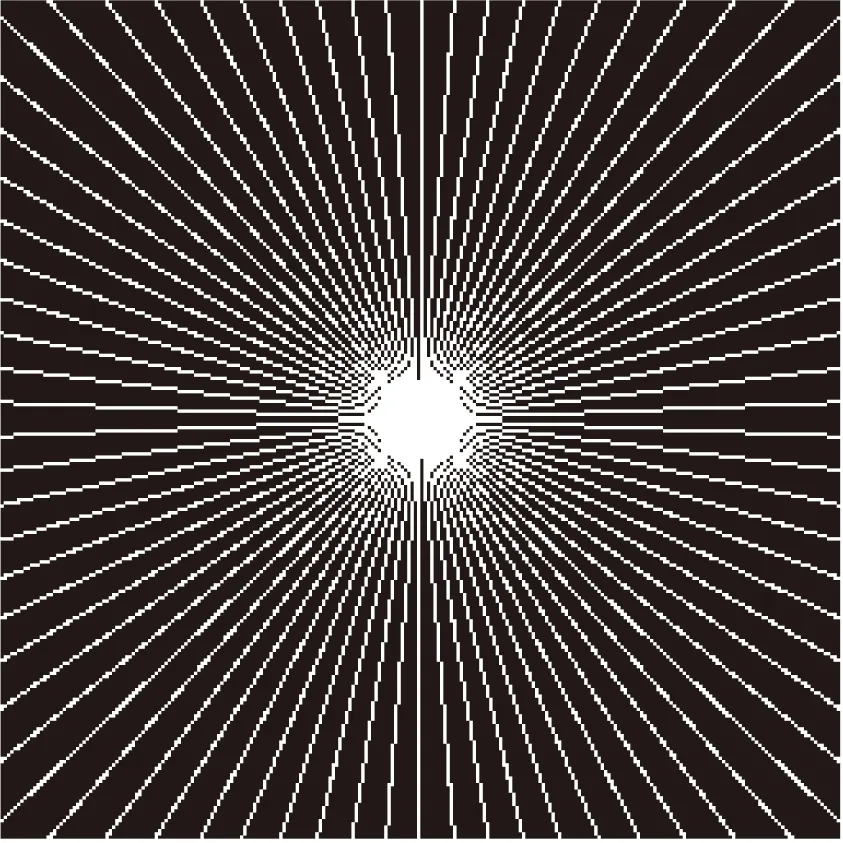

在红外与可见光图像融合领域普遍存在的问题是:在光照不足、目标和背景颜色接近时,容易出现目标信息丢失或减弱的现象。此外,由于红外图像的信噪比较低,噪声的干扰会影响图像的融合质量。考虑到由于现有的多数算法都很难正确区分噪声和原始图像的特征,从而导致融合结果产生模糊和虚假信息,本文提出了一种新的基于目标提取和稀疏表示的图像融合算法,算法流程如图1所示。首先生成红外图像的显著度图,利用显著度图指导红外目标分割。这样对具有复杂背景干扰及低信噪比的红外图像,依然能准确提取红外目标区域。然后对红外和可见光源图像分别进行NSST变换,对两幅源图像中的目标区域和背景区域分别采用不同的融合策略进行融合。仿真实验表明,本文算法在克服噪声干扰的同时,有效避免了目标信息丢失和弱化的问题。

图1 本文算法流程图

2 基于显著度图的红外目标区域分割

在红外目标区域分割过程中,主要存在两个问题:(1)当红外图像背景复杂度高,且存在背景干扰时,易导致误分割;(2)自然界分子的热运动会导致红外图像的信噪比较低,背景噪声的存在会干扰目标区域的正确提取。目前红外目标提取方法,有基于阈值的分割[9]、区域生长法分割、模糊聚类分割方法[10]等。上述方法仅对某些固定场景的红外图像有较好的分割效果,当背景干扰发生变化时,分割效果也会随之改变。对于红外图像的背景噪声问题,多数算法都采用去噪预处理解决。而去噪很容易导致目标区域边缘模糊,而且噪声很难完全去除。针对此问题,本文利用显著度图指导下的区域生长法来解决复杂背景干扰及低信噪比下的红外图像目标分割问题。

2.1显著度图

显著性区域检测就是找出图像中人类视觉注意焦点的区域,再用显著度图进行表示。红外成像取决于景物的温度分布,因此在红外图像中,目标区域相对背景区域来说是显著的。Achanta利用图像的颜色和亮度信息,针对自然景物的彩色图像,提出了基于频率域的显著区域提取方法[11]。选择高斯带通滤波器来抽取图像的显著特征。高斯带通滤波器定义如下:

G(x,y,σ1)-G(x,y,σ2),

(1)

其中:σ1,σ2(σ1>σ2)是高斯滤波器的标准方差。定义σ1=ρσ,σ2=σ,则高斯带通滤波器的带宽由ρ来控制。对具有不同ρ的高斯带通滤波器求和,能够获取更宽频带范围内的图像特征。求和后的表达式如下:

G(x,y,σρN)-G(x,y,σ).

(2)

低频截止频率ωlc由σ1决定,高频截止频率ωhc由σ2决定。通过选择合适的σ1与σ2的值,就得到能够保持期望空间频率特征的显著度图。为了尽可能地获得低频段的所有频率值,σ1设置为无穷大;为了去掉图像的高频噪声和纹理信息,选择先用小高斯核滤波器拟合离散的高斯值,然后利用下式来计算图像的显著度图S:

S(x,y)=‖Iμ-Iwhc(x,y)‖,

(3)

式中:Iμ为平均图像特征相量;Iwhc为经高斯滤波后的像素值;‖‖为欧式距离。利用上式分别计算亮度分量L和颜色分量A、B,得到最终的显著度图。该算法实时性好,能准确保留显著区域的边缘信息,还能有效抑制噪声的影响。

对于红外灰度图像,不能直接利用该模型,因此采用式(4)获取相应的显著度图:

S(x,y)=|Iμ-Iwhc(x,y)|,

(4)

式中:Iμ为红外图像灰度平均值;Iwhc为红外图像经高斯滤波后的图像。||是L1范数。

图2为一幅红外图像及其显著度图。由图2可见,在显著度图中,红外图像的显著区域(目标区域)变得更加显著,不显著区域(背景和噪声)得到了有效的抑制。

(a) 红外图像(a)Infrared image

(b)显著度图(b)Saliency map

2.2红外图像的目标区域分割

由于区域生长法对红外目标的分割效果较理想,因此被广泛采用。区域生长法的正确性依赖种子像素点的选取,当红外图像背景区域复杂,且存在干扰(如噪声等)时,容易选错种子点而导致误分割。而在红外图像的显著度图中,背景区域被抑制,目标区域相对噪声是显著的,因此可以在显著度图的指导下选择正确的种子像素点,得到更准确的分割结果。具体过程如下:(1)在显著度图中选择灰度值最大的点作为种子点;(2)以种子点为中心,考虑其4邻域像素点,如果满足生长规则,则将其合并。以邻域像素点与已分割区域灰度均值的差作为相似性测度,把差值最小的邻域像素点合并到分割区域;(3)当相似性测度大于分割阈值t时,则停止生长。本文算法选择阈值t=50。

为进一步验证本文算法的分割效果及抗噪性能,设置了实验,结果如图3所示。对图3(a)添加高斯噪声得到图3(b),对图3(b)进行目标区域分割。图3(b)具有复杂的野外背景,且信噪比更低。图3(c)为显著度图,图3(d)~(h)分别为Otsu算法,文献[9]中的最大熵法,文献[10]中的K均值聚类算法,传统区域生长法(区域生长过程与本文算法相同,唯一不同之处是在图3(b)中直接选择种子点。由于噪声干扰,误选了噪声点作为种子点)及本文方法的结果。

(a) 红外图像(a)Infrared image

(b) 加噪图像(b)Noisy infrared image

(c) 显著度图(c)Saliency map

(d) Otsu算法(d)Otsu

(e) 最大熵法(e)Maximum entropy

(f) K均值聚类(f)K-means clustering

(g) 传统区域生长法(g)Region growing method

(h) 本文算法(h)Proposed method

实验结果表明,本文算法对于有复杂背景干扰的图像及低信噪比图像仍然能得到正确分割结果。提取红外目标区域后将其映射至可见光图像中,完成对源图像目标区域与背景区域的分割。

3 基于区域分割和NSST的图像融合

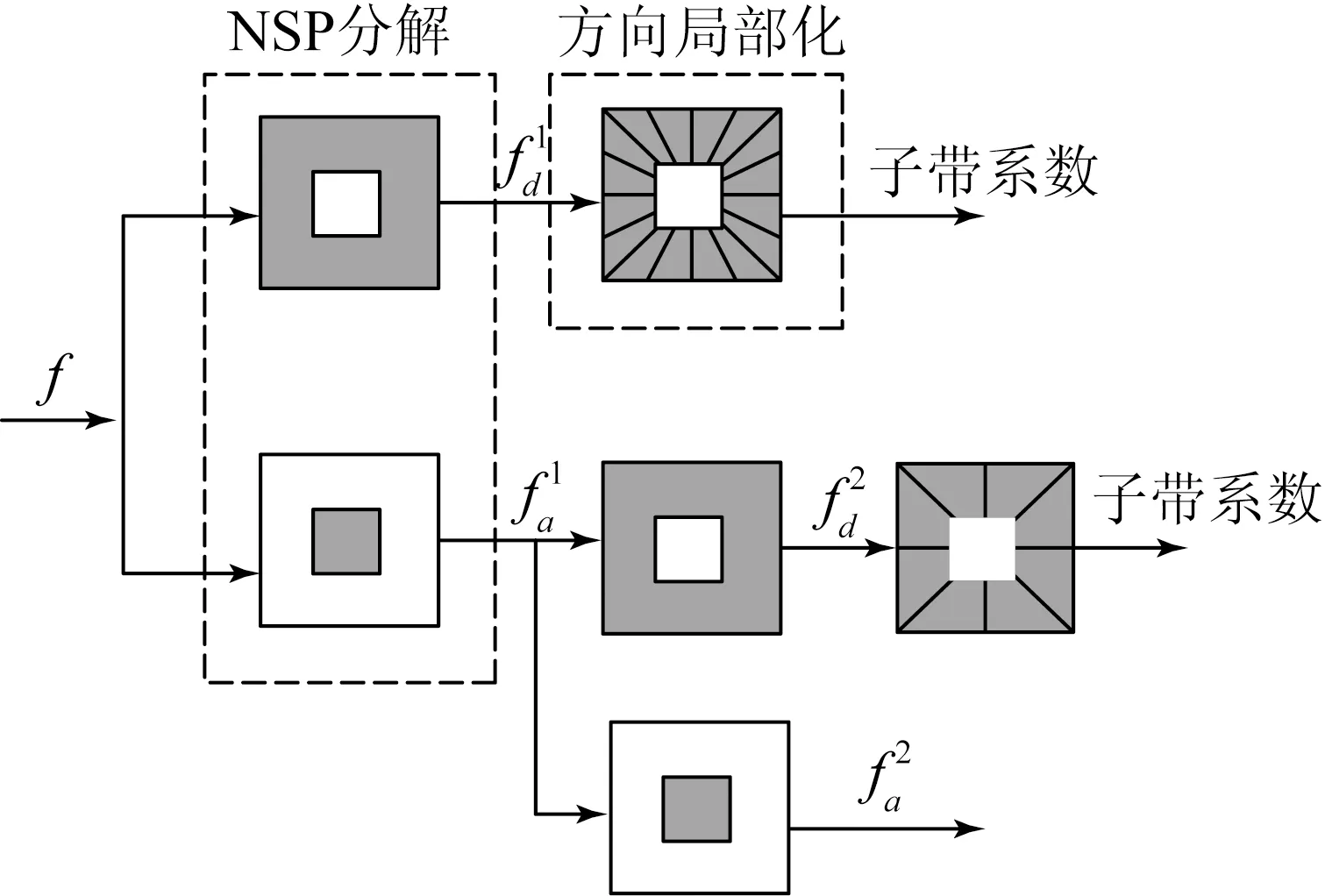

3.1NSST分解

由于NSST的整个分解过程中没有下采样环节,从而保证了平移不变性。NSST变换可以根据融合的实际需要选择分解的方向数,故克服了NSCT分解方向数受限制的缺陷,能更好地表达图像各方向上的边缘和细节特征。

(a) NSST二层分解流程(a)Two level decomposition of NSST

(b) 原始图像(b)Original image

(c) 低频子带图像(c)Low-frequency subband

(d) 4个高频子带图像

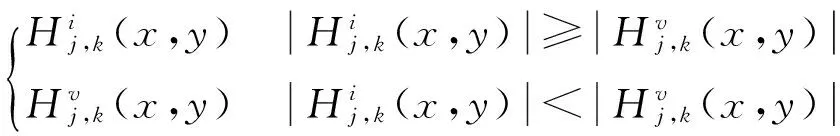

3.2目标区域融合规则

为了尽可能地保留红外图像的热目标信息,将红外图像的低频子带系数作为融合图像的低频子带系数:

LF(x,y)=Li(x,y),(x,y)∈T.

(5)

为了使目标区域的轮廓和细节特征更清晰,高频子带系数选择“模极大值”法,即:

(6)

3.3背景区域的融合规则

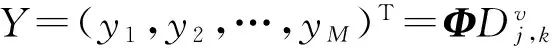

3.3.1低频子带的融合规则

基于混合多分辨率的思想[12],本文对于经过NSST变换后的背景区域的低频子带采用多分辨率奇异值分解(Multi-resolution Singular Value Decomposition,MSVD)进行融合。多分辨率奇异值分解与小波变换非常相似,它也是在分解过程中对信号分别用低通、高通滤波器进行滤波,区别是小波变换是通过有限脉冲响应(FIR)滤波器进行滤波,而MSVD是用奇异值分解(SVD)进行滤波。图像的一层MSVD分解过程如下:

(1)将大小为m×n的图像分成互不重叠的2×2的子块,然后把每个子块按照先列后行的顺序整理成4×1的列向量;再将所有子块的列向量进行组合,形成一个大小为4×(m×n/4)的矩阵R。

(2)对R进行奇异值分解:R=USVT,U和V均为4×4的正交矩阵。

(3)对R左乘UT,得A=UTR=SVT。

(4)A的第一行包含了最大的奇异值,代表了原图像的概貌,对应着图像的低频信息;A的其他行包含的是小的奇异值,对应着图像的细节,即高频信息。

对低频子带Φ1继续重复步骤(1)~(5)可进行下一层分解,以此类推,完成多层MSVD分解。图像的重构可由上述各分解步骤的逆过程实现。MSVD三层分解结构如图5所示。

图5 MSVD三层分解结构图

文献[13]对比分析了MSVD和小波融合的性能,实验结果表明,两者的融合效果非常接近,由于MSVD不像小波变换需要固定的基向量,其融合效果有时甚至超过小波。从融合时间上来看,MSVD的计算过程简单,实时性远高于小波融合方法。

NSST变换具有高度灵活的方向表达特性,在图像的各向异性表达上优于MSVD,非常适合表示图像的边缘特征,但对于某些局部细节特征区域,融合效果不如MSVD;而MSVD在图像边缘区域的融合误差较大。基于以上分析,本文提出一种新的融合规则,采用 MSVD分别对Li和Lv(Li,Lv∈B)进行二次分解,得到相应的低频和高频系数。由于可见光图像中包含的背景信息更丰富,选择MSVD分解后的可见光低频系数作为融合图像的低频系数,而高频系数选择“模极大值”的融合策略进行融合,最后利用 MSVD逆变换得到融合后的背景区域的低频子带LF(LF∈B)。

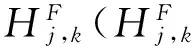

3.3.2高频子带的融合规则

由于图像的目标区域是更受关注的区域,如监控场景中的行人和车辆等。而由于压缩感知(Compressive Sensing,CS)能以较低的采样率高效地重构原信号,它已成为图像融合领域的研究热点。为了提高融合效率,对背景区域采用基于压缩感知的融合算法。目前主要的图像稀疏表示方法有DCT和正交小波变换及NSCT变换。DCT变换的时频分析性能不好;小波变换的方向选择性差;NSCT计算复杂度高,而且分解方向数受限。由于NSST可以根据融合需要选择任意的分解方向数,能更好地表达图像各方向的细节信息,比NSCT运算效率高,可以更好地进行图像的稀疏表示。因此,本文将NSST应用在压缩感知域,融合具体流程如图6所示。

图6 背景区域高频子带融合流程图

图7 星形采样模式

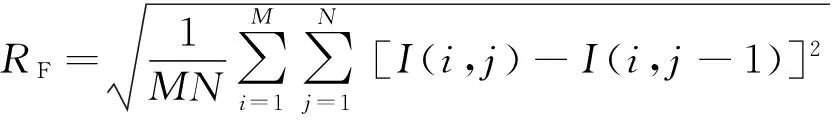

星形测量矩阵中,白色区域,即值为“1”的点是被采样的点。红外图像背景噪声主要存在于高频子带,故对高频子带进行压缩测量可以去除一部分噪声的影响。测量完成后,融合规则采用基于空间频率(Spatial Frequency, SF)加权的融合方法。SF越大代表图像细节信息越丰富,而且SF对噪声不敏感。图像I(i,j)的空间频率SF定义为:

(7)

(8)

(9)

设Φ为测量矩阵:

(10)

(11)

zi=wxxi+wyyi,i=1,2,…,M.

(12)

按照公式(9)计算X与Y的空间频率,记为SFx与SFy,则:

wx=SFx/(SFx+SFy),

(13)

wy=SFy/(SFx+SFy).

(14)

最小全变分算法对于二维信号的重构效果是最突出的,可以更好地保留图像细节[14]。全变分就是对图像x的梯度幅值求和。最小全变分重构的目标函数为:

(15)

式中:φ为测量矩阵,y=φx+n,n为噪声,x代表图像信号,‖x‖TV为图像x的全变分,x′为重构信号,λ为正则因子。式(15)中第一项中通过求l2范数使能量差最小来抑制噪声的干扰。第二项中的λ用来权衡图像的稀疏性能与噪声的抑制作用。

最后将融合后的目标和背景区域的高、低频子带进行NSST逆变换,即得到最终的融合图像。

4 实验与结果

为了验证本文算法的性能,与文献[15]中的离散小波变换融合法,文献[16]中的基于小波稀疏的压缩感知融合算法,文献[17]中的基于离散傅里叶变换的压缩感知融合算法,文献[18]中的基于目标区域分割的图像融合算法及基于NSST变换的图像融合算法(分别记为:DWT,DWT+CS,DFT+CS,RS,NSST)做了对比实验。本文算法NSST的尺度分解层数与方向数均为1。文献 [16]中的小波分解层数也为1层。文献[16]与[17]中的采样率和本文算法的一致,均为30%。基于NSST变换的图像融合算法采用文献[19]中的融合规则,分解层数为3层,方向分解级数依次为2,3,4(与文献[18]中采用的NSCT变换层数和分解级数相同)。3组已配准的红外与可见光源图像分别命名为:“Dune”、“Fieldcamp”和“UNcamp”,图像大小均为256×256。算法编程所用平台为MATLAB R2011a。融合实验的结果如图8~10所示。

(a)可见光图像(a)Visible image

(b)红外图像(b)Infrared image

(c)DWT方法(c)DWT method

(d)DWT+CS方法(d)DWT+CS method

(e)DFT+CS方法(e)DFT+CS method

(f)NSST方法(f)NSST method

(g)RS方法(g)RS method

(h)本文方法(h)Proposed method

(a)可见光图像(a)Visible image

(b)红外图像(b)Infrared image

(c)DWT方法(c)DWT method

(d)DWT+CS方法(d)DWT+CS method

(e)DFT+CS方法(e)DFT+CS method

(f)NSST方法(f)NSST method

(g)RS方法(g)RS method

(h)本文方法(h)Proposed method

由上面的两组对比实验结果可以看出:DWT,DWT+CS和DFT+CS 3种算法得到的融合图像细节信息均很模糊,如图8中的山丘、道路的轮廓模糊不清,图9中的人物和车辆的轮廓及树木的边缘及细节也都有不同程度的模糊。而且3种算法融合图像中的目标(人物或车辆)几乎被“淹没”在背景区域中。分析可知,DWT算法由于只对点目标物体能很好表达,所以融合结果的边缘轮廓信息易模糊。DWT+CS算法由于采用DWT做稀疏基,捕捉边缘能力差,而且其采用随机测量矩阵会导致测量值无法正确反映原图像的结构信息,而本文选择星形矩阵测量高频子带,使测量值与结构信息相关联;DWT+CS算法的融合规则为直接取最大,从而产生了条纹痕迹和噪声。而且DWT与DWT+CS两种算法的低频均采用简单的加权平均规则导致红外目标信息被削弱。DFT+CS算法对整幅图像用DFT做稀疏,星形矩阵主要采集位于图像中心区域的低频分量,高频系数只采样了少数点,所以造成了边缘细节信息模糊。而本文只对高频子带进行压缩感知,对高频子带的采样数目远多于DFT+CS,所以融合图像质量要好于后者。与NSST算法相比,本文算法的目标区域更突出,目标相对背景具有更高的对比度,更好地保留了红外图像的热目标信息。RS算法虽然和本文一样具有很好的目标指示特征,但就目标轮廓而言,本文算法的红外目标与背景之间的边界更清晰。

(a)可见光图像(a)Visible image

(b)红外图像(b)Infrared image

(c)DWT方法(c)DWT method

(d)DWT+CS方法(d)DWT+CS method

(e)DFT+CS方法(e)DFT+CS method

(f)NSST方法(f)NSST method

(g)RS方法(g)RS method

(h)本文方法(h)Proposed method

为了验证本文算法的抗噪性能,对红外图像添加了高斯白噪声,加噪图像如图10(b)所示。由加噪融合结果可以看出,本文算法对噪声的抑制能力最佳。其他算法的融合图像都不同程度地受到了噪声的污染,导致图像细节模糊,融合质量下降,尤其是DWT算法,NSST算法以及RS算法受到噪声的干扰最大。而本文算法即使对低信噪比图像进行融合,其目标区域仍能呈现高亮显示,道路,栅栏,房顶轮廓及房后的树木边缘仍清晰可见,可视效果最佳。

采用信息熵(E)[20],标准差(SD),互信息[21](MI)及边缘保持度(QAB/F)[22]对各算法的融合图像质量进行客观评价,结果如表1所示。本文算法除了对图8中的个别指标略低于NSST算法和RS算法外,其他指标在每一组实验图像中均为最大值,客观评价结果进一步证实了本文算法的优越性。此外,挑选融合效果较好的NSST算法和RS算法做了算法运行时间的对比,结果显示,本文算法的运行时间约为NSST算法的35.79%,是RS算法运行时间的17.02%。因此无论在融合质量上,还是在算法执行效率上,本文算法均占有一定优势。

表1 不同算法的客观评价

5 结 论

本文提出了一种新的红外与可见光图像融合算法。该方法中,通过高斯带通滤波器抽取红外图像的显著特征得到显著度图,根据显著度图完成红外目标的分割,以有效抑制红外背景噪声等干扰。鉴于NSST的多方向性,平移不变性,良好的实时性,本文将其应用在压缩感知域,并结合所提出的压缩感知融合方案实现了背景区域的融合,提高了融合效率;基于混合多分辨率分析的思想,提出了新的基于多分辨率奇异值分解的融合规则。仿真结果表明,与其他5种主流算法相比,本文算法的熵、标准差、互信息量和边缘保持度分别至少提高了3.94%,19.14%,20.15%和8.52%,既突出了红外图像的目标指示特性,也很好地保持了可见光图像的细节信息。

[1]张蕾,金龙旭,韩双丽,等. 采用非采样Contourlet变换与区域分类的红外和可见光图像融合[J]. 光学 精密工程, 2015, 23(3):810-818.

ZHANG L, JIN L X, HAN SH L,etal.. Fusion of infrared and visual images based on non-sampled Contourlet transform and region classification [J].Opt.PrecisionEng., 2015, 23(3):810-818.(in Chinese)

[2]EASLEY G, LABATE D, LIM W Q. Sparse directional image representation using the discrete Shearlet transforms [J].Appl.Comput.Harm.Anal, 2008, 25(1): 25-46.

[3]KONG W, ZHANG L, LEI Y. Novel fusion method for visible light and infrared images based on NSST-SF-PCNN [J].InfraredPhys.Technol., 2014, 65: 103-112.

[4]周强,赵巨峰,冯华君,等. 非下采样剪切波的红外偏振图像融合[J]. 浙江大学学报(工学版), 2014, 48(8): 1508-1516

ZHOU Q, ZHAO J F, FENG H J,etal.. Infrared polarization image fusion with NSST [J].JournalofZhejiangUniversity(EngineeringScicnce), 2014, 48(8): 1508-1516.(in Chinese)

[5]DING M, WEI L, WANG B. Research on fusion method for infrared and visible images via compressive sensing[J].InfraredPhys.Technol, 2013, 57: 56-67.

[6]WANG R, DU L. Infrared and visible image fusion based on random projection and sparse representation [J].Int.J.RemoteSens, 2014, 35(5): 1640-1652.

[7]何国栋,石建平,冯友宏,等. 基于压缩感知的红外与可见光图像融合算法[J]. 激光与红外, 2014, 44(5): 582-585.

HE G D, SHI J P, FENG Y H,etal.. Fusion algorithm for infrared and visible image based on compressive sensing [J].Laser&Infrared, 2014, 44(5): 582-585.(in Chinese)

[8]周渝人,耿爱辉,张强,等. 基于压缩感知的红外与可见光图像融合[J]. 光学 精密工程, 2015, 23(3): 855-863.

ZHOU Y R, GENG A H, ZHANG Q,etal.. Fusion of infrared and visible images based on compressive sensing[J].Opt.PrecisionEng., 2015, 23(3): 855-863.(in Chinese)

[9]杜峰, 施文康, 邓勇, 等. 一种快速红外图像分割方法[J]. 红外与毫米波学报, 2005, 24(3): 370-373.

DU F, SHI W K, DENG Y,etal.. Fast infrared image segmentation method[J].JournalofInfraredandMillimeterWaves, 2005, 24(3): 370-373.(in Chinese)

[10]云廷进, 郭永彩, 高潮.K-均值聚类中心分析法实现红外人体目标分割[J]. 光电工程, 2008, 35(3): 140-144.

YUN T J, GUO Y CH, GAO CH. Human segmentation algorithm in infrared images based onK-means clustering centers analysis[J].Opto-ElectronicEngineering, 2008, 35(3): 140-144.(in Chinese)

[11]RADHAKRISHNA A, SHEILA H,FRAN-CISCO E,etal.. Frequency-tuned salient region detection [J].ComputerVisionandPatternRecognition, 2009: 1597-1604.

[12]SHU T L, YANG B. Hybrid multiresolution method for multisensor multimodal image fusion [J].IEEESensorsJournal, 2010, 10(9): 1519-1526.

[13]NAIDU V P S. Image fusion technique using multi-resolution singular value decomposition [J].DefenceScienceJournal, 2011, 61(5): 479-484.

[14]CANDÉS E, ROMBERG J, TAO T. Stable signal recovery from incomplete and inaccurate measurements [J].CommunicationsonPureandAppliedMathematics, 2006, 59(8): 1207-1233.

[15]QU G H, ZHANG D L, YANG P F. Medical image fusion by wavelet transform modulus maxima [J].OpticsExpress, 2001, 9(4): 184-190.

[16]孙永明,吴谨,刘劲,等. 基于DWT的高频系数压缩感知图像融合[J]. 红外技术, 2014, 36(9): 714-718.

SUN Y M, WU J, LIU J,etal.. Image fusion based on compressed sensing of DWT high frequency coefficients [J].InfraredTechnology, 2014, 36(9): 714-718.(in Chinese)

[17]LI X, QIN S Y. Efficient fusion for infrared and visible images based on compressive sensing principle [J].IETImageProcessing, 2011, 5(2): 141-147.

[18]LIU K, GUO L, LI H H,etal.. Fusion of infrared and visible light images based on region segmentation [J].ChineseJournalofAeronautics, 2009(22):75-80.

[19]陈小林,王延杰.非下采样变换的红外与可见光图像融合[J]. 中国光学,2011,4(5):489-496.

CHEN X L, WANG Y J. Infrared and visible image fusion based on nonsubsampled contourlet transform [J].ChineseOptics, 2011,4(5): 489-596.(in Chinese)

[20]LEUNG L W, KING B, VOHORA V. Comparison of image data fusion techniques using entropy and INI [C].Proceedingsof22ndAsianConferenceonRemoteSensing,Singapore, 2001: 152-157.

[21]QU G H, ZHANG D L, YAN P F. Information measure for performance of image fusion [J].ElectronicLetters, 2002, 38(7):313-315.

[22]XYDES C S, PETROVI V. Objective image fusion performance measure [J].ElectronicsLetters, 2000, 36(4): 308-309.

王昕(1972-),女,辽宁大连人,博士,副教授,2003年于长春理工大学获得硕士学位,2007年于中国科学院长春光学精密机械与物理研究所获得博士学位,现为吉林大学博士后,主要从事图像融合,图像处理与机器视觉的研究。E-mail: wangxin 315@ccut.edu.cn

导师简介:

刘富(1968-),男,吉林农安人,博士生导师,教授,1994年、2002年于吉林大学分别获得硕士、博士学位,2004年香港理工大学博士后,主要从事计算机视觉与模式识别研究。E-mail:liufu @jlu.edu.cn

(版权所有未经许可不得转载)

Fusion of infrared and visible images based on target segmentation and compressed sensing

WANG Xin1,2, JI Tong-bo3, LIU Fu2*

(1.SchoolofComputerScience&Engineering,ChangchunUniversityofTechnology,Changchun130012,China;2.CollegeofCommunicationEngineering,JilinUniversity,Changchun130022,China;3.ChangchunInstituteofOptics,FineMechanicsandPhysics,ChineseAcademyofSciences,Changchun130033,China)

*Correspondingauthor,E-mail:liufu@jlu.edu.cn

The image fusion of infrared and visible light is susceptible to noise and the target information is weakened easily. Therefore, a new fusion algorithm based on target area extraction and compressed sensing was proposed. Firstly, the infrared image was detected in a salient region at frequency-tuned domain to obtain a corresponding salient map. Under the guidance of the salient map, the infrared target area was extracted together with region growing method to effectively overcome the effects of noise and complex background interference on target segmentation. Then, non-subsampled shearlet transform was adopted to decompose the source images and the high and low frequency sub bands in the target and backgound regions were fused respectively. Finally, a new fusion rule was proposed based on multi-resolution singular value decomposition and compressed sensing, and the fused image was reconstructed by the non-subsampled shearlet inverse transform. As compared with the other algorithms, experimental results show that the algorithm highlights the target area, preserves the details of the source images and suppresses the noise interference. The image fusion quality evaluation indexes including information entropy, standard deviation, mutual information and transferred edge information have increased by 3.94%,19.14%,9.96% and 8.52%, respectively.

image fusion; infrared image; visible image; saliency map; non-subsampled shearlet transform; target segmentation; compressed sensing; multi-resolution singular value decomposition

2015-07-07;

2015-08-20.

国家自然科学基金资助项目(No.61303132);吉林省科技厅自然科学基金资助项目(No.201215127)

1004-924X(2016)07-1743-11

TP751

Adoi:10.3788/OPE.20162407.1743