基于案例的嵌入式信息系统可用性检查列表的开发研究

李晓军 肖忠东 李 嘉

(1. 西安交通大学管理学院;2. 火箭军工程大学 908教研室;3. 华东理工大学商学院)

基于案例的嵌入式信息系统可用性检查列表的开发研究

李晓军1,2肖忠东1李嘉3

(1. 西安交通大学管理学院;2. 火箭军工程大学 908教研室;3. 华东理工大学商学院)

摘要:结合系统设计和任务特征,面向军事嵌入式信息系统可用性评估,提出了可用性检查列表开发方法,基于可用性问题分类框架设计系统可用性评价要素结构,建立面向军事应用的嵌入式信息系统可用性评价准则集合,在此基础上对可用性检查要素内容与可用性评价准则进行匹配,开发系统可用性检查列表,并通过案例研究评估其绩效。结果表明,同启发式评价方法、普渡可用性检查列表相比较,提出的可用性检查列表同时具备满意的完备性和效度特征,在军事嵌入式信息系统可用性评价中具有比较优势,同时也间接验证了提出的可用性检查列表开发方法的理论支撑性和操作可行性,以及面向评价对象对应的领域知识建立个性化可用性检查列表开展可用性评价的必要性和价值。

关键词:人因工程; 可用性检查列表; 案例研究; 嵌入式信息系统

嵌入式信息系统,如指挥信息系统、导弹测控系统等,是各级军事人员实现战场态势感知的主要手段和工具,是军事作战能力生成的重要载体,其功能可通过“6R”集中概括,即在正确的时间、正确的地点传递正确的信息,以辅助正确的决策,实现传递正确的意图和获取正确的结果之目的。但同时,信息的实变性、不完整性和不确定性,有限的计算资源和通信带宽,任务的关键性以及信息需求实时性等因素,对信息系统功能的有效发挥提出严峻挑战[1]。在这样的情形下,嵌入式信息系统的可用性,即系统在作战和训练环境下被用户操作时所具有的有效性、效率和主观满意度[2, 3],显得至关重要。高可用性的系统将有效降低用户的工作负荷、防止人因失误的发生、提高用户的满意度,并最终影响用户对于信息系统的接受程度[4]。因此,在嵌入式信息系统设计和实现过程中,开展“以用户为中心设计”,提高人机界面的可用性水平日益得到关注和重视。

在嵌入式信息系统寿命周期的不同阶段,实施可用性评价并发现、消除潜在的可用性问题是提高系统可用性的关键环节。当前,可用性评价方法主要包括自动化方法、形式化方法、实证分析方法以及启发式方法等[5]。其中,较之其他的评价技术,启发式评价技术由于其具有的时间和成本优势,且容易掌握和操作,在系统设计和实现阶段应用广泛。对于信息系统设计和实现者而言,启发式评价方法中的可用性准则通用性强,但也存在着与特定领域知识的结合还不够紧密,同时实践过程中评价结果的效度很大程度上依赖于评价人员的能力和经验。因此,在可用性工程领域,以启发式评价技术为基础,衍生出了可用性检查列表,其面向系统设计和实现人员,体现了领域知识特征,操作简便灵活,在可用性评价,尤其是在系统早期生命周期阶段中的应用具备比较优势。

在军事应用领域,一方面,面向作战与训练使用情境的嵌入式信息系统可用性检查列表研究文献报道有限;另一方面,已开发的检查列表还不能完全适应军事嵌入式信息系统可用性评价,主要是由于可用性与产品设计的使用情境,诸如用户、任务、环境等特征密切相关[6],与其他信息系统相比较,军事嵌入式信息系统具有组成结构复杂(如控制输入方式多样、信息输出界面集成度高、设计自毁装置模块等)、使用环境多变甚至恶劣、操作任务关键度高和时间压力大等特点,其可用性特征更加强调面向态势感知和保证人因可靠性[7],而现有的可用性检查列表则主要面向商业和个人应用,如信息搜索、数据管理等,更加强调用户主观满意度。基于上述分析,本研究面向设计和实现阶段的可用性评价需求,以军事嵌入式信息系统可用性评估为背景,建立系统的可用性评价要素结构和评价准则集合,提出可用性检查列表开发方法,并通过案例研究检验和分析本研究提出方法的有效性,为嵌入式信息系统领域可用性工程实践提供手段和工具。

1相关文献综述

由于研究目标和具体研究情境的不同,可用性的定义很难统一,基本可分为一般可用性、情境可用性、感知可用性、享乐可用性、组织可用性和文化可用性等6个视角[8]。信息系统可用性不能够直接测量,只有通过构建可用性指标结构才能够开展可用性评价[9],因此,在设计和实现过程中,诸如“界面友好”、“易用性高”等概括性的描述对于系统可用性问题发现和评估、可用性评级的指导意义有限,开发可操作性强、明确清晰且与领域知识高度切合的可用性评价工具显得必要且极具价值。

1.1可用性问题与可用性评价

可用性问题是指信息系统具有的导致其可用性水平降低的特征[10],可以从软件工程和人机交互两个视角对可用性问题进行分类[11]。其中,软件工程视角的可用性问题分类从开发者角度描述可用性问题的属性,为系统优化提供直接支持,如正交分类方案ODC(orthogonal defect classification)[12]、根原因分析RCA(root cause analysis)[13]及可用性问题分类方案CUP(classification of usability problem scheme)[14]等;人机交互视角的可用性问题分类,则更有助于从用户认知的角度理解可用性问题发生的原因及类型,如可用性问题分类UPT(usability problem taxonomy)[15]、用户行动框架UAF(user action framework)[16]以及基于循环交互的可用性问题分类UPCCI(usability problems classification using cycle interaction)[17]等。潜在的可用性问题会降低信息系统的操作效率,甚至会导致人因失误的发生,例如,研究发现手持处方系统存在的可用性问题与输入错误的发生高度相关[18]。因此,在信息系统设计和实现过程中,发现并评估潜在可用性问题的严重性是可用性评价的重要目标,通过迭代设计消除可用性问题具有重要意义。同时,实践表明可用性工程的相关工作开展得越早,可用性问题导致的信息系统研发成本越低,系统的可用性水平越高。

依据应用的阶段不同,可用性评价方法可分为形成性评价和总结性评价,二者在目标和操作层面存在着本质差异[19]。本研究所涉及的可用性检查列表属于一种用于形成性可用性评价的工具,其应用目的是发现信息系统设计方案或原型系统中潜在的可用性问题,并进行严重性评估,为系统可用性优化和迭代设计提供依据。

1.2可用性检查列表

为了满足信息系统设计和实现阶段的可用性评价需求,同时克服启发式评估对于评价人员可用性工程经验和领域知识的较高要求,并在评价效果和时间、成本间取得均衡,可用性检查列表技术被引入形成性可用性评价过程。同时,研究也证实,将可用性检查列表作为标准化工具整合进入软件系统开发和用户接受度测试,对于提高系统人因安全、效率及用户满意度等具有重要意义[20]。信息系统设计和实现过程中,遵循的可用性参考包括高等级的理论和模型、中等级的准则以及实践层面的可用性指南[21]。启发式评价方法基于一系列的中等级可用性设计准则得以实施,面向具体应用将可用性设计准则结合领域知识进一步细化,则得到实践层面的可用性指南[8, 22],其中就包括可用性检查列表工具。

可用性检查列表的开发主要包括两个阶段:建立可用性检查列表初始项集合;对可用性检查列表初始项进行整合、优化,如删减、合并、增加及权重分析等。其中,可用性检查列表初始项集合的建立方法主要包括文献综述、模型分析、访谈(如头脑风暴法、焦点小组法等)等。例如,JI等[23]在手机可用性检查列表开发中,在文献综述基础上,通过在人机界面元素与可用性准则的匹配建立初始列表项集合;LEE等[24]基于模拟情境技术建立家用电器设备可用性检查列表的初始项集合;ALROOBAEA等[25, 26]则综合运用文献综述、用户预测试、专家焦点小组等方法,进行在线教育系统可用性检查列表初始项集合的建立。尤其需要指出的是,建立可用性检查列表初始项集合必须紧密结合面向应用的特定领域知识,例如,LIM等[27]在E-Learning系统可用性研究中,就提出了区别于一般可用性的“面向教学的可用性”概念,并以此为基础开发可用性检查列表。在建立可用性检查列表初始项集合基础上,需依据列表开发的目的和测量对象的概念结构对初始项进行整合、优化,以保证不同项之间的一致性和测量的单一维度[28]。例如,TEZZA等[29]应用项目反应理论模型评估实际测量结果的收敛性,进行可用性检查列表初始项一致性检验,并以此为依据删减部分初始项;另外的研究中,OZTEKIN等[30, 31]则应用结构方程模型对可用性检查列表进行信度和效度检验,并量化不同项的权重指数。同时,已报道部分研究中也存在着,可用性检查列表开发的两个阶段界限区分并不是很清晰,例如,通过对可用性设计准则的选择过程实现可用性检查列表项的整合、优化[23]。

可以发现,由于产品设计的用户体验和系统人因可靠性日益受到重视,可用性检查列表的研究在人因工程领域得到持续关注。但同时,一方面在研究方法上,已报道可用性检查列表开发方法主要是从系统开发者视角提出的,集中表现为可用性评价要素结构主要基于的是软件工程领域的信息系统开发框架,对于系统操作流程及流程所体现的任务结构关注不足;另一方面,在研究对象上,已报道研究中适于军事作战与训练使用情境的可用性评价准则较少,面向军事应用的针对性不明显。

2可用性检查列表开发方法

针对上述问题,本研究将可用性检查列表应用目的侧重于发现系统潜在可用性问题,提出基于可用性问题分类框架UPT的军事嵌入式信息系统可用性评价要素结构,建立面向军事应用的信息系统可用性评价准则集合,并在此基础上对信息系统可用性检查要素内容与可用性评价准则进行匹配,实现军事嵌入式信息系统可用性检查列表。

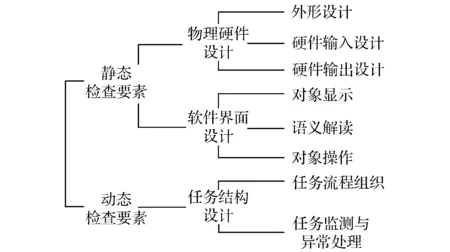

图1 基于UPT框架的信息系统可用性检查要素结构

本研究提出的可用性检查列表开发方法包括以下步骤:

(1)建立基于UPT框架的信息系统可用性检查要素结构其中,可用性问题分类UPT框架采用KEENAN等[15]提出的可用性问题分类方法,将可用性问题分为设计层面和任务层面两个考察维度,相较于其他分类技术,该方法有助于从用户视角描述可用性问题、从开发人员角度审视可用性问题产生原因及为可用性问题影响评估提供依据[11]。同时,本研究结合军事信息系统特点,对UPT进行了调整,将产品设计分为物理硬件设计和软件界面设计两部分,并以此为基础建立子层级结构,共包括3大类8个要素(见图1)。

图1中各可用性检查要素的具体内容见表1,信息系统设计层面的可用性问题通过静态检查发现,任务层面的可用性问题将主要通过动态检查发现。其中,信息系统设计层面分为物理硬件设计和软件界面设计两个大类,物理硬件设计涉及系统的外形设计、硬件输入设计、硬件输出设计等,软件界面设计涉及系统的对象显示、语义解读、对象操作等。任务结构设计包括系统的任务流程组织、任务监测与异常处理等两个方面,体现了信息系统开发人员对于军事作战与指挥流程的理解和认知,即信息系统操作使用过程中信息组织的逻辑结构和方法。对于信息系统任务结构设计的检查,必须通过基于模拟情境或实测任务的操作进行,如对于设计方案可以在设置的模拟情景中演示人机交互过程,对于原型系统则可以针对设计的操作任务进行实际测试,进而获得信息系统设计或原型系统中的任务结构方案。

表1 信息系统可用性检查要素

(2)建立面向军事应用的信息系统可用性评价准则集合①通过文献综述建立信息系统可用性评价准则初始集合;②通过专家评估,剔除“与军事应用绩效无关或受评价人员主观信念影响”的可用性评价准则;③基于多维尺度分析、聚类分析对可用性评价准则进行结构分析和优化,建立信息系统可用性评价准则结构及内容体系。

与军事信息系统相似的系统可用性评价准则研究,主要应用领域包括车载信息系统、家用电气设备、控制中心站以及可穿戴设备等的可用性评价。基于文献综述,整理得到的可用性评价准则见表2。

表2 信息系统可用性评价准则

以信息系统可用性评价准则初始集合为基础,对初试准则进行筛选,剔除标准为满足如下一个或多个条件:①重复;②与军事应用情境相关度低;③易受评价人员主观信念影响。同时,如果准则间存在包含关系,如“可见性”包含“系统状态可见性”,则剔除被包含准则,但其中考虑到将“有效性”、“效率”准则分别分解为面向一般交互过程和面向新手交互过程的对应准则更加适合军事应用情境,因此对“有效性”、“效率”准则进行剔除;如果准则存在明显多维度,如“灵活性与可控性”、“防错与可纠正性”、“表达一致性和规范性”、“系统错误可测试性和可恢复性”、“用户帮助与用户文档完善度”等,则对准则进行分解得到单一维度准则。得到可用性评价准则备选集合,结果见表3。

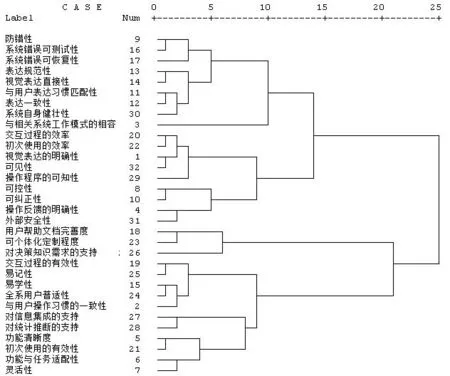

由8名可用性专家对备选集合中的可用性评价准则进行两两配对的相关性量化评估,构建准则间相关矩阵,其中,“0”代表完全不相关;“1”代表存在一定相关性;“2”代表高度相关。对准则间相关矩阵进行基于最优尺度变换的多维尺度分析,模型拟合优度Stress指标为0.092 34,D.A.F.指标为0.907 66,模型拟合效果较好,得到评价准则空间坐标见表4。

表3 信息系统可用性评价准则备选集合

注:剔除准则中项目标注代表满足的剔除条件。

表4 可用性评价准则空间坐标

图2 可用性评价准则聚类过程谱系图

应用组间平均链接法,对每项评价准则的二维空间坐标进行聚类分析,聚类过程谱系图见图2。以聚类过程谱系为基础,本研究将可用性评价准则分为人因安全性、相容性、操作便捷性、操作安全性、用户支持度、功能支持度和流程支持度等7个维度31项准则(见表5)。其中,人因安全性主要关注人机交互过程军事信息系统自身的安全,而操控安全性则体现了交互过程系统是否造成外部危害的评估;用户支持度、功能支持度和流程支持度等3个维度则用于评价信息系统对于用户操作、功能实现及任务流程的支持程度。需要指出的是,结合问题研究情境,本研究将准则“初次使用的有效性”、“功能清晰度”调整到功能支持度的维度。同时,对同一维度内的可用性评价准则进行了整合优化,使各个准则的含义更加明确:①人因安全性维度中,“系统自身健壮性”调整为“系统容错性”,“视觉表达直接性”调整为“表达直接性”;②操作简捷性维度中,“可见性”调整为“操作对象可见性”;③操控安全性维度中,删除了“外部安全性”准则。

表5 信息系统可用性评价准则结构及内容

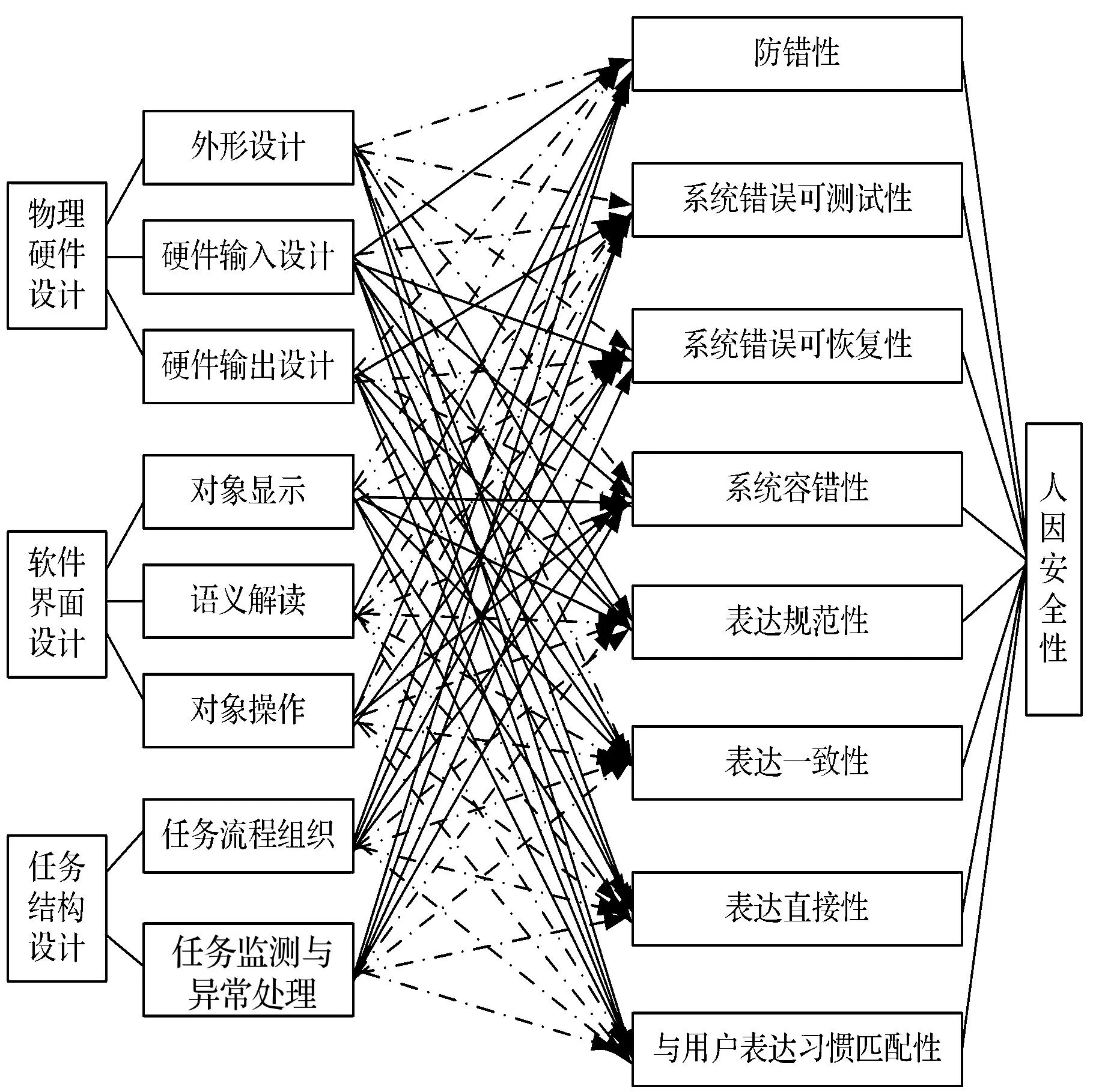

图3 可用性检查要素与人因安全性维度各准则间匹配关系

通过分析可以发现,与其他可用性准则集合相比较,军事嵌入式信息系统可用性评价准则具有两个特点:①安全性,包括人因安全性和操控安全性,占据重要地位,这是由军事信息系统任务关键性决定的;②流程支持度作为单一维度提出,体现了军事信息系统中任务流程组织的重要性,这是由于只有简洁、流畅的任务流程才能够最大程度地支持复杂条件下的军事作战与指挥。

(3)对信息系统可用性检查要素内容与可用性评价准则进行匹配其中,每一可用性评价准则并不一定适用于所有的可用性检查要素,因此,本研究用虚线表达二者之间的不适用关系,图3为可用性检查要素与可用性评价人因安全性维度各准则间的匹配关系。依据可用性检查要素内容与可用性评价准则间匹配关系,开发具体化的可用性检查问题,建立面向军事应用的信息系统可用性检查列表。为使可用性检查列表更加适于信息系统研发人员使用,可用性专家和信息系统研发人员共同对形成的检查问题进行修改和确认,不致出现模糊和歧义。

3案例研究

为了评估所提出的嵌入式信息系统可用性检查列表开发方法,本研究以基于该方法形成的军事嵌入式信息系统可用性检查列表为例,与启发式评价方法、普渡可用性检查列表[38]相比较,分析其可用性问题发现绩效。其中,用于启发式评价的可用性评价准则见表5,包含7个评价准则维度31项具体准则项目;普渡可用性检查列表基于信息处理模型提出,包括8个维度100项具体问题,其已经有成熟的中文版本,并在可用性工程实践领域应用比较广泛。3.1评价指标

发现潜在的真实可用性问题能力是评价可用性评价方法,尤其是形成性评价方法的首要标准。其中,真实属性表明该可用性问题在产品设计的实际应用中会被触发且对系统可用性水平造成实际影响。工程实践中,用于可用性评价方法评价的核心指标则主要包括完备性、效度和信度[39],并以核心指标为基础产生了其他的评价指标,如有效性、效率等[40]。其中,信度定义为评价人员间的一致性,是个体视角的评价指标,但大量实证研究表明单个评价人员仅能够发现约30%的真实可用性问题,可用性评价方法的评价须更强调面向评价人员团队[39]。因此,考虑到核心指标同其他指标间的关系,并保证研究结论的客观性,本研究从完备性和效度两方面对可用性评价方法进行分析和比较。

其中,可用性评价方法i的完备性ti定义为

(1)

式中,|Pi|=|Pi1∪Pi2∪…∪Pin|是可用性评价方法i发现的真实可用性问题集合的势;Pij(j=1,2,…,n)是评价人员j应用评价方法i发现的真实可用性问题集合;n是评价人员数目;|A|是信息系统所有的真实可用性问题集合的势,其值由如下计算方法进行估计[41]。

应用可用性评价方法i得到对|A|的估计

(2)

(3)

可用性评价方法i的效度vi定义为

(4)

3.2方法

本研究的可用性评价对象是某指挥信息系统原型系统,该信息系统基于国产CPU和操作系统平台,对于实现指挥信息装备的自主、安全、可控具有重要意义。可用性评价人员为该装备承研单位的研发工程师,共计15人,年龄在24~38岁之间(均值为32.10岁,标准差为4.24岁)。

实验过程遵循以下步骤:将15名评价人员随机分为A、B、C共3组,每组5人,A组应用启发式评价方法、B组应用普渡可用性检查列表、C组应用本研究提出的可用性检查列表分别对原型系统进行可用性评价;评价开始前,由实验人员对本次实验目的和过程进行说明,针对相应的可用性评价工具进行使用培训,确认评价人员明确知晓后开始可用性评价过程;每名评价人员的可用性评价过程是独立进行的,实验人员负责记录,评价结束后由评价人员向实验人员提交发现可用性问题清单;由8名可用性专家和3名系统用户共同对提交的15份可用性问题清单进行检查,确认真实可用性问题集合,并将最终结果反馈给实验人员。其中,评判可用性问题真实性的准则为同时满足如下条件:①实际应用中会被触发;②问题严重性对系统可用性水平造成实际影响。针对每一疑似可用性问题的评判中,6人及以上形成共识的结论作为最终结果。

3.3结果分析与讨论

(1)可用性评价方法的完备性分析

该原型系统潜在的真实可用性问题数目估计为:

max(21.94,16.26,19.76)=21.94 。

不同可用性评价方法对应的完备性见表6。

表6 不同可用性评价方法的完备性

结合可用性问题清单,可以发现5名评价人员参与的启发式评价和基于本研究提出的军事信息系统可用性检查列表方法能够发现系统潜在的80%左右真实可用性问题,高于基于普渡可用性检查列表的评价方法。主要的原因涉及:①普渡可用性检查列表的提出时间比较早,而信息技术的飞速进步已经显著地改变了各类型信息系统形态、功能及人机交互模式,限制了其对于当前信息系统可用性评价的适用性;②普渡可用性检查列表主要面向软件信息系统,而军事信息系统,如本研究中的评价对象,更多的是以嵌入式信息系统的形态出现,因此,导致其难以发现特定类型的可用性问题,如军事信息系统携行装置的人体生理适配、系统状态信息通过硬件输出的可见性等问题。

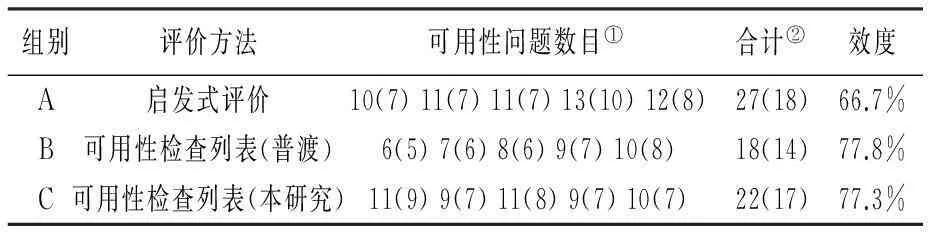

(2)可用性评价方法的效度分析

在可用性专家和系统用户对评价人员提交的可用性问题清单进行综合判定基础上,得到不同可用性评价方法的效度(见表7)。

表7 不同可用性评价方法的效度

注:①括号外数目代表评价人员提交问题数目,括号内代表经确认为真实可用性问题数目; ②合计数目中对于不同评价人员间出现的重叠项目进行了合并。

可以发现,相较于启发式评价方法,可用性检查列表方法的效度更高。结合经确认的真实可用性问题集合,表明基于启发式评价方法提交的问题清单中,经确认为非真实可用性问题主要集中于疑似可用性问题严重程度较低,可用性专家和用户认为其并不会对信息系统的操作使用造成显著影响。这是由启发式评价方法的特点决定的,其评价过程基于一系列的可用性评价准则,而准则描述了产品设计应实现的可用性特征。但是,在信息系统工程实践中,“低可用性水平”并不一定等价于存在真实的可用性问题。而本研究提出的可用性检查列表,基于UPT框架建立了信息系统可用性检查要素结构,对可用性评价准则具体化,使真实可用性问题发现的指向更加明确,因此得到了较高的效度水平。

综上所述,由于本研究提出的可用性检查列表更适用于当前军事嵌入式信息系统的特征和应用情境,且是建立在UPT框架上,能够更加准确地定位和确认真实的可用性问题,相较于启发式评价方法、普渡可用性检查列表,其能够同时具备满意的完备性和效度特征,具有显著的比较优势。

4结语

本研究面向嵌入式信息系统可用性评价需求,尤其是设计和实现过程中的系统可用性问题发现需求,提出了建立嵌入式信息系统可用性检查列表的方法,并通过案例分析,同启发式评价方法、普渡可用性检查列表相比较,分析了本研究提出的系统可用性检查列表的绩效。研究结果表明:①本研究提出的可用性检查列表同时具备较高的完备性和效度水平,更加适用于当前军事嵌入式信息系统可用性评价的问题情境;②案例研究结论也表明,本研究提出的基于UPT框架建立信息系统可用性检查要素结构,并以此为基础开发可用性检查列表的方法,具有理论支撑性和操作可行性;③上述结论也验证了面向评价对象对应的领域知识,如本研究中的军事信息系统特征,建立个性化可用性检查列表开展可用性评价的必要性和实践价值。

同时,本研究建立的嵌入式信息系统可用性检查要素结构基于的UPT框架的完备性和在其他领域的适用性则有待实证研究的进一步验证,提出的可用性检查列表构建方法的有效性在相关领域的推广则需进行验证和比较分析,这也是下一步研究工作关注的焦点。

参考文献

[1] BOUKHTOUTA A, BERGER J, GUITOUNI A, et al. Description and Analysis of Military Planning Systems [R]. Quebec, Canada: DRDC (Defence Research and Development Canada) Valcartier, 2005

[2] DIN E. 9241-11. Ergonomic Requirements for Office Work with Visual Display Terminals (VDTs)-Part 11: Guidance on Usability [S]. International Organization for Standardization, 1998

[3] TARKKANEN K, HARKKE V, REIJONEN P. Are We Testing Utility? Analysis of Usability Problem Types [M]//MARCUS A. Design, User Experience, and Usability: Design Discourse. Berlin Heidelberg: Springer-Verlag, 2015: 269~280

[4] VENKATESH V, DAVIS F D. A Theoretical Extension of the Technology Acceptance Model: Four Longitudinal Field Studies [J]. Management Science, 2000, 46(2): 186~204

[5] NIELSEN J, MOLICH R. Heuristic Evaluation of User Interfaces [C]. Proceedings of the SIGCHI Conference on Human Factors in Computing Systems, New York: ACM, 1990: 249~256

[6] BEVAN N, MACLEOD M. Usability Measurement in Context [J]. Behaviour & Information Technology, 1994, 13(1-2): 132~145

[7] GOUIN D, VERNIK R, WARK S. Using Large Group Displays to Support Intensive Team Activities in C2 [R]. Quebec, Canada: DRDC (Defence Research and Development Canada) Valcartier, 2011

[8] HERTZUM M. Images of usability [J]. International Journal of Human-Computer Interaction, 2010, 26(6): 567~600

[9] HORNB K K. Current Practice in Measuring Usability: Challenges to Usability Studies and Research [J]. International Journal of Human-Computer Studies, 2006, 64(2): 79~102

[10] KHAJOUEI R, PEUTE L W, HASMAN A, et al. Classification and Prioritization of Usability Problems Using an Augmented Classification Scheme [J]. Journal of Biomedical Informatics, 2011, 44(6): 948~957

[11] HAM D-H. A Model-Based Framework for Classifying and Diagnosing Usability Problems [J]. Cognition, Technology & Work, 2014, 16(3): 373~388

[12] CHILLAREGE R, BHANDARI I S, CHAAR J K, et al. Orthogonal Defect Classification: A Concept for In-Process Measurements [J]. IEEE Transactions on Software Engineering, 1992, 18(11): 943~956

[13] LESZAK M, PERRY D E, STOLL D. Classification and Evaluation of Defects in a Project Retrospective [J]. Journal of Systems and Software, 2002, 61(3): 173~187

[14] VILBERGSDOTTIR S G, HVANNBERG E T, LAW E L-C. Assessing the Reliability, Validity and Acceptance of a Classification Scheme of Usability Problems (CUP) [J]. Journal of Systems and Software, 2014, 87(1): 18~37

[15] KEENAN S L, HARTSON H R, KAFURA D G, et al. The Usability Problem Taxonomy: A Framework for Classification and Analysis [J]. Empirical Software Engineering, 1999, 4(1): 71~104

[16] ANDRE T S, HARTSON H R, BELZ S M, et al. The User Action Framework: A Reliable Foundation for Usability Engineering Support Tools [J]. International Journal of Human-Computer Studies, 2001, 54(1): 107~136

[17] RYU H, MONK A F. Analysing Interaction Problems with Cyclic Interaction Theory: Low-level Interaction Walkthrough [J]. PsychNology Journal, 2004, 2(3): 304~330

[18] KUSHNIRUK A W, TRIOLA M M, BORYCKI E M, et al. Technology Induced Error and Usability: The Relationship between Usability Problems and Prescription Errors when Using a Handheld Application [J]. International Journal of Medical Informatics, 2005, 74(7): 519~526

[19] LEWIS J R. Usability: Lessons Learned… and Yet to be Learned [J]. International Journal of Human-Computer Interaction, 2014, 30(9): 663~684

[20] PAGE C A K, SCHADLER A. A Nursing Focus on EMR Usability Enhancing Documentation of Patient Outcomes [J]. Nursing Clinics of North America, 2014, 49(1): 81~90

[21] SHNEIDERMAN B. Designing the User Interface: Strategies for Effective Human-Computer Interaction [M]. Boston, MA: Addison-Wesley Reading, 1992

[22] TE’ENI D, CAREY J M, ZHANG P. Human-computer Interaction: Developing Effective Organizational Information Systems [M]. Hoboken, New Jersey: John Wiley & Sons, 2005

[23] JI Y G, PARK J H, LEE C, et al. A Usability Checklist for the Usability Evaluation of Mobile Phone User Interface [J]. International Journal of Human-Computer Interaction, 2006, 20(3): 207~231

[24] LEE K I, JIN B S, JI Y G. The Scenario-Based Usability Checklist Development for Home Appliance Design: A Case Study [J]. Human Factors and Ergonomics in Manufacturing & Service Industries, 2011, 21(1): 67~81

[25] ALROOBAEA R S, AL-BADI A H, MAYHEW P J. Generating an Educational Domain Checklist through an Adaptive Framework for Evaluating Educational Systems [J]. International Journal of Advanced Computer Science and Applications, 2013, 4(8): 194~200

[26] ALROOBAEA R S, AL-BADI A H, MAYHEW P J. Generating a Domain Specific Inspection Evaluation Method through an Adaptive Framework: A comparative Study on Educational Websites [J]. International Journal of Human Computer Interaction, 2013, 4(2): 88~116

[27] LIM C, LEE S. Pedagogical Usability Checklist for ESL/EFL E-Learning Websites [J]. Journal of Convergence Information Technology, 2007, 2(3): 67~76

[28] CLARK L A, WATSON D. Constructing Validity: Basic Issues in Objective Scale Development [J]. Psychological Assessment, 1995, 7(3): 309~319

[29] TEZZA R, BORNIA A C, DE ANDRADE D F. Measuring Web Usability Using Item Response Theory: Principles, Features and Opportunities [J]. Interacting with Computers, 2011, 23(2): 167~175

[30] OZTEKIN A, NIKOV A, ZAIM S. UWIS: An assessment Methodology for Usability of Web-Based Information Systems [J]. Journal of Systems and Software, 2009, 82(12): 2 038~2 050

[31] OZTEKIN A, KONG Z J, UYSAL O. UseLearn: A Novel Checklist and Usability Evaluation Method for ELEARNING SYSTEms by Criticality Metric Analysis [J]. International Journal of Industrial Ergonomics, 2010, 40(4): 455~469

[32] RAVDEN S, JOHNSON G. Evaluating Usability of Human-Computer Interfaces: A Practical Method [M]. New York: Halsted Press, 1989

[33] NIELSEN J. Heuristic Evaluation[M]//NIELSEN J, MACK R L. Usability Inspection Methods. New York: Wiley, 1994: 25~62

[34] HARVEY C, STANTON N A, PICKERING C A, et al. A Usability Evaluation Toolkit for In-Vehicle Information Systems (IVISs) [J]. Applied Ergonomics, 2011, 42(4): 563~574

[35] WONG-PARODI G, FISCHHOFF B, STRAUSS B. A Method to Evaluate the Usability of Interactive Climate Change Impact Decision Aids [J]. Climatic Change, 2014, 126(3-4): 485~493

[36] ALONSO-R OS D,MOSQUEIRA-REY E,MORET-BONILLO V. A Taxonomy-Based Usability Study of an Intelligent Speed Adaptation Device [J]. International Journal of Human-Computer Interaction, 2014, 30(7): 585~603

[37] WANG C-M, HUANG C-H. A Study of Usability Principles and Interface Design for Mobile E-Books [J]. Ergonomics, 2015, 58(8): 1 253~1 265

[38] LIN H X, CHOONG Y Y, SALVENDY G. A Proposed Index of usability: A Method for Comparing the Relative Usability of Different Software Systems [J]. Behaviour & Information Technology, 1997, 16(4-5): 267~277

[39] HARTSON H R, ANDRE T S, WILLIGES R C. Criteria for Evaluating Usability Evaluation Methods [J]. International Journal of Human-Computer Interaction, 2001, 13(4): 373~410

[40] HVANNBERG E T, LAW E L C, L Rusd Ttir M K. Heuristic Evaluation: Comparing Ways of Finding and Reporting Usability Problems [J]. Interacting with Computers, 2007, 19(2): 225~240

[41] KANIS H. Estimating the Number of Usability Problems [J]. Applied Ergonomics, 2011, 42(2): 337~347

(编辑刘继宁)

Development of Usability Checklist for Embedded Information Systems:A Case Study

LI Xiaojun1,2XIAO Zhongdong1LI Jia3

(1. Xi’an Jiaotong University, Xi’an, China; 2. Rocket Force University of Engineering,Xi’an, China; 3. East China University of Science and Technology, Shanghai, China)

Abstract:To evaluate the usability of embedded information systems in military domain, this study proposes a development framework of usability checklist combining with the characteristics of designs and tasks. The elements and dimensions of design are established based on the framework of usability problem taxonomy, and the set of evaluation principles is built. And then the usability checklist is proposed by matching design elements and evaluation principles, and the performance of the proposed usability checklist is tested through a case study. The results show that the proposed checklist is with better thoroughness and validity compared with heuristic evaluation and Purdue Usability Testing Questionnaire. And the checklist is more appropriate in the contexts of usability evaluation of embedded information systems. The results also verify indirectly the essential role and feasibility of the proposed development framework of usability checklist. And it also verifies the need and value of developing specific usability checklist based on domain knowledge.

Key words:human factors; usability checklist; case study; embedded information systems

中图法分类号:C93

文献标志码:A

文章编号:1672-884X(2016)04-0595-10

基金项目:国家科技支撑计划资助项目(2015BAK16B02);国家自然科学基金资助项目(71371005);国家社会科学基金资助项目(15GJ003-243)

收稿日期:2015-12-29

通讯作者:周劲波(1970~),男,广西桂林人。广西师范大学(广西省桂林市541004)经济管理学院教授,博士。研究方向为企业管理。E-mail:jbzhou@163.com 李晓军(1981~),男,河北秦皇岛人。火箭军工程大学(西安市710025)908教研室讲师。研究方向为武器系统人因工程。E-mail: xi_anlxj@126.com

DOI编码: 10.3969/j.issn.1672-884x.2016.04.015