基于场相关性的运动自适应去隔行算法

史久根, 刘 军

(合肥工业大学 安全关键工业控制技术教育部工程研究中心 安徽 合肥 230009)

现代隔行扫描方式在电视系统中被广泛运用,去隔行已经成为基础性的处理过程。在隔行扫描一帧中的奇数行被存储在一场,下一帧中的偶数行被存储在下一场。如果隔行格式的视频在逐行扫描方式的显示设备(如LCD、PC显示器等)上直接显示,则会产生锯齿效应使观看者不适。通常,去隔行处理的目标就是根据在时间方向和空间方向上相邻行中的信息去重建那些在隔行扫描方式中丢失的行。现在已经提出了很多的去隔行算法,其目标就是在计算开销和图像质量上达到均衡。概括地讲,算法可划分为场内去隔行算法、场间去隔行算法和混合去隔行算法。

场内去隔行算法是利用图像在空间方向上的信息,使用单场中的像素插值,常用的有行重复法(line doubling)[1-2]、行平均法(line average)[1]和基于边缘的插值算法ELA(edge-based line average)[3-4]等;场间去隔行算法使用时间和空间方向的信息插值,分为运动补偿去隔行算法(motion compensated)[5-7]和非运动补偿算法(non-motion compensated);混合去隔行算法主要指运动自适应去隔行算法(motion adaptive)[8-11],它首先通过运动检测算法把图像分为运动区域和静止区域,然后对不同区域自适应地选择相应的去隔行算法,由于此类去隔行算法能够获得较高的去隔行质量,而且复杂度适中,得到了广泛的应用。

本文基于混合去隔行策略,提出一种基于场相关性的运动自适应去隔行算法(Correlation of Field Based Motion Adaptive De-interlacing,简称CFMAD),首先通过相邻场像素的相关性计算出运动区域和静止区域,然后对运动区域使用边缘分类的场插值算法ECFI(edge classification field interpolation)插值。该算法能够有效地保留场中的窄边缘,从而提高图像的质量。

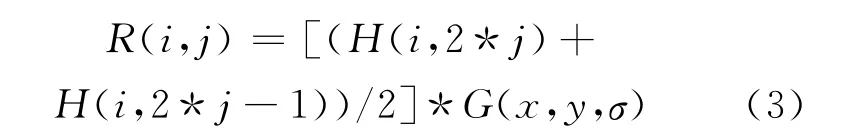

1 CFMAD算法

在隔行视频中,每次显示的图像称为一场,相邻的2场在时间维度上有一个时间间隔。如果在这个时间间隔内相邻场中的对应区域没有发生相对运动,则称该区域在相邻的场中具有相关性;如果相邻的2场中对应区域来自不同的场景,则该区域在相邻的场中无相关性。CFMAD算法的处理流程由视频预处理、运动状态分类和自适应插值3部分组成,视频预处理通过平滑算法降低视频中噪声的干扰,然后通过场间区域的相关性将待去隔行场的状态分为静止状态和运动状态,前者采用merge去隔行算法处理,后者通过基于边缘分类的插值算法自适应地选择相应的去隔行算法。

1.1 场尺度平滑

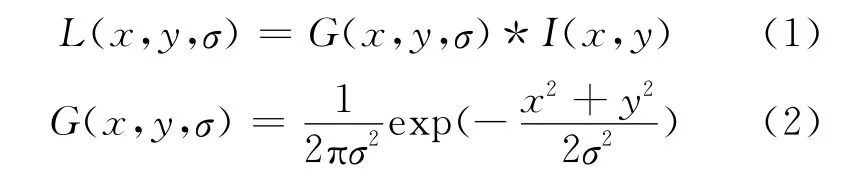

尺度空间理论最早出现在计算机视觉领域,其目的是描述图像数据的多尺度特征。Koendetink证明高斯卷积核是实现尺度变换的唯一变换核,而Lindeberg证明高斯核是唯一的线性核。因此,一个图像的尺度空间就定义为一个函数L(x,y,σ),它是不同尺度的高斯函数和输入图像的卷积。

其中,(2)式为高斯函数。

在尺度变换的过程中,由于输入的I(x,y)需要包含图像中的完整信息,因此场在进行尺度变换之前需要做相应的调整,调整方法为:由于场的垂直分辨率为原图像的1/2,而水平分辨率不变,故将水平分辨率通过线性插值进行0.5倍的缩小,则得到图像作为(1)式的输入,如图1所示。

在图1中,F为待处理场,H 为场中的有效行组成的图像,R表示经过水平缩放并高斯卷积后的图像,其中R可表示为:

在(3)式中,[H(i,2*j)+H(i,2*j-1)]/2表示H经过水平缩放后得到的图像。

图1 场尺度平滑流程图

1.2 基于场相关性的运动检测算法

在图2中,黑色圆圈表示像素值已知,灰色圆圈表示待插值像素,Fn表示当前场分别表示接下来的相邻3场。

图2 视频序列中相邻4场的模型

其中,(7)式表示Fn中以Fn(2*i,2*j)为中心,块大小为5×5的区域和相邻场对应区域的相关系数,设定阈值为th,当E(2*i,2*j)大于th时,该区域为运动区域,否则为静止区域。

1.3 ECFI算法

运动检测算法把输入的视频序列分为运动区域和静止区域,静止区域可以通过相邻2场合并的方法去隔行,对运动区域而言,由于相邻的2场发生了相对运动,直接合并会造成锯齿效应并严重影响输出图像的品质。因此,对于场中的运动区域,由于和时间维度上的相邻区域的无关性,丢失的像素只使用当前场中已有行的像素值计算。根据上述分析,本文提出了一种基于边缘分类的场插值算法,该算法将场中的边缘部分分为宽边缘、窄边缘2类。

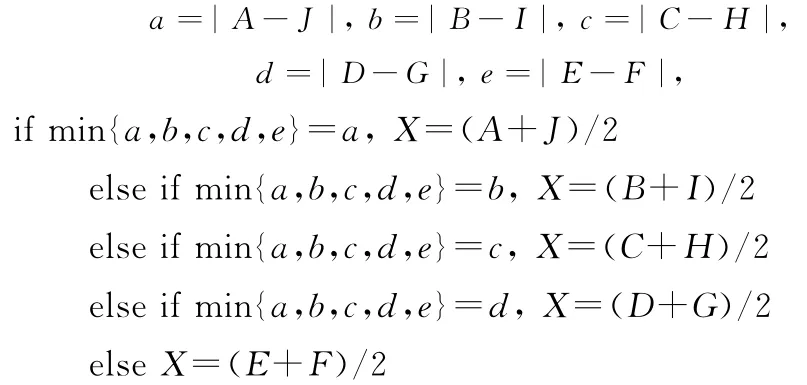

宽边缘指边缘分界面的两边宽度都大于某一阈值(该阈值的大小由宽边缘采用的插值方法决定,本文中为5个像素),对宽边缘部分的处理方法为:计算图中5个方向差的绝对值,找出其中最小者,差最小的2元素值的平均值即为所插像素的值。宽边缘插值如图3所示。

图3 宽边缘插值示意图

算法如下:

窄边缘主要出现在图像中的文字部分及画面中的细窄物体边缘,如果把这一部分边缘信息和其他边缘等同处理,容易造成边缘不连续从而导致最终的画面在这一部分出现闪烁,根据斜窄边缘的特点,窄边缘可分为4类:右倾深色窄边缘、右倾浅色窄边缘、左倾深色窄边缘、左倾浅色窄边缘。下面以右倾深色窄边缘为例说明本文提出的方法。

图4 窄边缘插值示意图

如果a<b,c>d和e>f同时成立,则X为右倾深色窄边缘上的点,即

窄边缘中的其他3类按照上述方法相应处理。

2 实验结果与分析

本文在Matlab上进行了仿真实验,分别采用本文的算法和传统的line doubling、field merge和ELA算法对一系列的标准视频进行去隔行处理,计算出整个视频序列的平均峰值信噪比(peak signal to noise ratio,简称PSNR),见表1所列。

表1 视频序列的平均PSNR比较

从表1中的试验数据可以看出,使用基于场相关性的运动自适应去隔行算法处理得出的平均PSNR值要明显高于其他算法处理得到的数值。

3 结束语

本文通过计算场间的相关性检测场中的运动区域。对检测出的运动区域进行边缘分类,对不同种类的边缘自适应地选择相应的插值方法。实验表明这种方法能够达到比较好的去隔行效果,不仅对传统的运动自适应算法进行了改进,而且其中的基于边缘分类的场插值算法对运动补偿去隔行算法具有一定的参考价值。

[1]Haan G D,Bellers E B.De-interlacing:an overview[J].Proceedings of the IEEE,1998,86(9):1839-1857.

[2]Lee MH,KiMJ H,Lee J S,et al.A new algorithMfor interlaced to progressive scan conversion based on directional correlations and its IC design [J].IEEE Transactions on Consumer Electronics,1994,40(2):119-129.

[3]Doyle T.Interlaced to sequential conversion for EDTV applications[C]//Proc Second Int Workshop Signal Processing of HDTV,1998:412-430.

[4]Hentschel C.Comparison between median filtering and vertical edge controlled interpolation for flicker redeuction[J].IEEE Transactions on Consumer Electronics,1989,35(3):279-289.

[5]Haan G D.IC for motion-compensated de-interlacing,noise reduction,and picture-rate conversion[J].IEEE Transactions on Consumer Electronics,1999,45(3):617-624.

[6]Huang Qian.De-interlacing using hierarchical motion analysis[J].IEEE Transactions on Circuits systems for Video Technology,2010,20(5):673-682.

[7]Chen Yingru.True motion compensated de-interlacing algorithm[J].IEEE Transactions on Circuits and Systems for Video Technology.2009,19(10):1489-1498.

[8]刘晓东,丁 勇,严晓浪.一种基于运动分类的运动自适应去隔行算法[J].仪器仪表学报,2011,32(10):2275-2282.

[9]Lee K.High quality de-interlacing using content adaptive vertical temporal filtering[J].IEEE Transactions on Consumer Electronics,2010,56(4):2469-2474.

[10]丁 勇,陆生礼,时龙兴.时空权重和边缘自适应去隔行[J].计算机学报,2007,30(4):655-660.

[11]Brox P.Fuzzy motion-adaptive interpolation with picture repetition detection for de-interlacing[J].IEEE Transactions on Instrumentation and Measurement,2009,58(9):2952-2958.