基于图像变换的无监督对抗样本检测方法研究

摘要深度神经网络(DNNs)对经过特殊设计的对抗样本存在脆弱性,容易受到欺骗.目前的检测技术虽能识别一些恶意输入,但在对抗复杂攻击手段时,其保护能力仍显不足.本文基于无标记数据提出一种新型无监督对抗样本检测方法,其核心思想是通过特征的构建与融合,将对抗样本检测问题转化为异常检测问题,为此设计了图像变换、神经网络分类器、热力图绘制、距离计算以及异常检测器5个核心部分.先对原始图像进行变换处理,将变换前后的图像分别输入神经网络分类器,提取预测概率数组与卷积层特征绘制热力图,并将检测器从单纯关注模型输出层拓展到输入层特征,增强检测器对对抗样本和正常样本差异的建模和度量能力,进而计算变换前后图像的概率数组KL距离与热力图关注点变化距离,将距离特征输入异常检测器判断是否为对抗样本.在大尺寸高质量图像数据集 ImageNet上进行实验,本检测器面向5种不同类型攻击取得的平均AUC值为0.77,展现出良好的检测性能.与其他前沿的无监督对抗样本检测器相比,本检测器在保持相近的误报率的情况下TPR大幅领先,检测能力具有明显优势.

关键词对抗样本检测;无监督学习;对抗攻击;深度神经网络;图像变换

中图分类号TP391.4

文献标志码A

0 引言

深度学习作为当今科技领域内最具活力的研究分支之一,已在众多领域取得了突破性进展,特别是在图像识别、目标检测、文本分析和推荐系统等方面的成就尤为显著.然而,随着这些技术的广泛部署,相应的安全隐患也逐渐显现.2015年,Goodfellow等 [1]首次揭示了对抗样本的存在,即通过向图像中添加细微的、人眼难以察觉的扰动,可以使得深度神经网络(Deep Neural Networks,DNNs)误分类,且常常以高置信度给出错误预测.这一发现凸显了深度学习模型在抵御恶意攻击方面的脆弱性,从而引发人们对用户安全和隐私保护的严重关切.

在基于图像的对抗样本检测领域,研究人员已经提出很多检测方法.Tian 等[2]发现对抗样本通常对某些图像变换操作很敏感,比如旋转和移动,相比之下正常图像一般不受这种操作的影响.基于这一现象,他们利用正常样本变换后的Softmax 分布和对抗样本变换后的Softmax分布训练一个二分类模型来检测对抗样本.该方法对某些攻击类型如CW攻击敏感,但对其他不同的攻击方法(如BIM、PGD)效果不佳.Agarwal 等[3]提出一种利用图像离散余弦变换和离散小波变换,通过计算多尺度和多方向梯度来编码边缘信息的检测方法,该方法对高级的对抗攻击,尤其是规避变换检测的攻击效果不明显.Xu等[4]提出一种特征挤压(Feature Squeezing,FS)方法,通过减少输入数据的颜色位深度和空间平滑滤波,来减少对抗样本中细微扰动的效果,从而降低其对模型的影响,但对高度精细的对抗攻击可能仍然不够鲁棒.上述方法存在对产生对抗样本的攻击类型检测不足和性能有待提升的问题.

为了对多种攻击类型产生的对抗样本进行检测,更有效地帮助图像分类模型防御对抗样本的攻击,本文在传统基于图像变换的对抗样本检测技术基础上,设计了一种实用的无监督对抗样本检测器.无监督对抗样本检测器在构建过程中不依赖于对抗样本的特征,因此其泛化性具有潜在优势.本文的主要工作如下:

1)提出一种基于图像特征融合的无监督对抗样本检测方法,其包含图像变换、神经网络分类器、热力图绘制、距离计算以及异常检测器5个互相依赖的模块,具备良好的实用性与可扩展性.具体而言,在图像变换模块,采用9种具有明确意义的图像变换策略,如旋转、错切、缩放等变换,放大了潜在的对抗扰动与原始图像间的差异,为后续特征分析提供了具有代表性的新视角.分别提取原始图像和经过变换的图像在分类器输出层的差异,一方面利用KL散度等方法度量Softmax概率输出的分布差异,另一方面引入Grad-CAM[5]技术,通过可视化模型关注区域并量化热力图的偏移量,测量空间注意力的差异性.在异常判别模块,通过融合互补的概率分布差异特征和空间注意力差异特征,并采用多种高效的无监督异常检测算法进行对抗样本检测,包括孤立森林[6]、One-Class SVM[7]、LOF[8]等.在这些模块的有机结合下,以较低的样本复杂度与计算复杂度实现了高性能的对抗样本检测,为提升深度学习模型的鲁棒性提供了新的解决思路.

2)采用大型、高分辨率的ImageNet数据集进行测试,其中包含高清晰度的彩色图像,更符合真实世界中常见的图像规格,从而增强了对抗样本检测器在现实应用中的适用性和实用价值.

1 相关工作

1.1 对抗攻击

1.1.1 基本介绍

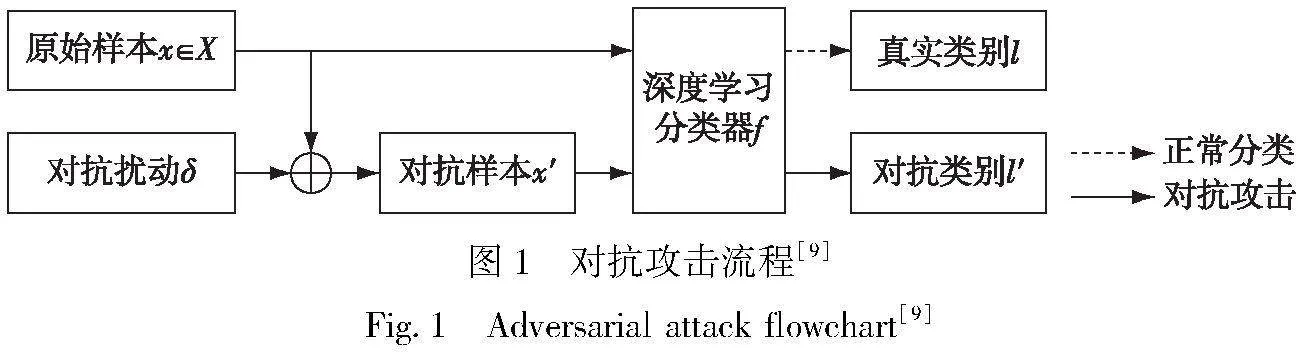

对抗攻击(Adversarial Attacks)是指通过对输入数据进行微小的、有针对性的修改,从而欺骗机器学习模型的行为.这些修改通常不会改变人眼观察的图像或样本的本质,但足以使模型产生错误的预测.对抗攻击可能会对机器学习模型的安全性和可信度造成威胁,尤其是在涉及安全关键领域,如图像识别、人脸识别、自动驾驶等.对抗攻击[9]的基本流程如图1所示.

1.1.2 常见的对抗攻击方法

Goodfellow等[1]提出的FGSM(Fast Gradient Sign Method)攻击通过模型梯度生成对抗样本,扰动量由超参数ε控制.BIM攻击[10]是FGSM的迭代版,它通过多步迭代微扰输入样本,逐步达到攻击目的,每步都重新计算梯度.CW攻击[11]是由Carlini和Wagner提出的一种针对机器学习模型的对抗样本生成方法,旨在最小化目标函数生成最佳扰动,主要有两种方法:基于L0的CW0和更常用、基于L2的CW2,后者因平滑性更适合实际优化.

基于解析几何原理,Moosavi-Dezfooli等[12]提出了DeepFool攻击方法,通过计算最小扰动改变样本标签,通过迭代将样本推向决策边界,直至越界,其L2范数衡量的扰动量小于FGSM.PGD攻击[13]采用与BIM类似的迭代方法,通过多次迭代修改输入数据,每次迭代将扰动限制在规定范围内,从而生成能够误导模型的输入样本.

1.2 对抗样本检测

对抗样本检测技术旨在检测图像中的对抗样本,即经过有意设计的对深度学习模型具有误导性的图像输入.它在提高模型鲁棒性、增强模型安全性、降低数据不确定性、提高模型可解释性以及辅助对抗样本生成等方面具有重要的优势,对深度学习模型的应用和研究具有重要意义.对抗样本检测技术一般被划分为以下4类:基于统计方法的对抗样本检测技术、基于辅助模型的对抗样本检测技术、基于神经网络特性的对抗样本检测技术、基于降噪处理的对抗样本检测技术.

1)基于统计方法的对抗样本检测技术的核心思想是利用对抗样本与原始样本的不同数字特征,通过检测输入是否符合正常样本的分布,从而判断输入是否具有对抗性.

2)基于辅助模型的对抗样本检测技术核心思想是通过提取样本的特征来训练一个二分类模型用于检测正常样本与对抗样本.

3)基于神经网络特性的对抗样本检测技术的核心思想是通过观察正常样本与对抗样本在神经网络中的表现或者行为,一般体现在利用神经网络内部神经元的激活值或者输出值的特性来构建检测器检测对抗样本.

4)基于降噪处理的对抗样本检测技术主要思路是通过对输入样本进行类似降噪的处理,探索降噪后正常样本与对抗样本之间的差异,因为对抗样本本质上可视为一种添加特殊噪声的正常样本,最后通过阈值或预测不一致的形式实现检测.

2 无监督的对抗样本检测方法

本文提出一种基于图像特征融合的对抗样本检测框架,包含图像变换、神经网络分类器、热力图绘制、距离计算以及异常检测器5个互相依赖的模块,充分利用了对抗样本在多个图像视角和特征空间呈现出的异常性质,具备良好的实用性与可扩展性,整体架构如图2所示.首先对原始图像x进行变换处理,得到变换后的图像x′.然后将x与x′分别输入神经网络分类器,利用神经网络分类器提取x与x′的预测概率数组与卷积层特征绘制热力图.接下来计算图像x和x′的概率数组的KL距离D1与热力图关注点变化距离H1,将距离特征(D1,H1)输入异常检测器,判断样本是否是对抗样本.

2.1 图像变换

数据处理主要是对输入样本的变换,包括加性噪声、平滑滤波、位深度减少、去高频、平移、翻转、旋转、错切、缩放等方法.为确定最适合本研究的图像变换技术,本文对上述多种方法进行了测试,最终选取效果最佳的一种作为主要的变换方法.常见的9种图像变换的示例如图3所示.

2.2 神经网络分类器

本文主要使用神经网络架构VGG19[14]作为分类器.VGG19是一个经典的卷积神经网络结构,在图像分类任务上表现优异.它的结构简单明了,包含连续的卷积层和池化层,最后接全连接层和Softmax输出层.这种规整的结构有助于在特征图上应用Grad-CAM算法,生成清晰的热力图.相比之下,一些更加复杂的网络结构(如ResNet的残差连接、Inception的并行模块等)可能会干扰Grad-CAM的梯度回传,影响热力图的质量.

VGG19拥有较大的感受野和丰富的特征表示能力.它使用了一系列3×3的小卷积核,通过不断加深网络来扩大感受野,能够捕捉图像中的局部和全局特征.这种多尺度的特征表示有助于在不同抽象层次上分析对抗样本的扰动效应.相比之下,一些浅层网络(如AlexNet)的特征表示能力相对有限,可能难以准确刻画对抗扰动的细微变化.

VGG19在图像分类领域得到了广泛应用和验证,预训练模型容易获取,可以方便地在不同数据集上进行迁移学习,快速建立起鲁棒的分类器.相比之下,一些专用的分类模型(如针对特定域的网络)可能缺乏可靠的预训练权重,需要从头训练,影响实验效率.

2.3 绘制热力图

为了洞察神经网络决策过程,本文使用Grad-CAM[5](Gradient-weighted Class Activation Mapping)绘制热力图.Grad-CAM是一种可解释性图像分类方法,用于可视化深度卷积神经网络中的注意力区域.

在执行图像分类任务时,卷积神经网络通过识别和学习图像特征来进行分类判断.Grad-CAM利用网络的梯度信息来确定每个类别在卷积层特征图中的重要性,进而生成针对特定类别的热力图.这些热力图突出显示了对分类决策至关重要的图像区域.具体来说,Grad-CAM通过分析网络最后一个卷积层的特征图和相应的输出类别梯度,计算出对于特定类别预测贡献最大的区域.然后,它将这些区域映射回输入图像,形成一张表征模型视觉注意力的热力图.Grad-CAM的可视化流程如图4所示.

输入图像先被送入一个预训练的卷积神经网络中进行前向传播,以获得网络最后一个卷积层的特征图和各个可能类别的预测概率.随后,针对网络预测的类别(目标类别),将该类别的梯度设为1,而其他类别的梯度设为0.这样做可以通过反向传播计算得出目标类别相对于最后一个卷积层输出的特征图的梯度,揭示出每个位置对于识别目标类别的重要性.接着,对梯度值执行全局平均池化操作,从而为每个特征通道生成一个权重值.这些权重揭示了每个通道在识别目标类别时的重要性.每个特征通道的权重与对应的特征图相乘,并对所有通道的结果进行逐通道求和,以生成代表类别激活的热力图.最后,该类别激活热力图会被叠加到原始输入图像上,创建出Grad-CAM的可视化结果,按照jet方式对热力图进行颜色映射.数值越大的区域,对应的颜色越亮,对于目标类别的决策贡献也越大.通过使用Grad-CAM,可以直观地了解到,在进行图像分类时哪些区域是网络关注的焦点.图5展示了正常样本(良性样本)与对应的对抗样本在经历变换前后的热力图对比.通过对比可以明显看出,对抗样本在变换后的热力图关注区域与良性样本相比发生了显著改变,表明对抗样本通过图像变换显著改变了网络关注的特征.

2.4 距离计算

2.4.1 概率数组距离计算

本文通过应用KL散度来量化这种差异.KL散度是一种用于衡量两个概率分布之间差异的指标,两个分布之间的差异越显著,KL散度的值越大,计算式为

2.4.2 热力图关注点距离计算

在绘制出的热力图中数值越大、颜色越亮的区域代表对分类结果的贡献越大.本文选取原始值大于0.5的区域作为关注区域,计算区域中心点的坐标作为关注点.具体计算过程如下:

1)对于样本xi,使用Grad-CAM技术绘制热力图进行距离计算时,不需要覆盖到原图上进行可视化处理.以VGG19为例,选取最后一个卷积层大小为7×7,绘制出的热力图与卷积层大小有关,热力图大小为7×7×1,使用双线性插值法将热力图放大为原图尺寸.分别绘制出图像变换前的热力图Mi与图像变换后的热力图M′i,其中,所有元素都在0到1之间.

2)元素mij∈Mi,i=0,1,…,n,j=0,1,…,n.选出Mi与M′i中大于0.5的mij,每个选出的mij都有对应索引(aij,bij),其中,aij表示元素在图中的横坐标,bij表示元素在图中的纵坐标.最后得到k个大于0.5的mij索引,即k×2的数组.

3)分别计算所有aij与bij的平均值,得到Mi的关注区域中心坐标mcenter,i.同理得到M′i的关注区域中心坐标m′center,i.

4)计算图像变换前后热力图关注区域中心点坐标的欧氏距离Hi:

Hi=mcenter,i-m′center,i2.(2)

2.5 异常检测器

无监督学习的异常检测算法适用于那些没有标签的数据集,其中既包含良性样本也包含对抗样本.异常值检测也被称为离群值检测,它不依赖于预先标记的异常样本.依托于数据本身的分布和特征,通过识别那些与大多数数据点显著不同的观测值来检测异常.本文选取3种无监督异常检测方法进行测试,并采用KL距离以及热力图关注点距离(Di,Hi)作为样本的2个特征.

2.5.1 孤立森林

孤立森林(Isolation Forest)[6]是一种流行的无监督异常检测方法,它依靠随机分割特征空间的方式来识别异常值.该算法通过随机选择特征并对数据进行随机划分来构建多棵决策树.在这些树中,数据被逐渐划分成越来越小的子集,直至每个子集只包含单一样本点或达到预设的树的深度.在构建过程中,样本点从根节点到达叶节点的路径长度被记录下来.路径越短,说明样本点越容易被孤立出来,因而更有可能是异常.通过对多棵树中的路径长度求平均,可以计算出每个样本的异常评分.评分越高的样本越有可能是异常点.最终,根据这些评分和预定的阈值来判定异常点.

2.5.2 One-Class SVM

One-Class SVM(Support Vector Machine)是另一种常用的无监督异常检测方法[7].其主要思想是找到最能代表正常数据分布的模型,并将那些与此模型偏差较大的点视为异常.该算法首先将正常数据映射至一个高维特征空间,并试图找到一个最大间隔超平面来包围这些数据点.这个超平面定义了数据的正常区域,与正常数据点之间的间隔被最大化.对于新的观测点,算法计算其到超平面的距离,距离较远的点更有可能被标记为异常.

2.5.3 Local Outlier Factor

LOF(局部离群因子,Local Outlier Factor)[8],是一种基于邻域密度差异的异常检测方法.它通过比较一个点与其邻近点的密度来鉴别异常.点与点之间的距离越远,密度越低;距离越近,密度越高.LOF算法首先计算数据集中每个点的k最近邻距离,然后利用这些距离来估算点的局部密度.每个点的局部可达密度是基于它到k个邻近点的可达距离的平均值来计算的.最后,通过比较数据点的局部可达密度与其邻近点的局部可达密度,计算出局部离群因子.当LOF值高于某个阈值时,该点被认为是离群点.

3 实验与结果

3.1 实验设置

3.1.1 数据集

本文使用的是ImageNet LSVRC 2012验证集[15],这个数据集包含的是高清晰度的大尺寸彩色图像,更贴近现实世界中图像的常见特征.ImageNet LSVRC 2012数据集拥有1 000个不同的类别,每个类别包含约120万张彩色图片,其中包括1 000张训练图片和50张验证图片.图片的清晰度参差不齐,但大多数图片具有较高的质量和丰富的细节.本文中,ImageNet LSVRC 2012验证集的每个类别都使用了50张图片.为了适应所使用的模型,所有的ImageNet图片在输入模型之前被统一处理成224×224像素的大小.

3.1.2 网络模型

为了实现对ImageNet数据集的高效分类,本文采用预训练好的VGG19网络模型.VGG19模型在ImageNet数据集上的表现非常出色,其Top-1准确率达到71.3%,Top-5准确率高达90%.

3.1.3 对抗样本生成

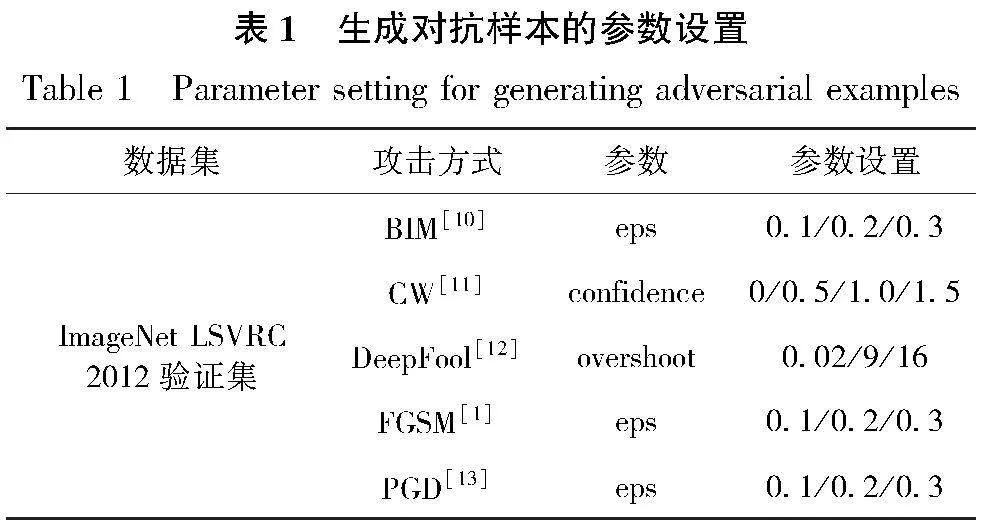

在进行异常检测的实验过程中,对抗样本的生成是不可或缺的一环.为评估模型的鲁棒性,本文采用5种常见的对抗攻击方法,使用CleverHans工具[16]生成不同攻击方式下不同强度的对抗样本.具体的参数设置如表1所示.

3.1.4 评价指标

为了全面评估模型对于对抗样本的检测效果,本文选取检测查准率、查全率、准确率、ROC(Receiver Operating Characteristic)曲线与AUC(Area Under the ROC Curve)作为评价指标.

1)查准率(True Negative Rate,TNR):表示正确识别为良性样本的比例.TNR的值越大,说明模型识别良性样本的能力越强.

2)查全率(True Positive Rate,TPR):表示正确识别为对抗样本的比例.TPR的值越大,说明模型识别对抗样本的能力越强.

TNR与TPR的计算方式如下:

TNR=TN/(TN+FP),

TPR=TP/(TP+FN).(3)

其中:TP表示真正例,即正确分类为对抗样本的样本;TN表示假反例,即错误分类为良性样本的对抗样本;FP表示假正例,即错误分类为对抗样本的良性样本;FN表示真反例,即正确分类为良性样本的样本

3)准确率(Accuracy,A):预测正确的样本占所有测试样本的比例,计算方式如下:

4)ROC曲线是一种用于评估分类模型性能的工具,尤其在二分类问题中广泛应用.它通过将真正例率(TPR)和假正例率(FPR)作为坐标,描绘分类器在不同阈值条件下的性能.其中,FPR=FP/(FP+TN).理想情况下,ROC曲线越靠近左上角表示模型性能越好,即在高TPR时保持低FPR.

5)AUC:本文还使用ROC曲线下的面积(AUC)作为重要的指标来衡量架构性能,其值介于0到1之间,值越接近1表示模型性能越好.

3.2 实验结果

3.2.1 检测性能评估

1)孤立森林

在使用孤立森林异常检测器时,不同图像变换方式的ROC曲线如图6a所示.在所有考虑的图像变换方式中,平移和翻转展现出较好的检测效果,而过滤高频信息和去噪表现最差.平移和翻转操作虽然简单,却能够破坏对抗扰动的空间相关性,使得对抗样本在特征空间中与正常样本拉开距离.反之,过滤高频信息和去噪却可能削弱对抗扰动的影响,导致异常检测器难以捕捉到两类样本的区别.鉴于平移变换的ROC曲线更加平滑,本文确定使用平移作为孤立森林异常检测器的图像变换手段.进一步地,本文探究了7种不同的平移强度——将图像平移1至7像素,并记录结果(图6b).根据图6的展示,不同平移强度所得的效果相差较小.这意味着即使较小幅度的平移也足以揭示对抗样本的异常特征,而过大的平移强度可能损害图像的语义信息,导致关键特征的丢失.因此,在权衡平移强度过大可能导致图像丢失关键特征细节的风险之后,本文决定选用1像素的平移强度作为孤立森林检测器的标准设置.

2)One-Class SVM

One-Class SVM在不同图像变换方式下的ROC曲线如图7a所示.其中,平移和旋转的检测效果较为突出.这表明平移和旋转变换能够有效地放大对抗样本与正常样本的差异,使得One-Class SVM更容易将它们区分开来.考虑到孤立森林异常检测器在平移变换上的良好表现,为了一致性,本文同样选择平移作为One-Class SVM的图像变换方式.图7b表明,One-Class SVM在不同平移强度下的表现差异不显著,因此本文决定同样选用1像素的平移强度.

3)LOF

局部异常因子(LOF)分析在不同图像变换方式下的ROC曲线如图8a所示,其中平移变换的表现较为优秀.这表明对于LOF检测器而言,平移变换是最有效的图像扰动方式,能够最大程度地放大对抗样本与正常样本在特征空间的差异,使得基于密度分析的LOF算法更容易将它们区分开来.因此,本文选定平移作为LOF的图像变换手段.图8b展示了不同平移强度下的检测效果.为了保持与前述异常检测器的一致性,也选择了1像素作为平移强度.

4)异常检测器比较

本文选择图像在ImageNet数据集上平移1像素作为最终的图像变换方式.为了筛选出最佳的异常检测器,将相同的对抗攻击样本应用于平移变换,并对不同的异常检测器进行了测试.测试结果如图9所示.由图9可以看出,3种异常检测器的ROC曲线都比较平滑,并且它们的AUC值相差不大.具体的测试结果如表2所示,结果显示孤立森林异常检测器较为优秀,因此选择孤立森林作为最终的异常检测器.

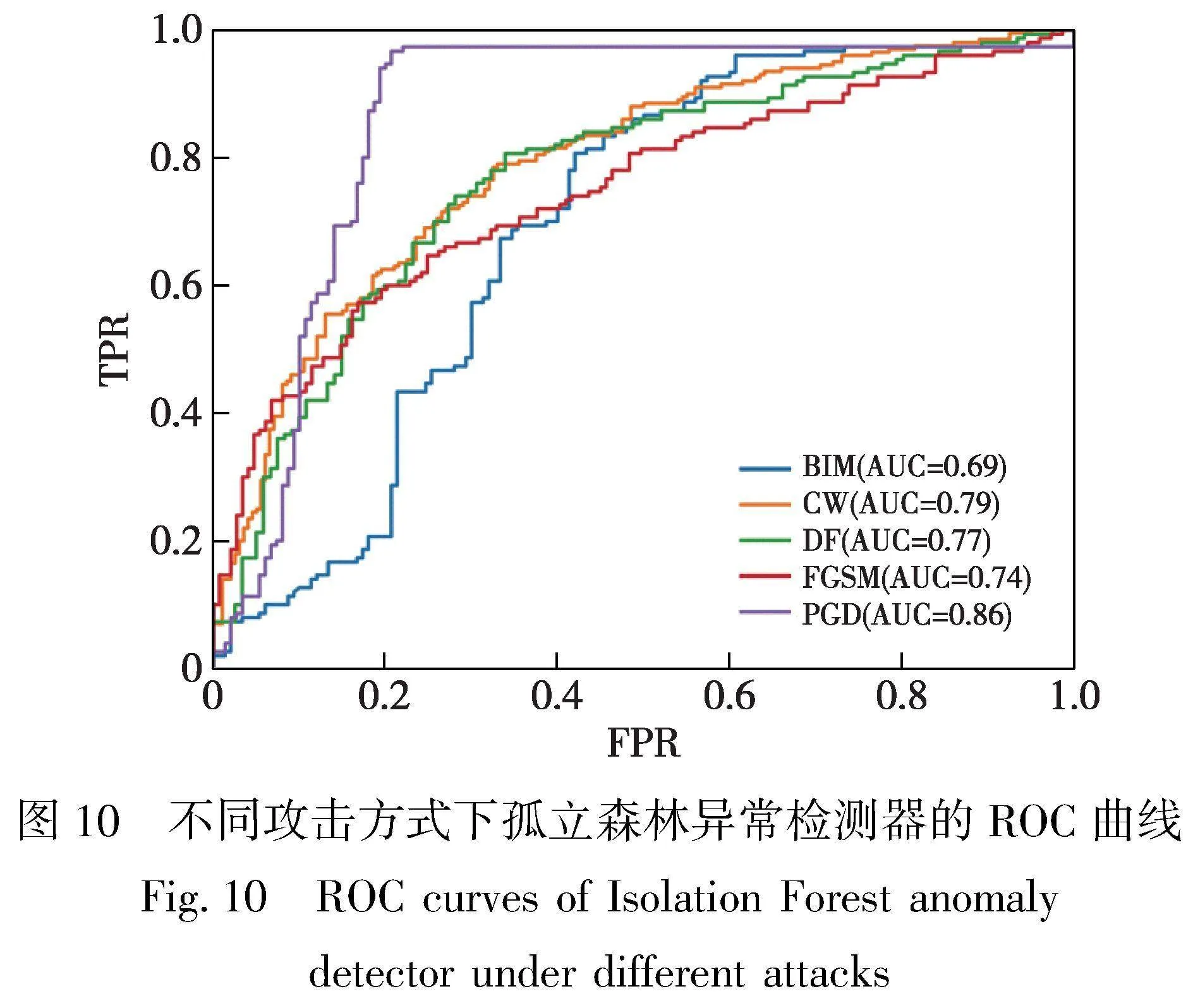

图10显示了孤立森林异常检测器在5种不同攻击方法下的ROC曲线.从图中可以推断,检测PGD对抗样本的效果最佳,而检测BIM对抗样本的效果相对较差.平均AUC值为0.77,这表明孤立森林检测器在多种类型攻击下展示出较好的鲁棒性.

3.2.2 架构计算效率

1)孤立森林异常检测器训练.使用100张图像对应的距离特征进行训练,时间为1.5 s.

2)图像变换时间.100张图像进行图像变换的时间为0.575 s.

3)距离计算时间.距离计算时间指图像变换完毕之后,将图像输入样本后,进行距离计算,到异常检测之前的时间,包括KL距离计算时间和热力图关注点距离计算时间.具体计算时间如表3所示.

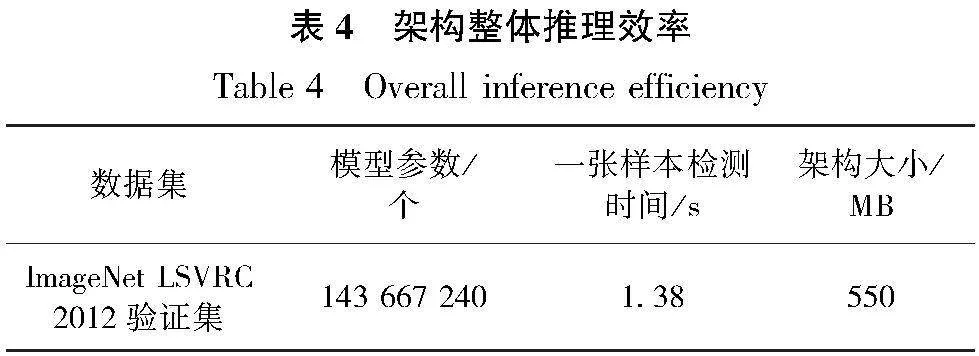

4)整体推理时间.ImageNet2012验证集使用的模型为VGG19,对于一张224×224×3的图片,从数据读取到完成距离计算最后异常检测大约需要1.38 s.具体计算效率与资源占用情况如表4所示.

3.2.3 与其他对抗样本检测器对比

本文选择了几种效率较好的前沿的无监督的对抗样本检测器,并在ImageNet数据集上进行了性能对比.对比结果如表5所示.

本文提出的异常样本检测器在整体上表现优于其他两种无监督对抗样本检测器.尤其对于BIM、CW、FGSM、PGD等对抗攻击方法的检测性能,本文提出的检测器显示了更强的性能,进一步证明了其优越性.

1)在BIM攻击下,本文方法的TPR达到20.51%,显著高于第二好的SFAD方法(TPR=8.02%),而FPR的差距相对较小(18.00%vs.16.38%).这表明本文方法在保证较低误报率的同时,大幅提升了对BIM对抗样本的检测能力.

2)在CW攻击下,本文方法的TPR达到58.16%,比SFAD方法(TPR=38.17%)大幅提高,且FPR差距依然不大(18.00%vs.16.38%).可见本文方法对CW对抗样本的检测效果也有明显优势.

3)在DF攻击下,SFAD方法取得了最高的TPR(72.23%),远超其他方法.本文方法的TPR为58.16%,虽然低于SFAD,但也明显优于FS方法(TPR=36.96%).SFAD之所以在DF攻击下表现突出,一个可能的原因是相比其他攻击方法,DF产生的扰动幅度更小,肉眼更难感知,本文方法的核心是利用图像转换、分类概率和Grad-CAM热力图的差异来检测对抗样本,但DF攻击可能恰好针对这种机制,在图像转换后仍能保持一致的分类结果和关注区域,从而逃避检测,体现了对抗攻防的博弈性.相比之下,SFAD利用了更多的特征视角,如模型不确定性、自编码器重构等,从更多维度刻画对抗样本的异常性,这种多视角集成的方式可能对DF攻击更多鲁棒.但本文方法的优势在于只需对变换图像同时提取两个距离特征,再用异常检测器判别,计算开销较小,更适合实时检测场景.

4)在FGSM攻击下,本文方法的TPR为57.40%,超过了SFAD方法(TPR=53.91%),且FPR差距不大(18.00%vs.16.38%).这表明本文方法对FGSM对抗样本的检测性能也略有优势.

5)在PGD攻击下,本文方法的表现最为突出,TPR高达79.93%,明显优于第二好的FS方法(TPR=36.10%).这可能是因为PGD攻击是一种强力的迭代攻击,在寻找对抗样本的过程中会引入更细微、更复杂的扰动,这种扰动更容易引起Grad-CAM热力图的变化,从而被本文方法所捕捉到.

6)在所有攻击场景下,本文方法的平均TPR为54.83%,显著高于SFAD方法(TPR=38.95%)和FS方法(TPR=28.75%),而平均FPR(18.00%)与SFAD、FS相当.这证明了本文方法在各种攻击场景下的整体检测性能最优,能够在控制误报率的同时实现较高的对抗样本检出率.

实验结果表明,本文方法在多数攻击场景下都取得了明显的性能提升,在BIM、CW、PGD等攻击下的表现尤为突出.这得益于Grad-CAM热力图对对抗扰动引起的细微特征变化的刻画能力,以及与图像变换、Softmax差异相结合形成的多角度异常检测机制.虽然在DF攻击下本文方法的TPR略逊于SFAD,但整体检测性能仍然最优,并且具有更高的计算效率优势.

需要指出的是,FS与SFAD使用的数据集为MiniImageNet,其图像尺寸和类别数量都远小于ImageNet数据集.而本文使用的是2个大尺寸高质量的数据集,更符合常见的图像规格要求,因此,本文的对抗样本检测器在实际应用中具有更高的实用性.未来将挖掘Grad-CAM热力图的潜力,并结合适当的跨域分析策略,有望进一步提升本方法对DF等攻击的检测能力.

4 总结

本文深入分析了对抗样本攻击的机制及现有的检测方法,在此基础上引入一种新型无监督对抗样本检测技术,其核心思想是从多个视角提取对抗样本的异常特征,并融合、利用这些不同特征进行检测,从而提高检测的精度和鲁棒性.该方法基于图像经过微小变换前后模型预测的概率分布差异以及使用Grad-CAM生成的热力图之间的差距,来有效地识别对抗样本.将检测器的关注点从单一的模型输出层扩展至输入层特征,从而显著增强了其对抗样本与正常样本之间差异的建模及评估能力.通过融合输入层(以直观的热力图形式展示)和输出层(提供预测概率)的信息进行联合决策,不仅显著提升了检测效果,还深化了对对抗性扰动如何影响模型判别过程的认识,可以在传统方法所能检测到的对抗样本的基础上,对更多种攻击类型产生的对抗样本进行检测.使用无监督学习来训练最终的对抗样本检测模型,不需要获取对抗样本进行训练,减少了时间和运算成本.实验结果表明,在符合常见图像规格的大尺寸高质量图像数据集上进行实验,特别是针对BIM、CW、FGSM、PGD等常用对抗攻击方法的检测,彰显了卓越的性能,也为未来对抗样本检测技术的研究与发展提供了宝贵的理论依据和实践指导.

参考文献References

[1]Goodfellow I J,Shlens J,Szegedy C.Explaining and harnessing adversarial examples[C]// 3rd International Conference on Learning Representations.May 7-9,2015,San Diego,CA,USA.DBLP,2015:1-11

[2] Tian S X,Yang G L,Cai Y.Detecting adversarial examples through image transformation[J].Proceedings of the AAAI Conference on Artificial Intelligence,2018,32(1):4139-4146

[3] Agarwal A,Singh R,Vatsa M,et al.Image transformation-based defense against adversarial perturbation on deep learning models[J].IEEE Transactions on Dependable and Secure Computing,2021,18(5):2106-2121

[4] Xu W,Evans D,Qi Y.Feature squeezing:detecting adversarial examples in deep neural networks[J].arXiv e-Print,2017,arXiv:1704.01155

[5] Selvaraju R R,Cogswell M,Das A,et al.Grad-CAM:visual explanations from deep networks via gradient-based localization[C]//2017 IEEE International Conference on Computer Vision (ICCV).October 22-29,2017,Venice,Italy.IEEE,2017:618-626

[6] Liu F T,Ting K M,Zhou Z H.Isolation forest[C]//2008 Eighth IEEE International Conference on Data Mining.December 15-19,2008,Pisa,Italy.IEEE,2008:413-422

[7] Schlkopf B,Platt J C,Shawe-Taylor J,et al.Estimating the support of a high-dimensional distribution[J].Neural Computation,2001,13(7):1443-1471

[8] Breunig M M,Kriegel H P,Ng R T,et al.LOF:identifying density-based local outliers[C]//Proceedings of the 2000 ACM SIGMOD International Conference on Management of Data.May 15-18,2000,Dalla,TX,USA.ACM,2000:93-104

[9] 刘会,赵波,郭嘉宝,等.针对深度学习的对抗攻击综述[J].密码学报,2021,8(2):202-214

LIU Hui,ZHAO Bo,GUO Jiabao,et al.Survey on adversarial attacks towards deep learning[J].Journal of Cryptologic Research,2021,8(2):202-214

[10] Kurakin A,Goodfellow I J,Bengio S.Adversarial examples in the physical world[J].arXiv e-Print,2016,arXiv:1607.02533

[11] Carlini N,Wagner D.Towards evaluating the robustness of neural networks[C]//2017 IEEE Symposium on Security and Privacy (SP).May 22-26,2017,San Jose,CA,USA.IEEE,2017:39-57

[12] Moosavi-Dezfooli S M,Fawzi A,Frossard P.Deepfool:a simple and accurate method to fool deep neural networks[C]//IEEE Conference on Computer Vision and Pattern Recognition.June 27-30,2016,Las Vegas,NV,USA.IEEE,2016:2574-2582

[13] Madry A,Makelov A,Schmidt L,et al.Towards deep learning models resistant to adversarial attacks[C]//6th International Conference on Learning Representations(ICLR).April 30-May 3,2018,Vancouver,BC,Canada,2018:1-23

[14] Simonyan K,Zisserman A.Very deep convolutional networks for large-scale image recognition[J].arXiv e-Print,2014,arXiv:1409.1556

[15] Krizhevsky A,Sutskever I,Hinton G E.ImageNet classification with deep convolutional neural networks[J].Communications of the ACM,2017,60(6):84-90

[16] Papernot N,Faghri F,Carlini N,et al.Technical report on the CleverHans v2.1.0 adversarial examples library[J].arXiv e-Print,2016,arXiv:1610.00768

[17] Aldahdooh A,Hamidouche W,Déforges O.Revisiting model’s uncertainty and confidences for adversarial example detection[J].Applied Intelligence,2023,53(1):509-531

Unsupervised adversarial example detection based on image transformation

Abstract Deep Neural Networks (DNNs) exhibit vulnerability to specially designed adversarial examples and are prone to deception.Although current detection techniques can identify some malicious inputs,their protective capabilities remain insufficient when confronted with complex attacks.This paper proposes a novel unsupervised adversarial example detection method based on unlabeled data.The core idea is to transform the adversarial example detection problem into an anomaly detection problem through feature construction and fusion.To this end,five core components are designed,including image transformation,neural network classifier,heatmap generation,distance calculation,and anomaly detector.Firstly,the original images are transformed,and the images before and after the transformation are input into the neural network classifier.The prediction probability array and convolutional layer features are extracted to generate a heatmap.The detector is extended from focusing solely on the model’s output layer to the input layer features,enhancing its ability to model and measure the disparities between adversarial and normal samples.Subsequently,the KL divergence of the probability arrays and the change distance of the heatmap focus points of the images before and after the transformation are calculated,and the distance features are then input into the anomaly detector to determine whether the example is adversarial.Experiments on the large-scale,high-quality image dataset ImageNet show that our detector achieves an average AUC (Area Under the ROC Curve) value of 0.77 against five different types of attacks,demonstrating robust detection performance.Compared with other cutting-edge unsupervised adversarial example detectors,our detector has a drastically enhanced TPR (True Positive Rate) while maintaining a comparable 1 alarm rate,indicating its significant advantage in detection capability.

Key words adversarial example detection;unsupervised learning;adversarial attack;deep neural networks(DNNs);image transformation