国际出版机构使用人工智能工具的出版伦理政策分析

[摘 要] 从科学网(Web of Science)的期刊引证报告(Journal Citation Reports)数据库排名前70的出版机构中筛选出23家,分析其人工智能(AI)出版伦理政策。在作者使用AI方面,出版机构主要从署名、AI使用边界、披露形式进行了规范。出版机构对AI身份问题已达成共识,即AI不能成为署名作者;出版机构允许在研究和写作中使用AI,但使用者需要对内容负责且充分披露,而目前只有少数(26.1%)机构明确规定了作者的AI使用边界,且各机构之间对于如何披露的规定存在差异。关于审稿者使用AI的政策,鉴于保密性要求,机构一般不允许审稿者将稿件上传至无法保证安全性的AI工具,但关于如何披露和违反AI使用政策的惩罚措施还有待完善。针对上述问题,建议出版机构从伦理、技术和法律三个层面,以及协同治理的角度,与学术共同体和管理部门合作,共同制定学术出版中AI使用的伦理规范,以营造健康的学术生态环境。

[关键词] 人工智能 生成式 出版伦理 透明化

[中图分类号] G237 [文献标识码] A [文章编号] 1009-5853 (2024) 06-0015-11

Analysis on Publishing Ethics Policies of International Publishers for the Use of Artificial Intelligence Tools

Dong Min Liu Xuemei Du Liang Lei Fang

(West China Hospital, Sichuan University, Chengdu, 610041)

[Abstract] The article selectes 23 publishing institutions from the top 70 in the Journal Citation Reports database of Web of Science and analyzes their artificial intelligence (AI) publishing ethics policies. In terms of the author’ s use of AI, publishing institutions have mainly standardized the authorship, AI usage boundaries and disclosure forms. Publishing institutions have reached a consensus on the issue of AI identity. That is, AI cannot become a co-author. Publishing institutions allow the use of AI in research and writing, but require authors’ responsibility and full disclosure. Currently only a few institutions (26.1%) have clearly defined the boundaries of authors’ AI usage, and there are differences among institutions on how to disclose them. Regarding the policy on the use of AI by reviewers, due to confidentiality requirements, institutions generally do not allow reviewers to upload manuscripts to AI tools that cannot guarantee security. However, there is still room for improvement on how to disclose and punish violations of AI usage policies. In response to the above issues, it is suggested that publishing institutions collaborate with academic communities and management departments from the perspectives of ethics, technology and law, as well as collaborative governance, to jointly develop ethical standards for AI applications in academic publishing, in order to create a healthy academic ecosystem.

[Key words] Artificial intelligence Generative Publishing ethics Transparency

2022年11月,ChatGPT的推出引发了全球广泛关注。这款由OpenAI公司开发的人工智能(AI)语言模型,凭借其卓越的自然语言处理能力和深度学习技术,迅速成为全球热门话题。ChatGPT 与以前版本 GPT的显著不同在于它的输出质量、交互能力和进行类人对话的能力、速度以及通过用户或专家改进其输出的能力[1]。越来越多的领域开始尝试使用ChatGPT,如教育、医疗卫生[2]。有人认为禁止 ChatGPT 在学术出版中使用可能不切实际[3],因为将会有更多的研究者在研究和写作过程中使用ChatGPT,可能造成论文爆发式增长,如索姆·比斯瓦斯(Som Biswas)医生利用 ChatGPT 在 4 个月内写 16 篇论文,其中 5 篇已发表[4]。此外,还有学者开始研究生成式AI/大型语言模型(large language models,LLMs)对稿件评估的作用,发现该工具能总结稿件的主要内容,包括稿件的主要目标和结论,并对写作风格和可读性提供了一些标准评估[5]。有研究者认为,生成式AI可以提供一种加速和自动化系统审查的方法,有可能大大改变同行评审专家和编辑的角色[6]。

随着生成式AI /大型语言模型在研究、写作、稿件评估中的使用,AI伦理问题再次引起广泛热议,给出版机构带来巨大挑战[7]。因此,出版界急需建立、健全关于AI工具,特别是生成式AI工具使用的伦理政策,为相关人员(如编辑、作者、同行评审专家)提供明确的指导原则,确保出版行业的道德准则得到遵守,防范潜在的伦理问题。

1 文献综述

AI概念最早由美国计算机科学家约翰·麦卡锡(John McCarthy)及其同事于1956年达特茅斯会议(Dartmouth Conference)上提出[8],随后应用于科学研究和写作。1965年费根鲍姆(Feigenbaum)与勒德贝格(Lederberg)利用AI开发了化学分析系统DENDRAL,1972年研究者开发了诊断血源性传染病的MYCIN系统,2009年科学家推出自运行研究系统 Adam [9]。2019年施普林格·自然(Springer Nature) 推出首本利用机器学习创作的研究图书《锂离子电池:机器生成的当前研究概要》(Lithium-ion batteries: A machine-generated summary of current research)。AI可从6个方面辅助科学研究与学术写作:研究想法启发与研究设计,内容开发和构建,文献综述与整合,数据管理和分析,编辑、审阅和发表支持,传播推广与风险检测和评估(剽窃检测、道德风险评估等)[10]。但AI技术的固有缺陷如数据偏差与系统性偏见、决策过程的透明度缺失与结果可解释性不足,以及数据隐私保护与安全性风险等,导致AI应用始终伴随伦理及著作权等法律问题的争议。

学术界通常对新兴技术持中立论,认为技术本身无善恶,其影响取决于使用和社会环境。然而,随着算法和AI的普及,技术中立论受到质疑。相对地,技术价值论认为技术具有价值负荷,在政治、经济、文化、伦理上非中性,可进行价值判断。有学者认为在数字出版智能语言模型治理路径上应调试理念,将两种观点辩证统一[11];应采用善治理念,制定“良法”,进行引导、规范和促进知识生产[12]。出版道德委员会(COPE)于2021年发布AI应用于学术出版的指导政策,内容包括期刊选择、识别论文主题,确定该主题是否符合期刊范围、筛选同行评审专家、语言质量评估、剽窃检测以及评估实验设计和统计学分析等[13]。但该政策是针对出版机构如何规范使用AI。在ChatGPT出现前,相关出版协会、机构及期刊并未制定作者、审稿专家使用AI的规范。

以ChatGPT为代表的生成式AI,由于其算法独创性、能力综合性、应用广泛性,将彻底改变出版内容生产范式和内容供给模式,但其技术局限性(AI幻觉、过度优化困境、算法歧视和有害指令)和不合理使用将加剧著作权问题,增加技术伦理失范和学术伦理失范的风险[14][15],如在ChatGPT出现初期,有研究者将ChatGPT列为作者,此举遭到很多学者反对[16]。因此,面对AI生成内容,出版界需重点关注著作权与伦理问题,如技术伦理和学术伦理失范等[17]。针对研究、写作、稿件评审过程中的AI工具使用,ChatGPT出现后,国际协会/委员会如出版道德委员会、国际医学期刊编辑委员会(ICMJE)、世界医学编辑协会(WAME)等[18][19][20]于2023年制定相关政策,但以上机构对作者和审稿专家使用AI的规范存在差异。

出版机构是学术内容质量、准确性、合法性和伦理性的“把关人”。一些出版机构,如爱思唯尔(Elsevier)与施普林格·自然正持续关注AI应用情况,并制定相应的伦理政策,为作者、审稿者提供AI使用指导。伦德(Lund)等调查了300种学术期刊的作者使用AI政策,发现58.7%的期刊有相关政策,但该研究范围比较局限,未能涵盖AI使用边界、审稿者AI使用规范[21],且隶属于施普林格·自然、爱思唯尔等出版机构的期刊均遵循其出版机构的AI作者政策。因此,有必要对出版机构关于作者和审稿者AI使用规范进行系统梳理。本文基于此目的对当前出版机构AI工具使用政策进行调查,包括AI使用边界、披露内容和形式等,以期全面了解AI的出版伦理政策及存在的问题。

2 研究设计

国际出版机构名单来源于科学网(Web of Science)的期刊引证报告(Journal Citation Reports)数据库,最近更新日期为2023年10月18日。科学网按2022年收录期刊数量对出版机构的排序,本文选择排名前70的出版机构。首先,由于这些出版机构的出版物数量和质量均较高,全球声誉高、影响力大,其AI应用伦理政策权威性高;其次,他们制定AI出版政策时充分考虑伦理、法律、社会和经济等多方面因素,内容综合性强;再者,其出版物涵盖专业广泛,几乎涉及理工农医所有专业,政策内容具有可推广性。

从出版机构官方网站发布的出版/编辑伦理(publication/editorial ethics)、作者/审稿专家指南(rguidelines for authors/peer re-viewers)中收集关于作者和审稿专家的AI出版政策。检索时间为2024年1月2—8日。纳入标准:(1)若出版机构之间是从属关系,AI出版政策完全相同,则纳入期刊数量最多的出版机构;(2)有的出版机构之间虽然是从属关系,但出版政策描述不完全一致,则分别统计;(3)名单中重复的出版机构则纳入其中1个;(4)如果出版机构有针对图书和期刊的不同出版政策,则选择针对期刊的AI出版政策。

排除标准:(1)出版机构官方网站无AI相关政策;(2)针对AI的使用政策以新闻(news)、社论(editorial)、观点(opinion、perspective)等形式发表,未在网站的出版/编辑伦理、作者/审稿专家指南出现;(3)出版政策中只提到参考出版道德委员会、国际医学期刊编辑委员会政策或提供其网址链接,并未对AI使用做特别要求和详细描述。

由一位作者分析AI出版伦理政策,另一位作者核对结果,如有分歧则通过讨论解决。

最终纳入23家出版机构。纳入机构收录期刊数均>40种,其中,施普林格·自然、爱思唯尔、泰勒弗朗西斯(Taylor & Francis)和威利(Wiley)收录期刊数均>1000种。

3 国际出版机构AI使用的出版政策现状

3.1 出版机构对AI身份问题已达成共识

生成式AI导致新型著作权争议,如AIGC权利归属、侵权、AIGC版权保护等问题[22]。AIGC责任主体涉及内容提供者、程序开发者、使用者、平台运营商[23]。各AI平台对于生成内容的归属权也有不同界定。根据 Midjourney的条款,免费用户创造或制作的内容的所有权利均归平台,而OpenAI将输出内容的所有权利、所有权和利益(若有)全部转让给使用者[24]。

23家(100.0%)出版机构都明确AI和AI工具不能成为作者和合著者。其中有两家(8.7%)出版机构包括爱思唯尔、多学科数字出版机构(Multidisciplinary Digital Publishing Institute,MDPI),规定不能将AI作为作者引用。16家(69.6%)出版机构认为作者对稿件的内容负有最终责任。5家(21.7%)出版机构提醒作者,AI技术应在人工监督和控制下使用,需仔细审查AI生成内容。目前,出版机构明确AI不能成为著作权主体,且使用者对稿件内容负有责任。在AIGC权利归属问题上,还有很多待解决的问题,如知识产权的认定、版权归属、利益分配等。界定AI使用范围对保护原创作品的完整性、界定版权归属、降低侵权风险、促进合理使用等有重要意义。

3.2 出版机构AI使用边界政策存在差异

研究者和作者在AI使用中可能面临一系列伦理和法律风险,如隐私侵犯、著作权纠纷等。明确AI使用边界对于学术诚信、知识产权保护等具有重要意义。此次调查中仅6家(26.1%)出版机构明确AI使用边界,且不同出版机构间存在差异。因AI生成图像引发新的版权问题和研究真实性问题,有3家(13.0%)出版机构,包括施普林格·自然、爱墨瑞得出版集团(Emerald Group Publishing)、爱思唯尔,明确一般情况下不接受生成式AI生成的图像和视频。

1家(4.3%)机构(爱墨瑞得出版集团)不允许使用生成式AI工具如大型语言模型撰写文章的任何部分,包括生成摘要或文献综述,不允许使用AI工具或大型语言模型生成或报告结果或进行统计数据的文本报告。两家(8.7%)机构,包括德古意特出版社(Walter De Gruyter)、约翰·霍普金斯大学出版社(Johns Hopkins University Press),不接受任何实质上由AI如大型语言模型撰写的稿件。AI和AI辅助技术在写作过程中,3家(13.0%)机构,包括爱思唯尔、爱墨瑞得出版集团、智力出版公司(Intellect Ltd),声明只能用于提高稿件的可读性和语言表达。

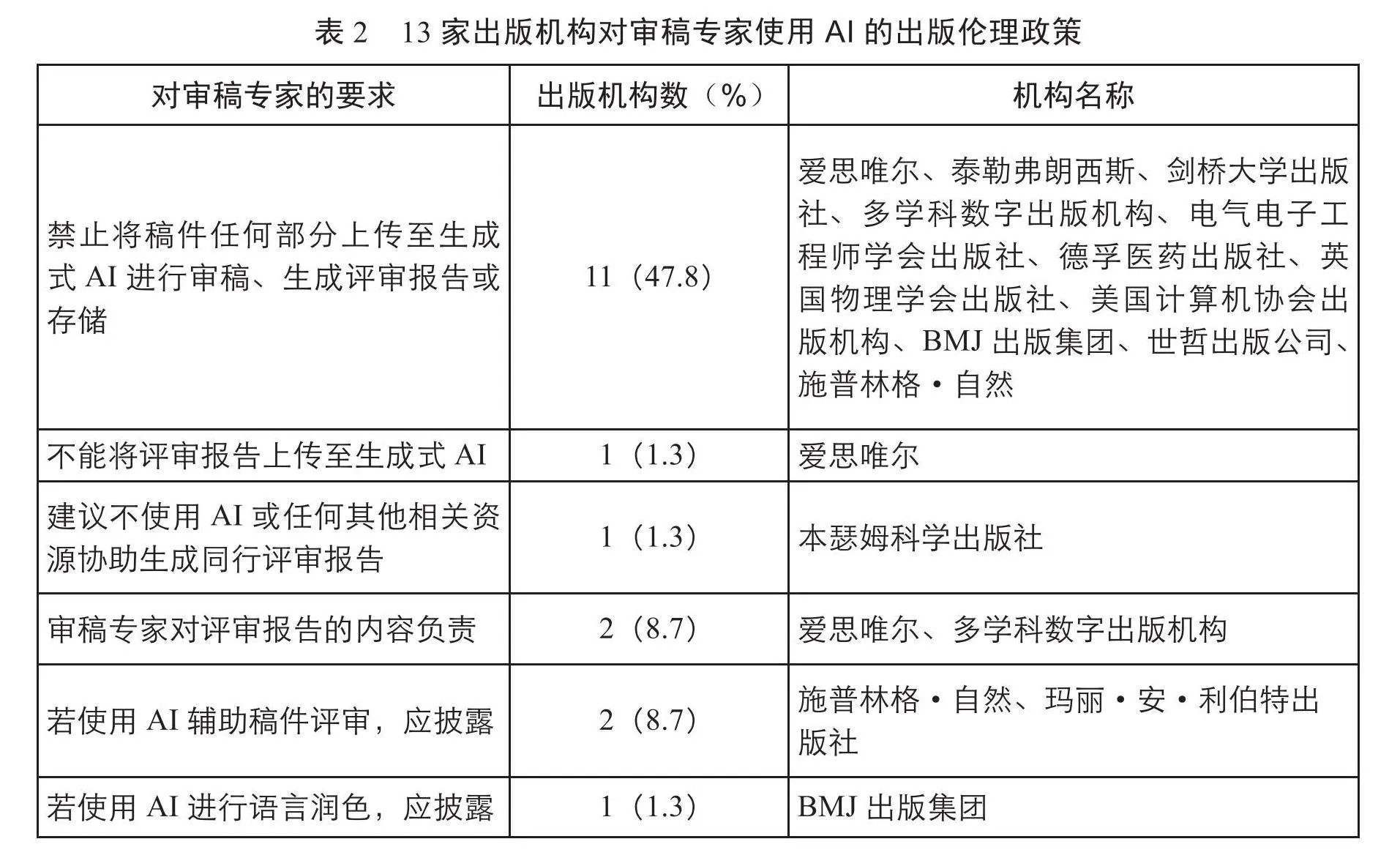

其余出版机构未特别界定AI使用范围,但在要求作者进行AI使用披露时列举了一些使用内容,见表1。从范围上来看,这些出版机构比上述6家出版机构AI允许使用的范围更广,主要体现在允许图片、观点、摘要、表格、代码等生成。

调查结果显示,出版机构在AI使用边界上意见不一。少数机构明确限制AI使用,尤其是视觉内容和完全由AI撰写的文章。而其他机构对作者的AI使用说明较模糊,政策较为宽松。尤其AI工具在文本和数据分析中的应用可能加剧剽窃的隐蔽性。

出版机构界定AI使用范围尚未达成共识的原因可能是AI技术的快速进步带来了层出不穷的新技术和新应用,使得人们难以全面理解AI的广泛应用范围和其潜在的深远影响,因此,目前出版机构难以制定出既全面又明确的规定。同时,国际协会/委员会未能跟上AI技术的快速发展,也未明确AI使用范围,出版机构尚不能在其指导下制定相关政策,显示出一定的滞后性。

3.3 出版机构AI披露政策存在分歧

ChatGPT介入学术论文创作涉及著作权的底层逻辑、学术诚信的本位逻辑、可信AI的顶层逻辑,三重逻辑都要求作者履行透明度义务[25]。目前,出版界已经达成共识,允许作者使用,但均要求作者进行披露(100.0%,23/23)。但对如何披露、在文章中披露的位置及披露的内容,出版机构之间尚存差异。4家(17.4%)出版机构,包括约翰·本杰明斯出版公司(John Benjamins Publishing Co)、剑桥大学出版社(Cambridge University Press)、德孚医药出版社(Dove Medical Press)、泰勒弗朗西斯,未说明需要披露的位置。9家(39.1%)出版机构,包括约翰·霍普金斯大学出版社、施普林格·自然、IOS出版社(IOS Press)、德古意特出版社、电气电子工程师学会出版社(The Institute of Electrical and Electronics Engineers)、美国计算机协会出版机构(Association for Computing Machinery)、蒂墨医学出版社(Thieme Me-dical Publishers)、威利及牛津大学出版社(Oxford University Press),未说明具体需要披露的内容。

本瑟姆科学出版社(Bentham Science Publishers)要求在方法部分说明AI工具使用方法以及类型;爱思唯尔要求作者在方法中解释AI工具使用方法,以及AI 的产品信息,如果在写作过程中使用了AI工具,需要在正文和参考文献之间设置独立的部分披露工具名称和使用原因;玛丽·安·利伯特出版社(Mary Ann Liebert, Inc)要求在方法中提供软件的名称和版本、最初使用的日期以及启动AI响应时所给的相关提示、信号,在结果中应讨论AI使用结果的潜在偏差和局限性; 蒂墨出版集团、威利、卡格尔出版社(Karger)和英国物理学会出版社(Institute of Physics Publishing)要求在方法或致谢部分进行披露,此外,卡格尔出版社还要求提供补充材料;爱墨瑞得出版集团要求在方法和致谢部分披露已创建或已修改的内容;多学科数字出版机构要求作者在材料和方法中披露AI工具的使用细节,在致谢中披露AI工具详细的产品信息;BMJ出版集团要求在贡献者部分披露AI技术的名称、使用原因、完成任务,在补充材料中说明原始输入提示和输出内容。

此外,爱墨瑞得出版集团和卡格尔出版社声明,如果作者使用了AI工具,要求其像引用其他软件一样对AI进行引用。约翰·霍普金斯大学出版社要求在文本、图像、图表或工作的其他部分使用生成式AI或大型语言模型,必须像使用任何外部来源一样进行引用。BMJ出版集团、卡格尔出版社和世哲出版公司提到,如果没有按照其要求充分披露AI的使用,可能会被拒稿或出版后再进行更正等。

在稿件中披露AI工具使用不仅是对研究方法的补充,也是对学术诚信、透明度的承诺,可以帮助其他学者更好地理解AI工具的应用,推动AI技术在学术界的普及和应用。同时,也有助于避免因为对AI工具的误解或不了解而导致的错误使用或滥用。出版机构向研究者和作者声明未充分披露导致的后果,对其有警示作用,不仅能够促使他们在进行研究和创作时更加谨慎和负责任,还能够引导他们充分认识到AI技术潜在的风险和挑战。

3.4 审稿专家AI使用政策待完善

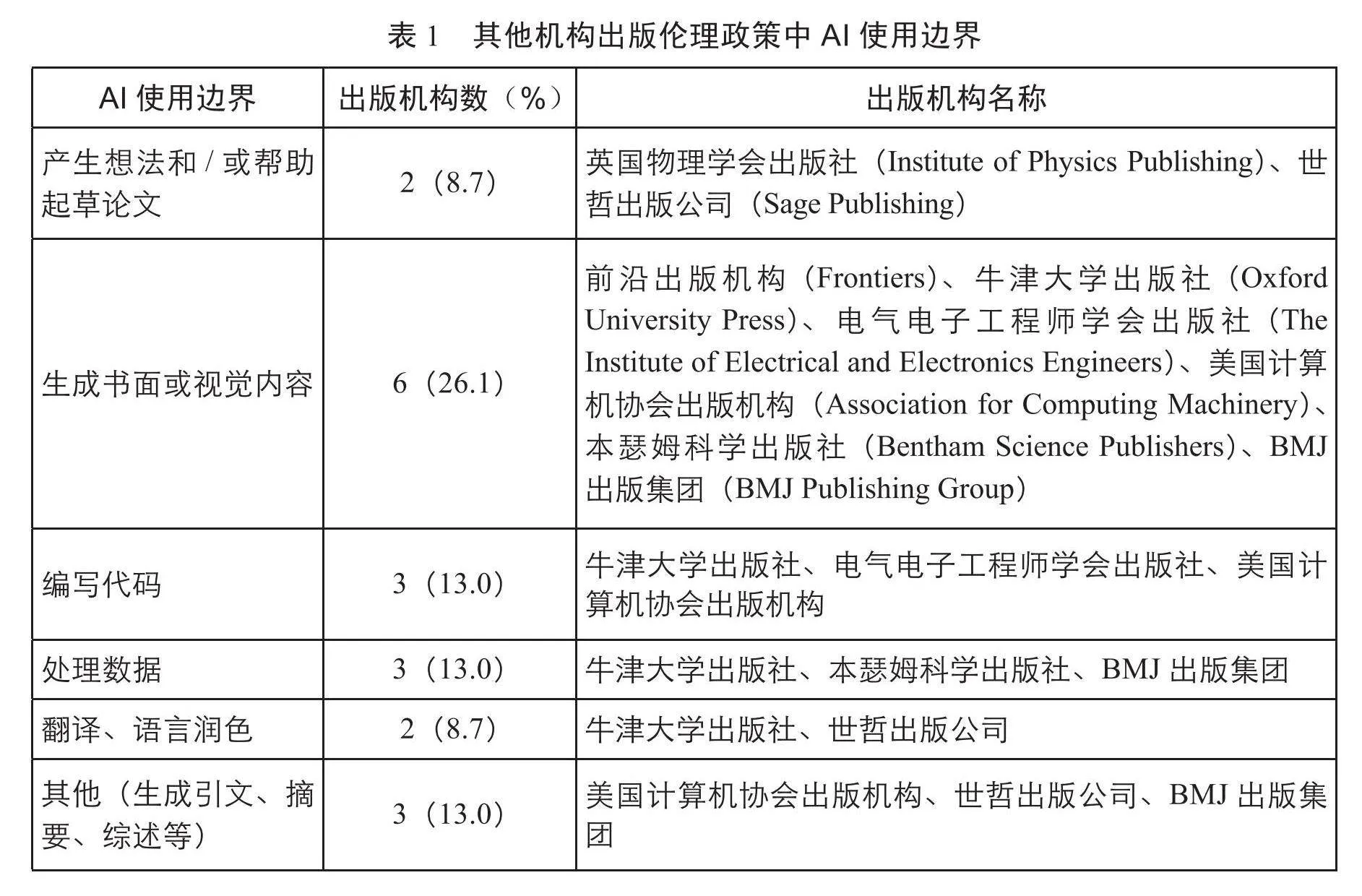

本文调查对象中仅有13家(56.5%)出版机构制定了审稿专家AI使用政策。11家(47.8%)出版机构要求不能将稿件或其中任何部分上传至生成式AI,其中爱思唯尔还要求审稿专家不能将评审报告上传至生成式AI。爱思唯尔、多学科数字出版机构要求审稿专家对评审报告内容负责。如果在审稿中使用了AI技术和工具,仅3家机构要求审稿专家在评审报告中进行声明,透明化处理;但所有出版机构均未说明如果评审过程中超出AI使用边界或未充分披露将造成的后果,见表2。

由于生成式AI通过公开数据进行训练,使用其进行审稿有诸多弊端。首先,保密原则是稿件评审的重要原则,过早透露稿件信息可能会侵犯作者的隐私权,包括个人隐私和数据隐私;其次,可能会产生偏见内容[26][27][28][29];

再次,缺乏透明度,导致评审结果缺乏可解释性,而且不可避免会产生错误信息。有研究者尝试利用大型语言模型对预印版稿件进行评审,发现聊天机器人提供虚假文献[30]。还有研究者认为大型语言模型缺乏人类评审的深度和洞察力,会提供一些看似有用的虚假评审报告,无法完全替代人类评审[31]。因此,2024版国际医学期刊编辑委员会推荐[32]中新增“审稿指南必须包括AI使用的指导”。

4 AI出版伦理建设的启示

我国先后出台了《新一代人工智能治理原则:发展负责任的人工智能》(2019年)、《新一代人工智能伦理规范》(2021年)、《关于加强科技伦理治理的意见》(2022年)和《科技伦理审查办法(试行)》(2023年),力图通过AI与伦理的有机结合,引导AI走上“科技向善”的健康发展道路[33]。AI工具使用的出版伦理是目前出版伦理建设中需要重点关注的内容。为研究者、作者、审稿专家制定详尽、透明的指导规范是出版机构的重要职责。此次调查结果显示,大部分出版机构还未向研究者和作者明确AI工具的使用范围,未说明未充分披露的后果,且同行评审过程中的AI使用政策待完善。目前,国内只有少部分期刊制定了AI使用规范。因此,国内出版机构需尽快探讨和建立一套完善的出版伦理政策来规范AI在学术研究、写作、审稿中的应用。政策制定需平衡AI技术与著作权、出版伦理之间的关系,体现数据使用伦理性、研究透明度和可重复性、技术偏见与公平性、责任归属等。

4.1 明确AI工具的使用边界

AI使用边界在技术伦理学中占有重要地位。明确AI的使用范围、使用条件和责任归属等,有助于确保AI技术的发展和应用能够符合伦理原则,促进公平公正,明确责任归属,以防范AI滥用[34]。有研究提出,出版机构应该明确稿件中AI使用范围,明确AIGC剽窃的界限[35]。

AI的稳健进步与科技伦理的引导之间存在显著的正向联系,通过加强技术责任制度的实际建设,可以提升科技工作者对伦理准则的执行水平[36]。在ChatGPT出现初期,我国一些期刊对作者AI生成论文内容制定了相关政策,如2023年2月,《暨南学报》《天津师范大学学报(基础教育版)》发布《关于使用人工智能写作工具的说明》,但并未对AI的使用边界进行说明。目前,爱思唯尔禁止使用生成式AI或AI辅助工具创建或更改稿件中的图片,施普林格·自然禁止使用AI生成的图片和视频。2023年9月,中国科学技术信息研究所联合爱思唯尔、施普林格·自然、威利发布的《学术出版中AIGC使用边界指南》[37](以下简称《指南》)中,关于图表使用作了更明确的建议:AI可用于推荐合适的统计图表类型、辅助调整图表样式、对图表进行格式化处理;但实验生成类图像必须由真实开展的实验研究获得,不可通过AI直接生成。

目前,国内仅有极少数期刊发布了关于AI使用范围的政策。在制定AI出版伦理政策时,须深思我国期刊出版特性与现状。2024年1月,中华医学会杂志社发布了《中华医学会杂志社关于在论文写作和评审过程中使用生成式人工智能技术的有关规定》[38](以下简称《规定》),明确作者附条件使用AI的情况,包括:文献检索、选题、关键词推荐等启发式探索用途;统计分析;润色、翻译;推荐图表类型、辅助制图;参考文献格式的规范化检查、参考文献与正文对应的自动化排序、自动引用生成等方面。国内医学期刊可以参考《指南》和《规定》为作者和审稿者制定AI使用边界。而AI技术的应用范围在不同学科领域可能表现出差异性,这要求其他领域期刊在参考《指南》制定相关出版政策时,需要依据本行业、协会相关政策及学科特性,与法律、技术、伦理等多领域的专家共同研究和探讨,以制定出一套科学、合理、可行的解决方案。同时需明确,AI政策应该是动态变化的,需要根据新形势作出调整。

4.2 持续完善AI披露政策

在论文写作中使用生成式AI具有客观隐匿性和主观隐匿性,客观隐匿性指的是AI的“黑箱”问题,生成过程不可见;主观隐蔽性是指使用者利用AI介入论文生成过程,其他人不知情,造成信息不对称[39]。

透明度义务是学术诚信的基本要求。在稿件中对AI全面披露对于维护技术伦理和保护著作权至关重要,让使用者、读者能够深入理解AI系统的运作方式,包括其功能、限制、风险及影响;有助于编辑和审稿专家在审查和出版稿件时考虑这些技术的局限性和偏见[40];有助于构建有效的监督和审查机制,确保AI技术的发展与应用符合伦理标准和社会期望;有助于了解作者和AI的贡献内容和贡献程度,对著作权归属和侵权责任判定具有重要意义。关于如何披露AI,出版道德委员会要求在稿件的材料和方法(或类似部分)中披露AI工具的使用方法以及类型。2024版国际医学期刊编辑委员会推荐[41]要求在投稿信和稿件中披露,如果AI用于辅助写作,在致谢部分对此进行说明;如果AI用于数据收集、分析或图形生成,则在方法中进行披露。世界医学编辑协会要求作者完整地列出所使用聊天机器人的技术规格(包括名称、版本、型号和来源)以及使用方法(包括查询结构和语法),并在投稿信和文章适当位置进行披露。但有研究者认为在致谢中披露AI的使用不合理,因为它没有自由意志,因此,不能对其行为承担道德或法律责任[42]。从此次调查结果看,不同国际出版机构关于如何披露尚存差异。

在ChatGPT之前,已有大型语言模型用于研究和写作,但出版机构未要求进行披露。生成式AI/大型语言模型(如ChatGPT)具有隐蔽性和混合性,促使重视学术质量的出版机构相继出台相关政策,以透明度义务确保高品质学术自由[43]。目前,国内出版机构关于如何披露AI的研究较少,还需继续探讨并完善AI披露细节,披露内容应尽可能详尽、全面,包括公开AI的使用目的、使用时间、重要步骤、主要类型等[44]。此外,玛丽·安·利伯特出版社建议在结果中讨论AI使用的潜在偏见和局限性,卡格尔出版社、BMJ出版集团要求将输入指令和AI的原始输出作为补充材料进行提交,通过提供这些原始数据,可以使研究过程更加透明。国内出版机构在制定AI披露形式时,可以参考国际同行的做法。

4.3 加强对审稿专家AI使用关注及完善指导方针

在学术出版领域,随着稿件数量不断上升,同行评审专家承受的评审压力亦相应增大。有研究认为可以使用AI技术协助审稿[45]。但出版道德委员会和世界医学编辑协会等相关委员会显然缺乏关于审稿专家是否应使用基于AI的工具以及如果使用、在什么条件下使用等问题的指导方针。

本文调查发现,仅有13家(56.5%)出版机构制定了针对同行评议的AI使用政策,这一比例相对较低,表明对审稿专家AI使用的关注度不足。此外,这些出版机构在其网站上描述的政策中,均未明确处理潜在违规行为的程序。对于审稿专家或编辑使用或疑似使用生成式AI的情况,缺乏透明度,处理方式及流程不明确,且不清楚是否由期刊伦理委员会或研究诚信团队负责。出版机构是否具备检测AI生成内容的手段也未知。在同行评审过程中,对使用生成式AI的审稿专家是否采取制裁措施尚未明确。这种政策缺失对同行评审构成风险,可能影响各方信任,挑战稿件决策,引发作者与期刊纠纷,进而威胁同行评审系统的完整性、真实性。

国内外出版机构在强化审稿过程中AI应用的监管层面,应采纳一系列具体策略:首先,编写一套详尽的审稿专家AI使用指南,明确界定AI工具的应用范畴、适用条件、操作流程及伦理准则。其次,实施定期AI技能培训与教育项目,以提升审稿专家对AI技术的认知水平及其在审稿实践中的合理运用;此外,审稿声明中应纳入AI使用条款,要求审稿专家承诺并披露AI的应用细节;同时,建立AI使用记录系统,以便追踪审稿过程中的AI工具应用情况;在审稿流程中增设监督环节,确保AI使用的合规性;建立反馈与评估机制,以便于从作者和编辑处收集对审稿专家AI使用的评价,并根据反馈进行周期性评估。最后,促进跨机构合作与交流,共享审稿专家AI使用的经验与最佳实践,以推动行业标准的提升。

4.4 加强AIGC审查与治理制度建设

针对其他学术不端和出版伦理问题,国际协会制定了相关政策,但目前还未对超出AI使用范围和未充分披露AI制定相应的审查和治理措施。AI生成的文本、图像等具有高度的复杂性和不确定性,增加了检测的难度;大型语言模型不断迭代,但目前AIGC检测软件还未普及,因此要依赖于使用者负责任地使用及透明化使用过程。为了应对这一问题,制定明确的处理措施至关重要,这样编辑在遇到相关问题时可以有据可依。同时,这也提醒研究者和作者在学术研究和写作中合理使用AI技术,遵循AI使用规范,维护学术诚信。

超出AI使用范围和未充分披露是学术伦理失范的表现形式之一。国内外出版机构应迅速建立和完善AI伦理审查制度。这样的制度不仅能够预防潜在的法律和责任问题,还能降低因技术应用不当而带来的伦理风险。审核的重点应包括数据的合法性、内容的合规性、敏感数据的处理方式以及知识产权的保护问题等。

此外,为了形成更加全面和有效的治理体系,出版机构在推进AI技术在学术出版中的应用时,应主动与高等教育机构、科研单位、项目资助机构等多元主体建立紧密的合作关系。通过合作,各方可以共同探讨和制定一套关于AI使用的治理规范,以引导和规范AI技术在学术出版领域的合理运用。这种跨学科、跨领域的合作模式,将极大地提高AI技术在学术出版中应用的透明度,确保其操作流程和结果的可追溯性,从而为AI技术的健康发展提供有力的制度保障。

5 结 语

本文采用严格的纳入与排除标准,仅从排名前70的国际出版机构中选取23家,样本量相对有限。但这些出版机构均在国际上享有盛誉,旗下拥有众多期刊,能够代表高水平的出版标准。本文对这些机构的政策进行了深入分析,并获得了有意义的发现。同时,注意到一些国际出版机构及其期刊以社论、新闻、观点文章等多种形式发布了关于AI出版的伦理政策。本文主要检索了官方网站上正式发布的政策与伦理声明,未专门搜寻相关文章,可能导致部分信息的遗漏或不全面。

随着AI技术的飞速发展,AI在出版领域的应用日益广泛,AI出版伦理也逐渐成为期刊伦理建设的核心组成部分。通过本文调查可以发现,出版机构在一些总的出版原则上与国际协会/委员会一致,如不承认AI工具的作者身份、透明化披露AI使用及使用者对稿件内容负全部责任。但目前关于AI的使用边界还比较模糊,披露细节也存在差异。关于AI使用还有很多问题待解决,如AIGC的检测、对剽窃的判定、AIGC版权归属,同时错误虚假的AIGC给同行评审也带来挑战。在未来的学术出版实践中,还会不断涌现出新的AI出版伦理问题,为了更好地应对这些问题,需要从伦理、技术、法律等多个维度,规范AI在学术研究及出版中的应用,明确使用者的主导地位;从协同治理理念出发,联合多方学术共同体及管理部门完善伦理规范,引导其沿着科技向善的方向稳定推进,营造良好的学术生态。

注 释

[1] Lambert J, Stevens M. ChatGPT and generative AI technology: a mixed bag of concerns and new opportunities [J]. Computers in the Schools, 2023:1-25

[2] Sedaghat S. Early applications of ChatGPT in medical practice, education and research [J]. Clinical Medicine(Lond) , 2023, 23(3): 278

[3] Rahimi F, Talebi Bezmin Abadi A. ChatGPT and publication ethics [J]. Archives of Medical Research, 2023, 54(3): 272

[4] ChatGPT helps radiologist churn out 16 papers in 4 months [EB/OL]. [2024-01-17]. https://healthimaging.com/topics/artificial-intelligence/chatgpt-helps-radiologist-churn-out-16-papers-4-months

[5][30] Donker T. The dangers of using large language models for peer review[J]. The Lancet Infectious Diseases, 2023, 23(7): 781

[6][31] Hosseini M, Horbach SPJM. Fighting reviewer fatigue or amplifying bias? Considerations and recommendations for use of ChatGPT and other large language models in scholarly peer review [J]. Research Square, 2023, rs.3.rs-2587766

[7] Ali MJ, Singh S. ChatGPT and scientific abstract writing: pitfalls and caution [J]. Graefes Archive for Clinical and Experimental Ophthalmology, 2023, 261(11): 3205

[8] 华劼. 合理使用制度运用于人工智能创作的两难及出路[J]. 电子知识产权,2019(4):28-39

[9] 英伦阁. 人工智能在研究与出版业的应用 [EB/OL]. [2024-01-16]. https://www.enago.cn/academy/ren-gong-zhi-neng-zai-yan-jiu-yu-chu-ban-ye-de-ying-yong

[10] Khalifa M, Albadawy M. Using artificial intelligence in academic writing and research: An essential productivity tool [J]. Computer Methods and Programs in Biomedicine Update, 2024( 5): 100145

[11][14] 任安麒. 数字出版领域智能语言模型的应用、风险与治理:基于ChatGPT技术特征的分析 [J]. 出版科学,2023,31(3):94-102

[12][17]宋时磊, 杨逸云. 应用场景、风险与前景:ChatGPT类大语言模型时代的学术出版 [J]. 出版科学,2023,31(5):76-84

[13] COPE. Discussion document:Artificial intelligence(AI)in decision making[EB/OL]. [2024-01-17]. https://publicationethics.org/sites/default/files/ai-in-decision-making-discussion-doc.pdf

[15][22] 方卿, 丁靖佳. 人工智能生成内容(AIGC)的三个出版学议题 [J]. 出版科学,2023,31(2):5-10

[16] Stokel-Walker C. ChatGPT listed as author on research papers:Many scientists disapprove[J]. Nature, 2023, 613(7945): 620-621

[18] COPE. COPE position statement (2023) In: Authorship and AI tools[EB/OL]. [2024-01-16]. https:// publicationethics.org/cope-position-statements/ai-author

[19][32][41] ICMJE. Recommendations for the conduct, reporting, editing, and publication of scholarly work in medical journals[EB/OL]. [2024-01-17]. https://icmje.org/recommendations

[20] Zielinski C, Winker MA, Aggarwal R, et al. Chatbots, Generative AI, and Scholarly Manuscripts. WAME Recommendations on Chatbots and Generative Artificial Intelligence in Relation to Scholarly Publications[EB/OL]. [2024-01-17]. https://wame.org/pdf/Chatbots-Generative-AI-and-Scholarly-Manuscripts.pdf

[21] Lund B D, Naheem K T. Can ChatGPT be an author? A study of artificial intelligence authorship policies in top academic journals [J]. Learned Publishing, 2024, 37(1): 13-21

[23] 范心悦. 从算法认知看人工智能的责任主体问题[D]. 甘肃:兰州大学,2023:7

[24] OpenAI. Terms of use [EB/OL]. [2024-02-17]. https://openai.com/policies/terms-of-use

[25][39][43][44] 程睿. ChatGPT介入学术论文透明度义务的可视正义功能 [J]. 科学学研究,2023,41(12):2138-2146

[26] Fujimoto S, Takemoto K. Revisiting the political biases of ChatGPT [J]. Frontiers in Artificial Intelligence,2023(12):2138-2146

[27] Alawida M, Mejri S, Mehmood A, et al. A comprehensive study of ChatGPT: Advancements, limitations, and ethical considerations in natural language processing and cybersecurity[J]. Information, 2023, 14(8): 462

[28] Yuan WZ, Liu PF, Neubig G. Can we automate scientific reviewing [J].2021, arXiv:2102.00176

[29] Graf A, Bernardi RE. ChatGPT in research: Balancing ethics, transparency and advancement [J]. Neuroscience,2023, 515: 71

[33] 李志祥.伦理学视域下的人工智能发展 [EB/OL]. [2024-01-17]. https://news.gmw.cn/2024-02/19/content_37150949.htm

[34] 韩旭至. 生成式人工智能治理的逻辑更新与路径优化 [J]. 行政法学研究, 2023(6): 30-42

[35] 蒋雪颖, 刘欣. 生成式人工智能技术下的学术生产与出版:变革、失范与路径 [J]. 数字图书馆论坛, 2023,19(5): 64-71

[36] 邓若玉. 人工智能发展的科技伦理反思 [J]. 广西社会科学, 2020(10): 93-97

[37] 吉林大学学报工学版. 《学术出版中AIGC使用边界指南》正式发布[OL].[2024-01-17]. https://mp.weixin.qq.com/s?biz=MzI2MjUzMDUwOQ==&mid=2247489029&idx=2&sn=ee1c3984ba809ee8a522e7e52360ad4a&chksm=ea48e2a7dd3f6bb1eeefc99a401efd33b230b7c98963a29a741b98026ca6ad48f98f4b389c4c&scene=27

[38]中华口腔医学杂志. 中华医学会杂志社关于在论文写作和评审过程中使用生成式人工智能技术的有关规定[OL]. https://mp.weixin.qq.com/s?__biz=MzA5Nzc2MjE5NQ==&mid=2653558636&idx=1&sn=370aafb6456cb83191f104c612d88b95&chksm=8b455990bc32d0862170c5ded1d019c3c642e7e70bd148ca937c3618274047cd448c80fec9ec&scene=27

[40] Gaggioli A. Ethics: Disclose use of AI in scientific manuscripts [J]. Nature, 2023, 614(7948): 413

[42] Hosseini M, Resnik DB, Holmes K. The ethics of disclosing the use of artificial intelligence tools in writing scholarly manuscripts [J]. Research Ethics, 2023, 19(4):449-465

[45] Bauchner H, Rivara FP. Use of artificial intelligence and the future of peer review [J]. Health Affairs Scholar, 2024, 2(5): qxae058

(收稿日期:2024-02-20;修回日期:2024-09-04)