基于改进Swin Transformer 的花色布匹瑕疵检测算法

邱健数 项朝辉 钱月钟

摘要:在进行布匹瑕疵检测时,复杂的花色纹理对瑕疵的检测带来一定的困难。针对该问题,文中提出了基于改进SwinTransformer的花色布匹瑕疵检测算法。首先,利用双路Swin Transformer注意力骨干网络提取缺陷图与模板图中的特征信息。然后,采用改进的特征金字塔网络对四个层次的特征进行融合。最后,根据融合后的特征完成了瑕疵的定位与分类。在布匹生成工厂采集的数据集上进行模型训练与测试,结果表明,文中所提算法的准确率和平均精确率均优于所比较的算法。

关键词:布匹瑕疵检测;注意力网络;特征金字塔网络;瑕疵分类;计算机视觉

中图分类号:TP391 文献标识码:A

文章编号:1009-3044(2024)13-0009-05 开放科学(资源服务)标识码(OSID) :

0 引言

纺织布匹具有多变、复杂的纹理图案,被广泛应用于服装、鞋类等产品的生产中。由于纺织机械故障、纱线原料问题,在纺织布匹制造过程中会出现种类多样的瑕疵。目前,纺织行业定义的织物瑕疵达到70多种[1]。传统纺织工厂仍主要采用人工检测,该方法依赖于检测人员的经验,且随着作业时间延长,易产生疲劳,造成漏检和误检。因此,纺织布匹自动检测对提升产品质量、降低经济损失具有较大意义。

传统的布匹瑕疵自动化检测方法包括:统计学方法[2]、光谱分析法[3]和模型法[4]。近年来,人工智能技术迅速发展,大量研究人员开始使用人工智能算法解决布匹瑕疵检测问题。其中,卷积神经网络相关的算法最为突出。Jing等[5]提出了一种非常高效的卷积神经网络Mobile-Unet来实现端到端的缺陷分割。Jun等[6]采用两阶段的卷积神经网络对局部缺陷和全局缺陷分别进行识别。Jing等[7]在YOLOv3模型的基础上结合织物缺陷尺寸和k-means算法对目标帧进行维度聚类,有效降低了织物疵点的检测错误率。Xie等[8]基于全卷积通道注意块和自底向上路径增强传递连接块设计了改进的RefineDet网络,提高了缺陷定位精度。Song等[9]采用了EfficientDet-D0作为检测算法,综合了轻量级和可扩展性的优点,适应资源受限的边缘设备。杨毅等[10]在MobileNetv2的逆残差结构中加入CoordAttention注意力模块,将空间精确位置信息嵌入到通道注意力中,增强网络聚焦小目标特征的能力。龙玥等[11]将RepVGG网络融合SE模块,提出SERepVGG网络作为SSD的主干网络在增强网络特征提取能力的同时,减少网络的参数量和计算量。张银等[12]针对织物图像尺寸大、局部瑕疵数量少、图像背景复杂等问题,设计了一种基于Cascade R-CNN融合尺度不变特征的织物瑕疵检测方法。曲皓等[13]提出一种双端输入型网络架构Wnet,在卷积深层网络中补充全局信息但对细小的织物瑕疵,检测效果依旧不够理想。

尽管利用卷积神经网络进行织物瑕疵检测具有良好的局部特征提取能力,但缺少全局建模能力,导致特征中缺乏全局信息,无法达到预期的检测效果。Transformer具有完备的全局建模能力,最初被广泛应用于自然语言处理领域,后被引入计算机视觉领域。Dosovitskiy等[14]提出的Vision Transformer将图片切分为图片块作为Transformer的输入,在图片分类任务上表现很好。Transformer的核心算法是自注意力机制,该机制弥补了卷积神经网络在全局建模上的短板。李辉等[15]提出了融合形变卷积和自注意力的素色布匹检测方法,有效提升了布匹瑕疵检测的准确率和效率。时造雄等[16]在改进的YOLOv5模型颈部中引入注意力机制,能同时关注空间和通道信息,提高花色布匹表面瑕疵检测的准确率。Transformer的自注意力机制从语言应用到视觉应用的挑战源自于两个领域的差异。例如,视觉实体在尺度上存在巨大差异。Liu等[17]提出了移动窗口计算的Swin Transformer,提升了在各种尺度上建模的灵活性,在许多通用检测数据集上取得了领先的检测效果。然而,纺织布匹瑕疵具有背景复杂、小目标为主和目标长宽比极端等难点存在,直接使用Swin Transformer 难以得到理想的效果。

因此,本文提出了一种改进的Swin Transformer布匹瑕疵检测网络Double-Swin。该网络设计了双路注意力通道的骨干网络,同时在检测图和模板图上进行注意力计算,且分阶段融合注意力信息,有助于网络关注到瑕疵与背景之间的联系。同时,采用改进的BiFPN颈部网络,对不同阶段的特征按照自适应权重进行融合,有助于目标的发现。在相同的复杂花色布匹数据集上进行的大量实验表明,Double-Swin的表现超过现有的主流目标检测模型。

1 Double-Swin 模型

1.1 Double-Swin 骨干网络

本文设计的Double-Swin骨干网络主要分为两部分:1) 设计了双路注意力通道,同时输入检测图和对应的模板图,经过注意力计算后,将上路注意力特征与下路注意力特征融合,进入下一阶段注意力计算。2) Swim Transformer模块,该模块在双路通道上共享相同的权重,在上路中主要计算检测图中的缺陷注意力,在下路中主要计算模板图中的背景注意力。具体结构如图1所示。

受人工检测过程启发,检测人员会对比检测布匹和模板布匹来发现瑕疵。因此,本文设计了双路注意力通道结构。双路注意力通道的主要作用包括:1) 计算检测图上的注意力,得到与布匹瑕疵相关的全局信息;2) 计算模板图上的注意力,得到与布匹背景相关的全局信息;3) 融合上下路注意力,使得网络能够关注到瑕疵与背景之间的联系。结合Swim Trans?former,该部分计算过程如下:

1.2 改进的特征金字塔网络

通常,在深度骨干网络提取特征的过程中,网络的深层包含较多的全局信息,而浅层包含更多的局部信息。将深层和浅层的多尺度特征进行融合,可以有效提升目标检测的效果[18-19]。特征金字塔网络(FPN) [20]提出了自上而下将深层特征和浅层特征进行融合的方法,从而提升小目标检测能力。受到NAS-FPN[21]和BiFPN[22]的启发,本文设计了改进的双向特征金字塔(DTSkip-BiFPN) 。该结构避免了NAS-FPN所需的极大搜索算力,同时与BiFPN相比,引入了自下而上的间隔跳跃连接,能够将深层的特征信息跨尺度融合到浅层特征中。具体结构如图2(d) 所示。

在进行特征融合时,对于每一个融合节点的输入特征赋予可学习的权重wi,且wi ≥ 0,以DTSkip-BiFPN 的第4层为例,融合过程如下所示:

式中,Ptd4 为自顶向下路径融合第4层的中间特征,Conv() 为卷积计算,Resize() 为重塑尺寸计算,ε=0.000 1起到避免数值不稳定的作用。

1.3 Double-swin 模型完整结构

Double-swin的完整网络结构如图3所示,首先将宽度均为W、高度为H 的检测图像和对应的模板图输入网络中,经过Patch Partition模块等分为16个区域,双路数据尺寸均从(W,H,3) 被转换为( W/4, H/4,48)。随后,在Double-ST Block1中,双路数据首先经过一个相同的Linear Emberdding层被分别投影至维度C,接着双路数据进入两个连续的Swim Transformer进行注意力计算,前一个Swim Transformer使用W-MSA进行多头自注意力计算,后一个Swim Transformer使用SW-MSA进行滑动窗口多头注意力计算,实现了信息的跨窗口通信,计算过程中,数据尺寸会维持在( W/4, H/4),Double-ST Block1 最终输出的双路数据尺寸均为( W/4, H/4,C )。双路的输出特征将进行一次融合,使得网络关注到瑕疵与背景之间的联系。融合后的特征和模板路的特征将再次以双路的形式进入Double-ST Block2中。在Double-ST Block2阶段,双路输入先经过一个共同的Patch Mergeing层,对数据完成一次下采样,双路数据尺寸均变换到( W/8, H/8,2C ),之后的注意力计算与Double-ST Block1 相同。Double-STBlock2 最终输出的双路数据尺寸均为( W/8, H/8,2C )。Double-ST Block3 和Double-ST Block4经过类似的计算,分别输出的数据特征尺寸为(W/16 , H/16 ,4C )和( W/32 , H/32 ,8C )。至此,骨干网络已完成注意力特征提取。4个阶段的特征信息再经过3层DTSkip-BiFPN的多尺度特征融合,最后经过预测层,实现最终的布匹瑕疵检测。

2 实验及结果分析

2.1 实验数据集说明

本文实验所使用的数据采集自佛山南海纺织车间[23]。训练集由3 933 幅缺陷图及对应的模板图构成,总计15 600个瑕疵标签。测试集包含438幅缺陷图,1 651个瑕疵标签。瑕疵缺陷涵盖了纺织业中常见的15类瑕疵,例如玷污、错花等,每幅待检测的缺陷图含有一种或多种瑕疵。图像的原尺寸为4 096×1696,在实验时进行了裁剪并缩放为512×256。在训练过程中,采取了随机翻转、对称变化等数据增强方式对训练集进行数据扩充,布匹瑕疵样本如图4所示。实验所使用的计算设备的CPU型号为Intel Core i7,GPU型号为NVIDIA RTX-3080,内存为64G,使用Py?Torch进行网络模型搭建。

2.2 实验评价指标

为了对本文方法的性能进行评估,从准确度(Ac?curacy,Acc) 和平均精准度(Average Precision,AP) 来分析性能,其中准确度:

式中,TP为判断正确的正例个数,FP为判断错误的正例个数,TN为判断正确的负例个数,FN为判断错误的负例个数。平均精确度:

式中,p = TP/TP + FP 表示精确率,r = TP/TP + FN 表示召回率,那么AP就可以模型在不同召回率下的平均精确度,即为PR曲线下的面积。

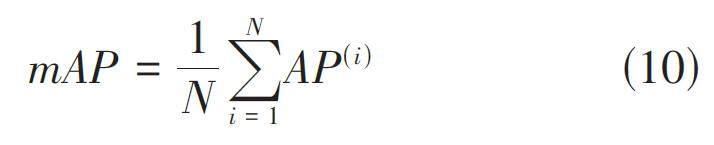

若AP(i)表示第i类瑕疵平均精确度,则类别平均精准度:

2.3 实验设计与结果分析

为验证本文模型的有效性,对比了本文模型与Faster R-CNN、Cascade R-CNN和DETR在2.1提到的布匹数据集上的性能。四组实验的Batch size均设置为8,并采用等间隔调整策略对学习率进行调整。根据表1,可见Double-swin和DETR在准确率和各项平均精确度上均优于卷积类的网络。这主要得益于trans?former类骨干网络相比卷积类骨干网络具有更好的全局信息提取能力,有利于瑕疵的检测。具体来说,AP50表示在IOU阈值为0.5时的平均精确率,AP75表示在IOU 阈值为0.75 时的平均精确率。本文提出的Double-swin,在AP50上分别比Faster R-CNN、CascadeR-CNN和DETR提升了11.8%、6% 和2.7%,在AP75上分别提升了13.5%、7.4%和2.9%。APs表示IOU阈值在[0.5, 0.95]区间上对尺寸小于32×32的瑕疵的平均精确率,APm表示IOU阈值在[0.5, 0.95]区间上对尺寸介于32×32 和96×96 之间的瑕疵的平均精确率,APl 表示IOU阈值在[0.5, 0.95]区间上对尺寸大于96×96的瑕疵的平均精确率。Double-swin在各个尺寸的瑕疵检测能力都优于其他模型,在小瑕疵和大瑕疵的检测效果提升明显,可推断Double-swin的双路注意力结构和改进的特征金字塔为布匹瑕疵检测提供了更多有效的信息。在关键评估指标mAP上,Double-swin相较其他模型分别提升了10.5%、4.4%和1.8%。

为了更直观地比较模型在复杂背景下的瑕疵检测性能,笔者对上述模型在布匹背景复杂情况下的实际检测效果进行了对比,结果如图5所示。图中红色框表示瑕疵的真实位置,绿色框表示模型的预测位置。从对比结果可以看出,本文提出的Double-swin 能够更完整、更精确地定位出瑕疵。

为进一步分析Double-swin中双路注意力结构和DTSkip-BiFPN的有效性,笔者设计了4组消融实验。从表2可以看出,与直接使用Swin Transformer作为骨干网络、BiFPN作为特征融合结构相比,使用Doubleswin的双路注意力骨干网络在关键评价指标mAP上提升了1.1%,使用DTSkip-BiFPN 在mAP 上提升了0.3%。由此可知,双路注意力结构和DTSkip-BiFPN 在提升模型性能上均是有效的,其中双路注意力结构的提升效果更为显著。

3 结束语

本文设计了Double-swin布匹瑕疵检测算法,能够有效地对花色布匹上的各类瑕疵进行定位与分类。首先,利用双路Swin Transformer骨干网络同时提取检测图和模板图上的注意力特征,然后使用改进的特征金字塔DTSkip-BiFPN对各阶段的特征进行融合,最后根据融合后的特征进行瑕疵检测。经实验分析发现,本文提出的检测算法效果优于Faster R-CNN、Cas?cade R-CNN和DETR等模型。

参考文献:

[1] HANBAY K,TALU M F,?ZG?VEN ? F. Fabric defect detec?tion systems and methods—a systematic literature review[J].Optik,2016,127(24):11960-11973.

[2] ZHANG K B,YAN Y D,LI P F,et al. Fabric defect detection us?ing salience metric for color dissimilarity and positional aggre?gation[J]. IEEE Access,2018,6:49170-49181.

[3] TONG L,WONG W K,KWONG C K. Fabric defect detection forapparel industry:a nonlocal sparse representation approach[J].IEEE Access,2017:1.

[4] YAN H,PAYNABAR K,SHI J J. Anomaly detection in imageswith smooth background via smooth-sparse decomposition[J].Technometrics,2017,59(1):102-114.

[5] JING J F,WANG Z,R?TSCH M,et al. Mobile-Unet:an efficientconvolutional neural network for fabric defect detection[J]. Tex?tile Research Journal,2022,92(1/2):30-42.

[6] JUN X,WANG J G,ZHOU J,et al. Fabric defect detection basedon a deep convolutional neural network using a two-stage strat?egy[J]. Textile Research Journal,2021,91(1/2):130-142.

[7] JING J F,ZHUO D,ZHANG H H,et al. Fabric defect detectionusing the improved YOLOv3 model[J]. Journal of EngineeredFibers and Fabrics,2020,15:155892502090826.

[8] XIE H S, WU Z S. A robust fabric defect detection methodbased on improved RefineDet[J]. Sensors,2020,20(15):4260.

[9] SONG S J,JING J F,HUANG Y Q,et al. EfficientDet for fabricdefect detection based on edge computing[J]. Journal of Engi?neered Fibers and Fabrics,2021,16:155892502110083.

[10] 杨毅,桑庆兵.多尺度特征自适应融合的轻量化织物瑕疵检测[J].计算机工程,2022,48(12):288-295.

[11] 龙玥,韩军,孙园,等.改进型SSD网络的织物瑕疵检测算法[J].厦门理工学院学报,2022,30(5):64-73.

[12] 张银,佟乐.基于改进CascadeR-CNN的织物瑕疵检测方法[J].上海师范大学学报(自然科学版),2023,52(2):231-237.

[13] 曲皓,狄岚,梁久祯,等.双端输入型嵌套融合多尺度信息的织物瑕疵检测[J]. 南京大学学报(自然科学),2023,59(3):398-412.

[14] DOSOVITSKIY A,BEYER L,KOLESNIKOV A,et al.An imageis worth 16x16 words: transformers for image recognition atscale[EB/OL]. International Conference on Machine Learning.PMLR, 2020.

[15] 李辉,吕祥聪,徐凌伟,等.融合形变卷积和自注意力的素色布匹瑕疵检测[J].聊城大学学报(自然科学版),2022,35(6):1-10.

[16] 时造雄,茅正冲.基于改进Yolov5的花色布匹瑕疵检测方法[J].计算机测量与控制,2023,31(4):56-62.

[17] LIU Z,LIN Y T,CAO Y,et al.Swin Transformer:hierarchical Vi?sion Transformer using Shifted Windows[C]//2021 IEEE/CVFInternational Conference on Computer Vision (ICCV).October10-17,2021.Montreal,QC,Canada.IEEE,2021.

[18] ZHANG F,LIN S L,XIAO X Y,et al.Global attention networkwith multiscale feature fusion for infrared small target detec?tion[J].Optics & Laser Technology,2024,168:110012.

[19] XU H,ZHONG S,ZHANG T X,et al.Multiscale multilevel re?sidual feature fusion for real-time infrared small target detec?tion[J].IEEE Transactions on Geoscience and Remote Sensing,2023,61:1-16.

[20] LIN T Y,DOLLAR P,GIRSHICK R,et al.Feature pyramid net?works for object detection[C]//2017 IEEE Conference on Com?puter Vision and Pattern Recognition (CVPR). July 21-26,2017.Honolulu,HI.IEEE,2017.

[21] GHIASI G,LIN T Y,LE Q V.NAS-FPN:learning scalable fea?ture pyramid architecture for object detection[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition(CVPR).June 15-20,2019.Long Beach,CA,USA.IEEE,2019.

[22] TAN M X,PANG R M,LE Q V.EfficientDet:scalable and effi?cient object detection[C]//2020 IEEE/CVF Conference onComputer Vision and Pattern Recognition (CVPR).June 13-19,2020.Seattle,WA,USA.IEEE,2020.

[23] 孟志青,邱健数.基于级联卷积神经网络的复杂花色布匹瑕疵检测算法[J].模式识别与人工智能,2020,33(12):1135-1144.

【通联编辑:唐一东】

基金项目:2023 年温州市基础科研项目:基于深度学习技术的复杂花色布匹瑕疵检测及预警系统构建(G2023091) ;浙江工贸职业技术学院教师科技创新项目:复杂图案布匹缺陷检测及预警技术研究(纵20220005) ;温州市重大科技项目:基于机器视觉的微型电子元器件在线检测技术研究及装备研制(ZG2023022) 资助