基于注意力交互的可见光红外跟踪算法

王 暐, 付飞亚, 雷 灏, 唐自力

(中国人民解放军63870部队,陕西 渭南 714299)

1 引 言

作为计算机视觉的一个重要研究方向,视觉跟踪长期以可见光图像为研究对象[1],但可见光图像在光照较差及雨、雾、霾等气候条件下的成像效果不理想,导致跟踪算法性能下降[2]。热红外相机在上述恶劣环境中的成像质量更高[1-2],因此,将可见光和热红外图像进行融合,利用二者信息的互补能够实现更稳定的跟踪。目前,可见光红外跟踪(RGB and Thermal infrared tracking,RGB-T)已成为一个新的研究热点,在无人驾驶、监控、军事等领域具有广泛的应用前景[2-3]。

RGB-T 跟踪在传统可见光跟踪算法的基础上进行多模态扩展。Li 等[4]较早进行了RGB-T的跟踪研究,在基于稀疏表示的跟踪框架下,将单模特扩展为多模态,引入自适应模态加权系数。Zhang 等[5]通过计算不同模态的融合权重,探索了后融合在RGB-T 跟踪中的作用,同时引入运动估计提高跟踪性能。

随着深度学习在可见光跟踪中的成功应用,深度学习也被应用于RGB-T 跟踪。Li 等[6]利用两个结构相同、参数经过微调的卷积神经网络分别提取可见光和红外图像的特征,进行在线特征选择,然后在核相关滤波[7]框架下跟踪。Zhang等[8]基于经典跟踪算法DiMP[9],全面考察了像素级、特征级和决策级的融合策略,指出特征级融合对RGB-T 跟踪的性能提升最为显著,但该方法使用了大量额外的训练数据。

基于Siamese 网络的跟踪[10-11]是可见光跟踪算法中的主流,具有优异的跟踪性能。Zhang等[12]在SiamRPN++[11]的基础上,提出一种特征互补和干扰物识别的RGB-T 跟踪算法,设计专用的多模态特征融合模块对可见光特征和红外特征进行交互融合。但这类方法对RGB-T 跟踪的性能提升并不明显,通常需要采用较多的额外数据对网络进行训练才能达到RGB-T 跟踪的基线水平,同时两个模态各有两路卷积网络,使得模型较为繁琐复杂。

MDNet[13]是一种相对较小的跟踪网络(参数量约为4.4M),将它扩展到可见光和红外两个模态时,对训练数据的量要求较低,符合该领域的发展现状,因此,较多的学者关注MDNet 架构下的RGB-T 跟踪算法。文献[14]提出了一种MANet 算法,将MDNet 中的卷积层定义为模态共享适配器,针对红外和可见光图像设计模态适配器,将MDNet 中的全连接层定义为目标适配器,同时考虑了模态间共享特征、模态专有特征以及目标特征。ADRNet[15],CAT[16],APFNet[17]均利用图像序列的属性提升跟踪性能,为每个属性类别的视频训练专门的网络,然后将基于属性的特征进行不同方式的融合。这些算法能够在一定程度上提高跟踪的精度和稳定性,但是在训练阶段需要额外提供图像的属性信息,同时专用网络也会增加算法的复杂性。Wang 等[18]利用相关性对MDNet 中的卷积特征进行增强,建模得到了模态内、模态间和图像帧间的相关关系,建立了红外和可见光图像特征的相互作用机制,取得较好的跟踪结果。在该研究的基础上,Xu 等[19]提出跨模态交互学习框架,将两个模态的特征进行逐像素的相关,尝试挖掘不同模态间更直接的相关关系,提升模态间的信息传播。

上述研究的焦点基本都在可见光特征与红外特征的有效融合上,融合方式主要以加权和串接为主。可见光和红外图像以相同的视角获取,不仅具有模态的差异性,而且在图像结构和内容上也具有共性,模态间的特征融合应同时考虑这种差异性和共性。文献[18-19]通过直观的相关操作对这种共性进行了探索和增强,但没有进行更深入的挖掘。近年来,注意力机制在自然语言处理和计算机视觉领域大放异彩[20-22],特别是Transformer[20]。利用Transformer 的编码器能够对特征进行增强,而解码器模块能够实现两种模态特征自然且充分的交互。

本文采用transformer 的编码器和解码器对两个模态的特征进行有效融合,增强可见光和红外特征,并在融合后的特征中保留两个模态的互补和共性信息,最终提升RGB-T 跟踪的性能。

2 原 理

2.1 基于MDNet 的RGB-T 跟踪算法框架

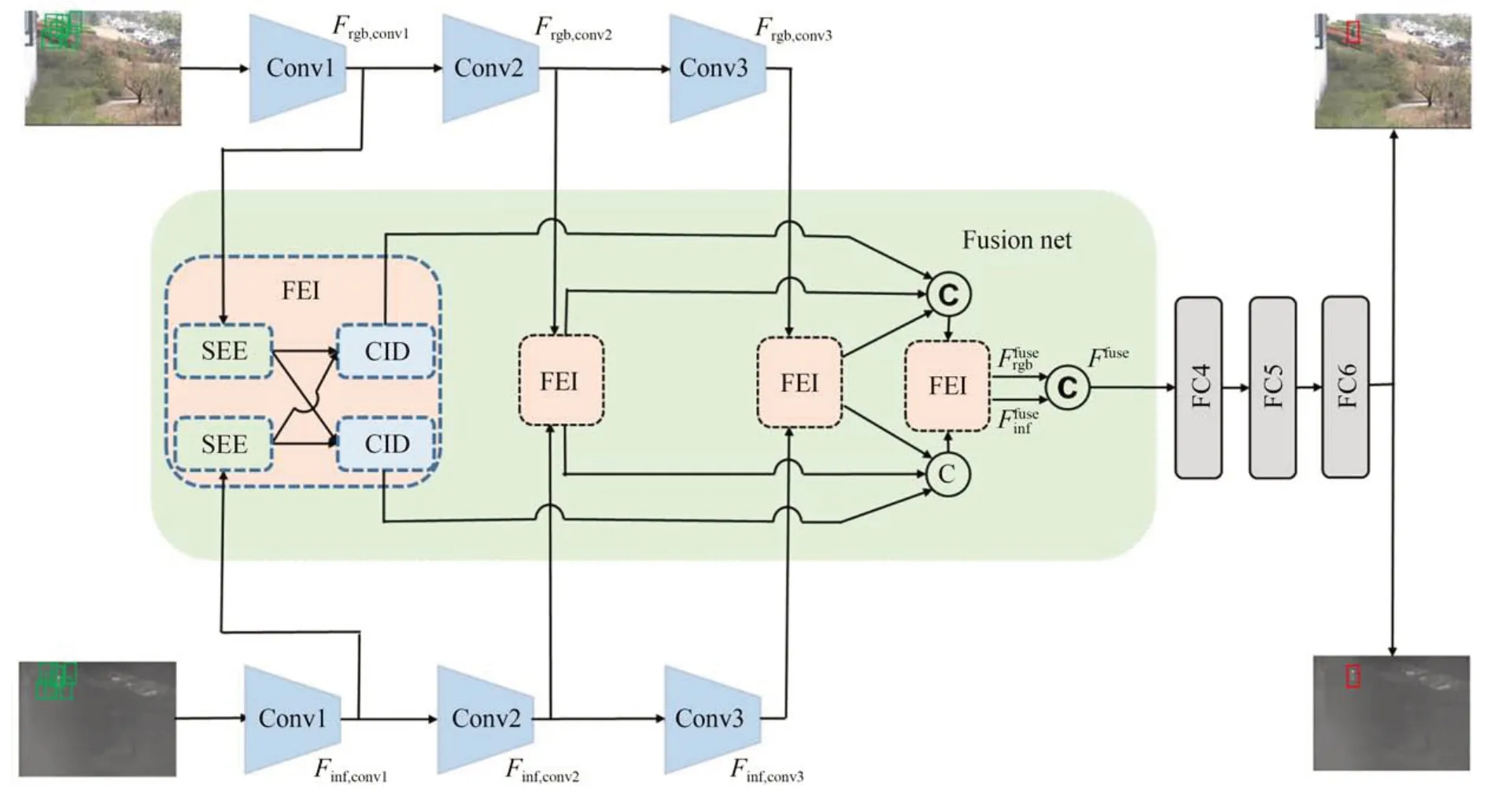

MDNet[13]是一种采用离线预训练和在线更新结合的视觉跟踪算法,其网络由三个卷积层(CNN)和三个全连接层(FC)组成。在RGB-T跟踪任务中,针对可见光和红外图像分别设置一路卷积,并将卷积特征进行融合,即可将MDNet扩展至多模态跟踪。其算法框架如图1 所示,包括双路卷积层、融合网络和全连接层等三部分。

图1 基于MDNet 的RGB-T 跟踪算法Fig.1 Basis framework of MDNet-based RGB-T tracking method

网络的输入为候选图像块,输出为该图像块为目标的概率,每一帧的跟踪结果为概率最大的图像块。MDNet 的卷积网络已经针对可见光跟踪进行了充分的训练,能够提取相应的卷积特征进行跟踪。在跟踪前仅需要对卷积层进行微调,并对融合网络和全连接层进行初始化和训练;在线跟踪过程中,仅对全连接层进行微调和训练。

2.2 Transformer

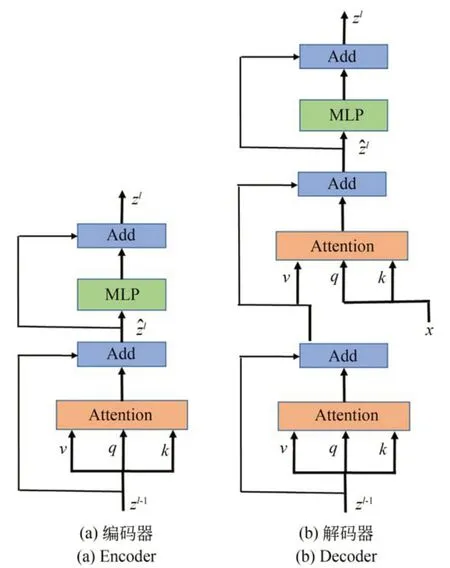

Transformer 首先在文献[20]中被提出,并应用于机器翻译任务。Transformer 由多个注意力模块相互串联构成,每个注意力模块的输入为整个句子,具有全局的表达能力。最初的Transformer 中采用两种注意力模块,编码器和解码器的结构如图2 所示。编码器中,输入序列zl-1首先映射生成q,k,v,三者进行注意力(Attention)运算:

图2 Transformer 结构Fig.2 Structure of transformer

该式通常采用矩阵化运算,d为k的维度。对ẑl进行残差操作(Add),经过映射和一个多层感知机(Multilayer Perception, MLP),即为编码器的输出zl。

解码器和编码器的结构基本相同,区别为解码器多进行一个自注意力操作,并在第二个注意力操作中将k和v替换为外部输入x的映射。文献[20]中还采用位置编码、多头注意力等设置,本文不再详述。

Transformer 结构目前已应用在图像分类[21]、目标检测[23]和目标跟踪[24]等计算机视觉任务中,并取得了较好的效果,验证了编码器-解码器的注意力机制对视觉任务的有效性。APFNet[17]在RGB-T 跟踪中首先引入Transformer,但仅作为其融合网络的众多模块中的一个,且只设计两个编码器和一个解码器对特征进行增强。消融实验表明,该Transformer 模块的引入并未大幅提升RGB-T 跟踪性能。与APFNet 不同,本文设计了一个完全由Transformer 结构组成的融合网络,用以验证Transformer 的注意力结构对多模态特征增强和融合的有效性。

3 本文算法

本文对可见光和红外两个模态的特征融合进行深入挖掘,在基于MDNet 的RGB-T 跟踪框架下,提出一种基于注意力交互的RGB-T 跟踪算法(Attention Interaction based RGB-T Tracking method,AIT)。AIT 的网络结构如图3 所示,包括卷积网络、全连接网络和融合网络,其中前两个网络与MDNet 中相同。融合网络的核心是特征增强和交互模块(Feature Enhance and Interaction module,FEI),它利用自注意力特征增强编码器(Self-feature Enhance Encoder,SEE)对红外和可见光图像特征进行增强,利用互注意力特征交互解码器(Cross-feature Interaction Decoder,CID)对两个模态的图像进行交互融合。为了充分利用多层卷积特征,融合网络对每层卷积特征均采用FEI 进行处理,并利用FEI 对处理后的融合特征进行进一步的融合和增强,以有效提高跟踪算法的性能。

图3 基于自注意力交互的RGB-T 跟踪算法总体结构Fig.3 Framework of attention interaction based RGB-T tracking method

3.1 特征增强和交互模块

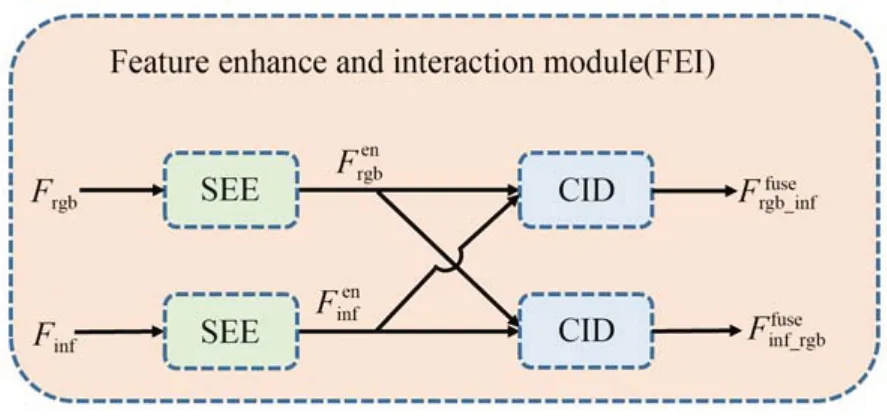

原始的Transformer 结构由编码器和解码器串联组成。为了实现更有效的特征增强和交互融合,这里采用相同的结构,利用两层编码器实现模态内的特征增强、两层编码器实现跨模态的特征交互。特征增强和交互模块的结构如图4 所示,由两个自注意力特征增强编码器(SEE)和两个互注意力特征交互解码器(CID)组成,SEE 和CID 的细节分别如图5(a)和5(b)所示。

图4 特征增强和交互模块结构Fig.4 Structure of FEI module

图5 自注意力增强编码器和互注意力交互解码器构图Fig.5 Structure of Self-feature Enhanced Encoder(SEE)and Cross-feature Interaction Decoder(CID)

SEE 的输入为单一模态的卷积特征,与原始Transformer 不同,本文没有对特征进行升维和降维处理。首先直接将输入特征Frgb(以可见光模态为例,红外模态处理方式相同)按照卷积的空间维度进行变换,设Frgb的维度为H×W×C,H和W分别为特征的空间高宽,C为卷积特征通道数,则索引Q、键K、值V的维度为HW×C,表示有HW个向量,每个向量维度是C,且Q=K=V。然后进行自注意力运算,得到:

其中:Conv1×1表示1×1 卷积,Res 表示残差连接。

SEE 第二层编码器结构与第一层相同,但输入中,索引Q、键值K由最初的特征Frgb维度变换得到,值V由第一层增强的特征维度变换得到,经第二层编码器增强后的特征表示为上述操作表述为:

CID 在结构上与SEE 类似。为了实现可见光和红外两个模态的交互融合,利用注意力机制进行两个模态特征的相互调节。以红外特征对可见光特征进行调节为例,CID 两层解码器的索引Q、键K均来自SEE 增强后的红外特征第一层解码器的值V由SEE 增强后的可见光特征维度变换得到,第二层解码器的值V来自第一层解码器调节交互后的特征。将上述操作表述为:

3.2 多层卷积特征

为了充分利用低层到高层的所有卷积特征,对3 个卷积层的特征都进行了特征增强和交互,得到两个模态分层增强和交互后的特征为了进一步在层间进行特征的增强和融合,对同一模态的多层融合特征进行维度变换并串接,得到和如图3(b)所示。将得到的两个特征作为FEI 的输入,进行多层特征总体的增强和融合,最后将FEI 的两个输出特征串接,得到两个模态的融合特征Ffuse。

3.3 离线训练和在线跟踪

所提网络的离线训练需要考虑:(1)两路卷积层需要分别学习可见光和红外图像的特征;(2)全连接层重新初始化,以适应融合特征的输入;(3)多层的特征增强和交互模块具备特征增强和跨模特的交互能力。在APFNet 等算法中,研究人员采用多阶段离线训练方式逐个模块进行训练,但训练过程较为繁琐。本文提出对各模块进行联合训练,同步优化卷积层、全连接层和融合模块。

通过分析,卷积层和全连接层的参数量与MDNet 基本相同(卷积层参数量为1.8M+1.8M,全链接层参数量为5M)。在FEI 结构下,解码器和编码器中采用传统的MLP,融合网络的参数量将超过100M,对其进行完全初始化的训练不利于网络的收敛,因此,本文提出将解码器和编码器中的MLP 改为1×1 卷积,将融合网络的参数量降至6M,以实现联合训练。联合训练的学习率设置为:卷积层0.000 01,全连接层0.001,融合网络0.000 1,训练的迭代次数为1 500。

在线跟踪阶段,在第一帧初始化FC6 层,微调FC4 和FC5 层,后续帧也仅对这3 个全连接层进行微调,FC4 和FC5 的学习率为0.000 1,FC6层学习率为0.001,网络的其他层参数固定。其余细节请参考MDNet[13]和APFNet[14]。

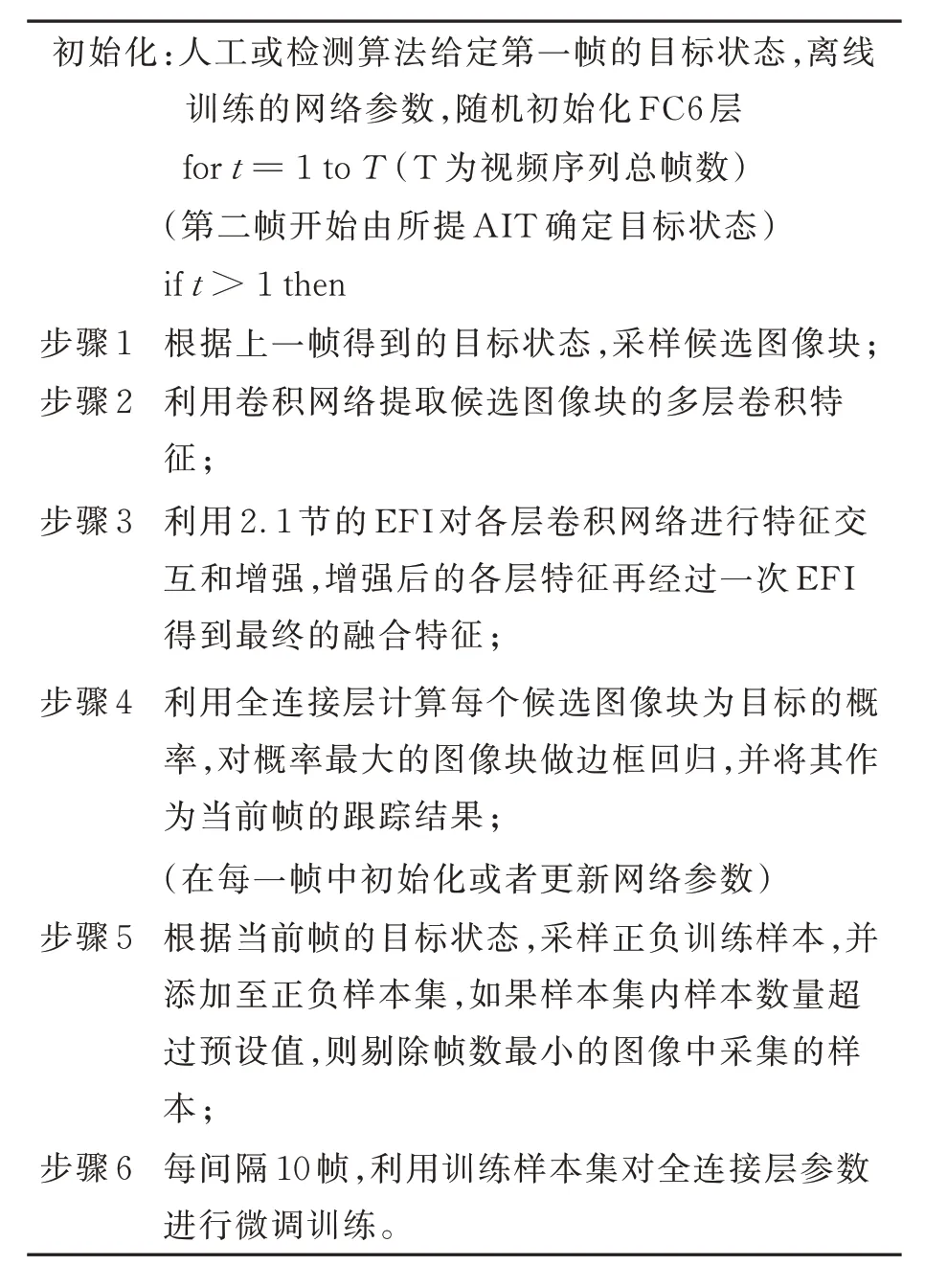

3.4 算法跟踪流程

综上,AIT 算法的在线跟踪流程如下。

4 实验结果分析

实验硬件平台配置如下:CPU 为Intel® Xeon E5-2630 v4,内存为32 GB,GPU 为NVIDIA GeForce RTX 1080Ti,操作系统为 Ubuntu 22.04 LTS,使用pytorch 1.0.1,python 3.7,CUDA 10.2 a 环境。

4.1 数据集及测评方法

GTOT 数据集[24]:该数据集包含50 个可见光-红外视频序列,共有15 000 帧图像,采集场景有道路、行人密集区域等,标注了尺度变化、快速运动、目标形变、热交叠、小目标、遮挡和低光照等7 类对跟踪具有挑战性的标签。

RGBT234 数据集[1]:这是目前应用最普遍的RGB-T 跟踪数据集,包含234 个可见光-红外视频序列,总帧数超过234 000 帧,标注了12 类属性标签和遮挡水平等。

LasHeR 数据集[3]:该数据是目前最大的RGB-T 跟踪数据集,包含1 224 个可见光-红外视频序列,其中979 个序列被划分为训练集,245 个被划分为测试集。

?

本文采用精确率(Precision Rate,PR)和成功率(Success Rate,SR)作为各数据集的评价指标。对某个数据集,精确率定义为跟踪算法输出的目标位置与标注位置的像素距离小于或等于给定阈值的帧数同该数据集总帧数的百分比。通过给定不同的阈值得到算法对数据集的PR 曲线。为了更直观地比较,在PR 曲线中取一个典型PR值对算法进行排名。GTOT 数据集中图像的分辨率较低,目标的像素尺寸小,取阈值为5 对应的精确率为典型值,RGBT234 和LasHeR 数据集中,取阈值为20 对应的精确率为典型值。此外,定义成功率曲线,曲线的横坐标为阈值,阈值范围为[0, 1],曲线纵坐标值为跟踪算法输出的边界框与标注边界框之间的交并比(Intersection of Union,IoU)大于该阈值的帧数同数据集总帧数的百分比,成功率的典型值定义为该成功率曲线下的面积。后续分析中的具体数值对比均采用上述典型值。

为了展示所提算法的有效性,实验选择现有的主流RGB-T 跟踪算法作为对比算法,包括APFNet[17],FANet[25],MANet[14],HDINet[26],M5L[27],CMPP[18],JMMAC[5],CAT[16],DAFNet[28],DAPNet[29],MaCNet[30],以及基础MDNet在RGB-T 跟踪任务上简单处理扩展后的MDNet+RGBT。其中,APFNet 和CMPP 具有最好的跟踪性能。

4.2 GTOT 数据集测评

采用RGBT234 数据集对所提算法进行离线训练,然后测评GTOT 数据集,结果如图6 所示。相较于基础的MDNet+RGBT 算法,AIT 的跟踪精确率和成功率分别提升了11.6% 和10.1%。图6 中,多数算法在GTOT 数据集上具有较高的跟踪性能,趋近饱和,表明该数据在规模和难度上已经不足以充分评估RGB-T 跟踪算法。

图6 AIT 及对比算法在GTOT 数据集上的跟踪结果Fig. 6 Evaluation results of AIT and compared algorithms on GTOT dataset

4.3 RGBT234 数据集测评

采用GTOT 对所提AIT 算法进行离线训练,图7 为所提算法与对比算法在RGBT234 数据集上的跟踪结果。如图7 所示,AIT 算法取得最优的跟踪结果,与原始MDNet+RGBT 相比,AIT 在精确率和成功率上分别提升了11.4%和8.6%,说明特征的交互融合对RGB-T 跟踪的重要性。与已有算法中性能最优的APFNet 算法相比,AIT 在精确率和成功率上分别高出0.9%和0.2%。需要注意的是,APFNet 在离线训练阶段利用视频的属性信息和多阶段的训练策略,而AIT 仅仅是在MDNet 的基础上利用FEI 进行特征增强和融合,进一步说明了FEI 的有效性。

图7 AIT 及对比算法在RGBT234 数据集上的跟踪结果Fig.7 Evaluation results of AIT and compared algorithm on RGBT234 dataset

4.4 LasHeR 数据集测评

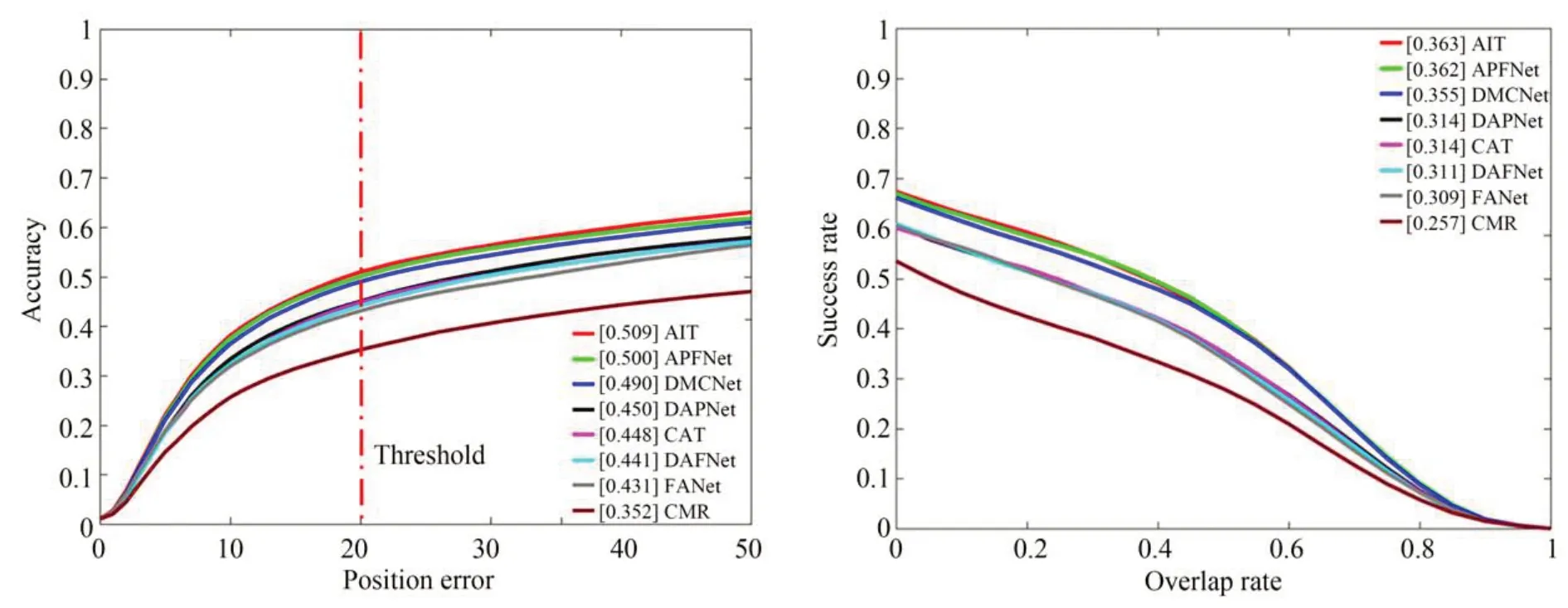

虽然LasHeR 数据集提供了专用的训练数据,但为了与已有算法保持一致,依然采用GTOT 进行离线训练,图8 为AIT 算法在LasHeR 数据集的测试集上的跟踪结果。与前两个数据集不同,该数据集的发布较晚,仅提供了部分较新算法的跟踪结果,因此在该数据集上的对比算法有所不同,包括APFNet,DMCNet[31],DAPNet,CAT,DAFNet,FANet 和CMR[32]。如图8所示,LasHeR 数据集的跟踪难度较大,但AIT 算法依然取得了最优的跟踪结果,在精确率上比已有的最好算法APFNet 和DMCNet 分别高0.9%和1.9%,在成功率上分别高0.1%和0.8%,说明了AIT 算法的有效性。

图8 AIT 及对比算法在LasHeR 测试集上的跟踪结果Fig.8 Evaluation results of AIT and compared algorithms on LasHeR testing set

4.5 消融实验

为了验证对所提融合网络设计的合理性,进行了消融实验。AIT 算法的几个变种包括:(1)AIT_ch,这个版本中将编码器和解码器的注意力按照通道(channel)维度进行操作;(2)AIT_spch,将编码器/解码器中的第二层注意力改为通道维度操作,第一层依然为空间维度;(3)AIT_conv3,仅利用第三层卷积层进行跟踪;(4)AIT_nolastEFI,在三个卷积层特征分别增强和融合后,直接进行维度变换和串接,不增加最后一个EFI 模块。表1 为AIT 与这4 个变种在RGBT234 数据集上的跟踪结果。

表1 AIT 及其变种在RGBT234 数据集上的跟踪结果Tab.1 PR/SR scores of AIT and its variants on RGBT234 dataset

表1 中,AIT 优于AIT_ch 和AIT_spch,表明在本文融合网络结构中,选用特征空间维度注意力操作优于特征通道维度。在特征方面,AIT 明显优于AIT_conv3 和AIT_nolastEFI,表明多层特征的有效性和最后一个EFI 模块的有效性。

5 结 论

本文提出了一种基于注意力交互的RGB-T跟踪算法,从可见光和红外两种模态图像的特征融合出发设计融合网络,引入注意力机制实现了特征增强和跨模态的特征交互。在传统Transformer 注意力网络的基础上,通过利用1×1 卷积替换全连接层等方式减小网络规模。考察了不同层卷积特征对跟踪性能的影响,提出了多层卷积融合的网络结构。AIT 算法在GTOT,RGBT234 和LasHeR 三个数据集上进行了验证,跟踪结果优于文献[17-18]中提出的基线算法,验证了在RGB-T 跟踪中注意力机制对多模态特征融合的有效性。