基于FGF与VGGNet19的红外可见光图像融合

杨艳春,闫 岩,王 可

(兰州交通大学电子与信息工程学院,甘肃 兰州 730070)

1 引 言

图像融合的目的是为了将不同的图像融合在一起生成更适于人类观察的图像,从而方便得到两幅图像中的有用信息[1]。红外图像中,物体热辐射与其对应在图像中的灰度值成正比关系,热辐射越高的物体,灰度值也就越高,能够较好地突出发热目标;可见光图像中,主要突出反射亮度较高的物体,具有丰富纹理细节信息,符合人类视觉感知[2-6]。将红外与可见光图像进行融合之后的图像既能够凸显红外图像中的热辐射较高的目标,也能够保持可见光图像中的纹理细节以及边缘信息,提高在视觉效果不佳时(如降水、大雾或有遮挡情况下)对发热目标的检测和识别的能力[7-10]。目前在电力设备监测、军事目标识别与自动驾驶等领域有广泛应用[11]。

目前大多数学者广泛认可的图像融合方法可分为两类:传统方法和基于深度学习的方法。多尺度变换方法是传统方法的一个重要分支,其中包括有金字塔变换方法[12]、小波变换[13]以及非下采样剪切波变换(Non-Subsampled Shearlrt Transform,NSST)[14]等。近年来,由于深度学习具有较强的非线性特征学习和复杂特征表达能力,因此在图像融合领域中得到了深入研究。Ma等人[15]利用两个神经网络同步训练的模式,训练出的生成器负责向红外图像中添加纹理细节,鉴别器负责识别生成器生成的融合图像,有效提升了融合质量;Zhang等人[16]提出了将多个融合问题转化为梯度和强度信息的提取和重建,并据此设计了一种由强度项和梯度项组成的通用形式的损失函数的一种压缩分解网络(SDNet);Tang等人[17]提出了一种基于光照感知的渐进式图像融合网络(PIAFusion),自适应地保持显著目标的强度分布,并保留背景中的纹理信息;Xu等人[18]提出的U2Fusion通过特征提取和信息测量,自动估计相应源图像的重要性,并提出自适应信息保留度。目前利用深度学习工具进行融合取得了较好的融合效果,然而红外与可见光图像在融合过程中存在不能很好地结合尺度信息,出现红外目标不够突出,边缘模糊及细节丢失等问题。

为了解决上述问题,由于快速引导滤波的边缘保护特性,在平滑操作中不丢失基础层的边缘信息,本文提出了一种基于FGF和VGGNet19的红外与可见光图像融合方法。首先,利用快速引导滤波器有效实现源图像双尺度分解。其次,利用VGGNet19网络得到初步融合权重图,采用最大类间方差法提取前景与背景,进行二值化。然后,对得到的二值图像再次使用快速引导滤波器得到最终融合权重矩阵,利用加权融合重建各层的融合图像以获得初步融合图像。最后,重构再利用FGF和增强处理实现图像最终融合。通过对比实验,本文方法能够有效保留显著热目标,边缘细节清晰,融合图像具有较好的可视性。

2 相关工作介绍

2.1 快速引导滤波器

快速引导滤波器(Fast Guided Filter,FGF)[19]是一种保边平滑滤波器,是对引导滤波器(Guided Filter)[20]的一个改进方法。

引导滤波器的局部线性关系为:

qi=ajIi+bj,∀i∈ωj

(1)

在公式(1)、(2)和(3)中Ii,pi与qi分别为引导图像、输入图像与输出图像对应像素点的值。对给定的输入图像p,使p与q之间的重构误差最小,因此可将aj与bj的求解问题转化为如下两式:

(2)

(3)

其中,λj与∂j是滤波窗口j中的均值与方差;δ为防止当输入图像p和引导图像I相同时导致aj=1的正则化参数。

快速引导滤波进行了针对性的改进,在(1)式中aj和bj为两个系数图,q中的边缘与结构主要通过引导图像I给出,但引导滤波器的主要计算是针对aj和bj,不需要以全分辨率执行。所以对输入图像p和引导图像I进行下采样(最近邻下采样或双线性下采样)。所有的盒式滤波器都在低分辨率图像上执行,这是引导滤波器的核心计算过程。在得到最终输出图像之前,将两个系数图aj和bj双线性上采样到原始大小。输出q仍然由qi=ajIi+bj计算。在最后一步中,图像I是未经下采样的全分辨率引导图像,所以引导图像分辨率没有变化。

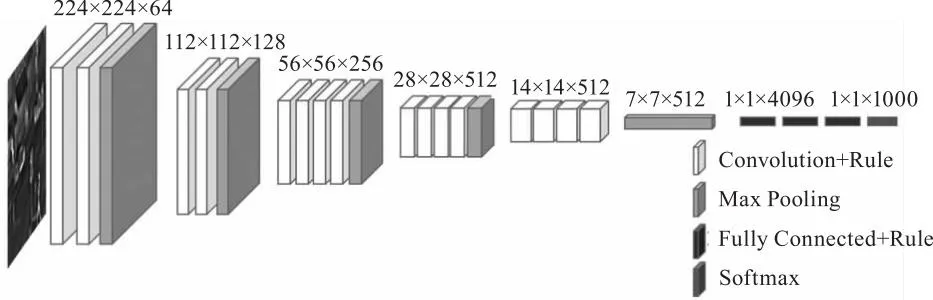

2.2 VGGNet19网络框架

因为采用更多的非线性层可以增加网络深度,有效提取图像特征,而且生成的参数还相对较少,提高网络性能,所以VGGNet19网络设计利用多个小卷积核代替单一大卷积核[21],在相同感受野的前提下,效果得到提升。更深一层的神经网络都会利用上一层输出的参数来更加精确的提取特征,所以,可以认为每层神经网络都是由多个不同卷积核所组成的多个局部特征提取器。与此同时,也验证了在一定程度上,增加网络卷积层的数量,可以提升网络最终的特征提取结果。VGGNet19网络包括16个卷积层与3个全连接层,其网络结构如图1所示。

图1 VGGNet19网络结构模型图

3 本文方法

本文提出的方法如图2所示,具体步骤如下:

图2 所提方法处理流程

(1)将红外图像I1与可见光图像I2通过使用快速引导滤波器,得到相应的基础图B1和B2与细节图D1和D2;

(2)将I1、I2输入到VGGNet19预训练模型中得到得分图S,将S经过最大类间方差法(OTSU),分割图像前景与背景并且二值化,得到特征图T,基础层与细节层权重图(WB1,WB2)、(WD1,WD2)由FGF得到;

(3)将得到B和D求和,再经过快速引导滤波和图像增强得到融合图像。

3.1 双尺度分解

均值滤波通常作为传统的双尺度图像分解方法,但是由于均值滤波器的特性,它不仅消除了高频噪声,还使图像边缘模糊,同时,细节层的边缘会产生冗余信息,这对融合结果产生不利影响。因此,本文使用快速引导滤波器对源图像进行双尺度分解。快速引导滤波器具有更好的边缘保护特性,可以在不模糊图像边缘的情况下获得图像的基础层,通过源图像减去基础层得到细节层不会生成冗余信息,并且比传统方法更真实地恢复图像细节。通过快速引导滤波得到的可表示为:

Bn=FGF(In,pn,r,eps,s)

(4)

其中,In为引导图像,pn为输入图像,将源图像作为引导图像此处引导图像与输入图像为同一组红外与可见光图像,r为FGF窗口尺寸,eps为正则化参数,s为子采样率。细节层Dn如下所示:

Dn=In-Bn

(5)

3.2 特征图与权重矩阵

VGGNet19网络最大的特点是源图像通过预训练框架得到的特征图能够充分提取图像特征,得到有用的部分,去除冗余数据与伪影,使得后续得到的融合权重图更加精准。因此将红外图像I1与可见光图像I2输入VGGNet19预训练框架,可表示为:

(6)

(7)

(8)

其中,r确定平均算子窗口大小。在本文的方法中r=1。

(9)

(10)

(11)

选取得到的四个初始得分图中每个对应像素点的最大值,输出有且仅有一个的最终得分图S:

S(x,y)=max[Si(x,y)|i∈{1,2,3,4}]

(12)

最大类间方差法[22](OTSU)其自适应性强,在任何前景与背景灰度值差异较大的情况下都可以取得很好的效果,且计算简单。

将得分图S通过OTSU算法得到初始特征图T′,可由式(13)表示:

T′(x,y)=OTSU[S(x,y)]

(13)

然后将T′进行二值分割,得到最终特征图T可由式(14)表示:

(14)

由于快速引导滤波器可以通过引导图像中的边缘部分将输入图像的边缘进行平滑,去除噪声与冗余,因此利用FGF对特征图T进行处理,特征图T分别由In与Dn作为引导图像,基础层和细节层的融合权重图(WB1,WB2)、(WD1,WD2)是利用FGF后得到,可由式(15)、(16)表示:

WBn=FGF(In,T,r,eps,s)

(15)

WDn=FGF(Dn,T,r,eps,s)

(16)

3.3 图像重构

对应于红外和可见光双尺度分解的基础层Bn和细节层Dn乘以相应的权重矩阵,以获得基础层和细节层的融合图像,其公式如下:

B=WB1×B1+WB2×B2

(17)

D=WD1×D1+WD2×D2

(18)

初步的融合图像FC如下:

FC=B+D

(19)

初步融合图像FC只保留了红外和可见光图像的细节部分,而并没有突出融合图像中的红外目标。为了得到细节丰富、目标突出的融合图像,利用快速引导滤波具有图像增强的特性,对初步融合图像进行增强:

G=FGF(FC,FC,r,eps,s)

(20)

F=(FC-G).*n+G

(21)

其中,G是以FC作为引导图像与输入图像的快速引导滤波结果;n是增强系数;F是最终融合图像,其中n=2。由于快速引导滤波对灰度值变化较大的边缘区域作用明显,所以通过式(21)增强图像边缘信息,然后将其叠加在G上以达到提取图像边缘信息的目的。

4 实验结果与分析

4.1 实验说明

本文红外与可见光源图像选取公共数据集TNO中的42组图像进行实验,实验仿真平台采用AMD Ryzen 7 5800H CPU,RTX 3060 GPU编程环境为Matlab2016a。为验证算法性能,本文选定6组已配准图像进行实验分析,其大小分别为768×576 pixel、596×328 pixel、620×450 pixel、768×576 pixel、768×576 pixel、632×496 pixel。本文快速引导滤波器参数为r=32;eps=0.3;s=4。

本文使用在ImageNet上训练的固定VGGNet19来提取特征。硬件平台为四个NVIDIA Titan Black GPU,训练时网络设置Batch size为32,学习率为10-3,训练轮数为150次,训练过程在Caffe框架上实现。

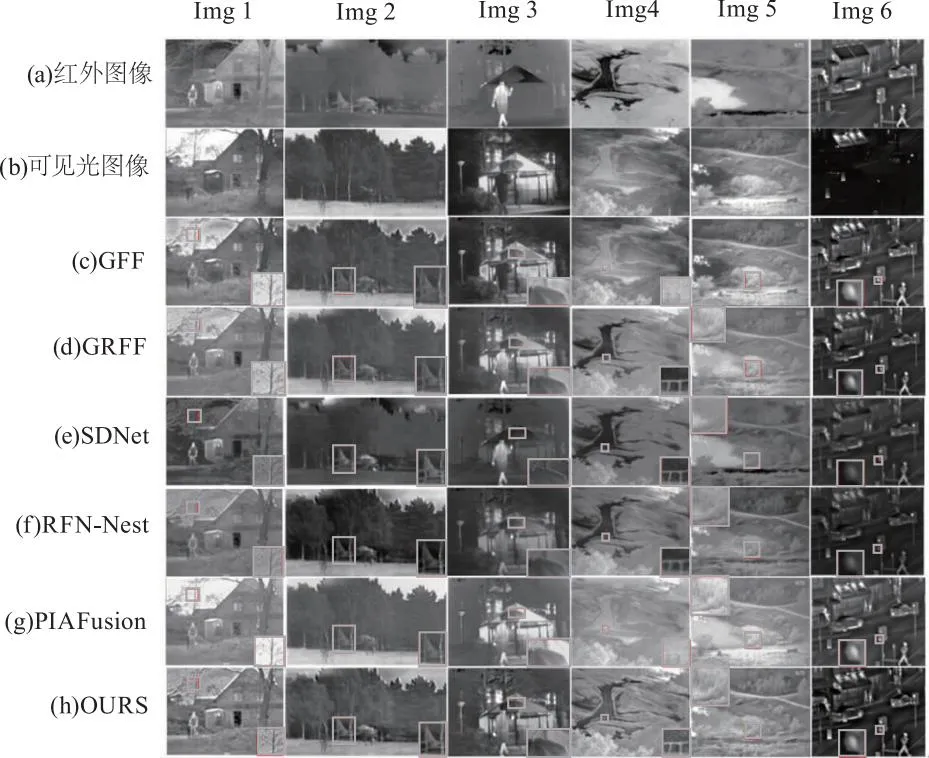

为验证本文算法的可行性与有效性,将本文方法的融合结果与引导滤波[20](GFF)、梯度滤波[23](GRFF)、压缩分解网络[16](SDNet)、基于融合网络体系结构[24](RFN-Nest)和渐进式图像融合网络[17](PIAFusion)五种方法进行了对比。

4.2 主观评价

通过6组实验的融合结果如图3所示,Img 1中GRFF右上角出现伪影,GFF与RFN-Nest中树木与背景分界轮廓不清,SDNet中树木与房屋轮廓不够清晰,PIAFusion包含一定纹理信息,但是不如OURS丰富,本文算法中树木细节清晰,红外人像突出;Img 2中GRFF红外目标不够清晰,GFF中树木上方出现白色伪影,SDNet中森林与天空分界轮廓不清,RFN-Nest与PIAFusion红外图像部分细节丢失,本文算法中红外目标轮廓与森林细节明显;Img 3中GRFF中人物部分没有体现红外细节,GFF中背景出现纹理缺失,SDNet中手持雨伞与背景无法区分,RFN-Nest人物虽显示出来,但是并不十分明显,PIAFusion中人物亮度过高,易于背景混淆,本文算法既突出了红外图像中的人物,又使得可见光图像中的雨伞与背景相区分;Img4中GRFF中道路护栏部分细节缺失,GFFusion中道路中间的细节无法区分,SDNet与RFN-Nest左下角纹理细节缺失,PIAFusion中道路与两旁轮廓不清,不易区分,本文算法对红外图像中的护栏部分细节提取完整,可见光图像中的草木纹理信息最为凸显;Img 5中GRFF中水域部分红外细节缺失,GFFusion图像水域中细节无法区分,SDNet图像大部分纹理信息缺失,RFN-Nest图像中心水草部分细节明显缺失,PIAFusion图像左侧明显缺失红外图像细节,本文算法将可见光图像中的水草纹理信息完整保留,同时与红外图像中的水域相区分;Img 6中GRFF图像右上角红外细节缺失,GFFusion图像人物边缘出现伪影,SDNet图像整体偏暗,细节区分不清,RFN-Nest图像红绿灯无法分辨,PIAFusion图像灯牌细节无法区分,本文算法既保留了可见光图像中的发光目标,如灯牌、路灯等,又突出了红外图像中的车辆、行人等发热目标。在所选取的六组图像中,本文方法能够有效保留显著热目标,细节边缘清晰,更加符合人类视觉感知,均优于其他五种对比方法。

图3 实验结果图

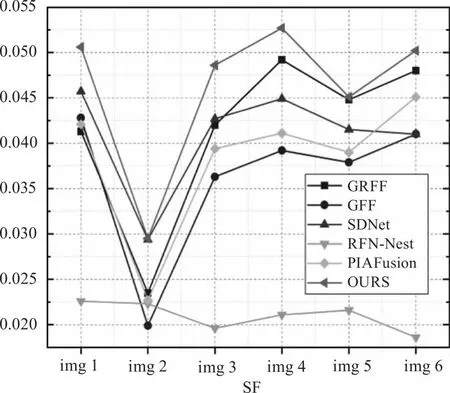

图4 指标对比折线图

4.3 客观评价指标

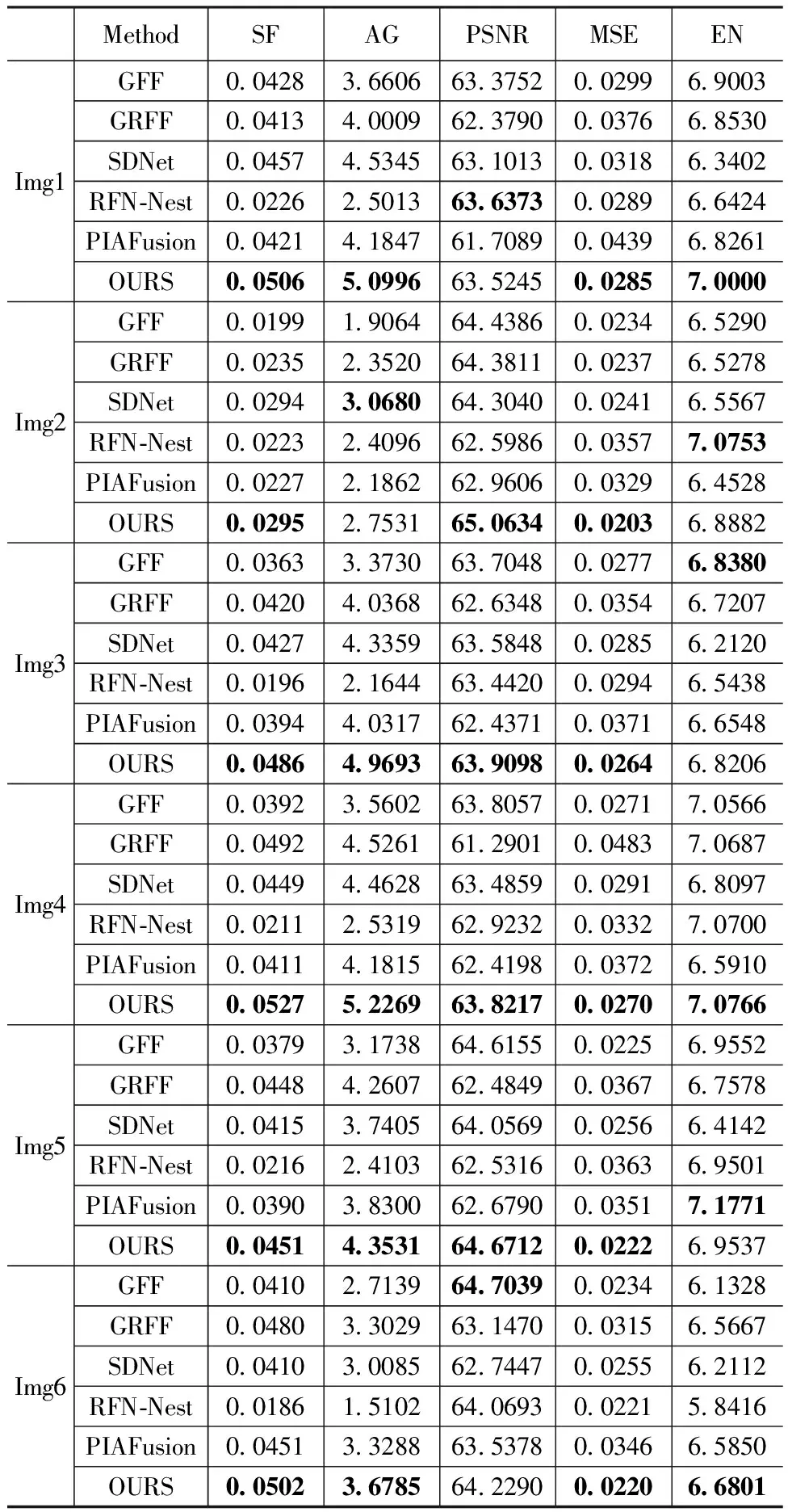

为验证算法性能及图像融合质量,本文采用反映灰度变化情况的SF(空间频率)、衡量图像清晰程度的AG(平均梯度)、体现图像失真和噪声的PSNR(峰值信噪比)、评估融合图像和源图像差异的MSE(均方误差)和表达图像所含信息的EN(信息熵)进行客观地分析[25]。其中只有MSE为数值越小,说明图像融合质量越好,其余五个指标均为数值越大,融合质量越好。

6组实验图像的客观评价指标值如表1所示。通过实验指标值可以看出本文方法的Img4在本文选定的五种指标中都处于最优,其余五幅图像绝大多数指标处于最优。表明本文方法所获得的融合图像包含的图像细节更丰富,融合质量更好与源图像差异程度小。综上,本文方法具有更优的融合效果。

表1 客观评价指标对比

5 结 语

本文提出了一种基于快速引导滤波器与VGGNet19的红外与可见光图像融合算法,不仅能够在进行图像平滑的过程中保留边缘信息,而且有效提取目标信息,使得融合图像同时具有丰富的纹理细节和较高的目标识别能力。利用FGF算法进行图像的双尺度变换,有效保留边缘细节;使用VGGNet19提取得分图,再使用OTSU算法进行前景与背景分割,进一步提取红外目标;再次利用FGF算法得到融合权重图;最后将初步融合图像经过FGF进行图像平滑和图像增强得到最终的融合图像。与其他方法相比,本文方法得到的融合图像具有更丰富的纹理细节与突出的红外目标,更加符合人类视觉感知,是一种有效的融合方法。为了更好地提取源图像特征信息,今后将进一步改进网络的具体架构、融合规则、尝试使用其他深度学习网络,来提高融合效果。