联合引导滤波和抠图技术的多聚焦图像融合*

田洋川,徐慧娴,陈明举,李天宇,吕 旋,石浩德

(1.四川轻化工大学人工智能四川省重点实验室,四川 宜宾 644000;2.四川轻化工大学自动化与信息工程学院,四川 宜宾 644000;3.四川轻化工大学企业信息化与物联网测控技术四川省高校重点实验室,四川 宜宾 644000)

0 引 言

由于光学透镜的景深有限,在景深范围内的目标清晰,而范围以外的目标则容易变得模糊,因此很难获取所有景物都是全聚焦的图像。多聚焦图像融合技术作为图像融合的子领域,它的目标就是将同一场景具有不同聚焦区域的多幅源图像整合成一个所有聚焦清晰的融合图像。目前,随着计算机视觉任务的发展,多聚焦图像融合已在数码摄影、目标跟踪和显微成像等领域得到了广泛的应用。

目前,卷积神经网络(CNN)[1]因其拥有强大的特征提取能力,被广泛应用于图像融合任务中。Liu Y等人[2]首次提出了使用神经网络代替传统聚焦检测方法的CNN融合算法。尽管Liu Y等人利用CNN获取决策图,提高了融合结果的质量,但由于其需要切片处理,计算效率较差。因此,在CNN的基础上,有监督通用图像融合网络--IFCNN[3]和无监督通用图像融合网络--U2F[4]提出了既不需要切片,也不需要决策图的通用融合框架,可以高效地获得融合结果。以上方法面对复杂的图像,容易导致部分融合结果存在伪影或者模糊的边缘。

本文提出了一种基于引导滤波和图像抠图技术的多聚焦图像融合算法。利用具有引导滤波的聚焦检测模块[5]可以获得准确决策图,面对部分识别错误的决策图,不再统一进行后处理,而是使用具有差异性的抠图技术进行修正,获得更精确的决策图。

1 本文方法

本文提出方法的整体流程:源图像首先在聚焦检测模块的作用下获得初始决策图;然后,利用形态学操作[6]将初始决策图处理成三值图,并将三值图和源图像一起送入到决策图优化模块中生成最终决策图;最后,结合优化后的决策图和源图像得到清晰的融合结果。

1.1 聚集区域检测

本文提出的基于引导滤波的聚焦检测算法能有效地获得源图像的梯度信息并生成初始的决策图,该算法的流程如图1所示。

图1 聚集区域检测结构

首先,根据图像重复模糊原则,使用中值滤波算法对图像进行模糊处理得到模糊后的图像B1和B2,如下

然后,计算模糊后的图像和源图像的差值的绝对值,即可得到梯度信息G1,G2,具体表达如式(3)和式(4)所示

本文以源图像为引导图像,利用引导滤波将源对G1,G2进行滤波,将源图像中的高频信息转移到G1,G2中得到F1,F2,具体表达如下

通过比价F1和F2原则获得初始的决策图,如下

1.2 决策图优化

本文采用抠图算法对决策图进行细化,它对不同的情况的决策图进行差异化的处理,可以更准确地优化决策图,有效地提升融合结果的性能。抠图的数学模型为

式中F(x,y)和B(x,y)分别为图像的前景和背景区域。α(x,y)为前景不透明度,取值取值范围是[0~1]。图像抠图的目的是准确区分前景和背景,即获得准确的α(x,y)值。而多聚焦图像融合的定义是将多幅图像在同一场景下的清晰的区域结合一张清晰的图像。其数学模型为

式中S1(x,y)和S2(x,y)为两幅源图像,D(x,y)为决策图,它属于一幅二值图。在抠图算法中,为了方便求解a(x,y)值,除了源图像外,还需要供一个三分图(trimap)。三分图由前景区域,背景区域和不确定区域组成,它作为抠图算法的一个关键的输入,往往需要手工标记完成。但是在多聚焦融合中,三值图由聚焦区域,非聚焦区域和不确定区域构成,它不在需要手工标记,只需要在初始决策图的基础上进行形态学的膨胀和腐蚀操作就能得到,生成结果如图2所示。

图2 生成的三分图

在获取三分图后,首先,在对初始图采样期间通过给定的三分图对每一幅图的前后背景进行采样估计;然后,通过对采样估计系数的判断,并且通过判断得出α 值;最后,通过最小化能量函数[7]对其进行优化,得到最终的结果图。相应公式如下

根据式(10)可得到清晰的融合结果,如图3所示。

图3 融合结果

2 实验结果与分析

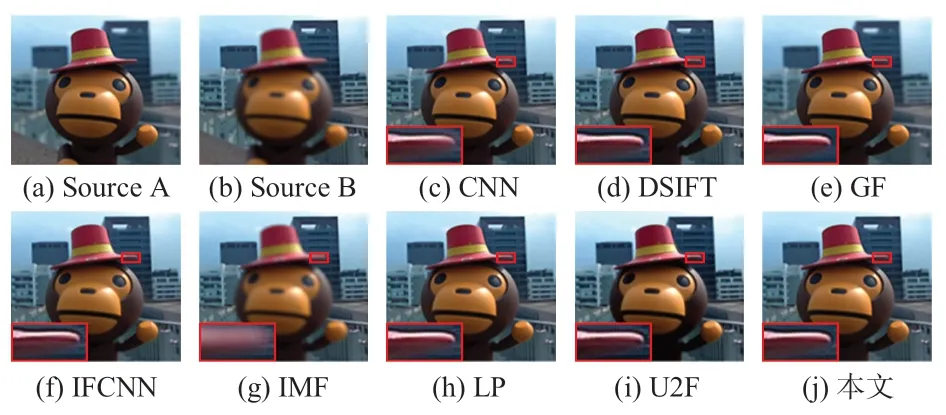

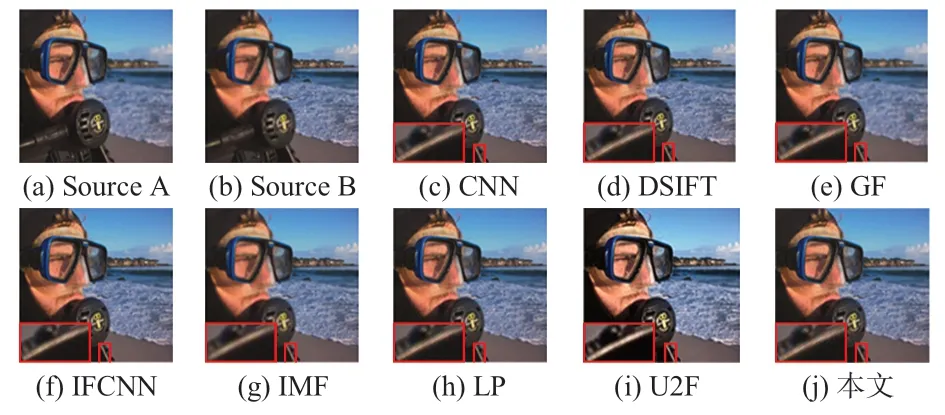

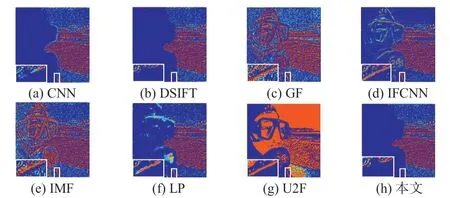

实验中选择使用彩色多聚焦数据集Lytro[8]作为测试集,进行了广泛的实验,并将其与最近提出的8 种不同的融合算法进行了主观和客观对比。它们分别是CNN、稠密SIFT(dense SIFT,DSIFT)[9]、引导滤波融合(GF)[10]、IFCNN、图像抠图融合(image matting fusion,IMF)[11],拉普拉斯金字塔(LP)[12],U2F。这些方法都是基于作者提供的代码,在1.6 Hz的Intel®CoreTMCPU 和8GB 内存计算机上进行的。多聚焦图像融结果应该尽可能包含源图像中的所有清晰特征,并有清晰的轮廓,为此从测试集中选择了2 组具有复杂边界的源图像和对应的各种融合结果进行了可视化展示,对比不同算法主观视觉上的差异性,为了进一步展示在轮廓上的差异,也展示了各种融合算法对应的差值伪彩图。

图4为各融合方法在彩色图像集“猴子”上的融合结果,直观地比较了本文方法与其他方法的性能。从整体上观察,各方法融合效果较佳,除图4(h)的图像整体模糊且亮度不正常的提高。选取局部进行放大观察,图4(g)的帽子直接呈现模糊,没有有效地获取源图像图4(a)中的清晰特征。图4(c)、图4(d)、图4(f)和图4(i)尽管帽子部分是清晰的,但是在帽子周围出现了伪影,这也是没有很好地整合图4(b)中的清晰特征。只有图4(j)在帽子部分呈现清晰,帽子周围也没有出现伪影,较好整合了源图像中的清晰锐利特征,视觉呈现效果更好。

图4 各种方法得到的“猴子”源图像和相应的融合结果

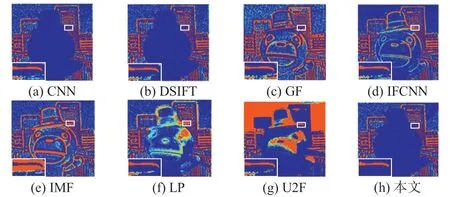

图5可视化了图4中每个融合图像减去第一张图像而获得的差值图像,并将差图转化成伪彩图来进行更好的对比观察。在伪彩图中,被减去的部分越干净,即呈现干净的蓝色的状态,留下的部分有清晰的边界轮廓则说明融合效果更好。反之,如果伪彩图中被减去的部分出现噪声像素,留下的部分边界轮廓不准确且不明显,则说明融合效果越差。从整体上看,图5(c)~(g)被减去的部分留有大量的噪声像素,并且轮廓不清晰,说明在融合过程中,这些算法除了获取源图像的信息外,还引入了其他的噪声像素。图5(a)、图5(b)和图5(f)被减去部分是完整的蓝色状态,留下部分有清晰的轮廓,但是从局部放大观察,其中图5(a)和图5(b)仍有噪声像素,只有图5(f)保持准确去清晰的轮廓,说明图5(h)较好地获取了源图像的清晰特征。综合图4和图5融合结果表明,本文提出的算法在“猴子”这组彩色图像集上提供了最好的融合结果。

图5 可视化图4 中每个融合图像的伪彩色图像

图6为各融合方法在彩色图像集“潜水员”上的融合结果,从整体亮度观察,各方法融合效果亮度均正常,只有图6(i)的图像亮度明显有不正常的提高。选取局部进行放大观察,图6(c)~(f)和图6(e)轮廓较为流畅,但是边界区域有不良伪影,图6(g)出现虚化现象。图6(j)整体清晰度较好,局部信息和边缘轮廓的效果均表现很优异无不良伪影,亮度和源图像保持一致。相应地,图7 可视化了图6 中每个融合结果的伪彩图。

图6 各种方法得到的“潜水员”源图像和相应的融合结果

图7 可视化图6 中每个融合图像的伪彩色图像

从图7中可以看出,图7(c)~(g)被减去部分存在源图像A相关的大量像素,只有图7(a)、图7(b)和图7(h)被减去部分是干净状态,留下部分呈现出来源图像B 的完整轮流,但是局部放大仍可以看到图7(a)和图7(b)轮廓边界不流畅,周围有噪声像素,只有图7(h)轮廓流畅,周围没有噪声像素。综合图6 和图7 表明,本文提出的算法在“潜水员”这组彩色图像集上提供了最好的融合结果。

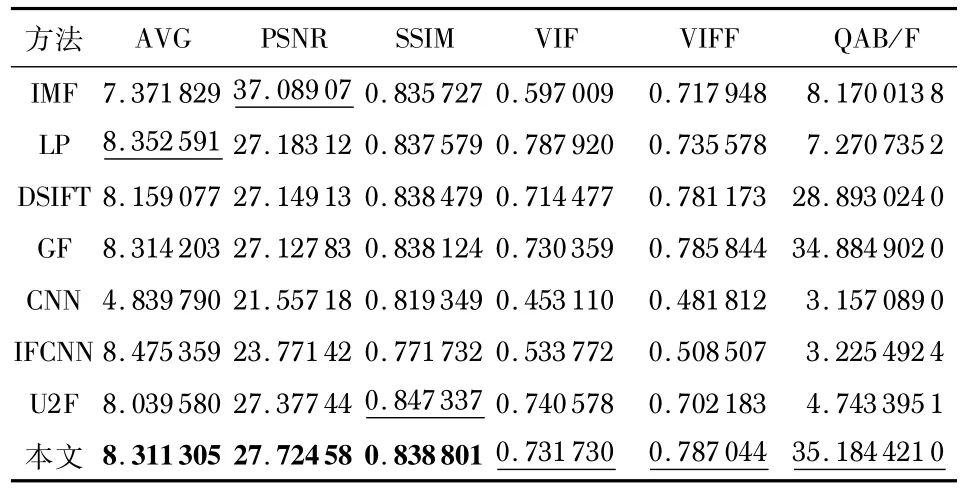

本文将用7种不同的指标来客观评价不同方法融合结果的性能。分别为平均梯度(AVG)、峰值信噪比(peak signal to noise ratio,PSNR)、结构相似性(structural similarity,SSIM)、视觉信息保真度(visual information fidelity,VIF)、衡量融合图像质量的指标(VIFF)、基于梯度的融合性指标(QAB/F)。

不同算法在Lytro 测试集上20 组图像的客观指标平均值如表1 所示,每一项指标中带下划线的数值表示最好的指标,加黑数值表示第二好的指标。从表1 中可以看出,本文算法的VIF,VIFF和QAB/F值均优于其余7 种融合方法,仅在少数指标上排第二。将主观评价与客观评价相结合,发现本文算法的融合效果优于其余7 种融合方法,本文算法能够从源图像中提取更多轮廓、细节及纹理等信息。

表1 融合图像的7 个质量指标的平均值

3 结束语

实验结果表明:和最近的融合算法相比较,本文算法获得的融合结果拥有更优越的性能,在聚焦和失焦边界细节信息更多。之后,会在本文方法基础上探索更有效的聚焦检测方法,以获得更好的融合框架,实现更好的融合性能。