基于人机协作的高质量城市图像采集方法

陈荟慧,钟委钊

1.佛山科学技术学院电子信息工程学院,广东佛山528225

2.佛山科学技术学院机电工程与自动化学院,广东佛山528225

人机协作研究的是人与机器同时工作时如何利用人类强大的认知决策能力和机器强大的计算、通信和存储能力来解决问题,其目标是由人和机器共同高效、高质量地完成一项任务。目前,人机协作技术已在手术机器人[1-2]、灾难搜救机器人[3]、装配机器人[4]、采摘机器人[5]、巡逻机器人[6]等场景中得到应用。

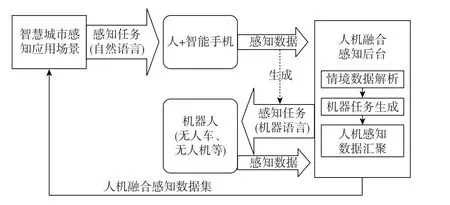

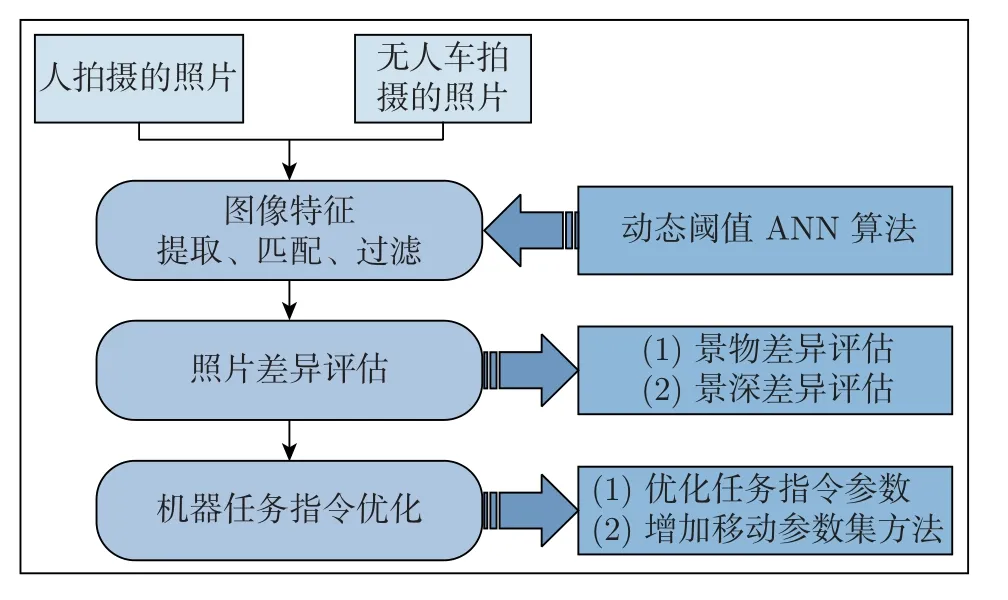

人机协作智慧城市感知框架包括人、智能手机、机器人(如无人车、无人机)和云端服务器4 部分,如图1 所示。基于人机协作的图像采集是智慧城市感知的一个场景。在此场景下,人接收到以自然语言表达的感知任务后,使用智能手机等设备采集数据并提交。人机融合感知后台根据人提交的感知数据解析出任务的关键参数后,生成以机器语言表达的感知任务并分发给具备工作能力的机器人。当机器人提交了感知数据以后,后台将人和机器采集的数据推送给应用场景做进一步处理。在这个工作流程里,由人引导机器人完成感知任务的核心功能是后台服务器根据人提交的感知数据解析出机器任务的关键参数,这也是本文研究的重点。

图1 人机协作框架图Figure 1 Human-machine collaboration framework

人机协作强调的是充分发挥人和机器各自的优点,两者相互协作完成任务。本文研究的人拥有强大的认知能力,负责找到感知对象,机拥有充足的时间和通信能力,负责按任务要求完成长期的感知任务。

人根据感知任务要求到达规定的感知地点,找到被感知对象,使用智能手机采集被感知对象的图像,将手机记录下的时空情境提交给人机融合感知云端服务器,并向移动机器人发送当前智能手机的情境数据。移动机器人接收到数据信息后,分析数据以调整云台的姿态,随后进行图像采集。

人机协作感知是人机协作技术的一种应用场景,它将群智感知和机器人感知结合在一起,是一种新的感知模式。群智感知将人群携带的移动设备作为基本感知单元,通过移动互联网进行有意识或无意识协作,实现感知任务分发与感知数据收集,完成大规模的、复杂的社会感知任务,例如交通路况感知[7]、街景变化检测[8]和噪声检测[9]。机器人感知指机器人根据设定好的程序自动完成感知任务,例如智能巡检机器人,它能满足农业、工业、商业、安全等不同应用场景下的巡检需求,也能完成地图构建[10-12]任务。

群智感知和机器人感知已经可以应用在许多场景,但也有一定的局限性。例如,群智感知需要通过激励措施招募大量参与者,若参与者不足则会降低群智感知应用的效果;机器人感知需要为机器人预设感知指令,这些指令需要凭借人类经验或者借助人工智能技术生成。人机协作可以融合群智感知中人的能力和机器人感知中机器的能力。本文利用基于人机协作采集城市场景图像数据,研究人机协作中存在的问题,提高人机协作的可用性。

智慧城市很多应用都需要采集城市图像[13],如海报[14]、道路裂纹[15]、突发事件[16]等。除了采用专业的图像采集车和采集设备,群智感知也是常用的图像采集途径[13,17-18],而且图像采集车和群智感知都由人准确找到目标并拍照。

目前机器人的认知能力有限,需要根据任务指令完成图像采集任务。机器人任务指令可以采用3 种方式生成:1)通过大量语义数据训练机器人,当机器人检测到相同语义的行为或者场景时拍照[19-21];2)人遥控指挥机器人进行拍照,例如机器人可以代替人进入有害环境中采集图像数据[22];3)人设置机器人拍照参数,包括地点和方位等,例如人为提供施工道路/建筑物的方位信息,派遣移动机器人持续跟踪施工进度并拍照。其中第2、3 种方式属于人机协作范畴,不同的是,前者将机器人当作人的代步工具,执行任务时,全程需要人工参与;而后者通过人提供的信息引导机器人拍照,这种方式既减少了因参与者不足而带来的不良影响,又间接地提高了机器人的感知能力。本文主要讨论第3 种机器人拍照指令的生成方式。

在人机协作方式下,机器人的行动指令来源于机器对人执行拍照任务行为的理解,该过程实际是一个用多传感器数据描述人的行为并转化为机器人拍照指令的过程。由于人的行为姿态的多样性和传感器存在一定的误差,因此机器人对人的拍照行为的理解会有一定的偏差。为了使机器人能准确理解人的拍照行为并自动生成高质量拍照指令,本文完成了以下工作:1)提出基于人机协作的图像采集框架,实现通过人与机器人的协作完成大规模图像采集任务;2)提出图像采集指令的优化方法,提高图像采集的质量;3)通过多组实验结果验证了人机协作图像采集模型的可用性和采集指令优化方法的有效性。

1 形式化定义

1.1 任务与数据

在人机协作场景下,由人承担的任务与群智感知任务类似,记作Th: (xh,yh,rh,th),其中,Lh: (xh,yh) 为任务地点的坐标点,rh为被感知对象所在区域的半径,th为任务的有效期。本文研究不涉及感知对象受时间的影响,因此任务简化为Th: (xh,yh,rh)。任务地点Lh和rh实际组成了一个圆形区域,表示被感知对象可能存在的区域,人可以根据任务提示寻找被感知对象[17]。

人找到被感知对象后拍照上传即完成了一次任务。拍照的情境在手机里自动获取并记录,记作Ch:(xc,yc,ec,hc,vc)。其中,Lc:(xc,yc) 表示被手机定位记录下的拍照地点,该定位可直接使用经度和维度表示,本文将GPS 坐标转换为平面坐标;ec为定位误差;(hc,vc) 为拍照时的镜头朝向,vc为镜头朝向与水平面的夹角;hc为镜头朝向在地面的投影与正北的夹角。

机器人的任务记作Tr: (xr,yr,hr,vr,fr),其中Lr: (xr,yr) 为任务地点的坐标;(hr,vr)为机器人拍照时镜头的朝向,通常(hr,vr)=(hc,vc);fr是定位围栏半径,由人工根据实际的物理环境而设,当机器人与任务地点Lr之间的距离小于等于fr米时,机器人按照情境参数(hr,vr) 调整拍照云台进行拍照。在受路网限制的区域内,若fr过小,则移动机器人可能受定位误差的影响而无法准确到达任务地点,从而导致任务失败。时间和fr对感知效果的影响与本文内容无关,在本文中不再探讨。

机器人的感知任务是对人的拍照情境数据的一种映射,情境参数(hr,vr) 被用于调整二自由度摄像云台,hr用于云台的水平旋转,vr用于云台的俯仰角度调整。机器人到达区域QR后,调整云台并拍照,记机器人拍照的情境为Cr:(xd,yd,hr,vr,ed),Lr与Ld:(xd,yd) 之间的距离不大于fr。区域QF 为参数(xd,yd,ed) 形成的区域。

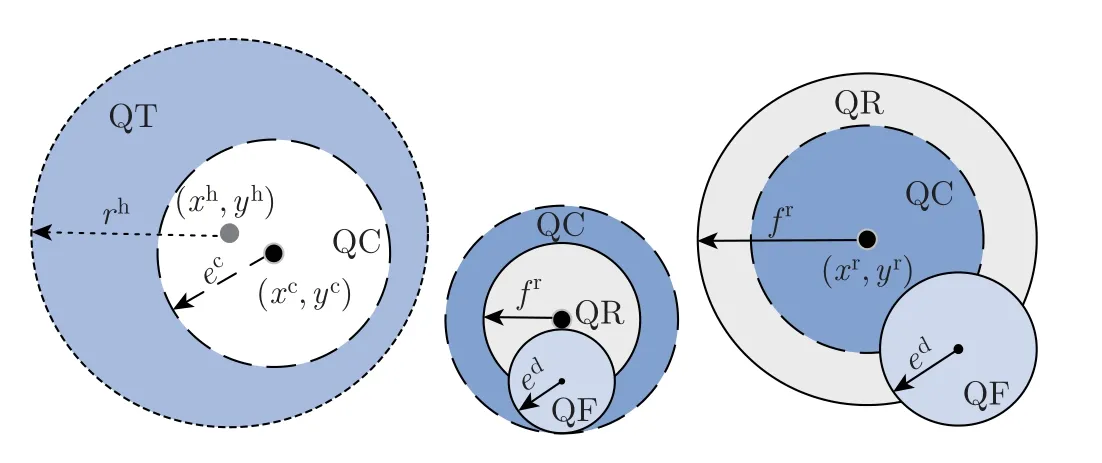

由于ec≥0,ed≥0,因此,机器人并不能保证每次准确复现人完成任务的数据质量,如图2 所示。

图2 数据采集任务的空间覆盖示意图Figure 2 Illustration on data acquisition task and spatial coverage

1.2 存在的问题

从感知任务发布阶段到机器人执行任务阶段,任务所在的物理空间并不能完全重叠。如图2 所示,QT 表示感知任务覆盖的区域,QC 为人拍照时的空间情境,QR 为机器人任务覆盖的区域。因为手机GPS 定位(或北斗定位)存在米级误差,所以,人实际的拍照地点在QC区域内。

假设引导者和机器人使用相同的定位技术(如GPS 或北斗),机器人的移动路径依赖于引导者的位置信息,于是引导者和机器人之间的期望距离范围是[0,fr+ec],人与机器人之间的实际距离范围为[0,fr+ec+ed],即

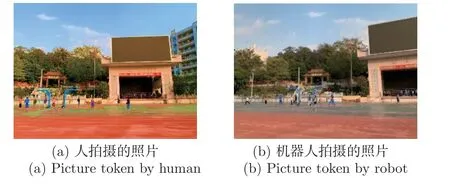

在理想情况下,若定位误差和拍照角度误差为零,则机器人到达引导者的位置由情境数据驱动机器人就可以进行有效感知。但由于人机协作过程中可能存在定位误差和拍照角度传感器误差,因此机器人采集的图像与引导者的真实图像也有一定的偏差。如图3 所示,图3(a)为引导者拍摄的图像,图3(b) 为机器人采集的图像,可以看出两幅图像存在差异,照片的重叠区域约占引导者拍摄图像的65%。若差异过大,机器人采集的图像可能无法呈现有效信息。

图3 人与机器人采集的图像Figure 3 Photos collected by human-machine collaboration

2 机器感知任务指令的优化算法

2.1 算法流程

为了提高机器人的感知能力,本文通过评估人和机器拍摄的图像差异,优化机器感知任务指令。任务优化流程如图4 所示。首先使用已标注的人机协作数据集对比人机采集数据的差异,并训练出能够提高机器人感知精度的参数值;然后修正机器人的任务指令。为了比对人机采集图像的差异,本文提出使用动态阈值近似最近邻(approximate nearest neighbor with dynamic threshold,DTANN)算法,匹配人机采集图像的SIFT(scale-invariant feature transform)特征点[23],再经过随机采样一致性(random sample consensus,RANSAC)算法[24]过滤错误匹配的特征点对。基于特征点的位置差异计算出景物差异和景深差异,这两种差异用于修正机器人的拍照任务指令。

图4 机器感知任务优化流程图Figure 4 Flow chart of machine perception task optimization

2.2 关键任务参数

二自由度云台由水平方向旋转舵机和垂直方向旋转舵机组成。云台即时姿态为(hs,vs);hs为水平方向舵机顺时针旋转时的角度值,取值区间为[0°,360°);vs为垂直方向舵机的角度值,取值区间为[0°,180°),当镜头垂直朝下时,vs=0°;机器人所处位置的坡度值为vg,vg的取值区间为[-90°,90°],机器人处于水平地面时,vg=0°,当机器人上坡时,vg值减小。云台调整姿态过程中,舵机水平顺时针和垂直向上的转动角度值分别为hm和vm,机器人的图像采集任务指令表示为I: (xr,yr,hm,vm),即移动机器人到达任务位置坐标(xr,yr)后获取云台的即时姿态,然后控制水平顺时针旋转hm和垂直向上旋转vm后拍照。其中,hm=hc-hs,vm=vc-vs+vg。

智能手机的方位角、翻转角参数(hc,vc) 与云台姿态参数(hs,vs) 在功能上相对应。原始vc的取值区间只有[0°,90°],需要借助加速度Z轴的值(记为a)来区分智能手机的俯仰状态,并扩展取值区间为[0°,180°]。当a <0 时,手机处于仰拍状态;当a >0 时,手机处于俯拍状态。通过式(4) 将vc的取值区间扩展至与vs的一致,为0°~180°。

2.3 图像差异评估

本文的人机协作感知差异指人和机器人采集照片中的景物差异和景深差异,可通过对比两幅图像的相似特征点的位置差异进行评估。

2.3.1 DTANN 算法

在人机协作感知过程中,人和机器人采集的图像之间的差异是不确定的,很难初始化一个固定阈值用于相似特征点的匹配,所以,本文提出DTANN 算法。DTANN 根据预设的期望匹配点对的最小数量(记为ω)对初始阈值进行迭代优化,直到匹配得到的相似特征点对的数量不小于ω或者已无法优化,此时得到一个阈值,且阈值是动态的。设目标点与最近邻特征点的距离为dn,目标点与次近邻特征点之间的距离为的比值上限记为τ,动态阈值设为σ,σ的初始值可设为0.3,此时σ的迭代计算为

当σ或者|FA| 无法再增大时,停止迭代。每次迭代时先使用ANN 算法计算出匹配特征点集合FA和FB,如果|M|<ω并且σ <τ,则更新σ后重新计算M,直到σ不满足更新条件。此时,M即为所求匹配特征点对集合。

2.3.2 景物差异评估

在人和机器人拍摄的照片中,从不同景物上提取的特征点能表示出该景物所在的位置,由于景物在图像中的分布是相对固定的,评估景物差异可知两幅图像在二维平面水平和竖直方向上的差异,本文采用相似性匹配后的特征点对的位置差异进行景物差异评估。

特征点对的平面位置差异可分为水平方向的差异Δx和竖直方向的差异Δy,分别表示特征点之间平面位置坐标差异的平均值,计算公式为

式中:M′为M经RANSAC 算法过滤后的特征点对集合。

2.3.3 景深差异评估

景深差异是由于人、机器人与景物之间的距离有差异造成的,两幅图像的匹配特征点覆盖区域比例能够反映出两幅图像的景深差异。因此,本文基于图像的匹配特征点对的空间分布对图像的景深差异进行评估。

式中:ε为一个无穷小的数,1 ≤k≤|M′|-1。

根据匹配特征点对的景深相似度,采用式(8) 将特征点对分为大、中、小3 类,分别对应3 个集合JL、JM和JS。

记两幅图像的景深差异量为μ。如果JL、JM或JS任一集合元素数量大于或等于则μ等于该集合元素的平均值;如果3 个集合元素数量均小于,则μ=1。

2.4 机器感知任务指令优化

机器人的图像采集任务指令表示为I: (xr,yr,hm,vm),根据图像差异,需要对任务指令进行优化。

2.4.1 云台参数修正

假设摄像头拍摄的分辨率为X×Y,当机器人拍照云台的水平舵机旋转1°时图像在水平方向上改变p个像素;当垂直舵机旋转1°时图像在垂直方向上改变q个像素值,那么舵机的任务参数的修正公式为

2.4.2 拍照位置参数优化

机器人到达位置(xr,yr) 后,调整云台使其指向优化后的拍照方向,然后机器人调整方向,使行驶方式与拍照方向一致。根据景物差异和景深差异对机器人的拍照位置进行优化。设机器人需横向向右平移xo,然后前进yo。当xo和yo为负时,表示向左平移和向后移动。

假设当机器人水平向右平移1 m 时拍摄的图像在水平方向上改变了p′个像素;当机器人前进1 m 时,图像无变化区域的像素为m×n,那么机器人位置修正的移动参数公式为

这里限定|xo|≤2ed和|yo|≤2ed。

3 算法评估

3.1 实验配置

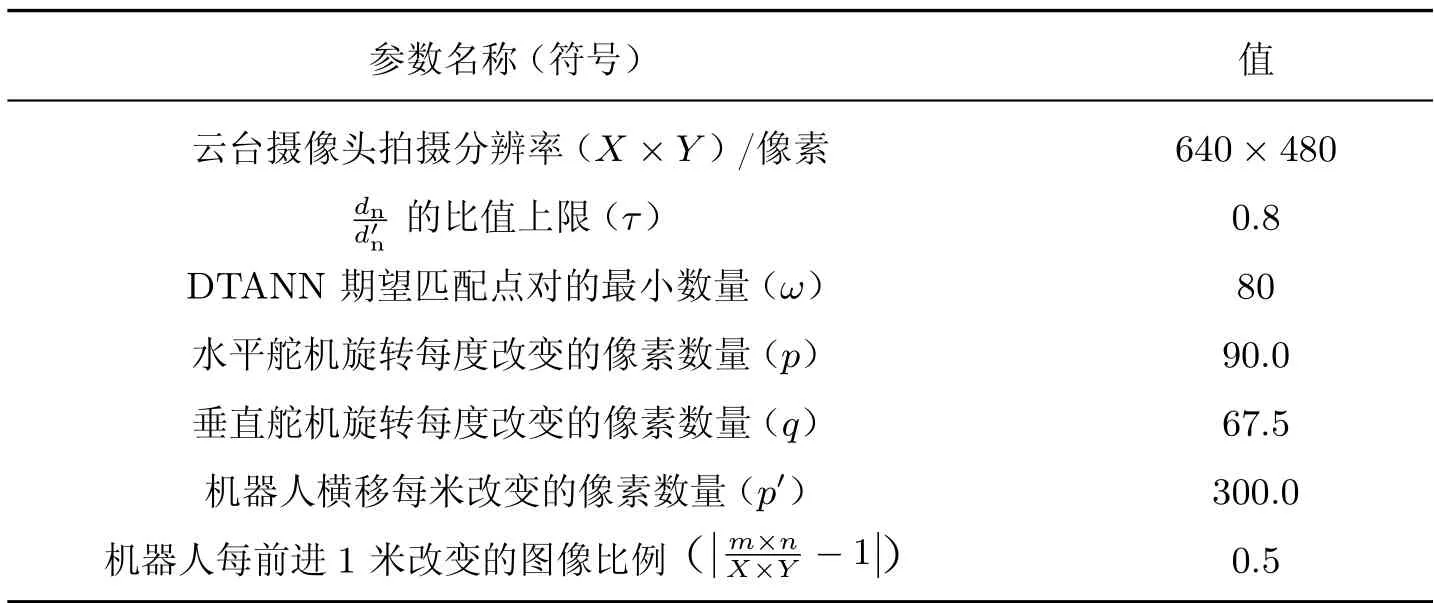

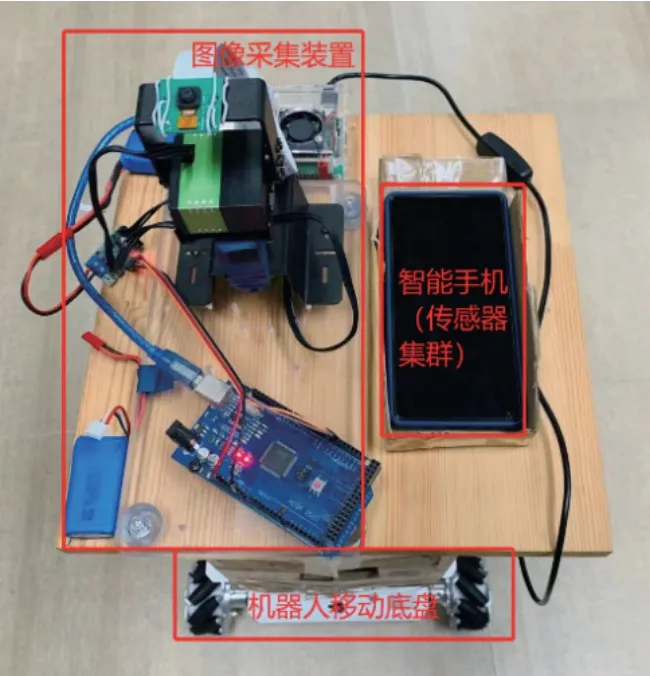

实验采用GPS 定位,在天气晴朗且空旷的环境下,定位误差不超过1 m。机器人感知平台如图5 所示,云台的旋转精度为0.1°,摄像头高度为1.5 m,各项实验参数如表1 所示,实验共采集了446 组人机协作拍照数据。

表1 实验参数表Table 1 Parameters for experiments

图5 机器人感知平台Figure 5 Robot sensing platform

3.2 机器感知能力评估指标

对机器感知能力的评价主要基于机器采集的图像B与人工采集的图像A的景物重叠度。将图像A与B变换为相同大小的图像,记oa表示机器采集的图像和人工采集的图像的公共部分的像素数量,noa表示图像A未被图像B覆盖的像素数量,ob表示图像B被图像A覆盖的像素数量,nob表示图像B未被图像A覆盖的像素数量。由于图像A和图像B存在景物和景深差异,相同景物在图像A和B中的大小不一定相同,所以,oa不一定等于ob。

参考分类算法的评价指标,本文定义的机器感知算法评价指标有召回率R、精准率P和F1-measure 值,公式分别为

3.3 期望效果

人机协同的感知图像采集的误差与定位误差有关,因此,本文将在没有定位误差情况下的人机协作效果作为期望效果,对文中的方法进行评估。假设引导者与移动机器人之间不存在定位误差,即当ec和ed均为0 时采集数据并评估实验结果。本文采集18 组人机协作图像数据,实验结果显示精确率、召回率和F1-measure 值的95% 置信区间分别为(91.22%,95.38%)、(80.24%,84.99%)、(82.90%,88.15%)。

3.4 任务参数选择

人机协作的任务参数对机器人感知质量具有一定的影响,比如引导者到感知对象的距离、定位误差、拍照姿态和地面坡度等参数。为了选出合适的参数值进行感知任务优化,这里通过实验评估任务参数对感知性能的影响,然后选择参数。

3.4.1 人与物之间的距离对机器感知能力的影响

在现实的城市情景感知下,定位误差是必然存在的。本文采用高德地图的组合定位,实验场景在晴天户外,定位误差半径可达1 m 以内,本文定位误差半径e值在0.25 m~1 m 范围内。

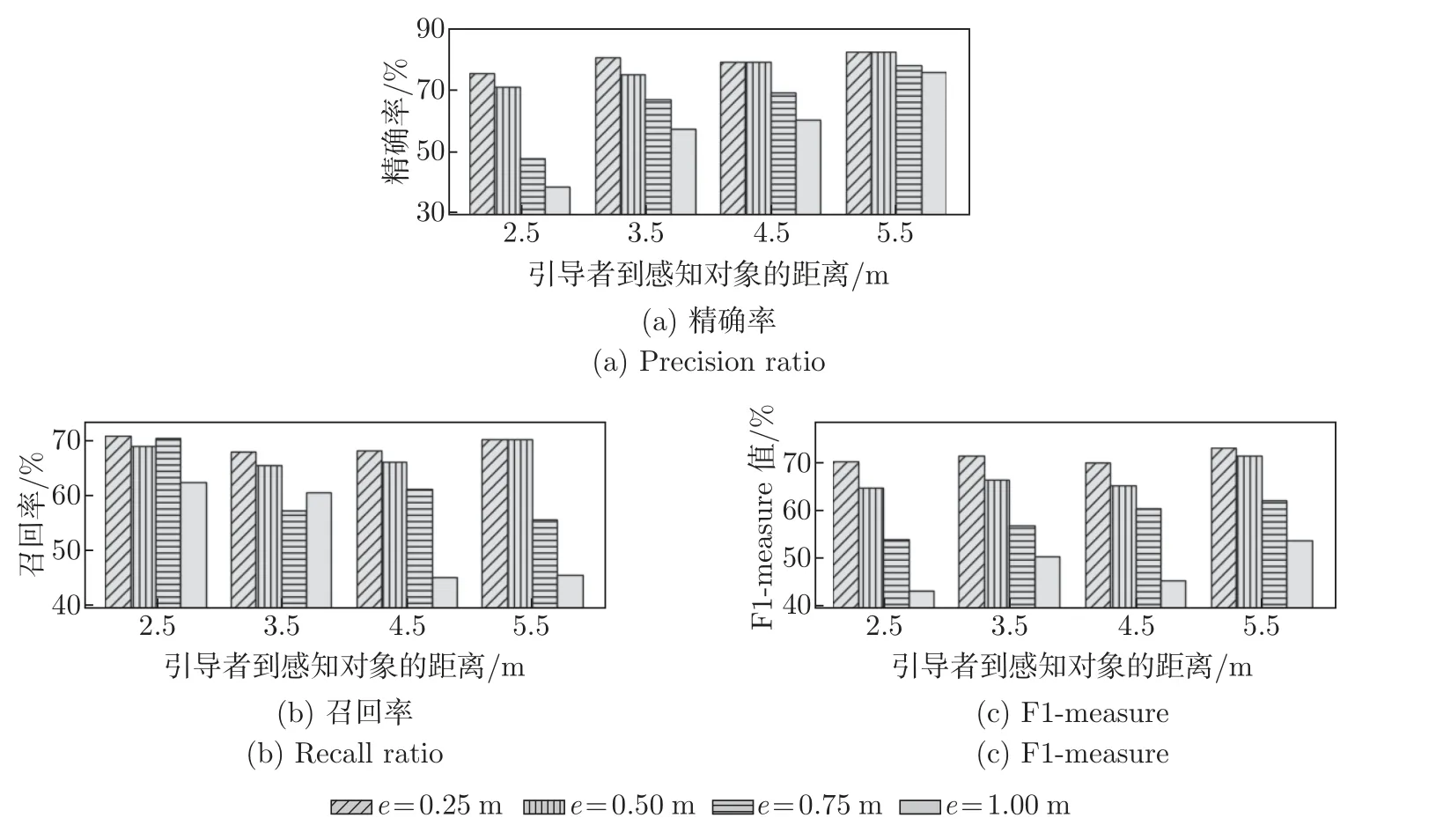

引导者与感知对象之间的距离会影响机器人的感知范围和能力。实验将引导者与感知对象之间距离以米为单位划分为4 种情况,分别是2.5 m、3.5 m、4.5 m 和5.5 m。每一种情况采集18 组图像数据,实验数据共4×4×18=288 组。对比平均召回率、平均精确率和F1-measure平均值如图6 所示。

图6 人与物距离的改变对机器感知能力的影响Figure 6 Impact of diffierent guider-object distance on machine sensing

图6 的实验结果显示,当定位误差增大时,整体的精确率、召回率、F1-measure 值均下降。当引导者到感知对象的距离大于或等于3.5 m 时,感知对象基本不会完全消失在移动机器人的视野中,平均精确率、召回率、F1-measure 值均大于或等于45%,达到基本感知要求。接下来的实验会以引导者到感知对象的距离大于或等于3.5 m 为标准进行。

3.4.2 人的拍照习惯对机器感知能力的影响

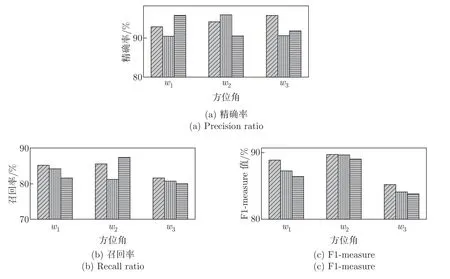

引导者持手机拍照时的习惯不同,那么手机拍照时的姿态可能不同,这将影响机器拍照参数。在没有定位误差的前提下,实验按水平和竖直两个维度对拍照姿态进行分类。水平维度指同一位置下选择3 个方向朝感知对象拍摄,记为w1、w2和w3;竖直维度分类包括仰拍、平拍和俯拍,共分为9 种组合情况。每种情况采集4 组人机协作图像数据,实验结果如图7所示。

图7 引导者拍照姿态不同时的实验结果Figure 7 Results of diffierent guider postures for taking photo

从图7 的实验结果可以看出,引导者的拍照姿态对机器感知能力的影响并不是很大。这一结论可以说明人机协同感知对引导者拍照姿态的限制不需要太苛刻。

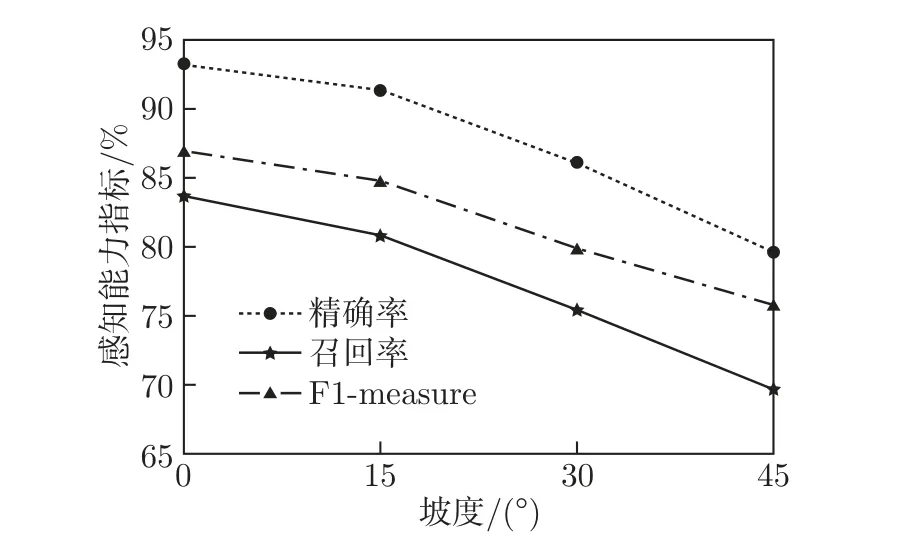

3.4.3 地形起伏对机器感知能力的影响

地形起伏主要体现为地面坡度的变化。坡度地形使得机器云台难以保持水平状态,那么机器感知能力会受到影响。在没有定位误差的前提下,实验中设定4 种不同的坡度,分别是0°、5°、30°、45°。在每种情况下采集10 组人机协作图像数据,实验结果如图8 所示。

图8 地面坡度不同时的实验结果Figure 8 Results of diffierent land’s slope for taking photo

从图8 的实验结果可知,当坡度增大时,机器感知效果整体下降。在小坡度时,机器感知能力受影响较小,足以胜任日常城市图像采集工作。而坡度较大时机器感知能力受影响更大,是因为云台的过度倾斜导致拍摄了大量的无关内容。针对这个问题,可在云台上增加一个镜头旋转舵机,根据机器人的倾斜状态使镜头保持水平,舵机旋转计算方法与垂直方向舵机旋转计算方法类似,在此不再赘述。

3.5 任务参数优化效果评估

机器感知任务参数优化包括云台参数优化和拍照位置参数优化。每种优化实验按定位误差的大小,将实验数据分为4 种情况,每种情况下采集8 组照片,分别是引导者采集的照片、未优化机器指令前的机器采集照片和优化机器指令后的机器采集照片,共计64 组实验数据。

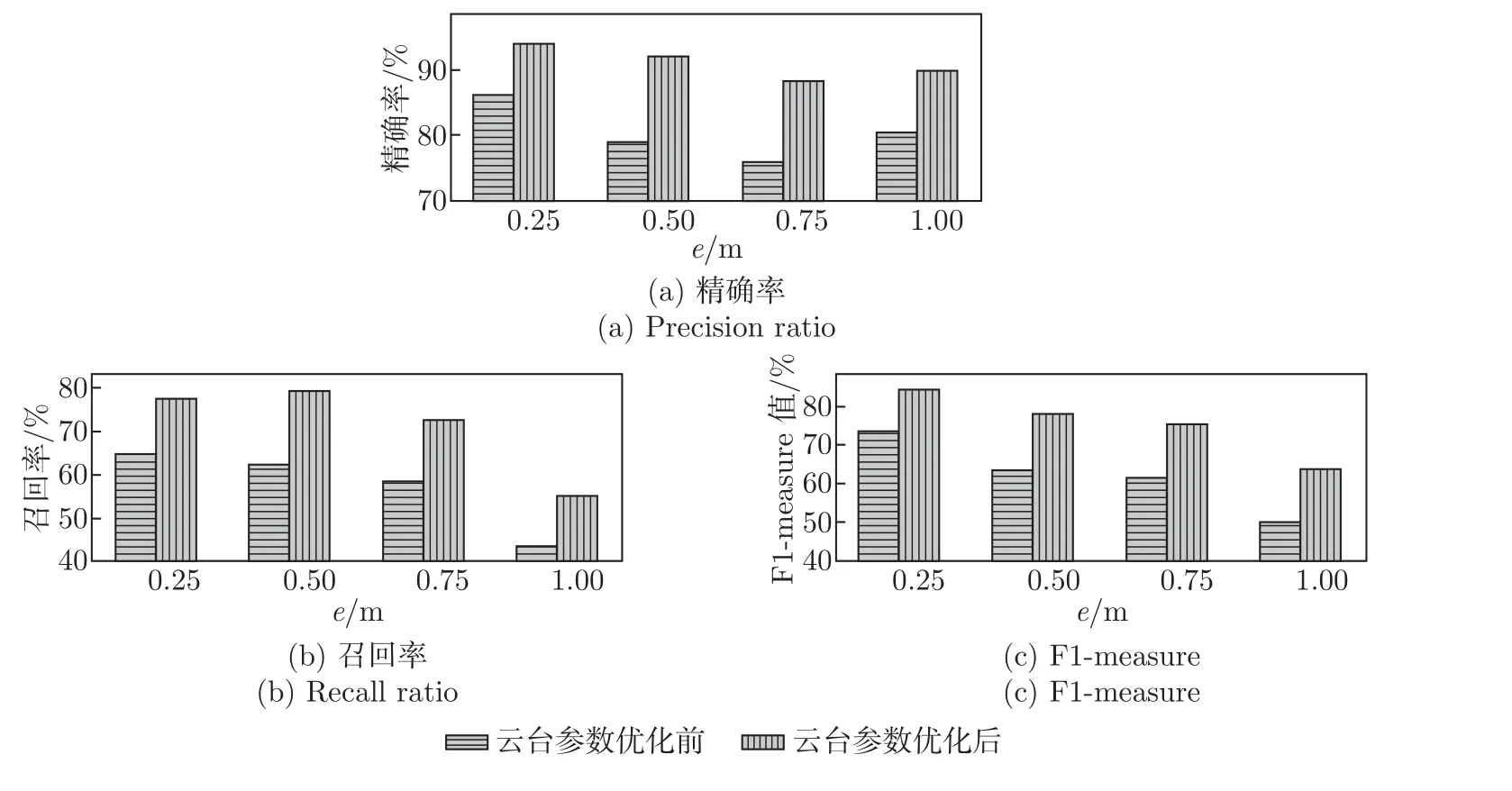

3.5.1 云台参数优化方法评估

对机器人的云台参数进行优化后的实验结果如图9 所示。从实验结果可以看出,对云台参数进行优化后,精确率、召回率和F1-measure 值均有不同程度的提高,其中,精确率平均提高约11%,召回率平均提高约14%,F1-measure 值提高约13%。

图9 云台参数优化提高机器感知能力的效果Figure 9 Effiect of steering engine parameter optimization on machine sensing

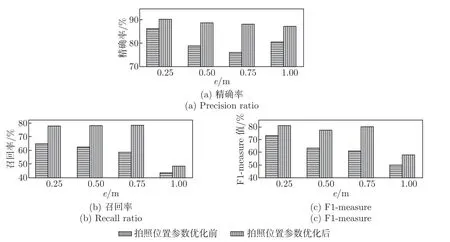

3.5.2 拍照位置参数优化方法评估

拍照位置参数优化的实验结果如图10 所示。实验结果显示,优化后采集图像的各项评价指标均有提升,但提升效果与定位误差有一定的关系。当定位误差e小于0.75 m 时,感知能力提高效果较明显,F1-measure 值提高近20%;当定位误差e为1 m 时,感知能力提高效果不明显,F1-measure 值仅提高了8%。

图10 拍照位置优化提高机器感知能力的效果Figure 10 Effiect of optimizing the camera position on machine sensing

对比图9 与10 的两种优化方法的实验结果,舵机旋转参数优化方法较拍照位置参数优化方法在指标提升方面上更稳定、更有效,拍照位置参数优化方法能够解决人机协作中的视差问题,符合实际应用场景的需求。

4 结语

本文以基于人机协作方式采集城市图像为应用背景,针对提高移动机器人的感知能力提出了优化感知任务指令的方法。在人机协作下移动机器人自主有效地进行感知是未来的应用需求。本文的研究主要是通过提高机器人的感知能力实现提高人机协同感知质量的目的。下一步,我们将在智能交通领域研究如何应用人机协作技术实现交通事件的人机协作机会式感知。