注意力聚集无锚框的孪生网络无人机跟踪算法

王海军,马文来,张圣燕

(1.滨州学院 山东省高校航空信息与控制重点实验室,山东 滨州 256603;2.南京航空航天大学 民航学院,江苏 南京 211106)

近年来,无人机(unmanned aerial vehicle,UAV)由于体积小、操作简单、动作灵活等特点,在军用、民用领域中得到广泛地应用,例如侦查敌情、精准打击、航空摄影、电力巡检、地理测绘、灾害救援、精准农业等.作为无人机应用的关键技术之一,无人机目标跟踪算法成为计算机视觉领域的研究热点,得到了学者们的广泛关注[1-4].相对于地面平台,无人机空中平台获得的视频具有角度多变、分辨率低、严重遮挡、运动模糊、尺度变化等严重干扰目标跟踪的因素,使得设计一种准确鲁棒的无人机目标跟踪算法具有十分重要的意义.

目前目标跟踪技术主要分为2 大类:相关滤波法和深度学习法.相关滤波方法将时域的卷积运算变换到频域进行点积运算,大大提高了跟踪速度.Bolme 等[5]将相关滤波引入到目标跟踪领域,提出误差最小平方和(minimum output sum of squared error, MOSSE)跟踪方法,跟踪速度超过了600 帧/s.Henriques 等[6]将多通道特征引入到核相关滤波(kernel correlation filter, KCF)中,在保证跟踪速度的同时,改善了跟踪性能.Huang 等[7]提出抑制畸变相关滤波(aberrance repressed correlation filters, ARCF)的无人机跟踪方法,对相关滤波响应图中的畸变或异常进行抑制,实现对目标的准确定位.Li 等[8]提出自动时空正则化(automatic spatio-temporal regularization tracker, AutoTrack)无人机跟踪算法,对空间权值和时间权值同时进行动态调整,有效提高了算法的稳定性.Lin 等[9]提出双向不一致感知相关滤波器(bidirectional incongruity-aware correlation filter, BiCF),将基于响应双向不一致的误差融合到相关滤波中,学习跟踪目标的外观变化,解决了跟踪过程中由于目标和背景变化导致的失败现象.虽然相关滤波方法取得较好的跟踪性能,但是该类方法大多采用灰度、颜色、纹理等手工特征,只适用于像素级目标定位,对旋转变形的鲁棒性很差,导致跟踪准确性和跟踪成功率的性能不高.部分相关滤波类方法采用卷积特征,改善了跟踪效果.在采用边缘计算设备(如英伟达Jetson AGX Orin 32GB)作为无人机平台计算资源时,跟踪速度大多小于30 帧/s,难以满足无人机平台实时的跟踪需求.

深度学习类跟踪方法采用离线训练网络模型提取跟踪目标的深度特征,能够有效地进行目标表征,在保证跟踪速度的同时,大大提升了跟踪性能.Bertinetto 等[10]将全卷积孪生神经网络(fully-convolutional siamese networks, SiamFC)应用到目标跟踪领域,通过学习搜索区域与目标模板的相似度响应图来确定目标位置,该方法显著提升了基于深度学习目标跟踪的速度.Li 等[11]在SiamFC 基础上提出孪生候选区域生成网络(siamese region proposal network, SiamRPN),将目标跟踪看成局部单目标检测任务,在保证较快跟踪速度的同时,有效提升了跟踪性能.SiamFC 和Siam-RPN 都是采用浅层神经网络提取出目标特征,限制了目标的深层表征能力.Li 等[12]突破深层神经网络不能应用到目标跟踪领域的限制,结合目标浅层和深层特征,在多个跟踪数据集上取得较好的跟踪性能.Xu 等[13]提出改进版全卷积孪生神经网络(fully convolutional siamese tracker++, Siam-FC++)算法,同时引入分类和状态估计分支,进一步提高了跟踪准确度.目前深度学习类目标跟踪算法取得突破性进展,大部分采用深度神经网络提取目标特征,加大计算复杂度,难以适应无人机平台的硬件配置.本研究提出注意力聚集无锚框的孪生网络无人机目标跟踪算法,在3 个无人机数据集上进行测试仿真,实现对目标位置和所占区域的准确估计.

1 SiamFC 跟踪算法

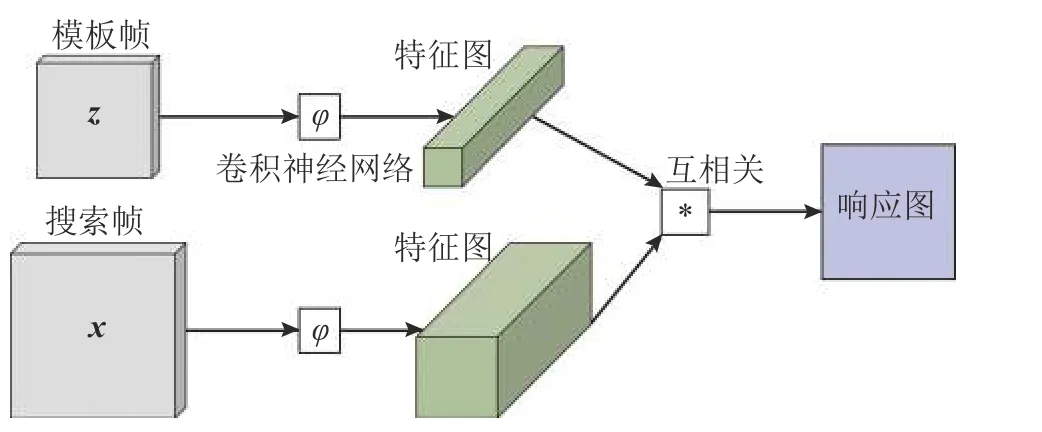

SiamFC 算法将目标跟踪问题转化为相似度学习任务,通过学习相似度度量函数f(z,x) 来比较模板图像z和搜索图像x的相似性:

式中:φ(·) 为特征提取器, ∗ 为互相关运算,b·I为响应图中每个位置的取值,I为单位矩阵.响应图中取值最高的位置,即是跟踪目标的位置.

虽然SiamFC 算法比较简单,兼顾了跟踪复杂度和跟踪准确度,但是当跟踪目标出现遮挡、快速运动、背景杂乱时,容易出现错误累加,导致跟丢目标.SiamFC 跟踪算法如图1 所示.

图1 SiamFC 算法的流程图Fig.1 Flowchart of SiamFC algorithm

2 注意力聚集无锚框孪生跟踪算法

2.1 算法整体框架

针对无人机的有限计算资源,本研究提出注意力聚集无锚框的孪生网络无人机跟踪算法(attention aggregation siamese network with anchor free scheme for UAV tracker, AASAF),算法流程图如图2所示,主要包括以下4 个方面.

图2 AASAF 算法的流程图Fig.2 Flowchart of AASAF algorithm

1) 构造以轻量级模型AlexNet 为主干网络的孪生跟踪框架,同时在2 个模板分支上引入高效通道注意力机制,使得跟踪算法具有较强的特征表达能力.

2) 融合双层相关响应,同时引入空间注意机制,能够有效聚合注意力特征,扩大模型的视野范围,充分利用特征的内在相关性.

3)引入无锚框机制来预测目标的位置和回归框,大大降低算法的复杂度,有效地提升了跟踪速度和跟踪性能.

4)在3 个无人机跟踪数据集上进行仿真实验,与当前比较流行的算法进行对比实验,验证了所提AASAF 算法的优越性.

使用AlexNet 浅层网络提取模板图像和搜索图像特征,φ4(z)和φ5(z) 分别为模板分支第4 层和第5 层提取的模板特征,φ4(x)和φ5(x) 分别为搜索分支第4 层和第5 层提取的搜索图像特征.分别将φ4(z) 和φ5(z) 输入到高效通道注意力模块[14](efficient channel attention, ECA),提高模板特征的网络表达能力,对应新的模板特征分别为和,并对2 条支路的特征图分别进行深度互相关操作:

式中:R4、R5分别对应两层深度互相关操作 ⊗ 得到的响应图,g(·) 为卷积操作模块.将响应图R4、R5进行拼接操作,输入到空间注意力模块,调整响应图的上下文信息,并分别输入到分类回归网络和锚点建议网络,确定目标位置和尺度.

2.2 通道注意力机制

传统SiamFC 算法使用AlexNet 网络提取图像特征,由于没有考虑通道信息,导致当跟踪场景比较复杂以及目标发生较大变化时容易跟丢目标.为了增强模板的表征能力,Rahman 等[15]直接将通道和空间注意力机制[16](convolutional block attention module, CBAM)加到传统SiamFC 算法的模板分支中,虽然改善了跟踪效果,但是由于CBAM模块的引入,增加了模型的复杂度,降低了算法的跟踪速度.为了有效地提升图像的表征能力,使得算法在提高跟踪性能的同时具有较高的跟踪速度,所提算法在AlexNet 网络模板分支的第4 层和第5 层分别引入高效的通道注意力模块,考虑到每个通道及其邻域通道,通过一维卷积快速完成通道权重的计算,实现对不同通道赋予不同的权值,有选择地加强有用通道信息,抑制无用通道信息.通道注意力模块的结构如图3 所示.

图3 通道注意力的结构图Fig.3 Mechanism diagram of channel attention

每个通道的权重因子为

式中:j为邻域通道变量;i为当前第i个通道;为当前所增强的特征;为特征对应的权重;为特征对应的k个邻域的集合; σ (·) 为激活函数,σ(x)=(1+e-x)-1.为了减少计算量,加快计算速度,采用一维卷积完成通道间的交互:

式中: C1Dk为一维卷积,只有k个参数.

通过引入残差结构,经过通道聚集后的特征为

式中:C为特征yi的通道数.

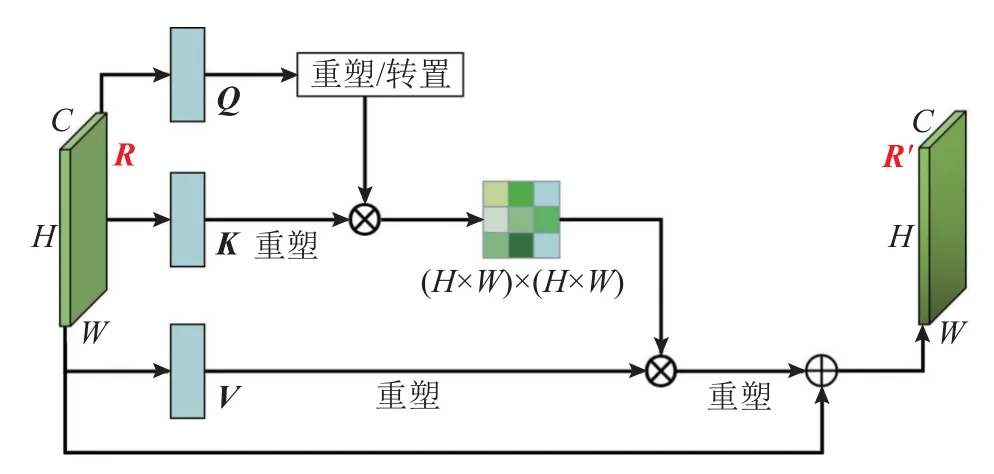

2.3 空间注意力机制

以往大部分孪生类跟踪方法都是将得到的响应图直接用于跟踪目标位置的确定和目标框的回归,忽略响应图中的特征依赖关系,导致算法在复杂场景下跟踪效果不佳.为了更好地提升响应图的特征聚合能力以及提高算法的鲁棒性,受Fu 等[17]的启发,在响应图中引入空间注意力模块,学习响应图中相似特征的依赖关系,以便更加准确地确定目标位置以及回归目标框的大小,其中空间注意力模块结构如图4 所示.

图4 空间注意力结构图Fig.4 Mechanism diagram of spatial attention

响应图RC×H×W分 别通过3 个卷积层,得到3 个特征图Q、K、V,并将空间维度分别重塑为C×(H×W),然后将转置后的Q与重塑后的K相乘,并通过归一化指数函数得到空间特征权值S(H×W)×(H×W),S矩阵中的每个元素为

式中:sj,i为响应图中位置i处对位置j处的影响.将S转置与重塑后的V做乘积后再乘以尺度系数 α ,并将空间维度重塑为C×H×W,最后与原始响应图R相加得到最终加权后的响应图中每个元素为

2.4 无锚框机制

SiamRPN 系列跟踪算法依赖锚点进行目标的分类和回归,虽然在部分视频上取得较好的跟踪效果,但是当跟踪目标遇到较大形变和尺度变化时,锚点与锚框的先验尺寸和长宽比限制了算法的鲁棒性,容易跟丢目标.为了克服锚点式跟踪器的缺点,引入无锚框分类回归子网络,在响应图中的每个位置产生一个锚点 (i,j) ,同时对应搜索图像x上位置:

式中:ws和hs分别为搜索图像x的宽和高,s为网络的步长.为了更加准确地确定目标位置及目标框大小,从响应图R′引出3 个分支,即1 个分类分支和2 个回归分支,如图2 所示.分类分支输出3 个分类特征图:中的每个点 (w,h,:) 包含一个二维向量,用于指示每个锚点是正例锚还是负例锚.将与真实标注包围框交并比(intersection over union, IoU)大于0.7 定为正例锚,将IoU 比率小于0.3 定为负例锚.中的二维向量分别表示搜索图像中前景和背景的分数,当落入真实边界框内,则为前景,反之,则为背景.用来评估每个预测框的质量,输出每个点的质量得分为

式中:l、t、r、b为在输入搜索图像中从相应位置到边界框的4 个边的距离,具体定义为

式中: (x0,y0) 和 (x1,y1) 分别为真实边界框的左上角坐标和右下角坐标, (x,y) 为锚点 (i,j) 在搜索图像上的对应位置.

综合3 个分类分支,可知总分类损失函数为

式中:Lcls1和Lcls2为交叉熵损失函数,Lcls3为二进制交叉熵损失函数, λcls1、 λcls2、 λcls3分别为对应的权值.

为搜索图像上位置 (x,y) 回归到真实目标框4 个边界的距离,定义同式(11).输出搜索图像到真实目标框的偏移计算式为

式中:gx、gy、gw、gh分别为真实目标框的中心点坐标和宽、高,px、py、pw、ph分别为预测图像框的中心点和宽、高.综合2 个回归分支可知,总回归损失函数为

式中:Lloc1为IoU 损失函数,Lloc2为平滑l1损失函数.λloc1和λloc2分别为对应的权重参数.

综合分类损失和回归损失,整体损失函数为

式中: λ1和 λ2分别为分类和回归权重系数.

3 实验与分析

3.1 实验平台及参数设置

所提算法的实验平台如下:CPU 为Inter Xeon(R) Silver 4216@2.10 GHz,内存为512 GB,显卡为Tesla V100 32 G,操作系统为Ubuntu 16.04,编程环境为基于python 3.6 的Pytorch.

训练数据如下:包含91 类目标、32.8 万个影像、250 万个标签的COCO 数据集[18];含有30 个基本类别、200 个子集的Image VID 数据集[19];含有563 个目标类别、87 种运动模式、超过1 万条视频的GOT-10K 数据集[20];含有38 万个视频片段、23 个类别、560 万个手动标注边界框的Youtube-BB 数据集[21].

参数设置如下:所提算法采用AlexNet 作为主干模型,采用随机梯度下降法训练网络,迭代次数为50,每批次处理图像124 对.前10 个迭代次数特征提取网络的参数被冻结,后40 个迭代次数对整个网络进行端到端的训练,学习率随着迭代次数变化从0.005 指数衰减到0.000 5,动量设置为0.9.模板图像的大小为1 27×127 像素,搜索图像的大小为 287×287 像素.

3.2 实验结果与分析

为了验证所提算法的跟踪性能,在UAV123@10fps[22]、UAV20L[22]和DTB70[23]这3 个广泛应用的无人机数据集进行仿真实验.

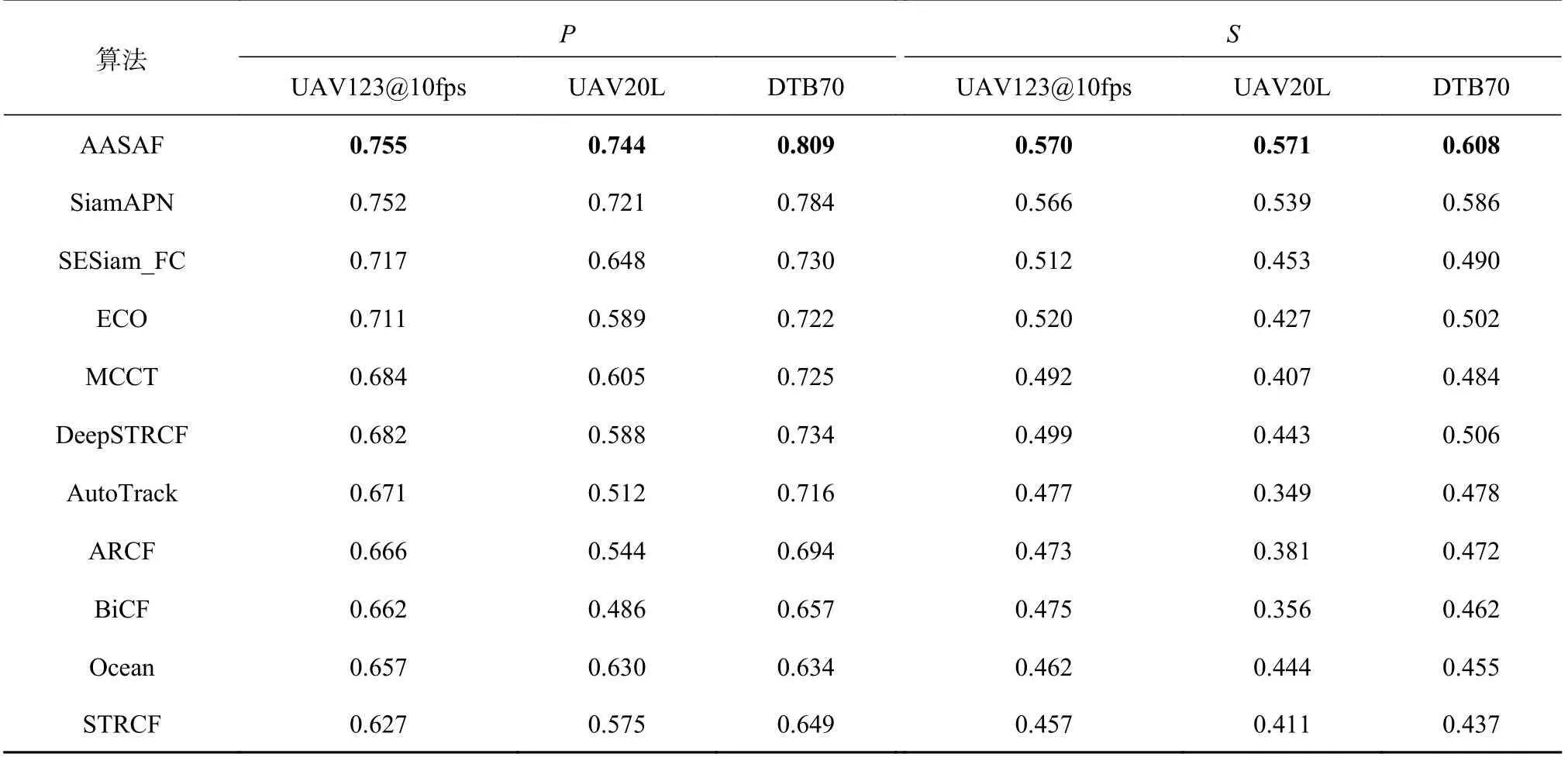

3.2.1 定量分析 表1给出所提算法分别在UAV123@10fps、UAV20L 和DTB70 数据集上与SiamAPN[24]、ECO[25]、MCCT[26]、DeepSTRCF[27]、AutoTrack[8]、ARCF[7]、Ocean[28]、BiCF[9]、STRCF[27]、SESiam_FC[29]等算法的对比实验结果.对于数据集UAV123@10fps,所提算法在跟踪准确度P和跟踪成功率S这2 个指标上分别取得了0.755 和0.570,相比最优的基于相关滤波的跟踪算法ECO,分别提升了6.2%和9.6%.对于UAV20L 数据集,所提算法在跟踪准确度和跟踪成功率上都取得了最优,分别为0.744 和0.571,相比SiamAPN 分别提高了3.2%和5.9%.对于DTB70 数据集,所提算法跟踪准确度达到0.809,跟踪成功率达到0.608,相比其他算法在指标数值上具有明显的优势.从表1可以看出,所提算法在3 个无人机数据集上以及2 个跟踪综合跟踪指标上都取得了最好的跟踪性能,具有较好的泛化性能.

表1 11 种跟踪算法在3 个无人机数据库上的跟踪准确度和成功率对比Tab.1 Comparison in terms of precision and success rate for eleven tracking algorithms on three UAV datasets

为了准确比较不同算法在各种挑战性场景下的跟踪性能,图5 给出7 种跟踪算法在3 个无人机数据集上不同属性的跟踪准确度和成功率对比.第1 列为不同属性的跟踪准确度对比,第2 列为不同属性的跟踪成功率对比.无人机跟踪视频一般具有下列几种挑战性属性,分别为宽高比变化(aspect ratio variation, ARV)、背景杂乱(background clutter, BC)、形变(deformation, DEF)、相机快速运动(fast camera motion, FCM)、平面内旋转(in-plane rotation, IPR)、运动模糊(motion blur,MB)、遮挡(occlusion,OCC)、平面外旋转(out-ofplane rotation, OPR)、视野外(out-of-view, OV)、尺度变化(scale variation, SV)、相似物体干扰(similar objects around, SOA)、完全遮挡(full_occlusion,FOC)、部分遮挡(partial_occlusion, POC)、快速运动(fast_motion, FM)、光照变化(illumination_variation, IV)、视角变化(viewpoint change, VC)、长程跟踪(long-term tracking, LTT).从图5 可以看出,所提AASAF 算法相比其他较好的6 种跟踪算法,几乎在所有的挑战性属性上,无论是跟踪准确度还是跟踪成功率指标都取得了最好的成绩.

3.2.2 定性分析 为了验证所提算法的优越性,图6 给出7 种不同算法在3 个无人机数据集上的部分跟踪仿真结果.图像中左上方的“#数字”表示跟踪结果的帧号.图6 (a)person17_1、(b)car1_2 来自UAV123@10fps 数据集,图6 (c)car6 和(d)person7 来自UAV20L 数据集,图6 (e)Yacht4、(f)ChasingDrones 和(g)BMX5 来自DTB70 数据集.

在图6 (a)中,当行人经过路边树木时,存在严重遮挡(如190 帧),树叶颜色与行人衣服非常接近,SiamAPN、BiCF 算法难以准确对目标人物和遮挡树木进行识别,从而跟丢目标.所提算法由于采用通道注意力机制对不同通道特征进行加权,能够分辨出目标人物,从而实现准确跟踪.

在图6 (b) 中,由于无人机距离目标汽车较远,利用传统相关滤波算法难以获取目标信息,导致视频中汽车占据的面积较小.当转弯时(如205 帧),ECO 算法跟丢目标汽车;当遇到遮挡时(如293 帧),MCCT 和BiCF 都完全跟丢目标,所提算法和SiamAPN 算法在整个视频全过程中都能实现小目标的准确定位与跟踪.

图6 (c)的car6 视频属于长时跟踪视频,帧数多达4 000 多帧.在对目标车辆进行跟踪过程中,由于无人机角度及高度变化,目标汽车存在较大的形变及尺度变化.所提算法采用无锚框机制,直接确定目标中心点到边框的距离,能够较准确地回归目标框尺寸,实现对目标的准确定位.在其他大多数算法中,目标框虽然也在目标汽车上,但是难以获得汽车的准确尺寸.

在图6 (d) 中,目标人物在草地上快速跑动,无人机大部分场景在目标人物上方,同时在部分场景中,目标人物跑到无人机视野外(如700 帧).当目标重新出现时,由于所提算法采用空间注意力机制,能够获取全局信息,从而能够重新对目标进行定位.

在图6(e)中,多个快艇出现在视野中,同时目标快艇被前面大艇遮挡(如240 帧),其他多数算法都偏移到干扰快艇上,只有所提算法能够始终实现对目标的定位,同时准确获取快艇的目标框.在图6(f)中,目标无人机在空中快速飞行,目标小且速度快,同时存在形变及背景干扰(如160 帧).可以看出,多数算法难以适应空中小目标的快速移动,从而跟丢目标,利用所提算法能够克服其他算法缺点,获得目标的鲁棒特征,从而实现准确的定位.在图6 (g)中,骑行运动员在场地内快速移动、目标人物外观变化比较频繁,可以看出,虽然多数算法能够实现对目标的定位,但是不能获得准确的目标框,只有所提算法和SiamAPN 算法能够获得准确的目标框.

3.3 跟踪速度对比

表2 给出不同算法在UAV123@10fps、UAV20L和DTB70 数据集上的跟踪速度对比.所有算法都在相同的实验平台上进行仿真.可以看出,AASAF算法和SiamAPN 算法在保证跟踪性能的同时,在3 个数据集上的平均速度v超过150 帧/s,能够满足实时跟踪的要求.基于深度神经网络提取目标特征的相关滤波算法的计算量比较大,跟踪速度较慢,难以满足无人机平台轻量级计算资源的需求.为了验证所提算法在实际无人机平台搭载边缘计算模块运行的可行性,利用AASAF 算法在英伟达Jetson AGX Orin 32GB 开发平台上进行仿真实验.在3 个无人机数据集上的平均跟踪速度达到36.2 帧/s,能够实现实时跟踪,表明所提算法在满足无人机平台搭载轻量级计算资源的前提下,可以实现快速鲁棒跟踪.

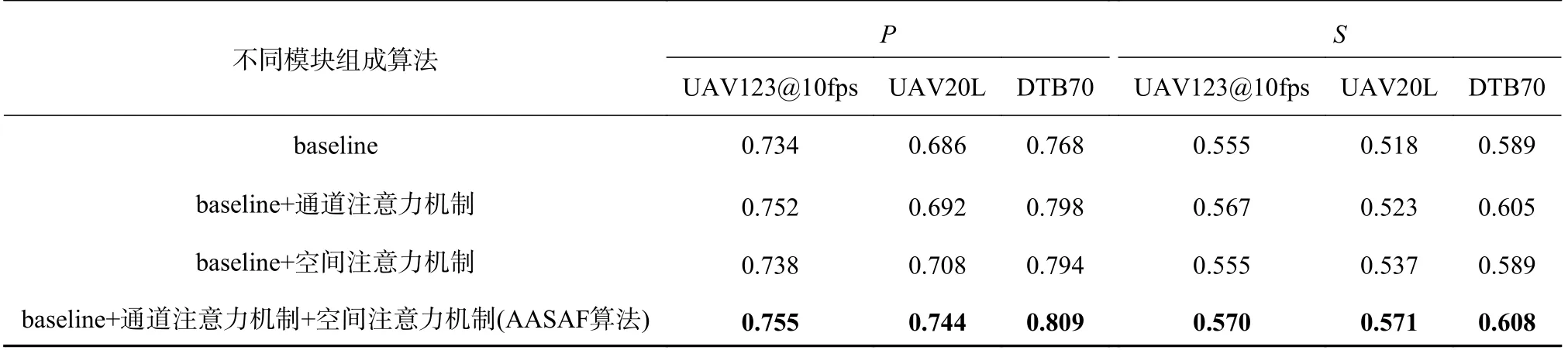

3.4 消融实验

表3 给出基准算法baseline 在通道注意力机制、空间注意力机制作用下,分别在3 个无人机数据库上的跟踪准确度和跟踪成功率对比.基准算法baseline 表示没有采取上述2 种注意力机制.从表3 可以看出,基准算法在3 个数据库上的跟踪准确度和跟踪成功率均最低;当通道注意力机制和空间注意力机制分别单独作用时,与基准算法baseline 相比,跟踪性能均有一定程度的改进,表明通道注意力机制的特征聚合作用和空间注意力机制的扩大视野范围对baseline 算法的跟踪性能均有一定程度的提升作用.当2 种注意力机制同时作用在baseline 算法时,AASAF 算法的跟踪准确度和跟踪成功率2 个指标改进最大.

表3 基准算法与不同注意力机制结合在3 个无人机数据库上的跟踪性能对比Tab.3 Comparison of tracking performance conducted on baseline algorithm with different attention schemes on three UAV datasets

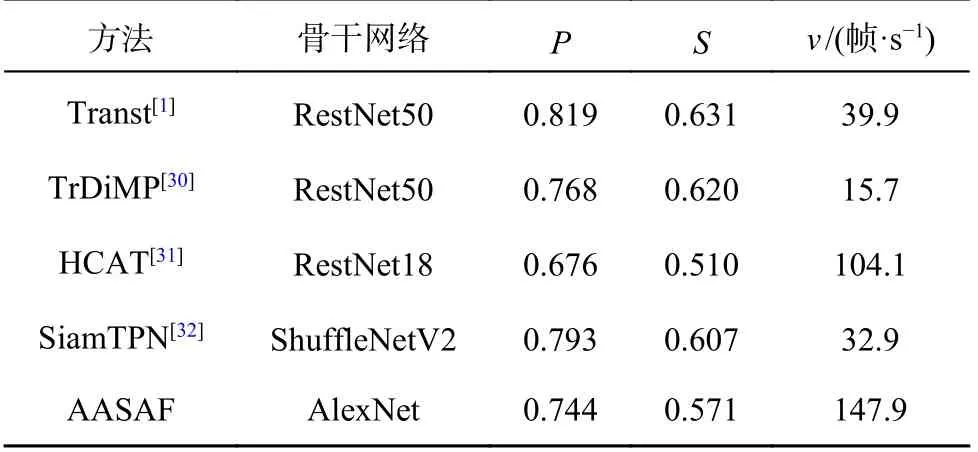

3.5 与Transformer 跟踪方法的对比

Transformer 在计算机视觉领域取得了巨大的成功,并被广泛应用于目标跟踪领域.由于Transformer 具有良好的捕获长距离依赖关系能力,在长时程视频以及目标被遮挡时,表现出较好的跟踪性能.如表4 所示为所提算法与4 种基于Transformer 的跟踪方法在UAV20L 数据集上的跟踪性能对比.可以看出,Transt、TrDiMP 和SiamTPN 这3 种算法在UAV20L 数据集上的跟踪准确度和跟踪成功率都取得比AASAF 算法更好的跟踪性能,但是这3 种算法的跟踪速度相比所提算法较慢,限制了其在无人机平台上的部署应用.HCAT 算法虽然取得了较快的跟踪速度,但是跟踪性能相比AASAF 算法较低.综合跟踪性能和跟踪速度,相比其他4 种基于Transformer 的跟踪算法,AASAF算法在无人机平台上具有较好的应用前景.

表4 与基于Transformer 跟踪方法在UAV20L 数据集上的跟踪性能对比Tab.4 Comparison of tracking performance with transformer based trackers on UAV20L

4 结 论

(1) 在传统AlexNet 主干网络输出的2 个模板分支中引入高效通道注意力机制,能够显著提升模型的特征提取能力和判别能力.

(2) 将两层相关响应进行融合,引入空间注意力机制,通过聚合注意力特征,扩大模型的全局视野,能够提取更多有效的语义信息.

(3) 引入无锚框机制,直接在每个像素上分类和预测回归框,有效降低运算复杂度,提升跟踪性能.

(4) 在UAV123@10fps、UAV20L 和DTB70 3 个无人机数据集上的跟踪结果表明,所提算法的跟踪准确度分别达到0.755、0.744 和0.809,跟踪成功率分别达到0.570、0.571 和0.608,且在较高的跟踪准确度和跟踪成功率下,Tesla V100 32 GB上的平均速度可达155.2 帧/s,边缘计算设备Jetson AGX Orin 32GB 上的平均速度可达36.2 帧/s,在无人机平台上具有较好的应用前景.

未来将搭建无人机实际飞行跟踪的测试平台,在长时程及遮挡方面提高无人机在真实环境下的跟踪性能,验证算法在高空平台上的实际跟踪效果,从而满足无人机实时跟踪的实际工程需求.